1. Einführung

Viele Klimatologen haben uns gesagt, dass die Umwelt der Erde ernsthaft in Gefahr ist, sich zu überhitzen, und zwar infolge der menschlichen Erzeugung von Treibhausgasen seit der industriellen Revolution. Kohlendioxid (CO2) sei der Hauptschuldige, aber Methan (CH4), Stickstoffoxid (N2O) und bestimmte Fluorchlorkohlenwasserstoffe tragen ebenfalls dazu bei.

„Wie erwartet ist die Botschaft immer die Gleiche: Die Beweise sind sehr eindeutig, dass die Welt sich erwärmt und das menschliche Aktivitäten der Hauptgrund dafür sind. Natürliche Änderungen und Fluktuationen gibt es zwar auch, doch sind diese relativ klein“– John Shepard in UK die die Royal Society am 27. September 2013.

„Wir können die Fakten nicht länger ignorieren: die Globale Erwärmung ist eindeutig, sie wird von uns verursacht und deren Konsequenzen werden erheblich sein. Das heißt aber nicht, dass wir dieses Problem lösen können“. – Andrew Weaver in Kanada in der Globe and Mail am 28. September 2013.

„Wir wissen ohne Zweifel, dass die von uns in die Luft geblasenen Treibhausgase zu einem globalen Energie-Ungleichgewicht geführt haben, und die globale Erwärmung beträgt seit vorindustriellen Zeiten schon 0,8°C. Diese Erwärmung führt zu einer Zunahme von Extremwetter in Gestalt von Hitzewellen, Dürren, Buschbränden und stärkeren Stürmen…“ – James Hansen in den USA am 6. Dezember 2013 in einer Sendung von CNN News.

Sind diese Ansichten gerechtfertigt? In der Vergangenheit lagen schon bedeutende Wissenschaftler falsch. Lord Kelvin, der noch nichts von Kernfusion wusste, hat die Schlussfolgerung gezogen, dass die Gravitationsenergie der Sonne diese nur noch 10↑7 Jahre lang scheinen lassen kann. Sir Arthur Eddington hat korrekt von einer nuklearen Quelle der Sonne gesprochen, hat aber Subrahmanyan Chandrasekhars Theorie degenerierter Materie zur Erklärung Weißer Zwerge abgelehnt. Im Jahre 1983 erhielt Chandrasekhar den Nobelpreis für Physik für seine Entdeckung.

Ich selbst habe Ausbildung in Physik und Astrophysik mit Erfahrung im Strahlungstransport, nicht Klimatologie, aber gerade dieser Blich von außerhalb auf diese Disziplin lässt mich einige ernste Probleme erkennen. Ich vermute, dass den meisten Klimawissenschaftlern diese Inkonsistenzen bewusst sind, aber diese verbleiben dennoch in den Berichten des IPCC einschließlich des jüngsten, am 27. September 2013 veröffentlichten Bericht. Politiker und Funktionäre der Regierung [und natürlich die Main Stream Medien in D! A. d. Übers.] richten sich nach diesen Berichten und bewerten sie als zuverlässig.

2. Theorie, Modelle und Beobachtungen/Messungen

Ein notwendiger Test jedweder Theorie oder jedweden Modells besteht darin zu schauen, wie gut es die Ergebnisse neuer Experimente oder Beobachtungen vorhersagt, die bei seiner Entwicklung nicht verwendet worden sind. Es ist nicht ausreichend, lediglich die Daten zur Entwicklung der Theorie oder des Modells zu präsentieren. Das gilt besonders im Falle der Klimamodelle, wo viele physikalische Prozesse zu kompliziert sind, um sie explizit mit regelbaren Parametern abbilden zu können. John von Neumann hat einmal gesagt: „Mit vier Parametern kann ich einen Elefanten beschreiben, und mit fünf kann ich ihn dazu bringen, mit seinem Rüssel zu wackeln“. Vier Parameter werden natürlich nicht alle Details eines Elefanten beschreiben können, aber das Prinzip ist klar. Die Modelle müssen unabhängigen Tests unterzogen werden!

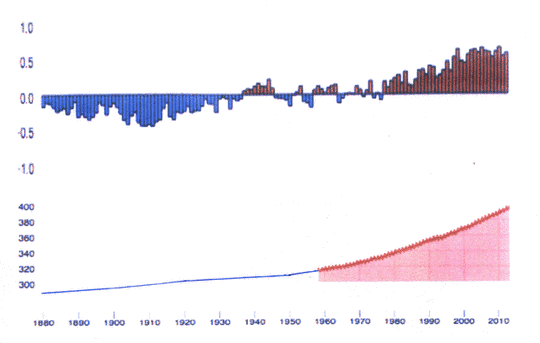

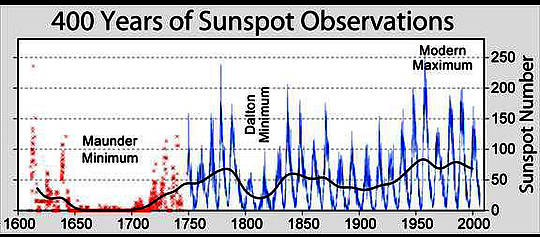

Abbildung 1: Globale mittlere Temperaturanomalie (°C, oben) und CO2-Konzentration (ppm, unten; Quelle Daten der NOAA. Die Ausdehnung von CO2-Daten auf frühere Jahre stammt aus Daten von Eisbohrkernen des Antarctic Law Dome hier.

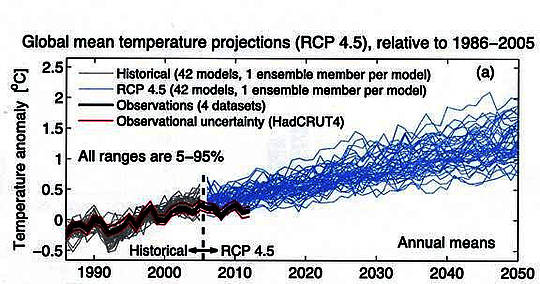

Der obere Plot in Abbildung 1 zeigt die Variation der Temperatur seit 1880 mit einer Abnahme bis 1910, einer Zunahme bis 1945, einem Plateau bis 1977, einem Anstieg um 0,6°C bis 1998, um dann während der nächsten 16 Jahre konstant zu verlaufen. Gleichzeitig hat die CO2-Anreicherung in unserer Atmosphäre stetig zugenommen. Abbildung 2 aus dem 5. Zustandsbericht (2013) zeigt, dass die gemessenen Temperaturen am unteren Ende der von den Klimamodellen vorhergesagten Bandbreite liegen.

Abbildung 2: Modellvorhersagen und Temperaturmessungen aus dem IPCC-Bericht 2013. Die Bezeichnung RCP4.5 (Representative Concentration Pathway 4.5) kennzeichnet einen Satz von Modellen mit einem moderaten Anstieg anthropogener Treibhausgase, was einer Zunahme der Gesamt-Sonneneinstrahlung von 4,5 W/m² (1,3%) gleichkommt.

Bereits im Jahre 2009 machten sich die Klimatologen Gedanken über die Änderung der Steigung der Temperaturkurve. Zu jener Zeit warfen Knight et al. (2009) die rhetorische Frage auf: „falsifizieren die globalen Temperaturtrends des vergangenen Jahrzehnts die Klimavorhersagen?“ Die Antwort lautete: „Trends nahe Null oder sogar negative Trends sind üblich für Intervalle von einem Jahrzehnt oder weniger in den Simulationen, und zwar infolge der modellinternen Klimavariabilität. Die Simulationen schließen aber (mit einer Wahrscheinlichkeit von 95%) aus, dass Null-Trends 15 Jahre oder länger vorherrschen. Das zeigt, dass das Fehlen einer Erwärmung dieser Dauer erforderlich ist, um zu einer Diskrepanz mit der erwarteten Erwärmungsrate bis zum aktuellen Tag zu kommen“.

Jetzt sagen einige Klimawissenschaftler, dass ein Zeitraum von 16 Jahren ein zu kurzer Zeitraum ist, um eine Klimaänderung abzuschätzen. Dann jedoch könnte auch der dem anthropogenen CO2 zugeordnete Anstieg von 1978 bis 1998 unecht sein. Andere Forscher untersuchen aktiv aus den Modellen stammende Phänomene, um die Diskrepanz zu erklären. Darunter sind:

1) eine starke Erwärmung durch ein El Nin͂o-Ereignis im Jahre 1998, so dass das Plateau nicht vor dem Jahr 2001 begonnen hat,

2) eine Überschätzung des Treibhauseffektes in manchen Modellen,

3) unangemessene Behandlung der Wolken und anderer Aerosole in den Modellen und

4) ein Reservoir in der Tiefsee für die fehlende Wärme.

Eine zusätzliche Erwärmung durch den El Nin͂o von 1998 scheint plausibel, aber es gab auch noch andere, die als Ursache für eine frühere Erwärmung in Frage kommen; und dann sind da auch noch die kühlenden La Nin͂a-Ereignisse. Alle vorgeschlagenen Gründe für das Plateau müssen mit ihren Auswirkungen auf die Erwärmung ebenfalls in die Modelle eingehen, die dann während des folgenden Jahrzehnts oder deren zwei mit der tatsächlichen Temperaturentwicklung verglichen werden können.

3. Der Rückkopplungs-Parameter

Es gibt keine Kontroverse in der Grundlagenphysik darüber, dass die Zuführung von CO2 in die Atmosphäre Sonnenenergie absorbiert, was zu einer geringen Erwärmung zusätzlich zu dem dominanten Faktor des Wasserdampfes führt. Die spektrale CO2-Absorption ist gesättigt und damit proportional dem Logarithmus der Konzentration. Der geschätzte Effekt kommt lediglich für die Hälfte des Temperaturanstiegs von 0,8°C seit der industriellen Revolution in Frage. Ohne jede Rechtfertigung haben die Modellbauer mögliche natürliche Gründe ignoriert und angenommen, dass der Anstieg hauptsächlich dem anthropogenen CO2 geschuldet ist, wobei Reflektionen durch Wolken und andere Aerosole die Absorption durch die anderen oben genannten Gase weitgehend neutralisieren. Folgerichtig postulierten sie eine positive Rückkopplung, weil wärmere Luft mehr Wasserdampf aufnehmen kann, was die Strahlungsabsorption und die damit einher gehende Rückerwärmung erhöht. Die Computersimulationen repräsentierten diesen Prozess sowie viele andere Effekte durch veränderbare Parameter, die gewählt worden sind, um zu den Beobachtungen zu passen. Im Abschnitt 9-9 im IPCC-Bericht 2013 heißt es: „Die Komplexität jeder Prozess-Repräsentation wird durch Beobachtungen herausgefordert, durch rechenintensive Ressourcen und gegenwärtiges Wissen“. Modelle, die keinen Temperaturanstieg zeigen, wären von jedem Ensemble ausgeschlossen worden, so dass der beobachtete Anstieg effektiv den Rückkopplungs-Parameter bestimmt.

Mit dem Stillstand des Temperaturanstiegs sehen wir jetzt, dass dieser Parameter nicht gilt. Er kann sogar negativ sein [worauf Herr Dr. Stehlik immer wieder hinweist! A. d. Übers.] Die CO2-Absorbtion ohne die vermeintliche Rückkopplung wird es zwar geben, aber die Auswirkungen davon werden nicht alarmierend sein. Die moderate Erwärmung ist möglicherweise insgesamt von Vorteil mit zunehmenden Erntemengen und weniger Kältetoten.

4. Die Sonne

Die Gesamtsolarstrahlung, also der Fluss integriert über alle Wellenlängen, ist ein grundlegender, in die Klimamodelle eingehender Faktor. Glücklicherweise ist unsere Sonne ein recht stabiler Stern mit nur minimalen Schwankungen seiner Strahlung. Seit dem Beginn von Satellitenmessungen des gesamten Spektrums im Jahre 1978 betrug die Schwankung über den 11-jährigen Aktivitäts-Zyklus im Mittel 0,1% mit gelegentlichen Spitzen bis 0,3%. Die damit verbundene Änderung der troposphärischen Temperatur beläuft sich auf etwa 0,1°C.

Stärkere Variationen könnten historische Warm- und Kaltzeiten erklären, wie die Mittelalterliche Warmzeit (etwa 950 bis 1250) und die Kleine Eiszeit (etwa 1430 bis 1850), aber das bleibt Spekulation. Die Sonne ist ein Gasball im hydrostatischen Gleichgewicht. Jedwede Reduktion der nuklearen Energiequelle würde durch eine Schwerkraft-Kontraktion in einer Zeitspanne von wenigen Minuten kompensiert werden. Komplizierter wird dieses Grundbild durch variable magnetische Felder und die Massenbewegungen, die dieses erzeugen. Li et al. (2003) haben diese Effekte in ein einfaches Modell eingegeben und fanden Variationen der Helligkeit um 0,1%, was mit den Messungen übereinstimmt.

Allerdings kann die Sonne die Erde in vielfältiger anderer Weise beeinflussen, die in den IPCC-Berichten nicht in Betracht gezogen werden, teilweise weil diese Mechanismen noch gar nicht verstanden sind. Die ultraviolette Strahlung ändert sich viel stärker mit der Sonnenaktivität, ~10% im 200 nm-Band, die das Ozon in der Stratosphäre bildet und zwischen 5% und 2% in den Absorptionsbändern zwischen 240 nm und 320 nm (DeLand & Cebula 2012). Die Graphiken dieser Autoren zeigen auch, dass die Flüsse während des jüngsten solaren Minimums niedriger sind als während der vorangegangenen zwei Minima, was zu geringerer Ozonbildung in der Stratosphäre und zu einer geringeren Absorption von Strahlung im nahen UV führt. Wie diese Absorption sich in untere Schichten der Atmosphäre ausbreiten kann, wird gegenwärtig untersucht, z. B. von Haigh et al. (2010).

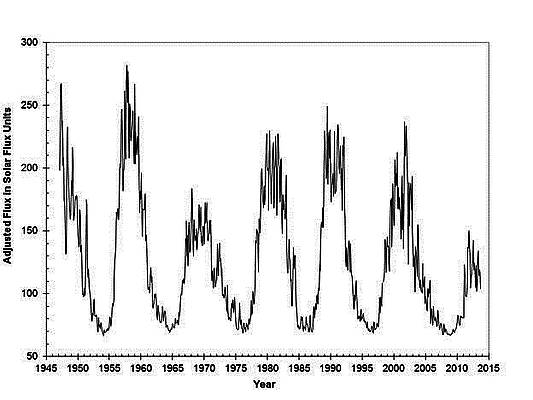

Abbildung 3: Monatliche Mittelwerte des 10,7 cm-Strahlungsflusses der Sonne, gemessen vom National Research Council of Canada und berechnet für die mittlere Distanz zwischen Sonne und Erde. Eine Einheit der Sonnenstrahlung = ![]() *. Das gerade vorüber gegangene Maximum ist ungewöhnlich schwach und das voran gegangene Minimum ungewöhnlich ausgedehnt. Graphik nach Dr. Ken Tapping vom NRC.

*. Das gerade vorüber gegangene Maximum ist ungewöhnlich schwach und das voran gegangene Minimum ungewöhnlich ausgedehnt. Graphik nach Dr. Ken Tapping vom NRC.

[Besser ließ sich das mit der Hochstellung nicht darstellen. A. d. Übers.]

Abnehmende Sonnenaktivität erniedrigt auch die Stärke des solaren Magnetfeldes, wodurch mehr galaktische Strahlung den Weg zur Erde findet. Experimente von Kirkby et al. (2011) und Svensmark et al. (2013) haben gezeigt, dass diese kosmischen Strahlen die Wolkenbildung begünstigen, die in der Folge mehr Sonnenlicht reflektieren und die Temperatur reduzieren, obwohl die Größenordnung dieses Effektes unsicher bleibt. Morton (2014) hat beschrieben, wie oft die Isotope 10Be und 14C in Eisbohrkernen und Baumringen vorkommen und damit Hinweise auf die Sonnenaktivität in der Vergangenheit geben sowie deren Antikorrelation mit der Temperatur [?]

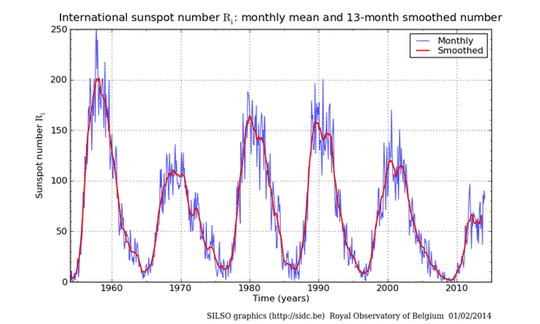

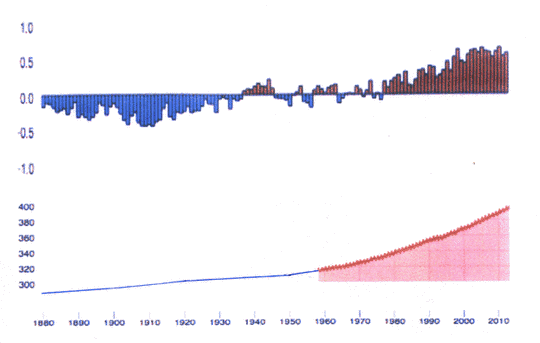

Von besonderem Interesse ist die gegenwärtig abnehmende Sonnenaktivität. Abbildung 3 zeigt den Strahlungsfluss bei 10,7 cm, gemessen von dem National Research Council of Canada seit 1947 (Tapping 2013), und Abbildung 4 die damit korrespondierende Sonnenfleckenzahl. Eine sorgfältige Kalibrierung des Strahlenflusses erlaubt zuverlässige Vergleiche von sechs Sonnenzyklen, selbst wenn es gar keine Sonnenflecken gab. Das letzte Minimum war ungewöhnlich ausgedehnt und das gegenwärtige Maximum außerordentlich schwach. Die Sonne ist in eine Phase geringer Aktivität eingetreten. Abbildung 5 zeigt, dass vorangegangene Zeiten sehr geringer Aktivität zum Dalton-Minimum von 1800 bis 1820 und das Maunder Minimum von 1645 bis 1715 aufgetreten waren.

Abbildung 4: Monatliche Sonnenfleckenzahlen der letzten 60 Jahre vom Royal Observatory of Belgium. Quelle.

Da diese Minima während der Kleinen Eiszeit aufgetreten waren, als sich die Gletscher in beiden Hemisphären ausdehnten, ist es möglich, dass wir derzeit in eine weitere Abkühlungsperiode eintreten. Ohne das physikalische Verständnis der Gründe derartiger Perioden können wir nicht spezifischer sein. Temperaturen wie in der Kleinen Eiszeit mögen vielleicht nicht auftreten, aber es muss eine gewisse Abkühlung geben, um die Erwärmung durch die zunehmende CO2-Konzentration zu kompensieren.

Bedauerlicherweise werden diese solaren Effekte und die Unsicherheiten, die sie für jedwede Prognose bedeutet, in den IPCC-Berichten fast nie erwähnt.

5. Die mittlere globale Temperatur

Langzeitliche Temperaturmessungen an einer bestimmten Stelle bieten einen offensichtlichen Test bzgl. Klimaänderung. Derartige Daten gibt es von vielen Stellen seit über einhundert Jahren, für einige Stellen sogar noch länger. Mit diesen Daten berechnen die Klimatologen Temperaturanomalien – die Abweichung von einem vieljährigen Mittel wie z. B. von 1961 bis 1990, und zwar für jeden Tag des Jahres zu der Zeit, zu der die Messung erfolgt. Dann mitteln sie über Tage, Nächte, Jahreszeiten, Kontinente und Ozeane, um die mittlere globale Temperaturanomalie für jeden Monat bzw. jedes Jahr zu erhalten, wie in Abbildung 1 dargestellt.

Unglücklicherweise gibt es aus vielen Gebieten der Welt kaum Messungen, und von den Ozeanen, die 71% der Erdoberfläche bedecken, schon gar nicht. Folglich müssen viele Messungen extrapoliert werden, um größere Gebiete mit unterschiedlichem Klima zu erfassen. Korrekturen sind erforderlich, wenn die Messungen an einer Stelle Lücken aufweisen oder Stationen an eine andere Stelle verlegt werden; oder um den städtischen Wärmeinseleffekt auszugleichen, falls die meteorologische Station signifikant höher liegt als der Meeresspiegel.

Abbildung 5: Sie stammt von der U. S. National Oceanic and Atmospheric Administration (NOAA) und zeigt die Sonnenfleckenzahlen seit deren erster Beobachtung mittels Teleskopen im Jahre 1610. Schon bald nach der Entdeckung eines 11-jährigen Zyklus‘ im Jahre 1843 begann man systematisch zu zählen. Später wurden mittels der Untersuchung älterer Aufzeichnungen die früheren Jahre hinzugefügt.

Die IPCC-Berichte beziehen sich auf vier Datenquellen zur Berechnung der Temperaturanomalie: dem Hadley Centre for Climate Prediction and Research, dem European Centre for Medium-range Weather Forcasting (ECMWF) in UK, dem Goddard Institute for Space Science (GISS) und der National Oceanic and Atmospheric Administration (NOAA) in den USA. In bestimmten Monaten können diese Daten um mehrere Zehntelgrad voneinander abweichen, aber alle zeigen die gleichen langzeitlichen Trends von Abbildung 1, also einen Anstieg von 1978 bis 1998 und ein Plateau seit 1998 bis heute.

Diese Verteilung stellt nach wie vor eine Herausforderung des Verständnisses der Forscher dar. Einige Klimatologen bevorzugen es, eine gerade Linie durch alle Daten seit 1978 bis heute zu ziehen. Daraus schließen sie dann, dass sich die Erde immer noch erwärmt, vielleicht lediglich etwas langsamer, aber falls diese Kurven irgendetwas mit der Realität zu tun haben, bedeutet eine Änderung der Steigung gar nichts. Sind sie Beweis für die chaotische Natur des Klimas mit abrupten Wechseln von einem Zustand in einen anderen?

Essex, McKitrick und Andresen (2007) sowie Essex und McKitrick (2007) haben in ihrem populären Buch die Verwendung dieser Mittelwerte der Temperaturdaten für die Erde kritisiert. Erstens ist die Temperatur eine intensive thermodynamische Variable, die sich an einer bestimmten Stelle im Gleichgewicht mit dem Messgerät befindet. Jede Mittelung mit den Werten anderer Stellen oder anderer Zeiten oder anderer Jahreszeiten hat keine physikalische Bedeutung. Andere Arten von Mittelwerten mögen geeigneter sein, von denen jedoch jeder Einzelne einen anderen zeitlichen Trend kann. Außerdem sind es die Temperaturunterschiede zwischen zwei Stellen, die die Dynamik treiben. Klimatologen haben nie erklärt, was eine einzelne Zahl der globalen Temperatur eigentlich bedeutet. Essex und McKitrick schreiben, dass dies „keine Temperatur ist. Es ist nicht einmal ein sinnvoller Index oder eine sinnvolle Statistik. Es ist eine Sequenz unterschiedlicher Statistiken, die zusammen gepresst wurden zusammen mit Ad-Hoc-Modellen“.

Diese fragwürdige Verwendung einer globalen Temperatur zusammen mit den Problemen, ein chaotisches System zu modellieren (siehe nächsten Abschnitt) führen zu grundlegenden Fragen hinsichtlich der Gültigkeit des Tests mit Beobachtungen in Abschnitt 2. Da die Klimatologen und das IPCC darauf bestehen, diese Temperaturzahl zu verwenden und deren Modelle für ihre Vorhersagen der globalen Erwärmung, ist es nur recht und billig, sie weiterhin mit den Beobachtungen zu vergleichen, die sie für relevant halten.

6. Chaos

Essex und McKitrick (2007) haben eine hilfreiche Einführung in dieses Problem angeboten. Dank der bahnbrechenden Untersuchungen der Gleichungen für Konvektion und der damit verbundenen Turbulenz durch den Meteorologen Edward Lorenz ist den Wissenschaftlern bewusst geworden, dass viele dynamische Systeme fundamental chaotisch sind. Die Lage wird oft als der Schmetterlings-Effekt bezeichnet, weil eine winzige Änderung der Anfangsbedingungen wie der Flügelschlag des Schmetterlings enorme Auswirkungen auf spätere Entwicklungen haben können.

Konvektion und Turbulenz in der Luft sind zentrale Phänomene bei der Berechnung des Wetters und müssen daher auch auf das Klima ihre Auswirkungen haben. Das IPCC trägt diesem Umstand auf Seite 1-25 des Berichtes aus dem Jahr 2013 Rechnung mit der Feststellung: „Es gibt fundamentale Limits, wie genau man jährliche Temperaturen projizieren kann, und zwar wegen der chaotischen Natur des Klimasystems“. Nichtsdestotrotz werden Vorhersagen mit großem Vertrauen gemacht. Die das Wetter modellierenden Meteorologen erleben, dass ihre Vorhersagen nach ein oder zwei Wochen unbrauchbar sind, und sie haben den Vorteil, ihre Vorhersagen stets mit den Beobachtungen vergleichen zu können.

Warum zeigen die Modelle des IPCC diese Instabilitäten nicht? Wurden sie selektiv darauf getrimmt, diese zu vermeiden, oder sind die chaotischen physikalischen Prozesse nicht angemessen berücksichtigt? Warum sollen wir glauben, dass langzeitliche Klimavorhersagen möglich sind, wenn das für das Wetter nicht gilt?

7. Die Beschwörung des Konsens’ und die Ruhigstellung des Skeptizismus’

Wir hören oft, dass wir akzeptieren müssen, dass sich die Erde infolge des anthropogenen CO2 mit einer alarmierenden Rate erwärmt, weil über 90% der Klimatologen das glauben. Nun ist Wissenschaft jedoch keine Konsens-Disziplin. Sie lebt von der Hinterfragung jedweder Hypothese, jedweder Theorie und jedweden Modells durch Skeptiker, bis alle rationalen Zweifel ausgeräumt sind. Jedwedes Unterfangen, das sich selbst durch Beschwörungen eines Konsens‘ oder durch die Ruhigstellung von Skeptikern beweisen muss, ist keine Wissenschaft. Warum verunglimpfen einige Befürworter des Klimaalarms Kritiker, indem sie sie mit Holocaust-Leugnern vergleichen? Vermutlich distanzieren sich die meisten Klimatologen von dieser unwissenschaftlichen Taktik, aber viel zu wenige sprechen das laut aus.

[Hervorhebung vom Übersetzer in der Hoffnung, dass er damit nicht seine Kompetenzen überschritten hat!]

8. Zusammenfassung und Schlussfolgerungen

Die im letzten IPCC-Bericht beschriebenen Vorhersagen werden mit mindestens sechs ernsten Problemen konfrontiert. Die Modelle zeigen nicht das Temperaturplateau seit 1998; sie übernehmen einen Rückkopplungs-Parameter, der auf einer ungerechtfertigten Annahme beruht, nämlich dass die Erwärmung vor 1998 hauptsächlich dem anthropogenen CO2 geschuldet ist; das IPCC ignoriert mögliche Auswirkungen reduzierter Sonnenaktivität während des vergangenen Jahrzehnts; die Temperaturanomalie hat keine physikalische Bedeutung; die Modelle versuchen, die Zukunft eines chaotischen Systems vorherzusagen; und es gibt einen Appell, dem Konsens in der Klimawissenschaft zu folgen.

Die Temperaturen könnten wieder anfangen zu steigen durch die weitere Hinzufügung von CO2 in die Atmosphäre; sie könnten aber auch sinken infolge der gegenwärtigen schwachen Sonnenaktivität. Viele Klimatologen versuchen, diesen Punkten gerecht zu werden, indem sie versuchen, uns ein besseres Verständnis der beteiligten physikalischen Prozesse und der Zuverlässigkeit der Vorhersagen zu vermitteln. Ein herausragendes Thema ist die Lokalisierung des gesamten anthropogenen CO2. Der Tabelle 6.1 im Bericht 2013 zufolge geht die Hälfte davon in die Atmosphäre, ein Viertel in die Ozeane, und das restliche Viertel wird irgendwie als Biomasse an Land gebunden.

Welche Politik sollte also ein vernünftiger Bürger befürworten? Wir riskieren ernste Konsequenzen entweder durch eine massive Klimaänderung oder durch eine ökonomische Rezession infolge der Bemühungen, den CO2-Ausstoß zu verringern. Meine persönliche Ansicht ist, dass wir das Temperaturplateau dazu nutzen sollten, alle relevanten Dinge zu überdenken. Gibt es Umweltauswirkungen, die genauso wichtig oder wichtiger noch als die globale Erwärmung sind? Sind einige Maßnahmen wie die Subventionierung von Biotreibstoffen kontraproduktiv? Sind riesige Windparks, Felder mit Solarzellen oder Spiegeln effektive Investitionen, wenn wir nicht in der Lage sind, Energie zu speichern? Wie zuverlässig ist die Behauptung, dass Extremwetterereignisse wegen der globalen Erwärmung häufiger auftreten? Ist es nicht an der Zeit einzuräumen, dass wir das Klima gar nicht ausreichend verstehen, um zu wissen, wohin es sich entwickelt?

References

DeLand, M. T., & Cebula, R. P. (2012) Solar UV variations during the decline of Cycle 23. J. Atmosph. Solar-Terrestr. Phys., 77, 225.

Essex, C., & McKitrick, R. (2007) Taken by storm: the troubled science, policy and politics of global warming, Key Porter Books. Rev. ed. Toronto, ON, Canada.

Essex, C., McKitrick, R., & Andresen, B. (2007) Does a Global temperature Exist? J. Non-Equilib. Thermodyn. 32, 1.

Haigh. J. D., et al. (2010). An influence of solar spectral variations on radiative forcing of climate. Nature 467, 696.

IPCC (2013), Climate Change 2013: The Physicsal Science Basis. Contribution of Working Group I to the Fifth Assessment Report of the Intergovernmental Panel on Climate Change, http://www.ipcc.ch

Li, L. H., Basu, S., Sofia, S., Robinson, F.J., Demarque, P., & Guenther, D.B. (2003). Global

parameter and helioseismic tests of solar variability models. Astrophys. J., 591, 1284.

Kirkby, J. et al. (2011). Role of sulphuric acid, ammonia and galactic cosmic rays in atmospheric

aerosol nucleation. Nature, 476, 429.

Knight, J., et al. (2009). Bull. Amer. Meteor. Soc., 90 (8), Special Suppl. pp. S22, S23.

Morton, D. C. (2014). An Astronomer’s view of Climate Change. J. Roy. Astron. Soc. Canada, 108, 27. http://arXiv.org/abs/1401.8235.

Svensmark, H., Enghoff, M.B., & Pedersen, J.O.P. (2013). Response of cloud condensation nuclei (> 50 nm) to changes in ion-nucleation. Phys. Lett. A, 377, 2343.

Tapping, K.F. (2013). The 10.7 cm radio flux (F10.7). Space Weather, 11, 394.

Link: http://wattsupwiththat.com/2014/02/17/crises-in-climatology/

Übersetzt von Chris Frey EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Lieber Hrr Paul,

das muss man natuerlich korrekt machen. Die Strahlungsleistung kann man direkt berechnen, oder ueber die beobachtbare Temperaturverteilung T(x,y) . Wenn die Verteilung des Emissionsgrades e(x,y) ueber die Erdoberflaeche bekannt ist. Die thermische Abstrahlungsleistung ist ja schliesslich das Oberflaechenintegral ueber die Sphaere (x,y) mit den Integranden e(x,y)*T(x,y)^4.

#22: NicoBaecker der Unsinn eines arithmetischen Mittels wird besonders deutlich wenn man mit einer Durchschnittstemperatur eine Strahlungsleistung berechnen will,

bisher immer noch die einzige und falsche Begründung für einen angeblichen CO2-Treibhauseffekt.

Lieber Herr Urbahn, #20

warum das lineaer Mittel („arithmetisch“) Mittel nun keine Willkuer, sondern die einzig mathematisch sinnvolle Wahl ist, eine physiklische Groesse zu mitteln, sollte jetzt klar geworden sein.

Lieber Herr Urbahn, #20

„zu der Mittelung der Abweichungen brauchen Sie aber einen Referenzwert, dazu nehmen Sie ohne jede physikalische Begründung das arithmetische Mittel.“

Daß für den Referenzwert, also das Klimamittel eines Ortes, nur das arithmetische Mittel in Frage kommt, ergibt sich in der Tat nicht aus der Physik, sondern aus der Mathematik (Stochastik).

„Auch Ihre gemittelten Abweichungen sind keine Temperaturen bzw. Temperaturdifferenzen, denn die Abweichung von einer Nichttemperatur kann nicht einfach wieder eine Temperatur sein.“

Das ist falsch, die Höhe überm „mittleren Meerespiegel“ ist natürlich auch eine reale Höhenangabe, auch wenn der „mittlere Meerespiegel“ an den meisten Stellen der Meeresoberfläche nicht realisiert wird.

„Die Verwendung des arithmetischen Mittels hat ganz eindeutig den Zweck, und dem haben sie in meinem vorherigen Kommentar auch nicht widersprochen, einen „passenden“ Zahlenwert für den THE zu bekommen.“

Das ist falsch, und ich habe Ihnen nicht deswegen nicht widersprochen, weil ich Ihnen zustimme, solche Schlüsse sind falsch.

Sie behaupten in #15: „Sie brauchen das arthmetische Mittel, um den Menschen einen eingermaßen glaubwürdigen Wert für eine „mittlere Erdtemperatur“ anzugeben. Ausgehend von der (falsch berechneten) Strahlungstemperatur von -18°C kann man dann mit dieser Nichtemperatur den THE begründen.“

Ihre Behauptung stimmt aus mehreren Gründen nicht:

1. kann man den Unterschied zwischen Strahlungstemperatur und bodennaher Temperatur messen.

Dazu muß man keine globalen Mittelwerte „erfinden“.

Ein Satellit empfängt über fast jedem Ort der Erde (ausgenommen möglicherweise mal Polargebiete bei Inversionswetterlagen) weniger Strahlungsenergie aus der senkrechten Säule im Nadir bis zum Boden als der Boden thermisch abstrahlt (man kann dies direkt übern Boden messen). Daher ist die bolometrische Strahlungstemperatur an der Oberkante dieser Säule im Weltall außerhalb der Atmosphäre geringer als die Bodentemperatur und liegt am Äquator schon fast bei -18 C, am Pol bei -35 °C. Die Strahlungstemperatur ist ja einfach die umgerechnete Strahlungsdichte (240 bzw. 180 W/m2). Bekanntlich misst man am Boden mehr (so um die 425 W/m2 bei 25°C, 160 bei -40°C) Im Mittel kommt da rund 33 K Differenz raus. Wobei eben bis auf die Inversionslagen an fast jeder Ort die Strahlungstemperatur der Säule vom Weltall gemessen niedriger als die Temperatur am Boden der Säule ist. Die Differenz der Strahlungsenergiedichten ist dem Treibhauseffekt geschuldet, was sich aufgrund der Strahlungsphysik in einer vertikalen Temperaturdifferenz ausdrückt.

2. Wenn Sie die Temperaturverteilungen am Boden und die Verteilung der Strahlungstemperatur rund um den Globus messen und mitteln, so hat die Mittelungsmethode kaum quantitativen Einfluß. Wir hatten ja schon mal gezeigt, wie gering die Mittelung über T hoch 4 statt T Einfluß nimmt. Bei der beobachtbaren Temperaturverteilung auf der Erde liegt die a la T hoch 4 gemittelte globale Mitteltemperatur (Mittelwert bei gleicher thermischer Abstrahlung) weniger als 1 Grad höher als die korrekt (also linear/arithmetisch) gemittelte Temperatur (muß ja höher sein wegen Hölderscher Ungleichung). Wenn Sie nun (auch wenn dies mathematisch wie physikalisch unsinnig ist) harmonisch Mitteln, liegt sie weniger als 1 Grad tiefer (ebenfalls wegen Hölderscher Ungleichung). Für die Strahlungstemperatur ist der Effekt noch geringer, da diese ja keinen so großen Äquator-Pol-Unterschied hat wie die Temperatur am Boden.

Die Differenz von um die 33K bekommen Sie nicht wegdiskutiert, das ist einfach so.

PS zu den „unendlich viele Mittelungsverfahren“:

Das arithmetische Mittel einer Menge von Messwerte T1,…,TN ist definiert zu TMA = (T1+…+TN)/N. Das ist bei der globalen Temperatur (oder jeden anderen global verteilten Größe) natürlich so nicht korrekt. Denn da fehlt ja die Flächengewichtung. Ebenso falsch wäre das harmonische Mittel der Form TMH = N/(1/T1 +…1/TN). Das globale Temperaturmittel (oder jeder anderen über die Erdsphäre verteilten physikalischen Größe) berechnet sich wie folgt (hatte ich übrigens oben schon erklärt, haben Sie’s übersehen?):

Mit der Temperatur T ist es wie mit jedem anderem Feld in der Physik, welches man ausmisst und kartiert. Man hat Stützstellen N (hier Stationen) an den Orten (xi, yi) mit dem Messwerten Ti. Nun interpoliert über die gesamte Fläche (hier Erdoberfläche). Für den Mittelwert integriert man die Temperaturverteilung über die Sphäre. Zum Schluß teilt man das Integral durch die Fläche. Da bei der Integration die Temperturwerte linear eingehen, sagt man kurz „arithmetisches“ Mittel, wobei klar ist, dass es nicht nach der obigen Formel (T1+..TN)/N gebildet wird, sondern durch numerische Integration des interpolierten Feldes T(x,y).

Jede andere Mittelungsformel (selbst mit Flächengewichtung) führt jedoch zu einer falschen Integrationsformel. Das können Sie gerne mal anhand der numerischen Integration einer einfachen Funktion durchprobieren. Nur bei Verwendung der Funktionswerte hoch 1 (also „arithmetisch“ oder linear, harmonisch wäre hoch -1, allg. hoch p) konvergiert die numerische Integrationsformal auch zum exakten Integral (Riemannsummen).

#19 Sehr geehrter Herr Bäecker,

zu der Mittelung der Abweichungen brauchen Sie aber einen Referenzwert, dazu nehmen Sie ohne jede physikalische Begründung das arithmetische Mittel. Auch Ihre gemittelten Abweichungen sind keine Temperaturen bzw. Temperaturdifferenzen, denn die Abweichung von einer Nichttemperatur kann nicht einfach wieder eine Temperatur sein. Ich habe das harmonische Mittel nur als Beispiel angeführt. Wie Admin richtig schreibt, gibt es unendlich viele Mittelungsverfahren. Die Verwendung des arithmetischen Mittels hat ganz eindeutig den Zweck, und dem haben sie in meinem vorherigen Kommentar auch nicht widersprochen, einen „passenden“ Zahlenwert für den THE zu bekommen.

MfG

Lieber Herr Urbahn, 15

nun, es wird ja die Temperatur (genauer Temperaturabweichung) gemittelt und nicht deren Kehrwert. Daher das arithmische Mittel und nicht das harmonische. Eine Mittelung der Kehrwerte der topographischen Hoehe fuehrt ja auch zu einer falschen mittleren Hoehe.

@ #15 H. Urbahn

“ Warum sagen Sie als einem auf dem Gebiet der Klimawissenschft tätigen Wissenschaftler …“

Herr Urbahn,

Der Mann ist in dem Metier nicht tätig, denn sonst wüßte er mehr über die GCM und deren Mängel.

Das ist ein typischer Satz eines „Treibhäuslers“:

„Es gibt keine Kontroverse in der Grundlagenphysik darüber, dass die Zuführung von CO2 in die Atmosphäre Sonnenenergie absorbiert, was zu einer geringen Erwärmung zusätzlich zu dem dominanten Faktor des Wasserdampfes führt.“

Es ist dieses wissenschaftlich völlig einseitige Bild:

– Es gibt nur die Sonne (Erwärmung). Das Weltall (Abkühlung) existiert nicht.

– Es gibt nur (erwärmende) Absorption. (Kühlende) Emission gibt es nicht.

Schlichter wissenschaftlicher Betrug!

Und selbst Weltall und Emission mal weg lassend, zeigt dieser Satz auch noch den totalen Unsinn zusätzlicher Absorption, die stattfinden soll, aber eben deshalb nicht stattfindet:

„Die spektrale CO2-Absorption ist gesättigt und damit proportional dem Logarithmus der Konzentration.“

Wie wird man heute Wissenschaftler?

Indem man kritiklos nachplappert, was andere vorgeplappert haben.

Sehr geehrter Herr Bäecker,

Sie schreiben: Man verwendet das arithmetische Mittel nur der Einfachheit halber (also ohne jede physkalische begründung). Da die Berechnung anderer Mittelwerte z.B. das harmonische Mittel kaum schwieriger ist (Computernutzung vorausgesetzt), ist dies nicht glaubwürdig. Sie brauchen das arthmetische Mittel, um den Menschen einen eingermaßen glaubwürdigen Wert für eine „mittlere Erdtemperatur“ anzugeben. Ausgehend von der (falsch berechneten) Strahlungstemperatur von -18°C kann man dann mit dieser Nichtemperatur den THE begründen. Warum sagen Sie als einem in der Klimaforschung tätigen Wissenschaftler (zumindest schließe ich das aus Ihren Postings hier) den Menschen nicht: Leute dieser Zahlenwert, den wir aus dem arithmetischen Mittel errechnet haben, ist aus physikalischen Gründen gar keine Temperatur, sondern nur eine Rechengröße, die wir für irgendwelche Zwecke brauchen. Bemerkenswert ist ja dann noch, daß, wenn diese Rechengröße um mehr als 2 Einheiten größer wird, dies den Untergang der Menschheit herauf beschwören soll.

MfG

Sehr geehrter Herr Bäecker:

Sie schreiben: Man verwendet das arithmetische Mittel nur der Einfachheit halber, also ohne jede physikalische Begründung (meine Aussage). Da andere Mittelwertbildungen z. B. das harmonische Mittel kaum schwieriger sind, ist dies einfach unglaubwürdig. Sie brauchen das arthimetische Mittel, um den Leuten zu erzählen, wie Sie von (den falsch berechneten) Strahlungtemperatur der Erde zu einem einiger Maßen glaubwürdigen Wert für die „mittlere Temperatur“ der Erde bzw. wie, Sie selbst zugeben, eine Nichttemperatur kommen, um damit Ihren THE zu begründen. Spannend ist auch warum es ab einer 2 (es streubt sich bei °C zuschreiben) höheren Nichttemperatur die Menschheit in Gefahr ist. Warum sagen Sie als einem auf dem Gebiet der Klimawissenschft tätigen Wissenschaftler (so empfinde ich zumindest Ihre Postings hier)den Menschen nicht, Leute, den Wert den wir als Durchschnittstemperatur für die Erde angeben, ist in Wirklichkeit keine Temperatur. Wir brauchen dies nur als Rechengröße.

MfG

#12: Rainer Olzem sagt:

Glauben Sie, dass die sog. Treibhausgase nur in eine Richtung wirken?

====================================

Nein, Herr Olzen, bezüglich der Duchlässigkeit für Strahlen einer bestimmten Wellenlänge verhalten sie sich natürlich in jede Richtung gleich.

Ein Gas kennt keine „Richtung“. Weder oben noch unten, noch links noch rechts. Wie sollte das auch gehen?

Gruß

Hans Jung

#4: Hans Jung das physikalische Problem Ihrer „Erklärung“ ist der messbare Fakt, dass CO2 in Erdnähe überhaupt nicht strahlt,

allerdings weiter oben in den Weltraum.

Das hängt mit der Alternative Stoßentlastung von absorbierter Strahlungsanregung zusammen

und ist dementsprechend dichteabhängig.

Klaus Metzger hat also recht

ebenso mit seiner Feststellung,

dass auch die fehlende Korrelation eine Kausalität ausschließt.

Treibhaustheoretiker und politische Aktivisten zeichnen sich also dadurch aus,

dass sie sattsam bekannte Fakten ausblenden.

Echten Diskussionsbedarf für die CO2-Rolle gibt es schon lange nicht mehr.

mfG

#4 Hans Jung sagt:

„die Strahlung der heißen Sonne ist kurzwelliger als die vom kälteren Boden abgegebene. Treibhausgase sind für kurzwellige Strahlung durchlässiger als für langwellige. Demzufolge ist die mit Treibhausgasen angereicherte Atmosphäre für die Einstrahlung der Sonne durchlässiger als für Abstrahlung vom Erdboden.“

Herr Jung,

Zwei Fragen: Wissen Sie, dass der IR-Anteil der eingehenden Sonnenstrahlung, also der langwelligen Strahlung, bei rund 50% liegt und der UV-Anteil, also der kurzwelligen, bei 7%?

Glauben Sie, dass die sog. Treibhausgase nur in eine Richtung wirken?

@ #6 Nicobäcker

„Man verwendet das arithmetische Mittel nur der Einfachheit halber.“

Nö, man verwendet Mittelwerte, um etwas zu vertuschen.

Ein Vergleich zwischen GFDL-Modell und gemessener „Realität“ für den Gitterpunkt 41,5 N und 93,8 W ergibt für das Jahresmittel der Jahre 1964 bis 2005 eine Differenz von 0,044109589 °C.

Wenn das kein Beweis für die hervorragende Qualität des GFDL-‚Klimamodells‘ ist, was ist es dann?

Ob NicoBaecker, der ‚allwissende‘ Forist hier, das Rätsel lösen kann?

@ #4 H. Jung

Kennen Sie das GiGo-Prinzip, Herr Jung?

@ #5 NicoBaecker

„Die Detektierbarkeit haengt nur von Signal zu Rausch Verhaeltnis ab, aber nicht von der Ursache des Signals“

Da irrt der große ‚Meister‘ mal wieder im Bereich der Paläometeorologie/-klimatologie.

So wie der reale Rausch (Bioethanol) nicht konstant ist, ist das Rauschen im Meßwald auch nicht konstant.

Und dann noch Teperaturverläufe mit großen Schwankungen mitteln ist dann so die richtige Methode um Kausalitäten zu bestimmen. Vor allen Dingen sind da ja Trends so besonders eindrucksvoll. Kennt man das nicht von Börsenkursen her?: The Trend is your Friend?

Lieber Herr Urbahn, 7

nun, Herr ML hat anscheinent noch die Vorstellung, dass es eine „Modellbildung“ gint. Auch die gibt es nicht, so wenig, wie das globale Mittel einen messbaren thermodynamischen Zustand im Erdsystem beschreibt. Man verwendet das arithmetische Mittel nur der Einfachheit halber. So wie man auch die mittlere Topoprahie etc. arthimetisch ueber die Erde bildet. Das globale Mittel ist natuerlich nicht notwendig fuer Klimamodellierung. Die benutzt den nicht.

Liebe admin,

es müßte aber in jedem Fall ein physikalische Begründung gegeben werden, warum man sich als Mittelunsverfahren das arithmetische heraussucht und nicht irgendein anderes. Aus den Daten selbst folgt das Mittelungsverfahren jedenfalls nicht.

MfG

„einem Plateau bis 1977“

Wenn es denn ein Plateau war!

Anfang der 80er Jahre war offenbar allgemein bekannt (auch einem Herrn Hansen!), dass in den 40er Jahren die globale Temperatur um ~0,2°C höher gelegen war:

http://tinyurl.com/ofb4cph

bzw. (Fig. 3 auf S. 5)

http://tinyurl.com/od36bvk

Später hat die NASA den Temperaturverlauf „korrigiert“:

http://tinyurl.com/pomue7z

Hier kann man weitere interessante Fakten zu den Temperaturanpassungen lesen:

http://tinyurl.com/ne7euz2

In diesem Zusammenhang erscheint diese Mail von Tom Wigley an Phil Jones interessant:

http://tinyurl.com/ptub5pf

„It would be good to remove at least part of the 1940s blip, but we are still left with „why the blip““

Kann mir das jemand erklären?

Kommentar in 3

Lieber Herr ML,

„Da haben Sie völlig recht. Es ist nur eine statistisch ermittelte Zahl, aber keine Temperatur. Man kann aber aus ihrem Verlauf über der Zeit schon einige Rückschlüsse ziehen. Weniger auf die absoluten Veränderungen im 1/10 K Bereich, das verhindern die unvermeidbaren systematischen Fehler, aber auf periodische Änderungen, die von den Kräften, die auf die Lufttemperatur einwirken, erzeugt werden. Und das sind die Variationen der Sonne und ihre angekoppelten Systeme z.B. der Meere. AMO, PDO usw.“

Halten wir also mal fest, wenn es nach Ihnen ginge, so waere

1 die globale Mitteltemperatur keine Temperatur.

Nun, das stimmt trivialerweise und ist jedem Wissenschaftler und jedem, der darueber berichtet, natuerlich auch klar.

2 bewegt sich der Fehler im globalen Mittel im Bereich einiger Zehntel Grad.

Die Fehler im relativen Mittel betragen fuer den Jahreswert ein paar Zehntel Grad, die damit bestimmten Trends ueber einige Jahrzehnte sind natuerlich genauer, das folgt aus der Mathematik.

3 natuerliche Klimaschwankungen sollen aus diesem Rauschen heraus sichtbar sein. Wieso nur die? Die Detektierbarkeit haengt nur von Signal zu Rausch Verhaeltnis ab, aber nicht von der Ursache des Signals. Das scheint Ihnen nicht klar zu sein…

#1: Klaus Metzger sagt:

Vielleicht kann mir mal jemand kurz erklären, wie mehr CO2 in der Atmosphäre die Erde überhaupt aufheizen kann. Die absorbierende Wirkung muss doch bei der Einstrahlung und bei der Abstrahlung gleich sein.

=========================

herr Metzger,

die Strahlung der heißen Sonne ist kurzwelliger als die vom kälteren Boden abgegebene.

Treibhausgase sind für kurzwellige Strahlung durchlässiger als für langwellige.

Demzufolge ist die mit Treibhausgasen angereicherte Atmosphäre für die Einstrahlung der Sonne durchlässiger als für Abstrahlung vom Erdboden.

Gruß

Hans Jung

Ich frage mich, wenn man die Arbeiten von Andersen, Essex und McKitrick gelesen hat, noch ernsthaft von einer „Mitteltemperatur“ für die gesamte Erde sprechen kann und dann noch frech und dreist als Mittelungsverfahren das arthmetische Mitell wählt.

MfG

Danke an Herrn Frey für die Mühe der wieder sehr guten Übersetzung.

„Wie zuverlässig ist die Behauptung, dass Extremwetterereignisse wegen der globalen Erwärmung häufiger auftreten?“

Wer Unternehmensnachrichten liest, durfte gestern auch von der Swiss Re lesen, dass die Gewinne auch im letzten Jahr weiter gestiegen sind, aufgrund von weniger Naturkatastrophen. Die Munich Re war schon vorher mit ihren gleichlautenden Meldungen in der Öffentlichkeit.

Korrelation bedeutet noch keine Kausalität, aber keine Korrelation schließt Kausalität aus. Vielleicht kann mir mal jemand kurz erklären, wie mehr CO2 in der Atmosphäre die Erde überhaupt aufheizen kann. Die absorbierende Wirkung muss doch bei der Einstrahlung und bei der Abstrahlung gleich sein. Dazu ein Gedankenexperiment. Stellen wir uns zwei Treibhäuser vor, A mit Einfachverglasung und B mit Dreifachverglasung. Was passiert? B wird im Vergleich zu A durch die bessere Isolierung am Tag kühler und in der Nacht wärmer sein. Der Temperaturverlauf ist also geglättet, aber die Durchschnittstemperatur ist gleich. So müsste sich auch die Erde mit höherer CO2 Konzentration in der Atmosphäre verhalten.