Die erste Studie von John Kennedy vom UK Met Office enthält eine kompakte und dringend nötige Ungenauigkeits-Analyse der Messungen und Analysen von Wassertemperaturen SST:

Eine Übersicht über in-situ-Messungen und Datensätze der Wassertemperatur

John Kennedy

Abstract: Archive mit In-Situ-Messungen der Wassertemperatur (SST) reichen über 160 Jahre zurück. Die Qualität der Messungen ist variabel und die Fläche der vermessenen Ozeane begrenzt, vor allem zu Beginn der Reihe und während der beiden Weltkriege.

SST-Messungen und darauf basierende gerasterte Datensätze werden in vielen Untersuchungen verwendet, so dass das Verständnis für und die Abschätzung der Unsicherheiten vital ist. Ziel dieser Übersicht ist es, die verschiedenen Komponenten aufzuzeigen, die zu der Gesamt-Unsicherheit der SST-Messungen beitragen sowie der daraus abgeleiteten Datensätze. Dabei bezweckt sie auch, gegenwärtige Lücken des Verständnisses zu identifizieren. Unsicherheiten entstehen auf der Ebene individueller Messungen sowohl durch systematische als auch durch Zufallseffekte. Obwohl diese eingehend untersucht worden sind, schreitet die Verbesserung der Fehlermodelle voran. Jüngste Verbesserungen gab es hinsichtlich des Verständnisses allgegenwärtiger systematischer Fehler, die die Abschätzung langzeitlicher Trends und der Variabilität betreffen. Allerdings sind die Adjustierungen zur Minimierung dieser systematischen Fehler unsicher, und diese Unsicherheiten sind vor den siebziger Jahren größer und vor allem in den Zeiträumen um den Zweiten Weltkrieg, und zwar infolge des Fehlens zuverlässiger Metadaten. Die Unsicherheiten in Zusammenhang mit der Auswahl der statistischen Methoden, mit denen man global vollständige SST-Datensätze erzeugen möchte, wurden mit Hilfe unterschiedlicher Analysemethoden erkundet, aber sie enthalten nicht die jüngsten Einsichten von Messfehlern, und sie verlangen nach einem ordentlichen Eckpfeiler zum Vergleich, mit dem ihre Eignung objektiv bestimmt werden kann. Diesen Problemen kann man begegnen durch die Erzeugung neuer SST-Analysen [new end-to-end SST analyses] und durch die Gewinnung und Digitalisierung von Daten und Metadaten aus Schiffslogbüchern und anderer zeitnaher Unterlagen.

Veröffentlicht in Reviews of Geophysics, Link zum Abstract und zum ganzen Manuskript.

Auszüge:

Bei der Verwendung der SST-Beobachtungen und der darauf basierenden Analysen ist es wichtig, die darin enthaltenen Unsicherheiten sowie die Hypothesen und statistischen Methoden zu verstehen, die zur Erzeugung beigetragen haben. Mit dieser Übersicht beabsichtige ich, die verschiedenen Komponenten aufzuzeigen, die zu der Gesamtunsicherheit der SST-Messungen und der daraus abgeleiteten Datensätze beitragen. Auch Wissenslücken möchte ich damit schließen.

Abschnitt 2 beschreibt eine Klassifizierung der Unsicherheiten. Die Einteilungen nach Klassen sind nicht definitiv und auch nicht ganz eindeutig. Allerdings spiegeln sie die Art und Weise, mit der man sich dieser Unsicherheiten in der Literatur angenommen hat. Und sie bieten einen nützlichen Rahmen, an Unsicherheiten in den SST-Datensätzen zu denken. …

Während dieser gesamten Studie wird unterschieden zwischen einem Fehler und einer Unsicherheit. Der Fehler in einer Messung ist der Unterschied zwischen einem idealisierten „wahren Wert“ und dem gemessenen Wert. Er ist nicht bestimmbar. Die Unsicherheit einer Messung ist definiert als der „Parameter zusammen mit dem Ergebnis der Messung, der die Verteilung der Werte charakterisiert, die man vernünftigerweise der Messgröße zuordnen kann“. In diesem Sinne ist Unsicherheit in der folgenden Diskussion gemeint. Das ist nicht notwendigerweise so wie in den zitierten Studien. Allgemein wird das Wort Fehler als Synonym für Unsicherheit gesehen, wie es in den üblichen Phrasen Standardfehler und Analysefehler zum Ausdruck kommt.

Grob gesagt wurden Fehler in individuellen SST-Beobachtungen aufgeteilt in zwei Gruppen: beobachtete zufällige Fehler [random observational errors] und systematische Fehler. Obwohl dies ein bequemer Weg ist, mit den Unsicherheiten umzugehen, werden sich allgemein Fehler in den SST-Messungen ein wenig durch gleiche Charakteristiken auszeichnen.

Zufällige Fehler treten aus vielen Gründen auf: falsche Ablesung des Thermometers, Rundungsfehler, die Schwierigkeit, ein Thermometer mit größerer Präzision als der vorgegebenen Skaleneinteilung zu lesen, falsch aufgezeichnete Werte, Fehler bei der Digitalisierung und Rauschen des Messfühlers. Obwohl all diese Fehler eine Einzelmessung beeinträchtigen, tendieren sie dazu, sich gegenseitig aufzuheben, wenn große Datenmengen miteinander verglichen werden. Daher ist der Beitrag von beobachteten Randwert-Fehlern zu den Unsicherheiten der globalen mittleren SST viel kleiner als der Beitrag eines Randwertfehlers zur Unsicherheit einer Einzelbeobachtung, selbst in Jahren mit geringster Anzahl von Messungen. Dennoch können, wenn nur wenige Beobachtungen vorliegen, beobachtete Randwert-Fehler einen wichtigen Beitrag zur Gesamtunsicherheit leisten.

Systematische Fehler sind viel problematischer, weil deren Auswirkungen relativ ausgeprägter sind, wenn größere Datenmengen zusammengeführt werden. Systematische Fehler können auftreten, weil ein bestimmtes Thermometer falsch kalibriert ist oder an einer ungeeigneten Stelle steht. Egal wie viele Daten man mittelt von einem Thermometer, das wegen falscher Kalibrierung stets 1 K zu viel anzeigt, wird den Fehler nicht unter dieses Niveau reduzieren, es sei denn durch Zufall. Allerdings wird der systematische Fehler in vielen Fällen von der Umgebung des Thermometers im Einzelnen abhängen und daher von Schiff zu Schiff verschieden sein. In diesem Falle wird die Mittelbildung von Messungen vieler verschiedener Schiffe oder Bojen dazu tendieren, den Beitrag systematischer Fehler zur Unsicherheit des Mittels zu reduzieren.

Kennedy et al. (2011b) haben zwei Formen der Unsicherheit betrachtet: die grid-box sampling-Unsicherheit und large scale sampling-Unsicherheit.* Grid-box sampling-Unsicherheit bezieht sich auf die Unsicherheit der Schätzung der mittleren Wassertemperatur in einem Gebiet innerhalb einer Gitterbox mit einer endlichen und oftmals kleinen Anzahl von Messungen. Large scale Sampling-Unsicherheit bezieht sich auf die Unsicherheit, die aus der Abschätzung der Wassertemperatur eines größeren Gebietes resultieren mit vielen Gitterboxen ohne eine Messung. Obwohl diese beiden Arten von Unsicherheit eng zusammenhängen, ist es oft einfacher, die Grid-box sampling-Unsicherheit abzuschätzen, wo man es nur mit der Variabilität innerhalb einer Gitterbox zu tun hat. Bei der großräumigen Sampling-Unsicherheit muss man das große Spektrum der Variabilität im globalen Maßstab berücksichtigen.

Im Zusammenhang mit der Unsicherheit der Wassertemperatur-[Daten] sind unbekannte Unbekannte die Dinge, die man leicht übersieht. Ihrem Wesen nach sind unbekannte Unbekannte nicht quantifizierbar; sie repräsentieren die tieferen Unsicherheiten, die allen wissenschaftlichen Unternehmungen anhaften. Mit dieser Übersicht hoffe ich zeigen zu können, dass die Bandbreite für Revolutionen in unserem Verständnis begrenzt ist. Nichtsdestotrotz kann eine Verbesserung durch eine kontinuierliche Entwicklung unseres Verständnisses nur erfolgen, wenn wir akzeptieren, dass unser Verständnis unvollständig ist. Unbekannte Unbekannte werden nur mit kontinuierlichen, sorgfältigen und manchmal erfinderischen Untersuchungen der Daten und Metadaten ans Tageslicht kommen.

Kommentar von Judith Curry: Das Uncertain T. Monster [das ist hier als „Name“ zu verstehen] ist SEHR erfreut über diese umfassende Diskussion der Unsicherheiten. Die größten Herausforderungen (in der Studie ausführlich beschrieben) sind die Annahme struktureller Unsicherheiten der Analysemethoden und die Kombination aller Unsicherheiten. Jedwede Applikation dieser Daten (einschließlich der Trendanalyse) erfordert die Berücksichtigung dieser Dinge.

In der zweiten Studie wird versucht, das Unsicherheits-Monster zu schlachten.

Coverage bias in the HadCRUT4 temperature series and its impact on recent temperature trends

[etwa: Betrachtung des Bias’ in den Temperaturreihen von HadCRUT4 und dessen Auswirkungen auf jüngste Temperaturtrends]

Kevin Cowtan und Robert Way

Abstract: Eine unvollständige globale Abdeckung ist eine potentielle Bias-Quelle bei globalen Temperatur-Rekonstruktionen, falls die nicht mit Daten erfassten Gebiete nicht gleichmäßig auf der Planetenoberfläche verteilt sind. Der meistverwendete HadCRUT4-Datensatz erfasst im Mittel 84% des Globus‘ während der letzten Jahrzehnte, wobei sich die datenfreien Gebiete um die Pole und in Afrika konzentrieren. Drei bestehende Rekonstruktionen mit einer fast globalen Überdeckung werden untersucht, wobei jede zeigt, dass HadCRUT4 anfällig für Bias ist infolge der Behandlung datenfreier Gebiete. Zwei alternative Vorgehensweisen, die globale Temperatur zu rekonstruieren, werden untersucht. Eine davon basiert auf einem optimalen Interpolations-Algorithmus und die andere auf einer Hybrid-Methode [?] mit zusätzlichen Informationen aus Satellitendaten. Die Methoden werden validiert auf Basis ihrer Eignung, fehlende Daten zu rekonstruieren. Beide Methoden führen zu besseren Ergebnissen als wenn man die datenfreien Regionen ausschließt, wobei vor allem die Hybrid-Methode gut geeignet ist für diese datenfreien Gebiete. Temperaturtrends der Hybrid-Methode und der Rohdaten von HadCRUT4 werden verglichen. Der weithin genannte Trend seit 1997 ist nach der Hybrid-Methode zweieinhalb mal größer als der korrespondierende Trend in den HadCRUT4-Daten. Der Bias verursacht einen kühlenden Bias der Temperaturen der letzten Zeit verglichen mit Ende der neunziger Jahre. Trends, die in den Jahren 1997 oder 1998 beginnen, sind hinsichtlich des globalen Trends besonders verzerrt. Das wird verschärft durch das starke El Nino-Ereignis von 1997/1998, der auch dazu tendiert, Trends zu unterdrücken, die in jenen Jahren begannen.

Veröffentlicht von der Royal Meteorological Society, link zum abstract.

Es gibt eine Website mit Daten und Metadaten und auch ein erklärendes youtube video.

Im Guardian findet sich ein ausführlicher Artikel. Auszüge daraus:

Es gibt große Gebiete mit Lücken in der Datenerfassung, hauptsächlich in der Arktis, der Antarktis und Afrika, wo es nur ganz vereinzelt Stationen gibt, an denen die Temperatur gemessen wird.

Die Temperaturaufzeichnungen von NASA’s GISTEMP versuchen, diese Meldelücke zu schließen, indem Temperaturmessungen in der Umgebung auf diese Gebiete extrapoliert werden. Allerdings fehlen den NASA-Daten Korrekturen von der Art, wie Wassertemperaturen gemessen werden – ein Problem, das bislang nur vom Met. Office angegangen worden ist.

In ihrer Studie wenden Cowtan & Way das Kriging-Verfahren an, um die Lücken in den Messungen zu füllen, allerdings tun sie das sowohl für das Festland als auch für die Ozeane. In einem zweiten Anlauf nutzen sie auch die nahezu globale Erfassung von Satellitendaten, indem sie die Satelliten-Temperaturmessungen der University of Huntsville in Alabama (UAH) mit den verfügbaren Oberflächendaten kombinieren, um die Lücken mit einem ‚Hybrid‘-Datensatz zu füllen. Sie fanden heraus, dass das Kriging-Verfahren die besten Ergebnisse liefert, um Temperaturen über den Ozeanen zu bestimmen, während die Hybrid-Methode am Besten auf dem Festland und vor allem auch über Meereis funktioniert, das große Teile der datenfreien Gebiete ausmacht.

Cowtan & Way untersuchen die Behauptung eines ‚Stillstands‘ der globalen Erwärmung der letzten 16 Jahre, indem sie die Trends von 1997 bis 2012 betrachten. Während aus den HadCRUT4-Daten während dieser Zeit lediglich ein Trend von 0,046°C pro Jahrzehnt hervorgeht – die NASA nennt 0,08°C pro Dekade – schätzen das neue Kriging-Verfahren und die Hybrid-Datensätze einen Trend von jeweils 0,11°C bzw. 0,12°C pro Jahrzehnt.

Diese Ergebnisse zeigen, dass die Verlangsamung der Erwärmung der globalen mittleren Temperatur nicht so signifikant ist wie ursprünglich gedacht. Die Erwärmung hat sich verlangsamt, zum größten Teil deswegen, weil mehr der Erwärmung während des letzten Jahrzehnts in die Ozeane transferiert worden ist (hier). Allerdings erfolgt diese Art der vorübergehenden Verlangsamung der Erwärmung (und Beschleunigungen) auf regelmäßiger Basis infolge kurzfristiger natürlicher Einflüsse.

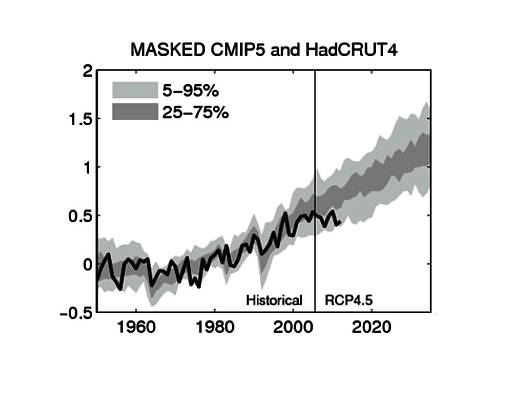

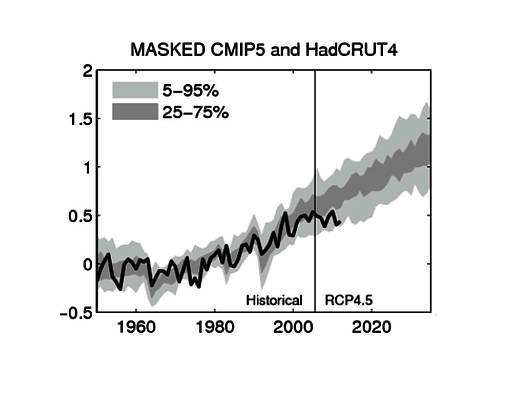

Die Ergebnisse dieser Studie haben auch Auswirkungen auf die jüngste Forschung. Zum Beispiel ergibt die Korrektur des jüngsten Kalt-Bias‘, dass die globale Temperatur nicht so weit vom Mittel der Modellprojektionen entfernt liegt als ursprünglich gedacht. Sie liegen mit Sicherheit noch innerhalb der Bandbreite der individuellen Temperatursimulationen der Klimamodelle (hier). Jüngste Studien, die ursprünglich zu dem Ergebnis gelangt waren, dass das globale Klima etwas weniger sensitiv auf zunehmende Treibhausgase reagiert als vorher gedacht, könnten ebenfalls die tatsächliche Klimasensitivität unterschätzt haben.

Das ist natürlich nur eine einzige Studie, beeilt sich Dr. Cowtan anzumerken.

„Kein schwieriges wissenschaftliches Problem wird jemals in einer einzigen Studie gelöst. Ich erwarte nicht, dass unsere Studie das letzte Wort hierzu ist, aber ich hoffe, dass wir die Diskussion vorangebracht haben“.

Beispiele für Tweets hierzu:

Dana Nuccitelli: Diese neue Studie killt den Mythos des Stillstands der globalen Erwärmung.

John Kennedy: Die Ironie ist, dass die zum Zerschlagen der HadCRUT4-Daten verwendete Studie annimmt, dass HadCRUT4 dort korrekt ist, wo es Daten gibt.

Die Studie erregt viel Aufmerksamkeit in den Medien, und auch ich selbst bekomme Fragen von Reportern.

Beurteilung von Judith Curry

Schauen wir zuerst auf die drei Methoden, die sie anwenden, um Datenlücken zu füllen, vor allem in Afrika sowie in der Arktis und der Antarktis.

1. Kriging

2. UAH-Satellitenanalysen der Lufttemperatur

3. Reanalysen von NCAR NCEP

Der größte Unterschied in ihrem rekonstruierten globalen Mittel kommt aus der Arktis, so dass ich mich darauf konzentriere (wobei ich gerade diesbezüglich einige Erfahrung habe).

Erstens, Kriging. Das Kriging-Verfahren über Eis auf Land und Wasser macht physikalisch keinen Sinn. Während in der Studie Rigor et al. (2000) genannt werden, die ‚eine gewisse‘ Korrelation im Winter zwischen Festland und Meereis bis zu einer Höhe von 1000 km gefunden haben, würde ich in anderen Jahreszeiten keine Korrelation erwarten.

Zweitens, UAH-Satellitenanalysen. Sie sind unbrauchbar in höheren Breiten bei Temperaturinversionen, und sie sind unbrauchbar über Meereis, das räumlich eine sehr komplexe Verteilung der Abstrahlung im Mikrowellenbereich aufweist). Hoffentlich wird sich John Christy dieses Problems annehmen.

Drittens, Reanalysen in der Arktis. Man betrachte Abbildung 1 in dieser Studie, die einem das Gefühl für die Größenordnung der Gitterpunktfehler an einem Punkt während eines jährlichen Zyklus‘ gibt. Zwar sind sie in gewisser Weise brauchbar, aber Reanalysen sind unbrauchbar, um Trends aufzuzeigen, die temporären Inhomogenitäten in den Datensätzen geschuldet sind.

Also denke ich, dass die Analyse von Cowtan und Way nichts zusätzlich zu unserem Verständnis des globalen Temperaturfeldes und des ‚Stillstands‘ hinzufügt.

Unter dem Strich bleibt die Graphik von Ed Hawkins, in der Klimamodell-Simulationen in Gebieten verglichen werden, in denen Beobachtungen existieren. Das ist der geeignete Weg, um Klimamodelle mit Beobachtungen und Messungen zu vergleichen, und es bleibt die Tatsache, dass Klimamodelle und Beobachtungen stark voneinander abweichen.

Gibt es irgendetwas Nützliches von Cowtan und Way? Nun, sie machen deutlich, dass wir versuchen sollten, auf irgendeine Weise Temperatur-Variationen über dem Arktischen Ozean zu erfassen. Daran wird gegenwärtig geforscht.

Link: http://judithcurry.com/2013/11/13/uncertainty-in-sst-measurements-and-data-sets/

Übersetzt von Chris Frey EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Ich greife einmal die folgende Aussage aus dem obigen Bericht auf:

>Diese Ergebnisse zeigen, dass die Verlangsamung der Erwärmung der globalen mittleren Temperatur nicht so signifikant ist wie ursprünglich gedacht. Die Erwärmung hat sich verlangsamt, zum größten Teil deswegen, weil mehr der Erwärmung während des letzten Jahrzehnts in die Ozeane transferiert worden ist (hier). Allerdings erfolgt diese Art der vorübergehenden Verlangsamung der Erwärmung (und Beschleunigungen) auf regelmäßiger Basis infolge kurzfristiger natürlicher Einflüsse.< Jeglicher Wärme-Eintrag in die Meere führt zu einer Längenausdehnung der Wassersäule, die nur nach oben ausweichen kann, also zu einer Meeresspiegel-Erhöhung. Diese kann seit 1992 recht genau von Satelliten gemessen werden und zeigt , dass die Zunahme (Steigung der Kurve) seit etwa 2000 abgenommen hat. Gegenüber Temperaturmessungen - auch in der Atmosphäre - ist die Messung der Veränderung der Meeresspiegelhöhen die genaueste und verläßlichste. Das Phänomen habe ich an Hand der offiziell herausgegeben Messdaten der Lufttemperaturen in Deutschland vom Deutschen Wetterdienst seit 1880 und der Meeresspiegel-Höhen in der Deutschen Bucht vom Deutschen Hydrographischen Institut seit 1840 untersucht und in meinem Bericht "Gibt es eine anthropogen verursachte Klimaerwärmung? (Notiz Nr. 11.2, Status April 2013)dargestellt. Gerd Zelck

Hallo F.Ketterer,

vielen Dank für den Link, sobald es meine Zeit zulässt werde ich ihren Ratschlag befolgen und dort einmal nachlesen.

Aber wie sie schon schrieben „dass für die Schweizer Stationen die Höhenlage im Winter eine Rolle spielt“ passt dies zum von mir verlinkten Artikel, dass die Winter kälter werden.

Zu #12: Uwe Klasen sagt: am Sonntag, 24.11.2013, 16:27

. . .

Offensichtlich findet dort „oben“ keine Klimaerwärmung statt.

#######################################

Hallo Herr Klasen,

Danke für den interessanten Aspket; hat mich zu googeln angeregt:

Das gesagte gilt nur für die Wintertemperaturen. Ich habe bei Meteoswiss eine interessante Darstellung gesehen:

http://tinyurl.com/MetSwissTrends

Stellen Sie bitte dieZeitauflösung auf „Saisonal“ und die Darstellung auf Nord-Süd schnitt.

Dann sehen Sie, dass für die Schweizer Stationen die Höhenlage im Winter eine Rolle spielt. Im Sommer sind die Trends über alle Höhen hinweg im Bereich der Erwärmung.

Hallo F.Ketterer,

selbst die Tatsache, dass die Messstationen um 1950m über N.N liegen dürfte doch im Zuge einer Klimaerwärmung nicht Relevant sein. Auch dort müssten dann steigende Temperaturen gemessen werden. Da dem nicht so ist sollte diesem „Phänomen“ mehr Beachtung geschenkt werden.

Offensichtlich findet dort „oben“ keine Klimaerwärmung statt.

#9: Uwe Klasen sagt:

am Samstag, 23.11.2013, 06:52

Hallo F.F.Ketterer,

vielen Dank für den Link. Wie wir sehen können widersprechen sich die beiden Aussagen, das ist Forschung, das muss nun geklärt werden. Vielleicht beschreibt der Metereologe bei Wetter.net aber auch nur ein „lokales“ Phänomen.

##########

Mir fiel auf, dass alle von Wetter.net Stationen über 1950m lagen.

MfG

Ketterer

Lieber Herr Klasen,

nee, ist bereits geklaert. Muss man nur genau nachvollziehen.

Hallo F.F.Ketterer,

vielen Dank für den Link. Wie wir sehen können widersprechen sich die beiden Aussagen, das ist Forschung, das muss nun geklärt werden. Vielleicht beschreibt der Metereologe bei Wetter.net aber auch nur ein „lokales“ Phänomen.

Sehr geehrter Herr Frey,

zur Begrifflichkeit der Messunsicherheit folgende Anmerkungen „random“ bedeutet in diesem Zusammenhang „zufällig“, also „zufällige Messabweichung“. Der Begriff „Messfehler“ ist in diesem Zusammenhang historisch.

mfg

K. Reuter

#4: Uwe Klasen sagt:

am Donnerstag, 21.11.2013, 14:41

….

FAZIT

Von immer milder werdenden Wintern sind wir in den Alpen ganz offensichtlich weit entfernt. Der Trend geht genau in die entgegengesetzte Richtung! Klimatologen hatten vor einigen Jahren den Wintersportorten der Alpen dazu geraten ihre Investitionen in Sachen Wintersport zurückzufahren- das würde sich aufgrund der steigenden Durchschnittstemperaturen bald nicht mehr lohnen.

Da fragt man sich: Welche steigenden Temperaturen meinten die Damen und Herren bloß?“

Quelle: http://tinyurl.com/ad3p5

########################

Wahrscheinlich diese hier. Und nebenbei: die ZAMG ist nicht bei den Klimahysterikern beheimatet.

http://tinyurl.com/ZAMG-TLWiSo-Alpen

Das sind nicht einzelne Stationen der Alpen sondern Daten auch aus dem HISTALP Projekt.

Der von mir verlinkte Bericht unter Kommentar #4 ist nun unter folgendem Link erreichbar:

Quelle: http://tinyurl.com/pdbc8la

@Uwe Klasen #4

Keine Angst, Hr. Klasen, die Natur-Physik ist auf unserer Seite. Die menschengemachten CO2-Erwärmungs-Propheten werden durch die Natur-Physik, in den kommenden Jahren, noch ihren Kalten-Albtraum erleben. Hab gehört, dass es nächste Woche, noch etwas kälter werden soll.

Etwas OT, aber meiner Meinung nach durchaus hierzu passend:

„Studie: Die Alpen trotzen der Klimaerwärmung!

Wiesbaden/Kitzbühel, den 21. November 2013 – Subjektiv kam es den Einwohnern des österreichischen Wintersportorts Kitzbühel in den letzten Jahren so vor, als wären die Winter kälter geworden. Um sich ein objektives Bild über die Lage zu machen, zog man los und bestellte sich bei der Zentralanstalt für Meteorologie und Geodynamik (ZAMG), dem staatlichen Wetterdienst Österreichs, die entsprechenden Wetterdaten der letzten 20 Jahre. Bei der Bewertung der Daten und Ergebnisse wurde ich von MMag. Günther Aigner, Marketer bei Kitzbühel Tourismus, um fachliche Unterstützung gebeten.

Die Auswertung hat Erstaunliches ergeben:

Nach einer fachlichen Prüfung meinerseits bin ich sehr überrascht. Die Winter sind dort in den letzten 20 Jahren tatsächlich nachweislich kälter geworden und das teilweise ganz massiv. Die letzten beiden Winter waren in Kitzbühel sogar die kältesten der vergangenen 20 Jahre.

Um weitere Untersuchungen anzustellen wurden von weiteren vier alpinen Bergstationen Wetterdaten angefordert und ausgewertet:

Zugspitze (Deutschland)

Sonnblick (Österreich)

Schmittenhöhe (Österreich)

Säntis (Schweiz)

Sie alle kamen zum selben erstaunlichen Ergebnis:

Die Winter in den Alpen sind in den letzten Jahrzehnten nach diesen Daten eindeutig kälter geworden. Wir haben dazu extra lange Zeitreihen von 20 bis 30 Jahren untersucht, genau so wie es die Klimatologen immer fordern.

Man befragte sogar die meteorologischen Fachkreise vor Ort nach ihren Meinungen zu den Ergebnissen. Allerdings hatte man dabei wenig Erfolg. Teilweise war man über diese Ergebnisse selbst erstaunt, teilweise wurde versucht die Ergebnisse zu relativieren.

Da stellt man sich schon die Frage: Kennt man diese Ergebnisse und will sie nur nicht hören, weil sie nicht ins aktuelle Weltbild des Klimawandels bzw. der Klimaerwärmung passen? Immerhin predigten uns die Klimaexperten schon vor 20 Jahren, dass es zukünftig keine Winter mehr mit Eis und Schnee in Mitteleuropa geben werde. Zudem würde Wintersport in den nächsten Jahrzehnten nur noch in den höchsten Lagen der Alpen möglich sein, da die Temperaturen immer weiter steigen würden. Doch nichts von alledem ist bisher der Fall wie diese Beobachtungsdaten aus den amtlichen Messnetzen des Deutschen Wetterdienstes (Zugspitze), der ZAMG (Kitzbühel, Sonnblick und Schmittenhöhe) und der MeteoSwiss (Säntis) eindrucksvoll belegen.

Mir kommt es so vor, als sei das Thema Klimawandel bzw. Klimaerwärmung mittlerweile zu einer Art Religion geworden. Wer dieser angehört, duldet keine anderen Erkenntnissen, wenn diese auch auf noch so eindeutigen Fakten wie jenen Messwerten beruhen. Es ist grenzt fast schon an ein Skandal, dass die zuständigen Fachkreise vor Ort, diese Erkenntnisse einfach zu ignorieren scheinen.

FAZIT

Von immer milder werdenden Wintern sind wir in den Alpen ganz offensichtlich weit entfernt. Der Trend geht genau in die entgegengesetzte Richtung! Klimatologen hatten vor einigen Jahren den Wintersportorten der Alpen dazu geraten ihre Investitionen in Sachen Wintersport zurückzufahren- das würde sich aufgrund der steigenden Durchschnittstemperaturen bald nicht mehr lohnen.

Da fragt man sich: Welche steigenden Temperaturen meinten die Damen und Herren bloß?“

Quelle: http://tinyurl.com/ad3p5

Bezüglich der Fakten zur angeblichen Erwärmung der Meere habe ich selbst ein wenig gesucht und bin bei Bob Tisdale fündig geworden

http://tinyurl.com/seaheat

Hier wird deutlich, dass es in dem Segment von 0 – 700 Meter Meersetiefe im Nordatlantik eine deutliche Abnnahme der Temperaturen gemäß NODC gegeben habe. Also eher das Gegenteil der Behauptung.

Das gilt auch für den Nordpazifik seit den gezeigten 2005, auch wenn die letzeten Werte 2011 – 2013 wieder einen starken Anstieg ausweisen.

Das AGW-Argument bezieht sich auf Stephens et al (2013). Dieser behaptet, dass es einen Überschuss des Enegieeintrages zur Energieabgabe gäbe. Wobei er aber eine sehr großen Konfidenzbereich ausweist: 0,6 +- 17 W/qm

Also ist der behauptete Effekt nicht nachgewiesen. Er könnte existieren, oder das Gegenteil.

Was Bob Tisdale hier aber nicht diskutiert ist die Wirkung, die von AMO und PMO ausgeht. Ich habe es so verstanden, dass wir zur Zeit eine überproportionale Erwärmung der nördlichen Hemisphäre haben, die nun aber wieder langsam abklingt und zu einer Abkühlung führen müsste. Dies geben die Daten zwar so noch nicht her, aber die Verschiebung der Eisbedenkung von der Arktis zur Antarktis scheint dies zu bestätigen.

Zum Thema des Hauptartikels: Ich zweifele, ob man hier überhaupt eine hinreichende Datenbasis haben kann. denn es erfordert Messungen, die in hundertstel Grad über den gesamten Temperaturgradienten präzise sein müssten. Wie dicht ist denn das Mess-Grid, um ggf, auch lokale Unterschiede und verändertes Strömungsverhalten abschätzen zu können.

Im Text wurde verwiesen auf http://tinyurl.com/pfr2zsh

Dabei wird im Guardian auf die Erwärmung der Meere verwiesen, die hier weder hinsichtlich der Messproblematik diskutiert wird, noch inhaltlich funktional besprochen wird.

Die These ist, dass sich die Luft nicht erwärmt hätte, aber die Temperatur ins Meer geflossen sei. Physikalisch hört sich das recht dubios an. Wie soll das gehen?

Wir denken bei Wärmetransport über Wärmestrahlung, Wärmeleitung und Massentransport / Konvektion. Unabhängig vonderPrüfung der Messung mal die Vermutung, dass sich tatsächlich die Verhätlinsse zwischen Luft und Wasser verändert haben könnte.

Denkbare wäre, dass bei geringerer Wolkenbedeckung ein stärkerer direkter Energieeintrag ins Meer sich ereignen könnte, die aber wegen der großen Wärmekapazität des Meeres in nur geringer Oberflächentemperaturänderung sich niederschlägt.

Mit dem CO2 Anteil kann es nichts zu tun haben, eher in negativer Rückkopplung. Denn wenn der Energieeintrag der Sonne durch steigenden CO2 Anteil stärker ausgefiltert wird, geht eben nichts mehr direkt in das Meer. Auch das Argument der Rückstrahlung zieht hier nicht, denn die Atmosphärentemperaturen haben sich nicht signifikant verändert.

Eine Erklärung über die Gründe der vermeintlichen ozeanischen Erwärmung habe ich weder seitens der AGW-Vertreter gelesen, noch eine fundierte Replik seitens der Klimarealisten.

Nun zu den Fakten: Ist es wirklich so, dass der Heat Content der Ozeane so rapide ansteigt, wie von Nuccitelli et al. behauptet?

Wer weiß hierzu mehr oder hat einen guten Link?

Man sollte lieber die Künste der Proxyauswertungen fördern als dieses planlose Herumgemesse.

Carsten

—

http://ruthe.de/cartoons/strip_0482.jpg