Hitzewellen sind die neuen Eisbären und schüren den Alarm über den Klimawandel. Klimawissenschaftler, die dies in den Medien thematisieren, verwenden irreführende und/oder unzureichende Ansätze. Wie sollten wir beurteilen, ob und wie viel die vom Menschen verursachte globale Erwärmung zu den jüngsten Rekordtemperaturen beigetragen hat? Werfen wir einmal einen Blick über den Tellerrand.

In den letzten Wochen wurde viel über die rekordverdächtige Hitzewelle im Nordwesten der USA und in Kanada geschrieben.

Es gab vier Kategorien von wissenschaftlichen Beiträgen zur Beantwortung dieser Frage, die in den Medien, Blogbeiträgen und Publikationen erschienen sind:

I. Heiße Luft: Wissenschaftler schwadronieren in den Medien

Klimawissenschaftler schreiben Meinungsäußerungen und geben auf Twitter an, dass AGW die Hitzewelle verursacht oder zumindest verschlimmert hat. Wissenschaftler in dieser Kategorie sind diejenigen, die über das Thema schwadronieren und Hitzewellen nutzen, um für ihre bevorzugte Klimapolitik zu werben, ohne tatsächlich etwas zu dem Thema gearbeitet zu haben.

Ein prominentes Beispiel ist dieser Artikel von Michael Mann in der NYTimes: Climate change is behind the heat dome.

Ein Argument der Heißluft-Argumentation basiert auf folgendem Diagramm: Wenn die Durchschnittstemperaturen steigen, dann steigt auch die Häufigkeit von Hitzeextremen:

Die Analyse der historischen Daten widerlegt jedoch diese einfache Interpretation:

Zur sich verändernden Form der sommerlichen Temperaturverteilung auf der Nordhemisphäre

https://agupubs.onlinelibrary.wiley.com/doi/abs/10.1002/2016JD025292

Vorsicht bei der Interpretation von Extremwetterstatistiken ist geboten:

https://journals.ametsoc.org/view/journals/clim/28/23/jcli-d-15-0020.1.xml

Für eine leichter zu lesende Zusammenfassung siehe diesen Bericht von Prescient Weather, der zeigt, dass die höheren Momente der Temperaturverteilungen ebenfalls kritisch sind und dass die Varianz möglicherweise abnimmt.

Der andere Teil des Arguments der heißen Luft bezieht sich auf die Hypothese, dass der Jetstream durch die globale Erwärmung „schwächer“ wird, ein Argument, das unter anderem von Michael Mann vorgebracht wird. Es gibt eine Menge neuerer Arbeiten, die diese Idee entlarven, und einige neuere Arbeiten deuten sogar darauf hin, dass Hochdruckdome, wie sie während der Hitzewelle auftraten, im Falle einer globalen Erwärmung schwächer werden.

Es ist intellektuell faul, wenn Wissenschaftler sich zu diesem (oder jedem anderen) Thema äußern, ohne tatsächlich etwas zu dem Thema gearbeitet zu haben oder zumindest aktuelle Forschungsergebnisse zu dem Thema gelesen und analysiert zu haben. Eine bequeme, aber ungerechtfertigte Storyline, die Ihren Aktivismus und Ihre bevorzugte Politik unterstützt, ist nicht hilfreich.

II. Wissenschaftler, die historische Daten analysieren

John Christy hat die folgende Analyse historischer Daten zur Verfügung gestellt, die im Blogbeitrag von Cliff Mass enthalten ist:

https://cliffmass.blogspot.com/2021/07/was-global-warming-cause-of-great.html

<Zitatanfang>

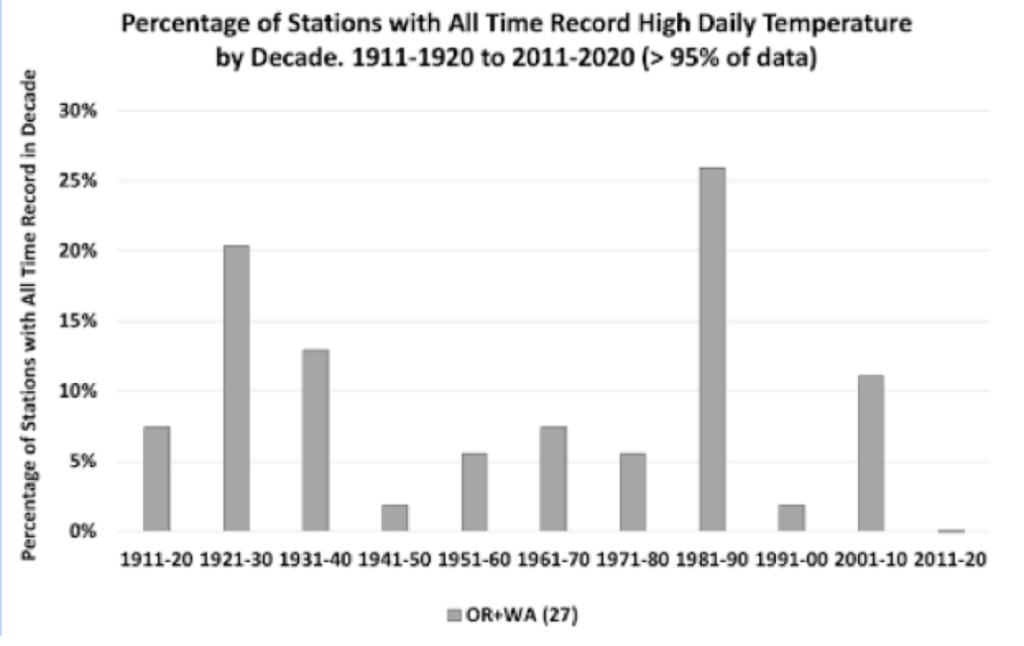

Wie unten gezeigt, gibt es KEINEN ANSTEIGENDEN TREND für mehr Rekord-Hochtemperaturen über unserer Region (Oregon, Washington) während des letzten Jahrhunderts. Tatsächlich gab es im letzten Jahrzehnt (2011-2020) überhaupt keine Allzeitrekorde:

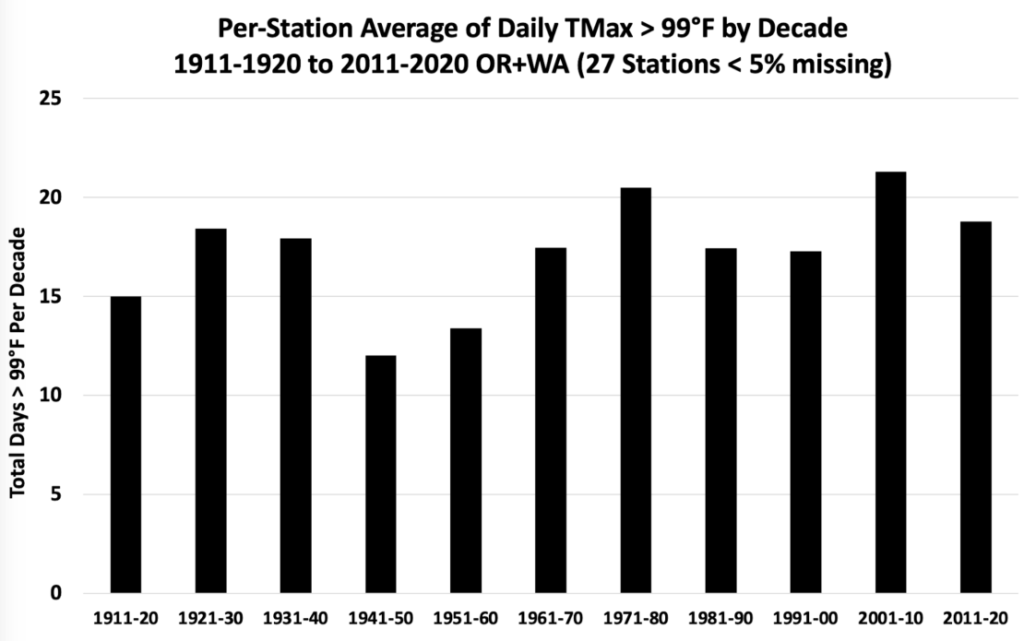

Durchschnittliche Anzahl von Tagen mit Temperaturen über 37°C in Oregon oder Washington? Ebenfalls kein Trend:

Diese Ergebnisse stimmen mit dem überein, was andere gefunden haben. Zum Beispiel fand das U.S. National Climate Assessment heraus, dass der wärmste Tag des Jahres über dem Nordwesten zwischen einem historischen (1901-1960) und einem aktuellen Zeitraum (1986-2016) tatsächlich in Letzterem nicht mehr so hoch ausgefallen ist.

Dr. Nick Bond, Washington State Climatologist, sagte, dass er und die Associate State Climatologist Karin Bumbaco ähnliche Ergebnisse gefunden haben, die in einer begutachteten Arbeit veröffentlicht wurden.

<Zitatende>

Ein einzelnes Hitzewellenereignis kann anhand der historischen Aufzeichnungen früherer historischer Hitzewellen (z. B. der letzten ~100 Jahre) bewertet werden. Abgesehen von einigen technischen Streitigkeiten über den Datensatz, die Gefahren der Homogenisierung usw., welche Logik genau steckt hinter der Verwendung historischer Temperaturaufzeichnungen in Diskussionen über die Gründe von Hitzewellen?

A. Wenn ein Rekord aufgestellt wird, führt das zu der notwendigen Schlussfolgerung, dass AGW eine Hauptursache dafür war?

B. Wenn kein Rekord aufgestellt wird, führt das zu der notwendigen Schlussfolgerung, dass AGW keine Hauptursache ist?

C. Wenn es einen zugrunde liegenden Trend in der Häufigkeit von Hitzewellen an diesem Ort gibt, führt das zu einer notwendigen Schlussfolgerung, dass AGW eine wichtige beitragende Ursache für ein einzelnes Hitzewellenereignis war?

D. Wenn es keinen zugrunde liegenden Trend in der Häufigkeit von Hitzewellen an diesem Ort gibt, führt das zu der notwendigen Schlussfolgerung, dass AGW keine wesentliche beitragende Ursache für ein einzelnes Hitzewellenereignis war?

E. Wenn es einen globalen Trend in der Häufigkeit/Schwere von Hitzewellenereignissen gibt, sagt das etwas über eine Rolle (oder nicht) von AGW bei der Beeinflussung eines einzelnen lokalen Hitzewellenereignisses aus?

F. Sagt das Ausmaß, mit dem ein Temperaturrekord gebrochen wird, überhaupt etwas über eine Rolle (oder nicht) des AGW bei der Beeinflussung eines einzelnen lokalen Hitzewellenereignisses aus?

Während die Bereitstellung eines historischen Zusammenhangs für ein lokales Hitzewellenereignis entscheidend für das Verständnis der Situation ist, lautet die Antwort auf jede dieser Fragen „Nein“. A, C, E und F in Kombination würden für ein „Ja“ sprechen, aber die Daten liefern keine quantitative Antwort darauf, wie viel Erwärmung durch die Hitzewelle infolge AGW verursacht wurde. Eine eindeutige „Nein“-Antwort allein durch die Analyse der Temperaturaufzeichnungen zu erhalten, ist eine größere Herausforderung. Aber wenn ein lokaler Hitzerekord aufgestellt wird, lohnt es sich, tiefer zu graben und zu versuchen, die unmittelbaren (Wetter-) Ursachen und jeden zugrundeliegenden Klimaeinfluss (multidekadische natürliche Variabilität und/oder AGW) zu verstehen.

III. Wissenschaftler, die Klimamodell-basierte Attributionsanalysen durchführen

Gavin Schmidt schreibt hier bei RealClimate:

„Die Art und Weise, wie die Klimamodell-basierte Zuordnung für Extremereignisse aussieht (wie zuvor auf RealClimate hier und hier usw. besprochen), ist, dass man sich die Situation mit und ohne das anthropogene globale Erwärmungssignal ansieht und das Verhältnis der Wahrscheinlichkeiten berechnet. Wenn ein Ereignis, sagen wir, mit der GW doppelt so häufig auftritt, dann kann man dem anthropogenen Antrieb einen Anteil von 50% zuschreiben und die Wiederkehrzeit ist halb so lang wie früher. Wenn es fünfmal wahrscheinlicher ist, ist die Zuschreibung 80% = 100*(5-1)/5 und die Wiederkehrzeit ist ein Fünftel von dem, was sie früher war. In diesem Fall sehen wir Wahrscheinlichkeitsverhältnisse von 150 zu 1000, was darauf hindeutet, dass diese, unwahrscheinlichen, Temperaturen fast vollständig auf die globale Erwärmung zurückgeführt werden können. Ohne das anthropogene Signal hätte es solche extremen Temperaturen seit Tausenden bis Zehntausenden von Jahren nicht mehr gegeben.“

Der schnelle Bericht des europäischen Teams ist [hier] zu finden.

Diese Bemühungen beinhalten eine riesige Menge an Zahlenwerk.

Dieser Bericht hat eine Menge Medienaufmerksamkeit bekommen, siehe zum Beispiel diesen Artikel von Time.

Also, was ist falsch an diesem Bild?

1. Eine Zeitreihe in der Größenordnung von hundert Jahren (aus Beobachtungen oder einer Modellsimulation) reicht nicht aus, um aussagekräftige Statistiken darüber zu entwickeln, dass es sich um ein Ereignis von 1 in 10.000 Jahren handelt.

2. Die atmosphärische Dynamik in globalen Klimamodellen ist ziemlich „bla“; die grobe Auflösung von Klimamodellen ist grundsätzlich nicht in der Lage, die Art von Blockierungsereignissen zu erfassen, die Hitzewellen verursachen, oder Hurrikane aufzulösen, oder extreme konvektive Ereignisse aufzulösen, die Überschwemmungen verursachen, usw.

3. Dieser Ansatz geht implizit davon aus, dass der gesamte Klimawandel durch Emissionen verursacht wird, und ignoriert oder charakterisiert die mehrdekadische natürliche interne Variabilität falsch (da die Klimamodelle nicht die richtigen Phasen und Amplituden haben).

Cliff Mass hat eine meisterhafte Arbeit geleistet, den Bericht der europäischen Gruppe zu kritisieren. Ich stimme allem zu, was er sagt.

Dieser gesamte auf Klimamodellen basierende Ansatz zur Zuordnung von Extremereignissen ist grundlegend fehlerhaft. Solange Klimamodelle nicht in der Lage sind, Zirkulationsmerkmale tatsächlich aufzulösen (was eine horizontale Auflösung von ~20 km erfordert), sind sie für die Zuordnung von extremen Wetterereignissen einfach nicht geeignet.

IV. Wissenschaftler führen prozessbasierte Analysen durch

Der NOAA-Wissenschaftler Marty Hoerling hat die Zuordnung von Extremwetterereignissen mit der Durchführung einer Autopsie verglichen. Man hat einige Hinweise, aber die Schlussfolgerung erfordert, sie in einer mechanistischen Abfolge von Ereignissen miteinander zu verknüpfen.

Cliff Mass hat den bisher besten Autopsiebericht über die Hitzewelle geliefert.

Er fasst die unmittelbare Abfolge der Ereignisse, die zur Hitzewelle führten, folgendermaßen zusammen:

„Eine Rekord-Amplitude eines Rückens/Hochdrucks über unserer Region, erzwungen durch eine tropische Störung im westlichen Pazifik, die einen nachgelagerten Wellenzug erzeugte. Eine Umgebung, die es der resultierenden Welle ermöglichte, sich zu verstärken. Der Höhenrücken musste sich in genau der richtigen Position relativ zu unserem Terrain befinden. Ein Höhentrog musste sich genau an der richtigen Stelle vor der Küste entwickeln und sich in die optimale Richtung bewegen, um eine starke südöstliche Strömung zu verursachen, die den oben erwähnten Verstärker förderte. Wir brauchten eine Periode, in der die Sonne sehr stark war. Und einen Sommerabschnitt ohne Rauch, der einen tiefgreifenden Kühleffekt hat.

Die meteorologischen Würfel mussten alle Sechsen ergeben. Und das taten sie.“

Prozess-basierte Analysen unterscheiden sich von irgendwelchen künstlichen „Storylines“. Hier ist, was Mass berücksichtigt hat:

1. Der Bundesstaat Washington hat sich in den letzten 120 Jahren um 1,5C erwärmt

2. Ob die Dürre und die trockenen Böden zur Hitzewelle beigetragen haben (nein, laut regionalen Modellsimulationen und der Tatsache, dass es keinen Trend zur Dürre im pazifischen Nordwesten gibt)

3. Ob die globale Erwärmung stärkere Hochdruckgebiete erzeugt (nein, laut Datenanalyse und Klimamodell-Simulationen)

4. Kein beobachteter Trend bei Hitzewellen (laut Analyse von Christy)

5. Verwendung eines regionalen Klimamodells (nein, CO2 erzeugt nicht mehr Hitzewellen)

6. Analyse der regionalen Wetterdynamik, unterstützt mit regionalen Ergebnissen der Klimamodellierung zeigt einen paradoxen Weg der Abkühlung in der Region

Haben wir hier also eine eindeutige „Todesursache“, d.h. eine eindeutige „Nein“-Antwort auf die Frage, ob AGW die Ursache für die Hitzewelle war oder zumindest einen Einfluss darauf hatte?

Eine einfache Zusammenschau dieser Beweise führt nicht zu einer eindeutigen „Nein“-Schlussfolgerung. Allerdings ist Cliffs Analyse wohl ausreichend, um zu folgern, dass CO2 nicht die alleinige oder gar dominante Ursache für die Rekordtemperaturen war.

V. Ein fünfter Weg

Wir brauchen eine bessere Logik, um extreme Wetterereignisse der globalen Erwärmung zuzuschreiben, und etwas Querdenken, wie man die Ursachen extremer Wetterereignisse zuordnen kann.

In Anbetracht der oben beschriebenen Strategien sind I und III unbefriedigend und offen gesagt überhaupt nicht sinnvoll. Vor allem für III wird eine enorme Menge an Ressourcen und Gehirnleistung für diesen Ansatz verschwendet, für den die globalen Klimamodelle in ihrer derzeitigen Auflösung einfach nicht geeignet sind.

II ist sehr nützlich, aber die Logik bei der Auswertung dieser Informationen für die Attribution ist unklar. IV bietet nützliche Einsichten, liefert aber keine quantitative Antwort bezüglich der Zuordnung oder einer klaren Rolle des CO2-Beitrags.

Wir brauchen einen fünften Weg, der auf II und IV aufbaut, eine bessere Logik für die Durchführung der Autopsie liefert und einige neue Ansätze berücksichtigt.

Extreme Wetterereignisse können in Bezug auf das Ausmaß einzelner Ereignisse, die Häufigkeit von Ereignissen, die einen bestimmten Schwellenwert überschreiten, oder die Häufung von Extremereignissen extrem sein. Es muss anerkannt werden, dass Extremereignisse per Definition selten sind, und kurze historische Aufzeichnungen (sogar jahrhundertelange Aufzeichnungen) sind unzureichend, um aussagekräftige Statistiken über Wiederkehrzeiten zu formulieren.

Es muss eine thermodynamische und dynamische Geschichte des Extremereignisses zusammengestellt werden, ähnlich wie Cliff Mass das Problem formulierte. Hier ist ein alternativer Ansatz für das Verständnis und die Quantifizierung des Effekts eines CO2-Anstiegs auf Unwettersysteme. Das hier angeführte Beispiel zielt auf die NW-Hitzewelle in den USA.

Einzelne Säulenmodelle der Atmosphäre, die mit der Landoberfläche gekoppelt sind, können eine quantitative Bewertung des direkten Beitrags des CO2-Antriebs zu den Oberflächentemperaturen liefern. Dies ist ein besserer Ansatz, als die historische Aufzeichnung der jährlichen durchschnittlichen Oberflächentemperaturen zu betrachten und anzunehmen, dass jeder Anstieg durch CO2 verursacht wird und das Ausmaß jeder Hitzewelle um den gleichen Betrag erhöhen würde.

Experiment Nr. 1: Für dieses spezielle Ereignis, am Tag des maximalen Temperaturrekords, kann ein lokales vertikales Profil von Temperatur und Luftfeuchtigkeit von einer Radiosonde oder der operativen Analyse von numerischen Wettervorhersagezentren erhalten werden. Dieses kann durch ein atmosphärisches Einsäulenmodell mit Strahlungstransportmodell und Landoberflächenmodell laufen, um die Oberflächentemperatur als Reaktion auf vorindustrielles CO2, aktuelle CO2-Werte und zukünftige CO2-Werte zu berechnen. Dies ist eine einfache Berechnung, die die Frage beantwortet: Wenn alle anderen Dinge gleich sind, wie viel Unterschied haben die Emissionen der letzten 100 Jahre auf die Oberflächentemperatur für das entstandene Hitzedom-Ereignis gemacht, nur durch die Strahlungseffekte des CO2? Kalte, trockene und wolkenlose Situationen verstärken den Einfluss des CO2 auf die Oberflächentemperatur. Es ist ziemlich einfach, genau zu berechnen, welche Auswirkung der Anstieg des CO2 auf die Oberflächentemperatur unter den lokalen Bedingungen für Portland, OR, haben würde. Ohne die Berechnung durchgeführt zu haben, würde mich ein Ergebnis von 1-3 F nicht überraschen.

Experiment Nr. 2: Dieses Experiment baut auf Nr. 1 auf, um die Auswirkungen der schnellen thermodynamischen Rückkopplungen auf die Änderung der Oberflächentemperatur zu berücksichtigen. Dies kann erreicht werden, indem die Form des Temperaturprofils und der relativen Luftfeuchtigkeit aus der ursprünglichen Radiosonden- oder Betriebsanalyse verwendet wird, um die Temperatur- und Luftfeuchtigkeitsprofile an die resultierende Oberflächentemperatur für die Berechnungen in Experiment Nr. 1 für verändertes CO2 anzupassen. Dies ermöglicht eine bessere Einschätzung der direkten Strahlungseffekte von verändertem CO2 in diesem speziellen Wettersystem.

Der nächste Satz von Experimenten befasst sich mit den dynamischen Effekten von steigendem CO2 auf das spezielle Wettersystem, das die rekordverdächtigen Oberflächentemperaturen beeinflusst hat.

Diese Hitzewelle wurde von einem globalen Ensemble-Wettervorhersagesystem außergewöhnlich gut bis zu 10 Tage im Voraus vorhergesagt. Ein globales Ensemble-Wettervorhersagesystem mit hoher Auflösung (mindestens 20 km) kann die täglichen Vorhersagen von 14 bis 1 Tag vor dem Ereignis simulieren, bei einer CO2-Konzentration von 300 ppm. An dieser Stelle ist nicht klar, ob eine einzelne Vorhersagesimulation zu jeder Vorlaufzeit ausreichend ist oder ob das gesamte Ensemble benötigt wird.

Experiment Nr. 3: Nehmen Sie keine Änderung am Wettervorhersagemodell vor, außer an der CO2-Konzentration. Man vergleiche die „Vorhersagen“ mit geänderter CO2-Konzentration mit den ursprünglichen Vorhersagen: Höhe der 500- bzw. der 850-hPa-Fläche sowie Temperaturen in der Nähe des Wärmedoms, auch die Oberflächentemperaturen in den NW USA und SW Kanada. Es könnte sich herausstellen, dass Experiment Nr. 3 ausreicht, um die Rolle von mehr/weniger CO2 auf die Entwicklung des Omega-Blocks, des Wärmedoms und der Rekordtemperaturen abzuleiten. Aber die Experimente Nr. 4 und Nr. 5 sollten in Betracht gezogen werden, da es Vorbehalte bei der Interpretation von Experiment Nr. 3 gibt.

Experiment Nr. 4: Ändern Sie die globalen Meeresoberflächentemperaturen (SST) auf eine Weise, die das globale Muster der SST für diesen Zeitraum beibehält, aber Größenordnungen aufweist, die eher mit einem 300 ppm Klima übereinstimmen. Ich würde dafür die Reanalysen der NOAA aus dem 20. Jahrhundert verwenden.

Subtrahieren Sie den Jahresdurchschnitt (oder Sommerdurchschnitt) der SST für jeden Ozean-Gitterpunkt für ein 300 ppm-Klima (um 1910) von den aktuellen Gitterwerten; subtrahieren Sie die Gitterdifferenz von dem SST-Feld für diesen Fall, das in den Wettervorhersagemodellen verwendet wird. Führen Sie den gleichen Satz von Experimenten wie in Nr. 3 durch; vergleichen Sie mit den ursprünglichen Vorhersagen und den reduzierten CO2-Vorhersagen aus Nr. 3. Hinweis: Es ist nicht klar, wie schnell sich die initialisierten atmosphärischen Temperaturprofile an die geänderte SST anpassen werden und wie sehr dies die Entwicklung der atmosphärischen Dynamik beeinflussen würde.

Experiment Nr. 5: Für Experiment #4 sind die initialisierten atmosphärischen Temperaturen zu hoch, ebenso wie die spezifische Feuchte im Verhältnis zu den niedrigeren SST-Werten. Die Initialisierung der Luftfeuchtigkeit spielt eigentlich keine Rolle, da das Modell schnell sein eigenes Luftfeuchtigkeitsfeld erzeugt. Allerdings kann das anfängliche Temperaturfeld eine Rolle spielen. Es sind die Temperaturgradienten, die die Zirkulationen beeinflussen. Im Sommer würde sich der Temperaturgradient von Pol zu Äquator zwischen hohem und niedrigem CO2-Gehalt kaum ändern; das Schmelzen des arktischen Meereises wäre Ende Juni 1910 gerade erst im Gange, während es im Juni des aktuellen Klimas schon weit fortgeschritten ist. Auch die konvektiven Stornoraten wären bei hohem und niedrigem CO2 unterschiedlich. Ich bin mir nicht sicher, wie schnell sich die atmosphärischen Temperaturen an die veränderten SSTs in Nr. 4 anpassen würden. Die initialen atmosphärischen Temperaturen wären nicht im Gleichgewicht mit den niedrigeren Oberflächentemperaturen, wodurch die Meeresatmosphäre zu stabil wäre. Eine Initialisierung mit atmosphärischen Temperaturen, die besser zu 1910 passen und gleichzeitig alle Temperaturgradienten beibehalten, wäre ideal. Das Team, das die Reanalysen des 20. Jahrhunderts durchführt, könnte vielleicht herausfinden, wie man das macht.

Diese Reihe von numerischen Experimenten würde es ermöglichen, Schlussfolgerungen zu ziehen, die die thermodynamischen und dynamischen Auswirkungen von reduziertem/erhöhtem CO2 auf die Oberflächentemperaturen und die Dynamik des Wärmedoms vergleichen. Die genaue Logik, wie solche Schlüsse gezogen werden sollten, mit welchen Vorbehalten und Unsicherheiten, würde mehr Aufmerksamkeit erfordern, als ich hier bieten kann.

Eine solche Analyse würde uns nur so weit bringen: Es bleibt die Frage, ob das erhöhte CO2 die gesamte hemisphärische Dynamik verändert, so dass solche Hitzedom-Ereignisse und Omega-Blöcke häufiger oder seltener auftreten. Experimente mit hochauflösenden (20 km horizontale Auflösung) gekoppelten globalen Klimamodellen mit erhöhtem/vermindertem CO2 können einige Erkenntnisse liefern (die wesentliche Zutat ist, dass das Modell eine ausreichend hohe Auflösung hat, um Blockierungsmuster aufzulösen).

Die Analyse globaler Reanalysedaten (ERA5 zurück bis 1950, Reanalyse des 20. Jahrhunderts eigentlich zurück bis zum 19. Jahrhundert) kann einige wichtige Erkenntnisse liefern:

● Verändert zunehmendes CO2 die multidekadischen Ozeanschwingungen? Ich habe eine Literaturrecherche gemacht und bisher keine Hinweise darauf gefunden.

● Verändert die zusätzliche Erwärmung ENSO? Ich habe eine Literaturrecherche durchgeführt und ja, ENSO hat sich seit 1950 verändert; ob diese Veränderungen durch CO2 verursacht werden, ist umstritten.

● Ändern sich die atmosphärischen Telekonnektionsregime (z.B. AO, PNA etc.)? Das ist etwas, das ich mir angesehen habe (seit 1950), und es gab keine Veränderungen, abgesehen von kleineren Schwankungen, die mit der multidekadischen Klimavariabilität zusammenhängen.

Was die Hypothese des wellenförmigen Jetstreams und seinen Einfluss auf die Blockierung betrifft, so verfolge ich die Literatur zu diesem Thema, habe aber keine formale Literaturübersicht dazu erstellt. Die grundlegenden dynamischen Überlegungen unterstützen die Hypothese des welligen Jetstreams nicht. Es muss mehr theoretische Forschung betrieben werden, und die ERA5- und die 20th Century Reanalysis sollten sich als guter Datensatz dafür erweisen, aber es kommt darauf an, wie diese Daten interpretiert werden.

Und schließlich werden maschinelles Lernen und netzwerkbasierte Verfahren zunehmend für Attributionsanalysen in einer Reihe von verschiedenen Bereichen eingesetzt.

Ich stelle diese Gedanken zur Diskussion und freue mich auf weitere Vorschläge, wie man dieses Problem angehen kann.

Hitze vs. Kälte

Und schließlich spreche ich den Alarm über Hitzewellen an. Ich war Ende Juni in Utah, wo die lokale Temperatur 44°C erreichte. Das ist nicht angenehm. Zum Glück konnte ich meistens drinnen bleiben, wo es kühler war. Es steht außer Frage, dass übermäßige und ungewöhnliche Hitze gesundheitliche Probleme verursacht. Die Menschen haben sich an sehr hohe Temperaturen angepasst (siehe diesen Artikel über Pakistan). Hier geht es um unerwartet hohe Temperaturen, auf die breite Bevölkerungsschichten nicht vorbereitet sind und keine Erfahrung im Umgang damit haben. Nach diesem Maßstab waren die rekordverdächtigen Temperaturen in Portland schwieriger zu bewältigen als die relative Routine und wesentlich höheren Temperaturen in Pakistan.

Während Hitze tötet, töten niedrige Temperaturen mehr als eine Größenordnung mehr Menschen als Hitze. Pat Michaels beschäftigt sich seit Jahrzehnten mit diesem Thema, und es ist nicht besonders umstritten. Dieser aktuelle Artikel im Guardian ist interessant:

Titel [übersetzt]: „Extreme Temperatur tötet 5 Millionen Menschen pro Jahr mit steigenden hitzebedingten Todesfällen“

Untertitel [übersetzt]: „In den letzten 20 Jahren starben mehr Menschen an Kälte als an Hitze, aber der Klimawandel verschiebt das Gleichgewicht.“

Die einzige Schlussfolgerung, die ich hier ziehen kann, ist, dass die globale Erwärmung mit weniger temperaturbedingten Todesfällen verbunden ist. Das steht im völligen Widerspruch zu dem Eindruck, den der Guardian-Artikel mit seiner alarmierenden Überschrift zu erwecken versucht.

Link: https://wattsupwiththat.com/2021/07/15/heat-waves-and-hot-air/

Übersetzt von Christian Freuer für das EIKE

Wird uns in Deutschland die Zunahme der Hitzetage mit über 40 Grad C nicht ständig als „Klimawandel“ verkauft? Wobei selbst Realisten andächtig nicken? Dann schaut man nach Oregon und Washington, und siehe da, dort sieht es schon wieder anders aus! Und selbst der naheliegende Zusammenhang von höheren Durchschnittstemperaturen und mehr Hitzeextremen ist ungewiss. Und von Wärmeinseleffekten, die solche „Temperaturanstiege“ begünstigen, ist dabei noch nicht einmal die Rede.

Was lernt man daraus? Traue keinem Aktivisten, der Klima-Alarm verbreitet! Trends, die für Deutschland gelten, müssen in anderen Regionen noch lange nicht stimmen! Ein weiterer Grund, die Kältereports wertzuschätzen…

Interessant auch in diesem nicht ganz einfachen Artikel, wie man sich einem Vergleich übereinstimmender Klimatas, jedoch mit und ohne CO2-Anstieg, nähern könnte. Dumm nur, dass man das „globale Klima-Experiment“, mit und ohne CO2-Anstieg, bei ansonsten gleichen Startbedingungen, nicht wiederholen kann. Also bleibt in jedem Fall viel Ungewissheit und Modell-Kosmetik. Nur die Alarmforscher wissen es ganz genau. Und dumme Politiker, Verfassungsrichter und Luisas glauben ihnen…