Die Computermodelle des IPCC (Intergovernmental Panel on Climate Change, Weltklimarat) sind nach wie vor von sehr begrenztem Wert, die resultierenden Vorhersagen so gut wie unbrauchbar – das Weltklima ist einfach zu kompliziert. So reichen die Prognosen des IPCC für die CO2-Klimasensitivität (Temperaturanstieg bei Verdoppelung des CO2) von 1,6 bis 5,6 Grad C, aber nur mit einer Wahrscheinlichkeit von 66%. Vor diesem unbefriedigenden Hintergrund haben, wie überall in der Physik, Messungen das letzte Wort. Und die gibt es inzwischen schon seit längerer Zeit. Ist es da nicht besser, man orientiert sich an konkreten Messergebnissen anstelle von fragwürdigen und in aller Regel übertriebenen Alarm-Prognosen?

Die Temperatur-Werte, ermittelt von vielen tausend Stationen, enthalten allerdings auch Fehlerquellen wie unregelmäßig verteilte Messstationen, welche Stationen ausgewählt werden, Messungenauigkeiten sowie die meist intransparenten Adjustierungen und Homogenisierungen der Messdaten. Über den Ozeanen und vor allem auf der Südhalbkugel gibt es weniger Messstationen. Je älter die Temperaturdaten, desto größer sind die Ungenauigkeiten. Belege für „gezielte“ Anpassungen gibt es ebenfalls. Nachfolgende HadCRUT4-Bodendaten werden auch vom IPCC verwendet – schon deshalb ist eine „Untertreibung“ eher unwahrscheinlich.

Unschwer ist zu erkennen, dass den Temperaturverläufen Periodizitäten überlagert sind, für die es teilweise gute Beschreibungsansätze gibt (Ozeanische Oszillationen, El Niño, Nord-Süd-Klimaschaukel, Solarzyklen verstärkt durch kosmische Strahlung und Wolkenbildung), die aber in den Klimamodellen bisher kaum Berücksichtigung finden. Auch ist bis heute nicht sicher bekannt, welche natürlichen Vorgänge die historischen Klimaschwankungen verursacht haben – wie damals die Mittelalterlichen Warmzeit, als u.a. die Wikinger Grönland besiedelten, und die vorausgegangenen Warmzeiten davor.

Die Ozeane stellen einen riesigen Wärmespeicher dar, mehr als 100mal größer als die gesamte Atmosphäre. Insbesondere in den tieferen Ozeanbereichen folgen die Meerestemperaturen einer Erderwärmung nur sehr langsam, von bis etwa 1000 Jahren Verzögerung ist die Rede. Auch wird über den Ozeanen weniger Temperaturanstieg gemessen als über Land. Zusätzlich sind die Temperaturanstiege auf der Nordhalbkugel größer als auf der Südhalbkugel (Klimaschaukel?).

Zusätzliche Einflüsse wie die Wärmeinseleffekte durch zunehmende Bebauung und möglicherweise der Luftverkehr (Eintrag von Aerosolen in die Stratosphäre) bis hin zur wachsenden Energiefreisetzung von immer mehr Menschen spielen ebenfalls eine Rolle. Worauf hier nicht näher eingegangen wird, weil der Einfluss von natürlichen Ursachen auf den Temperaturverlauf zwar oftmals plausibel ist, aber aus heutiger Sicht dennoch meist spekulativ. Die Vorgaben der 1,5 Grad bzw. 2 Grad-Ziele gemäß Paris-Abkommen beziehen sich immer auf globale Mitteltemperaturen, worauf auch hier der Schwerpunkt gelegt wird.

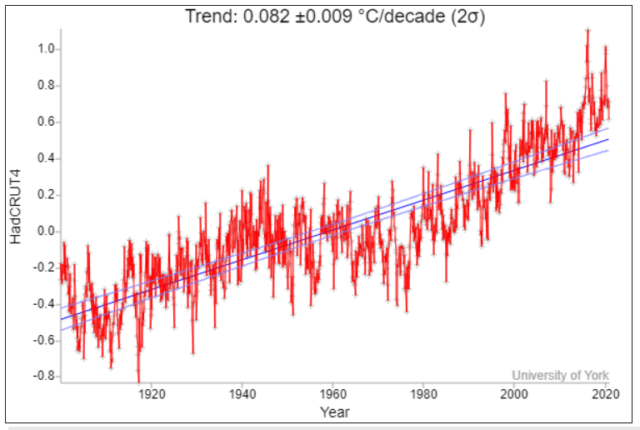

Der Temperaturanstieg seit Beginn der Industrialisierung fand vor allem im Laufe des letzten 120 Jahre statt (Darstellung unten nach Dr Kevin Cowtan – University of York, gefunden bei Kalte Sonne). Der Temperaturrückgang/-stillstand nach dem Jahr 2000 („Hiatus“), der den Temperaturrückgang zwischen 1945 und 1975 im Ansatz zu wiederholen schien, wurde seit 2016 von zwei El Niños unterbrochen. Was den Medien Gelegenheit gibt, fortlaufend „hohe“ Temperaturwerte zu vermelden, auch wenn es nur Zehntelgrad-Rekorde sind. Dennoch, in den kommenden zehn Jahren wird es spannend, wie es mit den Temperaturen weitergeht.

Setzt man diesen 120-jährigen Temperaturtrend fort, dann ist bis 2100 ein weiterer Temperaturanstieg von nur etwa 0,66 +/- 0,07 Grad C zu erwarten, was niemanden beunruhigen muss.

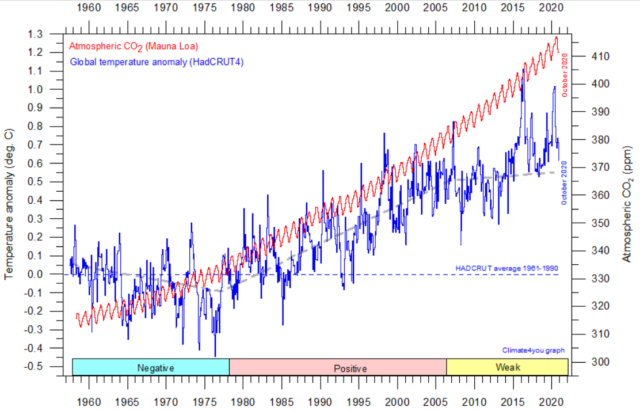

Von 1978 bis etwa 2005 korrelierten das CO2 und die Temperaturen kurzzeitig, was der Alarmforschung bekanntlich Auftrieb gab. Dazu in der nachfolgenden Grafik (von climate4you) rot eingetragen die CO2-Konzentration in der Atmosphäre, gemessen auf dem Mauna Loa. Davor und danach ist die Korrelation deutlich schlechter. Die beiden Peaks seit 2016 sind, wie bereits erwähnt, Folge des unregelmäßig wiederkehrenden Klimaphänomens El Niño, das von den Klimamodellen ebenfalls nicht dargestellt werden kann. Der CO2-Anstieg müsste genau genommen logarithmisch eingetragen werden, weil auch die spektroskopische Erwärmung nur dem Logarithmus der CO2-Konzentration folgt. Was dann den CO2-Anstieg etwas weniger „dramatisch“ aussehen lässt.

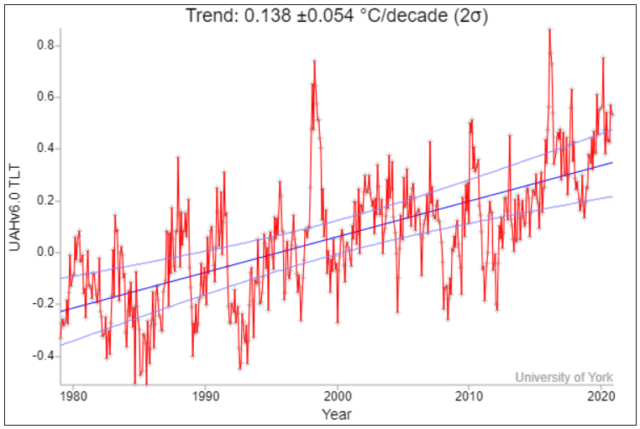

Seit etwa 1979 gibt es Satellitenmessungen, bei denen ebenfalls global gemessen wird und zwar die Mikrowellenstrahlung von O2 (Sauerstoff) in der Troposphäre:

Bei den Satellitendaten wird offenbar weniger manipuliert, doch auch hier gibt es einige Fragen: Man misst die Temperaturen in der Troposphäre und nicht in Bodennähe. Auch sind Nachjustierungen bei den Bahnparametern von Zeit zu Zeit erforderlich – zumindest, wenn dies bei den Satelliten nicht automatisch erfolgt. Auch gibt es z.B. bei El Niño Zeitverzögerungen, bis die Troposphäre den Bodentemperaturen folgt. Die hier gezeigten Satellitendaten schneiden immerhin gut ab beim Vergleich mit Ballonmessungen und sog. Nachrechnungen – siehe hier.

Bei Satellitendaten ist ferner zu beachten, dass es sie erst seit 1979 gibt, also seit Beginn der relativ steilen Anstiegsphase, ähnlich, wie sie auch schon von 1910 bis 1945 aufgetreten ist – was für eine „Übertreibung“ aufgrund der Auswahl des Zeitfensters spricht. In diesem kurzen Zeitabschnitt ist der Temperaturanstieg pro Dekade beinahe doppelt so hoch wie in den letzten 120 Jahren. Auch ist das Unsicherheitsintervall mehr als fünfmal größer.

Statistisch gesehen erlaubt deshalb der 120-jährige Messzeitraum, wie in der ersten Abbildung oben dargestellt, die verlässlichste Prognose mit einem Temperaturanstieg von nur 0,66 +/- 0,07 Grad C bis 2100. Wobei mit längerer Messdauer die Unsicherheitsintervalle immer kleiner werden.

Der reale Temperaturanstieg dürfte in Wirklichkeit sogar noch kleiner sein, wie z.B. der dänische Geologe Prof. em. Dr. Johannes Krüger ausführte:

„ Die offizielle, von NOAA (National Oceanic and Atmospheric Administration) entwickelte Temperaturkurve der globalen Temperatur für den Zeitraum 1900-1999, die das IPCC in seinen Berichten vorgestellt hat, wurde umfassend angepasst, um einen viel höheren Temperaturanstieg als die ursprünglichen Temperaturdaten zu zeigen. Die Anpassung trägt bis zu 0,3 ° C der postulierten globalen Erwärmung von 0,7–0,8 ° C während des 20. Jahrhunderts bei. Die Schlussfolgerung ist daher, dass die globale Temperatur zwischen 0,4 ° C und 0,7 ° C angestiegen ist, wobei die erste Zahl auf der ursprünglichen Temperaturreihe und die letzte auf angepassten und manipulierten Daten basiert. Keiner dieser Werte ist in irgendeiner Weise alarmierend.“

Was folgt daraus? Man sollte die Temperaturen unaufgeregt weiter beobachten, zumal Ozeane und Pflanzen immer mehr von dem atmosphärischen CO2 aufnehmen. Was auch die stark zunehmende Begrünung der Erde sowie die gestiegenen Ernteerträge beweisen. Und hinzu kommt, dass die Temperaturen, wenn überhaupt, aus spektroskopischer Sicht nur logarithmisch mit dem CO2 ansteigen. Auch gehen die „Fossilen“ sowieso früher oder später zur Neige. Selbst wenn nicht, was vor allem russische Wissenschaftler behaupten, ist genügend Zeit vorhanden, Temperaturen und das CO2 in der Atmosphäre vorerst weiter zu beobachten. Auch sollte man notwendige Folgetechniken möglichst dem Markt überlassen und nicht einer grünen Staatsplanwirtschaft!

Da die deutsche Energiewende kein tragfähiges Energiekonzept für die Zukunft bietet, wird voraussichtlich an Dual Fluid-Reaktoren der 4. Generation längerfristig kein Weg vorbei führen – sie sind inhärent sicher. Auch sind damit die bisher gelagerten Brennstäbe zu 90 bis 95% nutzbar. Bereits heute ist die Kerntechnik die mit Abstand sicherste Energietechnik – und dies trotz der Tschernobyl-Katastrophe. Letztere trat ein als Folge eines untauglichen Reaktorkonzepts sowie unglaublicher Bedienungsfehler. Die 20.000 Fukushima-Opfer waren ausschließlich dem Tsunami geschuldet, und nicht, wie es uns Grüne suggerieren, der Reaktor-Havarie, die sich dank unzureichendem Tsunami-Schutz ereignete. Der Kernbrennstoff Thorium sollte bei dem neuen Reaktorkonzept für mindestens 1 Mio. Jahre reichen. Bis dahin funktioniert auch die Fusion… Prozesswärme für synthetische Kraftstoffe gäbe es dann auch – Mobilität mit gewohntem Komfort und Reichweiten wäre möglich.

Die erhofften Resultate der geplanten CO2-Reduktion sind dagegen in jeder Hinsicht höchst ungewiss. Das beginnt mit der Frage, welche Staaten dabei überhaupt mitmachen – Deutschland alleine ist hier vollkommen bedeutungslos! Schon deshalb bleibt offen, wie viel CO2 überhaupt reduziert werden kann, und was, last but not least, bei den Temperaturen damit letztlich erreicht werden wird (und welches Temperaturziel überhaupt gelten soll). Auf die Klimamodelle kann man sich dabei nicht verlassen. Somit ist die Dekarbonisierung eine jahrzehntelange sehr kostspielige Geisterfahrt mit höchst ungewissem Ergebnis – die nachhaltige Schädigung des Industriestandorts Deutschland ist dagegen gewiss!

Wenn überhaupt, wären für eine CO2-Reduktion weltweite Aufforstungsprogramme sinnvoller und für eine zuverlässige Temperaturabsenkung Geoengineering billiger, zeitnah und effektiver!

Ärgerlich, warum sieht das Frau Merkel nicht genauso? Klar, sie hat bereits Billionen auf „Klima-Weltrettung“ durch Dekarbonisierung gesetzt, da gibt es kein Zurück…

Über den Autor

Dr. Roland Ullrich ist Physiker und promovierte an der LMU über Plasmaphysik.Sein Berufsweg führte ihn von der Plasmaphysik, einem kurzen Ausflug in die Welt der Metallhydridspeicher zu einer überwiegend gutachterlichen Tätigkeit in der technisch-wissenschaftlichen Analyseabteilung einer Bundesbehörde.

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"@ Dietze 10:58Wer mit „Wintermänteln“ argumentiert, darf sich über das „Missverständnis“ nicht beklagen. Aber auch so bleibt Ihre Argumentation „Cherry-picking“, da hier ja nun schon genug zur „Gegenstrahlung“ (Frequenzbänder, Sättigung, Größenordnung, etc.) gesagt wurde, bzw. nachzulesen ist.

Wiedermal sehr gut dargestellt, auch überzeugend für mich als metereolügischen Laien. Verbohrte Hirne, Grünlinge , Freitagshüpfer kann man aber nur sehr behutsam in Stufen von ihrer CO2 -Religion abbringen, nicht zuletzt, dass sie auch ihr Gesicht wahren können. 1. Stufe: Ja, es findet Erwärmung statt. Sie hat natürliche und menschengemachte Ursachen. 2.Stufe: hat vorwiegend natürliche und teilweise menschengemachte Ursachen. 3. Stufe: Die Erwärmung, so sie denn stattfindet hat, hat natürliche Ursachen, der vom Menschen gemachte Anteil ist vernachlässigbar. Die aufgeschlossene Wissenschaft und das hier versammelte EIKE- Forum kommt gleich mit der vollen Wahrheit der 3. Stufe und wird immer wieder abprallen. So sehe ich den Beitrag von Dr. Ullrich als wertvollen Beitrag der 1. Stufe. Irgendwann wird was hängen bleiben.

Dr. Michael Schnell hat doch mehrfach in seinen Versuchen gezeigt, dass CO2 kein Klimakiller sein kann. „Wer ist nur auf das Märchen gekommen, CO2 könnte die Erdatmosphäre spürbar erwärmen?“ Wo bleibt die öffentliche Resonanz?

„Krise um CO2 ist doch vorbei – liegt ALLES nur am EIS-Pulver der FLIEGEREI !!!“ – leichte Erwärmung seit 80er Jahre der TROPO bei gleichzeitiger Abkühlung der STRATO (auf „RMSS.COM“ gucken) – korreliert eindeutig mit EntWicklung des FlugVerkehrs in 10 KM Höhe und dem HIATUS – „meine“ mind. 300 Mio. To/p.a. H2O-EIS-Aerosole ergeben sich aus den mind. 800 Mio. To/p.a. CO2 der Kerosin-Turbinen – 9/11-FlugVerbote (USA, 2001, 3-4 Tage) hatten ein Temperatur-DELTA an über 4.000 MessStationen zwischen EINEM und 1,8 Kelvin ergeben (siehe TRAVIS et al. in NATURE 08/2002) – oder hat jemand eine „bessere“ Erklärung ?!? 😉

„Seit etwa 1979 gibt es Satellitenmessungen, bei denen ebenfalls global gemessen wird und zwar die Mikrowellenstrahlung von O2 (Sauerstoff) in der Troposphäre“Ich möchte diese Aussage etwas vertiefen. Das Sauerstoff-Molekül O2 ist paramagnetisch. Verschiedene Messverfahren zur Bestimmung der O2-Konzentration beruhen auf dieser Eigenschaft. Der Paramagnetismus führt auch zu Absorptionsbanden von O2 im Mikrowellenbereich. Sauerstoff ist also ein Treibhausgas. Die Absorption ist allerdings schwach. Deshalb empfängt ein Satellit Strahlung-Beiträge aus allen Höhen der Atmosphäre, also auch aus der unteren Atmosphäre. Wenn die Mikrowellen-Strahlung durch strahlungslose Prozesse unterdrückt werden würde könnte man solche Messungen nicht ausführen. Ich schließe meine Ausführungen mit ergänzenden Bildern zu Bild 3. Bild 1 zeigt die monatliche Zeitreihe der Global-Temperatur (Land+Ozean) in °C nach RSS TLT, Bild 2 entsprechend nur über Ozean und Bild 3 nur über Land. http://www.gigapico.de/EIKE_2020122101.jpg http://www.gigapico.de/EIKE_2020122102.jpg http://www.gigapico.de/EIKE_2020122103.jpgÜber Land ist der Trend größer als über den Ozeanen. Allerdings ist hier die mittlere Temperatur niedriger als über den Ozeanen.

@ „Da CO2 aber Infrarotstrahlung in einem bestimmten Wellenbereich (hauptsächlich bei 15 Mikrometer) absorbiert und emittiert, lässt sich leider auch das Gegenteil nicht beweisen.“ ein Blick auf die Website des Umweltbundesamtes:https://www.umweltbundesamt.de/service/uba-fragen/sind-kuenftige-durch-den-menschen-verursachtezeigt daß die Klimawirksamkeit des CO² lediglich für die beiden äußerst schmalen linken und rechten Banden der Frequenz 14,7 relevant sei, wobei tatsächlich nur noch die linke Bande Wirksamkeit ( Durchlässigkeit infraroter Strahlung in den Weltraum) erzielen könnte. Diesem schmalen Bereich der Durchlässigkeit durch weiter CO²-Zufuhr (bis zur letztendlichen Schließung dieses Mini-Fensters) eine tatsächliche, messbare Klimaveränderung von bis zu 5° zuzuschreiben, paßt eigentlich nur in ein Märchenbuch.Bei einer bis dato bereits fast vollständigen Sättigung der beiden CO²-relevanten Frequenzen, 4,3 und 14,7 ist es vollkomen egal ob noch eine künftige Verdoppelung oder Verfünffachung der anthropogenen CO²-Zufuhr erfolgt.

Ich frage mich immer wieder, wie schafft es ein Molkekül CO2 2400 Molkeküle der Luft zu erwärmen. Ich glaube es war Rahmstorf dem auch mal diese Frage gestellt wurde. Gespannt las ich die Antwort, und …?“Man dürfe das nicht so im Einzelnen sehen, sondern im Ganzen …“ (da folgte noch was, war aber nicht relevant)ja, also das war´s dann mit der aussagekräftigen Erklärung. War ich genauso schlau wie zuvor. Aber ich denke dieses eine Molkekül wird es nicht zuwege bringen die anderen 2500 (oder jetzt 2400) zu erwärmen.

Dazu verweise ich auf meine Antwort unten an Herrn Gerald Pesch.

>>Statistisch gesehen erlaubt deshalb der 120-jährige Messzeitraum, wie in der ersten Abbildung oben dargestellt, die verlässlichste Prognose mit einem Temperaturanstieg von nur 0,66 +/- 0,07 Grad C bis 2100. Wobei mit längerer Messdauer die Unsicherheitsintervalle immer kleiner werden.<<Derartige Messungen sind schlichtweg kompletter Bullshit!Gemessen darf nur da werden, wo man fernab von den Ozeanen, Flüssen und Ortschaften ist und eine Bewölkung nicht existent ist. Und das geht nur fernab der Meere und Hoch- und Tiefdruckgebiete.Und wenn man da mißt, dann stellt man was gänzlich Anderes fest, nur keine „Klimaerwärmung“. Da gibt es ne Abkühlung. Ein Blick auf die Sonnenfleckenanzahl erklärt auch warum das so ist.

Ich finde den Artikel super!Ohne Zorn und Eifer dieses ganze komplexe Problem auf den Punkt gebracht.

item.

>>So reichen die Prognosen des IPCC<<Was ist denn das sog. IPCC?Das hier:>>Das Intergovernmental Panel of Climate Change (IPCC) ist eine 1988 von dem United Nations Environment Programme (UNEP) und der World Meteorological Organization (WMO) errichtete Organisation mit Sitz in Genf, die sich der Aufgabe widmet den aktuellen Stand des Klimawandels zu bestimmen sowie dessen mögliche ökologische und sozial-ökonomischen Folgen abzuschätzen.<<Der Laden hat demgemäß mit Wissenschaft gar nix zu tun:>>Das IPCC bezeichnet sich selbst als eine wissenschaftliche Einrichtung [1], die keinerlei eigene wissenschaftliche Arbeiten durchführt. Seine Finanzierung wird durch Beiträge von WMO, UNEP und UNFCCC getragen. Das IPCC arbeitet also eigentlich wie die Fachzeitschrift einer wissenschaftlichen Vereinigung.<<Und damit ist alles das, was da in die Welt hinausposaunt wird, komplett unwissenschaftlich, denn eine unabhängige Kontrolle der „Schriftsätze“ durch politisch und ökonomisch unabhängige Wissenschaftler findet nicht statt. Und mit dem, was Fachzeitschriften publizieren, hat das, was das IPCC da von sich gibt, nun gar nix zu tun.Wer sich die gemessenen Temperaturverläufe fernab der Ozeane anschaut, kann sehr schnell feststellen, daß mit den Behauptungen des IPCC Etliches nicht stimmt. Allerdings sind nur die Temperaturen der USA frei im Original – also mit allen Fehlern – verfügbar.Und wer ist denn schon über mehrere Wochen im gesamten Atlantik von der Äquatorgegend bis zum Nordkap mit nem wissenschaftlichen Schiff gewesen und hat das Wetter da im Original mitbekommen? War schon enorm interessant 1974 mitzubekommen wo und wie ein Hurrikane entsteht. Wer kann sich denn vorstellen wie mal eben in weniger als 60 Minuten ca. 30 cm Regen runterkommen?

Lieber Herr Ullrich.Danke für die Zusammenstellung, letztlich wollen Sie sagen, dass es viele Gründe von Temperatur- und Klimaänderungen gibt, aber CO2 wohl kaum eine Wirkung hat. Da stimmen wir mit Ihnen überein. Aber bei diesem Pkt bedarf Ihr Artikel einer Ergänzung: Es geht um den menschengemachten Wärmeinseleffekt. Sie schreiben: „…Worauf hier nicht näher eingegangen wird, weil der Einfluss von natürlichen Ursachen auf den Temperaturverlauf zwar oftmals plausibel ist, aber aus heutiger Sicht dennoch meist spekulativ…“ Antwort: Da ist überhaupt nichts spekulativ, nur die exakte Größeneinsachätzung des WI-effektes mach schon bei einer Station Schwierigkeiten, dann erst recht, wenn man alle 1900 DWD-Stationen in der Summe sieht. Früher bei einem Forsthaus im Spessart, heute an den Landebahnen des Großflughafens im Strahle der 650 C heißen Abgase. Mein Tipp an Sie, kaufen Sie sich ein kleines Digitalthermometer, messen Sie einfach unregelmäßig und zu allen Jahreszeiten die Temperatur in der Gemeindemitte ihres Wohnortes, fahren sie dann 1 km aus der Bebauung raus in eine Wiesen/Waldumgebung und markieren dort einen festen Pkt, mit dem Sie zu allen Jahreszeiten die Temperaturen vergleichen. Schon nach 100 Vergleichen haben Sie einen ersten Anhaltspunkt über einen UHI-effekt. Der UHI-effekt ist Teil des Wärmeinseleffektes, denn der von Ihnen bestimmte Vergleichspunkt hat in den letzten 120 Jahren auch bereits einen WI-effekt entwickelt: großflächige Trockenlegungen durch die moderne Agrarindustrie, Straßenbau in der Nähe, Windräder, Photovoltaikfreiflächen usw. Ein weiterer Vorteil an Lebensqualität wird sich einstellen. Sie lernen ihre Heimat kennen und registrieren die ständigen menschenerzeugten Kleinveränderungen.

Herr Kowatsch, die WI- und UHI-Effekte gibt es, keine Frage! Trotzdem, über den Ozeanen gibt es sie nicht und trotzdem steigen dort die Temperaturen, wenn auch langsamer. WI- und UHI-Effekte gehen in die Temperaturen ein wie andere, natürliche Effekte auch. Aus unserer Sicht sogar sehr beträchtlich – die Alarmforschung ignoriert sie am liebsten ganz, denn nur das anthropogene CO2 darf schließlich Temperaturen erhöhen! Vor diesem Hintergrund, und den Ungewissheiten bei der „Quantifizierung“, halte ich es schon für sehr sinnvoll, die gemessenen Temperaturen genauer anzusehen – auch haben Messungen in der Physik bekanntlich das letzte Wort. Und da vielfach „adjustiert“ wurde mit der Tendenz, dass dadurch die Anstiege steiler wurden, ist man mit den publizierten Temperaturdaten ganz offensichtlich auf der „sicheren Seite“. Auch werden die Zeitspannen, in denen bisher gemessen wurde, immer länger. Und weil sich dadurch Trends immer deutlicher abzeichnen, darf man – mit aller Vorsicht – auch extrapolieren. Ich bin überzeugt, dass man auf diese Weise brauchbarere Vorhersagen erhält als mit den Klimamodellen des IPCC. Und die Temperaturtrends, die bisher undramatischen sind, sollten der Menschheit genügend Zeit lassen, die Zukunft mit Verstand und ohne Hysterie zu gestalten. Die Klimakirche sieht es leider anders…

Dass CO2 die Anregungsenergie unter den Druckbedingungen der Troposphäre nicht reemittiert, sondern per Stoßdeaktivierung abgeregt wird, lässt sich sehr wohl belegen. Damit ist der „Gegenstrahlung“ jede physikalische Grundlage genommen. Eine Erderwärmung durch CO2 ist nicht physikalisch plausibel begründbar.

Trotzdem, wie die Satellitenmessungen zeigen, weist die IR-Abstrahlung in den Weltraum bei den Absorptionsfrequenzen der Klimagase beträchtliche Dellen auf, also verringerte Abstrahlung dort – teilweise ausgenommen die Südpolregion. Diese Dellen waren allerdings schon vor dem Industriezeitalter da, die CO2-Delle wurde wegen des spektroskopischen Sättigungseffekts allenfalls geringfügig tiefer. Was dann die komplizierte Atmosphäre tatsächlich daraus macht, das scheint ziemlich ungewiss – während der IPCC vorwiegend nur Verstärkung sieht… Hinzu kommt, dass das CO2 mit den Temperaturen historisch nur schlecht korreliert. Diese Widersprüche sprechen dann doch wieder dafür, den Temperaturmessungen das letzte Wort zu lassen.

=> Da CO2 aber Infrarotstrahlung in einem bestimmten Wellenbereich (hauptsächlich bei 15 Mikrometer) absorbiert und emittiert, lässt sich leider auch das Gegenteil nicht beweisen. Sehr geehrter Herr Dr. Ullrich,das Problem ist dass die natürlichen Schwankungen die Temperaturwirksamkeit des CO2 deutlich überwiegen so dass man mit Beobachtungsdaten kaum zu brauchbaren Ergebnissen kommen kann. Und da IPCC-Modelle mit etwa 5fach zu hoher CO2-Sensitivität (einem Fake aus Eisbohrkernen) sowie mit falschen C-Modellen rechnen, entstehen noch grössere Diskrepanzen welche die Verwirrung nur verschlimmern.Man sollte aufhören, wegen der Fehlinterpretation des 2.HS über ja/nein zu streiten. M.E. kann man nur mit korrekten strahlungsphysikalischen Berechnungen sowie mit richtiger C-Modellierung (Senkenflüsse nicht nur zur Hälfte proportional zur Emission, sondern gänzlich zum ppm-Anstieg gegenüber vorindustriell, Halbwertszeit etwa 38 Jahre) den tatsächlich sehr geringen CO2-Temperatureinfluss ermitteln, welcher CO2 auf ein SCHEINPROBLEM (!) reduziert. Die Berechnungen ergeben z.B. dass die völlige Dekarbonisierung Deutschlands langfristig nur 0,01 Grad bringt. Ich empfehle nochmals https://www.fachinfo.eu/dietze2018.pdf sowie http://www.fachinfo.eu/dietze2020.pdf (engl. Version 2020e.pdf).

Wenn die CO2-Klimasensitivität bei 1,6 Grad C liegt, wie Sie, Herr Dietze, es errechnet haben und ich tendiere auch zu dieser Größenordnung, dann müssten bisher in der Tat die natürlichen Einflüsse überwiegen. Allerdings sind kürzer-periodische Schwankungen wie die AMO im 120-Jahres-Trend in der ersten Grafik oben bereits weitgehend herausgemittelt. Trotzdem, Theorie bleibt Theorie. Die Betrachtung der Temperaturkurven sagt zwar wenig über die Ursachen aus. Doch die ganze Welt wird alarmiert wegen der Temperaturen („1,5 -Grad-Ziel“ und ähnlicher Quatsch…), deshalb ist es, denke ich vernünftig, erstmals nachzusehen, wie sich die Temperaturen tatsächlich entwickeln. Aber deswegen schon heute ein Dekarbonisierungs-Harakari-Programm anzuzetteln, das ist abenteuerlich, da gebe ich Ihnen recht. Die Dramatik dafür ist auch bei den realen Temperaturen nicht zu erkennen, was ich versucht habe, nachzuweisen.

Sehr geehrter Herr Dr. Ullrich, die Verdoppelungssensitivität des CO2 im Gleichgewicht (mit Wasserdampf, Feedback sowie Wolken – unterhalb derer das CO2 weitgehend wirkungslos ist) beträgt real nur 0,6 Grad. Die Betrachtungen der beobachteten (transienten) Temperaturerhöhungen seit vorindustriell sowie die Extrapolationen beruhen m.E. auf einem Missverständnis. Der Anteil des anthropogenen CO2 daran beträgt nur etwa 25%, und nur dieser Anteil – und NICHT der Einfluss von Sonne und Wolkenbedeckung etc. (d.h. nicht die tatsächlich zu erwartende Temperaturentwicklung) – ist doch Gegenstand der Projektionen.

Versuch: Man nehme eine Metallplatte mit Temperaturmessung und zwei regelbare Wärmequellen nebeneinander oberhalb. Zunächst haben alle Elemente eine gemeinsame Temperatur der Umgebung. Dann führe man der ersten Wärmequelle Energie zu, um sie wärmer als die Metallplatte zu machen. Wenn man die Wärmequellen oberhalb der Metallplatte anordnet, wird nach unten hin hauptsächlich Wärmestrahlung wirken und kaum ein thermodynamischer Effekt, weil erwärmte Luft aufsteigt und nicht nach unten fällt. Mit mehr Aufwand könnte man all das natürlich auch im Vakuum machen. Es wird sich ein Zustand einstellen, daß die empfangende Metallplatte eine Temperaturerhöhung erfährt, bis wieder ein thermisches Gleichgewicht herrscht. Man regle die Wärmequelle so, daß eine Temperaturerhöhung beim Empfänger von 10°C erfolgt. Dann mache man einen zweiten Versuch. Nach Abkühlung regle man die zweite Wärmequelle so weit, daß der Empfänger eine Temperaturerhöhung um 5°C erfährt. Und schließlich schalte man beide Wärmequellen gemeinsam ein. Welche Temperatur wird die empfangende Metallplatte bekommen?

Wieso nehmen Sie eine Metallplatte? Metall reflektiert Wärmestrahlung gut und absorbiert deswegen wenig ( nur so 5-10%), nehmen Sie was Dunkles im IR.

Temperaturmacher:

Es geht nur darum, das Prinzip zu erkunden. So lange beide Wärmequellen wärmer als die gemeinsame Umgebungstemperatur sind, werden sowohl die starke als auch die schwache einzeln einen Wärmezuwachs beim Empfänger bewirken und beide zusammen zumeist einen etwas höheren.

Man kann nun variieren und eine Wärmequelle so stark machen, daß sie z. B. den Empfänger um 20°C über die Umgebungstemperstur erwärmt. Wenn man nun die zweite Wärmequelle auf eine Sendetemperatur regelt, die knapp unterhalb der um 20°C aufgewärmten Empfängerplatte liegt aber doch höher ist als die Umgebungstemperatur, dürfte gem. 2. HS ein Dazuschalten dieser Quelle keine zusätzliche Weitererwärmung des Empfängers bewirken.

Das beweist, daß die häufig gehörte Behauptung, einzelne Strahlungsquanten „wissen nicht“, wo sie dazugehören, falsch ist! Sie „wissen es“ natürlich genau! Der 2. HS ist nämlich auch für Strahlung gültig.

Noch extremer wird die Sache, wenn man bedenkt, daß es sich beim Versuch um einen strahlenden Körper(!) handelt.

Bei CO2 handelt es sich um einzelne Gasmoleküle, die im Gegensatz zum breiten Strahlungsspektrum eines Körperstrahlers spektral ganz eng begrenzt strahlen und allesamt kühler als der Boden sind. Welche Schlußfolgerung ergibt sich daher bezüglich einer Gegenstrahlungswirkung aufgrund von CO2?

=> ..die knapp unterhalb der um 20°C aufgewärmten Empfängerplatte liegt aber doch höher ist als die Umgebungstemperatur, dürfte gem. 2. HS ein Dazuschalten dieser Quelle keine zusätzliche Weitererwärmung des Empfängers bewirken.Herr Strasser, Sie verletzen hier den Energieerhaltungssatz und interpretieren den 2.HS immer noch so dass nur ein wärmerer Körper einen kälteren wärmer machen kann. Clausius hat 1887 leider (leistungs)beheizte Körper vergessen, die auch durch einen kälteren Körper wärmer werden können – soweit dieser wärmer ist als die Umgebung und damit zu einem reduzierten Wärmeverlust des beheizten Körpers führt.Bekannt ist dieser Effekt durch Wärmedämmung (z.B. auch Wintermäntel), aber ebenso durch Gegenstrahlung, welche Energie von kalt nach warm transportiert. Der Treibhauseffekt, der den 2.HS nicht verletzt, entspricht einer Behinderung der Strahlungskühlung, ist also eine „Strahlungsdämmung“. Man kann z.B. die Birne eines Diaprojektors zum Durchbrennen bringen wenn man einen Spiegel davor hält. Diese Effekte werden bis heute in der Thermodynamik NICHT behandelt. Daher der ewige Streit um den fehlinterpretierten bzw. unvollständigen 2.HS.

Was aber nun von „Ihrer (THE-)Seite“ ebenso immer wieder falsch dargestellt wird ist, daß ein Körper unter einem „Wintermantel“, wenn er seine Wärme zum fast ausschließlichen Teil durch die Strahlung von außen erhält, also keine eigene Wärmeentwicklung besitzt, auch nicht so warm wird, als einer ohne Wärmedämmung.

Die sogenannte Gegenstrahlung mit einer Wärmedämmung zu vergleichen, ist also nur für den sehr, sehr kleinen Teil der „Restwärme“ unseres Planeten zutreffend.

Das heißt also nichts anderes, als daß die Wärmedämmung in diesem Falle kühlt! Nutzt man technisch mit jeder Thermoskanne in der man im Sommer Kaltgetränke aufbewahrt.

Herr Brauns, Sie haben die „Strahlungsdämmung“ missverstanden. Diese entsteht nicht durch Dämmung der kurzwelligen solaren Einstrahlung (was Kühlung bedeuten würde), sondern durch zusätzliche Gegenstrahlung, welche sich aus der Absorption von thermischer Abstrahlung des Bodens in der Atmosphäre bildet und dessen Strahlungskühlung behindert – womit sich eine Erwärmung ergibt.

Hr. Dietze, ich will mit den Versuchen nicht ein System nachbauen, das der Erdsituation entspricht! Ich möchte lediglich belegen, daß der 2. HS richtig ist. Das kann man für Strahlungsenergie, die von Wärme verschiedener Temperaturen verursacht wird, schön zeigen. Die daraus sich ergebenden Schlußfolgerungen kann jeder selbst ziehen.

=> dürfte gem. 2.HS ein Dazuschalten dieser Quelle keine zusätzliche Weitererwärmung des Empfängers bewirken.

Herr Strasser, Sie zeigen keinesfalls, sondern behaupten (!) lediglich dass der 2.HS auch für Strahlung gilt. Er gilt schon nicht für Gegenstrahlung, die Energie von kalt nach warm transportiert. Dabei wird dem kalten Körper Wärme entzogen und bei Absorption im warmen Körper Wärme erzeugt. Dessen Temperatur steigt allerdings nur wenn er beheizt ist (also z.B. wie der Erdboden durch Solarstrahlung) – ansonsten erfolgt verzögerte Abkühlung.

Hr. Dietze, wenn Sie der Meinung sind, der 2. HS stimmt in manchen Fällen nicht, machen sie eine Studie, die diesen Umstand beweist. Dann lassen Sie diese Studie einer peer review unterziehen und wenn sie dann noch aufrecht ist, lassen sie sich als neuer Star im Universum der Experten für Wärmeübergänge feiern. Sie stellen sich dann auf eine Stufe mit Clausius, Planck, usw.

Viel Glück dazu! Technisch erspare ich mir einen Kommentar …