Roy W. Spencer und William D. Braswell zufolge, beide vom Earth System Science Center (ESSC) an der University of Alabama in Huntsville, ist die Magnitude der Reaktion der Bodentemperatur im Klimasystem auf ein herbei geredetes Ungleichgewicht bei der Strahlungsenergie – die Klimasensitivität – heute genauso unsicher wie sie es vor Jahrzehnten auch schon war. In einer atemberaubenden Studie unter dem Titel „On the Misdiagnosis of Surface Temperature Feedbacks from Variations in Earth’s Radiant Energy Balance“ [etwa: Über die Fehldiagnose der Feedbacks der Temperatur auf Variationen in der Bilanz der Strahlungsenergie der Erde], die im Journal Remote Sensing veröffentlicht worden ist, wird das Fehlen von Fortschritten bei der Verbesserung der Genauigkeit von Klimamodellen auf die Komplexität des Systems zurück geführt sowie auf die Unfähigkeit, Feedbacks im realen Klimasystem zu quantifizieren. In der Kurzbeschreibung (abstract) werden die von den Autoren gefundenen Ergebnisse gut zusammengefasst:

Die Sensitivität des Klimasystems hinsichtlich eines Strahlungsungleichgewichtes ist nach wie vor die größte Quelle der Unsicherheit bei Projektionen der zukünftigen anthropogenen Klimaänderung. Hier präsentieren wir weitere Beweise, dass diese Unsicherheit aus einer Beobachtungsperspektive hauptsächlich auf die Maskierung des Feedback-Signals durch den internen Strahlungsantrieb zurückzuführen ist, möglicherweise aufgrund natürlicher Veränderungen der Bewölkung. Dass diese internen Strahlungsantriebe existieren und wahrscheinlich die Diagnose des Feedback verschleiern, wird mit einer phasenverschobenen Regressionsanalyse und damit gekoppelten Klimadaten gezeigt und mit einem einfachen Feedback-Modell interpretiert. Während die satellitengestützten Messungen im Zeitraum 200 bis 2010 wesentlich in Richtung einer geringeren Klimasensitivität von den gleichen, von gekoppelten Klimamodellen simulierten Daten abweichen, sehen wir, dass es mit herkömmlichen Methoden nicht möglich ist, diese Diskrepanz hinsichtlich Feedbacks zur Klimasensitivität zu quantifizieren. Daraus schließen wir, dass die Diagnose des atmosphärischen Feedbacks zur Bestimmung der Klimasensitivität ein ungelöstes Problem bleibt, hauptsächlich wegen der Unfähigkeit, zwischen Strahlungsantrieb und –feedback aus dem mit Satelliten ermittelten Strahlungshaushalt zu unterscheiden.

Sie glauben, dass die wesentliche Schwierigkeit bei der Diagnose des Klimafeedbacks in der „Verunreinigung des Feedback-Abdrucks“ durch unbekannte Strahlungsfaktoren besteht, die intern erzeugt werden. Ein Beispiel eines solchen ‚unerzwungenen’ Feedbacks ist die natürliche Veränderung der Bewölkungsmenge. „Einfach gesagt, Strahlungsänderungen hervorgerufen durch Temperaturänderungen (feedback) können nicht so leicht von den Strahlungsänderungen getrennt werden, die eine Temperaturänderung verursachen (Antrieb)“, stellen die Autoren fest.

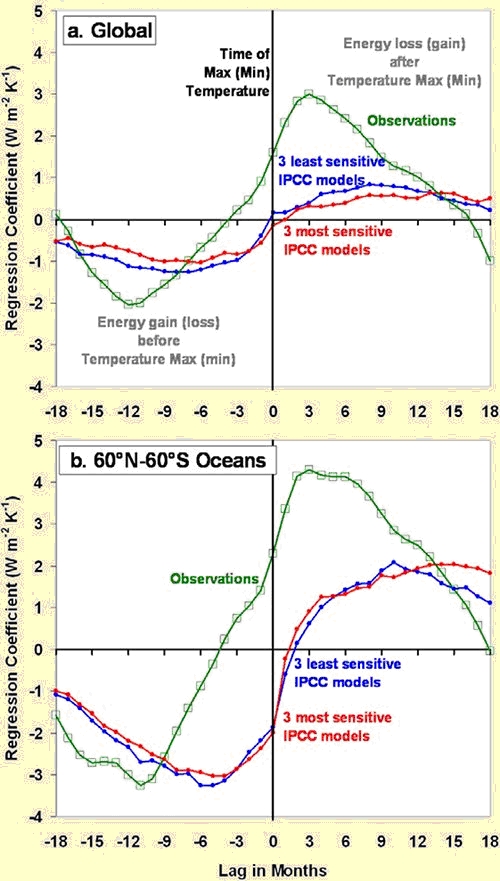

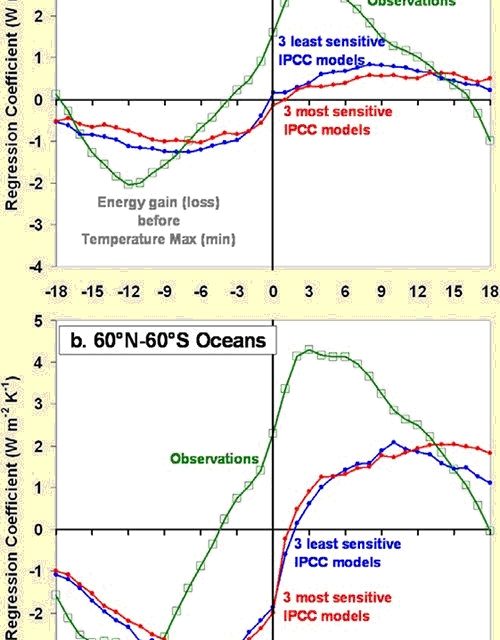

Zur Durchführung ihrer Analyse unterzogen die Autoren die Temperatur und die Strahlungsflüsse einer phasenverschobenen Regressionsanalyse. Die sich daraus ergebenden Regressions-Koeffizienten werden unten in der Abbildung dargestellt. Auflistungen der globalen Anomalien (a) und Anomalien, die nur aus Daten der globalen eisfreien Ozeane (b) stammen, werden separat gezeigt.

Phasenverschobene Regressionen zwischen der Temperatur und dem Strahlungsfluss

Die offensichtlichste Schlussfolgerung aus der obigen Abbildung lautet, dass die Satellitenbeobachtungen und die Klimamodelle ein markant unterschiedliches zeitabhängiges Verhalten zeigen. Temperaturunterschiede im Vergleich mit Variationen der Strahlung zeigen sich besonders über den Ozeanen. Man beachte die Änderung des Vorzeichens des Strahlungsungleichgewichtes, welches davon abhängt, ob die Strahlung[sänderung] vor oder nach der Temperatur[änderung] liegt. Die Modelle stimmen mit den realen Messungen ganz klar nicht überein. Die Daten, die für diese Studie genutzt worden sind, waren monatliche Anomalien des globalen Mittels der Temperatur von HadCRUT3 und Strahlungsflüsse gemessen von Terra CERES SSF Edition 2,5; und zwar im Zeitraum März 2000 bis Juni 2010.

Klimasensitivität wird allgemein so definiert: wie stark wird sich der Planet erwärmen, falls sich das Niveau des atmosphärischen CO2-Gehaltes verdoppelt? Die Beobachtungen von Spencer und Braswell lassen Versuche als albern erscheinen, die Klimaänderung auf nur einen einzigen Grund zu reduzieren. Natürlich ist dies nicht der erste Beitrag, aus dem hervorgeht, dass Klimamodelle keine akkurate Repräsentation des realen Klimasystems darstellen (siehe “The Sensitive Kind”).

Jüngste Untersuchungen haben gezeigt, dass die Modelle katastrophale Änderungen nicht vorhersagen können (hier). Jetzt haben Spencer und Braswell gezeigt, dass die Modelle nicht einmal in der Lage sind, die Änderungen von Tag zu Tag korrekt wiederzugeben. In der abschließenden Diskussion zu dieser Studie drücken sie es so aus:

Ein einfaches Modell des Antriebs-Feedbacks [?] zeigt, dass dies das Verhalten ist, das man von strahlungsbedingten Temperaturänderungen erwarten kann, und es ist mit Überlegungen hinsichtlich der Energieerhaltung konsistent. In solchen Fällen ist es schwierig, die Feedback-Parameter mit Regressionsverfahren abzuschätzen.

Im Gegensatz dazu würden vorherrschend nicht strahlungsbedingte Temperaturänderungen eine relativ genaue Diagnose der Feedback-Parameter mit Regressionen ohne Zeitverzögerung erlauben, da der größte Teil der Strahlungsvariabilität aus dem Feedback kommen würde. Unglücklicherweise scheint dies weder in Satellitenbeobachtungen noch in gekoppelten Klimamodellen der Fall zu sein.

Dies führt die Autoren zu der Schlussfolgerung, dass es eine „ziemlich große Diskrepanz“ zwischen dem Einfluss der Strahlung, wie sie das reale Klimasystem zeigt und von Satelliten gemessen wird, und den Klimamodellen gibt. Was bedeutet das für die Abschätzung der Klimasensitivität, einem der Lieblingsspiele der Klimawissenschaftler? „Während diese Diskrepanz nominell in Richtung einer geringeren Klimasensitivität des realen Klimasystems geht, gibt es eine Reihe von Parametern abweichend von Feedback, die die phasenverschobene Regressionsstatistik beeinflussen, so dass es schwierig ist, das genaue Feedback zu diagnostizieren.“ Mit anderen Worten, obwohl es schwierig ist, das zu beziffern, sagt ihre Analyse, dass sie niedriger liegt als die Angaben, die von den Alarmisten benutzt werden.

„Die Satellitenbeobachtungen weisen darauf hin, dass viel mehr Energie während und nach einer Erwärmung in den Weltraum abgestrahlt wird als die Klimamodelle zeigen“, sagt Spencer in einer Presseerklärung der University of Alabama. „Es gibt eine gewaltige Diskrepanz zwischen den Daten und der Vorhersage, die über den Ozeanen besonders groß ist“.

„Auf die Spitze getrieben zeigen die Satelliten, dass Energie verloren geht, während die Klimamodelle immer noch davon ausgehen, dass Energie gewonnen wird“, sagte Spencer. Also sind die Modelle falsch, aber können sie mit lediglich einigen weiteren Optimierungen verbessert werden, wie die Modellierer behaupten? „Das Hauptergebnis dieser Untersuchung besteht darin, dass es keine Lösung für die Messung des atmosphärischen Feedbacks gibt, hauptsächlich wegen unserer Unfähigkeit, zwischen dem Strahlungsantrieb und dem –feedback in unseren Beobachtungen zu unterscheiden“. Mit anderen Worten, die Modelle werden weiterhin falsch sein.

Diese Ergebnisse belegen ein weiteres Mal, wie inadäquat heute Klimawissenschaft betrieben wird: Die Modelle sind falsch; unser Wissen des Systems Erde steckt voller Lücken und Fehler; und die Komplexität des Systems macht jeden Versuch akkurater Vorhersagen zunichte. Die Studie illustriert auch die Überlegenheit von realen Daten über computererzeugte Ratereien. Die Zeloten der globalen Erwärmung sind vor eine harte Wahl gestellt – entweder sie bestehen weiterhin darauf, dass ihre Modelle genau sind, und geben alle Ansprüche auf, echte Wissenschaftler zu sein, oder sie geben zu, dass ihre Vorhersagen der zukünftigen Klimakalamität keinerlei Grundlage haben.

Wenn ein Arzt eine Krankheit falsch diagnostiziert und mit einer Behandlung fortfährt, die dem Patienten schadet, nennt man das Fehldiagnose. Ein weltumspannendes Kader von Klimapfuschern hat das irdische Klimasystem fehldiagnostiziert und Regierungen gedrängt, drakonische Maßnahmen durchzuführen, um die Krankheit der globalen Erwärmung zu „heilen“. Es ist höchste Zeit, dass diese wissenschaftlich Inkompetenten der Fehldiagnose bzgl. der Klimaänderung angeklagt werden, und dass sie für die Schäden, die sie damit angerichtet haben, bestraft werden.

Alles Gute, genießen sie das Interglazial und bleiben Sie skeptisch!

Doug L. Hoffman

Link: http://theresilientearth.com/?q=content/climate-malpractice

Übersetzt von Chris Frey für EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Hallo:

Schicke Ihnen gerne ein Exemplar meines Buches „Die Bedeutung der Naturgesetze für unsere Existenz“

Senden Sie mir dafür Ihre Postanschrift

Gruß

J.Bennewitz

Ich möchte auf mein Buch „Die Bedeutung der Naturgesetze für unsere Existenz“ , Novum Verlag, hinweisen, in dem u.a. die Klimafrage streng auf der Grundlage des 2. Hauptsatzes der Thermodynamik behandelt wird. Mathematisch nachvollziehbar.

Das Buch ist z.B. bei Amazon auf Lager

Mit freundlichem Gruß

Jürgen Bennewitz

Lieber Herr Fischer,

mit Politik hat meine Frage nichts zu tun. Politisch entscheiden kann man sich immer. Man muss dann nur mit den Unsicherheiten leben. Das ganze Konsensgejammere dient doch politisch nur dem Zweck sich den Unsicherheiten nicht stellen zu müssen. Ist in meinen Augen so etwas wie Feigheit.

Spencer ist sicher kein einfacher Mensch. Dessler war aber meiner Meinung nach schon im dem Disput mit Lindzen hinterfotzig, deshalb überrascht mich bei ihm nichts.

Und Schmidt zeigt ja sein Gesicht jedesmal in seinem Blog. Beides sind politische Aktivisten und können das nicht von ihrer Wissenschaft trennen meiner Meinung nach.

Mit freundlichen Grüßen

Günter Heß

Lieber Herr Bäcker und Herr Fischer,

das war der Kern meiner Abschätzung. Man kann zwar immer mehr Grips in die Auswertung stecken, aber was in den Rohdaten nicht steckt ist meistens auch nicht da, egal wie hochentwickelt die Auswertung ist.

Wenn also die Rohdaten schon die von mir beschriebene Messunsicherheit haben, war meine simple Frage nur, welche Auswertemethode das verbessern soll?

Oder anders ausgedrückt, wie genau können wir mit Proxys die Temperatur messen und wie genau können wir in der Vergangenheit den Strahlungsantrieb messen.

In letzter Zeit habe ich immer wieder Paper gelesen, die vorschlagen, dass die natürliche Variabilität im 20. Jahrhundert doch größer war als erwartet. Damit wäre zum Beispiel die „Optimal Fingerprint“ Methode von Hegerl et al. Makulatur und ihre Schlußfolgerung die im AR4 verwendet wurde hinfällig.

Mit freundlichen Grüßen

Günter Heß

Lieber Herr Hess, #24

wobei ja auch wohl kein Experte bezweifelt, dass die direkte Messung der Klimasensitivität nicht so einfach ist und Satellitenmessungen hier das beste ist, was messtechnsich zu bekommen ist.

Das Problem ist aber generell, dass man nicht die Antwort auf eine sprunghafte Änderung der Randbedingungen messen kann, denn die ist mit den anthropogenen Emissione nicht gegeben. Sondern man kann nur die reaktion auf sich transient ändernte Randbedingungen messen. Dies ist an sich kein Problem, aber erfordert eben mehr Grips bei der Auswertung. Und ohne eine modellunterstütze Auswertung bekommt man aber auch hier keine Klärung der Ursachen. So einfach macht es uns die Natur hier nicht.

Was Spencer nun zeigte, hat wohl wenig zu tun mit den Analysemethoden, die er bemängelt. Es zeigt vielmehr, dass es nach Spencers Methode nicht geht! Das ist aber auch kaum zu erwarten…Sie kennen ja selbst die überlagerten Fluktuationen und begrenzte Messgenauigkeit der Satelliten.

@21: Herr Andreas Zube, ich bin der gleichen Meinung wie Sie und sage hier ständig:: MESSEN, MESSEN, MESSEN, statt ständig gescheite Reden zu schwingen.

Ihre Vermutung, dass Satellitendaten noch sehr ungenaue Werte liefern, wird offenbar sogar von NASA Experten geteilt, denn diese fordern neue Satelliten mit wesentlich genaueren Messungen als in der Vergangenheit.

Auf der Basis der jetzigen Datenlage Billionen Dollar / Euro schon prophylaktisch zu verschleudern, wo wir doch beinahe am Abgrund des Währungssystems stehen, ist unverantwortlich. Aber das interessiert die besorgten Treibhaustheoretiker ja nicht.

Herr Bäcker,

Sie reden wie ein Politiker.

Darf ich Sie zuerst an Ihren geistigen Chef erinnern? Herr Schellnhuber sagt sinngemäß, das Klima ist kompliziert aber es gibt einen einfachen linearen Zusammenhang zwischen globaler Temperatur und CO2.

Roy Spencer behauptet nichts, er zeigt, dass die Abstrahlung sich nicht so verhält, wie in den Modellen vorgeschrieben, lt. den Messungen.

Herr Fischer und sein Königsweg,

„Mag sein, aber wenn wir am Ende des 21.Jdt. Bescheid wissen sollten, dann ist das wissenschaftlich sehr erfreulich, politisch aber zu spät.“

Auch Politiker? Wofür ist es zu spät? Neudeutsch heißt das jetzt “ Geld generieren“?

Deutsch heißt das Geldumverteilung?

Sie wollen also aus glazialen/interglazialen Paläodaten die Klimasensitivität berechnen?

Wollen Sie sich nicht erstmal, wie Pat Frank an der Zeit 1880 bis 2010 ausprobieren. Hätte den Vorteil, hier liegen GISS und CRU daten vor.

Ich wäre für letztes Jahrhundert und nicht nächstes Jahrhundert;-) Wäre auch lang genug für Herrn Bäcker;-)

@25 Herr Fischer, und deshalb was Sie in #25 sagen, auf Vorrat und weil die Besorgten (wie Sie, Bäcker, etc.) so gescheit sind, schon mal einige Billionen Euro / Dollar in den Sand setzen und die westlichen Wirtschaften schädigen durch CO2 Emissionsvermeidung und Abgaben auf CO2.

Mensch, merken Sie denn nicht, dass Sie soeben die Bankrotterklärung Ihres CO2 Weltbildes unterschrieben haben: „Wir können politisch nicht warten bis 2100, aber wissen tun wir jetzt trotzdem nichts Sicheres“

Wieso meinen Sie, dass man auf Vorrat soviel Geld aus dem Fenster hinauswerfen muss, bloss weil Schellnhuber sagt, der Meeresspiegel steigt bis 2100 um 1.9 Meter? MÜSSEN WIR DENN DEM HEILIGEN SCHELLNHuBER UNBEDINGT GLAUBEN??? Woher will er denn das wissen? Zur Zeit sind es ja angeblich 3mm pro Jahr (wenn das überhaupt stimmt): meinen Sie, es wird dann dann zwischen 2080 und 2100 jedes Jahr einige Zentimeter höhere Meeresspiegel geben, zu einer Zeit, wo Sie sich dann nicht mehr rechtfertigen können für Ihre Fehlprognosen (weil Sie ja dann vermutlich nicht mehr da sind)????

Liefern Sie härtere Fakten (und keine theoretischen Hirngespinste) wenn Sie schon Billionen Dollars / Euros dafür haben wollen.

#25: Norbert Fischer, es ist noch untertrieben, wenn Sie sich selbst Laie nennen.

Denn das Paleoklima widerlegt den CO2-Einfluss mit Temperatursprüngen nicht wie heute unterhalb von 1°C, auch nicht wie NB verharmlosend meint mit 3-4 °C sondern bis zu 10°C.

… und ausgerechnet da wollen sie ein „sensing“ berechnen können , ha, ha.

Ihre Aufgabe hier ist nichts anderes als gezielte Desinformation, ich wundere mich über die Großmut der Forenbetreiber.

Gruß

#23: Hallo NicoBaecker,

bitte auf Rechtschreibung achten.

Die Antwort auf Ihre Fragen kann Ihnen doch das Wood-Experiment geben.

CO2 kühlt,

wieviel ist erst mal zweitrangig.

Hallo Herr Heß

Zum „Königsweg“:

Es mag überraschen, aber ich habe diese Ansicht bei James Hansen, einem der Väter der Klimamodellierung gelesen. Leider habe ich die Quelle nicht wiedergefunden. Die Originalstudien findet man aber im Quellenverzeichnis bei Knutti/Hegerl in ihrem Überblicksartikel über die Methoden und Ergebnisse zur Bestimmung der Klimasensitivität.

Ganz grob also aus dem Gedächtnis:

Die Grundidee ist, zwei Zeiträume mit recht großen Temperaturdifferenzen zu finden, bei denen die Temperaturen im Gleichgewicht waren (Hinweis dafür ist die jeweilige längere Konstanz des Meeresspiegels). Ich gestehe vergessen zu haben, wie man das Forcing bestimmt hat, erinnere mich aber noch daran, dass gesagt wurde, der Großteil des Fehlers der Methode beruhe auf der Unsicherheit der Proxydaten (z.B. dem Zusammenhang zwischen Eisbohrkern“temperaturen“ und globalen Temperaturen) und nur zum kleinen Teil an der Bestimmung des Forcings (ich hätte es nämlich genau andersherum vermutet, deshalb erinnere ich mich noch). Die Fehlergrenzen waren etwas enger als im AR4 angegeben, Hansens Ansicht ist aber, dass gegenwärtig und in der näheren Zukunft keine exakte Bestimmung des Aerosolforcings möglich sein wird, und die Chancen, bei den Proxydaten Fortschritte zu machen, größer sind.

Der Vorteil der Methode liegt auf der Hand:

Die gegenwärtigen Unsicherheiten bei Feedbacks spielen keine Rolle, es kann keine Überraschung durch bislang unbekannte Feedbacks geben, die Feedbacks sind ja schon enthalten.

Was mir allerdings nicht so ganz klar ist, ob die damit gemessene Klimasensitivität auf unser heutiges Problem „passt“. Inwieweit spielen die „slow feedbacks“ heute eine Rolle, wenn man davon ausgeht, dass die atm. CO2-Konzentrationen in den nächsten Jahrhunderten wieder sinken werden (wenn auch das vorindustrielle Niveau nicht mehr erreicht werden wird)?

Zu den verschiedenen Klimasensitivitäten, Problemen bei der Messung der earth energy imbalance etc. lohnt sich ein Blick in dieses Mammutmanuskrript von Hansen: http://tinyurl.com/69gvkb9

„Mal ehrlich, ich halte den Königsweg in einer genauen Messung des Temperaturanstiegs und des Strahlungsantriebs im 21. Jahrhundert, wie es sich für die Naturwissenschaft gehört.“

Mag sein, aber wenn wir am Ende des 21.Jdt. Bescheid wissen sollten, dann ist das wissenschaftlich sehr erfreulich, politisch aber zu spät.

Warum erst am Ende des 21. Jhdts.? Ich denke, die Methode funktioniert erst dann, wenn der Temperaturanstieg groß im Vergleich zur natürlichen Variabilität ist.

Aber selbst dann gibt es noch jede Menge Probleme:

Selbst wenn bessere und längere Daten zu Wolken und Aerosolen dann zur Verfügung stehen werden, bleibt das Problem, das weiter zurückliegende Daten anders abgeschätzt werden müssen, man kennt das Problem bei der solaren Aktivität. Dass man keine Gleichgewichtstemperaturen hat, ist ebenfalls eine Erschwernis.

„Im Grunde ist das auch der wert des Spencer Papers, dieses Meßdilemma zu verdeutlichen.“

Da sehe ich sogar den Hauptwert, weshalb ich Trenberths Kritik zu hart finde, obwohl er einige Punkte gemacht hat. Was ich nicht so gelungen fand, ist der Umstand, dass das Ziel des Papers nicht klar genug rüberkommt. Eine Kritik an einigen Klimamodellen, wie die meisten meinen? Eine Kritik an Dessler 2010, wie ich meine? Der Disput um Desslers und Spencers konkurrierenden Paper ist bekannt, für uns Laien war es damals interessant, dass dieser nicht nur durch Paper, sondern zwischen Dessler und Spencer selbst öffentlich auf Spencers Blog ausgetragen wurde. In der Sache wurde hart gerungen, aber immer respektvoll, ich fand das damals sehr vorbildlich von beiden.

Deshalb überrascht es mich, Dessler hätte eine nicht so feine Reaktion jetzt gezeigt. Was ist da vorgefallen?

Herzliche Grüße

Lieber Herr Bäcker,

sie haben völlig Recht.

Mein Punkt ist jedoch simpel. Ohne genaue Messung kommen sie da nicht ran,vor allem nicht Paläodaten.

Da kann die Klimaforschung statistischen Preptalk, voran Schmidt und Dessler, benutzen wie sie wollen, das hat Spencer schön gezeigt. Mir reicht das.

Grüße

Günter Heß

Lieber Herr Hess,

die nichtradiativen stoerenden Fluktuationen, die Spencer einbezieht, zeigen ja, was los ist, naemlich, dass es wenig Sinn hat, mit Spencer anzunehmen, dass die Klimasensitivitaet eineKonstante waere. Es gibt keinen physikalsichen Grund, deiesen Paprmeter in den Status einer “ Systemkonstanten“ zu erheben. Vielmahr ist doch klar, dass man allgemein nach der Natwort bzw Transferfunktion zwischen radiativem Antrieb und Temperaturantwort sucht. Und Antwortfuktionen sind im allgemeinen selber Funktionen der Zeit bzw. durch eine spektrale Abhaengigkeit gekennzeichnet. Man sieht dies z.B. an der unterschiedlichen Klimasensitivitaet fuer die gerne untersuchten Spezialfaelle des transieten Treibhausgasanstiegs und des sprunghaften. Wenn Spencer nach der Klimasensitivitaet des Gleichgewichtszustandes nach impulsiver Treibhausgassprung sucht, so verletzt er ja mit seim Klimamodell die Oraussetzungen, denn die Relaxationszeit seines Modells liegt in der richtigen Groessenordnung fuer die schnelle Antwort der ozeanischen Deckschicht von 1 Dekade, aber die tieferen Schichten bewirken, dass das Gelichgewicht erst in 4 Dekaden erreicht ist. Aber selbst die schnelle Antwort ist noch zu langsam fuer Spencers Untersuchungszeitraum von 13 Jahren. Daher ist das Spencer lambda mit dem Lambda auf kliamtologischer Zeitskala nicht unbedingt gleich.

Lieber Herr Fischer,

sie schreiben:

„… dass ich bei der Bestimmung der Klimasensitivität die Methode aus der Bestimmung paläontologischer Daten beim letzten Übergang Glazial/Interglazial für den Königsweg halte“

Könnten sie die Methode mal genau beschreiben? Ich kenne jetzt die Methode nicht. Hätte aber folgende Anmerkung. Die Spannweite beim „Climate Sensitivity Parameter“ über die wir mit Ausnahmen streiten liegt zwischen 0.3 K/(W/m^2) Lindzen, Lüdecke, Link und 0.8 K/(W/m^2) GissE. Nehmen wir an wir könnten aus Paläontologischen Daten die Temperatur in einer Spannweite von 0.4K bestimmen. Die Messvorschrift für den „Climate Sensitivity Parameter“ wäre ja simpel: Messe in einem Zeitraum X den Temperaturanstieg und den Strahlungsantrieb.

Also zum Beispiel wir bestimmen für einen Zeitraum X, dass die Temperatur zwischen 1.8 und 2.2°C gestiegen ist. Dann müssten wir für diesen Zeitraum den Strahlungsantrieb in einer Spannweite von 2.7 W/m^2 und 6 W/m^2 genau bestimmen.

Wie genau haben wir denn den Strahlungsantrieb für das 20. Jahrhundert gemessen, inklusive „Cloud Radiative Forcing“ natürlich?

Plus/Minus 5 W/m2 oder genauer? Zitat wäre schön.

Mal ehrlich, ich halte den Königsweg in einer genauen Messung des Temperaturanstiegs und des Strahlungsantriebs im 21. Jahrhundert, wie es sich für die Naturwissenschaft gehört.

Im Grunde ist das auch der wert des Spencer Papers, dieses Meßdilemma zu verdeutlichen. Wir können nicht genau genug messen. Die Große Schwäche des Spencer Papers sind sicher die fehlenden Fehlerbalken. Für die Fehlinterpretationen im Internet kann er nichts.

Für mich hat es einen weiteren Wert der nicht wissenschaftlich ist. Die Art und Weise wie Aktivisten wie Gavin Schmidt und Andrew Dessler reagieren ist menschlich sehr erhellend. Die verlieren für mich die letzte Glaubwürdigkeit.

Mit freundlichen Grüßen

Günter Heß

Passend zu diesem Thema sind die Auflistung der Satellitendaten bei Climate4You doch ganz interessant:

http://tinyurl.com/yen7ujg

Insbesondere der Teil, wo die abgestrahlte, langwellige Strahlung gegenüber der Entwicklung des CO_2-Gehaltes aufgetragen ist (ein wenig tiefer scrollen):

http://tinyurl.com/3gjd4ly

Aus den Daten eine Korrelation zwischen CO_2-gehalt und ausgehender langwelliger Strahlungzu schließen ist in meinen Augen nichts weiter als Spekulation, jetzt nur bei Betrachtung der reinen Daten:

Zeigt sich global zwischen 90N bis 90S ein Minimum von ca. 231 W/m^2 bei ca. 355 ppm CO_2 und bei 393 ppm CO_2 eine angestiegene Strahlungsleistung auf ca. 235 W/m^2 (immerhin ein Anstieg von 4 W/m^2).

Etwas, was nach „gängiger Lehrmeinung“ bezüglich der Wirkung eines steigenden CO_2-Gehaltes eigentlich nicht der Fall sein sollte. Und jetzt? Diese Werte decken sich anscheinend weder mit der schwankenden Wolkenbedeckung in dem gleichen Zweitraum, noch mit der AMO.

Zwei Erklärungsmöglichkeiten fallen mir dazu ein:

1. Die Satellitendaten sind fehlerhaft

2. Die Betrachtung der Klimasensivität von CO_2 bezogen auf das Gesamtsystem Erde entspricht nicht dem Labormodell. Entweder CO_2 verhält sich nicht so, wie man es eigentlich vermutet (weil die Wirkung anderer Effekte entweder unterschätzt oder gar nicht betrachtet wurde), und/oder aber es gibt viel stärkere Gegekopplungseffekte, als man bisher dachte.

In Anbetracht der Tatsache, dass man Messfehler bei Satelliten durch Vergleichsmessungen verifizieren kann und wir bezüglich des Klimasystems Erde noch viel zu wenig wissen, vermute ich eher letzteres.

Und letztendlich zählt doch nur, was unter dem Strich heraus kommt und das muss wissenschaftlich fundiert sein. Ob nun pro oder contra CO_2-Hypothese: Nachvollziehbare bis völlig groteske Beweisführungen existieren auf beiden Seiten und irgendwo dazwischen liegt die Wahrheit. Nur in Anbetracht der Faktenlage tendiere ich seit längerer Zeit dahin, dass die Wirkung im Gesamtklimasystem (vorsichtig ausgedrückt) überschätzt wurde.

@ G. Innerhofer #19

„Man kann sich vorstellen, …“

Wenn Sie Naturwissenschaft tatsächlich erfolgreich – im Fach Meteorologie mit dem geschützten Titel ‚Diplom-Meteorologe‘ – abgesclossen hätten, würden Sie solch einen Dummfug nicht schreiben.

Meteorologie ist einerseits eine Naturwissenschaft, aber im Bereich der Vorhersage (Synoptik) „nur“ eine Erfahrungswissenschaft.

Die Meteorologen der synoptischen Disziplin arbeiten mit „Vorstellungen“, die Forscher jedoch nicht. Die arbeiten mit viel Mathematik, Differentialgleichungen und deren numerischer Lösung und Physik.

Und dann gibt es da noch die Messenden, deren Beitrag zum Verständnis der mit quasi unendlich vielen Freiheitsgraden zu beschreibenden Atmosphäre von den „Modellierern“ unterschätzt wird, denn die brauchen keine billigen Supercomputer, sondern teure Meßnetze.

Hallo Herr Fischer,

„Feedback über Paläoklimaanalyse-Königsweg!“

Genau mein Aufhänger.

Und jetzt nur ganz kurz dazu: nehmen wir das letzte Interglaziel mit seinen ca. +2-3°C über heute global und gegen Höhepunkt hin um 60 Watt/m² mehr Insolation um 65°N.Sommerhj. Man kann sich vorstellen, was das über Jahrhunderte für die Eismassen im Norden bedeutet hat. Dennoch, alles erdenkliche wirkte positiv in Richtung weiterer Erwärmung, die Ozeane verlieren CO2, das Albedo nimmt deutlich ab usw. Alleine die Abnahme der Insolation über N65 Sommer war entscheidend für die Kehrtwende der T. Der um 100ppm angestiegene CO2 Gehalt konnte die folgende Abkühlung max. etwas bremsen.

Wie auch immer, ich sehe auch hier einen möglichen erfolgreichen Weg diese sg. Sensitivität genauer bestimmen zu können.

Sehr geehrter Franz Zuber

Ich habe die Pressemitteilung Spencers ebenfalls mit Interesse gelesen, vor allem im Hinblick darauf, was durch sein Paper gedeckt ist. Meines Erachtens lehnt sich Spencer mit seiner Presseerklärung recht weit aus dem Fenster, sie passt m.E. in die Reihe zahllos unglücklicher Pressemitteilungen, die anscheinend eher das Ziel verfolgen, mediale Aufmerksamkeit zu erheischen als seriös über die Ergebnisse zu berichten (wir hatten dies zuletzt z.B. beim IPCC-Report über Erneuerbare Energien). Mein Rat: Lesen Sie in Spencers Paper nur mal den abstract, dort finden Sie diese Aussagen in dieser Schärfe nicht.

Zum Kiehl/Trenberth-Diagramm:

Beachten Sie bitte, dass dies sowieso eine vereinfachte Darstellung ist. Eine Kritik an diesem Diagramm kann ich dem Paper Spencers auch nicht entnehmen.

@#17

„Es wäre interessant von Ihnen zu hören, wie Sie die Aussage von Spencer sagen, dass die Klimamodelle mit einiger Wahrscheinlichkeit in einem entscheidenden Punkt falsch parametrisiert sind, und deswegen viel zu hohe Temperaturen für die Zukunft voraussagen.“

An dieser Stelle war ich mir über die Konsequenzen Spencers Kritik – falls korrekt – nicht sicher. Wie ich oben schrieb, fand ich Abschnitt 2 in Spencers Paper interessant, dort hatte er mit Daten des Terrasatelliten festgestellt, dass (einige, s.u.) Klimamodelle die zeitliche Verzögerung, die in den Daten sichtbar sind, nicht korrekt reproduzieren.

Ok, so weit, so klar. Jetzt bin ich mir allerdings unsicher, was die Konsequenzen angeht:

– betrifft dies dann nicht nur die zeitliche Abfolge der Erwärmung, nicht aber den Endzustand?

– betrifft dies im Grunde nur die z.B. durch ENSO verursachte natürliche Variabilität oder auch das Langzeitverhalten der Programme?

Kann mir jemand hier vielleicht weiterhelfen?

Interessant dazu Trenberths Beitrag bei RealClimate:

Trenberth zeigt, dass Spencers Auswahl der Simulationsprogramme nach dem Wert ihrer Sensitivität unpassend ist. Hätte Spencer die Modelle ausgewählt dahingehend, ob sie ENSO gut bzw. schlecht reproduzieren, wäre das Ergebnis anders gewesen. Trenberth u. Fasullo zeigen, dass Modelle, die ENSO gut reproduzieren, auch die von zeitliche Verzögerung recht gut reproduzieren. Das zeigt, dass Spencers Kritik – falls berechtigt – nicht für alle Modelle gilt.

Zum Abschluss noch etwas Positives:

Ich sehe den Wert Spencers Paper darin, die Feedback-Analysen mit CCMs kritisch zu hinterfragen und könnte mir vorstellen, dass an dieser Kritik etwas dran sein könnte. Wenn Sie meine Beiträge schon etwas länger verfolgen, dann wissen Sie vielleicht, dass ich bei der Bestimmung der Klimasensitivität die Methode aus der Bestimmung paläontologischer Daten beim letzten Übergang Glazial/Interglazial für den Königsweg halte.

Eben genau deshalb, weil bei dieser Methode keine Feedbackanalysen benötigt werden. Im gemessenen Wert der Erwärmung stecken ja schon alle Feedbacks (und ein Svensmarkeffekt – falls es diesen gibt) drin!

Ich unterscheide mich allerdings in einer Nuance von Spencer: Ich halte die Unsicherheit bei Aerosolen für den maßgeblichen Punkt.

Herr Fischer, ich glaube, dass das Hauptanliegen von Spencer & Braswell keinesfalls „z.B. bei der Kritik an Desslers Paper aus dem Jahre 2010“ ist, wie Sie es ausdrücken, sondern, dass es nach der Analyse der Terra Daten sehr gut möglich ist, dass die Klimamodelle des IPCC zu alarmistische Temperaturen ausrechnen aufgrund falscher Parametrieierungen. Dies ist der eigentliche Sprengstoff des paper.

Und dass Sie dies wieder einmal nicht kommentieren, entspricht Ihrer Taktik des gezielten Weglassens Ihnen unangenehmer Argumente, aber stattdessen auf Nebenschauplätzen irgendwelche Haare in der Suppe zu suchen, um dann den Anschein zu erwecken, als wäre das dann das Wichtigste.

Es wäre interessant von Ihnen zu hören, wie Sie die Aussage von Spencer sagen, dass die Klimamodelle mit einiger Wahrscheinlichkeit in einem entscheidenden Punkt falsch parametrisiert sind, und deswegen viel zu hohe Temperaturen für die Zukunft voraussagen.

@12 Herr Fischer, haben Sie den Spencer Artikel wirklich gelesen ? (Der erste wären Sie natürlich keineswegs, der den Artikel gelesen hat)

Merkwürdig, dass Ihre Zusammenfassung so gar nicht zum den Statements von Herrn Spencer selbst passt: Spencer sagte ja in der Presseerklärung:

„Die Satellitenbeobachtungen weisen darauf hin, dass viel mehr Energie während und nach einer Erwärmung in den Weltraum abgestrahlt wird als die Klimamodelle zeigen“ und „Es gibt eine gewaltige Diskrepanz zwischen den Daten und der Vorhersage, die über den Ozeanen besonders groß ist“. Außerdem: „Auf die Spitze getrieben zeigen die Satelliten, dass Energie verloren geht, während die Klimamodelle immer noch davon ausgehen, dass Energie gewonnen wird“

Wie konnten Sie dies überlesen? Wollen Sie ernsthaft behaupten, dass ausgerechnet Sie alles besser wissen als die Originalautoren von wissenschaftlichen Arbeiten, die in Journals mit peer-review erschienen sind.

Eine sich aus Spencer & Braswell sich logisch ableitende Konsequenz ist doch, dass das Kiehl&Trenberth Schema, auf dem der IPCC aufbaut, offensichtliche und gravierende Lücken hat. Nicht nur das: das dort angeführte atmosphärische Fenster für die direkte Abstrahlung von der Erde ins All von ca. 40W/m2 liegt offenbar katastrophal daneben. Was das für das AGW Weltbild bedeutet muss ich Ihnen wohl nicht erklären ! Es ist eine echte Katastrophe !!

Guten Tag,

danke für diesen Artikel.Man steckt immense Summen

in Computer , die dann unser Wetter und die Klimaentwicklung berechnen und vorhersagen können.

Und dann kommt heraus , daß diese Computersimulationen nichts taugen.

Kohlendioxid ist ein Spurengas und das meiste wird von der Natur selbst produziert.

Wo sollen auch 0,03 Prozent Kohlendioxid in der Atmosphäre

die Energie herholen und die restlichen 99,97 Prozent derGase in der Atmosphäre aufzuwärmen?

Und da das Kohlendioxidmolekül Strahlung bei 15 Mikrometer absorbiert , emittiert es auch hier.

Der Hauptstrom der Temperaturstrahlung der Erde geht folglich ungehindert an den Kohlendioxidmolekülen vorbei.

Eingedenk dieser Tatsache ist die Folgerung klar:

Die auf Computersimulationen beruhenden Aussagen bzgl.der sogenannten Erderwärmung kann man getrost auf den Müllhaufen der Geschichte werfen.

mfg. T.Peschka

Es wurde im – von Herrn Frey wieder hervorragend übersetzten – EIKE Artikel oben gesagt, dass die wesentliche Schwierigkeit bei der Diagnose des Klimafeedbacks in der „Verunreinigung des Feedback-Abdrucks“ durch unbekannte Strahlungsfaktoren besteht, die intern erzeugt werden. Ein Beispiel eines solchen ‚unerzwungenen’ Feedbacks sei

die natürliche Veränderung der Bewölkungsmenge.

Daraus lässt sich auch ableiten dass das Trenberth Schema viel zu simpel ist, offenkundige Mängel hat, indem zusätzliche Strahlenfaktoren bestehen, die im Schema fehlen. Das Trendberth Schema ist ja ohnehin falsch, da ja die Grösse des Atmosphärischen Fensters bedeutend grösser ist, als Kiehl&Trendberth angegeben haben.

Auch aus diesen Gründen sind die Grundannahmen für die Klimamodelle falsch und hinfällig, ergo rechnen sie völlig falsche zuküftige Temperaturen aus. Aber ein lineares chaotisches System lässt sich ohnehin nicht ausrechnen.

Herr Frey, Sie haben ntürlich völlig recht: in der Naturwissenschaft ersetzt nichts die Überprüfung der Hypothese durch das Experiment, die Beobachtung der Realität. Da hat die nur modellierende IPCC Klimawissenschaft ihre grösste Schwäche, und ihre Verfechter auch hier im Forum kneifen da auch regelmässig das zuzugeben.

@ zuber

Wahrscheinlich, aber nicht bekannt.

Den Schreibfehler im Nachnamen gibt’s nicht so häufig. (eigentlich Ploeger)

Vermutlich bin ich der erste, der Spencers Paper überhaupt gelesen hat, Zeit also für ein Resümee aus der Perspektive des interessierten Laien:

Abschnitt 1 und 2 fand ich interessant und lesenswert. Abschnitt 3 finde ich bedenklich, weil es meines Erachtens ein solch primitives Modell wie das von Spencer solche Schlussfolgerungen nicht erlaubt. Wer die „conclusions“ im Schlussabschnitt liest, wird feststellen, dass einiges davon hypothetischer Natur ist und auf einer tönernen Basis beruht.

Ein Urteil kann ich mir aber definitiv erlauben:

Im übersetzten Text des mir unbekannten Autors stehen viele Äußerungen, die von Spencers Paper nicht gedeckt sind. Der Autor projiziert in Spencers Paper seine persönlichen Meinungen hinein, was Spencers Arbeit nicht verdient hat.

Nein, das Paper ist nicht revolutionär, es wirft nichts über den Haufen, es beinhaltet allerdings interessante Denkanstöße, z.B. bei der Kritik an Desslers Paper aus dem Jahre 2010, worin ich auch das Hauptanliegen Spencers sehe.

seit wann werden denn hier wieder die übelsten Forentrolle freigeschaltet?!?

Hallo zusammen,

gerade habe ich zu einem anderen EIKE-Artikel unter der Rubrik Energie (zur Wärmedämmung) mich erfreut geäußert, auf welchem kompetenten und sachlichen Niveau dort gegensätzliche Standpunkte ausgetauscht werden. Hier ist es genau anders herum. Das macht KEINEN Spaß zu lesen!

Muss die verbale Ballerei sein? Ich habe im Artikel auch nur den Begriff Messungen bzw. Beobachtungen gefunden – im Vergleich zu den Modellen der AGW-Fraktion. Was ist daran schlecht? Sollte man nicht IMMER Messungen mit den Modellen vergleichen? Macht die AGW-Fraktion das?

fragt der Übersetzer Chris Frey – mit der dringenden Bitte um mehr Sachlichkeit!

@2 Herr Plöger, Sie sind doch hoffentlich nicht mit dem XXXXXXXXXX Wettermoderator Sven Plöger vom Kachelmann-Team verwandt ?????

Herr Hartmann, können Sie nicht lesen, oder erschliesst sich Ihnen der Sinn des Statements von Herrn Spencer (s.u.) aus irgend einem anderen Grund nicht?

Wiederholung aus dem Artikel oben (zu Ihrer gefälligen Erinnerung):

„Die Satellitenbeobachtungen weisen darauf hin, dass viel mehr Energie während und nach einer Erwärmung in den Weltraum abgestrahlt wird als die Klimamodelle zeigen“, sagt Spencer in einer Presseerklärung der University of Alabama. „Es gibt eine gewaltige Diskrepanz zwischen den Daten und der Vorhersage, die über den Ozeanen besonders groß ist“.

Was daran ist so schwer zu verstehen, Herr Hartmann, oder wissen Sie es aus einem geheimnisvollen Grund besser als der angesehene Wissenschaftler???

@5 Fischer, es würde auch Ihnen gut anstehen, einem verdienstvollen hochangesehenen Wissenschaftler wie Prof. Spencer die gebührende Achtung zu zollen. Aber nein, Fischer kann das nicht, er ist einfach überfordert. Wahrscheinlich ärgert er sich, dass er es nur zu einem Forenschreiber gebracht hat und nicht zu einem umjubelten Forscher. Ja, damit werden Sie leben müssen. Viel Glück bei der Verarbeitung …

@5 Fischer, das ist aber nicht etwa jener Trenberth der sein falsches Schema bezüglich der Grösse des atmosphärischen Fensters von 40W/m2, wider besseren Wissens von besseren Daten, nicht korrigiert hat? Ich bitte um Aufklärung, Herr Fischer!

Herr Lüdecke schreibt in #1:

„Spencer und Braswell bedienen sich keines Modells und schon gar nicht eines, das unphysikalisch ist.“

Haben wir dasselbe Paper gelesen? Im Abstract wird es erwähnt und auf S.1 erläutert.

Auch ich bin wie Hr. Hartmann überrascht, dass Leute, die hier regelmäßig die wenigen freien Parameter bei Simulationen kritisieren, bei Spencers Modell nicht aufschreien. Auch hier scheint zu gelten: Wenn das Ergebnis in die gewünschte Richtung zeigt, dann ist alles erlaubt und in Ordnung.

Und so warte ich als skeptischer Mensch immer noch auf eine Begründung, warum Roy Spencer mit seinem Paper richtig liegen soll und alle anderen falsch.

Ansonsten:

Trenberth hat gezeigt, dass Spencers Behauptung, die Werte würden den Klimamodellen widersprechen, nicht haltbar ist. Die Werte liegen in den Fehlerbereichen (s. Beitrag bei RealClimate)

PS:

„Einer neuen Studie zufolge haben Klimawissenschaftler die Feedbacks der Bodentemperatur fehlgedeutet,…“

So so. Ich bin vorsichtig mit solch vorschnellen Urteilen und erinnere daran, dass es eben dieser Spencer war, der jahrelang die Satellitendaten zur globalen Temperatur fehlgedeutet hat. Auch damals waren es andere, die ihm auf die Sprünge helfen mussten.

@1 Hartmann, gemäss meiner Identifikationstabelle zur Erkennung von Forentrollen, erfüllen sie grandios alle Kriterien. Der Kandidat hat 10 Punkte, gratulation. gleichzeitig disqualifizieren sie sich aber für eine ehrliche Debatte hier. Tut mir leid.

Den Argumenten von Prof. Lüdecke ist nichts hinzuzufügen.

Sie sind doch der, der hier vor kurzem agw gegner generell als vertrottelte rentner diffamiert hat??

Dieser Kommentar wurde grade zensiert, ich bitte ihn als direkte Antwort auf Herrn Lüdecke zu veröffentlichen. Von mir aus können sie diesen Absatz vorher entfernen.

Herr Lüdecke,

haben Sie das Paper gelesen? Oder zumindest das Abstract, aus dem ich mal kurz zitieren möchte: „[…] interpreted with a simple forcing-feedback model“.

Gruß

Peter Hartmann

@ Hartmann

Wenn ein Modell mit fixen Parametern und eines mit zufälligen das gleiche Ergebnis zeigen sind sie beide als zufällig anzusehen, oder? Mathe 2tes Semester (vor…) Aber wo steht das in diesem Artikel? In den zugrundeliegenden Artikeln leider auch nicht… Fragen über Fragen.

K. Plöger

Spencer und Braswell bedienen sich in ihrem Paper eines Modells, das nicht auf physikalischen Gegebenheiten beruht, sondern völlig frei einstellbare Parameter hat. Dies wirft zwei Fragen auf:

Inwiefern lassen sich damit physikalische Modelle widerlegen?

Wieso ist dieses Modell gut, aber alle anderen Modelle sind böse?

Hier wird das Paper kritisch besprochen, für die Skeptiker unter uns: http://goo.gl/9MVR3

p.