Abbildung: Ergebnisse der CMIP5-Klimamodelle im Vergleich mit Messungen von Wetterballonen (grün). Einzelheiten dazu, warum die Modelle statistisch so falsch sind, können in einer Studie von McKitrick und Christy (2018) nachgelesen werden.

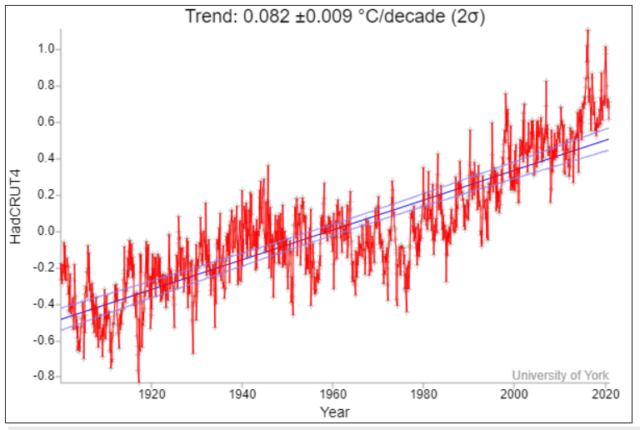

Die neueren CMIP6-Klimamodelle sind demzufolge eher noch schlechter. Gleichzeitig sind Land-Temperaturdaten durch verfälschende Wärmeinseleffekte z.B. in den USA zu 100% übertrieben (tatsächlich 0,13 statt 0,26 Grad/Dekade Temperaturanstieg), wie Roy Spencer und Anthony Watts nachweisen. Für Deutschland zeigen die Ergebnisse von Kowatsch und Kämpfe Ähnliches. Viele weitere Beispiele ließen sich aufführen.

Auf einer derart fragwürdigen Basis gründet der Klima-Alarm. Ganz im Gegensatz dazu die Wahrnehmung in der Öffentlichkeit: Der menschengemachte Klimawandel scheint inzwischen überall verinnerlicht, wobei unsere in der Mehrzahl rotgrünen Medien nach Kräften mithelfen. Selbst Artikel in TE sind inzwischen so abgefasst, als gäbe es an dieser „grundlegenden Erkenntnis“ nichts mehr zu rütteln. Und Grüne, die den Kindesmissbrauch vor nicht allzu langer Zeit noch schön geredet haben, setzen heute auf grüne Klima-Indoktrination von Kindern.

Beim Kinderspiegel, gefunden bei Kalte Sonne, liest es sich dann so: „Kurz: Am gegenwärtigen Klimawandel sind wir Menschen schuld, wir ganz allein.“ Man wird unwillkürlich an Goebbels erinnert: Man muss etwas nur oft genug wiederholen, dann wird es als Wahrheit geglaubt. Und die Medien, die Religionen und die Schulen helfen dabei wieder nach Kräften mit.

Der IPCC gibt für die CO2-Klimasensitivität seit neuestem eine Spanne von 1,6 bis 5,6 Grad C (zuvor 1,5 bis 4,5 Grad C) an je nach angenommener Verstärkung, aber nur mit einer Wahrscheinlichkeit von 66%. Man kann sich natürlich fragen, warum beharrt der IPCC bei der Berechnung der globalen CO2-Klimasensitivität seit Jahrzehnten auf seinen zwar rechenintensiven, aber großenteils unverstandenen Klimamodellen samt der zugehörigen großen Unsicherheiten. Es drängt sich der Verdacht auf, die Alarmforschung bewahrt sich mit Hilfe der großen Unsicherheitsspannen ganz bewusst den Spielraum für Klima-Alarm – wofür die Alarmforschung von der Politik schließlich gegründet wurde.

Nach dem Motto, was nicht mit letzter Sicherheit auszuschließen ist, kann weiterhin als Bedrohung verwendet werden. Wie z.B. die phantasievoll erfundenen Kipppunkte des Potsdamer Klimainstituts PIK. Man stelle sich vor, ein plötzlich Klima-realistischer IPCC käme zu dem Ergebnis, dass es keine ernsthafte Klima-Bedrohung durch den Menschen gibt – die Folgen wären schlichtweg undenkbar und in höchstem Maß unerwünscht!

Der Versuch, sich der Klima-Problematik mit einem alternativen Ansatz zu nähern, wurde kürzlich bei EIKE in nachfolgendem Beitrag veröffentlicht. Einige wichtige Punkte werden hier nochmals aufgegriffen – nicht zuletzt infolge der stattgefundenen Diskussion:

Anthropogener Treibhauseffekt: nach wie vor zu schwach für die Klimakatastrophe! – EIKE – Europäisches Institut für Klima & Energie (eike-klima-energie.eu)

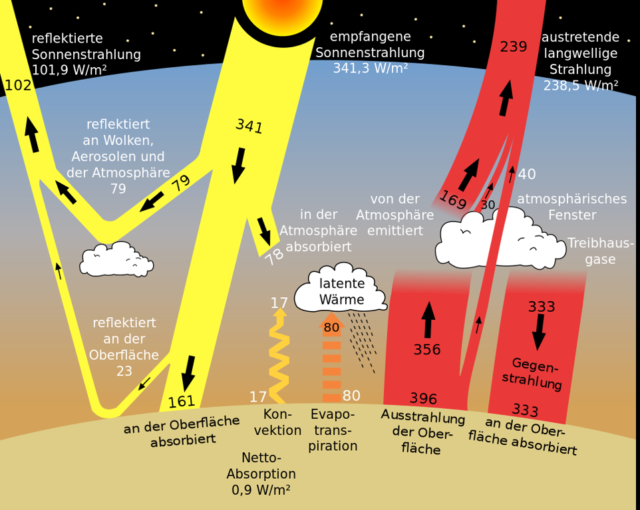

Dort wird der Gesamtantrieb, der weiter unten noch genauer beschrieben wird, aus der Energiebilanz an der Erdoberfläche berechnet. An der Erdoberfläche, wo wir leben, wird das wärmende Sonnenlicht absorbiert, deutlich weniger hingegen in der überwiegend dünnen und kalten Atmosphäre weiter oben. Von der Erdoberfläche wird auch wieder Energie abgeben, die über die Atmosphäre, die Wolken und letztlich durch Infrarot(IR)-Strahlung den Weg zurück ins Weltall findet. Dazu siehe auch die Strahlungsgrafik von Trenberth & Kiel weiter unten.

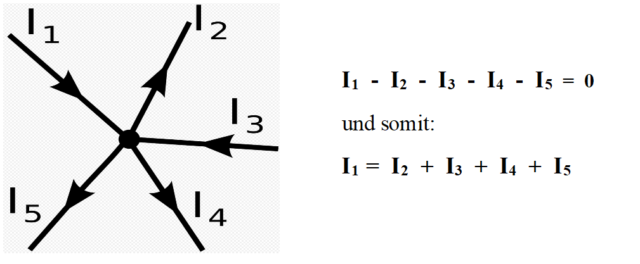

Kirchhoff’sche Knotenpunktregel gegen IPCC-Klimamodelle

Die vielen verschiedenen positiven (und auch negativen) Antriebe in einer komplizierten Atmosphäre samt ihrer Verstärkungs- oder Abschwächungsmechanismen kann kein Mensch korrekt berechnen. Im Oberflächenmodell lassen sie sich als Antriebssumme aus der Oberflächenbilanz ermitteln.

Weshalb ist das möglich? Ganz einfach, die Antwort gibt die Kirchhoff’sche Knotenpunktregel. Nachfolgend wird eine Grafik von Wikipedia verwendet. Zu beachten ist dabei, dass der Knotenpunkt keine zusätzliche Strom- bzw. Energiequelle enthält. Die Pfeilrichtungen sind unbedeutend, sie geben nur die Zählrichtung vor. Flussrichtungen entgegen der vorgegebenen Pfeilrichtungen sind gleichbedeutend mit negativen Vorzeichen. Auch kommt man im Oberflächenmodell mit nur vier „Pfeilen“ aus.

Was ist jetzt der Trick bei der Knotenpunktregel? Wenn man gemäß der Grafik Größe und Vorzeichen von vier Pfeilen kennt oder sie anderweitig bestimmen kann, dann kann man den fünften (I1 in diesem Beispiel) aus der Summenbilanz ausrechnen, egal wie groß, komplex und unberechenbar das Netzwerk ist, das den Pfeil I1 letztlich verursacht und bestimmt. So kann man auch im Oberflächenmodell den Gesamtantrieb aus den anderen Energieflüssen berechnen, egal, wie kompliziert, komplex und unverstanden die Auswirkungen der zugehörigen Atmosphäre auf den Gesamtantrieb sind. Der Knotenpunkt steht dabei für die Erdoberfläche.

Der Mythos von der „Gegenstrahlung“

Die häufigen Diskussionen bei EIKE um die ominöse „Gegenstrahlung“ kommen nicht von ungefähr. Hierzu nochmals das Strahlungsdiagramm von Trenberth & Kiel:

Ohne „Gegenstrahlung“ wäre in diesem Strahlungsdiagramm die IR-Ausstrahlung von der Erdoberfläche in Höhe von 396 Watt/m², die mit dem Stefan-Boltzmann’schen T4-Strahlungsgesetz errechnet wird, um enorme 333 Watt/m² zu hoch. Mehr als doppelt so hoch, wie an erwärmender Sonnenenergie auf der Erdoberfläche überhaupt eintrifft, was weder von der TK-Strahlungsbilanz noch von der Energiebilanz unterstützt wird – dazu siehe auch die Grafik unten. Diese ominöse „Gegenstrahlung“, die nach T&K den größten Teil der Stefan-Boltzmann’schen Oberflächen-Ausstrahlung von 396 Watt/m² kompensieren soll, hat eine einfache Erklärung:

In der dichteren, unteren Atmosphäre und am Übergang zum Boden herrscht überwiegend ein ungerichtetes Strahlungs- und Stoßgleichgewicht ohne irgendeine Vorzugsrichtung, wobei ein Netto-Energietransport in Richtung der Temperaturgradienten stattfindet – was der klassischen Definition der Wärmeleitung in Gasen bzw. hier in Luft entspricht.

Ein Gleichgewicht, das bei T&K irreführend in die beiden gegenläufigen, großen vertikalen Strahlungskomponenten „Ausstrahlung“ und „Gegenstrahlung“ aufgesplittet wird. Obwohl diese beiden fiktiven Strahlungsflüsse in Wirklichkeit eine untrennbare Einheit bilden, die auf mikroskopischer und molekularer Ebene nicht nur in vertikale, sondern in alle Richtungen strahlen – verursacht durch unzählige Absorptions- und Emissionsprozesse.

Was dann dazu führt, dass man aus allen Richtungen eine solche „Gegenstrahlung“ empfangen und messen kann. Die direkt nach oben durchgehende IR-Strahlung, die nicht mit den Klimagasen wechselwirkt, weil die Frequenzen im durchlässigen IR-Strahlungsfenster liegen, werden bei Bewölkung von der Wolkendecke absorbiert und teilweise zurückgestrahlt. Deshalb misst man bei Bewölkung eine erhöhte „Gegenstrahlung“ aus Richtung der Wolkendecke.

Die Wärmeleitung in Luft ist aber um Größenordnungen zu niedrig (was man mit Hilfe der bekannten Wärmeleitwerte für Luft leicht nachprüfen kann), um zur Strahlungsbilanz im T&K-Diagramm und somit zu der Energiebilanz nennenswert beizutragen. Deshalb fehlt korrekterweise genau dieser Teil bei der letztlich ausgestrahlten Energie. In einer Atmosphäre, die nicht strahlungsaktiv ist, würde auch dieser Teil ungehindert ausgestrahlt und gemäß Stefan-Boltzmann’schem T4-Strahlungsgesetz die Wärmeausstrahlung um ein Vielfaches erhöhen. In Wirklichkeit ist die Atmosphäre in großen Teilen des IR-Spektrums strahlungsaktiv und somit „wärmeisolierend“- hauptsächlich dank Wasserdampf und dem Spurengas CO2.

Die verbleibende, kühlungswirksame (Netto-)Ausstrahlung von 63 Watt/m² nach T&K, die nurmehr ca. 15% einer „ungebremsten“ Stefan-Boltzmann-Ausstrahlung ausmacht, wird bei fehlender Bewölkung teilweise direkt in den Weltraum ausgestrahlt (40 Watt/m² bei T&K), weil die zugehörigen Frequenzen im atmosphärischen Fenster liegen und nicht mit den Klimagas-Molekülen wechselwirken. Der Rest (23 Watt/m² bei T&K) wird von den Klimagas-Molekülen der höheren und dünneren Atmosphäre ausgestrahlt. Letzteres zusammen mit der aufgestiegenen Konvektions- und Verdunstungswärme – die Wärmeabgabe an den Weltraum erfolgt dann letztlich durch Infrarot-Strahlung. Die relativ geringe Wärmeleitung der Luft trägt aber mit dazu bei, dass sich das Temperaturgefälle zwischen Erdoberfläche und Weltraum einstellt.

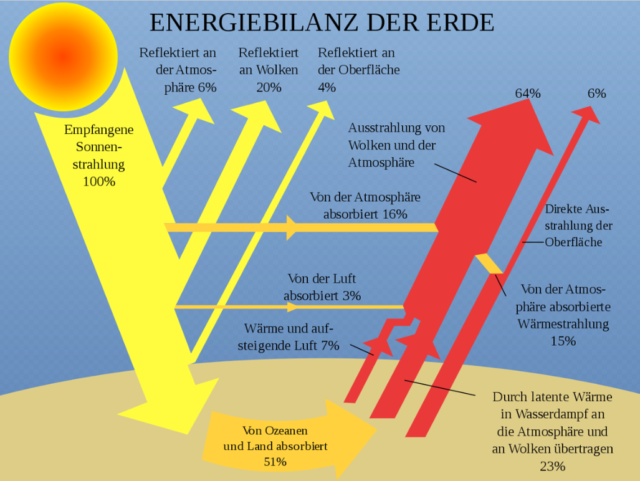

Nachfolgende realistische Darstellung der Energiebilanz der Erde ist bereits in einem Lehrbuch „Physics of Climate“ aus dem Jahr 1992 zu finden und wurde vor einigen Jahren von der US-NOAA wieder übernommen. Trotz einiger Abweichungen bei den Zahlenangaben ist diese Darstellung insgesamt klarer, kommt ohne die ominöse „Gegenstrahlung“ aus und wird deshalb hier nochmals gezeigt:

Die „geheimnisvollen“ Antriebe

Es gibt unterschiedliche Wirkmechanismen, die die Temperaturen erhöhen oder auch absenken können. Für die rechnerische Beschreibung hat sich der sog. „Antrieb“ (engl. „forcing“) als praktikabel erwiesen, der rechnerisch einer Heiz- oder Kühlleistung in Watt/m2 gleicht. Dabei handelt es sich meist um keine zusätzliche Energiequelle, sondern vielmehr um erhöhte oder verringerte Wärmeisolation, wie es auch beim anthropogenen CO2 oftmals angenommen wird.

Der Theorie nach wird die spektroskopische Erwärmung durch CO2 mittels ungerichteter IR-Emissionen und Absorptionen bei den CO2-Resonanzfrequenzen bewirkt, was eine Verringerung des Wärmetransports zur Folge hat. Verschiedentlich wird auch das Bild der rückgestrahlten IR-Energie benutzt, um die die Abstrahlung in den Weltraum verringert wird.

Beim Antriebskonzept wird jetzt so gerechnet, als würde eine Erwärmung durch entgegen gerichtete Energiezufuhr („Antrieb“) bewirkt. Obwohl diese zusätzliche Energiezufuhr oder Heizquelle in vielen Fällen nur fiktiv ist. Dies wirkt etwas irritierend, ist aber üblich und bewährt, was am Beispiel des CO2 nachfolgend gezeigt wird.

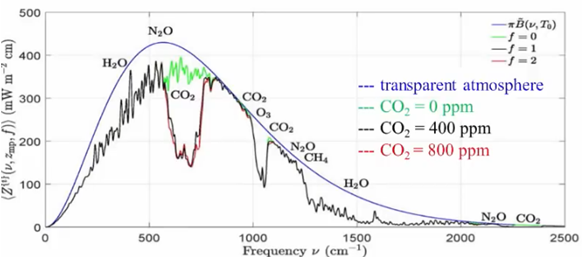

Bei CO2 errechnet man einen Strahlungsantrieb von 3,7 Watt//m2, der bei CO2-Verdoppelung wirksam wird und die Temperaturen um 1,1 Grad C (bei einigen Autoren etwas mehr) erhöht. Diesen Temperaturanstieg nennt man dann CO2-Klimasensitivität. Tatsächlich handelt es sich um einen verringerten IR-Strahlungstransport, wie folgende Grafik der in den Weltraum emittierten Infrarotstrahlung in Abhängigkeit von der Frequenz zeigt (nach Prof. Happer et al.):

Es gelangt bei den Frequenzen, bei denen das Spurengas CO2 IR-Strahlung absorbiert und emittiert, weniger IR-Strahlung in den Weltraum. Happer et al. haben diese Grafik errechnet, sie stimmt aber sehr gut mit den IR-Spektren überein, die aus dem Weltraum gemessen werden – allerdings nur über Wüsten und bei trockener Luft. Andernorts werden diese Spektren durch Aerosole und Bewölkung stark deformiert. Über der Südpolregion verkehren sich die CO2-Vertiefungen in Ausstülpungen – dort erhöht das atmosphärische CO2 die IR-Abstrahlung und wirkt somit kühlend. Was den starken Einfluss der jeweiligen atmosphärischen Bedingungen auf das Abstrahlverhalten der Klimagase deutlich macht. Und eine Ahnung davon gibt, wie schwierig es ist, die Wirkung der jeweiligen Klimagase samt etwaiger Rückkopplungen in einer realen Atmosphäre mit IPCC-Klimamodellen korrekt zu ermitteln.

Ein weiterer wichtiger Punkt wird in dieser Grafik sehr gut sichtbar, nämlich, dass eine weitere CO2-Verdoppelung, wie hier von 400 (schwarz) auf 800 ppm (rot), wegen der spektroskopischen Sättigung nur mehr sehr wenig bewirkt. Hinzu kommt der Einfluss der komplizierten Atmosphäre, der in dieser errechneten Grafik nicht sichtbar wird. Deshalb sind auch die großen Unsicherheitsspannen bei den IPCC-Klimamodellen nicht überraschend.

Oberflächenbilanz und Verdunstungswärme

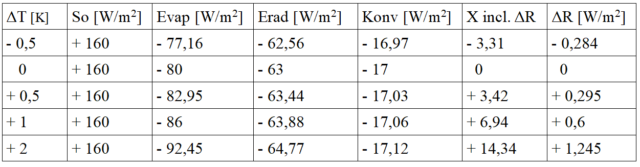

Sofern durch anthropogene Klimagase, variierende Sonneneinstrahlung (So) und andere natürliche Einflüsse Änderungen in der Oberflächenbilanz auftreten, sind sie im Gesamtantrieb X enthalten – siehe nachfolgende Ergebnistabelle, die aus der eingangs zitierten Arbeit übernommen wurde:

Die ausgehende IR-Strahlung Erad dürfte nach den vorausgegangenen Abschnitten näherungsweise richtig berechnet sein. Auch trägt sie nur maximal 1 Watt/m² zum Gesamtantrieb in Höhe von ca. 7 Watt/m² bei, bezogen auf 1 Grad C Temperaturerhöhung.

Als der mit Abstand wirkungsvollste Kühlmechanismus erweist sich an der Erdoberfläche demnach die abgeführte Verdunstungswärme Evap, die laut einer vorausgegangenen EIKE-Veröffentlichung (hier) global um 7,5% je 1 Grad C Temperaturanstieg zunimmt. Dieser Wert scheint naheliegend, denn auch der Dampfdruck wächst in gleicher Weise mit der Temperatur. Und somit auch der Wasserdampfgehalt in der Atmosphäre und der Wärmeeintrag durch Verdunstung. Gefunden wurde dazu eine Pool-Tabelle, die diesen Zusammenhang tendenziell und größenordnungsmäßig bestätigt. Auch spielen die Feuchtigkeit des Untergrunds (z.B. Land oder Ozeane), der Luft und die Windverhältnisse eine große Rolle.

Über einen interessanten, neu erforschter und publizierter Kühleffekt wird in der Klimaschau von Dr. Lüning (Ausgabe 16, ab etwa 5. Minute) berichtet: In den Tropen zieht aufsteigender Wasserdampf kalte, wasserdampfhaltige Luft mit nach oben. Dieser Kühleffekt wächst exponentiell mit der Temperatur und stellt damit einen zusätzlichen, bedeutenden Klimastabilisator dar und ist eine weitere Verstärkung der Verdunstungskühlung.

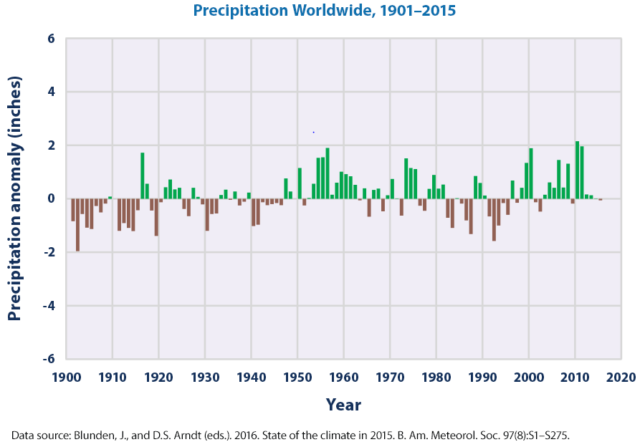

Eine weitere Möglichkeit zur Überprüfung bietet die Niederschlagsbilanz. Sämtlicher Wasserdampf, der durch Verdunstung in die Atmosphäre gelangt, kehrt als Niederschlag zur Erdoberfläche zurück. Wenn bei 1 Grad C Temperaturerhöhung die Verdunstung samt mitgeführter Verdunstungswärme um 7,5% zunimmt, dann müssten die Niederschläge ebenfalls um 7,5% zunehmen.

Ganz allgemein schreibt z.B. das österreichische ZAMG (Zentralanstalt für Meteorologie und Geodynamik): „Der Gesamtniederschlag wird auf der Erde im wärmeren Klima tendenziell zunehmen.“ Und das deutsche Umweltbundesamt: „Seit 1881 hat die mittlere jährliche Niederschlagsmenge in Deutschland um rund 10% zugenommen … insbesondere sind die Winter deutlich nasser geworden.“ Das ist jetzt nur Deutschland.

Der Berliner Senat, Ressort Umwelt, führt dazu aus: „Die Niederschlagsentwicklung abzuschätzen ist mit großen Unsicherheiten behaftet. Der globale Niederschlag hat eine sehr große räumliche und zeitliche Variabilität. Über Europa haben die Niederschläge im letzten Jahrhundert um 6 bis 8 % zugenommen, wobei die Zunahme mehrheitlich (10 bis 40 %) über Nordeuropa erfolgte und im Mittelmeerraum und Südeuropa ein Rückgang um bis zu 20 % zu verzeichnen war.“

In einer Fundstelle findet man die Arbeit von L. Jäger „Die globale Niederschlagsverteilung und ihre Veränderung im 20. Jahrhundert“. Dort werden tabellarisch verschiedene Autoren und die von ihnen ermittelten globalen Niederschlagswerte zu den jeweiligen Jahren angegeben. Mittels linearer Regression erhält man aus diesen Daten einen Anstieg von 34%. Sehr wahrscheinlich ein zu hoher Wert, was Folge von vielen möglichen Fehlerquellen sein dürfte.

Vermutlich realitätsnäher sind die Anomaliewerte für die globalen Niederschläge, die von der US-Umweltbehörde EPA gemäß nachfolgender Grafik veröffentlicht wurden. Die globalen Niederschläge stiegen den EPA-Angaben zufolge mit 0,08 inches/Dekade, während sie über Festland-USA (48 Staaten) um 0,17 inches/Dekade zunahmen. Nimmt man in Anlehnung an Jäger den globalen Mittelwert mit 40 inches an, dann sind laut EPA die globalen Niederschläge, bezogen auf 40 inches, sei 1900 nur um 2,4% angestiegen.

Vergleich Oberflächenmodell und Klimamodelle

Geht man von den EPA-Daten aus, dann stellt sich die Frage, warum bei den erwarteten globalen Niederschlägen, die um 7,5% je 1 Grad Temperaturerhöhung zunehmen sollten, nur eine mittlere Zunahme von 2,4% gemessen wurde. Obwohl die globalen Temperaturen gleichzeitig um etwa 1 Grad C gestiegen sind. War der globale Temperaturanstieg nur halb so groß wie bei den publizierten Temperaturen? Dies wäre angesichts der zahlreichen Adjustierungen nicht völlig auszuschließen. Oder sind die Niederschlagsmessungen nicht zuverlässig genug? Die ungleich größere Zunahme der globalen Niederschläge bei Jäger deutet in diese Richtung.

Wenn man, wie nachfolgend, von der größeren Verlässlichkeit der EPA-Daten ausgeht, käme als Erklärung auch infrage, dass es in dem betrachteten Zeitraum einen geringeren Zuwachs bei den Niederschlägen infolge natürlicher Klimavariationen, z.B. durch Überlagerung eines negativen Niederschlag-Trends, gegeben hat. Dass solche Effekte eine Rolle spielen können, dafür gibt die erkennbare Periodizität in der EPA-Grafik erste Hinweise. Und wie bei den Temperaturen könnten auch die Niederschläge natürlichen Einflüssen mit längerer Periodendauer unterworfen sein.

Zum Vergleich wurden oben die Grafen der EPA-Niederschlagsdaten und der globalen HadCRUT4-Temperaturen in gleichem Zeitmaßstab übereinander gestellt. Dabei zeigt sich eine interessante Übereinstimmung: Wenn die globalen Niederschläge höher sind, stagnieren die globalen Temperaturen oder nehmen sogar ab und umgekehrt. Dies kann mit aller gebotenen Vorsicht als Bestätigung für das Oberflächenmodell gewertet werden.

Dies lässt den Schluss zu: Hätte es eine „normale“ Niederschlagsentwicklung mit einer größeren, 7,5%-igen Zunahme der globalen Niederschläge gegeben, wäre der Kühleffekt entsprechen größer ausgefallen und die globalen Temperaturen wären nur um die Hälfte gestiegen. Hinzu kommt als verstärkender Effekt, dass mehr Niederschläge mit mehr Bewölkung einhergehen, wodurch die Sonneneinstrahlung reduziert wird, was aber im Gesamtantrieb enthalten ist.

Träfe der Fall zu, dass die Verdunstung einschließlich der abgeführten Verdunstungswärme und somit auch die Niederschläge im Mittel nur um 2,4% (anstelle von 7,5%) ansteigen, dann würde es keine großen quantitativen Unterschiede zwischen Oberflächenmodell und den IPCC-Modellen mehr geben. Allerdings besteht weiterhin ein wichtiger qualitativer Unterschied: In den IPCC-Modellen wird vorausgesetzt, dass das anthropogene CO2 incl. Verstärkung de facto alleiniger Temperaturtreiber ist. Im Oberflächenmodell bleibt hingegen offen, wie sich der Gesamtantrieb im Einzelnen zusammensetzt.

Es spricht vieles dafür, dass andere, zumeist natürliche Erwärmungsursachen, wie schon in den voraus gegangenen Warmperioden, auch bei der neuzeitlichen Klimaerwärmung maßgeblich beteiligt sind. Das Oberflächenmodell lässt Raum für weitere Antriebe, die dann ganz oder teilweise an die Stelle des CO2-Antriebs in den IPCC-Klimamodellen treten, um den neuzeitlichen globalen Temperaturanstieg zu erklären. Und dafür gibt es viele Hinweise wie Wärmeinseleffekte, ozeanischen Oszillationen, Nord-Süd-Klimaschaukel (derzeit fehlende Erwärmung im Südpolarbereich bei zugleich stärkerer Erwärmung im Nordpolarbereich) – obwohl die CO2-Zunahme praktisch überall die gleiche ist.

Nicht wenige der natürlichen periodischen Antriebe, zu denen auch die Sonnenaktivität samt Verstärkung gehören, erreichen aktuell ihre Minima oder wechseln ihre Vorzeichen. Was die spannende Frage aufwirft, wieweit jetzt eine Phase des langsameren Temperaturanstiegs oder gar Abkühlung folgt – wie schon bei vorausgegangenen Warmperioden. Wobei man die globale Niederschlagsentwicklung nicht außer Acht lassen sollte. Wohingegen es beim IPCC nur eine Richtung gibt, nämlich aufwärts, getrieben durch die CO2-Emissionen.

Somit erleben wir in den nächsten Jahren ein spannendes Live-Experiment und gleichzeitig die Nagelprobe, was das Spurengas CO2 tatsächlich bewirkt. Wobei das CO2 in der Atmosphäre aufgrund der zunehmenden Emissionen derzeit noch ansteigt. Allerdings mit ersten Anzeichen für eine Verlangsamung, was in dem zitierten EIKE-Artikel die gepunktet eingezeichnete CO2-Anstiegskurve von Roy Spencer nahelegt – offensichtlich infolge der wachsenden CO2-Absorption durch Pflanzen und Ozeane. Was auch in der zunehmenden Begrünung der Erde und den gestiegenen Ernteerträgen sichtbar wird und Folge des höheren CO2-Partialdrucks in der Atmosphäre ist. Hinzu kommt, dass die fossilen Vorräte endlich sind – voraussichtlich wird es keine CO2-Verdoppelung mehr geben.

Ausblick

Die großen Unsicherheiten in den IPCC-Klimamodellen sowie jetzt auch das unterschätzte Potential der Verdunstungskühlung unterstreichen die Fragwürdigkeiten eines Dekarbonisierungs-Programms, das auf viele Jahrzehnte oder sogar ein ganzes Jahrhundert angelegt ist. Denn abgesehen von der Frage, wer überhaupt mitmacht, ist es genauso fraglich, was ein solches Programm bei den Temperaturen und dem Erdklima letztlich bewirken kann. Absehbar ist hingegen eine nachhaltige Beschädigung des Industriestandorts Deutschland. Auch besteht die Gefahr bei einer (Gott sei Dank eher unwahrscheinlichen) CO2-Minderung, dass der wichtige CO2-Pflanzendünger dann nicht mehr ausreicht, um die gewachsene Weltbevölkerung zu ernähren.

Für Klima-Ängstliche wäre stattdessen Geoengineering die bessere Option, wobei bereits der Eintrag von wenigen Milligramm geeigneter Aerosole in die untere Stratosphäre, pro Quadratmeter und Jahr, die Temperaturen spürbar senken würde. Und, besonders wichtig, diese Methode wäre sofort wirksam und nicht erst, wenn überhaupt, in Hundert Jahren. Und kann auch genauso schnell wieder rückgängig gemacht werden.

Auch sollte man nicht vergessen, dass mittel- bis längerfristig das Ende der Zwischeneiszeit und die Rückkehr der Eiszeit droht, was die Menschheit vor ungleich größere Probleme stellen wird. Hinzu kommen vorhersehbare, ernstere Probleme und Krisen, gegen die sich die Menschheit wappnen sollte. Während Deutschland und Europa alle Kräfte samt Billionen auf ein Klima-Phantom konzentrieren.

Aber was ist zu erwarten? Eine Kanzlerin und frühere Umweltministerin hat ein Billionen-Programm initiiert und wird zu Lebzeiten ihren historischen Fehler niemals eingestehen. Auch steht sie Al Gore, Obama und den Demokraten näher – Trump war ihr so fremd wie ein Alien. Und eine EU-von der Leyen, bisher nicht durch Können aufgefallen, setzt bei der Dekarbonisierung noch eins drauf – man kommt aus dem Staunen nicht heraus. Kein Zweifel, wir werden von Klima-hysterischen Frauen regiert – ist es höchste Zeit, die Quote nochmals zu überdenken?

Ebenfalls ganz auf Dekarbonisierung ausgerichtet wird eine staatlich geplante grüne Energiewende durchgezogen, die unlängst im Wallstreet Journal als die „dümmste Energiewende weltweit“ beschrieben wurde. Belege dafür gibt es zuhauf. Und die beiden Klima-hysterischen Frauen an der Spitze folgen den Grünen und den FfFs und setzen sich an die Spitze der Klima-Aktivisten.

Bei Corona regte sich Widerstand gegen das Maskentragen und manche Übertreibungen beim Lockdown. Weshalb hält man ausgerechnet beim Dekarbonisierungs-Wahnsinn still? Obgleich Autofahrer und Heizungsbesitzer immer dreister abkassiert werden? Und dies trotz Corona-Rezesssion? Von den weltmeisterlich steigenden Strompreisen ganz zu schweigen?

Alle Weichen sind so gestellt, dass sich das Land, so ist zu befürchten, zum dritten Mal ruiniert. Trotzdem wünscht man, schon der Nachkommen wegen, dass Deutschland weiterhin lebenswert bleibt. Dafür ist die Rückkehr von ein wenig Resthirn unerlässlich – weniger Stimmen für die Grünen wäre ein erster Indikator. Aber aus heutiger „Klima-Weltretter“ und „Vorreiter“-Sicht gleicht dieser Wunsch dem Hoffen auf ein großes Wunder!

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Hm, nach meiner Kenntnis ist es so, dass da in den Klimamodellen den natürlichen Antrieben wie Sonne incl. Verstärkung, Ozeanische Oszillationen, Wärmeinseleffekten samt Landnutzungsänderungen kaum oder gar kein Raum gegeben wird. Auch habe ich bisher nicht gesehen, dass die gezeigte Temperaturkurve korrekt nachgebildet wird, obwohl es zumindest rückwirkend mittels Anpassungs-Paramentern, wie sie gerne benutzt werden und die wir nicht kennen, möglich sein sollte. Auch gibt es unterschiedliche Meinungen, wodurch die Täler und Berge letztlich verursacht wurden. Ich biete hier als weitere mögliche Ursache die Entwicklung der globalen Niederschläge an.

Sehr geehrter Herr Ullrich,

Das ist falsch. Die bei den IPCC reports berücksichtigten Klimamodelle sind allesamt globale Zirkulationsmodelle, die alle die anderen Klimatreiber ebenfalls implementiert haben. Das interne Klimarauschen zeigen auch die Klimamodelle. Was glauben Sie, woher sonst die Schwankungen in den Temperturkurven in der Abb. oben herkämen?

Klimamodelle sind reine CO2- Temperatur – Diagramme ohne andere Einflüsse mit ein wenig Rauschen zu Glaubwürdigkeit.

Sehr geehrter Herr Georgiev,

Das ist nicht richtig. Klimamodelle sind keine Diagramme, sondern Computerprogramme basierend auf dem Lösen der Navier-Stokes-Gleichungen für Atmosphäre und Meere und zusätzliche physikalische Effekte, die das Wetter bestimmen.

Klimamodelle beinhalten im Wesentlichen eine beliebige, von der Laune des Erstellers oder Bezahlers abhängige, Abhängigkeit der Temperatur vom CO2. Der Rest ist unwichtiges Beiwerk.

Meine IT Kenntnisse sind nicht besonder fundiert, aber ich habe mein ganzes Geld über mehrere Jahrzehnte damit gemacht, Programmierer zu triezen, dass ihre Algorithmen gefälligst das errechnen, was der Kunde erwartet, nicht was der Programmierer selbst für richtig hält. Jedes Computerprogramm errechnet exakt das, wofür es bezahlt wird, der Entwickler muss es nur umsetzen.

Entwickler von Klimamodelle werden dafür bezahlt, dass sie eine Erwärmung durch CO2 errechnen, das tun sie dann auch. Für das IPCC erst Recht. Genau so einfach kann man ein Klimamodell entwickeln, dass eine Abkühlung vorhersagt.

Bezahlt aber keiner.

Die von Gustav Robert Kirchhoff für elektrische Netze postulierten Überlegungen entspringen im Kern dem Prinzip der Energieerhaltung. Elektrisch ist das rel. einfach, weil die Energie an das Medium Draht gebunden ist (zumindest im niederfrequenten Bereich).

Allgemein ist dies außer als gültiges Prinzip allerdings nicht im Detail spezifizierbar. Aber natürlich kann man jedes Verhalten unter diesem Gesichtspunkt analysieren. Je besser die Kenntnis aller beteiligten Prozesse ist, desto besser kann man Abschätzungen auf Verhaltensplausibilität machen.

Untersucht man also z. B. einen beliebigen Punkt der Erdoberfläche, wirken viele unterschiedliche Prozesse dreidimensional. Es sind sowohl dynamische Einflüsse als auch rel. statische Eigenschaften. Dynamisch sind. z. B. Einstrahlung, Oberflächentemperatur, Lufttemperatur, Luftfeuchtigkeit, Wind, Strömung, Konvektion, Abstrahlung, Verdunstung, usw. Rel. statisch sind Oberflächenmaterial, -farbe, Luftzusammensetzung, usw.

All diese Dinge kann man zeitkonsistent messen und damit eine Verhaltenstheorie für diesen Punkt ansetzen, bei der die Summe über alle Energien Null ist. Tut man das für konkrete Punkte der Oberfläche, zeigt sich lediglich, daß die bekannten Gesetze der Physik offensichtlich stimmen. Ein Hinweis auf eine weitere Energiequelle außer der Sonne ist nicht feststellbar.

Schwieriger wird diese Analyse, wenn man einen Punkt der Atmosphäre z. B. in 2 m Höhe analysiert, jenen Ort also, wo eigentlich die von der Klimatologie als wesentlich betrachtete Temperatur gemessen wird. Welche Energiebilanz herrscht an so einem Punkt, der physikalisch aus Luft besteht, welche aber federleicht beweglich ist und laminar oder turbulent sein kann? Hier wirken viele Einflüsse dreidimensional und mit Gradienten. Zeitkonsistent messen kann man Temperatur, Luftfeuchtigkeit und Wind (Stärke, Richtung). Die treibenden Ursachen für diese Meßwerte kann man an diesem Ort aber nicht feststellen.

Deshalb sehe ich es auch als unmöglich an, für „alle Punkte“ der Erdatmosphäre ein konsistentes Abbild aufgrund von Navier-Stokes etc. zu ermitteln, und schon gar nicht, auf dieses Abbild sinnvolle Prognosen aufsetzen zu können, was die sog. Klimamodelle aber alle versuchen. Zusätzlich scheitern die Modelle an der Frage, wie genau wird die Wirkung von CO2 modelliert? Auf diese Frage gibt nämlich auch IPCC keine brauchbare Antwort.

Fazit Modelle: Code Garbage in – Ergebnis Garbage out …

Unabhängig davon, inwieweit das zugrunde gelegte Modell der thermischen Flüsse „Energiebilanz der Erde“ die realen Verhältnisse annähernd wiedergibt, werden die Kirchhoffschen Sätze m. E. lediglich als Analogon für die Abzweigungen, Zusammenflüsse und deren angedachte Richtungen dienen – die entsprechenden Gleichungen eines Gesamtsystems sind auch ohne Knotengleichung aufstellbar. Da Modelle der abgebildeten Art zum einen kein Zeitverhalten von Komponenten und zum anderen keine mehrdimensionalen Regelungssysteme (Mit- und oder Gegenkopplung) enthalten, was zu Differentialgleichungssystemen führen würde, handelt es sich lediglich um rein statische Modelle – vergleichbar mit Gleichstrom-Netzwerken. Vielleicht mögen damit einzelne singuläre Effekte beschreibbar sein, aber nicht ein überaus komplexes Klimasystem über ein Zeitfenster von Jahren, das erkenntnismäßig immer komplexer im Sinne von zusätzlichen Einflussgrößen wird. Bei der Approximation natürlicher physikalischer Vorgänge über lange Zeiträume ist eine Annäherung von Messkurve und Modell-Funktion in einem Zeitfenster vorstellbar, jedoch jede beliebige Abweichung außerhalb möglich (Mehrdeutigkeit). Den gerade aktuell postulierten gewünschten Kurvenverlauf oberhalb des approximierten Zeitfensters kann man dann durch Variation noch freier Parameter erzeugen…

Gerade eine solche Energiebilanz, oder wie hier am Beispiel der Knotenpunktregel dargelegt, bietet die Chance, die große Komplexität der Klimamodelle zu vermeiden. Natürlich bleiben dafür andere Fragen offen, wie sich z.B. der Gesamtantrieb im Einzelnen zusammensetzt. Und leider sind auch die globalen Niederschläge samt Temperaturverhalten bisher nicht ausreichend genau bekannt, was aber messtechnisch mit den vielen Wetter- und Messstationen lösbar sein sollte. Dagegen stehen die riesigen Fehlerspannen samt Unbekannten bei den IPCC-Klimamodelle…

>> Nimmt man in Anlehnung an Jäger den globalen Mittelwert mit 40 inches an, dann sind laut EPA die globalen Niederschläge, bezogen auf 40 inches, sei 1900 nur um 2,4% angestiegen.<<Nimmt man an …Was soll der Bullshit? Niederschlagsmessungen „weltweit“ gibt es seit wann?Ich war 1974 mit der Meteor im Mittelatlantik. Da wurde zwischen Afrika und den Karibischen Inseln erstmalig gezielt meteorologisch für dreimal drei Wochen mit ein paar Schiffen das Wetter gemessen. Und es wurde auch erstmalig die Entstehung eines Hurrikanes exakt bestimmt. Hat ganz schön kräftig gegossen als dessen Gründungssystem über uns hinwegzog und binnen 60 Minuten so mal eben mehr als 20 cm Regen runterkamen.Ansonsten hat es bis dahin nirgendwo Niederschlagsmessungen auf den Ozeanen dergestalt gegeben. Und Temperaturmessungen in 30-minütiger Auflösung auch nicht. Und als ich mit der Frithjof oben am Nordkap war, gab es zwischen Grönland und Island keine Messungen und zwischen Island und Spitzbergen auch keine.Was an Land gemessen wurde, war auch gering. Deshalb sind die Angaben bzgl. des letzten Jahrhunderts mehr als zweifelhaft.Wer sich die Daten von BHV anschaut, der kommt nicht drum herum sich das nahegelegene KKW anzuschauen, und zu überlegen was das an Energie in die Weser abgegeben hat. Das Warmwasser schwappte da ja über 30 Jahre immer hin und her.Wer sich die Werte in den USA anschaut, der kommt nicht darüber hinweg große und langanhaltende Variabilitäten festzustellen.Wie groß die sind konnte ich am Durchbruch des Potomac kurz vor Washington feststellen. Da wo der Parkplatz für die Besucher war, war die maximale Wasserhöhe angegeben, und die lag 3 Meter über dem Parkplatz = dem Durchbruch.Die Niederschlagsvariabilitäten sind extrem groß und weltweit noch nie bestimmt worden. Wie denn auch? Wo wurde und wird denn auf den Weltmeeren und Kontinenten gemessen?Als Segelflieger weiß ich wie groß die Variabilität von Temperatur und Luftfeuchtigkeit selbst im kleinen Umkreis von 75 km ist.

Sehr geehrter Herr Dr. Ullrich,bitte benennen Sie Abbildungen und Tabellen, z. B. Abb. 1, Tab. 2 usw., was einen leichteren, direkten Bezug in der Diskussion hier erlaubt.In der Abbildung zur IR-Emission ist in der Betitelung der Abszisse Frequenz eingetragen, jedoch mit der Einheit 1/cm. Die Absissenwerte passen zur dieser Einheit, welche aber Wellenzahl genannt wird.Klugscheißmodus aus.

Ich habe hier die Original-Darstellung von Prof. Happer gewählt, wie sie auch schon mal bei EIKE publiziert wurde. Ich hatte dabei im Hinterkopf, dass Physiker gerne die Lichtgeschwindigkeit mit c = 1 ansetzen, und dann wird aus Ihrer „Wellenzahl“ eine Frequenz.

@ Herrn Dr. Roland Ullrich

Sie schreiben im vorliegenden Text, 1. Satz im 4. Abs. unter der K&T-Abbildung, Zitat:

„Was dann dazu führt, dass man aus allen Richtungen eine solche ,Gegenstrahlung‘ empfangen und messen kann.“

Zur „Gegenstrahlung“ und deren „Messung“ hatte ich gerade 5 Widersprüche formuliert, die in der nachfolgenden Diskussion nicht ausgeräumt, sondern vielmehr bestätigt worden sind.

Meine Frage an Sie: Wo und wie wird die sogenannte „Gegenstrahlung“ eindeutig gemessen?

U. Weber schrieb am 7. MÄRZ 2021 UM 22:54

Es diskutiert doch kaum noch jemand mit Ihnen, da Sie eh nicht auf Nachfragen auf Ihre Thesen eingehen. Also können Sie kaum aus fehlendem Widerspruch auf eine Korrektheit Ihrer Annahmen schließen. Wenn ich nicht schon aufgegeben hätte, Sie etwas zu fragen, dann hätte ich sicherlich zum … 10. male nachgefragt, wieso der Subtrahent in ihrer „Stefan-Boltzmann-Umgebungsgleichung“

kein Ausdruck für eine Strahlung aus der Atmosphäre ist. Eine Frage, auf die Sie bewusst nie eingehen.

Und die Frage nach dem Messgerät wurde Ihnen von Herrn Holtz schon beantwortet (27. FEBRUAR 2021 UM 11:34). Sie mögen die Antwort nur nicht.

Wie gut und wie genau das mit verfügbaren Thermometern gemessen werden kann, weiß ich leider nicht. Es wurden aber immer wieder solche Messungen der „Gegenstrahlung“ berichtet. Sie, Herr Weber, haben in Ihrer letzten Veröffentlichung, soweit ich mich erinnere, Hilfreiches zu den messtechnischen Grenzen ausgeführt.

Zwei Bemerkungen: a) Artikel auf Tichys Einblick über den Wahlbetrug in den USA sind von Schülern geschrieben worden, die niemals über ein so detailliertes Wissen verfügen können. Das ist total feige von der dortigen Redaktion und lächerlich. Und jetzt schlucken die auch noch die Sache mit dem menschengemachten Klima? Haha, falls wahr: Deppen. b) Zitat: „[…] Man muss etwas nur oft genug wiederholen, dann wird es als Wahrheit geglaubt. […]“ Das machen Sie genauso, Herr Dr. Ullrich. Es ist traurig. Denken wir für einen Augenblick logisch nach. Die berüchtigte Ethikkommission bestand aus mindestens 15 Elementen. Davon waren 2,5 atheistische Theologen. Ergo? Trotzdem kapieren sehr viele Physiker das bißchen Mathe bis heute NICHT. Lächerlich. Zitat: „[…] Und die Medien, die Religionen und die Schulen helfen dabei wieder nach Kräften mit.“ Klar. Träumen Sie weiter. Das ist regelrechter Unsinn, welchen Sie ihr abliefern, Herr @Dr. Ullrich. Es ist der Atheismus, kann logisch nur dieser sein (vgl. Vernunft). Praktisch alles ist heute durch diese Flaschen korrumpiert und deren armselig flachem „Denken“. Außerdem ist das Christentum keine Religion. Wenn also die beiden Kirchen, diesen atheistischen Betrug mitmachen, dann weil keiner mehr von denen an GOTT glauben will und sich lieber der Gotteslästerung hingeben. Und Herr @Dr. Ullrich? Wer logisch nachprüft, im großen, restlichen Haus der Wissenschaft wird auch ernsthaft nach echtem und sehr wichtigem, vor allem sinnvollem Wissen gesucht, kann nur zu dem Ergebnis kommen. Auch geben Sie den Sachverhalt falsch wieder, wenn Sie so argumentieren ohne vorher gründlich zu reflektieren. GOTT macht das Wetter, nach christlicher Auffassung. Damit befassen, das in Frage stellen nur an Hybris leidende religiöse Atheisten, die deren Grenzen der Erkenntnis regelmäßig verkennen.

Sehr geehrter Her Dr. Ullrich,ihr Beitrag über die Zweifel an der Wissenschaftlichkeit des IPCC hat mich beeindruckt.Diesen neueren Beitrag lese ich jetzt zum dritten Mal.Mir fehlt noch der entscheidenene Kick,wie bei letzten Beitrag.Sie schreiben :Zitat: „[…] Dort wird der Gesamtantrieb, der weiter unten noch genauer beschrieben wird, aus der Energiebilanz an der Erdoberfläche berechnet. An der Erdoberfläche, wo wir leben, wird das wärmende Sonnenlicht absorbiert, deutlich weniger hingegen in der überwiegend dünnen und kalten Atmosphäre weiter oben. Von der Erdoberfläche wird auch wieder Energie abgeben, die über die Atmosphäre, die Wolken und letztlich durch Infrarot(IR)-Strahlung den Weg zurück ins Weltall findet. Dazu siehe auch die Strahlungsgrafik von Trenberth & Kiel weiter unten.[…].“Da beschreiben Sie etwas ,dass in der Realität nicht existiert.Die Knotenregel von Kirchhoff funktioniert nur bei Gleichzeitigkeit.Es sind noch mehr Ungereimtheiten drin.Eventuell zu einem späteren Zeitpunkt.

zur Gleichzeitigkeit: Ich gehe davon aus, dass die Knotenpunktregel auch für Energieflüsse gilt. Zusätzliche Energiequellen im Knotenpunkt habe ich ausgeschlossen. Ist auch die klassische Definition der Divergenz. Man könnte anstelle der Knotenpunktregel auch schreiben: divE = 0. Oder vereinfacht: Alles was rein geht, geht auch wieder raus – zumindest im zeitlichen und räumlichen Mittel. Ich denke, das Kriterium der Gleichzeitigkeit spielt vor allem bei elektrischen Strömen eine Rolle. Wenn man für diesen Fall noch einen Kondensator im Knotenpunkt zulässt, entsprechend der Wärmespeicherung in der Oberfläche, dann sind zwar kuzzeitige „Verletzungen“ der Knotenpunktregel möglich, die sich aber bei längerer und globaler Betrachtung ausmitteln. Im Grunde steht „Knotenpunktregel“ für „Energiebilanz“. Dass man letztere zeitlich und räumlich gemittelt aufstellen kann, ist auch die Grundlage für die gezeigten, bekannten Grafiken.

„Wenn man für diesen Fall noch einen Kondensator im Knotenpunkt zulässt, entsprechend der Wärmespeicherung in der Oberfläche, dann sind zwar kuzzeitige „Verletzungen“ der Knotenpunktregel möglich, die sich aber bei längerer und globaler Betrachtung ausmitteln.“

Auch mit Speicherelementen (z.B. Kondensator), die an den Knoten eines elektrischen Netzwerkes angeschlossen sind, gilt der Knotenpunktsatz. Damit auch in analogen, z.B. thermischen Netzwerken für Leistungsfluss und Temperaturdifferenz. Das ist jetzt zwar Formalismus, der mit dem Anliegen des Artikels nicht so sehr viel zu tun hat, aber diese „Nebensächlichkeit“ sollte schon korrekt dargestellt werden. Der Vorzeichenfehler in der Knotengleichung am Anfang des Artikels für I3 ist übrigens noch immer drin …

Sehr guter Artikel Herr Dr. Ullrich! Danke dafür. Das Strahlungsdiagramm von Trenberth & Kiel hielt ich schon lange für physikalischen Unfug. Doch obwohl ich die Kirchhoffche Knotenpunktregel in der Elektrotechnik öfter mal einsätze, wäre ich nie darauf gekommen das Diagramm von T&K damit gegenzurechnen. Die Lösungen liegen oft näher als man denkt. Auch Ihre weitern Ausführungen stimme ich bis zun letzten Satz zu 100% zu.

Der Vorzeichen-Fehler in der Knotengleichung wurde sicher als Aufmerksamkeitstest eingebaut … (;-))(Beitrag kann nach Korrektur gelöscht werden)

„Eine weitere Möglichkeit zur Überprüfung bietet die Niederschlagsbilanz. Sämtlicher Wasserdampf, der durch Verdunstung in die Atmosphäre gelangt, kehrt als Niederschlag zur Erdoberfläche zurück. Wenn bei 1 Grad C Temperaturerhöhung die Verdunstung samt mitgeführter Verdunstungswärme um 7,5% zunimmt, dann müssten die Niederschläge ebenfalls um 7,5% zunehmen.“Diese These kann man mit globalen Niederschlagsdaten von NCEP Reanalysis überprüfen. In Bild 1 sind globale monatliche Mittelwerte (mm/Tag) für 1948 – 2021 gezeigt,in Bild 2 entsprechende Daten für 1991-2021. In beiden Fällen ist die Zunahme der Niederschläge geringer als 7,5% pro °C. Sie ist sogar geringer als der von Ihnen ermittelte Wert (vgl Daten der US-Umweltbehörde EPA).

Mehr LuftFeuchte „RH“ in der ATMO (earth.nullschool.net) schlägt sich auf den unterkühlten Flächen der AntArktis und Arktis (Grönland) „direkt nieder“ – evtl. auch durch „PolarSchnee“ – also ohne WOLKEN-Bildung – denke Ich mal !?! 😉

Herr Berberich, Sie haben sicherlich korrekt recherchiert. Doch was wäre, wenn es keine Zunahme der Niederschläge und somit der Verdunstungskühlung mit steigender Temperatur gäbe (was ich allerdings für nicht sehr wahrscheinlich halte)? Die verbleibenden, relativ kleinen Kühlkomponenten müssten die erwärmenden Antriebe kompensieren. Eine spannende Frage, insbesondere, wenn man ausschließlich Antriebe zuließe, die nichts mit anthropogenen Klimagasen zu tun haben.

Folgt man den IPCC-Modellen, dann würde bei fehlender oder relativ geringer Zunahme der Verdunstungskühlung das CO2 das Temperaturgeschehen dominieren. Verstärkt würde die vom CO2 verursachte Temperaturerhöhung mit IPCC-typischen großen, aber ziemlich unbestimmten Faktoren. Bei der vergleichenden Bewertung gerät man leicht ins Schwimmen: Klimasensitivität, CO2-Antrieb, letzterer aber zuzüglich Verstärkung, wobei die Verstärkung wiederum ein positiver Antrieb ist, der von der Temperatur und somit letztlich vom CO2 abhängt. Eine CO2-Abhängigkeit wie beschrieben dürfte immerhin gewährleisten, dass es keinen run away-Effekt gibt.

Halbwegs klar stellt sich die Lage für die Grenzfälle dar:

1) Große Zunahme der Verdunstungskühlung mit der Temperatur: Das Temperaturgeschehen wird weitgehend von der Verdunstungskühlung gemäß Oberflächenmodell bestimmt.

2) Die Verdunstungkühlung nimmt nur wenig oder gar nicht zu: Die Temperaturentwicklung würde letztlich von den IPCC-Modellen (wenn man ihnen folgt) dominiert und allenfalls geringfügig von den verbleibenden Kühleinflüssen des Oberflächenmodells verringert.

Zwischen diesen Grenzfällen dürfte es kontinuierliche Übergänge geben.

Herr Berberich, verlässliche Daten zur globalen Niederschlagsentwicklung interessieren mich sehr! Leider kann ich „Bild 1“ und „Bild 2“ nicht öffnen. Es wird lediglich der Texthintergrund auf Dunkel umgeschaltet, mehr passiert auf meinem Bildschirm leider nicht.

Für meine Begriffe ist das von Thieme formulierte Modell eines thermodynamischen Atmosphäreneffektes das physikalisch plausibelste zur Begründung der Erdbodentemperatur von 33 K über Strahlungsgleichgewichtstemperatur.http://real-planet.eu/atmoseff.htm Die darauf basierende Arbeit von Prof. Hebert beerdigt eigentlich jede CO2 Klimaerwärmung.https://sites.google.com/view/gegenpol-ostbelgien/klima/der-atmosph%C3%A4reneffekt-eine-alternative-zur-co2-theorieDie „große Transformation“ basiert im Grunde nur auf einer großen Lüge….

es gibt keine „fossilen Vorräte“…ein über 125 Jahre altes Energie-Märchen…bei EIKE anscheinend ein Tabu-Thema?

Der willkürliche Eingriff des menschen in das natürliche Klima geschieht tatsächlich mittels Geoengineering unter anderem mittels HAARP-Mikro- und Kurzwellen-Technologie sowie dem großtechnischen Ausbringen von wetteraktiven chemischen Substanzen mittels Flugzeugen (zivil wie militärisch) in der oberen Atmosphäre (Künstliche Wolkenbedeckung und Ausfilterung von UV-Strahlung), auch als „Chemtrails“ bezeichnet.Warum erscheint hier keine einzige kritische Stellungnahme dazu?Dipl. Ing. (FH) Roland Weißel, Berlin

und ewig grüßt das Murmeltier oder Predigt in der Wüste. Wir als EIKE- Community freuen uns über den großartigen Beitrag und haben kaum etwas hinzuzufügen und die es lesen müßten, werden es auch wiederum ignorieren. Leider ist es nicht nur hier so, sondern auf allen Fachgebieten und auch im Internet sucht man nur nach Zustimmungen. So geht fruchtbarer Ideenaustausch nicht!Sie reden von der Endlichkeit fossiler Energieträger. Kein Einspruch, denn jed Ding ist endlich. Ich bin mir sicher, dass es aber noch sehr viel mehr gibt als wir derzeit ahnen, das meiste unter dem Meersboden und technisch noch nicht erreichbar. Erdöl /Erdgas – Unternehmen wissen es wahrscheinlich längst und halten es als Betriebsgeheimnis unter der Decke. Deren Wissen um die geogene Entstehung (nicht biogen – fossil!!!) ermöglicht die Suche nach ertragshöffigen Stellen.Auf weit entfernten Monden von Jupiter und Saturn haben unsere Sterngucker ganze Meere von Methan entdeckt, weit weg von jeder derzeitigen oder früheren biogener Entstehungsmöglichkeit und wir schalten immer noch nicht. Die Erde ist nicht anders.Jede chemische Reaktion ist umkehrbar. Bei der Verbrennung von Methan entstehen CO2 und Wasser + Wärme. Im Erdmantel gibt es diese Wärme, absinkender Kalkstein wird gebrannt zu CaO und CO2. Saure Magma wird basisch und kommt als basisches Ergußgestein zu Tage. Silikate, aus denen fast alles besteht, nehmen Sauerstoff auf und der Weg ist frei zur Methansynthese im Reaktor Mütterchen Erde. Nun braucht es nur noch tektonische Risse zum Aufstieg und eine letzte gasdichte Sperrschicht wie Salz , Ton oder Permafrost. Wo es diese Sperrschichten nicht gibt, tritt es seit Jahr und Tag aus und verliert sich durch Oxydation. Anders am Meeresboden unter Druck. Dort verbleibt es als Gashydrate. So könnte es sein. Dass Methan auch untergeordnet anders entstehen kann als Sumpfgas, Grubengas, aus Faulschlamm oder Biogas ist kein Widerspruch.Also sollten wir weiterhin unter fossilen Energieträgern nur Torf, Braunkohle und Steinkohle sehen, aber für Gas und Öl eine andere Bezeichnung, zum Beispiel „geogen“ verwenden.

Bitte hier nur unter vollem Klarnamen posten, siehe Regeln.

Weiser Mueller waere besser gewesen!

Ich stimme zu, es gibt Thesen, wonach unsere „fossilen“ Energieträger nicht fossilen Ursprungs sind. Soweit ich das sehe, werden dies Thesen, die auf russische Wissenschaftler zurückgehen, in der Fachwelt bisher überwiegend nicht geteilt. Sollte sich daraus aber tatsächlich eine längere Nutzbarkeit der „Fossilen“ ergeben, dann, so vermute ich, dürfte sich längerfristig ein etwas höheres CO2-Gleichgewicht in der Atmosphäre einpegeln. Zeit zur Beobachtung incl. Möglichkeiten für geeignete Gegenmaßnahmen, falls notwendig (z.B. Kernenergie, Geoengineering, Solar- und Windenergie – zumindest, dort wo es Sinn macht) sollten vorhanden sein.

„Soweit ich das sehe, werden dies Thesen, die auf russische Wissenschaftler zurückgehen, in der Fachwelt bisher überwiegend nicht geteilt.“

Joo!

Und wie kommt das Methan auf die Monde???

Damit sind die Argumente der sog. „Fachwelt“ doch schon zerschossen…

„Möglichkeiten für geeignete Gegenmaßnahmen, falls notwendig…“

CO2 kann die Temperaturen der Erdoberfläche nicht beeinflussen, ergo sind „Gegenmaßnahmen“ überflüssig/schädlich und dienen lediglich der Profitgier von „Wissenschaftlern“/Beratern/Großunternehmen und der Profilierungssucht ideologisierter Politdeppen.

Ja, ich bin seit 2005 in diversen Foren zu diesen Themen aktiv und der „Peak Oil“ war bis ca. 2015 ein ökologisches Totschlagargument. Seitdem ist der „peak oil“ aus dem grünen Gruselkabinett verschwunden, dass das Erdöl und das Erdgas nicht ausgehen lässt sich eben nicht mehr grün-ideologisch verschleiern. Statt dessen muss verstärkt das Märchen vom CO2 Klimawandel dafür herhalten den Menschen die Nutzung von Kohlenwasserstoffen zu verbieten. Nächsten Sonntag ist im Südwesten Wahltag und die grünen Schlafschafe wählen sicher wieder die GRÜNECDU zu ihrem Metzger. Wir schaffen das…..

1) Mir sind Methanseen und -regen bisher nur vom Saturnmond Titan bekannt. Ich denke auch, dass man ähnliche Entstehungsgeschichte für die Erde nicht gänzlich ausschließen kann, aber für einen Beweis reicht das m.E. noch nicht. Vielleicht kann sich zu diesem interessanten Thema mal ein Prospektionsexperte äußern. Müsste sich da nicht Dr. Lüning von Kalte Sonne Bescheid wissen?

2) Ich bin mir inzwischen ziemlich sicher, dass vor allem Wasserdampf und in geringerem Umfang das Spurengas CO2 die Erde wärmer machen. Hauptbeweis sind für mich die IR-Spektrogramme mit ihren charakteristischen Dellen, aus dem Weltraum gemessen. Auch gehen nur so die im Artikel gezeigten Energie- und Strahlungsbilanzen auf. Es wäre natürlich nach wie vor ein Hit, wenn es einen Nachweis für Ihre These gäbe – die Postulierung alleine genügt aber nicht! Und auch die Thermodynamik wird eine „erhöhte Wärmeisolierung“ durch strahlungsaktive „Klimagase“ nicht verbieten. Sonst müssten die Heizungsmonteure damit aufhören, Warmwasserleitungen mit Wärmeisolierungen einzuhüllen. Eine ganz andere Frage ist, wie weit der nurmehr geringe Zusatzeffekt des anthropogenen CO2 sich in einer komplizierten Atmosphäre bemerkbar macht – siehe auch die riesige Unsicherheitsspanne bei den IPCC-Modellen, die zwar Verstärkungseffekte kennen, aber offenbar keine Abschwächung.

„Und auch die Thermodynamik wird eine „erhöhte Wärmeisolierung“ durch strahlungsaktive „Klimagase“ nicht verbieten.“

Doch!

Über den 2ten Hauptsatz!!!

Herr Dr. Ullrich, „…nachweis für Ihre These..“ Das sehe ich garnicht so als These. Das Massenwirkungsgesetz ist für Chemiker sowas fundamentales wie für Energetiker zum Beispiel das Energieerhaltungsgesetz. Will und brauch ich nicht beweisen, Überlegung genügt mir. Ich habe keinen Zweifel, dass Methan in der Hitze des Erdmantels entsteht, wenn das chemische Umfeld passt. Auch ich habe vor 60 Jahren noch gelernt, dass die Genese biogen und fossil sein soll. Chemisch war das schon damals nicht schlüssig zu erklären und technisch auch nicht zu bewerkstelligen.. Bis zur Steinkohle ja, aber wie weiter? Dagegen kann man Methan synthetisch herstellen (wirtschaftlich jedoch völlig unsinnig) und es soll nicht gelten, dass es auch natürlich geschieht?

Es freut mich ehrlich, wenn ich hier lese, dass auch Andere schon derartiges publiziert haben. Davon wußte ich nichts, weil ich altersmäßig aus der Literatur-line heraus bin. Der Vorhalt, dass die Mehrheit der Wissenschaftler die Ansicht nicht teilt, erinnert mich an das CO2- Argument von der Gültigkeit der Mehrheit oder der Erde als Scheibe auch mehrheitlich damals. Mehrheit sagt alles, beweist nichts. Trotdem, Ihre Beiträge gefallen mir immer wieder sehr.

Sehr gut erkannt. Fossil vielleicht als Unterbegriff von geogen?