… und den Wissenschaftlern des Establishments, die sie verborgen halten sollen.

Cap Allon

Einführung

Die in den letzten 50 Jahren beobachtete „globale Erwärmung“ ist schwächer ausgefallen als von den meisten computergestützten Klimamodellen vorhergesagt. Die öffentliche Politik sollte sich auf diese wenig alarmierenden Beobachtungen stützen und nicht auf übertriebene Modellrechnungen.

Die durchschnittliche Erwärmung des Klimasystems in den letzten fünf Jahrzehnten wurde den CO₂-Emissionen aus der Verbrennung fossiler Brennstoffe zugeschrieben. Diese Überzeugung hat zu Bemühungen geführt, die Abhängigkeit der Menschheit von solchen Brennstoffen stark zu verringern und auf „erneuerbare“ Energiequellen umzusteigen, die sich immer wieder als teuer und unzuverlässig erweisen – ein Schritt, der die Energiepreise im Westen in die Höhe treibt.

Laut Dr. Roy Spencer, leitender Wissenschaftler an der Universität von Alabama in Huntsville und ehemaliger leitender Wissenschaftler für Klimastudien bei der NASA, sind im Zusammenhang mit dem Anstieg der globalen Durchschnittstemperatur seit den 1970er Jahren drei Fragen von Bedeutung:

1) Ist die jüngste Erwärmung des Klimasystems im Wesentlichen auf die anthropogenen Treibhausgasemissionen zurückzuführen?

2) Liegt die beobachtete Erwärmung in der Nähe dessen, was Computerklimamodelle zeigen – die als Richtschnur für die öffentliche Politik dienen?

3) Reicht die beobachtete Erwärmungsrate aus, um Alarm zu schlagen und eine umfassende Regulierung der CO₂-Emissionen zu rechtfertigen?

Die Projektionen des Klimawandels, die in den Nachrichten zu lesen sind und die Grundlage für die Bemühungen der Regierungen um eine Verringerung der Kohlendioxidemissionen bilden, stammen aus computergestützten Klimamodellen, die von Klimaforschungszentren in verschiedenen Ländern betrieben werden, so Dr. Spencer in einer aktuellen Veröffentlichung für die Heritage Foundation.

Diese Prognosen ähneln den Wettervorhersagemodellen, sind aber mit zusätzlichen Verbesserungen versehen, die für kurzfristige Vorhersagen nicht erforderlich sind. Die Modelle sind so eingestellt, dass sie keine langfristigen Veränderungen des Klimas bewirken. Mit anderen Worten: Die Modelle gehen davon aus, dass sich ohne menschliches Zutun normalerweise nichts am Klima ändern würde, dass der „Klimawandel“ völlig unnatürlich ist – sie werden dann als „Beweis“ für den vom Menschen verursachten Klimawandel herangezogen, wenn zusätzliches CO₂ hinzugefügt wird.

Das ist natürlich ein logischer Widerspruch, wie Dr. Spencer betont. Es gibt natürlich zahlreiche natürliche oder nicht CO₂-bedingte Gründe, warum sich das Klima ändern kann.

Die zahlreichen Klimamodelle ergeben globale Erwärmungsraten, die etwa um den Faktor drei variieren (1,8°C bis 5,6°C). Dies zeigt, dass die Prognosen der Klimamodelle nicht auf gesicherten physikalischen Grundlagen beruhen. Wäre dies der Fall, würden sie alle in etwa die gleiche Erwärmung vorhersagen. Außerdem hat sich dieser Faktor drei in den mehr als 30 Jahren der Verbesserung der Klimamodelle nicht verändert.

Temperaturveränderungen sind das Ergebnis eines Energie-Ungleichgewichts, und alle Klimamodelle wurden so „eingestellt“, dass sie ohne die vom Menschen verursachten CO₂-Äquivalent-Emissionen ein Energie-Gleichgewicht herstellen. Ohne solche „Tuning-Anpassungen“ (Dr. Spencer nennt sie „Fudge-Faktoren“) würde die Temperatur der Modelle im Laufe der Zeit langsam driften, d. h. immer mehr steigen oder sinken. Trotz dieser Anpassungen hat sich gezeigt, dass viele Modelle immer noch Probleme mit der Energieerhaltung haben.

Die Energieerhaltung (das wahrscheinlich grundlegendste Gesetz der Wissenschaft, der Erste Hauptsatz der Thermodynamik) sollte eine notwendige Voraussetzung für jedes Modell sein, das für energiepolitische Entscheidungen verwendet wird. Die Notwendigkeit der Modellanpassung ist unvermeidlich, da die grundlegenden physikalischen Prozesse im Klimasystem (insbesondere die Eigenschaften der Wolken) nicht genau genug bekannt sind, um ein stabiles Modell allein aus physikalischen Grundprinzipien zu erstellen. Daher müssen empirische Anpassungen an diesen modellierten Prozessen vorgenommen werden, damit das Modell über Jahrhunderte der Modelllaufzeit nicht ungewollt Erwärmung oder Abkühlung simuliert. Doch selbst auf dieser grundlegenden Ebene versagen viele Modelle.

Die Annahme, dass sich das Klimasystem in einem natürlichen Zustand des Energiegleichgewichts befindet, bedeutet auch, dass die Modelle keine Quellen langfristiger natürlicher Klimaänderungen enthalten. Auch diese Annahme ist ziemlich unvermeidlich, da die Modelle nur Prozesse einbeziehen können, welche die Klimaforscher verstehen und quantifizieren können, und dieses Wissen ist derzeit für natürliche Quellen langfristiger Klimaänderungen nicht vorhanden. Während Wissenschaftler oft davon ausgehen, dass langfristige Veränderungen von einem externen Antrieb ausgehen müssen (wie z.B. steigendes CO₂ oder eine Veränderung der Sonnenaktivität), ist das Erdklima bekanntlich ein „nichtlineares dynamisches System“, das chaotische Schwankungen aufweist, so dass langfristige Veränderungen auch ohne externen Antrieb möglich sind.

Aufgrund der den Klimamodellen zugrundeliegenden Annahmen ist jede Behauptung, sie würden „beweisen“, dass die Erwärmung auf menschliche Aktivitäten zurückzuführen ist, eindeutig zumindest fragwürdig. Es gibt keine „Fingerabdrücke“ einer vom Menschen verursachten Erwärmung, fügt Dr. Spencer hinzu.

Der Betrug mit den Rückkopplungen

Der vertrauensvollen Öffentlichkeit wurde vorgegaukelt, dass die Modelle ziemlich genau angeben, wie viel Erwärmung bei einer Verdoppelung des atmosphärischen Kohlendioxidgehalts eintreten sollte.

Die Theorie der globalen Erwärmung selbst besagt, dass eine Verdoppelung des CO₂-Gehalts nur eine direkte Erwärmung von 1,2 °C verursachen würde, wenn es keine anderen Veränderungen im Klimasystem als die Temperatur gibt.

Es sind jedoch diese anderen, indirekten Veränderungen (die so genannten „Rückkopplungen“), bei denen die Klimamodelle in den Weltraum abheben, wo sie die eher harmlose Erwärmung von 1,2 °C erheblich verstärken und sie auf 1,8 °C bis 5,6 °C steigen lassen – je nach der Stimmung der Alarmisten an diesem Tag.

Die derzeitigen Behauptungen über eine „Klima-Krise“ sind das Ergebnis des Vertrauens in die Modelle, welche die stärkste Erwärmung hervorbringen, und nicht in die tatsächlichen Beobachtungen des Klimasystems, die unauffällige Veränderungen während des letzten Jahrhunderts und darüber hinaus zeigen.

Beobachtungen in der realen Welt

Nun zum Kern der Sache, dem Dämpfer für die Freude der AGW-Partei…

Klimamodelle haben in der Vergangenheit eine stärkere Erwärmung erzeugt als in den letzten Jahrzehnten beobachtet worden ist; dies wird durch die Daten belegt und kann nicht bestritten werden (trotz der vielen Versuche, es doch zu tun – mehr dazu später).

Diese Diskrepanz trifft nicht auf alle Modelle zu, da zwei von ihnen (beide russisch) Erwärmungsraten erzeugen, die relativ nahe an den Beobachtungen liegen, aber diese Modelle sind natürlich nicht die, die zur Förderung der Klimakrisen-Narrative verwendet werden – sie sind russisch.

Nur die Modelle, die die stärkste Erwärmung erzeugen, finden ihren Weg beispielsweise in die Nationale Klimabilanz der USA, die vom Kongress in Auftrag gegebene Bewertung dessen, was globale Klimamodelle für das Klima in den Vereinigten Staaten vorhersagen.

Ein direkter Vergleich zwischen Modellen und Beobachtungen offenbart jedoch die Diskrepanzen:

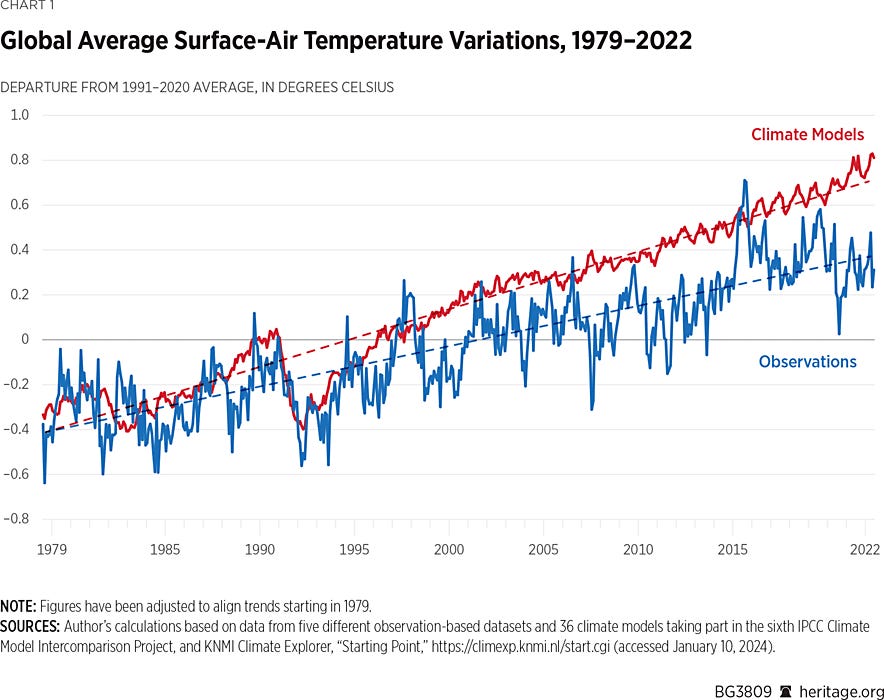

In der obigen Grafik wird der Durchschnitt von fünf verschiedenen , auf Beobachtungen basierenden Datensätzen (blau) mit dem Durchschnitt von 36 Klimamodellen verglichen, die in den sechsten IPCC Climate Model Intercomparison Project (CMIP6) eingehen.

Die Modelle haben im Durchschnitt eine um 43 % schnellere Erwärmung als die von 1979 bis 2022 beobachtete hervorgebracht – dem Zeitraum des schnellsten Anstiegs der globalen Temperaturen und der anthropogenen Treibhausgas-Emissionen, der auch dem Zeitraum entspricht, für den Satellitenbeobachtungen vorliegen.

Diese Diskrepanz zwischen Modellen und Beobachtungen wird nie erwähnt, obwohl die besagten Modelle verwendet werden, um den Bürgern der westlichen Welt (nicht Russland oder China, wohlgemerkt) zerstörerische politische Veränderungen aufzuzwingen, die über die Beobachtungen hinausgehen – Beobachtungen, die, wie ich hinzufügen möchte, oft von denselben Agenturen vorgelegt werden, die mit der Förderung von CAGW beauftragt sind, um es mal so zu sagen.

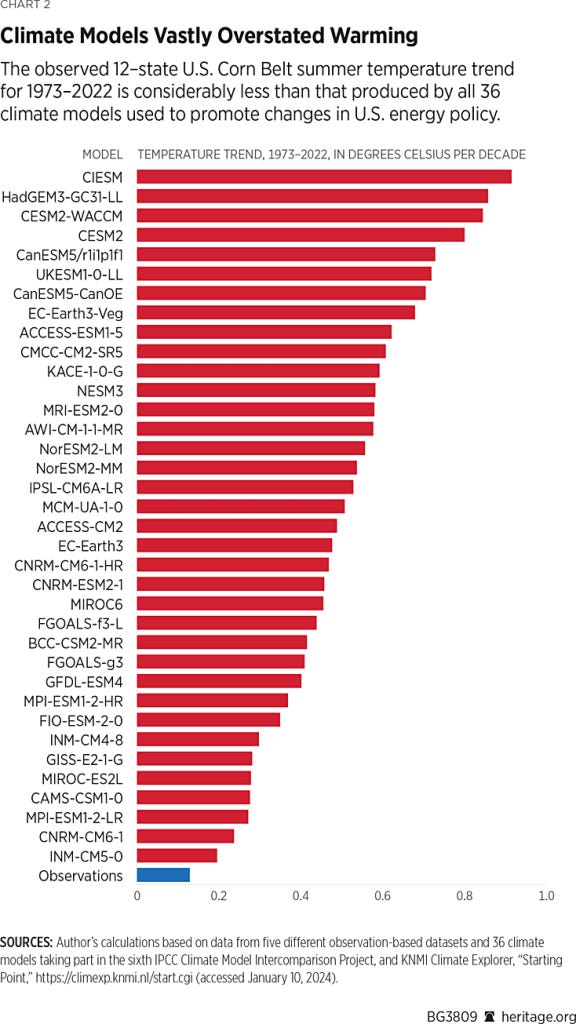

Es steht auch fest, dass die regionalen Temperaturen für die nationalen und regionalen Regierungen und ihre Bürger von größerer Bedeutung sind. In den Vereinigten Staaten zum Beispiel könnte ein starker Anstieg der Sommerhitze die menschliche Gesundheit und die Produktivität der landwirtschaftlichen Kulturen beeinträchtigen. Doch wie die nächste Grafik zeigt, weisen die Lufttemperaturen während der Vegetationsperiode (Juni, Juli und August) über dem Corn Belt in 12 Bundesstaaten in den letzten 50 Jahren eine enorme Diskrepanz zwischen den Klimamodellen und den Beobachtungen auf, wobei alle 36 Modelle Erwärmungsraten ergeben, die weit über den beobachteten Werten liegen, wobei das extremste Modell eine siebenmal zu starke Erwärmung erzeugt:

Die Tatsache, dass die weltweite Nahrungsmittelproduktion in den letzten 60 Jahren schneller gestiegen ist als das Bevölkerungswachstum, deutet darauf hin, dass etwaige negative Auswirkungen des Klimawandels gering bis gar nicht vorhanden waren. Tatsächlich ist gut dokumentiert, dass eine „globale Ergrünung“ als Reaktion auf mehr CO₂ in der Atmosphäre stattfindet, was sowohl das natürliche Pflanzenwachstum als auch die landwirtschaftliche Produktivität steigert.

Diese Diskrepanzen zwischen Modellen und Beobachtungen werden auch nie erwähnt, wenn diese Aktivisten-Wissenschaftler in den herkömmlichen Nachrichtenkanälen auftauchen. Stattdessen nutzen sie übertriebene Modellprognosen aus, um apokalyptische Erzählungen über einen „Klima-Notstand“ zusammenzubrauen.

Herausforderungen

Mit den oben genannten Argumenten werden Leute wie Dr. Spencer als „Parias“ und „Verschwörungstheoretiker“ positioniert, obwohl es die Daten sind, die für sich sprechen; sie machen sie zu Feinden des Establishments, zu einer Opposition, die ausgeschaltet werden muss.

Ein Beispiel dafür ist die kürzlich veröffentlichte Analyse von Dr. Spencer, die von Gavin Schmidt, dem Diener der AGW-Partei, angegriffen wurde.

Schmidt wurde wahrscheinlich damit beauftragt, die unbequemen Ergebnisse zu verleumden, was er auch tat, und zwar schnell. Weniger als vier Tage, nachdem Spencer seinen Artikel bei der Heritage Foundation veröffentlicht hatte, veröffentlichte Schmidt, der anscheinend nichts Besseres zu tun hatte, seine Kritik an „Spencers Albernheiten“ auf realclimate.org.

Seitdem hat Dr. Roy Spencer zurück geschlagen und eine Gegendarstellung zu jedem von Schmidts Punkten veröffentlicht.

„Wenn ich mir seine Kritik durchlese“, schreibt Spencer, „scheint er zu sehr zu versuchen, meine Behauptungen zu widerlegen, während er schwache (und sogar nicht vorhandene) Beweise verwendet.“

SCHMIDT: Der Basiszeitraum des Klimamodells (und der Beobachtung) (1991-2020) ist für die gezeigte Grafik (1. Diagramm oben) falsch. ROYS ANTWORT: Dies scheint ein Tippfehler zu sein, aber der Basiszeitraum ist für die Temperaturtrends irrelevant, um die es in dem Artikel geht.

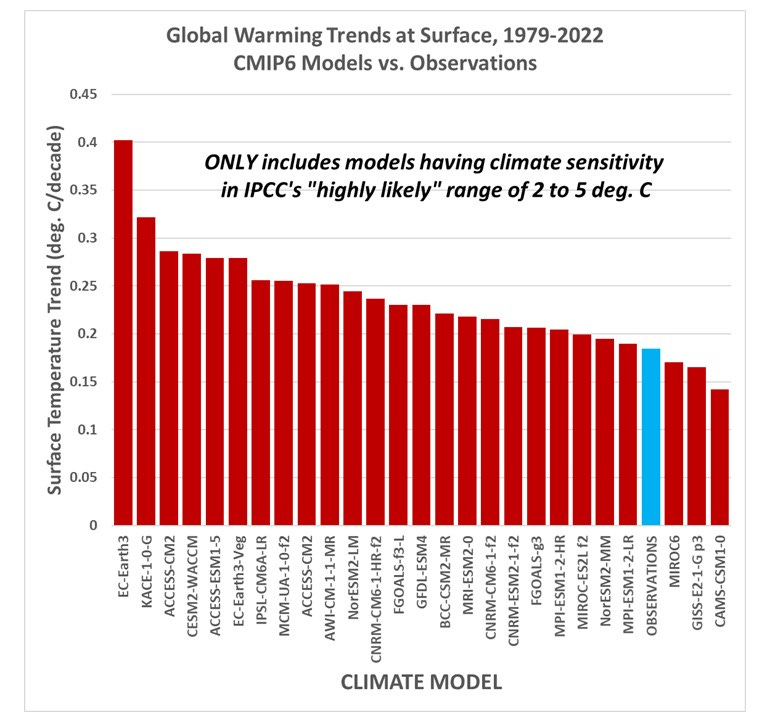

SCHMIDT: Die einzelnen Modelle, nicht der Modell-Durchschnitt, sollten gezeigt werden. Außerdem werden nicht alle Modelle in die IPCC-Schätzung der künftigen Erwärmung einbezogen, sondern nur die wärmsten Modelle, was die Diskrepanz verringern wird. ROYS ANTWORT: OK, wenn ich mir also nur die Modelle ansehe, die Gleichgewichts-Klimaempfindlichkeiten (ECS) im „sehr wahrscheinlichen“ Bereich des IPCC von 2 bis 5 deg. C für eine Verdopplung des atmosphärischen CO₂ diagnostiziert haben, zeigt die folgende Grafik, dass die beobachteten Erwärmungstrends immer noch am unteren Ende der Modellspanne liegen:

SCHMIDT: Gavin zeigt seinen eigenen Vergleich der Modelle mit den Beobachtungen (nur GISS, aber es ist sehr nah an Roys 5-Datensatz-Durchschnitt) und zeigt, dass die Beobachtungen innerhalb des Rahmens aller Modelle liegen. ROYS ANTWORT: Ich habe nie behauptet, dass die Beobachtungen „außerhalb des Rahmens“ aller Modelle liegen (zumindest für die globalen Durchschnittstemperaturen sind sie es für den Corn Belt). Ich will damit sagen, dass sie nahe dem unteren Ende der Modellspanne der Erwärmungsschätzungen liegen.

SCHMIDT: „Es gibt keine zusätzliche Anpassung, um den Unterschied in den Trends zu übertreiben“, wie es in Spencers Diagramm der Fall ist. ROYS ANTWORT: Ich habe keine Ahnung, warum Gavin glaubt, dass Trends davon beeinflusst werden, wie man zwei Zeitreihen in einem Diagramm vertikal ausrichtet. Sie werden es nicht. Um Trends zu vergleichen, richten John Christy und ich verschiedene Zeitreihen so aus, dass sich ihre linearen Trends am Anfang des Diagramms überschneiden. Wenn man darüber nachdenkt, ist dies die logischste Art, die Unterschiede in den Trends in einem Diagramm darzustellen, und ich weiß nicht, warum das nicht auch alle anderen tun. Jedes „Rennen“ beginnt am Anfang. Es scheint, dass Gavin es nicht mag, weil es die Modelle schlecht aussehen lässt, was wahrscheinlich der Grund ist, warum die Klimamodellierer es nicht so machen. Sie wollen Diskrepanzen verbergen, damit die Modelle besser aussehen.

SCHMIDT: Gavin mag es nicht, dass Dr. Spencer den US-Maisgürtel (2. Diagramm oben) „herauspickt“, wo die Erwärmung in den letzten 50 Jahren geringer war als die, die von ALLEN Klimamodellen erzeugt wurde. ROY’S ANTWORT: Der U.S. Corn Belt ist das größte Maisanbaugebiet der Welt. (Die Sojaproduktion ist ebenfalls sehr groß). Seit langem wird befürchtet, dass die Landwirtschaft dort durch steigende Temperaturen und geringere Niederschläge geschädigt wird. In dieser Publikation wurde beispielsweise behauptet, dass dies bereits so ist. Aber das ist nicht der Fall. Stattdessen ist die Erwärmung seit 1960 (da die Zahlen zur Ernteproduktion gut dokumentiert sind) (oder seit 1973 oder 1979… es spielt keine Rolle, Gavin) so gut wie nicht vorhanden, und die Niederschläge haben einen leichten Aufwärtstrend gezeigt. Warum habe ich mir also den Corn Belt ausgesucht? Weil er weltweit von der Getreideproduktion abhängig ist und weil behauptet wird, dass er unter dem „Klimawandel“ gelitten hat. Das hat er nicht.

SCHMIDT: Gavin wendet sich erneut gegen den Vergleich der globalen troposphärischen Temperaturdaten mit dem Durchschnitt mehrerer Modelle (in dieser Grafik) und nicht mit den einzelnen Modellen. Er zeigt dann ein ähnliches Diagramm, aber mit der Modellspanne. ROYS ANTWORT: Werfen Sie einen Blick auf sein Diagramm… die Beobachtungen (Satelliten, Radiosonden und Reanalyse-Daten) liegen ALLE am unteren Ende der Modellspanne. Gavin macht meinen Standpunkt für mich deutlich. UND… ich würde seinem Diagramm sowieso nicht trauen, weil die Trendlinien gezeigt und die Datenplots vertikal ausgerichtet werden sollten, damit sich die Trends am Anfang schneiden. Dies ist der logischste Weg, um die Trendunterschiede zwischen verschiedenen Zeitreihen zu veranschaulichen.

Schmidt geht nicht auf die anderen Punkte von Dr. Spencer ein, z. B. dass die auf Beobachtungen beruhenden Schätzungen der Klimasensitivität viel niedriger sind als die Behauptungen des IPCC, und auch nicht auf den Punkt, dass die kürzlich veröffentlichten Beweise zeigen, dass die Klimamodelle nicht einmal Energie sparen (was eine Notwendigkeit zu sein scheint, da die globale Erwärmung im Grunde eine Frage der Energieeinsparung ist).

Stattdessen schließt Gavin mit folgendem Satz: „Spencers Mätzchen zielen darauf ab, die Leser über die wahrscheinlichen Quellen von Diskrepanzen in die Irre zu führen und ihnen zu unterstellen, dass die Klimamodellierer an solchen Vergleichen nicht interessiert sind – und in beiden Punkten liegt er falsch.“

Man beachte, dass dies derselbe Gavin ist, der sich in der Fernsehsendung von John Stossel strikt geweigert hat, mit Dr. Roy Spencer zu debattieren, indem er aufstand und das Set verließ, bevor Spencer herein kam.

Es scheint, dass Gavin glücklich genug ist, Spencer hinter der Sicherheit seines Computerbildschirms selektiv zu widersprechen, aber eine offene und freie Debatte nicht riskieren kann. Das alles ist „ziemlich aufschlussreich“, schreibt Spencer.

Link: https://electroverse.substack.com/p/vast-dependencies-between-temperature?utm_campaign=email-post&r=320l0n&utm_source=substack&utm_medium=email (Zahlschranke)

Übersetzt von Christian Freuer für das EIKE

Da hört jeder Spaß auf, die Fairness sowieso. Die Klimakirche, Gefangene ihres dreisten Anspruchs, über die alleinige Wahrheit zu verfügen – obwohl es jeder Blinde mit Krückstock sieht, wie krass sie daneben liegt. Jeder seriöse Wissenschaftler würde solche „Ergebnisse“ in die Tonne treten. Nur unsere Politiker nicht, die uns mit diesem Wahnsinn ruinieren – aus infernaler Dummheit und Unfähigkeit.

deltaT = 1,1/0,69•0,22 = ECS•ln(420/280)/ln(2)

Das Ganze ohne Erläuterung, vor allem, ob diese schon ab dem Urknall Gültigkeit hat und ob das deltaT ein ordinäres deltaT oder gar ein adeliges globaldeltaT ist.

Besonders interessant sind die Zahlen 1,1 und 0,69 und 2,2. Vermutlich sind es neue Naturkonstanten, die aber noch nicht die allgemeine wissenschaftliche Wertschätzung erfahren haben. – Da wird man sich langsam darüber klar, dass die Wolken erheblich zur Systemstabilisierung beitragen, sie aber in den Modellen wegen der Unmöglichkeit deren Erfassung gar keinen Einzug gefunden haben, und dann steht da in einer neuen Weltformel eine 0,69, als ob sie als einzige Zahl in der Lage ist, unsere Zukunft zu beschreiben. Muss ja gehen, zumal man sich den Quotienten aus ln1,5 und ln2 noch so gerade vorstellen kann.

Eines steht sicher fest: Für die IPCC-Männer und den IPCC-Mann (=> Michael Mann) ist das sicher der letzte Stein der Weisheit, nur eben in eine erstaunlicherweise doch recht einfache Formel verpackt.

Auf jeden Fall kann man festhalten, dass das so errechnete deltaT schlussendlich die Dimension K*m²/W trägt. Scheint ein neuer Temperaturbegriff zu sein, wenn man T als Temperatur oder deltaT als Temperatur-Differenz auffasst. Man lernt eben einfach nicht aus. – Gut, wenn eine Erwärmung (Energie-Änderung) jetzt nicht in Ws sondern „Grad“ angegeben wird, kann man das ja so gerade noch einmal durchgehen lassen. Nur gilt dann wieder der bewährte Satz: Sieht interessant aus, is’ es aber nicht!

Herr Dietze schreibt: „Herr Prof. Puschner, da Sie bekanntlich mit W/m², Mittelwerten und Temperaturen Probleme haben,…“ Ein emergentes Klimasystem, unübersichtlich, dynamisch und multifaktoriell mit einer Einheitstemperatur zu etikettieren, ist nicht das Problem von Prof. Puschner. Es ist das Problem einer Clique von Lakaien, beim IPCC und Zweigstelle PIK beschäftigt, die eigens für eine pseudowissenschaftliche Fundierung des „baldigen Weltuntergangs“, argumentierend qua Instrument der selbstgefütterten Computerberechnungen, gegründet wurde; was eine brillante Geschäftsidee ist und eine unglaubliche Gewinnmaximierung in Aussicht stellt. Herr Dietze, selbst ohne jegliche physikalische Kenntnisse ist das ordinäre Temperaturgefälle in einem Wohnzimmer zwischen einer Messung am Fenster und direkt an der Heizung offensichtlich. Deshalb setzt sich Omma Pischke gerne an den Ofen. Mit solch fatalen Desavouierungen einfachster empirischer Erkenntnisse führen Sie Ihren so mühsam dargebotenen wissenschaftlichen Ansatz hier auf EIKE s e l b s t 👉 ad absurdum. 👎🏽 ZERO points.

Gerne, Herr Dietze, berichtige ich den Dimensionsfehler, er ist tatsächlich:

°C/(Co2-Verdoppelung),

aber damit immer noch nicht °C. Und natürlich messe ich auch die Temperaturen in unterschiedlichen Zimmern, macht ja auch die Heizungssteuerung, aber, und das ist der gravierende Unterschied, ich leite daraus nicht eine sog. „globale Erwärmung“ oder „globale Abkühlung“ des Globus ab.

Meine Kritik, dass für noch so komplexe oder auch genial einfache Rechnungen jedes Ergebnis irrelevant und falsch ist, wenn man mit einer nicht existierenden „Global-Temperatur“ als Eingangsgröße hantiert, ist davon unbenommen.

icht existierenden „Global-Temperatur“ als Eingangsgröße hantiert, ist davon unbenommen.

Und es sind gerade die Wolken, die dafür sorgen, dass sich die klimatischen Verhältnisse auf unserem Planeten seit Tausenden Jahren nur in überschaubarem Rahmen ändern. Nur, sie finden aufgrund ihrer Anzahl und Komplexität keinen Einzug in die sog. Klimamodelle, schließlich sind Wolken ja alles andere als regelmäßige geometrisch erfassbare Körper.

Es wird nicht mehr lange dauern, da wird man entdecken, dass man mit der Definition einer „Normwolke“ neue Gelder auftun und ein PIK 2.0, PIK 2.1 usw. gut durchfinanzieren kann. Die bisherigen Fehler beim Bilden einer Global-Temperatur trotz unterschiedlicher Objekte, die die Einzeltemperaturen bewirken, kann man ja weiterhin fortsetzen. Bis das einmal als falsch akzeptiert wird, kann man bestimmt noch einige Jahrzehnte für Klimafolgenforschung Gelder abzocken.

Wenn man die Normwolke geschickt (nicht richtig!) definiert, kann man jede Wolke auf jedem Quadratmeter des Globus durch eine Art Finite-Element-Methode zu Scheinwolken zusammensetzen und das als absolut richtig und fortschrittlich dem Durchschnittsbürger verkaufen. Und wenn man die Projektions-Programme (nicht Prognose-Programme) dann noch durch entsprechend geeignete Annahmen so gestaltet, dass bedrohliche Temperatur-Anstiege prognostiziert werden, sind die Geldquellen beim Bildungsstand unserer Politiker gesichert.

Das Klima verhält sich mit seinen atmosphärischen Ausgleichsprozessen (nicht Regelungen, da werden keine Istwerte im Vergleich zu Führungsgrößen bestimmt und davon abhängig etwas bewirkt), wie immer, aber die auf dem Globus lebenden Menschen können weiter gegängelt und ausgebeutet werden: „Same procedure as every year“. Oder aus Mediensicht „Nur schlechte Nachrichten sind gute Nachrichten!“

Das hält so an, biss die nächste Eiszeit sich nicht mehr leugnen lässt und in alter Übung dann wegen zu geringen Gehalts das CO2 in der Atmosphäre erneut der einzige Übeltäter ist. Auf CO2 wird der Mainstream nicht verzichten, so als würde man noch mit Setzmaschinen drucken und das CO2-Klötzchen (Matrizen) ist ja nun einmal bereits hergestellt und kann weiter verwendet werden.

Was heißt viele? Ich würde sagen alle!

Warum das so ist, haben Gerlich/Tscheuschner seinerzeit so erklärt:

„Das heißt, dass Erhaltungssätze (Kontinuitätsgleichungen, Bilanzgleichungen, Budgetgleichungen) nicht für Intensitäten niedergeschrieben werden können! Unglücklicherweise wird genau dies in den meisten klimatologischen Arbeiten getan. Dies ist der Kardinalfehler der Globalklimatologie.“

Weil W/m² stellt eine Intensität dar und keine Energie, deswegen heißt der Satz Energieerhaltungssatz und nicht Leistungserhaltungssatz.

Die von der Erde aufnehmbare Wärmeenergie hängt nur von zwei Parametern ab. Erstens von der zeitlich kontinuierlich eintreffenden Sonnenleistung und zweitens von der sog. Albedo. Also jenem Parameter, der angibt, wie viel von der ankommenden Energie tatsächlich durch Absorption in Wärme umgewandelt wird. Der Rest wird ohne Effekt reflektiert, hauptsächlich im sichtbaren Wellenlängenbereich.

Auf die Sonnenleistung hat der Mensch keinen Einfluß. Auf die Albedo aber schon. Je mehr Oberflächenanteile hin zu mehr Absorption verändert werden, z. B. durch Straßen und Siedlungen, desto höher wird die Absorption und damit die Gleichgewichtstemperatur. Eben weil sich das Gleichgewicht durch die tatsächlich wirkenden Nettoenergieaustausche ergibt.

Die natürlichen Albedoveränderer hinsichtlich Reflektion sind die modellmäßig schwer bis garnicht zu erfassenden Wolken (Wassertröpfchen). Nur eine korrekte Einbeziehung der stochastischen Wolkenmuster könnte Modelle wirklichkeitsnäher machen. Etwas, das aber aufgrund der inhärenten Stochastik eben ziemlich unmöglich sein dürfte. CO2 zählt aufgrund seiner physikalischen Eigenschaften jedenfalls nicht zu Albedoveränderern.

deltaT = 1,1/0,69•0,22 = ECS•ln(420/280)/ln(2)