Dr. Pat Michaels

Nach dem US-amerikanischen Global Change Research Act von 1990, wurde die Bundesregierung mit der Erstellung großer National Climate Assessments (NCA) [nationale Klima-Bewertungen; …~Abschätzungen] beauftragt, und heute ist die jüngste Wiederholung eingetroffen. Es ist typisch für diese Art von Dokumenten – viel darüber, wie die Zukunft die Menschheit dazu verurteilt, durch immer unregelmäßigeres Wetter und andere Beschwerlichkeiten zu leiden. Wie immer fehlen auch ein paar Informationen, die überzeugen, dass alles, was Bezug auf das kommende Klima des 21. Jahrhunderts nimmt, mit äußerster Vorsicht zu genießen ist.

Die Projektionen in der NCA basieren alle auf Klimamodellen. Wenn es darin etwas Wesentliches gibt, das systematisch darin nicht stimmt, dann sind die daraus abgeleiteten Projektionen es nicht wert, gemacht oder geglaubt zu werden.

Hier ist das erste bisschen an fehlenden Informationen:

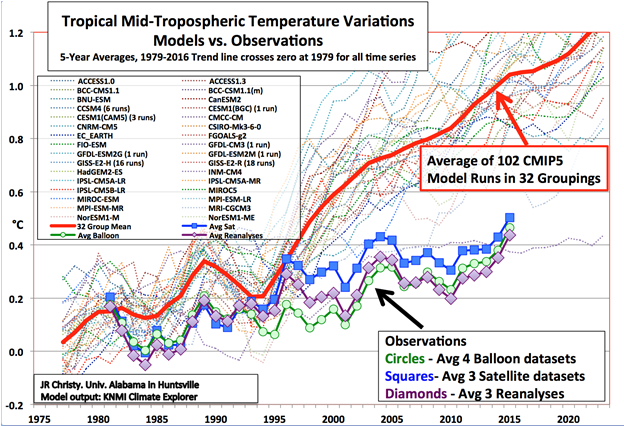

Das Diagramm zeigt die vorhergesagten und beobachteten tropischen (20⁰North-20⁰South) Temperaturen in der Mitte der aktiven Wetterzone der Erde – technisch gesehen die mittlere Troposphäre, ungefähr von 1.500m bis 9.100m Höhe. Die vorhergesagten Werte stammen aus den 102 Klimamodell-Realisierungen von 32 verschiedenen Basismodellgruppen. Diese Modelle stammen aus dem neuesten wissenschaftlichen Kompendium des Weltklimarats der Vereinten Nationen (IPCC) und sind das umfassendste verfügbare Set. Die Daten für die Grafik wurden vor kurzem im Bulletin der American Meteorological Societ veröffentlicht.

Die Quadrate zeigen den Durchschnitt der drei vorhandenen Datensätze für satellitengesteuerte globale Temperaturen in derselben Zone, die Kreise sind der Durchschnitt der vier Wetterballonaufzeichnungen und die Diamanten [Quadrate auf Spitze gestellt] sind die ausgefallenen neuen „Reanalysedaten“, die ein physikalisches Modell verwenden. um die Tatsache auszugleichen, dass nicht alle dreidimensionalen „Sondierungen“ der Atmosphäre jeden Tag von den gleichen Stationen kommen.

Der Unterschied zwischen den vorhergesagten Veränderungen und den beobachteten ist auffällig, wobei nur ein Modell, das russische INCM4, realistisch erscheint. In der jüngsten Iteration beträgt die Klimasensitivität (die Nettoerwärmung berechnet für eine Verdopplung der Kohlendioxid-konzentration in der Atmosphäre) 1,4 ⁰C (2,5 ⁰F) im Vergleich zum Durchschnitt von 3,2 ⁰C (5,8 ⁰F) in der Modellfamilie der nationalen Klimabewertung. In der Tat wird die Temperaturkurve, auf der sich die Erde befindet, zusammen mit einer erwarteten großen Verlagerung von Kohle zu Gas zur Stromerzeugung (die bereits in den USA und Kanada stattfindet) die vom Menschen verursachte Erwärmung auf weniger als 2,0 ° C (3,6 ° F) beschränken, für den Zeitraum zwischen 1950 und 2100, was das Ziel des Pariser Klimaabkommens ist.1

Das ist weit entfernt vom Extremismus der Nationalen Bewertung.

Das zweite Bit fehlender Informationen reicht aus, um die meisten Vorhersagen des Abschätzung ungültig zu machen. Es ist ein bisschen komplizierter als der erste.

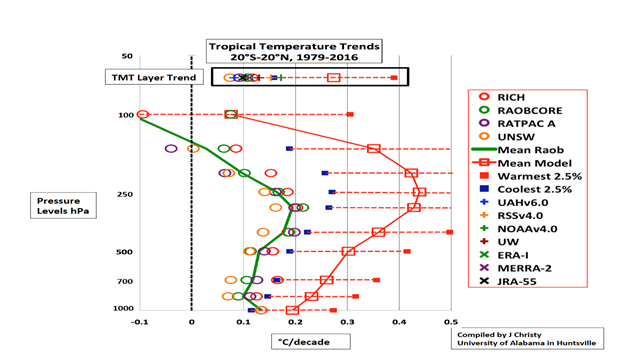

Die vertikale Achse ist die Höhe (gemessen durch den barometrischen Druck) und die horizontale Achse ist die Temperaturänderung in Grad C pro Dekade. Die durchgezogene grüne Linie ist der beobachtete Durchschnitt unserer vier Sätze von vertikal sondierenden Daten von Ballons. Sie können sehen, dass die beobachtete Erwärmungsrate an der Oberfläche (angegeben als „1000 hPa“ auf der linken Achse) etwas über 0,1° C / Dekade liegt, während der vorhergesagte Wert (1979-2016) unter 0,2 ° C liegt. Mit anderen Worten, in dieser Region, die für das globale Klima extrem wichtig ist, wird eine fast doppelt so hohe Erwärmung vorhergesagt als gemessen. Dies ist Abbildung S-2 im jüngsten Bericht über das Klima von 2016 des Bulleting der American Meteorological Society.

Aber die Situation wird wirklich entsetzlich [lächerlich], wenn man in der Atmosphäre aufsteigt. Die Modelle sagen voraus, dass es einen riesigen „Hot Spot“ über den gesamten Tropen geben sollte, was knapp 40% der Erdoberfläche ausmacht. Auf halber Höhe in der Atmosphäre (bestimmt durch den Druck) oder bei 500 hPa ist die vorhergesagte Erwärmung auch das Doppelte von dem, was beobachtet wird, und weiter oben wird siebenmal mehr Erwärmung vorhergesagt als beobachtet wird.

Dieses ist von größter Bedeutung. Die vertikale Temperaturverteilung in den Tropen bestimmt die Niederschlagsbildung. Wenn der Unterschied zwischen der Oberfläche und den oberen Schichten groß ist, ist die Oberflächenluft schwimmfähiger und wölbt sich aufwärts wie die Kumulonimbus-Wolke eines schweren Gewitters. Ist die Differenz geringer, wird die Sturmaktivität unterdrückt. Wie aus der Grafik hervorgeht, soll der Unterschied immer geringer werden, was in der generellen Tendenz zum tropischen Trocknen führen würde. In der Realität tritt das Gegenteil über einen großen Teil der Tropen auf, was eher zu einer Zunahme des Niederschlags als zu dem von den Klimamodellen prognostizierten Rückgang führt.

Das Fehlen des tropischen Hot Spots provoziert eine zusätzliche Kaskade von Fehlern. Eine große Menge der Feuchtigkeit, die hier den Niederschlag bildet, stammt aus den Tropen. Macht man das falsch, wird die Niederschlagsvorhersage mit zusätzlichen Folgewirkungen, diesmal für die Temperatur, reiner Müll.

Scheint die Sonne auf eine nasse Oberfläche, trägt der überwiegende Teil der einfallenden Energie eher zur Verdunstung von Wasser bei, als auf die direkte Erwärmung der Oberfläche. Deshalb herrschen im heißesten Monat in Manaus, Brasilien, mitten im tropischen Regenwald und nur drei Grad vom Äquator entfernt, hohe Temperaturen von nur 33°C (nicht nennenswert anders als das feuchte Washington, DC mit 31°C. Um die Wirkung von Wasser auf die Oberflächenerwärmung von Landgebieten abzuschätzen – es wurden im Juli im knochentrockenen Death Valley hohe Temperaturen von durchschnittlich 47°C gemessen.

Eine falsche Bestimmung der Oberflächentemperatur hat zusätzliche Konsequenzen für Vegetation und Landwirtschaft. Im Allgemeinen ist eine feuchteres Wetter gut für Rekordernten und eine gute Wasserversorgung im Westen der USA, was sich jedoch in der Abschätzung nicht wiederfindet.

So leidet diese Abschätzung, wie seine Vorgänger, unter ernsten und offensichtlichen Mängeln, die einfach ignoriert werden. In unserem 2004 erschienenen Buch Meltdown dokumentierten wir die ersten Bewertungsmodelle , die schlechter als eine Tabelle mit Zufallszahlen waren , die für das 20te Jahrhundert angrenzenden US Temperaturen und der Leitende Wissenschaftler des Bericht wusste es und kam damit durch! Die letzte (dritte) Veröffentlichung in Buchlänge – brachte öffentliche Kommentare, alle mit einem Sinn für Klimahumor, und die zweite Veröffentlichung war so schlecht, dass wir ein ein beinahe spiegelbildliches Dokument veröffentlichten.

Das Ignorieren der oben erwähnten massiven und kritischen Fehler – zusammen mit der aufkommenden Geschichte über die Willkürlichkeit der Klimamodelle – wird [hoffentlich] sicherlich dazu führen, dass das „Endangerment Finding“ der EPA [Feststellung der Gefährdungen] erneut überprüft wird, was die Basis ist für die Regulierung von Treibhausgasen.

1 Michaels, Patrick J. „Gemeinsamkeiten bei Klimaschutz und Anpassung finden“ 2017.

Erschienen auf WUWT am 03.11.2017

Übersetzt durch Andreas Demmig

Was Sie in der neuen US-Klimabilanz nicht finden werden

Cato Deckblatt, Link s.u.

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Werter Herr Demmig,

danke für die schöne Übersetzung. ich möchte nochmals an die Veröffentlichung von M.mann, B, Santer et al erinnern, die festgestellt hat, daß die sogenannte pause existiert und all eModelle diese weder vorhersagen noch im Nachhinein berechnen konnten. Die Modelle sind also alle falsch. Wie sollen aus falschen Modellen nur entfernt richtige Projektionen folgen?