Bild rechts: Quelle: www.STOPGREENSUICIDE.COM

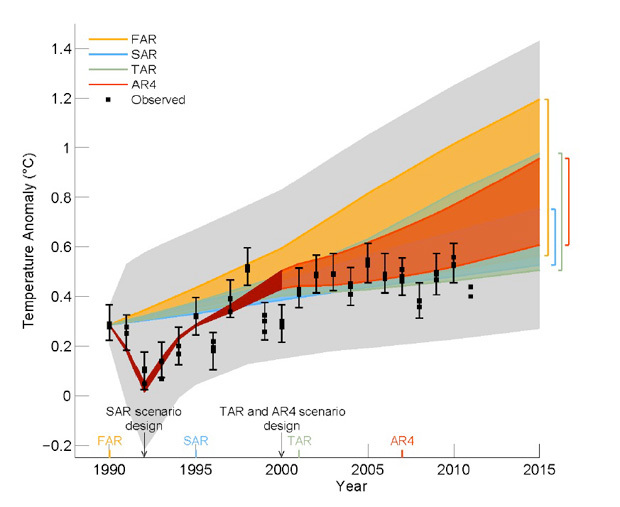

Bei dem Bild rechts handelt es sich um Abbildung 1.4 aus Kapitel 1 einer Version des 5. Zustandsberichtes des IPCC. Die Initialen oben repräsentieren den Ersten Zustandsbericht FAR aus dem Jahr 1990, den Zweiten (SAR) aus dem Jahr 1995. Schattierte Flächen zeigen die Bandbreite eines jeden der vier Klimamodelle, die in allen vier Zustandsberichten seit 1990 verwendet worden sind. Der letzte dieser Berichte wurde 2007 veröffentlicht. Modellläufe nach 1992 wurden nachträglich angepasst, um der vorübergehenden Abkühlung nach dem Ausbruch des Pinatubo auf den Philippinen im Jahre 1991 Rechnung zu tragen. Die schwarzen Quadrate zeigen mit den Fehlergrenzen die gemessene mittlere Temperatur im gleichen Zeitraum. Die Bandbreite der Modellläufe wurde in den vertikalen Säulen gebündelt. Die hellgrauen Flächen oben und unten sind nicht Teil der Bandbreite der Modellvorhersagen. Die endgültige Version des AR 5 wird Ende dieses Monats veröffentlicht werden.

Die Graphik stammt aus derjenigen Version, die im vergangenen Winter einer Experten-Begutachtung unterzogen worden ist. Sie vergleicht Klimamodell-Simulationen der globalen mittleren Temperatur mit den Beobachtungen seit dem Jahr 1990. Während dieser Zeit ist der atmosphärische Kohlendioxidgehalt um 12% gestiegen, nämlich von 355 ppm auf 396 ppm. Die IPCC-Graphik zeigt, dass die Klimamodelle korrespondierend damit im gleichen Zeitraum einen Temperaturanstieg zwischen 0,2 und 0,9°C vorhergesagt haben. Aber die tatsächliche Temperaturänderung hat nur 0,1°C betragen, was innerhalb der bandbreite um Null liegt. Mit anderen Worten, die Modelle haben den Erwärmungseffekt der CO2-Emissionen während der letzten 22 Jahre erheblich überschätzt.

Kapitel 9 der IPCC-Version zeigt, dass eine Überschätzung der Erwärmung selbst über längere Zeiträume beobachtet worden ist, nämlich im Vergleich mit Daten von Satelliten und Wetterballonen über den Tropen. Wegen der dominanten Rolle der Tropen für die planetare Verteilung von Energie und Niederschlag müssen die Modelle die Verhältnisse in den Tropen richtig abbilden, wenn sie glaubwürdig sein sollen hinsichtlich der Simulation des globalen Klimasystems. Basierend auf allen vom IPCC verwendeten Klimamodellen sollte es in dieser Region (vor allem in der mittleren Troposphäre der Tropen) zu der stärksten Treibhauserwärmung kommen. Jedoch zeigen die meisten Daten seit über 30 Jahren praktisch keinerlei Temperaturänderung.

Der Wissenschaft des IPCC zufolge, die seit den neunziger Jahren konstant aufrecht erhalten wird, ist das CO2 der Haupttreiber der derzeitigen Klimaänderung, und die natürliche Variabilität ist zu gering, um im Vergleich damit mithalten zu können. Dies ist auch die Ansicht des „Mainstream“ hinsichtlich der Klimawissenschaft, und dies wurde in alle modernen Klimamodelle hineinprogrammiert. Die Ergebnisse der Modelle wiederum haben die außerordentlich kostspielige globale Klima-Agenda der letzten Jahrzehnte befeuert. Aber jetzt wird immer klarer, dass die Modelle die Erwärmung erheblich übertrieben haben, und darin liegt ein Problem.

Ebenso wie die Diskrepanz zwischen Modellen und Realität größer geworden ist, ist auch die Anzahl der Mainstream-Wissenschaftler gestiegen, die behutsam darauf hinzuweisen beginnen, dass die Klimamodelle demnächst einer Art Überarbeitung bedürfen. In einer vor Kurzem erschienene Studie einiger gut bekannter deutscher Klima-Modellierer wurde die Wahrscheinlichkeit, dass die Modelle gegenwärtig mit den Beobachtungen in Übereinstimmung gebracht werden können, mit unter 2% angegeben, und es heißt darin, dass bei weiteren fünf Jahren ohne eine größere Erwärmung die Wahrscheinlichkeit auf Null fallen wird.

Das IPCC muss jeden für einen Dummkopf halten

Mehr noch, das Haupt-Klimamodellierungs-Labor in UK hat gerade in diesem Sommer seine langfristigen Wettervorhersagen revidiert um zu zeigen, dass es für mindestens die nächsten fünf Jahre keine Erwärmung vorhersagt. Falls dieses Modell richtig liegt, beweist es selbst, dass alle anderen Modelle seiner Art fundamental falsch liegen.

Für jene von uns, die die Klimadebatte seit Jahrzehnten verfolgt haben, werden die nächsten fünf Jahre elektrisierend sein. Die Wahrscheinlichkeit ist sehr hoch, dass wir Zeuge des Zusammenbruchs eines der einflussreichsten wissenschaftlichen Paradigmas des 20. Jahrhunderts werden, und die Auswirkungen auf Politik lokal und global könnten gravierend sein.

Es ist die Aufgabe der gigantischen UN-Organisation IPCC, die Führer der Welt über die Entwicklungen auf diesem Gebiet immer aktuell auf dem Laufenden zu halten. Dieser in wenigen Tagen fällige Bericht wäre doch die Chance, über diese erstaunlichen Entwicklungen zu berichten, nicht wahr? Nun, raten Sie noch einmal!

Beurteilt man das nach den Versionen, die in diesem Jahr in Umlauf gekommen sind, befindet sich das IPCC noch voll im Stadium des Leugnens. Seine eigene Graphik enthüllt eine Diskrepanz zwischen den Modellen und den Beobachtungen, und doch sagt es in der Diskussion etwas ganz anderes. Auf Seite 9 in Kapitel 1 erklärt es, woher die Werte stammen, es spricht über die zahlreichen Herausforderungen durch die Modelle und fasst dann die Graphik so zusammen: „Die global gemittelte Temperatur liegt deutlich innerhalb der Unsicherheits-Bandbreite aller früheren IPCC-Projektionen und generell in der Mitte der Bandbreite der Szenarien“. Weiter hinten, in Kapitel 9, wird mit „sehr hoher Zuversicht“ festgestellt, dass die Modelle die globalen Temperaturtrends korrekt simulieren können.

Das IPCC muss jeden Menschen für einen Dummkopf halten. Seine eigene Graphik zeigt, dass die beobachteten Temperaturen nicht innerhalb der Unsicherheits-Bandbreite der Projektionen liegen; sie sind unter die unterste Grenze der gesamten Spanne gefallen. Auch simulieren die Modelle Erwärmungstrends falsch; stattdessen übertreiben sie sie erheblich. (Sie passen sie auch nicht an regionale Maßstäbe an, wo sie typischerweise nicht besser passen als die Randwerte).

Dies ist nicht die Zeit für kostspielige und permanente klimapolitische Maßnahmen

In dem Abschnitt des Berichtes, in dem die Fehlvorhersagen der Modelle in den Tropen diskutiert werden, räumt das IPCC ein (mit „hoher Zuversicht“), dass die Modelle die Erwärmung in den Tropen überschätzen. Dann sagt es mit einem Schulterzucken, dass der Grund für diese Abweichung „schwer fassbar“ ist und lässt das Ganze prompt unter den Tisch fallen. Was ist mit den Implikationen dieser Abweichung? Das IPCC ist zu diesem Punkt nicht nur auffällig schweigsam, sondern kommt trotz aller gegenteiligen Beweise auch zu dem Ergebnis, dass es „sehr hohes Vertrauen“ hat, dass die Klimamodelle die atmosphärischen Auswirkungen sich ändernder CO2-Gehalte korrekt repräsentieren.

Die Lage lässt sich in fünf Schlüsselpunkten zusammenfassen

Erstens, etwas Großes wird demnächst geschehen. Die Modelle zeigen etwas und die Daten etwas ganz anderes. Die zahlreichen Versuche während der letzten Jahre, diese Differenzen zu überspielen, sind zersetzend. Während der nächsten paar Jahre kommt es entweder zu einer plötzlichen, rapiden Erwärmung, die die Temperaturen auf die von den Modellen vorhergesagten Niveaus schießen lässt, oder das Mainstream-Paradigma der Klimamodellierung fällt in sich zusammen.

Zweitens, da wir unmittelbar vor der Erkenntnis stehen, dass die aktuellen Daten die Fundamente der Mainstream-Klimatologie zum Einsturz bringen können, ist jetzt offensichtlich nicht die Zeit, kostspielige und permanente klimapolitische Maßnahmen zu ergreifen, die auf gescheiterten Modellvorhersagen beruhen. Die wirkliche Botschaft der Wissenschaft lautet: Man warte noch ein wenig, es werden bald Informationen kommen, die unser Verständnis dieses Themas radikal verändern können.

Drittens, alles, was gemeinhin als die „Mainstream“-Sichtweise der Klimawissenschaft genannt wird, basiert auf den Ergebnissen von Computermodellen. Was gemeinhin als „skeptisch“ oder „Leugner“ verunglimpft wird, steht in Übereinstimmung mit den Beobachtungen in der realen Welt. Sie wissen jetzt, wie man diese Ausdrücke interpretieren muss, wenn sie genannt werden.

Viertens, oftmals hören wir Slogans (von keinem Geringeren als Obama selbst sowie vielen anderen), dass 97% aller Klimaexperten, 97% aller veröffentlichten klimawissenschaftlichen Studien und alle führenden Wissenschaftsgesellschaften der Welt darin mit der Mainstream-Wissenschaft, wie sie in den Modellen zum Ausdruck kommt, übereinstimmen. Aber die Modelle zeigen nicht die Wirklichkeit. Die klimawissenschaftliche Gemeinschaft hat sich eine schlechte Zeit ausgesucht, mit der Uniformität des Gruppendenkens unter ihnen anzugeben.

Fünftens und letztens, das IPCC hat wieder einmal bewiesen, dass es unfähig ist, objektiv zu sein. Die kanadische Journalistin Donna Laframboise hat akribisch das Ausmaß dokumentiert, mit dem das IPCC durch Umweltaktivisten während all der Jahre unterwandert worden ist, und jetzt sehen wir das Ergebnis. Dass die Diskrepanz zwischen Modell und Wirklichkeit immer größer und deutlicher wird, wird man in den IPCC-Berichten zuallerletzt erwähnt finden.

Link: http://opinion.financialpost.com/2013/09/16/ipcc-models-getting-mushy/

Übersetzt von Chris Frey EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Schauen Sie mal direkt in die Sonne – aber machen Sie die Augen zu. Spüren Sie die Infrarorstrahlung der Sonne (ca. 50% der Strahlung).

Anschließend machen Sie das gleiche miz Blick auf die Erde und spüren die Infrarot-Rückstrahlung der Erde auf der Haut. Aber nicht zu lange, wenn Sie an die sonnengleiche Rückstrahlung der Erde glauben. Sonst kriegen Sie einen Rückstrahlungsbrand, und das ohne braun zu werden!

#8: J. Ehlig sagt:

am Montag, 23.09.2013, 00:04

Wenn die Modelle eine Rückstrahlung der Erde von über 300 W/m2 und eine fast so große Gegenstrahlung durch die „THG“ annehmen, dann kann nur Unsinn rauskommen. Eine solche Infrarotstrahlung der Erde gibt es nicht – das kann jeder Mensch selbst feststellen ohne Meßgerät.

######## #######

Und wie,

bitte erläutern?

Wenn die Modelle eine Rückstrahlung der Erde von über 300 W/m2 und eine fast so große Gegenstrahlung durch die „THG“ annehmen, dann kann nur Unsinn rauskommen. Eine solche Infrarotstrahlung der Erde gibt es nicht – das kann jeder Mensch selbst feststellen ohne Meßgerät.

Herr Wanninger #8

Gunnar Innerhofer sagt:

‚…die „ozeandynamik“ wird man niemals als solche einbauen können…‘

Ähem! Hallo ???? Wir lassen also so ca. 50% der Antriebe auf das Klimasystem mal weg und modellieren fleissig weiter, die Klimasensitiviät von Co2 kennt G. Innerhofer ja.“

1. Herr Wanninger, wird weder die Dynamik (als solche!) der Atmophäre noch die der Ozeane jemals in die Klimamodelle eingehen. Sie hegen vielleicht eine falsche Vorstellung, was Dynamik in diesen Fällen bedeutet. In der Meteorologie, also der Dynamik der Atmosphäre bildet die Beschreibung der zeitlichen Entwicklung und Änderungen eines Luftvolumens mehrere partielle Differenzialgleichungen, welche nicht numerisch lösbar sind. Es gibt aber sehr gute Näherungsmethoden und das wird in den sg. Wettermodellen gerechnet. Wie wir wissen, geht das gerade mal einige Tage in die Zukunft recht gut. Klimamodelle funktionieren wesentlich einfacher, es geht im Prinzip nur um Randwertprobleme und das bedeutet eben, dass die Dynamik (die chaotischen Zustände in Luft als auch Fluiden) nicht berücksichtigt werden kann.

Oszillationen, wie ich schrieb, od. auch andere Energieflüsse werden selbsverständlich nicht vernachlässigt, da haben sie einfach was falsch verstanden.

Übrigens habe ich nicht von der Klimasensitivität geschrieben, sondern nur vom Forcing der TH Gase. Das sind zwei paar Schuhe.

„Komisch ist nur, dass er genau die rekursiv aus dem Klimaverlauf bestimmt, wobei wesentliche Einflussgrößen wie die atlantischen und pazifischen Oszillationen einfach mal weggelassen werden…“

Hat niemand behauptet, wer lesen kann, ist im Vorteil…:-)

„Sonst sind Sie aber noch gesund ???“

Bei ihrem Wissensstand sollten sie sich solche Auswürfe sparen.

„Ein ganz Gesunder käme vielleicht auf das Ergebnis, dass die gesamte Klimamodellierung und -prognose total in die Hose gegangen ist, weil man wesenliche Antrriebe kaum ausreichend kennt und versteht und andere (wie solare) einfach ignoriert und sich wie ein scharfer Wachhund auf Co2 festgebissen hat.“

So gesund wie sie? Vielleicht sind sie wirklich sehr gesund und verfügen sogar über einen gesunden Hausverstand. Zum Verständnis der Meteorologie und der Klimatologie bedarf es dann aber doch ein wenig mehr…

#3 Gunnar Innerhofer sagt:

‚…die „ozeandynamik“ wird man niemals als solche einbauen können…‘

Ähem! Hallo ???? Wir lassen also so ca. 50% der Antriebe auf das Klimasystem mal weg und modellieren fleissig weiter, die Klimasensitiviät von Co2 kennt G. Innerhofer ja. Komisch ist nur, dass er genau die rekursiv aus dem Klimaverlauf bestimmt, wobei wesentliche Einflussgrößen wie die atlantischen und pazifischen Oszillationen einfach mal weggelassen werden, weil deren Berücksichtigung ‚in die Hose geht‘ ???

Sonst sind Sie aber noch gesund ???

Ein ganz Gesunder käme vielleicht auf das Ergebnis, dass die gesamte Klimamodellierung und -prognose total in die Hose gegangen ist, weil man wesenliche Antrriebe kaum ausreichend kennt und versteht und andere (wie solare) einfach ignoriert und sich wie ein scharfer Wachhund auf Co2 festgebissen hat.

#4: „Man weiß überhaupt nicht, was denn nun für diese ca. 15a Null Anstieg verantwortlich ist. Es könnte auch die Dynamik der Atmosphäre sein, welche die „Dynamik“ der Ozeane beeinflusst und umgekehrt. Oder die Modelle arbeiten zB. mit zu schwachen Signalen über die Sonnenaktivität, überschätzen die Albedo Rückkopplung usw usw.

Einzig das Forcing über TH Gase dürfte ganz gut einfließen. Da dieses über 10-20a jedoch so gering ist, kann es eben im Rauschen völlig verschwinden.“

Hallo Herr Innerhofer, da stimme ich Ihnen absolut zu. Nur verstehe ich nicht, warum selbst eine Reihe von Leuten, die ein MINT-Fach studiert haben, nicht nachvollziehen können, was das Signal-Rausch-Verhältnis bei der Durchschnittstemperatur bewirkt? Wieso fällt es denen so schwer zu verstehen, dass kürzere Zeitintervalle stärker durch das Rauschen beeinflusst werden als länger Abschnitte? Wieso glauben sie, man müsste in einem 15-Jahres-Abschnitt 1:1 ein CO2-Temperatur-Signal erkennen? Sowas ist mir immer echt ein Rätsel.

@ Fischer #3

deine Aussagen dazu sind ja größtenteils korrekt, denke ich.

Aber:

die „ozeandynamik“ wird man niemals als solche einbauen können, weil eben Dynamik…wenn, dann wird gemutmaßt, welche Oszillationen für die Stagnation verantwortlich sein könnten und hat man was gefunden, was dann auch gut reproduziert, wird man damit arbeiten, auch wenn der Ansatz noch so falsch ist.

Man weiß überhaupt nicht, was denn nun für diese ca. 15a Null Anstieg verantwortlich ist. Es könnte auch die Dynamik der Atmosphäre sein, welche die „Dynamik“ der Ozeane beeinflusst und umgekehrt. Oder die Modelle arbeiten zB. mit zu schwachen Signalen über die Sonnenaktivität, überschätzen die Albedo Rückkopplung usw usw.

Einzig das Forcing über TH Gase dürfte ganz gut einfließen. Da dieses über 10-20a jedoch so gering ist, kann es eben im Rauschen völlig verschwinden.

Man wird sich definitiv damit begnügen müssen, die Dynamik des Systems weiterhin weg zu lassen. Ist ja auch nicht das große Problem, wenn man zB. die globale Mittel T um 2050 od. 2100 abschätzen will. Man sollte aber die Finger von regionalen Klimamodellen lassen und wie es zB. der DWD macht, diese für T und RR für einzelne Regionen Deutschlands auch noch veröffentlichen. Das kann nur in die Hose gehen.

Mc Kitrick schreibt:

„Die hellgrauen Flächen oben und unten sind nicht Teil der Bandbreite der Modellvorhersagen.“

Was sind dann die grauen Flächen? Im durchgesickerten Draft des AR5 steht:

„The 90% uncertainty estimate due to observational uncertainty and internal variability based on the HadCRUT4 temperature data for 1951 -1980 is depicted by the grey shading.“

Und das kann man jetzt einfach mal weglassen? Hm. Ansonsten empfehle ich, den endgültigen Bericht abzuwarten und mal schauen, ob diese Graphik so überhaupt erscheinen wird. Ich finde, es ist sehr problematisch, die Kurven im warmen Jahr 1990 beginnen zu lassen.

Ob McKitricks Argumentation nachhaltig ist? Man stelle sich vor, die nächste Generation von Modellen mit verbesserter Ozeandynamik kann die Stagnation reproduzieren. Man stelle sich vor, die Erwärmung steigt im nächsten Jahrzehnt sprunghaft an. Dann gäbe es ja laut McKitrick keinen Grund mehr, an Modellen zu zweifeln. Oder sollen wir dann warten, bis auch die Niederschlagsmengen im Januar in Timbuktu auf die 2. Nachkommastelle genau reproduziert werden und falls nicht, sind alle Modelle falsch?

Modell mit „glatter Senfsoße“

Dass die Klimamodelle „schwammig“ seien, ist ja sehr milde ausgedrückt. Ross McKitrick setzt sich ja hier auch nur mit der Qualität der Modelle auseinander, nicht mit der Frage, welche Annahmen liegen ihnen zugrunde und welche davon sind falsch. Das ist aber gängige Praxis von IPCC und NIPCC und zeigt, wie problemlos heute von allen Seiten an der Sache vorbei argumentiert wird.

Das gilt auch für das Kapitel über diese Klimamodelle im neuen Buch „Die Klimafalle“ des Treibhauseffekt-Mitläufers Hans von Storch. Ich habe es gelesen und es war das erste Buch, das ich von der Stadtbibliothek Hanau nicht als Buch, sondern ganz schnell und ganz bequem als E-Book erhalten haben.

Hier meine Ergebnisse und meine Fragen zur Position des Professors HvS bei den Klimamodellen:

Wo versteckt sich das Chamäleon Hans von Storch heute? Eher im Lager der „Warner“, mit denen er die Klimaforscher meint oder eher im Lager der „Skeptiker“?

Im Buch schreibt er zur Begründung des Titels „Klimafalle“: „Warner wie Skeptiker berufen sich auf eine angeblich zeitlose Wissenschaft und erwarten. dass diese als objektive Schiedsrichterin die Debatte – natürlich zu den jeweils eigenen Gunsten – entscheidet.“

Das klingt ja so als stünde HvS als neutraler Vertreter der „zeitlosen Wissenschaft“ über beiden Streithähnen.

Aber wie sieht das bei folgendem Satz aus über die besonders fortschrittlichen Modelle, bei denen die Atmosphäre und der Ozean miteinander „gekoppelt“ sind:

„Man glaubte, wohl zu Recht. dass in diesem gekoppelten Modell die wesentlichen Eigenschaften zur Bestimmung der klimatischen Reaktion auf erhöhte Konzentrationen von atmosphärischem Kohlendioxid ausreichend gut beschrieben waren. Da war es in Ordnung, dass der Ozean in diesem Modell kein Wasserkörper war, in dem sich z. B. Wirbel bilden, sondern eine Senfsoße, die mehr oder minder glatte Strömungen bildet.“ Der Ozean ein wirbelfreie Senfsoße? Wechselt unser Chamäleon da gerade die neutrale Farbe, um ins Lager der Skeptiker zu schlüpfen?

Doch schon kommt gleich darauf der nächste Farbwechsel nun hin zu den Warnern:

„Was vorher nur vermutet worden war, wurde durch Anwendung von Hasselmanns Ansatz der „Signaltrennung“ mithilfe von Daten der aktuellen Entwicklung und unter dem Einsatz von Klimamodellen nun erhärtet. Das Ganze nahm die Form eines statistischen Tests an: Die Nullhypothese. „Erwärmungstrend der letzten Jahre größer als natürliche Trends“ wurde abgewiesen mit einer Irrtumswahrscheinlichkeit von weniger als 5 Prozent, die Eigenschaft „nicht natürlich“ des Wandels war also zu 95 Prozent „signifikant“. So der technische Befund. Das MPI informierte die Presse darüber, aber aus der Irrtumswahrscheinlichkeit von weniger als 5 Prozent wurde: 95 % der Erwärmung ist „menschengemacht“. Mit den Medien zu sprechen ist eben nicht einfach.“

Da haben wir’s. Weil nicht die Warner schuld sind, sondern die Medien, kann unser Chamäleon nun die Farbe der Warner annehmen. Denn die Warner waren ja gar keine Warner, sie wurden nur von den Medien zu Warner gemacht. Sie haben „nicht natürlich“ einfach falsch übersetzt mit „menschengemacht“.

Was bin ich so glücklich, dass ich so farblos bin. Ganz ohne Modell und ohne eigene Daten weise ich nach, was CO2 wirklich macht und was die Physikalische Chemie in meinem Kopf vorhersagt:

CO2 kühlt! Dr. Gerhard Stehlik

Jetzt bin ich mal gespannt, was die einschlägig bekannten Herrschaften diesmal zum Besten geben?

Wie immer vielen Dank in den Übersetze und einen schönen Wahlsonntag mit AfD 5+

PS. 5- wär‘ auch ein toller Erfolg