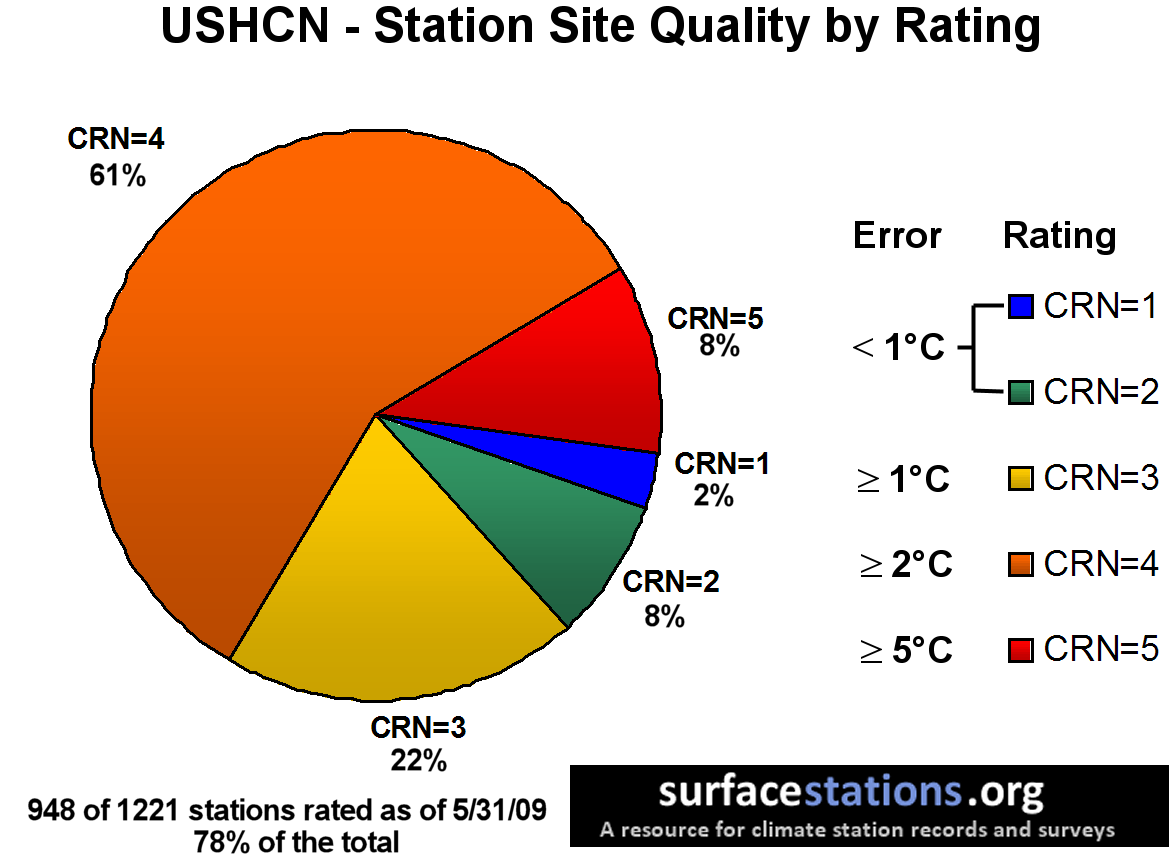

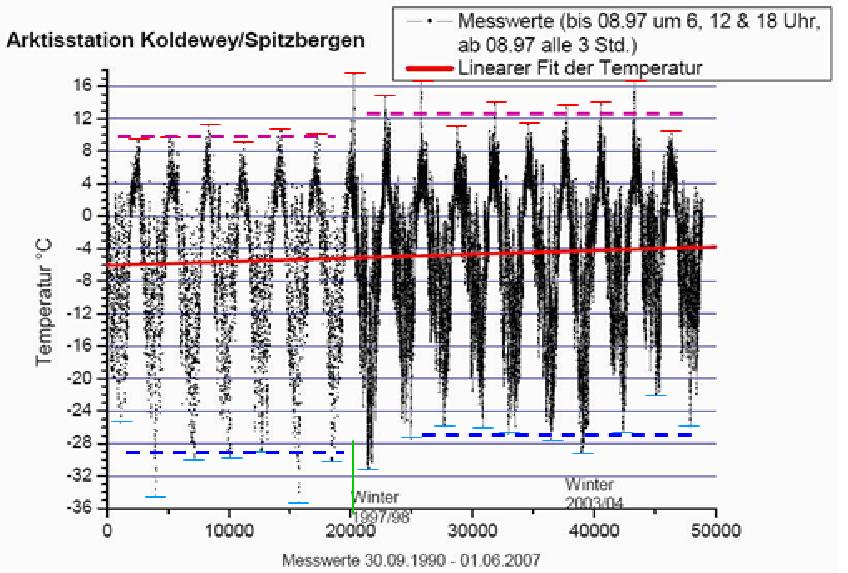

Zum eigentlichen Thema, der Temperaturentwicklung. Hier muss zuallererst einmal genauer die Erfassung derselbigen, sowie die statistische Auswertung betrachtet werden. Der letzte IPCC-Bericht 2007 (AR4) geht von einem Temperaturanstieg um, je nach Szenario, 0,11°C – 0,64°C pro Dekade aus. In den USA werden Audits der dort verwendeten Temperaturstationen durchgeführt, inwieweit deren Ergebnisse richtige Werte wiedergeben. Das Ergebnis fasst die folgende Abbildung zusammen.

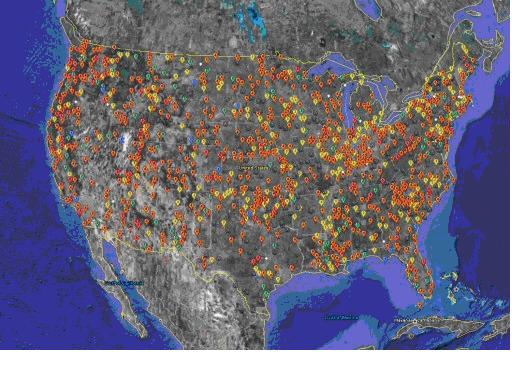

Die Abbildung 1 zeigt, dass 90% der Messstationen des US-Temperaturnetzwerkes einen Fehler von größer 1°C aufweisen und damit der Fehler bereits deutlich höher liegt, als die Temperaturbandbreite, die das IPCC in seinem Bericht AR4 als mögliche Dekadenerhöhung angibt. Bei der Auditstudie (http://www.surfacestations.org/) handelt es sich nicht um Stichprobenuntersuchung, sondern um eine Flächenerfassung der Messstationen, wie die folgende Abbildung zeigt, bei der 82% der Temperaturmessstationen auditiert wurden. Aus verständlichen Gründen fehlt in Deutschland eine ähnliche unabhängige Überprüfung.

Die Abbildung 2 zeigt die Klassifizierung der über den USA verteilten Temperaturmessstationen. Die rote Farbe überwiegt eindeutig. Es wurden 82% aller Temperaturmessstationen erfasst, wobei nur 10% der Stationen einen Fehlerwert von <1°C aufweisen.

Die Abbildung 2 zeigt die Klassifizierung der über den USA verteilten Temperaturmessstationen. Die rote Farbe überwiegt eindeutig. Es wurden 82% aller Temperaturmessstationen erfasst, wobei nur 10% der Stationen einen Fehlerwert von <1°C aufweisen.

Folgend nur zwei Beispiele von hunderten, warum die Messstationen solche Fehlertoleranzen aufweisen.

Die Abbildung 3 zeigt eine Temperaturmessstation in Perry, Oklahoma in unmittelbarer Nachbarschaft zur Feuerwehr. Dazu die Infrarotaufnahme, die zeigt, wie die Hauswand auf die Station rückkoppelt.

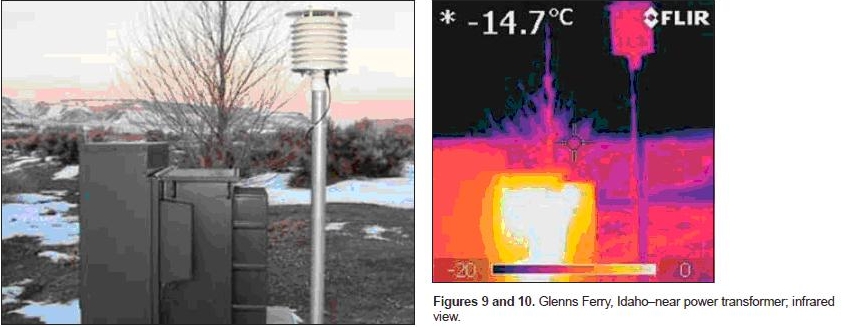

Die Abbildung 4 zeigt eine Temperaturmessstation in Glenns Ferry, Idaho in unmittelbarer Nähe einer Trafostation. Auch hier entlarvt die IR-Aufnahme, wie stark sich der Trafo erhitzt und auf die Station einwirkt.

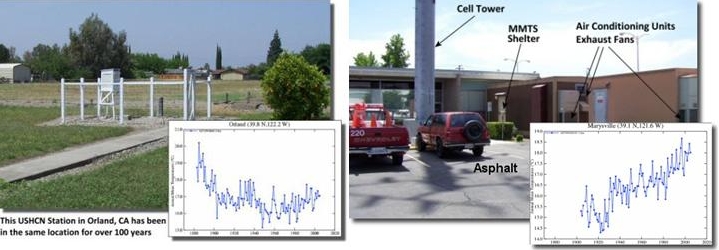

Die Studie zeigt weiter, dass Datenreihen von Stationen außerhalb von künstlichen Energiequellen/Rückstrahlern, keine Auffälligkeiten bei den Temperaturwerten ausweisen, wie folgende Abbildung links zeigt.

Die Abbildung 5 links zeigt die Messstation Orland in Kalifornien. Deutlich ist zu sehen, dass die Temperaturen zu Beginn des 20. Jahrhunderts z.T. deutlich höher lagen als während des sog. Klimawandels. Die Abbildung rechts (beide Abbildungen, Quelle: http://www.surfacestations.org/) zeigt eine ungenügende Station, die sich in unmittelbarer Nähe von aktiven Heizstrahlern befindet und einen starken Temperaturanstieg ausweist.

Geradezu unverschämt für einen Temperaturvergleich zu bisherigen Temperaturdaten ist die Tatsache, dass zum 01.04.2001 weltweit eine neue Temperaturdatenerfassung mit neuer statistischer Auswertung eingeführt wurde, alt und neu aber in ein und denselben Graphen abgebildet werden und dies auch noch unkommentiert. In 2001 wurden die sog. Mannheimer Temperaturwerteerfassung abgelöst.

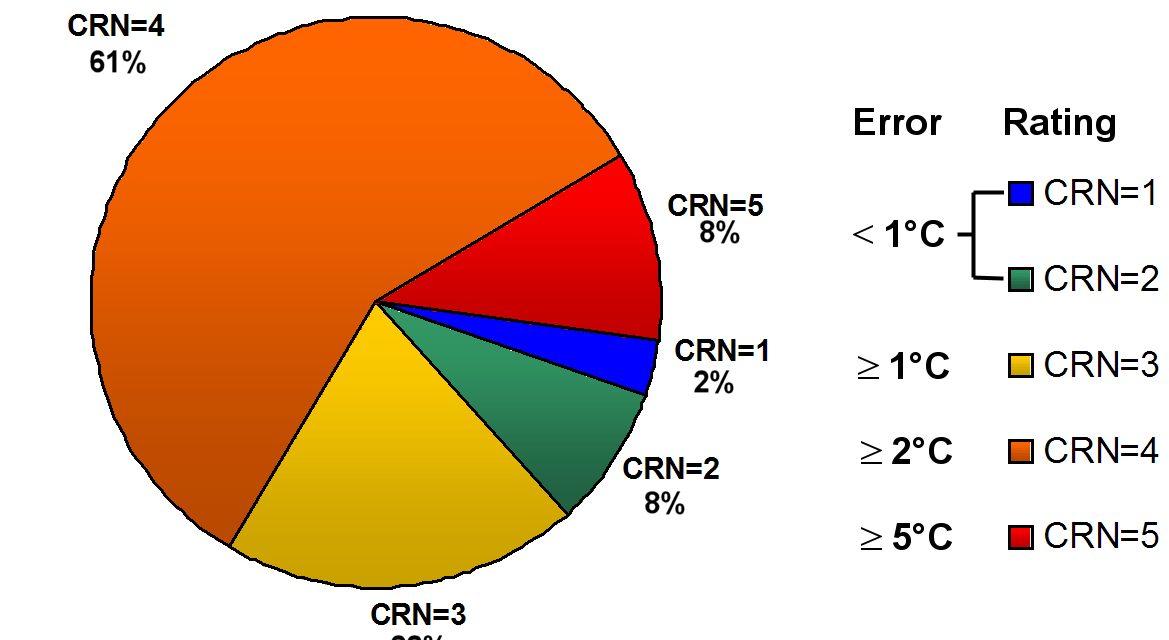

In Deutschland wurde bis zum 31.03.2001 um 7,30 Uhr, 14,30 Uhr und 21,30 Uhr (letzter Wert wurde doppelt gewertet, weil man sich den vierten Wert in der Nacht sparen wollte – geht auf den Meteorologen Johann Jakob Hemmer zurück, der erstmalig im 18. Jahrhundert einen weltweiten Standard einführte) gemessen und durch 4 geteilt. In der Schweiz um 7 Uhr, 13 Uhr und 19 Uhr (letzter Wert wird doppelt gewertet) und durch 4 geteilt. In Frankreich wurde nur das Tagesminimum und das Tagesmaximum gemessen und durch 2 geteilt. Und so hatte jedes Land eine andere Methode zur Ermittlung der Durchschnittstemperatur. Alle diese Daten werden jedoch zu einer Globaltemperatur einfach gemittelt, was wissenschaftlich betrachtet bereits ein Husarenstück darstellt. Ab dem 01.04.2001 wird nun stündlich gemessen (wobei auch 4-mal am Tag gemessen werden darf), und die Addition der Werte durch 24 dividiert (bzw. durch 4). Auf Grund des stark asymmetrischen Tagesganges der Temperatur, ergeben sich beim selben Tag andere Tagesmittelwerte, je nach Anwenden der Methode und zwar gehen nach der neuen Methode die Tagesmittelwerte der Temperatur, wegen der geänderten statistischen Auswertung, in die Höhe, wie in Abbildung 6 gezeigt wird.

Wie sehr sich die Temperaturmesswerte ändern, wenn die Datenerfassungszeiten und Datenmengen in der vorgenommenen Art und Weise geändert werden, zeigt sehr anschaulich das folgende Beispiel. Dies war unter (http://home.arcor.de/meino/klimanews/index.html#) im Netz. Nach einer Diskussion des Autors dieses Berichtes mit Prof. Dr. Rahmstorf in 2008 auf KlimaLounge, war der Link einige Tage später vom Netz. Dem Autor liegt das Screenshot dieser jetzt gelöschten Seite (Name: “Bremen und Umland im Bild“) vor, welches in der Anlage (lättern Sie auf Seite 18 und 19 der Anlage arktische Temperaturen Mittelwerte) ersichtlich ist.

Die Abbildung 6 zeigt die Temperaturmessungen (auf der Abszisse sind die Anzahl der Messungen aufgetragen) der Wetterstation in Ny Ålesund auf Spitzbergen (Station “Koldewey“), die vom Alfred-Wegener-Institut betrieben wird. Vom Herbst 1990 bis Sommer 1997 wurde dreimal am Tag und zwar um 6-, 12-, und 18 Uhr gemessen. Ab Sommer (bis heute) wird acht mal täglich gemessen und zwar um 0-, 3-, 6-, 9-, 12-, 15-, 18-, und 21 Uhr. Sehr gut ist zu erkennen, dass mit der neuen Temperaturerfassung, die Temperaturkurve deutlich angehoben wird. Die Messwerte um 15 Uhr verursachen darüber hinaus noch starke Temperaturausreißer nach oben. Sowohl im Zeitraum 1990 bis Sommer 1997, als auch im Zeitraum vom Winter 1997 bis 2007 ist keine Tendenz der Temperatur zu erkennen. Wird aber über den gesamten Zeitraum von 1990 bis 2007 die Temperatur betrachtet, so steigt diese, aufgrund der vorgenommenen Änderung der Datenerfassung.

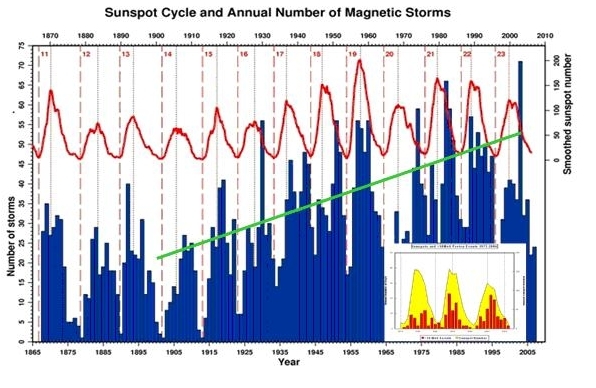

So ist denn auch der verbliebene, schwache Temperaturanstieg im 20. Jahrhundert, wie er auf Satellitendaten des UAH (http://climateresearchnews.com/wp-content/uploads/2008/12/uah_lt_since_1979.jpg) zu sehen ist, auf die gesteigerte Sonnenaktivität im 20. Jahrhundert zurückzuführen. Die Max-Planck Gesellschaft titelte am 27. Oktober 2004, “Sonne seit über 8.000 Jahren nicht mehr so aktiv wie heute“. Die folgende Abbildung zeigt denn auch, wie Sonnenaktivität und Temperatur auf der Erde bis in die heutige Zeit synchron laufen. Die Auswirkungen variabler Sonnenaktivität auf die Temperaturentwicklung bis in die Gegenwart, wurden auf EIKE bereits in zahlreichen Berichten dargelegt, z.B.: (http://www.eike-klima-energie.eu/news-anzeige/warnung-solar-cycle-may-cause-dangerous-global-cooling-in-an-few-years-time/).

Wichtig ist weiter zu wissen, dass es sich beim sog. TSI (Total Solar Irradiance), der üblicherweise zum Beleg der solaren Aktivität herangezogen wird, um eine irreführende Bezeichnung handelt, da nicht, wie die Bezeichnung angibt, die gesamte Strahlung der Sonne abgebildet wird, sondern nur der Teilbereich der Solarstrahlung von 200 nm – 2.000 nm, da die Satellitenmesssysteme nur diese Bandbreite erfassen.

Abbildung 7 zeigt die Änderung der magnetischen Stürme auf der Sonne von 1867 bis 2007 (blau, die grüne Linie zeigt den Trend von 1900 – 2005) und den 11-jährigen Schwabe-Zyklus. Es ist deutlich erkennbar, dass der Schwabe-Zyklus und der Gleißberg-Zyklus (Maximum während dem 19. Schwabe-Zyklus), der den Schwabe-Zyklus antreibt, zwar mit den relativen Maxima der magnetischen Stürme korreliert, nicht aber mit deren steigender Tendenz. Diese steht in Relation zum de Vries/Suess-Zyklus. Ergänzt nach Quelle: British Geological Survey (http://www.geomag.bgs.ac.uk/earthmag.html). In der kleinen Abbildung, in der die 3 letzten Schwabe-Zyklen dargestellt sind, ist gut zu sehen, wie mit dem Anstieg des de Vries/Suess-Zyklus die magn. Aktivität der Sonne stark zunimmt. Hierzu sind die hochenergetischen Protonen, die als Maß dienen, als rote Balken eingezeichnet (Quelle: NOAA Space Environment Center). Siehe auch unter (http://wetterjournal.wordpress.com/2009/07/14/der-einfluss-des-im-mittel-208-jahrigen-de-vriessuess-zyklus-auf-das-klima-der-erde/)

Quo vadis Temperatur?

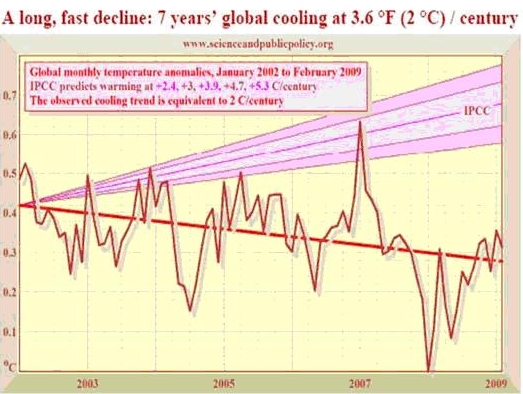

Die NASA, das Space and Science Research Center (SSRC) in Orlando und mittlerweile einer der bekanntesten deutschen Klimaforscher, Prof. Latif (http://www.eike-klima-energie.eu/news-anzeige/global-cooling-paradigmenwechsel-des-ipcc/) gehen für die nächsten Jahrzehnte von fallenden Temperaturen aus. Grund dafür sind keine Treibhausgase, wie auch nicht für den leichten Temperaturanstieg im 20. Jahrhundert, sondern, die fallende Sonnenaktivität, die ihr Maximum im de Vries/Suess-Zyklus um das Jahr 2003 hatte und bis zum Jahr 2005 hoch blieb. So schrieb der Sonnenforscher der NASA David Hathaway in 2005 (wir erinnern uns noch an die vermeintlichen Hitzetoten, die 2005 Einzug in die Presseberichte nahmen) “Das Solare Minimum explodiert – Das Solare Minimum sieht seltsamerweise aus wie ein solares Maximum“ (http://science.nasa.gov/headlines/y2005/15sep_solarminexplodes.htm). Von dieser Seite gab es unter (http://www.astrolabium.net/archiv_science_nasa/science_nasa_september2005/16-9-2005.html) eine deutsche Übersetzung, wie der Link-Name erkennen lässt – er bezieht sich eindeutig auf den NASA-Artikel. Auch dieser Artikel wurde kurz nachdem der Autor in einer Diskussion auf KlimaLounge mit Prof. Rahmstorf den solaren Einfluss auf das Klima darlegte, wenige Tage später aus dem Netz genommen. Heute ist dort eine Wettseite zu finden, die in keiner Weise mehr zum Link-Namen passt. Nach diesem kleinen Exkurs zurück, wie sich die Temperaturen, entgegen aller Prognosen des IPCC entwickelten. Die folgende Abbildung gibt dies wieder.

Die Abbildung 8 zeigt die fallende Temperaturentwicklung von Januar 2002 bis Februar 2009. Deutlich zu sehen, dass die Temperaturentwicklung entgegengesetzt zu den IPCC-Prognosen verläuft, Quelle: (http://vademecum.brandenberger.eu/themen/klima/ipcc.php#cooling).

Siehe auch unter (http://www.globalresearch.ca/index.php?context=va&aid=10783).

Derzeit ist die Sonne so inaktiv, wie seit mindestens 200 Jahren, so dass die Temperaturen, wie NASA, SSRC, Latif u.v.m. angeben für die nächsten Jahrzehnte fallen werden. Das Wissenschaftsmagazin Spektrum der Wissenschaft titelte in seiner Ausgabe 02/09 zur globalen Temperaturentwicklung und den IPCC-Prognosen “Kalt erwischt“.

Da die CO2-Konzentration offensichtlich weiter steigt, zumindest geben dies die diversen Messungen auf dem Mauna Loa an, ist ersichtlich, dass eine atmosphärische CO2-Konzentration keine Temperaturen triggert und somit keinen erkennbaren Einfluss auf diese ausübt. Das gegenwärtige trommeln einer drastischen Temperaturerhöhung um 4°C ( siehe z.B. hier) bis 2050, die (zufälligerweise?) doppelt so hoch ausfällt, wie die Postulate der Staats- und Regierungschefs auf dem G8-Treffen im Juli in L’Aquila, Italien, hat denn auch den Anschein, Medien, Journalisten und Öffentlichkeit mit Desinformationen auf Linie zu bringen, um dadurch Druck aufzubauen, dass die Klimakonferenz in Kopenhagen den Weg für weitere Milliardensummen im Klimamarkt freimacht. Wer die Zeche letztendlich zu begleichen hat, führte uns die Finanz- und Wirtschaftskrise vor.

Raimund Leistenschneider (EIKE)

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"@NB #9:

Die Geschichte hat bedauerlicherweise häufig genug gezeigt, dass wissenschaftliches Arbeiten kein Garant für fehlerfreiheit ist.

@NB

Stimmt, sie haben recht, bei GISS werde ich mich am besten schlau machen, um zu sehen, welche Fehler man wie am besten macht, und am häufigsten.

Und Frank Abels Kritik an automatischen Wetterstationen als naiv hinzustellen empfinde ich schon fast als eine Frechheit.

@ Limburg und Gans,

zwischen Ihren naiven Vorstellungen und wissenschaftlicher Arbeit liegen Welten. Für Sie also der gleiche Tipp: Machen Sie sich erstmal schlau, bevor Sie meinen, etwas Sinnvolles dazu beitragen zu können.

@NB

„In den bekannten Kurven für das globale Mittel steckt viel mehr Arbeit und Datenanalyse als Sie sich je erträumen.“

Errechnen kann man alles was man will, und was „man“ will, wissen wir.

Allein schon das „runterrechnen“ der Temperaturen auf NN ist zum Einen irrig, und ob die ganzen „Rechnereien“ stimmen…..

Ich empfehle mal folgenden Artikel nebst Diskussion:

„Denn bei immer mehr Wetterstationen werden Menschen durch Automaten ersetzt, ein meiner Meinung nach fataler Kurs, der dort eingeschlagen wird. Denn es fehlen von den bemannten Stationen nicht nur Daten wie Wolkenarten, Gesamtschneehöhe, Vereisung, et cetera. Es hat sich auch gezeigt, dass die automatischen Meldungen fehleranfällig sind. Zum Teil wird Bewölkung angezeigt, wo keine ist, Schnee tritt laut Wettermeldungen bei 20°C auf, und so weiter.“

http://tinyurl.com/yhsgz9n

Da können Sie rechnen was Sie wollen, da kann nur Murks bei rauskommen, und erzählen Sie mir nicht, daß das die Ausnahme wäre !

;.)

Herr Leistenschneider,

es ist ja rührend, wie Sie sich bemühen. Aber Ihr Artikel zeugt von Unprofessionalität. Die Messvorschriften waren tatsächlich einmal so und weltweit sind sie immer noch uneinheitlich. Auch gibt es Stationen mit katastrophal unrepräsentativen Standorten. Der Messfehler von 1 °C ist auch nicht untypisch.

Nur wie können Sie so naiv sein, anzunehmen, dies würden Profis einfach ignorieren und würden die globale Mittelwertkurve einfach auch diesen unrepräsentativen oder systematisch fehlerhaften Daten erzeugen? Herr Leistenschneider, machen Sie sich einfach bei den Profis schlau. In den bekannten Kurven für das globale Mittel steckt viel mehr Arbeit und Datenanalyse als Sie sich je erträumen.

Lieber Herr Kowatsch,

Ihnen kann wohl wenig geholfen werden. Nur dies:

1) wenn Sie Computern nicht trauen, bitteschön, dann warten Sie halt

2) Da Sie aber heute schon meinen – ohne abzuwarten – ein Urteil bilden zu können, ein paar Punkte zum Nachdenken:

a) informieren Sie sich mal, wie manche gut isolierende Fenster funktionieren, da ist ein Treibhausgas mit hohem GWP drin -…

b) „-Genauso könnte man im Winter um die Häuser anstatt Styropor eine C02-Außenhülle legen. … Geht aber nicht.“ Wieso nicht, so das an physikalischen oder praktischen Gründen liegen?

c)“ -Inversionswetterlagen im Winter:“ Eine interessante Hypothese, wieviel Erwärmung erwartet man bei 10-20 mal dem globalen CO2-Mittel in Tallagen (also so 6000ppm)?

Vier Grad Erwärmung bis 2050, sieben Grad bis 2100 und damit Hitzetod der Erde. Solche Fakten sollten wir uns merken, wenn wir bestimmte Klimawissenschaftler für ihren Blödsinn einst zur Rechenschaft ziehen werden.

Komischerweise fällt unseren Medien immer noch nicht auf, dass für die Begründung der bevorstehenden Klimatagung in Kopenhagen auch abkühlende Faktoren für die Erderwärmung herhalten müssen wie „erstmals Schnee in Bagdad“ oder „Schneefall in Kapstadt“ oder „kältester Winter in Großbritanien“. Einfach Katastrophe an Kackastrophe und die Bevölkerung wird moralisch eingeschüchtert. Ich warte immer noch auf den Versuchsbeweis, dass C02 ein Treibhausgas ist bei Veränderungen im ppm-Bereich. Computermodellrechnungen interessieren mich nicht.

Aber auch empirische Befunde sprechen gegen C02 als Treibhausgas

Hier sollen 2 von vielen genannt sein:

-Genauso könnte man im Winter um die Häuser anstatt Styropor eine C02-Außenhülle legen. Diese C02-Hülle müsste sich aufgrund des Treibhauseffektes, an dem auch noch die wärmeabstrahlende Hauswand mitwirkt, erwärmen und das Haus von außen heizen. Geht aber nicht.

-Inversionswetterlagen im Winter: Die dürfte es gar nicht geben, denn nicht nur kalte Luft, sondern auch C02 sammelt sich aufgrund seiner Schwere in den Tälern, und der Treibhauseffekt müsste bei Sonneneinstrahlung die Täler aufheizen. Doch trotz starkem C02-Anstieg, Experten schätzen die Werte auf das 10-bis 20fache in den Tälern, bleibt die Inversionswetterlage stabil. Die Affenkälte hält sich, C02 hat keine aufheizende Treibhaus-Wirkung.

Inversionswetterlagen sind ein realistischer Beweis, dass sich die Erde/Luft nur unwesentlich nach dem Treibhauseffekt erwärmt, bzw. die Wirkung von C02 bei weitem überschätzt wird.

Erg: Die Klimakatastrophe durch anthropogenes C02 kann weder durch eine wissenschaftliche Versuchsreihe noch durch empirische Befunde bewiesen werden.

Vince Ebert hat gerade passend zu diesem Thema gestern auf achgut.com einen in seiner netten Art gehalten Kommentar eingestellt.

http://tinyurl.com/yap35w4

Sind denn diese Wahnsinnigen wirklich nicht zu stoppen? Wer kann in der heute doch so aufgeklärten Welt noch glauben, dass der Mensch die Natur einfach so beeinflussen kann. Sind diese Leute wirklich so grössenwahnsinnig? Wenn doch nur noch ein Funken Vernunft in diesen Leuten steckte, so müssten sie doch einsehen, dass die Erwärmung – wenn sie auch stattfände – einfach naturgegeben ist. Da muss man doch kein Wissenschaftler sein um dies einzusehen. Man sollte einfach die Erdgeschichte einmal ansehen…?! Klar, der Sonne oder sonstwie der Natur könnte man keine Rechnung stellen, da ist nichts zu verdienen. Abzocken kann man nur die dummen Menschen, denen man einfach ein bisschen Angst einjagen muss uns schon bezahlen sie scheinbar gerne!

Zudem müsste zuerst die Bevölkerungsexplosion gestoppt werden, denn je mehr Menschen, desto mehr Verbrauch etc., etc.. Da beisst sich die Katze in den Schwanz.

Nun in Kopenhagen werden sich nicht die weisesten Leute treffen, sondern nur jene, mit den besten Ideen zum Geld verdienen à la Al Gore. Die andern werden sicher wieder aus- bzw. gar nicht eingeladen, denn die grosse Masse könnte den Klimasektierern ja auf die Schliche kommen…

Schade, dass die grossen Medien die Ideen der Realisten partout nicht verbreiten wollen. Vermutlich können die andern mehr bezahlen!

Aus der (Reuters)-Original-Agenturmeldung:

„One advance since 2007 was to model the effect of „carbon cycles.“ For example, if parts of the Amazon rainforest died as a result of drought, that would expose soil which would then release carbon from formerly shaded organic matter.“

Daraus wird im verlinkten FTD-Artikel:

„Die Forscher berechnen inzwischen die Folgen sogenannter Kohlenstoff-Zyklen ein, wie sie von Dürren in Waldgebieten und der damit verbundenen Freisetzung der giftigen Stoffe ausgelöst werden.“

Möglicherweise ist den FTD-Redakteuren gar nicht bewußt, daß sie hier einen Skandal ungeheuren Ausmaßes aufgedeckt haben:

Beim Verrotten organischen Materials werden offenbar große Mengen giftiger Karbonverbindungen freigesetzt, ohne daß die Gesundheitsbehörden Maßnahmen zum Schutz der Bevölkerung eingeleitet haben? Wo bleiben die Aufklärungskampagnen und Schilder, die vor Spaziergängen im mit Giftstoffen hochbelasteten herbstlichen Laubwald warnen?

Die Klimarealisten argumentieren sachlich-wissenschaftlich; beim „Klimawandel“ handelt sich es allerdings um ein politisch-wirtschaftlich-ideologisches Konstrukt. Ggf. muß hier die Diskussion erweitert werden.

„Man muss eine gewisse Panik schüren, und dann fliesst das Geld.“

(Prof. John Christy, Lead author for IPCC reports)

Fakten:

Von 1998 bis 2008 ist die globale Temperatur um 0,2°C zurückgegangen.

Die Nordhalbkugel hat sich um 0,1°C, die Südhalbkugel sogar um 0,3°C abgekühlt.

„KYOTO-Uhr“, Stand 8.11.2009:

Seit Inkrafttreten am 16. Februar 2005, kostete das Kyoto-Protokoll etwa

US$ 696.790.000.000

womit eine potenzielle Verminderung des Temperaturanstiegs bis zum Jahr 2050 von

0.007225973 °C

erreicht werden soll.

Man beachte: die Temperatur ändert sich im Milliardstel-Bereich, was offensichtlich in einem weltweiten Massstab nicht messbar ist. Mehr Informationen gibt es bei Junk Science.“

http://www.oekologismus.de/

http://www.junkscience.com/

Theologisches („Church of Global Warming“):

„KLIMADEBATTE – Mission gegen Emission

Wie hältst du’s mit dem CO2?

Der Kampf gegen die Erderwärmung ist zur Glaubensfrage geworden.

Es geht um Sünde und Strafe, Heil und Apokalypse. … “

http://www.merkur.de/2008_18_Mission_gegen_Emi.27841.0.html

Terrorismus:

„Besteht nicht die einzige Hoffnung für diesen Planeten in dem Zusammenbruch der industriellen Zivilisation? Liegt es nicht in unserer Verantwortung, dafür zu sorgen, dass dieser Zusammenbruch eintritt?“

Maurice Strong, erster UNEP-Direktor, (Wood,1990) und 1992 in Rio

http://klima-ueberraschung.de