Bild rechts: WoodForTrees.org – Paul Clark – Quelle

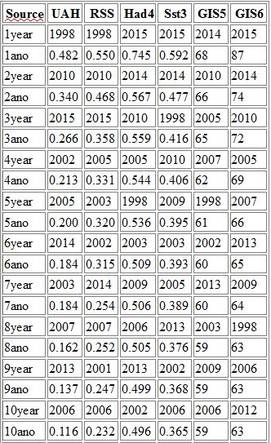

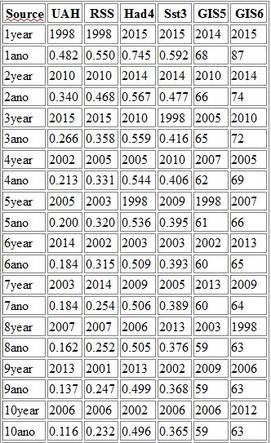

Die folgende Tabelle zeigt die zehn an erster Stelle stehenden Jahre mit den Werten der fünf Datensätze, die ich betrachte. „1 Jahr“ nennt das Jahr mit der wärmsten Anomalie jenes Datensatzes, und „1 ano“ zeigt die Anomalie jenes Jahres, und so weiter. Allerdings habe ich eine Extraspalte hinzugefügt, über die ich ebenfalls sprechen werde, nämlich GISS. GIS6 sind die jährlichen, im Januar 2016 veröffentlichten Anomalien, GIS5 diejenigen, die im Januar 2015 bekannt gegeben wurden.

Zu allererst möchte ich die Aufmerksamkeit auf die Anomalien der Jahre 2014 und 1998 lenken, wie schon im vorigen Jahr. Im vorigen Jahr hatte die Anomalie für 1998 61 und für 2014 68 betragen, wie aus der Spalte GIS5 hervorgeht. In Spalte GIS6 erkennt man, dass es für das Jahr 1998 einen Sprung um 2 auf 63 gegeben hat, während 2014 ein Sprung von 6 auf 74 erfolgte. Und 2013 sprang um 5, aber 2002, welches Jahr es nicht in die Top Ten schaffte, sprang nur um 3. Und man weiß, was es für den „Stillstand“ bedeutet, wenn man von 1998 bis 2015 die späteren Jahre wärmer macht als die früheren Jahre.

Als Nächstes möchte ich einige Implikationen von GIS5 ansprechen. Mancher wird sich an die Kontroverse aus dem vorigen Jahr erinnern, als GISS verlauten ließ, dass 2014 ein rekordwarmes Jahr gewesen sei. Später hatte man dort aber hinzugefügt, dass die Chance, es habe sich wirklich um einen Rekord gehandelt, nur bei 38% lag. Grund hierfür war, dass der Fehlerbalken für die Anomalie eines jeden Jahres etwa 0,1 beträgt.

Zwei Dinge gehen in dieser Hinsicht aus GIS5 hervor. Die Anomalie des Jahres 2010 lag nur um 0,02 niedriger als die Anomalie des Jahres 2014. Dies bedeutete, dass 2010 eine ziemlich große Chance hatte, das wärmste Jahr gewesen zu sein, wenngleich mit einer geringeren Prozentzahl als 38%. Ebenso betrug die Anomalie für 2014 0,68, während die Anomalie des an zehnter Stelle stehenden Jahres 0,59 betrug. Diese Differenz von 0,09 war kleiner als der Fehlerbalken. Das heißt, selbst das an zehnter Stele rangierende Jahr hat noch die Chance, das wärmste Jahr zu sein, obwohl die Wahrscheinlichkeit dafür sehr gering sein würde. Während also das Jahr 2014 eine größere Wahrscheinlichkeit besaß, das wärmste jemals zu sein, lag die kumulierte Gesamtzahl der folgenden neun Jahre, das wärmste Jahr zu sein, bei etwa 62%.

In diesem Jahr sieht das alles völlig anders aus! Man betrachte die Anomalien 2015 für HadCRUT4, Hadsst3 und GIS6. Im Einzelnen beachte man die Differenz zwischen 1ano und 2ano für diese drei Datensätze. In allen drei Fällen ist die Differenz größer als 0,1. Dies bedeutet, dass die Wahrscheinlichkeit für einen neuen Rekord 2015 in jedem Falle über 90% liegt. Für GISS sind es 94%.

Im Gegensatz dazu betrachte man jetzt die Anomalien aus den beiden Satelliten-Datensätzen UAH6.0beta4 und RSS. Vor allem vergleiche man die Werte 2015 unter „3ano“ mit den Werten 1998 unter „1ano“. Der Unterschied ist deutlich größer als 0,1, was zeigt, dass die Chance, das Jahr 2015 sei den Satelliten-Datensätzen zufolge KEIN Rekordjahr war, deutlich über 90% liegt.

Falls wir eine Fehlerbandbreite von 0,1 annehmen, liegt selbst noch der zweite Platz außerhalb dieses Fehlerbalkens für HadCRUT4, Hadsst3 und GISS. Allerdings sieht es hinsichtlich der Satelliten ganz anders aus. Falls wir annehmen, dass die UAH-Anomalie von 0.266 auch 0,366 bzw. 0,166 betragen könnte, dann könnte diese Stellung auf Rang 3 auch auf Rang 2, aber auch auf Rang 7 stehen.

Falls wir annehmen, dass die RSS-Anomalie von 0,358 auch 0,458 bzw. 0,258 betragen könnte, dann kann die Platzierung an dritter Stelle nicht höher sein als diese dritte Stelle, aber es könnte auch an sechster Stelle liegen.

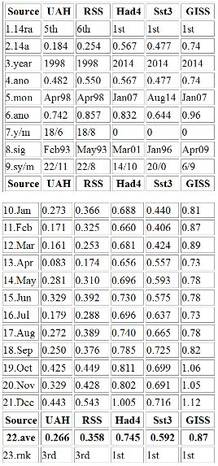

Es geht nirgendwo aus obiger Tabelle oder aus der Tabelle in Abschnitt 3 hervor, aber die Anomalien November und Dezember zeigten in allen fünf Datensätzen Rekordwerte für diese Monate. Ebenso zeigten viele andere Monate monatliche Rekordwerte in einigen der Datensätze.

Wie man in Abschnitt 3 sieht, zeigen die Datensätze HadCRUT4, Hadsst3 und GISS Allzeit-Rekordwerte. Im Datensatz HadCRUT4 bricht die Dezember-Anomalie von 1,005 den bisherigen Allzeit-Rekordwert von 0,832 aus dem Januar 2007. Bei GISS bricht die Dezember-Anomalie von 1,12 die vorherige Allzeit-Rekordmarke von 0,96 aus dem Januar 2007. Auch für die Monate Oktober und November zeigt GISS, dass die Marke 0,96 jeweils mit 1,06 und 1,05 gebrochen worden ist. Bei Hadsst3 bricht die September-Anomalie von 0,725 die bisherige Marke von 0,644 aus dem August 2014.

Zu den beiden Satelliten-Datensätzen: trotz der Rekordwärme der Monate November und Dezember lagen sie nicht einmal annähernd in der Nähe von deren Allzeit-Rekordwert der April-Anomalie 1998. Falls jedoch 2016 dem Jahr 1998 nachfolgt, könnte der Rekord aus dem April 1998 fallen.

Was wird dann mit dem Stillstand nach RSS seit über 18 Jahren geschehen? Alles hängt davon ab, wie hoch und wie lange die RSS-Anomalien hoch bleiben. Falls die RSS-Anomalien von ihrem derzeitigen Wert von 0,543 während der nächsten drei Monate auf 0,25 sinken, wird der Stillstand weiterhin mehr als 18 Jahre dauern. Aber falls sie hoch bleiben, dann könnte die Stillstands-Dauer auf 15 Jahre oder auf 7 Jahre zurückgehen oder ganz verschwinden. Falls der Stillstand verschwindet, würde es einer La Nina bedürfen, um den Stillstand wieder auf über 18 Jahre zu bringen.

In den folgenden Abschnitten werde ich wie in früheren Beiträgen die jüngsten Fakten nennen. Die Informationen kommen in drei Abschnitten und einem Anhang. Im ersten Abschnitt werde ich zeigen, wie lange es in einigen Datensätzen keine Erwärmung gegeben hatte. Im Moment zeigen nur die Satellitendaten über mehr als ein Jahr einen flachen Verlauf. Im zweiten Abschnitt werde ich zeigen, seit wann es keine statistisch signifikante Erwärmung in verschiedenen Datensätzen gegeben hatte. Im dritten Abschnitt werde ich zeigen, wie das Jahr 2015 bisher sich im Vergleich zum Jahr 2014 macht sowie den wärmsten Jahren und Monaten bisher. Für drei Datensätze ist das Jahr 2014 ebenfalls das wärmste Jahr. Im Anhang werden die Abschnitte 1 und 2 auf andere Weise illustriert. Graphiken und eine Tabelle werden die Daten illustrieren.

Abschnitt 1

Für diese Analyse wird der letzte Monat herangezogen, für den Daten bei WoodForTrees.com (WFT) verfügbar sind. Alle Daten bei WFT stehen auch bei den unten spezifizierten Quellen. Wir beginnen mit den gegenwärtigen Daten und gehen bis zum am weitesten zurück liegenden Monat, in dem die Neigung mindestens leicht negativ ist von mindestens einer Berechnung. Falls also die Neigung im September 4 X 10↑-4 beträgt, im Oktober aber -4 X 10↑-4, nehmen wir die Zeit ab Oktober, damit uns niemand vorwerfen kann, unehrlich zu sein, falls wir sagen, dass die Neigung eines bestimmten Monats flach ist.

1. Bei GISS ist die Neigung während keiner erwähnenswerten Periode flach.

2. Bei Hadcrut4 ist die Neigung während keiner erwähnenswerten Periode flach.

3. Bei Hadsst3 ist die Neigung während keiner erwähnenswerten Periode flach.

4. Bei UAH ist die Neigung seit Juli 1997 flach oder seit 18 Jahren und 6 Monaten. (Bis Dezember nach Version 6.0).

5. Bei RSS ist die Neigung seit Mai 1997 flach oder seit 18 Jahren und 8 Monaten (bis Dezember).

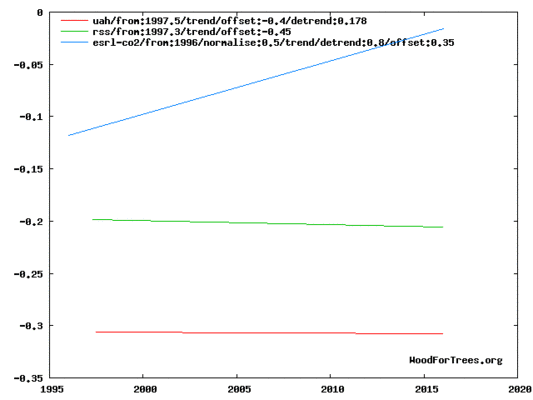

Die nächste Graphik zeigt einfach die Linien, um Obiges zu illustrieren. Man betrachte es als Nebengraphik, in der die Länge der Linien die Relativzeiten anzeigen, in denen die Neigung Null ist. Außerdem zeigt die aufwärts verlaufende blaue Linie oben, dass der CO2-Gehalt stetig während dieses Zeitraumes zugenommen hat. Man beachte, dass UAH5.6 von WFT eine Trendbereinigung braucht, um zu zeigen, dass die Neigung für UAH6.0 Null beträgt.

WoodForTrees.org – Paul Clark – Quelle

Wenn man zwei Dinge plottet, wie ich es getan habe, zeigt die Linke allein eine Temperatur-Anomalie.

Die tatsächlichen Zahlen sind bedeutungslos, da beide Neigungen im Wesentlichen Null betragen. Für CO2 werden keine Zahlen angegeben. Einige haben gefordert, den Verlauf des CO2-Gehaltes zu plotten. Allerdings gibt es bei WFT diese Option nicht. Die aufwärts verlaufende CO2-Linie allein zeigt: während der CO2-Gehalt während der letzten 18 Jahre gestiegen ist, waren die Temperaturen über verschiedene Zeiträume in den beiden Datensätzen flach verlaufen.

Abschnitt 2

Für diese Analyse stammen die Daten aus dem Trendviewer von Nick Stoke, verfügbar auf seiner Website. Diese Analyse zeigt, wie lange es Nicks Kriterien zufolge keine statistisch signifikante Erwärmung gegeben hatte. Die Daten gehen bis zur jüngsten Aktualisierung jedes Datensatzes. In jedem Falle beachte man, dass der untere Fehlerbalken negativ ist, so dass eine Neigung bei Null im benannten Monat nicht ausgeschlossen werden kann.

In vielen verschiedenen Datensätzen gab es keine statistisch signifikante Erwärmung zwischen 6 und 22 Jahren. Cl steht für die Vertrauensgrenzen im 95%-Niveau.

Hier folgen die Details für die Datensätze:

UAH6.0: Seit Februar 1993 Cl von -0,014 bis 1,658. Das sind 22 Jahre und 11 Monate.

RSS: Seit Mai 1993 Cl von -0,030 bis 1,574. Das sind 22 Jahre und 8 Monate.

HadCRUT4.4: Seit März 2001 Cl von -0,031 bis 1,650. Das sind 14 Jahre und 10 Monate.

Hadsst3: Seit Januar 1996 Cl von -0,021 bis 2,082. Das sind 20 Jahre glatt.

GISS: Seit April 2009 Cl von -0,065 bis 5,706. Das sind 6 Jahre und 9 Monate.

Abschnitt 3

In diesem Abschnitt werden Daten über 2015 und weitere Informationen gezeigt, und zwar in Gestalt einer Tabelle. Die Tabelle zeigt die fünf Datenquellen oben und auch dazwischen, damit man sie immer erkennt. Die Quellen sind UAH, RSS, Hadcrut4, Hadsst3 und GISS.

Die Spalten zeigen Folgendes:

1. 14ra: Dies ist die finale Platzierung des Jahres 2014 für jeden Datensatz. BEACHTE: Diese liegen vor 2015. Siehe die erste Tabelle in diesem Beitrag um zu erkennen, wie sehr 2015 die Platzierungen 2014 beeinflusst hat.

2. 14a: Zeigt die mittlere Anomalie für 2014.

3. year: Zeigt das bislang wärmste Jahr jemals für jeden Datensatz. Man beachte, dass die Satelliten-Datensätze das Jahr 1998 als das wärmste Jahr ausweisen und die anderen das Jahr 2014.

4. ano: Zeigt das Mittel der monatlichen Anomalien im wärmsten Jahr direkt darüber.

5. mon: Zeigt den Monat, in dem der jeweilige Datensatz die höchste Anomalie aufweist. Die Monate werden identifiziert durch die ersten drei Buchstaben jedes Monats und die letzten beiden Ziffern des betreffenden Jahres. BEACHTE: Alle Zahlen liegen vor 2015.

6. ano: zeigt die Anomalie des Monats direkt darüber.

7. y/m: zeigt den längsten Zeitraum in Jahren/Monaten, in dem die Neigung nicht positiv ist. Z. B. bedeutet 16/2, dass die Neigung 16 Jahre und 2 Monate lang im Wesentlichen Null betrug. Zeiträume kürzer als ein Jahr wurden nicht mitgezählt und mit „0“ angegeben.

8. sig: Dies ist der erste Monat, in dem eine Erwärmung Nicks Kriterien zufolge nicht statistisch signifikant ist. Den ersten drei Buchstaben des Monats folgen die letzten beiden Ziffern des Jahres.

9. sy/m: Zeigt die Jahre und Monate aus Zeile 8. Abhängig von der letzten Aktualisierung könnte ein Monat fehlen.

10. Jan: Zeigt die Anomalie im Januar 2015 für den jeweiligen Datensatz.

11. Feb: Zeigt die Anomalie im Februar 2015 für den jeweiligen Datensatz – usw.

22. ave: Dies ist die mittlere Anomalie aller Monate bis heute, ermittelt aus der Addition aller Zahlen und Division durch die Anzahl der Monate oder die Zahlen in den Datensätzen.

23. rnk: Dies ist der Rang im jeweiligen Datensatz, den das Jahr 2015 einnimmt.

Falls man selbst alle jüngsten Anomalien verifizieren möchte, schaue man hier:

Für UAH wurde die Version 6.0beta4 verwendet. Man beachte, dass WFT Version 5.6 verwenden. Um also die Länge des Stillstands in Version 6.0 zu verifizieren, muss man Nicks Programm heranziehen:

http://vortex.nsstc.uah.edu/data/msu/v6.0beta/tlt/tltglhmam_6.0beta4.txt

RSS siehe: ftp://ftp.ssmi.com/msu/monthly_time_series/rss_monthly_msu_amsu_channel_tlt_anomalies_land_and_ocean_v03_3.txt

Hadcrut4 siehe: http://www.metoffice.gov.uk/hadobs/hadcrut4/data/current/time_series/HadCRUT.4.4.0.0.monthly_ns_avg.txt

Hadsst3 siehe: http://www.cru.uea.ac.uk/cru/data/temperature/HadSST3-gl.dat

GISS siehe:

http://data.giss.nasa.gov/gistemp/tabledata_v3/GLB.Ts+dSST.txt

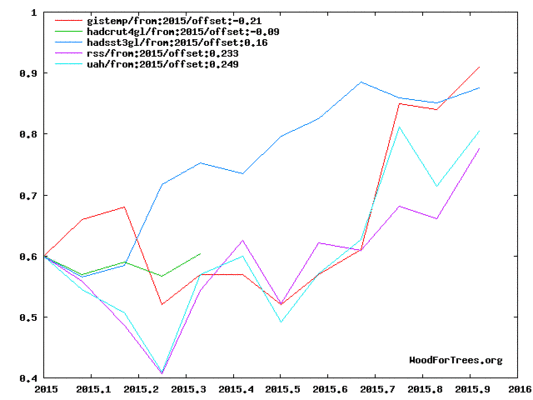

Um alle Punkte seit Januar 2015 in Gestalt einer Graphik zu sehen, betrachte man die folgende WFT-Graphik. Man beachte, dass die UAH-Version 5.6 gezeigt ist. Auch ist Hadcrut4.3 und nicht Hadcrut4 gezeigt, weshalb die letzten paar Monate bei Hadcrut fehlen.

WoodForTrees.org – Paul Clark – Quelle

Wie man sieht, beginnen alle Linien an der gleichen Stelle im Januar 2015. Dies macht den Vergleich von Januar 2015 mit der jüngsten Anomalie einfach.

Anhang

Hier fassen wir die Daten jedes Datensatzes separat zusammen:

RSS

Die Neigung ist flach seit Mai 1997 oder seit 18 Jahren und 8 Monaten (bis Dezember).

Es gibt keine statistisch signifikante Erwärmung seit Mai 1993: Cl von -0,030 bis 1,574. Die monatliche RSS-Anomalie des Jahres 2015 beträgt 0,358. Dies platziert dieses Jahr an 3. Stelle. Das Jahr 1998 war das wärmste Jahr mit 0,55. Die höchste monatliche Anomalie jemals war im April 1998 aufgetreten mit 0,857. Die Anomalie im Jahre 2014 betrug 0,254 und stellt es an die 6. Stelle.

UAH6.0beta4

Die Neigung ist flach seit Juli 1997 oder seit 18 Jahren und 6 Monaten (bis Dezember nach Version 6.0beta4).

Es gibt keine statistisch signifikante Erwärmung seit Februar 1993: Cl von -0,014 bis 1,658 (nach Version 6,0 Nicks Programm zufolge).

Die mittlere Anomalie 2015 betrug 0,266. Dies würde die 3. Stelle bedeuten. 19988 war das wärmste Jahr mit 0,482. Die höchste monatliche Anomalie jemals war im April 1998 mit 0,742 aufgetreten. Die Anomalie 2014 betrug 0,184 und lag an 5. Stelle.

Hadcrut4.4

Die Neigung ist in keinem erwähnenswerten Zeitraum flach.

Es gibt keine statistisch signifikante Erwärmung seit März 2001: Cl von -0,31 bis 1,650.

Die monatliche mittlere Anomalie 2015 beträgt 0,745. Dies bedeutet einen neuen Rekord. Der bisherige Rekordwert der monatlichen Anomalie war im Januar 2007 mit 0,832 aufgetreten. Dies liegt vor 2015. Die Anomalie 2014 beträgt 0,567 und setzt einen neuen Rekord.

Hadsst3

Die Neigung ist in keinem erwähnenswerten Zeitraum flach. Es gibt keine statistisch signifikante Erwärmung seit Januar 1996: Cl von -0,021 bis 2,082.

Die Anomalie des Jahres 2015 beträgt 0,592. Dies setzt einen neuen Rekord. Die höchste monatliche Anomalie jemals war im August 2014 mit 0,644 aufgetreten. Dies liegt vor 2015. Die Anomalie 2014 betrug 0,477, was einen neuen Rekord bedeutet.

GISS

Die Neigung ist in keinem erwähnenswerten Zeitraum flach.

Es gibt keine statistisch signifikante Erwärmung seit April 2009: Cl von -0,065 bis 5,706.

Die mittlere Anomalie 2015 beträgt 0,87, was einen neuen Rekord setzt. Die höchste monatliche Anomalie jemals war im Januar 2007 mit 0,96 aufgetreten. Dies liegt vor 2015. Die Anomalie 2014 betrug 0,74 und setzte einen neuen Rekord.

Schlussfolgerung

Im Moment haben die Satellitendaten nicht wie im Jahre 1998 reagiert. Glauben Sie, dass irgendwelche Rekorde aus dem Jahr 1998 in den Satellitendaten im Jahre 2016 gebrochen werden? Wie viele terrestrische Rekorde im Jahre 2015 waren Ihrer Ansicht nach real, und wie viel war den Adjustierungen geschuldet?

P. S. Ich dachte, dass Senator Cruz bzgl. Klimathemen gut informiert sei. Vor kurzem habe ich herausgefunden warum.

Judith Curry sagt dazu: „Senator Cruz scheint sehr vertraut mit den Daten und weiß auch allgemein über den wissenschaftlichen Prozess Bescheid. Einer seiner Mitarbeiter ist ein eifriger Leser von WUWT und offensichtlich auch auf dem Blog von Steve Goddard“.

Link: http://wattsupwiththat.com/2016/01/27/final-2015-statistics-now-includes-december-data/

Übersetzt von Chris Frey EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"@ #3

„Theorie des Treibhauseffekts“

Es gibt keine Theorie des Treibhauseffekts. Der sog. „Treibhauseffekt“ ist eine unbewiesene Hypothese. In Cuxhaven investiert Siemens 200 Mill. € in die Windmühlenproduktion. Die Politik spricht so von Chancen, als wären die erhofften ‚Gewinne‘ für die Pleitestadt bereits Realität.

Aufgrund einer Fata Morgana, dem sog. Treibhauseffekt, werden gigantische Summen ausgegeben, um ihn, dessen Realität noch nicht gegeben ist, zu vermeiden. Eine Fata Morgana hat im Gegensatz zu den Chancen der Investitionen eine Realität als Ausgangspunkt.

Aber die Menschen lieben ja den Ablaßhandel … .

@ #5 H.-D. Schmidt

„Selten so einen Quatsch gehört, aber viel beklemmender ist, dass genau dieser Quatsch so verbreitet kolportiert und offenbar auch geglaubt wird.“

Die Menschen glauben alles, was sie glauben wollen. Wobei ich mir bei den meist naturwissenschaftlich ungebildeten Bürgern nicht sichen bin mit dem Wollen, denn Ungebildete können ja eigentlich keinen freien Willen haben.

#4:

Ich bitte Sie, was soll diese Gegenfrage?

Es ging um diese – Ihre – Behauptung:

„Es ist bekannt, dass die Troposphäre in verschiedenen Schichten abkühlt, sich aber in Bodennähe erwärmt. Das bedeutet, dass bei Mittelwerten der „unteren“ Troposphäre zwangsweise Schichten in die Mittelwerte einfließen, die sich abkühlen. Daher ist der Gesamttrend sogar mittlerweile negativ.“

Die Theorie des Treibhauseffekts erwartet aber einen stärkeren Temperaturanstieg in der (unteren) Troposphäre als in Bodennähe.

#1

Die Satellitenmessungen der unteren Troposphäre messen tatsächlich eine mehrere km dicke Schicht, aber: Es ist Unsinn zu glauben, dass sich die unteren Schichten erwärmen und die oberen abkühlen: Überschreitet der vertikale Temperaturgradient eine gewisse Grenze, entsteht sofort Konvektion.

Auch die Alarmistenbande faselt ja von einem „CO2-Deckel“, der die Wärme unten festhalten soll. Selten so einen Quatsch gehört, aber viel beklemmender ist, dass genau dieser Quatsch so verbreitet kolportiert und offenbar auch geglaubt wird.

Dipl.-Met. Hans-Dieter Schmidt

@#1: Admin:

Die Satellitendaten messen keine Bodentemperatur. Aus atmosphärischen Querschnittswerten versucht man die Temperatur der unteren Troposphäre durch entsprechende Gewichtungen zu ermitteln. Was übrigens auch Probleme mit sich bringt und Fehler verursacht. Das geben sogar die Betreiber von RSS zu. Und die untere Troposphäre umfasst mehrere Kilometer. Also auch atmosphärische Schichten über uns, von denen man weiß, dass sie andere Trends aufweisen, nämlich deutlich kühler werden.

Wer sich auf „Sie hängt lediglich ab von der Geometrie und der mittleren Temperaturabnahme mit der Höhe.“ verlässt, handelt sehr riskant und hat keine Ahnung von der Meteorologie bzw. von dem Wetter, was über unseren Köpfen passiert.

Und auch wenn es möglich ist, durch diese Geometrie einigermaßen durch Mittelwerte auf die bodennahen Temperaturen zu schließen: Sie verwenden in Ihren Diagrammen trotzdem die originalen atmosphärischen Querschnittswerte der unteren Troposphäre, die mehrere Kilometer umfasst, und keine bodennahen Temperaturen. Damit vergleichen Sie weiterhin Äpfel mit Birnen. Wo sind denn die aus den Satelliten berechneten bodennahen Temperaturen, die überhaupt einen Vergleich zulassen würden?

Und überhaupt: Sie lassen Interpolationen über riskante Geometrien zu, aber eine weltweite Durchschnittstemperatur halten Sie für unmöglich.

@#3: Welche Vermutung?

#1:

Ihre Vermutung steht im Widerspruch zur Theorie des Treibhauseffekts:

http://tinyurl.com/zmtx8pf

Nach gängigen Vorstellungen sollte sich die (untere) Troposphäre stärker erwärmen als die bodennahe Zone. Dass dies im Widerspruch zu den Beobachtungen steht, ist sogar für einen AGW-„Papst“ wie Gavin Schmidt ein echtes Problem.

Ich halte dieses „Ranking“ für nicht sehr aussagekräftig. Ich betrachte Tabelle 1, Spalte GIS6. In 2015 (Rang 1) ist die globale Anomalie 0,87 °C, in 1998 (Rang 8) 0,63 °C. (Ich habe die beiden Jahre herausgegriffen, da beides El Nino-Jahre sind.) Als Trend schätze ich ab: 0,24/1,7= 0,14 °C/Dekade. Dies ist viel geringer als die meisten Klima-Modelle vorhersagen. Meine Enkel und ich können damit leben. Die UAH- und RSS-Datenreihen sind Auswertungen von MSU (microwave sounding unit), also Messungen der Strahlungstemperatur der Atmosphäre. Die erdgebundenen Daten beruhen auf Messungen der Lufttemperatur in 2m Höhe (Land) bzw. der Temperatur der Ozeanoberfläche. Ein Vergleich der beiden Messungen erfordert ein Klimamodell, das bisher offensichtlich noch nicht in der erforderlichen Genauigkeit existiert. Eine solche Vorgehensweise kenne ich von Ceres. Da wird aus den mit Satelliten gemessenen Strahlungsflüssen die von der Erdoberfläche abgestrahlte IR-Strahlung berechnet. Daraus errechne ich einen Trend von 0,14 °C/Dekade für 2001 -2014. Da die Ceres-Daten wenig zitiert werden, nehme ich an, dass sie in der Fachwelt wenig Vertrauen genießen.

Vielleicht einmal zur Aufklärung:

Die RSS-Daten, in diesem Falle die verwendeten Daten der unteren Troposphäre, entsprechen nicht den Boden- oder 2-Meter-Temperaturen, sondern eben der „unteren“ Troposphäre. Und diese erstreckt sich über mehrere Kilometer.

Es ist bekannt, dass die Troposphäre in verschiedenen Schichten abkühlt, sich aber in Bodennähe erwärmt. Das bedeutet, dass bei Mittelwerten der „unteren“ Troposphäre zwangsweise Schichten in die Mittelwerte einfließen, die sich abkühlen. Daher ist der Gesamttrend sogar mittlerweile negativ.

Dies bedeutet aber nicht, dass die Bodentemperatur ebenfalls einen negativen Trend haben muss.

Die Werte von UAH, GISS usw. können und dürfen nicht mit den RSS-Daten verglichen werden. Die Satelliten messen nämlich nicht die Bodentemperatur. Die Werte der „unteren“ Troposphäre repräsentieren ein völlig anderes Luftpaket.