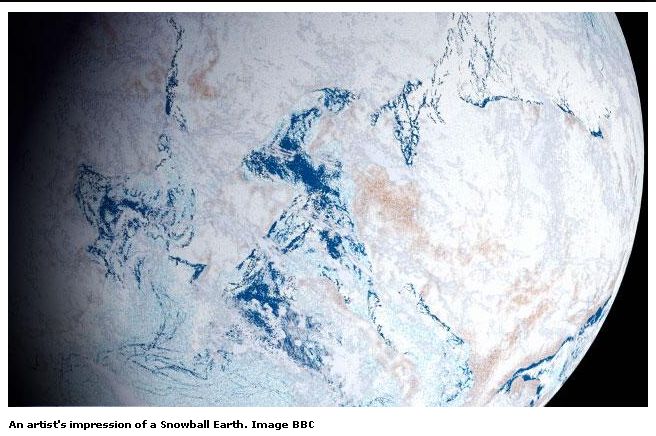

Heutzutage ist es in Mode, über die Ausdehnung der polaren Eiskappen zu lamentieren, aber diejenigen, die das tun, sind naiv, wenn sie zu wissen glauben, welches Level der Eisausdehnung „normal“ ist. Geologische Beweise zeigen, dass sich Meereis im Zuge des aufblühenden und komplexen Lebens auf der Erde mindestens zweimal bis fast zum Äquator ausgedehnt hat. Dass unser Planet fast oder ganz vollständig von Pol zu Pol gefroren war, wird von Klimawissenschaftlern als Schneeball-Erde-Hypothese bezeichnet. In „Dynamics of a Snowball Earth ocean” beziehen sich Yosef Ashkenazy et al. auf die Möglichkeit, dass ozeanische Zirkulationen und Durchmischungsprozesse die Schmelz- und Gefrierraten beeinflusst haben, die die Eisdicke bestimmen, was wiederum das Überleben photosynthetischen Lebens beeinflusst hätte.

Ihr in der Zeitschrift Nature erschienener Bericht erklärt nicht, warum es zur Entwicklung des Schneeballs Erde gekommen war, sondern wie es das Leben fertig gebracht hat, ein solches Gefrieren zu überstehen. Man beachte, dass das Meereis, über das sie reden, nicht das die Arktische See überdeckende oder die Antarktis umgebende kümmerliche Packeis ist. Auf einem Schneeball Erde sind die Ozeane von 200 m dicken fließenden Gletschern bedeckt. Hier folgt ein Abschnitt aus dieser Studie, der die Motivation der Autoren beschreibt:

Der Fluss dicken Eises über einen Schneeball-Erde-Ozean („Meeresgletscher“, charakterisiert durch eine Dynamik, die sich sehr von der dünneren Eises unterscheidet), hat während der letzten Jahre erhebliche Aufmerksamkeit erhalten. In gleicher Weise wurden die Rolle und die Dynamik der atmosphärischen Zirkulation und des Wärmetransportes, der CO2-Konzentration, Wolken-Rückkopplungen und Anordnung der Kontinente untersucht, ebenso wie die Rolle des Staubes über der Eisdecke auf dem Schneeball Erde. Im Gegensatz dazu wurde den ozeanischen Zirkulationen während der Schneeball-Phase trotz ihrer Bedeutung nur wenig Aufmerksamkeit zuteil. Die wenigen Studien, in denen Generelle Zirkulationsmodelle des ganzen Ozeans zur Anwendung kamen, konzentrierten sich hauptsächlich auf die Rolle der Ozeane bei der Entwicklung hin zum Schneeball und nach dessen Auftauen. Es gibt keine Studien, in denen die kombinierten Auswirkungen dicker Eisbedeckung und Eisströme untersucht worden ist, und auch nicht die Antriebe durch geothermisches Aufheizen.

Man beachte, dass die Dinge auf dem Planeten Erde vor 700 Millionen Jahren anders lagen als heute: Das Leben in den Ozeanen war nicht das gleiche wie heute, und die kontinentalen Landmassen lagen anders. Und doch hat das Leben überlebt – vielleicht wegen des Typs dynamischer Zirkulation, der von den Autoren vorgeschlagen worden ist – bis das Eis zu schmelzen begann. Was Ashkenazy et al. nicht erklären ist, wie es überhaupt zu einem Schneeball Erde kommen konnte und – noch wichtiger – wie es zu Ende ging.

Für wissenschaftliche Spekulationen hinsichtlich des Entstehens und der Abschwächung [schwer übersetzbares Wortspiel: waxing and waning] solcher planetarischen Erfrierungen betrachte man den Artikel „A ’snowball Earth‘ climate triggered by continental break-up through changes in runoff“ von Yannik Donnadieu et al., der 2004 in Nature erschienen war. Das Abstract dieser Studie lautet:

Geologische und paläomagnetische Studien zeigen, dass die Eisschilde den Äquator zum Ende des Proterozoischen Zeitalters vor 800 bis 550 Millionen Jahren erreicht haben könnten, was zu dem Bild einer vollständig von Eis bedeckten ‚Schneeball Erde’ führte. Klimamodell-Simulationen zeigen, dass dieser Schneeball-Status von außerordentlich geringen atmosphärischen CO2-Konzentrationen abhängt, zusätzlich zu der verglichen mit heute um 6% schwächeren Sonneneinstrahlung. Allerdings bleiben die Mechanismen für diesen geringen CO2-Gehalt kontrovers. Hier vermuten wir die Auswirkungen paläogeographischer Änderungen vor der Sturtischen Vereisungsperiode vor 750 Millionen Jahren auf die langzeitliche Evolution des atmosphärischen CO2-Gehaltes, die wir mit dem gekoppelten Klima- und geochemischen Modell GEOCLIM berechnet haben. In unserer Simulation führt das Zerbrechen [des Urkontinents] Rodinia zu einer Zunahme des Wasserabflusses und in der Folge zum Verbrauch von Kohlendioxid durch kontinentale Alterung, die die atmosphärischen Kohlendioxidkonzentrationen um 1320 ppm haben abnehmen lassen. Dies zeigt, dass tektonische Änderungen während des Neoproterozoischen Zeitalters einen fortschreitenden Übergang von einem ‚Treibhaus’ zu einem ‚Eishaus’ ausgelöst haben. Wenn wir diese Ergebnisse mit den begleitenden Alterungseffekten der voluminösen Basaltformationen kombinieren, die während des Auseinanderbrechens von Rodinia ausbrachen, kommen unsere Modelle zu einem Schneeball.

Man sollte auch erwähnen, dass es damals viel mehr Kohlendioxid in der Atmosphäre gegeben hat, und dass das auch eine gute Sache war. Ein mächtigerer Treibhauseffekt war erforderlich, um das planetarische Gefrieren unter der Voraussetzung eines schwächeren Outputs der noch jungen Sonne zu verhindern. Rodinia war ein antiker Superkontinent, der fast die gesamte kontinentale Landmasse des Planeten enthalten hatte.

Rodinia war für mindestens 350 Millionen Jahre die dominierende Landmasse der Erde, bevor sie vor etwa 750 Millionen Jahren begann auseinanderzubrechen. Dieses Auseinanderbrechen veränderte den Kohlenstoffzyklus derart, dass CO2 mit steigender Rate der Atmosphäre entzogen wurde, was den Gehalt um 1320 ppm reduzierte (Heute befinden sich lediglich 390 ppm CO2 in der Atmosphäre). Mit dem Rückgang des CO2 folgten die Temperaturen. Schon bald sah die Erde aus wie auf dem Bild unten.

Schneeball-Bedingungen dauerten zehn oder mehr Millionen Jahre, verursacht durch das abrupte Entfernen von CO2 aus der Atmosphäre – vielleicht eine Lektion für diese im Entstehen begriffenen Geo-Engineering-Typen, die die heutige Erdatmosphäre durch das Entfernen des Kohlendioxids „reinigen“ wollen. Was hat die Erde aus diesem eisigen Zustand zurückgeholt? Die meisten Wissenschaftler glauben, dass Vulkane eventuell das CO2 in die Atmosphäre zurück gebracht haben, und zwar genug, um das Eis um den Äquator schmelzen zu lassen. Danach feierte das photosynthetische Leben ein rauschendes Comeback.

Mit der Zeit bildeten die Kontinente erneut eine einzige riesige Landmasse mit der Bezeichnung Pangäa, und der Rest ist Geschichte. Was waren die Ursachen für Auftreten und Verschwinden dieser Super-Eiszeiten? Donnadieu et al. fassen das in einem einzigen Satz zusammen: „Die langzeitliche Evolution (länger oder gleich 106 Jahre) des Partialdrucks des atmosphärischen CO2 (pCO2) wird bestimmt durch die relative Bedeutung des Ausgasens vulkanischer Prozesse und dem CO2-Verbrauch durch kontinentale Silikat-Alterung“.

Wissenschaftler glauben, dass Vulkane die Super-Eiszeiten des Schneeballs Erde beendet haben

Aber ist das nicht genau das, was die Klimaalarmisten seit vier Jahrzehnten hinauslabern, dass nämlich das CO2 zu Temperaturanstieg führt, was uns alle gefährdet? Kaum. Das Niveau atmosphärischen CO2-Gehaltes, über das wir hier reden, ist viele Male höher als selbst in den wildesten Projektionen des IPCC. Während eindeutig ist, dass der Kohlenstoffzyklus hilft, die Temperaturen auf der Erde zu regulieren, waren die Niveaus von in die dramatischen Ereignisse der Vergangenheit involvierten Treibhausgasen viel größer als die heutigen Variationen. Die Schneeball-Erde-Studie hat Folgendes ergeben:

Mit Hilfe eines komplexen Modells und Quantifizierung des Effektes des Auseinanderbrechens sagen wir eine markante Reduktion der Konzentration von CO2 in der Atmosphäre vorher auf einen persistent niedrigen Wert im Bereich 400 bis 630 ppm in Zeiträumen über 10 Myr [= Millionen Jahre]. Wir finden auch, dass sich die vom Modell vorhergesagten Werte im Bereich der Strahlungsantriebe befinden, was zu Bildung von Eisschilden in Breiten über 30° führt. Diese CO2-Konzentrationen liegen gerade über den Werten, die erforderlich sind, um eine Schneeball-Erde zu erzeugen und betragen dem GEOCLIM-Modell zufolge 250 ppm.

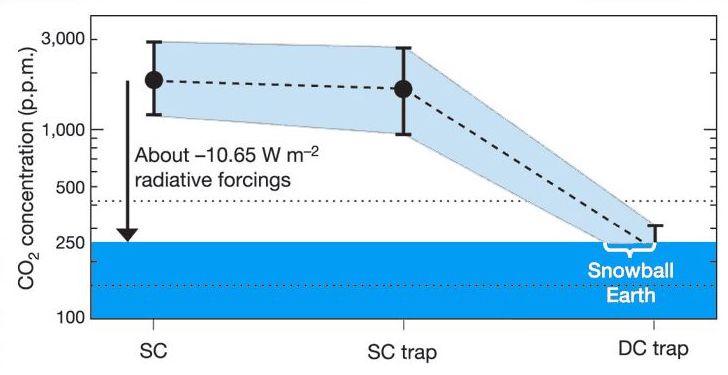

Dieser Studie zufolge liegt die untere Bandbreite, die zu einer Eiszeit führen kann, zwischen 400 und 630 ppm – man erinnere sich noch einmal daran, dass das gegenwärtige „angehobene“ Niveau um 390 ppm liegt. Man beachte, dass das Gefahren-Niveau, d. h. der Punkt, die Erde in einen Schneeball fallen zu lassen, bei 250 ppm liegt, nicht weit unter dem „vorindustriellen“ Niveau von 280 ppm, das von den Klimaalarmisten oftmals als wünschenswert propagiert wird. Die folgende Graphik aus der Studie zeigt Änderungen des atmosphärischen CO2-Niveaus während der fraglichen Zeit:

Atmosphärischer CO2-Verlauf während der Zeit vor dem Sturtischen Schneeball-Ereignis

In dieser Graphik steht SC für Supercontinent Configuration und DC für Dispersed Landmass Configuration. Gezeigt werden stationäre Zustände atmosphärischer CO2-Niveaus nach dem GEOCLIM-Modell für SC-Läufe, weil SC mit der Inklusion basaltischer Gebiete (angezeigte SC-Senke) läuft und DC auch mit basaltischen Gebieten läuft (angezeigte DC-Senke). Die horizontalen gestrichelten Linien kennzeichnen die genauen CO2-Werte, die von dem Modell in den Standardläufen erreicht werden. Der vertikale Pfeil zeigt die Änderung des Strahlungsantriebs aus direkten CO2-Effekten allein. Der dunkelblaue Bereich zeigt die CO2-Niveaus, die für einen global vergletscherten Zustand erforderlich sind bei den Klimasimulationen vor 750 Myr, die von den Forschern verwendet werden. Die gepunktete Linie verkörpert die Bandbreite des CO2-Niveaus, die für Vereisungen in niedrigen Breiten erforderlich sind, wie von verschiedenen Klimamodellen vorhergesagt. Sie stehen hier zum Vergleich mit den Wertebereichen des GEOCLIM-Modells.*

[* Ich bitte um Verständnis – bei diesem Abschnitt habe ich nur ‚Bahnhof’ verstanden! A. d. Übers.]

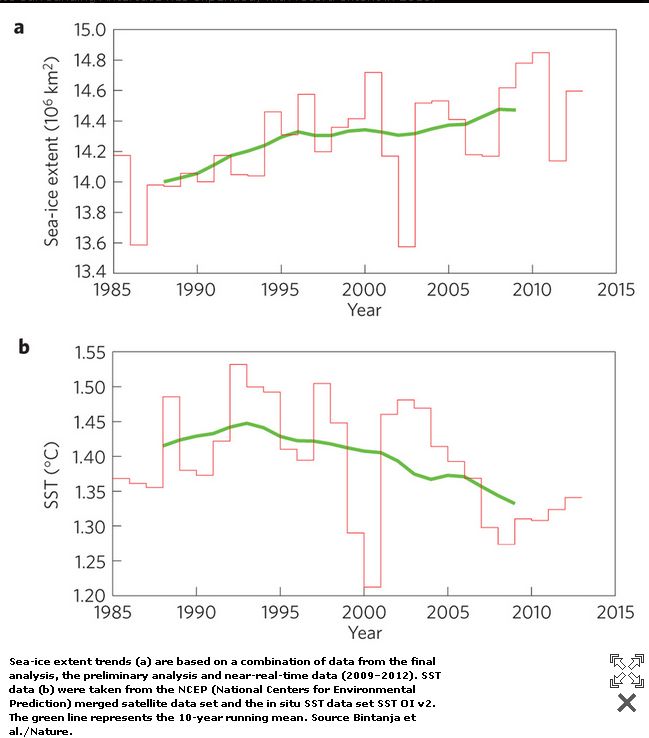

Während es stimmt, dass der Mensch zur Zunahme des atmosphärischen CO2-Niveaus beigetragen hat, lag die Zunahme nicht einmal ansatzweise in der Nähe solcher Ereignisse in der Vergangenheit. Und angesichts des geringen Umfangs von Treibhausgasen, um die es heutzutage geht, ist CO2 nicht der einzige Klimarückkopplungs-Mechanismus, der zur Klimaänderung beiträgt. Einem Bericht zufolge, der in Nature Geoscience veröffentlicht werden soll, hat das Meereis um die Antarktis während der letzten Jahre etwas zugenommen. Eine Kombination von Beobachtungen und Modellsimulationen zeigt, dass die Abkühlung der Ozeanoberfläche durch Schmelzwasser der antarktischen Eisschilde signifikant zu dieser Ausdehnung beigetragen hat. R. Bintanja et al. zufolge hat sich das antarktische Meereis ausgedehnt mit einem Maximum im Jahr 2010.

„Wir präsentieren Beobachtungen, die zeigen, dass Schmelzwasser der antarktischen Eisschilde in einer kühlen Schicht Süßwasser an der Oberfläche akkumuliert und die Ozeanoberfläche von den die Eisschilde schmelzenden wärmeren Wassern in größerer Tiefe abschirmt“, berichten sie. „Diese starke negative Rückkopplung wirkt der Erwärmung der Südhemisphäre entgegen“.

Gezeigt werden hier die Trends der Meereis-Ausdehnung (a) basierend auf einer Kombination von Daten aus der finalen Analyse, der vorläufigen Analyse und Echtzeit-Daten (2009 bis 2012) aus Bintanja et al. SST-Daten (b) stammen aus von den National Cetres for Environmental Prediction (NCEP) abgeleiteten Satellitendaten und dem in situ-SST-Datensatz SST OIv2. Die grüne Linie repräsentiert das 10-jährige jahresübergreifende Mittel. Sieht das für irgendjemanden wie globale Erwärmung aus? Tatsächlich stützt es das weit verbreitete Eingeständnis, dass die globale Erwärmung seit 15 Jahren zum Stillstand gekommen ist.

Das Fehlen globaler Erwärmung trotz unvermindert steigenden CO2-Gehaltes war eine bittere Pille für die Angst erzeugenden Klimaalarmisten. Selbst globale Anführer der globalen Erwärmung wie der Telegraph in UK und der Economist waren gezwungen zuzugeben, dass die Dinge nicht so laufen, wie sie es den Schriften der Klimaalarmisten zufolge tun sollten. Wie der Economist schreibt:

„Während der vergangenen 15 Jahre waren die Temperaturen an der Erdoberfläche flach verlaufen, während die Treibhausgasemissionen unverändert anhielten. Die Welt fügte der Atmosphäre zwischen den Jahren 2000 und 2010 etwa 100 Milliarden Tonnen Kohlenstoff hinzu. Das ist etwa ein Viertel des anthropogen erzeugen CO2’ seit 1750. Und doch, wie James Hansen, Leiter des GISS beobachtet, „die fünfjährige mittlere Globaltemperatur ist seit einem Jahrzehnt flach verlaufen“.

Der Artikel fährt fort, das Missverhältnis zu beschreiben zwischen steigenden Treibhausgas-Emissionen und nicht steigenden Temperaturen, was eines der größten Rätsel der Klimawissenschaft sein soll. „Flach wie sie sind, verharrten die Temperaturen in der ersten Dekade des 21. Jahrhunderts fast 1°C über dem Niveau der ersten Dekade des 20. Jahrhunderts“, ereifern sich die Anti-Kohlenstoff,Aspiranten. „Aber das Rätsel muss nicht erklärt werden“.

Teil des Puzzles ist, warum irgendjemand denken sollte, dass die Temperaturen während des ersten Jahrzehnts des 20. Jahrhunderts in irgendeiner Weise „normaler“, richtiger waren als die heutigen Temperaturen. Warum nimmt man nicht das Mittel der Temperatur während der Mittelalterlichen Warmzeit oder dem Höhepunkt der Eem-Zeit oder dem Ende des Jura? Wenn man beliebige Standards zum Vergleich wählt, kann man immer mit jedem fabrizierten gewünschten Ergebnis kommen.

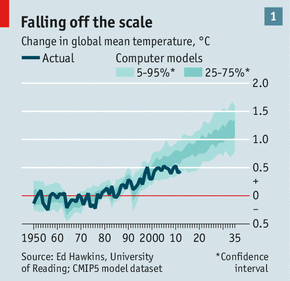

Ed Hawkins von der University of Reading weist darauf hin, dass die Temperaturen bereits seit 2005 am unteren Ende der Bandbreite der aus 20 Klimamodellen abgeleiteten Projektionen liegen (siehe Graphik). Wenn sie weiterhin flach verlaufen, werden sie innerhalb weniger Jahre ganz aus dieser Bandbreite herausfallen. Da die Modelle, entwickelt in Jahrzehnten, auf der Mainstream-Klimatheorie basieren, würde das bedeuten, dass die Theorie auch falsch ist. Dann stehen all jene, die die Gefahren der anthropogenen globalen Erwärmung an die Wand gemalt haben, entweder als Narren oder als Scharlatane da.

Nicht dass sie das Handtuch werfen – der Glaube der wirklich Gläubigen an die Klimaänderung ist stärker als das. Natürlich, egal was die Klima-Alarmisten glauben oder sagen, hat auf das tatsächliche Verhalten des Klimas den Einfluss Null.

Das Klima der Erde ist ein dynamischer Balanceakt, mit einigen Mechanismen, die versuchen, den Planeten zu erwärmen, und anderen, die versuchen ihn abzukühlen. Während der letzten 30 Millionen Jahre oder so war die Abkühlung im Anstieg begriffen, und wenn nicht alles täuscht, werden wir in der Zukunft wieder Gletscherbedingungen haben. Die Wiederbelebung von Eiszeitbedingungen wird Last genug sein für die Lebewesen der Erde und die menschliche Zivilisation. Falls der Planet wirklich irgendwann in eine neue Schneeball-Phase wechseln sollte, würde keine Spezies der heutigen Flora und Fauna überleben.

Das könnte Tahiti sein in einer weiteren Schneeball-Phase

Anstatt dämonisiert zu werden, sollte das CO2 gefeiert werden! Es hält unseren Planeten belebbar und nährt das Pflanzenleben, das die Luft atembar und alle anderen Lebensformen möglich macht. Das heutige Niveau von Kohlendioxid ist weit entfernt davon, gefährlich hoch zu sein, sondern es ist gefährlich niedrig. Alle Lebewesen der Erde, die sich gegenwärtig an der gemäßigten Wärme des Holozäns erfreuen, sollten Gott danken für das CO2. Und wenn die Historie unsere Anleitung ist, müssen wir weiterhin diese fossilen Treibstoffe verbrennen, wenn wir zukünftigen Generationen nicht eine eisige Hölle hinterlassen wollen.

Bleiben Sie sicher, freuen Sie sich über die Zwischeneiszeit und bleiben Sie skeptisch!

Link: http://theresilientearth.com/?q=content/thank-god-co2

Übersetzt von Chris Frey EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Lieber HerrKuhnle, 178

Sie sollten sich einfach mehr mit der Klimamodellierung befassen statt hier substanzlose Mutmassungen basierend auf Verschwoerungstheorien oder vorwitzigen Vorstellungen zu bringen. Das ist Stochern im Nebel.

@#177

Sehr geehrter Herr Hader,

Das Problem im IPCC-Repot ist folgendes:

Das IPCC betrachtet verschiedene ausgewählte Klimamodelle, wobei die Einschätzungen von Prof. Lindzen, Prof. Harde, Prof. Svensmark, etc. vermutlich außen vor bleiben. Dann werden die (vermutlich aus Störungsrechnungen erzielten) Streuungen der ausgewählten Modelle zu einer Gesamtunsicherheit zusammengefasst. Dann wird den politischen Entscheidungsträgern eine Klimazukunft prognostiziert, die mit der Realität überhaupt nichts zu tun hat. Es sind nur Computersimulationen, die sich als völlig falsch erweisen könnten. In diesem Zusammenhang von „likely“ zu sprechen ist in meinen Augen falsch. Bei den Wettervorhersagen haben die Metereologen langjährige Erfahrungen. Sie wissen unter welchen Gegebenheiten die Vorhersagen wie zuverlässig sein können. Bei den Klimavorhersagen gibt es diese Erfahrungen nicht. Zwar mag es schon lange Vorstellungen zum atmosphärischen Treibhauseffekt und zu verstärkenden Rückkopplungen geben, es sind aber eben nur Vorstellungen, d.h. Hypothesen. Insbesonderere bei den Rückkopplungen beruht der Konsens im IPCC eher auf Zwang.

Skepsis ist hier überaus angebracht. Ich bin mir sicher, dass viele Wissenschaftler skeptisch denken (schließlich ist es ein fundamentaler Wesenszug wissenschaftlichen Denkens) aber sich nicht trauen ihre Skepsis offen auszusprechen. Wenn man sieht wie agressiv offen ausgesprochene Skepsis bis hon zu unsachlichen persönlichen Beschimpfungen bekämpt wird, dann kann man dies durchaus nachvollziehen. Querdenker bekommen einfach kein Forschungsgeld und werden mit aller Macht von Veröffentlichungen abgehalten. Mit der Monopolmacht des IPCC werden Fachzeitschriften, die IPCC-kritische Arbeiten veröffentlichen, mit Ignoranz bedroht. Es gab bereits einige Rücktritte von Redakteuren, denen „versehentlich“ skeptische Beiträge „durchgerutscht“ sind. Ich finde dies sehr bedenklich. Ohne Politik und IPCC wäre die offene Skepsis innerhalb der Wissenschaften erheblich größer und dies wäre im Sinne des wissenschaftlichen Fortschritts ein großer Gewinn.

Die experimentelle Bestätigung von Teilaspekten wird im Übrigen völlig überbewertet. Teilweise werden Parameter mit Hilfe der Experimente nur gefittet, d.h. die Ergebnisse der Experimente sind Eingangsgrößen für die Modelle und keine Verifizierung derselben. Letztendlich kann man über Teilaspekte niemals die Zuverlässigkeit des Gesamtmodells bewerten. Ein einziger nicht verifizierter oder nicht ausreichend beachteter anderer Teilaspekt reicht aus um die 100jährige Vorhersagezuverlässigkeit der Klimamodelle vollständig zu kippen. Andersherum kann eine experimentelle Widerlegung eines Teilaspekts ein Modell falsifizieren. Diesen Weg hat Prof. Singer beschrieben, woraufhin ihm von klimawahnsinnigen Wissenschaftlern die Nähe zur Öl- und Tabakinstustrie vorgehalten wurde. Eine sachliche Diskussion wäre da nützlicher gewesen. Eine offene Diskussion unter Anwesenheit der Kontrahenden fand aber nie statt. Warum eigentlich nicht?

Der politische Streit geht natürlich weit über den naturwissenschaftlichen hinaus. Die muss auch so sein. Ihre Behauptung, es gäbe Leute die den Grad der Informiertheit zurückdrehen wollen, ist absurd. Sie sollten akzeptieren, dass es auch andere politische Ansichten als Ihre gibt und fair bleiben.

Hallo Dr. Kuhnle, erst mal danke für Ihre Antwort.

#175: „Wenn Sie die physikalischen Zusammenhänge verstehen wollen, dann müssen Sie die von Ihnen beschriebene Puzzlearbeit leisten. Damit sind Sie aber noch nicht am Ziel. Sie brauchen noch die experimentelle Bestätigung. Wenn dabei das Signal-Rausch-Verhältnis zu schlecht ist, dann haben Sie Pech oder müssen eben so lange warten bis dass Signal aus dem Rauschen herauskommt. Sie sollten nicht einfach vorschnell behaupten Ihr Modell sei wahrscheinlich richtig.“

Das man zu wenig Daten besitzt oder nur auf kurze Zeitreihen zurückgreifen kann, das Problem kennt man auch aus anderen naturwissenschaftlichen oder technischen Bereichen. Als Signalverarbeiter hat man beispielweise einige Werkzeuge in der Hand, wenn ein schlechtes Signal-Rausch-Verhältnis vorliegt (Filter, Frequenzanalyse usw.). Hängt auch stark von der Art des Rauschens ab. Experimentelle Bestätigungen kann man auch in Teilaspekten erzielen, in dem man die von der Erde zurückgeworfene Strahlung spektral untersucht oder gezielt den Tagesverlauf untersucht (ist die nächtliche Abkühlung geringer als noch vor Jahrzehnten?). Zu verrauschte und/oder zu wenige Daten erschweren die Analyse, aber das Gute an den Naturwissenschaften ist ja, dass es immer mehrere Wege zum Erkenntnisgewinn gibt. 🙂

„Sie dürfen von Ihrem Modell überzeugt sein, Sie dürfen Vermutungen aufstellen, Sie mùssen aber auch damit rechnen, dass Ihr Modell völlig unbrauchbar sein könnte.“

Natürlich, ist in meiner täglichen Arbeit nicht anders. Auch da muss ich aufgestellte Modelle modifizieren und auf den neuesten Wissensstand bringen.

„Es ist nicht möglich eine Aussagewahrscheinlichkeit mit einem Modell, dass sich in seiner Prognosefähigkeit bisher nicht bewährt hat, statistisch zu berechnen.“

Sie scheinen mit Aussagewahrscheinlichkeit mit einem Modell etwas anderes zu verstehen, als man es in der Statistik tut. Wenn man da von Konfidenz spricht (was Sie hier vermutlich meinen), dann sagt das etwas aus, wie stark die Koeffizienten im Modell statistisch schwanken können. Die Modelle gehen schon von einer Schwankung der Input- und inneren Zustandsgrößen aus. Einfachstes Beispiel, man möchte den Mittelwert einer physikalischen Größe bestimmen und ermittelt empirisch Daten. Man kann unter der Annahme bestimmter Randbedingungen sagen, in welchem Konfidenzintervall der tatsächliche Mittelwert liegt. Wenn aber die Wirklichkeit sehr stark von den Randbedingungen abweicht, dann schwanken auch die berechneten Werte in einem ganz anderen Ausmaß. Kurz zusammengefasst, die Konfidenzen sagen was über die Schwankungen der Modelle aus, muss aber mit der Wirklichkeit nicht identisch sein.

„Ohne jede wissenschaftliche Veröffentlichung zu kennen, gehe ich davon aus, dass Wahrheitsaussagen und spekulativ behauptete Aussagewahrscheinlichkeitsaussagen den Wissenschaftlern eher fremd sind und weitgehend vermieden werden. Anders ist dies beim IPCC. Dort liest man in den Berichten immer wieder die Wörter „likely“ und „very likely“.“

Okay, machen Sie doch mal folgendes Experiment, welches ich vorhin auch durchgeführt habe. Öffnen Sie mal Google Scholar, eine umfangreiche Datenbank für wissenschaftliche Publikationen. Geben Sie dort mal den Suchbegriff „very likely“ ein. Ich kam da vorhin auf über 900.000 Einträge. Mit anderen Worten, Ausdrucksweisen wie „very likely“ (Leo gibt als deutsche Übersetzung „höchstwahrscheinlich“ an) sind gängig in den Wissenschaften und alles andere als unwissenschaftlich. Es hätte mich auch gewundert, wenn es anders wäre. Ich weiss nicht, weshalb solche Ausdrucksweisen für Sie ein rotes Tuch darstellen, vielleicht können Sie es noch näher erläutern.

„Ohne die Politisierung und WWF-Durchseuchung des IPCC würde die Klima-Wissenschaft wesenlich nüchterner, sachlicher und seriöser argumentieren als es heutzutage leider der Fall ist.“

Klimawissenschaften gab es schon vor der Gründung des IPCC. Die damaligen Ergebnisse waren nicht fundamental anders als heute. Es gab auch damals die Vorstellungen zum atmosphärischen Treibhauseffekt. Auch damals gingen Wissenschaftler von positiven Rückkopplungseffekten bei einer Erhöhung des CO2-Anteils aus. Der Unterschied zu damals ist allerdings (neben dem allg. wissenschaftlichen und technischen Fortschritt), die Ergebnisse war in der politischen Entscheidungsebene weit weniger bekannt als heutzutage. Und das scheint einige politisch (nicht wissenschaftlich) arg zu stören und würden den Grad der Informiertheit am liebsten wieder zurückdrehen. Nicht ohne Grund ist in einigen industriellen Ländern der Zuspruch des Klimaskeptizismus in der Politik größer als in der Wissenschaft selbst, siehe große Teile der Republikanischen Partei in den USA oder die UK Independence Party in Großbritannien. Was die meisten Klimaskeptiker tatsächlich stört, sind ja meist nicht die wissenschaftlichen Aussagen, sondern was die politischen Entscheidungen betrifft. Meinen Sie, die Empörung bzgl. den Klimawissenschaften wäre nur halb so groß, wenn man die Ergebnisse in der Politik gar nicht zur Kenntnis nehmen würde?

Herr Kuhnle,

welche Modelle meinen Sie eigentlich, was sind die Variablen zur Validierung und nennen Sie Signalhoehe und Rauschlevel in absoluten

Werten dieser Variablen.

@#173

Sehr geehrter Herr Hader,

Wenn Sie die physikalischen Zusammenhänge verstehen wollen, dann müssen Sie die von Ihnen beschriebene Puzzlearbeit leisten. Damit sind Sie aber noch nicht am Ziel. Sie brauchen noch die experimentelle Bestätigung. Wenn dabei das Signal-Rausch-Verhältnis zu schlecht ist, dann haben Sie Pech oder müssen eben so lange warten bis dass Signal aus dem Rauschen herauskommt. Sie sollten nicht einfach vorschnell behaupten Ihr Modell sei wahrscheinlich richtig. Sie dürfen von Ihrem Modell überzeugt sein, Sie dürfen Vermutungen aufstellen, Sie mùssen aber auch damit rechnen, dass Ihr Modell völlig unbrauchbar sein könnte. Es ist nicht möglich eine Aussagewahrscheinlichkeit mit einem Modell, dass sich in seiner Prognosefähigkeit bisher nicht bewährt hat, statistisch zu berechnen.

Ohne jede wissenschaftliche Veröffentlichung zu kennen, gehe ich davon aus, dass Wahrheitsaussagen und spekulativ behauptete Aussagewahrscheinlichkeitsaussagen den Wissenschaftlern eher fremd sind und weitgehend vermieden werden. Anders ist dies beim IPCC. Dort liest man in den Berichten immer wieder die Wörter „likely“ und „very likely“. Dies ist dem Auftrag geschuldet, Vorgaben für politisches Handeln zu liefern. Ohne die Politisierung und WWF-Durchseuchung des IPCC würde die Klima-Wissenschaft wesenlich nüchterner, sachlicher und seriöser argumentieren als es heutzutage leider der Fall ist.

Mit freundlichen Grüßen,

Dr. Kuhnle

#173: S.Hader speziell für Sie ein paar ganz einfache Fragen zum „Modell“, da man den Treibhauseffekt ja leider nicht messen kann:

http://tinyurl.com/lrvupp

Ist dieses immer noch weit verbreitete Modell von Kiel und Trendberth nach physikalischen Gesetzen, die in der Realität wirken MÖGLICH???

JA oder NEIN ?

mfG

Lieber Dr.Kuhnle, soweit ich Ihnen im letzten Text zustimmen kann, hier „Bisher haben die Modelle eher kläglich versagt, denn alle Erwärmungsprognosen der letzten 16 Jahre wurden noch nicht einmal im Vorzeichen des Trends bestätigt.“ betreiben Sie eine Simplifizierung der Klimaforschung, die unzulässig ist. Die Klimaprognose besteht nicht aus einem Vorzeichen. Sie werden zudem in keiner wissenschaftlichen Veröffentlichung oder IPCC-Bericht die Aussage antreffen, dass der Wert der globalen Durchschnittstemperatur ab einem Zeitpunkt t stets über dem Wert von t liegen wird. Es ist doch logisch, dass bei der vorhandenen Klimavariabilität und einem noch „moderaten“ Anstieg des CO2-Gehalts die Temperaturkurve in einem Zeitfenster von 1-2 Jahrzehnten ausgesprochen flach sein kann. Mich persönlich erstaunt das als jemand, der beruflich viel mit Datenanalyse, Modellen und Vorhersagesystemen zu tun hat, überhaupt nicht. Auf kurze Zeiträume gesehen ist das Signal-Rausch-Verhältnis zu miserabel, um daraus die Wirklichkeit ableiten zu wollen. Mit rein datengetrieben Ansätzen, die das Klima nur als Black-Box sehen, wird man eh nicht weit kommen, dass ist mir ziemlich bewusst (Ihnen scheinbar nicht). Man wird nicht umhinkommen, die physikalischen Zusammenhänge herauszuarbeiten und in einer Puzzlearbeit in die Modelle einzufügen.

„Eine noch nicht ganz zu 100% widerlegte Hypothese ist allerdings Welten entfernt von einer zu 100% verifizierten Hypothese.“

Man kann in der Naturwissenschaft keine Hypothesen zu 100% verifizieren. Das sollte Ihnen als Physiker (das sind Sie doch, oder?) bekannt sein.

„Die freche Behauptung, die IPCC-Modelle seien „wahrscheinlich“ richtig oder die CO2-Klimasensitivität sei sehr wahrscheinlich 2 bis 4,5 Grad sind blancke Spekulationen. Von einem Wissenschaftler erwarte ich, dass er hinter seiner Hypothese steht und dass er sie verteidigt. Aber bitte keinen Wahrheitsanspruch, sonst verkommt die Wissenschaft zur Religion.“

Zeigen Sie doch bitte eine einzige wiss. Veröffentlichung, die von sich aus behauptet, die Wahrheit zu verkünden. Da bin ich sehr gespannt drauf. So ein Paper müsste nach meinem wiss. Verständnis aus jedem peer-Review-Prozess herausfliegen.

„Vermutungen und Schätzungen aber auch Bedenken sind zentrale Denkweisen in der Wissenschaft, „wahrscheinlich richtig“-Aussagen“ nicht.“

Eine Vermutung ist Ihrer Ansicht nach wissenschaftlich, aber zu sagen, eine bestimmte Aussage ist wahrscheinlich richtig, sei es nicht? Das ist jetzt unlogisch. Es sei denn, sie wollen Statistik generell zur Unwissenschaft erklären.

@171 Dr. Kuhnle: „Von einem Wissenschaftler erwarte ich, dass er hinter seiner Hypothese steht und dass er sie verteidigt. Aber bitte keinen Wahrheitsanspruch, sonst verkommt die Wissenschaft zur Religion. Vermutungen und Schätzungen aber auch Bedenken sind zentrale Denkweisen in der Wissenschaft, „wahrscheinlich richtig“-Aussagen“ nicht. Aus dem Auftrag des IPCC leitet sich leider ab, wissenschaftliche Denkweisen durch politisch-ideologische zu ersetzen. Dadurch wird die Wissenschaft als Ganzes schwer beschädigt“

Ja, die Wissenschaft an sich wird durch die AGWler schwer beschädigt und deswegen erzürnen mich auch deren Exponenten, die die Nähe der Politik und Medien wegen Machtgelüsten, Profilierungssucht, Welterrettungsphantastereien etc. suchen (die Schellnhubers, Rahmstorfs, Latifs, NicoBaeckers, Ebels, N. Fischers, Marvin Müllers usw. usw.) so sehr. Was diese CO2-hysterischen AGWler betreiben ist ideologisierte Politagitation aber keine Wissenschaft.

Die vom IPCC veröffentlichten Szenarien prognostizieren für den Zeitraum bis 2100 global ansteigende Temperaturen. Es wird behauptet, der Temperaturanstieg hänge wesentlich von der Nutzung fossiler Energieträger durch die Menschheit ab. Diese Behauptung nenne ich AGW Hypothese. Ist diese Hypothese nun wahr oder unwahr, richtig oder falsch?

Hier im EIKE-Blog wird heftig darüber gestritten ob die dahinter stehende Physik richtig oder falsch ist. Scheinbar ist dies nicht einfach zu beurteilen, ich gehe aber davon aus, dass die IPCC-Modelle auf legitimen physikalischen Vorstellungen beruhen. CO2 kann IR-Strahlung absorbieren und emittieren, dies bezweifelt niemand. In welchen Frequenzbereuchen dies wie geschieht scheint mir auch relativ genau erforscht. Die Fragen, die sich stellen sind jedoch viel weitergehend. Wann gibt es überhaupt ein Gleichgewicht, und über welche Zeiträume stellt sich ein Gleichgewicht wie ein? Wie wechselwirken einzelne Einflussparameter miteinander? Gibt es noch Einflüsse, die bisher noch gar nicht erfasst oder nicht komplett verstanden worden sind?

Die IPCC-Modelle müssen diese und weitere Fragen beantworten, und dies wird auch getan. Aber – Sind die Antworten alle zweifelsfrei richtig? An dieser Stelle outen sich die IPCC-Leute als unseriöse Aktivisten, wenn sie Behaupten sie seien im Besitz der Wahrheit. Hier setzt meine Kritik ein. Eine Hypothese erweist sich nur dann als brauchbar, wenn Sie durch Fakten bestätigt wird. Die Bestätigung ist frühestens 2100 möglich, wenn die prognostizierte Temperaturerhöhung bis dahin wirklich eintritt. Und selbst dann muss weitgehend ausgeschlossen werden, dass die Temperatur nicht zufällig oder aus einem anderen Grund gestiegen sein könnte. Bisher haben die Modelle eher kläglich versagt, denn alle Erwärmungsprognosen der letzten 16 Jahre wurden noch nicht einmal im Vorzeichen des Trends bestätigt. Die Zukunfts-Prognosen waren demnach bisher extrem schlecht. Prof. Rahmstorf und andere mögen ja daran glauben, dass es irgendwann endlich wärmer werden wird und betrachten die 16 Jahre als zu kurz um die AGW-Hypothese zu widerlegen. Eine noch nicht ganz zu 100% widerlegte Hypothese ist allerdings Welten entfernt von einer zu 100% verifizierten Hypothese.

Die freche Behauptung, die IPCC-Modelle seien „wahrscheinlich“ richtig oder die CO2-Klimasensitivität sei sehr wahrscheinlich 2 bis 4,5 Grad sind blancke Spekulationen. Von einem Wissenschaftler erwarte ich, dass er hinter seiner Hypothese steht und dass er sie verteidigt. Aber bitte keinen Wahrheitsanspruch, sonst verkommt die Wissenschaft zur Religion. Vermutungen und Schätzungen aber auch Bedenken sind zentrale Denkweisen in der Wissenschaft, „wahrscheinlich richtig“-Aussagen“ nicht. Aus dem Auftrag des IPCC leitet sich leider ab, wissenschaftliche Denkweisen durch politisch-ideologische zu ersetzen. Dadurch wird die Wissenschaft als Ganzes schwer beschädigt.

@#166: Ebel sagt:

„Selbst mit dem Unsinn von besso (Samstag, 30.01.2010, 13:34) „Wenn in größerer Höhe (bei gleicher Temperatur) abgestrahlt werden soll, so vergrößert sich die abstrahlende Fläche mit der dritten Potenz des Radius.“ werden es nur 0,45%.“

Ebel, Ebel, Ebel, tz, tz, tz:

Wollten Sie nicht „Techn. Thermodynamik I und II“ nachholen?

Sie sollten in der Uni sein und was machen Sie?

Sie zitieren mich schon wieder falsch!

Jetzt konzentrieren Sie sich doch bitte mal auf Ihre Ausbildung und verwenden weniger Zeit darauf irgendwelche Vermutungen zu den physikalischen Vorgängen in der Atmosphäre anzustellen.

Lieber Herr Kuhnle, #150

„Grundsätzlich habe ich nichts gegen die IPCC-Modelle.“

sind Sie sich da wirklich sicher? Dafür wettern sie aber eifrig daegen…

„Möglicherweise treten die Vorhersagen sogar ein, ich schätze aber eher nicht.“

„Bedenken“ und „Schätzen“ wiegt die Wissenschaft nicht auf.

„Bei der Aussage die Vorhersagen würden wahrscheinlich entreten sträuben sich mir die Haare. Bei Modellen, die in ihrer Gesamtheit nicht eindeutig (durch Nachweis) verifiziert sind, ist eine solche Aussage nicht möglich.“

Wie kommen Sie darauf, daß diese nicht verifiziert sind?

„Statistische Fehlerrechningen sind ungeeignet, weil systematische Fehler nicht ausgeschlossen werden können. Systematische Fehler können ganz unterschiedlicher Art sein. Letzlich muss bewiesen werden, dass die Modelle nicht nur die Vergangenheit, sondern auch die Zukunft nicht nur in Details, sondern auch insgesamt mit hoher Zuverlässigkeit abbilden können.“

Was für die Zukunft nicht möglich ist…, nach dieser Logik wäre jede Vorhersage unmöglich.

„Ihre Frage zu den Temperatursprüngen gehört hier nicht zum CO2-Thema und ich würde lieber an anderer Stelle darüber diskutieren.“

Ok, gerne.

„Wichtig ist die Erkenntnis dass der Mittelwert von Temperaturen physikalisch etwas anderes ist als eine Temperatur.“

Klar, ist aber auch nicht der Punkt.

„Die Einheit ist zwar gleich, aber es ist etwas völlig anderes.“

… die mittlere Lebenserwartung ist auch etwas anderes als meine eigene oder Ihre. Aber dennoch sind Mittelwerte kein mathematischer Nichtsnutz.

„Global sieht es anders aus. Hier stagniert der Temperaturtrend zwar erst seit etwa 16 Jahren, aber das 2-Sigma Konfidenzintervall der IPCC-Hypothese wurde bereits verlassen. Dies liegt an der geringen Streuung der globalen Mittelwerte.“

Ich frage mich auch, ob man da nicht Äpfel mit Birnen vergleicht und die Konfidenzintervalle der Modelle nicht auf Realisationsbasis bestimmt größer wären und Modellgenauigkeit dadurch zu schlecht wiedergegeben wird.

#166: Ebel rechnet:

“ … sind 1000% (100 m² zu 10 m²) wesentlich größer als 0,3%.“

100 ist also 1000% von 10, nanu?

Baecker würde jetzt höflich fragen, wie man das jetzt so verstehen könnte, dass mit 1000 doch 10 gemeint sind.

weiter Ebel:

„Kommentar von Eschenbach zu Woods Experiment: „Hierzu möchte ich Folgendes sagen: Weil die Differenz der äußeren Oberfläche der Hülle und der Planetenoberfläche nur etwa 0,3%* ausmacht, mache ich die vereinfachende Annahme, dass beide Oberflächen gleich sind.““

Das ist nun wirklich KEIN Kommentar zu WOODs Experiment 1909

weiter Ebel:

„…Aber viel wesentlicher ist, das mit kürzerer Absorptionsläge, die dazu führt, daß nur Emissionen aus größeren Höhen den Weltraum erreichen,..“

Falsch! Die Emission ist abhängig von der Moleküldichte der Gesamtatmosphäre, also unabhängig von der „CO2-Absorbtionsläng“. Zudem wird es „weiter oben“ nicht kälter sondern wärmer.

Max. Kühleffekt von CO2 in ca. 50km Höhe.

weiter Ebel:

„… zu einem höheren Transportwiderstand führt. Dadurch sinkt die nachgelieferte Leistung stärker als die Abstrahlfläche zunimmt.“

Falsch! CO2 ist kein Isolator, der die Erde irgendwie an der Abstrahlung hindern könnte.

Entsprechend falsch sind auch daraus abgeleiteten weiteren Schlussfolgerungen.

Mehr CO2 hindert die Erde bezüglich ihrer Wärmeabgabe in gar keiner Weise, siehe auch Doppelglasisolierfenster, Argon etwa 20 mal häufiger schon mehr, obwohl (weil!) es Strahlung überhaupt nicht absorbiert oder emittiert, hat einen deutlich größeren „Wärmetransportwiderstand“.

Dagegen führt mehr CO2 zu mehr Kühlung in den Weltraum, WEIL es strahlen kann.

Um um mit dem Jargon der Treibhauskünstler zu sprechen,

muss ja dann aus Bilanzgründen die Erde weniger abstrahlen und wird kälter,

sehen wir ja seit 17 Jahren 🙂

Kugeloberfläche = 4 pi r^2

mfG

#165: Wolfgang Rasim Sie haben völlig recht mit Gerlich, die Treibhaustheorie wimmelt nur so von physikalischen Fehlern.

Gerlich ist für den Laien, dazu gehören GANZ OFFENSICHTLICH auch viele Klimatologen, rel. schwer lesbar, weil er mit physikalischen Formeln und Differenzialgleichungen nur so um sich wirft.

Wer mit der Gegenstrahlunghypothese a la Kiel und Trenberth heute noch argumentiert, wie hier der Forentroll Baecker, obwohl eine solche ENERGIEQUELLE in der Atmosphäre, die deutlich über 500W/m2 leisten soll NICHT existiert, zeigt das ganz deutlich (das entspr. nach S&B einer Temperatur von 35 bis 40°C!!!).

Was den Treibhausgas-Erderwärmungs-Predigern jedoch endgültig den Hals bricht, ist die messbare Tatsache der spektralfrequenzspezifischen Absorbtion und THERMALISIERUNG dieser langwelligen „Wärmestrahlung“der Erde.

Das heist auf Deutsch „Strahlungsdivergenz“,

die Strahlung der „Treibhausgase“ geht einseitig in den Weltraum und KÜHLT.

Das wissen heute auch alle Meteorologen, man muss nur einmal über long wave radiation heating rates, oder cooling rates googeln.

Das Wissenschaftsgeschäft mit dem Klima ist aber inzwischen dermaßen gigantisch aufgebläht, dass man lustig weiter macht mit dem „menschengemachten Katastrophenmeldungen“.

Da kommt eine Satellitengeneration nach der anderen in Milliardenhöhe um das earth energy budget besser berechnen zu können, was bisher immer noch völlig unmöglich ist, weniger bei der Frage der Sonneneinstrahlung, sondern bei der Frage, was die Erde damit macht. Die Wolken sind z.B. noch nicht annähernd quantitativ berechenbar. Also boomt die Klimaforschung weiter auf höchstem Niveau.

Für eine vernünftige „Menschenpolitik“ reicht das Geld natürlich nicht. Man muss ja erst das Klima der nächsten 200 Jahre retten, obwohl man nicht weis, wie es sich entwickelt und wie das mit dem „Retten“ funktionieren soll.

mfG

#162: Dr.Paul sagt am Donnerstag, 02.05.2013, 22:24

Zu #160: Ebel „In der Schulphysik lernt man, das die Kugeloberfläche mit dem Radius zunimmt.“

Ganz abgesehen davon, daß ich in #160 gar keinen Bezug auf die Kugeloberfläche genommen habe, sind 1000% (100 m² zu 10 m²) wesentlich größer als 0,3%. Aber Pauls Schulwissen etwas auffrischen:

Kommentar von Eschenbach zu Woods Experiment: „Hierzu möchte ich Folgendes sagen: Weil die Differenz der äußeren Oberfläche der Hülle und der Planetenoberfläche nur etwa 0,3%* ausmacht, mache ich die vereinfachende Annahme, dass beide Oberflächen gleich sind.“

Selbst mit dem Unsinn von besso (Samstag, 30.01.2010, 13:34) „Wenn in größerer Höhe (bei gleicher Temperatur) abgestrahlt werden soll, so vergrößert sich die abstrahlende Fläche mit der dritten Potenz des Radius.“ werden es nur 0,45%.

Aber viel wesentlicher ist, das mit kürzerer Absorptionsläge, die dazu führt, daß nur Emissionen aus größeren Höhen den Weltraum erreichen, zu einem höheren Transportwiderstand führt. Dadurch sinkt die nachgelieferte Leistung stärker als die Abstrahlfläche zunimmt. Das drückt sich auch darin aus, daß Paul immer wieder die zunehmende Kühlung betont und geringere Temperatur bedeutet verringerte Abstrahlung – in Übereinstimmung mit dem höheren Transportwiderstand.

Das führt dazu, daß in den absorbierenden Wellenlängenbereichen (und nur in diesen stammen Photonen, die den Weltraum erreichen), der Wärmestrom abnimmt und dafür als als Ausgleich mehr Photonen emittiert werden müssen, die von der Erdoberfläche den Weltraum direkt erreichen – atmosphärisches Fenster. Dieses Mehr an Photonen erfordert eine höhere Oberflächentemperatur.

Zwar vergrößert die zunehmende Oberflächentemperatur auch etwas die Temperaturdifferenz zur Abstrahlhöhe – aber diese Zunahme der Temperaturdifferenz kompensiert nicht die Erhöhung des Transportwiderstandes.

MfG

# 162

Dr. Paul,

ist mir fast peinlich, quadratisch stimmt doch, mit der 3. Potenz betrifft das Volumen, ich musste dafür gerade eine Formelsammlung zu Hilfe nehmen.

Zur gesamten Diskussion der Atmosphärenphysik in diesem Forum mit über 160 Beiträgen:

Altkanzler Schmidt äußerte einmal sinngemäß zu diesem „Klima- CO2- Modellierungs- Wahnsinn“:

Alles Quatsch, die gesamten Zusammenhänge sind noch viel zu wenig erforscht.

Kennen Sie die Ausführungen von Prof. Gerlich, TU Braunschweig?

Von ihm wird nachgewiesen (ich habe das als „Nichtphysiker“ ein wenig nachzuvollziehen versucht), dass der „Entdecker des Treibhauseffektes“ (so in: Berliner Zeitung, 19.02.2009, S. 15), der Nobelpreisträger für Chemie, Svante Arrhenius in seiner Abhandlung dazu das Stefan- Boltzmann- Gesetz nicht richtig oder überhaupt nicht angewendet hat.

MfG

# 162

Hallo, Dr. Paul,

pardon, ich meinte natürlich,

„mit der dritten Potenz“ zunimmt.

MfG

# 162

Hallo, Herr Kollege Dr. Paul,

heißt das nicht doch so, dass die Kugeloberfläche mit dem Radius

q u a d r a t i s c h

zunimmt?

MfG Dr.- Ing. Wolfgang Rasim

P. S. im anderen Forum zum Infraschall (Säugling) wäre ich für eine konstruktive Antwort dankbar

#160: Ebel

„Ich habe den Eindruck, Paul tut so als hätte er einen Röntgenblick. “

na klar, für den „CO2-Treibhauseffekt“,

nur keinen Neid, Ebel, wer hat, der hat.

In der Schulphysik lernt man, das die Kugeloberfläche mit dem Radius zunimmt.

mfG

Lieber Herr Ebel, #151

danke fuer die Erklaerung. Ich bin vo einerZustandsaenderung konstante Enthalpie von isotherm isobar zu adiabatisch ausgegangen, nachdem g eingeschaltet ist, die Enthalpie also auch im isothermen, isobaren Zustand die potentiellen Energie schon enthaelt. Sie gehen dagegen davon aus, dass die potentielle Energie den Nullpunkt auf Hoehe des Erdbodens hat und gehen von einem isothermen&isobaren Zustand ohne potentielle Energie aus und beziehen. nach Einschalten von g die Energieaenderung auf dieen Nullpunkt. Das ist moeglich, aber wie auch immer, das Problem ist wie gesagt gar nicht eindeutig definiert. Wie ich schon schrieb kann man den Nullpunkt der pot. Energie auch ins Unendliche legen.

Ich werde mir Ihren Weg trotzdem auch noch im Detail angucken. Danke fuers Erste.

Kommentar: @ #158: Dr. Kuhnle sagt am Dienstag, 30.04.2013, 21:48

„Paul … Von welcher Fläche sprechen Sie?“

Ich habe den Eindruck, Paul tut so als hätte er einen Röntgenblick. Bei hintereinander 10 Flächen a‘ 10 m² sieht er 100 m², obwohl man 100 m² nur sieht, wenn die Flächen nebeneinander sind.

Photonen werden in allen Höhen emittiert. Den Weltraum erreichen nur Photonen, die nicht vorher absorbiert werden. Die Menge der übrig bleibenden Photonen wird durch die Temperatur bestimmt, da die Temperatur das Verhältnis absorbierender zu emittierender Moleküle bestimmt. Paul will aber die Absorption unberücksichtigt lassen und addiert je nach Lust und Laune die Emissionen aus verschiedenen Höhen (seine Flächen hintereinander).

MfG

#158: Dr. Kuhnle wenn man von dem mathematischen Konstrukt einer „Fläche“ ausgeht, was nur für die Erdoberfläche zutrifft, wird die selbstverständlich größer mit zunehmender Höhe.

Bei CO2 haben wird verglichen mit einer kleinen Fläche jedoch eine Säule von über 100 km Höhe mit Temperaturen die teilweise höher sind als die auf der Erdoberfläche.

Wenn es um grobe Vergleichskalkulation geht darf man das auch ein Vergrößerung der Abstrahlfläche nennen. Quantifiziert wird das üblicherweise als Kühlrate mit K/d.

Hierfür kommen auf Gase beschränkt im wesentlichen,

Wasserdampf (H2O), Kohlendioxyd (CO2) und Ozon (O3) infrage!

Das heist, es gibt nicht „die Emissionshöhe“ der Atmosphäre oder „der Treibhausgase“, sondern sie ist völlig unterschiedlich für jedes strahlungsfähiges Gas,

wobei rund 70% des Wasserdampfes in in den untersten 2 km der Atmosphäre zu finden ist. Oberhalb sinkt der Anteil wegen der adiabatischen Temperaturabnahme (Kältefalle) praktisch auf 0 in der Stratosphäre. Selbstverstädlich spielt Wasser trotzdem wegen der Menge eine große Rolle, wobei die Kühlung überwiegt.

Ozon ist bekanntlich weitgehend begrenzt auf die Ozonschicht, auch Ozon kühlt selbstverständlich.

NUR CO2 findet man unverändert vom Erdboden bis zur Grenze der „Homosphäre“, deshalb die rel. starke Kühlrate.

weiteres später,

Gruß

@#153

Sehr geehrter Herr Dr. Paul,

Das mit der Abstrahlfläche habe ich nicht verstanden. Von jedem Quadratmeter der Erdoberfläche strahlt es Richtung All. Je nach Wellenlänge direkt vom Boden oder auch aus höheren Schichten. Von welcher Fläche sprechen Sie?

Zur Messung der Abstrahlung:

Wie kann man die Abstrahlung messen? Woher weiß man, aus welcher Höhe die gemessene Abstrahlung emittiert wurde? Wie sieht das Ergebnis der Messungen aus?

Mit freundlichen Grüßen

Dr. Kuhnle

@#147: Dr. Kuhnle sagt:

„Der AGW Hypothese fehlt daher die experimentelle Bestätigung.“

Halo Herr Dr. Kuhnle,

ich glaube, Sie haben die richtige Fährte aufgenommen. Man braucht gerade bei diesem Thema ein sehr gesundes Selbstbewußtsein um sich hinzustellen und zu sagen daß der Treibhauseffekt gar nicht existiert.

Ist ja beinahe so, als hätte im Mittelalter jemand behauptet daß die Erde sich um die Sonne dreht…

MfG

@ #153: Dr.Paul sagt am Dienstag, 30.04.2013, 16:08

„Auf jeden Fall sind strahlungsfähige Gase in der Atmosphäre ZU ADDIEREN.“

Ja und? Je nach überlappender Spektralbereiche emittiern und absorbieren verschiedene Treibhausgase gleichzeitig.

@ #153: Dr.Paul sagt am Dienstag, 30.04.2013, 16:08

„Für die Bilanz mit dem Weltall, die ja nur mit Strahlung erreicht werden kann, kommt es auf die Gesammtfläche an, die bis in den Welraum strahlt.“

Es geht um die Gesamtfläche senkrecht zu den Radiusvektoren – ganz gleich in welcher Höhe die Emission erfolgt. Aber nur die wenigsten emittierten Photonen erreichen das All – die meisten werden absorbiert, bevor sie das All erreichen könnten.

MfG

@ #151: NicoBaecker sagt am Dienstag, 30.04.2013, 12:19

„wie bei der Umwandlung unter Enthalpiekonstanz“

Die Enthalpie ist H = U + pV, die potentielle Energie ist in der Enthalpie nicht enthalten, muß aber beim Zusammenfallen berücksichtigt werden. Die Änderung der Massenhöhe wird beim Zusammenfallen als Umwandlung von potentieller Energie in Wärmeenergie berücksichtigt.

@ #151: NicoBaecker sagt am Dienstag, 30.04.2013, 12:19

„Können Sie mal die DGL angeben?“

x sei die normierte Höhenkoordinate des Anfangszustandes

y sei die normierte Höhenkoordinate des Endzustandes

dy = [1 + c(x – y)][pk – e x]^(-1/k) dx

k ist der Adiabatenexponent (1,38)

pk ist der normierte Druck am Kern (normiert auf den Anfangsdruck)

c und e sind Konstanten, die den Aufbau beschreiben

c = g * H /(cp * Ta) = 0,12

e = g * M / pa = 0,45

Die erste eckige Klammer beschreibt die Umwandlung der potentiellen Energie in Wärme, die zweite eckige Klammer beschreibt die adiabatische Änderung.

Anfang ist x = 0, y = 0. pk ist so zu wählen, daß für x = 1, y = 1 wird.

MfG

#152: Ebel ich staune immer über Ihre physikalischen Neuschöpfungen:

„Die Intensitätsspitze bei 15 µm stammt allerdings nicht aus niedriger Höhe, sondern aus dem Ozonbereich, wo die Temperatur wieder ansteigt. Zur Spitze kommt es, weil bei 15 µm die Absorptionslänge so kurz ist, daß sie nur bis in den Ozonbereich reicht.“

.. so kurz, ?

war das nicht vielleicht doch NOCH ETWAS KÜRZER?

mfG

#147: Dr. Kuhnle ich habe 1) und 2) lange erfüllt!

in #145 ist eigentlich alles entscheidende gesagt.

Ihre Aussage:

“ Die Abstrahlingsfläche ist immer die komplette Erdoberfläche.“

Hm, meinen Sie jetzt irgendwelche „Modelle“?

Auf jeden Fall sind strahlungsfähige Gase in der Atmosphäre ZU ADDIEREN.

Für die Bilanz mit dem Weltall, die ja nur mit Strahlung erreicht werden kann,

kommt es auf die Gesammtfläche an, die bis in den Welraum strahlt. Bei der Erdoberfläche sind durch Absorbtion in der Atmosphäre deutliche Abzüge erforderlich, was diese Fläche auf die sog. „offenen Fenster“ insbesondere im Strahlenmaximum um 10µm beschränkt.

Wenn nun die Abstrahlleistung der Treibhausgase höher ist als der „geschlossene Fensterteil“,

bewirken sie eine Kühlung.

Genau das sagen Experten des IPCC, z.B. auch der Meteorologe Feldman und Kramm.

Dazu benötigt man keine Programme, sondern die Messung der Abstrahlung, die bei CO2 von mindestens 15km beginnt und bis ca. 120km Höhe reicht. Die Emissionstemperaturen sind dort teilweise deutlich HÖHER als auf der Erdoberfläche.

http://tinyurl.com/ctp8w8d

deshalb kühlt CO2,

anders ausgedrückt in der Realität gibt es keinen Treibhauseffekt von CO2.

mfG

@ #147: Dr. Kuhnle sagt am Montag, 29.04.2013, 19:19

„Die These der CO2-Erwärmung funktioniert natürlch nur, wenn die Emissionshöhe in der Troposphäre liegt.“

Wegen unterschiedlicher Absorptionslängen reicht der Höhenbereich aus dem emittierte Photonen das All erreichen und nicht absorbiert werden, verschieden tief. Aus welchen Höhenbereich emittiert wird, ist an der Intensität zu ersehen – weil die Intensität von der Temperatur abhängt und die Temperatur nach oben niedriger wird. Ein Beipsiel aus Ermeckes Klimarettern:

http://tinyurl.com/DErmeck

Die Intensitätsspitze bei 15 µm stammt allerdings nicht aus niedriger Höhe, sondern aus dem Ozonbereich, wo die Temperatur wieder ansteigt. Zur Spitze kommt es, weil bei 15 µm die Absorptionslänge so kurz ist, daß sie nur bis in den Ozonbereich reicht.

Obwohl daneben die Intensitätskurve fast einer Planckkurve folgt, folgt daraus nicht eine konstante Absorptionslänge (die steigt nämlich) sondern die nahezu konstante Temperatur der Stratosphäre.

MfG

Lieber Herr Ebel, #149

Ich hatte Sie gefragt, was Sie mit „zusammengefallener Luft“ meinen. Haben Sie diese nun in #149 beschrieben?

„Rechenweg:

…

Dieses Verfahren liefert eine Differentialgleichung ersten Grades, die nicht geschlossen lösbar ist. Eine numerische Lösung mit 1000 Streifen ist ausreichend genau.“

Ich bin mir nicht sicher, ob ich Sie verstanden habe. Sie nehmen Schichten einer bestimmten Druckänderung in der anfänglich isobaren, isothermen Atmosphäre und lassen diese im Gravitationsfeld fallen und bilden so einen Stapel mit einer neuen Druck- und Temperaturverteilung. Die Schichten fallen bis auf die vorherige Schicht. Dabei bleibt die Gesamtenergie innerhalb eines Streifens/Schicht konstant und wird nur umgewandelt? Richtig?

Können Sie mal die DGL angeben?

Kommt da nicht das gleiche raus, wie bei der Umwandlung unter Enthalpiekonstanz von der gesamten Schicht von 3100 m Dicke von einer isothermen & isobaren Schichtung in eine adiabatische?

@#146

Sehr geehrter Herr Baecker,

Den Herren Paul, Wehlan und Keks kann ich keinen Vorwurf machen. Mir gegenüber waren sie bisher in der Regel fair. Sie waren dagen manchmal grenzwertig. Unfreundlichkeiten können sich gegenseitig aufschaukeln. Wir sollten da aufpassen, dass die Diskussion sachlich bleibt. Jeder hat das Recht auf seine eigenen Ansichten. Jeder bringt seine eigenen spezifischen Kentnisse hier mit ein, möchte aufklären oder Kritik üben.

Meine Fragen sollten dazu dienen, die elementaren physikalischen Vorstellungen der Diskussionspartner (von beiden Lagern) kennenzulernen. Für mich ergeben sich dadurch neue Blickwinkel was die eigene Gedankenwelt bereichert. Meine Bedenken bezüglich der Berechenbarkeit der Klimazukunft zu eliminieren war nicht das Ziel. Vermutlich ist dies überhaupt nicht möglich. Schließlich sind es ja auch nur Bedenken. Grundsätzlich habe ich nichts gegen die IPCC-Modelle. Möglicherweise treten die Vorhersagen sogar ein, ich schätze aber eher nicht.

Bei der Aussage die Vorhersagen würden wahrscheinlich entreten sträuben sich mir die Haare. Bei Modellen, die in ihrer Gesamtheit nicht eindeutig (durch Nachweis) verifiziert sind, ist eine solche Aussage nicht möglich. Statistische Fehlerrechningen sind ungeeignet, weil systematische Fehler nicht ausgeschlossen werden können. Systematische Fehler können ganz unterschiedlicher Art sein. Letzlich muss bewiesen werden, dass die Modelle nicht nur die Vergangenheit, sondern auch die Zukunft nicht nur in Details, sondern auch insgesamt mit hoher Zuverlässigkeit abbilden können.

Ihre Frage zu den Temperatursprüngen gehört hier nicht zum CO2-Thema und ich würde lieber an anderer Stelle darüber diskutieren. Wichtig ist die Erkenntnis dass der Mittelwert von Temperaturen physikalisch etwas anderes ist als eine Temperatur. Die Einheit ist zwar gleich, aber es ist etwas völlig anderes. Mit der Sprungkurve kann man den Temperaturtrend sehr gut beschreiben. Es gab aber keinen Temperatursprung. Temperaturen ändern sich stetig und müssen orts- und zeitbezogen bestimmt werden. Temperaturen sind messbar, Mittelwerte nicht.

Mit Konfidenzintervallen kann man Hypothesen und Stichprobenergebnisse miteinander vergleichen. Im Ergebnis erhält man eine Aussage, mit welcher Wahrschenlichkeit die Hypothese falsch ist. Dass die Hypothese richtig ist, kann man damit nicht beweisen. Der in Deutschland seit 25,5 Jahren Temperatur-Nulltrend, liegt noch im +/- 2 Sigma Signifikanzbereich gewisser Temperaturanstiegshypothesen. Man könnte damit behaupten, es sei Zufall. Skepsis ist jedoch auch dann angebracht, wenn die Wahrscheinlichkeit, dass die Hypothese falsch ist, nur 85% anstatt 95% ist. Global sieht es anders aus. Hier stagniert der Temperaturtrend zwar erst seit etwa 16 Jahren, aber das 2-Sigma Konfidenzintervall der IPCC-Hypothese wurde bereits verlassen. Dies liegt an der geringen Streuung der globalen Mittelwerte.

Mit freundlichen Grüßen

Dr. Kuhnle

@ #132: Ebel sagt am Sonntag, 28.04.2013, 12:13

„Die zusammengefallene Luft wird aber keinen adiabatischen Verlauf haben.“

Die Berechnung ergibt nichts anderes.

Rechenweg:

Die ursprüngliche Verteilung mit 0,78 bar und -18°C wird in schmale Streifen zerlegt.

Die Dicke jedes Streifens ändert sich, seine Masse bleibt erhalten. Jeeder geänderte Streifen wird auf die vorhergehenden Streifen aufgelegt.

Die Dicke jedes Streifens wird beim Herabfallen auf die neue Höhe dicker, weil er wärmer wird durch Umwandlung der potentillen Energie in Wärme. Die Dicke ändert sich weiterhin adiabatisch durch Druckänderung.

Zunächst wird ein beliebiger Druck unmittelbar am Kern vorgegeben. Mit zunehmenden Abstand vom Kern sinkt der Druck, weil die Auflast durch die immer weniger verbleibenden ursprünglichen Streifen immer weniger wird.

Der letzte Streifen muß an der Hülle bleiben. Der Druck am Kern wird so lange variiert, bis der letzte Streifen tatsächlich an der Hülle bleibt.

Dieses Verfahren liefert eine Differentialgleichung ersten Grades, die nicht geschlossen lösbar ist. Eine numerische Lösung mit 1000 Streifen ist ausreichend genau.

Der Druck am Kern ist 0,969 bar

Der Druck an der Hülle ist 0,619 bar

Der Temperatur am Kern ist -6,84°C

Der Temperatur an der Hülle ist -29,6°C

und die Temperatur liegt immer über der linearen Temperaturveränderung (Adiabate) – allerdings ist die Abweichung vom linearen Verlauf gering (0,96 K).

MfG

@#146: NicoBaecker sagt:

„Ihr Beitrag #141 klingt ehrlich und aufrichtig. So stelle ich mir eigentlich sachgerechte Diskussion vor. Leider kommt das zu selten zustande.“….

Ich bin klein, mein Herz ist rein,

das sagt euch euer liebes Baeckerlein

Mensch Baecker, ich habe ja richtig Mitleid mit Ihnen…

@#145

Sehr geehrter Herr Dr. Paul,

Soweit ich das „Treibhaus-Modell“ verstanden habe, können CO2-Moleküle IR-Strahlen absorbieren und emittieren. Durch vermehrtes CO2 wird natürlich nicht weniger, sonder mehr IR-Strahlung Richtung All emittiert. Allerdings kann die Strahlung in höheren Schichten auch wieder absorbiert werden. Nur die Strahlung erreicht das All, die unterwegs nicht mehr absorbiert wird. Die Emissionshöhe liegt damit dort, wo umgekehrt IR-Strahlung von der Sonne (Richtung Erde) von der Atmosphäre zum erseten Mal absorbiert wird. Die Emissionshöhe hängt sicherlich entscheidend von der Wellenlänge ab. Die Abstrahlingsfläche ist immer die komplette Erdoberfläche.

Die These der CO2-Erwärmung funktioniert natürlch nur, wenn die Emissionshöhe in der Troposphäre liegt. Vermutlich werden die Vorgänge in der Stratosphäre mit der Pierrehumberts-Software mit berücksichtigt (ich kann es nicht sagen). Wie erwähnt bin ich kein Atmosphärenphysiker und ich muss mich hier mit Bewertungen zurückhalten. Im Laufe der Zeit werde ich mich wohl tiefer einarbeiten.

Wenn Sie die „Treibhauskünstler“ kritisieren wollen, haben Sie 2 Möglichkeiten:

1) Sie arbeiten sich tief inderen Materie ein und decken Unzulänglichkeiten auf. Dazu müssen Sie aber genau wissen was die Software macht.

2) Sie haben ein anderes Modell und verteidigen dieses. Das Modell muss dann auch Gleichgewichtszustände erklären können.

Meine Kritik ist mehr allgemeiner Art und basiert auf Erfahrungen in meinem Fachbereich mit Modell-basierten Simulationen komplexer Vorgänge. Diese Erfahrungen sind zwar fachspezifisch, lassen sich aber ohne weiteres auf jedes andere Gebiet übertragen. Fest steht, dass die außergewöhnliche Erwärmung bisher nur in Computern stattgefunden hat. In der realen Welt bewegen sich die jüngsten Klima-Veränderungen im Rahmen der natürlichen Schwankungen. Der AGW Hypothese fehlt daher die experimentelle Bestätigung.

Mit freundlichen Grüßen

Dr. Kuhnle

Lieber Herr Kuhnle, #141

Ihr Beitrag #141 klingt ehrlich und aufrichtig. So stelle ich mir eigentlich sachgerechte Diskussion vor. Leider kommt das zu selten zustande. Für mich nervig ist es nur, wenn ich den Eindruck bekomme, Leute würden mit mir eine pseudowissenschaftliche Diskussion führen wollen und Interesse an der Wissenschaft nur heucheln. Wie Sie an den Beispielen Paul, Wehlan, keks besonders gut sehen können. Das kann man sich sparen.

Ihre letzten Fragen fand ich „gehaltvoll“ aber doch recht „elementar“. Ich bin mir nicht sicher, ob Sie nun mit der Diskussion vorher und des Thieme-Modells im Speziellen nun wirklich weiter gekommen sind im Hinblick auf Ihre eingangs geäußerten Bedenken der „Berechenbarkeit der Klimazukunft“.

Aber Sie bringen im letzten Kommentar einen interessanten Punkt auf, der nicht trivial ist und der eine Diskussion lohnt:

„Eines meiner beruflichen Fachgebiete sind Berechnungen von Aussagewahrscheinlichkeiten. Wenn die IPCC-Modelle Parameter verwenden, und für diese Unsicherheiten schätzen, dann kommt im Ergebnis z.B. raus, dass die CO2-Klimasenitivität 3 +/- 0,75 Grad sei. Daraus wird eine Aussagesicherheit von 95% für 3 +/-1,5 Grad abgeleitet. Dies ist falsch.“

Können Sie mal genauer ausführen, wie Sie darauf kommen und woher Sie die Angaben nehmen? Die Angabe „95% für 3 +/-1,5 Grad“ entstammt ja der Zusammenfassung der Ergebnisse mehrerer Modelle. Dies ist statistisch natürlich nicht gleichwertig mit einer Stichprobe aus einer Grundgesamtheit. Spielen Sie mit Ihrer Kritik darauf an?

Dann hatte ich Sie auch schon mehrere Male ergebnislos nach den Konfidenzgrenzen Ihrer „Sprung-Untersuchung“ in den Temperaturzeitreihen gefragt. Wenn Sie nun beruflich bedingt da Expertise haben, warum antworten Sie mir darauf nicht?

#129:Hallo Herr Dr. Kuhnle, Sie benutzen hier eine völlig physikwidrige Argumentation von Treibhauskünstlern.

Es gibt physikalisch keine Möglichkeit durch vermehrte Absorbtion die Emission zu reduzieren, sondern nur das Gegenteil!

Können Sie mir einen plausiblen physikalischen Grund nennen, warum CO2 bei KÜRZERER Absorptionslänge erst SPÄTER mit der Emission beginnen sollte???

NEIN

Die Emission durch CO2 = cooling-rate fängt sowieso erst so richtig in der Stratosphäre an, die oberhalb der troposphärischen Konvektionszirkulation liegt und hat einen ersten Gipfel in ca. 50km Höhe, der verursacht wird durch die Ozonaufheizung, also einer Temperaturerhöhung! CO2 ist hier der stärkste Kühler!

Die Kühlleistung von CO2 ist also NICHT begrenzt durch das, was die Erdoberfläche bei 15µm emittiert.

Man kann auch formulieren:

CO2 vergrößert die Abstrahlungsfläche für die aufgenommene solare Energie,

was physikalisch zu einer Temperaturerniedrigung führen muss.

Mehr CO2 kühlt also das Erd-Atmosphärensystem,

so schwer ist das doch nicht!

mfG

#142: Ebel was soll der Unsinn,

kennen Sie keine Kühlung durch Emission??? „weiß eigentlich schon jedes Kind.“

Sie blamieren sich also selbst!

Durch CO2-Anstieg steigt die Emission und damit auch die Kühlwirkung, siehe mein IPCC-Zitat! So funktioniert Physik.

Ihre Ebelschen Spielereien mit dem „abnehmenden Wärmerstrom durch vermehrte Absorbtion“ sind lächerlich!

In der entscheidenden Energiebilanz ist die Wärmezunahme durch Absorbtion bei CO2-Anstieg GERINGER, als die die Zunahme der Kühlung durch Emission.

Es gibt also KEINEN CO2-Treibhauseffekt, weder einen „natürlichen“ noch einen „künstlichen“ (menschengemacht).

Merken Sie sich das endlich!

und in #143 drücken Sie sich wiedermal wortreich vor einer Antwort.

mfG

#139: Dr.Paul sagt am Sonntag, 28.04.2013, 19:26

„Sie wollten uns doch Ihre Version verraten, war die nun mit oder ohne Gegenstrahlung?“

Betrachtung mit und ohne Gegenstrahlung sind zwei Seiten der gleichen Medaille. Im Rahmen der Quantenphysik ist die Wärmestrahlung nach oben die Differenz der entgegengesetzten Photonenströme etwas unterschiedlicher Stärke. Wenn man allein dem nach unten gerichteten Photonenstrom einen Wärmestrom zuordenet hat man die Gegenstrahlung. Im Rahmen der Thermodynamik ist die Gegenstrahlung eine reine Rechengröße ohne physikalische Bedeutung.

Ob „mit oder ohne Gegenstrahlung“ ist eine reine Widerspiegelung des Wissensstandes. Wer von Quantenphysik keine Ahnung hat, aber trotzdem so tut, vermischt zwei Betrachtungsweisen – ohne überhaupt eine davon verstanden zu haben.

MfG

Paul will sich mal wieder blamieren:

#127: Dr.Paul sagt am Sonntag, 28.04.2013, 09:52

„ist die Zunahme der CO2-Emission in der Höhe signifikant. Das bedeutet Kühlung,“

So ein Unsinn. Kühler bedeutet weniger Emission, da die emittierte Intensität eine Funktion der Temperatur ist – weiß eigentlich schon jedes Kind.

Grund dafür: Bei größerer CO2-Konzentration steigt der Transportwiderstand für die Wärmestrahlung, wodurch die transportierte Strahlungsintensität abnimmt. Die Temperatur am Abstrahlort nimmt so lange ab, bis die abgestrahlte Intensität gleich dem nachgelieferten Wärmestrom ist. Da in den absorbierenden Wellenlängenbereichen wegen des höheren Transportwiderstandes weniger abgestrahlt wird, erhöht sich wegen des Ungleichgewichts absorbierte Solarstrahlung und Wärmeabfuhr die Oberflächentemperatur so lange, bis es wegen des daraus folgenden höheren Wärmestroms in den nichtabsorbierenden Wellenlängenbereichen wieder zur Bilanz kommt.

Der erhöhte Transportwiderstand folgt aus der ansteigenden Zahl der Emissions-Absorptions-Vorgänge bei steigender Dichte der Treibhausgasmoleküle.

Richtig verstehen kann man das quantenphysikalisch, weil ein angeregtes Molekül gleich wahrscheinlich in alle Richtungen emittiert – sowohl nach oben als auch nach unten. Die Dichte der angeregten Moleküle steigt mit zunehmender Temperatur und damit auch die Stärke des Photonenstroms. Verringerung des Wärmestroms und stärkerer Photonenstrom scheinen ein Widerspruch zu sein – sind es aber nicht. Weil die Photonenströme nach allen Richtungen gleich sind, folgt der Wärmestrom aus der Differenz der Photonenströme. Ist das Gas isotherm sind alle Photonenströme gleich und kompensieren sich zum Wärmestrom Null.

Ist ein Temperaturgradient vorhanden, so sind die emittierten Photonenströme unterschiedlich und kompensieren sich nicht mehr, so daß ein Wärmestrom entsteht. Die Länge über der die Differenz der Photonenströme entsteht ist nahezu die Absorptionslänge, denn nach der Absorptionslänge sind sowieso von den neu emittierten Photonen fast alle wieder absorbiert. Deswegen ist der Wärmestrom etwa die Differenz der Photonenströme über der Absorptionslänge. Ist über der Absorptionslänge die Temperaturdifferenz gering, so sind die entgegengesetzten Photonenströme fast gleich und demzufolge ist der Wärmestrom (als Differenz der entgegengesetzten Photonenströme) gering.

Besonders deutlich ist das in der Troposphäre, wo der Temperaturgradient näherungsweise konstant ist. Die Temperdifferenz über der Absorptionslänge ist dann Temperaturgradient mal Absorptionslänge – kleinere Absorptionslänge bedeutet kleinere Temperaturdiffernz -> fast gleiche entgegengesetzte Photonenströme -> geringer Wärmetransport.

Da bei konstnten Anteil die Dichte der Treibhausmoleküle mit der Gasdichte sinkt, steigt die Absorptionslänge mit der Höhe -> sinkt der der Transportwiderstand mit der Höhe.

Durchschnittlich werden in der Höhe werden ca. 150 W/m² abgestrahlt. Wegen des hohen strahlenden Transportwiderstandes am Boden ist demzufolge der strahlende Wärmestrom niedrig (ca. 60 W/m²) und der konvektiv transportierte Wärmestrom hoch. Bis zur Tropopause hat sich der strahlende Transportwiderstand so weit erniedrigt, daß der strahlende Wärmestrom so stark angestiegen ist, daß der konvektive Anteil zu Null geworden ist.

MfG

@#138

Sehr geehrter Herr Baecker,

Das Thieme-Modell wurde hier nicht von mir in die Diskussion gebracht. Ich fand es nicht unbedingt überzeugend, aber schön anschaulich und daher lohnend darüber zu diskutieren. Darüber hinaus habe ich mir einige zusätzliche „dumme“ Fragen ausgedacht. Wenn es Sie genervt hat, dann frage ich mich warum Sie überhaupt mitdiskutiert haben. Herrn Heß hat es Spaß gemacht. Mir hat es viel gebracht, auch wenn Sie den Eindruck haben dem sei nicht so und ich würde stehen bleiben.

An meinem Glauben werde ich in jedem Fall festhalten. Dies hat aber mit Religion und nicht mit Wissenschaft zu tun. In wissenschaftlichen Dingen pflege ich skeptisch zu sein, insbesondere gegenüber den eigenen Ansichten. Fremde Ansichten kann ich nur dann komplett übernehmen, wenn ich sie vollständig nachvollziehen kann. Mißtrauisch werde ich nur dann, wenn Andersdenkende bekäpft werden oder wenn offensichticher Unsinn erzählt wird. Herr Heß hat auf mich des öfteren einen kompetenten Eindruck gemacht, so dass er für mich vertrauenswürdig ist. Ähliches gilt für Prof. Singer, Prof. Harde und andere. Alle diese Herren sagen, CO2 trägt zur Erwärmung bei. Vermutlich ist es so. Ich kann aber nicht behaupten, dies sei sicher. Dies sollen die Fachleute tun.

Spätestens bei der Frage wieviel CO2 zur Erwärmung beiträgt stelle ich fest, dass es auch unter den Fachleuten unterschiedliche Ansichten gibt (auch wenn dies von Manchem bestritten wird). Eine Zielorientierte Herangehensweise ist prima, man darf aber nicht vergessen die Richtung immer mal wieder kritisch nachzuprüfen. Ab und zu querdenken schadet nicht. Wenn Sie glauben die Frage zweifelsfrei beantworten zu können dann ist dies eben Ihre Ansicht. Aus eigener Erfahrung mit komplexen Modellen und Supercomputern kann ich nur sagen, dass komplexe Modelle oft falsche Ergebnisse liefern. Letztlich zählt der Vergleich der Vorhersage mit den Fakten.

Eines meiner beruflichen Fachgebiete sind Berechnungen von Aussagewahrscheinlichkeiten. Wenn die IPCC-Modelle Parameter verwenden, und für diese Unsicherheiten schätzen, dann kommt im Ergebnis z.B. raus, dass die CO2-Klimasenitivität 3 +/- 0,75 Grad sei. Daraus wird eine Aussagesicherheit von 95% für 3 +/-1,5 Grad abgeleitet. Dies ist falsch.

#132: Ebel

„Die zusammengefallene Luft wird aber keinen adiabatischen Verlauf haben. Der richtige Verlauf ist nicht einfach zu bestimmen. Ich überlege noch, ob sich die Berechnung lohnt.“

ach nee, was denn sonst, statt adiabatisch?

Ich hatte Ihnen doch wiki empfohlen:

Ich darf nochmal zitieren

http://tinyurl.com/3dwx2d6

„Atmosphäre mit linearem Temperaturverlauf.

Der streng lineare Temperaturverlauf besteht nur in der idealisierten Vorstellung einer ruhenden Atmosphäre ohne Konvektion und Ausgleich aller thermodynamischen „Gefälle“. Dabei ist selbstverständlich der adiabatische Gradient selbst kein „Gefälle“, sondern ein Gleichgewicht, da Bewegungsenergie nur in potentielle Energie umgewandelt wird. Die potentielle Energie eines Teilchens im Gravitationsfeld ist E = m · g · h Da es jedoch in der Realität durch permanenten „Wärmetransport“ keinen konvektionslosen Zustand gibt, wird der lineare Verlauf immer leicht modifiziert durch Wärmetransport aller Art, der bekannteste ist die Kondensation von Wasserdampf, die zu einem geringeren Temperaturabfall führt („feucht-adiabatisch“, eine etwas irreführende Bezeichnung).“

zu#131 Nennen Sie bitte Argumente, die meine Angaben widerlegen,

KEINE NAMEN

mfG

#138: NicoBaecker in seinem Element, zwar ohne Fakten aber doch:

„Im Prinzip erwarte ich von jedem halbwegs gebildeten Bürger, daß er in der Lage ist, den eigenen Wissenstand mit dem verfügbaren Wissenstand zu vergleichen und daraus abzuleiten, wie weit er noch entfernt ist, sich eine Meinung zu bilden, die möglichst weit aus dem verfügbaren Wissenstand begründet wird.“

Da geben wir Ihnen recht,

der Wissenstand reicht um die Treibhaustheorie als Schwindel zu erkennen.

Sie wollten uns doch Ihre Version verraten,

war die nun mit oder ohne Gegenstrahlung?

mfG

Lieber Herr Kuhnle, #133

„Wenn Sie der Meinung sind, ich hätte noch nicht einmal die einfachsten Modelle begriffen, dann klingt dies so als sei ich völlig verblödet oder Sie haben die einfachsten Modelle nicht gut erklärt. Wollten Sie mich beleidigen oder Selbstkritik üben?“

Weder noch. Im Prinzip erwarte ich von jedem halbwegs gebildeten Bürger, daß er in der Lage ist, den eigenen Wissenstand mit dem verfügbaren Wissenstand zu vergleichen und daraus abzuleiten, wie weit er noch entfernt ist, sich eine Meinung zu bilden, die möglichst weit aus dem verfügbaren Wissenstand begründet wird.

Ihre Vorgehensweise beruht ja auf einem anderen Weg, nämlich dem Misstrauen als Ausgangszustand. D.h. hier wird eine ganz andere Metrik als Mass für Objektivität genommen als die Sachfrage es nahelegt. Nämlich sich zu fragen, ob einer wissenschaftliche Aussage Vertrauen geschenkt werden kann. Dies ist aber die falsche Herangehensweise, denn sie orientiert sich nicht an der Sachfrage, sondern an den Urhebern einer Antwort darauf.

Die einfachen Modelle heißen einfach, weil sie einfach sind. D.h. sie geben den Sachverhalt nur genähert wieder, haben also (evtl. gravierende) Mängel, aber dagegen den Vorteil, daß man sie durch Analogien zum Allgemeinwissen auch ohne Spezialausbildung verstehen kann.

Es macht aber wenig Sinn, ein a priori begrenzt aussagekräftiges Modell nun über seine Anwendbarkeit hinaus zu stressen. Einige gravierende Mängel des Thieme-Modells sind hier gezeigt worden. Wenn Sie das verstanden haben, so haben Sie ein Etappenziel erreicht. Der nächste Schritt ist nun, dass Sie sich um das Verständnis von aussagekräftigeren Modelle bemühen.

Ihre Aussagen über „Chaos und Komplexität“ heutiger Klimamodelle zeigen mir, daß da bei Ihnen Verunsicherung herrscht und nur vage Kenntnisse in den Details vorliegen. Bildung hilft da weiter.

„anders Denkende nicht diffamiert “

Diesen Eindruck möchte ich nicht vermitteln. Aber „Anderesdenken“ ist nunmal in nicht immer eine zielführende Methode. In der Wissenschaft bekommt man vor allem lang erprobte und verifizierte Lösungsmethoden vermittelt, dabei kann man auch über andere, alternative, neue Lösungsmethoden nachdenken. Das kann aber den Weg zur Lösung sehr verlängern, weil man dabei i.d.R. einen „trial & error“-Prozeß durchlaufen muß. Um sich bei heutigen wissenschaftlichen Fragen auf den Stand des Wissens zu bringen, ist es unpraktisch, den „andersdenk-Prozeß“ für jeden elementaren Schritt zu durchlaufen (und womöglich noch andere damit zu nerven, die die korrekte Lösung bereits kennen).

Wenn ich also etwas beleidigend wirke, so nur, weil ich davon aussgehe, daß jeder an einer zielorientierten Herangehensweise interessiert ist und um Tips für diesen Weg aufgeschlossen ist. Wenn Sie dageben jedes Blümchen am Wegrand aussondieren wollen, so können Sie das machen, aber dann müssen Sie eben auch in Kauf nehmen, sich lange Zeit keine sachgerechte, wissenschaftsorientierte Meinung bilden zu können, denn dafür muß man erst zum Ziel gekommen sein.

Sie scheinen im Moment auf dem Weg stehen zu bleiben und sich zu überlegen, doch am alten Stand basierend auf Misstrauen und Glauben festzuhalten und diesen mit dem Argument Zeitmangel zu rechtfertigen. Kann ich nicht nachvollziehen, nutzen Sie Ihre Zeit einfach effektiver und nehmen Sie die von der Zeit für die Suche nach statistisch nicht signifikanten Klimasprüngen 😉

Lieber Herr Kuhnle #125,

Danke. Ihre Fragen zu beantworten hat mir Spaß gemacht. Mein Fazit sieht aber etwas anders aus.

Ich habe ein Programmskript von R. Pierrehumbert verwendet, das auf die bekannte Physik der Atmosphäre inklusive den HITRAN-Messungen aufsetzt und geeignet ist Fragen wie ihre auf dem eigenen PC zu beantworten. Ich habe das Programm gegen Modtran geprüft und vergleichbare Ergebnisse erhalten. Modtran wiederum ist in der Lage die experimentell gemessenen thermischen Emissionsspektren der Erde zu simulieren, wie man auf der webseite von David Archer nachprüfen kann. Insofern hat das Programmskript von R. Pierrehumbert Anschluß an die Atmosphärenphysik und reale Messungen.

Mit diesem Skript war ich in der Lage ihre Fragen semiquantitativ und schlüssig zu beantworten. Das Skript findet sich auf der Webseite von R. Pierrehumbert und kann auch geprüft und kritisch nachvollzogen werden.

Mit dem Modell von Thieme ist es nicht gelungen ihre Fragen zu beantworten.

Dazu wurden von Herrn Bäcker und Herrn Ebel Fehler im Thieme-Modell aufgezeigt. Das Modell von Thieme hat auch keinen Anschluß zu experimentellen Ergebnissen, der Anschluß an die Atmosphärenphysik mit der Zwangsumwälzung ist bestenfalls unklar. Dazu enthält es wie ich oben gezeigt habe unbelegte Behauptungen.

Ich für meinen Teil muss deshalb das Modell von Thieme verwerfen, solange bis es nachgebessert ist und Fragen wie die ihren schlüssig beantwortet. Ich empfehle auch allen Lesern das Modell von Thieme skeptisch zu hinterfragen bzw. zu versuchen ihre Fragen mit dem Modell von Thieme zu beantworten.

Ob man es verwerfen will, muss jeder selbst entscheiden.

Mit freundlichen Grüßen

Günter Heß

P.S. Das Lehrbuch von M. Salby ist sehr gut, wenn es aber um die Physik der Atmosphäre geht, empfehle ich R. Pierrehumberts „Principles of Planetary Climate“. Das Buch ist mit einer exzellenten Webseite begleitet, einer Vorlesungsreihe und der zugehörigen Software begleitet.

@Dr.Kuhnle, #125: „Durch die Mittelwertbildung verringert sich zwar der Streuwert des Erwartungswertes, das chaotische Verhalten bleibt aber im Prinzip.“

Durch die starke Glättung nimmt das chaotische Verhalten des Zeitsignals erheblich ab.

„Ich bin mir sicher, dass die Supercomputer zur Wetter- und Klimasimulation nahezu alles berücksichtigen was irgendwie berechenbar ist. Ob die aus den Berechnungen erzielten Ergebnisse aber wirklich (wissenschaftlich und nicht nur für politische Zwecke) brauchbar sind, ist nicht garantiert.“

Sie sind nicht garantiert, aber aller Voraussicht nach recht wahrscheinlich.

@#127: Dr.Paul sagt:

„Das wissen sogar kluge Leute bei der IPCC:

http://tinyurl.com/cnj6bnh