Bild rechts: Monatliche globale mittlere Temperaturanomalien der unteren Troposphäre nach RSS (dunkelblau) und Trend (dicke hellblaue Linie). Von September 1996 bis Mai 2014 zeigt sich seit 17 Jahren und 9 Monaten kein Trend.

Die Stillstands-Periode von 17 Jahren und 9 Monaten ist der weiteste Schritt zurück, den man bei den RSS-Temperaturdaten gehen kann und immer noch einen Null-Trend findet. Aber die Länge des Stillstands der globalen Erwärmung, so signifikant sie inzwischen auch ist, ist von geringerer Bedeutung als die immer weiter zunehmende Diskrepanz zwischen den von den Modellen vorhergesagten Temperaturtrends und der beobachteten weniger begeisternden Temperaturänderung in der realen Welt.

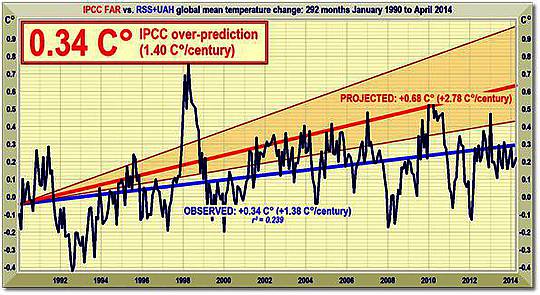

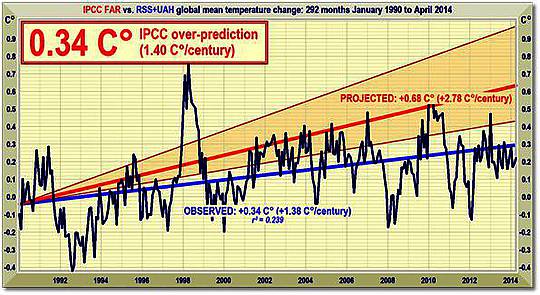

Im Ersten Zustandsbericht wurde noch vorhergesagt, dass die globale Temperatur um 1,0 (0,7; 1,5)°C bis zum Jahr 2025 steigen würde, das wäre äquivalent zu einer Rate von 2,8 (1,9; 4,2)°C pro Jahrhundert. In der Executive Summary wurde gefragt: „Wie viel Vertrauen haben wir in unsere Vorhersagen?” Das IPCC wies auf einige Unsicherheiten hin (Wolken, Ozeane usw.), kam aber zu der Schlussfolgerung:

„Nichtsdestotrotz … haben wir substantielles Vertrauen, dass unsere Modelle zumindest die Features der Klimaänderung im groben Rahmen vorhersagen können … Es gibt Ähnlichkeiten zwischen den Ergebnissen gekoppelter Modelle, die einfache Repräsentationen des Ozeans verwenden und jenen, die kompliziertere Beschreibungen verwenden, und unser Verständnis derartiger Unterschiede gibt uns einiges Vertrauen in die Ergebnisse“.

Jenes „substantielle Vertrauen” war substantielles Über-Vertrauen. Ein Vierteljahrhundert nach 1990 beträgt das Ergebnis bis heute 0,34°C – ausgedrückt als lineare Regression kleinster Quadrate des Mittels nach GISS, HadCRUT4 und NCDC der monatlichen globalen Temperaturanomalien. 0,34°C, das ist äquivalent zu einer Rate von 1,4°C pro Jahrhundert oder genau die Hälfte der zentralen Schätzung des IPCC (1990) und deutlich unter selbst der geringsten Schätzung (Abbildung 2).

Abbildung 2: Mittelfristige globale Temperatur-Projektionen des IPCC (1990) von Januar 1990 bis April 2014 (orangene Fläche und rote Trendlinie) im Vergleich zu beobachteten Anomalien (dunkelblau) und Trend (hellblau) als Mittel der monatlichen Temperaturanomalien nach RSS und UAH.

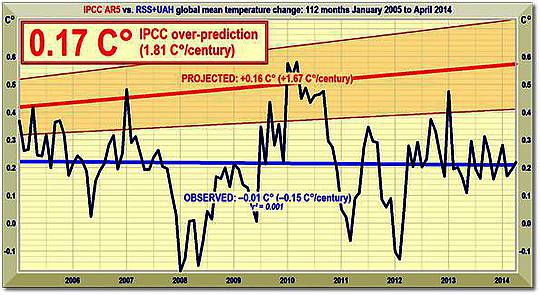

Abbildung 3: Vorhergesagte Temperaturänderung seit 2005 mit einer Rate äquivalent zu 1,7 (1,0; 2,3)°C pro Jahrhundert (orangene Fläche mit dicker roter Trendlinie des Best Estimate), verglichen mit den beobachteten Anomalien (dunkelblau) und Trend (hellblau).

Bemerkenswerterweise liegen auch die jüngsten und erheblich reduzierten kurzfristigen Projektionen der globalen Erwärmung immer noch exzessiv zu hoch (Abbildung 3).

Im Jahre 1990 lag die zentrale Schätzung der kurzfristigen Erwärmung um zwei Drittel höher als heute. Dann war es ein Äquivalent zu 2,8°C pro Jahrhundert. Inzwischen sind es lediglich 1,7°C – und, wie Abbildung 3 zeigt, ist selbst das noch eine substantielle Übertreibung.

Hinsichtlich der RSS-Satellitendaten gab es seit über 26 Jahren keine statistisch signifikante globale Erwärmung. Keines der Modelle hat das vorhergesagt – im Endeffekt ist es ein Vierteljahrhundert ohne jede globale Erwärmung.

Neue Versuche, die ernste und immer noch wachsende Diskrepanz zwischen Vorhersage und Realität hinweg zu erklären, gibt es inzwischen fast jeden Tag. Viel zu wenig Wissenschaftler hinter der Klima-Angst waren bisher gewillt, die offensichtlichste Erklärung anzubieten – dass nämlich die Modelle so programmiert worden sind, dass eine viel stärkere Erwärmung vorhersagen als wahrscheinlich eintritt.

Es kann gut sein, dass der lange Stillstand diesen Winter zu Ende geht. Ein El Niño-Ereignis hat eingesetzt. Die üblichen Verdächtigen haben gesagt, dass es Rekorde brechen wird, aber bislang gibt es viel zu wenig Informationen, um sagen zu können, zu wie viel vorübergehender Erwärmung es dadurch kommen wird. Die Temperaturspitzen der El Niño-Ereignisse von 1998, 2007 und 2010 kommen in den Abbildungen 1 bis 3 klar zum Ausdruck.

Zu einem El Niño kommt es alle drei oder vier Jahre, obwohl noch niemand genau sagen kann, was sie auslöst. Sie verursachen eine temporäre Temperaturspitze, oftmals gefolgt von einem starken Rückgang während der La Niña-Phase, wie man in den Jahren 1999, 2008 und 2011-2012 erkennen kann, als es einen „Doppel-Dip“ La Niña gab.

Das Verhältnis zwischen El Niños und La Niñas tendiert dazu, in die 30-jährige negative oder Abkühlungs-Phase der Pazifischen Dekadischen Oszillation zu fallen, deren jüngste Ende 2001 eingesetzt hat. Obwohl also der Stillstand zum Jahreswechsel einige Monate lang unterbrochen werden könnte, dürfte er Ende 2015 höchstwahrscheinlich wieder einsetzen.

Wie auch immer, es wird immer klarer, dass die globale Erwärmung nicht einmal annähernd mit der von den Klimamodellen vorhergesagten Rate stattgefunden hat, und es ist überhaupt nicht wahrscheinlich, dass sie selbst mit der jetzt vorhergesagten erheblich reduzierten Rate stattfinden wird. Es könnte in diesem Jahrhundert eine globale Erwärmung bis 1°C geben, aber nicht die vom IPVV vorhergesagten 3 bis 4°C.

Zentrale Fakten hinsichtlich der globalen Temperatur

Ø Der RSS-Satellitendatensatz zeigt keinerlei globale Erwärmung seit 213 Monaten, also von September 1996 bis Mai 2014. Das ist über die Hälfte der gesamten, 425 Monate langen Periode mit Satellitenaufzeichnungen.

Ø Die höchste auf ein Jahrhundert umgerechnete Erwärmungsrate war in Mittelengland von 1663 bis 1762 mit einer Rate von 0,9°C aufgetreten – vor der industriellen Revolution. Es kann also nicht unsere Schuld gewesen sein.

Ø Der globale Erwärmungstrend seit 1900 ist äquivalent zu 0,8°C pro Jahrhundert. Dies liegt deutlich innerhalb der natürlichen Variabilität und wird nicht viel mit uns zu tun haben.

Ø Der höchste Erwärmungstrend über zehn Jahre oder mehr ereignete sich in den 40 Jahren von 1694 bis 1733 in Mittelengland – mit einer Rate äquivalent zu 4,3°C pro Jahrhundert.

Ø Seit 1950, als ein menschlicher Einfluss auf die globale Temperatur zum ersten Mal theoretisch möglich war, lag der globale Erwärmungstrend äquivalent zu 1,2°C pro Jahrhundert.

Ø Die höchste Erwärmungsrate über zehn Jahre oder mehr seit 1950 ereignete sich während der 33 Jahre von 1974 bis 2006. Die Rate war äquivalent zu 2,0°C pro Jahrhundert.

Ø Im Jahre 1990 lautete die mittelfristige Schätzung des Erwärmungstrends äquivalent zu 2,8°C pro Jahrhundert, also um zwei Drittel über der heutigen IPCC-Vorhersage.

Ø Der globale Erwärmungstrend seit 1990, als das IPCC seinen ersten Bericht geschrieben hatte, ist äquivalent zu einer Rate von 1,4°C pro Jahrhundert – die Hälfte von dem, was das IPCC zu der Zeit vorhergesagt hatte.

Ø Im Jahre 2013 lautete die neue mittelfristige Vorhersage des IPCC auf eine Rate äquivalent zu 1,7°C pro Jahrhundert. Aber auch das ist noch übertrieben.

Ø Obwohl des IPCC seine kurzfristige Erwärmungs-Vorhersage zurückgefahren hat, ist dessen Vorhersage einer Erwärmung von 4,7°C bis zum Jahr 2100 weiterhin Business as Usual.

Ø Diese vom IPCC vorhergesagte Erwärmung von 4,7°C bis zum Jahr 2100 liegt mehr als doppelt so hoch wie der höchste beobachtete Erwärmungstrend in der realen Atmosphäre über zehn Jahre, der seit 1950 gemessen worden ist.

Ø Die IPCC-Vorhersage von 4,7°C bis zum Jahr 2100 liegt fast vier mal so hoch wie der beobachtete Erwärmungstrend in der realen Welt, seit wir theoretisch in der Lage gewesen sein könnten, die Temperatur zu beeinflussen (1950).

Ø Seit dem 1. Januar 2001, dem Beginn des neuen Jahrtausends, ist der Erwärmungstrend im Mittel von 5 Datensätzen Null. Keine Erwärmung seit 13 Jahren und vier Monaten.

Ø Jüngste Extremwetterereignisse können nicht mit der globalen Erwärmung in Verbindung gebracht werden, einfach weil es keine Erwärmung gegeben hat. So einfach ist das.

Technische Anmerkung

Die jüngste Graphik zum Thema zeigt der RSS-Datensatz während der 213 Monate seit September 1996 bis Mai 2014 – über die Hälfte der 425 Monate langen Überwachung per Satellit.

Terrestrische Temperaturen werden mit Thermometern gemessen. Thermometer, die korrekt aufgestellt sind in ländlichen Gebieten und weit weg von menschlichen Wärmequellen zeigen Erwärmungsraten deutlich unter denen, die veröffentlicht werden. Die Satellitendaten basieren auf Messungen durch die genauesten derzeit verfügbaren Thermometer – Platin-Widerstands-Thermometer, die nicht nur die Temperaturen in verschiedenen Höhen über der Erdoberfläche mittels Mikrowellen-Sounding messen, sondern sich auch ständig selbsttätig kalibrieren durch die Messung der bekannten Temperatur der kosmischen Hintergrundstrahlung via auf das Weltall ausgerichtete Spiegel. Sie macht 1% des Gefrierpunktes von Wasser aus bzw. liegt nur 2,73° über dem absoluten Nullpunkt. Es war die Messung dieser minimalen Variationen der kosmischen Hintergrundstrahlung, durch die die NASA das Alter des Universums bestimmt hat: 13,82 Milliarden Jahre.

Die Graphik ist akkurat. Die Daten stammen monatlich direkt von der RSS-Website. Ein Computer-Algorithmus liest sie aus dem File heraus, mittelt sie und plottet sie automatisch mittels einer ausgereiften Routine. …

Der jüngste monatliche Datenpunkt wird durch Augenschein inspiziert um sicherzustellen, dass er korrekt positioniert ist. Die hellblaue Trendlinie durch die dunkelblaue Kurve der einzelnen Datenpunkte zeigt, dass die aktuellen Daten bestimmt werden durch die Methode der linearen Regression kleinster Quadrate, die den Schnittpunkt mit der y-Achse berechnet sowie die Steigung der Linie mittels zwei etablierten und funktional identischen Gleichungen, die miteinander verglichen werden um sicherzustellen, dass es zwischen ihnen keine Diskrepanz gibt. Das IPCC und die meisten anderen Agenturen berechnen mittels linearer Regression globale Temperaturtrends. Prof. Phil Jones von der University of East Anglia verlangt dies in einer der Klimagate-E-Mails. Die Methode ist geeignet, weil die globalen Temperaturaufzeichnungen nur wenig Auto-Regression zeigen.

Dr. Stephen Farish, Professor für epidemiologische Statistik an der University of Melbourne hat freundlicherweise die Zuverlässigkeit des Algorithmus‘ verifiziert, der den Trend in der Graphik und den Korrelations-Koeffizienten bestimmt. Er ist sehr klein, weil trotz der hoch variablen Daten der Trend flach ist.

Link: http://wattsupwiththat.com/2014/06/04/the-pause-continues-still-no-global-warming-for-17-years-9-months/

Übersetzt von Chris Frey EIKE

Der Stillstand geht weiter: Immer noch keine globale Erwärmung, nunmehr seit 17 Jahren und 9 Monaten

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Ich habe mich gefragt, welcher Datensätze denn am eher die Realität abbildet. Christopher Monckton of Brenchley bezieht sich auf RSS. Ähnlich in Methode und Ergebnis ist UAH, obwohl hier ein anderer Satelit verwendet wird. Sehr populär sind auch HADCRUT3 und HADCRUT4. Wohl am tendenziellsten, auch im Umgang mit Korrekturverfahren ist wohl GISS.

Wie aber sehen Sie die Bedeutung der unterschiedlichen Datensätze? Sie liefern teilwese stark divergente Ergebnisse.

Beispiele: http://tinyurl.com/GISSadju

http://tinyurl.com/uahrssgiss

Nun wäre es unredlich, sich eben nach interesse zu bedienen. Was also bildet die Realität am Besten ab? Es muss ja nicht das sein, was man am ehesten mag.

#10: Dr.Paul sagt: „Deshalb ist es mehr als legitim, wie Monckton auf den fehlenden Temperaturanstieg seit deutlich über 10 Jahren trotz CO2-Anstieg hinzuweisen, der der CO2-Treibhaustheorie eklatant widerspricht.“

============================================

Zeit darüber nachzudenken, warum ein Angehöriger der „Treibhauseffekt“-Fraktion diese These immer wieder bringt. Versuchen Sie mal eine rationale Erklärung dafür zu finden.

Laut Morgenmagazin NATÜRLICH wieder der Klimawandel Ursache für die Unwetter in NRW. Und der Herr Wetterfroch (Donald XY) hat ja so viele Extreme in den letzten Jahren beobachtet, auch extrem-Schnee, der ja eigentlich gar nicht mehr hätte kommen dürfen. Für ihn steht es fest…..

Nur 17 Jahre Pause erzeugen bei ihm auch keinen leichten Widerspruch. Sind solche Leute so eingeschworen oder wie?

@ #6 G. Kramm

„dass die Modelle trotz Adjustierung Ergebnisse liefern,“

Der Vergleich der GFL-Modellergebnisse mit der gemessenen Realität ist in der Tat ernüchternd.

Man achaue also auf den Gitterpunkt 41,5 °N und 93,75 °W. Da ergibt sich dann:

TMAX TMIN TMITT

Modell 13,89 6,07 9,98 [°C]

Gemessen 15,82 3,82 9,82 [°C]

Soll hier ja Foristen geben, die immerzu behaupten, daß die Modelle die Physik hinreichend beinhalten. Im Mittel stimmts, denn eine Abweichung über 75 Jahre von nur 0,16 K ist in der Tat wenig, nur die 2,25 K bei der Minimumtemperatur und die 1,93 K sind zu viel.

Nun dürfte auch klar sein, warum man sich auf die globale Mitteltemperatur fixiert hat.

#1: Michael Leiser

BMW plant Erweiterungsinvestitionen in Höhe von circa 1 Milliarde US-Dollar in Spartanburg, South Carolina, was womöglich die grösste Produktionsstätte von BMW bedeuten würde, konzernweit und ausser Landes. Zwischen 2008 und 2012 sollen deutsche Unternehmen 800 Milliarden US-Dollar in den USA investiert haben. Die Deutsche Industrie- und Handelskammer erwartet für 2014 Investitionen um die 200 Milliarden US-Dollar, demnach auch und nur für die USA.

Quelle(n): Über Dritte (Sekundärliteratur), mit indirektem Bezug auf die Deutsche Bundesbank und DIHK.

Der Stillstand geht weiter, in vielerlei Hinsicht. Verlierer ist Deutschland. Eindeutig. Und der Nachbar freut sich, über Investitionen. Hoffentlich bringen diese auch (einen positiven) Gewinn für besagte Unternehmen. Der grüne Virus arbeitet zuverlässig am Körper des geistig verwirrten und schwer kranken Patienten. Das Klima ist und kann nur ein Ablenkungsmanöver sein.

MfG

P.S.: 126.000 EUR. Und die Folgekosten kommen hinzu. Einige böse Überraschungen lauern. Teure Eitelkeit des Kunden. Lohnt sich das für BMW? Imagepolierung oder Rentabilität? So ein Wagen müsste für chinesische Piraten leicht zu kopieren sein? Ich frage.

Die Berechnung mit dem Trendkalkulator von University York zeigt einen globalen „Null“ Trend seit 18 Jahren in dem Zeitfenster von Juni 1996 bis Mai 2014.

Trendberechnung auf der Seite University York :

Startdatum: 1996.6

Enddatum: 2014.5

Zeitfenster: 18 Jahre

RSS – Daten

Ergebnis:

Globaler Trend: -0,00 C/ century(Jahrhundert), Stand: 09.06.2014

Siehe Link:

http://tinyurl.com/ox8ejvs

Vergleichsberechnung auf der Seite WoodForTress.org:

Startdatum: 1996.6

Enddatum: 2014.5

Zeitfenster: 18 Jahre

RSS -Daten

Ergebnis: globale waagerechte Trendgerade ( globaler „Null“ Trend seit 18 Jahren)

Stand: 09.06.2014

Siehe Link:

http://tinyurl.com/nflsghq

Die Wertung der Ergebnisse überlasse ich den Lesern.

#5: Greg House um eine gegenseitige Beziehung (Abhängigkeit, Korrelation) feststellen zu können, ist es selbstverständlich nicht zulässig, sich eine beliebe Zeit dazu herauszupicken.

Natürlich kann man etwas messen, sowohl Temperatur, als auch CO2,

wie genau und wie „representativ“ steht auf einem anderen Blatt.

Stellt man sich auf Ihren Standpunkt der Nicht-Messbarkeit, könnte man überhaupt keine Aussage treffen!

Das ist mir ehrlich gesagt zu wenig!

http://tinyurl.com/oybzywl

hier haben wir z.B. die Widerlegung einer gegenseitigen Abhängigkeit in sehr groben langfristigen Zeiträumen.

und hier:

http://tinyurl.com/c9g4txy

entnommen von meinem Freund Humlum:

http://tinyurl.com/d665jcu

ganz kurzfristige Korrelationen,

die zeigen, dass CO2 in der Luft der Temperatur mit Zeitverzögerung folgt,

was schlicht der temperaturabhängigen Löslichkeit in Wasser entspricht,

Henry´sches Gesetz

http://de.wikipedia.org/wiki/Henry-Gesetz.

Deshalb ist es mehr als legitim, wie Monckton auf den fehlenden Temperaturanstieg seit deutlich über 10 Jahren trotz CO2-Anstieg hinzuweisen,

der der CO2-Treibhaustheorie eklatant widerspricht.

mfG

1.Einen statistisch signifikantes Temperaturanstieg seit 1850 bekommt man nur, wenn man das autoregressive Modell zugrundelegt. Dieses ist aber wie der Statistiker D. McNeall vom Met Office ausgeführt hat “ simply inadequate“ (siehe dazu auch den entsprechenden Artikel hier auf EIKE).

2. Auch der vom IPCC behaupteten und hier auch angegebenen linearen Anstieg der Temperatur seit 1950 ist nicht richtig. Schaut man sich die Daten seit 1950 an, dann stellt man fest, daß der Anstieg von 1950 bis 1976 praktisch null ist.

1976 steigt die Temperatur durch Pacific Dekadel shift, ist dann bis 1986 konstant. 1986 -1988 kommt es durch den EL Nino zu einem weitern Temperaturanstieg. Die Nächste Temperaturzunahme wird durch den El Nino von 1997/98 verursacht. Danach wieder keine weitere Zunahme der Temperatur. Dieser Temperaturverlauf wird von K. Trenberth in mehreren Interviews vertreten. In seinen Veröffentlichungen von 2001 und 2011 hat K. Trenberth gezeigt, daß El Nino-Ergeignisse nicht durch den „Treibhauseffekt“ verursacht werden. Ich habe hier Herrn Trenberth angeführt, weil er ein führender AGW-Vertreter ist. Es zeigt sich also, daß der Temperaturanstieg seit 1950 anders als vom IPCC behauptet auch ohne die sogenannten Treibhausgase verursacht sein kann und wahrscheinlich auch ist.

MfG

#6: gkramm bravo!

@#2 Greg House

Ja, die Warmisten sprechen von längeren Zeitperioden. Leider übersehen die Warmisten auch die Tatsache das ihr Argument mit dem CO2 verbunden ist.

Laut Mauna Loa CO2 „annual mean growth rates“ ist in den Jahren 1997-2013 der CO2 Anteil um 34.33ppm angestiegen.

In den Jahren 1973-1996 ist der Anteil um 34.41ppm angestiegen. In beiden Zeitperioden ist der CO2 Anstieg quasi gleich.

Der Unterschied ist in den Jahren.

1997-2013 = 17 Jahre

1973-1996 = 24 Jahre

Damit kann man sagen das die 17+ Jahre, wenn man den CO2 Anstieg nimmt, eigentlich 24+ Jahre sind.

Nach der Auffassung der Warmisten ist die Ursache das CO2 und damit sollte man die Ursache mit einbeziehen.

mfg

Zur Kenntnis:

Ein Kollege von mir, Prof. Dr. Wendler, hat mit Mitarbeitern den Trend fuer Alaska analysiert (siehe Wendler et al., 2012, The first decade of the new century: A cooling trend for most of Alaska, http://www.benthamscience.com/open/toascj/articles/V006/111TOASCJ.pdf). Im Abstract heisst es:

„Abstract: During the first decade of the 21st century most of Alaska experienced a cooling shift, modifying the long-term warming trend, which has been about twice the global change up to this time. All of Alaska cooled with the exception of Northern Regions. This trend was caused by a change in sign of the Pacific Decadal Oscillation (PDO), which became

dominantly negative, weakening the Aleutian Low. This weakening results in less relatively warm air being advected from the Northern Pacific. This transport is especially important in winter when the solar radiation is weak. It is during this period that the strongest cooling was observed. In addition, the cooling was especially pronounced in Western Alaska,

closest to the area of the center of the Aleutian Low. The changes seen in the reanalyzed data were confirmed from surface observations, both in the decrease of the North-South atmospheric pressure gradient, as well as the decrease in the mean wind speeds for stations located in the Bering Sea area.“

Zur Qualitaet von Modellen:

Der Abstract von Mauritsen et al. (2012), „Tunig the climate of a global model“ lautet:

„During a development stage global climate models have their properties adjusted or tuned in various ways to best match the known state of the Earth’s climate system. These desired properties are observables, such as the radiation balance at the top of the atmosphere, the global mean temperature, sea ice, clouds and wind fields. The tuning is typically performed by adjusting uncertain, or even non-observable, parameters related to processes not explicitly represented at the model grid resolution. The practice of climate model tuning has seen an increasing level of attention because key model properties, such as climate sensitivity, have been shown to depend on frequently used tuning parameters. Here we provide insights into how climate model

tuning is practically done in the case of closing the radiation balance and adjusting the

global mean temperature for the Max Planck Institute Earth System Model (MPIESM). We demonstrate that considerable ambiguity exists in the choice of parameters, and present and compare three alternatively tuned, yet plausible configurations of the climate model. The impacts of parameter tuning on climate sensitivity was less than anticipated.“

Man kann also davon ausgehen, dass trotz des Adjustierens des globalen Modells an Groessen wie der globalen Mitteltemperatur der seit etwa 17 Jahren anhaltende Zustand nicht getroffen wurde.

Wer braucht also Klimaprojektionen fuer das Ende des Jahrhunderts, von denen wir bereits heute wissen, dass die Modelle trotz Adjustierung Ergebnisse liefern, die nicht der Realitaet entsprechen? Niemand. Klimaprojektionen sind so ueberfluessig wie ein Kropf.

#3: Frank Abels sagt: „Die Argumentation Moncktons greift keineswegs ins Leere, denn den „Warmisten“ reichte seinerzeit eine Wärmephase von knapp zehn Jahren um mit ihren apokalyptischen Horrorthesen von einer gefährlichen Klimaerwärmung die Öffentlichkeit zu erschrecken.“

=================================================

Nach meinen Informationen betrifft die Kernaussage die Zeitperiode von 100-150 Jahren, seit Beginn der Industriellen Revolution. Und zwar, den langfristigen Trend, mit kurzfristigen „Erwärmungen“ und „Abkühlungen“ drin. Deshalb greift diese These von Lord Monckton ins Leere. Schlimmer noch, so wird auch der „Globaltemperatur“-Quatsch quasi legitimiert.

Da aber James Hansen im Jahr 1987 ein globale Mitteltemperatur von 15,4°C/15,5°C ausgewiesen hatte:

http://tinyurl.com/lppnyor

…die Bundestagsdrucksache 11/8030 auf Seite 29 für 1990 eine „weltweit gemittelte Temperatur in Bodennähe“ ebenfalls 15,5°C ausweist:

http://tinyurl.com/mswmbm9

…aktuell aber 14,5°C als weltweit gemitteltee Bodentemperaturausgewiesen wird, z.B. Latif im Jahr 2012:

http://tinyurl.com/n4v7575

gibt es sogar seit 1987 bzw. seit Gründung des IPCC im Jahr 1988 – also seit über 25 Jahren – nachweislich KEINE (gefährliche) globale Erwärmung, sondern eine globale Abkühlung von mindestens 1°C.

Wäre nett, wenn das auch mal Lord Monckton begreifen und thematisieren würde…

#2 Greg House

Die Argumentation Moncktons greift keineswegs ins Leere, denn den „Warmisten“ reichte seinerzeit eine Wärmephase von knapp zehn Jahren um mit ihren apokalyptischen Horrorthesen von einer gefährlichen Klimaerwärmung die Öffentlichkeit zu erschrecken. Heute nach den

siebzehn Jahren ohne Anstieg der Globaltemperatur (trotz gestiegener CO2 Werte) fordern die gleichen Leute natürlich schamlos eine längere Bewertungsphase.

Ob die Globaltemperatur wissenschaftlich akzeptabel ist oder nicht- darüber lässt sich trefflich streiten. Fakt ist, dass selbst das IPCC den Terminus „Globaltemperatur“ verwendet.

Christopher Monckton of Brenchley: „Der Stillstand geht weiter: Immer noch keine globale Erwärmung, nunmehr seit 17 Jahren und 9 Monaten“

======================================

Herr Monckton weiß mit Sicherheit, dass Warmisten über längere Zeitperioden sprechen, also greift diese Argumentation ins Leere.

Zweitens, da sich die „globale Erwärmung“ bzw. „Globaltemperatur“ nicht wissenschaftlich berechnen lässt, ist jeder Behauptung über die Höhe der „Globaltemperatur“ unwissenschaftlich. Genauso gut kann man über den Stillstand der Einhörner-Population sprechen.

Als Laie muss man sich auf sein Gefühl und auf aussagen der Wissenschaft verlassen.

Wärme ist jedenfalls besser als bittere Kälte.

Wenn ich mit Leuten über die so genannte Klimaerwärmung spreche und genau das anspreche was der Autor klar darlegt, sind die meisten überrascht. Hören sie doch sonst immer welch schreckliche Auswirkungen die Erwärmung haben wird.

Falls wir einen Einfluss haben, so könnte ich mir einen in die entgegengesetzte Richtung vorstellen: durch unentwegtes einbringen von staub und Schmutz in die Atmosphäre müsste es ja zu mehr Wolken und damit zu einer Abkühlung kommen. Aber letztlich wird auch dieser Einfluss verschwindend gering sein.

Nebenbei: habe gestern zum ersten mal eine Werbung für den BMW e8 gesehen. Ein elektro-Auto.

Der Preis hat mich mal interessiert: fur 126000 EUR retten wir damit die Erde vor der nicht stattfindenden Erwärmung. Na dann frohe Pfingsten.