Teil 2: Temperaturmessung global – sind selbst die Daten der modernen Hightech-Meßgeräte nicht zuverlässig?

Unsere Kollegen von CLINTEL (Climate Intelligence Foundation) veröffentlichten vor kurzem das Buch „Die starren Vorstellungen des Weltklimarates“.

https://clintelwebshop.org/de/product/die-starren-klima-vorstellungen-des-ipcc/

Der niederländische Journalist Marcel Crok und der Geologe Guus Berkhout, die Gründer von CLINTEL, konzentrieren sich mit ihrer kritischen Aufklärungsarbeit auf die Sachstandsberichte des Weltklimarates IPCC (Intergovernmental Panel on Climate Change). Diese „Assessment Reports“ werden in unregelmäßigen Abständen alle paar Jahre veröffentlicht und in den Medien punktuell präsentiert.

„Punktuell“ ist hier der entscheidende Begriff, weil die Berichte mittlerweile über 10.000 Seiten Umfang haben, die von Hunderten Autoren formuliert wurden. Die enorme Menge von Informationen kann natürlich kaum jemand verarbeiten, weswegen es stets stark verkürzte Versionen für politische Entscheider gibt.

Im Abschnitt A – Beobachtungen – berichten die CLINTEL-Autoren von der Technologie der globalen Temperaturmessung und eklatanten Widersprüchen.

Messen mit Meßfehler

Die Messung der Oberflächentemperatur machte in den letzten 150 Jahren bewundernswerte Fortschritte – von den Quecksilber-Thermometern über elektronische Verfahren bis hin zur aktuellen Satellitenmessung. Auch wenn die Weiterentwicklung der Technik grundsätzlich zu begrüßen ist, hat der Fortschritt doch seine Tücken. Meßtechniker wissen, daß jede Messung, ob Genexpression im Labor oder Temperatur im Harz, einen Fehler bis zu 10% enthält. Wenn also der elektronische Meßfühler eines Wetterhäuschens im Harz 10°C anzeigt, kann es auch etwas weniger sein – oder mehr.

Erfahrungsgemäß neigen verschiedene Apparate mehr in die eine oder andere Richtung, was die Vergleichbarkeit alter und neuer Technologie-Daten erschwert. Die Abweichungen liegen meist nicht im relevanten Bereich – ob es morgen 10 oder 10,3°C sind, spielt für Bürger oder Industrie keine Rolle. Da die Klima-Berichterstattung aber auf Erhöhungen der Durchschnittswerte im Nachkommastellenbereich abhebt, können Meßfehler und Technologie-typische Abweichungen sehr wohl eine Rolle spielen.

Etwas Theorie und höchst pikante Praxis zu diesem Thema hören Sie in diesem Video von Michael Limburg, Ingenieur für Meßtechnik:

Ein weiteres gern verschwiegenes Beispiel ist der sogenannte städtische Wärmeinsel-Effekt in sich ausbreitenden Siedlungen, der für teils deutlich höhere Durchschnittstemperaturen sorgt, die von alten Meßstationen registriert werden. In dem Zusammenhang müssen auch bewußte Täuschung & Pfusch erwähnt werden, wie der aktuelle Skandal des britischen Meteorologie-Dienstes, die EIKE mit dem Artikel „Geister-Wetterstationen in Großbritannien? Mehr als ein Drittel nicht existent“ beschrieb.

„Welttemperatur“ wirklich weltweit gemessen?

Wahrscheinlich nur halb absichtliche systematische Fehler sind die Verringerung der Zahl terrestrischer Meßstationen ab 1990 und die traditionell grotesk ungleiche Verteilung der Meßpunkte auf dem Planeten. Im 18. und 19. Jahrhundert wurde außerhalb der westlichen Welt, also Europa, Nordamerika und Australien/Neuseeland, nicht flächendeckend gemessen. Dieser Zustand besserte sich erst nach dem Zweiten Weltkrieg allmählich. Das bedeutet, daß die „Weltmitteltemperatur“ der Jahre vor 1950 von Daten der nördlichen Hemisphäre dominiert wird – und auch noch von Daten der damaligen Industrieländer. Das wiederum heißt nicht, daß es nicht mindestens in Europa zwischen 1900 und 1940 etwas wärmer geworden ist, aber die „globalen“ Meßdaten vor 1950 sind nicht global und besitzen nur regionale oder kontinentale Aussagekraft.

Das Wort „kontinental“ deutet an, daß zudem meist nur Daten vom Land vorliegen – die 70% Wasser auf der Erdoberfläche hingegen, wo das Wetter überwiegend gemacht wird, sind historisch kaum erfaßt. Heute sieht es mit den ARGO-Roboterbojen schon etwas besser aus, aber jede Boje deckt im riesigen Pazifik einen riesigen Bereich ab. Heißt, bis heute ist die „globale Mitteltemperatur“ der Meßtechnik am Boden alles andere als global, weil die meisten Daten von zentralen Regionen an Land kommen.

Die Fallstricke des technischen Fortschrittes

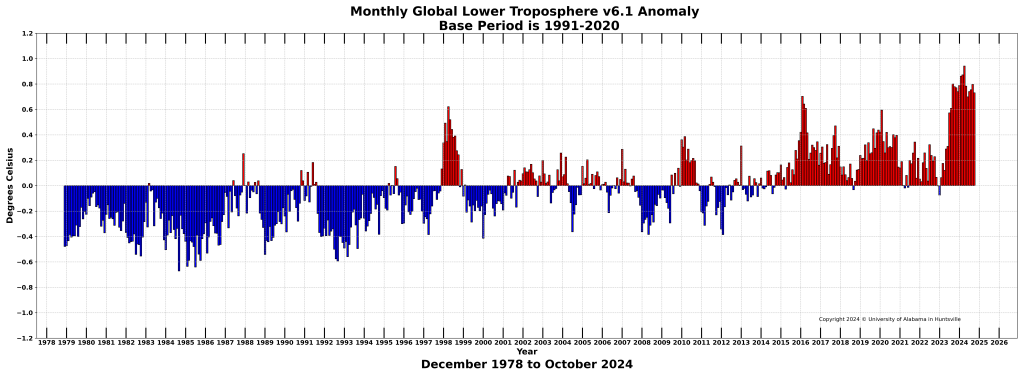

Da seit 1979 neben den terrestrischen Meßstationen die Satellitentechnik hinzukam, die unabhängig von abgelegenen Landstandorten oder den Ozeanen überall messen kann, wurde das Problem scheinbar gelöst. Leider können Satelliten die Temperatur gar nicht wirklich messen, sondern nur die Reflexion des Lichts von der Oberfläche. Der erhaltene Wert für einen Ort wird dann mittels Formel in eine Temperatur umgerechnet. Erfahrenen Klimaskeptikern ist diese Methodik nicht neu, da in der offiziösen Klimawissenschaft erstaunlich viel „errechnet“ statt gemessen wird. Das Verfahren ist bestens von den Klima-Computermodellen bekannt, und auch von der jahrezehntelangen Messung des „globalen“ CO2-Gehalts der Atmosphäre von einer Station auf dem aktiven, also CO2 emittierenden Mauna Loa-Vulkan der Hawaii-Hauptinsel. Das störende vulkanische Kohlendioxid wird natürlich „herausgerechnet“.

https://www.nsstc.uah.edu/climate/2024/october/202410_Bar.png

Erderwärmung seit den 1980ern? Satelliten-Daten der Universität von Alabama in Huntsville, wo unser Referent Roy Spencer die Temperaturaufzeichnung managt.

Heißester Monat x seit 125.000 Jahren

Vor allem historische Vergleiche oder Meßkurven über Jahrhunderte, die in den Massenmedien oder offiziösen Wissenschaftsmagazinen publiziert werden, sind daher mit äußerster Vorsicht zu genießen. Stilblüten wie „heißester Monat x seit 125.000 Jahren“ geben natürlich nicht die Realität wieder, sondern sind politisch motiviert. Und Vergleiche wie „heute höchster CO2-Gehalt seit sechs Millionen Jahren“ könnten zwar grob stimmen, sind aber schlichte Manipulation, weil nicht gleichzeitig offengelegt wird, daß die globale CO2-Konzentration der Erdatmosphäre schon seit Millionen von Jahren im unteren Bereich weit unter 1.000 ppm (1 Promille) liegt. In der Zeit davor hingegen hatte die Atmosphäre nicht selten CO2-Werte im Prozentbereich – in heißen und in kalten (!) Phasen.

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Die „mittlere Erdtemperatur“ ist so real wie die mittlere Körpertemperatur aller Patienten in einem Krankenhaus. Wer legt sich denn in ein Krankenhaus wo seine Medikation nicht von seiner Körpertemperatur abhängt sondern vom Durchschnittswert im Krankenhaus, und schlimmer noch, seine Medikation dient dazu diesen Durchschnittswert zu steuern. Er wäre schnell genau so tot wie unsere Wirtschaft nach dem Versuch mittels CO2 Abgaben die Erdtemperatur zu steuern…. Der Ökologismus, die neue Volksreligion des 21. Jahrhunderts.

Wir sind alle Opfer einer Politik, die uns ins Mittelalter zurück katapultiert. Eine Politik, die eine korrumpierte Alarm-„Forschung“ schuf, die alarmieren muss und für Alarm bezahlt wird. Seriöse Wissenschaft und solide Messungen werden durch Alarm, Panik sowie Klimamodelle mit übertreibenden Alarm-Prognosen ersetzt. Man nennt es zynisch „die Wissenschaft“. Schon ist die Verdummung perfekt und kaum zu überbieten.

Wer im Namen dieser „Wissenschaft“ alarmiert und Panik verbreitet, der liegt richtig und erhält Orden dafür. Von den dümmsten Idio… aller Zeiten. Dazu die Schlaumeier, die sich daran dumm und dämlich verdienen – dank Klima- und Energiewende-Wahn. Wo bleiben Politiker mit Hirn, wie es sie früher einmal gab? Anstelle der Null-Zero-Armleuchter?

Unterschrieben, Herr Dr. Ullrich.

Die anderen Messwerte werden aber nicht als Referenz publiziert, so wie die Keeling-Kurve. Warum also sollte es somit keine berechtigte Kritik daran geben wenn Anlass besteht das es dort örtliche Einflüsse gibt die den Wert verfälschen könnten. Und die Kritik ist keine Mode aus „letzter Zeit“, die gibt es schon lange und genauso lange gibt es keine schlüssige Antwort darauf. 🙁

Thomas Grun schrieb am 7. Dezember 2024 17:58

Ich hatte neulich erst auf einen Artikel aus dem Jahre 2010 hingewiesen, in dem die diversen Kritikpunkte adressiert wurden: „Under the Volcano, Over the Volcano„. Vielleicht ist der schon zu alt und das Wissen in Vergessenheit geraten. Da kommen jetzt die Kritikpunkte als neu und unbeantwortet daher …

Wie gesagt, die Kritik ist ein alter Hut, wie Ihr Artikel zeigt, denn der ist von 2010. 😀

Thomas Grun schrieb am 9. Dezember 2024 0:23

Genau wie die schlüssigen Antworten darauf, die es angeblich nicht gibt und die auch im Artikel stehen …

Dass Messgeräte fehlerbehaftet arbeiten, muss nicht weiter diskutiert werden, wenn man die Messgenauigkeit kennt und eine Fehlerabschätzung vornimmt. Selbst beim Autofahrer-Blitzen wird das gemacht, wenn auch falsch.

Viel wichtiger sollte die Erkenntnis sein, dass man Temperaturen nicht mitteln darf. Sie ist eine abgeleitete Größe der Wärme, die einen definierter Körper mit all seinen spezifischen Eigenschaften im Bezug hat. Wärme ist Energie, die Dimension ist Ws. Temperatur als abgeleitete Größe wird in °C angegeben.

Eine Erwärmung ist also eine Zunahme von Energie. Über eine gemittelte Temperatur über unterschiedlich geartete Körper kann dann gerade nicht mehr auf eine Energiezunahme geschlossen werden. Dazu hätte man die einzelnen Energiezunahmen der unterschiedlichen Körper erfassen müssen, über denen die Einzel-Temperaturen gemessen worden sind. Die Körper Eis in der Antarktis, Wald in Europa oder Sand im Death Valley unterscheiden sich aber gewaltig in ihren physikalischen Eigenschaften.

Wer jetzt meint, es wird ja die Lufttemperatur in 2m Höhe gemessen, und die Luft ist überall gleich. der übersieht, dass die Luft nur das konvektiv arbeitende Übertragungssystem des darunter liegenden „Körpers“ zum Temperatur-Sensor ist, wobei der „Körper“ seine aus Einstrahlung erhaltene Wärme über Wärmeleitung an die Grenzschicht Körper / Luft abgibt.

Jeder Elektrotechniker lernt (und behält es hoffentlich auch mit Verständnis), dass man aus Spannungs- und Strommittelwerten keine Leistung und mit Berücksichtigung der Zeit eben Energie bestimmen kann. Eine Quelle mit Innenwiderstand, die periodisch im Leerlauf und Kurzschluss betrieben wird erzeugt in der einen Phase die Leerlaufspannung U=Uo und den Strom I=0 und in der folgenden Phase U=0 und I=Ik. Daraus ergeben sich Mittelwerte von Um=Uo/2 und Im=Ik/2. Die Multiplikation der Mittelwerte führt zu einer Leistung P=(Uo/2)*(Ik/2), tatsächlich ist sie aber 0, weil in beiden Phasen eine der Größen U oder I Null ist. Und damit ist auch die so an den Klemmen erfasste Energie gleich Null.

Mit Mittelwerten kann man einfach nicht mehr auf Leistung oder Energie schließen. Wer Temperaturmittelwerte bildet, kann auch nicht mehr auf thermische Leistung oder Energie schließen.

Dennoch wird es immer wieder gemacht und auch noch resistent gegen physikalische Grundsätze verteidigt.

Wann soll das endlich einmal aufhören? Es gibt kein physikalisches Gesetz, welches mit Mittelwerten operiert oder Mittelwerte für mathematische Operationen zulässt. Das heißt nicht, dass ein dummer und emotionsloser Rechner das macht, insbesondere in Potsdam. Es ist physikalisch verboten und derartige Ergebnisse sind falsch und lassen sich auch nicht mehr korrigieren und beschönigen!

Temperaturmittelwerte haben keinen Bezug zu Wärme oder Erwärmung, auch wenn das dem einen oder anderen Mittelwertverfechter nicht gefällt, weil er nach Stefan Boltzmann auch noch die 4. Potenz bemüht, um den Erwärmungsfehler auch noch zu potenzieren!

Bei aller Problematik. Kennen Sie einen besseren Wert als die Temperatur als Anzeiger dafür dass sich etwas erwärmt hat? Ist es nur deshalb fehlerhaft und heiß umstritten , weil lineare Mittelwertbildung gemacht wird, weil andere Mittelungen zu aufwändig sind?

Zu einem Mythos, das auch Ihre Meinung scheint: Die auf der Erdoberfläche aufliegende Luft erhielte ihre Wärme durch Konvektion von der Oberfläche. Versuchen Sie sich mal selber zu erklären wie es geht, dass bei einer Sonnenfinsternis innerhalb weniger Minuten die Lufttemperatur um 5 bis 7 °C sinkt, nicht nur in 2m Höheund auch höher und der Boden dagegen beharrend gleiche Temperatur behält. Aber das ist ein anderes Thema.

freundliche Grüße

Der bessere Wert ist die Messung der Wärme (Energie). Aus der Gesamtsumme kann man dann energetisch Erwärmung oder Abkühlung ableiten. Fehlerhaft und unzulässig bestimmte Global-Temperaturen sind natürlich bequemer. Die Globaltemperaturverfechter bescheiden sich ja noch nicht einmal darauf, dass ihre falschen Mittelwerte eine höhere oder niedrigere Temperatur ergeben (was ohnehin nur mit dem Gewicht unterschiedlicher Mehlsäcke ausgedrückt in kg und mittleres Gewicht geht), nein, sie sprechen eindeutig von Erwärmung, manchmal auch von Abkühlung. Das bedingt aber ein Energiedelta, welches eben nicht in °C oder K angegeben wird, sondern in Ws.

Soll man für falsche Physik nun Mitleid haben, nur weil der Volksmund ein Zimmer mit höherer Temperatur als wärmer bezeichnet und er dabei sein Bad mit dem zehnmal größeren Wohnzimmer vergleicht? Wärmer ist hier ohne Physik subjektives Empfinden, mehr aber auch nicht. Und das hat mit Erderwärmung (Energiezuwachs) rein gar nichts zu tun. Kein Mensch wird sagen, wegen der verflixten Erhöhung der unzulässig gemittelten Globaltemperatur ist es jetzt hier aber verdammt warm geworden.

Wenn Sie feststellen, dass bei einer Sonnenfinsternis die Luft um ~6°C abkühlt, der Boden aber nicht, kann die vorherige Wärme der Luft ohne Sonnenfinsternis eindeutig nicht auf Abstrahlung vom Boden zurück zu führen sein. Damit bleiben einzig veränderte Bedingungen in der Grenzschicht und in der Konvektion übrig. Vom Messsystem mit seiner räumlichen Installation in einem Käfig reden wir noch gar nicht.

Die Luft über der Erdoberfläche kann nur durch Konvektion erwärmt werden, allenfalls noch durch Advektion. Und da die vorher, in Bezug auf Ihr Beispiel, eingestrahlte Energie in tiefere Lagen über Advektion abgeleitet wurde, erscheint die Handauflegung gleichwarm, aber nur deshalb weil ohne weitere Energiezufuhr und konvektiven abtransport der Energie nunmehr der wärmere Boden seine Wärme noch oben wieder ableitet weil es dort in dem Fall kühler ist/wird. Die Oberfläche selbst ist weder kälter noch wärmer, weil eine Oberfläche eine Grenzfläche zwischen unterschiedlichen Medien ist und keine Masse besitzt, kann sie demnach keine Wärme selbst aufnehmen noch speichern.

„Wer Temperaturmittelwerte bildet, kann auch nicht mehr auf thermische Leistung oder Energie schließen.“

Vielleicht will der ja gar nicht auf thermische Leistung oder Energie schließen! Die Temperatur ist jedenfalls eine eigenständige physikalische Größe, die man nicht zwangsläufig in Verbindung mit Energie oder Leistung benutzen muss.

Und wer sich so pauschal und undifferenziert gegen Temperaturmittelung ausspricht, hat offenbar auch nicht begriffen, dass Temperatur eine Größe ist, die selbst auf Mittelung beruht. Man kann sie z.B. in einem Gas in Beziehung zur mitlleren(!) Geschwindigkeit seiner Moleküle setzen.

Mir persönlich fällt auf, dass die Kampfansagen gegen Temperaturmittelung v.a. aus der Ecke Elektrotechnik kommen. Als wenn Elektrotechnik der einzige Maßstab für physikalische Sachverhalte wäre!

Der Kommentar zu meinen Ausführungen ist schon recht seltsam und nur für solche Menschen verständlich, die einfach nicht zwischen Wärme und Temperatur unterscheiden wollen. Weshalb man deshalb die Elektrotechnik schlecht machen muss, bleibt ein Geheimnis des Schreibers. Tatsächlich ist es so, dass alles, was uns bei Materie und Strahlung berührt, letztlich auf Feldgrößen basiert. Und da war Maxwell nun einmal ein Vorreiter!

Hier noch einmal zum Mitschreiben oder besser zum Mitdenken:

Temperatur wird in °C oder K angegeben.

Wärme als Energie wird in Ws angegeben.

Wer also mit Temperaturwerten herumhantiert, sollte auch dabei bleiben und von höheren und niedrigeren Temperaturen sprechen, selbst wenn er sie unzulässig gemittelt hat.

(Vielleicht will der ja gar nicht auf thermische Leistung oder Energie schließen!)

Und wer Angst vor Erderwärmung hat, sollte sich auch mit Wärme = Energie beschäftigen.

Dann braucht er die Physik nicht vergewaltigen und kann sich oberflächlich in Wärme oder Kälte bewegen.

(Frage: Meinen Sie mittlere Geschwindigkeit oder mittlere kinetische Energie von Molekülen? Kleine Hilfestellung: Die absolute Temperatur eines Körpers ist ein Maß für die mittlere kinetische Energie seiner Teilchen. Es gilt T ∼ E ¯ kin).

Der geneigte Leser merkt aber schon, dass Sie aus Bequemlichkeit (haben wir ja schon immer so gemacht) bei der physikalisch unzulässigen Temperaturmittelung bleiben wollen und ein Fan falscher Ansätze sind. Wenn Sie sich jetzt noch mit PD zusammentun, der rechnet Ihnen dann das ganze Universum in voller Überzeugung rauf und runter! Wenn es sein muss oder hilft auch auf 6 Stellen hinter dem Komma.

Ein seltsamer Kommentar, der mir zumindest nichts Neues an Erkenntnis bringt. Es geht mir übrigens gar nicht darum, die Elektrotechnik schlecht zu machen. Meine Aussage ist lediglich, dass die Elektrotechnik nicht der Weisheit letzter Schluss in puncto Physik-Verständnis ist.

Nehmen wir nur Ihre Berufung auf J.C.Maxwell und seine klassischen Feldgrößen. Da sind Sie offenbar im ausgehenden 19. Jahrhundert stehen geblieben. Danach ist noch ein kleines bisschen passiert im Hinblick auf das Verständnis der Welt. Stichwort: Quantentheorie.

„dass Sie aus Bequemlichkeit (haben wir ja schon immer so gemacht) bei der physikalisch unzulässigen Temperaturmittelung bleiben wollen“

Es gibt nicht die unzulässige Temperaturmittelung. Es gibt unzulässige und es gibt zulässige Temperaturmittelungen. Unterscheidungsvermögen ist gefragt! Mit Bequemlichkeit hat das nichts zu tun.

„Und wer Angst vor Erderwärmung hat, sollte sich auch mit Wärme = Energie beschäftigen.“ Keine Ahnung, ob das die Angst mindert (ich habe diese Angst ja nicht). Aber vielleicht können wir uns wenigstens darauf einigen, dass wenn die Temperatur steigt, auch mehr Energie im System ist. Das wird nun aber niemanden wirklich überraschen.

…“.wenn die Temperatur steigt, auch mehr Energie im System ist. Das wird nun aber niemanden wirklich überraschen.“

Volle Zustimmung. Keine Frage, dass eine arithmetische Mittelwertbildung felerbehaftet ist. Da ist auf der einen Seite ca. 80% Wasser, bei 71% Ozeane + bis zu 50% Feuchtigkeit in Böden + bis zu 80% in Pflanzen + Wasser als Schnee und Eis und auf der anderen Seite auch trockener Sand.

Weiter ist die Mehrzahl aller Messwerte landgestüttzt und auch das nicht gleichverteilt.

Bei all diesen Gründen für eine Mittelwertbildung : Das war gestern so und das wird übermorgen mit demselben Fehler behaftet sein. Und wenn es dazwischen eine Temperaturerhöhung gibt, dann ist es eben auch wärmer geworden.

Wer der gemittelten Temperatur eine Wertlosigkeit zuspricht, der muß sich auch von St.Bo. verabschieden. Dort ist nur Temperatur, sonst nichts .

Dann tauschen Sie doch einfach nur die Temperatur in Ihrem Wohnzimmer mit der Ihres Badezimmers aus (Betätigung der Temperaturregler für den jeweiligen Raum). Temperaturmittelwert bleibt! Ist es jetzt wärmer oder kälter geworden und wo? In der gemittelten Wohnung?

Da Sie offenbar eine merkwürdige Schwäche für Nichtverstehenwollens haben. Nun, in meinem Badezimmer und im Wohnzimmer ist zufällig immer die gleiche Temperatur. Gelle, was nun?

Ich hoffe sehr, dass Sie wissen, was ich mit St.Bo. gemeint habe. Stefan Boltzmann Formel, googeln Sie mal, falls Sie Philosoph sind oder ähnliche Vorbildung.

Weil Sie sich weigern das zu verstehen, was ich meine: richtig ist und das bestreitet niemand, dass man die 2 Messwete nicht arithmetisch mitteln kann ohne Fehler. Wenn man die Raumgrössen in m3 berücksichtigt, dann wird es richtig. Manche sagen vereinfacht das gewogene Mittel dazu. Also könnte man mit richtiger (aber sehr aufwändiger ) Methode auch richtige Mittelwerte bilden. Vorsicht, selbst Wasser ist nicht gleich. Bewegtes Meer hat eine andere Dynamik (Änderungen kaum meßbar als Schwimmbecken oder flache Pfütze (wird sehr warm).

Auch bei der arithmetischen Mittelwertbildung bleibt der Fehler gestern so wie morgen und wenn solch ermittelter Wert für die Temperatur größer wird, dann ist es eben auch wärmer geworden. Dass das WIEVIEL nicht stimmt, gleicht sich aus, wenn die Messpunkte oder die Messmethode nicht verändert werden und das ist leider häufig der Fall.

Auf diese Antwort ohne jeglichen Inhalt sind Sie wahrscheinlich auch noch ganz, ganz stolz. Und S-B gilt für einen beschriebenen (schwarzen) Körper. Und eine Globaltemperatur kannten die beiden Herren auch nicht.

Na, dann über Sie sich weiter in billiger Dialektik, ein Diskussionspartner zu physikalischen Problemstellungen sind Sie jedenfalls nicht.

Hallo Herr Puschen, bitte schreiben Sie unter Ihrem Klarnamen.

Lieber Admin,

unter Klarnamen habe ich immer geschrieben, bis von Ihrer Seite das Kützel P Pu eingeführt wurde. Ich habe mich sogar darüber beklagt

Am18.11.2024 schrieb ich an Admin:

Bitte erst einmal die Schrift von der Schwärzung her leserlich machen, so wie die publizierten Texte, dann kann man sich stressfrei den Rest anschauen.

Und die Namen müssen nicht anonymisiert werden, drei Buchstaben ist schon nahe an namenlos. Ob man akademische Grade verbannt, kann man geteilter Meinung sein. Wer akademische Grade hat, weiß das natürlich selbst. Aber für Außenstehende erleichtert das eine Einordnung „Troll oder nicht Troll“.

An mir hat es also nicht gelegen.

MfG Peter Pushcner

Wir haben das nicht eingeführt. Wir verändern keine Namen.

Lieber Admin,

entweder hat dies beim Umstellen des Editors einer von den „wir“ gemacht, oder jemand von außen. Ich war es jedenfalls nicht. Warum solle ich mich über die Anonymisierung auslassen, wenn ich das selbst gemacht hätte? Das ergibt doch keinen Sinn.

Ich habe mich ja auch zu der zu schwachen Gradation der Schrift geäußert, die Frage nach entsprechenden Anregungen kam von Ihnen.

Gerne bin ich Ihrem Wunsch nachgekommen und habe meinen vollständigen Namen wieder eingesetzt, diesmal ohne akademische Grade, da dies bei einigen Schreibern Aggressionspotentiale freigesetzt hat. An meinen durch Technologie und Physik geprägten Auffassungen ändert sich dadurch nichts.

Herzliche Grüße, Peter Puschner

In meinem Namen ist versehentlich ein Dreher erfolgt:

Peter Puschner, Prof. Dr.-Ing.

Steht bei Ihnen im Namensfeld beim Absender des Kommentars wirklich Peter Puschner, Prof. Dr.-Ing. ? Ich habe das frecherweise mit einem erklärenden Kommentartext mal ausprobiert und da erschien in der Kommentarvorschau der korrekte und vollständige Titel.

Andererseits mag ich P Pu. Da kuckt man mehr auf den Inhalt, als auf den Titel …

Eine „mittlere Erdtemperatur“ was soll das sein ausser totalem Blödsinn. Die Erde hat vereiste Pole mit Temperaturen bis 193 K und Wüsten mit Temperaturen bis 328 K und dazwischen riesige Ozeane (2/3 der Erde sind von Wasser bedeckt) tropische Urwälder, arktische Tundra, gemässigte Klimazonen…. usw….. Dazu gesellt sich eine wechselnde Insolation zu den Polen hin durch die schräg stehende Rotationsachse die zu ausgeprägten jahreszeitlich variierenden Temperaturen führt. Und aus alledem rechnen die Auguren des IPCC eine „mittlere Erdtemperatur“ und wollen diese auf 1,5 K genau steuern – durch den CO2 Gehalt der Atmosphäre im ppm Bereich! Das ist der komplette Irrsinn, aber alle machen mit und einige verdienen sogar sehr gut daran….

Bedeutet, die von IPCC, PIK et.all, angegebenen globalen Temperatur- und CO2-Werte sind politische Daten, oder?

Politisch und in Betrugsabsicht „ermittelt“.

Herr Poost, dass der globale Mittelwert ziemlich fehlerhaft ist und auch manipuliert wurde, ist klar. Aber dessen Anstieg seit vorindustrieller Zeit kann doch auch strahlungsphysikalisch berechnet werden. Gemäß S-B gilt im Gleichgewicht ∆T=ECS•ln(C/Co)/ln(2). Und die CLINTEL-Konferenz hat für CO2 (ohne Feedback) 0,24 K für ECS ergeben, was für den Anstieg auf 420 ppm +0,14 K bedeutet. Da sind noch Korrekturfaktoren für Hin- und Herstrahlung zum Boden und Feedback anzubringen, die dann +0,32 K ergeben.

Für transiente Beobachtung seit vorindustrieller Zeit bei nur etwa 20% CO2-Anteil gilt

1,2/0,7•0,2=ECS•ln(420/280)/ln(2)

woraus ECS=0,59 und ∆T=+O,24 K folgt – was ja auch mit MODTRAN berechnet wird. Dabei ist CO2 unterhalb von Wolken weitgehend wirkungslos, und der Feedbackfaktor ist gegenüber IPCC nicht 2,7 sondern nur 1,4.

Damit ist alles gesagt, oder?

Herr Poost, wollen Sie damit behaupten dass die Szenarienberechnungen auf fehlerhaften Messwerten beruhen und strahlungsphysikalische Formeln sowie HITRAN und MODTRAN sowie auch Ergebnisse von CLINTEL bei der THE-Berechnung irrelevant sind??

Kann man seit Climategate noch auf eine seriöse und auf Wissenschaft basierende „Klimawissenschaft“ vertrauen?

Meiner Meinung nach, nein.

Und überhaupt, welchen Sinn hat die fehlerhafte Messung eines lebensnotwenigen Spurengases, das für alles Leben auf diesem Planeten essentiell ist?

Hat keinen Sinn.

Aber jedes Jahr erzeugen die Rotorblätter der ca. 30.000 Windmühlen in Deutschland Mikroplastik von 4000 Tonnen, welches fruchtbare Böden kontaminiert.

DAS ist bedrohlich, nicht CO2

Warum ist denn Mikroplastik bedrohlich?

Erstens sind die lungengängigen Fasern für die auf den Feldern arbeitenden eine Gefahr, für die welche die Ernte einbringen und weiter verarbeiten sowieso und bei entsprchender Größenordnung können diese auch über längere Zeiträume von den Pflanzen aufgenommen werden. Nicht umsonst müssen nach Kontamination die Äcker abgesucht werden und die Pflanzen der Vernichtung anheimfallen.

Die THE Berechnung auf Basis von Klimagasen ist irrelevant.

Die Grundbestandteile der Atmosphäre, Stickstoff und Sauerstoff, tragen am meisten zur Wärmespeicherung im Treibhaus der Erde bei. Die als Treibhausgase bekannten Gase – hauptsächlich Wasserdampf, Kohlendioxid und Methan – wirken mit ihren molekularen Schwingungsfreiheitsgraden als Sender und Emitter, die den Energiefluss zwischen Erde und Universum regulieren, dank ihrer Eigenschaft, Wärme in IR-Photonen umzuwandeln und umgekehrt. In einem reversiblen Austauschprozess können sie somit auch bei geringen Konzentrationen große Effekte erzielen. Gemäß dem 2. Hauptsatz der Thermodynamik verteilt sich Wärme von heißen zu kälteren Molekülen; es gibt keine Hotspots unter Molekülen oder Molekülarten in der Atmosphäre. Eine besondere Rolle von Kohlendioxid kann nicht bestätigt werden. Nur H2O kann durch seine Phasenumwandlungen große Wärmemengen speichern. Eine Reihe von Fragen bleibt ungelöst und ist wahrscheinlich experimentell nicht zugänglich. Der Sättigungsgrad und die Verweildauer der Wärme in den GH-Gasmolekülen sind unbekannt. Mit abnehmender Temperatur, die einer zunehmenden Höhe über der Erdoberfläche entspricht, verschiebt sich die von den GH-Gasmolekülen emittierte IR-Strahlung zu immer längeren Wellenlängen. Keine der Umwandlungen muss vollständig sein, d. h. die Wellenlänge des IR-Quants nimmt mit zunehmender Höhe ab, der Rest kann als kinetische Energie (Wärme) verbleiben. Es ist nicht möglich festzustellen, ob die eingestrahlte und die abgestrahlte Energie pro Zeiteinheit im Sinne eines Strahlungsgleichgewichts gleich sind. Dies könnte dazu führen, dass sich die Energie in der Atmosphäre über bestimmte Zeiträume hinweg ansammelt. Selbst bei konstanten solaren und planetarischen Parametern scheint die Strahlungsbilanz weder täglich noch im Laufe eines oder mehrerer Jahre ausgeglichen zu sein. Manchmal geschieht dies erst über Jahrtausende. Das Treibhaus der Erde arbeitet langsam, und die Menschheit sollte auf Klimaveränderungen vorbereitet sein. Und nicht einem irrelevantem Dogma nachlaufen.

Wie hier schon ausgeführt wird: „Aber dessen Anstieg seit vorindustrieller Zeit kann doch auch strahlungsphysikalisch berechnet werden.“ => „kann berechnet werden“!

Aber: Er wird nicht berechnet, sondern durch unzulässigen Mittelwertbildung von Messwerten physikalisch falsch erzeugt.

Und die strahlungsphysikalische Berechnung erfordert die Definition von Parametern zu Randbedingungen, die man beliebig je nach Glaubensüberzeugung festlegen kann.

Es gibt offensichtlich unzählige Menschen, PD gehört dazu, die glauben, dass man das komplexeste System, welches Menschen kennen, aber nicht verstehen können, durch eine einzige Zahl mit zwei Stellen hinter dem Komma beschreiben kann.

Wer der Klimakirche angehört, dem ist es egal, ob falsch gemessen und gemittelt oder falsch berechnet oder sonst etwas ausgedacht worden ist. Er singt das Lied mit, welches der Kantor gerade über eine Nummer auf die Lied-Anzeige in der Klimakirche projiziert hat. – Amen!