Nein, ich habe sie berechnet. Ich habe nicht, wie sie sagen, naïv nach Art von Rosinenpickerei das Jahr 1998 als Startpunkt gewählt, als ob ich einen unfairen Vorteil aus dem starken El Niño jenes Jahres gezogen hätte.

Stattdessen habe ich durch iterative Verfahren den frühesten Monat berechnet, der bis heute keinerlei globale Erwärmung zeigt. Im RSS-Datensatz, welchen ich für die folgende Analyse nutzen werde, ist dieser Monat der September 1996, was auf 17 Jahre und 6 Monate ohne jede globale Erwärmung hinausläuft.

Bild rechts: Diese Graphik ist berühmt geworden. Patrick Moore, einer der Gründer von Greenpeace (den Greenpeace jetzt mit rasender Verlogenheit versucht zu verstoßen) hat sie kürzlich bei Fox News gezeigt, gefolgt von heulenden und mit den Zähnen knirschenden Individuen in der gesamten Sphäre der Linken. Marc Morano zeigt diese Graphik als führenden Indikator auf seiner unschätzbaren Website ClimateDepot.com. Sie taucht in fast allen Blogs auf.

Die wahrhaft Gläubigen wringen ihre Hände und jammern über Rosinenpickerei. Mit diesem Vorwurf wollen wir uns einmal näher befassen und ganz nebenbei etwas Faszinierendes entdecken.

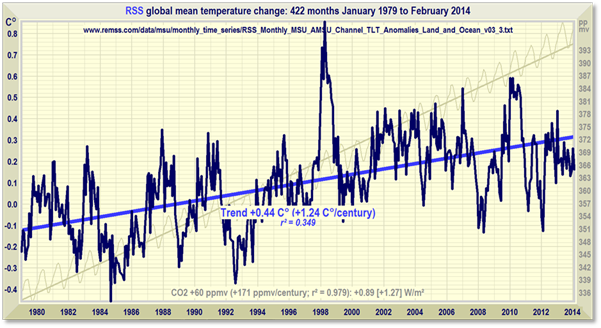

Um diesen Vorwurf der Rosinenpickerei bzgl. unseres Startzeitpunktes auszuräumen, wollen wir mal am Anfang der Satellitenaufzeichnungen beginnen. Das sieht so aus, seit Januar 1979:

Oh weh! Anstatt eines Null-Trends zeigt sich jetzt eine schreckliche Zunahme der globalen Temperatur, und zwar mit einer Rate von kochend heißen – ähm – 1,24°C pro Jahrhundert. Das liegt unter der Rate von 1,7°C pro Jahrhundert im 5. Zustandsbericht des IPeCaC. Und noch deutlicher unter den 2°C pro Jahrhundert aus dem 4. Zustandsbericht 2007. Im 1. Bericht war noch eine Rate von 3,5°C pro Jahrhundert genannt worden. Und 1988 hat der übernervöse James Hansen vor dem Kongress noch 5°C pro Jahrhundert vorhergesagt.

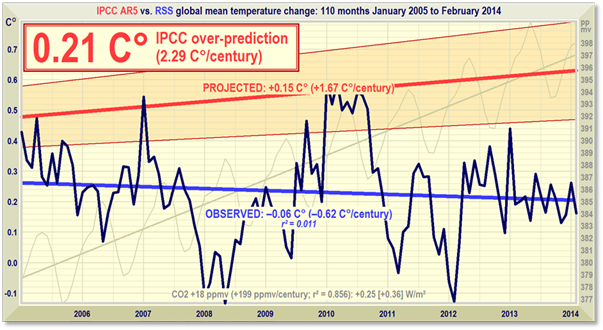

Es ist also eindeutig, dass die Vorhersagen mit der Zeit immer weniger extrem werden. Aber sie sind auch heute noch im Vergleich mit der Realität deutlich übertrieben. Die jüngste Version der „Konsens“-Vorhersage des IPeCaC sieht im Vergleich mit den RSS-Beobachtungen der realen Welt so aus:

Welchen Datensatz auch immer man wählt; welchen Startpunkt auch immer man wählt – die von den Modellen vorhergesagte Rate der globalen Erwärmung lag und liegt erheblich, schamlos, ungeheuer außerhalb dessen, was in der realen Welt passiert. Es ist diese zentrale Wahrheit, die jeden Versuch der Hinwegerklärung des Stillstands zunichte macht.

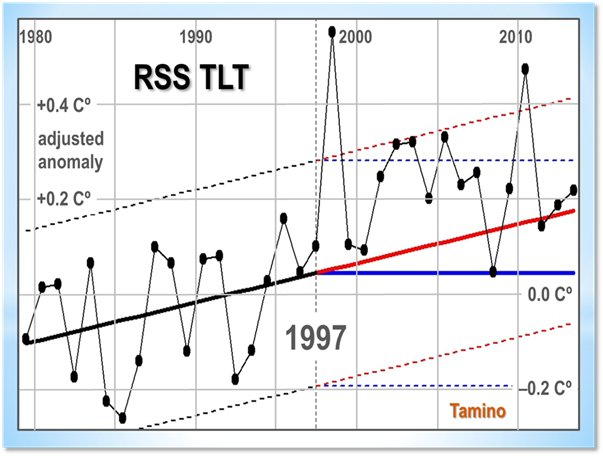

Einer der durchtriebensten Versuche, so zu tun, als gebe es den Stillstand nicht, stammt von „Tamino“, also einem dieser wie Druiden in weiße Gewänder gehüllten, bärtigen Erzpriester mit buschigen Augenbrauen.

„Tamino“, der von seinen Pflichten als Sonnenanbeter in Stonehenge eine Auszeit nimmt, will uns unterstellen, dass wir im Jahre 1997 vorhergesagt haben, dass die zuvor beobachtete Erwärmungsrate entweder so weitergehen oder horizontal werden würde. Wo würden die folgenden jährlichen Datenpunkte liegen?

Taminos jubelnde Schlussfolgerung lautet: „14 von 16 Jahren waren wärmer als erwartet, selbst nach der Vorhersage einer weiter gehenden Erwärmung, und alle 16 Jahre lagen über der Vorhersage der Nicht-Erwärmung (eines davon jedoch nur gerade noch so)“.

Puh! Die globale Erwärmung ist also doch nicht zum Stillstand gekommen!! Die Erde hat immer noch Fieber!!! Die globale Temperatur steigt immer noch – und zwar mit einer höheren Rate als zuvor!!!! Was für eine Erleichterung!!!!! Wir sagten, dass wir uns bzgl. der zukünftigen globalen Erwärmung sicherer sind als hinsichtlich aller anderen Dinge in der großen weiten Welt – und wir hatten recht!!!!!!.

Einen Moment, Lord Copper. Die Wahrheit, wenn man wirklich nach ihr sucht und nicht die Daten um und um wühlt, bis sie das gewünschte Ergebnis zeigen, ist viel interessanter.

Erstens ist es nicht angebracht, jährliche Datenpunkte zu verwenden, wenn diese auch monatlich zur Verfügung stehen. Die Verwendung monatlicher Daten multipliziert die Freiheitsgrade in einer Analyse um das Zwölffache und macht das Bild deutlicher.

Zweitens – und das kann man gar nicht zu oft wiederholen – sind Trendlinien in gemessenen Daten, vor allem, wenn man weiß, dass diese Daten stochastisch und das Verhalten des zugrunde liegenden Objektes chaotisch ist, keine – ich wiederhole: keine – ich wiederhole: keine Vorhersagen.

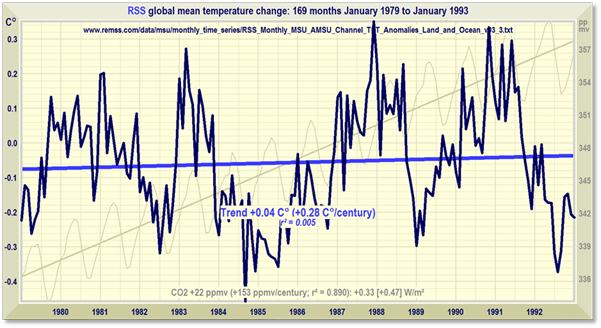

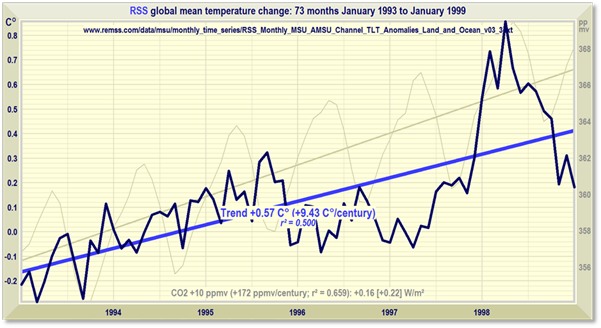

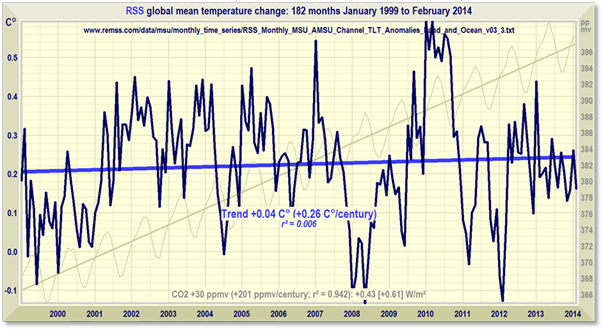

Spielen wir Taminos Spiel der Unterteilung des RSS-Datensatzes in Sequenzen mit. Aber wir wollen ihn in drei Sequenzen teilen, nicht nur in zwei. Diese drei Perioden sind: Januar 1979 bis Januar 1993, Januar 1993 bis Januar 1999 sowie Januar 1999 bis Februar 2014.

Es war Fred Singer, der mich zum ersten Mal auf diese beunruhigende Charakteristik der Temperaturaufzeichnungen nach 1979 aufmerksam machte. Wir saßen vor einem großen Computerbildschirm und spielten die Datensätze durch.

Fred sagte mir, dass es bis zum Großen El Niño 1998 nur einen sehr geringen Trend bei der Temperatur gab, ebenso wie nach diesem Ereignis. Aber, so sagte er, es war zu einer bemerkenswerten ruckartigen Änderung in den Daten in der kurzen Zeit bis zu diesem Ereignis gekommen, das in dem El Niño gipfelte.

Die Trends bis Januar 1993 und ab Januar 1999 sind tatsächlich fast identisch mit etwas über einem Viertel Grad Celsius pro Jahrhundert. Das ist nicht besorglich. Aber der Trend in den sechs Jahren von Januar 1993 bis Januar 1999 war ein Erlebnis. Er war äquivalent zu einer spektakulären Rate von 9,4°C pro Jahrhundert.

Was also war die Ursache für diesen plötzlichen Sprung der globalen Temperatur nach oben? Da das Fehlen einer Korrelation notwendigerweise das Fehlen von Kausalität impliziert, wissen wir, dass es nicht das CO2 sein kann – ist doch die CO2-Konzentration monoton gestiegen, ohne plötzliche Sprünge.

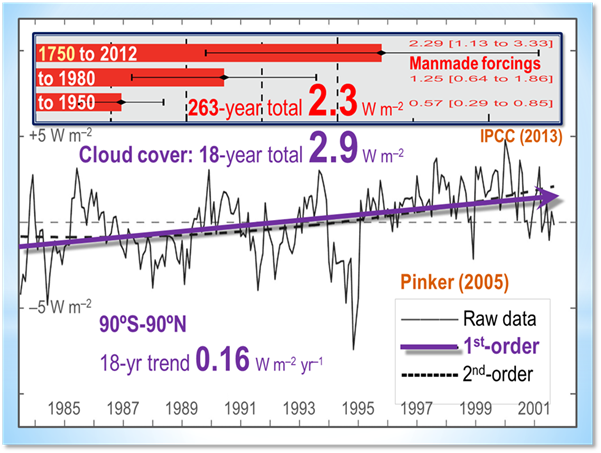

Tatsächlich kann kein Phänomen in der Atmosphäre diesen Sprung wirklich ausgelöst haben. Sicher, es hat in den 18 Jahren von 1983 bis 2001 eine natürlich vorkommende Verringerung der Wolkenbedeckung gegeben. Das hat zu einem Antrieb von 2,9 W/m² geführt (Pinker et al. 2005). Das liegt um 25% über den gesamten 2,3 W/m² des anthropogenen Antriebs aus allen Quellen während der 263 Jahre seit 1750.

Wie Dr. Pinkers Graphik jedoch zeigt, war der Trend hinsichtlich des Antriebs durch die Wolkenbedeckung relativ konstant, und es gab tatsächlich einen Rückgang dieses Antriebs in den Jahren 1993 bis 1995.

Da sich die Sonnenaktivität während dieses Zeitraumes nicht stark genug verändert hat, um einen derartigen Sprung der globalen Temperatur auszulösen, scheint es keinen einzigen externen Grund zu geben, warum die Temperatur sechs Jahre lang einen plötzlichen Anstieg mit einer Rate von fast 1°C pro Jahrzehnt durchlaufen hat.

Es gab auch keine verstärkte Vulkantätigkeit auf dem Festland; falls das der Fall gewesen wäre, wäre es allenfalls zu einer vorübergehenden Abkühlung gekommen.

Wenn alle Möglichkeiten ausgeschlossen werden können, muss das Unmögliche die Wahrheit sein. Der Schuldige ist also nicht atmosphärischen und auch nicht außerirdischen Ursprungs und auch nicht auf dem Festland zu suchen, sondern in den Ozeanen.

Um die atmosphärischen Temperaturen permanent um fast 0,3°C nach oben zu treiben und den Jahrhundert-Trend um fast ein Grad Celsius nach Norden zu schieben, muss unter den Wellen irgendetwas Drastisches passiert sein.

Vielleicht ist die immer noch kaum darstellbare Verteilung der Durchmischung, die wärmeres Wasser mit kälterem Tiefenwasser austauscht, vorübergehend ist Stocken geraten.

Vielleicht werden wir es niemals wissen. Unsere Fähigkeit, Änderungen des ozeanischen Wärmegehaltes zu erfassen, war damals nicht existent, weil die ARGO-Bojen noch nicht im Einsatz waren; und selbst heute ist die Erfassung, worauf schon Willis Eschenbach hingewiesen hatte, so spärlich, dass es der Entnahme eines einzigen Profils von Temperatur und Salzgehalt aus dem Oberen See einmal pro Jahr gleicht.

Vielleicht war es zu einer massiven untermeerischen Vulkanaktivität im äquatorialen Ostpazifik gekommen, die 1993/94 begonnen und 1998 ihren Höhepunkt erreicht hat. Noch einmal, das werden wir wohl niemals wissen, da wir nicht alle 3,5 Millionen untermeerischen Vulkane der Erde überwachen können (der größte von ihnen, größer als jeder andere im Sonnensystem, wurde erst im vorigen Jahr entdeckt).

Das Merkwürdigste an dieser plötzlichen und bemerkenswerten Erwärmung in nur sechs Jahren – nennen wir sie das Singer-Ereignis – ist die äußerst geringe Aufmerksamkeit, die das IPeCaC diesem Phänomen geschenkt hat.

Das Singer-Ereignis repräsentiert ganze vier Fünftel des globalen Erwärmungstrends während der gesamten Satelliten-Ära. Ohne dieses Ereignis würde niemand über die globale Erwärmung klagen.

Aber findet man eine Erwähnung des Singer-Ereignisses irgendwo in irgendeiner IPeCaC-Zusammenfassung für Politiker seit 2001? Nein. Es liegt politisch nicht auf Linie.

Und ganz klar gesagt, solange man die Ursache des Singer-Ereignisses nicht eindeutig festmachen kann, gibt es nichts, aber auch gar nichts in den Temperaturaufzeichnungen der Satelliten-Ära, das darauf hinweist, dass das CO2 überhaupt irgendeinen merklichen Einfluss auf die globale Temperatur hat.

Und schließlich – falls einer der Trolle darüber meckert, warum ich bei der Analyse ausgerechnet den RSS-Daten vertraut habe – ich bevorzuge RSS, weil er als einziger der fünf Datensätze den Großen El Niño als das zeigt, was er war: nämlich signifikant stärker als alle anderen El Niño-Ereignisse der Temperaturaufzeichnungen mit Thermometern.

Es gab zuvor noch zwei weitere Große El Niño-Ereignisse während der letzten 300 Jahre. In jedem davon brachte es wie 1998 und anders als alle anderen seit der Instrumenten-Ära die Korallen weltweit dazu, in großem Umfang auszubleichen. Bleichen ist ein natürlicher Verteidigungs-Mechanismus gegen eine plötzliche Erwärmung der Ozeane, und die Korallen haben sich seitdem wieder gut erholt, wie es ihnen von der Evolution vorgegeben war.

Aber die Korallen zeugen davon, dass das Singer-Ereignis etwas Atypisches ist. Und es ist der RSS-Datensatz, der am besten reflektiert, wie außerordentlich das Singer-Ereignis war.

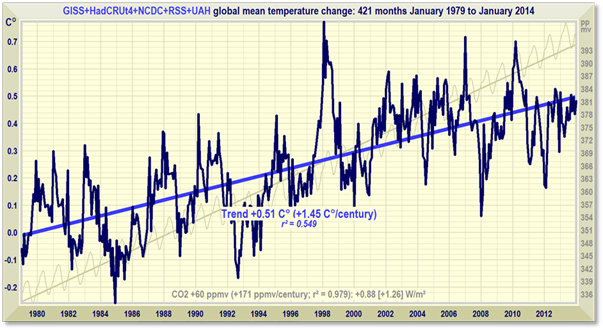

Um nun den Trollen noch einen Gefallen zu tun, folgt hier die gesamte globale Temperaturaufzeichnung seit Januar 1979 als Mittelwert aller 5 globalen Temperatur-Datensätze (es ist in Ordnung, das Mittel zu nehmen, weil die Diskrepanzen zwischen den einzelnen Datensätzen klein genug sind, um sich langfristig gegeneinander weg zu mitteln).

Unter dem Strich: Der Erwärmungstrend seit 1979 im RSS-Datensatz betrug 0,44°C, während der im Mittel aller Datensätze nicht viel größer als 0,51°C war. Wenn also die Trolle geltend machen, dass ich Rosinenpickerei betreibe, geht es dabei um wenige Hundertstel Grad Celsius.

Das Singer-Ereignis ist eindeutig im Graph der fünf Datensätze erkennbar und noch mehr in früheren RSS-Graphen.

Ich bin höchst interessiert an Kommentaren zum Singer-Ereignis, weil ich eingeladen worden bin, eine Studie aus der begutachteten Literatur dazu anzufertigen. Jedwede Hilfe, selbst von den Trollen, würde ich sehr begrüßen.

Link: http://wattsupwiththat.com/2014/03/19/un-cherry-picking-and-the-singer-event/

Übersetzt von Chris Frey EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Lieber Herr Kuhnle, 5

Die geben in etwa den Stand der Eiszeitentheorie von vor etwa 30 Jahren wider. Heute weiß man mehr.

„Wie genau funktioniert in diesen Modellen die Stabilisierung?“

Gar nicht. Die Stabilisierung muß sich auch im Modell wie in der Natur aus der Klimadynamik von selbst einstellen und hängt von den Randbedingungen ab, sprich den externen Klimafaktoren wie Sonneneinstrahlung, Erdbahnparameter, Vulkanismus, CO2-Level,…, wie schon einfache nichtlineare Modelle, wie z.B. vom Budyko-Sellers-Typ zeigen.

„Welche negativen Rückkopplungen wirken wie?“

Das gibt das Modell doch aus. Müssen sie nur in der Litertur wühlen.

„Warum hängt die Gleichgewichtstemperatur in den GCM-Modellen linear nur von einem Parameter (vom Log CO2) ab?“

Weil alles in der Natur in 1. Näherung linear abhängt 😉

Wie schon öfter erklärt: das ist nur ein Fit und keine Naturgesetz, klar?

„Welcher physikalische Zusammenhang könnte so etwas rechtfertigen? “

Naturgesetze und optimale Fits müssen sich nicht rechtfertigen.

Sehr geehrter Herr Dr. Hovestadt

Der nachfolgende Satz soll nicht Ihr Wissen und ihre Kompetenz in Frage stellen. Aber,

daß der Anstieg der CO2 Konzentration einer Erwärmung folgt und nicht umgekehrt, ist hier auf EIKE schon beinahe Standardwissen. Nur sollte sich die „Ehrenrettung“ des Gases nicht auf diese Tatsache allein beschränken. Selbst eine zeitlich parallel laufende Entwicklung muß nicht zwangsläufig auf eine Abhängigkeit voneinander hinweisen, denn Analogieschlüsse, aus bestimmten Beobachtungen, können unterschiedlich gedeutet werden, je nach Präferenz.

mfG

S.Bernd

#4: NicoBaecker, der Begriff „tipping point“ ist eigentlich ein Eigentor der AGW-Ideologen, weil sie unbedingt Angst erzeugen wollen.

Denn er stammt aus der „Chaostheorie“, die der ordinären „numerischen Wettervorhersage“ einerseits bestens bekannt ist,

aber andererseits eine längerfristige Prognose ausschließt.

Es ist geradezu intellektuell unverschämt, ausgerechnet die Eiszeiten, wenn auch verbal etwas verschleiert („Geheimnis“) für die CO2-Treibhaustheorie zu missbrauchen.

mfG

@#4

Sehr geehrter Herr Baecker,

Die Eiszeiten sind ein schönes Beispiel von positiver Rückkopplung. Durch wachsende Gletscher wird vermehrt Sonnenstrahlung reflektiert, dadurch wird es kälter und die Gletscher wachsen weiter, usw. Bliebe die positive Rückkopplung für alle Zustände erhalten, dann würde die Erde komplett zufrieren. Angeblich soll es den Schneeball Erde ja gegeben haben, was jedoch umstritten ist. Seit dem Beginn der Vereisung der Arktis vor 2-3 Mio Jahren gab es eine solche Klimakatastrophe aber nicht, d.h. die Vergletscherung erreichte immer ein Maximum. In diesem metastabilen Zustand waren dann die Rückkopplungen zwangsläufig negativ, d.h. die Vereisung hatte sich stabilisiert. Umgekehrt sind auch die Warmzeiten metastabil, d.h. die Gletscher auf Grönland und vor allem in der Antarktis blieben weitgehend erhalten. Zwar schmelzen auch diese Eisschilde, aber eben extrem langsam, so dass niemand damit rechnet, dass sie innerhalb unserer Warmzeit komplett verschwinden. Wäre die Erde komplett eisfrei, was ja geologisch historisch gesehen der Normalfall ist, dann ist mit globalen Temperaturen bis 22 Grad (also 7-8 Grad mehr als heutzutage) zu rechnen. Einen Zusammenhang von Temperatur und CO2 ist erdgeschichtlich nicht zu erkennen. Auch bei der Vergletscherung geht man eher von Einflüssen der Erdbahnparameter (Milankovic) und deren Einfluss auf lokale Klimaverhältnisse aus, die globale Strahlungsbilanz ist nicht das Entscheidende. Arrhenius kannte Milankovic nicht, als jener die Eiszeiten mit Schwankungen des CO2 und dem von Fourrier eingeführten Treibhauseffekt erklärte. Nachdem sich Milankovoc durchsetze, war die Arrhenius-Theorie praktisch tot, bis Umweltpolitiker (mit eigenen Interessen) in den frühen 80ern den Arrhenius-Nachfolger Bert Bolin mit der Wiederbelebung beauftragten und den Klimawahn auslösten. Der Weg in die Lehrbücher dauerte fast eine Generation und es ist zu befürchten, dass es genausolange dauert, bis dieser Unsinn wieder aus den Lehrbüchern verschwindet.

Was ist ein Tipping-Point? In meinem Modell könnte es ein Zustand sein, der schwach instabil ist und einen lang-anhaltenden Änderungsprozess nach sich zieht. Im Gebirge wäre es ein schwach abfallender Abhang mit weit entferntem Tal. Entscheidend ist weniger wie ein solcher instabiler Zustand ausgelöst wird, sondern warum es in der Nähe keinen metastabilen Zustand gibt, an dem sich alles stabilisieren würde.

Damit kommen wir zu den entscheidenden Fragen:

– Was kennzeichnet die methastabilen Zustände? Wie funktionieren die Mechanismen der Stabilisierung, d.h. der negativen Rückkopplungen?

– Welche Störung ist notwendig, um den metastabilen Zustand zu verlassen? D.h. wann versagen die Stabilisierungsmechanismen!

– In welchen anderen metastabilen Zustand könnte das System übergehen? Was sind die dortigen Stabilisierungsmechanismen?

Die Fragen sind wohl schwer zu beantworten, aber Wissenschaftler sollten sie dennoch stellen und nach möglichen Antworten suchen. Dabei darf man es nich nicht zu einfach machen und Differenzen weniger Daten von Warm- zu Eiszeiten eifach auf ganz andere Zustände extrapolieren. Etwas seltsam kommen mir in diesem Zusammenhang die GCM-Modelle vor. Wie genau funktioniert in diesen Modellen die Stabilisierung? Welche negativen Rückkopplungen wirken wie? Warum hängt die Gleichgewichtstemperatur in den GCM-Modellen linear nur von einem Parameter (vom Log CO2) ab? Welcher physikalische Zusammenhang könnte so etwas rechtfertigen? Prof. Lindzen ist von dieser Simplifizierung nicht überzeugt.

Gruß, Dr. Kuhnle

Lieber Herr Kuhnle,

Ihr Bild ist ja ganz hilfreich. Eine Uebergang von einem metastabilen Zustand zum anderen benoetigt aus den Eiszeiten abgeschaetzte Bilanzabweichung von 5 Wm-2 ueber mehr als 100

Jahre. In diesen Bereich kommt man ab Mitte dieses Jahrhunderts, wenn sich weiter CO2 ansammelt. Die Diskussion der tipping points basiert auf solchen Ergebnissen der Klimavergangenheit. Auch wenn bei den Eiszeiten der Ausloeser nicht menschlich war, was grundsaetzlich natuerlich ohne Belang ist.

Inzwischen bin ich der Ansicht, dass der steigende CO2-Gehalt möglicherweise überhaupt keinen Einfluss auf die globale Temperatur hat, und zwar unabhängig davon ob der CO2-Strahlenantrieb existiert oder nicht.

Komplexe Systeme sind dadurch charakterisiert, dass es keine einfachen Ursache-Wirkung Zusammenhänge gibt. Es gibt auch kein eindeutiges stabiles Gleichgewicht, sondern es gibt methastabile Zustände. Außerdem sind Übergange von einem zum anderen methastabilen Zustand vermutlich nicht reversibel. Um sich das Ganze anschaulich vorzustellen, kann man eine Kugel in einem Gebirge betrachten. Die methastabilen Zustände sind die Täler und die Zustände auf den Bergen sind instabil, so dass positive Rückkopplungen sehr schnell für eine Zustandsänderung hin zu einem methastabilen Zustand sorgen. Dort sind die Rückkopplungen stark negativ, so dass der Zustand stabil bleibt. Um einen methastabilen Zustand zu verlassen, ist eine größere Störung notwendig. Wie groß die Störung sein muss, hängt von der Stabilität des Zustands ab.

Im obersten Bild kann man dies eindrucksvoll erkennen. Dezeit haben wir einen recht stabilen Zustand, der durch die blaue Linie gekennzeichnet ist. Das ElNino Ereignis von 1998 war zweifellos eine große Störung, welche die Zustandsänderung ausgelöst haben dürfte. Nach diesem Ereignis hat sich die globale Temperatur auf dem heutigen Niveau eingependelt. CO2 spielt daben keine Rolle, die Störungen, wenn es sie gibt, wären viel zu klein um den Zustand zu ändern. Die negativen Rückkopplungen würden den CO2-Effekt ausgleichen. Da es im historischen Vergleich der letzten 2 Mio Jahre relativ warm ist, ist eine weitere Erwärmung nicht zu vermuten. Sichere Prognosen sind in komplexen Systemen allerdings nicht möglich.

Sehr geehrter Lord Monckton of Brenchley,

Was immer der Grund für das „Singer Ereignis“ des schnellen Temperaturanstiegs der globalen Temperatur (SST und Airtemperatur)ist, das damit wahrscheinlich zusammenhängende El-Nino Ereignis hat im daraus folgenden Temperaturmaximum eine Besonderheit. Die zeitliche Verzögerung des zugehörigen CO-2 Maximums gegenüber dem 1. Ozean-Tempertur Maximum (nach dem El Nino) ist mit mehr als 12 Monaten besonders hoch.

Dieses geht aus der neuen Arbeit von Ole Humlum et al. 2013, GLOBAL AND PLANETARY CHANGE 100, p.51 – 69 (Univ. Oslo) hervor. Diese Arbeit scheint leider weitgehend in Klimawissenschaftlichen Kreisen („gläubigen“ und „skeptischen“) unbekannt zu sein. Dabei ist sie eine der stärksten experimentellen Argumente gegen den anthropogenen CO-2 Effekt als Ursache der Erwärmung der Erwärmung. Schlichtweg, weil der Co-2 Anstieg ca 11 – 12 Monate nach einer Erwärmung des Ozeans eintritt.

Warum findet diese Arbeit so wenig Beachtung

Für eine Stellungnahme wäre ich dankbar.

Es grüsst

D.Hovestadt

Dr.D.Hovestadt

Sehr geehrter Lord Monckton of Brenchley,

ich würde weniger von Vulkanaktivität als vielmehr von seismischer und hydrothermaler Aktivität im Ostpazifik sprechen.

Ich empfehle, seismische Daten aus dem Ostpazifk, besonders entlang des East Pacific Rise auszuwerten. Die Zeitspanne sollte möglichst lang sein, z.B.10 Jahre, also von 1988-1998. Dürfte nicht einfach sein, insbesondere da zu vermuten ist, dass die lückenlosesten Datenreihen aus dem militärischen Bereich stammen.

Mehr seismische Aktivität – Aufreissen von Spalten hinab bis in den oberen Mantel – Eindringen größerer Massen an Ozeanwasser – Aufheizung bis ca,. 400°C – „Auswurf“ des erhitzten, hochmineralisierten Wassers z.B. über Black Smoker, aber auch entlang von linearen Strukturen – Erwärmung des oberflächennahen Ozeanwassers oder Verzögerung seiner Abkühlung

Das könnte – grob skizziert – die Wirkungskette – sein.

mit freundlichen Grüssen

Dirk Weißenborn