Henri Masson, Professor (emeritus) an der Universität Antwerpen

Einführung

Dieser Aufsatz ist eine Reaktion auf die Wiedereinführung einer Hockeyschlägerkurve durch das IPCC in die SPM (Summary for Policy Makers) im AR6. Ursprünglich von Michael Mann in AR4 eingeführt und in AR5 nach der verheerenden Analyse von Mc Intyre, der die methodischen Mängel von Michael Mann aufzeigt, verschwunden war. Diese neue Kurve scheint im erweiterten Bericht AR6 nicht zu erscheinen, was einige Zweifel an ihrer wissenschaftlichen Bedeutung aufkommen lässt.

Aber gleichzeitig liegt diese manipulierte Grafik dem politischen Ziel des IPCC zugrunde, als Massen-Manipulationswaffe die Medien zu alarmieren und die Leute zu ängstigen. All dies rechtfertigt einen tieferen Einblick in die Methoden, die der IPCC verwendet, um diese Grafik zu generieren.

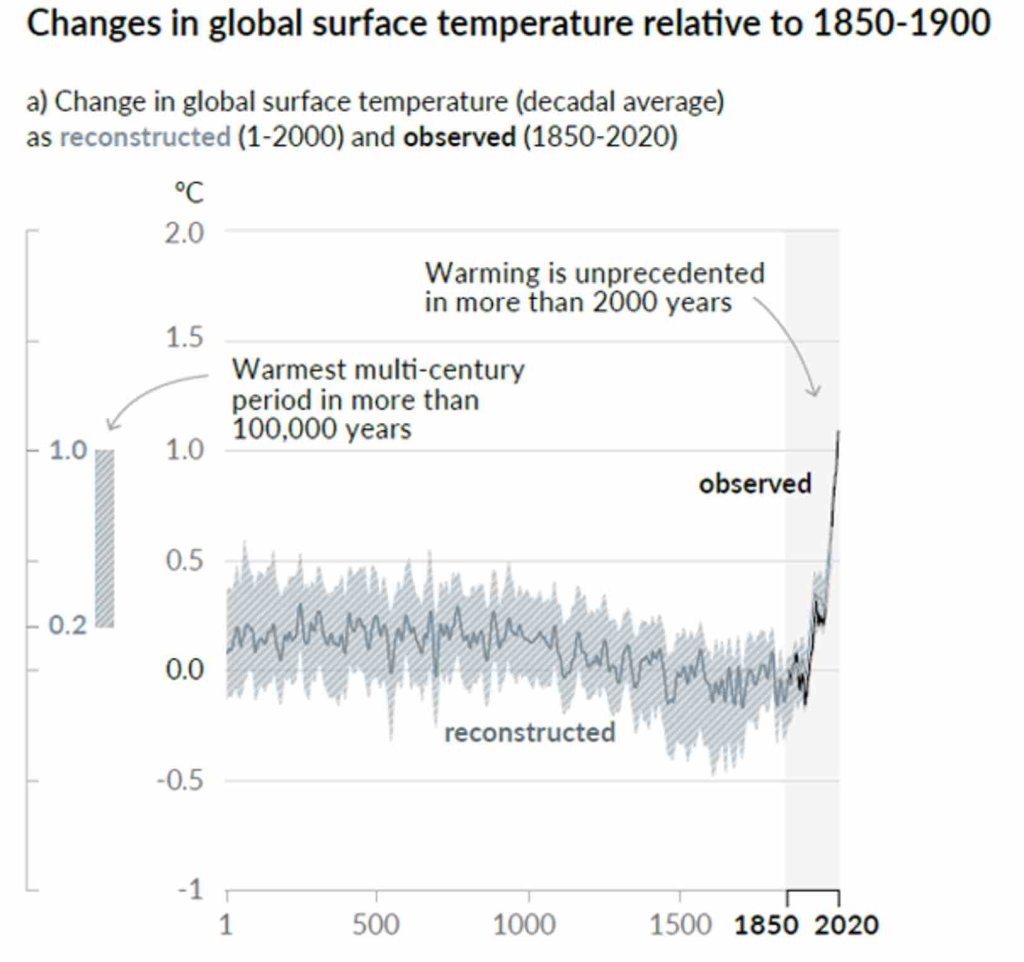

Fig 1- IPCC graph von summary for police makers an deciders SPM AR6 (source: https://www.ipcc.ch/assessment-report/ar6/) [… beispielslose Erwärmung …]

Die vom IPCC zur Konstruktion dieser Kurve verwendeten Daten sind eine Kombination aus vielen Proxys für die Daten aus der Vergangenheit und direkten Temperaturmessungen für die neuesten Daten (nach 1980).

Steve Mc Intyre hat diese neue Hockeyschlägerkurve in https://climateaudit.org/ bereits wissenschaftlich entlarvt .

In diesem Aufsatz wollen wir nun anhand eines fiktiven Beispiels, einige gängige methodische Tricks demonstrieren, die verwendet werden, um eine solche Kurve zu erstellen. Aus Spaß an der Übung werden wir uns in die Lage eines IPCC-Klimatologen versetzen, der die Datenwissenschaft entdeckt, in einem Buch mit einfachem „Data Mining für Dummies“ oder ähnliches.

| Die parodistischen Teile dieses Aufsatzes sind kursiv geschrieben und in Wortkästen eingefügt, um Verwechslungen zu vermeiden. |

Der illustrative Fall

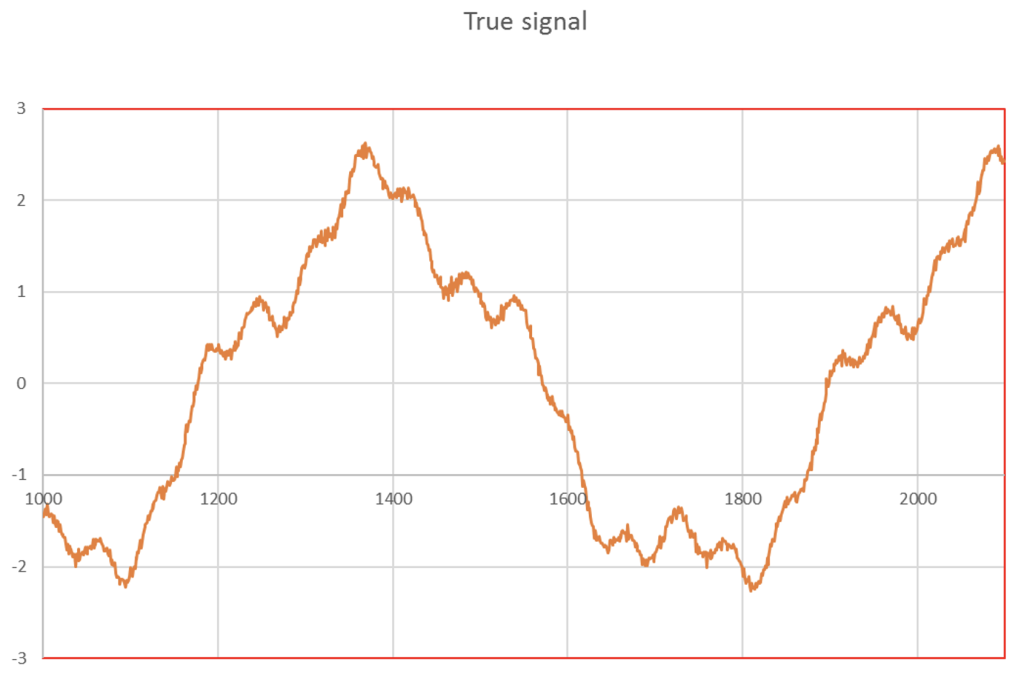

In dieser Arbeit wird angenommen, dass die Geschichte der Temperaturanomalien durch Überlagerung von 3 Sinusoiden vernünftig simuliert werden könnte, was es ermöglicht, das mittelalterliche Optimum (~ Jahr 1 350), Maunder (~ Jahr 1650) und Dalton (~ Jahr 1820) Minimum und die gegenwärtige „Pause (oder „hiatus“) sehr angenähert zu reproduzieren, wie in Abbildung 2 gezeigt.

| Wie bei meinen angesehenen Kollegen vom IPCC, müssen diese natürlichen Schwankungen vom menschlichen (anthropotischen) Beitrag getrennt werden; diese natürlichen Schwankungen müssen als unbedeutendes Rauschen betrachtet und als solches behandelt werden. |

Tabelle 1 enthält Details zu den Parametern, die verwendet wurden, um diese Sinuskurven zu konstruieren.

Abbildung 2- Simulierte Temperaturaufzeichnung unter Verwendung von 3 Sinussoids

| Amplitude | 2 | 0,4 | 0,2 |

| Periode (Jahre) | 725 | 180 | 60 |

| Initialphase (grad) | 260 | 60 | 60 |

Tabelle 1- Parameter der 3 im Modell verwendeten Sinussoids

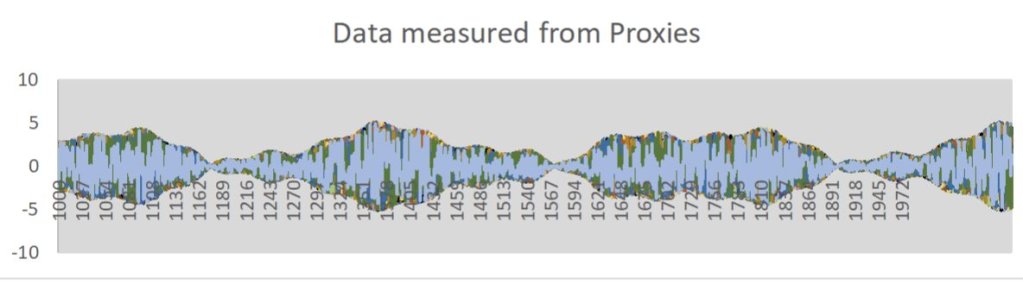

Proxys sind, wie der Name schon sagt, ungefähre Schätzwerte für die Temperatur, aber leider für einige von ihnen auch für andere Faktoren wie Feuchtigkeit usw. Die über diese Proxys durchgeführten Messungen werden daher ernsthaft durch Rauschen verfälscht.

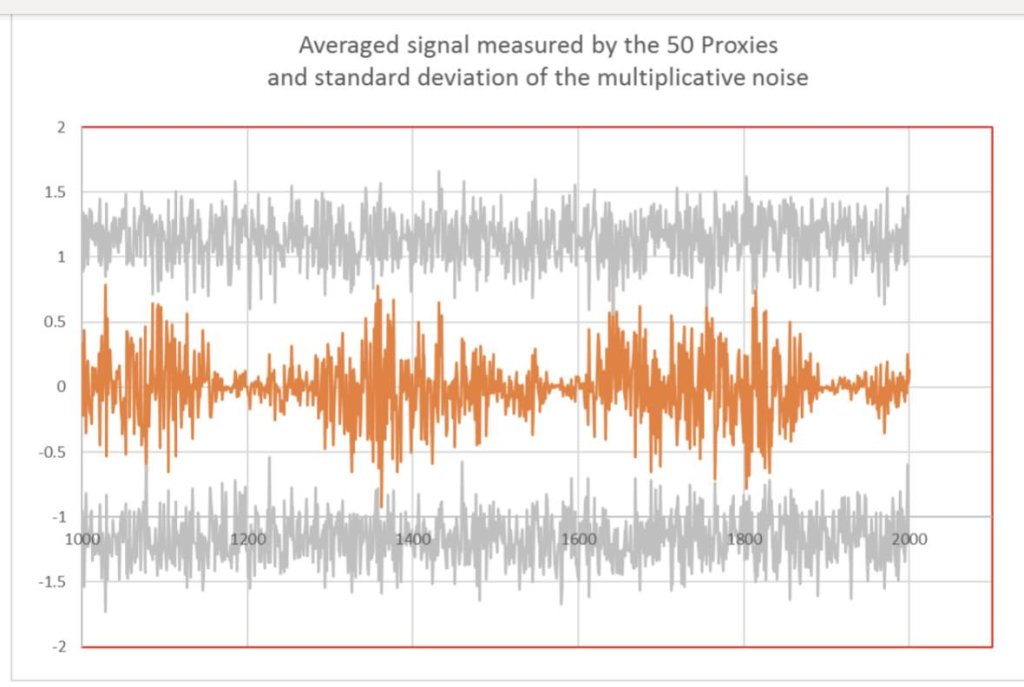

In der vorliegenden Arbeit wurden die Messungen von 50 Proxies simuliert, indem das „wahre Signal“ mit Zufallsrauschen multipliziert wurde. Diese Multiplikation entspricht Kalibrierungsfehlern der Proxys. Für den betrachteten Fall lagen diese Zufallsvariablen im Bereich von -2 bis +2 und verteilten sich über einen Zeitraum von 1100 Jahren, der von 1 000 bis 2 100 Jahren dauerte, mit einer zeitlichen Auflösung von einem Jahr.

Abb. 3 zeigt die „Messdaten“, wie sie von den 50 einzelnen Proxys erhoben wurden.

Abb. 3- Von den 50 verschiedenen Proxys gesammelte Daten

| Wir alle wissen beim IPCC, dass Proxys mit viel Rauschen versehen sind. Lassen Sie uns also ihren Mittelwert und ihre Standardabweichung berechnen, wie es in der Sekundarschule gelernt wurde. |

Für jedes Jahr wurden Mittelwert, Standardabweichung und Konfidenzintervalle der „gemessenen“ Daten gebildet. Die Konfidenzintervalle wurden willkürlich als Mittelwert + – Standardabweichung definiert, obwohl die Verteilung der „gemessenen“ Daten um die Summe der 3 Sinuskurven, die die „wahren“ Daten simulieren, gleichmäßig ist und keine Gauß-Verteilung.

Datenreduzierung

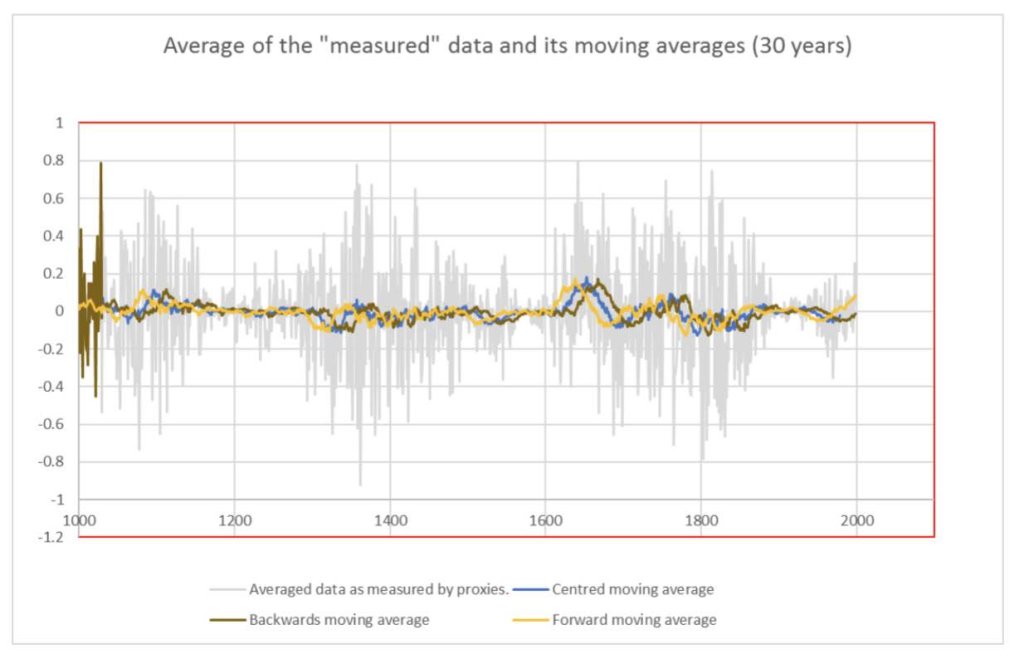

Abb. 4 überlagert die gemittelten simulierten Daten, wie sie von den Proxies gesehen werden, mit ihrer mittleren Standardabweichung. Einige Punkte der simulierten Daten überschreiten die durch die Standardabweichung gegebenen Grenzen.

| In dem Vulgarisierungsbuch (Vereinfachungs Anleitung), das ich geöffnet habe, um ein wenig über Data Mining zu lernen (nicht mein Spezialgebiet, ich bin Glaziologe), habe ich entdeckt, dass Sie Ihre Daten bereinigen und Ausreißer entfernen müssen, die als „Schurken“-Punkte angesehen werden, weil diese Punkte wahrscheinlich von einem experimentellen Fehler resultieren. Seltsamerweise scheinen meine Daten in Zyklen „gepulst“ zu sein.

Durch einen Blick in Wikipedia habe ich festgestellt, dass eine bessere Methode zum Bereinigen der Daten mit einigen Ausreißern und Zyklen darin besteht, eine Trendentfernungstechnik anzuwenden, und dass die Verwendung von gleitenden Durchschnitten für diesen Zweck gängige Praxis ist (https://en.wikipedia .org/wiki/Moving_average ). |

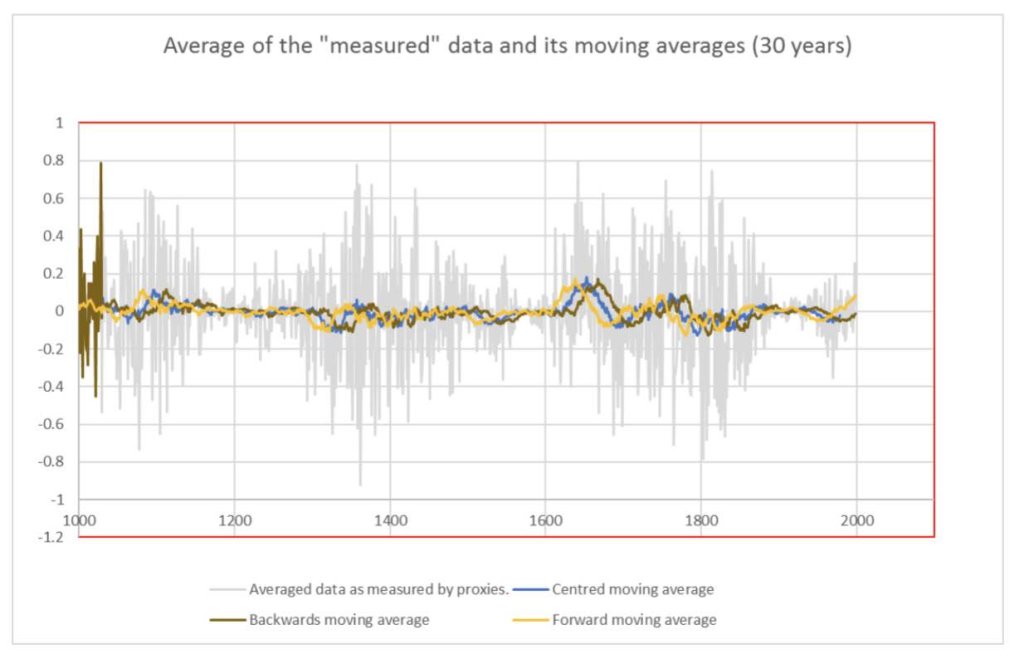

Abb. 5- Daten, gemessen durch Proxys und Glättungskurven des gleitenden 30-Jahres-Durchschnitts. Der zentrierte gleitende Durchschnitt reduziert „Randeffekte“ am Anfang und am Ende des Zeitfensters.

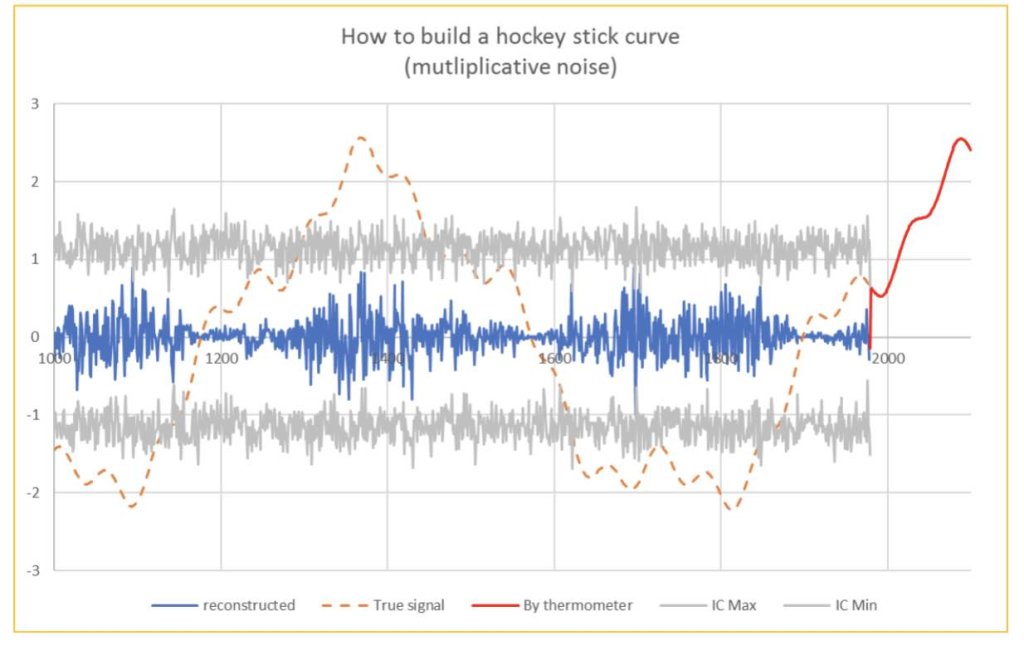

| Glücklicherweise verbessert sich die Genauigkeit der Temperaturmessungen mit der Zeit; Seit 1980 verfügen wir über zuverlässige Thermometermesswerte, die durch Satellitenmessungen der NASA bestätigt werden.

Auf der anderen Seite sind wir uns alle beim IPCC einig, dass es außer eines massiven Beitrags anthropischer Treibhausgase, keine andere Erklärung für den enormen und extrem schnellen Temperaturanstieg gibt, den wir seit diesem Datum beobachtet haben. Ab 1980 stellen unsere Daten somit die aktuellen Anomalien dar, und es ist absolut legitim, die gemessenen Temperaturen seit diesem Datum zu den trendbereinigten Daten der Proxys hinzuzufügen. Bei einer solchen Kurve bin ich mir ziemlich sicher, dass es leicht sein muss, die politischen Entscheidungsträger, die an der kommenden COP26 in Glasgow teilnehmen werden, davon zu überzeugen, viel Geld auf den Tisch zu legen. Dies wird natürlich in gewisser Weise „kaskadieren“, als nette weitere Zuschüsse für meine Forschungsaktivitäten, die vor dem Klima-Hype eher vertraulich blieben. Wenn nicht, muss ich mir einen anderen Job suchen. |

| Abb. 4- Zusammenfassung der Daten. In Rot die „gemessenen“ Daten und in Grau die Standardabweichung des Proxy-Rauschens (und seiner Symmetrie). Einige der Daten liegen außerhalb des (ungefähren) Konfidenzintervalls. Auch die Streuung der Daten ist im Laufe der Zeit nicht konstant, was für einen Auswerter von Daten, der die Existenz natürlicher Zyklen von Bedeutung nicht ahnt, eine Trendbeseitigung rechtfertigt.

Wenn man bedenkt, dass die WMO [Weltorganisation für Meteorologie, eine Sonderorganisation der Vereinten Nationen] die Absicherung zwischen Meteorologie und Klima auf eine Dauer von 30 Jahren gesetzt hat, erscheint es mir logisch und kohärent, die Daten mit einem gleitenden Durchschnitt einer Gesamtlänge von 30 Jahren zu glätten und auf diesen Weise jede meteorologische Störung zu eliminieren. In Analogie zum Konzept der globalen Temperaturanomalie (und ich schaute erneut in Wikipedia, um mein Gedächtnis über dieses spezifische Konzept aufzufrischen, das wir beim IPCC ausgiebig als einzigen Klimaindikator verwenden: https://en.wikipedia.org/wiki/Temperature_anomaly), scheint eine Glättung der Daten durch einen rückwärts gleitenden Durchschnitt das am meisten angezeigte Verfahren zu sein. Um jedoch meine Computerkenntnisse zu zeigen, habe ich die in Abb. 5 gezeigte Grafik erstellt, in der ich die gemittelten „gemessenen“ Daten mit einem rückwärts, vorwärts und zentrierten gleitenden Durchschnitt von 30 Jahren vergleiche. Offensichtlich bietet die zentrierte Einstellung die beste Anpassung, indem sie die „Randeffekte“ am Anfang und am Ende des betrachteten Zeitfensters reduziert; Da ich vor meinen Kollegen als Perfektionist gelten möchte, werde ich dieses Verfahren übernehmen . Auch in Anbetracht der Tatsache, dass meine Kollegen am IPCC den anthropischen Beitrag zum Klimawandel vom natürlichen trennen und sich nur auf den ersten konzentrieren, bin ich überzeugt, dass dieser zentrierte gleitende Durchschnitt ein zuverlässiges Bild des anthropischen Beitrags zum Klima liefern wird; und offensichtlich besteht unter uns Einigkeit darüber, dass der anthropische Beitrag vor der industriellen Revolution vernachlässigbar ist. |

| Abb. 5- Daten, gemessen durch Proxys und Glättungskurven des gleitenden 30-Jahres-Durchschnitts. Der zentrierte gleitende Durchschnitt reduziert „Randeffekte“ am Anfang und am Ende des Zeitfensters. |

| Glücklicherweise verbessert sich die Genauigkeit der Temperaturmessungen mit der Zeit; Seit 1980 verfügen wir über zuverlässige Thermometermesswerte, die durch Satellitenmessungen der NASA bestätigt werden.

Auf der anderen Seite sind wir uns alle beim IPCC einig, dass es keine andere Erklärung für den enormen und extrem schnellen Temperaturanstieg gibt, den wir seit diesem Datum beobachtet haben, als einen massiven Beitrag anthropischer Treibhausgase. Ab 1980 stellen unsere Daten somit die aktuellen Anomalien dar und es ist absolut legitim, die gemessenen Temperaturen seit diesem Datum zu den trendbereinigten Daten der Proxys hinzuzufügen. Mit einer solchen Kurve bin ich mir ziemlich sicher, dass es leicht sein muss, die politischen Entscheidungsträger, die an der kommenden COP26 in Glasgow teilnehmen werden, davon zu überzeugen, viel Geld auf den Tisch zu legen. Dies wird natürlich in gewisser Weise „kaskadieren“, als nette weitere Zuschüsse für meine Forschungsaktivitäten, die vor dem Klima-Hype eher vertraulich blieben. Wenn nicht, muss ich mir einen anderen Job suchen. |

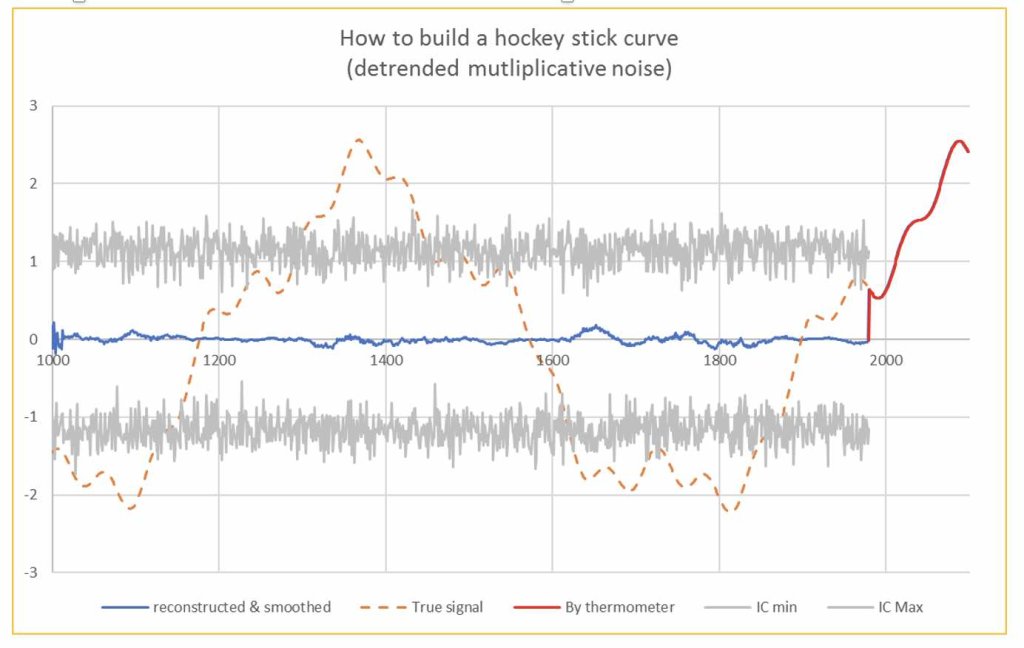

| Abb. 6- Der Hockeyschläger rekonstruiert. Die grauen Linien geben das Vertrauensintervall an, das dem Proxy-Rauschen entspricht

Ich bin sehr froh, clever genug gewesen zu sein, die Messungen von Proxies erfolgreich zu detrendieren, sonst hätte meine Grafik natürlich immer noch nicht genügend überzeugt… aber weniger, als in Abb. 7 gezeigt. Einige Klimaskeptiker können sich auf die verbleibenden Zyklen konzentrieren, auch wenn diese nicht sehr signifikant sind, fallen sie in das Konfidenzintervall, was es mir ermöglicht, sie als Rauschen zu betrachten. |

| Abb. 7- Gemittelte Messwerte über Proxies und Thermometer( -messungen) nach 1980 |

Abschluss

Die Hockeyschläger-Grafik in Abbildung 6, was ein zuverlässiges Abbild der in Abbildung 2 dargestellten „Rohdaten“ sein soll, ist eine „Fälschung“ und resultiert aus dem Missbrauch von Data-Mining-Techniken, basierend auf Märchenhypothese , die nicht länger akzeptiert werden können. Als Übung im kritischen Denken ist der Leser eingeladen, die in dieser parodischen Anmerkung absichtlich eingeführten methodischen Fehler zu finden.

Zusatzmaterial :

Die Zahlen dieser Anmerkung wurden in einer Excel-Tabelle erstellt, die auf Anfrage erhältlich ist.

Interessenkonflikt

Der Autor bestätigt, dass kein Interessenkonflikt besteht und dass keine Finanzierung für diese Arbeit bereitgestellt wurde.

Weiterlesen

IPCC AR6 und SPM (Summary for Policy Maker) https://www.ipcc.ch/assessment-report/ar6/

- Hyndman and G. Athanasopoulos, Forecasting https://otexts.com/fpp2/

https://www.science-climat-energie.be/2021/08/16/how-to-build-your-hockey-stick-graph/

Übersetzt durch Andreas Demmig

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"