Kurz-, mittel- und langfristige Klimavorhersagen sind über 50% der Zeit falsch, so dass eine richtige Vorhersage nicht besser ist als ein Zufallsereignis. Globale und regionale Vorhersagen sind oftmals genauso falsch. Falls es ein Klimamodell geben würde, dessen Vorhersagen zu 60% zutreffend sind, würde jedermann dieses benutzen. Da es aber keine einzige genaue Klimavorhersage gibt, geht das IPCC dazu über, alle Modellvorhersagen zu mitteln, als ob sich die Fehler dadurch irgendwie gegenseitig aufheben würden und das Mittel der Vorhersagen repräsentativ wäre. Klimamodelle und deren Vorhersagen haben eklatante Schwächen, die in anderen Unternehmungen ihre sofortige Aussortierung zur Folge hätte. Es sei denn, natürlich, dass es sich um ein von der Regierung finanziertes Fiasko handelt. Tägliche Wettervorhersagen sind seit der Entwicklung moderner Vorhersagemethoden seit dem 1. Weltkrieg immer besser geworden. Dagegen scheinen allerdings selbst kurzfristige Klimavorhersagen nicht besser zu sein als der Old Farmers Almanac aus dem Jahr 1792, bei dem als Vorhersagegrundlage Mond, Sonne und andere astronomische und terrestrische Indikatoren herangezogen worden waren.

Ich habe viel gesagt und geschrieben über die Schlüsselrolle von Modellen bei der Erzeugung und Fortführung der Katastrophen-AGW-Mythologie. Menschen waren erschrocken über die durchgesickerten E-Mails der CRU, aber die meisten wissen nicht, dass die tatsächlichen Instruktionen zum „Verstecken des Stillstands“ [hide the decline] im Anteil der Baumringe der Hockeyschläger-Graphik in den Computercode Eingang gefunden haben. Dies ist ein Grund, warum Menschen vom Akronym GIGO (Garbage in, Garbage out) sprechen, wenn von Klimamodellen die Rede ist.

Ich bin es leid, dass immer weiter so getan wird, als könnten die Klimamodelle akkurate Vorhersagen in einem chaotischen System erzeugen. Die Wirklichkeit ist, dass die Modelle nicht funktionieren und nicht funktionieren können, und zwar aus vielen Gründen einschließlich sehr fundamentaler: Fehlende Daten, fehlendes Wissen der wesentlichen Mechanismen, fehlendes Wissen über grundlegende physikalische Prozesse, fehlende Fähigkeit, physikalische Phänomene wie Turbulenz in mathematischer Form präsentieren zu können und fehlende Computer-Kapazität. Bob Tisdale hat die Probleme in seinem 2013 erschienenen Buch Climate Models Fail zusammengefasst. Es ist an der Zeit aufzuhören, weiterhin Geld und Zeit zu verschwenden und Menschen und Computer wichtigeren Dingen zu widmen.

Das Einzige, was die Leute weiter an den Modellen arbeiten lässt, sind finanzielle Zuwendungen der Regierung, entweder an Wetterbüros oder an Akademien. Ohne diese Finanzierung würden die Computermodellierer nicht das Studium des Klimas dominieren. Ohne diese Finanzierung könnte das IPCC nicht existieren. Viele in die Klimamodellierung involvierte Personen kennen sich in Klimatologie oder Klimawissenschaft nicht aus bzw. haben keinerlei Erfahrung damit. Sie waren Absolventen von Programmen zur Modellierung mittels Computer auf der Suche nach einer herausfordernden Gelegenheit, Zugang zu großen Computern zu haben und exzessiv bezahlt zu werden. Die Atmosphäre und später auch die Ozeane boten diese Gelegenheiten. Jetzt werden beide Bereiche zusammengeschustert, um das Fiasko fortzusetzen. Unglücklicherweise ist all dies für die Gesellschaft extrem teuer. Jene Ausgaben enthalten Kosten für die Computer und die Modellierungszeit, aber viel schlimmer ist, dass die falschen Ergebnisse im globalen Energie- und Umweltbereich angewendet werden.

Hört auf mit dem Theater sowie Geld und Zeit zu verschwenden! Streicht die Finanzierung, und niemand würde privates Geld für die Arbeit an Klimavorhersage-Modellen ausgeben!

Gewöhnlich argumentiere ich, dass es ein wenig bringen könnte, im Labor mit Klimamodellen zu spielen, mit wissenschaftlicher Verantwortung hinsichtlich Genauigkeit, Durchführbarkeit und Anwendbarkeit. Es ist eindeutig, dass sie diesen Verantwortlichkeiten nicht genügen. Jetzt erkenne ich, dass diese Haltung falsch ist. Wenn Modellergebnisse als die einzige Basis für Regierungspolitik herhalten muss, haben sie keinerlei Wert. Sie sind ein massiver Kostenfaktor und ein großer Schaden für die Gesellschaft, aber genau das zu tun war der Auftrag an das IPCC.

Das IPCC hat einen kleinen Wert. Es illustriert all die Probleme, die in vorherigen Kommentaren angesprochen worden waren. Im Labor erzeugte Klimamodelle werden manipuliert sogar weit über wissenschaftliche Präzision hinaus in regierungsamtlichen Wetterämtern oder Akademien. Dann werden sie zur Grundlage öffentlicher Politik in Gestalt der Summary for Policymakers SPM.

Ein weiterer Wert der IPCC-Berichte ist, dass sie eine detaillierte Auflistung der Gründe bieten, warum die Modelle nicht funktionieren und nicht funktionieren können. Zu blöde, dass nur Wenige diese Berichte lesen oder verstehen. Falls das der Fall wäre, würden sie erkennen, dass die Grenzen so hoch liegen, dass sie jede Erfolgschance zunichte machen. Nur eine einzige Teiluntersuchung illustriert diesen Punkt.

Daten

Die IPCC-Mitarbeiter wussten von Anfang an um die Grenzen der Daten, doch hat sie dies nicht daran gehindert, Modelle zu konstruieren.

Im Jahre 1993 hat Stephen Schneider, an einer der vordersten Plätze der AGW-Hypothese stehend, hinsichtlich des Gebrauchs von Klimamodellen gesagt:

„Ungewissheit über wichtige Rückkopplungs-Mechanismen sind ein Grund, warum das ultimative Ziel der Klimamodellierung, also die zuverlässige Vorhersage der Zukunft grundlegender Variablen wie Temperatur und Niederschlagsmenge, nicht realisierbar ist“.

In einem Bericht des US National Research Council vom 3. Februar 1999 heißt es:

Defizite hinsichtlich Genauigkeit, Qualität und Kontinuität der Aufzeichnungen stellen ernste Begrenzungen hinsichtlich des Vertrauens dar, das man den Forschungsergebnissen entgegen bringen kann.

Darauf erwiderte Kevin Trenberth:

Es ist sehr eindeutig, dass wir kein Klima-Beobachtungssystem haben … dies könnte für Viele ein Schock sein, die davon ausgehen, dass wir genau wissen, was mit dem Klima passiert, aber wir wissen es nicht.

Zwei Direktoren der CRU, Tom Wigley und Phil Jones, sagten:

Viele Unsicherheiten bzgl. der Gründe des Klimawandels werden niemals gelöst werden können, weil die dafür notwendigen Daten fehlen.

70% der Welt werden von Ozeanen überdeckt, von denen es praktisch keine Messungen gibt. Die Pole sind von grundlegender Bedeutung hinsichtlich der Dynamik des atmosphärischen Antriebs und des Klimas, und dennoch gibt es im 15 Millionen km² großen Gebiet des Arktischen Ozeans oder dem 14 Millionen km² großen antarktischen Kontinent praktisch keine Messstationen. Von etwa 85% der Erdoberfläche liegen keine Wetterdaten vor. Das IPCC räumt diese Begrenzungen ein und behauptet, dass die Daten einer einzelnen Station repräsentativ sind für die Bedingungen in einem Umkreis mit einem Radius von 1200 km. Ist das eine zulässige Annahme? Ich glaube nicht.

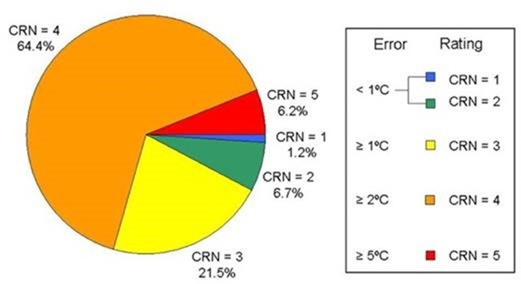

Aber es sind nicht nur die fehlenden Daten von der Erdoberfläche. Tatsächlich fehlen nicht nur die Daten von der Oberfläche, sondern auch aus diversen Höhenschichten über der Oberfläche zwischen 1,25 und 2 m. Und wie Forscher (Climate Near the Ground) zeigen, unterscheiden sich diese Höhenschichten markant von tatsächlichen Oberflächen-Temperaturen, wie sie an den wenigen Mikroklima-Stationen gemessen werden, die es gibt. Angeblich sind die US-Stationen die besten, aber wie Anthony Watts akribische Studie zeigt, messen lediglich 7,9% dieser Stationen mit einer Genauigkeit von weniger als 1°C (Abbildung 1). Ins Verhältnis gesetzt: im IPCC-Bericht aus dem Jahr 2001 behauptet Jones, dass die Zunahme um 0,6°C über 120 Jahre jenseits einer natürlichen Zunahme liege. Dies unterstreicht auch die Tatsache, dass die meisten der instrumentell gemessenen Temperaturen auf 0,5°C genau gemessen worden sind.

Bei anderen grundlegenden Daten einschließlich Niederschlag, Luftdruck, Windgeschwindigkeit und -richtung sieht es noch schlechter aus als bei den Temperaturdaten. Zum Beispiel gibt es in Afrika nur 1152 Wetterbeobachtungsstationen, welche ein Achtel der von der WMO geforderten minimalen Dichte ausmachen. Wie ich bereits in einem früheren Beitrag betont habe, reichen fehlende Daten für alle Aggregatzustände von Wasser (hier) allein aus, um das Scheitern der IPCC-Projektionen zu garantieren.

Die Modelle versuchen, eine dreidimensionale Atmosphäre zu simulieren, aber es gibt über der Oberfläche praktisch keine Daten. Die Modellierer glauben, dass wir dumm genug sind zu glauben, dass mehr Ebenen in den Modellen dieses Problem lösen, aber falls man keine Daten hat, spielt die Anzahl der Ebenen keine Rolle.

Wesentliche Mechanismen

Während meiner Laufbahn als Klimatologe wurden viele Phänomene von Wetter und Klima entweder gefunden oder gemessen, angeblich mit hinreichender Genauigkeit, um Eingang in ein Modell zu finden. Unter diesen Phänomenen sind ENSO, Pacific Decadal Oscillation (PDO), the Atlantic Multidecadal Oscillation (AMO), the Antarctic Oscillation (AAO), the North Atlantic Oscillation (NAO), Dansgaard-Oeschger Oscillation (D-O), Madden-Julian Oscillation (MJO), Indian Ocean Dipole (IOD) und andere.

Abgesehen davon wissen wir immer noch wenig über Phänomene, die mit der Hadley-Zelle und der Innertropischen Konvergenzzone ITC zusammenhängen, welche im Wesentlichen die gesamten tropischen Klima-Mechanismen sind. Der Milankovitch-Effekt bleibt umstritten und geht nicht in die IPCC-Modelle ein. Die Theorie kosmischer Strahlen scheint eine Antwort zu geben auf die Beziehung zwischen Sonnenflecken, globaler Temperatur und Niederschlag, aber auch diese wird gleichermaßen vom IPCC ignoriert. Auch das Phänomen Monsun wird kaum berücksichtigt, wenn es heißt:

Kurz gesagt, die meisten AOGCM-Modelle simulieren nicht genau die räumliche oder jahreszeitliche Variation der Monsun-Niederschläge.

Es gibt nur sehr begrenzt Wissen über die großen ozeanischen Zirkulationen an der Oberfläche und in den Tiefen. Es gibt praktisch keine Messungen des transferierten Wärmevolumens oder wie sich dieses mit der Zeit ändert, einschließlich Messungen der geothermischen Wärme.

Das IPCC räumt ein, dass:

wir bei der Klimaforschung und -modellierung erkennen sollten, dass wir es mit einem gekoppelten, nicht linearen chaotischen System zu tun haben, und dass daher die langfristige Vorhersage zukünftiger Klimazustände nicht möglich ist.

Dieser Kommentar reicht schon aus, um mit dem Verschwenden von Zeit und Geld aufzuhören. Man füge das zweite und damit verbundene Problem hinzu, das von Essex und McKitrick in dem Beitrag Taken By Storm identifiziert worden ist, und man findet dick unterstrichen aufzuhören.

Klimaforschung ist alles andere als eine routinemäßige Anwendung klassischer Theorien wie Strömungslehre, obwohl manch einer versucht sein könnte, genau das zu glauben. Es muss in der „exotischen“ Kategorie wissenschaftlicher Probleme betrachtet werden, teilweise weil wir versuchen, eine wissenschaftlich bedeutende Struktur zu finden, die niemand sehen kann oder jemals gesehen worden ist und die vielleicht nicht einmal existiert.

In dieser Hinsicht muss man unabdingbar im Hinterkopf behalten, dass es keine Experimentier-Anordnung für das globale Klima gibt, so dass alles, was wir haben, jene ersten Prinzipien sind. Man kann alle Messungen heranziehen, die man heute will; man kann Terabyte Plattenspeicher füllen, falls man will, aber das kann nicht als experimenteller Apparat dienen. Apparate können kontrolliert werden, und deren Betreiber können Messungen eigener Variablen durchführen über eine Bandbreite kontrollierter, physikalisch relevanter Bedingungen. Im Gegensatz dazu haben wir nur das heutige Klima als direkte Stichprobe, vorausgesetzt wir sind klug genug, sogar zu wissen wie man streuende Daten auf physikalisch bedeutsame Weise mitteln kann, um das Klima zu repräsentieren. Kurz gesagt, das globale Klima ist durch keinerlei konventionelle Mittel zu erfassen.

Computer-Kapazität

Modellierer behaupten, dass die Computer immer besser werden und dass alles, was sie brauchen, größere und schnellere Computer wären. Das macht mit Sicherheit keinen Unterschied, und die Geldverschwendung geht weiter. Im Jahre 2012 stellte Cray den Supercomputer mit der Bezeichnung Gaea vor (Abbildung 2). Er hat eine Kapazität von 1,1 Petaflops. Die Abkürzung FLOP bedeutet Floating-Point Operations per Second, und Peta sind um 1000 Millionen Floating-Point Operations per Second. Jagadish Shukla sagt, die Herausforderung bestehe darin,

dass wir in der Lage sein müssen, Klimamodelle mit der gleichen Auflösung laufen zu lassen wie die Wettervorhersagemodelle, die während der nächsten 5 Jahre eine horizontale Auflösung von 3 bis 5 km erreichen können. Dies wird Computer mit einer Spitzenfähigkeit von etwa 100 Petaflops erfordern.

Unabhängig von der Computer-Kapazität ist das alles bedeutungslos, wenn die Daten für das Modell fehlen.

Abbildung 2: Der Gaea-Computer von Cray mit dem umweltlichen Image.

Gescheiterte Vorhersagen (Prophezeiungen, Projektionen)

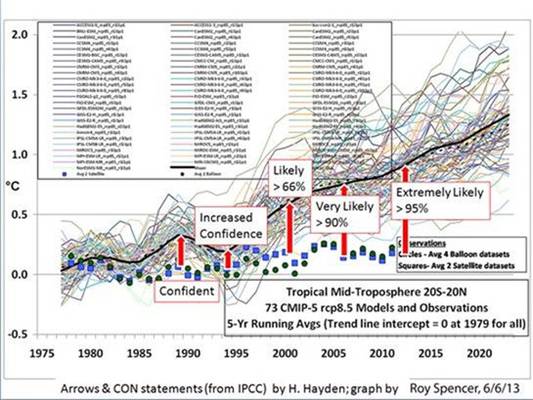

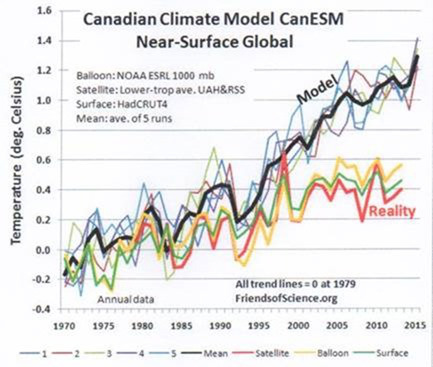

Abbildung 3 zeigt die gescheiterte Vorhersage des IPCC. Dort wird so etwas Projektion genannt, aber die Öffentlichkeit glaubt, dass es Vorhersagen sind. Wie auch immer, sie sind konsistent falsch. Man beachte die Beschriftungen, die Haydens Graphik aus der Summary for Policymakers SPM hinzugefügt worden sind. Während die Fehlerbandbreite bei den aktuellen Daten immer größer wird, behauptet die Summary stur, dass sie sich verbessern. Eines der vom IPCC herangezogenen Computermodelle gehört Environment Canada. Dessen Prophezeiungen sind die schlechtesten von all jenen, die für die Mittelung der Ergebnisse durch das IPCC Eingang fanden (Abbildung 4).

Abbildung 3

Abbildung 4. Quelle: Ken Gregory

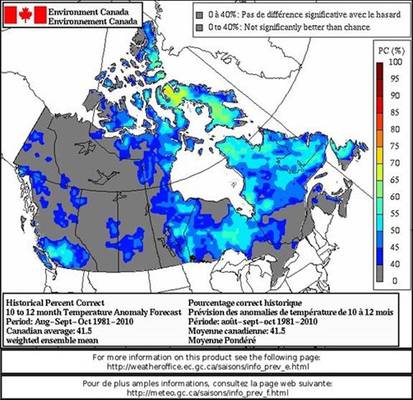

Das kanadische Desaster ist keine Überraschung, wie deren Abschätzung der Vorhersageleistung über ein Jahr zeigt. Sie machen eine Vorhersage über ein Jahr und bieten eine Karte an, die die Verteilung der Eintreff-Genauigkeit in Prozent zeigt, verglichen mit dem Mittel des Zeitraumes 1981 bis 2010 (Abbildung 5).

Abbildung 5

Die kanadische mittlere prozentuale Genauigkeitsverteilung ist unten links mit 41,5 Prozent angegeben. Das ist das beste, was sie erreichen konnten nach etwa dreißig Jahren Modellentwicklung. Ergebnisse in anderen Ländern sind auch nicht besser.

In einem Bericht im New Scientist sagte Tim Palmer, ein führender Klimamodellierer am EZMW in Reading:

Ich möchte das IPCC nicht unterminieren, aber die Vorhersagen, vor allem für regionale Klimaänderungen, sind in großem Umfang unsicher.

Die Kosten

Joanna Nova hat die umfangreichsten Forschungen hinsichtlich der Kosten der Klimaforschung durchgeführt, die der US-Regierung entstehen (hier):

Insgesamt wird die US-Regierung während der letzten 20 Jahre bis zum Ende des Finanzjahres 2009 32 Milliarden Dollar für die Klimaforschung ausgegeben haben – und weitere 36 Milliarden Dollar für die Entwicklung klimabezogener Technologien. Das sind tatsächliche Dollars, ersichtlich aus Berichten der Regierung, und nicht inflationsbereinigt. Finanzielle Zuwendungen anderer Regierungen sind nicht berücksichtigt. Die wirkliche Summe kann nur weiter steigen.

Es gibt keinen Zweifel daran, dass diese Summe wuchs, und die Welt als Ganzes wird wahrscheinlich die US-Ausgaben verdoppeln, wie dieser Kommentator behauptet:

Allerdings kann ich mindestens eine zuverlässige halbe Milliarde Pfund zu Joanne Novas 79 Milliarden-Dollar-Rechnung hinzufügen – plus: wir wissen jetzt schon, dass das Framework 7-Programm der EU 1,9 Milliarden Euro für die direkte Klimaforschung enthält. Framework 6 beläuft sich auf 769 Millionen Euro. Falls man alle Anhang-1-Länder zusammenfasst, muss die ausgegebene Summe deutlich über 100 Milliarden liegen.

Das sind lediglich die Kosten für die Computer-Modellierung. Die ökonomischen und sozialen Kosten sind noch viel höher und praktisch unmöglich zu berechnen. Paul Driessen sagt dazu:

Wie die entsprechenden polaren Gebilde sind 90% des titanischen Eisberges der Klimaförderung für die meisten Bürger unsichtbar, Geschäftsleute und Politiker gleichermaßen.

Es ist kein Wunder, wenn Larry Bell sagen kann:

Das Government Accounting Office (GAO) der USA ist nicht in der Lage herauszufinden, welche Vorteile der Steuerzahler von den vielen Milliarden Dollars hat, die jedes Jahr für eine Politik ausgegeben werden, die angeblich dem Kampf gegen den Klimawandel gewidmet ist.

Falls es wirklich einer vermeintlich hoch entwickelten Agentur wie dem GAO der USA nicht möglich ist, die Kosten zu berechnen, dann gibt es keine Chance für eine globale Abschätzung. Es gibt kaum Zweifel daran, dass die direkten Kosten in Billionen Dollar gemessen werden. Darin sind nicht enthalten die verpassten Gelegenheiten für Entwicklung und das Leben derer in Armut zu verbessern. Und all das nur wegen der als falsch nachgewiesenen Ergebnisse von vollständig gescheiterten Computermodell-Prophezeiungen, Projektionen oder wie immer man das nennen kann.

Es ist an der Zeit, diesen Wahnsinn zu beenden, welcher in der Klimawissenschaft in der Erzeugung immer neuer Computermodelle besteht, die nicht funktionieren und nicht funktionieren können!

Jene, die Wissen haben, prophezeien nichts. Jene, die prophezeien, haben kein Wissen“. Tzu Lao im 6. Jhd. vor Christus.

Übersetzt von Chris Frey EIKE.

Anmerkung des Übersetzers: Wie bloß kann man all diese Dinge der deutschen Zipfelmütze vermitteln?!

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Lieber Herr Berberich, #10

„Mich wundert immer folgender Sachverhalt: Ich erhitze Wasser in einem Wasserkocher und versuche die Temperaturverteilung im Topf zu erklären. Da spricht man von aufsteigenden Dampfblasen und Konvektion. Der Wärmetransport durch Strahlung wird vernachlässigt.“

Ja, das liegt an der kurzen Absorptionslänge von Strahlung in kondensierter Materie.

„In der bodennahen Atmosphäre soll plötzlich alles anders sein. Da überwiegt der Strahlungstransport.“

In Gasen sind die Absorptionslängen größer als in kondensierter Materie (fest, flüssig).

„Die große Gefahr sind die Treibhausgase, die den Strahlungstransport hemmen.“

Na, grundsätzlich sind sie bei der Erde ein Segen, denn sonst wäre es ja viel zu kalt.

„Betrachten wir die Energiebilanz in der Atmosphäre (Stephens 2012, An update on Earth’s energy balance in light of the latest global observations). Es werden 15 % des Transports durch Konvektion, 54% durch Verdunstung und nur 32% durch Wärmestrahlung verursacht. Warum spricht man nur von den 32% und sagt zu dem Rest „die Prozesse sind vielfältig“?“.

Verstehe ich nicht. Worauf beziehen sich die Prozente? Natürlich spielt der nicht-radiative Wärmetransport eine nicht untergeordnete Rolle. Der muß auch bei dem Einfluß eines Treibhausgasanstiegs berücksichtigt werden, denn der bleibt dabei nicht konstant.

Lieber Herr k_ochs, #27

Herr Haders Aussage stimmt doch grundsätzlich, denn ohne das CO2 wäre die bodennahe Temperatur nicht so hoch, das finden Sie in jedem Planetologie-lehrbuch. Nur Ihre mit dem Durchglühen der gesamten Venus stimmt -wie ich Ihnen erklärt habe- nicht.

#24

Wie bitte?

Her Bäcker, das sollten Sie Herrn H schreiben, der doch kundtat, dass die zwischen 400-450 Grad C auf der Venusoberfläche einzig dem CO2 geschuldet sind.

MfG

Okay, ich schicke meine letzten beiden Beiträge zusammen, die nicht durchgingen. Es kann sich ja nur ein technisches Problem handeln.

Sehr geehrter Fred F. Mueller, Sie schreiben: „die Einstrahlung der „faint young sun“ war vor ca 500 Mio. Jahren etwa 4-5 % niedriger als heute. Bei heute im Mittel 160 W/m2 am Erdboden eintreffender Solarstrahlungsleistung würde dies also zwischen 6 bis 7,5 W/ m2 ausmachen. Nach den aktuellen Darstellungen bei Wikipedia würde dieser Unterschied im Strahlungsantrieb einem Temperaturunterschied von lediglich 4-5 °C entsprechen.“

Ich habe mal auf der englischsprachigen Wikipedia-Seite nachgeschaut: http://tinyurl.com/prlx84k Dort wird als climate sensitivity in Bezug auf den Strahlungsantrieb ein Wert von 0,8K/(W/qm) angegeben. Bei 6 bis 7,5 W/qm macht das 4,8-6°C aus. Vom Grundsatz stimme ich Ihnen aber zu.

„Legt man dagegen die Zahlenangaben des IPCC zur Klimasensitivität des CO2 zugrunde, dann hätten wir mit einem Temperaturanstieg von bis zu 20 °C zu rechnen. Das ist ein Unterschied von bis zum Faktor 4-5. Und die Erde hat dies gut überstanden.“

Hmm, auf diesen Wert komme ich nicht. Wenn Sie den Faktor 20 bei der CO2-Konzentration ansetzen, dann ergibt das einen Strahlungsanstieg von 5,35*ln(20)=16,0 W/qm. Das wiederum würde einen durchschnittlichen Temperaturanstieg von 0,8*16,0= 12,8 °C bedeuten. Macht also eher einen Faktor von 2 bis 2,5.

Nun gab es neben den höheren CO2-Werten auch eine andere Verteilung der Landmassen und Ozeane als heute. Das dürfte auch erheblichen Einfluss auf das Klima gehabt haben. Sprichwörtlich heiß diskutiert wird in der Wissenschaftswelt, inwieweit Vulkanausbrüche und Aerosole für eine Dämpfung auf das Klimasystem bewirkt haben. Da ist mit Sicherheit noch nicht das letzte Wort gesprochen.

„Zu behaupten, schon eine einfache Verdopplung in heutiger Zeit sei dagegen katastrophal, wie es die AGW-Vertreter tun, ist Unsinn. Vor allem, da wir von einer Verdopplung meilenweit entfernt sind.“

Ich mag auch nicht das Wort „katastrophal“, weil es eine nüchterne, sachbezogene Diskussion verhindert. Wenn aber die genannten Formeln stimmen sollten, dann bedeutet eine Verdoppelung einen Temperaturanstieg von 3°C und das ist für menschliche Gesellschaften in so kurzer Zeit eine enorme Belastung. Und so weit sind wir von einer CO2-Verdoppelung nicht entfernt, bezogen auf 280 ppm. Bei einer wachsenden CO2-Emission werden unsere Kinder noch die 560 ppm mitbekommen.

„C14-Untersuchungen nach Atomversuchen ergaben schon vor Jahrzehnten recht kurze mittlere Verweilzeiten (1 bis 10 Jahre) von CO2-Molekülen in der Atmosphäre, bevor sie im Ozean gelöst wurden. Das ist Ihnen (als Programmierer von Klimamodellen?) ganz sicherlich bekannt. Wenn dennoch soviel mehr CO2 in der Atmosphäre gemessen wird, als dem Gleichgewichtszustand entspräche, kann es eigentlich nur an einer per Saldo steigenden CO2-Emission aus den Ozeanen in die Atmosphäre liegen.“

Kurze Info, ich programmiere keine Klimamodelle. Momentan haben wir eine CO2-Emission durch Verbrennung, die umgerechnet 4 ppm pro Jahr beträgt, wovon 2 ppm innerhalb dieses Jahres in die Weltmeere gehen. Das bestätigt die These der kurzen Verweildauer. Würde es eine steigende CO2-Emission aus den Ozeanen in die Atmosphäre geben, dann müsste der CO2-Partialdruck im Wasser höher sein als in der Luft. Es ist aber genau umgedreht. Das Gas geht nicht vom niedrigen Partialdruck in den höheren Partialdruck über, sondern in die andere Richtung. Sonst würde auch unsere Atmung nicht funktionieren.

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

Sehr geehrter k_ochs, Sie schreiben: „Warum macht der Mars das nicht auch, fragte ich mich eben so, als ich Ihre Worte las..?“

Der Atmosphärendruck auf dem Mars beträgt 0,006 bar, der auf der Venus ca. 90 bar. Auch wenn beide Atmosphären fast ausschließlich aus CO2 bestehen, unterscheidet sich die Gesamtmenge (und Masse) um mehrere Zehnerpotenzen.

„Dennoch so kalt auf dem, um einiges kleineren Mars?“

Der Mars ist weiter als die Erde von der Sonne entfernt (gut 50% mehr). Entsprechend kommt nicht mal die Hälfte an Sonnenenergie dort im Vergleich zur Erde an. Am Rande bemerkt, die exzentrische Mars-Bahn spielt da auch eine Rolle. Das mit dem Albedo stimmt, auf dem Mars wird weniger zurückgestrahlt. Aber auch auf dem Mars gibt es einen Treibhauseffekt, er ist nur gering ausgeprägt. Kurzum, aus einer einzelnen physikalischen Größe kann man leider nicht die Ausprägung des Treibhauseffektes ableiten. Man braucht alle relevanten Einflussfaktoren.

„Und die Sonneneinstrahlung spielt, wenn ich Sie richtig verstanden habe, auch keine Rolle.“

Natürlich spielt es eine sehr wichtige Rolle. Wenn eine deutlich geringere Strahlungsmenge von der Sonne auftrifft und nur eine dünne Atmosphäre vorliegt, dann wird es schwierig einen stark ausgeprägten Effekt auszubilden.

MfG

S.Hader

#5 Werter Herr Hader,

warum wird dann die „Pause“ in dem letzten AR5 -Report angeführt und zugeben dafür keine Erklärung zu haben? Warum gibt es bisher über 50 Erklärungsversuche dieser „Pause“, wenn diese doch nach Ihren Worten nur durch Chery-picking existiert. Sind Sie jetzt schlauer als die ganzen AGW-Wissenschaftler. Übrigens Ihre Behauptung des chery-pickings war bei den Erklärungsversuchen auch schon dabei und ist kläglich gescheitert. Weiterhin läßt sich der Temperaturanstieg seit 1976 viel besser durch die pazifische dekadische Verschiebung 76 und die beiden El -Ninos 1986-89 und 1997/978 erklären als durch den CO2-Schwachsinn. Wenn Sie das doch widerlegen können. Herr Hader, dann schreiben sie doch eine Veröffentlichung in der Sie zeigen, daß die „Pause“ garnicht existiert.

mfG

H. Urbahn

„#22: k_ochs sagt:

#12/13

Hallo Herr Hader,

wenn ich Sie richtig verstehe „glüht“, nach Ihrer Meinung, die Venus ob des hohen atmosphärischen CO2 Anteils sozusagen „durch“..“

Da haben Sie wohl nichts korrekt verstanden.

Bei der Venus ist es wie bei jedem anderen terrestrischen Planeten unseres Sonnensystems: die oberflächennahe Temperaturverteilung der terrestrischen Planeten ist im wesentlichen durch die solare Einstrahlung, Albedo, Masse, chemische Zusammensetzung der Atmosphäre(Treibhausgase), horizontaler Wärmeadvektion und der Rotationsperiode determiniert. Der Wärmefluß in oder aus den Planeten ist hierbei untergeordnet. Ein „glühendes“ Planeteninnere ist ein „Relikt“ der Entstehungsphase und zusätzlich radioaktivem Zerfall.

Vor einigen Wochen sah ich noch eine Doku über Winston Churchill. Eines seiner bekannten Zitate war: „ich traue keiner Statistik, außer ich habe sie selber gefälscht“

Klima ist bekanntlich auch eine Statistik über Wetterdaten im Laufe von 30 Jahren. Egal ob man für oder wider diesen CO2-Klamauk ist, darin sind sich alle einig.

Klimamodelle sind nichts anderes als zufünftige Statistiken, und die „Klimaforscher“ veröffentlichen natürlich ihre Statistiken, wo die temperaturen wärmer werden, auch wenn dies nichts mit der Realität zu tun hat.

Auch die Eishockey-Schläger-Kurve wurde im Nachhinein doch noch irgendwie brauchbar verkauft (laut Wikipedia)

AUCH KLIMAFORSCHER TRAUEN NUR STATISTIKEN, DIE SIE SELBER GEFÄLSCHT HABEN.

#12/13

Hallo Herr Hader,

wenn ich Sie richtig verstehe „glüht“, nach Ihrer Meinung, die Venus ob des hohen atmosphärischen CO2 Anteils sozusagen „durch“..

Warum macht der Mars das nicht auch, fragte ich mich eben so, als ich Ihre Worte las..?

Das Gewicht der Mars Atmosphäre beträgt so 2.5 x 10^16 kg und kann also fast gleichgesetzt werden mit der Masse des CO2 dort. Die Masse des CO2 in der hiesigen Atmosphäre liegt wohl eine 10er Potenz niedriger – so 3 · 10^15 kg. Dennoch so kalt auf dem, um einiges kleineren Mars? Die Albedo dürfte ja auf dem Mars geringer denn auf Erde oder Venus sein. Und die Sonneneinstrahlung spielt, wenn ich Sie richtig verstanden habe, auch keine Rolle.

mfg

Es ist bis jetzt nur ein Gerücht, dass die Volkswagen-Software-Ingenieure auch die Software für die Klimamodellierer geliefert haben… :-))

Herr Oellien, Sie wissen doch, als Neuschwabe setze ich voll und ganz auf Open Source Klimamodelle und bezahl keinen Cent extra. Vielleicht gibt es auch was preiswertes auf dem Gebraucht-Klimamodellmarkt. Am besten was für die gesamte Familie, wo man nebenbei Spiele daddeln kann, während er rechnet. 🙂

„Da Sie ja diese Klimaprognosen“Modelle“ für so sinnvoll halten können Sie ja mein altes Auto bestimmt auch gut gebrauchen, oder?“

Okay, da ich jetzt nicht genau weiß, wie das eine mit dem anderen zusammenhängt, lächle ich einfach, sage freundlich Danke für das Angebot und lehne es mit der Begründung ab, dass so ein Auto bei mir sowieso die ganze Zeit rumstehen würde.

„Werden Sie doch endlich mal skeptisch, Klimaskeptiker gegenüber den Prognosen des PIK, IPCC .“

Warum nur skeptisch bei denen? Warum nicht auch bei EIKE, Vahrenholt usw.? Wenn schon, dann will ich lieber ein ganzheitlicher Skeptiker sein. 😉

Lieber Herr Scholzen, #17

„Die CO2-Klimaforscher konnten ja nicht mals grob vorhersagen, dass es zwischen 1999 und 2014 nicht wärmer wurde. (sagt sogar das IPCC)“

Ist aber auch nicht verwunderlich.

Sie können ja auch nicht vorhersagen, ob es am 1. Dezember schneit und friert, aber Sie wären töricht, wenn Sie aufgrund dessen Ihre Heizung rauswerfen.

@ # 12 S. Hader,

Herr Hader,

die Einstrahlung der „faint young sun“ war vor ca 500 Mio. Jahren etwa 4-5 % niedriger als heute. Bei heute im Mittel 160 W/m2 am Erdboden eintreffender Solarstrahlungsleistung würde dies also zwischen 6 bis 7,5 W/ m2 ausmachen. Nach den aktuellen Darstellungen bei Wikipedia würde dieser Unterschied im Strahlungsantrieb einem Temperaturunterschied von lediglich 4-5 °C entsprechen. Legt man dagegen die Zahlenangaben des IPCC zur Klimasensitivität des CO2 zugrunde, dann hätten wir mit einem Temperaturanstieg von bis zu 20 °C zu rechnen. Das ist ein Unterschied von bis zum Faktor 4-5. Und die Erde hat dies gut überstanden.

Damals 6.000 ppm (Faktor 20) waren mehr als genug, um den Einfluss der „faint young sun“ mehrfach zu kompensieren, ohne dass die Erde Schaden nahm. Zu behaupten, schon eine einfache Verdopplung in heutiger Zeit sei dagegen katastrophal, wie es die AGW-Vertreter tun, ist Unsinn. Vor allem, da wir von einer Verdopplung meilenweit entfernt sind.

Sie schreiben: „Der Ausgleich des CO2-Partialdruckausgleichs zwischen den Medien Wasser und Luft findet nicht mit einem Schlag statt, sondern braucht eine gewisse Zeit. Welchen Erklärungsansatz können Sie anbieten?“

C14-Untersuchungen nach Atomversuchen ergaben schon vor Jahrzehnten recht kurze mittlere Verweilzeiten (1 bis 10 Jahre) von CO2-Molekülen in der Atmosphäre, bevor sie im Ozean gelöst wurden. Das ist Ihnen (als Programmierer von Klimamodellen?) ganz sicherlich bekannt. Wenn dennoch soviel mehr CO2 in der Atmosphäre gemessen wird, als dem Gleichgewichtszustand entspräche, kann es eigentlich nur an einer per Saldo steigenden CO2-Emission aus den Ozeanen in die Atmosphäre liegen.

Mfg

#5,

„grob vorhersagen“: das ist wohl der beste Klaf, den ich seit langem über Klimamodelle vernommen habe.

Die CO2-Klimaforscher konnten ja nicht mals grob vorhersagen, dass es zwischen 1999 und 2014 nicht wärmer wurde. (sagt sogar das IPCC)

CO2 + Supercomputer + Kaffeesatzlesen = Klimamodell

@Es Hader #14

Zitat:

—–

Dort handelt es sich um eine Temperaturrekonstruktion aus verschiedenen Messdaten.

—–

Nur dass es sich bei den s. g. „Messdaten“ größtenteils um zweifelhafte Proxies handelt…

Guten morgen Herr S.Hader.

Ich sehe schon, man kann Ihnen nichts vormachen, Sie sind einfach mit allen Wassern gewaschen, und Sie lassen sich einfach nicht übers Ohr hauen.

Sie würden gerissen und gewiwt wie Sie sind einfach immer wieder diese teureren „Klimamodelle“ immer wieder kaufen, stimmts?

Für welche Variante haben Sie sich den dieses Jahr entschieden?

Und für welche Variante entscheiden Sie sich den nächstes Jahr?

Darf ich Ihnen auch eine Klimaprognose geben? Ist ganz umsonst, ich arbeite eine für Sie aus ok! 😉

Da Sie als Steuerzahler es nicht so wichtig halten wo für Ihre Steuern so verwendet werden mach ich Ihnen ein einmaliges Angebot, ich gebe Ihnen mein Altes Auto hat nur 400 000 KM gelaufen und die Heckscheibe ist nun auch nicht mehr so ganz heile, ach und der Kühler ist auch ausgebaut, gebe ich Ihnen zum einmaligen Angebot von 1000 € .

Da Sie ja diese Klimaprognosen“Modelle“ für so sinnvoll halten können Sie ja mein altes Auto bestimmt auch gut gebrauchen, oder?

Wachen Sie endlich mal auf und seien Sie Realist, Klimarealist.

Werden Sie doch endlich mal skeptisch, Klimaskeptiker gegenüber den Prognosen des PIK, IPCC .

Mit freundlichen grüßen.

#11: „ALLE COMPUTERMODELLE ZUR KLIMABERECHNUNG SIND SCHROTT-PROGRAMME, weil sie absolut nix relles konnten und können.“

Sehr geehrter Herr Scholzen, selbst wenn es bis heute kein einziges Computermodell über das Klima gebe, würde Ihnen die Wissenschaft die Aussagen aus #5 bestätigen. Es gibt eine Reihe von Einflussgrößen auf das Klima, das weiß man auch ohne Modelle. Und welches Klima wir in der Zukunft haben werden, hängt entscheidend vom Verlauf dieser Größen ab, aber beim CO2 (oder Methan) kann Ihnen niemand genau sagen, wie viel wir 2050 oder 2100 in der Luft haben werden.

„Bestes Beispiel war wohl die „Hockey-Schläger-Kurve“ aus den späten 1990er Jahren“

Dort handelt es sich um eine Temperaturrekonstruktion aus verschiedenen Messdaten. Mit Klimasimulation hat das nix zu tun.

„Sehr viel mehr CO2 sollte auch einen dramatischen Ansprung der Temperaturen hervorbringen… “

Ich fürchte, da verwechseln Sie was. Diese Studie beschäftigte sich nicht mit dem CO2-Gehalt und trifft auch keine Vorhersage über die Zukunft.

Sehr geehrter Herr Endres, Sie schreiben: „Solange es keinen experimentellen Beweis für einen Einfluss von CO2 auf das Erdklima gibt, sind alle Computer-Simulationen reine Spekulation.“

Wenn es Ihnen nur um den Nachweis einer Einflussnahme des CO2 auf ein plantares Klima geht, dann nehmen Sie die Venus. Das Argument dürfte für Sie bestimmt nicht neu sein. 😉 Wenn Sie eine realistische Erklärung für die hohen Temperaturen auf der Venusoberfläche im Verhältnis zur Sonneneinstrahlung und dem Albedo haben, die nicht auf den CO2-Gehalt beruht, dann immer her damit.

„Bitte nicht auf die Venus verweisen.“

Oh doch. 🙂

„Von der Venus weiß man so wenig, dass Interpretationen m.E. nahe an der Spekulation sind.“

Natürlich weiß man von der Venus eine Menge, so dass man verschiedene Thesen schnell ausschließen kann. Die Erkenntnisse über die Venus sind schon wesentlich weiter im Vergleich zu den letzten 20 Jahren. Gibt es nicht sogar Kooperationen der TU Clausthal-Zellerfeld mit dem Institut für Planetenforschung am DLR? Die könnten bestimmt weiterhelfen.

@Fred F. Mueller,#7: „Das mit dem Delta stimmt allerdings nicht nur für die Zukunft, sondern auch für die Vergangenheit. Vor ca. 500 Mio. Jahren hatten wir rund 6.000 ppm in der Atmosphäre, seitdem ist der Wert bis auf ca. 300 ppm (1 Zwanzigstel!) abgesunken, und wir hatten in diesem langen Zeitraum alle Klimaausprägungen, die man sich nur denken kann.“

In diesen 500 Millionen Jahren haben sich noch einige andere relevante Eingangsgrößen geändert, als erstes die Sonnenaktivität (early faint sun) zu nennen, aber auch die geänderte Anordnung der Landmassen hatte erheblichen Einfluss. Auch wenn beim CO2 das Zahlenverhältnis 1:20 beträgt, auf der logarithmischen Skala bedeutet es „nur“ etwas mehr als die vierfache Verdopplung.

„Jetzt stimmt man ein riesiges Gejammer wegen einer Erhöhung um ein Drittel an! Vergessen Sie Ihr Delta.“

Die Erhöhung von 280 auf 400 ppm ist vergleichsweise harmlos. Schon wesentlich anders sieht es bei Werten von 600 oder mehr ppm, also dem gut doppelten Wert.

„Die AGW-Anhänger können ja noch nicht einmal erklären, wieso das CO2 nicht stracks in die Ozeane marschiert, wo es nach den üblichen Gesetzen der physikalischen Chemie eigentlich landen sollte (und über kurz oder lang auch wird).“

Der Ausgleich des CO2-Partialdruckausgleichs zwischen den Medien Wasser und Luft findet nicht mit einem Schlag statt, sondern braucht eine gewisse Zeit. Welchen Erklärungsansatz können Sie anbieten?

#5, S.Hader,

Nehmen Sie zur Kenntnis:

ALLE COMPUTERMODELLE ZUR KLIMABERECHNUNG SIND SCHROTT-PROGRAMME, weil sie absolut nix relles konnten und können.

Bestes Beispiel war wohl die „Hockey-Schläger-Kurve“ aus den späten 1990er Jahren: Sehr viel mehr CO2 sollte auch einen dramatischen Ansprung der Temperaturen hervorbringen… was ist passiert? Nichts spektakuläres. Und man könnte noch viel mehr aufzählen.

Wenn ein Simu‘-Programm die Realität nicht nachbilden kann, dann hat es keinen Zweck, basta.

Für so ‚en Schrott bezahlt man kein Geld.

Bitte im Denken die Ideologie ausschalten, und Hirn auf Marktwirtschaft und Realität eichen. Danke.

@ #8 F.Endres

„… in 30 Jahren wären die Ressourcen vollständig verbraucht.“

Das wird schon seit den 60ern vom sog. Club of Rome behauptet.

Stimmt allerdings bzgl. der Ressource fruchtbares Land und Wälder. Da wo die sozialistische Planwirtschaft herrscht werden die Güter knapp. Deshalb wollten die Saharastaaten ja auch nicht den Sozialismus. Der Sand wäre knapp geworden. Bei uns wird der Strom demnächst knapp.

#5: Herr S.Hader auch bei dem „Schmetterlingszitat“ geht es nur um ein Gedankenmodell, das die (chaotische) Indeterminiertheit = Unberechenbarkeit beschreiben soll, die langfristige Wettervorhersage unmöglich macht.

Wetter ist nichts anderes als ein kleiner Zeitausschnit von Klima.

#5, #6: Herr Hader, Sie gehen davon aus, dass CO2 wärmt und zum „gefürchteten“ anthropogenen Treibhauseffekt führt. So weit ich Ihre Beiträge verfolgt habe (habe noch andere Dinge zu tun), kommen Sie wohl immer und immer wieder mit diesem Argument, oder stellen Fragen, die zu nichts oder in eine Sackgasse führen. Solange es keinen experimentellen Beweis für einen Einfluss von CO2 auf das Erdklima gibt, sind alle Computer-Simulationen reine Spekulation. Ich sage nicht, dass die Klima-Programmierer ihr Handwerk nicht verstehen, nur kann kein anderes Ergebnis erhalten werden, wenn man die Modelle mit der Annahme füttert, eine Verdopplung der CO2-Konzentration führt zu x Grad Erwärmung.

Da wir das jeden und jeden Tag in allen Zeitungen und auf allen Kanälen sehen und hören, frage ich mich, warum man diese Institute nicht einfach schließt. Wenn „the science settled“ ist, braucht man ja auch nicht mehr weiter forschen. Der Erkenntnisgewinn wird sich in diesem Falle asymptotisch einem Grenzwert nähern.

Man muss immense Ressourcen einsetzen, um überhaupt noch etwas Neues zu finden, wenn „the science settled“ ist. Mit anderen Worten, das hat nun nichts mehr mit Wissenschaft zu tun, sondern ist nur noch astreine und angstmachende Politik. Die Medien schaffen es sicher auch alleine, die „Klimakatastrophe“ am Leben zu halten, die ganze Medienlandschaft ist ja mehr oder weniger grün.

Und ich habe noch niemanden kennengelernt, der eine Idee hat, wie man ein Experiment aufbauen kann, das alleine den THE beweist, und zwar ohne jeglichen Zweifel. Wie Prof. Gerlich (R.I.P.) schön dargelegt hat, gehen alle Annahmen zum THE auf Ergebnisse des 19. Jahrhunderts zurück. Bitte nicht auf die Venus verweisen. Von der Venus weiß man so wenig, dass Interpretationen m.E. nahe an der Spekulation sind. Geschickt ist das alles schon, denn selbst wenn der Erde nun eine Abkühlung widerfahren sollte, können die AGW-Protagonisten wunderbar mit der stärkeren (als erwarteten) internen Variabilität argumentieren, und die katastrophale Erwärmung in die nahe oder mittlere Zukunft verlegen.

Das politische Ergebnis wäre sowieso dasselbe: Wenn sich die Erde abkühlen sollte, müssen die Deutschen eben noch mehr Energie sparen, denn die Ressourcen sind ja bald verbraucht. Am Freitag verschlug es mir beinahe die Sprache, als ein Master-Student mir beängstigt sagte, dass wir JETZT etwas tun müssen, weil sie in der Schule und von einigen „lieben Kollegen“ gehört haben, in 30 Jahren wären die Ressourcen vollständig verbraucht. Ich werde demnächst eine Art „Gegen-Vorlesung“ halten und den Studierenden ihre Ängste nehmen.

Gegen Energieforschung habe ich nach wie vor nicht das geringste einzuwenden, mache ich selber. Ca. 95% der eingeschlagenen Wege in der Forschung werden sich sowieso als Irrwege erweisen. Das war schon immer so, und wird sich auch dann nicht ändern, wenn der grüne Leitgedanke die Forschungsthemen vorgibt.

@ # 5 S. Hader

Herr Hader,

sie schreiben: „Das ist es nach wie vor, CO2 ist ein Faktor von vielen. Da können Sie jeden Klimawissenschaftler fragen. Aber es wird wahrscheinlich der Faktor mit dem größten Delta für die kommenden Jahrzehnten sein und das ist eben das Problem“.

Das mit dem Delta stimmt allerdings nicht nur für die Zukunft, sondern auch für die Vergangenheit. Vor ca. 500 Mio. Jahren hatten wir rund 6.000 ppm in der Atmosphäre, seitdem ist der Wert bis auf ca. 300 ppm (1 Zwanzigstel!) abgesunken, und wir hatten in diesem langen Zeitraum alle Klimaausprägungen, die man sich nur denken kann.

Jetzt stimmt man ein riesiges Gejammer wegen einer Erhöhung um ein Drittel an! Vergessen Sie Ihr Delta.

Die AGW-Anhänger können ja noch nicht einmal erklären, wieso das CO2 nicht stracks in die Ozeane marschiert, wo es nach den üblichen Gesetzen der physikalischen Chemie eigentlich landen sollte (und über kurz oder lang auch wird).

Mfg

P.S.: „Zitat aus der damaligen Sendung „Müsste man alle Luftzirkulationen berücksichtigen, dann würde gar EIN FLÜGELSCHLAG EINES SCHMETTERLINGS GENÜGEN, UM EINEN ORKAN auszulösen““

Ja, einen Orkan auslösen. Aber eben keinen Klimawandel. Das ist der wesentliche Unterschied zwischen Wetter und Klima.

Sehr geehrter Guido Scholzen, ein Prognose können Sie nur dann machen, wenn Sie die wesentlichen Eingangsgrößen für die Zukunft kennen. Und die wissen wir beim Klima nicht. Es ist nicht klar, wie viel CO2 wir 2050 oder 2100 in der Atmosphäre haben werden, weil es von unserem Handeln abhängt, dasselbe gilt auch für Methan und man weiß nicht genau, wie die Sonne drauf sein wird. Deshalb werden statt Prognosen Szenarien berechnet, die genau diese Eingangsgrößen vorher festlegen.

„1. Niemand legte sich konsequenter weise fest, dass es allgemein auf Erden wärmer wird, denn es gibt nicht nur 1 Klima auf Erden, sondern verschiedene Klimazonen.“

Was hat sich zu heute geändert? Sollte durch ein Wunder der CO2-Gehalt konstant bleiben oder sogar abnehmen, dann kann es sehr wohl passieren, dass es auch wieder langfristig kälter wird. Aber auch bei wahrscheinlichen Szenarien wird es so sein, dass der Temperaturanstieg regional anders sein wird, das simulieren auch die Klimamodelle. Die globale Temperatur ist ein skalarer Wert, der den Gesamtzustand auf eine einzige Zahl reduziert. Sie können die heranziehen, oder die Details aus den verschiedenen Klimazonen. Ich sehe da keinen unterschied zu früheren Simulationen.

„2. CO2 war NUR EIN FAKTOR unter vielen andern (zb. Abholzung der Urwälder, Verstädterung, Nutzung von Agrarflächen, Vulkanausbrüche [Pinatubo war aktuell]…), CO2 war nicht DER Faktor schlechthin.“

Das ist es nach wie vor, CO2 ist ein Faktor von vielen. Da können Sie jeden Klimawissenschaftler fragen. Aber es wird wahrscheinlich der Faktor mit dem größten Delta für die kommenden Jahrzehnten sein und das ist eben das Problem.

„Dass es seit 1999 nicht mehr wärmer wurde, hat keiner vorhergesagt.“

Es ist ja wärmer geworden. Klar, wenn man sich natürlich den Datensatz herauspickt, der in diesem Zeitraum die geringsten Anstieg aufweist und alle anderen ignoriert, kann man getrost bei seiner Meinung bleiben.

„Das Klima errechnen, ist eine Utopie.“

Es ist zumindest keine Utopie, die wichtigsten Einflussgrößen zu identifizieren und grob vorherzusagen, was bei einer Änderung dieser Größen passieren wird. Dazu braucht man nicht mal Computermodelle.

MfG

S.Hader

zu #3,

wollte noch hinzufügen:

In jeder Computersimulation kann man vorne eintippen, was hinten rauskommen soll.

ich kann auch ein Programm schreiben, wo ich eintippe „1 + 1“, und das Ergebnis ist 1 oder 2 oder 3, so wie es mir gefällt. Computer machen keine Fehler, nur der programmierende Mensch. (=manipulierender Mensch)

Klimaforscher könnten auch zu den Walt-Disney-Studios gehen, und den Zeichnern dort vorschlagen, mal einen Trickfilm über Klimaerwärmung zu zeichnen.

Das sind Klimasimulationen wert: an sich nichts, nur Propaganda.

Da ich in den 1980er Jahren ein Computer-Freak war und mich allgemein für Wissenschaften interessiere, geriet ich über die Informatik zum Thema „Klimawandel“. Oder besser gesagt, was verschiedene „Wissenschaftler“ darunter verstehen.

Schon in den 1980er waren es Automobil-Konzerne, die gezielt Computersimulationen heranzogen, um die Realität „nachzurechnen. So entstanden Arbeiten an Cray-Super-Computern (heutzutage hat ein normaler Aldi-PC mehr Power), die eindrucksvoll demonstrierten, dass man die Wirklichkeit auch wirklich nachrechnen kann. Allererste Arbeiten simulierten Crashs von Automobilen, die nachher so real waren, dass man Prototypen kollidieren lassen konnte, ohne auch nur einen reellen Dummy dafür zu verschleißen. Ähnliches Großartiges brachte man auch in der Automobilindustrie zustande, als man Simulationen entwarf, die zeigten, wie Brennstoff in einen Motor verbennt.

Das US-Militär machte Anfang der 1990er jahre die letzten unterirdischen Atombombentests, denn danach wurden nur noch Simulationen verwendet, um Auswirkungen von nuklearen Detonationen zu errechnen. Alle diese Simulationen haben eines gemeinsam: Man braucht entsprechend Rechen-Power, denn diese Programme arbeiten mit Millionen von variablen und Parametern, die geändert werden können, um ein BRAUCHBARES ERGEBNIS liefern. Ich verlasse mich darauf, dass die Auto-Konzerne (auch Raumfahrt und Flugzeugtechnik) richtig gute Simulationsprogramme haben, denn sonst hätten die die schon längst über den Haufen geworfen. Das selbe gilt für das US-Militär, denn wenn die Atombomben-Simu’s nicht funktionieren würden, dann würden die alle paar jahre unterirdische Explosionen machen; die lassen sich nichts verbieten.

Doch was ist eine Computersimulation in Sachen Klima wert?

Wie geschrieben werden Simulationen gebraucht, um die Realität nachzustellen und um Kosten einzusparen. Doch beides ist in Sachen Klimaforschung nicht der Fall.

Die ersten richtigen Berichte über derlei sah ich Anfang der 1990er bei der sonntäglichen Wissenschaftssendung „Sonde“ im Südwest-3. Da sah man etwas, was heute keiner mehr wahrhaben will. Es gab damals schon mindestens 5 verschiedene „Szenarien“, denn an „Prognosen“ trauten sich damals nicht alle heran.

In einer Sendung wurde da Thema „Klima“ behandelt. Dort präsentierte man verschiedene Szenarien. Eine zeigte, wie es wärmer wurde; eine andere, wie es kälter wurde (am Südpol sollte es mehr schneien); eine andere sah vor, wie sich Klimazonen verschoben, die einen wurden wärmer, andere wiederum kälter …etc…

Aber eines war auch anders als heute.

1. Niemand legte sich konsequenter weise fest, dass es allgemein auf Erden wärmer wird, denn es gibt nicht nur 1 Klima auf Erden, sondern verschiedene Klimazonen.

2. CO2 war NUR EIN FAKTOR unter vielen andern (zb. Abholzung der Urwälder, Verstädterung, Nutzung von Agrarflächen, Vulkanausbrüche [Pinatubo war aktuell]…), CO2 war nicht DER Faktor schlechthin.

Dass es seit 1999 nicht mehr wärmer wurde, hat keiner vorhergesagt. Da diese Programme die Realität nicht nachstellen können, kann man die ruhig in die Mülltonne klopfen. Vor Jahrzehnten hatte man Programme mit Millionen von Parametern und Variabeln. Klimamodelle haben aber Milliarden und aber Billionen Unbekannte, die sich PERMANENT ändern. Kein Computer der Zukunft kann so schnell und vor allem flexibel reagieren, um sowas zu errechnen. Das Klima errechnen, ist eine Utopie.

In den 1980 sah ich eine Folge von „Aus Forschung und Technik“ mit Joachim Bublath über „Chaos-Forschung“ (das Informatik-Thema in den 1980er) und das Wetter ist Chaos. Zitat aus der damaligen Sendung „Müsste man alle Luftzirkulationen berücksichtigen, dann würde gar EIN FLÜGELSCHLAG EINES SCHMETTERLINGS GENÜGEN, UM EINEN ORKAN auszulösen“

Es gibt kein Computerprogramm, das alle Unbekannten derlei Größenordnungen berücksichtigen kann. Darum kann man auch das Wetter nur wenige tage voraussagen, auf Ungefähr.

Aber eigentlich ist es gut, dass es diese Klima-Simulationen gibt, dann haben die Supercomputer wenigtens was zu tun. Klima-berechnen ist doch interessanter als Schach-Spielen oder Auto-Crashs, nicht wahr liebe Informatiker an den Klimazentralen… 😉

In der neusten Ausgabe des Spiegel hat ein gewisser Horan Knaub den Artikel „Klima Basar“ geschrieben. Soviel gequirlter Unsinn auf einem Haufen war selbst in dem traditionel AGW freundlichen Spiegel bisher nicht zu finden. Der gute Mann befürchtet, dass der Klimagipfel in Paris kein Erfolg wird und feuert zur Unterstützung noch eine volle Breitseite aller

bisher schon x- mal widerlegten Klimalügen ab.

Herr Frey, das funktioniert nicht, weil die Medien ideologisch bedingt, nicht interessiert sind, die Bürger zu informieren. Es muss erst einen Crash geben und dann will keiner davon gewusst haben. Das hatten wir schon einmal und endete vor 70 Jahren.

Danke bei dieser Gelegenheit für Ihre Übersetzungen!