Dass NASA-GISS die Temperaturdaten rückwirkend ändert, war nach dem EIKE-Bericht von Steven Goddard (26.01.2012) zu vermuten, denn wie berichtet wurde, hatte NASA-GISS die Temperaturganglinien von Reykjavik und Godthab Nuuk rückwirkend geändert, und danach sollte es in der Arktis wärmer werden.

Temperaturdaten sind Dokumente. Der Verdacht rückwirkend geänderter Temperaturdaten erforderte eine Untersuchung, um den Verdacht entweder zu widerlegen oder zu bestätigen. Eine Analyse war möglich, weil die 2010 von NASA-GISS angebotenen Temperaturdaten damals archiviert worden waren und nun mit den 2012 von NASA-GISS angebotenen Daten verglichen werden konnten. Da eine Veränderung von Temperaturdaten im Sinne der Initiatoren nur dann zweckmäßig war, wenn sie nicht nur die Arktis sondern die ganze Welt beträfe, musste die Untersuchung die 2010- und 2012-Daten von möglichst vielen Stationen miteinander vergleichen. Dafür wurden nach dem Zufallsprinzip 120 Stationen weltweit festgelegt. Der Vergleich hat den Goddard-Bericht bestätigt und zeigt, dass diese Veränderungen in allen 120 Stationen vorgenommen worden sind. Sie täuschen eine größere Erwärmung vor. Auch wenn der Nachweis jetzt nur für 120 Stationen erbracht werden konnte, ist anzunehmen, dass die rückwirkenden Änderungen auch alle anderen Stationen weltweit betreffen. Das Ergebnis der Analyse wird in [1] behandelt. Eine Kopie der Arbeit ist im Anhang beigefügt, hier werden die wesentlichen Ergebnisse zusammengefasst:

Die Analyse hat ergeben, dass man bei den Veränderungen fallweise eine unterschiedliche Methodik angewendet hat. Um den Eindruck von einer erheblichen und fortschreitenden Erwärmung zu erzielen, wurden mehrere Methoden angewendet, nämlich:

· eine Absenkung der Jahresmittelwerte in der Anfangsphase,

· eine Verringerung einzelner höherer Werte in der ersten Warmphase,

· eine Erhöhung einzelner Werte in der zweiten Warmphase,

· eine Unterdrückung der um 1995 beginnenden zweiten Abkühlungsphase,

· eine Änderung der Temperaturskala je nach ausgewählter Methode, und

· eine Verkürzung der Datenreihe um die frühen Jahrzehnte.

· Bei den Langzeitreihen wurden Datenreihen sogar um die frühen Jahrhunderte gekürzt. .

Infolge der individuellen Gegebenheiten und Änderungsmethoden ergeben sich für die Klassifizierung der Ganglinien-Paare der 2010- und 2012-Daten 10 unterschiedliche Gruppen. Da in [1] aus Platzgründen nur die Ganglinien-Paare der Gruppen 1, 3, 4 und 7 mit jeweils nur einem Beispiel dargestellt werden konnten, werden hier in einer separaten Datei die Ganglinien-Paare aller 120 Stationen beigefügt [2].

Die 2010-Daten ergaben 91 Erwärmungen und 29 Abkühlungen mit einer durchschnittlichen Erwärmung von 0,0051°C/a, die 2012-Daten täuschen mit 108 Erwärmungen und 12 Abkühlungen eine durchschnittliche Erwärmung von 0,0093°C/a vor. Die Änderungen der 2012-Daten haben die durchschnittliche Erwärmung der 120 Stationen also fast verdoppelt.

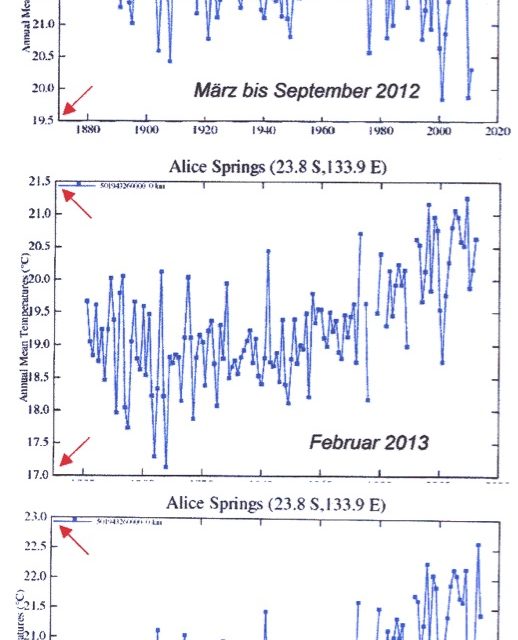

Während der Auswertung der Daten und der Erarbeitung des Manuskriptes wurden bis März 2013 aus dem Internetportal von NASA-GISS wiederholt die Daten und Ganglinien einzelner Stationen abgefragt. Es zeigte sich, dass auch später weitere Änderungen vorgenommen wurden. Das in [1] Abb. 19 benutzte Beispiel der Station Alice Springs wurde hier um die heute von NASA-GISS angebotene Version ergänzt (hier Abb.1). Um zu erkennen, dass – und wie sehr – sie sich auch wieder von den Vorgängerversionen unterscheidet, wurden die Eckpunkte der Temperaturskala mit roten Pfeilen versehen. Es ist wahrscheinlich, dass Änderungen immer noch und auch mit den Datensätzen anderer Stationen vorgenommen werden.

“The GISS analysis uses only GISS homogeneity adjusted data” [1]. Es ist hier nicht zu diskutieren, ob und wie weit ‚Homogenisierung’ als zweckgerichtete Anpassung von Temperaturmessungen wissenschaftlich vertretbar ist. Es sollte gelten, dass die Botschaft der Daten nicht verändert werden darf. Jedoch genau das bewirken die hier behandelten Änderungen. Es ist nicht akzeptabel, dass Ganglinien

· durch das Verkleinern oder Vergrößern der gemessenen Temperaturen in ihr Gegenteil umgewandelt werden, um damit statt der gemessenen Abkühlung eine Erwärmung oder statt der gemessenen Erwärmung eine Abkühlung zu erhalten,

· durch das Löschen von Daten in ihr Gegenteil verkehrt werden, um eine noch stärkere Abkühlung oder Erwärmung zu erhalten,

· durch das Verkleinern oder Vergrößern der gemessenen Temperaturen ausgewählter Abschnitte eine größere Erwärmung oder eine größere Abkühlung erhalten,

· durch Löschen von Daten unterbrochen werden, um „passende“ Übergänge zu verstecken.

Zum Schluss bleibt die Frage „Warum werden Dokumente verändert“? Dem Autor bleibt als Antwort nur eine Vermutung: Nach dem offiziellen Klimapostulat soll die Erwärmung durch die anthropogenen CO2-Emissionen verursacht werden. Die wirkliche Temperaturentwicklung widerlegt dieses Annahme: Im 20. Jh. gab es zwei Warmphasen. Die erste zwischen 1920 und 1950 war die deutlich stärkere, kann aber nicht durch die CO2-Emissionen verursacht worden sein, denn die begannen erst nach 1950 (siehe Abb. 20 und 21 in [1]),. Die zweite Warmphase zwischen 1980 und 1995 war erheblich schwächer. Indem man nun mit den Änderungen die erste Warmphase abschwächt und die zweite Warmphase verstärkt, verringert man den Gegensatz zwischen der vorgetäuschten Temperaturentwicklung und dem offiziellen Klimapostulat. Vermutlich hat man die praktische Bedeutung dieses Gegensatzes nicht früh genug realisiert und versucht nun, ihn mit den Änderungen zu verschleiern. Es erschien wohl unwahrscheinlich, dass dies entdeckt werden könnte, denn dies setzte voraus, dass jemand die 2010-Daten archiviert hatte und zwei Jahre später auch noch den Gegensatz zu den 2012-Daten erkannte. Warum werden dann aber immer noch Veränderungen vorgenommen? Vielleicht soll ein automatisches Programm auch dafür sorgen, das die von NASA-GISS angebotenen Daten im Falle abweichender Messwerte immer die gewünschte Erwärmung anzeigen.

Nachtrag

: http://data.giss.nasa.gov/gistemp/updates_v3/ bzw. http://data.giss.nasa.gov/gistemp

Am 15. und 16.2. publizierte NASA-GISS die mit den Links erreichbaren Berichte. Sie sollen begründen dass, wann, wie und warum Änderungen, Löschungen und Homogenisierungen vorgenommen wurden – bzw. werden. Vielleicht ist man durch den Beitrag von Christopher Booker im The Telegraph (07.02.2015) aufmerksam geworden und liefert jetzt Erklärungen nach. EIKE übernahm den Beitrag in deutscher Übersetzung am 12.2.

Aber: Alle ‚Begründungen’ entschuldigen nicht, warum alte, jahrzehntelange Datenreihen eliminiert oder geändert wurden, ja, dass sogar Abkühlungen in Erwärmungen umfunktioniert worden sind. Wären tatsächlich nur ‚Homogenisierungen’ beabsichtigt, müssten sich Erwärmungen und Abkühlungen ungefähr ausgleichen. Das Gegenteil ist der Fall – siehe oben. In der Eile wird übersehen, dass solche Erklärungen eine Bankrott-Erklärung für das Mess-System und die Verwaltung der Daten sind.

Als Anlagen beigefügt:

[1] Ewert F-K: „NASA-GISS ändern rückwirkend Temperaturdaten – warum ?“. Mitteilungen der Wilhelm-Ostwald-Gesellschaft, 19 Jg., 2014, Heft 2, S, 10-41, 17 Abb., 7, Tab. 2 Tafeln.

[2] zitiert in [1] als Anlage 2: „Vergleich Temperaturganglinien aller 120 Beispiele nach der Art ihrer Veränderungen klassifiziert in Gruppen“

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"@ #6 M. Müller

„wenn sich die Input-Daten ändern“

Außer der Korrektur offensichtlicher Fehler ist die Veränderung von Original(meß)daten unzulässig. Offensichtliche Fehler können dadurch entstehen, daß das Meßistrument ausgetauscht wird und/oder nach einem anderen Prinzip funktioniert (Widerstandsthermometer). Und natürlich können die Meßwerte an eine Referenzstation angeglichen werden, so geschehen während der Expedition GATE, wo die Meßboje (Meteorologisches Institut der Uni HH) und die Meteor die Referenzstationen waren, so daß die anderen Schiffe nach Ende der Meßkampagne sich mit der Meteor trafen … .

Wenn dann aggregierte Daten „angepaßt“ (an was eigentlich?) werden, ist das schlichtweg Schmu, denn an Land gibt es keine Referenzstationen (incl. Umgebung), die man mal eben so woanders hin transportieren kann. Ist eine Station falsch aufgestellt, z.B. die Meßhütte auf einem Parkplatz, neben dem offenen Wassertank einer Kläranlage etc., sind die Messungen generell unbrauchbar.

„… versucht nun, ihn mit den Änderungen zu verschleiern. Es erschien wohl unwahrscheinlich, dass dies entdeckt werden könnte, denn dies setzte voraus, dass jemand die 2010-Daten archiviert hatte und zwei Jahre später auch noch den Gegensatz zu den 2012-Daten erkannte.“

Folgt man der URL, die ich in #6 angegeben hatte, findet man ein Diagramm, dass die Unterschiede zwischen vor/nach 2012 anschaulich darstellt (http://goo.gl/LTXxpl „GISS Surface Temperature Analysis, Updates to Analysis: GHCN-M V3 vs. V2“). Dort sieht man das, was auch Herr Ewert beschreibt: Es gibt Stationen, die nach dem Update einen positiveren Trend aufweisen, aber auch Stationen die einen geringeren Trend ausweisen (die hier im Artikel nicht diskutierten Gruppen 5-9 aus dem zweiten verlinkten Dokument). Wenn GISS das auf der eigenen Webseite dokumentiert, wie kommt es dann zu der Aussage, man wolle diese Änderungen verstecken und hofft, dass das nicht bemerkt wird?

„Zum Schluss bleibt die Frage „Warum werden Dokumente verändert“? Dem Autor bleibt als Antwort nur eine Vermutung: Nach dem offiziellen Klimapostulat soll die Erwärmung durch die anthropogenen CO2-Emissionen verursacht werden.“

Als der Wechsel von GHCN-V2 nach V3 erfolgte, wurde das eigentlich (zumindest in den englischsprachigen Blogs) ausführlich diskutiert. Es wurden die Temperaturkurven der V2 und V3 verglichen, die Stationsanzahl (die bei V3 wieder größer ist), … GISS diskutiert auch die Konsequenzen auf der eigenen Webseite … Sind diese Informationen Herrn Ewert nicht bekannt? Oder warum muss er über die Ursachen spekulieren?

Unsere Klimatologen sind die besten der Welt. Es ist strengstens verboten, an deren Kompetenz zu zweifeln. Es ist den Klimaleugnern untersagt, den Maßstab ihrer beschränkten Einsicht an die Handlungen der Klimamodellierer zu legen. Messen und Experimentieren gehören der Vergangenheit an und ist etwas für Rückwärtsgewandte. Wissenschaftler, die mit der Zeit gehen, modellieren, adjustieren und glätten so lange, bis sich ein Anstieg zeigt.

Unsere Klimatologen kennen bereits das Klima der Zukunft ganz genau. Beim Klima der Vergangenheit ist man sich noch nicht ganz sicher. Aber wer das Klima der Vergangenheit beherrscht, der beherrscht auch das Klima der Zukunft.

„Am 15. und 16.2. publizierte NASA-GISS die mit den Links erreichbaren Berichte. Sie sollen begründen dass, wann, wie und warum Änderungen, Löschungen und Homogenisierungen vorgenommen wurden – bzw. werden. Vielleicht ist man durch den Beitrag von Christopher Booker im The Telegraph (07.02.2015) aufmerksam geworden und liefert jetzt Erklärungen nach. “

Die updates_v3-Webseite gibt es, seit es GHCN v3 gibt, wie man leicht im Webarchive sehen kann. Die wurde also nicht erst extra angelegt. Was ergänzt wurde, war eine Anmerkung nach dem Veröffentlichen des Booker-Artikels.

Liest man den Text stolpert man eingentlich unweigerlich über die dazu gehörende FAQ: „Why are some current station records different from what was shown before 2012?“ (Warum unterscheiden sich einige aktuelle Stationsdaten von denen, die vor 2012 gezeigt wurden? http://goo.gl/re5ITw). Die Kurzversion ist: Es gab einen Wechsel von GHCN Version 2 auf Version 3.2 als Ausgangspunkt der GISS-Analyse. Da GISS nur die Ergebnisse der eigenen Analysen zeigt, sehen die natürlich anders aus, wenn sich die Input-Daten ändern. Genaueres kann man in der längeren FAQ lesen.

@ #4 R. Steppan

Nachdem unsereins aus den Rohdaten der NOAA (COOP-Daten 3200) die offensichtlichen Fehler eliminiert hat, zeigt sich, daß östlich des 102ten Längengrades die arithmetische Mitteltemperatur aus TMIN und TMAX in den 30er Jahren höher war, als in den ersten 10 Jahren des 3. Jahrtausends.

Desweiteren zeigt sich bei einem Vergleich benachbarter Stationen, daß ein Ersatz fehlender Messungen durch vorhandene der Nachbarstation zu Abweichungen führt.

Man lese hierzu die vorliegende Beschreibung zur Fehlerkennzeichnung in den COOP-Daten. Man kann auch anhand der Stationsgeschichte, mit Koordinaten und Höhenangaben! (oberhalb des Flußtals oder mittendrin bringt massive Abweichungen; mitten im Ort, in Luv oder Lee oder im Wald!) die Temperatursprünge nachvollziehen, die zu korrigieren wären, wenn man eine einheitliche Temperaturreihe konstruieren will.

Je nach Konstruktion des Korrekturalgorythmus kann man manipulieren. Und das scheinen die Herrschaften gemacht zu haben.

Warum wohl? Weil sie nicht so passen. Die Vergangenheit wird geglättet und ggf auch etwas nach unten gedrückt und die Gegenwart wird aufgepumpt. Homogenisierungen gehen wohl zu 100% in eben diese Richtungen, die die Religion unterstützt. Die IPCC-Sekte sind die „Klimaleugner“ der Vergangenheit.

Um es noch einmal deutlich zu sagen: Es gibt keine Weltmitteltemperatur, errechnet aus Gleichgewichtstemperaturen gemessen an verschiedenen Orten auf der Welt (soweit es überhaupt Daten gibt). Das gilt auch für die sogenannten Anomalien.

mfG

Es zeigt doch nur wieder, dass es gar nicht, um die Sache geht, sondern darum eine neue Weltordnung aufzubauen. Die Kirche der Klimaangst braucht heute Daten, um zu zeigen, wie böse wir sind und schrckt auch nicht davor zurück, Daten zu fälschen. Das machen allen Diktaturen und auch alle aggressiven Religionsgemeinschaften. Wenn etwas nicht passt, wird es passend gemacht und die Ketzer verbrannt.

Wir bewegen uns langsam immer schneller zu „1983“ hin. Neusprech etc. Oder zurück ins finstere Mittelalter, wo die Kirche der Gnade, ohne Gnade die Menschen knechtete. Unsere neue grüne Kirche heißt IPCC.

Und Frau Meinhardt, nein, es ist kein Generallangriff auf Ihre geliebte Kirche.

sie sollten langsam verstehen, was man unter der Homogenisierung von T Reihen versteht.

Wenn sie eine Station hernehmen, müssen sie deren Historie kennen. Wann wurde wie gemessen?

Sprich, gab es Änderungen der Instrumente, der Höhe der Messungen, die Wetterhütte an sich etc. Wenn sie diese und andere Daten kennen, müssen sie entweder über sehr nahe gelegene Stationen die Fehler eliminieren oder eben Vergleichsmessungen mit den ursprünglichen Verfahren anstreben. Wird das alles sauber gemacht, sind Homogenisierungen nicht nur sinnvoll, sondern auch extrem wertvoll. Irgendwelche Statistiken zu strapazieren und über Stationsdaten irgendwo weit entfernt zu homogenisieren ist Käse.