Ziel ist es, die IPCC-Projektionen mit den beobachteten Temperaturänderungen auf einen Blick vergleichen zu können.

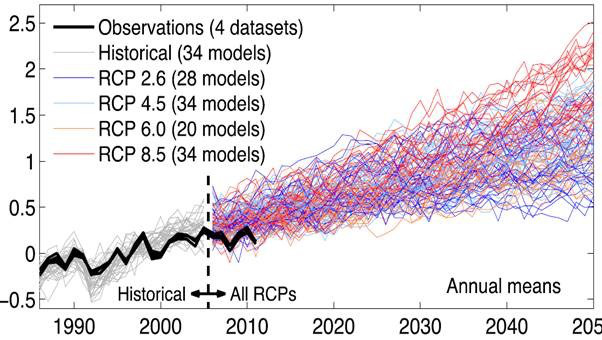

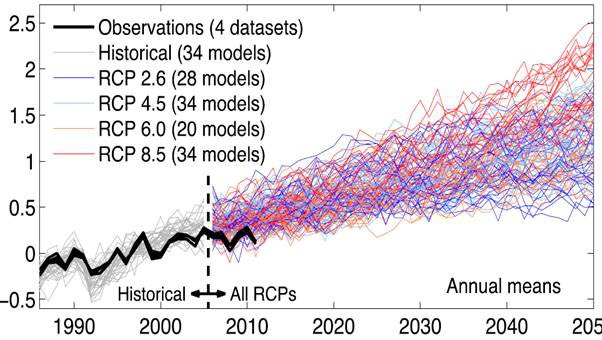

Das Intervall der IPCC-Temperaturprojektionen aus dem Jahr 2005 wurde dem Spaghetti-Graph im AR 5 entnommen. Es basiert auf 34 Modellläufen für anthropogen angetriebene Szenarien.

Komischerweise liegen die rückwärtigen Projektionen der Periode von 2005 bis 2013 nicht um die Messungen (schwarze Linie) gleichmäßig verteilt, sondern sie liegen deutlich über den Beobachtungen. Nichtsdestotrotz bin ich dem IPCC gefolgt und habe die angenäherten oberen und unteren Grenzen seiner Spaghetti-Graphik übernommen.

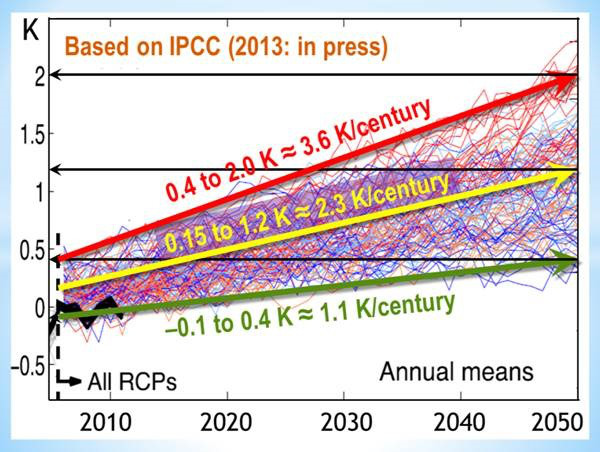

Die zentrale Projektion der 34 Modellläufe (unten in gelb) zeigt, dass die Erwärmung von 2005 bis 2050 mit einer Rate äquivalent zu etwa 2,3°C pro Jahrhundert erfolgen sollte. Dies liegt unterhalb der seit Langem etablierten IPCC-Vorhersage von 3°C im Jahrhundert, weil die Modelle eine Beschleunigung der Erwärmung nach 2050 erwarten. Die Projektionen der oberen bzw. unteren Grenze sind äquivalent zu 1,1 bzw. 3,6°C pro Jahrhundert.

Auf der Temperaturskala links ist die beobachtete Temperaturanomalie im Januar 2005 als Nullpunkt angegeben. Von diesem Punkt ausgehende Linien bestimmen die Neigung der Modellprojektionen.

Und hier ist der resultierende Graph. Die IPCC-Projektionen erscheinen blassblau.

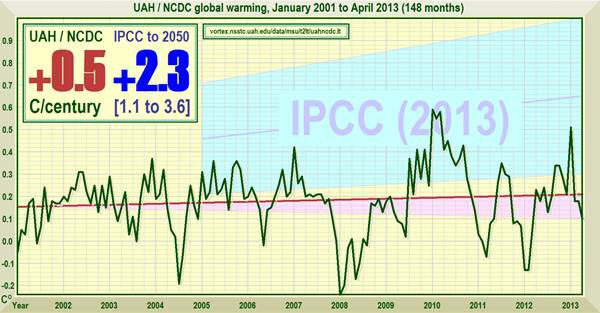

Die monatlichen von UAH beobachteten Temperaturanomalien der unteren Troposphäre (vortex.nsstc.uah.edu/data/msu/t2lt/uahncdc.lt) wurden geplottet vom Beginn dieses Jahrtausends am 1. Januar 2001 bis zum letzten verfügbaren Monat (derzeit April 2013).

Die Satelliten-Aufzeichnungen werden bevorzugt, weil sie viel weniger empfindlich auf den UHI reagieren als terrestrische Thermometer, und weil die Wahrscheinlichkeit, dass die Daten frisiert werden, deutlich geringer ist.

Der Januar 2001 wurde als Startpunkt gewählt, weil er zeitlich genügend weit von dem großen El Niño-Ereignis des Jahres 1998 entfernt liegt. Verzerrungen durch diese bemerkenswerte Wärmespitze werden dadurch verhindert.

Da die Messungenauigkeit von 0,05°C selbst in den vom Satelliten gemessenen Temperaturanomalien substantiell ist, wird ein einfacher kleinste-Quadrate-Regressionstrend gegenüber einer polynomischen Anpassung höherer Ordnung bevorzugt.

Der einfachste Test hinsichtlich statistischer Signifikanz in dem Trend wird übernommen. Ist der Erwärmungs- oder Abkühlungstrend während dieser Periode größer als der Messfehler im Datensatz? Auf dieser Basis wird der Bereich der Nicht-Signifikanz rosa gekennzeichnet. Derzeit liegt der Trend an der oberen Grenze dieser Zone und ist daher folglich kaum signifikant.

Die gesamte Trendlinie liegt unter dem Intervall der IPCC-Projektionen. Obwohl dieses Ergebnis zum Teil ein Artefakt der unorthodoxen Trainingsperiode [?] des IPCC ist, ist die Neigung des linearen Trends mit lediglich 0,5°C pro Jahrhundert während der letzten 148 Monate sichtlich weniger als halb so groß wie die niedrigste Schätzung des IPCC von 1,1°C pro Jahrhundert bis zum Jahr 2050.

Das wesentliche Ergebnis, gezeigt in der Tafel oben links in der Graphik, lautet, dass die beobachtete Erwärmungsrate der letzten 12 Jahre und 4 Monate mit einem Äquivalent von 0,5°C pro Jahrhundert weniger als ein Viertel der derzeitigen IPCC-Projektion von 2,3°C pro Jahrhundert bis zum Jahr 2050 beträgt.

Der einzige Zeitpunkt, zu dem die Temperaturanomalie den Wert der zentralen IPCC-Schätzung erreicht hatte, war zur Spitze des substantiellen El Niño-Ereignisses im Jahr 2010.

Der RSS-Datensatz, für den die April-Anomalie noch nicht verfügbar war, zeigt eine statistisch signifikante Abkühlung seit Januar 2001 mit einer Rate äquivalent zu 0,6°C pro Jahrhundert.

Die Kombination beider Satelliten-Datensätze in Gestalt ihres arithmetischen Mittels ist legitim, da ihre räumliche Abdeckung ähnlich ist. Insgesamt ergibt sich dabei eine statistisch nicht signifikante Abkühlung äquivalent zu 0,1°C pro Jahrhundert in diesem Millenium.

Die Diskrepanz zwischen den Modellprojektionen und der beobachteten Wirklichkeit ist verblüffend. Da die lange Periode ohne eine statistisch signifikante Erwärmung (mindestens 17 Jahre in allen Datensätzen, 23 Jahre laut den RSS-Daten) weiter geht, wird selbst ein weiteres großes El Niño-Ereignis wenig ausrichten, die multidekadische Erwärmungsrate auf das Niveau der IPCC-Projektion zu heben, die da äquivalent zu 1,1°C pro Jahrhundert bis zum Jahr 2050 ist.

Tatsächlich liegt die maximale globale Erwärmungsrate seit mehr als einem Jahrzehnt in allen instrumentellen Aufzeichnungen – äquivalent zu 1,7°C pro Jahrhundert – noch deutlich unter der mittleren, vom IPCC projizierten Erwärmungsrate von 2,3°C pro Jahrhundert bis zum Jahr 2050.

Diese Diskrepanz wirft hinsichtlich der Zuverlässigkeit der Modellprojektionen ernste Fragen auf. Da die Theorie eine gewisse anthropogene Erwärmung erwarten lässt, zeigt deren Fehlen, dass die Modelle natürliche Einflüsse wie etwa der Sonne unterbewertet, deren Aktivität derzeit nach dem Beinahe-Grand-Maximum um das Jahr 1960 rapide abnimmt.

Die Modelle sind auch unfähig, die sich auf natürliche Weise ändernde Wolkenbedeckung vorherzusagen, die einer aktuellen Studie zufolge, die sich auf eine meiner vor drei Jahren veröffentlichten Studien bezieht, für viereinhalb mal so viel Erwärmung von 1976 bis 2001 verantwortlich sein könnte als alle anderen Einflüsse einschließlich des Menschen.

Auch können die Modelle – oder irgendjemand sonst – El Niño-Ereignisse nicht mehr als ein paar Monate im Voraus vorhersagen. Es gibt Beweise, dass das Verhältnis von El Niño zu La Niña-Ereignissen, deren Oszillation kürzlich abgenommen hat, ein signifikanter Treiber von mittelfristigen Temperaturvariationen ist.

Es ist auch möglich, dass die Modelle inhärent zu empfindlich hinsichtlich Änderungen des Strahlungsantriebs sind und nicht ausreichend den Abkühlungseffekt nicht-radiativer Flüsse berücksichtigen.

Außerdem verlassen sich die Modelle mit der Multiplikation der direkten Antriebe um den Faktor 3 hinsichtlich vermuteter gesamt-positiver Temperatur-Rückkopplungen zu stark auf eine Gleichung, die auf die Prozesssteuerung elektronischer Verstärker anzuwenden ist, für die sie entwickelt wurde, und die für das reale Klima keine physikalische Bedeutung hat.

Ohne die Bode-Gleichung könnten die Gesamt-Rückkopplungen sehr gut kaum von Null unterscheidbar sein, in welchem Falle die Erwärmung als Folge einer CO2-Verdoppelung, die etwa die gleiche ist wie die Jahrhundert-Erwärmung, äquivalent sein wird zu der jüngst vom IPCC vorhergesagten minimalen Erwärmungsrate äquivalent zu 1,1°C pro Jahrhundert.

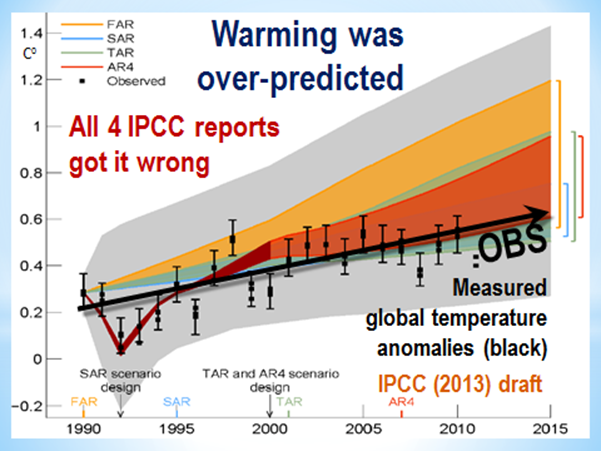

Sei dem, wie es sei, wie die oben stehende Graphik aus dem Entwurf des AR 5 zeigt, haben die Modelle in jedem der vier vorherigen IPCC-Zustandsberichte die Erwärmungsrate wild übertrieben, verglichen mit dem gemessenen Ergebnis; und wie der neuerliche Graph der Ergebnisse zeigt, ist das im 5. Zustandsbericht wieder der Fall.

Ich wäre interessiert an Reaktionen der Leser hinsichtlich Methode und Ergebnis. Würden Sie gerne irgendwelche Änderungen in der monatlichen Graphik sehen? Und wäre es ein monatlich aktualisierter Graph wert, in breitem Umfang an die Nachrichten-Medien verteilt zu werden als eine Antwort auf ihre dämliche Frage „warum glauben Sie nicht an die globale Erwärmung?“

Weil es bislang in diesem Millenium keine erwähnenswerte Erwärmung gegeben hat, darum! Die Bemühungen vieler Medien, diese Tatsache zu verschleiern, sind beschämend. Diese eine, einfache monatliche Graphik, wenn sie weithin verteilt werden würde, würde es für diese Medien viel schwieriger machen so zu tun, als beschleunige sich die Rate der globalen Erwärmung und dass wir dafür verantwortlich sind; oder dass der „Konsens“, den sie aus Faulheit akzeptiert haben, vertrauenswürdig ist.

Die Klimahysterie hat nur deswegen so lange gedauert, weil die Tatsachen, dass die Modelle gescheitert sind und die Welt sich kaum erwärmt hat, sorgfältig verschleiert worden sind. Lassen wir diese Verschleierung zu einem Ende kommen.

Christopher Monckton of Brenchley

Link: http://wattsupwiththat.com/2013/05/05/benchmarking-ipccs-warming-predictions/

Übersetzt von Chris Frey EIKE

Bewertung der IPCC-Erwärmungsprognosen

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Klasse! Die so genannten „rückwärtigen Projektionen“ müssen komplett weggelassen werden. Ich hab mich schon beäumelt vor lachen, als ich die IPCC-Version gesehen hatte, die im Jahre 1950 anfing, zu 100% genau die Vergangenheit vorhergesagt und zu 0% genau die Zukunft vorhergesagt.

Fuzzy Logik, Spieltheorie, der Mann weiß, wovon er spricht (s.u.)

Trainingsperiode meint, das das Rechenmodell zuerst einmal angelernt werden muß, um dann (die erwünschten) Ergebnisse zu liefern. Lord Monckton kritisiert hier, daß das Modell eine andere Skalierung verwendet, als die Daten. die zum trainieren des Algorithmus verwendet wurden. In der Informatik nennt man dies das GiGo Prinzip. (Garbage in -> Garbage out) Wir sollten immer im Auge behalten, das Viscount Monckton einer der besten Mathematiker der Gegenwart ist.

Out of Topic:

Es gibt kein größeres Hindernis des Fortgangs in der Wissenschaft als das Verlangen, den Erfolg davon zu früh verspüren zu wollen.

Georg Christoph Lichtenberg (1742 – 1799), deutscher Physiker

Fundstelle http://alturl.com/83ap9

Das gilt nicht für Christopher, sondern, man wundert sich doch, wie lange die IPCC-Methode schon bekannt sein sollte.

Klaus Plöger