Was genau ist der Decline-Effekt? Ist es die Tatsache, dass bestimmte wissenschaftlich entdeckte Wirkungen mit der Zeit abnehmen, je mehr sie untersucht und erforscht werden? Fast, aber nicht wirklich. Das Wiki hat diese Definition für uns:

„Der Decline-Effekt kann auftreten, wenn wissenschaftliche Behauptungen im Laufe der Zeit immer weniger Unterstützung erhalten. Der Begriff wurde erstmals von dem Parapsychologen Joseph Banks Rhine in den 1930er Jahren beschrieben, um das Verschwinden der außersinnlichen Wahrnehmung (ESP) bei den von Rhine durchgeführten psychischen Experimenten im Laufe des Studiums oder der Zeit zu beschreiben. In seiner allgemeineren Bezeichnung bezeichnete Cronbach in seinem wissenschaftlichen Übersichtsartikel „Beyond the two disciplines of scientific psychology“ (auch als pdf hier) das Phänomen als „generalizations decay“ [1]. Der Begriff wurde 2010 in einem Artikel von Jonah Schooler in The New Yorker erneut verwendet.“

Einige sind der Ansicht, dass der Decline Effect nicht nur eine Abnahme der Unterstützung im Laufe der Zeit ist, sondern dass er sich vielmehr auf eine Abnahme des Effektes im Laufe der Zeit bezieht – oder, nach Ansicht einiger, auf beides, auf das eine oder das andere. Das heißt, dass die Unterstützung abnimmt, weil die gefundenen Effektgrößen abnehmen, oder dass aufgrund der abnehmenden Unterstützung die berichteten Effektgrößen abnehmen. Als Ursache für den Rückgang werden häufig genannt: Publikationsverzerrungen, Zitationsverzerrungen, methodische Verzerrungen und Prüfereffekte. Teil 1 dieser Serie war ein Beispiel für Prüfereffekte.

Um es ganz klar zu sagen: Der Decline Effekt bezieht sich in keinem Fall auf einen tatsächlichen Rückgang der realen Auswirkungen bestimmter physikalischer Phänomene, sondern lediglich auf die in Forschungsberichten gefundenen und/oder angegebenen Effektgrößen im Laufe der Zeit.

Eine der besten Diskussionen über den Decline-Effekt wurde vor über einem Jahrzehnt in The New Yorker veröffentlicht. In einem Artikel mit dem Titel: „The Truth Wears Off – Is there something wrong with the scientific method?“ [etwa: Die Wahrheit verschleißt – stimmt etwas nicht mit der wissenschaftlichen Methode?] von Jonah Schooler. Mit 2100 Wörtern dauert die Lektüre etwa 10 Minuten – und ist jede Minute wert.

Schoolers Artikel beginnt mit folgendem Satz:

„Die Verrücktheit der Hypothese war der Punkt: [Jonathan] Schooler weiß, dass es für Präkognition[man denke an ESP -kh]keine wissenschaftliche Erklärung gibt. Aber er testete keine übersinnlichen Fähigkeiten, sondern den Decline-Effekt. „Zunächst sahen die Daten erstaunlich aus, genau wie wir es erwartet hatten“, sagt Schooler. „Ich konnte nicht glauben, wie viel Präkognition wir gefunden haben. Aber dann, als wir die Probanden weiter untersuchten, wurde die Effektgröße“ – ein statistisches Standardmaß – „immer kleiner und kleiner.“ Die Wissenschaftler testeten schließlich mehr als zweitausend Studenten. „Am Ende sahen unsere Ergebnisse genauso aus wie die von Rhine“, so Schooler. „Wir fanden diesen starken paranormalen Effekt, aber er verschwand bei uns.“

Es ist besorgniserregend, dass der Decline-Effekt bedeuten könnte, dass mit der wissenschaftlichen Methode etwas nicht in Ordnung ist. Eine Gruppe hat vor zwei Jahren eine sorgfältige Studie durchgeführt und wirklich beeindruckende, starke Effekte festgestellt, aber seither haben weitere Studien immer weniger starke Effekte gezeigt, was ihre ursprünglich unterstützte Hypothese in Zweifel zieht. Was ist hier los?

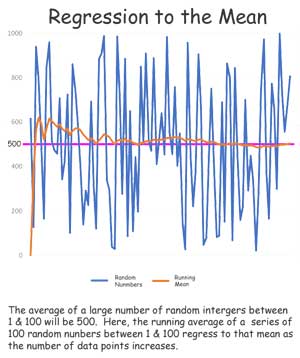

Viele Leser sind statistisch bewandert und können die Möglichkeit erkennen, dass es sich bei diesem Effekt lediglich um eine Regression zum Mittelwert handelt. Wenn das Experiment wiederholt wird und mehr Datenpunkte gesammelt werden, kommt es zu anfänglichen statistischen Ausreißern, zunächst zu ungewöhnlich hohen oder niedrigen Werten, und dann, wenn immer mehr Ergebnisse eingehen, tendiert der Durchschnitt der gesamten Ergebnisse dazu, sich dem tatsächlichen statistischen Mittelwert anzunähern. Ich werde nicht zu viel Zeit darauf verwenden, aber dieses Bild wird Ihnen helfen, das Konzept zu verstehen:

Aber wir haben ein Problem mit unseren ESP-Ergebnissen – sie fanden nur hohe Werte der ESP-Fähigkeit, nicht einige wirklich hohe und einige wirklich niedrige, im Gegensatz zu unseren zufällig generierten Zahlen im obigen Diagramm. Ohne Ausreißer, die sowohl hoch als auch niedrig sind, ist es schwer, die ESP-Ergebnisse auf Regression zurückzuführen. Die wahrscheinlichste und üblichste Ursache dafür ist, dass die Forscher nach ESP gesucht haben und nicht nach dem Fehlen von ESP. Das ist der Grundsatz, dass man im Allgemeinen das findet, wonach man sucht, entweder absichtlich oder durch einen psychologischen Effekt.

In der Praxis habe ich einen Verwandten, dessen Familientradition die Zahl 13 bevorzugt – die Glückszahl seines Urgroßvaters. Mein Verwandter ist daher überrascht, wie oft die Zahl 13 oder Kombinationen, die diese Zahl enthalten (313, 1313, 3131, 1:13 usw.), im täglichen Leben auftauchen – und ist fest davon überzeugt, dass sie häufiger vorkommt, als es statistisch belegbar ist. Sie sehen, wonach sie suchen. Oder sie bemerken das Vorkommen der Zahl, weil sie dafür sensibilisiert sind.

In Wissenschaft und Forschung ist dies oft unbeabsichtigt – es kann das Ergebnis eines schlechten Studiendesigns, voreingenommener Datenerhebungsmethoden oder subjektiver Beobachtungen sein, die durch Erwartungen beeinflusst werden. Studien, die sich auf Daten stützen, die „mit den Augen gemessen“ werden – ein Mensch mit einer Stoppuhr, der zählt, wie oft ein Schimpanse seine rechte oder linke Hand benutzt, wie schnell eine Spinne auf Reize reagiert usw. – können leicht schief gehen. Diese Art von Ursachen wären methodische Probleme.

Oder, wenn Jonathan Schooler Recht hat, in einem größeren Bereich, könnte es durch Publikations-Verzerrungen und besonders durch unveröffentlichte Ergebnisse verursacht werden. Fachzeitschriften mögen große, aufsehenerregende Ergebnisse. Zeitschriften mögen keine ungültigen, negativen oder „nichts gefunden“-Studien. Das bedeutet, dass bei einer Meta-Analyse veröffentlichter Arbeiten in der Regel die Studien mit großen Ergebnissen gefunden werden – und nicht die vielen, die winzige oder gar keine Auswirkungen aufgezeigt hatten. Diese Arbeiten mit null oder winzigen Effekten sind möglicherweise in Zeitschriften erschienen, die keinen wirklichen Einfluss haben: nicht englischsprachige, kleine oder obskure Zeitschriften. Schooler weist darauf hin, dass viele Studien mit Nullbefunden oder geringen Auswirkungen abgelehnt und nicht veröffentlicht werden oder, schlimmer noch, nie von Forschern geschrieben werden, die wissen, dass ihre Chancen auf eine Veröffentlichung gering sind.

In neuen Forschungsbereichen neigen Wissenschaftler dazu, nach Ergebnissen zu suchen, die den großen Resultaten ähneln, die denjenigen, die als erste über die neuen Phänomene berichteten, Ruhm und Erfolg brachten. Wenn sie diese finden, beeilen sie sich mit der Veröffentlichung. Finden sie hingegen keine großen, beeindruckenden Ergebnisse, denken sie vielleicht, dass sie sich in irgendeiner Weise geirrt haben und sind nicht bereit, sich dem neuen Trend zu widersetzen. Publikations-Verzerrungen wirken sich auf Meta-Analysen aus. In den meisten Bereichen, die nicht politisiert werden oder einem erzwungenen Konsens unterliegen, werden die Ergebnisse schließlich richtig, es werden mehr und mehr realistische Effekte gefunden, der Decline-Effekt tritt ein und die Wissenschaft entwickelt sich weiter.

Eine weitere Möglichkeit, wie Meta-Analysen verzerrt werden können, ist:

Voreingenommenheit bei der Quellenangabe

Das Zitieren oder Nicht-Zitieren von Forschungsergebnissen, je nach Art und Richtung der Ergebnisse. Autoren neigen dazu, positive Ergebnisse gegenüber negativen oder ungültigen Ergebnissen zu zitieren, und dies wurde für einen breiten Querschnitt von Themen festgestellt. Die unterschiedliche Zitierung kann dazu führen, dass in der Öffentlichkeit der Eindruck entsteht, eine Intervention sei wirksam, obwohl sie es nicht ist, und sie kann zu einer Überrepräsentation positiver Ergebnisse in systematischen Übersichten führen, wenn diejenigen, die nicht zitiert werden, schwer zu finden sind.

Die selektive Zusammenführung von Ergebnissen in einer Meta-Analyse ist eine Form der Verzerrung durch Zitate, die besonders heimtückisch ist, da sie das Wissen beeinflussen kann. – Wiki

Denken Sie nur an die Auswirkungen, die diese beiden Faktoren auf Themen haben, deren öffentliche Wahrnehmung von Meta-Analysen abhängt, wie z. B. die IPCC-Zustandsberichte oder die NOAA- und NASA-Berichte über den Meeresspiegel, das Klima oder extreme Wetterereignisse, die nur das verwenden, was die Autoren dieser Berichte als „anerkannte““ Studien und „maßgebliche“ Quellen betrachten. Einer der ersten Schritte einer Meta-Analyse ist die Auswahl der zu berücksichtigenden Studien, und allzu oft bedeuten „anerkannt“ und „maßgebend“ in der Praxis einfach „stimmt mit uns überein“.

[Hervorhebung im Original]

Methodische Verzerrungen

Dies ist eine breite Problemkategorie, die jedoch am einfachsten zu lösen ist. In den ersten Stadien der Wissenschaft über die Versauerung der Ozeane [Ocean Acidificagtion OA] gab es viele Voreingenommenheiten: die größte davon war die a priori-Annahme, dass die Senkung des pH-Wertes des Meerwassers schlecht sei – dass sie unweigerlich zu negativen Auswirkungen führe. Um dies zu beweisen, weil es „so offensichtlich“ war, führten Forscher, die sich nicht mit der Chemie des Meerwassers auskannten, Experimente mit „gesenktem pH-Wert“ durch, wobei sie die einfachste Methode anwendeten, die sie in der High School gelernt hatten: Sie fügten dem Meerwasser einfach Säure hinzu. Chris Cornwall und Catriona Hurd haben eine wichtige Arbeit veröffentlicht, in der sie einige dieser Unsinnigkeiten richtig gestellt haben (siehe hier und hier). Nachdem die Verfahren korrigiert worden waren, wurden bei OA-Experimenten im Allgemeinen weit weniger schädliche Auswirkungen festgestellt. Und jetzt, wo sich die Arbeiten über die Auswirkungen auf das Fischverhalten als höchst fragwürdig erweisen, wird das Feld von den Klimakrisengegnern zurückgedrängt. Zur Verteidigung der OA-Forscher wurden Standards für ordnungsgemäße Methoden der OA-Forschung entwickelt und vom European Project on OCean Acidification (EPOCA) veröffentlicht, das die Broschüre „Guide to best practices for ocean acidification research and data reporting“ [etwa: Leitfaden für bewährte Praktiken bei der Erforschung der Ozeanversauerung und der Datenerfassung] herausgegeben hat.

In anderen Bereichen sind methodische Verzerrungen an der Tagesordnung. Auf dem Gebiet des Meeresspiegels gibt es immer noch viele Arbeiten, die einfach den Durchschnitt der Daten von Gezeitenpegelstationen bilden (Gezeitenpegel, die jeweils den relativen Meeresspiegel an einem einzigen Ort messen) und dann die Satellitenmessungen des eustatischen Meeresspiegels mit den Beobachtungsreihen der Gezeitenpegel für den lokalen relativen Meeresspiegel verbinden (ein Fehler, bei dem Äpfel, Birnen und Bananen im Obstsalat landen), oder den neuesten methodischen Wahnsinn der hybriden Meeresspiegel-Rekonstruktionen (bei denen alle oben genannten Fehler zusammen auftreten).

Es gibt und gab viele Lösungsvorschläge für das, was als „Saving Science“-Bewegung bekannt geworden ist. Dazu gehören eine ernsthafte und detaillierte Replikation wichtiger Ergebnisse und die Vorab-Registrierung von Studien (einschließlich Hypothese, Datenerfassung, Methoden, Datenanalysemethoden, alles). Die Vorabregistrierung ermöglicht eine Überprüfung der vorgeschlagenen Studie durch Fachkollegen, bevor Aufwand und Geld für einen schlecht durchdachten Plan aufgewendet werden.

Meiner Meinung nach müssen die Forschungsbereiche ihre klügsten Köpfe zusammenbringen und echte Forschungsziele aufstellen, um ihre Grundlagen zu stärken und Wissenslücken aufzuzeigen – sie müssen sich Ziele setzen, um grundlegendes Wissen zu wiederholen und zu verifizieren und Wissenslücken zu schließen. Der Sinn von Saving Science besteht darin, das Gute vom Schlechten zu trennen, die Wahrheiten von den Mythen, die entdeckten Grundprinzipien von den aktuellen wissenschaftlichen Moden.

Mit anderen Worten: Wir müssen aufhören, herumzualbern. Wir brauchen ein paar Forscher, die verrückte Dinge erforschen. Aber wir brauchen auch dringend korrigierende wissenschaftliche Studien – Wissenschaft, die die wissenschaftlichen Fehler der Vergangenheit korrigiert. Es gibt viel zu viele Bereiche wie die OA-Forschung, die Erforschung des Meeresspiegels und die Korallenriff-Forschung, die auf gefährlichen Pfaden ins wissenschaftliche Nirgendwo abgewandert sind, indem sie modischen Versionen der Realität gefolgt sind, die zu Tatsachen geworden sind, Memos, die selbst ex nihilo geschaffen wurden, um soziale und politische Agenden zu fördern.

Bemerkungen des Autors hierzu:

Der Decline-Effekt bedeutet nicht unbedingt, dass jemand betrügt. Er kann nur bedeuten, dass das, was auf den ersten Blick wichtig erschien, keine große Sache ist. Leider wollen junge Forscher, die mit einem großen Fund einen Treffer landen, oft auf diesem Pony reiten und eine Festanstellung, Reichtum und Ruhm erlangen. Wenn nachfolgende Forscher die ursprüngliche(n) große(n) Entdeckung(en) nicht wiederholen und in Frage stellen können, kommt es zu Problemen. Diejenigen, die versuchen, die wissenschaftlichen Aufzeichnungen zu korrigieren, werden als „Angreifer der Wissenschaft“ beschimpft, obwohl sie selbst Wissenschaftler sind.

Die Wissenschaft kann sich nicht selbst korrigieren, wenn diejenigen, die versuchen, die notwendigen Korrekturen vorzunehmen, dafür angegriffen werden.

[Hervorhebung vom Übersetzer]

Link: https://wattsupwiththat.com/2022/02/28/the-decline-effect-part-2-how-does-this-happen/

Übersetzt von Christian Freuer für das EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"„Die Wissenschaft kann sich nicht selbst korrigieren…“

solche Textschnitzereien finde ich „sehr dekorativ“. Es ernährt akademisch dekorierte Stände aller Arten, die davon leben, zu texten, statt Bagger zu fahren, Maschinenbau zu betreiben oder anderen reale Werte schöpfenden, beruflichen Tätigkeiten nachzugehen und zu betreiben.

Gut so, jeder nach seinen Möglichkeiten bzw., was so im Zeitgeist, als Wissenschaft, mehr finanzielle Unterstützung und damit hohes Einkommen, dieser „Mainstream-Wissenschaftler“ ausmacht. Womit ich wieder bei meiner Einteilung bin, die Ingenieure analysieren, was sich kombinieren und konstruieren lässt, damit es die Anwender und Konsumenten, auch als Laien gerne und sicher nutzen können. Das wird seit ewigen Zeiten praktiziert, wie Frischwasserversorgung, Kanalisation oder Schiffbau zeigen, und was sich als „Wissen“ in der Industrialisierung enorm beschleunigte, wo wir den Rechenschieber ersetzten und nun den PC nutzen.

Darin sehe ich, die Ergebnisse kognitiver Intelligenz in ganz konkreter, greifbarer Form, als ein „Wissen“ was etwas funktionierendes „geschaffen“ hat, was den Einen ein schönes Wunder sein kann oder den Pessimisten irrationale Angst macht. Natürlich lassen die Neurotiker ihre Phobie nicht therapieren, sondern agieren wie die Maschinenstürmer mit zorniger Sabotage, wie u. a. gegen Kernkraftwerke. Nun existieren neben denen die hauptberuflich Bagger fahren, Heerscharen von Leuten mit mehr linken Händen und noch weniger koordinierten theoretischen Talenten, die es darum in Unis und Parlamente drängt, um der sogenannte „Wissenschaft“ anzuhängen die ihnen persönlich Reputation ermöglicht, um als nützliche Idioten, z. B. in einem aus Steuermillionen finanzierten Klima-Institut zu residieren, was den Profis der Finanzbranche, Scheinargumente schnitzt, die dann an der Wall-Street zu „CO2-Glaubens-Zertifikaten gehandelt“ und durch politische Marionetten legitimiert sind, statt als „falscher Zauber von arglistigen Halunken“ kräftig abgewatscht zu werden. Dieser „Klima-Kot“ einer Bösen-Ära, in der sogar kostümierte „Gesetze-Schnitzer“ sich scheinheilig auf „Wissenschaft“ vom zukünftigen politischen Wetter, berufen, offenbart fiese Erbärmlichkeiten.

Ich wünsche mir eine Freiheit, eine entspannten Souveränität, einen fairen Wettbewerb, wo „Wissen“ gute Chancen hat, sich als nützlich und genial weiter zu entwickeln.

>>was die Autoren dieser Berichte als „anerkannte““ Studien und „maßgebliche“ Quellen betrachten.<<

In der Wissenschaft zählt nur der Beweis und niemals die Anerkenntnis. Und „maßgebliche“ Quellen sind auch Quatsch. Was nur zählt bzw. zählen kann, ist die Korrektheit einer Darstellung der „Quelle“, aber nicht deren „Maßgeblichkeit“, denn die ist letztendlich nur eine Meinung. Die kann natürlich richtig sein, muß es aber nicht.

Ohne Beweis sind Aussagen nicht zwangsweise korrekt.

Und wer die Existenz der „Klimaerwärmung“ behauptet, der muß das hier erklären können:

Oder das hier:

Das sind tägliche Werte seit 1894.

>>Die Wissenschaft kann sich nicht selbst korrigieren, wenn diejenigen, die versuchen, die notwendigen Korrekturen vorzunehmen, dafür angegriffen werden.<<

Man muß nix korrigieren, man muß nur prüfen, ob die Behauptung stimmt. Und daß die beiden Bildchen stimmen kann jeder, der mit Excel arbeiten kann und weiß wie man gemessene Daten aus der Meteorologie eingibt, überprüfen. Und daß es in Hamburg Anfang der 90er Jahre des letzten Jahrhunderts am wärmsten im Sommer war, kann auch jeder beweisen. Die Meßdaten gibt es. Und die 3000m Höhendifferenz ohne Wolkenflug hat unsereiner mit dem Segelflieger genau in dem Jahr in Norddeutschland geschafft. Woran das wohl meteorologisch lag? Bereits 1971 hat unsereiner mit dem Segelflieger problemlos ne Höhe von 2600m erreicht.

„Der Decline-Effekt kann auftreten, wenn wissenschaftliche Behauptungen im Laufe der Zeit immer weniger Unterstützung erhalten“

Die letzte Hoffnung, dass auch der Klima-Wahn irgendwann ausstirbt. Gegenwärtig hat man den Eindruck, dass eher das Gegenteil passiert. Je mehr, je öfter und je penetranter der Wahn vor allem in den Medien propagiert und befeuert wird und um so mehr er kostet, desto mehr wird aus dem Wahn akzeptierte Wirklichkeit. Ach ja richtig, wir leben schließlich in einer Klima-Diktatur und Diktatoren verfahren schon immer nach diesem Rezept. Bis sich die gewünschte Resignation einstellt. Dann gibt es noch die Überzeugungstäter, die in der grünen Propaganda-Abteilung tätig sind. Also mehr Absicht und bewusste Lenkung dahinter, als es der Artikel annimmt – zumindest beim Klima- und Dekarbonisierungs-Wahn.