Joseph D’Aleo, CCM

[Vorbemerkung: Manche Grafiken in diesem Beitrag kommen etwas unscharf daher. Das war auch im original so. – Ende Vorbemerkung]

Praktisch jeden Monat und jedes Jahr lesen wir in den ehemals zuverlässigen Medien und von ehemals unparteiischen Datenzentren Berichte, die den wärmsten Zeitraum in der gesamten Aufzeichnung bis 1895 oder früher (oft bis 1850) zurückverfolgen.

Im ADDENDUM zum Forschungsbericht mit dem Titel: On the Validity of NOAA, NASA and Hadley CRU Global Average Surface Temperature Data & The Validity of EPA’s CO2 Endangerment Finding, Abridged Research Report, lieferten Dr. James P. Wallace III, Dr. (Honorary) Joseph S. D’Aleo, Dr. Craig D. Idso im Juni 2017 (hier) reichlich Beweise dafür, dass die Global Average Surface Temperature (GAST) Daten für die Verwendung in der Klimamodellierung und für jeden anderen Zweck der Analyse der Klimawandelpolitik ungültig sind.

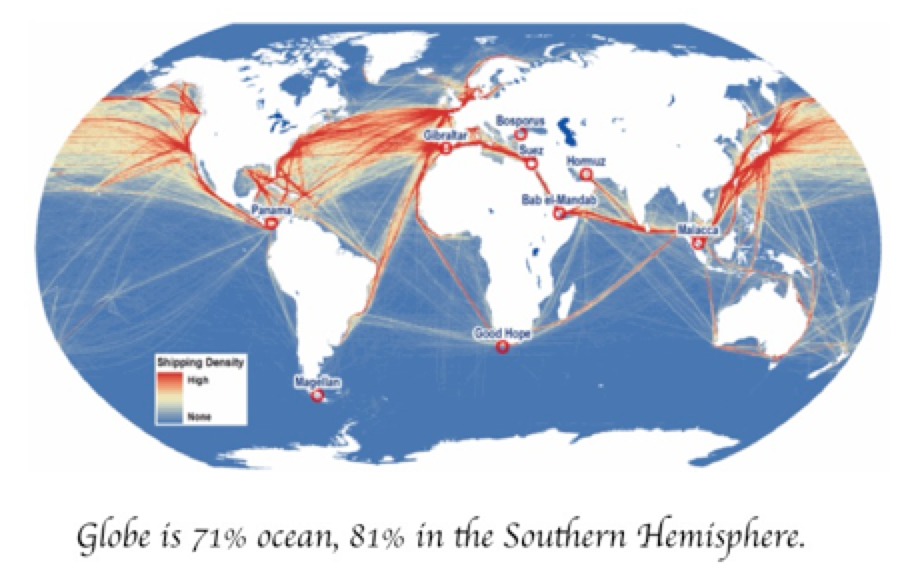

„Die schlüssigen Ergebnisse dieser Untersuchung sind, dass die drei GAST-Datensätze die Realität nicht korrekt wiedergeben. Das Ausmaß ihrer historischen Datenanpassungen, durch die ihre zyklischen Temperaturmuster entfernt wurden, steht nämlich in völligem Widerspruch zu den veröffentlichten und glaubwürdigen Temperaturdaten der USA und anderer Länder. Daher ist es unmöglich, aus den drei veröffentlichten GAST-Datensätzen den Schluss zu ziehen, dass die letzten Jahre die wärmsten aller Zeiten waren – trotz der aktuellen Behauptungen einer rekordverdächtigen Erwärmung. Dies gilt umso mehr, wenn man bedenkt, dass 71 % der Erdoberfläche aus Ozeanen bestehen und die einzigen Ozeandaten vor Beginn der Satellitenära in den 1970er Jahren auf Schiffsrouten in der nördlichen Hemisphäre beschränkt waren.“

Nach Ansicht der Beobachter der langfristigen instrumentellen Temperaturdaten ist die Aufzeichnung der südlichen Hemisphäre „größtenteils erfunden“. Der Grund dafür ist die extrem begrenzte Anzahl verfügbarer Messungen sowohl in der Vergangenheit als auch in der Gegenwart von der Antarktis bis zu den äquatorialen Regionen.

1981 berichteten James Hansen und seine Kollegen von der NASA, dass „die Probleme bei der Erstellung einer globalen Temperaturgeschichte auf die ungleichmäßige Verteilung der Messstationen zurückzuführen sind, wobei die südliche Hemisphäre und die Ozeanregionen kaum vertreten sind“ (Science, 28. August 1981, Band 213, Nummer 4511).

1978 berichtete die New York Times, dass es zu wenig Temperaturdaten aus der südlichen Hemisphäre gab, um zuverlässige Schlussfolgerungen zu ziehen. Der von deutschen, japanischen und amerikanischen Fachleuten erstellte Bericht erschien in der Ausgabe vom 15. Dezember in der britischen Zeitschrift Nature und stellte fest: „Die Daten von der südlichen Hemisphäre, insbesondere südlich des 30. südlichen Breitengrades, sind so dürftig, dass zuverlässige Schlussfolgerungen nicht möglich sind“, heißt es in dem Bericht. „Schiffe fahren auf festgelegten Routen, so dass weite Teile des Ozeans überhaupt nicht von Schiffen überquert werden, und selbst diejenigen, die dies tun, liefern möglicherweise keine Wetterdaten von der Route.

Dieser Befund wurde kürzlich von Dr. Mototaka Nakamura, einem MIT-Absolventen, in einem Buch über „den traurigen Zustand der Klimawissenschaft“ mit dem Titel [übersetzt] „Bekenntnisse eines Klimawissenschaftlers: Die Hypothese der globalen Erwärmung ist eine unbewiesene Hypothese“ bekräftigt.

Er schreibt: „Die angebliche Messung der globalen Durchschnittstemperaturen seit 1890 basiert auf Thermometer-Ablesungen, die kaum 5 Prozent des Globus abdecken, bis vor 40-50 Jahren die Satellitenära begann. Wir wissen nicht, wie sich das globale Klima im letzten Jahrhundert verändert hat, wir kennen nur einige begrenzte regionale Klimaveränderungen, etwa in Europa, Nordamerika und Teilen Asiens.“

Man beachte die geringe Anzahl von Land-Stationen in den Datensätzen aus den frühen Jahrzehnten des Datenfensters.

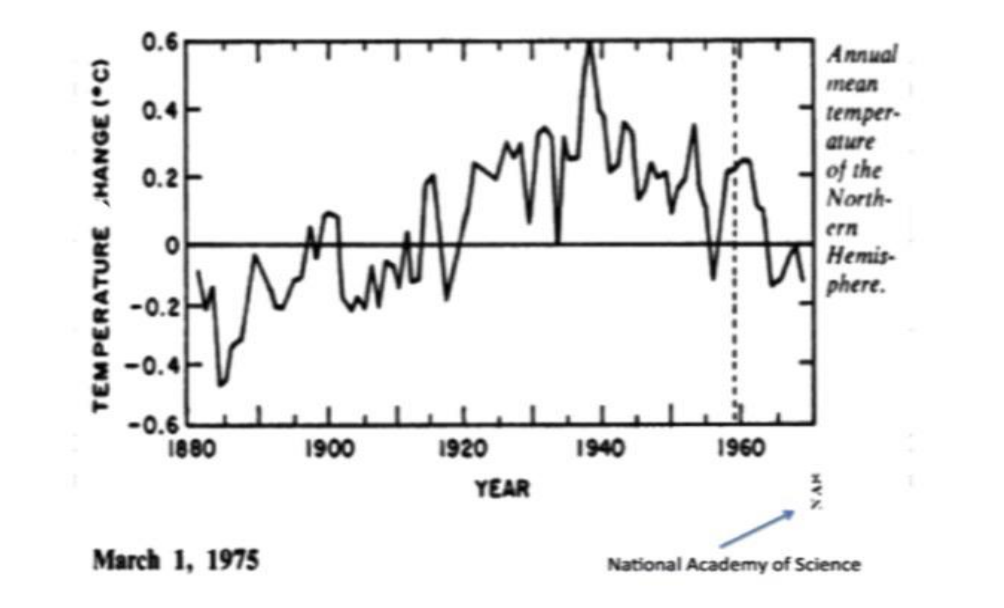

Die National Academy of Science erkannte dies in ihrem ersten Versuch, in den 1970er Jahren einen Temperaturtrend zu bestimmen, den sie auf die Landgebiete der nördlichen Hemisphäre beschränkte. Sie zeigte eine dramatische Erwärmung von den 1800er Jahren bis etwa 1940 und dann eine Umkehrung, die in einer entsprechenden Abkühlung Ende der 1970er Jahre endete, als sogar die CIA schrieb, dass wir nach übereinstimmender Meinung der Wissenschaftler auf eine gefährliche neue Eiszeit zusteuern könnten.

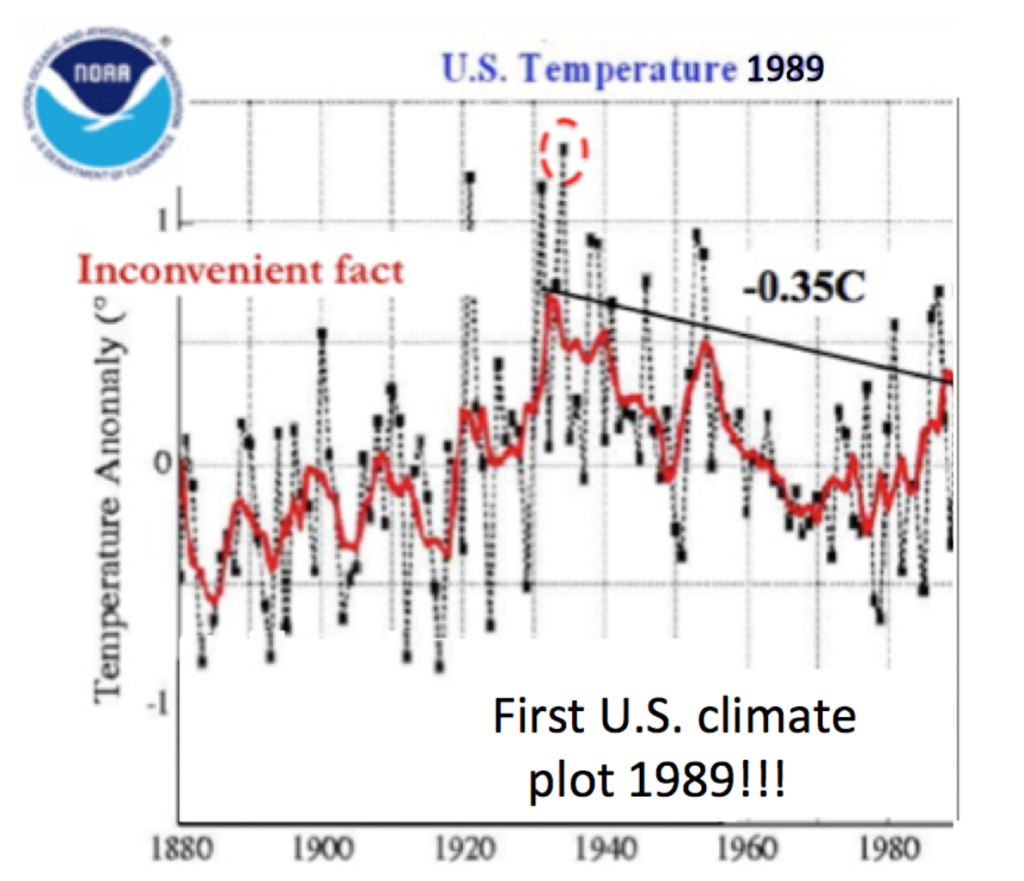

Die erste Erfassung von Temperaturtrends in Echtzeit erfolgte 1989 – und zwar nur für die USA, da die USA über das beste Netz von Oberflächenstationen verfügten und die städtische Beeinträchtigung berücksichtigt wurde.

Tom Karl, der 1988 die UHI-Anpassung für die erste Version des USHCN definierte (die in Version 2 entfernt wurde), schrieb zusammen mit Kukla und Gavin in einem Papier von 1986 über städtische Erwärmung: „Meteo-säkulare Trends der Oberflächenlufttemperatur, die überwiegend aus Daten städtischer Stationen berechnet werden, haben wahrscheinlich eine ernsthafte Erwärmungsverzerrung… Der durchschnittliche Unterschied zwischen den Trends in städtischen und ländlichen Gebieten entspricht einer jährlichen Erwärmungsrate von 0,34°C/Dekade. Der Grund, warum die Erwärmungsrate wesentlich höher ist, könnte darin liegen, dass die Rate nach den 1950er Jahren zugenommen hat, was mit dem starken Wachstum in und um Flughäfen in jüngster Zeit zusammenhängt. Unsere Ergebnisse und die anderer zeigen, dass die Inhomogenität des städtischen Wachstums schwerwiegend ist und bei der Bewertung der Zuverlässigkeit von Temperaturaufzeichnungen berücksichtigt werden muss.“

Die NY Times berichtete, dass die US-Daten den von Hansen 1980 vorhergesagten Erwärmungstrend nicht aufzeigen.

Selbst 1999 lag die Temperatur noch unter der von 1934 – James Hansen stellte fest: „Die USA haben sich im vergangenen Jahrhundert erwärmt, aber die Erwärmung übersteigt kaum die Schwankungen von Jahr zu Jahr. In der Tat war das wärmste Jahrzehnt in den USA die 1930er Jahre und das wärmste Jahr 1934.“

Als die Datenzentren unter Druck gesetzt wurden, dasselbe mit den globalen Daten zu tun, sahen sie sich mit einem Dilemma konfrontiert, da die Abdeckung der Stationen schlecht und die Qualität der Stationen unbekannt war. Das Ergebnis ohne Qualitätskontrolle der Stationen war eine Erwärmung nach 1980.

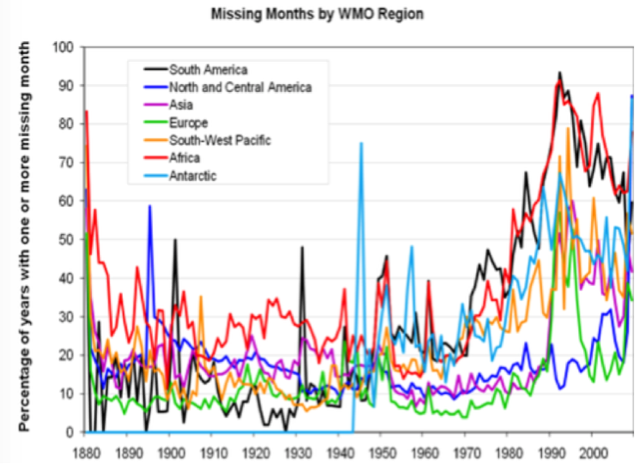

Selbst als die Zahl der Stationen und ihre Abdeckung zunahmen, wurde ihre Zuverlässigkeit zu einer Herausforderung, da viele große Kontinente einen hohen Prozentsatz an fehlenden Monaten in den Stationsdaten aufwiesen. Daher mussten die Datenzentren die fehlenden Daten schätzen, um einen monatlichen und dann einen jährlichen Durchschnitt zu erhalten.

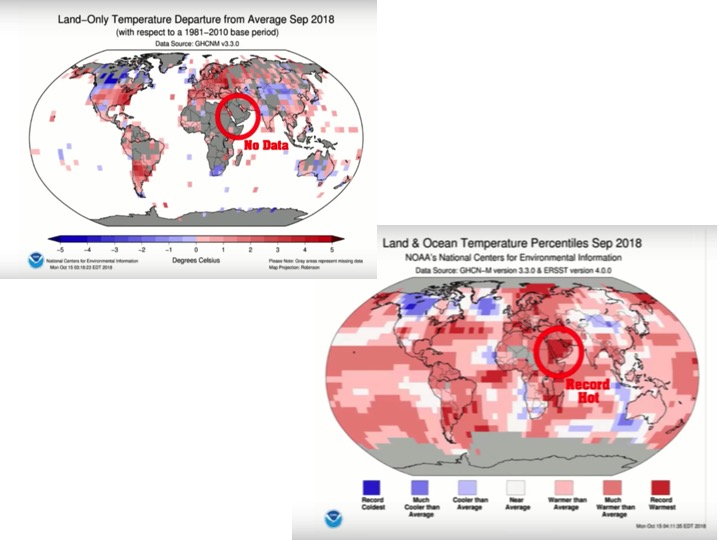

Es mag Sie überraschen, dass dies auch heute noch so ist. Dieses notwendige Rätselraten gibt denjenigen, deren Aufgabe es ist, ihre Modelle zu validieren, die Möglichkeit, Anpassungen vorzunehmen, die ihre Vorurteile bestätigen. Sehen Sie sich die ersten Datenregionen im September 2018 an, die durch Algorithmen aufgefüllt wurden. Dazu gehört in einer großen Datenlückenregion eine Rekord-Wärmebilanz (Heller 2018):

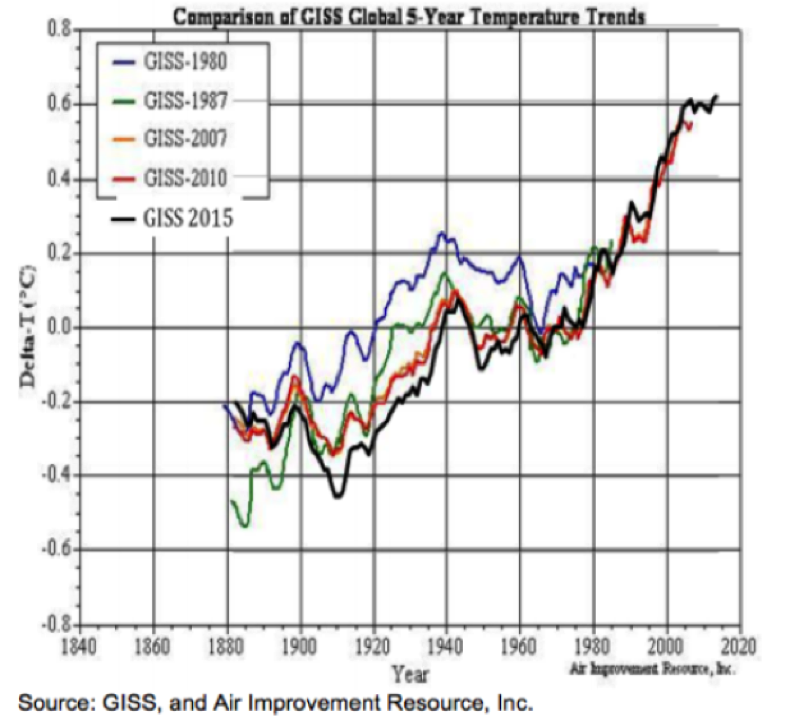

Bei unseren Bewertungen haben wir festgestellt, dass mit jeder Aktualisierung die vergangenen Jahre mehr und mehr gekühlt werden, was dazu führt, dass die Trends im Laufe der Zeit besser mit den Modellszenarien übereinstimmen.

Hier ist die NASA-GISS-Anpassung der NOAA-GHCN-Daten. Jede Aktualisierung kühlt die Vergangenheit ab, so dass der Trend nach oben deutlicher wird:

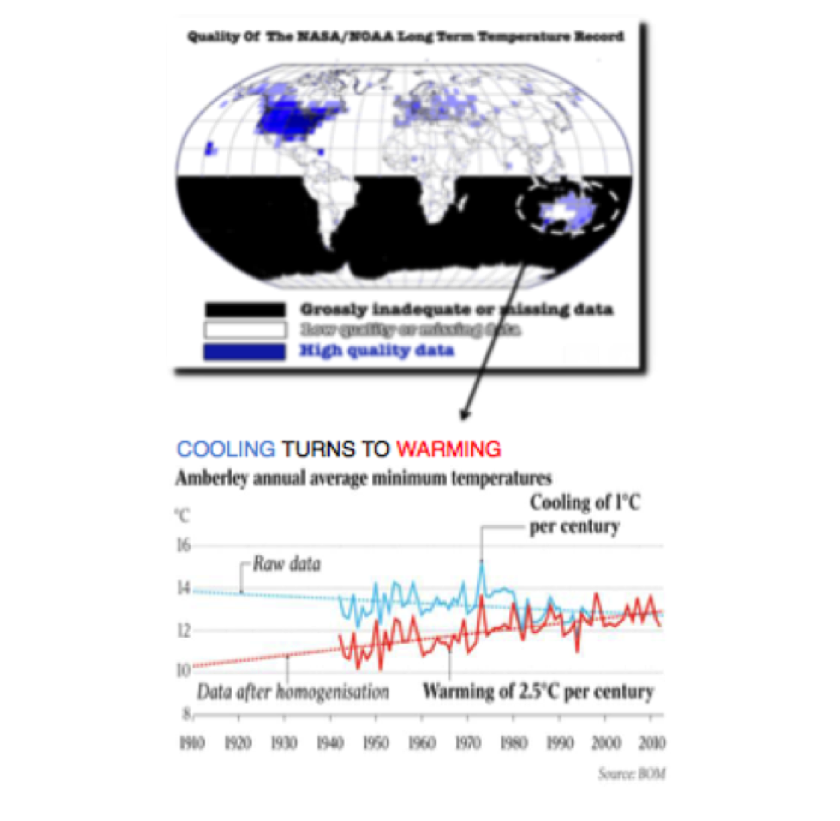

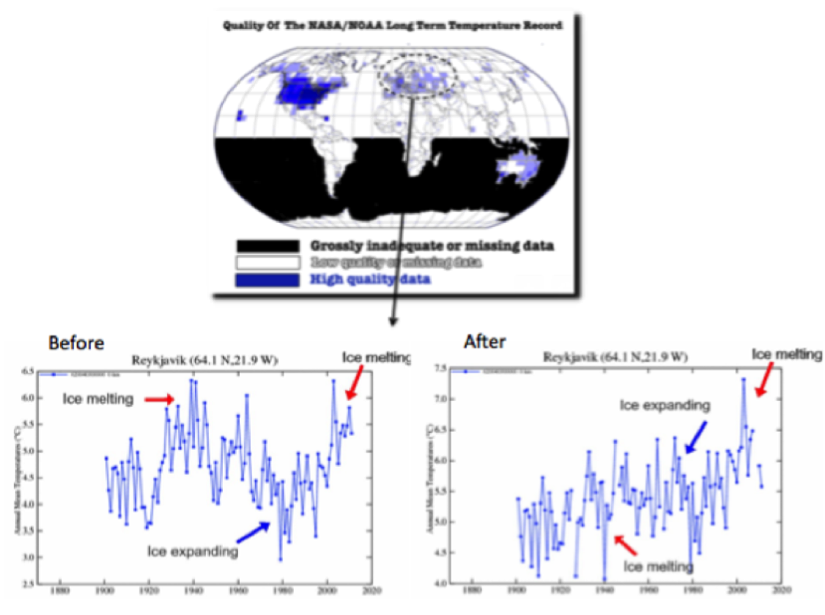

Selbst in Gebieten mit besseren Daten wurden die Stationsdaten von den Analysten angepasst (verfälscht), um aus einem Abkühlungstrend die gewünschte Erwärmung zu machen. Wir haben nur drei von vielen Beispielen ausgewählt – eines in Australien, das zweite in Island und die Grafik für den Bundesstaat Maine.

Für Australien wurden viele Beispiele aufgedeckt, darunter Darwin und hier Amberley. Blau war die ursprüngliche Darstellung der Daten, rot ist die Darstellung nach der Anpassung in Australien:

Die NASA-GISS-Diagramme für die isländischen Rohdaten und die angepassten Daten zeigen einen Zyklus, der durch eine lineare Erwärmungsrate ersetzt wurde. Die bereinigten Daten wurden von der isländischen Met-Abteilung widerlegt:

Eine neue Version der US-Daten erschien 2010 und zeigte ähnliche Anpassungen.

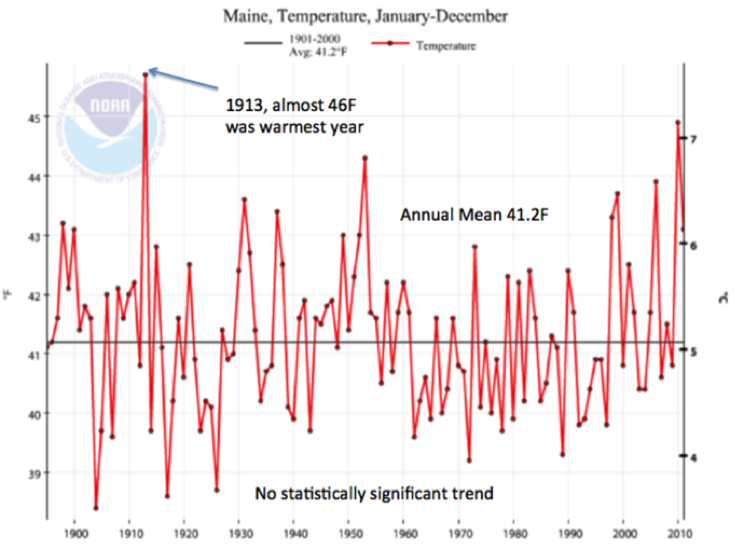

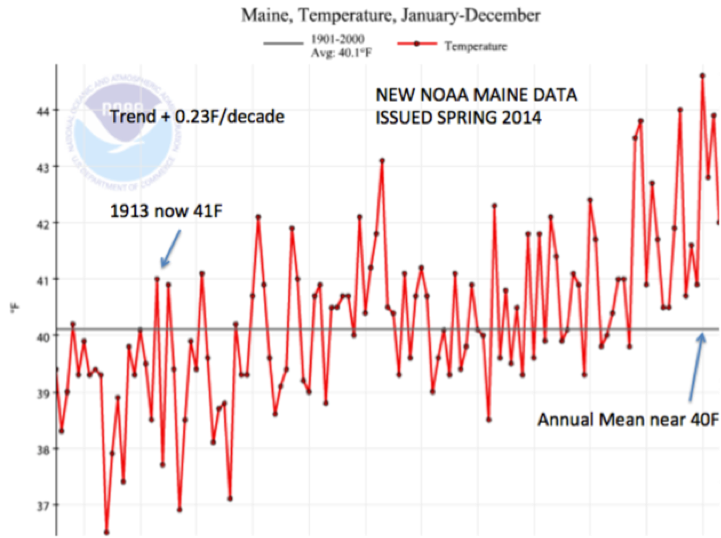

Der Maine-Temperaturtrend der NOAA wurde 2011 und erneut nach 2013 abgerufen. Der erste zeigte keinen statistisch signifikanten Trend ab 1895 (-0,01 F/Dekade) mit dem wärmsten Jahr 1913. Der zweite zeigte einen Trend von +0,23 F/Dekade, wobei 1913 um fast 3°C nach unten korrigiert worden war:

Siehe die Darstellung der monatlichen Durchschnittstemperaturen in den USA seit der Einführung im Jahr 2005 im Klimareferenznetz (Stationen, die nach bestimmten Kriterien von Wärmequellen entfernt sind):

Und die durchschnittlichen monatlichen Höchsttemperaturen für die Klimazonen der USA:

Die Climategate-E-Mails enthüllten den wahren Zustand der Datenbanken, die als Grundlage für weltpolitische Entscheidungen dienen. Ihre eigenen Entwickler und ihr leitender Wissenschaftler wurden entlarvt und gezwungen, die Datenmängel einzugestehen. Ian ‚Harry‘ Harris, der leitende CRU-Klimadaten-Programmierer und -analyst, gab in den ‚Climategate‘-E-Mails zu: „[Der] hoffnungslose Zustand ihrer (CRU-)Datenbasis. Es gibt keine einheitliche Datenintegrität, es ist nur ein Katalog von Problemen, der weiter wächst, wenn sie gefunden werden… Es gibt Hunderte, wenn nicht Tausende von Paaren von Dummy-Stationen… und Duplikate… Aarrggghhh! Es ist wirklich kein Ende in Sicht. Dieses ganze Projekt ist so ein Wahnsinn. Kein Wunder, dass ich eine Therapie brauchte!!“ Link: http://www.di2.nu/foia/HARRY_READ_ME-0.html

Der CRU-Wissenschaftler im Zentrum des Climategate-Skandals an der Universität East Anglia, Phil Jones, hat, nachdem er dachte, die Sache sei gelaufen, in der BBC offen zugegeben, dass seine Oberflächen-Temperaturdaten so durcheinander sind, dass sie wahrscheinlich nicht überprüft oder repliziert werden können, dass es in den letzten 15 Jahren keine statistisch signifikante globale Erwärmung gegeben hat und dass der Trend von 2002 bis 2009 um 0,12°C/Dekade abwärts verläuft. Jones wies ausdrücklich den Slogan „Die Wissenschaft ist settled“ zurück.

Der Versuch, aus derart lückenhaften, ungeordneten, fehlerbehafteten, geografisch unausgewogenen und sich ständig ändernden Daten, bei denen es deutliche Hinweise auf Manipulationen gibt, eine „globale Durchschnittstemperatur“ zu ermitteln, ist eher politisch motivierter Betrug als Wissenschaft.

[Hervorhebung vom Übersetzer]

Was die Behauptungen über die Zunahme von Extremen betrifft, so finden Sie hier einen aufschlussreichen Faktencheck.

Die Daten unterstützen die Ergebnisse der oben erwähnten Forschung:

„Die schlüssigen Ergebnisse dieser Forschung sind, dass die drei GAST-Datensätze keine gültige Darstellung der Realität sind. In der Tat ist das Ausmaß ihrer historischen Datenanpassungen, die ihre zyklischen Temperaturmuster entfernt haben, völlig unvereinbar mit veröffentlichten und glaubwürdigen Temperaturdaten aus den USA und anderen Ländern. Daher ist es unmöglich, aus den drei veröffentlichten GAST-Datensätzen zu schließen, dass die letzten Jahre die wärmsten aller Zeiten waren – trotz der aktuellen Behauptungen einer rekordverdächtigen Erwärmung.“

Link: http://icecap.us/index.php/go/new-and-cool vom 17. November 2021 und hinter Zahlschranke: https://wordpress.com/post/alarmistclaimresearch.wordpress.com/743

Übersetzt von Christian Freuer für das EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Gerade heute wurde das Erwärmungs-Narrativ wieder gefüttert. Stündlich in den Nachrichten: Nie da gewesene Dezembertemperatur von 22 Grad C in Kanada. Vom eigeschneiten Großbritannien kein Wort.

Bitte hier nur unter vollem Klarnamen posten.

Sorrry

„Ich weiß dass ich nicht weiß.“ Irgendwie lässt der Artikel den Leser hilflos zurück. Doch es gibt meiner Meinung nach zuverlässige Werte der Global-Temperatur, die in den Wetter-Modellen aus vielen Messungen (Boden-Stationen,Wetterballone,Flugzeuge, Satelliten) zuammenfließen. Nach NCEP Reanalysis Surface Air Temperature Glb 194801 202111.txt beträgt die Global-Temperatur im November 2021 13,7 °C und das 12-Monate Mittel 202012-202111 14,4°C.

Ein sehr verdienstvoller, unverzichtbarer Artikel, wenn man sich auf die „Messwerte“ der globalen Temperaturen stützen möchte. Auch Satellitenmessungen sind nicht perfekt, wie Herr Strasser in seinem Kommentar unten zu recht bemängelt. Die noch viel größere Kaffeesatz-Leserei sind jedoch die Computer-Klimamodelle des IPCC, die ein Klimaverständnis samt Prognostizierbarkeit vorgaukeln, wie sie auch nicht annähernd der Realität entsprechen.

Man ist m.E. besser beraten, den gemessenen mittleren globalen Temperaturanstieg bei UAH/Roy Spencer von 0.135 Grad pro Dekade linear zu extrapolieren. Sehr wahrscheinlich ist man dabei auch auf der sicheren Seite, weil die Satelliten-Aufzeichnungen 1980 mit dem relative steilen Temperaturanstieg bis etwa 2000 beginnen. Dann kam der Hiatus und 2016 dann zweimal El Nino – spannend, wie es weitergeht…

Dann sollte man noch ein besonderes Augenmerk auf die CO2-Mauna-Loa-Kurve richten. Man darf gespannt sein, ob jetzt der Wendepunkt beim CO2-Anstieg in der Atmosphäre erreicht wird, was für rationale Menschen Entspannung beim Dekarbonisierungs-Wahn signalisieren sollte. Nicht natürlich bei unseren medial Klima-Indoktrinierten und die sind leider die Mehrheit – zumindest bei den Wählerstimmen…

Es gibt den Dienst: http://temperature.global/

Dieser Dienst läuft offenbar seit 1/2015 ununterbrochen und bezieht seine Temperaturangaben auf einen Referenzwert von +14°C. Es werden stündlich unkorrigierte Rohwerte von vielen Zehntausend Bodenstationen mit Onlineverfügbarkeit abgefragt und verarbeitet.

Man sieht, die Kurve schlug 2015 und 2016 ins Positive aus, was Temperaturen teilweise über +15°C entspricht. Seit Ende 2016 bis heute bewegen sich die Temperaturen immer unter der 14°C Schwelle, aktuell bei 13,87°C.

Was diese Auswertung jedenfalls nicht hergibt, ist eine ununterbrochene Weitererwärmung mit ausschließlich positivem Vorzeichen, im Gegenteil.

Wenn es stimmt, daß pro Stunde zwischen 40.000 und 80.000 Stationen verarbeitet werden, ist die Zeitkonsistenz dieser Messung wesentlich besser als z. B. einer Satellitenmessung, weil bei Satelliten viel Zeit vergeht, bis eine konkrete Gegend neu gemessen wird. Was in dieser Zeit passiert, geht dem Satellit durch die Lappen.

Satelliten zur Temperaturmessung haben Bahnen unter 90° zum Äquator, laufen also auf einer Polarbahn, während die Erde sich unter ihnen durchdreht. Wenn so ein Satellit wie üblich 12 Umläufe pro Tag macht, verläuft der nächste Scan um 30° versetzt zum letzten. Weil sich die Erde kontinuierlich dreht, verlaufen die Projektionen der Bahn auf die Oberfläche aber nicht auf Meridianen sondern schräg dazu. Dadurch ergibt sich ein Muster, bei dem ein „Zweieck“ zunächst von Süd nach Nord abgetastet wird und ein dazu um 15° versetztes Zweieck 12 Stunden später von Nord nach Süd, usw. Wenn man die Länge des Äquators grob mit 40.000 km rechnet, ergeben 30° am Äquator einen Abstand von 3330 km und 15° ergeben 1660 km. Und es werden aufgrund des Verfahrens nicht bodennahe Temperaturen gemessen, sondern Troposphärentemperaturen in vielen km Höhe. Gemessen wird temperaturabhängige Mikrowellenemission von Luftsauerstoff im 50-60 GHz Bereich. Ein 1:1 Vergleich mit Bodenmessungen ist daher weder möglich noch sinnvoll.

Sie haben recht, letztendlich ist auch die Satellitenmessung eine zeitlich und räumliche Mittelung mit unsicherer Annäherung an den exakten globalen Mittelwert – und das noch in der Troposphäre und nicht in Bodennähe. Trotzdem hat Roy Spencer gezeigt, dass bei den Datensätzen von UAH/Roy Spencer eine sehr gute/die beste Übereinstimmung mit Höhen-Ballon-Messungen besteht. Auch muss man davon ausgehen, dass die Computermodell-Basteleien des IPCC im Vergleich zu den Satelliten-Messungen noch weitaus mehr Kaffeesatz-Leserei beinhalten. Und man bei UAH/Roy Spencer wenigstens hinsichtlich der Adjustierungen das meiste Vertrauen haben kann.