Von der Website science, climat et énergie (SCE)

[Alle Hervorhebungen in diesem Beitrag im Original. ]

Wir haben erfahren, dass der Nobelpreis für Physik 2021 am Dienstag, den 5. Oktober, an zwei Experten für die Modellierung des Klimawandels, den amerikanisch-japanischen Syukuro Manabe und den deutschen Klaus Hasselmann, sowie an den italienischen Theoretiker Giorgio Parisi verliehen wurde.

Die Hälfte des Preises geht an den 90-jährigen Syukuro Manabe und den 89-jährigen Klaus Hasselmann „für die physikalische Modellierung des Erdklimas und für die Quantifizierung seiner Variabilität und die zuverlässige Vorhersage der globalen Erwärmung“, so die Jury. Die andere Hälfte des Preises geht an Giorgio Parisi, 73, „für die Entdeckung des Zusammenspiels von Unordnung und Fluktuationen in physikalischen Systemen vom atomaren bis zum planetarischen Maßstab“.

SCE beglückwünscht die Preisträger und nutzt die Gelegenheit, um an einige offensichtliche Fakten zu erinnern, die von den meisten Medien nicht erwähnt werden.

1. Das Nobel-Komitee belohnt Modellierer

Mit dem Nobelpreis für Physik werden Modellphysiker ausgezeichnet, d. h. Wissenschaftler, die auf der Grundlage bekannter physikalischer Gesetze komplexe mathematische Modelle erstellen und damit versuchen, vergangene und zukünftige Veränderungen im Klimasystem zu reproduzieren.

Dabei ist zu bedenken, dass ein mathematisches Modell nicht die Realität ist und dass im Hinblick auf das Klima kein Modell jemals in der Lage sein wird, genau vorherzusagen, was in der Zukunft passieren wird.

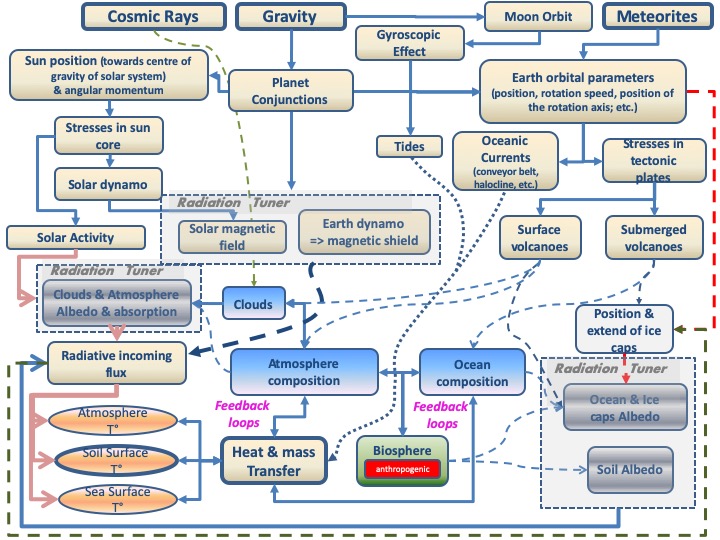

Das ist der Grund dafür. Erstens sind viele physikalisch-chemische Phänomene noch immer schlecht verstanden (z. B. die Bildung von Wolken [französisch]). Sollte sich herausstellen, dass dies nicht der Fall ist, könnte die wissenschaftliche Forschung heute eingestellt werden. Das Klima ist ein komplexes System, d. h. es setzt sich aus einer Vielzahl von Elementen zusammen (sowohl auf der Erde als auch außerhalb der Erde), und alle diese Elemente können untereinander eine Vielzahl von Wechselwirkungen haben (Abbildung 1). Es sind viele Arten von Wechselwirkungen möglich; das System enthält auch viele direkte oder indirekte Rückkopplungsschleifen (und daher mit einer gewissen Verzögerung). Es ist auch dynamisch, d. h. es entwickelt sich in Raum und Zeit.

Abbildung 1. Die vielen Parameter, die das Klima steuern: das „Klima-Metamodell“. Für weitere Informationen siehe hier [französisch].

Wenn die Wechselwirkungen zwischen den Objekten des Systems linear und kurzzeitig sind, kann die Entwicklung des dynamischen Systems als Funktion der Zeit durch Systeme gewöhnlicher Differentialgleichungen modelliert werden. Das System entwickelt sich dann mit der Zeit zu einer einzigen Lösung, bei der sich die Werte der Variablen nicht mehr ändern. In diesem Fall können Vorhersagen gemacht werden.

Leider sind natürliche Systeme, die die Eigenschaft der Linearität besitzen, äußerst selten, um nicht zu sagen nicht existent. Viele Systeme lassen sich jedoch einigermaßen linearisieren, um ihre Untersuchung zu erleichtern. Viele Theorien der Physik und der Mechanik werden daher unter Berücksichtigung linearer Systeme aufgestellt.

Wenn aber die Wechselwirkungen zwischen den Objekten des Systems nichtlinear sind (Anmerkung: nichtlinear = das „Überlagerungsprinzip“ wird nicht beachtet; die meisten physikalischen Systeme sind nichtlinear. Beispiel: Navier-Stokes-Gleichungen in der Flüssigkeitsmechanik), muss die Entwicklung des dynamischen Systems als Funktion der Zeit durch Systeme nichtlinearer Differentialgleichungen modelliert werden. Diese Gleichungen sind sehr schwer zu lösen… Lange Zeit mussten wir auf Vereinfachungen zurückgreifen, um diese Gleichungen unter den Bedingungen der Linearität zu untersuchen. Glücklicherweise können uns die Computer helfen. Und diese Computer zeigen uns dann, dass es mehrere mögliche Lösungen gibt! In einigen Fällen konvergiert das System nie direkt zu der einen oder anderen Lösung, sondern „dreht sich“ in asymptotisch konvergierenden Bahnen; in anderen Fällen entwickelt sich das System in variablen, aber nicht konvergierenden Bahnen um einen der „seltsamen Attraktoren“ und wechselt zu unvorhersehbaren Zeiten von einem „Attraktor“ zum anderen. Ein solches System wird als „chaotisch“ bezeichnet (im mathematischen Sinne des Begriffs; im Englischen ist es ein „dynamisches System“). Es kann durch ein System perfekt definierter nichtlinearer Gleichungen beschrieben werden, aber der Wert seiner abhängigen Variablen kann sich zu einem bestimmten Zeitpunkt enorm ändern, wenn wir die Ausgangsbedingungen oder den Wert eines der Parameter nur geringfügig ändern, was ein solches System in der Praxis vollkommen unvorhersehbar macht. Dies ist das, was man als deterministisches Chaos [französisch] bezeichnet hat. Das System schwingt unregelmäßig (aperiodisch) und wiederholt nie genau dieselbe Schwingung zweimal. Es ist also nicht möglich, das Verhalten des Systems auf lange Sicht vorherzusagen.

Im deterministischen Chaos bestimmt jede Anfangsbedingung vollständig die zukünftige Entwicklung, denn es handelt sich nicht um einen Zufall: Das System ist vollständig deterministisch. Zwei sehr ähnliche Ausgangsbedingungen können jedoch völlig unterschiedliche Entwicklungen haben. Die Entwicklung des Systems wird dann unvorhersehbar, weil ein kleiner Messfehler oder eine Rundung auf die 15. Nachkommastelle nach einer gewissen Zeit zu völlig anderen Ergebnissen führt.

Mit anderen Worten, wenn eine mathematische Variable geringfügig geändert wird, wird das Klimamodell nicht dieselbe Vorhersage liefern. Hier ist ein konkretes Beispiel (Abbildung 2).

Abbildung 2. Ergebnisse von 30 Simulationen, die mit demselben Klimamodell durchgeführt wurden (Karten 1 bis 30), für Nordamerika im Winter. Die Karten zeigen die Trends zwischen 1963 und 2012 (50-Jahres-Zeitraum). Der einzige Unterschied zwischen den Simulationen ist die Starttemperatur, wobei die Unterschiede zwischen den Simulationen sehr gering sind (es wurde eine kleine [(10↑-14)°C] zufällige Rundungsdifferenz zum anfänglichen Lufttemperaturfeld verwendet). Die EM-Karte ist der Durchschnitt der 30 Simulationen, die OBS-Karte sind die Beobachtungen. Die Farben stellen die Variationen (in °C) über 50 Jahre dar. Quelle: Deser et al. 2016, Journal of Climate 29: 2237-2258.

Abbildung 2 (aus Deser et al. 2016, Journal of Climate 29: 2237-2258) zeigt uns, dass wir völlig unterschiedliche Vorhersagen erhalten können, wenn wir die Ausgangstemperatur um einen winzigen Wert (10↑-14°C) variieren.

Der Mittelwert der Simulationen (EM in Abbildung 2) stimmt nicht mit den beobachteten Messungen überein, und schlimmer noch, wir bringen die Modelle dazu, genau das zu sagen, was wir wollen, indem wir einen der Parameter auf infinitesimale Weise verändern. Man kann naiv hoffen, dass mathematische Modelle (und ihre Algorithmen zur Berechnung eines Mittelwerts) es ermöglichen, die chaotische Signatur eines komplexen Phänomens zu „löschen“, aber in Wirklichkeit verleihen die Modelle selbst, durch die Struktur der verwendeten Gleichungen, den Ergebnissen, die sie produzieren, einen chaotischen Charakter.

Für weitere Einzelheiten sei auf die Veröffentlichung [französisch] des SCE über chaotische Systeme verwiesen.

2. Klimamodelle sind ungenau

Nach dem eben Gesagten ist es offensichtlich, dass die Jury des Nobelkomitees falsch liegt, wenn sie schreibt, dass Klimamodelle „die globale Erwärmung zuverlässig vorhersagen können“. Hier sind zwei weitere Beobachtungen, die das Gegenteil zeigen:

– Kein Computermodell hatte die Pause (den „Hiatus“) in der Entwicklung der globalen Temperaturen, die zwischen 1998 und 2014 beobachtet wurde, vorhergesagt. Zu diesem Problem sind Dutzende von Artikeln veröffentlicht worden. Siehe zum Beispiel Hedemann et al. 2017 (Nature Climate Change).

– Computermodelle, die auf der CO2-Rate basieren, sagen einen atmosphärischen „Hot-Spot“ voraus (wir haben hier [französisch] darüber berichtet). Dieser „Hot-Spot“ entspricht jedoch nicht den Messungen, die in situ mit Wetterballonen durchgeführt wurden! Für weitere Details siehe Christy et al. 2018.

Glauben Sie immer noch, dass die Klimamodelle korrekt sind? Es ist seit langem bekannt, dass die Klimamodelle übermäßige Erwärmungsraten in der tropischen Troposphäre aufweisen. Und das ist kein Geheimnis für viele Modellierer, die versuchen, ihre Modelle zu verbessern… Nur das Nobelkomitee scheint es nicht zu wissen!

Was die neuen Versionen der Klimamodelle CMIP6 (Coupled Model Intercomparison Project Version 6) angeht, die im letzten Bericht des IPCC (AR6) verwendet wurden, so sind sie nicht besser. In einer Veröffentlichung aus dem Jahr 2020 untersuchten McKitrick und Christy beispielsweise 38 CMIP6-Modelle anhand historisch beobachteter Parameter. Sie konzentrierten sich dabei auf den Zeitraum 1979-2014. Die Autoren zeigen, dass die Modelle zu einer Erwärmung führen, die nicht mit den Beobachtungen übereinstimmt, weder für die untere noch für die mittlere Troposphäre, weder in den Tropen noch anderswo auf der Welt.

3. Die Philosophie des Nobelpreises dürfte nicht beachtet worden sein

Es ist unklar, ob Alfred Nobel den Physikpreis 2021 billigen würde, wenn er ihn sehen könnte. Der Erfinder des Dynamits war ein leidenschaftlicher Verfechter der konkreten Aspekte von Wissenschaft und Technik und wollte diejenigen belohnen, die einen konkreten Beitrag zu deren Fortschritt geleistet hatten. So wurde der Nobelpreis für Physik 1903 gemeinsam an das Ehepaar Curie (Pierre und Marie) und an Henri Becquerel für die Entdeckung der natürlichen Radioaktivität verliehen, einem bis dahin unbekannten physikalischen Phänomen. Der Nobelpreis von 1935 wurde James Chadwick für seine Entdeckung des Neutrons im Jahr 1932 verliehen, eines wesentlichen Elements, das die Materie ausmacht. Beispiele dieser Art gibt es viele.

Erst nach und nach wurde der Preis auch für Theorien esoterischer Natur verliehen. Eine der Bedingungen für die Verleihung war, dass diese Theorien zum Verständnis der Eigenschaften der physikalischen Welt beitragen konnten. Ein gutes Beispiel dafür ist der Nobelpreis für Physik von 1963, der Eugène Wigner (gemeinsam mit Maria Goeppert-Mayer und Hans Jensen) für seine grundlegenden Arbeiten zu Symmetriegruppen verliehen wurde, einer sehr abstrakten mathematischen Theorie zum Verständnis wichtiger Aspekte der Struktur des Universums.

Mit dem Nobelpreis für Physik 2013 wurden zwei Theoretiker (Brout und Englert) ausgezeichnet, die ein mathematisches Modell entwickelt haben, das die Eigenschaften eines fundamentalen Teilchens, des Higgs-Bosons, erklärt, das 2012 mit den Instrumenten am großen CERN-Collider nachgewiesen wurde. Diese Entdeckung erklärt die Verleihung des Preises an die drei Autoren, von denen nur zwei den Preis erhielten, da Brout 2011 verstarb.

Der diesjährige Preis wird dieser Perspektive bei weitem nicht gerecht. Bringen diese Autoren des Modellierens noch nie dagewesene Ergebnisse? Wir können das bezweifeln, mit der möglichen Ausnahme von Giorgio Parisi. In der Begründung ist lediglich von „zuverlässigen“ Ergebnissen die Rede. Das Mindeste, was wir sagen können, ist, dass diese Einschränkung nicht viel bedeutet. Außerdem bietet das Modell nichts grundlegend Neues in der Physik. Alles, was es ausmacht (Physik der Sonne, der Atmosphäre, der Ozeane und ihrer Wechselwirkungen), ist seit Jahrzehnten bekannt. Der Preis ist also eher eine „mathematische“ als eine „physikalische“ Aufgabe. Der Wille Alfred Nobels wird also in gewisser Weise verraten.

4. Conclusions

Indem das Nobelkomitee am Vorabend von COP26 Klimamodellierer belohnt, macht es eine politische und mediale Geste. Das gemeine Volk, das keine Ahnung von Modellierung hat, wird dazu neigen, den Vorhersagen des Heiligen Berichts des IPCC zu glauben.

Abschließend sei an dieser Stelle daran erinnert, was der Physiker Jacques Duran auf seiner Website „Pensée-unique“ geschrieben hat:

„Vorhersagen über die Zukunft unseres Planeten sind gelinde gesagt riskant, denn wir haben es mit einem riesigen System von Differentialgleichungen mit unbekannten Koeffizienten zu tun, die nichtlinear und miteinander gekoppelt sind. Diese Gleichungen sind daher sehr schwer zu entschlüsseln. Darüber hinaus verhalten sich einige dieser Gleichungen chaotisch, d. h. sie reagieren sehr empfindlich auf oft unbekannte Anfangsbedingungen. Es gibt nichts Schlimmeres! Doch Computerprogrammierer haben einen Heidenspaß mit Tausenden von unbekannten Parametern und der Form von Master-Gleichungen, die man versuchen muss zu erraten. Das Problem ist jedoch, dass wir die Ergebnisse beliebig verändern können, indem wir nur einen der Parameter oder nur eine der unbekannten Gleichungen ändern. Wie können wir dann glauben, dass Computer eine korrekte Vorhersage machen, wenn die wesentlichen Mechanismen des Austauschs und der positiven und negativen Rückkopplungen immer noch sehr schlecht verstanden sind und immer noch Gegenstand erbitterter Diskussionen zwischen Chemikern, Physikern, Klimatologen und anderen Geophysikern sind?“

Der Glaube an den Wahrheitsgehalt einer bestimmten Computervorhersage ist eher eine Glaubensfrage als eine wissenschaftliche Gewissheit. Angesichts der Vielzahl möglicher Auflösungsmethoden, der komplizierten Gleichungen und der Anzahl der einstellbaren Parameter sind die Ergebnisse von Computersimulationen für jemanden, der sie nicht selbst programmiert hat, nur schwer zu kontrollieren. Kurzum, wir tappen im Dunkeln, und die Vorurteile nehmen überhand. Politiker und Umweltschützer hingegen wählen die Ergebnisse aus, die für sie richtig sind, ignorieren aber die vielen Unsicherheiten, Annäherungen und Probleme, die die angewandten Methoden mit sich bringen. Politiker und Umweltschützer sind völlig unfähig, die Verlässlichkeit der ihnen mitgeteilten Ergebnisse einzuschätzen, und man kann es ihnen angesichts der Schwierigkeiten des Problems nicht verdenken. Das Einzige, was man ihnen vorwerfen kann, ist ihre zu große Leichtgläubigkeit und ihre zwingenden Behauptungen, um zu glauben, dass all dies sicher ist, während es das überhaupt nicht ist!“

5. References

John R. Christy, Roy W. Spencer, William D. Braswell & Robert Junod (2018) Examination of space-based bulk atmospheric temperatures used in climate research, International Journal of Remote Sensing, 39:11, 3580-3607, DOI: 10.1080 /01431161.2018.1444293

Link: https://www.science-climat-energie.be/sce-info-a-nobel-prize-for-mathematical-models/

Übersetzt von Christian Freuer für das EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Also die Abbildung 1 („Klima-Metamodell“) macht einen vernünftigen Eindruck. Ist aber bestimmt nicht Gegenstand des Nobel-Preises. Das ist wohl eher das kleine rote Kästchen auf dem Diagramm. Und die Preisträger behaupten jetzt wirklich, sie könnten die globalen Erwärmung auf Jahrhunderte zuverlässig vorhersagen, natürlich inkl der Quantifizierung seiner Variabilität. Echt, wer glaubt denn an sowas? Vorsichtig ausgedrückt (mir fallen da ganz andere, viel zutreffendere Ausdrucksformen ein) sind diese Modelle, betrachtet man die Abbildung 2, fuer eine seriöse Vorhersage schlichtweg unbrauchbar.

Zurück zum „Klima-Metamodell“, links oben ist das Kästchen „Planet Conjunctions“. Damit sind sicherlich, vor allem die 4 größten Planeten Jupiter/Saturn/Neptun/Uranus gemeint, welche in 12/30/84/165 Jahren die Sonne umrunden. Sie verschieben den Massenschwerpunkt des gesamten Sonnensystems zyklisch um bis zu 2 Millionen Kilometer (= 5-fache Entfernung Erde-Mond, das Licht braucht für diese Strecke ca. 7 Sekunden)! Das muss man sich mal vorstellen: es gibt Jahre, da befindet sich der Massenschwerpunkt des gesamten Planetensystems innerhalb der Sonne, einige Jahrzehnte später wieder bis zu ca. 1 Million km außerhalb der Sonne! Eins ist da absolut sicher: das hat gewaltige, zyklische Auswirkungen auf die Vorgänge innerhalb der Sonne. Das soll im „Klima-Metamodell“ im Kästchen „Stresses in sun core“ angedeutet werden.

In meinem Kommentar am 7. Juni 2021 zu EIKE, 6. Juni 2021, „Kältereport Nr. 12“ steht eine einfache Mathe/Physik-Aufgabe +Lösung, wie man die Verschiebungen des Schwerpunktes des Planetensystems selbst berechnen kann. Jedes aufgeweckte (Schul-)Kind sollte dazu in der Lage sein.

Mathe for Future (MFF) statt Volksverdummung durch Friday for Future (FFF)!

Weiter geht es im „Klima-Metamodell“ mit den Sonnenaktivitäten, Sonnen-Magnetfeldänderungen, Wolkenbildung, Höhenstrahlung usw usf. Und hier auf der Erde ist natürlich das Wasser mit seinen einzigartigen thermodynamischen Eigenschaften der „Chef im Ring“. Nix co2, wie uns diese Flachdenker (Knechte der Super, Super Reichen) mit der Selbstzerstörungs/Abzock-Agenda-2030 über die Altmedien/Altparteien einreden wollen.

Wie im Fachbeitrag schon zum Ausdruck gebracht, eine seriöse Berechnung der zukünfigen Klima-Änderungen ist unmöglich bis sehr schwer, in jedem Fall aber sehr ungenau. Was aber eine Hilfe sein könnte, und auch schon gemacht wird, ist die Tatsache, dass diese „Planet Conjunctions“ im „Klima-Metamodell“ indirekt Spuren auf der Erde hinterlassen (Kästchen: „Radiative incomimg flux“). Diese Spuren aus der Vergangenheit (Eisbohrkerne) sind zeitlich bestimmbar. Das gleiche gilt für die „Planet Conjunctions“, denn die 4 größten Planeten umkreisen präzise wie ein „Schweizer Uhrwerk“ die Sonne. Man muss also „nur“ noch das Klima der Vergangenheit und den damaligen, leicht berechenbaren Planetenstellungen mit den heutigen oder zukünftigen Planetenstellungen vergleichen, und kann dann Rückschlüsse auf die zu erwartende Klima-Änderung ziehen.

Auch das wurde bei EIKE schon gemacht, zum Beispiel hier:

In dem EIKE-Fachbeitrag „Der solare Retrograd-Zyklus“ vom Nov 27, 2020 ist sogar von einer richtigen Eiszeit die Rede, die sehr bald kommen wird, nix Klima-Erhitzung! Nicht das Klima muss geschützt werden, sondern unsere Freiheit. Auch müssen wir uns weltweit vor den korrupten Regierungen schützen, damit die Bevölkerung den zu erwartenden Klima-Wandel (Abkühlung) durch bewährte Kohle/Gas/Atom-Kraftwerke zusammen mit den alternativlosen Kohlenwasserstoffen überstehen kann. Diese Windmühlen/Solaranlagen (Schrott, da kein Speicher verfügbar) helfen da bestimmt nicht weiter, sondern verschlimmern nur alles massiv.

Ok

Sehe ich nicht, wodurch?

Sehr geehrter Herr Heinemann,

da kann geholfen werden:

Ein ähnlicher Fall aus der alltäglichen Praxis. Man stelle sich einen PKW vor, an dessen Vorderrad das bei der Reifenmontage und Auswuchtung angebrachte Ausgleichsgewicht fehlt bzw. abgefallen ist. Der Abrollumfang des Rades ist ca. 2 m. Bei einer Geschwindigkeit vom 72 kmh = 20 m/s vibriert das Lenkrad mit f = ((20 m/s) / 2 m) = 10 Hz. Das hat man als Autofahrer bestimmt schon mal erlebt. Der gleiche Effekt kann auch auftreten, wenn die Vorder-Reifen abgefahren sind und schon lange nicht mehr ausgewuchtet wurden. Bei hohen Geschwindigkeiten und langer Zeit kann das durchaus zu Schäden am Radlager führen.

Nun zur Sonne:

Da ist grundsätzlich überhaupt nichts ausgewuchtet. Die Planeten wollen eigentlich das Planetensystem verlassen, werden aber durch die Zentripetalkraft der Sonne (=Massenanziehung durch die Gravitation) davon abgehalten. Der Effekt (= zyklische Auswirkungen auf die Vorgänge inerhalb der Sonne) tritt jetzt nicht durch die Unwucht selbst auf, sondern durch die laufende zyklische Änderung der Unwucht. Beispiel: die beiden größten Planeten Jupiter (=318 Erdmassen, Umlaufzeit: 11,9 Jahre) und Saturn (=95 Erdmassen, Umlaufzeit: 29,5 Jahre) sind am Anfang von der Sonne aus gesehen in der exakt gleichen Richtung angeordnet. Das ergibt eine Schwerpunktverschiebung des Sonnensystems um ca. 1 Millionen km in Richtung der beiden Planeten zu diesem Zeitpunkt. Ca. 10 Jahre später stehen sich Jupiter und Saturn genau gegenüber. Die Unwucht beträgt nur noch ca. 0,33 Millionen Km in Richtung Jupiter. Nach weiteren 10 Jahren zeigen Jupiter und Saturn wieder in die gleiche Richtung und das Spiel beginnt wieder von vorne. Alleine durch Jupiter und Saturn „vibriert“ die Sonne mit einer Frequenz von ca. 1/(20 Jahren) oder besser ausgedrückt mit einer Zykluszeit von 20 Jahren („Klima-Metamodell“: Kästchen „Stresses in sun core“). Die Planeten Uranus(=14,5 Erdmassen, Umlaufzeit: 84 Jahre) und Neptun (=17,1 Erdmassen, Umlaufzeit: 165 Jahre) haben da natürlich auch noch ein Wörtchen mitzureden.

So ein Kommentar ist natürlich kein Vortrag, mehr Infos dazu gibt es bestimmt am 12.-13. November 2021 bei der 14. Internationalen EIKE- Klima- und Energiekonferenz in Gera.

Herr Wähner,

Danke für Ihre Erklärungen, aber soweit bin ich schon. Meine Frage ließe sich einfach durch einige wissenschaftliche Arbeiten zum Einfluß der Schwerpunktbewegung auf die Stellarphysik, also der Magnetohydrodynamik der Sonne klären. Haben Sie solche paper? Grundsätzlich müssen es ja die gleichen Effekte ( nur schwächer) wie bei Doppelsternsystemen sein.

Nur mal so zum Nachdenken: relativ zu was bewegt sich denn die Sonne, wenn sie sich um den Schwerpunkt des Sonnensystems dreht, und woher kommen dann die physikalischen Kräfte. Einfach abzuschätzen ist auch die zusätzliche Zentrifugalkraft auf die Sonnenmaterie und deren Verhältnis zu derselben aufgrund der der Eigenrotation der Sonne. Nur mal überschlagsmässig: die Sonne rotiert in ca. 1 Monat einmal um sich selbst, der Jupiter induziert eine Peroide von 12 Jahren, die Zetrifugalkraft skaliert mit der Drehfrequenz zum Quadrat, bei größenordnungsmäßig gleichem Drehradius von 0,7 Mio km ist das Verhältnis der Fliehkräfte Jupitereinfluss / Eigenrotation = (1Monat / 12×12 Monate)^2 = 1/20.000. Stimmt’s? Die sonnenaktivität wird durch den Jupiter (alle anderen Planeten haben noch geringeren Einfluss) also um 1/20.000 gegenüber der „eigengesteuerten“ Aktivität beeinflusst.

naja, die Autoren scheinen sich nicht mit Physik auszukennen und zu wissen, dass die Physik nicht nur aus Empirie und auf experimentellen Ergebnissen besteht, sondern einen Großteil ihres Erfolges aus der Theorie und der damit verbundenen mathematischen Beschreibung bestreitet. Wer dies „esoterisch“ nennt, versteht die Zusammenhänge und ihre Bedeutung für die Naturgesetze offensichtlich nicht. Natürlich sind viele „Theorien“ nicht erfolgreich, aber es ist ja gerade das bestreben der Physik, die „richtigen“, d.h. diejenigen, die sich experimentell bestätigen, zu finden. Nur ohne Theorie taugt das beste Experiment nichts, denn man versteht gar nichts, was dort passiert.

@ Heinemann am 15. Oktober 2021 um 12:44

Sie haben vollkommen recht, „… einen Großteil ihres Erfolges aus der Theorie und der damit verbundenen mathematischen Beschreibung bestreitet.“

Genau das fehlt aber beim sog. Treibhauseffekt! Es gibt weder eine semantisch eindeutig ausformulierte Theorie, noch eine diese Theorie vollständig abbildende mathematische Notation, die diese Theorie auf Basis der bekannten Physik abhandelt und belegt. Gäbe es so eine Notation nämlich, gäbe es keine widersprüchliche Diskussion. Weil Leute, die bekannte Physik „leugen“, sind mir vollkommen unbekannt.

Die Welt wartet nach wie vor vergeblich auf eine eindeutige Notation, die lückenlos, durchgängig und damit meßtechnisch verifizierbar die angebliche Wirkung beschreibt.

„…dass die Physik … einen Großteil ihres Erfolges aus der Theorie und der damit verbundenen mathematischen Beschreibung bestreitet.“

Sie beschreiben auf wunderbare Weise das Grundproblem der heutigen Füssigger:

Eine Theorie aufstellen und diese mathematisch zu beschreiben hat keinen Wert und ist damit auch kein Erfolg.

Ein Erfolg wäre für eine in der Natur gemachte Beobachtung eine Theorie aufzustellen, diese mathematisch zu beschreiben und die Richtigkeit der Theorie mittels Experiment und Vergleich mit der Realität zu beweisen.

Ihr Beitrag beweist aber auch eines:

Ihre Ahnungslosigkeit!

Mathematische Modelle funkltionieren dann und nur dann, wenn sie auf bekannten und bewiesenen Zusammenhängen aufbauen! Gleichzeitig darf es keine Bereiche geben, die unberücksichtigt bleiben, es muß also der gesamte Prozeß vollständig modelliert werden, um sinnvolle Ergebnisse zu erhalten.

Ich frage, welche Zusammenhänge kennt man beim „Klima“ so gut, daß sie bewiesen sind? Keinen einzigen! Klimamodelle bauen auf Vermutungen und auf einer Unzahl von Parameterannahmen auf. Man muß nichts studiert haben, um zu erkennen, daß so etwas bestenfalls ein Computerspiel ist und die Ergebnisse reine Fiktion sind.

Und daß ein Modell, in dem eine Annahme enthalten ist, daß mehr CO2 zu mehr Temperatur führt, bei steigendem CO2 mehr Temperatur ausspuckt, ist sonnenklar und wenig verwunderlich. Dazu braucht man aber kein Modell, dazu genügt eine einfache Schlußrechnung!

Nobel dreht sich wohl im Grabe um, mehr fällt mir dazu nicht ein.

Mich würde eines interessieren:

man kann immer wieder lesen, eine Erwärmung von ca. 1,5°C durch CO2-Verdoppelung könne nachgewiesen werden, angeblich sogar in irgendwelchen Versuchen!? Viele Klimatologen vertreten angeblich diese Meinung.

Wo kann man die Ableitung/Erklärung dieser Behauptung nachlesen und wie sieht der Versuch konkret aus? Wie kann sie z. B. aus der Darstellung TK97 herausgelesen werden?

Nirgends! Und es gibt nur die Versuche von Dr. Michael Schnell, hier bei EIKE nachzulesen. Und ob und wenn ja wie weit übertragbar sind, steht in den Sternen.

Daraus das Resumé:

Sie meinen vermutlich Kiehl/Trenberth 97, also KT 97. Aus diesem Nullsummenspiel (Bodenstrahlungsfluss vs. Gegenstrahlungsfluss) können Sie beliebiges herauslesen.

Das „beliebige“ daran ist sicher falsch. Nicht beliebig, sondern schwarz auf weiss ist hingegen der Mittelwert der Abstrahlung vom Boden, so um 390 W/m2, was zwangslos mit der Temperaturverteilung über den Globus im Einklang steht, und die korrespondierende Abstrahlung ins All von so 240 W/m2. Beide Zahlenwerte waren die letzten Jahrzehnte noch mit etwa 10 W/m2 Unsicherheit behaftet. Aber auch damit ist klar, dass sie nicht gleich sind und damit der Treibhauseffekt unzweifelhaft existiert.

Richtig. Setzt man dagegen die unleugbare Einstrahlung auf der Halbkugel an, jeden Tag den Gott werden lässt zu sehen, dann stimmt die Bilanz auch wieder. Dann braucht man nicht das Karussell von KT sondern einfache Strahlungsphysik.

Admin schrieb am 17. Oktober 2021 um 21:45

Durch eine andere Verteilung wird es nicht mehr Energie: A/2 * 480W/m² = A*240W/m² < A*390W/m² mit A – Oberfläche der Erde. Sie können das auch an den Iterationen von Herrn Weber sehen, der letzten Endes die Bilanz durch seine Einführung des „Stefan-Boltzman-Umgebungsgesetzes“ ausgleichen musste – ein „Gesetz“, das die von der Erdoberflöche abgestrahlte Energie reduziert. Schaut man sich das „Gesetz“ an, ist es eigentlich nur eine verschleierte Einführung der Wirkung der „Gegenstrahlung“ …

#268140

Niemand hat behauptet das deswegen mehr Energie eingestrahlt wird. Die Einstahlleistung/Fläche – und nur die zeigen K/T – ist aber anders verteilt.

Admin am schrieb 18. Oktober 2021 um 12:48

Können Sie dann vielleicht mal ergänzen, die durch die Betrachtung der Einstrahlung auf eine Halbkugel die Bilanz ausgeglichen wird?

#268165

Die Energiemenge die – eideutig und nicht zu bestreiten – nur auf der Tagseite, also der Halbkugel, eingestrahlt wird, muss und wird über die Tag- und Nachtseite, also die Vollkugel, wieder abgestrahlt. Die Bilanz ist ausgeglichen. Wo liegt das Problem?

Admin am 18. Oktober 2021 um 15:05

Das Problem ist nachgelagert. Denn daraus alleine läßt sich nicht die beobachtbare Temperaturverteilung folgern, die Vertreter dieser Theorie behaupten dies aber. Indem sie die in jedem Moment eingestrahlte Leistungsdichte am Tage gleich der abgestrahlten setzen. Dies ist jedoch falsch.

Da sind Sie auf dem Holzweg. Die beobachtete Temperaturverteilung passt exzellent zu dieser nicht bestreitbaren Tatsache.

Admin schrieb am 18. Oktober 2021 um 15:05

Ich hatte die Bilanz hingeschrieben: A/2 * 480W/m² < A*390W/m² mit A – Oberfläche der Erde.

Haben Sie das kleiner-Zeichen darin bemerkt? Es wird mehr abgestrahlt, als eingestrahlt – es ist ein Defizit von A*150W/m² in der Bilanz. Irgendwie verstehe ich nicht, wie Sie sagen könne, dass die Bilanz ausgeglichen wäre. Entgeht mir hier was?

#268186

Sie vergleichen Äpfel mit Birnen. Ich rede von der Bilanz der Energiemenge die zu und abgeführt wird. Sie von der eingestrahlten Leistung/Fläche. Warum soll die ausgeglichen sein?

Admin am 18. Oktober 2021 um 16:17

Vielleicht können Sie Ihre Bilanz ja mal etwas formaler hinschreiben? Dann kann es keine Missverständnisse geben.

In meiner Bilanz gab es kein pro Fläche mehr, es war die pro Sekunde zu- und abfliessende Energie gegenübergestellt (durch die Multiplikation mit A entfiel das pro Fläche). Das kann man auch gerne durch Angabe einer Zeitspanne zu Energie machen. Es sollte aber eigentlich offensichtlich sein, dass sich dadurch nichts am Defizit ändert. Durch Multiplikation mit Fläche und Zeit werden nur die Zahlen größer …

#268194

Sie machen mehrere Fehler auf einmal.

Es gibt keine Notwendigkeit eine Strahlungsbilanz der Leistung zu erstellen. Die Leistung kann morgen hoch und übermorgen niedrig sein. Ihre Bilanz kann heute aufgehen, morgen nicht übermorgen nur zum Teil. Macht nichts, entscheidend ist nur wieviel Energie ein und ausgetragen wird. Daher nur eine Bilanz der Energie- Zu und Abfuhr.

Es gibt auch keine Notwendigkeit Flächen einzubeziehen, kann man machen, muss aber nicht wieder muss nur die Energiemenge über Zu- und Abfuhr bilanziert werden.

Sie tun aber beides.

Das einzig realistische Experiment ist die reale komplexe Atmosphäre samt Ozeanen. Die sich mit realistischen Wasserdampf- und CO2-Spurengas-Konzentrationen nicht in Labordimensionen simulieren lässt – bereits die Messsignale wären dort viel zu gering.

Happer und al. haben für CO2 und Wasserdampf sehr sorgfältige spektroskopische Berechnungen durchgeführt – für clear sky-Bedingungen. Und kommen mit Wasserdampf-Verstärkung auf 2,4 Grad Klimasensitivität. Berücksichtigt man, dass die Erde zu 2/3 bewölkt ist, der CO2-Effekt dort von der Bewölkung überdeckt wird und nimmt man die anderen Klimagase hinzu (evtl. auch 20% Wärmeinseleffekte, wie sie Scafetta vertritt) dann kommt man im Flächenmittel auf etwa 1 Grad Klimasitivität bei CO2-Verdoppelung, wie sie Prof. Happer bei der Bundestagsanhörung vertreten hat.

Verglichen mit dem bisherigen Temperaturanstieg seit der Kleinen Eiszeit von ca. 1 Grad Erwärmung bei knapp 50% CO2-Anstieg wäre dann etwa die Hälfte des bisherigen Anstiegs menschengemacht, so wie es übrigens auch Lüning und Vahrenholt mutmaßen.

@ Dr. Ullrich am 15. Oktober 2021 um 12:00

Vielen Dank für den Hinweis. Allerdings stehe ich, wie schon an anderer Stelle ausgeführt, jeglicher „Verstärkungstheorie“ sehr skeptisch gegenüber. Warum? Weil jeder Verstärker Energie benötigt, um verstärken zu können. Und diese Energie muß von irgendwoher kommen! Wenn ich in einen Verstärker mit 1 W hineingehe und 1,5 W herausbekomme, muß diese Differenzleistung real von irgendwoher verfügbar sein! Woher nimmt der Wasserdampf in diesem Fall diese Leistung?

Nebenbei sollte es wohl eher umgekehrt sein, oder? Wenn man Wasserdampf als das „stärkste“ Treibhausgas ansieht, was auch immer „stark“ bedeutet, dann müßte die Basiswirkung doch vom Wasserdampf ausgehen und CO2 müßte der „Verstärker“ sein, oder?

Kennen Sie die diesbezügliche Happer-Studie? Die würde ich gerne im Detail studieren.

M.E. trifft es zusätzliche „Wärmeisolierung“ durch Klimagase besser, die ohne zusätzliche Wärmequelle eine Temperaturerhöhung bewirkt. Im Winter nutzen wir diesen Effekt, indem wir eine zusätzliche „Isolierschicht“ (=Winterkleidung) anlegen. Die zitierte Arbeit von Happer et al wurde bei EIKE schon zweimal gebracht. Sie ist inhaltlich ziemlich anspruchsvoll und über 20 Seiten lang – sie ist bestimmt mit der Suchfunktion auffindbar.

Bei zwar nur moderat ansteigenden globalen Mitteltemperaturen sollte man vielleicht trotzdem nicht übersehen: Wenn die spektroskopische Erwärmung vor allem unter „clear sky“-Bedingungen wirksam ist, dann würde sich dies vor allem durch mehr Hitzetage bemerkbar mache. Die sich in D seit den 50er-Jahren von ca. 3,6 auf 11 verdreifacht haben sollen:

Klima: Dreimal so viele Hitzetage wie in den Fünfziger Jahren | ZEIT ONLINE

Allerdings kann man geteilter Meinung sein, wieviel davon auf das Konto von Wärmeinseleffekten geht…

Sehr geehrter Herr Dr. Ullrich,

für mich wäre das einzig „realistische“ Experiment, die Erde von kosmischen Einflüssen abzuschirmen und stufenweise das CO2 von 0 auf 100 zu erhöhen, geht aber nicht…

Bezürglich den Vergleich mit der Vergangenheit, sollte man nicht einen erdgeschichtlichen Wimpernschlag, sondern die ganze Erdgeschichte betrachten: von vor 3,5 Mrd bis vor 300 Mio Jahren sank das CO2 kontinuirlich von 17% auf ca. 0,6…0,03% (mit ppm hätte man zu viel Nullen, daher in %), in den letzten 300 Mio Jahren schwankt das CO2 natürlich zwischen 0,6% und 0,03%. Die Temperatur war unbeeindruckt davon immer relativ konstant, immer wieder unterbrochen von Eiszeiten über mehrere Mio Jahren, Korrelation fehlt völlig.

darüber hinaus widerspricht die „Sensitivität“ grundsätzlich der ellementaren Physik, wo bei jeder Gleichung die Einheiten auf beiden Seiten übereinstimmen müssen. Verdopplung CO2 auf der einen, delta K auf der anderen kann nur eine Schätzung sein. Zweitens lehnt mein Verstand ab, dass eine Verdopplung von 1 auf 2 ppm den gleichen Effekt wie die vierdopplung von 50 auf 100% hervorrufen soll.

Es gibt also genügend Gründe, das ganze als Voodoo und nicht als Wissenschaft einzustufen.

@ Dr. Ullrich am 16. Oktober 2021 um 10:57

Natürlich ist es jedem unbenommen, Theorien zu vertreten. Trotzdem kann ich in der Atmosphäre nur schwer eine Analogie zum isolierenden Gewand finden. Eine Isolationsschicht arbeitet so, daß Luft mechanisch körpernah festgehalten wird und die Oberflächentemperatur der Haut annimmt. Es tritt auch keine echte Erwärmung ein, auch wenn man das sprachlich so sagt. Die Temperatur wird nie über jene steigen, die der Mensch durch seinen Stoffwechsel selbst produziert. Ziehen sie einem Stein einen Mantel an, bewirkt die Isolation lediglich eine Zeitverzögerung, mit der die Innentemperatur der Außentemperatur folgt.

Auf der Erde gibt es aber keine Luftschicht die in diesem Fall „oberflächennah“ festgehalten wird. Im Gegenteil, erwärmte Luft steigt rasch auf und kühlere kommt nach. Es kann sich alles frei bewegen. Isolation wäre außerdem Thermodynamik, bei der Klimaerwärmung soll aber doch Strahlung, speziell die Abstrahlung ins All eine Hauptrolle spielen.

Ich werde den Happer-Artikel suchen und bei Gelegenheit studieren. Ich hoffe, es gibt ein abstract, wo man die wesentlichen Erkenntnisse und wie sie zustande kommen, nachvollziehen kann.

Sehr geehrter Herr Strasser,

Gewisse Isolierungseigenschaften innerhalb der Atmosphäre durch Zurückhaltung der Strahlung kann man nicht absprechen, z.B. die Wolken. Im Winter wärmen sie, im Sommer dagegen kühlen sie. Kann mir vorstellen, dass in der Summe die Wolken wärmen, bei den ganzen Strahlenrechnereihen wird aber immer nur die eine Richtung betrachtet.

Dazu kommt, dass nach meinem Verständnis eine Rückstrahlung an einer Schichtgrenze hervorgerufen wird, wie durch einem Spiegel oder eben die Wolken. Das CO2 bildet aber keine Schicht, sondern ist gleichmäßig im unteren Bereich verteilt.

Ich hatte schon mal die Analogie gepostet: Die Erwärmung der Erde funktioniert wie in einem Zimmer: Die Sonne ist der Heizkörper, das Fenster die Atmosphäre, die Gardinen die Wolken und der Staub auf das Fensterglas das CO2. Ist das Fenster ordentlich verstaubt, ist es wirklich ein Tick dunkler, also ein wenig Strahlung wird zurückgehalten. Man putzt aber nicht die Fenster, wenn es zu warm ist, sondern dreht an die Heizung.

Das CO2 hat einen Einfluss auf der xxxxten Stelle hinter dem Komma, so wie der Reifendruck am rechten Hinterreifen beim Spritverbrauch… Da man keinen anderen Grund kennt und kennen will, erfindet man die Sensitivität.

Peter Georgiev schrieb am 17. Oktober 2021 um 12:49

Man kann sich den Einfluss der Treibhausgase in Messungen ansehen, siehe z.B. Grafik in diesem Kommentar. Eine Reduzierung von etwa 400W/m² in Bodennähe auf etwa 260W/m² in 12km Höhe ist IMHO schon deutlich.

#268141

@ Marvin Müller,

Lassen Sie Ihre Diagramme stecken und machen Sie folgenden Versuch: Unter den Sonnenschirm im Hochsommer sitzend, strecken Sie den Arm in die Sonne aus, einmal in der prallen Sonne und einmal beim Wolkendurchzug. Dabei können Sie alle Diagramme und Strahlenwissenschaft vergessen, Ihre 400 0der 260 sonstwas Werte, aber die Haut registriert eine sehr hohe Differenz an Energiestrahlung, die von den Wolken zurückgehalten wird. Ihre Fehler bei der einseitigen Betrachtung:

1. Wenn etwas die Strahlung zurückhält, dann in beiden Richtungen.

2. Nicht 0,04% der Atmosphäre hält die Strahlung zurück, sondern 100% der Atmosphäre, mit allen Bestandteilen. Der deutlich Höhere Anteil der Wolken als „Strahlungsbremse“ spürt man nicht nur im genannten Versuch, sondern auch in Winternächte… Sie können feststellen, dass Wolken 10-20 K Unterschied machen können, wenn Sie sich auf die CO2-Rückstrahlung als Wärmequelle verlassen, erfrieren Sie im klaren Winterwetter.

Verbrennen Sie Ihre Diagramme und beobachten sie die Natur mit offenen Augen!

Offensichtlich nicht!! Alles schon mal erklärt. Was ist eigentlich so schwer daran, das TK97 Diagramm zu verstehen? Oder sehen Sie etwa an Ihrer Haushaltsbilanz von diesem Jahr, wie diese in 10 Jahren aussieht?

@ Heinemann am 15. Oktober 2021 um 12:50

Ihre Ausflüchte werden immer abenteuerlicher! Gerade Bilanzen haben die Eigenschaft beliebige Varianten rechnen zu können, weil die Basisregel immer konstant bleibt.

Wenn KT97 also eine Bilanz für irgend einen Arbeitspunkt darstellen soll, muß man auch in der Lage sein, einen anderen Arbeitspunkt damit zu simulieren! Wie sähe das also für 300 ppm CO2 aus und wie für 600 ppm?

Welche? Lesen Sie erstmal mein Geschriebenes, erst wenn Sie das verstanden haben und immer noch Fragen haben, dürfen Sie sich beschweren.

Der Begriff „Basisregel“ existiert nicht, weder bei Bilanzen noch im sonstigen Sprachgebrauch. Wenn Sie bei KT97 Beliebigkeit sehen, haben Sie Sie nicht verstanden. Vermischen Sie nicht die Fakten, die hier jeder lesen kann, mit eigenen Zusätzen , die Sie uns im Verborgenen halten.

Sie schreiben selber, dass KT97 nur einen „Arbeitspunkt“, also nur einen Satz von Bilanzwerten darstellt. Eine Bilanz ist aber keine Simulation, eine Simulation errechnet die Bilanzwerte aus der Physik, eine Bilanz nimmt nur die Werte, die da sind. Jedes Klimamodell liefert natürlich automatisch auch eine Bilanz wie KT97 es für das aktuelle Klima liefert.

Wie sieht KT also fuer 600 ppm aus?

Wieso 1,5K? Für 2xCO2 werden 1-1.2K angenommen, ohne feedbacks. Das ergibt sich aus…

1. Den Modellen für den Strahlungshaushalt, wie etwa hitran oder modtran. Problem: der Wert ergibt sich indem man realite Emissionsgrade leugnet, und Überlagerungen mit anderen THGen und Wolken. Ausserdem wird noch ein falsches Lambda verwendet (0.3 statt korrekt 0.27). Korrekt wären lediglich 0.53K

2. Passt es ja so ungefähr zum aktuellen Erwärmungstrend. Problem: es steht nirgendwo geschrieben, dass dieser von CO2 herrührt. Tatsächlich ist das, s.o., sogar definitiv auszuschließen. Man müsste mehr an Kondensstreifen denken..

3. Deuten Paläoklimadaten auf den Zusammenhang zwischen CO2 und Temperatur hin. Tatsächlich rührt die quantitative Einschätzung des CO2 Effekts ursprünglich maßgeblich auf diesen Daten. Problem: man musste bald erkennen, dass die so ermittelte Sensitivität unmöglich stimmen kann. Also wird CO2 nun eine Rolle als feedback zu anderweitig verursachten Klimaschwankungen zugewiesen. Behauptet wird, dass die anderweitig ermittelte Klimasensivität exakt zu den Paläoklimadaten passen würde. Nun kenn man aber nicht die eigentliche Störgröße, womit sich problemlos jedes beliebige „feedback“ einpassen lässt. Die Formel a + b = 10 ist für jedes a gültig, wenn b beliebig ist. Dieser „Beweis“ ist also rekursiv.

@Schaffer – … „mehr an Kondensstreifen denken …“ u n d „an dem PALLA sein“ EIS-Pulver (zuletzt „300“ Mio. To. H2O-Eis-Aerosole bei „800“ Mio. To./p.a. CO2-AbGase) der FLIEGEREI !!! – seit 1980 bis dato auf „remss.com“ schön die TROPO-Er“Wärmung“ bei gleichzeitiger STRATO-Ab“Kühlung“ bis dato zu „studieren“ (BreitenGradGenau) – korreliert eindeutig mit der Luft-Verkehrs-Entwicklung !!! – Mehr muss man eigentlich nicht wissen !?! 😉

Denke ein bisschen mehr zu wissen kann nicht schaden. Aber das wird Ihnen wahrscheinlich gefallen..

„This result shows the increased cirrus coverage, attributable to air traffic, could account for nearly all of the warming observed over the United States for nearly 20 years starting in 1975, but it is important to acknowledge contrails would add to and not replace any greenhouse gas effect“

https://www.nasa.gov/centers/langley/news/releases/2004/04-140.html

@Schaffer – schöner Link – DA sieht man „echte Rabulisten“ (Wiki gucken) am Werk !!! – so wie sich mein „spezieller“ Freund „40/100-Rahmstorf“ für Mich darstellt – also CONTRAILS und „mein“ EIS-Pulver der Fliegerei haben zwar ihre Wirkung, aber die ALLER-GRÖSSTE hat natürlich das „mickrige“ SPUREN-Gas „Zeh-Oh-Zwei“ – d.h. die „ZuNahme“ von Drei auf Vier ZentiMeter verglichen mit der START-Linie beim „Hundert-METER-Lauf“ – NICHT L A C H E N !!! – „CO2-Klima-LUEGNER“ glauben das ernsthaft 😉

… alles zutreffend, aber Hautsache dem billigen Volk wurde als Argumentationshilfe ein Physik— Nobelpreis untergejubelt. So wie Merkel als „Physiker“ dem Volk untergejubelt wurde. Was es davon hat, hat das billige Volk bis heute nochnichteinmal verstanden. Trotzdessen die CDU nun am Boden liegt — zerstört von Merkel , sagt und schreibt nut keiner — noch nicht!