Ich habe bereits früher über die Vorhersage-Zuverlässigkeit von Klimamodellen auf WUWT Stellung geommen, und zwar hier, hier, hier und hier. Wer eine Videopräsentation der Arbeit bevorzugt, findet sie hier. Volle Transparenz erfordert, dass man Dr. Patrick Browns (jetzt Prof. Brown an der San Jose State University) Videokritik zur Kenntnis nimmt, die hier gepostet wurde und die in den Kommentaren unter diesem Video, beginnend hier, widerlegt wurde.

Diejenigen, die sich diese Kommentare durchlesen, werden sehen, dass Dr. Brown keine offensichtliche Ausbildung in der Analyse physischer Fehler aufweist. Er machte die gleichen Anfängerfehler, wie sie bei Klimamodellen üblich sind und die hier und hier ausführlich diskutiert werden.

In unserer Debatte benahm sich Dr. Brown sehr zivilisiert und höflich. Er wirkte wie ein netter Kerl und wohlmeinend. Aber als man ihm keine Möglichkeit ließ, die Genauigkeit und Qualität der Daten zu beurteilen, verrieten ihn seine Lehrer und Mentoren.

Mangelnde Ausbildung in der Bewertung der Datenqualität ist offenbar eine Lücke in der Ausbildung der meisten, wenn nicht aller AGW-Konsens-Klimaforscher. Sie finden keinen Sinn im entscheidend zentralen Unterschied zwischen Präzision und Genauigkeit. Es kann überhaupt keinen möglichen Fortschritt in der Wissenschaft geben, wenn die Mitarbeiter nicht geschult sind, die Qualität ihrer eigenen Daten kritisch zu bewerten.

Die beste Gesamtbeschreibung von Klimamodellfehlern ist immer noch Willie Soon, et al., 2001 vorbehalten in seinem Beitrag „Modeling climate effects of anthropogenic carbon dioxide emissions: unknowns and uncertainties“. So ziemlich alle beschriebenen Simulationsfehler und Schwächen sind auch heute noch zutreffend.

Jerry Browning hat kürzlich eine rigorose mathematische Physik veröffentlicht, die an ihrer Quelle die von Willie et al. beschriebenen Simulationsfehler aufdeckt. Er zeigte, dass die falsch formulierte physikalische Theorie in Klimamodellen diskontinuierliche Heiz-/Kühlterme erzeugt, die eine „Größenordnung“ der Verringerung der Simulationsgenauigkeit bewirken.

Diese Diskontinuitäten würden dazu führen, dass die Klimasimulationen rasch voneinander abweichen, es sei denn, die Klimamodellierer unterdrücken sie mit einer hyperviskosen (Melasse-)Atmosphäre. Jerrys Papier bietet einen Ausweg. Dennoch bleiben Diskontinuitäten und Melasseatmosphären auch in den neuen verbesserten CMIP6-Modellen erhalten.

Im Fünften Zustandsbericht 2013 (5AR) verwendete der IPCC CMIP5-Modelle, um die Zukunft der globalen Lufttemperaturen vorherzusagen. Der kommende 6AR wird die aktualisierten CMIP6-Modelle verwenden, um die thermische Zukunft vorherzusagen, die uns erwartet, falls wir weiterhin fossile Brennstoffe verwenden.

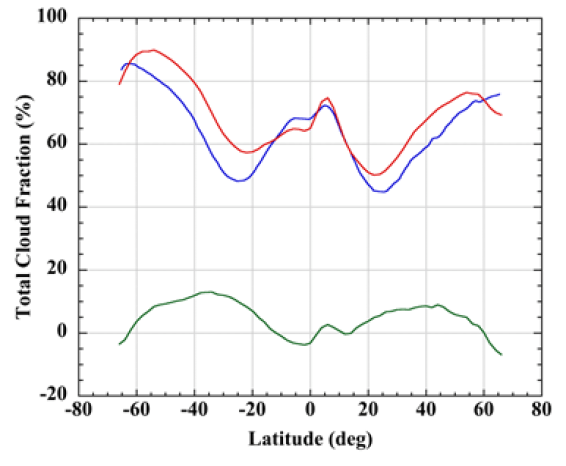

CMIP6-Wolkenfehler und Nachweisgrenzen: Abbildung 1 vergleicht den vom CMIP6 simulierten globalen durchschnittlichen jährlichen Wolkenanteil mit dem gemessenen Wolkenanteil und zeigt deren Differenz zwischen 65 Grad nördlicher und südlicher Breite. Der durchschnittliche jährliche Fehler (rms root mean square) des Wolkenanteils beträgt ±7,0%.

Dieser Fehler kalibriert die durchschnittliche Genauigkeit von CMIP6-Modellen gegenüber einem bekannten, beobachtbaren Wolkenanteil. Der durchschnittliche jährliche rms-Fehler des CMIP5-Wolkenanteils über den gleichen Breitenbereich beträgt ±9,6%, was auf eine Verbesserung des CMIP6 um 27% hinweist. Nichtsdestotrotz weisen CMIP6-Modelle immer noch signifikante Simulationsfehler des globalen Wolkenanteils auf.

Abbildung 1 Linien: rot, MODIS + ISCCP2 gemessener jährlicher durchschnittlicher Wolkenanteil; blau, CMIP6-Simulation (9 Modellmittelwerte); grün, (gemessen minus CMIP6) jährlicher durchschnittlicher Kalibrierungsfehler (rms-Fehler in Längsrichtung = ±7,0%).

Die folgende Analyse ist eine einfache Erweiterung der bisherigen, auf die CMIP5-Projektionen der Lufttemperatur angewendeten Fehlerfortpflanzung auf die CMIP6-Modelle.

Fehler bei der Simulation des globalen Wolkenanteils führen zu Folgefehlern im langwelligen Wolkenantrieb (LWCF) des simulierten Klimas. LWCF ist eine Quelle des thermischen Energieflusses in der Troposphäre.

Der troposphärische thermische Energiefluss ist die Determinante der Lufttemperatur in der Troposphäre. Simulationsfehler in LWCF führen zu Unsicherheiten im Wärmefluss der simulierten Troposphäre. Diese wiederum führen zu Unsicherheiten bei den projizierten Lufttemperaturen.

Für weitere Diskussionen siehe hier – Abbildung 2 und den umgebenden Text. Das oben verlinkte Fehlerfortpflanzungspapier bietet ebenfalls eine ausführliche Diskussion dieses Punktes.

Der globale jährliche Mittelwert des langwelligen LWCF rms-Kalibrierfehlers der CMIP6-Modelle beträgt ±2,7 W/m² (28 Modellmittelwerte aus Abbildung 18 hier).

Ich konnte die Gültigkeit dieser Zahl überprüfen, denn dieselbe Quelle lieferte auch den durchschnittlichen jährlichen LWCF-Fehler für die 27 von Lauer und Hamilton bewerteten CMIP5-Modelle. Der von Lauer und Hamilton ausgewertete CMIP5 rms-Jahresdurchschnitts-LWCF-Fehler beträgt ±4 W/m². Eine unabhängige Neubestimmung ergab ±3,9 W/m²; dasselbe gilt für den Rundungsfehler.

Die kleine Frage der Auflösung: Im Vergleich mit dem CMIP6 LWCF-Kalibrierungsfehler (±2,7 W/m²) beträgt die durchschnittliche jährliche Zunahme des CO2-Antriebs zwischen 1979 und 2015 0,025 W/m² (Daten von der EPA). Die durchschnittliche jährliche Zunahme der Summe aller Antriebe für alle wichtigen Treibhausgase im Zeitraum 1979-2015 beträgt 0,035 W/m².

Der durchschnittliche jährliche CMIP6 LWCF-Kalibrierungsfehler (±2,7 W/m²) ist also ±108-mal größer als die durchschnittliche jährliche Zunahme des Antriebs durch CO2-Emissionen allein und ±77-mal größer als die durchschnittliche jährliche Zunahme des Antriebs durch alle THG-Emissionen.

Das heißt, eine untere Grenze der CMIP6-Auflösung ist ±77 Mal größer als die zu erkennende Störung. Dies ist eine kleine Verbesserung gegenüber CMIP5-Modellen, die eine ±114-mal zu große Auflösung der unteren Grenze aufwiesen.

Die analytische Strenge erfordert in der Regel, dass die instrumentelle Nachweisgrenze (Auflösung) 10-mal kleiner als die erwartete Messgröße ist. Um also ein Signal von CO2– oder THG-Emissionen vollständig zu erkennen, müssen die aktuellen Klimamodelle ihre Auflösung um fast das 1000-Fache verbessern.

Eine andere Möglichkeit ist, dass die CMIP6-Klimamodelle die Auswirkungen von CO2– oder THG-Emissionen auf das Erdklima oder die globale Lufttemperatur, so überhaupt existent, nicht erfassen können.

Diese Tatsache dürfte von der Konsensus-Klimatologie-Gemeinschaft ignoriert werden.

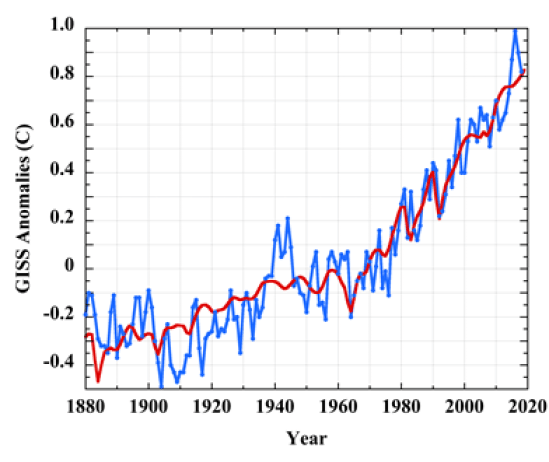

Gültigkeit der Simulation: Papalexiou et al., 2020 stellten fest, dass „die Glaubwürdigkeit von Klimaprojektionen typischerweise dadurch definiert wird, wie genau Klimamodelle die historische Variabilität und Trends abbilden“. Abbildung 2 zeigt, wie gut die lineare Gleichung, die zuvor zur Emulation der CMIP5-Lufttemperaturprojektionen verwendet wurde, die GISS-Temp-Anomalien reproduziert.

Abbildung 2 Linien: blau, GISS Temp 1880-2019 Land plus SST-Lufttemperaturanomalien; rot, Simulation unter ausschließlicher Verwendung der Meinshausener RCP-Antriebe für CO2+N2O+CH4+ Vulkanausbrüche

Die Nachahmung geht durch die Mitte des Trends und ist besonders gut in der Zeit nach 1950, wo die Lufttemperaturen angeblich durch Treibhausgasemissionen (THG) angetrieben werden. Die durch vulkanische Aerosole verursachten nichtlinearen Temperaturabfälle werden erfolgreich in den Jahren 1902 (Pelée), 1963 (Agung), 1982 (El Chichón) und 1991 (Pinatubo) reproduziert. Nachdem wir die Glaubwürdigkeit der veröffentlichten Norm nachgewiesen haben, können wir fortfahren.

CMIP6 Welt: Die neuen CMIP6-Projektionen haben neue Szenarien, die Shared Socioeconomic Pathways (SSPs).

Diese Szenarien kombinieren die repräsentativen Konzentrationspfade (Representative Concentration Pathways – RCPs) des AR 5 mit „quantitativen und qualitativen Elementen, die auf Welten mit verschiedenen Ebenen von Herausforderungen für die Abschwächung und Anpassung basieren [mit] neuen Szenario-Handlungssträngen [die] Quantifizierungen der damit verbundenen Bevölkerungs- und Einkommensentwicklung umfassen … zur Verwendung durch die Klimawandel-Forschungsgemeinschaft“.

Zunehmend entwickelte Beschreibungen dieser Handlungsstränge sind hier, hier und hier verfügbar.

Die Simulation der CMIP6-Lufttemperatur-Projektionen unten folgt der identischen Methode, die in dem oben verlinkten Fehlerfortpflanzungspapier beschrieben ist.

Die Analyse konzentriert sich hier auf Projektionen, die mit Hilfe des Erdsystemmodells CMIP6 IMAGE 3.0 erstellt wurden. IMAGE 3.0 wurde so konstruiert, dass alle erweiterten Informationen, die in den neuen SSPs zur Verfügung gestellt werden, berücksichtigt wurden. Die IMAGE 3.0-Simulationen wurden lediglich der Bequemlichkeit halber ausgewählt. Die von van Vuulen et al. im Jahr 2020 veröffentlichte Studie enthielt in seiner Abbildung 11 praktischerweise sowohl die SSP-Vorgaben als auch die daraus resultierenden Lufttemperaturprojektionen. Die veröffentlichten Daten wurden mit DigitalizeIt, einem Werkzeug, das mir gute Dienste geleistet hat, in Punkte umgerechnet.

Hier ist ein kurzes Zitat aus der Beschreibung für IMAGE 3.0: „IMAGE ist ein integrierter Bewertungsmodellrahmen, der globale und regionale Umweltfolgen von Veränderungen menschlicher Aktivitäten simuliert. Das Modell ist ein Simulationsmodell, d.h. Änderungen der Modellvariablen werden auf der Grundlage der Informationen aus dem vorhergehenden Zeitschritt berechnet.

Simulationen werden von] zwei Hauptsystemen angetrieben: 1) das menschliche oder sozio-ökonomische System, das die langfristige Entwicklung menschlicher Aktivitäten beschreibt, die für eine nachhaltige Entwicklung relevant sind; und 2) das Erdsystem, das Veränderungen in natürlichen Systemen wie dem Kohlenstoff- und Wasserkreislauf und dem Klima beschreibt. Die beiden Systeme sind durch Emissionen, Landnutzung, Klima-Rückkopplungen und mögliche politische Reaktionen des Menschen miteinander verbunden“.

[Hervorhebung vom Autor]

Über fehlerbehaftete Iterationen: Der oben fettgedruckte Satz beschreibt die schrittweise Simulation eines Klimas, bei der jeder zuvor simulierte Klimazustand in der iterativen Berechnung die Anfangsbedingungen für die nachfolgende Klimazustandssimulation bis hin zum endgültigen simulierten Zustand liefert. Die Simulation als schrittweise Iteration ist Standard.

Wenn die in der Simulation verwendete physikalische Theorie falsch oder unvollständig ist, überträgt jeder neue iterative Anfangszustand seinen Fehler in den nachfolgenden Zustand. Jeder nachfolgende Zustand ist dann zusätzlich einem weiteren Fehler unterworfen, der sich aus der Anwendung der falschen physikalischen Theorie auf den fehlerhaften Anfangszustand ergibt.

Entscheidend: Als Folge der schrittweisen Iteration werden systematische Fehler in jedem Klimazwischenzustand in jeden nachfolgenden Klimazustand fortgeschrieben. Die Unsicherheiten aus den systematischen Fehlern pflanzen sich dann als Wurzel-Summen-Quadrat (rss) durch die Simulation fort.

In diesem Zusammenhang zeigte Jerry Browning in seinem Beitrag analytisch und gründlich auf, dass Klimamodelle eine falsche physikalische Theorie verwenden. Abbildung 1 oben zeigt, dass eine der Folgen ein Fehler im simulierten Wolkenanteil ist.

Bei einer Projektion zukünftiger Klimazustände sind die physikalischen Fehler der Simulation unbekannt, da zukünftige Beobachtungen nicht zum Vergleich zur Verfügung stehen.

Die rss-Fortpflanzung eines bekannten Modell-Kalibrierungsfehlers durch die iterierten Schritte erzeugt jedoch eine Zuverlässigkeits-Statistik, anhand derer die Simulation bewertet werden kann.

Obiges fasst das Verfahren zusammen, welches zur Bewertung der Projektionszuverlässigkeit in der Ausbreitungspapier und hier verwendet wird: Zuerst wird das Modell gegen bekannte Ziele kalibriert, dann wird der Kalibrierungsfehler durch die iterativen Schritte einer Projektion als Wurzel-Summen-Quadrat-Ungenauigkeit fortführt. Man wiederholt diesen Prozess bis zum letzten Schritt, der den vorhergesagten zukünftigen Endzustand beschreibt.

Die abschließende Wurzel-Summen-Quadrat-(rss)-Unsicherheit gibt die physikalische Zuverlässigkeit des Endergebnisses an, da der physikalisch wahre Fehler in einer Zukunftsprognose nicht bekannt ist.

Diese Verfahren ist Standard in den physikalischen Wissenschaften, wenn es darum geht, die Zuverlässigkeit eines berechneten oder vorhersagbaren Ergebnisses zu ermitteln.

Emulation und Ungewissheit: Eine der wichtigsten Demonstrationen in der Fehler-Fortpflanzungstudie war, dass fortgeschrittene Klimamodelle die Lufttemperatur lediglich als eine lineare Extrapolation des THG-Antriebs projizieren.

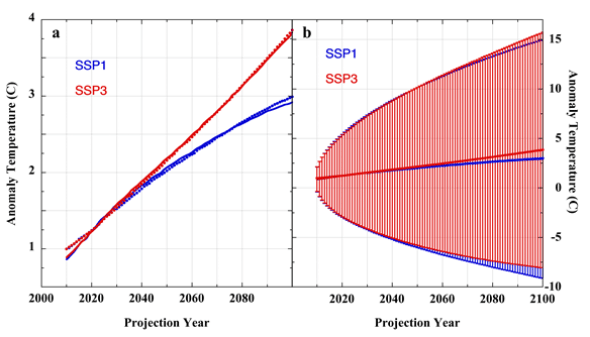

Abbildung 3, Tafel a: Punkte sind die IMAGE 3.0-Lufttemperaturprojektion von Szenario SSP1 (blau) und Szenario SSP3 (rot). Vollständige Linien sind die Emulationen der IMAGE 3.0-Projektionen: blau, SSP1-Projektion, und rot, SSP3-Projektion, die unter Verwendung der in der veröffentlichten Analyse der CMIP5-Modelle beschriebenen linearen Emulationsgleichung erstellt wurden. Tafel b ist wie Tafel a, zeigt aber auch die expandierenden 1 s rss-Ungenauigkeits-Kurven, die entstehen, wenn ±2,7 W/m² des jährlichen durchschnittlichen LWCF-Kalibrierungsfehlers durch die SSP-Projektionen vermehrt und fortgeführt werden.

In Abbildung 3a oben zeigen die Punkte die Lufttemperaturprojektionen der Handlungsstränge SSP1 und SSP3, die mit dem Klimamodell IMAGE 3.0 erstellt wurden. Die Linien in Abbildung 3a zeigen die Emulationen der IMAGE 3.0-Projektionen, die unter Verwendung der linearen Emulationsgleichung erstellt wurden, die in der Fehlerfortpflanzungs-Studie (ebenfalls in einem Artikel aus dem Jahr 2008 im Skeptic Magazine) ausführlich beschrieben wird. Die Emulationen sind 0,997 (SSP1) oder 0,999 (SSP3) mit den IMAGE 3.0-Projektionen korreliert.

Abbildung 3b zeigt, was passiert, wenn ±2,7 W/m² des jährlichen mittleren LWCF-Kalibrierungsfehlers durch die globalen Lufttemperaturprojektionen IMAGE 3.0 SSP1 und SSP3 vermehr und fortgeführt wird.

Die Unsicherheitsbereiche sind so groß, dass die beiden SSP-Szenarien statistisch nicht unterscheidbar sind. Es wäre unmöglich, entweder eine Projektion oder, in Erweiterung, irgendeine SSP-Lufttemperaturprojektion als repräsentativer für die sich entwickelnde Lufttemperatur zu wählen, da jede mögliche Änderung der physisch realen Lufttemperatur in allen Projektionsunsicherheits-Bereichen untergegangen ist.

Ein Intermezzo – Es gibt Drachen: Ich werde hier einen Nebenschauplatz einbauen, um einem früheren heftigen, hartnäckigen und wiederholt behaupteten Missverständnis zuvorzukommen. Bei den Unsicherheitseinhüllenden in Abbildung 3b handelt es sich nicht um physikalisch reale Lufttemperaturen. Das muss eindeutig klar sein.

Diese Unsicherheitsbalken bedeuten nicht, dass das Klima in Zukunft 15°C wärmer oder 10°C kälter sein wird. Unsicherheitsbalken beschreiben eine Bandbreite, in der Unwissenheit herrscht. Ihre Botschaft lautet, dass die projizierten zukünftigen Lufttemperaturen irgendwo innerhalb der Unsicherheitsbandbreite liegen. Aber niemand kennt den Ort. CMIP6-Modelle können nichts Definitiveres sagen als das.

Innerhalb dieser Unsicherheitsbalken befindet sich Terra Incognita. Es gibt Drachen.

Wer darauf besteht, dass die Unsicherheitsbalken tatsächliche reale physikalische Lufttemperaturen implizieren, sollte sich überlegen, wie sich dieser Gedanke gegen die Notwendigkeit durchsetzt, dass eine physikalisch reale ±C-Unsicherheit eine Gleichzeitigkeit von heißen und kalten Zuständen erfordert.

Unbestimmtheits-Balken sind streng axial. Sie stehen im Plus und im Minus auf jeder Seite eines einzelnen Datenpunktes. Die Annahme zweier gleichzeitiger, gleich großer, aber entgegengesetzt polarisierter physikalischer Temperaturen, die auf einem einzigen Punkt des simulierten Klimas stehen, ist eine physikalische Unmöglichkeit.

Die Idee verlangt Unmögliches, nämlich dass die Erde gleichzeitig Treibhaus und Eiskeller des globalen Klimas einnimmt. Bitte also diesen Gedanken endgültig verwerfen.

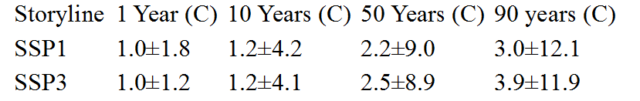

Und nun zurück zu unserer Feature-Präsentation: Die folgende Tabelle enthält ausgewählte Anomalien der Projektion der Szenarien IMAGE 3.0 SSP1 und SSP3 nebst ihren entsprechenden Unsicherheiten.

Keine dieser prognostizierten Temperaturen ist anders als physikalisch bedeutungslos. Keine einzige von ihnen sagt uns etwas physikalisch Reales über mögliche zukünftige Lufttemperaturen.

Es folgen mehrere Schlussfolgerungen.

Erstens projizieren die CMIP6-Modelle, wie ihre Vorläufer, die Lufttemperaturen als lineare Extrapolation des Antriebs.

Zweitens machen CMIP6-Klimamodelle, wie ihre Vorgängermodelle, großräumige Simulationsfehler im Wolkenanteil.

Drittens erzeugen CMIP6-Klimamodelle wie ihre Vorläufer LWCF-Fehler, die enorm größer sind als die winzige jährliche Zunahme des troposphärischen Antriebs durch Treibhausgasemissionen.

Viertens erzeugen die CMIP6-Klimamodelle, wie ihre Vorläufer, so große und unmittelbare Unsicherheiten, dass die Lufttemperaturen selbst für ein Jahr nicht zuverlässig prognostiziert werden können.

Fünftens müssen CMIP6-Klimamodelle, wie ihre Vorläufer, eine etwa 1000-fach verbesserte Auflösung aufweisen, um ein CO2-Signal zuverlässig zu erkennen.

Sechstens erzeugen CMIP6-Klimamodelle, wie ihre Vorläufer, physikalisch bedeutungslose Lufttemperatur-Projektionen.

Siebtens haben die CMIP6-Klimamodelle, wie ihre Vorläufer, keinerlei Vorhersagewert.

Die unvermeidliche Schlussfolgerung ist nach wie vor, dass ein anthropogenes Lufttemperatursignal in Klimabeobachtungen nicht nachgewiesen werden konnte und auch gegenwärtig nicht nachgewiesen werden kann.

Ich schließe mit einer Bemerkung, die schon einmal gemacht wurde: Wir wissen jetzt mit Sicherheit, dass all die Hektik um CO2 und das Klima umsonst war.

All die verängstigten Erwachsenen; all die verzweifelten jungen Menschen; all die Gymnasiasten, die zu Tränen und Schuldzuweisungen durch Lektionen über bevorstehendes Unheil, Tod und Zerstörung verängstigt sind; all die sozialen Unruhen und Verwerfungen. All das war umsonst.

All die Schuldzuweisungen, all die Rufmordanschläge, all die zerstörten Karrieren, all die überschüssigen Todesfälle im Winter durch Brennstoffarmut, all die Männer, Frauen und Kinder, die weiterhin mit Rauch in geschlossenen Räumen leben, all die enormen Summen, die umgeleitet wurden, all die zerstörten Landschaften, all die zerhackten und verbrannten Vögel und Fledermäuse, all die gewaltigen Geldsummen, die von der Mittelschicht an reiche Subventionsbauern überwiesen wurden:

Alles umsonst.

Link: https://wattsupwiththat.com/2020/10/27/cmip6-update/

Übersetzt von Chris Frey EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Zitat: „Wenn die in der Simulation verwendete physikalische Theorie falsch oder unvollständig ist, überträgt jeder neue iterative Anfangszustand seinen Fehler in den nachfolgenden Zustand. Jeder nachfolgende Zustand ist dann zusätzlich einem weiteren Fehler unterworfen.“

Erinnert mich irgendwie an den PCR-Test!

Wenn die Temperaturänderungen während der letzten 2000 Jahre gezeigt werden, erweist sich die jetzige Änderung als gering.

Das Bildchen 2 ist schlichtweg eine unsinnige Darstellung. Aber so ist das inzwischen in der sog. Wissenschaft: Es geht nicht um die Wissenschaft sondern um politische Ziele. Und da manche mit der primitiven Windmühlenkonstruktion viel Geld verdienen werden die Unsinnsdinger von den politischen Freunden „gefördert“.

Verrauscht kann man die Ergebnisse nicht nennen, immerhin spuckt das Modell ohne es vorher verabreicht bekommt zu haben die Klimazonen raus und reproduziert als Ergebnis gekoppelter Differentialgleichungen „quasi aus dem Urschleim“ ein ziemlich genaueres Abbild des beobachteten Klima.

Wie schrieb es Patrick Frank: Klimamodelle können zukünftige globale Lufttemperaturen nicht vorhersagen. Nicht für ein Jahr und auch nicht für 100 Jahre. Klimatische Lufttemperaturprojektionen sind physikalisch bedeutungslos. Sie sagen überhaupt nichts über die Auswirkungen von CO₂ Emissionen auf die globalen Lufttemperaturen aus. Da stellt also Patrick Frank grundlegend in Frage, ob die Klimamodelle – und zwar alle – überhaupt in der Lage seien, die Einflüsse von Treibhausgasen auf das Klima zu zeigen, weil die Mess- oder Regelgröße vollständig im Fehlerrauschen untergehe. Satie on … Was erlaubt sich dieser „Klimaleugner“, dieser Ketzer, der da so frech die Offenbarung der Orakel-Modelle stört? Satire off…„Nach dem gegenwärtigen Stand der Theorie wird sich ein AGW – Signal, falls vorhanden, niemals aus dem Klima-Rauschen hervorheben, egal wie lange die Beobachtungsaufzeichnung dauert, da die Unsicherheitsbreite notwendigerweise viel schneller zunimmt als ein projizierter Trend der Lufttemperatur. Jegliche Auswirkung von Treibhausgasen geht immer innerhalb einer Unsicherheitssituation verloren. Selbst fortgeschrittene Klimamodelle weisen eine schlechte Energieauflösung und sehr große Projektionsunsicherheiten auf. Die unvermeidliche Schlussfolgerung ist, dass ein Temperatursignal von anthropogenen CO₂ -Emissionen – falls vorhanden – nicht in Klima-Observablen nachgewiesen werden konnte oder kann.“ Nichts gegen Klimamodelle, aber immer gilt es zu beachten; … dass die Modelle nur Hilfsmittel und Werkzeuge derjenigen sind, die sie erstellt haben, um (begrenzt) Szenarien durchspielen zu können. Es handelt sich keinesfalls um Instrumente, die in der Lage wären, die Zukunft vorauszusagen. Denn dabei gilt wie immer im Leben und in der Wissenschaft: „Garbage in – Garbage out!“

Es ist, wie es Patrick Frank sagt, es bleibt bei einem Rauschen … im Modell. Lesen sie auch die Arbeiten von Nic Lewis und Mototaka Nakamura. Ich finde es großartig, dass Dr. Jing-Jia Luo diese wissenschaftliche Arbeit von Patrick Frank 2019 geprüft und frei gegeben hat. ( Peer Review )

Jedem Klimamodellierer ist zu empfehlen ein paar Tage die Wolken anzuschauen. Dann kehrt Demut ein. Die berechneten Fehlerbalken der Klimaprojektionen in Abb. 3 b halte ich für angemessen. Die Politik sollte derartige Informationen berücksichtigen.

>> Die Politik sollte derartige Informationen berücksichtigen.<<

Ihnen scheinen die tatsächlichen Intelligenzqotienten der Politiker nicht bekannt zu sein, sehr geehrter Herr Müller. Allerdings wissen die Politiker eines: Daß die weitgehende Mehrheit der Bundesbürger noch mieserabler gebildet ist als die Mehrheit der Politiker.

Und Abb. 2 ist als Darstellung komplette Falschdarstellung. Wenn die gemessenen Temperaturverläufe korrekt mit der Geschichte dargestellt werden würden, müßten die Temperaturwerte seit Beginn des Jahres Null – also der Geburt von Jesus Christus – dargestellt werden. Desweiteren müssen die globalen Werte berücksichtigt werden, also die Werte Asiens und Nordamerikas und nicht nur die auf der Ostseite des Atlantiks.

Würde das getan, würde erkannt werden, daß die Werte die nächsten Jahrzehnte nach unten gehen werden und die Abnahme in Nordamerika bereits nach den Jahren 1930 bis 1950 begonnen hat.

Um es aus Sicht eines fehlertheoretisch weniger Geübten nochmals zu klären: Die relative Stimmigkeit zwischen GISS-Temperaturen und Simulation in Abbildung 2 kommt dadurch zustande, dass das Modell dank geeigneter Parameterwahl für die Vergangenheit an die GISS-Kurve angepasst bzw. mit dieser „geeicht“ wurde. Und jetzt glaubt man, das Modell müsse mit diesen Parametern dann die zukünftigen Temperaturen richtig beschreiben. Im Artikel wird hingegen völlig zurecht die einzukalkulierende Fehlerbandbreite aufgezeigt, die natürlich erst von heute an gilt. Letztere entsteht eben dadurch, dass insbesondere die Wolkenbildung, weil weitgehend unverstanden, sich einer zuverlässigen Modellierung entzieht. Man darf sich also nicht durch die relativ gute Übereinstimmung in der Vergangenheit täuschen lassen!

Vielleicht ein Vergleich mit der Börse: Es gibt immer wieder Börsen-Experten, die eichen ihre Börsenkurs-Modelle anhand zurückliegender Kursverläufe und wundern sich dann, dass es in der Zukunft trotzdem nicht stimmt…

Wie vielfach schon festgestellt, das Weltklima ist, zumindest mit den heutigen Möglichkeiten, nicht prognostizierbar!

Die gesamten Klimamodelle haben einen durchgängigen Ansatzfehler: Sie mitteln und adjustieren eine Vielzahl gemessener Temperaturen und schließen daraus auf eine sog. globale Erwärmung. Derartige Klimamodelle können daher niemals Klima- oder Erwärmungsmodelle sein, sondern einzig und genau nur Temperaturmodelle.

Gemessene Temperaturen ohne Bezug zu definierten Massen, die diese Temperaturen haben, können keine Aussage über die Energien dieser Massen liefern. 1m³ Luft hat eine andere Energie (Wärme) als 1m³ Wasser. Oder anders ausgedrückt: 2m³ Wasser haben erheblich mehr Energie als 2m³ Luft, auch wenn beide die gleiche gemittelte Temperatur aufweisen.

Das System Sonne – Erde – Weltall besitzt die Sonne als Quelle, die Erde als Strahlungs- und damit Energie-Empfänger und das Weltall als Senke für die von der Erde abgehende Strahlung, für das die Erde wiederum Quelle ist. Energetisch stellt sich eine Balance ein, je mehr die Erde Wärme (Energie) von der Sonne über die Strahlung aufnimmt und durch zusätzliche Aktivierung gespeicherter Energieträger umsetzt, desto größer wird ihr energetischer Zustand, der sich je nach der Größe der sich erwärmenden Massen unterschiedlich in deren Temperaturen ausdrückt. Dennoch kann sich dieser Zustand nicht beliebig erhöhen, denn ein größeres Gefälle zwischen energetischem Zustand der Erde zum Weltall sorgt für eine größere Abstrahlung. Darüber kann der Mensch keine Kontrolle bekommen, es handelt sich im regelungstechnischen Sinne um Prozesse mit Ausgleich. Auch wenn man ein Stück Eis in ein Glas Wasser gibt, folgt kein Regelungsprozess mit Sollwert- und Istwert- Vergleich von physikalischen Parametern und steuerungstechnischem Eingriff.

Zurück zur Strahlung der Sonne. Diese trifft mit einer bestimmbaren Intensität auf völlig unterschiedliche Massen gut verteilt auf die Erde, was zur Folge hat, dass diese Massen pro m² Oberfläche eine garantierte Zuteilung der Strahlung erhalten, wobei diese in der Tat keine Konstante ist, weil die Atmosphäre mit unterschiedlichen Luftschichten und Wolken diese dämpfen und reflektieren. Auch die Sonne selbst ist kein Körper mit konstanter Strahlung, auch wenn Herr Lesch das so verbreitet. Die darin laufenden Prozesse unterliegen der Stochastik und sind daher niemals konstant. Abhängig von den spezifischen Massen ergeben sich bei gleicher Energiezufuhr durch Strahlung äußerst unterschiedliche Temperaturen. Natürlich kann man diese mitteln, adjustieren und ggf. ergebnisorientiert verfälschen, um dann am Ergebnis einer einzigen Zahl daran Freude zu haben. Aus dieser Zahl aber eine Erwärmung oder Abkühlung des Planeten abzuleiten, ist physikalisch gesehen einfach falsch.

Es hilft dann nicht, von heute hochleistungsfähigen Rechnern zu schwadronieren. Galt vor 20 Jahren bei langsamen Rechnern „Shit in => Shit out, so gilt heute eben „Shit in => Hochleistungs-Shit out“!

Vielleicht sollte Herr Schellnhuber noch einmal über seine Selbstverbrennung nachdenken. Wenn er elektrotechnisch gebildet ist, kann er sich Milliarden unterschiedlicher Kondensatoren gleichmäßig über der Erde verteilt vorstellen, wobei alle Kondensatoren die gleiche zugewiesen Einströmung (aus der Sonne) erfahren. Den identischen Vorgang kann man analog für die Abstrahlung sehen. Da kann man noch so elegant deren Spannungen (analog Temperaturen) messen, adjustieren und mitteln, über deren gesamten Ladezustand wird man nicht erfahren, ob die gespeicherte Energie zu- oder abgenommen hat, wenn man nicht die jeweiligen Kapazitäten zu jedem einzelnen Messwert berücksichtigt hat.

Wenn das Buch von Herrn Schellnhuber einmal das wichtigste Buch werden soll, was nach seiner Auffassung je geschrieben wurde, dann würde es sich auch für ihn lohnen, einmal mit etwas Abstand die darin enthaltenen Fehler zu betrachten und demütig ein neues vorübergehend verbessertes Buch zu schreiben.

Bitte kürzer fassen!

Wie bitte?

„Die gesamten Klimamodelle haben einen durchgängigen Ansatzfehler: Sie mitteln und adjustieren eine Vielzahl gemessener Temperaturen und schließen daraus auf eine sog. globale Erwärmung“

Immer noch falsch!

Klimamodelle berechnen die Temperaturen, genauso wie Wettervorhersagemodelle, aus den physikalischen Grundgleichungen.

Sie haben es immer noch nicht verstanden.

Die Klimamodelle berechnen mittels genauer Gleichungen auf 2 Stellen hinterm Komma das Rauschen.

@Sverre Petersen

Zitat: „Klimamodelle berechnen die Temperaturen, genauso wie Wettervorhersagemodelle, aus den physikalischen Grundgleichungen.“

xxxxxxxxxxx. Sie argumentieren unredlich.

Physikalische Grundgleichungen? Listen Sie doch mal alle stillschweigenden Annahmen dafür auf. Dazu sind Sie fachmännisch NICHT in der Lage. Sie verstehen überhaupt nicht was gemeint ist.

Was wollen Sie aus Ihren albernen Worten ableiten? Autorität um über das Schicksal der Menschheit allein entscheiden zu können? Sie verstehen Ihre eigenen Worte, denn Sinn nicht.

Aus London (Benny Peiser, GWPF) ist HEUTE zu hören, was logisch seit langem gefolgert wurde, Zitat: „Economic growth is bad for the climate, Europe’s Science Academies claim.“

Europäische Akademien? Nichts da. Diese Leute haben mit echter Wissenschaft NICHTS am Hut. Absolut nichts. Das sind Betrüger. Unsere Unis sind von kompletten, verblendeten, habgierigen Geisteskranken bevölkert. Das ist alles. Ihr billiges, nichtssagendes Geschwaffel von physikalischen Grundgleichungen klingt wie das Geschwätz von Hühnern im Stall, die es aus Angst vor dem Fuchs nie haben verlassen wollen.

Wer die Freiheit des Menschen bekämpft ist stets ein Feind der Wissenschaft. Genau das ist das Ziel des Marxismus: die Zerstörung der erhabenen Freiheit.

Eine physikalische Gleichung läßt sich immer auch in jede andere Sprache übersetzen. Mathematik ist eine Hilfswissenschaft, eine universelle Sprache.

xxxxxx

Für Sie: Wirtschaftswachstum ist sehr gut für das Klima, sogar ausgezeichnet.

@ Sverre Peterssen

Pardon, verkündet werden (insbesondere aus Potsdam und vom IPCC) Temperatur-Erhöhungen, keine physikalischen Grundgleichungen. Haben Sie wirklich verstanden, was ich ausgeführt habe?

Grober Unfug Herr Petersen!

Wettermodelle, die das Wetter in 2 Wochen beschreiben, können schon mal 20 Grad daneben liegen, eine Ungenauigkeit von mehreren Grad wird immer selbst zugegeben. Weil keiner die Temperatur berechnen kann.

Die Temperatur von morgen wird auch nicht berechnet, sondern anhand der heutigen geschätzt und in einer Spanne von 5 Grad angegeben.

Klimamodelle sind reine Spekulation. Ob Sie nun heute berechnen, dass am 7. August 2022 in Berlin Schönefeld um 18:00 Uhr 21,00 Grad warm sein wird oder die Erde sich 2100 um 2 Grad erwärmt, kommt aufs Gleiche.

Null physikalische Gleichungen, sondern Selbstbetrug und Aberglaube über die Unfehlbarkeit der überdimensionierte Taschenrechner, auch Computer genannt.

Selten so eine schwache Aussage auf Eike gelesen…

Zum Glück gibt es nicht so viele Ausführungstypen von Kondensatoren im Klimasystem für die größten Energiemengen.

„wenn man nicht die jeweiligen Kapazitäten zu jedem einzelnen Messwert berücksichtigt hat“

Der bedeutenste Kondensator ist das Meerwasser, Eismassen, festland, Luft. Die Wärmekapazitäten sind bekannt, alles andere kann für unsere Belange vernachlässigt werden.

@ Sverre Petersen

Ich freue mich, dass Sie immerhin im Begriff sind, die Analogie zwischen Kapazitäten und Massen zu verinnerlichen. Egal, was Sie glauben vernachlässigen zu können, weder das Meer mit seinen Strömungen, noch die Luft mit Feuchtigkeit und Strömungen, noch die Eismassen mit Zuwachs und Verlust und auch nicht das Festland mit seinen Zubauten auf dem Weg zu 10 Mrd. Bewohnern sind bezüglich ihres Strahlungsverhaltens (Aufnahme und Abstrahlung) konstant. Da die damit gebildeten Wärmekapazitäten nicht konstant sind, können sie auch nicht als erfasst in Klimamodelle eingehen.

Vielleicht können Sie ja allen Interessierten und mir die wesentliche Frage beantworten, warum in Potsdam immer von Global-Temperatur die Rede ist und nicht von Global-Energie? Man braucht doch nur die Temperaturen mit den entsprechenden Wärmekapazitäten zu verknüpfen, um auf die einzig aufschlussreiche Größe Energie zu kommen. Scheint vielleicht doch nicht ganz so einfach zu sein, die von der jeweiligen Strahlung aufgeheizten Einzelmassen zu bestimmen. Oder?