Wie wird die Temperatur der Erde denn berechnet?

Es gibt sicher niemanden, der denkt, man liest die Erdtemperatur am entsprechenden Thermometer, sagen wir in Norwich, in East Anglia Super-Exaggerated Temperature ab.

Es gibt sicher niemanden, der denkt, man liest die Erdtemperatur am entsprechenden Thermometer, sagen wir in Norwich, in East Anglia Super-Exaggerated Temperature ab.

Wie kommt sie dann zustande?

Das Grundproblem mit der Erdtemperatur besteht darin, dass Temperatur sehr heterogen ist. In der Arktis ist es kälter als in Mali und in München wärmer als in Aberystwyth, während es in Khartoum wärmer ist als in Reykjavik. Mit anderen Worten, um die Temperatur der Erde zu bestimmen, braucht man viele verschiedene Messstationen, sehr viele verschiedene Messstationen, die so über die Erde verteilt sind, dass ihr Gesamt auf die Erdtemperatur schließen lässt. Die Messstationen dürfen jedoch nicht nur an Land stehen, es muss sie auch auf dem Meer geben: auf Schiffen, in Bojen usw.

Derzeit gibt es weltweit vier Datensätze, die genug Temperatur-Informationen enthalten (sollen), um die Erdtemperatur zu bestimmen.

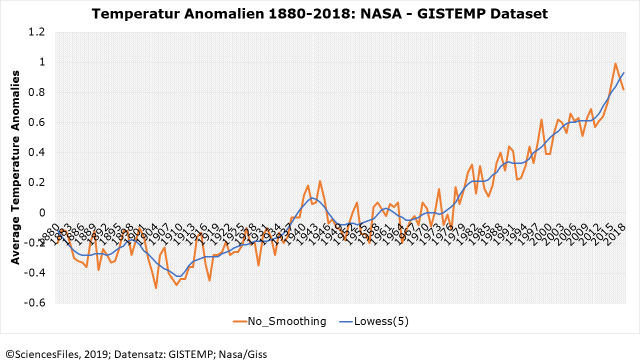

Der wohl umfassendste Datensatz ist der GISTEMP-Datensatz, den das Goddard-Institute for Space Science der NASA zusammenstellt. Er soll 99% der Erde mit Temperaturinformationen abdecken.

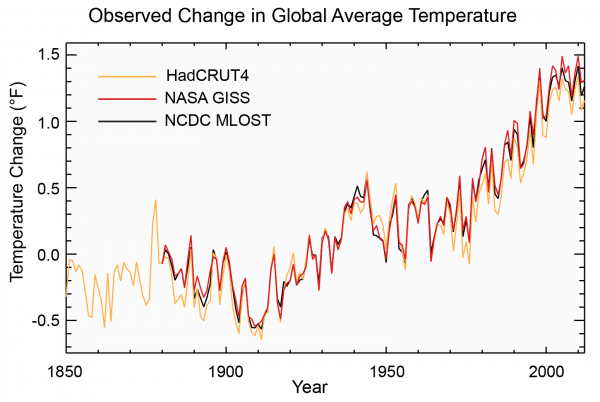

Daneben gibt es noch den MLOST-Datensatz der National Oceanic and Atmospheric Administration (NOAA) der USA, den HadCRUT4-Datensatz, der von UK Met Office Hadley Centre und der Univeristy of East Anglia (Climate Research Unit) zusammengestellt wird, sowie einen Datensatz, den die Japanese Meterological Agency (JMA) erstellt. Er hat mit rund 85% die geringste Abdeckung durch Messstationen. Die Daten stammen für HadCRUT4 aus rund 5.500 Messstationen, GISTEMP basiert auf rund 6.300 Einzeldaten, MLOST auf rund 7.000. Alle Messstationen befindet sich an Land. Die Temperaturmessung auf dem Meer ist ein eigenes Problem.

Die Datensätze unterscheiden sich nicht nur darin, aus wie vielen Messstationen sie ihre Informationen beziehen, sie unterscheiden sich auch in der Länge der Datenreihen. Die längste Datenreihe stellt HadCRUT4 bereit, sie beginnt 1850, GISTEMP und MLOST Daten beginnen mit dem Jahr 1880, die Daten der JMA beginnen im Jahr 1891.

Aus diesen Quellen stammen die Informationen, auf denen dann eine Abbildung wie die folgende basiert, die wir auf Basis der NASA GISTEMP Daten erstellt haben.

Die Musik bei dieser Abbildung spielt in dem, was links am Rand abgetragen ist: Average Temperature Anomalies. Was es damit auf sich hat, beschreibt NOAA wie folgt:

“The term temperature anomaly means a departure from a reference value or long-term average. A positive anomaly indicates that the observed temperature was warmer than the reference value, while a negative anomaly indicates that the observed temperature was cooler than the reference value.”

Nicht unbedingt der Gipfel an Transparenz und Informationsbereitstellung. Bei der NASA findet sich der folgende Splitter:

„This graph illustrates the change in global surface temperature relative to 1951-1980 average temperatures.”

Aus beiden Informationen kann man sich nun zusammenbasteln, was eine Temperatur Anomalie ist. Sie wird als Abweichung der täglich gemessen (Anmerkung der Redaktion genauer-aus Messungen, nach bestimmten aber unterschiedlichen Algorithmen errechneter) Durchschnittstemperatur für eine Messstation von einem Erwartungswert berechnet. Der Erwartungswert, der bei NASA und NOAA die Grundlage der Anomalien darstellt, ist der Mittelwert der Temperatur (an der entsprechenden Messstation) für den entsprechenden Tag im Zeitraum von 1951 bis 1980.

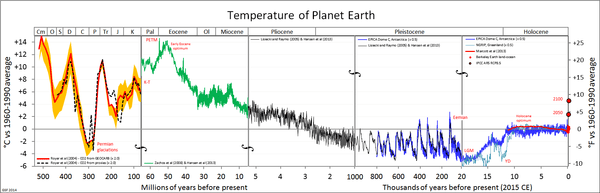

Für jede Messstation wird aus den Tagesdurchschnittswerten ein Monatsdurchschnittswert berechnet, der jeweils die Temperatur-Anomalie, also die Abweichung zur Durchschnittstemperatur für den Zeitraum 1951 bis 1980, angibt. Warum der Zeitraum von 1951 bis 1980 und nicht der Zeitraum von 1931 bis 1960? Weil der Zeitraum von 1931 bis 1960 die „Heisszeit“ der End-1930er und 1940er Jahre enthält:

Die Abbildung enthält Temperaturangaben für die vier oben genannten Datensätze HadCRUT4, GISTEMP (NASA GISS) und MLOST (NOAA). Wie man sieht, weichen die Temperaturangaben von einander ab. Indes: Es handelt sich hierbei um die Angabe der Erdtemperatur auf Basis tatsächlich gemessener Werte. Offenkundig gibt es mehr als eine durchschnittliche Erdtemperatur oder die Berechnung dessen, was durchschnittliche Erdtemperatur sein soll, ist nicht so einfach, wie gedacht.

Und das ist sie tatsächlich nicht. Stellen Sie sich vor, sie haben die Daten für ihre Messstationen, die sich an unterschiedlichen Orten der Erde befinden. Wie kommen Sie von den Einzeldaten zur durchschnittlichen Erdtemperatur?

Die Vorgehensweise von NASA, NOAA; Met Office / East Anglia und JMA ist weitgehend identisch. Die Erde wird in ein Netz von Quadraten eingeteilt, für jedes Quadrat wird die durchschnittliche Temperatur bestimmt. Für GISTEMP liegen die meisten Daten vor, also kann es sich das Goddard Center leisten, ein Grid aus Quadraten von jeweils 2 Breiten- und 2 Längengraden herzustellen. Alle anderen müssen mit 5 Breiten- und 5 Längengraden arbeiten.

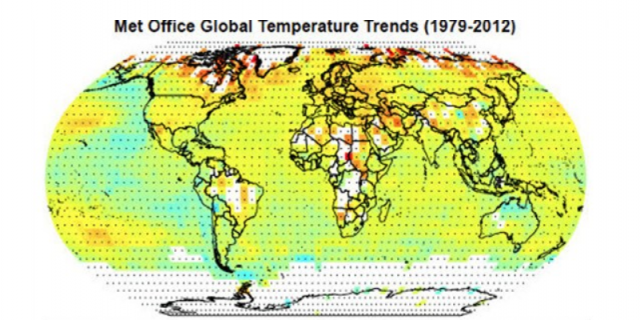

Bislang haben wir quasi den Idealfall dargestellt. Die Realität besteht darin, dass alle vier Datensätze mit leeren Feldern in Ihrem Grid umgehen müssen. Die folgende Abbildung für HadCRUT4 zeigt, dass zum Teil erhebliche Lücken bestehen:

Die weißen Gridzellen sind solche, für die keine Informationen in HadCRUT4 vorhanden sind. Wenn Wissenschaftler mit leeren Zellen in ihren Daten konfrontiert sind, haben sie mehrere Möglichkeiten, man kann die leeren Zellen aus den räumlich gesehen nächsten Zellen, für die Werte vorliegen, berechnen. Diesen Weg geht man im Goddard Center der NASA. Es ist auch möglich, die fehlenden Werte mit dem errechneten „globalen Durchschnitt“ zu füllen. Diesen Weg gehen die Forscher bei HadCRUT4.

All die Entscheidungen, all die Unterschiede in der Berechnung der Erdtemperatur tragen dazu bei, dass die Modelle der Klimaforscher je nachdem, welchen Datensatz sie zu Grunde legen, unterschiedliche Ergebnisse ausspucken. Hinzu kommen nicht wirklich nachvollziehbare Entscheidungen wie die, die Erdtemperatur für die nördliche und südliche Hemisphäre zunächst getrennt zu berechnen und daraus einen Mittelwert für die endgültige Erdtemperatur zu errechnen. Der Hintergrund ist, dass es im Norden mehr Messstationen als im Süden gibt. Hinzukommt, dass die Distanz zwischen zwei Längengrad am Äquator größer ist als an den Polen. Um dieses Problem auszugleichen, werden die Ergebnisse aus den Zellen, für die Werte vorliegen, gewichtet (wie auch immer).

Die Darstellung der Berechnung der durchschnittlichen Erdtemperatur, die wir morgen für die Darstellung einiger Ungereimtheiten bei der NASA benötigen, sollte schon jetzt gezeigt haben, dass die Temperatursteigerung, die die Klimawandeljünger wie einen Fetisch anbeten, das Ergebnis eines sehr komplexen und mit vielen, sehr vielen Annahmen, Extra- und Interpolationen durchsetzten Prozesses ist. Die durchschnittliche Erdtemperatur, wie wir sie kennen, ist ein Educated Guess, mehr nicht.

Der Beitrag erschien zuerst bei ScienceFiles hier

Weiterführende links zum o.a. Thema hier

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"„Educated Guess: Wie wird eigentlich die durchschnittliche Erd-Temperatur berechnet?“

Das ist doch ganz einfach, man geht genauso vor, wie bei der Ermittlung der globalen Telefonnummer von Berlin. Und dann werden ein paar Rufnummern wie z. B. die 110 oder die 112 adjustiert, und schon kommt ein Ergebnis heraus, an dem 97% der Wissenschaftler keine Zweifel haben.

Und vor allen Dingen, globale Temperatur und globale Telefonnummer haben eine nicht für möglich gehaltene und überraschende Gemeinsamkeit: Man kann damit rein gar nichts anfangen!

Sorry, wenn ich den Spaß hier etwas störe: Die Temperatur ist eine Eigenschaft von Systemen im thermischen Gleichgewicht. Weder die Erde noch größere Teile von ihr (Atmosphäre, Oberfläche. Meere, Inneres) besitzen demzufolge eine „Temperatur“ – da können Sie rechnen, bis sich die Balken biegen.

Seriöse Wissenschaft nennt zu ihren Meßwerten auch den möglichen Fehlerbereich, der durch die angewandten Meßmethoden der Messung innewohnt. Alle immer wieder veröffentlichten Kurven tun so, als gäbe es keinen Fehlerbereich.

Die realen Temperaturen der Atmosphäre in Bodennähe variieren zwischen ca. -80°C bis +50°C, überdecken also einen Bereich von etwa 130°C. Hier einen Mittelwert zu bilden, dem man eine Genauigkeit von Zehntelgraden attestiert, ist absurd. Es wird nicht einmal definiert, was der Wert überhaupt darstellen soll.

Weil eine direkte Mittelung von Temperaturen, die von den unterschiedlichsten Seehöhen stammen, außer einer mathematischen Zahl kein physikalisch relevantes Ergebnis sein kann.

Dazu kommt die Tatsache, daß jegliche weiterführende Rechnung, die auf mathematisch gebildeten Temperaturmittelwerten beruht, physikalischer Schwachsinn ist, weil die physikalische Wirkung von Oberflächentemperatur abhängig ist von der vierten Potenz der wahren Temperatur.

Und auch über den Energiegehalt gibt Temperatur als intensive Größe überhaupt keine Auskunft, der kann nur über die Wärme, gemessen in Joule, als extensive Größe ermittelt werden.

Leider erfahren wir nichts über die Unterschiede in der Auswertung z.B. bei GISS oder HadCruT. Der ganze Artikel wirkt so, als hätte jemand mit null Vorkenntnissen eine Viertelstunde recherchiert und das aufgeschrieben, was er verstanden zu haben glaubt.

Warum wurde z.B. ein so bekannter Datensatz wie BEST nicht einmal erwähnt, der eine fundamental andere Auswertemethode (Kriging) hat? Cowtan&Way gibt es auch noch als weiteren Datensatz.

„Hinzukommt, dass die Distanz zwischen zwei Längengrad am Äquator größer ist als an den Polen. Um dieses Problem auszugleichen, werden die Ergebnisse aus den Zellen, für die Werte vorliegen, gewichtet (wie auch immer).“

Das muss jemand mit naturwissenschaftlicher Vorbildung nicht recherchieren. Wie man in Kugelkoordinaten über Theta und Phi integriert, weiß und kann man dann einfach. Peinlich.

Was integrierst du da genau? Ist das mit diskreten Messstationen nicht etwas schwierig?

Bitte „Sie“, nicht „du“, wir wollen ja höflich sein.

Ich berechne durch Integration die Fläche einer Zelle, das ist dann der Wichtungsfaktor.

Interessanter ist, wie man aus einem diskreten Netz von Messtationen die mittlere Temperatur einer Zelle bestimmt, da unterscheiden sich die Anbieter fundamental voneinander. Da schreibt der Autor nichts, und das ist die Quelle meiner Kritik.

Das „educated“ dürfen Sie getrost weglassen, das ganze Konzept einer Welt-Durchschnitts-Temperatur halte ich schon lange für komplett verblödet! Man hat nicht umsonst in früheren, noch naturwissenschaftlich geprägten Zeiten, die Erden in verschiedene „Klimazonen“ aufgeteilt, wohlwissent, daß die Postulierung einer Durchschnitts-Temperatur aller dieser Klimazonen vollkommen irrelevant ist. Diese Durchschnitts-Temp. ist nur wichtig für aufgeblasene sog. „Klimaforscher“, denen naturwissenschaftliches Denken vollständig abgeht. Deren Spielwiese sind „Modellrechnungen“ diverser Art aber völlig frei von experimenteller Bestätigung.

So sehe ich das auch. Großer Aufwand für eine rein geschätzte Größe. Vorab dazu ein Text aus meinem neuen Manuskript, was derzeit in der Druckvorbereitung ist:

Ein Mittelwert, der keiner ist

„Die Schwierigkeiten, eine solche Funktion (Anmerkung: gemeint ist die Berechnung der globalen Mitteltemperatur) auf einer Kugel mit entgegengesetzt verlaufenden Jahreszeiten in ihren beiden Hemisphären überhaupt aufzustellen, wollen wir hier einmal vernachlässigen. In der öffentlichen Klimadiskussion wird das Weltklima ja schließlich auf eine einzige Durchschnittstemperatur reduziert. Das ist aber keine Naturkonstante, sondern ein künstlicher Zahlenwert, der sich überhaupt erst als statistische Definition ermitteln lassen dürfte. In Ermangelung jeglicher Aussagekraft eines solchen Durchschnittswertes für unser Weltklima müssen dann katastrophale Schreckensszenarien für eine populistische „Belebung“ eben dieses Kunstwertes herhalten.“ Zitat1 aus „Does a global mean temperature exist?“

Aber sie ist noch aus zwei anderen Gründen für den ihr zugedachten Zweck wertlos.

Ein erster ganz wesentlicher Grund ist, dass es zwar mehrere ernsthafte Versuche gegeben hat, ihren Wert aus Messungen zu bestimmen, z.B. durch den bekannten (ehemaligen) Chef der Climate Research Unit P.D. Jones und seiner Mannschaft von der University of East Anglia, diese aber misslangen, bzw. misslingen mussten. Und das deshalb, weil die weltweit verfügbaren Datensätze, viel zu spärlich, viel zu inhomogen und defacto – jedenfalls wenn man die normalen Regeln der Physik und der Messtechnik anwendet, kaum miteinander vergleichbar waren, also nicht in einen Topf geworfen werden durften. Trotzdem wurden munter Lufttemperaturen (SAT) mit Seewassertemperaturen (SST) miteinander kombiniert und die Wichtung der jeweiligen Datensätze einer willkürlichen – wenn auch vermutlich vernünftigen Annahme- unterworfen. Und da ist es auch kein Trost, wenn Jones et al 2(1999 und später noch 2013) in ihrem zum Standard avancierten paper zufrieden hervorheben, dass die von ihnen verwendete CAM Methode (Climate Anomaly Method) sich im Ergebnis nur in wenigen Hundertstel Grad von den Ergebnissen anderer Forscher, die andere Algorithmen verwendeten, unterscheide. Meiner Meinung nach ist das aber allein der Tatsache geschuldet, dass die Forscher dieselben unvollständigen Datensätze verschiedenster Provenienz verwendet haben, welche bei einigermaßen sinnvollen Verknüpfungsalgorithmen – wie Reference Station Method (RSM) von Hansen and Lebedeff (1987) oder der First Difference Method (FDM) von Peterson et al (1998) zu fast denselben Rechenergebnissen führen müssen. Auch die spätere Arbeit von Jones et al 20133 kann daher das Grund-Dilemma nicht auflösen, und deswegen erklären die Autoren unter Results zutreffend.

..Und das Jones dann allerdings später tief in die sog. Climate Gate Affäre verwickelt war, sollte uns jedoch nicht dazu bringen, ihm nicht ernsthafte Bemühungen zur Bestimmung der gesuchten Größe nach bestem Wissen, zu unterstellen.

Daraus folgt der zweite Grund, nämlich, dass sie nicht gemessen wird, nicht nur weil sie nicht gemessen werden kann, sondern weil sie hilfsweise aus den hypothetischen Betrachtungen der Wirkungen, der überwiegend ebenso hypothetischen Energieflüsse innerhalb und außerhalb der Atmosphäre, als Sollwert bestimmt wird. Dem liegt aber eine missbräuchliche Anwendung des Stefan/Boltzmann Gesetzes zugrunde, weil das nur wie eine Einbahnstraße verwendet werden darf. Darauf werde ich später noch ausführlicher eingehen. Jetzt nur soviel: Die Temperatur ist darin das Maß für den (abgehenden) Strahlungs-Energiefluss. Und bestimmt diesen auch nur für einen schwarzen Körper, der sich mit seiner Umgebung im energetischen Gleichgewicht befindet. Ein schwarzer Körper erzeugt also eine Strahlungs-Energiefluss, der allein von seiner Temperatur, diese aber zur 4. Potenz erhoben, abhängt. Umgekehrt gilt aber nicht, dass immer ein gerichteter Strahlungs-Energiefluss, der auf einen Körper gerichtet wird, die Temperatur desselben bestimmt. Dem ist mitnichten so. Beinahe täglich kann man dies im eigenen Mikrowellenherd beobachten. Dort erwärmt die Strahlung zwar die Wassermoleküle in den Speisen, aber nur diese, welche dann mittels Wärmeleitung auch die umhüllenden Stoffe erwärmen. Das (wasserlose) Porzellan hingegen bleibt kalt.

Übertragen auf die idealisierte Erde und ihre Atmosphäre bedeutet dass: Nur wenn man also fälschlich bestimmte, rein hypothetischen Energie(fluss)werte in das Stefan-Boltzmann Gesetz einsetzt, kommen als zugehörige „(Mittel)Temperatur“ 15 ° C (neuerdings, wie schon erwähnt, 14 °) heraus. Und zwar für die ganze, als idealisiert betrachtete Erdatmosphäre. Unabhängig vom Tag und Nacht-Rhythmus, den Jahreszeiten und was sonst noch alles die Erde als Planeten im Sonnensystem auszeichnet. Auch in der Bundestagsdrucksache 11 /3246 (Bericht der Enquete-Kommission zum Schutze der Erdatmosphäre vom 02. November 1988) findet sich auf Seite 188 die Aussage (Hervorhebungen von mir) wird festgestellt: „Verglichen mit der IR-Abstrahlung von 236 W pro m2 aus einer Höhe von etwa 6 km ist die IR-Abstrahlung an der Erdoberfläche dank des Treibhauseffektes wesentlich höher: Sie beträgt bei der mittleren Erdoberflächentemperatur von +15° C gemäß dem Strahlungsgesetz von Stefan-Boltzmann 390 W /m2“ . Da ist sie wieder, die ominöse „Erdoberflächentemperatur von 15 °“, und man kann man lange rätseln, wo und in welcher Höhe die „gemessen“ wurde, wann sie gemessen wurde und auch darüber, was eher da war, die Henne oder das Ei. Da aber eindeutig feststeht, dass weder eine mittlere IR Abstrahlung in Höhe von 390 W/m2 jemals – und schon gar nicht in „vorindustrieller Zeit“, weder direkt noch indirekt- gemessen wurde, ebensowenig wie die dazugehörende Stefan-Boltzmann Temperatur von 15 °, ist das eigentlich auch egal. Was allein stimmt ist, wenn ein schwarzer Körper eine Strahlung von 390 W/m2 (390,92 W/m2 um genau zu sein) abgibt und damit genau so viel wie er empfängt (Gleichgewichtsbedingung), dann muss er eine Temperatur von 15 ° C (288,15 Kelvin) haben. Da aber die genannten 390 W/m2 u.a. darauf beruhen, dass die mittlere von der Sonne empfangene Strahlungsleistung um nur geschätzte 30 % (Albedo) gemindert und dann wegen der Kugelfläche der Erde zur Vereinfachung durch 4 geteilt wird, obwohl die Erde nur auf der Tagseite – also immer nur und jederzeit der halben Fläche- beschienen wird, beruhen sie auf falschen Annahmen, zu deren Berechnung man auf Schätzungen zurückgreift, zu deren Bestimmungen man auf geschätzte Annahmen angewiesen war. Jedoch wird mit der Berechnung auf zwei Stellen hinter dem Komma eine präzises Wissen und damit eine Wissenschaftlichkeit vorgetäuscht, die einfach nicht vorhanden ist.

Das Team vom Klimamanifest von Heiligenroth1 (Siehe Abbildung 4), hat den großen Verdienst, genau das unwiderlegbar herausgearbeitet zu haben. Und auf diesen Grundwert, von 15 ° jetzt plötzlich 14 °, der sozusagen den Torso bildet, werden die aus Messungen berechneten Mittelwerte der Anomalien, also der Temperaturdifferenzen, nach vielfältiger undurchsichtiger Bearbeitung, einfach aufgesetzt. Wie bei einer immer gleichen Schaufensterpuppe, je nach Wunsch des Dekorateurs, bekommt sie einen Kopf mit schwarzem Haar aufgesetzt , oder ein junges Gesicht mit blondem Haar, oder, oder. Und, es kann garnicht oft genug wiederholt, oft genug betont werden, diese „normale Mitteltemperatur“ der Torso also, auf den die Anomalien nach ziemlich undurchsichtigen Kriterien ermittelt und aufgesetzt werden, gibt es weder in der Realität, noch wird sie irgendwo auf Grunde von Temperaturmessungen bestimmt. Sie existiert allein auf Grund von Annahmen, basierend auf Annahmen, die mittels fälschlich angewendeten Stefan-Boltzmann Gesetzes geschätzt werden.

Mit freundlichen Grüßen

M.L.

„Verglichen mit der IR-Abstrahlung von 236 W pro m2 aus einer Höhe von etwa 6 km ist die IR-Abstrahlung an der Erdoberfläche dank des Treibhauseffektes wesentlich höher: Sie beträgt bei der mittleren Erdoberflächentemperatur von +15° C gemäß dem Strahlungsgesetz von Stefan-Boltzmann 390 W /m2“

////

Und das Sahnehäubchen dabei ist, dass als Begründung für die Erdbodentemperatur von + 15°C die „Gegenstrahlung“ von 340 W/m² genannt wird, die selbst wiederum als Ursache die Bodentemperatur von + 15°C hat. Ein sich selbst erwärmendes System, ein perpertuum mobile der 2.Art welches die Klimawissenschaftler da erfunden haben. Aber eines produziert es es ganz sicher, Steuereinnahmen. Wer wagt es denn der „Klimarettung“ zu widersprechen, da wird gezahlt, nicht gezweifelt. Es ist zum verzweifeln….

Wie oft wird eigentlich gemessen, um eine Tagesdurchschnittstemperatur zu bestimmen? Wenn es um Zehntel Grad geht, dürfte es doch einen Unterschied machen, ob ich 24 mal am Tag messe und dann durch 24 teile, oder ob ich nur dreimal messe und dann durch 3 teile.

Das war weltweit ganz verschieden. von 2 x (max und min) über 3 x (Mannheimer Stunden) div. 4 x aber zu verschiedenen Stunden etc. Jeder eingesetzte Algorithmus wie aus den Messwerten ein Tagesdurchschnitt gebildet wird, führt zu unterschiedlichen Ergebnissen, die bei der Zusammenführung fehlerkorrigiert werden müssten, was aber nicht passiert. Der dadurch entstehende systematische Fehler liegt bei ca. ± 0,25 °. Näheres hier

Heute sind es elektronische Messstationen die ihrerseits rd 1/10 ° Fehler hinzufügen und minütlich oder 10 minütlich messen.

Michael Mann, der Klimakaiser, ist nackt. Er wollte in einem Gerichtsprozeß seine Daten und Methodik nicht offenlegen. Offensichtlich eine Nachricht von Bedeutung, betrifft es doch das KLIMA und die „Klimawissenschaft“, aber in der Systempresse kein Wort darüber.

Vielleicht erinnern sich die Jüngeren an den Fall Schröder. Schröder verklagte einen Journalisten, der behauptete, er, Schröder, würde sich die Haare färben. Die Systempresse hatte über viele Tage kein anderes Schlagzeilenthema und ich glaube sogar in der tagesschau wurde darüber bericht.

Das mal nur als Kontrast zur medialen Berichterstattung.

Aber ich will auf etwas Anderes hinaus. Vor einigen Tagen ist mir nachfolgend verlinktes Video in meiner eigenen Suchmaschine aufgetaucht.

Es geht dabei um das Thema Klima. Ein Wissenschaftler präsentiert Daten und Fakten eines Teams aus Wissenschaftlern vor dem US-Senat. Eine Senatsanhörung also. Eine Senatsanhörung in den USA ist so etwas ähnliches wie Anhörungen eines Bundestagsfachausschußes zu dem Fachleute eingeladen werden. Aber bedeutender, denn da befragen Senatoren der Bundesstaaten der USA Fachleute. Was in etwa einer Befragung von Fachleuten durch die Ministerpräsidenten der deutschen Bundesländer entspräche.

Nun gut, hier nun das Video. Ist von einer Anhörung aus dem Jahr 2013, habe in den letzten Tagen die präsentierte Daten- und Faktenlage, so weit möglich, überprüft und es hat sich daran bis heute NICHTS geändert.

Und jetzt zu meiner Aktion. Habe den Link zum Video an alle Volksvertreter meines Wahlkreises gesendet, mit der Bitte um eine zeitnahe Stellungnahme. Macht das bitte ähnlich. Wer wissen will, welche Volksvertreter in seinem Wahlkreis zuständig sind, gehe auf https://www.bundestag.de/abgeordnete etwas runterscrollen und sein Bundesland anklicken, Wahlkreis auswählen, dort bekommt auch die Emailadresse.

Hier nun das Video:

https://www.youtube.com/watch?v=vVQuE9ng4s8

Frag an die Fachleute von EIKE. Ist die Daten- und Faktenlage wie im Video präsentiert noch immer so?

Vielen Dank für die Mühe.

Danke für die Antwort. Vor diesem Hintergrund möchte ich auf diese Publikation aufmerksam machen.

„The battle against global warming:an absurd, costly and pointless crusade“

In dieser wird nur mit Mathematik das völlig absurde der „Klimawissenschaft“ an Hand von Zahlen/Mathematik offen gelegt.

Tut mir leid, das Video war für mich nicht sichtbar. Die Datenlage die Don Easterbrook präsentiert ist unverändert so wie präsentiert.

Ja Don Easterbrook ist bekannt. Zudem muss man vor den Senatoren die Wahrheit sagen, sonst kann man ins Gefängnis kommen. Easterbrook war nicht im Gefängnis.

bekanntlich haben unsere modernen Autos in ihrer Klimaanlage eine recht präzise Anzeige der Aussentemperatur.

Letzter heißer Tag 29.August, Autobahn, schwarzer Asphalt noch recht neu,

Temperatur 36°C. Abfahrt in Sicht, Freudenberg, nette Kleinstadt nun noch 30°C. Dann unterqueren wir die Autobahn und fahren durch einen romantischen kerngesunden Hochwald in unser Hotel mitten im Wald angenehme 26°C und das innerhalb einer Zone von 2-3 km im Zeitabstand von 10 Minuten.

Nun immer noch Fragen zur „Klimaerwärmung ?

Der schöne Artikel ist leider unvollständig. Ich vermisse die Erwähnung der monatlichen Datensätze der Meeres-Temperaturen ERSST v5 ab 1854 und der Land-Temperaturen GHCN v4. ERRST v5 verwendet ein 2° x 2°-Gitternetz und ist vollständig. Für Meereis wird eine Temperatur von -1,8 °C angenommen. GHCN v4 ist eine Sammlung der historischen Station-Messungen ab ca. 1700. Überträgt man diese Daten in ein Gitternetz muss man fehlende Netz-Elemente interpolieren. Daneben stellt CERES „Skin-Temperaturen“ ab 20003 bereit, die aus Satelliten-Daten berechnet werden. Es wird ein 1°x 1°-Gitternetz verwendet und ist vollständig. Dieser Datensatz gibt meiner Meinung nach das beste aktuelle Bild.

Quellen

http://ftp.ncdc.noaa.gov/pub/data/cmb/ersst/v5/ascii

http://ftp.ncdc.noaa.gov/pub/data/ghcn/v4

https://ceres.larc.nasa.gov/order_data.php

Ein interessanter Artikel, nur stellt sich die Frage: Warum sind die 3 Abbildungen jeweils doppelt eingestellt worden?

Offtopic, aber ich fand es witzig und wert geteilt zu werden:

Der Elektroauto Song:

https://www.youtube.com/watch?v=KEO7BChL1Wo