Es geht um folgende Aussagen:

Im AR 5 des IPCC aus dem Jahr 2013 heißt es:

Gleichgewichts-Klimasensitivität (ECS) liegt wahrscheinlich im Bereich 1,5°C bis 4,5°C (hohes Vertrauen). Extrem unwahrscheinlich ist ein Wert kleiner als 1°C (hohes Vertrauen), und sehr unwahrscheinlich ein Wert über 6°C (mittleres Vertrauen).

Auf Seite 17 liest man:

Es ist extrem wahrscheinlich, dass über die Hälfte der beobachteten Zunahme der globalen mittleren Temperatur von 1951 bis 2010 der anthropogenen Zunahme von Treibhausgas-Konzentrationen und anderen anthropogenen Faktoren zusammen geschuldet ist.

Soon, Conolly und Conolly („SCC15“) können sehr gut begründet zeigen, dass die ECS bei einer Verdoppelung von CO2 weniger als 0,44°C beträgt. Außerdem ist deren Schätzung der Klimasensitivität in Bezug auf Variationen der solaren Gesamt-Einstrahlung (TSI) größer als die Schätzung des IPCC. Folglich sind die anthropogenen Treibhausgase ihrer Schätzung zufolge kein dominanter Treiber des Klimas. Begleitende Informationen der drei Autoren einschließlich der von ihnen verwendeten Daten können hier heruntergeladen werden.

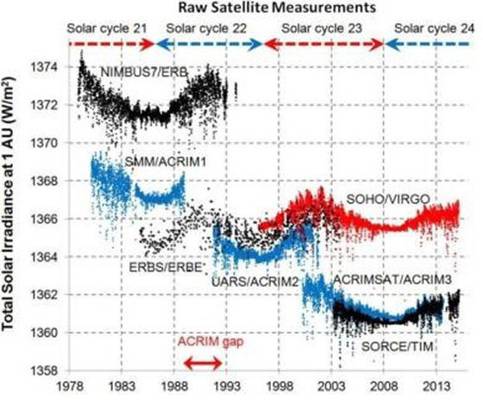

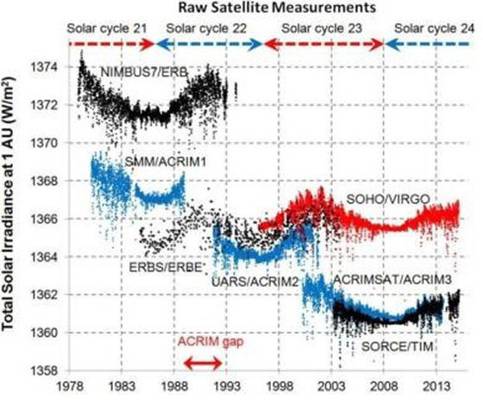

Aus allen Satellitendaten geht hervor, dass der Output der Sonne mit der Sonnenflecken-Aktivität variiert. Ein Sonnenflecken-Zyklus dauert im Mittel 11 Jahre, variiert jedoch von 8 bis 14 Jahren. Nimmt die Zahl der Sonnenflecken zu, steigt auch der solare Output, und umgekehrt. Satellitenmessungen stimmen darin überein, dass die Variation vom Spitzen- zum Minimumwert etwa 2 W/m² beträgt. Die Satellitenmessungen stimmen nicht überein hinsichtlich der Menge der solaren Gesamtstrahlung bei 1 AU [AU = Astronomical Unit = der mittlere Abstand der Erde von der Sonne], zeigen sie doch eine Differenz von 14 W/m², und der Grund für diese Diskrepanz ist unbekannt, aber jeder Satellit zeigt den gleichen Trend über einen Sonnenfleckenzyklus (siehe folgende Abbildung:)

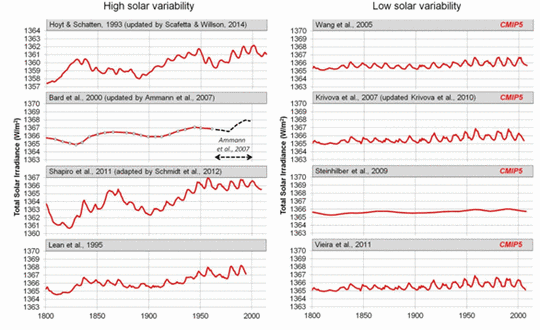

Vor dem Jahr 1979 standen uns lediglich am Boden geschätzte Werte der TSI zur Verfügung, die alle nur auf indirekten Messungen oder „Proxys“ beruhten. Darunter waren Sonnenbeobachtungen, vor allem Art, Größe, Form und Anzahl von Sonnenflecken, die Länge von Solarzyklen, die Aufzeichnung kosmogener Isotope in Eisbohrkernen, Baumring-Analysen mit der C14-Methode und andere. In der Literatur gibt es viele TSI-Rekonstruktionen aus Proxys, von denen einige in der folgenden Abbildung gezeigt sind (aus SCC15 Abbildung 8):

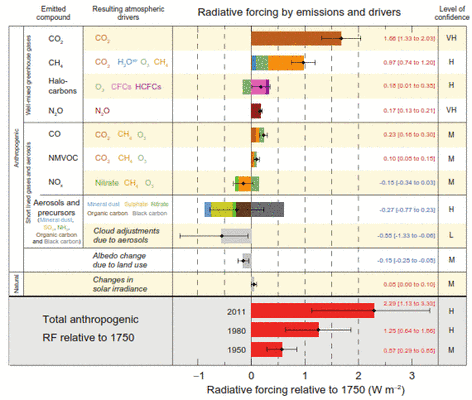

Jene, die höhere Sonnenaktivität anzeigen, sind links zu sehen. Sie wurden vom IPCC bei der Berechnung des menschlichen Einflusses auf das Klima außen vor gelassen. Mit der Auswahl der geringe TSI anzeigenden Aufzeichnungen rechts war man in der Lage zu sagen, dass die Sonne kaum Einfluss hat und die jüngste Erwärmung hauptsächlich den Menschen zur Ursache hatte. Der AR 5 des IPCC zeigte in seiner Abbildung SPM.5 (unten), dass der gesamte anthropogene Strahlungsantrieb (relativ zum Jahr 1750) 2,29 W/m² betrug, derjenige der Sonne aber nur 0,05 W/m².

Folglich geht das IPCC davon aus, dass der Strahlungsantrieb der Sonne seit 1750 relativ konstant ist. Dies ist konsistent mit den Rekonstruktionen der geringen Sonnenaktivität in der rechten Hälfte der Abbildung 8 in SCC15, nicht jedoch mit den Rekonstruktionen auf der linken Seite.

Die Autoren des Kapitels „The Physical Science Basis“ im AR 5 des IPCC mögen wirklich glauben, dass die TSI-Variabilität seit 1750 gering ist. Aber dies spricht sie nicht frei davon, andere gut belegte und begutachtete TSI-Rekonstruktionen zu betrachten, die eine viel größere Variabilität zeigen. Insbesondere hätte man die Rekonstruktion nach Hoyt and Schatten, 1993 berücksichtigen sollen. Diese Rekonstruktion, modifiziert von Scafetta und Willson 2014 (Summary hier) hat den Test mit der Zeit sehr gut bestanden.

Temperatur an der Erdoberfläche

Der Hauptdatensatz zum Studium der Temperaturen an der Erdoberfläche weltweit ist der monatliche Datensatz des Global Historical Climatology Network (GHCN). Es wird verwaltet von der National Oceanic and Atmospheric Administration (NOAA) National Climatic Data Center (NCDC). Gegenwärtig sind die Daten hier einsehbar. Es gibt viele Probleme bei den Messungen der Temperatur über lange Zeiträume. Ländliche Stationen werden städtisch, Ausstattung oder Aufstellungsorte können verändert bzw. verlagert werden.

Longhurst 2015 schreibt auf Seite 77:

…eine grundlegende Übersicht (hier) des Grades, bis zu dem diese Messungen in den USA von Wetterstationen korrekt platziert und betrieben wurden, stammt von einer Gruppe von 600 Mitarbeitern des Blogs Climate Audit: ,…an den in bester Lage aufgestellten Stationen weist die tägliche Temperaturspanne keinen Trend im Jahrhundert-Zeitmaßstab auf‘ … die relativ kleine Anzahl korrekt aufgestellter Stationen zeigte eine geringere langfristige Erwärmung als das Mittel aller US-Stationen. …das Mittel aller Stationen in den obersten beiden Kategorien wies fast gar keinen langzeitlichen Trend auf (0,032°C pro Jahrzehnt während des 20.Jahrhunderts). Fall, et al., 2011).

Die GHCN-Daten sind vom NCDC in Rohformat und „homogenisiert“ verfügbar. Das NCDC glaubt, dass der homogenisierte Datensatz einen Stations-Bias korrigiert hätte einschließlich des Wärmeinsel-Effektes, und zwar mittels statistischer Verfahren. Zwei der Autoren von SCC15, Dr. Ronan Connolly und Dr. Michael Connolly, haben die Temperaturaufzeichnungen von NOAA/NCDC USA und global näher untersucht. Sie haben einen maximalen möglichen Temperatureffekt berechnet infolge Verstädterung; im NOAA-Datensatz, adjustiert um einen Bias der Beobachtungszeit. Dieser Temperatureffekt ergab sich zu 0.5°C pro Jahrhundert (voll städtisch – voll ländliche Stationen). Ihre Analyse zeigt also, dass die NOAA-Adjustierungen der Aufzeichnungen immer noch einen städtischen Bias hinterlassen relativ zu vollständig ländlichen Stationen. Der US-Datensatz enthält 272 von 1218 voll ländliche Stationen (23,2%). Bei Verwendung des US-Datensatzes kann der Bias also abgeschätzt werden.

Der globale Datensatz ist problematischer. Im globalen Datensatz gibt es 173 Stationen mit Daten aus 95 der letzten 100 Jahre, aber nur acht davon sind voll ländlich, und nur eine davon befindet sich auf der Südhemisphäre. Man kombiniere dies mit Problemen sich ändernder Instrumentierung, anderem Personal, Verlagerungen der Instrumente, anderen Wetterhütten – und die Genauigkeit der gesamten globalen Temperaturaufzeichnung ist fraglich. Wenn wir berücksichtigen, dass die Schätzung der globalen Erwärmung im AR 5 von 1880 bis 2012 0,85°C ± 0,2°C beträgt, kann man leicht sehen, warum es Zweifel darüber gibt, wie viel Erwärmung es tatsächlich gegeben hat.

Außerdem: Während die GHCN-Oberflächentemperaturen und die mittels Satellit gemessenen Temperaturen der unteren Troposphäre hinsichtlich ihrer absoluten Werte mehr oder weniger übereinstimmen, zeigen sie unterschiedliche Trends. Dies gilt vor allem für die Studie von Karl, et al. 2015 (die den Stillstand „zerschlagen“ hat) und in diesem Jahr von der NOAA übernommen worden ist. Der NOAA NCEI-Datensatz von Januar 2001 zeigt einen Trend von +0,09°C pro Dekade, und die Satelliten-Datensätze der unteren Troposphäre (sowohl RSS als auch UAH) einen solchen von minus 0,02°C bis minus 0,04°C pro Dekade (hier). Beide Trends liegen innerhalb der Fehlerbandbreite und sind daher statistisch gesehen Null-Trends. Aber ist der Trend unterschiedlich wegen der zahlreichen „Korrekturen“ wie in SCC15 sowie Connolly and Connolly 2014 beschrieben? Der Trend ist so gering, dass es unmöglich ist, sich diesbezüglich sicher zu sein, aber die umfangreichen und zahlreichen Korrekturen seitens der NOAA sind verdächtig. Ich persönlich vertraue den Satellitenmessungen viel mehr als den Temperaturmessungen an der Oberfläche. Aber jene sind kürzer und reichen lediglich bis 1979 zurück.

Die IPCC-Berechnung des menschlichen Einflusses auf das Klima

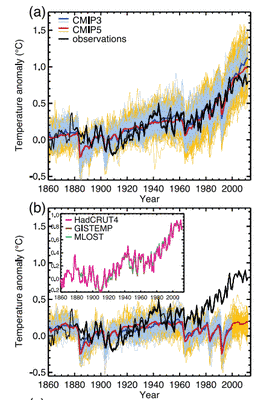

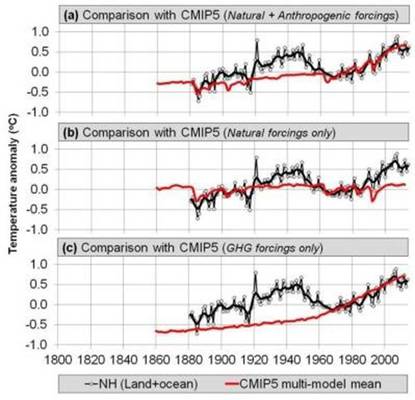

Bindoff et al. 2013 haben zahlreiche Klimamodelle mit vier Komponenten entwickelt, zwei natürlichen und zwei anthropogenen. Die beiden natürlichen Komponenten waren vulkanische Abkühlung und solare Variabilität. Die beiden anthropogenen Komponenten waren Erwärmung durch Treibhausgase, hauptsächlich anthropogenes CO2 und Methan, sowie anthropogene Aerosole, die die Atmosphäre kühlen. Sie haben mit diesen Modellen die globalen Temperaturen von 1860 bis 2012 ,nachhergesagt‘. Ergebnis: alle vier Komponenten zeigten gute Übereinstimmung mit den Messungen, aber wenn man sie ohne die beiden anthropogenen Komponenten laufen lässt wie im CMIP5-Multimodell funktionierte die Nachhersage nur von 1860 bis 1950. Auf der Grundlage dieses Vergleichs kam der AR 5 zu der Schlussfolgerung:

Über die Hälfte der beobachteten Temperaturzunahme von 1950 bis 2010 ist sehr wahrscheinlich der beobachteten Zunahme anthropogener Treibhausgas-Konzentrationen geschuldet.

Der vom IPCC herangezogene Beweis für diese Schlussfolgerung wird in ihrer Abbildung 10.1 illustriert, auszugsweise oben gezeigt. Die obere Graphik (a) zeigt die GHCN-Temperaturaufzeichnung in schwarz und das Ensemble-Mittel von CMIP5 in rot. Dieser Lauf enthielt anthropogene und natürliche „Antriebe“. Die untere Graphik (b) enthält nur natürliche „Antriebe“. Von 1961 oder so bis heute passt das nicht sehr gut. Falls wir davon ausgehen, dass ihre Modelle alle oder fast alle Auswirkungen auf das Klima enthalten, natürliche und anthropogene, ist ihre Schlussfolgerung angebracht.

Während das einfache Vier-Komponenten-Modell des IPCC gut zur gesamten GHCN-Aufzeichnung passen mag (die rote Linie in obigen Graphiken) für alle Stationen, sieht es nicht so gut aus, wenn man nur ländliche Stationen heranzieht:

Wieder ist das CMIP5-Modell in rot gezeigt. Graphik (a) ist das gesamte Modell mit natürlichen und anthropogenen „Antrieben“, (b) enthält nur die natürlichen und (c) nur die Treibhausgas-Antriebe. Keiner dieser Modellläufe passt zu ländlichen Stationen, welche die geringste Wahrscheinlichkeit aufweisen, von städtischen Einflüssen betroffen zu sein. Der Leser wird sich erinnern, dass Bindoff et al. die Rekonstruktionen mit geringer TSI ausgewählt haben, gezeigt in der rechten Hälfte der SCC15-Abbildung 8. Für eine vollständigere Kritik von Bindoff et al. siehe hier (vor allem Abschnitt 3).

Die TSI von Soon et al. im Vergleich zu meist ländlicher Temperatur-Rekonstruktion

Wie also sieht es aus, wenn eine der hoch variablen TSI-Rekonstruktionen, im Besonderen die von Hoyt and Schatten 1993, aktualisiert von Scafetta and Willson 2014, verglichen wird mit den Temperaturaufzeichnungen ländlicher Stationen aus SCC15?

Dies ist Abbildung 27 aus SCC15. Darin werden sämtliche ländlichen Aufzeichnungen (aus China, den USA, Irland und einem Komposit der Nordhemisphäre) verglichen mit der TSI, wie sie von Scafetta und Wilson berechnet worden ist. Der Vergleich ist für alle sehr gut für das 20. Jahrhundert. Die ländlichen Temperaturaufzeichnungen sollten die bestmögliche Aufzeichnungen für diesen Zweck sein: falls die TSI sehr gut zu ihnen passt, muss der Einfluss anthropogenen CO2′ und Methans logischerweise gering sein. Die Erwärmung der Arktis nach dem Jahr 2000 scheint ein wenig verstärkt; dies könnte einem Phänomen mit der Bezeichnung „Polar Amplification“ geschuldet sein.

Diskussion des neuen Modells und der Berechnung des ECS

Eine Korrelation kleinster Quadrate zwischen der TSI in Abbildung 27 und der ländlichen Temperaturaufzeichnung zeigt, dass eine Änderung von 1 W/m² eine Änderung der Lufttemperatur auf der Nordhemisphäre um 0,211°C führen sollte (die Neigung der Linie). Vielleicht erreichen wir nicht ganz zufällig einen Wert von 0,209°C unter der Voraussetzung, dass die Sonne die dominante Wärmequelle ist. Das heißt, falls die mittlere Temperatur der Erde 288 K beträgt und ohne die Sonne bei 4 K liegen würde, beträgt der Unterschied infolge der Sonne 284 K. Kombiniert man dies mit einer mittleren TSI von 1361 W/m², bedeutet dies, dass 1/1361 0,0735% sind und dass diese 0,0735% von 284 sich zu 0,209°C pro W/m² ergibt. Ziemlich cool, aber dies beweist nicht, dass die TSI das Klima dominiert. Es zeigt vielmehr, dass Bindoff et al. 2013 die falsche TSI-Rekonstruktion und vielleicht die falsche Temperaturaufzeichnung verwendet haben könnten. Mir persönlich erscheinen die TSI-Rekonstruktion in SCC15 und die ländlichen Temperaturaufzeichnungen genauso gültig wie jene von Bindoff et al. 2013. Dies bedeutet, dass die von Bindoff und dem IPCC geäußerte Annahme, dass anthropogene Treibhausgase über die Hälfte der Erwärmung von 1951 bis 2010 verursacht habe, fragwürdig ist. Die fundierte Alternative im SCC15 ist genauso plausibel.

Das SCC15-Modell scheint zu funktionieren, zumindest mit den verfügbaren Daten. Also sollten wir in der Lage sein, eine Schätzung der AGW-Komponente zu berechnen. Falls wir die oben beschriebene ländliche Temperatur-Rekonstruktion vom Modell subtrahieren und die Residuen evaluieren (unter der Annahme, dass diese der anthropogene Beitrag zur Erwärmung sind), kommen wir auf eine maximale anthropogene Auswirkung (ECS) von 0,44°C bei einer Verdoppelung des CO2-Gehaltes. Das ist substantiell geringer als die vom IPCC vorhergesagten 1,5°C bis 4,5°C. Bindoff et al. 2013 behaupten ebenfalls, dass ein Wert unter 1°C extrem unwahrscheinlich ist (Hervorhebung von ihnen). Ich denke, dass zumindest der Passus „extrem unwahrscheinlich“ in jener Studie problematisch ist. Die Schätzung von SCC15 mit 0,44°C ist ähnlich der von Idso 1998 abgeleiteten Schätzung von 0,4°C. Es gibt zahlreiche Studien aus jüngerer Zeit, die ECS-Werte berechnen am äußerten unteren Ende der IPCC-Bandbreite und sogar noch niedriger. 14 dieser Studien sind hier aufgelistet. Darunter ist auch die Eckpfeiler-Studie von Lewis and Curry und natürlich die klassische Studie von Lindzen and Choi 2011.

Ist CO2 dominant oder die TSI?

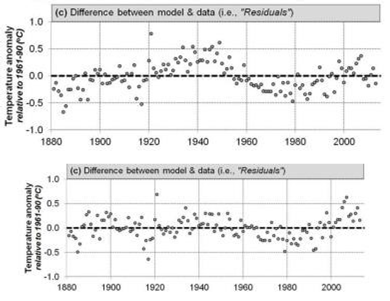

Danach führen SCC15 ein interessantes Gedankenexperiment durch. Was ist, falls CO2 der dominante Treiber der Erwärmung ist? Nehmen wir das mal einen Moment an und berechnen die ECS. Dabei extrahieren sie einen ECS-Wert von 2,52°C, welcher in der unteren Hälfte der vom IPCC gegebenen Bandbreite zwischen 1,5°C und 4,5°C liegt. Allerdings führt dieses Verfahren zu Residuen unter den Modelldaten, die immer noch sehr viel „Struktur“ oder Information enthalten. Mit anderen Worten, dieses Modell erklärt die Daten nicht. Man vergleiche die beiden Plots der Residuen hier:

Der obere Plot zeigt die Residuen des Modells, das annimmt, dass anthropogenes CO2 der dominante Faktor bei einer Temperaturänderung ist. Der untere Plot zeigt Residuen aus dem Vergleich der TSI (und nichts sonst) mit einer Temperaturänderung. Eine beachtliche Anzahl von „Struktur“ oder Information verbleibt im oberen Plot. Dies zeigt, dass das Modell nur sehr wenig der Variabilität erklärt hat. Im zweiten Plot bleibt nur wenig Struktur übrig, und einiges davon kann dem CO2, geschuldet sein, aber der Effekt ist sehr gering. Dies ist ein überzeugender qualitativer Beweis, dass die TSI die Temperatur dominant beeinflusst und CO2 nur einen geringen Einfluss hat.

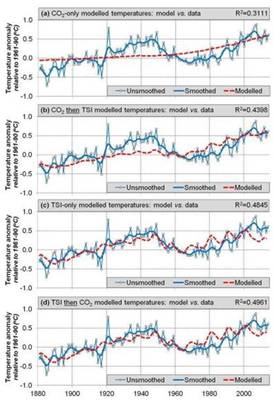

Die AGW-Befürworter sind sehr emsig dabei, die Beweislast der Gemeinschaft der Skeptiker aufzubürden. Die Hypothese, dass der Mensch die meiste Erwärmung von 1951 bis 2010 verursacht hat, ist die zu beweisende Position. Die traditionelle und etablierte Hypothese lautet, dass Klimaänderungen natürlichen Ursprungs sind. Diese Hypothesen sind hier geplottet:

Dies ist Abbildung 31 aus SCC15. Der obere Plot (a) zeigt die Temperaturrekonstruktion der Nordhemisphäre (blau) von SCC15 im Vergleich zur atmosphärischen CO2-Konzentration (rot). Beides passt kaum zusammen. Der zweite Plot (b) passt die CO2-Konzentration an die Temperaturaufzeichnung an und dann die Residuen an die TSI – auch das passt kaum zusammen. Der dritte Plot (c) vergleicht die Temperatur allein mit der TSI, und das passt viel besser. Der vierte Plot schließlich (d) passt die TSI an die Temperaturaufzeichnung an und die Residuen an CO2, und hier passt alles am besten zusammen.

Es folgt die Diskussion dieser Plots aus SCC15:

Dies zeigt, dass zumindest seit 1881 die Temperaturtrends der Nordhemisphäre primär beeinflusst worden sind durch Änderungen der Gesamt-Sonneneinstrahlung TSI und nicht durch atmosphärische CO2-Konzentrationen. Man beachte aber, dass dieses Ergebnis nicht einen sekundären Beitrag durch atmosphärisches CO2 ausschließt. Tatsächlich ist der Korrelations-Koeffizient für Modell 4 (d) etwas besser als für Modell 3 (c), (also ~0,50 zu ~0,48). Wie oben angesprochen zeigt Modell 4 (d) jedoch, dass Änderungen des atmosphärischen CO2′ verantwortlich sind für höchstens ~0,12°C (von insgesamt 0,85°C) im Zeitraum 1880 bis 2012. Das heißt, CO2 hat bislang nur einen sehr mäßigen Einfluss auf nordhemisphärische Temperaturtrends.

Der letzte Absatz aus SCC15 lautet:

Als wir unser neues (Temperatur-)Komposit mit einer der Rekonstruktionen hoher solarer Variabilität der TSI verglichen, was von den Nachhersagen des CMIP5 nicht berücksichtigt worden war, fanden wir eine bemerkenswert gute Übereinstimmung. Falls die Rekonstruktion von Hoyt & Schatten und unsere neue Schätzung des nordhemisphärischen Temperaturtrends akkurat ist, scheint es, als ob man den größten Teil der Temperaturtrends seit mindestens 1881 mit der solaren Variabilität erklären kann, wobei die atmosphärischen Treibhausgas-Konzentrationen höchstens einen geringen Beitrag leisten. Dies widerspricht der jüngsten Behauptung des IPCC, dass das meiste der Temperaturtrends seit den fünfziger Jahren Änderungen der atmosphärischen Treibhausgas-Konzentrationen geschuldet ist (Bindoff et al. 2013).

Schlussfolgerungen

SCC15 zufolge ergibt sich also ein maximales ECS bei einer Verdoppelung von CO2 von 0,44°C. Die Studie zeigt auch, dass von der Erwärmung um 0,85°C seit Ende des 19. Jahrhunderts nur etwa 0,12°C anthropogenen Effekten geschuldet sind, zumindest auf der Nordhemisphäre, von wo die besten Daten vorliegen. Dies ist ebenfalls ein maximaler anthropogener Effekt, wenn wir viele andere Faktoren wie eine variierende Albedo (Wolken, Eis usw.) sowie Wärmetransport-Zyklen in Ozeanen ignorieren.

Während die Korrelation zwischen der neuen Temperatur-Rekonstruktion von SCC15 und der TSI-Rekonstruktion von Hoyt und Schatten sehr gut ist, bleibt der genaue Mechanismus, wie TSI-Variationen das Erdklima beeinflussen unbekannt. In SCC15 werden zwei Optionen angesprochen, nämlich einmal die Zirkulation von Wärme in den Ozeanen und zum anderen der Wärmetransport zwischen Troposphäre und Stratosphäre. Möglicherweise spielen beide Mechanismen eine Rolle in unserem sich ständig ändernden Klima.

Die TSI-Rekonstruktion nach Hoyt und Schatten wurde vor über 20 Jahren entwickelt und scheint immer noch zu gelten. Dies kann man von keinem einzigen der IPCC-Klimamodelle behaupten.

Die Konstruktion einer Temperaturaufzeichnung an der Erdoberfläche ist sehr schwierig, weil sich genau hier Atmosphäre, Festland und Ozeane berühren. Gewöhnlich gibt es hier die höchsten Temperaturgradienten im gesamten System, zum Beispiel den „skin” effect [?]. Misst man die „Oberflächen“-Temperatur am Boden? Einen Meter über Grund? Ein Inch [ca. 2,5 cm] über dem Wasser der Ozeane? Oder ein Inch unter der Ozean-Oberfläche in der warmen Schicht? All diese Temperaturen werden in dem Maßstab, über den wir hier sprechen, immer erhebliche Unterschiede aufweisen, wenige Zehntelgrad Celsius. Die Oberfläche der Erde befindet sich niemals im Temperatur-Gleichgewicht.

Aus Essex et al. 2007:

Während die globale mittlere Temperatur an der Erdoberfläche nichts weiter ist als ein Mittel über Temperaturen, wird es als Temperatur betrachtet, als ob eine Mitteltemperatur tatsächlich die Temperatur selbst ist und als ob ein sich außer Gleichgewicht befindendem Klimasystem nur eine Temperatur aufweist. Aber eine Mitteltemperatur, zusammengestellt aus einem nicht im Gleichgewicht befindlichen Feld ist keine Temperatur. Außerdem muss kaum erwähnt werden, dass die Erde eben nicht nur einfach eine Temperatur hat. Sie befindet sich nicht im thermodynamischen Gleichgewicht – weder in sich selbst noch mit seiner Umgebung“.

Aus Longhurst 2015:

Eine fundamentale Täuschung bei der Verwendung dieser Zahl ist die Vermutung, dass kleine Änderungen der Lufttemperatur an der Erdoberfläche eine Akkumulation oder einen Verlust von Wärme auf dem Planeten bedeuten infolge der Existenz von Treibhausgasen in der Atmosphäre; und mit einigen Einschränkungen ist dies auf dem Festland eine vernünftige Vermutung. Aber über den Ozeanen und damit über 70% der Erdoberfläche bewirkt eine Änderung der Lufttemperatur wenige Meter über der Wasseroberfläche allenfalls eine sich ändernde Vertikalbewegung im Ozean als Reaktion sich ändernde Windverhältnisse an der Oberfläche. Daraus folgt, dass Änderungen der Wassertemperatur (und solchen der Lufttemperatur weniger Meter darüber) nicht notwendigerweise signifikante Änderungen des globalen Wärmegehaltes repräsentieren, obwohl genau diese Vermutung immer wieder geäußert wird.

Allerdings reichen Satellitenbeobachtungen nur bis zum Jahr 1979 zurück und Messungen der globalen Lufttemperatur bis zum Jahr 1880 oder sogar noch weiter. Der Zeitraum von 1979 bis heute ist zu kurz, um irgendwelche bedeutsamen Schlussfolgerungen zu ziehen angesichts der Länge sowohl solarer Zyklen als auch Wärmeverteilungs-Zyklen in den Ozeanen. Selbst der Zeitraum von 1880 bis heute ist noch ziemlich kurz. Wir haben nicht die benötigten Daten, um zu irgendwelchen gesicherten Ergebnissen zu kommen. Die Wissenschaft ist definitiv nicht settled.

Link: http://wattsupwiththat.com/2015/10/08/a-short-summary-of-soon-connolly-and-connolly-2015-re-evaluating-the-role-of-solar-variability-on-northern-hemisphere-temperature-trends-since-the-19th-century/

Übersetzt von Chris Frey EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Zitat: … unbenommen Ihrer Rechenkünste machen Sie allerdings den Fehler aller Treibhausprediger, dass Sie in Ihren Berechnungen einen solchen einfach voraussetzen. Das ist nicht nur unzulässig, sondern falsch.

Nein, machte ich nicht. Zumal das auch nichts mit dem „Treibhaus-Effekt“ zu tun hat, nur ganz nebenbei.

Das Erd-System ist kein statisch-konservatives System, wo der Energie-Input und Energie-Output in jedem Zeitintervall gleich ist. Nur in einem statisch-konservatives System gilt: Energie-Input(t) = Energie-Output(t). Bei dynamischen und dissipativen Systemen mit externen Einflüssen treten immer Divergenzen (bzw. dynamische Divergenzen) zwischen Input und Output auf, das lässt sich nicht vermeiden. In einem dynamisch und dissipativen System gilt: Energie-Input(t) + div(t,in) = Energie-Output(t) + div(t,out).

Und die „Klimasensitivität“ ist eigentlich die Divergenz-Betrachtung zwischen den energetischen Input und Output für das dynamische und dissipative System Erde. Nun liegt es an der Messtechnik, wie genau oder ungenau solche dynamisch-bedingten Divergenzen bestimmt werden können. Die Divergenz kann sich natürlich ändern, je nachdem, wie die externen Einflüsse schwanken bzw. im Inneren des Systems dissipative Strukturen ausgebildet oder zerstört werden. Gut, man kann das auch als systemische Fluktuations-Größe oder dynamische Divergenz-Größe eines realen Systems bezeichnen.

Das Problem liegt daran, dass man leider nur unvollständige Informationen über ein dynamisches System hat, wie zum Beispiel:

+ Anzahl der Freiheitsgrade unbekannt

+ meist nur eine oder wenige Variablen gemessen

+ Rauschen

+ endlicher Beobachtungszeitraum

+ endliche Datengenauigkeit

Das kann natürlich auch zu Fehl-Interpretationen der Werte führen, falls man div(t,in) oder div(t,out) getrennt betrachtet, denn es gilt: Energie-Input(t) – Energie-Output(t) = div(t,out) – div(t,in).

Mfg

Werner Holtz

#10: Dr.Paul sagt:

„und zu @#7: besso keks, auch „ein wenig CO2-Strahlung ist NICHT da“ ,

das kann man leicht messen.“

Hallo Herr Dr. Paul,

manchmal bin ich zu gutmütig…

Sie haben aber Recht: man soll in der Diskussion um die Ökofaschistenphysik keinen mm zurückweichen.

MfG

#5: Hallo sehr geehrter Herr Werner Holtz unbenommen Ihrer Rechenkünste machen Sie allerdings den Fehler aller Treibhausprediger, dass Sie in Ihren Berechnungen einen solchen einfach voraussetzen.

Das ist nicht nur unzulässig, sondern falsch.

Es ist doch nun wirklich nicht so schwer zu verstehen, dass es zwar einen ganz erheblichen Atmosphäreneffekt gibt,

das zeigt der Vergleich mit dem Erdmond ohne Atmosphäre mit dem gleichen Abstand zur Sonne,

aber,

dass z.B. Wasser die Erdoberflächentemperatur senkt und nicht erhöht.

a)Wasser ENTZIEHT der Erdoberfläche beim Verdunsten Wärme, die sie von der Sonne erhält und b) als Wolke reduziert Wasser die Energiezufuhr von der Sonne.

und zu @#7: besso keks, auch „ein wenig CO2-Strahlung ist NICHT da“ ,

das kann man leicht messen.

Der physikalische Effekt von CO2 (0,04% der wasserfreien Luft) in der Troposphäre beschränkt sich auf auf die Absorption im 15µm-Bereich in der Absorptionslänge von maximal einigen 100 Metern von der Oberfläche. Danach gibt es keine 15Mm-Strahlen mehr.

Mir hat noch keiner exakt vorgerechnet wieviel „Wärme“ dabei im Bereich dieser Absorptionslänge frei wird, nach Gerlich als Temperatur der 100% Atmosphäre nicht messbar.

Und was macht diese Wärme?

Sie führt prinzipiell bei dem bekannt hohen Ausdehnungskoeffizient und der minimalen kinetischen Viskosität der Luft zu einer Beschleunigung der aufwärts gerichteten Luft- zirkulation.

Aber nicht zu einer Erhöhung der Erdoberflächentemperatur.

Was ist nun der „Atmosphäreneffekt“?

cum grano salis:

1) Die Sonne strahlt DURCH die Atmosphäre auf die Erdoberfläche,

2) Die Erdoberfläche gibt einen erheblichen Teil davon materiell durch Konvektion an die Atmosphäre ab (=Kühlung).

3) Dieser Teil ist der Wärmespeicher für die Nacht (+ globale Zirkulation), denn die Atmosphäre ist zum Vakuum des Weltraums perfekt isoliert, sie strahlt nicht (im Gegensatz zur Erdoberfläche).

Die „Gegenstrahlungstheorie“

ist grob FALSCHE Kindergartenphysik und hat nicht das geringste mit seriöser „Wissenschaft“ zu tun.

mfG

„Der Hauptdatensatz zum Studium der Temperaturen an der Erdoberfläche weltweit ist der monatliche Datensatz des Global Historical Climatology Network (GHCN).“

Ein GCM ist nur dann brauchbar, wenn es die regionalen Entwicklungen der bodennahen Temperatur vernünftig abbildet, nämlich da, wo das Meßnetz hinreichend dicht ist.

Die Strömungsmuster der Atmosphäre mit ihren langen Wellen werden von der meridionalen Temperaturdifferenz erzeugt und nicht von der „globalen“ Mitteltemperatur. Die spielt natürlich auch eine Rolle, über den Wasserdampf, also der meridionalen latenten Energiedifferenzen (Differenzen der pseudopotentiellen Temperatur).

„Der Hauptdatensatz zum Studium der Temperaturen an der Erdoberfläche weltweit ist der monatliche Datensatz des Global Historical Climatology Network (GHCN).“

FDas Problem mit diesem Datensatz ist, daß er nicht konsistent ist und die Stationen nicht repräsentativ für die Region sind.

Es gibt in den USA das wesentliche dichtere COOP-Meßnetz, welches genutzt werden müßte, um die Repräsentativität der einen GHCN-Station festzustellen und zu normieren, heißt deren systematische Abweichungen vom normierten Flächenmittel des dichteren Stationsnetzes zu bestimmen und so zu „homogenisieren“.

#6: Markus Estermeier sagt:

„Nun seien Sie mal nicht so streng.“

Hallo Herr Estermeier,

unabhängig davon, daß wir in der Sache eh einig sind,

der Trend geht zu Klimasensivität = 0.

Das zeigt ja auch der neue Beitrag von Herrn Dr. Koelle.

Herr Holtz, den ich aufgrund seiner kompetenten Beiträge hier sehr schätze kommt nun auf sagenhafte dT(2*CO2) = 0,0355K.

Wie will man das überhaupt messen können?

Und warum? 😉

Sollte es einen tatsächlichen Wert in dieser Größenordnung geben (ein wenig Strahlung ist wohl da), dann wäre zumindest erklärt, warum keine Korrelation von T und CO2 feststellbar ist.

Auch gut

MfG

#4 besso keks

Nun seien Sie mal nicht so streng.

Ich hab da so ein Gedankenspiel ganz ohne dieses Strahlungs-/Gegenstrahlungs-Gedöns.

Nehmen wir mal an wir hätten eine Atmosphäre ohne CO2, dann würde sich das „freie Fenster“ der Erdabstrahlung um diese 15mikro-Bande erweitern. Temperaturmäßig dürfte das wohl keine große Auswirkung haben. Nun haben wir aber dieses Molekül in der Luft und der freie Durchmarsch ist nicht gegeben. Also wird diese vom CO2-Molekül absorbierte Energie zusammen mit der „restlichen“ warmen Luft nach oben getragen. Ich glaub das nennt man Thermik 😉

Ob nun dieses CO2 Molekülchen unterwegs seine Erregung durch stuppsen oder strahlen mal verliert und danach eventuell von einem Nachbarn wieder in der richtigen Frequenz angeregt wird, spielt eigentlich keine Rolle. Es ist ein Geben und Nehmen bis in eine Höhe, wo Stuppsen vor Strahlen eher unwahrscheinlich ist. Ab hier kann Herr Stehlik weiter erzählen.

Hallo

Interessante Ausarbeitung und Schlussfolgerungen!

Zitat: Eine Korrelation kleinster Quadrate zwischen der TSI in Abbildung 27 und der ländlichen Temperaturaufzeichnung zeigt, dass eine Änderung von 1 W/m² eine Änderung der Lufttemperatur auf der Nordhemisphäre um 0,211°C führen sollte (die Neigung der Linie). Vielleicht erreichen wir nicht ganz zufällig einen Wert von 0,209°C unter der Voraussetzung, dass die Sonne die dominante Wärmequelle ist. Das heißt, falls die mittlere Temperatur der Erde 288 K beträgt und ohne die Sonne bei 4 K liegen würde, beträgt der Unterschied infolge der Sonne 284 K. Kombiniert man dies mit einer mittleren TSI von 1361 W/m², bedeutet dies, dass 1/1361 0,0735% sind und dass diese 0,0735% von 284 sich zu 0,209°C pro W/m² ergibt.

Man sollte dabei aber bedenken, dass diese Temperatur-Änderung von ca. 0,21 Grad alle Bestandteile der Atmosphäre betrifft. Damit ergibt sich zwangläufig für das CO2 ein noch viel geringer Einfluss. Der Einfluss des Wassers in all seinen Aggregatzuständen in der Atmosphäre beträgt ca. 90%, damit bleibt für das CO2 nicht mehr viel übrig.

Auch meine einigen Berechnungen aus den ERBE und CERES Daten ergeben eine „Klimasensitivität“ bei Verdoppelung der CO2 Konzentration von gerade mal dT = 0,355K inklusive den Wassereinfluss in der Atmosphäre.

dT = 0,511K*ln(c/c0) = 0,511K*ln(2) = 0,355K (1,85 W/m^2)

oder

dT = 0,21K + 0,21K*ln(c/c0) = 0,355K

Wenn man das Ergebnis inklusive Wassereinfluss nur auf das reine CO2 bezieht, ergibt sich eine nur CO2-bedingte Temperaturänderung von gerade mal dT(2*CO2) = 0,0355K.

Mfg

Werner Holtz

Wieder eine Studie, dazu noch einigermaßen aufwendig, die versucht einen Wert für die angebliche „Klimasensivität“ von CO2 anzugeben.

Lächerlich und so überflüssig wie ein Kropf!

Sehr sachliche Darstellung.

Zur Frage des Skin-Effekts – leider gibt es wohl wenige längerfristige und keine großräumigen Messungen von Gesteins-/Bodentemperaturen in z.B. 3 und (gleichzeitig) 5m Tiefe.

…

„…bleibt der genaue Mechanismus, wie TSI-Variationen das Erdklima beeinflussen unbekannt“

Es sind ja mehrere Hypothesen dazu vorhanden:

– neben den genannten vertikalen Transporten in den Fluiden Tiefenwasser und Luft (Stratosphäre) ja noch direkte (stärkere Strahlungsabsorption der stärker mit dem Sonnenzyklus schwankenden Strahlungsanteile im Wassermolekül) und indirekte (Sonnenwind und kosmische Strahlung) Wirkung auf Wolkenbildung und -Auflösung sowie weitere…z.B. Wechselwirkungen der Magnetfelder und Strömungen von Ladungsträgern im Meer und im Erdinneren und des Sonnenmagnetfeldes bis zu Strahlungsanteilen, deren Messung (und Wechselwirkungsbeurteilung) problematisch ist (Neutrinos)…ein weiteres Feld als schnödes CO2;-)

Derjenige der in der im Leben etwas zu Ende entwickeln musste weis, dass A und O eines brauchbaren Ergebnisses das Messen der existierenden Parametern ist. Einen der schwierigster Problem stellt sich eine Temperatur der Atmosphäre verlässlich zu messen. Aus dieser Messwertreihen ein Durchschnittwert zu rechnen wird immer mit einem Fehler behaftet besonders dann, wenn der Zweck und Ergebnis schon vorbestimmt ist. Damit meine ich den Einfluss von nicht präzis bestimmbaren Anteil von CO2 in der Luft als Faktor der Temperatur in der Atmosphäre. Das Ergebnis ist zwangsläufig ein nicht zu ernst nehmende „Kuttelmuttel“ was gerade für die „Wissenatoren“ z.B von PIK, IPPC etc. was für neue Zukunftprojektionen und“Vorschungsprojekte2 wichtig ist, damit die Steuergelde fliesen.

Ein klaren Ergebnis scheuen wie der Teufel Weihwasser und das schreibe ich als Atheist.

MfG

Ein sehr interessanter Artikel, auch wenn er ein wenig holperig und langatmig daher kommt. Im Besonderen ist die Bedeutung der Klimasensitivität ansonsten meist völlig unterbewertet, obwohl diese der zentrale Faktor in der AGW-Hypothese ist. Selbst innerhalb der IPCC Publikationen ist bereits die Bandbreite von 1,5 – 4,5 für ‚wahrscheinliche‘ Werte ein Armutszeugnis. Selbst ohne die hier geleistete Argumentation kann es dem aufmerkasmmen Leser nicht als plausibel erscheinen, wenn man die Faktor 3 zwischen dem kleinsten ‚wahrscheinlichen‘ Wert und dem größten ‚wahrscheinlichen‘ Wert heran zieht. Das belegt in sich bereits, dass man völlig unzureichendes Wissen hat, und bestreitet dies auch nicht mal, will aber zugleich Milliardenprogramme lostreten und kolportiert Alarmmeldungen.

Ergänzend möchte ich auf das Maodell von Prof. Harde verweisen, das hier nicht erwähnt wurde, aber zu ähnlich niedrigen Klimasensitivitäten kommt. Darin wird auch nicht bestritten, dass die sogenannten Treibhausgase durchaus Klimawirksam sind. Allerdings bei weitem nicht in dem Maß, wie es das IPCC behauptet.

Der Artikel zeigt, dass die TSI Varianz und die damit verbundene Erklärung weit stärker ist. Das war mir neu. Ich bin früher von den niedrigen Schätzdaten ausgegangen, auf die das IPCC verweist. Allerdings erscheint mir dieser Ansatz nun immer weniger haltbar.

Ein kleines Argumentationsproblem ensteht aber im Kontext durch einen Konflikt zwischen TSI-Erklärung und Wolkenbildung nach Svensmark.

Nach Svensmart ist eine hohe TSI-Varianz nicht erforderlich, denn durch die kosmische Strahlung und deren Steuerung des Sonnenmagnetfeldes sollte die Erklärung weitgehend erfolgen. Hier aber wird die TSI-Varianz als weitgehende Erklärung heran gezogen. Dies macht den Svensmark Ansatz überflüssig, denn es bliebe nicht mehr genügend beobachtbare und ansonsten unerklärte Varianz übrig, die Svensmark erklären könnte.