Nun stagnieren die weltweiten CO2-Emissionen, aber die CO2-Gehalte der Atmosphäre steigen unverändert weiter an – das führt die Aussagen des „Klimarates der Vereinten Nationen“ (IPCC) zur Wirkung von CO2 ad absurdum und damit auch die deutsche ideologische Energiepolitik

Durch die Dekarbonisierung Deutschlands wird der CO2-Gehalt der Atmosphäre um skurrile 0,000 28 ppm/a (0,000 000 028 %/a) abgebaut – die Verfolgung dieser Dekarbonisierung im „Kern durch die Bepreisung der Treibhausgase“ (Regierung) entbehrt bei diesen CO2-Spuren jeglicher Grundlage

Dr. Erhard Beppler

Fazit

Es gibt viele messbare Einflussgrößen auf die Temperatur der Erde wie z. B. der Abstand der Erde zur Sonne (Milankovic-Zyklus), die Sonnenaktivität, etc., nur der Einfluss des CO2-Gehaltes der Atmosphäre auf die Temperatur konnte nicht gemessen werden.

Nun werden fehlerhafte Computermodelle des IPCC herangezogen, um den Einfluss der weltweiten, von Menschen verursachten CO2-Emissionen auf die Temperatur zu beweisen.

Aber besagte Modelle weisen viele Fehler auf.

So wird stets vom Gesamt-CO2-Gehalt der Atmosphäre ausgegangen, obwohl der anthropogene CO2-Anteil nur bei 4% liegt.

Selbst bei der atmosphärischen Rückstrahlung (Treibhauseffekt) bleibt in den Modellen unberücksichtigt, dass die Absorptionsbanden des CO2 (0,04%) im Wellenlängenbereich von 14-17 µm stark von Wasserdampf (bis 4%) überlagert werden.

Außerdem kann der Einfluss von Wasserdampf und Wolken in den Modellen nicht berücksichtigt werden.

Schließlich geht auch noch der Anstieg der weltweiten anthropogenen CO2-Emissionen bis 2024 gegen null. Nach der Vorstellung des IPCC zum ausschließlichen Einfluss des anthropogenen CO2-Anteiles der Atmosphäre auf den Anstieg der Temperatur müssten dann die Temperaturen abfallen – aber das Gegenteil ist der Fall: die Temperaturen steigen sogar vermehrt an.

Durch den Rückgang des Anstieges der weltweiten anthropogenen CO2-Emissionen von 2019-2024 auf nur noch 0,112 Giga Tonnen (Gt) CO2/a steigen die CO2-Gehalte der Atmosphäre nur noch um 0,112/7,75 = 0,014 ppm/a und nicht um 2 ppm/a nach Aussage des IPCC.

Wird nun berücksichtigt, dass Deutschland an den weltweiten CO2-Emissionen nur mit weniger als 2% beteiligt ist, errechnet sich ein skurriler deutscher Anteil am Anstieg der CO2-Gehalte der Atmosphäre von 0,014 x 0,02 = 0,000 28 ppm/a oder 0,000 000 028 %/a.

Damit wird der „Kern des Klimaschutzes, die Bepreisung der Treibhausgase“ (Regierung) obsolet.

Deutschland lebt dennoch völlig losgelöst von Fakten und will die Dekarbonisierung bis 2045 vollenden, obwohl die Stromkosten bereits die weltweit höchsten sind, die Industrien abwandern, die Insolvenzen Rekordzahlen aufweisen mit Folgen für die Steuereinnahmen und damit die sozialen Fähigkeiten unseres Sozialstaates (Reaktionen aus der Politik sind inzwischen vernehmbar).

1.Einleitung

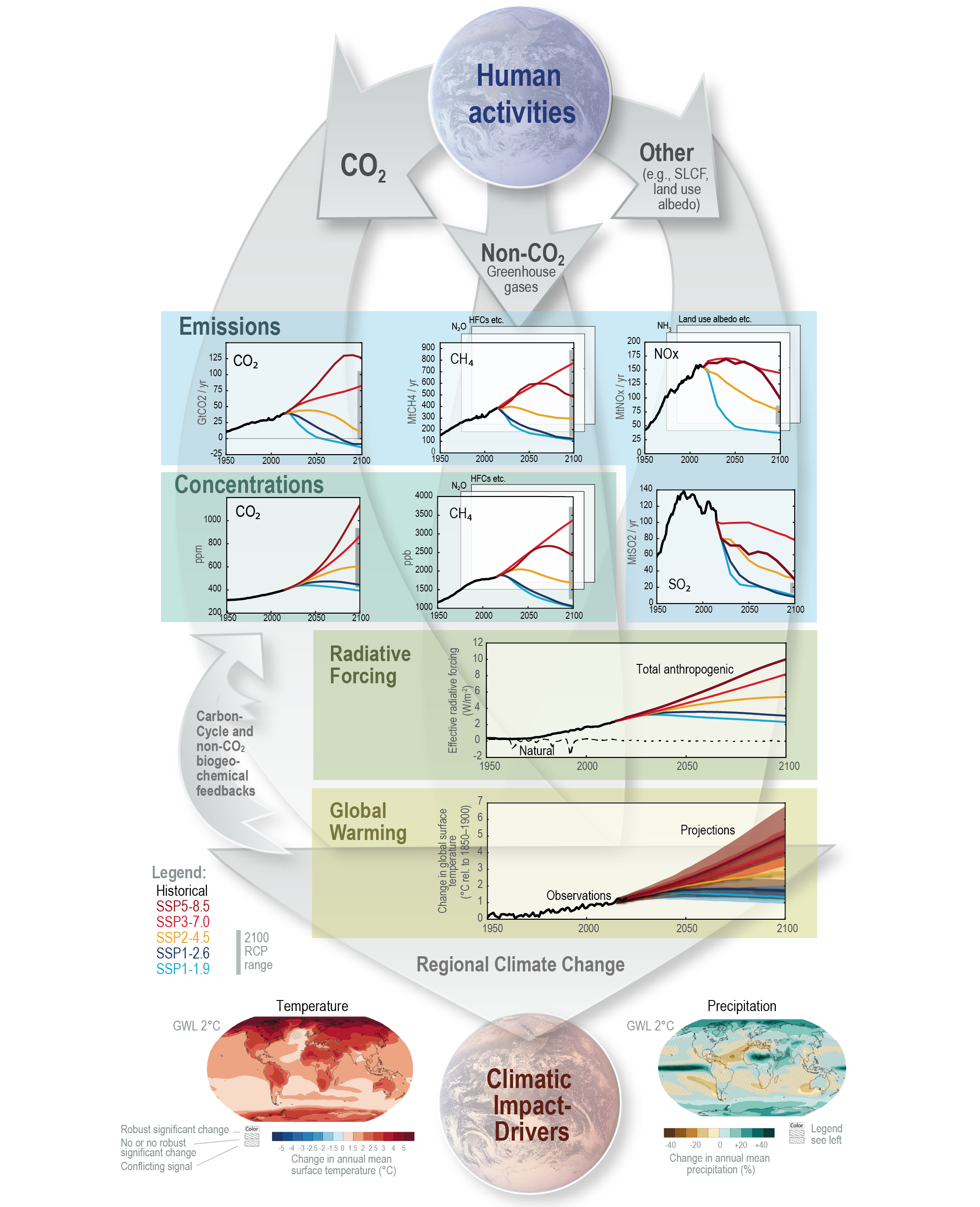

Die Klimapolitik der Welt wird seit den 1980er Jahren vom Klimarat der Vereinten Nationen“ (IPCC) bestimmt mit Aussagen zum ausschließlichen Temperaturanstieg der Atmosphäre durch die weltweiten anthropogenen CO2-Emissionen auf der Basis von Computermodellen und Hinweisen auf diverse Weltuntergangsszenarien (6. Sachzustandsbericht IPCC, März 2023).

Im Einzelnen lauten die Aussagen des IPCC wie folgt:

a) Von den jährlichen weltweiten anthropogenen CO2-Emissionen von z.Z. 10 Giga Tonnen Kohlenstoff/a (GtC/a) entsprechend 4 ppm gelangen 50% in die Atmosphäre , sichtbar an einem CO2-Anstieg der Atmosphäre von z.Z. 2 ppm/a und verbleiben dort über Jahrhunderte, und die andere Hälfte wird in gleichen Teilen (je 25%) von 10 GtC/a vom Ozean und der Biomasse aufgenommen

b) Durch den Eintrag der anthropogenen CO2-Emissionen in die Atmosphäre soll die CO2-Konzentration der Atmosphäre immer weiter ansteigen und damit über den Treibhauseffekt die Temperaturen auf der Erde bis zur Katastrophe anheben. (Anstieg CO2-Gehalte von 1850 bis heute etwa 120 ppm (0,0120%))

c) Daraus resultiert die Forderung nach einer vollständigen Dekarbonisierung (Net Zero), nur so könnte die Klimakatastrophe abgewendet werden

Gemäß Koalitionsvertrag von Union und SPD soll der Kern des Klimaschutzes aus der Bepreisung von Treibhausgasemissionen bestehen, d.h. am Ende sollen nur Wind und Sonne einschließlich Wasserstoff die Stromerzeugung sichern, koste es was es wolle.

2. Erdgeschichtliche Betrachtung der CO2-Gehalte der Atmosphäre sowie der Temperatur und Einflussgrößen auf die Temperatur

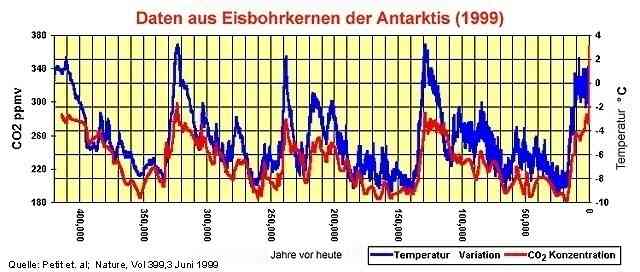

Durch die Veränderung der Umlaufbahn der Erde um die Sonne von kreisförmig zu elliptisch im Zeitraum von etwa 100 000 Jahren wurden die Temperaturen auf der Erde gewaltig verändert (Milankovic-Zyklus), wie Messungen an Eisbohrkernen gezeigt haben. (Bild 1)

Bild 1: Verlauf der CO2-Gehalte wie der Temperaturen nach Messungen an Eisbohrkernen

In den Eiszeiten sind CO2-Gehalte um 200 ppm, in den Warmzeiten um 280 ppm gemessen worden. Der Anstieg der CO2-Gehalte der Atmosphäre folgt zeitversetzt dem Temperaturanstieg – durch die mit steigender Temperatur abnehmende Löslichkeit von CO2 in Wasser.

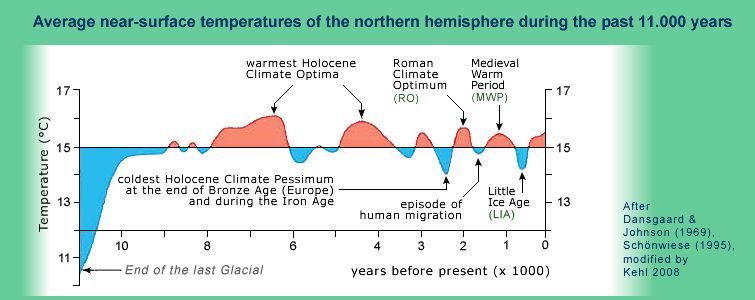

Der Temperaturverlauf nach der letzten Eiszeit ist Bild 2 zu entnehmen.

Bild 2: Warmphasen nach der letzten Eiszeit

In den wärmsten Phasen des Holozäns waren die Alpen eisfrei.

Ausgerechnet die jetzige Warmzeit wird vom IPCC als ein apokalyptisches Ereignis bezeichnet und das vom Menschen verursachte CO2 für den Temperaturanstieg verantwortlich gemacht, obwohl die Warmphasen vor der jetzigen ohne menschlich verursachtes CO2 praktisch alle wärmer waren.

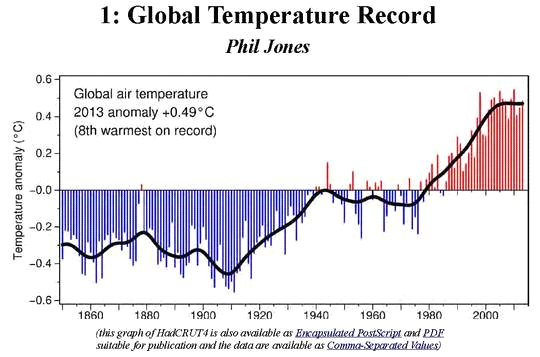

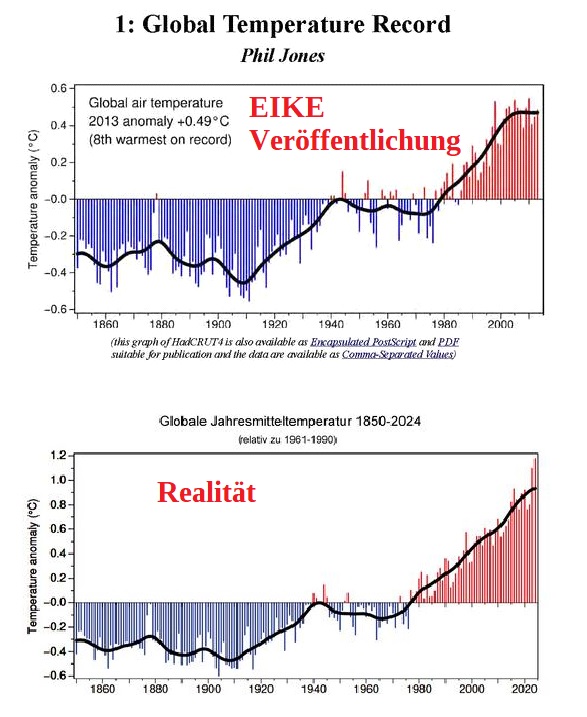

Neuere Messungen zeigen, dass in der jetzigen Warmphase nach 1940 bis etwa 1980 die Temperaturen nach einem Anstieg zunächst wieder abfallen, um dann bis heute erneut anzusteigen. (Bild 3)

Bild 3: Temperaturentwicklung nach 1850

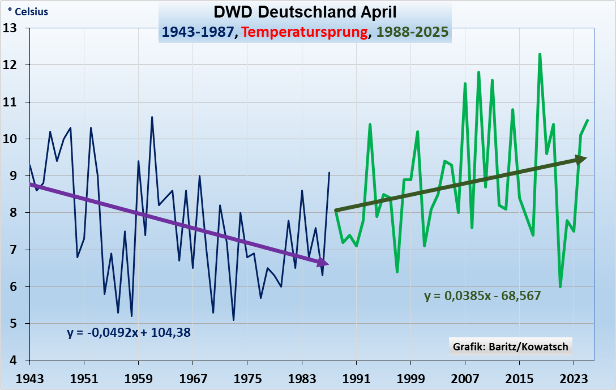

Dieser Abfall bis etwa 1980 und Wiederanstieg bis 2025 wird auch in neueren Messungen bestätigt. (Bild 4)

Bild 4: Temperaturentwicklung 1940 bis 2025

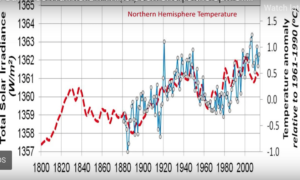

Dieser Verlauf ist im Wesentlichen auf wechselnde Aktivitäten der Sonne einschließlich der damit verknüpften kosmischen Strahlung zurückzuführen. (Bild 5) (1)

Hinzugefügt werden muss noch die zunehmende Sonnenscheindauer als Einflussgröße auf den jetzigen Temperaturanstieg, verursacht durch einen Rückgang der Aerosole als Verursacher für die Wolkenbildung.

Bild 5: Verlauf der Intensität der Sonneneinstrahlung

Hervorzuheben ist weiterhin, dass trotz steigender Temperaturen die Nachttemperaturen abfallen, vermutlich durch die Abnahme der nächtlichen Bewölkung. (2)

Es kann also festgestellt werden, dass es viele gemessene Einflussgrößen auf die Temperatur gibt, aber keine zum Einfluss des CO2-Gehaltes der Atmosphäre, geschweige denn den von anthropogenen CO2-Emissionen. (vgl. Kapitel 4)

Nicht unerwähnt darf auch der Einfluss des Vulkanismus auf die Entwicklung des CO2-Gehaltes bleiben, ebenso wie die CO2-Freisetzung der Meere bei steigenden Temperaturen, etc. (vgl. später)

Schließlich sind die Ozeanzyklen und ihr Einfluss auf die globalen Temperaturen zu nennen: El Nino Sothern Oszillation (ENSO), Pazifische Dekaden-Oszillation (PDO), Atlantische Multidekaden-Oszillation (AMO) (mit Temperaturänderungen bis zur Arktis) und die Indische-Ozan-Dipol (IOD), etc. (3)

3. Weitere kritische Betrachtungen zu der Aussagefähigkeit der Modelle des IPCC

Nachdem es nun viele messbare Einflussgrößen auf die Temperatur gibt aber keinen durch den Einfluss der CO2-Konzentrationen, nun zu den Aussagefähigkeiten der IPCC-Modelle, dargestellt an einigen Beispielen.

Alle Wetter- und Klimaphänomene der Erde sollen mit Hilfe von Computermodellen gelöst werden – aber selbst einfachste Eingaben in die Modelle sind nicht nachvollziehbar. So wird ausgerechnet bei der Vorhersage der Temperatur auf der Basis von CO2-Vorgaben nicht differenziert nach anthropogenen CO2-Emissionen und natürlichen CO2-Quellen, sondern stets ausschließlich von ihrer Summe. (vgl. Kapitel 5)

Außerdem ist die Betrachtung der atmosphärischen Rückstrahlung („Treibhauseffekt“) des CO2 kritisch zu sehen. Die Absorptionsbanden des CO2 (0,04%) im Wellenlängenbereich von 14-17 µm werden stark von Wasserdampf (bis 4% H2O) überlagert. Schon alleine dadurch kann CO2 energetisch betrachtet in der Atmosphäre keine Rolle spielen.

Selbst der Einfluss des Wasserdampfes und der Wolken kann in den IPCC-Modellen nicht berücksichtigt werden.

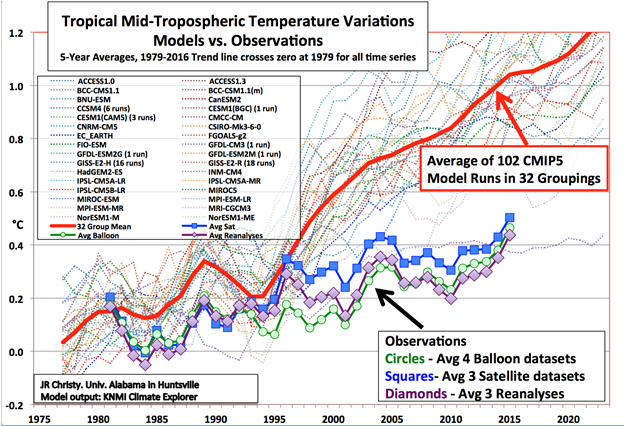

Es verwundert nun nicht mehr, dass die mit Hilfe der IPCC-Modelle ausgewiesenen Temperaturerhöhungen bei steigenden CO2-Gehalten der Atmosphäre weder die Vergangenheit abbilden können, geschweige denn die Zukunft voraussagen. (Bild 6)

Bild 6: Aussagefähigkeit der Klimamodelle

4. Betrachtung des anthropogenen CO2-Anteiles in der Atmosphäre von 1870 bis 2020

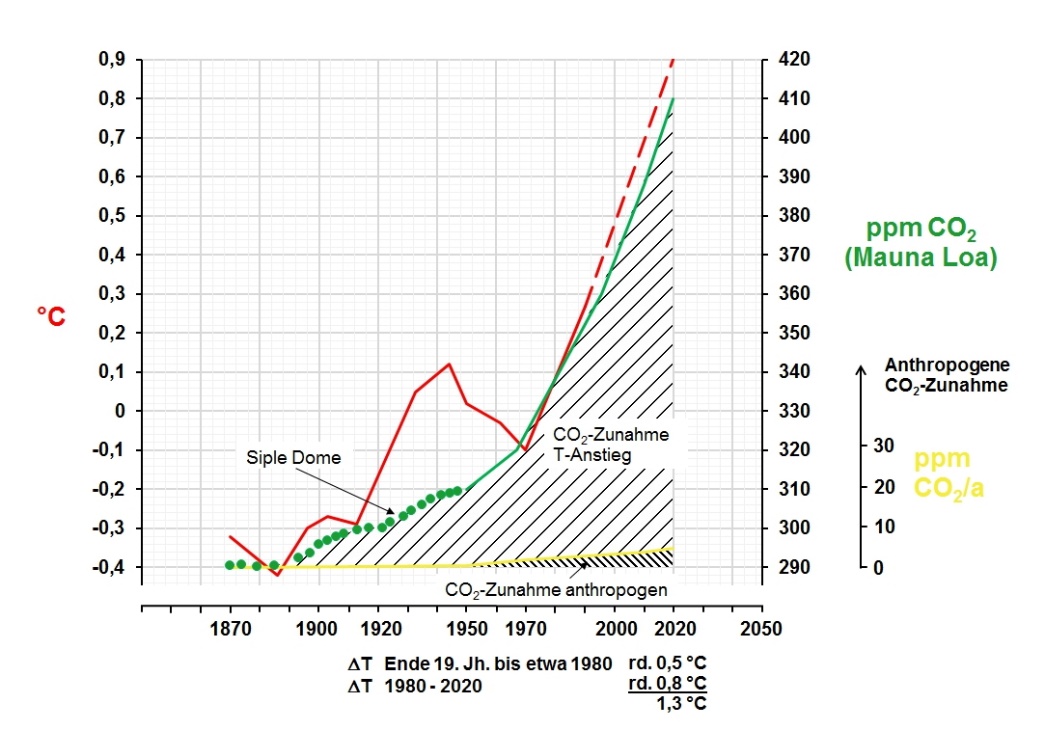

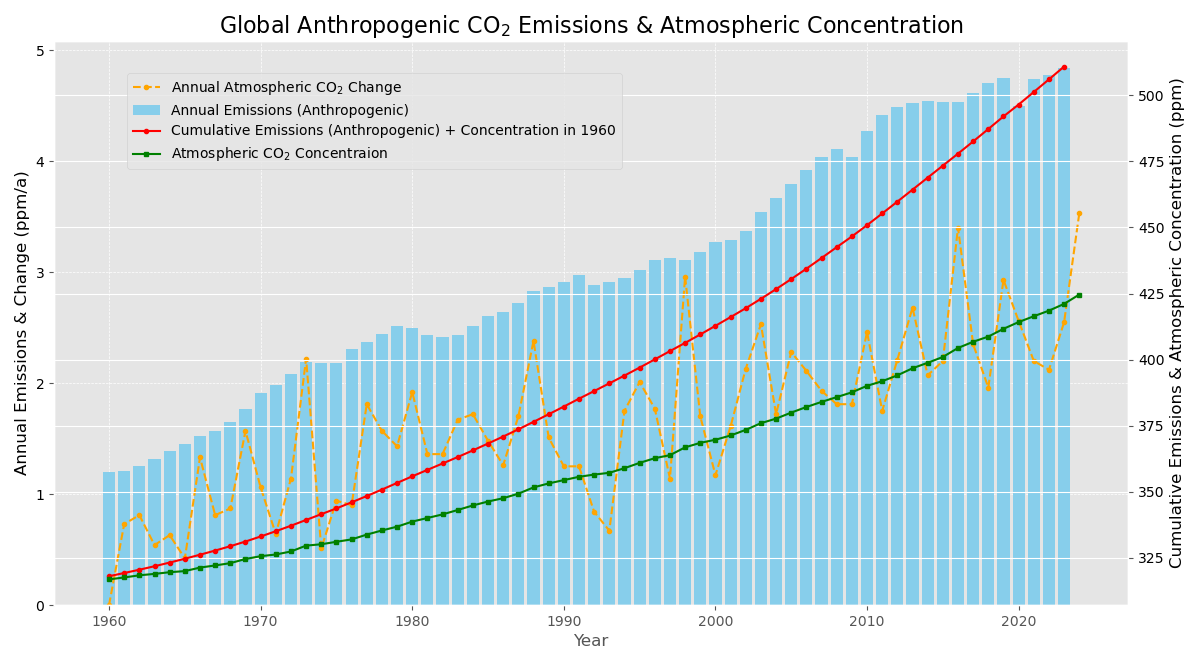

In früheren Arbeiten (4) war der CO2-Zuwachs der Atmosphäre aus dem weltweiten anthropogenen CO2-Eintrag in die Atmosphäre von 1870 bis 2020 mit den gemessenen CO2-Gehalten dargestellt worden (Bild 7), ausgehend von 870 Gt Kohlenstoff in der Atmosphäre (6. Zustandsbericht des IPCC, Fig.5.12).

Bild 7: Anstieg der gemessenen und über die anthropogenen CO2-Emissionen in die

Atmosphäre eingebrachten CO2-Gehalte

Bekanntlich steigen die CO2-Gehalte der Atmosphäre von 1870 bis 2020 um 120 ppm von 290 auf 410 ppm an.

Die in 2020 eingebrachten anthropogenen CO2-Emissionen in die Atmosphäre liegen bei 35 008 Mio. t CO2 (35 Gt CO2). (vgl. Bild 9) Daraus errechnen sich 4,7 ppm CO2 oder 0,000 47%.

Somit gilt: 410 – 290 – 4,7 = rd. 115 ppm, die auf natürliche CO2-Quellen zurückzuführen sind. (CO2-Löslichkeit Meere, Vulkane, etc.)

Damit liegt der CO2-Anstieg über natürliche Quellen bei 96%, über den anthropogenen Anteil bei 4%.

Aus Bild 7 wird weiter deutlich, dass vor 1950 der CO2-Anstieg der Atmosphäre ausschließlich über den CO2-Eintrag über natürliche Quellen erfolgte. Ein merklicher Anstieg über anthropogenen CO2-Emissionen erfolgt erst nach 1950 bis auf 4,7 ppm in 2020 – oder durchschnittlich 4,7 ppm/70 Jahre = 0,07 ppm/a und nicht 2 ppm/a nach Aussage des IPCC (siehe Einleitung, vgl. auch Kap.5).

Wenn das IPCC den Temperaturanstieg durch Abbau der anthropogenen CO2-Emissionen auf null setzen will, so kann sich diese Maßnahme nur in einer Verminderung der CO2-Gehalte der Atmosphäre in der Größenordnung von 4,7 ppm CO2 äußern, was wiederum bedeutet, dass eine messbare Temperaturabnahme über Wunschdenken nicht hinaus kommt.

5. Stagnation der weltweiten anthropogenen CO2-Emissionen bis 2024 durch die weltweiten Maßnahmen zu ihrer Absenkung sowie ihre Wirkung auf die CO2-Gehalte der Atmosphäre

Die Bemühungen der verschiedenen Länder zur Absenkung der CO2-Emissionen sind unterschiedlich.

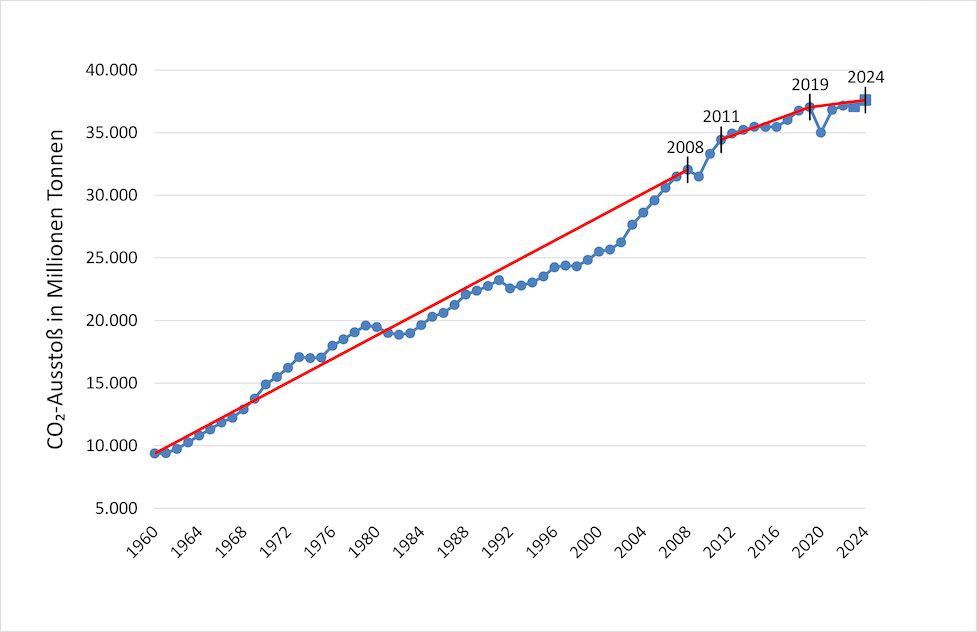

In Bild 8 sind die weltweiten anthropogenen CO2-Emissionen aller Länder zusammengefasst.

Die Werte bis 2022 basieren auf Angaben von „Statista“, die Werte für 2023 und 2024 wurden aus den Angaben von „International Energy Agency“ (IEA) und „wissenschaft.de“ entnommen und zu 37,1 Gt CO2 (2023) und 37,6 Gt CO2 (2024) gemittelt (in Bild 8 gekennzeichnet mit Vierecken).

Bild 8: Entwicklung der anthropogenen CO2-Emissionen von 1960 bis 2024

Die Entwicklung der weltweiten anthropogenen CO2-Emissionen zeigt von 1960 bis 2024 eine starke Abflachung.

Die Entwicklung der Abflachung lässt sich mathematisch wie folgt definieren:

1960- 2008: 478 Mio. t CO2/a; 2011- 2019: 325 Mio. t CO2/a; 2019- 2024: 112 Mio. t CO2/a.

Das Jahr 2009 wurde nicht in die Auswertung einbezogen, weil das Jahr als das Jahr des konjunkturellen Tiefganges bezeichnet wird, sichtbar an dem Einbruch der jährlichen CO2-Emissionen.

Auch das Corona-Jahr 2020 wurde nicht einbezogen, da bedingt durch Corona die Weltwirtschaft zurückgefahren werden musste.

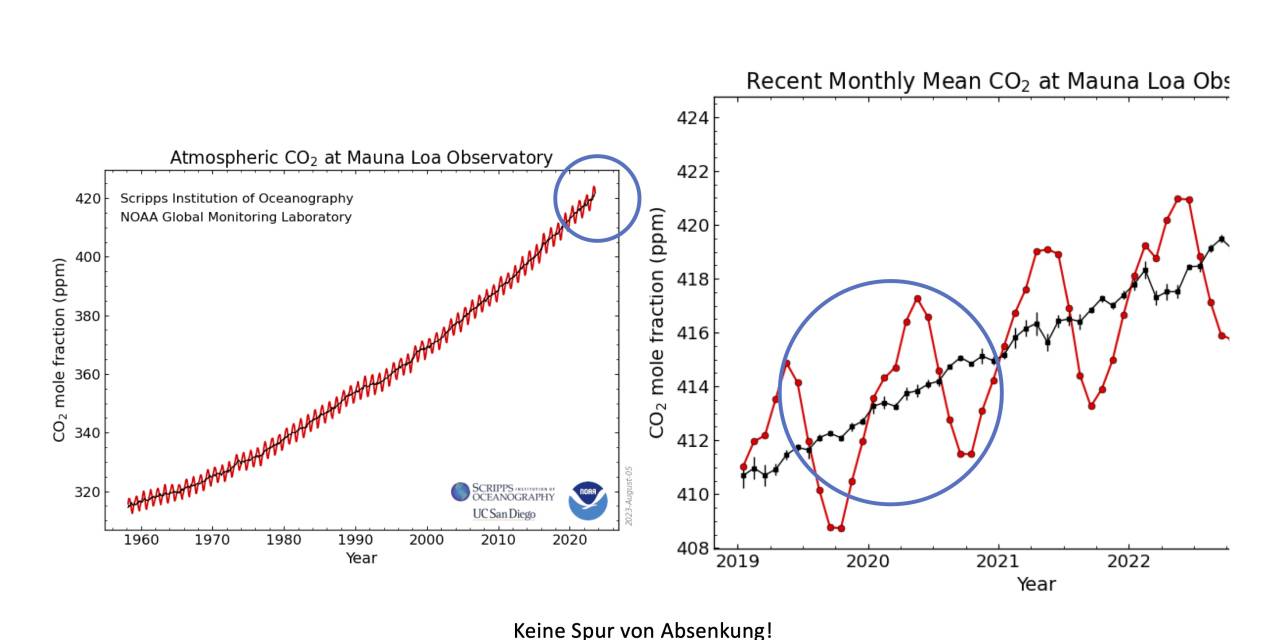

Die weltweiten CO2-Emissionen lagen 2019 bei 37 040 Mio. t CO2/a, im Corona-Jahr 2020 bei 35 008 Mio.t CO2/a (Statista), entsprechend einer Absenkung von 5,5% – eine Abnahme der CO2-Gehalte der Atmosphäre konnte jedoch nicht gefunden werden.

Aus der Abflachung des Eintrages der anthropogenen CO2-Emissionen kann zunächst abgeleitet werden, dass das Bestreben der Weltgemeinschaft zur Absenkung des C02-Anstieges bisher deutliche Früchte trägt.

Wenn nun aber nach Bild 8 der Anstieg der weltweiten CO2-Emissionen bis 2024 gegen null geht, müsste dann nach der Vorstellung des IPCC der Anstieg des CO2-Gehaltes der Atmosphäre auch gegen null gehen (Bild 9) einschließlich einer Abnahme der Temperatur.

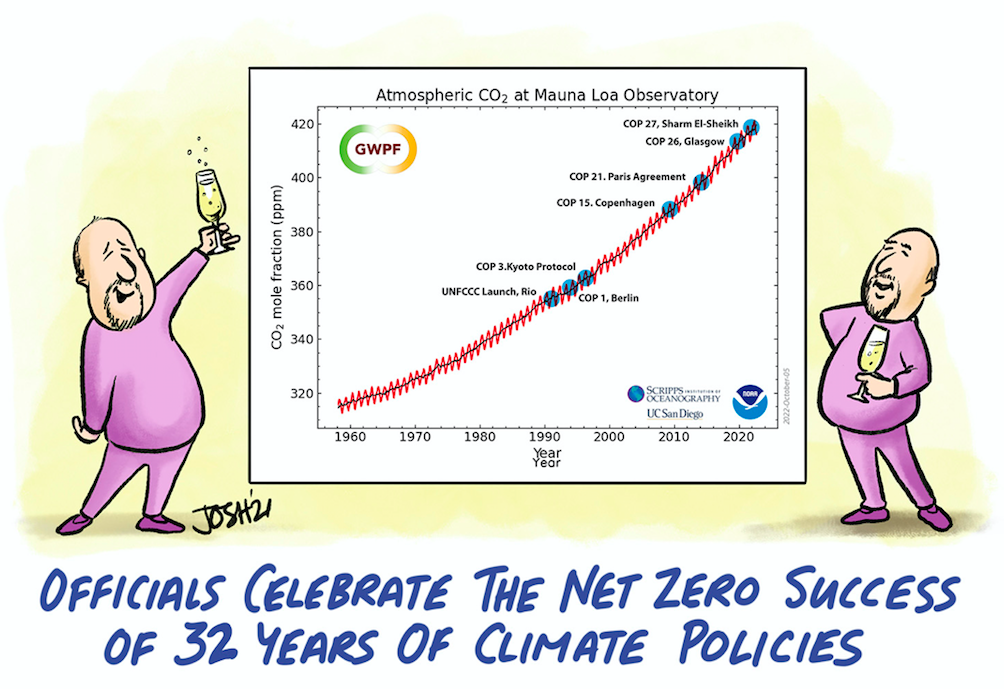

Bild 9: Entwicklung der CO2-Gehalte der Atmosphäre sowie die hoffnungslosen Versuche zu ihrer Absenkung

Bild 9 zeigt aber zunächst, dass die praktisch gegen null verlaufenden weltweiten, anthropogenen CO2-Emissionen auch nicht den geringsten Einfluss auf einen zu erwartenden Abfall der CO2-Gehalte der Atmosphäre ausüben (vgl. auch Corona-Jahr) – im Gegenteil: die CO2-Gehalte steigen nach 2000 sogar verstärkt an.

Außerdem wird der hoffnungslose Versuch einer Absenkung der CO2-Gehalte der Atmosphäre durch diverse Tagungen und dort beschlossene Maßnahmen sichtbar. Aber bei den niedrigen anthropogegen CO2-Emissionen von 4% kann eine Abnahme des CO2-Gehaltes der Atmosphäre auch nicht erwartet werden (vgl. Kapitel 4)

Nach den Vorstellungen des IPCC steigt der CO2-Gehalt der Atmosphäre über die jährlich eingebrachten CO2-Emissionen um 2 ppm an. (vgl. „Einleitung“)

Das entspräche einem CO2-Eintrag in die Atmosphäre von 2 ppm CO2/a oder 15,5 Gt CO2/a.

In den Jahren 2019 bis 2024 stiegen nach Bild 8 die anthropogenen CO2-Emissionen jedoch nur um 0,112 Gt CO2/a an oder 0,112 Gt CO2/7,75 = 0,014 ppm/a und nicht 2 ppm/a nach Aussage des IPCC:

Wird zudem berücksichtigt, dass Deutschland an den weltweiten CO2-Emissionen mit weniger als 2% beteiligt ist, so errechnet sich ein geradezu skurriler deutscher Anteil von 0,014 ppm/a x 0,02 = 0,000 28 ppm/a oder 0.000 000 028%/a– natürlich nicht messbar.

Bei diesem abbaubaren deutschen CO2-Anteil aus der Atmosphäre ist die Vorstellung der Regierung geradezu absurd, dass der „Kern des Klimaschutzes aus der Bepreisung von Treibhausgasen bestehen“ soll. Das Sondervermögen für Klimaschutz ist sinnvoller zu nutzten.

6. Welches sind die Quellen und Senken für die CO2-Gehaltes der Atmosphäre

In Kapitel 4 war aufgezeigt worden, dass der CO2-Anstieg der Atmosphäre in 2020 nur zu 4% (4,7 ppm) über anthropogene CO2-Emissionen erfolgt, 96% (115 ppm) über natürliche Quellen.

Neben den anthropogenen CO2-Quellen aus der Verbrennung von fossilen Brennstoffen, Abholzung, Landwirtschaft, Zementproduktion gehören zu den natürlichen Quellen die Ausgasung der Meere bei Erwärmung, Vulkanausbrüche, Atmung Lebewesen und die Zersetzung organischer Stoffe.

Zu den CO2-Senken werden im Wesentlichen Pflanzen und Wälder, humusreiche Böden, Gesteinsverwitterung und technologische Senken gezählt (vgl. später).

Ozean als CO2-Quelle

Ozeane enthalten 40mal so viel CO2 wie die Atmosphäre.

In der Vergangenheit wurden die Ozeane zu CO2-Senken erklärt, obwohl durch die Temperaturerhöhungen der Atmosphäre inzwischen auch die Meere erwärmt wurden und große CO2-Mengen freigeben. (CO2-Löslichkeit von CO2 in Wasser fällt mit steigender Temperatur)

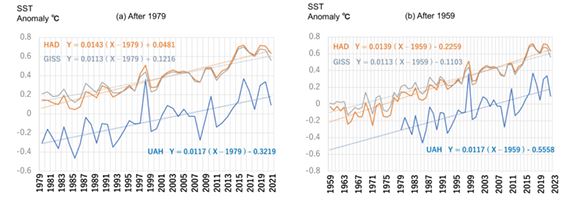

In einer Untersuchung des „Science of Climate Change“ (5) waren anhand von multiplen linearen Regressionsanalysen die Einflussgrößen auf den Anstieg der Meerestemperaturen SST (sea surface temperature) untersucht worden (vgl. auch (6)).

Sowohl auf der Basis der UAH-, HAD- wie GISS-Daten konnten enge Verknüpfungen der SST mit den CO2-Daten gefunden werden. (Bild 10)

Bild 10: Anstieg der Meerestemperaturen

In Bild 10 beinhalten die Jahreszahlen auf der X-Achse die jeweiligen CO2-Gehalte der Atmosphäre.

Der Anstieg der Meerestemperaturen von 1979 bis 2021 auf der Basis von Satellitenmessungen liegt bei etwa 0,5 °C (Bild 10 ((a) After 1979), was einem CO2-Anstieg in der Atmosphäre von 335 auf 415 ppm entspricht. (Bild 9)

Ebenfalls in Bild 10 ((b) After 1959) sind die Messergebnisse für den Zeitraum 1959 bis 2023 dargestellt mit einem Temperaturanstieg von etwa 0,8 °C und einem CO2-Anstieg nach Bild 9 von 315 auf 420 ppm.

Die CO2-Löslichkeit in Wasser nimmt mit steigender Temperatur deutlich ab: bei 15 °C liegt die Löslichkeit bei 1,97 g CO2/kg H20/bar, bei 20°C bei 1,67.

Wird von einem Temperaturanstieg der Meere im Temperaturbereich von 15-20°C ausgegangen,

so fällt die CO2-Löslichkeit von 1,97 (15°) auf 1,67 (20°) g CO2/kg H2O oder 0,048 g CO2/kg H2O je 0,8 °C ab.

Wird bei einer Wasseroberfläche der Meere mit 360 570 000 km2 eine Reaktionstiefe von 500 m und eine Temperaturerhöhung von 15 auf 15,8°C angesetzt, so könnte eine CO2-Menge bei einem Betrachtungszeitraum von 64 Jahren (1959-2023) 8 650 Gt CO2 aus dem Meer freigesetzt werden. (oder 4325 Gt CO2 bei 250 m)

Die Atmosphäre enthält etwa 3300 Gt CO2.

Neuere Untersuchungen zeigen im Übrigen im Vergleich zu Messungen an Eisbohrkernen deutlich schnellere Ansprechzeiten der CO2-Gehalte der Meere bei Temperaturerhöhungen im Bereich von wenigen Monaten. (7)

Hinzu kommt noch die nicht unerhebliche Verdunstung von Wasser an Land bei steigenden Temperaturen, was hier nicht berücksichtigt wird.

Vulkane als CO2-Quelle

Kürzlich wurde berichtet: 19 000 neue Unterwasser-Vulkane entdeckt. (8)

Eine Studie der Universität von Manchester zeigt, dass vulkanische CO2-Emissionen dreimal höher sein könnten als bisher angenommen. In einer 2.Studie der School of Ozeans and Earth Science and Technology (SOEST) geht es um 19 325 neu entdeckte unterseeische Vulkane. Damit erhöht sich die Gesamtzahl auf 43 000.

Bisher sind nur ¼ des Meeresbodens mit Sonar kartiert worden, d.h. die meisten dieser Unterwasserriesen sind noch unerforscht.

Die Strömungen um die untermeerischen Berge erzeugen „Wirbelschleppen“, die kohlenstoffreiches Tiefwasser an die Oberfläche ziehen.

Im Januar 2022 brach der Unterwasservulkan Hunga Tonga aus und erzeugte gewaltige Wasserdampf – Mengen – etwa 50 Mio. t bis in die Stratosphäre.

Dieser Anstieg der Feuchtigkeit in der Stratosphäre um etwa 10-30% hat zu einer Erwärmung der Erdoberfläche 2023-2024 erheblich beigetragen. (9)

Waldbrände als CO2-Quelle

Laut Phys.org wurden in 2021 durch Waldbrände 1,8 Mrd. t CO2 in die Atmosphäre freigesetzt.

CO2-Senken

Die Erde wird grüner, erhöhte CO2-Gehalte der Atmosphäre sind dafür verantwortlich. Chinesische Wissenschaftler stellten fest, dass 55% der globalen Landmasse eine „beschleunigte Wachstumsrate“ der Vegetation aufweisen bei gleichzeitiger Verringerung der Wüstenbildung. (10)

Technologische Maßnahmen als CO2-Senken

Die neue Regierung will das Gesetz zur Abscheidung und Speicherung von CO2 über das CCS-Verfahren durchbringen (Carbon Capture Storage).

CO2 soll aus der Luft entzogen werden (oder direkt bei der Erzeugung von Produkten – z.B. von Zement), um es unterirdisch zu lagern.

Nachbar- und Überseeländer haben CCS als wirksames Instrument zur angeblichen Klimaneutralität weiterentwickelt: Großbritannien, Norwegen, Liederlande, Schweden.

Weltweit gibt es z.Z. 47 CCS-Anlagen. Forscher schätzen die Kosten für Abscheidung, Transport und Speicherung von CO2 mittelfristig auf 150 bis 250 EURO/t CO2.

Die CO2-Löslichkeit im Meerwasser liegt etwa 40mal höher als die CO2-Gehalte in der Atmosphäre und beide stehen in einem thermodynamischen Gleichgewicht zueinander.

Außerdem bedeutet die Reduzierung der CO2-Gehalte der Atmosphäre über CCS nach dem „Prinzip vom kleinsten Zwang“ ein Entweichen von CO2 aus den Meeren in die Atmosphäre.

Das CCS -Verfahren kann daher nicht zu einem Abbau der CO2-Gehalte der Atmosphäre führen.

7. Schlussbetrachtung

Bei der Überflutung der Nachrichten in den Medien mit zunehmenden Extremwetterlagen, Waldbränden, schmelzenden Gletschern, Rekord- Temperaturen etc. sind die vermehrt aufkommenden Klimaängste in Deutschland nicht überraschend: 68% der Deutschen befürworten die Energiewende.

Hinzu kommen all die Profiteure dieser Energiewende: ein Windrad in Tübingen bringt der Stadtkasse 250 000 EURO ein (Aussage B. Palmer in einer Talk Show bei M. Lanz am 20.07.2025).

Selbst der „Internationale Gerichtshof“ in Den Haag formulierte kürzlich einen klaren juristischen Auftrag an die Staatengemeinschaft zum Klimaschutz. Kommen Staaten dieser Pflicht nicht nach, stelle das nicht nur einen Verstoß gegen das Völkerrecht dar, sondern könne unter Umständen sogar zu Schadenersatzansprüchen führen.

Deutschland folgt diesen Umfrageergebnissen, obwohl Deutschland nur 0,000 28 ppm/a (0,000 000 028%/a) CO2 durch seine Dekarbonisierung aus der Atmosphäre abbauen kann.

Der Nobelpreisträger (Physik) John F. Clauser bezeichnete den CO2-Klimawandel eine „schockjournalistische Pseudowissenschaft“.

Dennoch will Deutschland in 2045 den Strom ausschließlich über Wind, Sonne und Wasserstoff darstellen, obwohl die Stromkosten bereits die höchsten in der Welt sind, die Industrien abwandern, die Insolvenzen bereits heute Rekordzahlen aufweisen.

A. Thess (Universität Stuttgart) ermittelte für die deutsche Energiewende Gesamtkosten von 10 Billionen EURO.

Deutschland muss raus aus den ideologischen Träumereien, deren Stromversorgungsicherheit keineswegs gewährleistet ist. (Es sei an den Stromausfall in Spanien am 28.04.2025 erinnert)

Bei der hohen Sensibilität für gesicherten Strom in Deutschland sowie die erforderliche Absenkung der Kosten können nur Kohle-, Gas-, Kernkraftwerke helfen – eine Verabschiedung von der Skurrilität eines deutschen CO2-Abbaues der Atmosphäre durch die Energiewende von 0,000 28 ppm/a oder 0,000 000 028%/a ist zwingend geboten.

Die Vorstellung der Regierung, dass „der Kern des Klimaschutzes aus der Bepreisung von Treibhausgasen bestehen sollte“, entbehrt damit jeglicher Grundlagen.

8. Quellen

1.https://tinyurl.com/y5nhhfnd

2 Baritz, B., J. Kowatsch: „Frühlingsverlauf Deutschland: ein weiterer Verlauf gegen die These einer starken Treibhausgaserwärmung“; EIKE, 18.06. 2025

3. Fleischmann, B.: „Warum sich das Klima ändert (Kurzfassung)“; Version 30.09.2021

4. Beppler, E.: „Quantifizierung des marginalen anthropogenen CO2-Gehaltes in der Atmosphäre – ein seit Jahren überfälliger Schritt“; EIKE, 16.12.2020

5. https://scienceofclimatechange.org.

6. Eschenbach, W.: „Wassertemperatur-Blues“; EIKE, 10.06.2024

7. Macrae, A., J. D` Aloe: „Die wirkliche Klimakrise ist nicht die globale Erwärmung, sondern die globale Abkühlung und vermischt hat sie bereits begonnen“, EIKE,05.03.2020

8. Watts, A.: „Vulkane emittieren dreimal mehr CO2 als gedacht“, EIKE, 22.05.2025

9. Allen, C.: „Aktualisierung: Neues zum stratosphärischen Wasserdampf“, EIKE, 25.07 2024

10. Sterling Burnett, H.: „Dank des Klimawandels: die Erde wird grüner“, EIKE, 05.03.2020

Seltsame Temperaturverläufe, die bei EIKE veröffentlicht werden beim

.

Oh Mann, das kann doch nicht wahr sein!

Erst stellen sie ein CO2 Messgerät auf einen aktiven Vulkan. Dann kommt die Überschrift: „Vulkane als CO2-Quelle“ und sie betrachten Unterwasservulkane!

Ihr seid echt spaßig!

http://climate4you.com/images/DIFF12%20GlobalCO2%20HadCRUT5%20HadSST4%20Since1958.gif

Solange wie zusätzliches CO2 freigesetzt wird durch die Verbrennung von Öl, Gas und Kohle,

so lange steigt auch der CO2-Gehalt der Atmosphäre steig an.

.

Da steigen auch die weltweiten Temperaturen an, ob Wassertemperatur oder Lufttemperatur, beide steigen.

Herr Kraus, durch zusätzliche Verbrennung steigt der CO2-Gehalt der Atmosphäre nur an solange die Emission größer ist als der Senkenfluss. Und dieser beträgt bei 420 ppm bereits etwa 26,5 GtCO2/a und würde bei Erreichen von harmlosen max. 500 ppm sogar auf den Wert der heutigen Emission ansteigen so dass eine Dekarbonisierung garnicht nötig ist.

Oceans absorbed heat equivalent to seven Hiroshima nuclear explosions every second, expert says

Haben Sie schon einmal versucht Wasser mit einem Föhn zu erwärmen?

Was ist mit der Tatsache dass wenn Wasser, z.b. durch die Sonne erwärmt wird dieses evaporiert, was einen kühlenden Effekt (Wärmetranport) hat? Das bedeutet dass die Luft über dem Wasser kälter als das Wasser ist, auftsteigt und dabei weiter abkühlt.

Die Luft kühlt das Wasser, egal wieviele Hiroshimas man bemüht, es ist Unsinn. CO2 kühlt.

So gesehen erzählen Sie hier ein Märchen.

Auftragsmärchen, oder?

In dem Fall auch keine Ahnung.

Ist das eigentlich ein zulässiges Experiment für zu Hause, mit einem Fön Wasser, zum Beispiel in der Badewanne zu erwärmen?

Ich dachte immer da fallen einem die Solarpanele auf den Kopf.

Ich frage für Herrn Kraus …

Auch hier die Frage. Wenn das:

eine signifikante Rolle spielt, müsste dann der pH-Wert nicht steigen. Es wird aber eine Abnahme des pH-Wertes Beobachtet. Das deutet auf eine Aufnahme von CO2 hin.

Danke für den guten Artikel, CO2 nimmt weiter zu, aber nicht der anthropogene weltweite Ausstoß. Für die Anhänger der CO2-Glaubenskirche sind das keine Argumente, denn der April wurde wärmer und da kann per Glaubensdekret nur der Mensch schuld sein.

Eine Ergänzung zur Grafik 4. Wir hätten ihnen gerne die neueste Grafik bis 2025 überlassen, wir wußten halt nichts von ihrem Artikel. Dazu:

1) Die Steigungsformel nach 1988 hat sich vergrößert. Den Hauptgrund für den T-anstieg seit 1987/88 sehen wir in der Zunahme der Sonnenstunden. Aber wie Sie auch schreiben, gibt es sicher noch viele Gründe, die sich gegenseitig summieren.

2) Da die Sonne nur tagsüber scheint, steigen die Tageshöchsttemperaturen, die Nachttemperaturen gar nicht.

3) Man muss sich also fragen, was hat zum Temperatursprung in Mitteleuropa geführt und was sind die Gründe, dass die Sonnenstunden seit 1988 bis 2025 stetig zunehmen. Bis 1987 haben sie nämlich abgenommen.

Und wo bleibt die Temperaturregelwirkung von CO2. Antwort: Nirgendwo, diese Regelwirkung gibt es nciht, das ist eine Erfindung der Treibhauskirche, die will unser Geld.

Josef Kowatsch 3. September 2025 13:03

Die Sonnenstunden haben zu genommen wegen Änderung der Bewölkung (und Änderung der Zirkulation). Die Änderung der Bewölkung ist eine Folge der Zunahme der CO2-Konzentration.

Es ist doch völlig legitim, die Sonnenscheindauer als unabhängige Ursache in Betracht zu ziehen, nicht alles muss sich auf CO2 zurückführen lassen, auch wenndie Klimawisssenschaft diesen Eindruck erweckt.

Alles auf CO₂ zurückzuführen, ist weder methodisch noch empirisch sauber.

Ja und? Muss es doch auch nicht, Hauptsache es passt zum Narrativ. Ich garantiere Ihnen wenn demnächst die Renten nicht mehr gezahlt werden können liegt das nicht am Versagen der Politiker sondern am CO2. Wir hätten uns halt mehr anstrengen müssen, beim „Klimaschutz“…

Deswegen gibt es auf der Venus keine Wolken bei 950000 ppm CO2 😉

Gerald Pesch 3. September 2025 20:45

„Deswegen gibt es auf der Venus keine Wolken“

Um Polemik zu machen, fantasieren Sie: https://www.astronews.com/news/artikel/2008/12/0812-012.shtml

Sie haben also die logische Konsequenz aus ihren Annahmen nicht verstanden? Herr Pesch hat das eigentlich genau erkannt!

Siehe da.

Herr Ebel, also je mehr CO2 desto weniger Wolken? Hatten Sie nicht mal behauptet dass sich durch THG die Konvektion verstarkt und damit mehr Wolken entstehen? M.W. wird ohne THG die Atmosphäre IR-transparent und damit isotherm. Der Luftdruck erzeugt ja keinen THE und die Sonnenstunden erhöhen sich auch durch verbesserte Luftreinhaltung.

Beides geht nicht oder? Mehr Wolken durch CO2 und weniger Wolken durch CO2?

Peter Dietze 5. September 2025 7:07

Dietze, Sie verwechseln was.Ich hatte geschrieben, das Fortak vor mehr als 50 Jahren vermutet hat, das die Wolken zunehmen. Die weitere Entwicklung hat gezeigt, das Fortaks Vermutung falsch war.

Also weniger Wolken ohne zutun vom CO2?

Sagt wer?

Ich will mal zusammenfassen, was ich so aus der Literatur entnehme:

Günter Heß 3. September 2025 16:37

Aber indirekt – das wußte Fortak schon 1971.

Die anderen Ursachen sind zwar auch, aber deren Einfluß ist gering.

Womit stützen sie diese Behauptung?

Die Untersuchungen und Messungen dazu sind ja erst jüngeren Datums. Das konnte Fortak 1971 wohl kaum berücksichtigt haben. Viele Messungen kannte er ja noch nicht.

Eine der Untersuchung die ich gelesen habe ist von 2022. Die berücksichtigten Daten gehen von 1960 bis 2015. In Fortan 1971 sind also nur höchstens 6 Jahre der Messungen davon drin.

Günter Heß 4. September 2025 11:41

„Womit stützen sie diese Behauptung?“

Ohne Anstieg der CO2-Konzentration waren jahrhundertelang die Temperaturen in einem engen Korridor. Jetzt soll plötzlich ohne Zusammenhang die Wolken sich so verändern?

Auch die Zirkulation veränder sich stark, wenn bei einer Tropopausenhöhe von ca. 10 km sich die Höhe um ca. 1/2 km ändert – und da ist der Zusammenhang direkter gegeben.

Außerdem haben Sie Fortak ( https://erlebte-geschichte.fu-berlin.de/personen/dr-heinz-fortak ) nicht gelesen – er hatte nur einen Teil betrachtet, der ihn dazu führte das es mehr Wolken geben würde.

.Ich glaube, das fragen sich die Naturwissenschaftler unter den Klimaforschern auch – und deshalb wird es sicherlich weiter untersucht. In einem raumzeitlich chaotischen System wie dem Klima ist die eindeutige Zuordnung von Ursachen ohnehin nicht einfach. Klar ist: Die Wolkenbedeckung wird stark durch Aerosole beeinflusst und nicht primär durch CO₂. Klimamodelle nutzen jedoch gerade Wolkenparameter zum Tuning ihrer Klimasensitivität. Damit entsteht ein Zirkelschluss: Änderungen, die real durch Aerosole verursacht sind, werden im Modell indirekt dem CO₂-Effekt zugeschrieben.“

Die Behauptung, Temperatur und Wolken seien jahrhundertelang in einem engen Korridor stabil gewesen, ist nicht belegt. Historische Klimadaten sprechen dagegen: Wir sehen die Mittelalterliche Warmzeit und die Kleine Eiszeit, beide mit deutlichen Temperatur- und Zirkulationsänderungen. Auch Wolken- und Niederschlagsmuster waren davon betroffen. Das Klima war also nie völlig stabil. Deshalb kann man heutige Wolkenänderungen nicht einfach mit einem angeblich konstanten ‚Vorher‘ dem CO2 zuordnen.

Günter Heß 4. September 2025 16:47

Ganz gleich, um welches chaotisches System es sich handelt, es sind immer Gesetzmäßigkeiten vorhanden: z.B. bei den chaotischen Molekülgeschehen die Gasgesetze, bei Radioaktivität die Halbwertszeit.

Dem Trend bei einem chaotischen sind immer Abweichungen überlagert – das ändert aber nichts am Trend, kann aber die Trendbestimmung erschweren.

Abweichungen überlagern den Trend, ändern ihn aber nicht“ gilt dann nur für den direkten Strahlungsantrieb ohne Feedbacks, oder?

Sobald Rückkopplungen und Attraktorwechsel ins Spiel kommen (z. B. Wolken, Eis, etc), ist diese Aussage zu schlicht

Ein langer Trend erhöht die Plausibilität, dass ein Mechanismus wirkt, beweist aber weder seine Dauerhaftigkeit noch eine einzige Ursache.

.

Günter Heß 5. September 2025 11:06

Ihnen sollte zu denken geben, daß die Zunahme der Sonnenstunden genau parallel zum Anstieg der CO2-Konzentration ist.

Damit hätte man nur bewiesen was schon lange bekannt ist und auch anerkannt ist: Eine Korrelation zwischen Temperatur und CO2-Konzentration. Aber nicht die Kausalität!

Roland Fuchs 5. September 2025 17:44

Das die Korrelation kein Zufall ist, folgt aus den physikalischen Zusammenhängen – das wußte Fortak schon vor über 50 Jahren:

Das er von den physikalischen Zusammenhängen nur einen besonders einfachen genannt hat, ist eben nur ein Auszug.

Ich weiss nicht worauf die Antwort abzielt.

Es ging mir um „Korrelation“ vs. „Kausalität“ von Temperatur und CO2-Gehalt, alleine dass CO2 ein IR-Absorber ist, ergibt keine Kausalität zwischen Temperatur und CO2-Gehalt.

Wenn angesetzt ist, dass die zunehmenden Sonnenstunden für eine höhere Temperatur sorgen (das lässt sich empirisch nachweisen, gehen Sie einfach nach draussen) und da bekannt ist (Eisbohrkerne) dass der CO2-Gehalt der Temperatur folgt (empirisch gemessen und irgendwie von allen anerkannt aber trotzdem soll es „heute anders“ sein), ist die Korrelation zwischen den drei Faktoren hergestellt und um den Faktor Zeit erweitert, ergibt das zusammengefasst: Weil es wärmer wird steigt der CO2-Gehalt, nichts anderes.

Roland Fuchs 7. September 2025 13:24

Da Sie offensichtlich den Treibhauseffekt nicht verstehen, schreiben Sie solchen Unsinn. Wenn zuerst die Temperatur steigt, erfolgt eine Ausgasung, die den Treibhauseffekt verstärkt. Steigt zuerst die CO2-Konzentration, dann folgt die Temperatur.

Nennt man da Korrelation? Wie ist der physikalische Zusammenhang?

Ich frage, weil es soll so eine Wasserdampf Rückkopplung geben….

Aber Herr Ebel, ganz ohne CO2 (bzw. THG) hátten wir doch eine transparente und isotherme Atmosphäre ohne Konvektion und Wolken. Sie behaupten schon wieder das Gegenteil.

Peter Dietze 5. September 2025 18:39

Wo glauben Sie gelesen zu haben, daß ich den Unsinn (Gegenteil) behauptet habe?

Herr Ebel, je mehr CO2 desto mehr Feuchtkonvektion, Erhöhung der Tropopause und gradientenbedingte Bodenerwärmung – behaupten Sie. Ich sage, Feuchtkonvektion KÜHLT den Boden, und da das stimmt, betreiben Sie schon wieder Desinformation. Das gipfelt darin dass ich den THE nicht verstanden haben soll, obwohl ich doch die IR-Absorption aus HITRAN (wo die Tropopausenhöhe irrelevant ist) sowie die Änderung der Gegenstrahlung am Boden (0,6 Grad mit S-B pro ppm-Verdoppelung) konform mit CLINTEL, MODTRAN und Harde berechnet habe.

Peter Dietze 10. September 2025 11:44

„Feuchtkonvektion KÜHLT den Boden“

Ich würde nicht sagen „KÜHLT den Boden“, aber ich hatte Ihnen ja schon den größeren Wert des Treibhauseffektes ohne Konvektion vorgerechnet – aber der Wert fand keine Gnade vor Ihren Augen – aber jetzt schreiben Sie selbst, das ohne Feuchtkonvektion die Oberflächentemperatur höher wäre.

Das sind die 3 Stufen: mit Feuchtkonvektion (jetzt real), trockenadiabatische Konvektion, gar keine Konvektion.

Noch eine Ergänzung:

1. Primärquelle für die Bruttoflüsse (Schlüsselveröffentlichung)Titel: The Global Carbon Budget 1959–2011

Autoren: C. Le Quéré et al. (2012)

Journal: Earth System Science Data

Link: https://essd.copernicus.org/articles/4/11/2012/

2. Aktuelle und laufende UpdatesDie zentrale Quelle für die aktuellsten Zahlen (einschließlich der Netto-Aufnahme von ~2.5 Gt C/Jahr) ist das jährlich aktualisierte Global Carbon Budget:

Projekt: Global Carbon Project

Webseite: https://www.globalcarbonproject.org/carbonbudget/

Aktuelle Publikation: Die neueste Version erscheint jährlich in der Zeitschrift Earth System Science Data.

3. Weitere wichtige LiteraturquellenTitel: The oceanic sink for anthropogenic CO2

Autoren: C. Sabine et al. (2004)

Journal: Science

Link: https://www.science.org/doi/10.1126/science.1097403

Titel: Gas Exchange Rates

Autoren: Liss, P. S., & Slater, P. G. (1974)

Journal: Nature

Link: https://www.nature.com/articles/247181a0

Titel: Relationship between wind speed and gas exchange over the ocean

Autoren: Wanninkhof, R. (1992)

Journal: Journal of Geophysical Research

Link: https://agupubs.onlinelibrary.wiley.com/doi/abs/10.1029/92JC00188

Zusammenfassung der Quelle:Die Zahl ~90 Gt C/Jahr für die Bruttoflüsse ist ein gut etablierter, modellierter Wert aus der Synthesearbeit des Global Carbon Project (speziell Le Quéré et al., 2012). Sie wird verwendet, um die Dynamik des Kohlenstoffkreislaufs zu veranschaulichen, bei dem der kleine Nettofluss von ~2.5 Gt C/Jahr die Differenz dieser zwei großen, gegenläufigen Ströme ist.

Für detaillierte und aktuelle Zahlen ist die Webseite des Global Carbon Project die beste Anlaufstelle.

Unsinn. Gravitation sorgt für einen mit der Höhe abnehmenden Luftdruck, der wiederum trotz Volumenzunahme zur Temperaturabnahme führt (p*V=n*R*T). Also keine isotherme Atmosphäre möglich. Daran ändern auch Konvektion und Wolken nichts.

Zudem ist CO2 nicht das einzige IR-aktive Spurengas in der Erdatmosphäre. Der Elephant im Raum ist das Wasser in der Erdatmosphäre! Also keine transparente Erdatmosphäre möglich, wenn man vom atmosphärischem IR-Fenster (7um..13um) absieht.

Herr Vetter, eine transparente Atmosphäre erzeugt KEINE BODENERWÄRMUNG und muss isotherm sein. Wenn der Luftdruck Gradienten-Wärme erzeugen würde (wie auch Dr. Nikolov annimmt) wüde er mehr abstrahlen als er von der Sonne absorbiert und man könnte ja durch Gravitation Strom erzeugen.

Hans J. Vetter 10. September 2025 10:04

.. ist das, was Sie schreiben. Die Gasgleichung (p*V=n*R*T) geben Sie richtig wieder. Die Temperatur T kann druckabhängig sein [T(p)], damit kann die Gasgleichung auch geschrieben werden:

p*V=n*R*T(p). Umgestellt wird daraus:

V/n = R*T(p)/p

und selbst wenn man konstante Molekülmengen betrachtet (n = konst) ist das V entsprechend groß:

V = n*R*T(p)/p

Die Gasgleichung ist also für beliebige Werte von T und p erfüllt. Für maximale Entropie muß T(p) konstant sein, allerdings dauert wegen der geringen Wärmeleitfähigkeit der Luft das Erreichen der konstanten Temperatur recht lange. Wenn allerdings der Temperaturgradient den adiabatischen Wert überschreitet, kommt es zur Strömung, bis der Temperaturgradient unteradiabatisch ist (Schwarzschild 1906).

Ja. Deshalb hatte ich geschrieben:

Er kann konsistent mit CO2-getriebenem Forcing sein, aber genauso gut durch interne Variabilität oder Aerosoländerungen erklärt werden oder auch eine Überlagerung der verschiedenen Ursachen sein.

Mein Star ist der Folgende:

Von den 1950er- bis 1980er-Jahren nahm die Sonnenscheindauer weltweit ab, das sogenannte Global Dimming. Seit den späten 1980ern/1990ern zeigt sich ein Global Brightening, vor allem durch den Rückgang der Aerosole infolge von Luftreinhaltemaßnahmen. CO₂ spielt für diesen Wechsel keine direkte Rolle, der Trend der Sonnenscheindauer folgt den Aerosolen, nicht dem Treibhausgas CO2.

Anbei noch die Daten einer der ältesten Datensätze aus Stockholm das ich in der Fachliteratur gefunden habe.

Stand

Herr Ebel,

Du hast ganz schön aus dem Fenster gelegt.

Guter Anfang!

Abbildung 6, welche die Klimamodelle widerlegen soll, ist untauglich. Verglichen werden hier CIMP-Datensätze, welche sich auf die Oberflächentemperaturen beziehen mit beispielsweise Ballondaten. Klar, dass diese unter den Oberflächendaten liegen.

Herr Freitag, es geht nicht darum, ob die Ballondaten wegen der Abkühlung in der Höhe auch tiefer sind, es geht um die Steigung und diese ist bei den Ballondaten wesentlich geringer als bei den Bodendaten.

Das Bild 6 ist nicht zu retten. Täglich steigen vielleicht 100000 Wetterballons auf, in Deutschland allein 15000, die in verschiedensten Höhen bis zu 30km Temperaturen messen. Es ist absurd zu erwarten, dass die Steigungen der Temperaturkurven in verschiedenen Höhen gleich sind.

Täglich 15000 Wetterballons? Das allein wäre schon ein Umweltfrevel ohne Ende.

Sind diese Zahlen belegt?

War wohl eher Montag bei ihnen!

Danke für den Hinweis mit Bitte um Nachsicht. Es war jährlich (statt täglich) gemeint. Die Zahlen und Variationen davon findet man an vielen Stellen im Internet, auch bei KI. „Amtliche“ Zahlen habe ich nicht gefunden, gehe aber davon aus, dass die Größenordnung stimmt. Die Zahl 100000 jährlich ist unterschätzt. Hierzu ein Artikel von Orf.

Flugobjekte wie Ballons fliegen in einer Höhe von bis zu 36 Kilometern, also in der Stratosphäre. Besonders häufig handelt es sich dabei um Wetterballons. Laut US-Wetterdienst wird im Schnitt zweimal täglich von 900 Standorten weltweit ein Wetterballon gestartet, das entspricht mehr als 600.000 jährlich.

Naja, die Anzahl hat ja nichts damit zu tun wo sie fliegen. Warum ist das eigentlich wichtig das diese Ballons eventuell in 36 km noch fliegen?

Die Graphik 6 hat nichts damit zu tun, oder?

Sie wäre dann aber genau so untauglich wie alle diesbezüglichen Abbildungen aus dem IPCC-Sachstandsbericht. Deklariert als „Anthropogenic global CO2 emissions“ erfolgt die Wertangabe als „Pg C/y“, was zwei völlig verschiedene Paar Schuhe sind, den reines C = Kohlenstoff kann nur über einen einzigen Weg in die Atmosphäre gelangen, nämlich über Aerosole, Ruß im wesentlichen aus unvollständiger Verbrennung. Und das hat mit Atmosphärischem CO2 rein garnichts gemein, ist allenfalls ein Faktor zur Abkühlung, weil es die Wolkenbildung fördert. Diese krude Verfahrensweise stößt mir bei vielen solcher Publikationen auf, weil sie schlicht und einfach falsch ist, was natürlich nicht gerade die Glaubwürdigkeit solcher Arbeiten steigert. Kohlenstoff zu CO2 bedingt den Faktor X 3,6. 🙁

Wurde auch im Artikel genannt. Kann auch an sowas liegen.

Allmählich gewinnt man den Eindruck dass bei EIKE eine Affinität zu falschen Klimamodellen herrscht. Uli Weber kam 60mal mit der falschen Anwendung von S-B und ohne Gegenstrahlung mit dem Hemisphärenmodell, dann hatten wir den Physiker Dr.Nikolov, der den THE am Boden (abgesehen von der Sonnenstrahlung) durch den Luftdruck erklärt, und nun haben wir – bereits mehrfach – Dr. Beppler, der unbelehrbar und grob falsch davon ausgeht dass unser emittiertes CO2 in nur einem Jahr (!!!) verschwindet und der ppm-Anstieg garnicht von der Emission, sondern nur von dem jährlichem Zuwachs bestimmt wird.

Mit dem Badewannenmodell von Prof. Ganteför und dem „Plan B“ (Halbierung unserer Emission um etwa auf den heutigen ppm–Wert zu stabilisieren, was ja auch Prof. Vahrenholt vorschlägt) hat er sich offenbar nicht befasst. Da bei konstanter heutiger Emission sein ppm nicht weiter ansteigt, könnten wir uns doch jegliche Dekarbonisierung und somit auch die von Prof. Thess abgeschätzten Kosten von 10 Billionen € für die Energiewende einfach sparen. TOLL!!

Da hat korrekte Klimamodellierung kaum Chancen. Für Herrn Pesch gibt es als Sahnehäubchen „keine physikalisch plausible Begründung für eine Klimaerwärmung durch ir-anregbare Spurengase“. Und Prof. Puschner (bekannt als besserwissender Nichtfachmann sowie durch seine Mittelwert-Allergie) erhebt sich über Dietze und alle anderen Modellierer mit der Aussage dass „Modellierungen eines chaotischen Systems zwangsläufig zu fehlerhaften Ergebnissen führen“. Da erinnere ich z.B. an den chaotischen Würfel, der doch bei zahllosen Würfen im Mittel 3,5 macht und weise darauf hin dass Strahlung und CO2 sich auf der Erde NICHT chaotisch, sondern ziemlich korrekt gemäß Physik, Mathe und Chemie verhalten, und daher als Grundlage für die Klima- und Energiepolitik eine korrekte Modellierung erforderlich ist.

Das grob falsche Kumulationsmodell des IPCC, welches Basis für das BVG-Urteil und unseren fatalen Weg zu NetZero ist, basiert im Gegensatz zu früheren Rechnungen nicht auf einer CO2-Halbwertszeit von etwa 570•ln(2)=395 a, sondern (abgesehen von einem deutlich zu geringen prozentual festen Senkenfluß) eher auf 35.000 a obwohl der korrekte Wert nur etwa 38 a beträgt.

Herr Dietze,

Bereits zu Ihrem Beitrag vom 1.September,9.26 Uhr, hatte ich darauf verwiesen, dass meine Aussagen Messergebnisse darstellen und nicht auf Modell-haften Vorstellungen und Aussagen beruhen.

In meinen Bildern 7 und 8 sind schlicht und einfach die gemessenen Anstiege der CO2-Gehalte über die Zeit und die Entwicklung der anthropogenen CO2-Emissionen über die Zeit aufgetragen – nicht mehr und nicht weniger.

Daraus kann jeder seine Schlüsse ziehen.

Wenn Sie mitteilen, dass „ich unbelehrbar und grob falsch davon ausgehe, dass unser emittiertes CO2 in nur einem Jahr verschwindet und der ppm-Anstieg gar nicht von der Emission, sondern nur von dem jährlichen Zuwachs bestimmt wird“, dann ist das Ihre Aussage zu Messergebnissen.

Normalerweise basieren Modellbetrachtungen auf Messergebnissen und nicht umgekehrt.

Ich weiß nicht, auf welchen Messergebnissen Ihre Aussagen fußen. Es macht mich aber stutzig, dass Ihre Vorstellungen offensichtlich nicht zu den von mir dargestellten Messergebnissen passen.

Herr Dr. Beppler, ich wiederhole dass Sie Ihre „Stoffbilanzen“ fälschlich (und unbelehrbar) nicht aus Emission minus Senkenfluss nehmen, sondern nur vom EmissionsANSTIEG (!), und das ist grottenfalsch: „In den Jahren 2019 bis 2024 stiegen nach Bild 8 die anthropogenen CO2-Emissionen jedoch nur um 0,112 Gt CO2/a an oder 0,112 Gt CO2/7,75 = 0,014 ppm/a und nicht 2 ppm/a nach Aussage des IPCC“.

Sie haben sich da völlig verrannt, denn Sie müssen nicht den ANSTIEG der Emission betrachten sondern die EMISSION, und die ist gut 41 GtCO2/a, wovon nach Abzug des zu ppm-280 proportionalen Senkenflusses die von IPCC genannten +2 ppm übrig bleiben. Ihr Problem ist dass Sie – im Gegensatz zu mir – kein realistisches C-Modell entwickelt und mit Szenarien sowie Meßwertverläufen durchgerecht haben (siehe http://www.fachinfo.eu/dietze2020.pdf).

Herr Dietze, wenn der Anstieg der weltweiten anthropogenen CO2-Emissionen gegen null geht, dann muss nach der Vorstellung des IPCC der CO2-Gehalt der Atmosphäre zurückgehen – und das ist nicht der Fall.

Dem ist nichts hinzuzufügen und damit die Diskussion für mich beendet.

Dr. Erhard Beppler 3. September 2025 11:39

„damit die Diskussion für mich beendet.“

Die Beendigung ist kein Wunder – bei dem vielen Unsinn, den Sie geschrieben haben.

„dann muss nach der Vorstellung des IPCC der CO2-Gehalt der Atmosphäre zurückgehen – und das ist nicht der Fall.“

Wenn Sie aus Unkenntnis dem IPCC etwas unterstellen, das nicht zutrifft, wird das nicht wahrer.

Wenn die „anthropogenen CO2-Emissionen gegen null gehen“ wird zwar langfristig die Konzentration auf den natürlichen Wert zurück gehen – aber das in Tausenden von Jahren.

Herr Ebel, die 1/e-Zeitkonstante für den Rückgang auf 280 ppm ist 55 Jahre.

Peter Dietze 3. September 2025 15:19

„ist 55 Jahre.“

Woher haben Sie diese unbrauchbare Zahl?

Herr Ebel, Sie als Physiker haben in Sachen C-Modellierung leider keine Ahnung und blamieren sich schändlich, denn Sie haben noch nicht verstanden dass tau=55 a eine Naturkonstante ist und bisher mehrfach von verschiedenen Wissenschaftlern ermittelt wurde. Sie könnten ebensogut behaupten, die Lichtgeschwindigkei sei eine unbrauchbare Zahl.

Die einfachste Bestimmung von tau=55 a erfolgt durch den anthropogenen CO2-Inhalt der Atmosphäre, dividiert durch den Senkenfluss. (140 ppm+33% Zusatzpuffer)•7,78/26,5 ergibt 54,7. Auch Dr. Ahlbeck (Dozent für chemische Verfahrenstechnik an der Abo-Uni in Finnland) hat bereits vor etwa 25 Jahren durch sorgfältige Regressionsanalyse von CDIAC-Daten 55 Jahre bestimmt.

Ich konnte damals diesen Wert aus einer IPCC-Grafik der C-Flüsse (siehe Abbildungen 1 und 2 meiner hier verlinkten Doku dietze2020.pdf) sowie auch durch Nachrechnung der Kurve von Mauna Loa mit dem Emissionsverlauf bestätigen. Dr. Joachim Dengler rechnet m.W. ebenfalls mit etwa 50 a in dem Paper „Improvements and Extension of the Linear Carbon Sink Model“.

Herr Dietze, zu Ihrer tau-Berechnung würde mich interessieren: wie kommen diese 33% Zusatzpuffer zustande, und wie ist die Zahl 26,5 begründet (die zweifellos als GtCO2/a zu interpretieren ist)?

Herr Mechtel, der Senkenfluss ist Emission GtCO2/a minus ∆ppm/a•2,123•3,67 und beträgt derzeit global (bei +140 ppm) etwa 26,5 GtCO2/a. Der (schnelle) Zusatzpuffer von +33% für die Atmosphäre (den Sie nur bei meinem Modell finden) entstand durch Optimierung der Excel-Kurve des berechneten ppm-Anstiegs seit 1840 gemäß dem anthropogenen Emissionsverlauf. Der Zusatz kommt durch Oberflächenwasser und Bodenfeuchte, leiche Biomasse und Schnee zustande, was sonst nicht berücksichtigt wird.

Damit erhöht sich der Inhalt des Atmosphärenpuffers, und mit Division durch den Senkenfluß ergibt sich eine höhere Zeitkonstante. Alle Rechenwerte passen damit noch besser zum beobachteten (geglätteten) ppm-Verlauf, wodurch sich natürlich auch die Qualität der Ergebnisse für zukünftige Szenarien verbessert. Bei der C-Modellierung bleiben Solarstrahlung, Wolkenbedeckung sowie der große natürliche CO2-Kreisfluss konstant (was auch wegen des nur geringen anthropogenen ∆T anzunehmen ist) und dieser wird deshalb gemäß Theorie der Dynamik linearer Systeme ausgeklammert.

Mit anderen Worten ein Herr Dietze Fudgefaktor, basierend auf Kurvenanpassung an die Realitaet, ohne Berucksichtigng von wirklichen Prozessen.

Herr Schulz, wenn Sie mir die korrekte globale CO2-Pufferkapazität von Seen, Flüssen, Ozeanoberflächen, Bodenfeuchte, Schnee und leichter Biomasse nennen, könnten Sie auf die böswillige Diffamierung meiner Berücksichtigung von beobachteten Einflüssen verzichten.

Sie kennen diese Pufferwirkung also nicht und haben diese als Fudgefaktor eingefuegt und jetzt bestaetigen sie das. Warum soll das eine Diffamierung sein, wenn ich sage wie es ist?

Danke für Ihre Antwort, Herr Dietze. Ich muss noch darüber nachdenken, ob Ihre +33% eine ähnliche Rolle spielen wie die nicht-anthropogene Zusatzquelle in meinem linear-quadratischen Ansatz.

Diesen Satz könnte man doch auch so umformulieren: ‚Die 280 ppm sind gesetzt als natürlicher Gleichgewichtswert‘. Hier bin ich allerdings nach wie vor skeptisch.

Herr Mechtel, die +33% stellen eine Vergösserung des Atmosphärenpuffers und des anthropogenen Inventars pro ppm dar. Das ist KEINE Zusatzquelle, sondern verursacht nur eine Änderung der Dynamik, also der ppm-Kurve.

Peter Dietze 4. September 2025 7:57

„dividiert durch den Senkenfluss.“

Dietze, Sie machen einen Zirkelschluß. Aus irgendwelchen Größen berechnen Sie einen Senkenfluss und benutzen dann Ihren Senkenfluss um zu „beweisen“, daß Ihre Ausgangsgröße richtig ist.

Aber selbst, wenn Ihr Senkenfluss richtig wäre, sagt das nichts aus über die Konzentrationsänderung in der Atmosphäre, da Sie nichts über die Ausgasung des Ozeans sagen – und die Änderung der Konzentration hängt vom Zusammenspiel beider ab. Siehe mein Beispiel des konstanten Wasserdampfdruckes als Zusammenspiel zwischen Verdampfung und Rückkehr.

Schliesse mich an!

Herr Ebel, Sie haben leider das C-Modell, welches unter dietze2020.pdf dokumentiert ist, immer noch nicht verstanden. Und dass der von mir berechnete Senkenfluss auf einem Zirkelschuss beruht, ist eine frei erfundene Desinformation. Ebenso wie die angeblich fehlende tropische Ozeanausgasung, welche ja mit der polaren CO2-Aufnahme eine in der Mauna-Loa-Kurve enthalte Netto-Absorption ist.

Herr Ebel, zum Thema Netto-Absorption noch der Hinweis dass bei Anstieg der ppm sich die tropische Ausgasung VERRINGERT und sich die polarnahe Absorption VERGRÖSSERT. Damit steigt die anthropogene Netto-Absorption proportional zu ppm-280 an. Und wieviel das ist, kann anhand der (für tau=55 a optimal approximierten) Mauna-Loa-Kurve ohne Zirkelschluss berechnet werden.

Peter Dietze 5. September 2025 9:40

Sie haben den Austausch bei konstanter Konzentration nicht verstanden.

Also erklären Sie mal wie Sie es verstanden haben und warum meine richtige Modellrechnung falsch ist.

Peter Dietze 5. September 2025 18:47

Das C14-Isotop in der Atmosphäre löst sich in 15 – 20 Jahren zur Hälfte im Ozean, da aber kaum C14 im Ozean ist, kann man das beobachten. Aber anzunehmen, das das was bei C14 gilt, für alle Isotope gilt ist ein Witz. Verstehen Sie das Beispiel mit dem konstanten Dampfdruck trotz Verdunstung und Rückkehr.

Herr Ebel, dass ich annehme, dass das was bei C14 gilt (eine Halbwertszeit von 15-20 a), für alle Isotope gilt, sei ein Witz, ist dumm und unverschämt gelogen. Wie Sie Fig.8 von http://www.john-daly.com/dietze/cmodcalc.htm (2001) entnehmen können, ist die Halbwertszeit von C14 nur 16•ln(2)=11 Jahre und hat aus dort diskutierten Gründen mit der des C12 von 38 Jahren nichts zu tun. Letztere gilt nämlich für die Menge von C12 während erstere nur für die individuell (radioaktiv markierten) C14 gilt.

Peter Dietze 6. September 2025 11:56

Erklären Sie mal den Grund für den angeblichen großen Unterschied zwischen 12CO2 (44) und 14CO2(48)! Zwischen 11 Jahren und 38 Jahren ist der Unterschied gewaltig.

Herr Ebel, der Grund für den großen Unterschied der Halbwertszeiten zwischen 14CO2 und 12CO2 (11 und 38 Jahre) ist der Austausch der Atmosphäre mit den Reservoiren Ozeane und Biomasse. Bei 14CO2 kam es nach einem Eingangsimpuls (Atombombentest) in der Atmosphäre nicht nur zur Konzentrationsabnahme durch den Abfluss sondern es fand zusätzlich eine VERDÜNNUNG statt weil beim Austausch über einige Jahre viele radioaktive Moleküle durch nicht radioaktive aus Ozeanen und Biomasse ersetzt wurden.

Diesen Effekt gibt es bei 12CO2 nicht, weshalb die geringere Halbwertszeit von 14CO2 für 12CO2 und unsere C-Modellierung keine Relevanz hat. Die Zeitkonstante tau=55 a wurde wie gesagt dreifach übereinstimmend ermittelt aus Nachrechnung der Mauna-Loa-Kurve, einem C-Flussbild von IPCC sowie durch Regressionsanalyse von CDIAC-Daten.

Peter Dietze 6. September 2025 16:33

Langsam kommen Sie der Realität näher. Sie erkennen, daß ein Austausch zwischen Atmosphäre und Ozean stattfindet. Warum soll der Austausch nur bei C14 stattfinden, der findet natürlich auch bei C12 stattfindet.

Der Unterschied zwischen C14 und C12 ist der Unterschied im Verhältnis der Konzentrationen. Bei C12 gibt es fast das gleiche Verhältnis der Konzentrationen in Atmosphäre und Ozeanen, da es im Ozean aus Atmosphäre kommt. Bei der Atmosphäre ist durch den Eintrag der Bombenisotope das Verhältnis zunächst ein anderes.

Herr Ebel, es gibt m.E. hinsichtlich Diffusionsfluss keine Differenz der ppm zwischen 14CO2 und 12CO2 da die Moleküle weitestgehend gleich und nur summarisch behandelt werden. Die 14CO2 verschwinden nur mit geringerer Halbwertszeit weil sie verdünnt werden, aber mit derselben Halbwertszeit würden 12CO2 verdünnt werden wenn man sie mit roter Farbe markiert hätte.

Peter Dietze 6. September 2025 23:02

Das ist richtig – aber „verdünnt“ ist falsch, da es statt verdünnt heißen muß „ausgetauscht“ werden.

Solange die Emissionen steigen, hinkt die Konzentration im Ozean der Konzentration in der Atmosphäre ca. 10 Jahre hinterher. Wenn die Emissionen auf 0 gehen, sinkt die Konzentration in der Atmosphäre und die Konzentration im Ozean steigt bis beide Konzentrationen gleich sind.

Dann sinkt die Konzentration nur sehr langsam, weil CO2 nur langsam gebunden wird.

Herr Ebel, was passiert wenn die Emission auf Null geht und z.B. die Atmosphäre 350 ppm hat, sehen Sie am Beispiel in Abb.2 von dietze2020.pdf, Kurve c. Mit einer 1/e-Zeitkonstanten von 55 a fällt die Konzentration um 70 ppm auf 280 ppm ab. Nach 110 Jahren also auf 13,5% dieser Differenz – vorausgesetzt natürlich dass die Ozeane noch weitgehend bei 280 ppm sind.

Wenn Wasser wärmer wird, gast mehr CO2 aus?

Herr Schulz, die Erhöhung der Ausgasung bei Temperaturerhöhung ist ziemlich gering und kann gegen den Temperaturanstieg durch CO2 fast vernachlässigt werden. Pro CO2-Verdoppelung ist ∆T nur 0,6 Grad, aber etwa die 30 fache Erwärmung würde benötigt um die ppm durch Ausgasung zu verdoppeln.

Peter Dietze 5. September 2025 21:07

Sie vergessen das mit steigender CO2-Konzentration der Partialdruck des CO2 steigt. Der steigende Partialdruck überkompensiert die Wirkung einer Temperaturerhöhung.

Herr Ebel, also ich vergesse dass der steigende Partialdruck die Wirkung einer Temperaturerhöhung.überkompensiert?? Genau auf den Faktor 30 habe ich doch hier hingewiesen. Sie sind schon wieder mit Desinformation unterwegs (nach dem Vorbild Honecker „niemand hat die Absicht eine Mauer zu errichten“).

Mein Modell berechnet doch KEINE (gar nicht existierende) Nettoausgasung durch geringe Temperaturerhöhung. Allenfalls wird das beim Senkenfluss (auf Basis der Mauna-Loa-Kurve) berücksichtigt. Was soll also Ihre Behauptung dass ich den Austausch bei konstanter Konzentration nicht verstanden habe?? Wie haben Sie diesen denn besser verstanden obwohl Sie noch nie ein brauchbares C-Modell entwickelt haben und stattdessen nur fragwürdige Behauptungen absondern – wie z.B. ein ∆T von 1 Grad pro 100 ppm was etwa um den Faktor 6 zu hoch ist.

Peter Dietze 6. September 2025 8:16

Unsinn. Sie rechnen irgendwelche Witze aus und behaupten dann die Beobachtungen und die Aussagen von Fachleuten wären falsch.

Sie tun so, als ob das Mehr an CO2 überall wäre, aber benutzen als Ausgang die Konvektion mit – vernachlässigen aber die Änderung der Konvektion. Die Frage nach der Änderung der Tropopausenhöhe können Sie nicht beantworten und haben es noch nie getan – obwohl das wesentlich (ca. 5%) ist. Die Tropopausenhöhe ist ca. 10 km (schwankt stark zeitlich und breitengradabhängig) ist ist bei ca. 50 % mehr CO2 um ca. 0,5 km gestiegen.

Und den Austausch bei konstanter Konzentration haben Sie auch nicht verstanden. Siehe auch: https://www.chemie.schule/WP/wp03-Mineralwasser/wp03-ab/ab_loeslichkeit_kohlenstoffdioxid_wasser.htm

Gibt es einen Beleg für diese Rechnung?

Sie behaupten ja auch das kälteres Wasser mehr CO2 aufnimmt….

Herr Schulz, fällt Ihrer destruktiven Denke nichts Besseres gegen meine C-Modellierung ein als für allgemein bekannte Tatsachen Belege zu fordern? Wenn ich mit 3+4=7 rechne, würden Sie dazu vielleicht als Nachweis noch eine Review-Veröffentlichung in einer Fachzeitschrift fordern.

Ich fände Belege eigentlich ziemlich konstruktiv. Was soll an der Frage nach dem Beleg destruktiv sein?

Gibt es für ihre Rechnung gar keine Review-Veröffentlichung in einer Fachzeitschrift?

Herr Schulz, wenn Sie einen Beleg für den Faktor 30 brauchen – oder die 6,5 Grad welche durch Ausgasung für +100 ppm nötig sind, was beim Vostok-Eisbohrkern festgestellt wurde – empfehle ich https://www.fachinfo.eu/dietze2022.pdf

In dem 2. Seiten Artikel steht ungefähr gar nichts über den Faktor 30 drin. Ist es der richtige Link?

Herr Schulz, rechnen Sie mit ECS=0,6 Grad (im Gleichgewicht) z.B. mal einen Anstieg von 280 auf 380 ppm. Mit 0,6•ln(380/280)/ln(2) ergibt das 0,264 Grad. 6,5 Grad beim Vostok-Eiskern sind dagegen Faktor 24,6. ECS=0,6 Grad ist richtig, und der Vostok-Wert stammt aus der Beobachtung, bezieht sich jedoch auf Ausgasung. Herr Ebel lässt sich von seiner Beobachtung (1 Grad pro 100 ppm, Faktor 6,5) nicht abbringen.

ECS=3 Grad beim IPCC ist gegen ECS=0,6 Grad ein Faktor 5, und wenn auch noch die Halbwertszeit unseres emittierten CO2 um den Faktor 10 oder gar gegen unendlich erhöht und jedes Jahr eine COP veranstaltet wird, glauben alle Dummies dass wir mit NetZero eine Klimakatatrophe verhindern müssen.

Peter Dietze 11. September 2025 6:17

Herr Dietze, Sie sind ein Spaßvogel. Wenn eine Beobachtung zu Ihren Vorurteilen paßt, ist diese Beobachtung richtig, paßt diese nicht zu Ihren Vorurteilen, dann ist die Beobachtung falsch.

Die Auswirkungen der Erhöhung der CO2-Konzentration sind vielfältig. Sie berechnen nur einen Teil der Auswirkungen und wundern sich, das alle, die sich mit der Gesamtwirkung beschäftigen, Ihre Teilergebnisse als zu klein für die Gesamtwirkung erkennen.

Wenn Sie über Ihre falschen Ergebnisse nicht nachdenken, dann sollte Sie die Denkfaulheit oder bewußten Falschdarstellung der anderen Klimaleugner nicht wundern – diese machen nur, was Sie auch machen: ihre persönlichen Vorurteile als Maßstab für Beurteilungen zu nehmen.

Typisch für dieses Nichtanerkennen der Beobachtung durch Sie ist z.B. die Vernachlässigung des Anstiegs der Tropopausenhöhe (folgt aus dem Schwarzschild-Kriterium). Wenn Ihnen dieser Anstieg nicht klar ist, haben Sie den Treibhauseffekt nur teilweise verstanden.

Herr Ebel, wenn Sie als Physiker nicht verstehen dass dieTropopausenhöhe mitsamt Gradient für die strahlungsphysikalische Berechnung von ECS (also Absorption, Gegenstrahlung und CO2-Verdoppelungseffekt am Boden) IRRELEVANT ist und Feuchtkonvektion KÜHLT, kann ich Ihnen nicht helfen. Eher sind Sie der Spaßvogel, denn dass CO2 zu 120% (statt nur zu etwa 20%) die Bodentemperatur bestimmt, ist ebenso falsch wie die Beobachtung dass die Zahl der Babys proportional zur Zahl der Störche ist.

Peter Dietze 11. September 2025 10:47

Das schreibe ich doch die ganze Zeit. Für die Angabe der Klimasensitivität reicht die strahlungsphysikalische Berechnung nicht aus – außerdem schreiben Sie selbst, daß die „Konvektion kühlt“.

Ich würde zwar nicht von Kühlung sprechen, aber mit der Wärmeabgabe der Oberfläche durch Konvektion ist die Oberflächentemperatur niedriger als ohne Konvektion. Oder „kühlen“ Sie mit den Außenwänden Ihres Hauses Ihre Räume, denn diese entziehen den Räumen Wärme durch Wärmeleitung.

Die Konvektion setzt ab der Tropopause ein – und wenn Sie zwar durch Konvektion richtig das Verringern der Temperatur der Oberfläche nennen (wenn auch mit der falschen Bezeichnung „kühlen“), so spielt die Höhe der Tropopause eine Rolle (und ist nicht „IRRELEVANT“), denn dort setzt Ihre „kühlende“ Konvektion ein!

Herr Dietze,

eigentlich ging es um die Konzentration vom CO2 und nicht um die „Klimasensitivitaet“. Also beim Faktor 30 meinen sie den theoretischen Zusammenhang von Temperaturerhoehung und CO2 Konzentration?

Na gut, das diskutieren sie besser mit Herrn Ebel.

Nur ist Herr Ebel nicht dumm, Daher scheint das Problem zu sein, das wenn man die Leute mit einer anderen Ansicht als dumm darstellt dann vergisst ordentlich zu argumentieren.

Was halten sie von dem Ansatz von Herrn Hess? Ich finde das ist seit langem eine der besten Interpretationen, die man lesen durfte.

Eventuell ist ihr Model zu einfach. Haben sie den Einfluss vom „Restglied“ selber festgestellt?

Ich denke es gibt keine Klimakatastrophe, und da sind wir auf der gleichen Seite. Und um so wichtiger ist diese Diskussion, die man nicht sinnvoll fuehrt, andere als dumm zu bezeichnen oder zu sagen sie haben es nicht verstanden.

Vielleicht gibt es ja noch mal eine Neuaufarbeitung ihres Modelles…

mfg Werner

Herr Schulz, Sie meinen, der Ansatz von Herrn Heß sei seit langem eine der besten Interpretationen, die man lesen durfte. Sie haben also NICHT gespannt dass Herr Hess lediglich die von IPCC benutzte gewichtete Summe von e-Funktionen mit stark unterschiedlichem tau – siehe z.B. die von mir aus der CSIRO-Doku angegebe Funktion G(t) – einmal unter Weglassung des „Ewigkeitsrests“ (!) getestet und mit meiner Kurve exp(-t/55) verglichen hat.

Dass Herr Heß bisher festgestellt hat dass die ppm-Kurve des IPCC, die bei gegebenem Emissionsverlauf nur durch ein 10fach zu hohes tau von 570 a (!) und einen sehr großen Zusatzpuffer approximiert wird, grottenfalsch ist weil sie auf dem Berner Diffusionsmodell beruht, habe ich noch nicht gesehen.

Mein tau von 55 a wurde durch optimale Anpassung an die Mauna-Loa-Kurve und noch durch zwei weitere Analysen berechnet. Mit dem G(t) des IPCC funktioniert es bei Mauna Loa überhaupt nicht – was Herr Heß nicht geprüft hat. Und mein Chat mit ChatGPT scheint Sie garnicht zu interessieren. Stattdessen von Ihnen die Bemerkung, dass es vielleicht eine Neubearbeitung (!) meines (vermeintlich zu einfachen und fehlerhaften) Modells geben wird. Wenn Sie das vom IPCC etwa für richtig(er) halten und für Sie Physik nur für eine Ansichtssache ist, kann ich Ihnen nur einen Arztbesuch empfehlen.

Herr Dietze,

Nachdem sie mir eine Quelle genannt haben, wo nicht drinn stand, was sie zu einem Thema gesagt haben, was gerade nicht besprochen wurde, drohen sie mir mit ChatGPT oder dem Arzt?

Ich weiss nicht viel, aber ich weiss, das ich von ChatGPT nicht die richtige Antwort erwarten kann, es sei denn ich weiss schon was ich frage, und ich weiss, dass ich nicht zum Arzt gehen brauch, weil mir nichts fehlt.

Ihr Austausch mit Herrn Ebel ist allerdings köstlich. Lassen sie sich also nicht stören.

Der Temperaturanstieg durch CO2 soll die Atmosphäre betreffen, hier geht es aber um die Ozeane, die angeblich weniger auf CO2 Erwaermung reagieren.

Wenn sie 30 fach sagen, meinen sie die Ozeane?

Ich habe meine Antwort schon!

Zu Jochen Ebel

Wenn Sie aus Unkenntnis dem IPCC etwas unterstellen, das nicht zutrifft, wird das nicht wahrer.

Offensichtlich kennen Sie die Aussagen des IPCC nicht – dann würden Sie nicht einen solchen Unsinn schreiben.

Herr Dr. Beppler, Sie haben offensichtlich die Aussagen des IPCC missverstanden, und – wie ich anhand des völlig falschen Kumulationsmodells gezeigt habe – sogar ins Gegenteil (!) verkehrt, womit Sie nichtmal die Ursache (nämlich beim IPCC Null Senkenfluss bei Null Emission) für den Unsinn verstehen dass wir CO2 auf NetZero (also vermeintlich auf fast Null) reduzieren sollen.

Dr. Erhard Beppler 3. September 2025 11:39

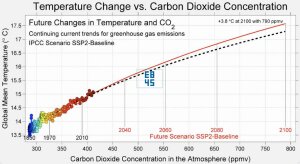

Da haben Sie etwas falsch verstanden. Nach Ansicht des IPCC müssen die Emissionen gegen null gehen bzw. sogar negativ werden (durch aktives Entfernen von CO2 aus der Atmosphäre, SSP1-*) – nicht der Anstieg der Emissionen. Kann man im folgenden Bild gut sehen:

Geht der „Anstieg der weltweiten anthropogenen CO2-Emissionen gegen null„, steigt der CO2-Gehalt weiter an (gelbe Kurve SSP2-4.5).

Als Ergänzung der IPCC schreibt bei SPM Figure 7:

und an anderer Stelle:

Herr Dr. Beppler, Sie haben also immer noch nicht meine Exel-Grafik angesehen und verstanden was passiert wenn der ANSTIEG der weltweiten anthropogenen CO2-Emission gegen null geht, die Emission also konstant wird. Solange die Emission grösser ist als der Senkenfluss (und der ist heute erst bei 64%), müssen die ppm ANSTEIGEN. Erst wenn die Emission kleiner wird als 64% oder gar gegen Null geht, geht der CO2-Gehalt der Atmosphäre langsam zurück.

Dass Sie die Diskussion beenden und IPCC-Aussagen frei erfinden, zeigt dass Sie triviale Grundlagen vom C-Kreislauf noch nicht verstanden haben und unbelehrbar immer noch Emission und Emissionsanstieg verwechseln.

Herr D. Beppler, Ihre Aussage dass wenn der Anstieg der weltweiten anthropogenen CO2-Emissionen gegen null geht, dann muss nach der Vorstellung des IPCC der CO2-Gehalt der Atmosphäre zurückgehen, ist falsch. Ihnen ist offenbar nicht bekannt dass beim Kumulationsmodell des IPCC der Senkenfluss ein fester kleiner Anteil (z.B. etwa 30%) der Emission ist. Solange also der Anstieg oder die Emission gegen Null geht, haben wir beim IPCC einen ppm-Anstieg. Und um diesen zu verhindern, sollen wir ja CO2 auf Null reduzieren. Dann wird aber der Senkenfluss Null, und deshalb muss ja noch CO2 aus der Atmosphäre entnommen werden um die gegenwärtige Erwärmung zu reduzieren. Auch das scheinen Sie nicht verstanden zu haben.

Kann man hier durchaus als Meinung in den Raum stellen, aber hier nur zu einem Punkt. Ihre Vorstellungen zu chaotischen Prozessen, die übrigens vollends mit den Gesetzen von Physik, Chemie und Mathematik harmonieren, zu nichtlinearen Systemen, zu intensiven physikalischen Größen, etc. sind durchaus begrenzt, was Ihre Meinung schnell als nur überheblich ausdeutbar macht, oder?

Immer wieder witzig zu sehen wie die GHE-Gläubigen in ihrer unermesslichen Arroganz beweisen dass sie schöne Modelle bauen können, ansonsten aber wenig Ahnung haben. Und jeder dieser Experten hat seine eigenen Vorstellungen die natürich aich die einzig richtige ist. Was für ein Glück dass es keine einheitliche, klare technische Definition des GHE gibt, so ist man immer auf der richtigen Seite undkann die Torpfosten nach belieben verschieben.

Schon einmal was von der Internationalen Standardatmosphäre ISA gehört?

Zeigen Sie doch mal woher Sie das Temperaturprofil und die 6.5°C pro 1000m her haben. Hansen selber hat zugegeben dass die Zirkulationsmodelle mit der lapse rate der ISA arbeiten, damit es wenigensten ein bisschen nach echter Physik aussieht was da an Modellen produziert wird.

Marcus Portius 2. September 2025 18:29

Das ist der Durchschnitt der Meßwerte. Das aktuelle Temperaturprofil hängt vom Wasserdampfgehalt ab – und die Meßwerte sind z.B. im jeweiligen aktuellen Stüvediagramm (bzw. TLogP-Diagramm – ), als Unterstützung für das Flugwetter. https://www.dwd.de/DE/fachnutzer/luftfahrt/download/produkte/vertikalprofile/vertikalprofile_download.pdf?__blob=publicationFile&v=2

Die Abhängigkeit des Temperaturgradienten vom Wasserdampfgehalt (der mit der Höhe abnimmt) zeigt z.B. Fig. A6. in https://arxiv.org/pdf/2004.00708

Naja, der wirkliche Unterschied von der Standardatmosphäre und den Treibhausthesen ist, das die Standardatmosphäre physikalisch abgeleitet und erklärt werden kann, die Thesen nicht.

Deshalb auch „Thesen“!

Der GHE existiert bekanntlich nur im Modell. Sowohl Happer/van Wijngaarden als auch Sabine Hossenfelder haben Videos in denen das Temperaturprofil der Standardatmosphäre SA gezeigt wird. Auch in Happer’s GHE Primer in dem er das Modell erklärt wird das Standardmodell (barometrische Formel, hydrostatisches Gleichgewicht) erwähnt. Hansen hat auch darauf hingewiesen „It’s a fudge“ dass die lapse rate aus einem anderen Modell stammt.

Die GCMs simulieren quasi das Standardmodell mit Strahlungstransportgleichungen. Die Lukewarmer und Alarmisten nutzen also ein Modell als Grundlage, verleugnen aber die Grundlage dieses Modells, Ideales Gasgesetz, graviationsbedingter Temperaturgradient.

Die ganzen Experten belügen sich selber. Es ist absurd und es stellt sich die Frage an welcher Stelle die Modellierer falsch abgebogen sind da sie ganz offensichtlich glauben dass die Realität wie ihr Modell arbeitet (wobei Arbeit in deren Modell keine Rolle spielt).

Auch die Verwendung des Begriffs Konvektion ist obskur, insbesondere für einen adiabatische Prozess, es wird von einem „Energietransport“ geredet während sich in der Realität warme Luft vertikal bewegt. Das dynamische wird durch ein quasi statisches System (Fourier) ersetzt wo „Energie“ zwischen den hypothetischen Schichten der SA ausgetauscht wird, man addiert und subtrahiert Wärmeflüsse unabhängig von der vom 2ten HS vorgegebenen Richtung (um die Erwärmung durch Kompression zu simulieren)

Mich wundert immer wieder dass sich kaum jemand mal mit den GCMs befasst hat.

Marcus Portius 4. September 2025 18:20

Es gibt keinen „graviationsbedingter Temperaturgradient“.

Welches Modell hat Fourier denn erfunden?

Das müssen Sie mal beweisen, nicht mit Gelaber sondern einem Experiment. Das werden Sie nicht liefern. Selbst wenn Sie es wollten können Sie es nicht.

Thermal Steady States of Gases in a Gravitational Field

Ist das was auch de Saussure in seiner Box beobachtet hat. Das Sie fragen welches Modell Fourier erfunden hat entbehrt nicht einer gewissen Komik, zeigt es dass Sie Fourier entweder nicht gelesen und/oder nicht verstanden haben und dass Sie von der Atmosphäre in der Realität keine Ahnung haben. Phüsiker halt.

Und dann noch was Josef Loschmidt beschrieben hat.

Sie stellen immer Behauptungen auf, können diese aber nie mit etwas handfestem untermauern, sie schwurbeln rum, lenken ab, aber was substantielles kommt da nicht.

Marcus Portius 4. September 2025 22:01

Was bei Kigoshi für die Atmosphäre falsch ist, weiß ich noch nicht. Die Daten liefern für seine Experimente einen Temperaturgradienten von ca. 8000 K/km, aber der beobachtete Temperaturgradient mit Konvektion ist nur ca. 6,5 K/km – also ist Kigoshi kein Beweis.

Zwar kann sich auch ohne Konvektion im Gravitationsfeld ein Temperaturgradient unter 6 K/km eine Zeit lang halten, da die Wärmeleitung im Gas sehr gering ist.

Möglicherweise entsteht bei Kigoshi der Temperaturgradient durch das Umdrehen, da beim Umdrehen im Gravitationsfeld sich der Druckgradient ändert – und die Änderung des Druckgradienten erfolgt adiabatisch mit entsprechender Temperaturänderung. Kigoshi hat dann nicht lange genug beobachtet, um statt der adiabatischen Druckänderung einen möglichen gravitationsbedingten Temperaturgradienten zu beobachten.

Ist das nicht genau das was diesen Gradienten ausmacht?

Der Druckgradient ist doch gravitativ beeinflusst oder nicht? Warum wollen sie das unterscheiden?

Nur wundern, Herr Ebel muss immer recht haben, auch wenn er sich dabei selbst beständig in Widerspruch zu eigenen Aussagen setzt. 😀

Moritz Steinmetz 5. September 2025 18:23

Falsch. Mit Ihrem geringen Wissen konstruieren Sie immer irgendwelche Widersprüche, die nicht existieren.

Obwohl Kigoshi vom Schwerpunkt der Gasmasse spricht, beachtet er diesen Punkt nicht. Beim Umdrehen bleibt im ersten Moment der alte Schwerpunkt im Gefäß – wird aber symmetrisch zur Mitte verschoben. Der Schwerpunkt wird also verschoben und zur Schwerpunktverschiebung muß Arbeit geleistet werden, die die innerer Energie ändert. Bei der geringen Wärmeleitfähigkeit der Luft dauert es bei dem großen Gefäß sehr lange, bis die Änderung der inneren Energie an die Umgebung abgegeben wird.

Man kann sich mit den Modellen auseinander setzen. Ich vermute die atmosphärenphysikalischen Grundlagen sind gar nicht vorhanden, weil sie global mit irgendwelchen Forcings rechnen, die aber nichts mit der Realität zu tun haben. Ich nehmen sogar an, das sie keine Möglichkeiten haben Jetstreems zu simulieren, oder warum Herr Tengler immer noch 5 K weniger messen kann als die DWD Wetterstation.

GCMs sind im Prinzip Wettermodelle und wie sie designed sind machen si durchaus Sinn wenn man etwas dynamisches simulieren will. Fragwürdig wird das ganze wenn man der festen Überzeugung ist diese Modelle repräsentieren die Wirklichkeit und/oder wenn man mit der falschen Prämisse arbeitet, die Annahme eines strahlenden Effekts der für die Temperatur verantwortlich ist, im Durchschnitt.

Schauen Sie wie sich Ebel et al gegen die Gravitation sträuben, es ist „das falsche Experiment“ weil es zeigt was nicht sein darf.

Oder der Unfug mit der Konvektion die es ohne GHGs nicht geben soll.

oder warum Herr Tengler immer noch 5 K weniger messen kann als die DWD Wetterstation

Ich nun glaube ich ganz bei Ihnen.

Herr Ebel wieder mal mit umgekehrten Vorzeichen unterwegs?

„Die Werte der Internationalen Standardatmosphäre (ISA), einschließlich ihres Temperaturgradienten, sind das Ergebnis einer physikalischen Berechnung und eines Konsenses, der auf einer Vielzahl von physikalischen Prinzipien beruht.“

So wurde es von Ihm auch schon des öfteren definiert, nun plötzlich meint er, es ist der „Durchschnitt von Messwerten“. Kann man so machen, muss man sich aber nicht wundern wenn es lächerlich wirkt. 😀

Moritz Steinmetz 5. September 2025 18:20

Ich schrieb ja schon, Ihr geringes Wissen läßt Sie Widersprüche erfinden, wo keine sind. Der „Durchschnitt von Messwerten“ bestätigt die „physikalischen Prinzipien„.

„Mein geringes Wissen“ reicht aber allemal aus um Ihre ständig wandelbaren und damit widersprüchlichen Einlassungen zu identifizieren. Damit bin ich also schon ein ganzes Stück weiter als Sie. 😀

Moritz Steinmetz 6. September 2025 11:34

Na dann bringen Sie doch mal „widersprüchliche Einlassungen“! Aber nicht zwei Seiten einer Medaille wie Ihre zwei Seiten eines Sachverhalts z.B. der Erhöhung der CO2-Konzentration: Die eine Seite ist das rechnerische Verstehen und die zweite Seite das Messen der Wirkung – und beides stimmt überein.

Was wahrscheinlich nicht übereinstimmt ist das Verstehen meiner Aussagen mit Ihren Vorurteilen.

Warum soll ich auf Ihre Vorurteile eingehen die Sie mit immer dem gleichen Singsang und bei jeder passenden wie unpassenden Gelegenheit matraartig wiederholen. Einen Sinn ergeben diese Beiträge nicht wirklich, aber Hauptsache Sie gaben Ihren Senf dazu. 😀

Moritz Steinmetz 6. September 2025 18:51

Vorurteile haben Sie, nicht ich. ihre Vorurteile erschweren es Ihnen die Wissenschaft zu verstehen.

Wo bleiben Beispiele von Ihnen, daß ich angeblich „widersprüchliche Einlassungen“ mache?

Die Aussage in Abschnitt 4, dass der atmosphärische CO2-Zuwachs nicht allein durch menschliche CO2-Emissionen verursacht wird, deckt sich zumindest qualitativ mit meinem eigenen Befund, auf den ich hier in aller Bescheidenheit hinweisen darf:

https://eike-klima-energie.eu/2025/05/07/woher-kommt-das-atmosphaerische-CO2/

Meiner Analyse liegt eine lineare Näherung für den Anstieg der menschlichen Emissionen bis 2018 zu Grunde. In diesem Zusammenhang verdient die Feststellung, dass in den letzten Jahren der Emissions-Anstieg abflacht, die Keelingkurve aber im Gegensatz dazu weiterhin progressiv ansteigt, besondere Beachtung, wie Dr. Beppler bereits in der Überschrift sehr richtig bemerkt (vgl. a. Bild 9). Auch sein Hinweis in Abschnitt 6 auf Unterwasservulkane und unterseeische Wirbelschleppen als mögliche natürliche Quellen ist hier von Belang.

Leider gibt es allerdings quantitativ einiges im Artikel zu kritisieren. Bereits der Satz im Fazit

ist nicht haltbar. Wenn der Anstieg der jährlichen Emissionen gegen Null geht, heißt das, dass die Emissionen konstant werden. Der atmosphärische Gehalt geht dann gegen einen Gleichgewichtswert größer als Null, und dann haben die Temperaturen nach den Vorstellungen des IPCC keinen Grund, zu fallen.

Übrigens: der atmosphärische Gehalt lässt sich z.B. in ppm messen. Die Jahres-Emissionen dann in ppm/a (erste Ableitung des Gehaltes) und der Anstieg der Emissionen in ppm/a² (zweite Ableitung des Gehaltes, deshalb geht die Einheit a für Jahr hier quadratisch ein). Das wird im Artikel durchweg ignoriert, was dann zu Fehlschlüssen führt wie z.B. in Abschnitt 4:

Wenn klar ist, dass die Emission in Wirklichkeit als 4,7 ppm/a zu schreiben ist, dann lautet der Anstieg der Jahresemission 0,07 ppm/a² und kann auf Grund der unterschiedlichen Einheiten nicht mehr mit der Jahresemission von 2 ppm/a selber verwechselt werden.

Weiter zu kritisieren (ebenfalls Abschnitt 4):

Die subtrahierten 4,7 ppm sind die Jahresemission von 2020 allein. Es müsste aber die Summe aller Emissionen von 1870 bis 2020 abgezogen werden. Allein von 1960 bis 2018 betrug die Gesamt-Emission 1340 Gt CO2 oder 167 ppm. Das führt bereits auf einen negativen Wert für die natürlichen Quellen, weist also auf eine Senke hin.

Schließlich ist die Berechnung zur ozeanischen Ausgasung zwar numerisch richtig, aber unplausibel (Kapitel 6):

8650 Gt entsprechen rund 1079 ppm, die da ausgegast wären. Die Zunahme im genannten Zeitraum beträgt aber nur 106 ppm. Wo soll der Rest geblieben sein? Offensichtlich genügt es nicht, die reine CO2-Löslichkeit nach dem Henry-Gesetz zu berücksichtigen, weil da noch weitere chemische Umsetzungen eine Rolle spielen.

Antwort auf die Aussage Herrn Mechtel