Von Henri Masson, Professor (emeritus) an der University of Antwerp (Belgium) und Michael Limburg Dipl. Ing.

Dieser Artikel wiederholt weitgehend einen Teil des Vortrags, den der Autor Henri Masson auf der 12. jährlichen EIKE-Konferenz (München 2018) gehalten hat. Der Text, der die PowerPoint-Folien der Präsentation umgibt, ist jedoch unveröffentlicht, ebenso wie das, was den Kern dieser Studie ausmacht: die Analyse der Anpassungs-Residuen von Hadcrut 5.0.1.0-Daten durch eine Summe von Sinuskurven oder eine lineare Regressionslinie.

Der Beitrag wurde aus praktischen Gründen in 4 Teile aufgeteilt

Das Video dazu findet man hier.

Teil 1

Präambel

Die globale Erwärmung, die im Laufe der Jahre erst als Wandel, dann als Störung und derzeit als Klimanotstand bezeichnet wird, wird vom IPCC als die Entwicklung der globalen Temperaturanomalie pro Jahr, Jahrzehnt oder Jahrhundert beschrieben.

Dieser Ansatz, über den in den Medien viel berichtet wurde, ist in mehr als einer Hinsicht irreführend.

Denn die in dieser Form dargestellten experimentellen Daten dienen der Kalibrierung der vom IPCC verwendeten mathematischen Modelle und damit der Rechtfertigung seiner „Projektionen“, die als Grundlage für die von ihm formulierten klimapolitischen Empfehlungen dienen. Diese sind die „Spitze des Eisbergs“ seiner Berichte in Form von „Zusammenfassungen für Entscheidungsträger“. Diese Zusammenfassungen, die von den Vertretern der verschiedenen beteiligten Regierungen umfassend überarbeitet und politisch redigiert wurden, sind das Einzige, was die große Mehrheit der Menschen konsultiert, insbesondere die politischen Entscheidungsträger, an die sie sich richten und die sie beeinflussen sollen, sowie die Medien, die ausführlich darüber berichten, ohne dass jemals jemand die Gültigkeit der „Wissenschaft“ oder die Qualität der experimentellen Daten, auf denen das ganze Gebäude beruht, in Frage stellt. Die Notwendigkeit, die (so genannte) globale Erwärmung zu bekämpfen, ist also nichts weiter als eine prinzipielle Frage.

Die Gültigkeit und damit die Glaubwürdigkeit eines mathematischen Modells hängt jedoch von der Qualität seiner Kalibrierungsdaten, der Qualität der verwendeten Algorithmen, der Genauigkeit der zugrunde liegenden Annahmen, die nicht immer eindeutig sind, und der Anpassung seiner Parameter ab. Diese Anpassung der Parameter muss natürlich realistischen Werten entsprechen und darf nicht der betrieblichen Bequemlichkeit dienen (z. B. um die Ergebnisse der durchgeführten Simulationen zu stabilisieren und reproduzierbar zu machen, die bei der Verwendung realistischer Werte für diese Parameter eine ungünstige Tendenz zu Abweichungen aufweisen würden). Dies ist leider der Fall bei den so genannten „Global Circulation“-Modellen, auf die sich der IPCC stützt.

Dieser Artikel befasst sich speziell mit dem Vertrauen, das man in globale Temperaturanomalien haben kann oder nicht. Er untersucht eine Reihe von Problemen im Zusammenhang mit ihrer Konstruktion und Verwendung, und zwar ausschließlich unter dem Gesichtspunkt der Datenanalyse, ohne auf andere Aspekte der „Wissenschaft“ einzugehen, die den IPCC-Berichten oder den von ihm verwendeten numerischen Simulationen zugrunde liegt. Es handelt sich hierbei um eine weitere Qualitätsprüfung, die sicherlich von unabhängigen Sachverständigen durchgeführt werden sollte, die sich an die Regeln der guten Praxis in diesem Bereich halten.

Die in dieser Studie verwendeten Verfahren sind allgemeiner Art und gelten umfassend für sozioökonomische, epidemiologische, biologische usw. Daten wie auch für Klimadaten. Sie entsprechen dem „State of the Art“ der Datenanalyse. Mit dieser Klarstellung wird ein möglicher Vorwurf der „Klima-Inkompetenz“ an den Autor von vornherein entkräftet.

Jeder Indikator muss eine physikalische Bedeutung haben

Zunächst ist festzustellen, dass die Temperatur eine thermodynamisch intensive Größe ist, also ihrem Wesen nach lokal.

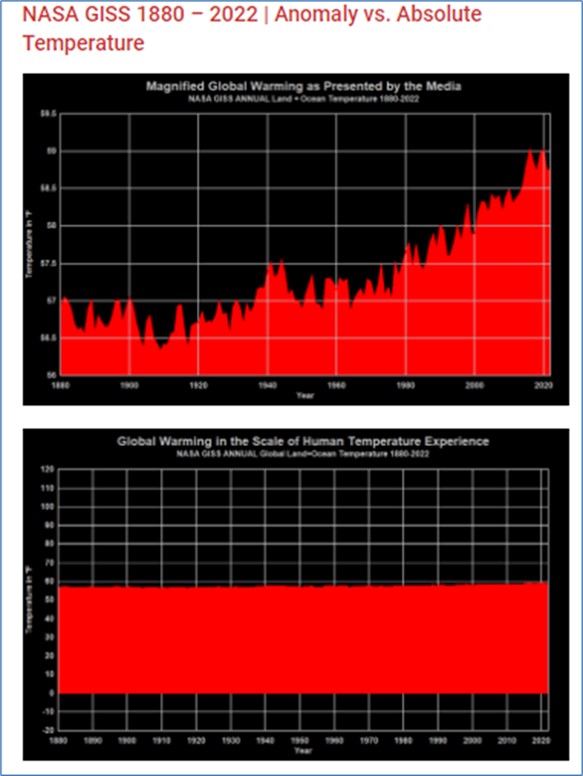

Die Verwendung einer Temperaturskala, die in Grad Celsius oder Fahrenheit ausgedrückt wird, ist eine einfache praktische Konvention; nur die absolute Temperatur, ausgedrückt in Grad Kelvin (Grad Celsius + 273,15), hat eine thermodynamische Bedeutung. Schlimmer noch, die Berücksichtigung von Temperaturanomalien im Vergleich zu einer willkürlich gewählten Temperatur ist eine grobe Manipulation, die darauf abzielt, die Bevölkerung übermäßig zu beunruhigen, es sei denn, es handelt sich nicht mehr nur um eine Frage der wissenschaftlichen Unkenntnis (Abbildung 1).

Abbildung 1: Temperaturen (°C) und Anomalien. Die Veränderung der Skala entlang der vertikalen Achse, von einer Abbildung zur anderen, ermöglicht jede Art von Manipulation der öffentlichen Meinung und schafft auch ein Gefühl der Dringlichkeit „angesichts des Ausmaßes der Klimakrise“.

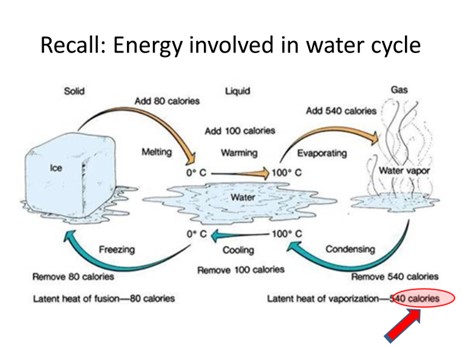

In Wirklichkeit spielt die Natur eine hervorragende Rolle als natürlicher Thermostat, insbesondere über die Verdunstungswärme – Kondensation entlang des Wasserkreislaufs (Abbildung 2).

Abbildung 2: Verdunstungs-Kondensationswärme entlang des Wasserkreislaufs

Aber das ist noch nicht alles: Die Berechnung von räumlichen und zeitlichen Durchschnittswerten der Temperatur ist problematisch.

Ein Indikator muss spezifisch sein (kritisch gegenüber räumlichen Durchschnittswerten)

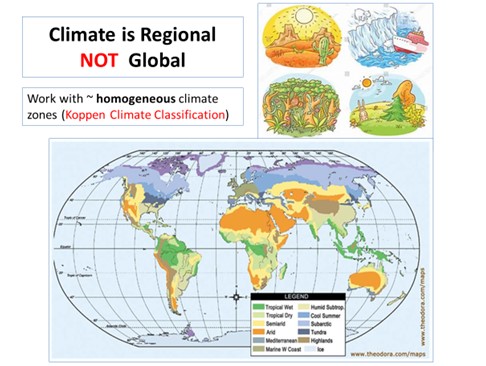

Zunächst einmal ist es gut, sich daran zu erinnern, dass es kein globales Klima gibt, wie jeder Geograf bestätigen wird (Abbildung 3):

Abbildung 3: Von Geographen definierte Klimazonen (Köppen-Klassifikation)

Aperiodische und nichtsynchrone zyklische Komponenten

Darüber hinaus werden bei der räumlichen Mittelung lokaler Temperaturanomalien saisonale Komponenten weitgehend ausgelöscht. Wenn auf der nördlichen Hemisphäre Winter ist, ist auf der südlichen Hemisphäre Sommer. Auf den ersten Blick sollten sich diese natürlichen Zyklen kompensieren und sich daher durch Summierung gegenseitig aufheben.

Aber auch geophysikalische Phänomene wie der Polarwirbel, der sich zeitweise entlang des einen oder anderen Längengrades bildet, oder El Nino greifen ein und verursachen lokale, aber asynchrone zyklische Temperaturschwankungen von einem Punkt des Globus zum anderen.

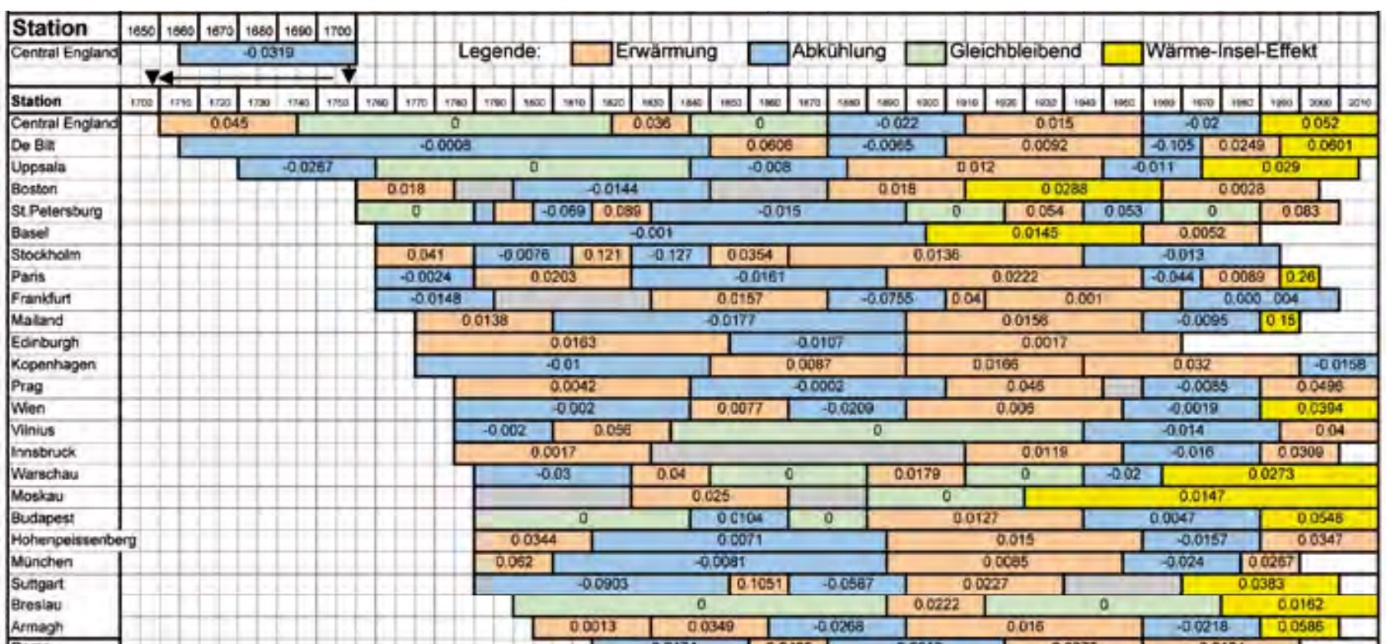

Durch räumliche Mittelung werden diese natürlichen Schwankungen bis zu einem gewissen Grad eliminiert und ihre Auswirkungen auf einen Gesamtindikator minimiert; lokal betrachtet spielen sie jedoch eine wichtigere Rolle als globale Temperaturanomalien. Dies ist einer der Gründe, warum IPCC-Modelle, die auf globale Temperaturanomalien geeicht sind, lokale oder regionale Temperaturschwankungen nicht korrekt beschreiben können: Diese Modelle unterschätzen algorithmisch die lokalen natürlichen Schwankungen. Und genau diese sind von Bedeutung. Die Folgen des Klimawandels, wie Dürren, Überschwemmungen, Tornados oder sogar die Notwendigkeit, eine ganze Bevölkerung in Klimaflüchtlinge zu verwandeln, werden nämlich lokal beurteilt. Es gibt also objektive Gründe, mit lokalen Größen zu arbeiten und nicht mit globalen Indikatoren, die physikalisch keinen Sinn machen und zudem Verzerrungen und falsche Trends hervorrufen, wie weiter unten gezeigt wird (Abbildung 4):

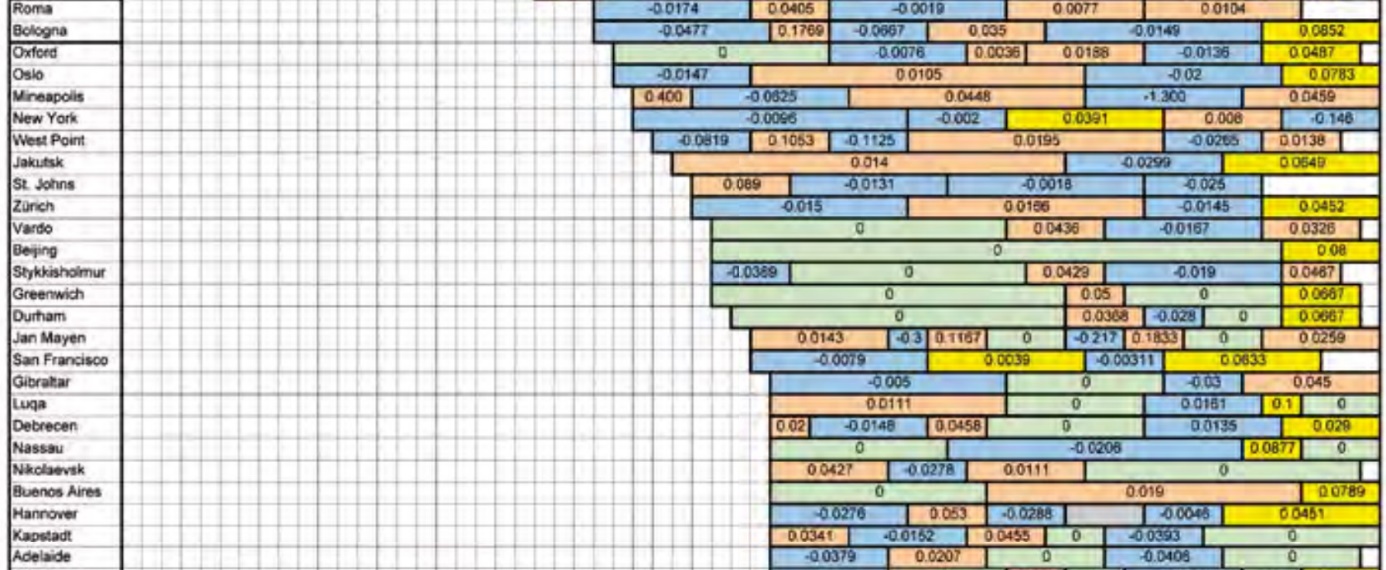

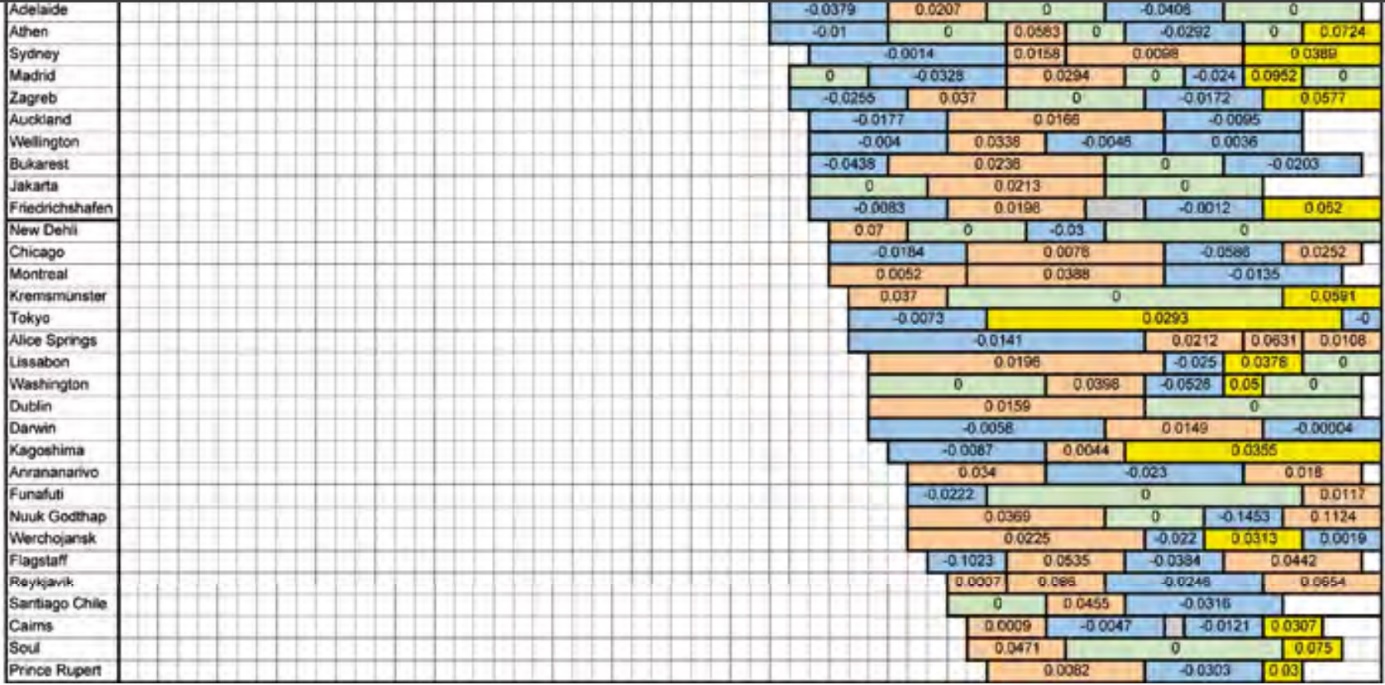

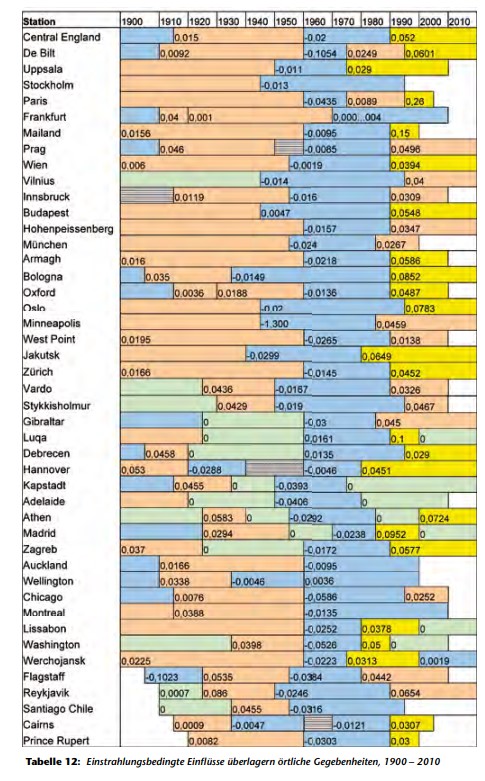

Abbildung 4: Verlauf der lokalen Temperaturschwankungen. Örtlich schwankt die Temperatur zyklisch, aber auch asynchron von einem Punkt zum anderen. Die Mittelung nicht synchroner zyklischer Signale als Gesamtindikator hebt diese Schwankungen auf. Die Folgen für das Klima sind jedoch lokal spürbar. Daher unterschätzt die Verwendung eines globalen Indikators zur Bewertung eines lokalen Effekts die Auswirkungen von Klimaschwankungen an einem bestimmten Punkt. (Übersetzung der Farbcodes am oberen Rand des Bildes, von links nach rechts: Erwärmung, Abkühlung, Stabilisierung, Stadtblockeffekt). Die Zahlen in den Kästchen entsprechen den Temperaturanstiegen oder -abnahmen im betrachteten Zeitraum“ (Quelle: Ewert F.K. Fusion 32, 2011 Nr3 S. 31-61).

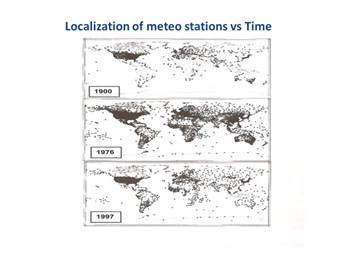

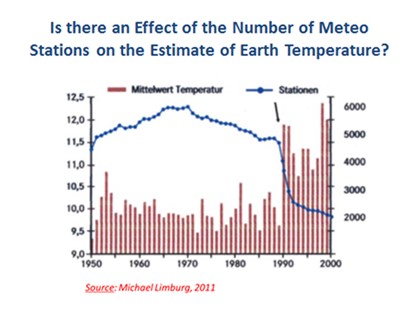

Ein weiteres Problem, das sich auf die Qualität der globalen Messungen auswirkt, ist die Tatsache, dass die Zahl der Stationen im Laufe der Zeit erheblich zurückgegangen ist, insbesondere infolge der Entkolonialisierung des afrikanischen Kontinents sowie des Zusammenbruchs der UdSSR und der daraus resultierenden Haushaltskürzungen am Ende des letzten Jahrhunderts (Abbildungen 5a und 5b):

Abbildung 5: Anzahl der Wetterstationen in Abhängigkeit von der Zeit. Abb. 5a: Lage der Wetterstationen in Abhängigkeit von der Zeit. Die Auswirkungen der Kolonialisierung und der Entwicklung des internationalen Verkehrs sowie der Entkolonialisierung in der Afrikanischen Union und der Sowjetunion hatten einen erheblichen Einfluss auf die geografische Verteilung und die Anzahl der Wetterstationen. Die große Mehrheit der terrestrischen Wetterstationen befindet sich in den USA. Abb. 5b: Überlagerung der Anzahl der Wetterstationen und der Berechnung der globalen Durchschnittstemperatur (°C) Im Jahr 1990, das dem Zusammenbruch der UdSSR entspricht, ändert sich die Anzahl der in Betrieb befindlichen Wetterstationen, und auch die berechnete globale Durchschnittstemperatur steigt deutlich an. Quelle:

(ftp://ftp.ncdc.noaa.gov/pub/data/qhcn/v2/v2.temperature.readme)

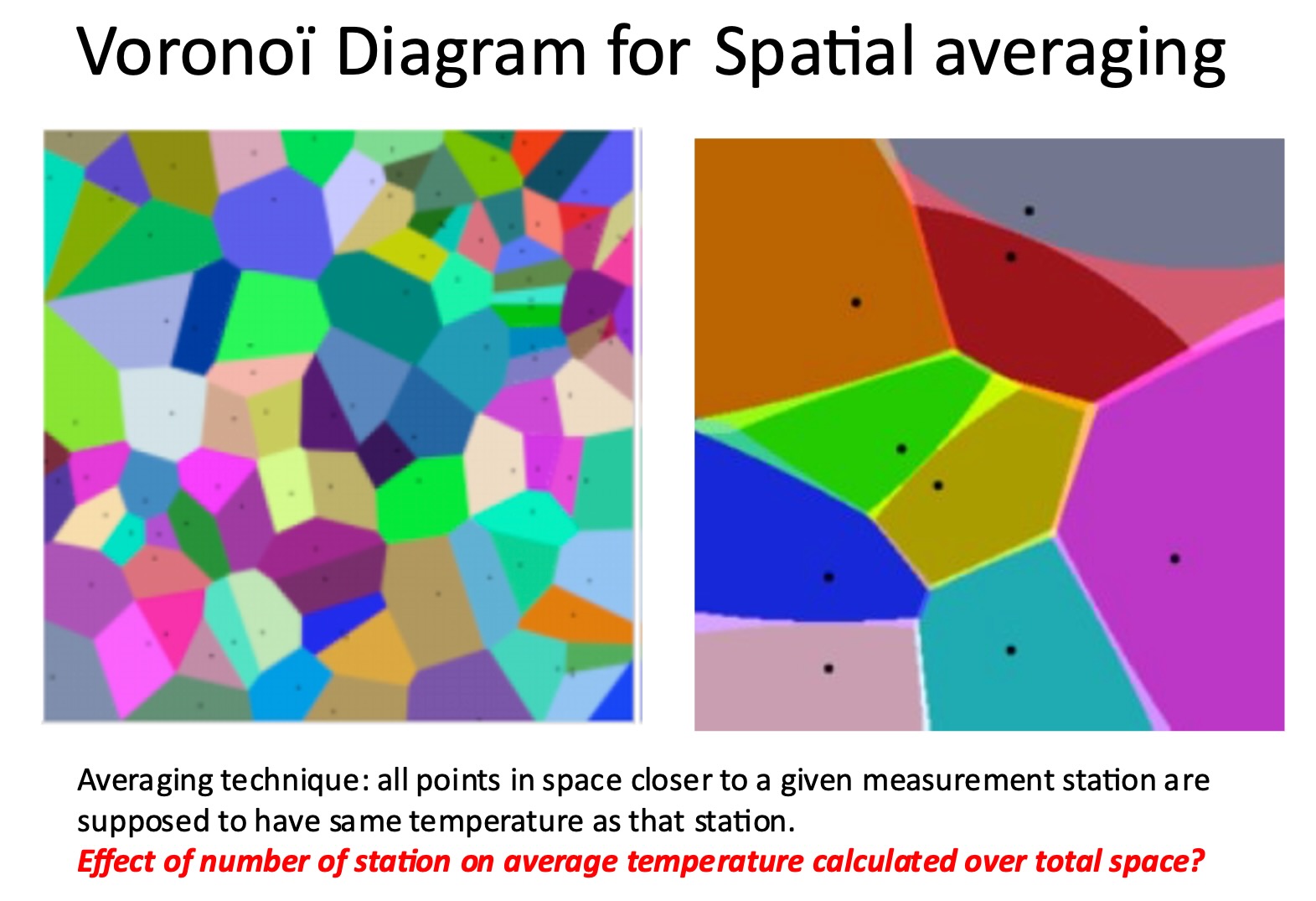

Zur Berechnung der globalen Durchschnittstemperatur oder ihrer Anomalie wird jedoch eine Form der Gewichtung von Punktmessungen verwendet, und zwar durch Algorithmen wie VoronoÏ. Letzterer ordnet die Temperatur einer Messstation allen Punkten zu, die näher an dieser Messstation liegen als andere, und definiert so eine „Kontrollzone“ (Abbildung 6):

Abbildung 6: Illustration des VoronoÏ-Algorithmus. Die Kontrollbereiche sind durch unterschiedliche Farben gekennzeichnet. Wenn die Anzahl der Stationen (dargestellt durch schwarze Punkte) abnimmt, vergrößern sich deren Kontrollbereiche.

Abbildung 6: Illustration des VoronoÏ-Algorithmus. Die Kontrollbereiche sind durch unterschiedliche Farben gekennzeichnet. Wenn die Anzahl der Stationen (dargestellt durch schwarze Punkte) abnimmt, vergrößern sich deren Kontrollbereiche.

Wenn die Anzahl der Stationen abnimmt, nimmt die Repräsentativität aller noch aktiven Stationen ab, aber auch der Kontrollbereich, der den benachbarten, aber noch aktiven Standorten entspricht, nimmt zu, was ihre Gewichtung bei der Berechnung der Gesamtdurchschnittswerte verändert. Dies führt zu Diskontinuitäten in den Gesamtmaßen.

Ende Teil 1

Wird fortgesetzt

Wer den gesamten Bericht sofort lesen will, findet ihn als pdf hierIPCC has it all wrong Li-Edition Deutsch

Die Berechnung von räumlichen und zeitlichen Durchschnittswerten der Temperatur ist problematisch.“

Nein, sie ist nicht problematisch, sondern einfach nur unzulässig und falsch. Da die Luftvolumina, die eine gerade erfasste Temperatur haben, unbekannt sind, helfen auch keine Gewichtungen von Punktmessungen. Man hat zwar damit das Problem erkannt, aber gerade nicht gelöst, weil sich die Bereiche um den Messpunkt „Annahmen“ beugen müssen, dass in einem willkürlich definierten aber dennoch unbekannten Bereich um den Punkt die identische Temperatur wie am Ort des Messpunktes herrscht.

Hingegen, Mittelwertbildungen aus den Messsignalen, die genau ein Sensor liefert, sind erlaubt, weil tatsächlich nicht Temperaturen gemittelt werden, sondern die Störungen unterliegenden Signalspannungen. Dabei handelt es sich immer um auf die Messleitungen einwirkende Wechselgrößen, deren Mittelwert 0 sein muss. Gleichspannungen als Störgrößen kann man nicht induzieren. In diesen Bereich fallen auch die bei mehreren Wandlungen in den Analog-Digitalwandlern auftretenden Ungenauigkeiten. Hingegen ist schon die Mittelwertbildung von zwei an unterschiedlichen Messpunkten erfassten Temperaturen physikalisch falsch.

Es ist immer davon auszugehen, dass das Umfeld von einem Sensorpunkt zum nächsten unterschiedlich in seiner Ausdehnung und Masse ist. Erwärmung, also Energie ist aber mit dem eine bestimmte Temperatur führenden Volumen bzw. der Masse verknüpft, die jedoch bestenfalls angenommen oder tatsächlich nur geraten wird, auch wenn man die dahinter liegende Methodik mit einem Namen versieht (VoronoÏ-Algorithmus).

Wie es ganz richtig heißt: „Dies führt zu Diskontinuitäten in den Gesamtmaßen.“ Jede weitere Rechnung nimmt einen nicht abschätzbaren Fehler mit, es bedarf daher keines Folgenforschungs-Instituts mehr, um noch weitere Annahmen und Verbiegungen durchzuführen, die nur unnötig große Rechnerkapazitäten missbrauchen, aber dennoch keine energetische Aussage liefern, nämlich, ob es wärmer oder kälter wird!

Wenn man einfach die Meßwerte aus einer verteilten Anzahl an Meßstationen mittelt, dann ist das natürlich nicht die globale Mitteltemperatur der Erde, sondern bloß der Mittelwert dieser Meßstationen, also eine Art Hausnummer, die nicht viel aussagt.

Man könnte diese Hausnummer evtl. als indirekten Indikator für die tatsächliche Mitteltemperatur der Erde nehmen, um wenigstens qualitativ einen zeitlichen Trend erkennen zu können. Das setzt aber voraus, dass die Meßstationen der Art, Anzahl und Platzierung nach konstant bleiben, ebenso wie ihre Umgebung.

Wenn sich aber diese Bedingungen ändern (und das wird mit Sicherheit der Fall sein), dann ist die Brauchbarkeit des Verfahrens völlig hinüber.