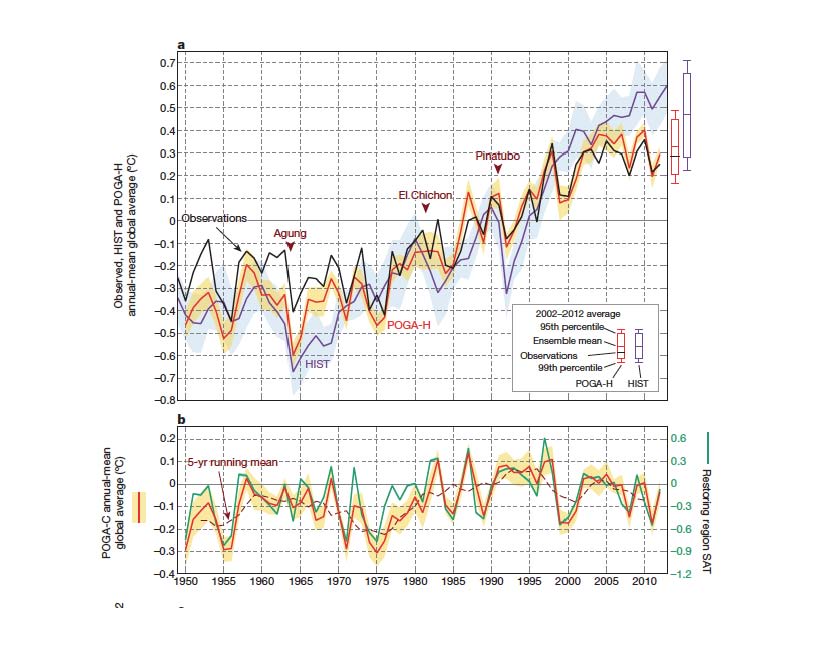

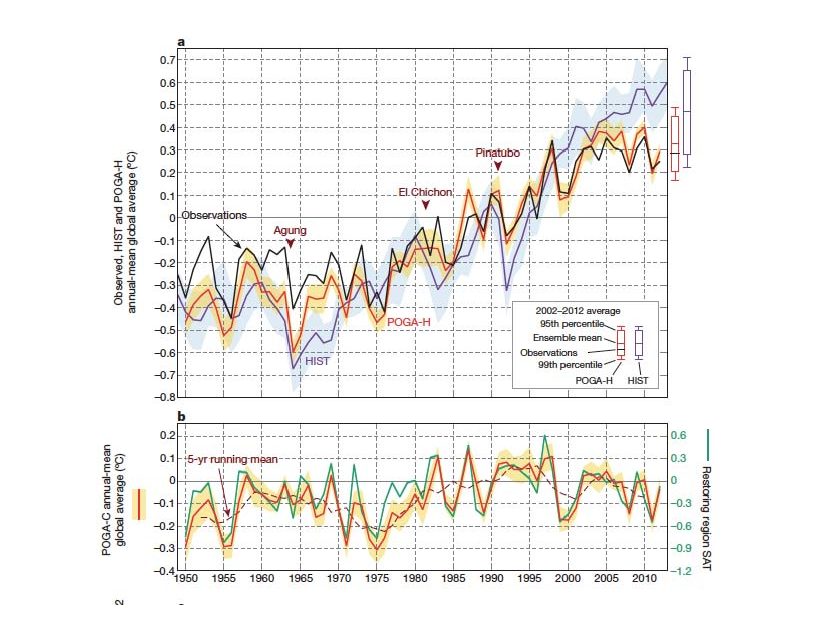

Die weiteren Ausführungen folgen dem Artikel der renommierten US-Klimaforscherin Judith Curry, für Details wird auf ihren Aufsatz verwiesen (hier). KX verwenden das bekannte GFDL Modell (hier) und führten damit Simulationen durch. Diese unterschieden sich durch die in das Modell eingesetzten Klimaantriebe. Neu an der Arbeit von KX war die Berücksichtigung der gemessenen Meerestemperaturanomalien im östlichen äquatorialen Pazifik. Die Ergebnisse der Modellrechnungen zeigt Fig. 1

Fig. 1: Maßgebend sind die beiden rotgelben Kurven oben und unten. Oben wird die Messung gezeigt, unten das Modellergebnis OHNE den Einfluss des anthropogenen CO2, also nur durch die interne natürliche Variabilität verursacht. Die gute Übereinstimmung beider Kurven ist verblüffend gut.

Die Messung zeigt von 1975-1998 einen Temperaturanstieg von 0,68 °C, das Modell von 0,4 °C. Somit kann das Modell von KX mehr als die Hälfte der globalen Erwärmung mit natürlicher Klimavariabilität erklären. Bisher wurde dagegen die Erwärmung seitens der AGW-Verfechter und des IPCC ausschließlich dem anthropogenen CO2 zugeschrieben.

Das Ergebnis von KX passt zudem bestens mit den Temperaturänderungen zusammen, die man aus guten, bis etwa 2000 Jahre zurückreichenden Proxy-Reihen entnehmen kann. So enthält z.B. die Proxy-Reihe von Christiansen/Ljungqvist bereits vor 1700 n.Chr. (hier) mehrfach Temperatursteigerungen, aber auch Temperaturabfälle, die die des 20. Jahrhunderts an Stärke und Geschwindigkeit übertreffen. In zwei Publikationen des Verfassers (hier, hier) wird außerdem gezeigt, dass der Temperaturabstieg des 19. Jahrhunderts in seiner Stärke dem erneuten Anstieg im 20. Jahrhundert nicht maßgebend nachsteht. Anthropogenes CO2 erscheint daher zur Erklärung des globalen Temperaturverlaufs im 20. Jahrhundert nicht erforderlich, und die Klimasensitivität des CO2 wird mit hoher Wahrscheinlichkeit vom IPCC stark überschätzt.

Es wäre pikant, wenn ausgerechnet Klimamodelle, deren Versagen der bekannte Klimaforscher Hans von Storch in einem SPIEGEL-Interview beklagte (hier), zwar einen ihrer vielen Mängel (nämlich die aktuelle globale Abkühlung nicht erklären zu können) zu beheben vermögen, dies aber nur zu dem Preis eines "Freispruchs für das anthropgene CO2".

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Admin, ich habe am 08.09.13 18:41 zu #26: Paul Niederwieser eine Antwort geschrieben, besonders auch deshalb, weil er schon wieder gegen Forenregeln verstößt!!!

Hat er Sonderrechte, andere beleidigen zu dürfen?

mfG

#26 Paul Niederwieser

„“Der 15µm Frequenzteil aus dem Weltraum einschließlich der Atmosphäre selbst (CO2) erreicht nicht die Erdoberfläche“

richtig, aus dem „Weltraum“, was auch immer sie damit meinen, sicher nicht.“

Hallo Herr Niederwieser

auch im saukalten Weltraum gibt es IR-Strahlung. Wohin sollte die Erde, alle Sterne, Planeten und was sonst noch Wärme abgibt denn strahlen?

„Gleiches gilt für „CO2″ IR Emissionen aus einigen km Höhe, aber eben nicht aus geringerer Höhe.“

Mit der „geringeren Höhe“ meinen Sie vermutlich bestenfalls ein paar Meter oder besser noch Zentimeter wenn Sie sich auf die Ebene beziehen, die für uns Menschen bewohnbar ist.

mfg

herzlichen Dank Dr. Paul:

„#24: Paul Niederwieser, wissen Sie nicht was die Transmission eines Mediums ist?

Durchlässigkeit für elektromagnetische Strahlung.

Das Medium ist hier die Atmosphäre.

Sie liegt zwischen 0 (intransparent) und 1 (transparent).“

Na jetzt weiß ich das endlich, danke!-)

„0 für den 15µm-Bereich gilt praktisch für die ganze Troposphäre…“

praktisch?

„..und bedeutet,

Der 15µm Frequenzteil der thermischen Erdemission erreicht nicht den Weltraum“

nicht direkt vom Boden, richtig.

„Der 15µm Frequenzteil aus dem Weltraum einschließlich der Atmosphäre selbst (CO2) erreicht nicht die Erdoberfläche“

richtig, aus dem „Weltraum“, was auch immer sie damit meinen, sicher nicht. Gleiches gilt für „CO2“ IR Emissionen aus einigen km Höhe, aber eben nicht aus geringerer Höhe.

„Erklären muss ich gar nichts,

das ist ein Messergebnis!“

tja, da haben sie eben die Messungen falsch interpretiert und es spricht für sie, wenn sie besser nichts erklären versuchen, bzw. wenn sie es einfach sein lassen würden. Kaum vorstellbar, dass irgendjemand Nutzen aus ihren „Erklärungen“ ziehen könnte. In welchem Fach haben sie eigentlich ihre Dissertation geschrieben od. ist Dr. ihr Vorname?

„Aber da es die CO2-Treibhaustheorie widerlegt,

wurde das mindestens 20 mal ignoriert.“

Ignoranz wäre definitiv die richtige Antwort auf derartiges Geschwurbel. Nichts für Ungut, aber es ist sehr offensichtlich, dass sie mit Physik und im Speziellen mit der Physik der Atmosphäre (Meteorologie) gröbere Berührungsängste haben.

#24: Paul Niederwieser, wissen Sie nicht was die Transmission eines Mediums ist?

Durchlässigkeit für elektromagnetische Strahlung.

Das Medium ist hier die Atmosphäre.

Sie liegt zwischen 0 (intransparent) und 1 (transparent).

0 für den 15µm-Bereich gilt praktisch für die ganze Troposphäre und bedeutet,

Der 15µm Frequenzteil der thermischen Erdemission erreicht nicht den Weltraum =

Der 15µm Frequenzteil aus dem Weltraum einschließlich der Atmosphäre selbst (CO2) erreicht nicht die Erdoberfläche.

Erklären muss ich gar nichts,

das ist ein Messergebnis!

http://tinyurl.com/cvrssgr

Erklärt wurde das hier bei EIKE mindestens schon 20 mal.

Aber da es die CO2-Treibhaustheorie widerlegt,

wurde das mindestens 20 mal ignoriert.

Es hängt zusammen mit dem energetischen Austausch zwischen CO2, das hier absorbieren kann und nicht strahlenden Nachbarmolekülen und ist eine zeitabhängige quantenmechanische Wahrscheinlichkeitsverteilung,

die sich folglich mit der Nähe der Nachbarmoleküle = Gasdichte ändert.

mfG

Dr. Paul#23:

„Die „Empirie“ liegt hier, nebenbei gesagt, in der fehlenden CO2-Gegenstrahlung (Transmission 0 bei 15µm)“

Oha, interessant. Weil (korret: t=0, 15ym) gibt es keine CO2 DLR?

Das müssten sie aber schon erklären versuchen:-)

#20: Paul Niederwieser fragt:

„“Zudem bin ich eher bekannt als Kritiker von „Klimatheorien“, die man empirisch widerlegen kann.“

Die da wären?“

Das einzig wichtige ist hier, damit man sich nicht verzettelt,

die Hypothese, dass CO2 in der Atmosphäre die Erdoberfläche durch sog. „Gegenstrahlung“ erwärmen könnte, noch völlig falsch tituliert mit „Treibhauseffekt“.

Und ganz kühne Wissenschaftler machen da sogar quantitative Strahlungsbilanzen,

die einem Strahlungsphysiker die Schamröte ins Gesicht treiben müsste z.B. thermische Strahlung ohne Strahlungsquelle (Temperatur).

Aber (fast) alle schweigen und akzeptieren das stillschweigend:

http://tinyurl.com/lrvupp

Es ist beleidigend und unentschuldbar,

daher dieses forum!

Die „Empirie“ liegt hier, nebenbei gesagt, in der fehlenden CO2-Gegenstrahlung (Transmission 0 bei 15µm)

mfG

#20: Paul Niederwieser, das war doch schon mal ein vernünftiger Anfang!

Wolken kühlen also, worauf ja die Hypothese von Henrik Svensmark beruht, die immer heftig todgeschwiegen wird 🙂

Mein link (erstes Diagramm) war selbstverständlich KEIN Modell,

den Unterschied müssen Sie noch lernen:

„This is not a pure theoretical consideration, but is demonstrated by observations (see diagram below).“

steht genau für dieses Diagramm bei climate4you,

ich bin ja ganz begeistert, dass Sie diese sehr gute Quelle erwähnt hatten,

direkt darunter ist dieses Diagramm:

http://tinyurl.com/ozotag7

das das gleiche zeigt.

Dass Wolken im Detail extrem schwierig quantitativ zu berechnen sind, besonders weil die Dinger sich ja ständig verändern, ist unbestritten, wie das Wetter selbst.

Jedenfalls korrelieren Sie mit der Temperatur,

CO2 nicht.

mfG

@ Gunnar

„hat man leider die Aufmerksamkeit an natürlichen Klimaschwankungen verloren. Anstatt zu versuchen, diese endlich hablbwegs befriedigend zu erforschen,…“

Sehe ich nicht so. Natürliche Klimaschwankungen standen immer schon im Interesse. Möglicherweise ist das Paper von Kosaka und Xie ein großer Schritt vorwärts, was den Zeitraum von ca. 1945-75 angeht:

Da gab es ja zwei Denkschulen: Eine meint, dass die CO2-Wirkung von steigenden Aerosolen kompensiert wurde, die andere, dass dafür dekadische Meeresströmungen verantwortlich sind.

Meine subjektive Laienmeinung dazu:

Der Trend geht klar in Richtung Meeresströmungen, was tendenziell auf eine Klimasensitivität von unter 3° hindeutet, eher so um 2,5° herum.

Und um Missverständnisse zu vermeiden: Das ist meine Laienmeinung, es gibt Wissenschaftler, die da eine viel bessere Intuition und Übersicht besitzen.

oha, Dr.Paul #8:

„Zudem bin ich eher bekannt als Kritiker von „Klimatheorien“, die man empirisch widerlegen kann.“

Die da wären?

„Wenn Sie (Anm. Innerhofer) z.B. meinen, dass Wolken erwärmen, dann ist das falsch und Ihr persönliches Problem.

siehe z.B.:“

http://tinyurl.com/cz2kmuv

Der Link zeigt ein Modell! Siehe auch

http://www.climate4you.com/

zweites Drittel unten (zuerst auf clouds klicken und den Rest anschaun würde auch helfen…)

Klar ist dabei, dass alle Wolken auf die bodennahe Temperatur erwärmend wirken und zwar kräftig, solange die Sonne nicht „scheint“.

Bei Einstrahlung der Sonne werden die Umstände sehr komplex und wie Innerhofer korrekt bemerkt hat, wirken einige Wolken selbst tagsüber erwärmend. In Summe sagt die Wissenschaft aber, kann bei Zunahme der globalen Bewölkung von einem Kühleffekt ausgegangen werden.

Aber, diese Pauschalierung ist mit Vorsicht zu interpretieren. Sie geht nämlich davon aus, dass die Bewölkung dann am ganzen Globus gleichmäßig zu- od. abnimmt, inkl. aller beteiligten Wolkentypen und dazu wurde das Modell siehe Link berechnet.

Jetzt könnte die Bewölkung z.B. global betrachtet zunehmen, die Zunahme von ein paar % würde aber wegen gewisser Oszialltionen bzw. natürlicher Klimaschwankungen hauptsächlich in Breiten höher 60°N/S erfolgen, ansonst bleibt die Bewölkung in der Annahme unverändert. Dies hätte unweigerlich die Konsequenz, dass die Zunahme auch eine Zunahme der globalen Mitteltemperatur zur Folge hätte. Umgekehrt würde zb. eine Zunahme in den mittleren Breiten eine deutliche Abkühlung dort und in Summe dann auch global bewirken, mit der Einschränkung, dass dies auch nicht für alle Wolkentypen gilt.

Man sieht also, dass doch etwas mehr als „Laienwissen“ wie es Namenskollege Paul nennt erforderlich ist, um Wolken besser zu verstehen.

#12: Gunnar Innerhofer Ihre xxxxxxxxxxxxxxxxx

Ihre lächerliche Polemik ohne Argumente gegen Gerlich z.B.

Sie lehnen wie viele Treibhaustraumtänzer die Diskussion über die Existenz des sog. „CO2-Treibhauaseffektes“ kategorisch ab

und bestehen darauf, nur über seine Höhe zu diskutieren. Sehr sehr wissenschaftlich, da stören natürlich auch Wolken.

Man könnte ja auf die ketzerische Idee kommen, dass diese das gewünschte nicht messbare CO2-forcing einfach übernehmen.

http://tinyurl.com/cz2kmuv

mfG

hi Fischer #17,

ja eh, Xie et al sagen ja selbst, es mögen max. 0,2°C Beitrag sein und das ist ja am Ende auch nichts Neues. Wir sehen diese pekas immer wieder bei ausgeprägten positiven od. negativen Phasen.

Currys Interpertation ist freilich Nonsens, auch schon deshalb, weil sie tatsächlich zwei Einzeljahre raus klaubt. Das ist genau genommen peinlich.

Mir persönlich ist ja, wie alle wissen klar, dass seit geraumer Zeit ein fürchterlicher Fehler in die Klimawissenschaft eingezogen ist. Man geht trotz der großen Unsicherheiten von einem bestimmten forcing durch THG aus, welches dann mit einem darauf basierenden gloablen T Anstieg korrelieren soll. Da dieses forcing lt. IPCC Gemeinde alle natürlichen Einflüsse klar übersteigt, hat man leider die Aufmerksamkeit an natürlichen Klimaschwankungen verloren. Anstatt zu versuchen, diese endlich hablbwegs befriedigend zu erforschen, versteckt man sich nun in den relativ einfachen Modellierungen über Treibhausgasemissionen und diversen Feedbacks und übersieht dabei, dass man wahrscheinlich einen Faktor 2 Fehler macht. Bezieht man einen solchen ein, wird auch der T Verlauf über die letzten 150a viel besser erklärbar, insbesondere der von ca. 1900 bis 1940 und der der letzten 15a.

@ Gunnar Innerhofer (Re #1)

„Kleine Korrektur vielleicht. Sieht man sich die zwei Abbildungen besser an, sollte man schreiben: die gemessene Erwärmung ab ca. 1970 bis heute beträgt ca. 0,6°C, davon sind 0,3°C, also die Hälfte über die PDO zu erklären.“

Ich fürchte, Curry irrt. Und zwar in ihrer Interpretation von POGA-C als rein natürlich getriebene Entwicklung.

Vorsicht: In den POGA-C läufen werden zwar die eternen Forcings konstant gesetzt. Es fließen aber die tropischen Meeresoberflächentemperaturen ein, und die beinhalten ja den Effekt des global warmings. Gut, könnte man sagen, aber das geschieht ja gerade mal auf 8% der Erdoberfläche, auf dem Rest passiert ja nichts. Dann hätte man aber die Kernaussage des Papers übersehen, nämlich wie bedeutsam gerade diese 8% für das globale Temperaturgeschehen ist.

Viel substanzieller als Currys Schnellschuss finde ich folgenden Beitrag von J. Nielsen-Gammon, siehe http://tinyurl.com/l2hvfu4

Was meinst du bzw. die anderen Leser dazu?

@ #15

Es hätte natürlich AMO (Atlantic Multidecadal Oscillation) heißen müssen.

„Die GCM`s „berechnen“ das zukünftige Auftreten od. gar die Stärke dieser nicht, deshalb auch immer die Ansage, dekadische, natürliche Klimavaraitionen.“

Was denn im Klartext heißt, daß die gekoppelten GCM diese natürlichen Prozesse nicht abbilden können (ohne Manipulation durch entsprechendes Forcing keine akzeptable Nachvorhersage (hindcast) produziert haben, sondern nur irgendeine mittlere Statistik). Daraus folgt dann deren Unbrauchbarkeit zu Vorhersagezwecken wie beispielsweise der periodisch in Nordamerika auftretenden Dürren vom Typ Dustbowl, die enorme ökonomische und ökologische Auswirkungen haben.

Bestes Beispiel für derartige Fehlvorhersagen ist die Aussage von Mojib Latif zum Auftreten von mitteleuropäischen Wintern der Klasse der Jahre 1962/63, 1963/64 und 2009/2010, den es ja gar nicht mehr hätte geben dürfen.

Natürliche Klimavariationen, die man nicht kannte und die die GCM nicht – obwohl ja die Physik korrekt repräsentiert wird? – simulieren konnten? Ob man deshalb die Aussagen der Modellergebnisnutzer noch als vertrauenswürdig ansehen darf?

Heinzow#14:

„die NAO, PDO und NAO und deren Folgen zu simulieren, bevor diese Oszillationen entdeckt wurden.

Wie sieht es denn damit aus, Herr Innerhofer? Konnten die das?“

wie? zwei mal NAO und einmal PDO? Nein, kann ich nicht.

Aber, der Begriff „Oszillation“ sollte auch ihnen was sagen…

Die GCM`s „berechnen“ das zukünftige Auftreten od. gar die Stärke dieser nicht, deshalb auch immer die Ansage, dekadische, natürliche Klimavaraitionen.

@ #13

Die Güte der sog. „Klimamodelle“ kann man problemlos daran messen, ob sie ohne spezielles Forcing in der Lage gewesen sind die NAO, PDO und NAO und deren Folgen zu simulieren, bevor diese Oszillationen entdeckt wurden.

Wie sieht es denn damit aus, Herr Innerhofer? Konnten die das?

hi axel#10,

habe nur drauf gewartet, dass von dir der „Wink“ zum Modell kommt:-)

Fällt leider immer wieder auf, dass Klimamodelle hier pauschal als Müll dargestellt werden, außer eben…

Paul:

„#1: Gunnar Innerhofer, trotz Ihrer schweren Erkrankung müssen Sie uns doch noch erklären was denn der THE ist.“

Schön Paulchen, wenn sie mir eine Ferndiagnose machen können, herzlichen Dank. Aber welche schwere Erkrankung habe ich nun?

Wenn sie das erraten, werden sie auch bald drauf kommen, was der THE ist.

(Sie können sogar bei G&T nachfragen, die zwei armen sind mittlerweile so still geworden, es würde sie sicher freuen wenn sie merken, es gibt da draussen noch einen, der ihre Irrtümer noch immer nicht verstanden hat:-)

#5

„Da spricht ja die ganz große Erfahrung…“

Teufel, von Programmieren habe ich keine Ahnung. Aber Programmierer dazu zu zwingen, Modelle so zu entwickeln, wie der Kunde es will, ist mein Job. Wer das Wort „unmöglich“ in den Mund nimmt, wird ausgetauscht. Und die Software entspricht als Endergebnis eben exakt den Erwartungen des Geldgebers. Auf Klimamodelle zurückzukommen: Erwartet der Auftraggeber 2 Grad bei der Verdopplung des CO2, werden es zwei, erwartet er 4 Grad, werden es vier. Die Zahl wird in der Regel nicht ausgesprochen, es reicht das Wissen, bei welchen Ergebnissen der Auftraggeber glücklich sein wird, und bei welchen der Auftrag verloren geht.

Das nebenbei die Simulation einer Vorgabe aus der Vergangenheit ähneln muss ist eine Selbstverständlichkeit und für Profiteams keine Herausforderung. Da keiner das Ergebnis überprüfen kann (das Klima in 30 bis 100 Jahren!), haben die Entwickler einen riesigen Spielraum, mit unüberprüfbaren Algorithmen das erwartete Ergebnis zu simulieren.

Nun, in den letzten Jahren hat die Natur sich anders entwickelt als die Simulationen, wo ist das Problem, dann wird eben an den Algorithmen ein wenig verändert… schon wird das Erwärmungsloch in der Simulation doch angezeigt… Wenn in 10 Jahren man wieder 0,5 Grad drüber oder drunter liegt… wo ist das Problem…Für Profis in Null Komma Nichts integrierbar.

Die Simulation als Kopie der Natur zu betrachten setzt eine Mischung aus Naivität, Unwissen und unendliche Überheblichkeit voraus.

Eine hochinteressante Studie, die nebenbei auf einem Klimamodell beruht.

#1: Gunnar Innerhofer, trotz Ihrer schweren Erkrankung müssen Sie uns doch noch erklären was denn der THE ist.

mfG

#6: Gunnar Innerhofer, weil Sie mich schon wieder erwähnen,

ich kommen leider in dem Beitrag von Herrn Prof. Lüdecke mit keinem Wort vor!

Zudem bin ich eher bekannt als Kritiker von „Klimatheorien“, die man empirisch widerlegen kann.

Wenn Sie z.B. meinen, dass Wolken erwärmen, dann ist das falsch und Ihr persönliches Problem.

siehe z.B.:

http://tinyurl.com/cz2kmuv

Das ist nun mal sogar Laienwissen 🙂

Oder haben Sie als „Experte“ mal unter Wolkeneinfluss geschwitzt?

mfG

#6 Und schon wieder beginnen Sie mit Beleidigungen bzw. Unterstellungen. Lassen Sie das doch einfach mal, vielleicht können wir uns dann konstruktiv austauschen. Ihre Sichtweise scheint zumindest nicht dem Alarmismus zu folgen. Für mich gehören Sie am ehesten in die Kategorie „ein bißchen ATHE, aber keine Katastrophe“. Gehen Sie mal davon aus, dass mir die Annahmen des „anthropogenen“ Treibhauseffekts sehr vertraut sind und ich sowohl die Arbeiten von Gerlich als auch das Papier von Ebel sehr gut verstehe. Ich beleidige Sie doch auch nicht aus eigenem Antrieb (ich wehre mich lediglich), und von Physik verstehe ich auch eine ganze Menge. Ob ich hochintelligent bin (vielleicht, vielleicht auch nicht) oder eine Dumpfbacke („meine Freunde nennen mich 75“, oder war´s 65 ?), spielt in diesem Zusammenhang keine Rolle.

@ Schlohr #3

ich unterstelle ihnen nicht Dummheit, wenn dann gravierende Mängel in Klimatologie, Meteorologie und Physik im Allgemeinen. Sie können dennoch ein hoch intelligenter Mensch sein. Zu solchen Themen haben sie aber offensichtlich nichts sinnvolles beizutragen.

Übrigens, man weiß sehr wohl einiges über Wolken und seit es zuverlässige Sat. Daten gibt auch über globale Änderungen. Wenig weiß man nur über mögliche Änderungen in der Zukunft und da haben sie recht, dass kann viel ausmachen. Aber, um zB. auf Pauls Milchmäditherorie zurück zu kommen: mehr Wolken = Abkühlung?

Vereinfacht gesagt, haben fast alle Wolkentypen unterscheidliche Auswirkungen, einige wirken insgemsamt erwärmend, andere kühlend, weil eben zB. die Albedo stärker wirkt, als die Gegenstrahlung und umgekehrt. Die stärkste Kühlung durch Wolken allg. finden sie in mittleren Breiten um 50°N. In polaren Regionen wirken Wolken fast immer stark erwärmend (auf die bodennahe T bezogen) und in den Tropen ist es ziemlich ausgeglichen. Eine schwierige Sache, aber man weiß gut Bescheid, zu gut um behaupten zu können, mehr Bewölkung würde unbedingt zu einer Abkühlung führen.

„Ein Computermodell zeigt exakt das an, was der Modellentwickler angezeigt haben will. “

Da spricht ja die ganz große Erfahrung…

wie ich oben schon anmerkte,

dazu die Antwort von Xie auf Currys Formulierung:

siehe Link im Artikel, dann etwas scrollen:

1975 was a La Nina year, and 1998 followed the strongest El Nino in the instrumental record. My estimate indicates that the El Nino-La Nina difference accounts for 0.2-0.3 C difference of her 0.4 C in POGA-C. So for multi-decadal trend, PDO accounts for only 0.1-0.2 C for the longer period of 1950-2010

Aber immerhin und dann gibt´s da ähnliche Bezüge zur NAO und eben das lange solar max von ca. 1980 bis knapp 2010.

Summasummarum werden es gut 50% sein, was die natürliche Klimaänderung über das 20. Jahrhundert bis heute ausgemacht hat.

Herr Innerhofer: Können Sie ausschließen, dass sich die „mittlere“ Bewölkung NICHT verändert hat ? Eine minimale Veränderung der Bewölkung, und dazu gibt es kaum Daten und simulieren kann man die Bewölkung bis heute nicht (geben sogar die Simulierer zu), bringt Ihnen leicht die Energie (in W/m^2), die dem „anthropogenen Treibhauseffekt“ im „Rückstrahlungsmodell“ zugeordnet wird. Wenn es keine gesicherten Daten über die Bewölkung gibt, würde ich mich mit den 0,3 K nicht zu weit aus dem Fenster lehnen. Und schon wieder beleidigen Sie implizit die „Skeptiker“. Lassen Sie es doch einfach mal, anderen Dummheit und Ignoranz zu unterstellen. Sie stellen sich damit nur in ein schlechtes Licht.

Ein Computermodell zeigt exakt das an, was der Modellentwickler angezeigt haben will.

Die Modellentwickler der Klimamodelle bekommen sehr viel Geld und mediale Aufmerksamkeit, wenn ihre Modelle einen Zusammenhang CO2 – Temperaturanstieg anzeigen. Welch eine Wunder, genau das zeigen die Modelle an! Nun, die Prognose haute nicht hin, also suchte man einen Grund. Die Ozeane mussten hinhalten. Schnell das Modell angepasst, nun stimmen Modell und Wirklichkeit der letzten jahre wieder überein. Das kann man alle paar Jahre wiederholen…

Was hat das aber mit Wissenschaft oder gar mit der Natur zu tun?

Sehr geehrter Herr Lüdecke,

danke für diesen Beitrag!

Endlich mal eine PDO Studie in nature mit einem interessanten und glaubwürdigen Ergebnis.

Kleine Korrektur vielleicht. Sieht man sich die zwei Abbildungen besser an, sollte man schreiben: die gemessene Erwärmung ab ca. 1970 bis heute beträgt ca. 0,6°C, davon sind 0,3°C, also die Hälfte über die PDO zu erklären. (Einzeljahre raus zu pieken ist nie gut…).

Und wenn dann noch um die 0,3K dem zunehmenden THE zukommen, sind wir genau dort, was ich immer wieder zeigen versuche und andere Skeptiker auch und wir reden hier zB. von Leuten wie Lindzen, Spencer, Akasofu usw. usw.