Fangen wir mit dem zweiten Argument an. Die Erde ist seit der Kleinen Eiszeit um 1850 wärmer geworden. Darüber herrscht generelles Einverständnis. Siehe hierzu z. B. Akasofu. Damit hat Climategate nichts zu tun.

Beim zweiten Argument, der Datenintegrität, liegen die Dinge anders.

„Ja“, gab man zu, “diese Burschen haben E-mails gelöscht und verhindert, dass in Wahrnehmung der Rechte aus dem Informationsfreiheitsgesetz zugegriffen werden konnte. Sie haben Proxy-Daten durcheinander gebracht, sie haben die Veröffentlichung anderer Wissenschaftler-Papiere unterdrückt … das hat aber alles mit den Daten nichts zu tun. Die stimmen immer noch.“ Klingt doch vernünftig?

Es gibt drei globale Datenbestände. Einer davon liegt bei der CRU (Climate Research Unit of the University of East Anglia). Ein anderer liegt bei NOAA/GHCN (Global Historical Climate Network), den dritten führt die NASA/GISS (Goddard Institute for Space Studies). Alle drei nehmen die Rohdaten und „homogenisieren“ sie, um zu berücksichtigen, wenn z. B. eine Messstation in eine wärmere Umgebung versetzt wird und dann ein 2 C Grad-Sprung stattfindet. Die drei globalen Temperaturdatenbestände werden gemeinhin CRU, GISS, GHCN genannt. Sowohl GISS als auch CRU erhalten fast alle ihre Rohdaten vom GHCN. Alle drei Datenbestände erzeugen aus den Rohdaten sehr ähnliche Temperaturverläufe.

Ich bin noch mit meinem mehrjährigen Versuch beschäftigt, die Klimadaten zu verstehen. Man weiß nie, wohin das führt. Dieses mal bin ich in Australien gelandet und habe dabei an Professor Wibjorn Karlens Aussage über Australien gedacht, die ich hier zitiert habe:

Noch ein Beispiel ist Australien. NASA [GHCN] präsentieren nur 3 Stationen, die die gesamte Zeitspanne von 1897 – 1992 abdecken. Auf welcher Art von Daten beruht also das IPCC-Australien-Diagramm?

Falls da überhaupt ein Trend ist, dann eine leichte Abkühlung. Falls man eine kürzere Periode wählt (1949-2005), dann steigt die Temperatur beachtlich an. Die Australier haben viele Messstationen und haben mehr detaillierte Karten und Trends über Veränderungen veröffentlicht.

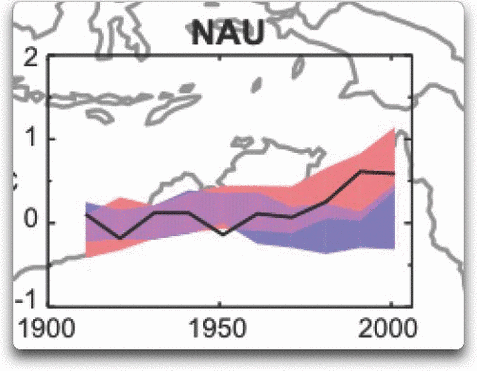

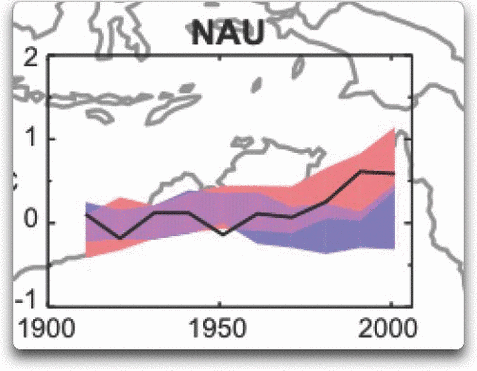

Die CRU-ler haben Wibjorn gesagt, dass er einfach völlig daneben läge. Hier kann man sehen, was sie für richtig erklärten. Es ist die Datenreihe 9.12 aus dem 4. Auswertebericht des IPCC (AR4) , die Wibjorn meinte. Sie zeigt Nord Australien:

Abb. 1. Temperatur-Trends und Modellrechnungs-Ergebnisse für Nord-Australien. Die schwarze Line sind die Messungen (Aus Fig. 9.12 des UN IPCC AR4). Betrifft das Gebiet von 110 Grad Ost bis 155 Grad Ost und von 30 Grad Süd bis 11 Grad Süd. Beruht auf den Landdaten von der CRU.

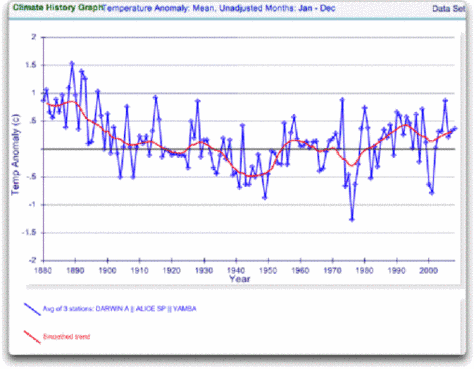

Aus den veröffentlichten CRU E-Mails kam ans Licht, dass die CRU als Eingangs-Rohdaten den Datenbestand des Global Historical Climate Network (GHCN) benutzt. Also habe ich mir den GHCN-Datenbestand mal angesehen. Da gibt es drei Stationen für Nord Australien, ganz so wie Wibjorn gesagt hat und überhaupt nur neun Stationen für ganz Australien für den Zeitraum von 1900 – 2000. Hier sind die unveränderten Daten von diesen drei nördlichen Messstationen (Quelle: AIS)

Abb. 2. GHCN Rohdaten, Alle Messstationen über 100 Jahre für das vorher genannte IPCC-Gebiet.

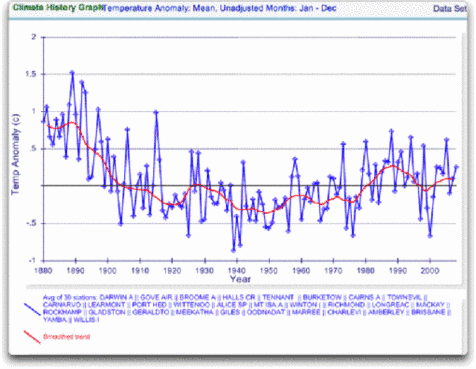

Und wieder hat Wibjorn recht, das sieht dem IPCC-Temperaturverlauf für Nord Australien gar nicht ähnlich. Dazu kann man aber noch nichts sagen. Wibjorn zeigte nur 3 Messstationen. Drei sind nicht viel, ist aber alles, was wir im IPCC Jahrhundertbericht für das bezeichnete Gebiet haben. Nun werfen wir mal mehr Daten in diesen längsten Messstationsbericht ein. Dies sind die Daten für das vom IPCC benannten Gebiet von jeder Messstation bis zum Jahr 2000, ohne Rücksicht darauf, wann die Aufzeichnungen begannen. Es sind 30 an der Zahl.

Abb. 3. GHCN Rohdaten. Alle Stationen bis 2000 im IPCC Gebiet.

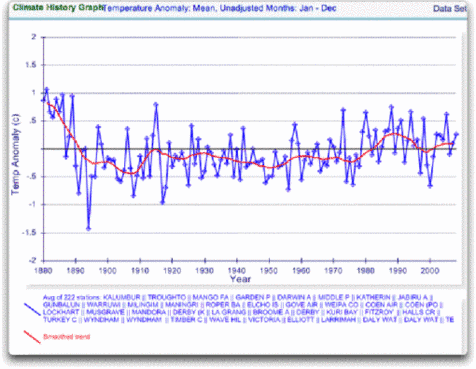

Immer noch keine Ähnlichkeit mit dem IPCC. Deshalb habe ich mir jede Station im Gebiet einzeln angeschaut. Es waren 222. Hier ist das Ergebnis:

Abb. 4. GHCN Rohdaten. Alle Stationen bis 2000 im IPCC Gebiet.

Abb. 4. GHCN Rohdaten. Alle Stationen bis 2000 im IPCC Gebiet.

Jetzt sieht man, warum Wibjorn Bedenken hatte. Es sieht wirklich nicht nach den IPCC-Daten aus, die von der CRU stammen, die wiederum auf den GHCN-Daten beruhen. Wo liegt der Unterschied?

Nun, alle diese Grafiken benutzen die rohen GHCN Daten. Das IPCC aber benutzt “justierte” (adjusted) Daten. Das GHCN justiert die Daten, um sogenannte “Inhomogenitäten” zu beseitigen. Daher habe ich mir gleich die erste Station auf der Liste angesehen, Flughafen DARWIN. Ich wollte wissen, wie so eine Inhomogenität vor Ort aussieht. Und ich habe herausbekommen, wie hoch die GHCN-Justierung für DARWIN war.

Zuvor aber: was ist eine Inhomogenität? Besser als GHCN kann man es nicht sagen:

Die meisten Langzeit-Messstationen waren Veränderungen ausgesetzt, die deren Messdatenreihen inhomogen machten. Es gibt viele Ursachen dafür, u.a. Änderungen der Messinstrumente, der Gehäuse, der Umgebung der Gehäuse, des Aufstellungsorts zur Zeit der Aufzeichnung und auch bei den Verfahren zur Ermittlung der Durchschnittstemperaturen. Oft kommen die Änderungen zur gleichen Zeit gehäuft vor, z. B., wenn automatisierte Wetterstationen eingeführt warden, wie es in vielen Weltteilen vorkommt. Wenn man derartige Klimadaten verlässlich für Langzeitanalysen der Klimaveränderung nutzen will, müssen Justierungen vorgenommen werden, um die nicht-klimatischen Unregelmäßigkeiten zu berücksichtigen.

Das macht Sinn. Die Rohdaten werden Sprünge aufweisen, wenn die Station umzieht. Wir wollen doch nicht auf eine Erwärmung schließen, nur weil das Thermometer in einer wärmeren Umgebung steht. Das mag zwar unangenehm sein, aber wir müssen es berücksichtigen.

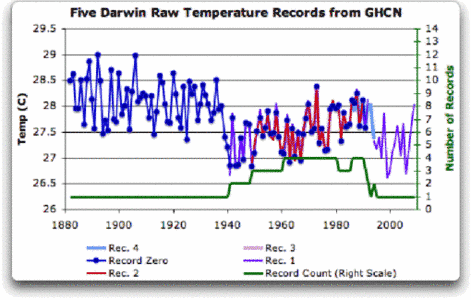

Ich pflege immer mit den allerrohesten Daten anzufangen, um „Justierungen“ zu erkennen. Für DARWIN gibt es fünf getrennte Stationsaufzeichnungen, die zu einer einzigen DARWIN-Aufzeichnung zusammengefasst wurden. Hier sind die Einzelaufzeichnungen der Stationen von dort, von Station Record zero bis Rec. 4 durchnummeriert.

Quelle: http://data.giss.nasa.gov/cgi-bin/gistemp/findstation.py?datatype=gistemp&data_set=0&name=darwin

Abb. 5. Fünf einzelne Temperaturaufzeichnungen von DARWIN, dazu in grün die Stationszählung. Diese Rohdaten sind vom GISS heruntergeladen. GISS benutzt die GHCN Rohdaten als Ausgangsbestand für deren Analyse.

Für DARWIN gibt es einige Vorzüge gemessen an anderen Stationen mit Mehrfachaufzeichnungen. Es gibt eine durchlaufende Aufzeichnung seit 1941 bis zur Gegenwart (Station 1). Es gibt auch eine durchlaufende Aufzeichnung für ein ganzes Jahrhundert. Die Stationen stehen in enger Übereinstimmung über die gesamte Aufzeichnungsperiode. Man kann das tatsächlich daran erkennen, dass die Linien mehrerer Stationsdaten so eng beieinander liegen, dass sie hinter der Linie von Station Zero verborgen sind.

Das ist eine ideale Station, weil man daran viele Probleme veranschaulichen kann, die bei den rohen Stationsdaten existieren.

- • Keine einzige Aufzeichnung überdeckt die gesamte Periode.

- • Die kürzeste Aufzeichnung ist nur neun Jahre lang.

- • In nahezu allen Aufzeichnungen sind Lücken von einem Monat und mehr.

- • Um 1941 herum scheint es Probleme bei den Daten gegeben zu haben.

- • Bei den meisten Datenreihen fehlen einige Monate.

- • Für die gesamte Zeitdauer gibt es wenig Nachbarstationen.

- • Für kein einziges Jahr gibt es Aufzeichnungen aller fünf Stationen zugleich.

- • Die Temperatur ist über einen Sechsjahreszeitraum gefallen, von einem Höchstwert 1936 bis auf einen Niedrigwert 1941. Die Station zog 1941 um, was aber war in den sechs Jahren zuvor?

Wenn man Stationsaufzeichnungen auswertet, kommt die persönliche Beurteilung ins Spiel. Zuerst einmal ist zu entscheiden, ob überhaupt etwas verändert werden muss. Das wird bei DARWIN eng. Der Datenreihe scheint um 1941 herum durcheinandergebracht worden zu sein, nicht aber im Jahr des Umzugs.

Obschon der 1941er Temperatursprung groß zu sein scheint, sehe ich einen ähnlichen Sprung zwischen 1992 und 1999. Betrachtet man das Gesamtbild, so sollte man alles so lassen, wie es ist. Das ist das Beste, wenn man keine anderen Hinweise hat.

Oberstes Prinzip: nichts verändern!

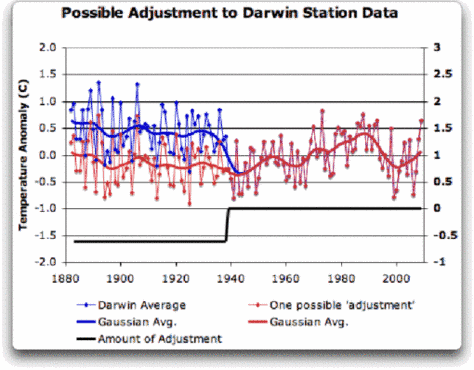

Aber es gibt eine Begründung, warum man etwas ändern sollte, vor allem wegen des 1941er Umzugs. Wenn ich mich für eine „Justierung“ entscheide sollte, dann sähe das so aus:

Abb. 6. Eine mögliche „Justierung“ für DARWIN. Die schwarze Linie (rechts skaliert) zeigt den Gesamtbetrag der Justierung an. Darunter die Zeitskala.

Ich habe die vor-1941-Daten um etwa 0.6 C vermindert. Beim Verlauf vom Anfang bis zum Ende erhalten wir eine kleine Änderung bei meinen „justierten“ Daten (rote Linie). Es gibt weder Erwärmung noch Abkühlung. Die offensichtliche Abkühlung in den Rohdaten nach 1941 aber wird abgeschwächt. Wo die anderen Linien sich überdecken, liegen die Aufzeichnungsdaten dicht beieinander. Daran ändere ich überhaupt nichts. Warum sollten wir das tun, wenn sie alle genau das Gleiche anzeigen?

So also würde ich die Daten homogenisieren, wenn ich müsste. Aber ich bin überhaupt dagegen, weil damit nur eine Stationsreihe (DARWIN Zero) geändert würde, und die übrigen im Urzustand blieben.

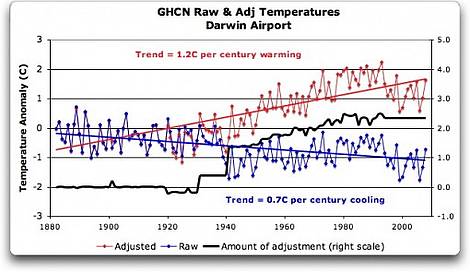

Anschließend habe ich mich damit beschäftigt, was passiert, wenn das GHCN die “Inhomogenitäten” beseitigt und die Daten “justiert”. Von den fünf Rohdatensätzen wirft das GHCN zwei weg, vermutlich wegen deren kurzer Zeitspanne und weil sie Daten aus längeren Reihen nur duplizieren. Die drei verbleibenden werden zuerst „homogenisiert“, dann die Durchschnitte errechnet, um die „GHCN-justierten“ Temperaturdatenreihe für DARWIN zu erzeugen.

Das ergab eine Überraschung. Um die volle Tragweite zu veranschaulichen, zeige ich sie mit beiden Datenreihen am gleichen Ausgangspunkt beginnend – nicht am Endpunkt, wie es oft geschieht.

Abb. 7. GHCN Homogenitäts-Justierungen an der zusammen gefassten DARWIN Datenreihe.

Pfui Teufel! Vor der Homogenisierung fallen die Temperaturen mit 0,7 C Grad pro Jahrhundert … aber nach der Homogenisierung steigen sie mit 1,2 C Grad pro Jahrhundert. Die „Justierung“ beträgt also mehr als zwei Grad pro Jahrhundert … Wenn diese Burschen „justieren“, gehen richtig ran. Und dann sieht die “Justierung” noch komisch aus. Zuerst geht sie schrittweise hoch, dann bleibt sie bei 2,4 C Grad.

Deswegen habe ich genau hingeschaut, wie das GHCN die Temperaturdaten “justiert”. Das steht in An Overview of the GHCN Database:

GHCN Temperaturdaten enthalten zwei verschiedene Datensätze: die Originaldaten und einen „homogenitäts-justierten“ Datensatz. Die gesamte Überprüfung der Homogenisierung wurde auf jährlichen Datensätzen durchgeführt. Das Homogenitäts-Justierungsverfahren geschieht in zwei Schritten:

Im ersten Schritt wird eine homogenisierte Referenzserie für jede Station erzeugt (Peterson and Easterling 1994). Eine vollständige homogenisierte Referenzserie unter Benutzung unbekannter Inhomogenitäten zu erzeugen, kann unmöglich sein, aber wir haben verschiedene Methoden angewandt um mögliche Inhomogenitäten in den Referenzserien zu minimieren.

…

Beim Erzeugen der ersten jährlichen Differenz-Referenzserie haben wir die fünf höchstkorrelierten Nachbarstationen benutzt, die ausreichend Daten hergaben, um die Kandidaten-Station zu modellieren.

…

Beim abschließenden Verfahren zum Minimieren der Inhomogenitäten bei den Referenzserien wurde der Durchschnitt der drei Hauptwerte benutzt (aus den fünf Nachbarstationen), um die erste Differenzserie zu erzeugen.

Man muss fair bleiben, das alles klingt gut. Sie nehmen fünf Nachbarstationen und bilden die Mittelwerte. Dann vergleichen sie diese Mittelwerte mit den Werten der untersuchten Station. Wenn die zweifelhaft aussehen im Vergleich mit dem Mittelwert der fünf Referenzstationen, dann überprüfen sie alle historischen Aufzeichnungen auf Änderungen, und dann homogenisieren sie die armen Daten gnadenlos.

Ich habe einige Probleme mit dem, was sie beim Homogenisieren machen. Aber auf diese Weise identifizieren sie die inhomogenen Stationen.

Schauen wir mal … wir wissen, dass die Stationen in Australien spärlich sind. Wie konnte man für 1941 fünf „benachbarte“ Stationen finden?

Ich habe es mir angesehen. Die nächste Station aus dem Jahr 1941 liegt 500 km von DARWIN entfernt. Sie ist nicht nur 500 km weg, sie ist auch die einzige innerhalb 750 km um DARWIN für die 1941er Zeitspanne. (Es ist auch noch eine Kneipe, Daly Waters Pub, um genau zu sein, so ist es halt in Australien.) Es existieren also keine fünf Stationen für die Bildung einer “Referenzserie”, um die Abnahme von 1936-1941 in DARWIN zu überprüfen.

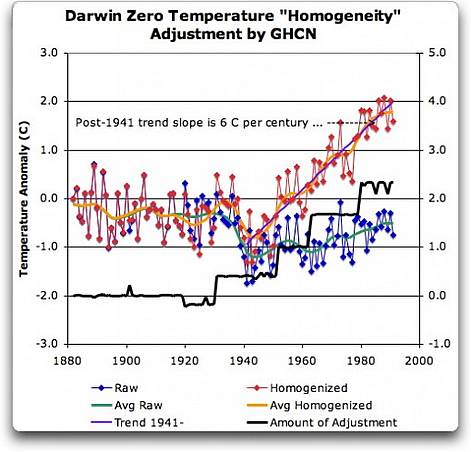

Ich war verwirrt von der merkwürdigen Form der gemittelten homogenisierten DARWIN-Serien. Ich machte mich nun daran, die Art und Weise der Homogenisierung für jede der einzelnen Stationsdatenserien zu erkennen. Wie ist dieser komische Mittelwert in Abb. 7 entstanden? Ich begann mit DARWIN Zero und der frühesten Aufzeichnung. Hier ist das Ergebnis mit den Rohdaten und den homogenisierten.

Abb. 8. DARWIN Zero. Homogenisierung-, Justierung. Schwarze Line: Betrag und Zeit.

Pfui und nochmals Pfui! Was um Himmels Willen rechtfertigt so etwas! Wie kommen die darauf? Seit 1941 haben wir fünf verschiedene Aufzeichnungen für DARWIN. Sie stimmen fast genau überein. Warum also „Justierung“? Man hat einfach einen großen völlig imaginären Trend auf die letzte Hälfte der Rohdaten gesetzt! Jetzt sieht es so aus, wie in der IPCC-Grafik in Abb. 1 – na ja … aber ein Trend von 6 Grad pro Jahrhundert? Und das noch in Form einer gleichmäßig steigenden Stufenpyramide bis zum Himmel? Was ist denn da los?

Das liebe Freunde, sind die plumpen Fingerabdrücke einer Datenverfälschung auf ägyptische Art … Es ist der unwiderlegbare Beweis, dass „homogenisierte“ Daten verändert werden, damit sie in das Vorurteil von der Erderwärmung passen.

Eins ergibt sich daraus ganz klar. Wer sagt, dass „Climategate“ nur eine Angelegenheit von Wissenschaftlern mit schlechtem Benehmen sei, die Daten aber in Ordnung wären, der irrt! Mindestens eine Sorte von Daten ist auch falsch. Der Beweis dafür ist DARWIN Zero.

Und weiter: Ich habe eine ungelöstes Rätsel. Wie und Warum hat GHCN DARWINs historische Datenreihe „justiert“ um eine radikale Erwärmung zu zeigen? Warum haben sie stufenweise „justiert“? Benützen Phil Jones und die CRU-Kollegen die „justierten“ oder die rohen Daten von GHCN? Ich vermute die „justierten“, weil sie die Erwärmung zeigen.

Eine weitere Merkwürdigkeit ist, dass GHCN die Station 1 “justiert” hat, damit sie mit der seltsamen DARWIN Zero “Justierung” übereinstimmt. Station 2 wurde völlig im übergangen (die deckt in etwa die gleiche Zeitperiode ab und ist in perfekter Übereinstimmung mit Station Zero und Station 1). Nur zwei der drei wurden homogenisiert. Dann erfolgte die Mittelwertbildung.

Auf diese Art erhält man einen Durchschnitt, der einigermaßen reell aussieht. Vermutlich zum Verstecken der Temperaturabnahme (hide the decline).

Wie auch immer, schauen Sie sich mal an, wie GISS damit umgeht. Die benutzen nämlich die Daten von DARWIN erst ab 1963. Eine saubere Art, um das Problem zu umschiffen … und auch um alle unbequem kälteren Daten vor 1941 wegzuwerfen.

Das ist wahrscheinlich besser als die GHCN Ungeheuerlichkeit. Aber auch schwerlich zu rechtfertigen.

Ohne Wenn und Aber: Die unverfrorene Schwindeljustierung des GHCN bei dieser einzigen Station bedeutet nicht, dass sich die Erde nicht erwärmen würde. Sie bedeutet auch nicht, dass die drei Datenbestände (CRU, GISS, GHCN) generell falsch seien. Es kann sich um einen Einzelfall handeln, wir wissen es nicht. Aber jedes Mal, wenn Daten überprüft und homogenisiert werden, nehmen die Trends zu. Jetzt macht das GISS seine eigenen „Justierungen“. Sie kommen aber zum gleichen Ergebnis wie GHCN, wie sie immer wieder verkünden. Das stellt die GHCN–Daten auch unter Verdacht.

Was wir daraus lernen ist, dass es wenigstens eine Temperaturmessstation gibt, wo der Trend künstlich nach oben erhöht worden ist, um einen falschen Alarm auszulösen, während die Rohdaten eine Abkühlung zeigen. Zusätzlich sind die Durchschnittsdaten für Nord Australien ganz verschieden von den „justierten“. Es muss also eine Anzahl von … sagen wir mal für uns interessanten „Justierungen“ in Nord Australien zusätzlich zu DARWIN geben.

Im Einklang mit dem lateinischen Sprichwort “Falsus in unum, falsus in omNis” (Eines falsch – Alles falsch) misstrauen wir jedem, der homogenisierte Daten benutzt. Solange, bis alle Stations-Justierungen überprüft sind (CRU, GHCN, GISS einbegriffen).

Gruß an Alle, kämpft weiter für die gute Sache.

Willis Eschenbach

Die Übersetzung besorgte Helmut Jäger EIKE

Den Originalartikel (vom 8.12.2009) finden Sie hier.

Mit Dank an Spürnase Meister am 7.12.10

NOTE: Figures 7 and 8 updated to fix a typo in the titles. 8:30PM PST 12/8 – Anthony

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"#20: U. Langer sagt am Freitag, 17.12.2010, 11:14:

„Sehr geehrter Herr Müller,

Ihre Formulierung, in der Sie von einer nötigen Höhenkorrektur bei der Harmonisierung von „so einer eigenartigen Korrektur“ sprechen ist nicht gerade vertrauenerweckend!“

Was hat das mit Vertrauenerwecken zu tun? Sie schreiben von einer „notwendigen Höhenkorrektur“ und deren Problemen. Wenn ich daraufhin nachfrage, wer denn sowas bei der Ermittlung der Stationsanonalien machen würde und damit mit solchen Problemen konfrontiert würde, kommt nichts. Da mag das eigenartig etwas provokant wirken, im Idealfall hätte es zu einer ausführlicheren Begründung Ihrerseits gefolgt von einer Bitte um Entschuldigung meinerseits geführt. So bleibts leider nur bei einer behaupteten Höhenkorrektur, die ich weiterhin eigenartig finde, da meines Wissen nach niemand sowas macht.

Sehr geehrter Herr Müller,

Ihre Formulierung, in der Sie von einer nötigen Höhenkorrektur bei der Harmonisierung von „so einer eigenartigen Korrektur“ sprechen ist nicht gerade vertrauenerweckend!

MfG

#18: U. Langer sagt am Mittwoch, 15.12.2010, 12:57:

„Sehr geehrter Herr Müller,

bzgl. #9 … Bezüglich der hier angesprochenen Homogenisierung wird das Problem relevant, wenn man die Daten einer Station unter Benutzung von Daten anderer Stationen verändert, welche nicht in der gleichen Höhe liegen. Das würde ich hier aber nicht diskutieren, da das ein anderes Thema ist.“

Das ist also nicht belegt, dass das auch wirklich so gemacht wird, wie Sie das als mögliches Scenario hier skiziiert haben. hat mich wie gesagt gewundert, gehört habe ich von so einer eigenartigen Korrektur noch nie.

Sehr geehrter Herr Müller,

bzgl. #9 kann ich nun nicht wissen, was Sie nicht wissen.

Grundlagen zur Thematik der Höhenkorrektur können Sie finden, wenn Sie mal nach Begriffen wie „Temperaturgradient der Atmosphäre“ oder „Potentielle Temperatur“ googeln. Bezüglich der hier angesprochenen Homogenisierung wird das Problem relevant, wenn man die Daten einer Station unter Benutzung von Daten anderer Stationen verändert, welche nicht in der gleichen Höhe liegen. Das würde ich hier aber nicht diskutieren, da das ein anderes Thema ist. Ich wollte mit diesen Beispielen nur zeigen, dass es unter verschiedenen Gesichtspunkten nötig sein kann, „Rohtemperaturen“ nach oben zu korrigieren.

MfG

M.L. kommentierte:

Marvin Müller: „Viele Leute haben sich der Temperaturrekonstruktionen angenommen, eine gute Zusammenfassung fand man im July auf WUWT: „Calculating global temperature“ http://preview.tinyurl.com/38gxp4a. Dort wurde auch beleuchtet, wie sich Homogenisierungen auswirken. Ein interessanter Artikel, wird man hier nie lesen …“

Kommentar M.L.: „Sie müssen den genannten Artikel wirklich mal lesen. Der behandelt die statistische Bearbeitung immer derselben Datensätze (mit geringen Abweichungen zueinander). Er behandelt nicht die selektive Auswahl der Daten, noch die ihnen inherenten systematischen Fehler, bzw. deren nicht vorgenommene Korrektur.

Thema verfehlt, setzen, 5!“

Hmm, hier im Artikel wird anhand der Station „Darwin“ gezeigt, wie die „rohen Stationsdaten“ des GHCN von GissTemp angepasst werden. Lese ich den von mir referenzierten Artikel gründlich, stolpere ich über einen Graphen, der die „rohen GHCN-Daten“ und GissTemp gegenüberstellt: http://preview.tinyurl.com/35pexrh

Ich weiss nicht, warum dass nicht zum Thema passen soll. Ausserdem ist der Artikel ja nicht gerade frei von Kritik an den Temperaturrekonstruktionen … Man stolpert übrigens beim Lesen auch über einen der vielen Graphen, die die Auswirkungen des Entfallens von Stationen darstellt (einer von vielen mit derselben Botschaft): http://preview.tinyurl.com/23wtpfh

Setzt allerdings vorraus, dass man den Artikel wirklich liest …

zu #6 Schweickhardt:

Es geht um Betrug und Fälschung. Das sind strafbare Handlungen, die ohne Rücksicht auf irgendeinen Streitwert verfolgt werden müssen, sobald sie zur Kenntnis der Staatsanwaltschaft gelangen. Es geht hier zunächst darum, einen Juristen zu finden, der diese strafbaren Handlungen in einer Form zur Anzeige bringt, die die Staatsanwaltschaft dazu zwingt, die Strafverfolgung aufzunehmen und Anklage zu erheben.

zu #7 U.Langer:

Eine Umrechnung – ich sage bewußt nicht Korrektur – der Meßwerte auf NN ist bei Luftdruckmessungen, die zur Herstellung der Wetterkarten mit den dort eingezeichneten Isobaren dienen, gewiß sinnvoll. Inwieweit dies auch für Temperaturmessungen sinnvoll ist, und ob es da überhaupt gemacht wird, kann ich nicht beurteilen. Unter Korrektur eines Meßergebnisses verstehe ich allerdings nicht eine derartige Umrechnung, sondern die Berücksichtigung eines systematischen Meßfehlers, der in seiner Größe und Abhängigkeit von den Umständen der Messung hinreichend genau bekannt sein muß. Die unvermeidlichen zufälligen Meßfehler lassen sich überhaupt nicht korrigieren, sie lassen sich als nur wahrscheinlicher Fehlerbereich angeben und sagen etwas über die Genauigkeit der Messung aus.

#13: Mathias Köcher sagt am Dienstag, 14.12.2010, 08:32:

„Dass Herr Müller und Herr Baecker hier nur Kommentare kommentieren, werte ich einstweilen als „beredtes Schweigen“…“

Der Artikel ist mehr als ein Jahr alt, wenn einen das interessiert, findet man genug Artikel, die das ganze auseinandernehmen. Und in der Zwischenzeit ist viel passiert. Viele Leute haben sich der Temperaturrekonstruktionen angenommen, eine gute Zusammenfassung fand man im July auf WUWT: „Calculating global temperature“ http://preview.tinyurl.com/38gxp4a. Dort wurde auch beleuchtet, wie sich Homogenisierungen auswirken. Ein interessanter Artikel, wird man hier nie lesen …

@NicoBaecker #11

Also die Grafik sagt einen kontinuierlichen Anstieg über 1000 Jahre voraus.

Und auch Sie und ihre Glaubensbrüder sagen den Menschen eine Zunahme der Temperatur für die Zukunft voraus.

In Cancun hat man beschlossen den Temperaturanstieg in der Zukunft auf 2 Grad zu beschränken.

Jeder von ihren Glaubenskrieger propagiert für die Zukunft einen Temperaturanstieg! Also was nun?! Stehen Sie hinter ihren Modell der Angstmache nicht mehr? Kommt jetzt die große Angstmache über den Temperaturabschwung oder müssen Sie sich jetzt schon allgemeiner halten und die Angst vor der Klimakatastrophe ins „Schlachtfeld“ führen?!

Dass Herr Müller und Herr Baecker hier nur Kommentare kommentieren, werte ich einstweilen als „beredtes Schweigen“…

#2: Helmut Jaeger sagt:

“ … schon einige Monate alt, aber er

ist immer noch brisant“

Gilt auch für:

„Besteht nicht die einzige Hoffnung für diesen Planeten in dem Zusammenbruch der industriellen Zivilisation?

Liegt es nicht in unserer Verantwortung, dafür zu sorgen, dass dieser Zusammenbruch eintritt?“

– Maurice Strong, Eugeniker, erster UNEP-Direktor, Hochgrad-Freimaurer und Satanist. Insider:

„Liebe Angela Merkel,

..

dummerweise unterschrieben Sie eben so schnell ein inhaltlich fingiertes Kyoto-Protokoll, ein für die Bürger Deutschland fatales Dokument, ohne sich damals darum zu kümmern, dass sowohl Präparierung des Gesamt-Meetings in Kyoto, wie auch Organisation zur Offerte des Protokolls weitgehend in Händen des Präsidenten der UNEP lag. Er hieß und heißt noch: Maurice Strong. Sie kennen ihn. Damals waren Sie Bundes-Umweltministerin. Dass er für Jahrzehnte in praxi „Manager“ von Finanzen und Intimus des Hauses Rockefeller war, ließ bei Ihnen nichts klingeln. …“

Zitiert aus:

„Brief an Frau Merkel“, 13.12.2010

von Hartmut Bachmann, er war u. a. Präsident eines Wirtschaftsinstitutes in den USA und leitete zur Zeit der Erfindung der Klimakatastrophe, also vor ca. 25 Jahren, als CEO und Managing Director eine US-Firma, die sich exklusiv mit Klimafragen beschäftigte. Er war Kommissar des US Energy Savings Programms. Deswegen war er präsent bei zahlreichen Meetings und Verhandlungen in den USA, welche die Geburt des IPCC, des späteren Weltklimarates, zur Folge hatten.

http://tinyurl.com/353fybl

P.S.: Danke für die Übersetzung.

#10: Hofmann,M sagt:

„Ein kontinuierlicher Temperaturanstieg vorherzusagen, der über einen Zeitraum von über 1000 Jahre geht, dass hat nichts mehr mit sorgfältiger Wissenschaft zu tun “

Sie haben Recht. Das macht aber auch keiner.

@Stricker #8

Ich frage mich nur, was diese schönen Grafiken aussagen sollen!? Hier wird ein Sprung von 1980 bis über das Jahr 3000 gemacht!!???

Ein kontinuierlicher Temperaturanstieg vorherzusagen, der über einen Zeitraum von über 1000 Jahre geht, dass hat nichts mehr mit sorgfältiger Wissenschaft zu tun sondern mit Wahrsagerei und Abzocke!

Schon die letzten 10 Jahre haben keinen Temperaturanstieg mehr gehabt.

#7: U. Langer sagt am Sonntag, 12.12.2010, 21:16:

„es ist durchaus möglich, dass Temperaturen nach oben korrigiert werden müssen.

Denken Sie z.B. an die Höhenkorrektur. Liegt eine Messstation z.B. in 500m Höhe, ist es dort kühler als auf Meeresspiegelniveau. Um die Daten dieser Station zu verwenden, wird nun korrigiert, indem man 5×0,65°C zu den Messwerten addiert.“

Können Sie das mal eben mit einer Quelle belegen? Das ist das erste mal, dass ich von so etwas lese. Alle anderen Quellen beschreiben, dass genau wegen der Nichtvergleichbarkeit der verschiedenen Orte mit Anomalien gerechnet wird (also mit Veränderungen der Temperatur an einem bestimmten Ort) statt mit Absoluttemperaturen …

Erwischt! Hier Stefan Rahmstorfs Temperaturtrick:

http://tinyurl.com/2uqdg4w

Sehr geehrter Herr Oberhöfer,

es ist durchaus möglich, dass Temperaturen nach oben korrigiert werden müssen.

Denken Sie z.B. an die Höhenkorrektur. Liegt eine Messstation z.B. in 500m Höhe, ist es dort kühler als auf Meeresspiegelniveau. Um die Daten dieser Station zu verwenden, wird nun korrigiert, indem man 5×0,65°C zu den Messwerten addiert. (Dabei müsste man aber eigentlich die Luftfeuchtigkeit berücksichtigen, sonst können sich systematische Fehler von mehreren Grad ergeben!)

Eine zweite Ursache für eine Korrektur nach oben kann z.B. die Änderung der Messzeiten sein. Wurde früher 3 Mal am Tag gemessen (früh, mittags, abends) und die Abendmessung verdoppelt (damit man nachts nicht raus muss), wird nun meist alle 2 Stunden gemessen.

Das Problem ist nur, dass solche Veränderungen ja begründbar sind, diese Begründung aber nur sehr unzureichend gemacht wird, so dass die Korrekturen oft nicht nachvollziehbar sind – siehe obigen Artikel und #4.

Und wenn die Temperaturen wie bei Darwin mehrmals nach oben korrigiert werden, ist m.E. Misstrauen mehr als angebracht!

MfG

#5 ja, um Haftung, so ich meine aus Betrug, um das gehts! Aber bitte hier in DE. Unsere Fuzzies brauchen nochne Klatsche.

Das Gericht und die Anwälte fragen zuallererst nach der Streitsumme. Diese großen Gebühren könnte nur eine große Gemeinschaft aufbringen.

Ich würde mich beteiligen. Im Blog hatte ich das Thema Haftung schon mal angesprochen.

Club gründen, Spendenauftruf machen, RA finden,

Klageschrift verfassen, Adressat finden, (wer ist Gegner). Gruß Gerhard Schweichardt

Ein gutes Thermometer ist ein sehr genaues und konstantes Meßinstrument, und ich setze mal voraus, daß für die Wetterbeobachtungen nur gute Thermometer eingesetzt werden. Die Lufttemperatur läßt sich damit problemlos auf 1/10 °C genau messen, und eine größere Genauigkeit ist für die Wetterbeobachtung nicht erforderlich und würde auch die Qualität der daraus gewonnenen Erkenntnisse nicht verbessern. Wenn man mit einem Thermometer die Lufttemperatur messen will, muß man das Thermometer vor elektromagnetischer Strahlung schützen, die mit der Lufttemperatur nicht im thermischen Gleichgewicht ist. Das erreicht man durch den Einbau der Thermometer in ein genügend großes, wärmeisolierendes Gehäuse, welches Strahlung von außen abhält und Strahlung nach außen verhindert. Die Innenfläche des Gehäuses muß die gleiche Temperatur wie die zu messende Luft angenommen haben. Auf ausreichende Luftzirkulation ist zu achten. Wenn eine solche Meßstation im freien Land steht, also außerhalb von Siedlungen, betonierten oder asphaltierten Flächen oder Flughäfen, die einen Wärmeinseleffekt erzeugen, dann bedarf die Temperaturmessung in dieser Station keinerlei Korrektur. Steht die Station ungünstigerweise innerhalb einer Wärmeinsel, dann ist die gemessene Temperatur um den geschätzten Wärmeinseleffekt nach unten zu korrigieren. Ich kann mir nicht vorstellen, daß eine korrekt ausgeführte Meßstation jemals zu geringe Temperaturen mißt, die einer Korrektur nach oben bedürfen. Ich halte das für physikalisch unmöglich, lasse mich aber gern belehren, wenn jemand mir gute Gründe dafür nennen kann. Die hier in dem Artikel gezeigten, im Laufe der Zeit ansteigenden Korrekturen der Messungen um bis zu über 2 °C halte ich für einen ausgemachten Schwindel. Die angebliche Klimaerwärmung ist damit ausschließlich das Ergebnis dieser willkürlichen, absichtlichen und physikalisch unsinnigen Korrekturen. Man kann diesen Skandal nicht laut genug verkünden, ich jedenfalls werde meiner Zeitung einen entsprechenden Leserbrief schreiben, und ich werde auch meinem Bundestagsabgeordneten und meinem Ministerpräsidenten Mappus schreiben. Besteht keine Möglichkeit, die sogenannten Wissenschaftler, die diese Verfälschungen der Meßergebnisse, Homogenisierung genannt, vor Gericht zu bringen? Juristen an die Front!

Sehr geehrter Herr Hovestadt,

In Neuseland mußte die zuständige Behörde ihre homogenisierten Daten mit einem Temperaturanstieg von 1,2 °C in 100 Jahren bei einem Temperaturanstieg in den Rohdaten von maximal 0,3 °C vor Gericht zurückziehen. Sie erklärte, daß sie nicht mehr nachvollziehen könnte, wie es zu diesem Anstieg von 1,2°C gekommen sei. Dies ist zwar nicht so eine Analyse, wie hier veröffentlicht, aber es sagt doch wohl alles über die Qualität der Temperaturmessungen bzw. deren Bearbeitung. Nachzulesen ist dies alles im Blog von Anthony Watts. Sie müßten allerdings ein bischen suchen, da die Artikel über die Temperaturen in Neuseeland schon vor einiger Zeit erschienen sind.

Mit freundlichen Grüßen

H. Urbahn

Wenn das alles stimmt mit der „Homogenisierung“ der Australiendaten, ist das

a) ungeheuer

b) muss man davon ausgehen, dass viele weitere Daten, möglicherweise alle so oder ähnlich massiert sind. Dann wäre Hockeystick auch in Ansätzen Unsinn. Das wäre doch ein Knüller für den investigativen Journalisten

Bevor man das aber akzeptieren muss würde ich gern eine 2. unabhängige Recherche für einen anderen Ort/Land sehen.

# 1 Wolf Krab

Sehr geehrter Herr Grab,

als Übersetzer danke ich für Ihre freundlichen Worte zu meiner Arbeit.

Der Beitrag von Willis Eschenbach ist

ja schon einige Monate alt, aber er

ist immer noch brisant, vor allem

weil derzeit wieder mächtig in unseren

Medien für KYOTO-Nachfolge getrommelt wird.

Es wäre schön, wenn sich mal jemand aus

unserer EIKE-Gemeinde vergleichsweise mit

deutschen Wetterstationen beschäftigen würde und im Einzelfall prüfen würde, ob und wie deutsche Rohdaten in GHCN oder CRUTEM frisiert wurden.

Es gibt ja die sehr dankens- und anerkennungswerte Arbeit von Herrn Kowatsch zu den Manipulationen des DWD. Was aber geschieht mit den Daten des DWD bei GHCN oder bei CRUTEM? Gehen die vom DWD schon frisierten Daten etwa als Rohdaten dorthin

zur Nachfrisur?

Danke

Helmut Jäger

Erstmal vielen herzlichen Dank an Helmut Jäger für die Übersetzung. Man tut sich halt leichter, Texte mit derartig brisantem Inhalt in der Muttersprache zu lesen.

So, jetzt erstmal tief Luft holen um das offenbar Ungeheuerliche zu verstehen.

Das was Willis Eschenbach hier beschreibt, geht ja weit über die kleinen Mogeleien des Alltags hinaus.