Alle Daten beziehen sich auf eine Reihe von 1958 bis 2002.

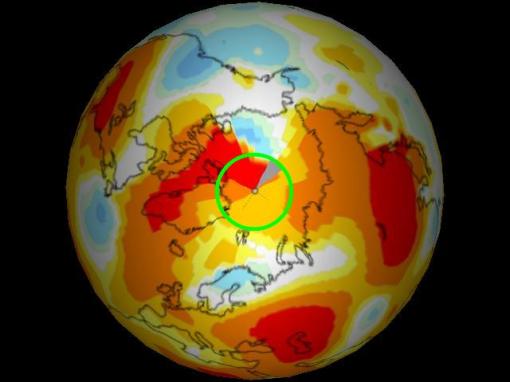

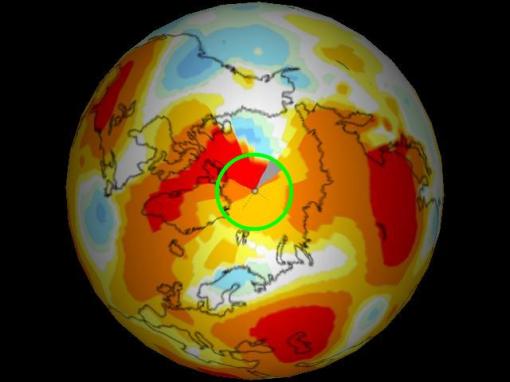

Die erste Graphik zeigt die Anomalien im Juni 2010, vom GISS interpoliert aus einem Gitterpunktsabstand von 1200 km . Die grüne Linie markiert den 80. Breitengrad Nord. Man erkennt, dass die Darstellung von GISS im Wesentlichen in der Region nördlich von 80° eine Temperaturabweichung bis +4 K zeigt.

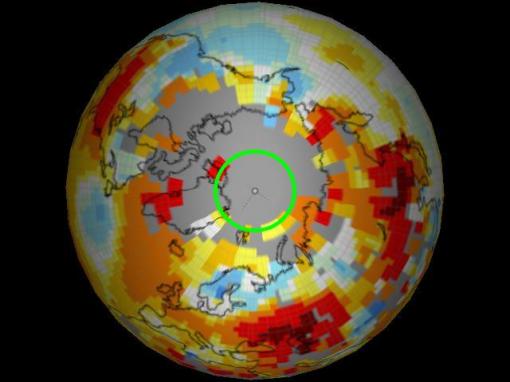

Die folgende Graphik zeigt das Gleiche, jedoch mit einem Abstand der Gitterpunkte von 250 km. Wie man sieht, hat das GISS nur sehr wenige oder gar keine Daten nördlich von 80° N.

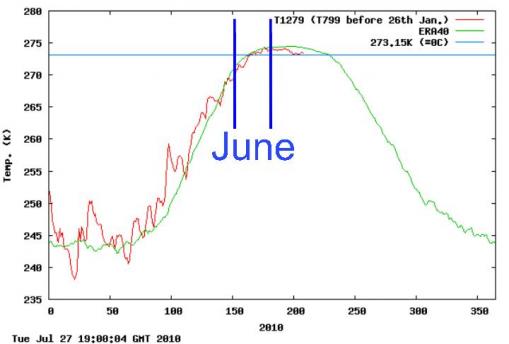

Jetzt lassen Sie uns diese Interpolation vergleichen mit den Daten des DMI für Juni 2010.

Tägliche mittlere Temperatur in der Arktis nördlich von 80° im Vergleich zu den mittleren klimatologischen Werten von 1958 – 2002.

http://ocean.dmi.dk/arctic/meant80n.uk.php

Das DMI zeigt im Wesentlichen, dass die Temperatur im gesamten Monat unter den Mittelwerten von 1958 – 2002 lag. Das GISS zeigt dagegen Werte weit über diesem Mittel. Obwohl GISS nördlich von 80° überhaupt keine Daten hat.

Schlussfolgerung: Die Interpolationen des GISS bzgl. der Arktis sind weit jenseits von gut und böse […way off the mark]. Falls sie einen globalen Temperaturrekord von 0,01 Grad in diesem Jahr melden, dies ist der Grund dafür.

——————————————————————

Original aus dem Schandmaul: [Straight from the horse’s mouth]:

…die über 12 Monate gleitende mittlere globale Temperatur hat in den Analysen des GISS im Jahre 2010 einen neuen Rekord erreicht… . Die GISS–Analysen weisen das Jahr 2005 als das wärmste Kalenderjahr aus, während die Analyse vom HadCRUT 1998 als das wärmste Jahr zeigen. Hauptursache [für diese Diskrepanz] ist, dass wir die geschätzte Temperatur der Arktis mit einbezogen haben.

– James Hansen

Mit anderen Worten, die Daten vom GISS basieren auf inkorrekten, konstruierten Daten. Warum hat es Hansen offensichtlich gefallen, die gemessenen Daten des DMI zu ignorieren und stattdessen auf „geschätzte“ Daten aus der Arktis zurückzugreifen? Die Temperaturanomalien in der Arktis sind nach GISS bis zu 4 K zu hoch, und doch behauptet er, einen gemessenen Rekord um ein paar Hundertstel Grad zu haben. Wie [die Physiker] Penn und Teller sagen würden… Nun, das kann ich hier nicht zitieren.

Steve Goddard

Den Originalartikel finden Sie hier

Alle Einschübe in eckigen Klammern vom Übersetzer. Alle anderen Hervorhebungen im Original!

Übersetzt von Chris Frey. EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Lieber Herr Hartmann, #13

danke für die Ergänzungen. Die Punkte zum Bedenken teile ich.

Ich bin auch der Meinung, dass das Problem eher in der Intrerpretation von Dritten liegt als in der Auswertung. Wobei man angesicht der Popularität der Daten in diesem Fall GISS nahelegen sollte, die Methode und ihren Grenzen noch klarer darzustellen. Es ist einfach müßig, wenn sich Leute über eine Abweichung von 1 Grad aufregen und Betrug schreien, wenn die Methode nicht erlaubt, genauere Werte anzugeben.

PS: Literatur zu der Thematik habe ich bereits. Ich bin im Bilde.

Lieber Herr Bäcker,

mir ging es gar nicht vordergründig darum, die oben gezeigten Darstellungen zu beurteilen. Das kann man erst dann tun, wenn man die Lage der verwendeten Messpunkte (x,y-Koordinaten) und die dazugehörigen Messwerte (z-Koordinaten) kennt.

Ich gehe davon aus, dass die Fachleute in den entsprechenden Fachgebieten (z. B. Geographen, Meteorologen, Hydrogeologen, Geologen, Vermessungsingenieure usw.) sehr gut Bescheid wissen sollten bzw. es auch wissen, was bei Isoliniendarstellungen richtig oder falsch und wichtig ist. Das ist nicht mein Problem. Wie die Situation in der genannten Hinsicht (was richtig oder falsch ist)in den entsprechenden Fachgebieten ist, kann ich auch schlecht beurteilen. (Wie es in meinem Fachgebiet damit bestellt ist, weiß ich etweas besser, könnte und müsste darüber aber in einem gesondertem sehr langen Brief dem für Bildung verantwortlichen Kultusministerium berichten. Soviele andere Briefe müsste ich dann auch noch verfassen. Das erspare ich mir aber lieber…)

Wie gesagt, eine konkrete Beurteilung ist nur unter o.g. Bedingungen erlaubt.

Mit dem Fehler ist das auch nicht ganz so einfach. Natürlich gibt es a, b, c. Dabei ist c) der am einfachsten auszuweisende. Ein weiterer zufälliger Fehler liegt auch in der rein zeichnerischen Darstellung. Wenn Sie meine Ausführungen nochmals aufmerksam durchlesen, sehen Sie, dass die richtige Wahl der Messpunktverteilung (b) a) automatisch ausschließen und man damit einfach linear interpolieren können würde. Und genau dort liegt eben der Haase im Pfeffer. Erst wenn wir das Verhalten bspw. eines Parameters genau kennen, können wir bestimmen, wie ein ideales Messnetz aussehen würde bzw. müsste. D.h. das gilt,erst wenn, man die statistischen Eigenschaften eines Parameters einschließlich seiner räumlichen Anisotropie auf gewünschtem Signifikanzniveau kennt und somit auch weiß, wie groß die optimale bzw. kritische Messpunktanzahl ist. Aber genau das, ist auch z.B. ein Teil der eigentlichen Aufgabenstellung. Damit muss man aber zwangsläufig leben und deshalb das Messnetz ständig optimieren bzw. verbessern, wenn es denn dazu die Möglichkeiten gibt. (Sie sehen schon mit meinem letzten Teilsatz kommt wieder ein ganzer Ratteschwanz auf uns zu, der meine Ausführungen im Falle des Weiterschreibens in das Format eines Lehrbuches wandeln würde.)

So kann man bspw. bei der Betrachtungen oben gezeigter Darstellungen sofort erkennen, dass die Messpunktdichte im arktischen Bereich nicht ausreichend ist. Das weiß auch jeder verantwortliche Bearbeiter solcher Probleme, denke ich. Für die unbefriegende Messpunktdichte gibt es natürlich auch handfeste verständliche Gründe. Das eigentliche Problem ist nur, was verantwortliche Dritte daraus machen.

Guten Abend

B. Hartmann

P.S.: Ich bin gerade am Überlegen, welche Literatur ich Ihnen dazu empfehlen würde, falls Sie sich interessieren würden. Auf Anhieb kann, ich nicht einmal sagen, wo solche Probleme abgehandelt werden, wie wir sie hier besprechen. Falls Sie wünschen, schauen Sie doch mal unter den Stichworten „Statistik“, „Geostatistik“, „Krigging“ nach.

Lieber Herr Hartmann,

wenn ich Sie richtig verstehe, gibt es 3 Fehlerquellen bei einer Karte:

a) der Fehler durch die Wahl der Interpolationsmethode

b) der Fehler durch die Auswahl oder Positionierung der verwendeten und als repräsentativ postulierten diskreten Messpunkte.

c) der Messfehler selber

Alle drei Fehlerarten werden in der Klimatologie berücksichtigt und Fehlerbalken daraus werden abgeschätzt. Ich stimme Ihnen zu, dass es kein mathematisch eindeutiges Verfahren gibt, wie man von den Messwerten zur Karte kommt. Noch bedenklicher ist, dass es sogar auch kein mathematisch eindeutiges Verfahren gibt, die Fehler zu berechnen. Die notwendige Erfahrung des Experten ist also nicht auf Null zu reduzieren. Nehmen wir ein Beispiel und vereinfacht an, dass die Thermometer exakt messen würden, und die Aufgabe gestellt sei, die Jahresmitteltemperatur entlang einer Geraden durch die Landschaft zu bestimmen. Dann stellen Sie 2 Themometer auf und konstruieren die Isolinie als Gerade zwischen den Messpunkten, kontrollieren dazwischen durch eine dritte Messung und stellen fest, dass die Messwerte von den der interpolierten Gerade um x abweichen. Wenn x größer als ein Akzeptanzwert ist, müssen Sie das Netz dichter machen und/oder andere Positionen suchen. Wieso sollte dies also bei den Klimamessnetzen nicht auch in Prinzip so gemacht werden?

Letzlich aber müssen Sie einen Restfehler aus Durchführungsgründen akzeptieren. Und da selbst die Kontrollprozeduren nur Stichprobencharakter haben, müssen Sie aus den messtechnisch ermittelten Abweichungen mit menschlicher Expertise auf den Gesamtfehler des Feldes schließen.

So, lieber Herr Bäcker,

ich möchte Ihnen nun endlich antworten!

Mit dem ersten Teil Ihrer Äußerung kann ich mich einverstanden erkären und freue mich auch, dass ich Ihre Herangehensweise vollkommen teile.

Was den zweiten Teil – Ihre Frage – betrifft, so kann ich Ihnen ganz ohne Not und Schwierigkeiten antworten. Sie können und müssen nicht wissen, dass die Zeit meines Studiums bis heute mit der Erstellung besagter Isolinien auf engste Weise verbunden ist, ständig von Fragen zur Methodik der Erstellung, des Wahrheitsgehaltes und des Grades der Widerspiegelung der Realität mit Hilfe von Isolinien, der u.a. auch mathematischen Begründung der Dichte und Ausrichtung von Messnetzen begleitet ist. Deshalb können Sie meine Aussagen beruhigt für bare Münze nehmen. Konkrete Antworten gebe ich unten.

Mit solchen Fragen muss sich ein verschwindend kleiner Teil der arbeitenden Bevölkerung auseinandersetzen. Jedoch frühestens seit dem Geografieuntericht oder über die Massenmedien bei der Darstellung irgendwelcher Sachverhalte werden wir damit mehr oder weniger häufig konfrontiert und nehmen dies meist unkritisch zur Kenntnis. Dazu haben wir auch jeden Grund, denn wir haben z. B. beim Wandern, Rad- oder Autofahren die Erfahrung gemacht, wenn auch unbewusst, dass die zur Verfügung stehenden Karten uns nicht in die Irre führten.

Sie sagen es ja selbst, die Messpunkte haben in ihrer Lage diskreten Charakter, sind also die real existierenden Punkte, an denen irgend ein Parameter gemessen wird. Alles andere, was daraus entwickelt wird, (bspw. Isolinien, Gitterboxen) stellt eine Ableitung und Weiterverarbeitung konkreter Messwerte dar. Auf diese Weise tragen auch die erzeugten Isolienen, die nach unterschiedlichen Methoden erstellt werden können, bzw. die daraus gemachten Aussagen grundsätzlich Wahrscheinlichkeitscharakter. So würden bspw. Aussagen, die auf der Basis eines Messnetzes mit unendlich dicht zueinander liegenden Messpunkten getroffen werden würden, eine Wahrscheinlichkeit von nahezu 1 haben. In dieser Hinsicht ist es natürlich einerseits sinnvoll, den Messfehler für den darzustellenden Messparameter anzugeben. Andererseits ist der Fehler der Isoliniendarstellung bzw. innerhalb dieser eine ganz andere Sache, in die der Messfehler der Feststellung einer Parametergröße als solcher nur nebensächlich einginge. Der eigentliche Fehler von Isolinendarstellungen hängt mit der räumlichen Veränderlichkeit der Messparameter, der tatsächlichen Kenntnis darüber und der auf dieser Basis umzusetzenden räumlichen Struktur des entsprechenden Messnetzes zusammen. Es ist grundsätzlich davon auszugehen, dass die Veränderlichkeit von Größen bspw. in der Erdkruste in allen räumlichen Richtungen andersartig ist. Drückte man diese Veränderlichkeit als räumliche Vektoren aus, würden sie im Idealfall eine Kugeloberfläche (im weitesten Sinne Isotropie in allen Richtungen) beschreiben und im entgegengesetzten Fall eine chaotisch gestaltete Oberfläche (im weitesten Sinne Anisotropie in allen Richtungen). Die optimale Menge von Punkten zur Ermittlung und Darstellung der Eigenschaften bestimmter Größen lässt sich relativ einfach bestimmen, indem man ermittelt, ab wann bzw. ab welcher Messpunktanzahl sich die Veränderlichkeit in Form beschreibender statistischer Maßzahlen nicht mehr wesentlich ändert. Dies ließe sich für räumlich anzuordnende Messpunkte auch in jede Raumrichtung exerzieren. Voraussetzung dafür ist, dass man über eine mehr als optimal notwendige Anzahl von Messungen verfügt. An dieser Stelle liegt das fast schon philosophische Grundproblem jedes Projektes von Messungen in der „Black Box“, deren Wesen in ihrem Inhalt wir wünschen durch geeignete Beobachtungen zu ergründen. Erst dann, wenn wir diese „Black Box“ aufgebrochen haben, werden wir wirklich wissen, ob die Anzahl, Anordnung usw. unserer Messpunkte für die hinreichende Charakterisierung des gewünschten Sachverhaltes, Objektes usw. optimal war oder nicht…

Im Zusammenhang mit dem bisher Gesagten, wäre es also zumutbar, machbar, vertretbar und sinnvoll einzufordern beispielsweise obige Darstellung mit der Lage der Messpunkte und der dazugehörigen Messpunkte zu versehen. Dies würde der Möglichkeit einer sachlichen Beurteilung solcher Darstellungen entgegenkommen.

Zum Wesen und der Genese der besagten Gitternetzpunkte bzw. Gitterboxen möchte ich mich nicht wiederholen. Ich hoffe nur, dass Sie nun irgendwie doch teilen können, dass das Vorhaben, diese Boxen mit statistischen Zahlen zu kennzeichnen, natürlich auch praktisch möglich ist aber wenig Sinn hat.

Zuallerletzt kurz noch etwas zur Methodik der Isolinieerstellung, um damit bei EIKE bzw. den beteiligten Disputanden aufzuräumen.

Es gibt grundsätzlich zwei Verfahren Isolinien zu erzeugen. Einmal kann dies manuell geschehen oder unter der Anwendung entsprechender Software, deren erfolgreiche Entwicklung und Anwendung bereits in den 1960-ern(!) begann. Die manuelle Erstellung von Isolinien basiert auf der linearen Interpolation der Messwerte benachbarter Messpunkte. Bei der manuellen Bearbeitung können relativ leicht außerdem Sachverhalte einbezogen werden, die außerhalb der Interpolation Randbedingungen darstellen und mit der Kenntnis über die Änderung, Restriktionen, Beeinflussung usw. hinsichtlich des Verhaltens der darzustellenden Messgröße im Zusammenhang stehen. Bei der Nutzung von Software ist dies schwer bzw. so oft einfach nicht möglich. Andererseits wird in der Praxis nun meist spezielle Software genutzt, weil eine manuelle Datenverarbeitung schon aufgrund der vorhandenen Datenmengen schlicht und einfach unzumutbar ist. Die Anwendung der EDV erlaubt es dagegen, Methoden der Interpolation anzuwenden, die die Kenntnis über die Variabilität der Messgrößen sinnvoll einzubeziehen bzw. zu berücksichtigen (z. B. das so genannte „Krigging“, womit anderseits auch oft vollkommen unnötige Augenwischerei betrieben wird). Im Zusammenhang mit der Diskussion über Isoliniendarstellungen fällt auch sehr oft der Begriff „Einflussradius“. Dieser Begriff ist genetisch im Zusammenhang auch mit der Anwendung der EDV bzw. entsprechender Isoliniensoftware zu sehen. Damit hängt auch der Terminus „Nuggeteffekt“ zusammen, der auf deutsch viel besser als „Inseleffekt“ bezeichnet werden könnte. Dieser Nuggeteffekt hängt mit dem statistisch ermittelbaren Messabstand zusammen, ab dem die beobachtete Variabilität eines Messparameters in einer diskreten Richtung, sich nicht mehr „gesetzmäßig“ verhält. Bei Kenntnis des Abstandes von Messpunkten, bei dem der Nuggeteffekt auftritt, lässt sich der „Einflussradius“ festlegen, dessen Angabe bei der Nutzung bestimmter Software als Option erforderlich ist. Ist dieser Einfluzssradius in seiner Größe ungünstig angegeben, geschieht es, dass bei der Isolinienerzeugung um einen Messpunkt eine „Insel“ in Form einer Isolinie gezeichnet wird, obwohl es in der Nähe dieses Messpunktes Messpunkte mit Werten gibt, mit denen der Wert des Inselpunktes interpoliert werden könnte. (Bei manueller Arbeit könnte dies einfach nicht passieren.) Die gängige software ist derartig „gestrickt“, dass für eine Messgebiet nur ein Einflussradius anzugeben ist. Da die Messnetze von Natur aus unregelmäßig sind, kann es denn auch einmal diesen Inseleffekt geben, was dann seriöserweise eine manuelle Nachberarbeitung erforderlich macht.

Wie Sie sehen, könnte man über die Thematik wirklich ein Buch schreiben, ist also mit dem, was ich hier losgeworden bin, bei Weitem noch nicht erschöpft.

Mit freundlichem Gruß

B. Hartmann

Lieber Herr Hartmann, #7

„Sehen Sie das nicht so, dass das Informationsgeschehen in den Massenmedien zum Thema Klima usw. meist oberflächlich, einseitig, unkritisch und gar tendenziös ist?“

Ja, daher lese ich auch keine Massenmedien, wenn ich mich gezielt über ein klimatologisches Thema informieren will.

Aufgund diese massenmedialen Übertreibungen und Sinnverfälschungen das Kind mit dem Bade auszuschütten und die thematisch damit verknüpfte Wissenschaft an die Wand zu stellen, halte ich jedoch für unsachgerecht und hysterisch.

„P.S.: Und noch etwas Nebensächliches: Bezüglich meines Textes von #5, hinsichtlich seiner Akzeptanz und Verständnisses wäre der Gebrauch, Hinweis usw. auf Gitternetzboxen, die auch noch mit Fehlerintervallen versehen sein sollen, gelinde gesagt, absolut unvernünftig.“

Wieso?

„Das Primat haben grundsätzlich die Messpunkte mit ihren diskreten Raum-Zeit-Koordinaten und den entsprechenden Messwerten!

B.H. “

Nun, die Messpunkte liegen ja nur diskret vor. Vermissen Sie die Darstellung der der KArtographie zugrundeliegendne Rohdaten?

Ja, wirklich hoch interessant, dass man etwas länger als gewohnt, eine Antwort erwartet auf Fragen und Argumente, bei denen es mir leicht möglich erscheint, einen ganz kleinen gemeinsamen Nenner zu finden.

Gute Nacht!

B. Hartmann

#4: „NicoBaecker“ sagt:

„Wie oft wird bewußt die halbe Wahrheit verbreitet, um Verschwörungstheorien am Leben zu halten.“

Treffer. 😉

#5: Bernd Hartmann sagt:

„Dieses Wort ist hier m. E. vollkommen fehl am Platz“

Das ist ein ideologischer Kampfbegriff.

Früher nannte man „VerschwörungstheoretikerInnen“ investigative Journalisten. „Qualitätsjournalismus“ ist zum Schimpfwort verkommen. Ein Synonym für unkritische Hofberichterstattung und Tot-Schweigen von Relevantem. Früher nannte man (!) „Verschwörungstheoretiker“ auch ehrliche, weitsichtige und charismatische Politiker. Eine bekanntlich schwer vom Aussterben bedrohte Spezies.

„Wir haben es mit einer monolithischen und ruchlosen weltweiten Verschwörung zu tun, die ihren Einfluß mit verdeckten Mitteln ausbreitet …

Es ist ein System, das mit gewaltigen menschlichen und materiellen Ressourcen eine komplexe und effiziente Maschinerie aufgebaut hat, die miltärische, diplomatische, geheimdienstliche, wirtschaftliche, wissenschaftliche und politische Operationen verbindet. Ihre Pläne werden nicht veröffentlicht, sondern verborgen, ihre Fehlschläge werden begraben, nicht publiziert, Andersdenkende werden nicht belobigt, sondern zum Schweigen gebracht, keine Ausgabe wird in Frage gestellt, kein Gerücht wird gedruckt, kein Geheimnis enthüllt.

Kein Präsident sollte die öffentliche Untersuchung seines Regierungsprogramms fürchten, weil aus der genauen Kenntnis sowohl Unterstützung wie auch Opposition kommt, und beides ist notwendig.

Ich bitte Ihre Zeitungen nicht, meine Regierung zu unterstützen, aber ich bitte Sie um Ihre Mithilfe bei der enormen Aufgabe, das amerikanische Volk zu informieren und zu alarmieren, weil ich vollstes Vertrauen … (Applaus) …. in die Reaktion und das Engagement unserer Bürger habe, wenn sie über alles uneingeschränkt informiert werden. Ich will die Kontroversen unter Ihren Lesern nicht ersticken, ich begrüße sie sogar. Meine Regierung wird auch offen zu ihren Fehlern stehen, weil ein kluger Mann einst sagte, Irrtümer werden erst zu Fehlern, wenn man sich weigert, sie zu korrigieren.“

John F. Kennedy am 27. April 1961

youtube.com/watch?v=WqFsB9nUdgw

Lieber Herr Bäcker,

Sie haben natürlich Recht, auch was Ihre Person betrifft. Sie wissen aber auch genau, dass dies hier keine, sagen wir mal so schnoddrig daher, AGW-ler Plattform ist. Da bleibt es eben nicht aus, dass Sie hier als Angehöriger einer Minderheit, innerhalb der EIKE-Grenzen gesehen, das eine oder andere Mal Hiebe einstecken müssen. Angesichts dessen ist es andererseits schon bemerkenswert, mit welcher Ausdauer, warum auch immer, Sie hier Ihren Standpunkt vertreten.

Sie müssen oder können zweifellos auch zugeben bzw. anerkennen, dass das im anderen Rest des Lebens genau umgekehrt ist, was die Zugehörigkeit zu einer Minderheit betrifft. Sehen Sie das nicht so, dass das Informationsgeschehen in den Massenmedien zum Thema Klima usw. meist oberflächlich, einseitig, unkritisch und gar tendenziös ist? Bemerken Sie etwa nicht, wie diese Thematik in den Massenmedien schon fast allgegenwärtig ist, wenn man es so bezeichnen will, die gesamte Gesellschaft vom Kindergarten bis ans Grab damit indoktriniert wird? Haben Sie es noch nicht erlebt, wie „andersdenkende“ belächelt, ausgebuht, schief angeguckt, als Ketzer bezeichnet oder, obwohl sie da nicht hingehören, in die faschistoide Ecke gestellt wurden? Und glauben Sie, mit oder ohne Verschwörungstheorie ist man hinsichtlich einer ideologischen Berieselung als Ureinwohner bestimmter Bundesländer besonders sensibilisiert! Auch wissen wir, dass dort die Holzhammer-Methode aller Wahrscheinlichkeit nach genau zum Gegenteil führt bzw. führen würde. In unserer Gegenwart ist das Ganze inzwischen aber weit effizienter und auch subtiler…

Mit freundlichem Gruß

B. Hartmann

P.S.: Und noch etwas Nebensächliches: Bezüglich meines Textes von #5, hinsichtlich seiner Akzeptanz und Verständnisses wäre der Gebrauch, Hinweis usw. auf Gitternetzboxen, die auch noch mit Fehlerintervallen versehen sein sollen, gelinde gesagt, absolut unvernünftig. Das Primat haben grundsätzlich die Messpunkte mit ihren diskreten Raum-Zeit-Koordinaten und den entsprechenden Messwerten!

B.H.

Lieber Herr Hartmann, #5

eine sachliche Diskussion würde ich auch bevorzugen. Leider sehen Sie aber auch, welchen Angriffen ich ausgesetzt bin, wenn ich dabei „Reizworte“ verwende, die mittlerweile dem sachlichen Zusammenhang entnommen wurden und jenseits ihres ursprünglich wissenschaftlichen Sinns eine neue Deutung bekommen haben (vgl. die populären Deutungen, was die Relativitätstheorien besagen sollen). So ist es doch komisch, dass man sich hier mit jeder Erklärung der Physik des Treibhauseffektes gleich „verdächtig“ und als „IPCC-hörig“ verurteilt wird, ohne dass sich die Leute überhaupt Gedanken über den eigentlichen Inhalt gemacht haben. Es reichen Stichworte und schon fällt die Klappe. Ich gebe zu, dass der Vorwurf, zu „Verschwörungstheorien“ anzuhängen, ebenso vorurteil-belastet sein kann. Aber die Beobachtung, welch Widerstand der Einlassung auf eine sachgerechte Diskussion über die „Reizworte“ entgegengebracht wird, zeigt mir, dass hier bei einigen, „etwas nicht stimmen“ kann, denn man bekommt ja fast den Eindruck, man würde sich versündigen…

Zu den Karten: durch die leichte Zugänglichkeit von Karten im Netz, müssen sich die Autoren bewußt werden, dass durch eine laienhafte Deutung die originale Aussage verfälscht wird. Karten verführen dazu, als exakt gedeutet zu werden. Beim Beispiel GISS sehen Sie, dass GISS voll ins Fettnäpfchen tritt. Denn Fehlerbalken sind dort nicht abgebildet, man muss sich erst aufwändig durch die Texte wühlen, um überhaupt mal was über die Genauigkeiten zu finden. Dabei ist jedem Klimatologen klar, dass Fehler in den einzelnen Arealen von x Zehntel Grad durch Messabdeckung und Interpolationsmethoden gar nicht zu vermeiden sind. Nun kann man GISS vorschlagen, dies zu verbessern und neben den Wert auch seine Genauigkeiten pro box anzugeben o.ä. .

Wahrscheinlich haben die ihre Gründe, es so zu tun, wie sie es tun. An dieser Stelle schlägt nun wieder die Stunde der Verschwörungstheoretiker, denn für die ist klar, warum GISS es nicht verbessert, und jedes Argument von GISS warum sie es nicht tun, würde als Ausrede angesehen. Sie sehen, was passieren kann, wenn man in Netz als ultimative Referenz deklariert werden, die sie vielleicht gar nicht erfüllen wollen oder können. Nun ist Hansen keiner, der sich mit seinen Daten im stillen Kämmerlein versteckt, so muss er damit leben, dass dies von ihm gefordert wird. Bei der Popularität von Temperaturdaten sollte sich jeder überlegen, die Daten selbsterklärend und transparent aufzubereiten, dass unsachliche Diskussionen erst gar nicht gereizt werden.

Ja, hier ist es schon wieder, das leidliche Problem bei der Konstruktion von Isolinien und der damit zusammenhängenden Interpolation!

Zu Anfang des Beitrages wird von einem Gitter gesprochen – schon dies führt in eine falsche Richtung! Schon einmal nahm ich hier dazu Stellung. Natürlich habe ich keinerlei Anspruch in dieser Frage von jedem ersnst genommen zu werden. Aber fragen Sie doch Meteorologen, Geographen oder z.B. auch Vermessungsingenieure – all diese müssten das nämlich schon allein berufsbedingt wissen.

Die Basis einer jeglichen Isoliniendarstellung bildet ein Messnetz, bestehend aus einzelnen Messpunkten, an denen entsprechend die jeweils gewünschten Parameter ermittelt werden. Bspw. im Fall der Temperatur der Erdatmosphäre ist dieses Messnetz naturgemäß äußerst unregelmäßig bzw. in seiner Messpunktdichte sehr inhomogen, wie es auch nicht anders sein kann. Erst bei der Verarbeitung dieser Messdaten mit einer bestimmten Software (davon gibt es schon sehr lange weltweit unzählige mehr oder weniger gute Varianten)werden regelmäßige so genannte Gitternetzboxen (die „rätselhaften“ und vielbesagten finiten Elemente!) erzeugt. Es handelt sich dabei also um imaginäre aber auch hilfreiche Konstrukte, die der softwarebedingte Lösungsalgorithmus zur letztendlichen Erstellung von Isolinien so vorsieht.

Es gibt auch funktionstüchtige Software, bei der diese Gitternetzboxen nicht angewendet werden bzw. nirgendwo in Erscheinung treten. Die Erstellung von Isolinien als solche ist ein erlernbares Handwerk, was auch die Kenntnis über die Zulässigkeit und das Verbot der Interpolation unter bestimmten Punkten des Messnetzes und auch mögliche Extrapolationen mit einschließt. Die Isolinienerstellung mit Hilfe von entsprechender Software stellt also eine Automatisierung dieses Prozesses dar. Die Resultate dieser Automatisierung sind nach den oben angedeuteten Regeln durch entsprechend kompetentes Peronal auf ihre Schlüssigkeit und Logik zu überprüfen und gegebenen Falls zu korrigieren. Bedingt durch das formale Herangehen der Software, wie es auch aktuell noch immer der Fall ist, ist diese subjektive Überarbeitung einfach notwendig. In seriösen Häusern wird dieser Schritt auf keinen Fall den Computerfreaks überlassen. Zur Seriosität gegenüber Auftraggebern, der Fachwelt usw. gehört auch, dass Isoliniendarstellungen, welches Wissensgebiet oder Branche sie auch betreffen mögen, grundsätzlich mit der Darstellung des Netzes der Messtellen und der zugehörigen Messwerte in geeigneter Form gekoppelt sein müssen. (Ich setze voraus, dass dies auch in der Klimafachwelt nicht anders praktiziert wird.)

Die eigentliche Wissenschaft bei der Erstellung von Isolinien im Vergleich zum handwerklichen Aspekt liegt in der gezielten Anwendung mathematisch-statistischer Methoden, von Methoden der Wahrscheinlichkeitsrechnung usw. bei der Verarbeitung und Analyse der Messdaten.

Grundvoraussetzung für die Erstellung dieser Art zweidimensionaler Darstellungen ist die Schaffung eines Massivs aus Daten, die volle Berechtigung haben, in „einem Topf“ verarbeitet zu werden. Dazu ist eine einheitliche Messmethodik sowie ein definierter Messzeitpunkt notwendig. Ist dies bspw. bei der Messmethodik nicht der Fall, so müssen die entsprechenden Daten bspw. mit einem Korrekturfaktur versehen werden, ehe sie in den großen „Topf“ gelangen usw. usf.

Die Analyse der Messdaten kann z. B. das Ziel haben, eine komplette Charakteristik bspw. des Messparameters Lufttemperatur zu erzeugen, die es erlaubt, Aussagen über dessen Veränderlichkeit (Variabilität) in Raum und Zeit zu treffen. Damit wäre auch gegeben, ein Messnetz mit optimaler Messpunktdichte bzw. Messpunktverteilung zu begründen. Im Idealfall würde sich ein mehr oder weniger regelmäßiges Messnetz mit lokalen Besonderheiten ergeben, welches in der Ausrichtug der Gitternetzboxen (in diesem Idealfall wären die Messpunkte tatsächlich identisch mit den Ecken der Boxen) die ortsbezogene Veränderlichkeit der jeweiligen Messgröße widersiegelte.

Obige Darstellungen der Temperaturverhältnisse in der Atmosphäre der nördlichen Hemisphäre sind für ein breites Publikum natürlich zulässig als solche, können aber irreführend sein und deshalb eben doch unzulässig, wenn dabei nicht allgemeinverständlich kommentiert wird, wo ihre objektiven und ohne jeglichen Gesichtsverlust begründbaren Unzulänglichkeiten liegen.

Und lieber Herr Innhofer und lieber Herr Bäcker,

es liegt doch auch an uns, welches Niveau hier herrscht oder nicht. Deshalb lassen Sie uns doch bewusst Abstand nehmen von allen vorurteilsbehafteten und pauschalen Verurteilungen und Schuldzuweisungen und an der Stelle sachlich diskutieren. Das haben wir doch alle schon mal hingekriegt!

Auch insofern muss ich nochmals etwas zu „Verschwörungstheorien“ sagen, denen wir alle nicht gern aufsitzen möchten. Dieses Wort ist hier m. E. vollkommen fehl am Platz, denn es handelt sich um viel mehr und etwas ganz anderes, schon allein deshalb, weil daran viel mehr teilnehmen als nur eine handvoll Personen an einer Verschwörung. Bitte versuchen wir doch nicht ganz so blauäugig zu sein als langsam erwachsen werdende Menschen. Ich würde Ihnen vollkommen folgen, wenn unser Thema das einzige wäre, womit von „Oben“ Missbrauch betrieben würde. Es betrifft jedoch noch viel viel mehr und verschiedenste andere Gebiete…

Lieber Gunnar I., #2

ich stimme Ihnen zu. Wie oft wird bewußt die halbe Wahrheit verbreitet, um Verschwörungstheorien am Leben zu halten.

Aber Sie sehen auch, wie leicht es für einen kritischen Leser ist, dahinterzukommen, dass die Sache nicht so einfach ist, wie es gerne dargestellt wird. Herauszubekommen, wie es wirklich ist, ist nun leider nicht mehr so einfach. aber man kommt da wohl nicht drumherum.

Lieber Admin,

was heisst Klarname?

Gunnar I. ist eben Gunnar Innerhofer, muss ich das immer ausschreiben?

Das ist doch ein alter Hut.

Warum kopieren sie einen alten Bericht von WUWT einfach auf ihre Seite, ohne sich dabei etwas mehr zu denken?

Sogar ich habe vor einigen Tagen bei Prima Klima diesen Sachverhalt dargestellt, ungefähr zeitgleich mit A. Watts. Es fällt jedem auf, der ein bisschen up to date ist.

Zu Sache:

wenn sie Lesern was sinnvolles weiter geben wollen, sollten sie auch ein bisschen quantifizieren. Es zeigt sich, dass die 1200km GISS Interpolation eine im Mittel ca. +2,0°C Abweichung ergibt. Aus der DMI Graphik lässt sich eine Abweichung von ca. -0,5°C schätzen.

Diese sind aber auch keine Stationsdaten (ganz wenige nur), der Rest ist die Reanalyses des ECMWF und die ist „OK“ sage ich mal, aber niemals exakt das, was eine Station vermitteln kann.

Auch ich bin ein Kritiker von NASA GISS und von Hansen sowieso, aber wenn sie so schwammige, schlampige und zum Teil haltlose News bringen, machen sie sich selbst nur immer unglaubwürdiger.

Die Amundsen Station über dem Südpol zeigte für Juni zB. eine Abweichung von -2,6°C, auch diese einzige Station um den Pol wird in der Interpolation ebenfalls berücksichtigt, obwohl es vielleicht im Mittel der Fläche nur 1°C zu kalt war. So könnten sich diese Fehler in Summe über längere Zeiträume aufheben bzw. relativieren.

Auch so etwas sollten sie berücksichtigen und ihren Lesern sagen, denn nur papalapap und Verschwörund da und dort usw. ist halt auch zu wenig, finden sie nicht?

MFG

G.I.

„Interpolierte“ GISS-Daten –

wie wär’s mit „harmonisiert“?

Klingt doch viel netter als MANIPULIERT.

Das erinnert an das Durchschnitts-Wohlbefinden, wenn man mit dem Hintern auf der heißen Herdplatte sitzt und mit den Füßen im Eiskübel.