Greg Chapman

„Die Welt hat weniger als ein Jahrzehnt Zeit, um den Kurs zu ändern und eine unumkehrbare ökologische Katastrophe zu vermeiden, warnte die UN heute.“ The Guardian 28. November 2007

„Es ist schwer, Vorhersagen zu treffen, besonders über die Zukunft.“ Yogi Berra

Einführung:

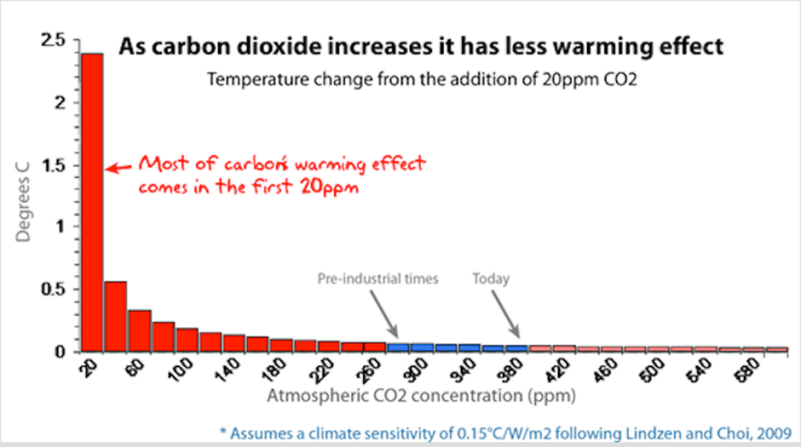

Das weltweite Aussterben aufgrund der globalen Erwärmung wurde schon öfter vorhergesagt als der Klimaaktivist Leo DiCaprio mit seinem Privatjet geflogen ist. Aber woher kommen diese Vorhersagen? Wenn man davon ausginge, dass sie einfach aus der bekannten Beziehung zwischen CO2 und der Absorption des Sonnenenergiespektrums errechnet wurden, würde man aufgrund der logarithmischen Natur der Beziehung nur einen Anstieg von etwa 0,5 °C gegenüber den vorindustriellen Temperaturen als Folge einer CO2-Verdoppelung erwarten:

Der von den Modellen vorhergesagte unkontrollierte Temperaturanstieg von 3-6 °C und mehr hängt von den gekoppelten Rückkopplungen vieler anderer Faktoren ab, darunter Wasserdampf (das wichtigste Treibhausgas), Albedo (der Anteil der von der Oberfläche reflektierten Energie – z. B. mehr/weniger Eis oder Wolken, mehr/weniger Reflexion) und Aerosole, um nur einige zu nennen, die theoretisch die geringe zusätzliche CO2-Erwärmungswirkung verstärken können. Aufgrund der Komplexität dieser Zusammenhänge sind Vorhersagen nur mit Klimamodellen möglich, da sie nicht direkt berechnet werden können.

Der Zweck dieses Artikels besteht darin, dem Laien zu erklären, wie Klimamodelle funktionieren, und nicht darin, sich mit den Problemen zu befassen, die der eigentlichen Klimawissenschaft zugrunde liegen, da die Modelle die primären „Beweise“ sind, die von denen verwendet werden, die eine Klimakrise behaupten. Das erste Problem ist natürlich, dass keine Modellprognose ein Beweis für irgendetwas ist. Es handelt sich lediglich um eine Vorhersage. Deshalb ist es wichtig zu verstehen, wie die Vorhersagen erstellt werden, welche Annahmen ihnen zugrunde liegen und wie zuverlässig sie sind.

Wie funktionieren Klimamodelle?

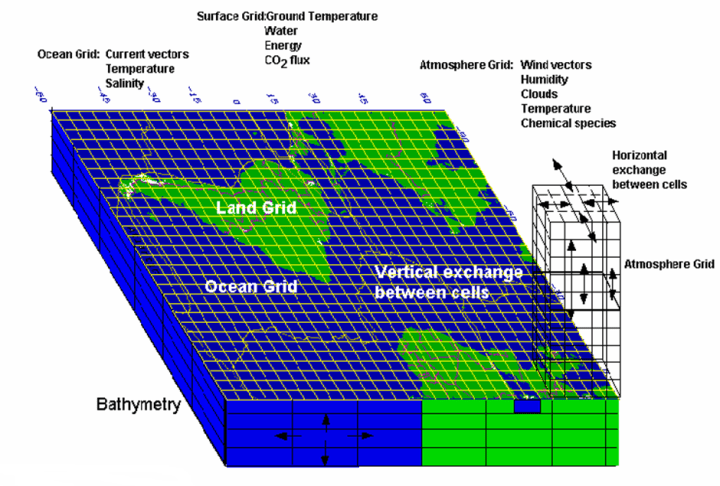

Um die Erde in einem Computermodell abzubilden, wird ein Gitter aus Zellen vom Boden des Ozeans bis zum oberen Rand der Atmosphäre erstellt. Innerhalb jeder Zelle sind die Komponenteneigenschaften, wie Temperatur, Druck, Feststoffe, Flüssigkeiten und Dampf, einheitlich.

Die Größe der Zellen variiert zwischen den Modellen und innerhalb der Modelle. Idealerweise sollten sie so klein wie möglich sein, da sich die Eigenschaften in der realen Welt ständig ändern, aber die Auflösung wird durch die Rechenleistung begrenzt. In der Regel beträgt die Fläche der Zelle etwa 100×100 km², obwohl es über solche Entfernungen erhebliche atmosphärische Schwankungen gibt, so dass jede der physikalischen Eigenschaften innerhalb der Zelle zu einem einzigen Wert gemittelt werden muss. Dies führt zu einem unvermeidlichen Fehler in den Modellen, bevor man sie überhaupt laufen lässt.

Die Anzahl der Zellen in einem Modell variiert, aber die typische Größenordnung liegt bei etwa 2 Millionen.

Sobald das Gitter konstruiert ist, müssen die Komponenteneigenschaften jeder dieser Zellen bestimmt werden. Es gibt natürlich keine 2 Millionen Datenstationen in der Atmosphäre und im Ozean. Derzeit gibt es etwa 10.000 Datenpunkte (Wetterstationen am Boden, Ballons und Ozeanbojen), und wir verfügen über Satellitendaten seit 1978, aber die Abdeckung ist historisch gesehen schlecht. Das hat zur Folge, dass bei der Initialisierung eines Klimamodells, das vor 150 Jahren beginnt, fast keine Daten für den größten Teil der Landoberfläche, die Pole und die Ozeane zur Verfügung stehen, und nichts über der Oberfläche oder in den Tiefen der Ozeane. Dies sollte als ein großes Problem verstanden werden.

Nach der Initialisierung durchläuft das Modell eine Reihe von Zeitschritten. Bei jedem Schritt werden für jede Zelle die Eigenschaften der benachbarten Zellen verglichen. Wenn in einer Zelle ein höherer Druck herrscht, entsteht eine Strömung von dieser Zelle zur nächsten. Wenn sie eine höhere Temperatur hat, erwärmt sie die nächste Zelle (während sie sich selbst abkühlt). Dies kann dazu führen, dass Eis schmilzt oder Wasser verdampft, aber die Verdunstung hat eine kühlende Wirkung. Wenn Polareis schmilzt, wird weniger Energie reflektiert, was zu einer weiteren Erwärmung führt. Aerosole in der Zelle können je nach Art zu einer Erwärmung oder Abkühlung sowie zu einer Zunahme oder Abnahme der Niederschläge führen.

Erhöhte Niederschläge können das Pflanzenwachstum steigern, ebenso wie eine Erhöhung des CO2-Gehalts. Dadurch ändern sich die Albedo der Oberfläche und die Luftfeuchtigkeit. Höhere Temperaturen führen zu einer stärkeren Verdunstung aus den Ozeanen, was die Ozeane abkühlt und die Bewölkung erhöht. Klimamodelle können Wolken aufgrund der geringen Auflösung des Gitters nicht modellieren, und ob Wolken die Temperatur erhöhen oder verringern, hängt von der Art der Wolke ab.

Es ist kompliziert! Natürlich geschieht dies alles in drei Dimensionen und in jeder Zelle, was zu erheblichen Rückkopplungen führt, die bei jedem Zeitschritt berechnet werden müssen.

Die Zeitschritte können so kurz wie eine halbe Stunde sein. Denken Sie daran, dass der Terminator, der Punkt, an dem der Tag in die Nacht übergeht, am Äquator mit etwa 1700 km/h über die Erdoberfläche wandert, so dass selbst halbstündige Zeitschritte weitere Fehler in die Berechnung einbringen, aber auch hier ist die Rechenleistung eine Einschränkung.

Während die Temperatur- und Druckänderungen zwischen den Zellen nach den Gesetzen der Thermodynamik und der Strömungsmechanik berechnet werden, werden viele andere Änderungen nicht berechnet. Sie beruhen auf der Parametrisierung. So variiert beispielsweise der Albedoantrieb von Eiskappen über den Amazonasdschungel und die Saharawüste bis hin zu den Ozeanen und der Wolkendecke sowie allen dazwischen liegenden Reflexionstypen. Diese Eigenschaften werden einfach zugewiesen, und ihre Auswirkungen auf andere Eigenschaften werden aus Nachschlagetabellen ermittelt, nicht berechnet. Die Parametrisierung wird auch für die Auswirkungen von Wolken und Aerosolen auf Temperatur und Niederschlag verwendet. Alle wichtigen Faktoren, die auf einer Untergitter-Skala auftreten, wie Stürme und Ozeanwirbel und -strömungen, müssen ebenfalls parametrisiert werden, wobei eine gemittelte Auswirkung für die gesamte Gitterzelle verwendet wird. Während die Auswirkungen dieser Faktoren auf Beobachtungen beruhen, ist die Parametrisierung eher ein qualitativer als ein quantitativer Prozess und wird von den Modellierern selbst oft als eine Kunst beschrieben, die weitere Fehler mit sich bringt. Die direkte Messung dieser Effekte und ihre Verknüpfung mit anderen Faktoren ist äußerst schwierig und nur unzureichend bekannt.

Vor allem in der Atmosphäre kann es zu scharfen Grenzschichten kommen, die die Modelle zum Absturz bringen. Diese starken Schwankungen müssen geglättet werden.

Auch die Energieübertragung zwischen Atmosphäre und Ozean ist problematisch. Die energiereichsten Wärmeübertragungen finden auf Untergitter-Skalen statt, die über viel größere Gebiete gemittelt werden müssen.

Die Wolkenbildung hängt von Prozessen im Millimeterbereich ab und lässt sich einfach nicht modellieren. Wolken können sowohl wärmen als auch kühlen. Jede Erwärmung erhöht die Verdunstung (die die Oberfläche abkühlt), was zu einer Zunahme von Wolkenpartikeln führt. Auch Aerosole beeinflussen die Wolkenbildung auf Mikroebene. All diese Effekte müssen in den Modellen gemittelt werden.

Wenn die Gitterannäherungen mit jedem Zeitschritt kombiniert werden, kommen weitere Fehler hinzu, und bei halbstündigen Zeitschritten über 150 Jahre sind das über 2,6 Millionen Zeitschritte! Leider sind diese Fehler nicht selbstkorrigierend. Stattdessen akkumuliert sich diese numerische Streuung im Laufe des Modelllaufs, aber es gibt ein Verfahren, welche die Klimamodellierer einsetzen, um dies zu überwinden. Hier folgt eine Kurzbeschreibung desselben.

Initialisierung des Modells

Nach der Erstellung eines Computermodells jeglicher Art erfolgt ein Initialisierungsprozess, bei dem das Modell daraufhin überprüft wird, ob die Ausgangswerte in den einzelnen Zellen physikalisch miteinander vereinbar sind. Wenn man zum Beispiel eine Brücke modelliert, um zu prüfen, ob die Konstruktion starken Winden und Erdbeben standhält, muss man sicherstellen, dass das Modell alle erwarteten Spannungen und Dehnungen einer statischen Struktur erfüllt, bevor man ihm andere äußere Kräfte als die Schwerkraft auferlegt. Denn wenn die Ausgangsbedingungen des Modells nicht stimmen, wie kann man sich dann darauf verlassen, dass es vorhersagen kann, was passiert, wenn äußere Kräfte auf das Modell einwirken?

Glücklicherweise sind bei den meisten Computermodellen die Eigenschaften der Komponenten recht gut bekannt und die Ausgangsbedingungen sind statisch, wobei die einzige äußere Kraft die Schwerkraft ist. Wenn Ihre Brücke bei der Initialisierung nicht stehen bleibt, ist entweder mit dem Modell oder der Konstruktion etwas nicht in Ordnung!

Bei Klimamodellen haben wir zwei Probleme mit der Initialisierung. Erstens haben wir, wie bereits erwähnt, nur sehr wenige Daten für den Zeitpunkt Null, wann immer wir ihn gewählt haben. Zweitens befindet sich das Modell zum Zeitpunkt Null nicht in einem statischen Gleichgewichtszustand, wie dies bei so ziemlich jedem anderen Computermodell der Fall ist, das entwickelt worden ist. Zum Zeitpunkt Null könnte es einen Schneesturm in Sibirien, einen Taifun in Japan, Monsunregen in Mumbai und eine Hitzewelle in Südaustralien geben, ganz zu schweigen von der einen oder anderen Vulkanexplosion, die alle innerhalb eines Tages oder so verschwunden sein könnten.

Es gibt nie einen Zeitpunkt, an dem sich das Klima stabilisiert, so dass es unmöglich ist, Klimamodelle bei der Initialisierung zu validieren.

Das Beste, worauf die Klimamodellierer hoffen können, ist, dass ihr glänzendes neues Modell nicht schon in den ersten paar Zeitschritten abstürzt.

Das Klimasystem ist chaotisch, was im Grunde bedeutet, dass jedes Modell die Zukunft schlecht vorhersagen kann – man kann nicht einmal ein Modell einer Lottokugelmaschine erstellen (die ein vergleichsweise viel einfacheres und kleineres interagierendes System ist) und damit das Ergebnis der nächsten Ziehung vorhersagen.

Wenn also die Klimamodelle mit wenig mehr als Vermutungen statt mit tatsächlichen Beobachtungsdaten zum Zeitpunkt Null gefüllt werden und die Fehler mit jedem Zeitschritt zunehmen, wie gehen die Klimamodellierer dann mit diesem Problem um?

Vergleich mit der Historie

Wenn das System, für das ein Computermodell erstellt werden soll, bereits seit einiger Zeit in Betrieb ist, kann man diese Daten nutzen, um das Modell abzustimmen, und dann die Vorhersage vor Ablauf dieses Zeitraums starten, um zu sehen, wie gut es passt, bevor man Vorhersagen daraus ableitet. Im Gegensatz zu anderen Computermodellierern nennen die Klimamodellierer dies „Hindcasting“*, weil dies nicht so klingt, als würden sie die Modellparameter manipulieren, um die Daten anzupassen.

[*Das könnte man mit „Nachhersage“ übersetzen, aber ein guter deutscher Terminus ist nicht bekannt. Vielleicht hat ein Kommentator eine Idee? A. d. Übers.]

Die Theorie besagt, dass, obwohl die Konstruktion von Klimamodellen viele Mängel aufweist, wie z. B. große Gittergrößen, lückenhafte Daten von zweifelhafter Qualität in den ersten Jahren und schlecht verstandene physikalische Phänomene, die das parametrisierte Klima antreiben, dass man das Modell während des Hindcasting innerhalb der Parameterunsicherheiten abstimmen kann, um alle diese Mängel zu überwinden.

Es stimmt zwar, dass man das Modell so abstimmen kann, dass es zumindest mit einigen Komponenten der Geschichte einigermaßen übereinstimmt, aber die Übereinstimmung ist nicht einzigartig.

Als im letzten Jahrhundert erstmals Computermodelle verwendet wurden, sagte der berühmte Mathematiker John Von Neumann:

„Mit vier Parametern kann ich einen Elefanten anpassen, mit fünf kann ich ihn mit dem Rüssel wackeln lassen“.

In Klimamodellen gibt es Hunderte von Parametern, die auf die Geschichte abgestimmt werden können. Das bedeutet, dass es eine fast unendliche Anzahl von Möglichkeiten gibt, eine Anpassung zu erreichen. Ja, viele davon sind unphysikalisch und werden verworfen, aber es gibt keine eindeutige Lösung, da die Ungewissheit bei vielen Parametern groß ist, und solange man innerhalb der Ungewissheitsgrenzen abstimmt, können immer noch unzählige Übereinstimmungen gefunden werden.

Ein weiterer Fehler beim Abgleich mit der Vergangenheit ist die Länge einiger natürlicher Zyklen. Die Ozeanzirkulation beispielsweise erstreckt sich über Hunderte von Jahren, und wir haben nicht einmal 100 Jahre an Daten, mit denen wir sie abgleichen könnten.

Außerdem ist es schwierig, alle Klimavariablen abzugleichen. Während die globale durchschnittliche Temperatur das Hauptziel des historischen Abgleichs ist, sind andere Daten wie troposphärische Temperaturen, regionale Temperaturen und Niederschläge sowie tageszeitliche Tiefst- und Höchstwerte nur schlecht abzugleichen.

Kann der historische Abgleich der Hauptvariablen, der durchschnittlichen globalen Temperatur, die mit jedem Zeitschritt des Modells unweigerlich auftretenden Fehler eindämmen?

Vorhersagen

Nehmen wir eine Schrotflinte. Wenn der Abzug betätigt wird, bewegen sich die Kügelchen aus der Patrone den Lauf hinunter, aber es gibt auch eine seitliche Bewegung der Kügelchen. Der Flintenlauf hat die Aufgabe, die seitlichen Bewegungen zu dämpfen und die Streuung zu verringern, wenn die Kugeln den Lauf verlassen. Es ist bekannt, dass Schrotflinten auf große Entfernungen nur eine begrenzte Treffsicherheit haben und dass das Schussbild mit der Entfernung zunimmt. Der Zeitraum, in dem ein Klimamodell in die Geschichte eingeht, ist wie der Lauf einer Schrotflinte. Was passiert also, wenn das Modell vom Anpassungs- in den Vorhersagemodus wechselt?

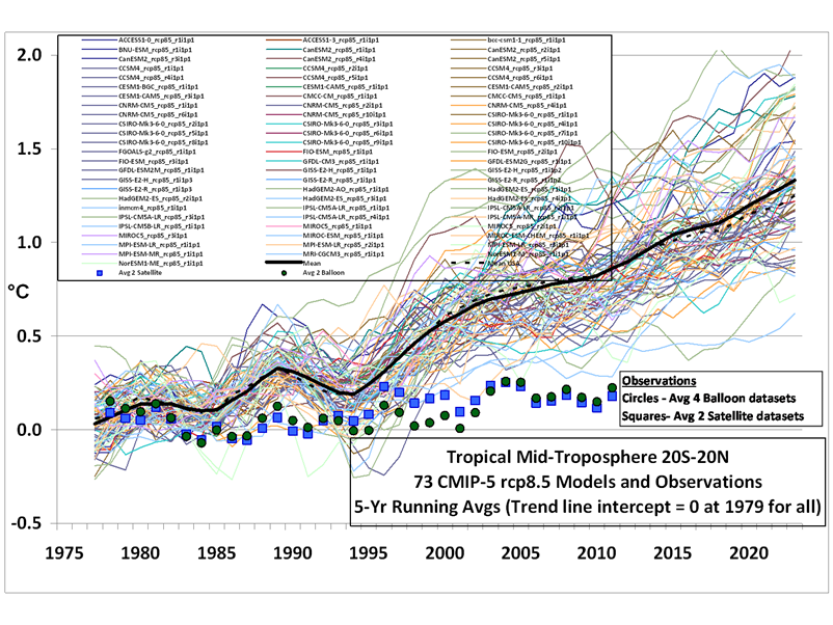

Abbildung 5: IPCC-Modelle im Vorhersagemodus für die mittlere Troposphäre im Vergleich zu Ballon- und Satellitenbeobachtungen [5]

Wie die Gewehrkugeln, die den Lauf verlassen, übernimmt die numerische Streuung in der Vorhersagephase die Führung. Jedes der 73 Modelle in Abbildung 5 wurde in der Vergangenheit abgeglichen, aber außerhalb des Anpassungszeitraums weichen sie schnell voneinander ab.

Nun kann höchstens eines dieser Modelle richtig sein, wahrscheinlicher ist jedoch, dass keines von ihnen richtig ist. Wäre dies ein echter wissenschaftlicher Prozess, würden die wärmsten zwei Drittel der Modelle vom IPCC abgelehnt und weitere Untersuchungen auf die Modelle konzentriert, die den Beobachtungen am nächsten kommen. Das wird aber aus mehreren Gründen nicht getan.

Erstens würde eine Ablehnung der meisten Modelle in der Gemeinschaft der Klimawissenschaftler für Empörung sorgen, vor allem bei den abgelehnten Teams, die daraufhin ihre Finanzierung verlieren würden. Noch wichtiger ist, dass der so genannte 97 %-Konsens sofort in sich zusammenfallen würde.

Zweitens, wenn die wärmsten Modelle verworfen würden, läge die Prognose für 2100 bei einem Anstieg von etwa 1,5°C (der überwiegend auf die natürliche Erwärmung zurückzuführen ist), und es gäbe keine Panik mehr, und der „Gravy Train“ wäre beendet.

Wie also sollte das IPPC diese große Bandbreite an Prognosen miteinander in Einklang bringen?

Stellen Sie sich vor, Sie wollten wissen, wie hoch der Wert von Bitcoin in 10 Jahren sein wird, damit Sie heute eine Investitionsentscheidung treffen können. Sie könnten sich an einen Wirtschaftswissenschaftler wenden, aber wir alle wissen, wie nutzlos deren Vorhersagen sind. Also konsultieren Sie stattdessen einen Astrologen, aber Sie machen sich Sorgen, ob Sie Ihr ganzes Geld auf eine einzige Vorhersage setzen sollten. Um auf Nummer sicher zu gehen, konsultieren Sie 100 Astrologen, aber die geben Ihnen eine sehr große Bandbreite an Vorhersagen. Was sollen Sie nun tun? Sie könnten tun, was der IPCC tut, und einfach den Durchschnitt aller Vorhersagen bilden.

Aber: Man kann die Genauigkeit von Müll nicht verbessern, indem man ihn mittelt.

Ein alternativer Ansatz

Klimamodellierer behaupten, dass eine Anpassung an die Geschichte ohne Einbeziehung des CO2-Antriebs nicht möglich ist. Das mag stimmen, wenn man den hier beschriebenen Ansatz mit seinen vielen Annäherungen verwendet und das Modell nur auf einen einzigen Bezugspunkt (die Temperatur) abstimmt und Abweichungen von anderen (wie der troposphärischen Temperatur) ignoriert, aber analytische (im Gegensatz zu numerischen) Modelle haben Übereinstimmungen ohne CO2-Antrieb erzielt. Dabei handelt es sich um Modelle, die rein auf historischen Klimazyklen beruhen und die Oberschwingungen mit Hilfe einer mathematischen Technik der Signalanalyse ermitteln, die lang- und kurzfristige natürliche Zyklen mit unterschiedlichen Perioden und Amplituden zerlegt, ohne Änderungen der CO2-Konzentration zu berücksichtigen.

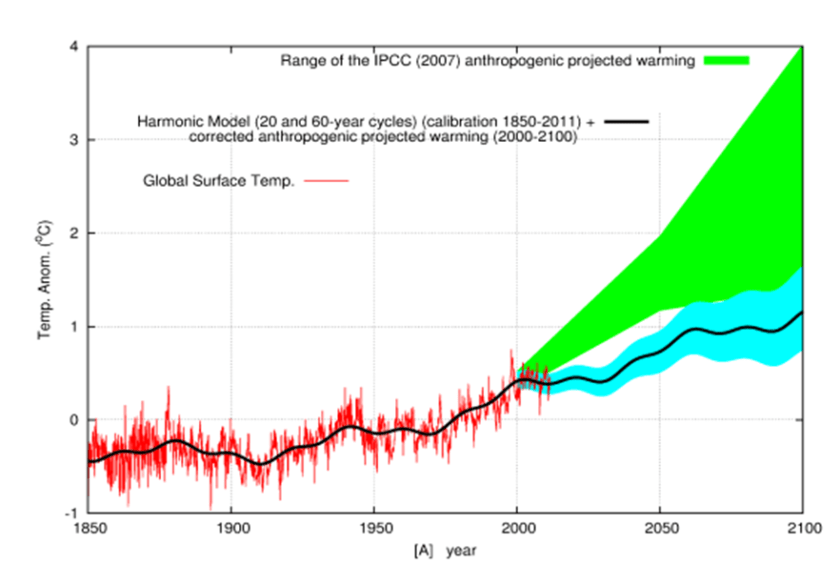

In Abbildung 6 wird ein Vergleich zwischen den IPCC-Vorhersagen und der Vorhersage eines einzigen analytischen harmonischen Modells vorgenommen, das nicht von der CO2-Erwärmung abhängt. Eine Übereinstimmung mit der Geschichte kann durch die harmonische Analyse erreicht werden und bietet eine viel konservativere Vorhersage, die im Gegensatz zu den IPCC-Modellen die aktuelle Pause im Temperaturanstieg korrekt vorhersagt. Mit diesem Beispiel soll nicht behauptet werden, dass dieses Modell genauer ist – es ist nur ein weiteres Modell – sondern es soll mit dem Mythos aufgeräumt werden, dass es keine Möglichkeit gibt, die Geschichte ohne den anthropogenen CO2-Anstieg zu erklären, und es soll gezeigt werden, dass es möglich ist, die Temperaturänderungen mit natürlichen Schwankungen als vorherrschendem Faktor zu erklären.

Abbildung 6: Vergleich der Vorhersagen des IPCC-Modells mit denen eines harmonischen analytischen Modells [6].

Zusammengefasst:

● Klimamodelle können aufgrund mangelnder Daten und eines chaotischen Anfangszustands nicht durch eine Initialisierung validiert werden.

● Die Modellauflösung ist zu gering, um viele Klimafaktoren abzubilden.

● Viele der Antriebsfaktoren sind parametrisiert, da sie von den Modellen nicht berechnet werden können.

● Unsicherheiten bei der Parametrisierung bedeuten, dass es keine eindeutige Lösung für das History Matching gibt.

● Die numerische Streuung über die Phase der historischen Anpassung hinaus führt zu einer großen Divergenz in den Modellen.

● Das IPCC lehnt es ab, Modelle zu verwerfen, die in der Vorhersagephase nicht mit den Beobachtungsdaten übereinstimmen – und das sind fast alle Modelle.

Die Frage ist nun, ob Sie das Vertrauen haben, Billionen von Dollar zu investieren und den Lebensstandard von Milliarden von Menschen zu senken, um die von den Klimamodellen vorhergesagte globale Erwärmung zu stoppen, oder ob wir uns einfach an die natürlichen Veränderungen anpassen sollten, wie wir es immer getan haben.

Greg Chapman is a former (non-climate) computer modeler.

Footnotes

[2] https://serc.carleton.edu/eet/envisioningclimatechange/part_2.html

[3] https://climateaudit.org/2008/02/10/historical-station-distribution/

[4] http://www.atmo.arizona.edu/students/courselinks/fall16/atmo336/lectures/sec6/weather_forecast.html

Während die Klimamodelle auf die Temperaturen abgestimmt sind, sagen sie einen troposphärischen Hotspot voraus, den es nicht gibt. Dies allein sollte die Modelle ungültig machen.

Link: https://wattsupwiththat.com/2022/11/10/the-dirty-secrets-inside-the-black-box-climate-models/

Übersetzt von Christian Freuer für das EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"… und dann kommt Dr. Nuke und drückt die rote Taste. Dann hat sich jeglicher Klimawandel zu hohen Temperaturen hin sowieso erledigt😂

Danke für diese gut nachvollziehbare Beschreibung der Klimamodellierung und ihrer inhärenten Unzulänglichkeiten und Schwächen! Hinzu kommt das extreme Anwachsen der Fehlerwahrscheinlichkeiten, wie sie Pat Frank aufgezeigt hat. Die vielen Klima-Aktivisten/Terroristen auf der Straße ahnen nicht im Entferntesten, dass sie die größten Verdummungsopfer der Neuzeit abgeben. Die Nachwelt wird sich ihrer schämen – oder sich erheitern, falls die Wahn-Folgen sich in Grenzen halten.

Na, dann wissen wir es ja in ein paar Jahren.

…“aber analytische (im Gegensatz zu numerischen) Modelle haben Übereinstimmungen ohne CO2-Antrieb erzielt.“

Das bestätigt mein „Idiotaüberzeugung“: es geht nicht um Klima, es geht um Geselschaftumwandlung, eh, pardon, kaputmachung…

Nur mal grundsätzlich und „ergänzend“ eingeworfen, nicht speziell zu „Klimamodellen“ sondern EDV-generell:

Schon 1986 programmierte ich selbst bei einem eigenen Programm mit dem ich viel arbeiten mußte und viele Stunden Zeit verbringen oder auch nicht, eine ganz diskrete „zusätzliche“ Schleife (ich nannte sie einfach für mich selbst die „GOTT-Schleife“!), die außer mir, nur wenige Kollegen kannten und überhaupt aufrufen konnten. Andere wußten gar nichts davon. Darin fragte das Programm ganz simpel undn salopp formuliert beim Bediener, nach Eingabe aller betroffenen Parameter einer Rechenaufgabe, final nach:

„Herrgott, was willst DU als Endergebnis? Wie lange soll ich scheinbar daranb herumrechnen?“

Dann kam nachher -oh Wunder- immer das heraus, was mir praltischerweise zu lange Abende und unnötige Zeitverschwendungen, wegen irgendwelcher Nachkommastellen und so, ersparte.

Als Realist glaube ich NICHT, daß die Programmierer und gut bezahlten IT-Fachleute beim PIK und anderswo, etwa DÜMMER seien, als ich es 1086, also vor 36 Jahren, gewesen war…

Den „Rest“ mag sich jetzt jeder selbst denken…

Werner Eisenkopf

Genauso läuft es wie von Ihnen, lieber Herr Eisenkopf beschrieben, ist der Ablauf. Die IT-Fachleute werden doch dafür bezahlt, das richtige Ergebnis zu finden. Neue Computer und eine neue Software liefern noch schlimmere Klimapanikmeldungen, dafür ziehen 440 Mitarbeiter beim PIK an einem Strang, damit die staatlichen Zuschüsse weiter fließen. Klimalpanik ist ein Geschäftsmodell.

Kriegen es unsere „heutigen“ Klimamodelle eigentlich sauber hin, das Klima vergangener Erdzeitalter (Jura, Kreide, usw.) nachzuvollziehen, ohne dass die Parametrisierung absurd angepasst werden muss?

Nein, das versuchen sie aber auch nicht.

Kurze, schnippische Antwort.

Lassen sie uns doch mal an ihrem Wissensstand teilhaben, welchen Gültigkeitsbereich unseren hochgeschätzten Klimamodelle haben. 1880 bis heute. Und davor und danach?

Gibt’s keine zitierfähige Publikation, die einschätzt, inwieweit Klimamodelle die Naturgesetze eigentlich eingefangen haben?

Weil Lindzen, Choi 2009 immer wieder zitiert wird, zumindest per Grafik; hat denn jemals einer gelesen was da drin steht und worum es da geht? Ich vermute eher nicht.

Das Diagramm zeigt die gänzliche Lächerlichkeit um CO2 als Triebfeder für den Klimawandel auf. Mehr braucht man dazu nicht zu sagen!

Und was ist mit den diversen prognostizierten und vore allem berechneten!! (u.a. Prof. H. Abdusamatov 2008) Aussagen zur kommenden Abkühlung – vulgo neues Maunder Minimum? Das ist in Figure 3 nicht im Ansatz enthalten. Da geht es munter immer weiter nach oben – ob gestreut oder gemittelt oder sonstwas. Nun denn – nur weiter so. Damit hat die Union unter Kohl noch eine Wahl gewonnen – aber dann war Schluß mit lustig, dann kamen die Grünen mit der SPD zusammen ans Ruder, danach der SED/FdJ-Import. Wer hat die dem Kohl damals nur aufs Auge gedrückt? Wer sich mal was „Ergötzliches“ antun möchte, dem sei das Interview von Günter Gaus mit der angehenden Ministerin Merkel aus 1991 „empfohlen“: https://www.youtube.com/watch?v=YQBslPEZceI

Wer das damals gesehen hatte, hatte keine Fragen mehr – doch die eine noch: Wie konnte das passieren?

Ich weiß nicht, wie viel Ahnung der Autor von tatsächlichen Klimamodellen hat.

Weil eines erwähnt er nicht, und das ist das permanente Erfordernis, daß die Energiebilanz zwischen zugeführter und abgegebener Energie stimmig sein muß. Das ist eine der wichtigsten Grundanforderungen am Modelle.

Die allgemein dargestellte Vision, daß bei gleichbleibender Energiezufuhr die Temperatur mit „Ende nie“ ansteigen kann, ist einfach unphysikalisch. Punkt! Egal wie groß eine Zellengröße ist und egal welche Parameter man erfindet.

Klimamodelle sind jene Burgen, in denen sich Wisssenschaftler, die von ihrer Wissenschaft nichts verstehen, verstecken können, ohne das die Allgemeinheit es nachvollziehen kann.