Diejenigen unter Ihnen, die WUWT schon seit einigen Jahren verfolgen, wissen, dass ich oft praktische Experimente durchführe, um einige der lächerlichsten Behauptungen zum Klimawandel zu veranschaulichen und zu entkräften, die auf beiden Seiten der Debatte aufgestellt werden. Auf der Seite der Panikmacher erinnern Sie sich vielleicht an dieses Experiment:

Al Gore und Bill Nye VERSAGEN bei einem einfachen CO2-Experiment.

Die Replikation von Al Gores Videoexperiment Climate 101 (aus dem 24-Stunden-Gore-a-thon) zeigt, dass seine „Highschool-Physik“ niemals so funktionieren kann, wie angekündigt.

Leider hat YouTube das Video abgeschaltet, aber ich werde versuchen, es anderswo zu veröffentlichen, z. B. auf Rumble. Die Diagramme der Temperaturmessungen und andere Bilder sind noch da.

Trotz der Tatsache, dass ich zweifelsfrei bewiesen habe, dass das Experiment nicht nur tödlich mangelhaft, sondern sogar FALSCH war, wird es heute noch als Propaganda auf der Webseite von Al Gore verwendet.

Sie haben es nie heruntergenommen. Idioten.

In diesem Sinne habe ich, wie Willis es oft tut, über den kürzlich in Atmosphere veröffentlichten Artikel einiger unserer Waffenbrüder (Willie Soon, The Connallys usw.) in Sachen Klimaskepsis nachgedacht [Zu dieser Studie ist ein anderer Beitrag in deutscher Übersetzung beim EIKE hier veröffentlicht].

[etwa: Bewertung der Homogenisierungs-Anpassungen, die auf die europäischen Temperaturaufzeichnungen im Datensatz des Globalen Netzwerks für historische Klimatologie (GHCN) angewendet wurden

Abstract

Der weit verbreitete monatliche Temperaturdatensatz des Global Historical Climatology Network (GHCN) ist in zwei Formaten verfügbar – nicht homogenisiert und homogenisiert. Seit 2011 wird dieser homogenisierte Datensatz fast täglich aktualisiert, indem der „paarweise Homogenisierungsalgorithmus“ (PHA) auf die nicht homogenisierten Datensätze angewendet wird. Frühere Studien haben gezeigt, dass der PHA bei der Korrektur synthetischer Zeitreihen gut funktioniert, wenn bestimmte künstliche Verzerrungen eingeführt werden. Seine Leistung bei realen Daten ist jedoch weniger gut untersucht worden. Daher wurden die homogenisierten GHCN-Datensätze (Version 3 und 4) über einen Zeitraum von zehn Jahren (2011-2021) fast täglich heruntergeladen, was 3689 verschiedene Aktualisierungen der Datensätze ergab. Die verschiedenen identifizierten Bruchpunkte wurden für eine Reihe von Stationen aus 24 europäischen Ländern analysiert, für die Metadaten zur Stationsgeschichte verfügbar waren. Dabei zeigte sich eine bemerkenswerte Inkonsistenz bei den identifizierten Haltepunkten (und damit den vorgenommenen Anpassungen). Von den für GHCN Version 4 angewandten Anpassungen wurden 64 % (61 % für Version 3) bei weniger als 25 % der Läufe identifiziert, während nur 16 % der Anpassungen (21 % für Version 3) bei mehr als 75 % der Läufe konsistent identifiziert wurden. Die Konsistenz der PHA-Anpassungen verbesserte sich, wenn die Haltepunkte mit dokumentierten Ereignissen in den Metadaten der Stationsgeschichte übereinstimmten. Allerdings waren nur 19 % der Haltepunkte (18 % für Version 3) mit einem dokumentierten Ereignis innerhalb eines Jahres verbunden, und 67 % (69 % für Version 3) waren mit keinem dokumentierten Ereignis verbunden. Obwohl der PHA ein nützliches Werkzeug in der Homogenisierungs-Toolbox der Gemeinschaft bleibt, könnten viele der PHA-Anpassungen, die auf den homogenisierten GHCN-Datensatz angewendet wurden, falsch gewesen sein. Die Verwendung von Stationsmetadaten zur Bewertung der Zuverlässigkeit von PHA-Anpassungen könnte möglicherweise dazu beitragen, einige dieser falschen Anpassungen zu identifizieren.

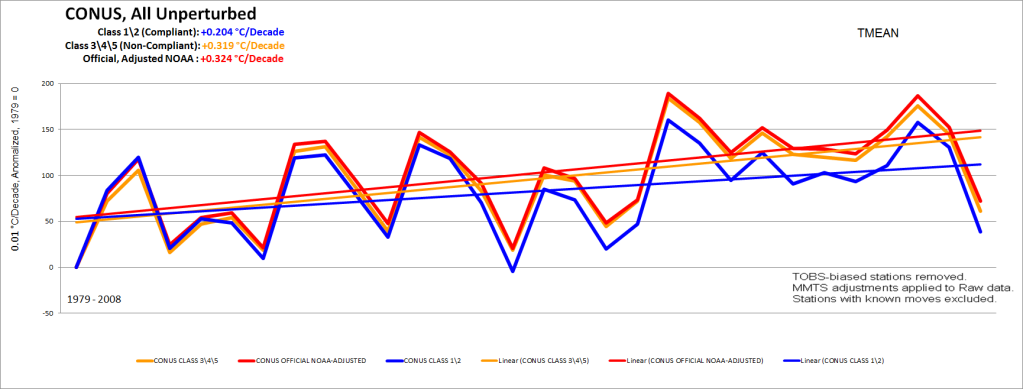

Zusammengefasst kommen sie zu dem Schluss, dass der Homogenisierungsprozess künstliche Verzerrungen in die langfristigen Temperaturaufzeichnungen einführt. Das ist etwas, was ich schon vor über 10 Jahren beim USHCN vermutet und auf der AGU 2015 mit dieser Grafik veröffentlicht habe, die zeigt, dass das Endprodukt der homogenisierten Daten so viel wärmer ist als Stationen, die nicht durch Urbanisierung und künstliche Oberflächen wie Asphalt, Beton und Gebäude beeinträchtigt wurden. Nach meiner Analyse sind fast 90 % des gesamten USHCN-Netzes nicht standortkonform und leiden daher unter den falschen Auswirkungen nahe gelegener Wärmequellen und -senken:

In dem neuen Papier gibt es einen relevanten Absatz, der sich auf die Grafik bezieht, die ich 2015 auf der AGU veröffentlicht habe:

Je mehr Haltepunkte für jeden Datensatz angepasst werden, desto mehr werden sich die Trends dieses Datensatzes den Trends seiner Nachbarn annähern. Auf den ersten Blick mag dies wünschenswert erscheinen, da die Trends der homogenisierten Datensätze homogener sein werden (wohl eines der Hauptziele der „Homogenisierung“), und daher haben einige gegen diese Kritik Einspruch erhoben [41]. Wenn jedoch mehrere Nachbarn systematisch von ähnlichen langfristigen nicht-klimatischen Verzerrungen betroffen sind, dann werden die homogenisierten Trends eher zu den Durchschnittswerten des Stationsnetzes (einschließlich systemischer Verzerrungen) konvergieren als zu den wahren klimatischen Trends der Region.

Der Schlüsselbegriff ist „mehrere Nachbarn, d. h. nahe gelegene Stationen“.

Bereits am 1. August 2009 habe ich eine Analogie zu diesem Problem mit der Homogenisierung anhand von Schüsseln mit schmutzigem Wasser erstellt. Wenn das sauberste Wasser (eine gute Station an einem guten Standort) mit nahegelegenen Stationen homogenisiert wird, die aufgrund von Schmutz im Wasser unterschiedliche Trübungsgrade aufweisen, wobei 5 der schlechteste Wert ist, vermischt die Homogenisierung effektiv das saubere und das schmutzige Wasser, und am Ende erhält man einen Datenpunkt für die mit „?“ gekennzeichnete Station, der einen gewissen Trübungsgrad aufweist, aber nicht klar ist. Im Grunde handelt es sich um eine Datenmischung aus sauberen und schmutzigen Daten, die zu trübem Wasser bzw. verworrenen Daten führt.

Bei der Homogenisierung werden die Daten im Vergleich zu den benachbarten Stationen in einem bestimmten Umkreis gewichtet. So kann eine Station, die mit einem Wert von „1“ beginnt, mit den Daten der benachbarten Stationen verunreinigt werden und als neuer Wert, z. B. gewichtet mit „2,5“, enden.

Was glauben Sie, wie hoch die Werte (der Trübung) der Stationen in der Karte unten sein würden, wenn eine homogenisierende Glättung angewandt und die Stationen in der Nähe der Stationen mit den Fragezeichen nach ihrer Entfernung gewichtet würden? Und wie nahe würden diese beiden Werte für die fragliche Station an der Ostküste und die fragliche Station an der Westküste beieinander liegen? Beide würden näher an einem geglätteten mittleren Wert liegen, der auf den benachbarten Stationen basiert.

Natürlich ist dies nicht die eigentliche Methode, sondern nur eine visuelle Analogie. Aber es ist im Wesentlichen das, was laut diesem neuen Papier mit den Temperaturdaten geschieht.

Und es liegt nicht nur an mir und dieser neuen Studie, die dies behauptet. Bereits 2012 habe ich über eine andere Studie berichtet, die das Gleiche behauptet.

Neue Studie macht Homogenisierung von Wetterstationsdaten für etwa die Hälfte der globalen Erwärmung verantwortlich

Die Autoren Steirou und Koutsoyiannis kommen nach Berücksichtigung von Homogenisierungsfehlern zu dem Schluss, dass die globale Erwärmung im vergangenen Jahrhundert nur etwa die Hälfte [0,42 °C] der vom IPCC behaupteten Erwärmung [0,7-0,8 °C] betrug.

Hier ist der Teil, der mir wirklich gefällt: Bei 67 % der untersuchten Wetterstationen wurden fragwürdige Anpassungen an den Rohdaten vorgenommen, die zu folgenden Ergebnissen führten:

„verstärkte positive Trends, verringerte negative Trends oder änderte negative Trends in positive“, während „der erwartete Anteil bei 1/2 (50%) liegt“.

Und:

„Die bis heute angewandten Homogenisierungsverfahren sind hauptsächlich statistisch, nicht gut durch Experimente begründet und werden selten durch Metadaten unterstützt. Es kann argumentiert werden, dass sie oft zu falschen Ergebnissen führen: natürliche Merkmale hydroklimatischer Zeitreihen werden als Fehler angesehen und bereinigt.“

Aus meiner Sicht ist es also ziemlich klar, dass die Homogenisierung eine falsche Klimaerwärmung hinzufügt, wo es eigentlich kein echtes Klimasignal gibt. Stattdessen wird der Urbanisierungseffekt, der zu einer Erwärmung der Durchschnittstemperatur führt, aufgegriffen und dem Klimasignal hinzugefügt.

Steve McIntyre stimmt dem in einem Beitrag zu und schreibt:

Wenn schließlich Referenzinformationen von nahe gelegenen Stationen verwendet wurden, neigen Artefakte an Nachbarstationen dazu, Anpassungsfehler zu verursachen: das Problem der „schlechten Nachbarn“. In diesem Fall wurden nach der Anpassung die Klimasignale an nahe gelegenen Stationen ähnlicher, auch wenn die durchschnittliche Verzerrung über das gesamte Netzwerk nicht verringert wurde.

Daher möchte ich ein Experiment zur Simulation und Veranschaulichung des „Bad Neighbour“-Problems mit Wetterstationen konzipieren und ein Video dazu erstellen.

Ich denke dabei an Folgendes:

1. Verwenden Sie die Analogie zur Trübung in irgendeiner Weise, vielleicht mit roter und blauer Lebensmittelfarbe anstelle eines Schwebstoffs, der sich absetzen wird. Dies dient lediglich der Veranschaulichung.

2. Verwenden Sie die tatsächliche Temperatur, indem Sie Temperatur-kontrollierte Wasserfläschchen mit unterschiedlichen Temperaturen herstellen.

3. Mischen des Inhalts der Fläschchen und Messen der daraus resultierenden Trübung/Farbänderung und der daraus resultierenden Temperatur der Mischung.

Der Trick besteht darin, einzelne Temperatur-kontrollierte Wasserfläschchen herzustellen und diese Temperatur zu halten. Dazu werden einige Laborgeräte, Schläuche und Pumpen benötigt.

Zur Veranschaulichung könnte ich eine Karte der USA oder der Welt erstellen, die Fläschchen darin platzieren und damit die Ergebnisse visualisieren und messen.

Übersetzt von Christian Freuer für das EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"„Neue Studie macht Homogenisierung von Wetterstationsdaten für etwa die Hälfte der globalen Erwärmung verantwortlich“

Unsere grünen Trottel im Westen, aufgehetzt von den unfähigsten und skrupellosesten „Forschern“ aller Zeiten, wollen das „Weltklima retten“. Diese einfältigen Deppen, wie man sie bei uns auch in Karlsruhe, den grünen Redaktionsstuben, auf den Bäumen und auf der Straße findet, ruinieren das Land und die Menschheit mit vollster Hingabe und nie da gewesener Einfalt und Dummheit – wegen ein paar Zehntel Grad angeblicher globaler Erwärmung, die uns allen gut tut. Und wegen einem wertvollen Pflanzendünger CO2, der uns allen zum Segen gereicht, und nicht viel weiter steigen wird – ganz ohne Dekarbonisierungs-Wahn.

Die grüne Pe.., die in den Umweltministerien und an den Regierungsschalthebeln ihr Unwesen und Zerstörungswerk betreibt, macht eine Katastrophe daraus, diese üblen Menschheitsverbrecher. Wie werden wir diese elende grüne Verdummungs-Mafia, diesen größte Menschheits-Katastrophe, nur wieder los? Und deutsche Klima- und Energiewende-Deppen stehen wie immer an die Spitze der Menschheits-Schädiger, diese größten Trottel auf dem Globus, das lassen sich elend dumme deutsche Vorreiter einfach nicht nehmen…

Die neueste Masche:

Die Regierung dreht jetzt aber noch schneller:

Aus der BZ Berlin hier

„