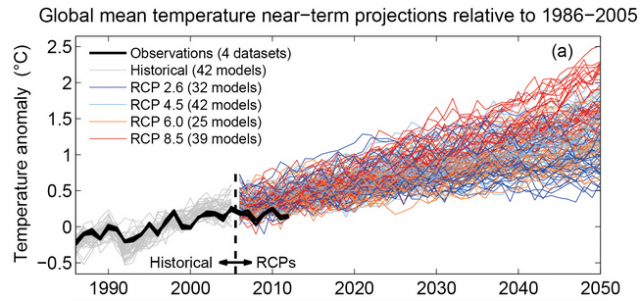

Im IPCC-Report AR5 wurde das folgende Diagramm gezeigt, woraus hervorgeht, wie sehr die Modelle die jüngste Erwärmung übertreiben:

Dabei handelt es sich um die Abbildung 11.25, die auch in der Technical Summary als Abbildung TS-14 erschien. In Kasten TS3 wird darüber Folgendes ausgeführt:

„Eine Analyse sämtlicher historischer Simulationen der CMIP5-Modellkette (ergänzt für den Zeitraum 2006 bis 2012 mittels RCP4.5-Simulationen) zeigt, dass 111 der 114 Realisationen von 1998 bis 2012 einen GMST-Trend zeigen, der höher ist als der Trend im gesamten HadCRUT4-Ensemble (Kasten TS.3, Abbildung 1a; der mittlere Trend des Ensembles laut CMIP5 beträgt 0,21°C pro Dekade). Diese Differenz zwischen simulierten und gemessenen Trends könnte zustande kommen durch eine Kombination von a) der internen Klima-Variabilität, b) fehlendem oder falschem RF und c) Fehler der Modell-Reaktion“.

Nun könnte man denken, dass die neuen Modelle besser sind als ihre Vorgänger. Dies ist mathematische Modellierung 101: Falls ein Modell nicht zu den Daten passt, verbessert man das Modell entsprechend, um die Daten besser zu repräsentieren. Aber diese elementare Logik kommt im Bereich Klimawissenschaft in keiner Weise zum Tragen.

Das Hauptmerkmal (-fehler?) der neuen Modelle ist deren hohe Klima-Sensitivität. Man erinnere sich an die Aussage des IPCC, dass die Gleichgewichts-Sensitivität 1,5 bis 4,5°C beträgt, also eine Bandbreite, die sich über 30 Jahre nicht geändert hat. Die Studie des Met.-Office wartet mit einer Graphik von 5,4°C auf und die GFDL-Gruppe mit rund 5°C. Beide liegen also weit außerhalb der vom IPCC angegebenen Bandbreite. Natürlich haben die nützlichen Idioten in den Medien nichts Eiligeres zu tun als zu posaunen, dass sich die Erde noch schneller erwärmt als ursprünglich gedacht (hier). Aber solches wird nicht einmal in den Studien selbst behauptet.

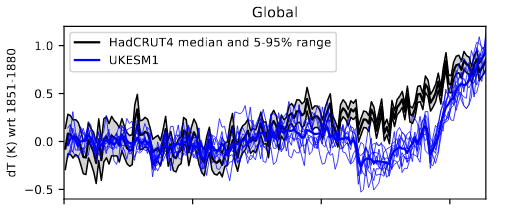

Angesichts des Umstandes, dass die früheren Modelle zu warm laufen, wie es aus obiger IPCC-Graphik hervorgeht, und des Umstandes, dass in die neuen Modelle eine viel höhere Sensitivität eingeht, lautet die offensichtliche Frage, wie gut die Modelle sind hinsichtlich der Reproduktion im 20. Jahrhundert. Nun, man muss sich durch die gesamte UKESM1-Studie wühlen, um die Antwort auf diese Frage zu finden, aber vielleicht geht sie auch aus Abbildung 29 hervor, in welcher das neue Modell verglichen wird mit HadCRUT4 von 1850 bis zur Gegenwart:

(Die GFDL-Studie zeigt eine sehr ähnliche Grafik in Abbildung 12). Das Modell zeigt eine Erwärmung in jüngster Zeit, die erheblich über derjenigen der Beobachtungen liegt. Das Modell ist eindeutig viel zu sensitiv. Und was sagen die Autoren dazu? Es ist unglaublich, aber sie behaupten gleich oben in der Studie im Abschnitt „key points“:

UKESM1 zeigt gute Ergebnisse, mit einem stabilen vorindustriellen Zustand, und es zeigt eine gute Übereinstimmung mit Beobachtungen in einer breiten Vielfalt von Zusammenhängen.

Dann wiederholen sie diese Falschaussage im Abstract und behaupten, dass die Übereinstimmung genau dort besonders gut ist, wo sie besonders schlecht ist:

Alles in Allem zeigt das Modell gute Ergebnisse, mit einem stabilen vorindustriellen Zustand und guter Übereinstimmung mit den Beobachtungen im späteren Teil seiner historischen Simulationen.

Und noch einmal wiederholen sie das in der „plain language summary“ darunter. Vermutlich ist beabsichtigt, dass diese Lüge von den ahnungslosen Medien immer wieder herausgewürgt wird.

Selbst der alarmistische Klimawissenschaftler und BDS-sufferer [?] James Annan spottet über die Behauptungen in der Studie (hier) und schlägt die Formulierung vor „UKESM1 funktioniert großartig in jeder anderen Hinsicht als in seine primären Funktion“.

Betrügen sich diese Klima-Schussel am Met.-Office wirklich so sehr, dass sie von einer guten Übereinstimmung ausgehen? Hierzu kann man nur Richard Feynman mit seinen Worten zitieren:

Oberste Priorität muss es haben, sich nicht selbst zu betrügen – denn man selbst kann sich am leichtesten betrügen. [Siehe Bild oben!]

Link: https://cliscep.com/2019/11/05/new-climate-models-even-more-wrong/

Übersetzt von Chris Frey EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Logischerweise könnte nur 1 Modell richtig sein falls man daran glaubt.Aber selbst das fällt den Politikern anscheinend nicht auf…

„Falls man daran glaubt“ weil selbst das IPCC sagt das man das Klima NICHT vorhersagen kann.

Warum sollten Computermodelierer, die wahrscheinlich nicht einmal ein Doktor haben in diesem Fach, wenn sie an die Erwärmung glauben müssen, plötzlich gegenteilige Ergebnisse Publizieren? Job weg. Da ist nichts zuerwarten es sei denn die Finanzierung wechselt das Lager.

Was soll das schon wieder?

Die erste Grafik hört bei ca. 2012/13 auf, bei der zweisten Grafik ist die Rechts-Achse überhaupt nicht bezeichnet.

So macht sich EIKE unglaubwürdig!

MfG Oliver Schlicht

Herr Schlicht,

sie sollten mal lesen aus welcher Quelle die Grafiken stammen. EIKE hat diese nicht erstellt.

Also machen sich das IPCC und die Wissenschaftler unglaubwuerdig?

Diesen Bumerang sollten sich besser fangen, bevor er Ihnen das Kartenhaus zerschlaegt.

Na ja, der geneigte Leser könnte durchaus dem Link auf die Arbeit folgen und die Grafik dort bestaunen.

Die fehlende Achsenbeschriftung kam daher, dass dort eine Dreifach-Grafik abgebildet ist:

– Global

– Nordhemisphäre

– Südhemisphäre

Im EIKE-Artikel wurde halt besondere Aufmerksamkeit auf die globalen Temperaturanomalien gelegt und die beiden Hemisphären-Grafiken weggeschnitten. Dass dadurch die Abszisse wegfiel, ist natürlich etwas unglücklich. Aber gleich mit „unglaubwürdig“ zu kommen, halte ich etwas übertrieben.

Wie gesagt – selber in der Primärliteratur nachschauen (was man eigentlich IMMER tun sollte!) würde das „Problem“ lösen.

Noch was:

Dass die Kurve der „Observations“ in Abb.1 bereits bei ~2012 endet, ist auch kein Zeichen der Unglaubwürdigkeit von EIKE.

Nein, die Abbildung ist dem „Technical Summary“ des AR5 des IPCC entnommen. Und der wurde bekanntlicherweise 2013 publiziert. Hier war die Modellgeneration CMIP5 verwendet worden.

Das Thema dieses Artikel ist, dass die neue Modellgeneration CMIP6 die Beobachtungen noch schlechter repräsentiert, was mit Abb. 2 belegt wird.

Ich sehe keine Grundlage für Ihre Kritik. Also könnte man sich ob Ihrer Einlassung fragen: „Was soll das schon wieder?“

Die Temperaturen steigen, Global betrachtet, zweitwärmster Oktober seit 130 Jahren.

Er ist sogar noch wärmer als in den Hitzejahren 2014, 2016, 2017 und 2018.

Nur im Jahr 2015 konnte das Wetter im Oktober eine NOCH höhere Temperaturen aufweisen.

Toll oder. Warmes Wetter!

Noch besser: Warmes Klima!

Das hieße ja, dass die Temperaturen global betrachtet seit 2015 sinken.

Tatsächlich liefern alle bei Woodfortrees verfügbaren Temperaturmodelle außer GISTEMP dTs bei Betrachtung ab 2015 einen fallenden linearen Trend. Könnte also hinkommen.

Sehr geehrter Herr Breiner,

haben Sie sich bei diesen Meldungen wie „zweitwärmster Oktober seit 130 Jahren“ eigentlich noch nie gefragt, ob das denn stimmt.

Glauben Sie wirklich ernsthaft, dass man den Temperaturdurchschnitt der gesamten Welt auf Hunderstel Grad genau bestimmen kann?

MfG

PS: Apropos Glauben und Wissen – die Frage „Stimmt das denn?“ ist die grundlegende Frage der Wissenschaft. Ohne diese Frage gäbe es nur Glauben und wir würden heute noch glauben, dass es auf den Bäumen wohl am besten für uns ist.

Also, der Vergleich des Modells mit HadCRUT4 ist dem entscheidenden letzten Abschnitt so krass, dass man es fast nicht glauben möchte – plumper geht es nicht. Ein derart verzerrter Anstieg gerade im letzten Abschnitt liefert dann exakt die gewünschte extrem steile Extrapolation und somit die Phantasiewerte für die Temperatursensitivität. Aber für unsere denkunfähigen „Klimaexperten“ in Politik und Medien erfüllt es garantiert seinen Zweck, mehr soll es wahrscheinlich auch nicht. So kann man sich dann auch zukünftig weiter von Modell zu Modell hangeln, natürlich unentwegt verbessert. Umweltministerinnen lassen sich sogar mit einem 99%-Konsens verblöden…

Und gleichzeitig muss man den Temperatur-Messwerte-Sammlern mit allergrößtem Misstrauen auf die Finger schauen. Die Berichte über Manipulationen sind endlos, natürlich wird dabei stets der gewünschte Temperaturverlauf bestätigt oder der Anstieg verstärkt. Man darf gespannt sein, ob und wie sich peu a peu der Hiatus seit Ende der 90er-Jahre immer mehr in einen Anstieg verwandelt…

Den größeren Fehler macht der Betrachter der Modelle, nicht der Erschaffer.

Ein Phänomen, das ich nun häufiger beobachte: Wenn ich sage „es ist 18 Grad warm“ kommt aus der Umgebung eine Antwort: „Mein Handy zeigt aber nur 15 Grad an“. Wo liegt der Fehler? Ich fürchte jüngere (und aus meiner Sicht sind es sehr sehr viele) können nicht verstehen, dass das eine eine echt gemessene Temperatur ist, das andere eine Simulationsprognose, die naturbedingt weit von der Realität abweichen kann.

Der von mir beschrieben Zusammenhang ist nur etwas einfacher zu verstehen, aber identisch mit der Betrachtung der Klimamodelle.

Ob es 2100 2 Grad wärmer wird, 2 grad kälter wird, oder so bleibt wie es ist weiß nur der liebe Gott und der sitzt nun mal nicht im Computer. Klimamodelle sind ein sehr einträgliches Geschäftsmodell, und der größte Fehler ist, denen überhaupt Aufmerksamkeit zu schenken.

„BDS-sufferer [?]“

Vielleicht hat der Autor ja ein „Betting Disorder Syndrome“ erfunden – Annan ist ja bekannt für seine Wetten auf den Klimawandel – mit Richard Lindzen (läuft noch), mit Galina Mashnich und Vladimir Bashkirtsev (angeblich gewonnen, ohne daß die russischen Wissenschaftler gezahlt hätten) und mit David Whitehouse (verloren, keine Ahnung, ob Annan gezahlt hat …)

b) fehlendem oder falschem RF

Das ist die Antwort. Die zugrunde liegenden Strahlungsmodelle sind falsch. Diese liefern eine Erhöhung des Forcings aufgrund höherer Rückstrahlung bei Erhöhung der CO2 Konzentration, weil von einer nahezu 100% Emission der absorbierten IR-Strahlung ausgegangen wird.

Das ist jedoch falsch, wie Dr. Hug mit Der anthropogene Treibhauseffekt – eine spektroskopische Geringfügigkeit, hier schon gezeigt hat.

Alles andere ist trivial. Jedes Atmosphärenmodell, in das man mehr mehr Leistung (Forcing) reinsteckt liefert höhere Temperaturen. Genauso wie die Herdplatte wärmer wird, wenn man den Strom einschaltet.