Die Grundlagen des Klimawandels sind bekannt. Die Debatte dreht sich um die wichtigen Details – und die begutachtete wissenschaftliche Literatur steckt voller derartiger Nicht-Übereinstimmungen, häufig bzgl. des gleichen Datensatzes. Von den enthusiastischeren Alarmisten werden diese allgemein ignoriert.

Empirische Daten sind das Eine, aber was man für politische Entscheidungen braucht, sind Prognosen. Prognosen basieren auf Modellen, und deren Grenzen sind offensichtlich: was wir über die reale Welt wissen, was wir messen können und wie wir diese Dinge in Computermodelle eingehen lassen können. Modelle sind niemals die reale Welt und werden es auch niemals sein, aber sie sind notwendig und verführerisch.

Es gibt eine Lücke in den Klima-Prophezeiungen. Sie liegt zwischen Jahren und Jahrzehnten. Zwar können Wissenschaftler lückenlose Vorhersagen des Wetters über ein paar Tage machen, doch wären sie mit Vorhersagen im Maßstab von Jahreszeiten, Jahren und Jahrzehnten in einer weit besseren Position, um die Politik zu beeinflussen. Aber so wie es aussieht, sind Wettervorhersagen und kurzfristige Jahreszeiten-Vorhersagen ein anderes Paar Schuhe als Vorhersagen über Jahrzehnte. Die Einführung von etwas, das mancher als ein „nahtloses Klimaservice-Liefersystem“ bezeichnet, wurde zu einer der größten Herausforderungen der Klimawissenschaft hochstilisiert.

Einige sind darob optimistisch. Einer aktuellen Presseerklärung der University of Exeter zufolge wird es derartige zeitnahe Klima-Prophezeiungen demnächst geben. Prof. Adam Scaife, Leitautor der Studie im Journal Nature Climate Change sagt:

„Es gibt immer noch viel zu tun, aber genau wie Wettervorhersagen im 20. Jahrhundert regelmäßig operationell geworden sind, nähern wir uns jetzt einem Zeitpunkt, an dem es zeitnahe Klima-Prophezeiungen geben wird. Eine ganze Reihe wissenschaftlicher Institute weltweit arbeitet daran“.

Nach der Lektüre der Studie und der sie unterstützenden Literatur bin ich nicht so optimistisch. Schließlich wird in der Studie einerseits behauptet, dass die Aussichten auf Erfolg gut sind, während es andererseits erhebliche Herausforderungen gibt.

Wir sind noch nicht einmal in der Lage, Schlüsselfaktoren auszumachen und anzuwenden, um die Klima-Vorhersagbarkeit in Maßstäben von Wochen und Jahrzehnten zu bestimmen, wenn wir die Unsicherheiten nicht kennen. Tatsächlich ist in der Studie von einem „Umschlag von Unsicherheiten“ die Rede, kontrolliert durch erzwungene und interne Klima-Variabilität.

Zukünftige Vergangenheit

Einige glauben, dass zeitnahe Prognosen bestätigt worden seien durch etwas, das man rückwirkende Prognosen oder ,Nachhersagen‘ nennt. Modellierer aller Disziplinen werden einem sofort sagen, dass Vergangenheit und Zukunft nicht das Gleiche sind – aus dem offensichtlichen Grund, dass man auf die Zukunft warten muss. Erfolge bei der Nach-Hersage sind keine Garantie für erfolgreiche Vor-Hersagen. Das einzige, was machbar ist, ist die Ausgabe einer Prognose und darauf zu warten, als wie gut sie sich herausstellt.

Ich weiß, dass ich nicht allein stehe mit meinen Gedanken, dass der Optimismus bzgl. zeitnaher Klima-Prognosen von den Schwierigkeiten widerlegt wird, besonders wenn man von der Hoffnung liest, dass diese Prognosen so gut sein werden wie die gegenwärtig verfügbaren Prognosen für Jahreszeiten. Man muss nicht lange in der Erinnerung kramen, um zu erkennen, wie ungenau derartige Prognosen des UK Met.-Office waren.

Betrachtet man die Projekte, in welchen Klimamodelle mit Daten aus der realen Welt verglichen werden, zeigt sich, dass Klimaprognosen schwierig und ungenau sind. Das ist die Lektion der 5. Generation des Climate Model Inter-comparison Project (CMIP). CMIP6 ist nicht sehr ermutigend. Dieses Modell wird Eingang finden in den nächsten IPCC-Report AR 6 im Jahre 2021. Es steht erst am Anfang, aber bislang zeigen sich die gleichen Probleme wie bei CMIP5 mit Vorhersagen viel zu hoher Temperaturen:

Die Grundlagen der Klimawissenschaft mögen in Ordnung sein, aber Debatten über sehr wichtige Faktoren (die meisten davon mit Unsicherheiten behaftet) verbleiben – Faktoren, die unabdingbar sind zum Verständnis dessen, was los ist und was da kommen wird. Was Klimamodelle betrifft, so stecken diese voller offensichtlicher Probleme und Bedenken. Um das zu sehen, muss man sich lediglich vor Augen führen, wie falsch die Jahrzehnte-Prognose während der letzten 20 Jahre gewesen sind, oder wie das UK Met.-Office so riesige Fehlerbalken braucht, wenn die globale Temperatur nur für das nächste Jahr prognostiziert werden.

Link: https://www.thegwpf.com/climate-forecasting-the-big-gap/

Übersetzt von Chris Frey EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Man kann nicht oft genug davor warnen, dass Klima-Modelle bestenfalls Projektionen sind und keineshfalls Prognosen oder Vorhersagen. Man lasse einfach einmal 1000 honorige Klimawissenschaftler getrennt voneinander jeweils ein derartiges Modell erstellen und programmieren und vergleicht anschließlich das von Grooßrechnern ermittelte Ergebnis der 1000 Modelle bezüglich einer Erderwärmung. Da wird mit Sicherheit alles andere herauskommen, als eine auf ein Kommastelle genaue gleiche Zahl.

Insofern kann ich nur raten, niemals bei Klima-Modellen und deren Berechnungen mit Computern von Prognosen oder Vorhersagen zu sprechen, sondern einzig nur von dem was sie wirklich sind:

Computer-Spiele.

Computerspiele, das passt. Zumal, wenn linear in die Zukunft hochgerechnet wird, was aus vergangenen Zyklen gegenwärtig sich ergibt. Klimavorhersage bedeutet schlicht, die Evolution des Universums vorhersehbar zu machen:

https://guidovobig.com/2017/04/10/text-34-die-zukunft-des-menschen-aus-sicht-der-vergangenheit-1/

Da das nicht gelingen kann, macht man es andersherum. Man benutzt immer mehr Energie aka Rechenpower, um EINE Geschichte zu konstruieren, in der die Vorhersagen die Hauptrolle spielen und wiederholt diese Geschichte immer wieder und wieder.

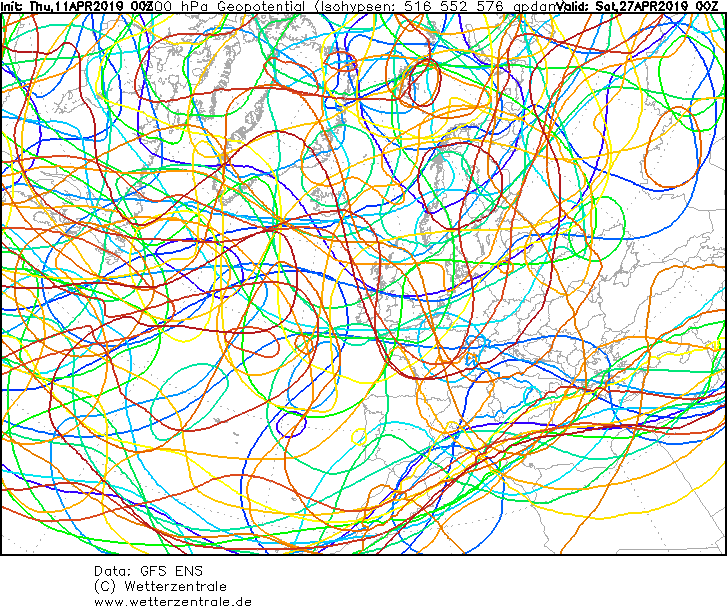

Klimamodelle? Hallo? Kostenexplosionen im Bauwesen, vom Fluchhafen BBR will ich gar nicht schreiben. Da gab es Modelle, solche aus Wettbewerben. Und trotzdem stimmten hinterher keine Vorgaben oder gar Kosten. Genauso beim „Klima“ und den entsprechenden „Modellen“. Diese werden errechnet, mit von Menschen programmierter Software und mit Zahlenreihen gefüttert und anschließend solange korrigiert bis es wie gewünscht passt. Was sollen bei der Betrachtung des zurückliegenden „Klimas“ Jahrzehnte oder gar Jahrtausende? Gemessen an der bisherigen „Lebensdauer“ unserer Erde ist das Alles ein Mückensch… Nun ja, die Rautengöttin vermag ja sogar festzulegen, wie sich die Temperatur auf oder der Erde nur verändern darf!? Wetter und die dieses beeinflussende Faktoren sind unvorhersehbar. Sonne, All, Wolken, Vulkane etc. sind nicht berechenbar und daher chaotisch. Ich verfolge seit Jahren täglich „Wettervorhersagen“. Entsprechende Diagramme habe ich interessenhalber mal kopiert. Die stimmten oftmals am gleichen Tag nicht überein, geschweige denn über mehr als zwei Tage. Auf Kachelmannwetter.com sind die Rechenergebnisse einzelner Länder übereinandergelegt. Schon hier stimmt naturgemäß nichts überein. Und da wollen uns „Wissenschaftler“ Modelle für das Langzeitchaos präsentieren? Diese Schaffenden werden sicher bei gewünschtem Ergebnis weiter reichlich aus Steuergeldern alimentiert. Vielleicht sollten sie besser forschen, wie wir Menschlein uns an das Wetter und seine Auswirkungen anpassen können. Ich Träumer…

„… mit von Menschen programmierter Software und mit Zahlenreihen gefüttert und anschließend solange korrigiert bis es wie gewünscht passt.“

Exakt so wird absolut jede Software entwickelt, und immer „von hinten“ korrigiert, also man hat einen Wert, gemessen oder als Erwartung und dreht so lange an die Algorithmen, bis dieser Wert errechnet wird. Eine andere Möglichkeit zu „Bug-Beseitigung“ gibt es weder praktisch, noch theoretisch.

„…Modelle sind niemals die reale Welt und werden es auch niemals sein, aber sie sind notwendig…“

Unter diesem Kontext muss man:

a) niemals vergessen, dass es keine reele Werte sind und immer skeptischer betrachten, als es die Allgemeinheit tut.

b) regelmäßig die Ergebnisse der Simulationen, unter unterschiedlichen Bedingungen, mit echt gemessenen Werte vergleichen und entsprechen die Algorithmen entsprechend anpassen.

Da beim Klima b) unmöglich ist (Nachbildung einer Vergangenheit reicht nicht), sind diese reine Spekulation. Oder besser gesagt, Betrug oder u.U. Selbstbetrug. Eine Erwärmung bei CO2-Anstieg wird vom Auftraggeber, vielleicht auch von Entwickler erwartet. Kommt bei ersten Entwürfen des Codes keine Erwärmung raus, geht man davon aus, einen Fehler gemacht zu haben und korrigiert so lange, bis es passt. Daher ist eine Simulation erst dann sinnvoll, wenn man ständig mit der Wirklichkeit abgleichen kann, nicht mit einem „Wunschwert“.

Wenn so lange an der Stellschraube gedreht wird bis es passt, wozu benötige ich dann den ganzen IT- und Software-Rummel? Dann kann ich doch gleich den gewünschten Wert veröffentlichen und spare mir den ganzen Zirkus. Sorry, ich vergaß, dann verdiene ich ja nichts daran und verfüge nicht über die „richtigen“ Zahlen und dann auch noch die „wissenschaftlichen“. Ich rechne mir die Welt wie sie mir gefällt. Na denn… Pipi Langstrumpf läßt grüßen.

Hallo Herr Gramberg,

alles, was eine Software errechnet, kann man auch mit dem Taschenrechner errechnen. Die Software macht nichts neues, sondern nur schneller. Man hat durch Einsatz von Software kein Erkenntnisgewinn, nur Zeitgewinn.

„Exakt so wird absolut jede Software entwickelt, und immer „von hinten“ korrigiert, also man hat einen Wert, gemessen oder als Erwartung und dreht so lange an die Algorithmen, bis dieser Wert errechnet wird. Eine andere Möglichkeit zu „Bug-Beseitigung“ gibt es weder praktisch, noch theoretisch.“

Dann entwickle ich doch keine Software, das muss irgendetwas anderes sein, womit ich mein Geld verdiene. Es gibt zwei Dinge auf dieser Welt, bei denen jeder meint, mitreden zu können – Beton mischen (eine Pampe aus Wasser, Zement und Kies, die irgendwann hart wird) und Software erstellen (das Wort BASIC richtig buchstabieren können, reicht aus, um Experte auf diesem Gebiet zu sein).

Sehr geehrter Herr Schubert,

Ich habe beschränkte Kenntnisse über Codes, weiß aber ganz genau, wie man Softwareentwickler dazu bringt, das Programm so zu trimmen, bis es macht was ich (auf Wunsch des Kunden) will. Programmierer neigen dazu manchmal zu glauben, die absolute Wahrheit dem Code beibringen zu können, ich weiß es aber besser. Im Code steckt nur der Kundenwille, von mir übertragen an den Entwickler, vom Entwickler im Code festgeschrieben.

Die Software, wie die ich verantwortlich bin kann sich an Komplexität in Richtung Simulationen bewegen, wenn auch nicht so umfangreich. Trotz großer Testaufwand kommen manchmal Rechenfehler (Bugs) vor. Das schwierigste ist, den Fehler zu reproduzieren, da unter 1000 Konstellationen das Programm richtig rechnet, und auf 1001 muss man erst kommen. Ohne das richtige Ergebnis zu kennen, kann man gar nichts.

Selbst bei weniger komplexer Software, wie z.B. Gehaltsabrechnung, werden zig Testläufe gefahren nach dem Einlesen der neuen Steuertabellen zum Jahreswechsel, wobei die errechneten Werte mit Vergleichswerte auf Übereinstimmung zu kontrolliert werden. anders kann eine Fehlerfreiheit nicht garantiert werden.

Ob Sie nun selbst kontrollieren, oder Sie eine Testabteilung hinter sich haben, wissen sie besser. Wenn Sie aber an Softwareergebnisse blind glauben, bei der nicht jeder Schritt mit Vergleichswerte aus der Wirklichkeit auf Übereinstimmung geprüft haben (wie bei Klimasimulationen), dann machen Sie sich etwas vor.

Die virtuelle Welt hat mit der reellen nichts, aber auch gar nichts zu tun. Das ist die Wahrheit! Wenn man keine „Schnittstellen zu Wirklichkeit“ hat (Abgleich zwischen reellen und virtuellen Werte) ist jede Software reine Spekulation.

Auch weltonline huldigt heute die Attributforschung von Frederike Otto:

https://www.welt.de/wissenschaft/plus191905721/Wie-der-Klimawandel-die-Wahrscheinlichkeit-fuer-Extremwetter-erhoeht.html (Bezahlschranke).

Ein Schmankerl ist die Methode:

„Um ein bestimmtes Wetterereignis zu untersuchen, gehen die Forscher in fünf Schritten vor. „Wenn es bei einer Hitzewelle heiß ist, stellen beispielsweise viele Leute die Frage: Ist das jetzt Klimawandel oder nicht?“, erklärt Otto. „Im ersten Schritt müssen wir dann herausfinden, was überhaupt gerade passiert.“ Das bedeutet, dass sich die Forscher die Beobachtungsdaten, die Wetteraufzeichnungen, anschauen.

Im zweiten Schritt werde das Ereignis definiert. Was heißt überhaupt Hitzewelle? Im Sommer 2018 hätten die Menschen nach drei Tage Hitze begonnen, daran zu leiden. Also definierten die Forscher: Bei Höchsttemperaturen über einen Zeitraum von drei Tagen ist es eine Hitzewelle.“

Und wie beantwortet diese Methodik die Frage in der Artikelüberschrift „Wetter oder Klima? Endlich gibt es Antworten“

Meine Antwort – gar nicht!

Wir fassen zusammen zusammen: Eine Forscherin besetzt einen Forschungszweig, der Zuordnungen zu einem Ereignis berechnet. Zu welchem Ereignis?Klimawandel im Allgemeinen und Extremwetterereignisse im speziellen. Dazu gibt sie auch politische Ratschläge, wer besonders darunter leidet und was man dagegen tun kann.

Ergebnis: Hurrikan Harvey war ein seltenes Ereignis aber mit 3-5xhöherer Wahrscheinlichkeit war der Klimawandel dafür verantwortlich. Daraus folgt, dass seltene Ereignisse mehr werden aber die Reaktionsmöglichkeiten können aufgrund der Effekte des Klimawandels lokal auch ganz anders sein (stabileres Wetter mit Trockenphasen und Kältewellen).

Tja, da sind wohl noch viele Forschungsgelder und mehr Rechnerzeit erforderlich aber Zeit Bücher zu schreiben und für mahnende Fernsehauftritte ist immer drin.

Ein Komentar zum Buch „Wütendes Wetter“ lesenswert Attributionsstudien sind in der Lage auf Grund von Klimadaten eine Aussage zu der Wahrscheinlichkeit eines Extrem Wetterereignis zu treffen. Hier der Link des br24

https://www.br.de/nachrichten/kultur/friederike-otto-wuetendes-wetter-interview,RNRFL1Z

Welchen Kommentar meinen Sie? Der Link führt auf die BR Seite zur Sendung und ist ein Interview mit Frau Otto.