In einer Veröffentlichung in [der Zeitschrift] Nature “Recent Climate Observations Compared to Projections” von Rahmstorf, Hansen und anderen im Jahre 2007 behaupteten die Autoren, dass ein Sprung nach oben in der Kurve des Temperaturverlaufs zeigt, dass „die globalen Temperaturen schneller als erwartet steigen“, und als Konsequenz daraus, dass die Klimaänderung schlimmer als erwartet ausfallen würde.

In der Veröffentlichung “Recent Climate Observations: Disagreement with Projections”, wurde mit der gleichen Methode, wie sie die Autoren verwendeten, und mit den Aufzeichnungen von zwei zusätzlichen Jahren gezeigt, dass der Sprung nach oben eine Folge unsauberer Glättung der Auswirkungen eines starken El Niño war. Möglicherweise war es diese Widerlegung, die zu einer Revision von Rahmstorfs Graph mit einer längeren Glättung führte, doch hatte dies den (für ihn) unglücklichen Nebeneffekt, dass der Sprung nach oben verschwand, so dass sie nun eben nicht mehr behaupten konnten, „die globalen Temperaturen steigen schneller als erwartet“.

Können wir die Frage „erwärmt sich die Atmosphäre immer noch?” auf sinnvolle Weise beantworten?

Aus dem Bereich der Ökonometrie kommen empirische Fluktuationsprozesse (EFP), die Programmierern in einem R-Paket mit der Bezeichnung strucchange zugänglich sind – entwickelt, um Dinge wie changes in exchange rates* durch den brillanten Achim Zeileis zu analysieren. Dahinter steht der Gedanke, die Null-Hypothese zu testen, die da lautet, dass sich die Steigung m in einem Teilbereich einer Reihe mit der Zeit nicht verändert hat:

H0: m1 = m2 im Vergleich zu der Alternative H1: m1 not equal to m2

Die Idee ist, ein Fenster mit konstanter Breite über die gesamte Beispielperiode zu bewegen und lokale Trends mit der allgemeinen Verbreitung von Trends zu vergleichen. Der sich daraus ergebende Verlauf sollte unter der Null-Hypothese nicht zu stark um die Null-Linie schwanken und – da die asymptotische Verteilung dieser Prozesse gut bekannt ist – die Grenze können berechnet werden, wenn auch nur mit einer gewissen Wahrscheinlichkeit. Andererseits, falls empirische Verfahren große Fluktuationen zeigen, die auch die Grenzwerte überschreiten, ist dies ein Beweis dafür, dass die Daten eine strukturelle Änderung der Parameter enthalten. Die Spitzen können datiert werden, und abschnittweise Regressionslinien können in die Brüche der Steigung eingepasst werden.

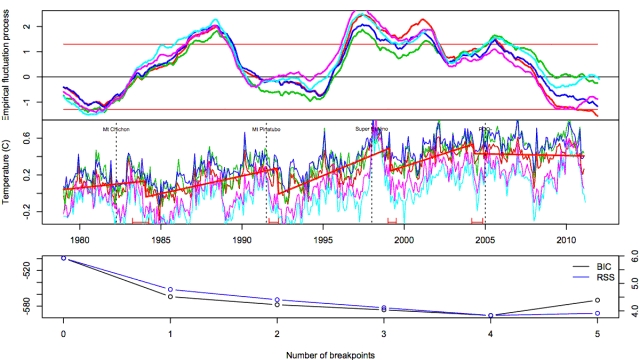

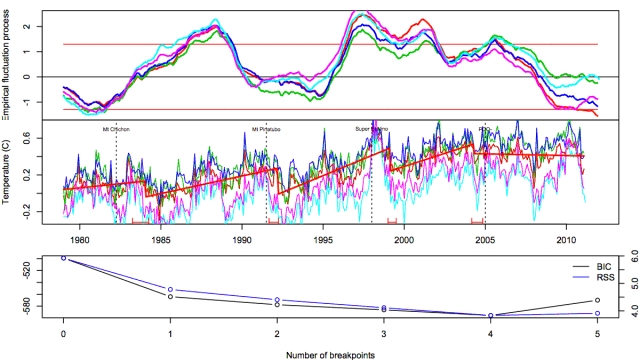

Ich habe die fünf offiziellen Datensätze der globalen Temperatur (CRU, GISS, NOAA, UAH und RSS) von 1978 bis zu den jüngsten Daten 2011 und bezogen auf den globalen mittleren Meeresspiegel einer strucchange [= statistische Datenanalyse mit R. R = ist eine freie Programmiersprache für statistisches Rechnen und statistische Grafiken {Quelle: Wikipedia, mehr hier}] unterzogen. Die Ergebnisse für die globale Temperatur sieht man hier:

Abbildung 1: Fluktuationsprozess, strukturelle Änderungen und Verdeutlichungen, um die Anzahl der strukturellen Brüche für die fünf globalen Datensätze zu bestimmen (CRU, GISS, NOAA, UAH and RSS).

Der Fluktuationsprozess (obere Darstellung) kreuzt die obere Signifikanzgrenze mehrmals, was darauf hindeutet, dass der Trendparameter instabil ist. Beispielsweise findet eine solche Kreuzung 1998 statt, was mit einem starken El Niño zusammenfällt, um danach abzuflachen. In jüngster Zeit lagen drei Datensätze an der unteren Grenze, was darauf hinweist, dass sich zumindest die Datensätze von CRU, NOAA und RSS von dem Erwärmungstrend seit 1978 entfernt haben.

Im mittleren Teil der Abbildung 1 sieht man im Modell die strukturellen Brüche im Datensatz von CRU, wobei die optimale Anzahl der Brüche im Minimum des Bayesian Information Criterion (BIC) (untere Darstellung) liegt. Die zeitliche Position der Brüche geht (mit einer gewissen Verschiebung) einher mit markanten Ereignissen: Ausbrüche der Vulkane Mt Chichon und Pinatubo, die bis in die Stratosphäre reichten, dem Super El Niño und der Phasenänderung des Pazifischen Dekadischen Oszillation PDO im Jahre 2005.

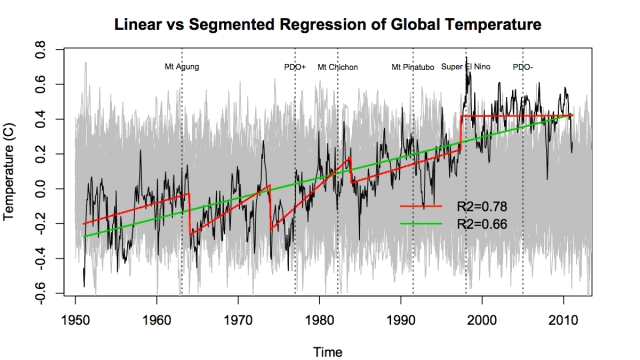

Manchmal reagieren diese Modelltypen auf die Wahl des Start- und Endpunktes. Daher führte ich die ganze Prozedur noch einmal mit Daten seit 1950 durch. Abbildung 2 zeigt die sich ergebenden strukturellen Brüche im Datensatz von CRU. Während der Fluktuationsprozess nicht das gleiche Ausmaß des jüngsten Abwärtstrends zeigt, sind die strukturellen Brüche ähnlich den der kürzeren Reihen in Abbildung 1, mit Ausnahme der Temperaturen seit 1998, die einen einzelnen flachen Verlauf haben.

Die Temperatur wurde geplottet über random multiple AR(1) simulations [?] und zeigen, dass die Temperatur während der Periode innerhalb der Extreme eines AR(1) – Modells verlief.

Abbildung 2: Vergleich zwischen linearen und abschnittweisen Regressionen für den globalen Datensatz von CRU, mit Angabe von Zeitpunkten signifikanter Ereignisse.

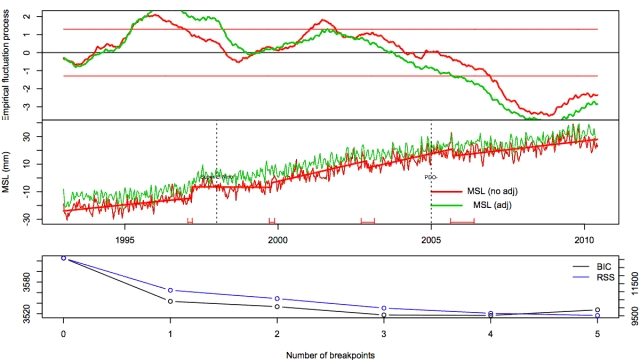

Ein anderer Indikator der globalen Temperatur ist der mittlere globale Meeresspiegel, sowohl barometrisch als auch nicht-barometrisch justiert. Der globale Meeresspiegel zeigt das Gleiche wie die atmosphärische Temperatur, mit einer signifikanten Verlangsamung des Anstiegs des Meeresspiegels nach der Phasenänderung der PDO im Jahre 2005.

Abbildung 3: Der Fluktuationsprozess, das Modell struktureller Brüche und Messungen des globalen Meeresspiegels, sowohl barometrisch als auch nicht-barometrisch justiert.

Mit diesen objektiven Kriterien scheint sich zu ergeben, dass eine strukturelle Änderung weg vom mittleren Erwärmungstrend im Gange ist. Bedeutet dies, dass die globale Erwärmung zum Stillstand gekommen ist?

Welche Argumente sprechen dafür, dass die Erwärmung unvermindert weitergeht?

Easterling und Wehner haben in ihrem Artikel “Is the climate warming or cooling?” scharf kritisiert, dass „zahlreiche Websites, Blogs und Artikel in den Medien, die behaupten, dass sich das Klima nicht mehr erwärmt und sich inzwischen abkühlt“, dies auf willkürlich ausgewählte Daten zurückführen. Sie untersuchten die Verteilung von 10-Jahres-Verläufen sowohl der gemessenen als auch der simulierten globalen Temperatur. Sie argumentieren, dass wegen der geringen Anzahl von 10-Jahres-Perioden, die flach verlaufen, der langzeitliche Erwärmungstrend nach wie vor da ist.

Sowohl E&W als auch EFP stimmen darin überein, dass es eine kleine Wahrscheinlichkeit eines flachen Temperaturverlaufs für 10 Jahre gibt (EFP beziffern diese auf rund 5%) innerhalb eines längerzeitlichen Erwärmungstrends. Was E&W sagen, ist, dass unter der Voraussetzung einer geringen Wahrscheinlichkeit zu einer bestimmten Zeit die Wahrscheinlichkeit eines flachen Temperaturverlaufs während irgendeines Zeitraumes, sagen wir mal 50 Jahre, viel höher ist. Dies ändert nichts an der Tatsache, dass für einen Beobachter in irgendeiner dieser Dekaden, wenn der Temperaturverlauf flach ist (wie derzeit), immer noch eine Wahrscheinlichkeit von 5% für einen Bruch im langzeitlichen Trend besteht.

Breusch und Vahid (2008, überarbeitet 2011) hieben in die gleiche Kerbe mit ihrem Artikel “Global Temperature Trends”, in dem sie feststellten, dass „es keinen signifikanten Beweis für einen Bruch im Trend in den späten neunziger Jahren gibt“, und dass „es nichts gibt, das darauf hinweist, dass um 1998 irgendetwas Bemerkenswertes geschehen ist“. So sehr ich auch danach suchte, konnte ich doch keine Abschätzung der Signifikanz finden, die ihre Behauptung, dass es sich um einen signifikanten Beweis handelt, stützen würde.

Die Feststellung ist sogar noch verwirrender, sind doch die letzten 15% [der Daten] an den Enden der Reihen typischerweise nicht auf Brüche infolge der nachlassenden Intensität des Tests aufgrund der immer weniger werdenden Daten geprüft worden. Die neunziger Jahre liegen außerhalb dieser 15%. Brüche von der Größenordnung wie der Bruch im Jahre 1976 wären aus ihren Daten nicht erkennbar gewesen.

Natürlich gibt es noch zahlreiche andere Beobachtungen der Strahlungsbilanz der Erde und des Wärmegehaltes der Ozeane, die die Hypothese „keine Erwärmung“ stützen, und zwar von Spitzenforschern wie Douglas und Loehle. Es scheint keinen glaubwürdigen empirischen Beweis von AGW dafür zu geben, dass sich die Atmosphäre immer noch erwärmt.

Ich habe den Verdacht, wie kürzlich in “Recent Climate Observations”, wo Klimawissenschaftler mit dem steilen Aufwärtsknick der globalen Temperatur während eines starken El Niño absichtlich getäuscht worden waren, damit sie denken, dass „die Klimaänderung schlimmer als erwartet sein wird“. Und sie wurden auch mit einem steilen, aber längerzeitlichen Aufwärtstrend in Zusammenhang mit der positiven Phase der PDO in die Irre geführt .

Gastbeitrag von Dr. David Stockwell auf WUWT hier

Übersetzt von Chris Frey für EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"#32 mit „Sonne“ meinte ich die Sonneneinstrahlung

sie liegt in diesem Chema bei 341,3 W/m2

die „Ausstrahlung“ an der Erdoberfläche ist mit 396 W/m2 angegeben,

bemerkenswert ist darüber hinaus, dass die Summe der netto Abstrahlung plus der Rückstrahlung deutlich höher ist als die brutto-Abstrahlung der Erde.

Wir haben also neben der Sonneneintrahlung in diesem Chema noch (mindestens) zwei zusätzliche Strahlenquellen installiert

Das geht nur noch mit blindem „Glauben“ 🙂

Herr Paul,

was hat denn Ihr Beitrag mit meinem Kommentar zu tun? Wo schreibe ich das von Ihnen zitierte „erklären“?

Egal, was passt Ihnen denn an dem Bildchen nicht bzw. wie kommen Sie von dort ausgehend darauf dass die Erde wärmer sei als die Sonne?

#29: Frohe Ostern Herr Gregor Mendel,

Sie wollen „erklären“???

http://tinyurl.com/lrvupp

nach diesem Chema aus Wikipedia, das auf Keihl and Trenberth und die NASA zurückgeht,

ist es also auf der Erde heißer als auf der Sonne

Wir sind also IM KINDERGARTEN mit Eurem Treibhauseffekt.

Gruß

Herr weiss, #27,28

„1: In welcher Publikation einer anerkannten Zeitschrift wird experimentell eindeutig gezeigt (das heisst reproduzierbar gemessen, nicht gerechnet oder prognostiziert von einem Ihrer beliebten Computerspiele) dass ca. 1.3 Volumenprozent Wasserdampf in der Erdatmosphäre 20 Grad Kelvin entsprechen, wie Sie behaupten.“

Meinen Sie ein Experiment mit der Erdatmosphäre, bei dem man ihr alles Wasser entzogen hat und gemessen hat, wie kalt es wird? Wenn es das gegeben hätte, wäre das so eindrücklich, dass Sie es wohl kaum nicht mitbekommen hätten. Es gab es natürlich nicht, daher keine Publikation dazu!

Selbst wenn man das Experiment machen könnte, so könnte man schwer die Sekundäreffekte eliminieren, denn ohne Wasser würde sich nicht nur der Strahlungstransfer der langwelligen Strahlung in der Atmosphäre ändern, sondern auch andere Randbedingungen, die man bei einem Vergleich (experimentell oder theoretisch) eigentlich konstant halten will (Strahlungstransfer kurzwelliger Strahlung, Albedo). Somit wäre so ein globales Experiment auch wieder ziemlich unsinnig und ein Modellexperiment viel sinnvoller.

Da der Wasserdampf jedoch stark variiert, wird diese variable Treibhauswirkung experimentell/beobachtungstechnisch zugänglich, denn die Gegenstrahlung variiert stark mit dem Wasserdampf, A. Angström fand anhand meteorologischer Beobachtungen und Strahlungsmessungen den folgenden Zusammenhang zwischen Dampfdruck e und Gegenstrahlung G:

G = sigma*T^4*(0,790-0,174*exp(-0,055/1,333*e))

(A. Angström, Recording noctural radiation, Medd.Stat.meteor.-hydrogr. Anst., vol. 3, no 12, 1927, bzw. in F. Möller, Einführung in die Meteorologie, Bd. 2, BI 1973, p53, Gl. 11.4a,

oder googlen, z.B.: http://preview.tinyurl.com/6yk9r4p

sigma = 5,6697e-8 Wm-2K-4 (Stefan-Boltzmann Konstante)

T = Lufttemperatur in K

e = Dampfdruck in hPa

G = Gegenstrahlung in Wm-2

Die Variation des Wasserdampfs macht sich in einer Variation der nächtlichen effektiven Ausstrahlung (thermische Abstrahlung des Bodens – Gegenstrahlung) bemerkbar, was sich an unterschiedlichen nächtlichen Abkühlungen in den Temperaturkurven widerspiegelt.

Ohne Wasserdampf (e= 0) kann man leicht ausrechnen, dass dann am Boden ca. 50 Wm-2 mehr effektiv abgestrahlt würden, was in der Nacht zu einer ca. 3 Grad stärkeren Abkühlung führt, Der neue Gleichgewichtszustand (moduliert um den Tag-Nachtzyklus) benötigt einige Tage (~20) zum Einpendeln. Die 20 K sind jedoch nur ein Modellwert unter der Annahme konstanter anderer Randbedingungen und im globalen Mittel, lokal können andere Abkühlungen rauskommen. Aber wie gesagt, dieses Experiment (e=0 global) wird es nicht geben!

Seit Angström ist man weiter, man kann den Strahlungstransfer numerisch besser genauer berechnen, kennt die druck- und temperaturabhängigen Spektren der Treibhausgase besser anhand es experimentellen und Theorievergleichs und kann per Satellitenmessungen auch globale Kartierungen dieser damals nur lokalen Messungen machen und damit die globalen Mittelwerte berechnen. Im ERBE/CERES Projekt wird dies gemacht (http://preview.tinyurl.com/3vt69za, http://preview.tinyurl.com/3uf262g). In dem ersten link finden Sie in Tabelle 3 die Angaben zum globalen Wasserdampfanteil am Treibhauseffekt: 60% *33 K = 20 K.

„2: Behaupten Sie etwa auch, dass 380 ppm CO2 in der Atmosphäre ca. 7 Grad Kelvin Anteil an der „Globaltemperatur“ ausmachen ?“

Etwa 8K, 280 ppm vorindustriell etwa 7K. Dieses Experiment läuft ja unfreiwillig seit ein paar Jahrzehnten schon ab.

„3: Wissen Sie zufällig, wie hoch die „Globaltemperatur“ auf der Erdoberfläche wäre, wenn es überhaupt keine Atmosphäre gäbe (etwa wie auf dem Mond oder Merkur)?“

Das hängt von der resultierenden Albedo und eintreffenden Sonnenstrahlung der atmosphärenlosen Erde ab. Grob kann man ohne Luft und Wasser annehmen, dass die Albedo mit 0,30 (heute globales Mittel 0,31) etwa konstant bleibt, ohne Wasser gäbe es keine Ozeane, keine Vegetation und keine Eiskappen; Wüstenlandschaften haben etwa eine Albedo von 0,3.

Die mittlere globale Einstrahlung wäre also dann ca. 0,7 * S/4 = 240 Wm-2. Die Temperatur des Bodens (Emissionsgrad ca. 0,9) wäre also T = 240/sigma /e K = -11 °C.

http://climate.nasa.gov/uncertainties/

#28: Die Unsicherheiten 1.-7. kann man grob in 3 Klassen unterteilen, wobei Überlapp besteht. 1) Unsicherheiten im feedback-Verhalten bei Treibhausgaszunahme (Wolken, Eis, (Niederschläge, Kohlenstoffzyklus)) , 2) Unsicherheiten der Prognose des Klimas insgesamt (neben durch 1), Sonne, Aerosole, Ozeanzirkulation, Kohlenstoffzyklus) und 3) Unsicherheiten in den Auswirkungen (Niederschläge, Eis).

Dies führt zu der angegebenen Unsicherheit von 2-4 °C im AR4 bei CO2-Verdopplung im Laufe der kommenden 100 Jahre. Genauer als +/- 1 °C im globalen Mittel kann man es heute noch nicht angeben, weil man insb. die Wolken nicht genauer modellieren kann. Bei Modellierung über mehrere Jahrhunderte steigt die Unsicherheit stark!

Herr Weiss,

um Aussagen darüber zu treffen, welche Unsicherheiten der IPCC verschweigt sollten Sie den Bericht erstmal lesen. Haben Sie getan? Dann nennen Sie bitte konkret die Punkte die Ihrer Meinung nach nicht im IPCC-Bericht enthalten sind!

@#26 Bäcker

Von der Website der NASA (climate.nasa.gov) (http://tinyurl.com/y8jgtqv):

„Below is an explanation of just a few other important uncertainties about climate change, organized according to the categories forcing and feedback. This list isn’t exhaustive. It is intended to illustrate the kinds of questions that scientists still ask about climate.

Forcings

1. Solar Irradiance. The sun has a well-known 11-year irradiance cycle that produces about .1% variation in output.1 Solar irradiance has been measured by satellite daily since the late 1970s, and this known solar cycle is incorporated into climate models. There is some evidence from proxy measurements-sunspot counts going back centuries, measurements from ancient trees, and others-that solar output varies over longer periods of time, too. While there is currently no evidence of a trend in solar output over the past half century, because there are no direct observations of solar output prior to the 1970s, climate scientists do not have much confidence that they understand longer-term solar changes. A number of U.S. and international spacecraft study the sun.

2. Aerosols, dust, smoke, and soot. These come from both human and natural sources. They also have very different effects on climate. Sulfate aerosols, which result from burning coal, biomass, and volcanic eruptions, tend to cool the Earth. Increasing industrial emissions of sulfates is believed to have caused a cooling trend in the Northern Hemisphere from the 1940s to the 1970s. But other kinds of particles have the opposite effect. The global distribution of aerosols has only been tracked for about a decade from the ground and from satellites, but those measurements cannot yet reliably distinguish between types of particulates. So aerosol forcing is another substantial uncertainty in predictions of future climate.

Feedbacks

3. Clouds. Clouds have an enormous impact on Earth’s climate, reflecting back into space about one third of the total amount of sunlight that hits the Earth’s atmosphere. As the atmosphere warms, cloud patterns may change, altering the amount of sunlight absorbed by the Earth. Because clouds are such powerful climate actors, even small changes in average cloud amounts, locations, and type could speed warming, slow it, or even reverse it. Current climate models do not represent cloud physics well, so the Intergovernmental Panel on Climate Change has consistently rated clouds among its highest research priorities. NASA and its research partners in industry, academia, and other nations have a small flotilla of spacecraft and aircraft studying clouds and the closely related phenomenon of aerosols.

4. Carbon cycle. Currently, natural processes remove about half of each year’s human carbon dioxide emissions from the atmosphere, although this varies a bit year to year. It isn’t well understood where this carbon dioxide goes, with some evidence that the oceans are the major repository and other evidence that land biota absorbs the majority. There is also some evidence that the ability of the Earth system to continue absorbing it may decline as the world warms, leading to faster accumulation in the atmosphere. But this possibility isn’t well understood either. The planned Orbiting Carbon Observatory mission will mark NASA’s first attempt to answer some of these questions via space observations.

5. Ocean circulation. One very popular hypothesis about climate change is that as the Earth as a whole warms, ocean circulation in the Atlantic will change to produce cooling in Western Europe. In its most extreme form, this hypothesis has advancing European ice sheets triggering a new ice age. A global-warming induced ice age is not considered very likely among climate scientists. But the idea highlights the importance of ocean circulation in maintaining regional climates. Global ocean data sets only extend back to the early 1990s, so there are large uncertainties in predictions of future ocean changes.

6. Precipitation. Human civilization is dependent upon where and when rain and snow fall. We need it for drinking water and for growing our food. Global climate models show that precipitation will generally increase, but not in all regions. Some regions will dry instead. Scientists and policymakers would like to use climate models to assess regional changes, but the models currently show wide variation in their results. For just one example, some models forecast less precipitation in the American southwest, where JPL is, while others foresee more precipitation. This lack of agreement on even the direction of change makes planning very difficult. There’s much research to be done on this question.

7. Sea level rise. In its 2007 Fourth Assessment Report, the Intergovernmental Panel on Climate Change used new satellite data to conclude that shrinkage of ice sheets may contribute more to sea level rise than it had thought as recently as 2001. The panel concluded that it could not „provide a best estimate or an upper bound for sea level rise“ over the next century due to their lack of knowledge about Earth’s ice.2 There are 5-6 meters worth of sea level in the Greenland ice sheet, and 6-7 meters in the West Antarctic Ice Sheet, while the much larger East Antarctic Ice Sheet is probably not vulnerable to widespread melting in the next century. Many hundreds of millions of people live within that range of sea level increase, so our inability to predict what sea level rise is likely over the next century has substantial human and economic ramifications. “

Herr Bäcker, bei so vielen Unsicherheiten und Wissenslücken der Wissenschaft (die oben von der NASA eingeräumt und offenbar auch teilweise vom IPCC erkannt sind, wenngleich auch den Politikern / Medien / Volk nicht mitgeteilt werden seitens des IPCC): wie kommen Sie dazu – in Ihrer selbstzufriedenen Art – von einem Temperaturanstieg der „globalen Temperatur“ verursacht durch ein klein wenig anthropogenes CO2 (ungeachtet der wirklich klaren Einflussfaktoren: Sonne, Wolken) so überzeugt zu sein (haben Sie den Beitrag der NASA zur Rolle der Wolken oben überhaupt zur Kenntnis genommen). Haben Sie denn überhaupt keine Kritikfähigkeit bezüglich der Grunddogmen der AGW Bewegung (Kritikfähigkeit bezüglich dieser Dogmen wäre ein erster Schritt Ihrerseits zu einer wahren wissenschaftlichen Haltung, denn diese erfordert, dass man grundsätzlich immer bereit ist, seine eigenen Positionen kritisch zu hinterfragen; das vermisse ich bei Ihnen ja so schmerzlich, wie auch bei Herrn Fischer und den von Ihnen so apostrophierten „populären Klimagurus“ Schellnhuber und Rahmstorf).

@#26 Bäcker

1: In welcher Publikation einer anerkannten Zeitschrift wird experimentell eindeutig gezeigt (das heisst reproduzierbar gemessen, nicht gerechnet oder prognostiziert von einem Ihrer beliebten Computerspiele) dass ca. 1.3 Volumenprozent Wasserdampf in der Erdatmosphäre 20 Grad Kelvin entsprechen, wie Sie behaupten.

2: Behaupten Sie etwa auch, dass 380 ppm CO2 in der Atmosphäre ca. 7 Grad Kelvin Anteil an der „Globaltemperatur“ ausmachen ?

3: Wissen Sie zufällig, wie hoch die „Globaltemperatur“ auf der Erdoberfläche wäre, wenn es überhaupt keine Atmosphäre gäbe (etwa wie auf dem Mond oder Merkur)?

weiss, 25

die Treibhauswirkung des Wasserdampfs betraegt ca. im mittel 20 Kelvin. Da der wasserdampfgehalt stark variiert, variiert auch die Temperaturwirkung, was man bei der Temperaturvorhersage in der wettervorhersage jedoch quantitativ im Griff hat.

#23: nicobäcker

Anthropogenes CO2 quantitativ völlig unbedeutend und temperaturunwirksam

Herr Bäcker

Eine der grundsätzlichen Schwächen Ihres AGW Weltbildes, besteht darin, dass Sie die blosse Quantität des anthropogenen CO2 in der Atmosphäre völlig überschätzen. Nur zur Erinnerung: der Volumenanteil von CO2 in der trockenen Luft beträgt ca. 0.038 % (eben jene berühmten 380 ppm, die sogar Al Gore kennt). Die jährliche Steigerungsrate durch anthropogene CO2-Emissionen beträgt ca. 2 ppm oder (0.0002 %).

Im Vergleich dazu beträgt der mittlere Volumenanteil des Wasserdampfs in der Atmosphäre circa 1.3% (oder 13’000 ppm), d.h. 6’500 (sechstausendfünfhundert) Mal so viel wie das pro Jahr zusätzlich in die Atmosphäre gelangende anthropogene CO2.

u

Nun mein Vorwurf Sie und Ihre AGW Bewertung (IPCC / PIK): warum verwenden Sie beinahe all Ihre Energien auf die Untersuchung des Einflusses von zur Zeit 2 ppm zusätzlichen CO2 pro Jahr auf die „Welttemperatur“ (die Sie gar nicht genau messen oder mittels Computern berechnen können) und man hört so gar nichts von Ihnen zur Erforschung des Einflussses des volumenmässig sechstausendfünfhundert Mal wichtigeren Wasserdampfs auf die „Welttemperatur“. Wenn man Proportionen richtig erfassen könnte, wäre doch vollkommen klar, was man zuerst erforschen müsste.

Also nun meine Frage an Sie: wie hoch schätzen Sie den Anteil von 13’000 ppm Wasserdampf auf die „Welttemperatur“ in Grad Kelvin ?

weiss 17

wenn Sie in Nature, science oder geowissenschaftlichen journals keine arbeiten gefunden haben, so haben Sie offenbar nichr richtig gesucht. ich habe einen stapel papiere darueber

Herr Kramm, #14,15

„Bis heute fehlt der wissenschaftliche Beweis dafuer, dass es einen Zusammenhang zwischen der global gemittelten oberflaechennahen Lufttemperatur und der atmosphaerischen CO2-Konzentration existiert. Der Grund dafuer ist einleuchtend, dann diese Temperatur spielt im globalen Energieflussbilanz-Schema des System Erde-Atmosphaere ueberhaupt keine Rolle. Es ist eine diesem System von aussen willkuerlich aufgepraegte Temperatur, die keinen thermodynamischen Zusammenhang mit dem globalen Energieflussbilanz-Schema aufweist.“

Die global gemittelte Temperatur kommt im Energieschema nicht vor, aber die lokalen Temperaturen der Luft und des Bodens schon, und diese beeinflussen die Energieflüsse beachtlich. Ungekehrt werden die lokalen Temperaturen durch die Energieflüsse determiniert. Ich denke, da werden Sie mir nicht widersprechen.

Damit impliziert die vollständige Kenntnis der Energieflüsse die Temperaturverteilung und damit auch das globale Mittel. Die vollständige Kenntnis der Energieflüsse erfordert u.a. die Kenntnis der Verteilung von Treibhausgasen, denn diese modifizieren die Strahlungsflüsse. Damit gibt es eine Relation zwischen CO2 und globalem Temperaturmittel.

Diese Relation ist jedoch nicht eindeutig, die Temperaturverteilung und damit das globale Temperaturmittel hängen von anderen Faktoren auch noch ab, und damit ist der Schluß von einer beobachtbaren Temperaturerhöhung auf eine CO2-Erhöhung oder umgekehrt zu schließen, nicht eindeutig.

Auf einer solchen Schlussfolgerung alleine beruht jedoch nicht die heute wissenschaftliche Indizkette. Eine solche erfordert, dass man alle Alternativen zur Erklärung des Zusammenhangs quantitativ ausgeschlossen hat. Dies ist nach Einschätzung von vielen Klimawissenschaftlern im Rahmen der im IPCC angegebenen „Sicherheitseinschätzung“ erfolgt. Es gilt jedoch auch welche (wie Pielke), die vorsichtiger sind.

Dass prinzipiell der Irrtum nie exakt ausgeschlossen ist, gilt immer in der Wissenschaft.

Wichtig ist deswegen die Sicherheitsbewertung, und dazu gehört auch, wie wichtig man Mahner nimmt, die auf konkrete (!, nicht substanzlose Allgemeinheiten oder Schlüsse basierend auf nicht zutreffenden Prämissen, siehe das Beispiel von Ihnen oben) Schwachstellen in der Beweiskette eingehen. Aber durch Mahnung, Skeptizismus oder Kontraposition wird man nicht zum Genie oder wissenschaftlicher Revoluzzer!

Auch hbeim Mahnen gilt es vor allem konkret zu sein – denn solche Argumente im Stile: „die Quantentehorie widerspricht der klassischen Mechanik und daher ist alles, was auf Quantentheorie basierend behauptet wird, falsch“, sind offenbar reichlich dünnblütig und bringen die Wissenschaft nicht weiter.

Nun kann man sich streiten, ob man die Unsicherheitsbewertung und damit die Vorlage für das Risiko für darauf basierende Konsequenzen der Wissenschaft oder der Politik überläßt. Fest steht jedenfalls: es wird eine geben! Und da das so ist, bin ich klar dafür, dass diese Bewertung durch die Wissenschaft erfolgt!

„Hier ein Besipiel: Das anthropogene radiative Forcing, RF = 1,66 W/m^2, fuer CO2 wird an Hand des Ansatzes

RF = C log ([CO2](t)/[CO2](t_0))

berechnet, worin C eine Konstante ist und [CO2](t) sowie [CO2](t_0) die atmosphaerischen CO2-Konzentrationen zum Zeitpunkt t (=2005) sowie t_0 (= 1750) sind. Dieser Ansatz ist unvereinbar mit der Schuster-Schwarzschild-Milne-Gleichung.“

Sie verdrehen da etwas. Diese Gleichung widerspricht nicht den Gleichungen des Strahlungstransfers, denn dieser Gleichung liegt überhaupt keine analytische Rechnung bzw. Näherung zugrunde. Sie ist eine empirische Fitfunktion, die aus den Ergebnissen verschiedener numerischer GCMs (inkl. Strahlungstransferberechnung) für Scharen von [CO2] gewonnen wurde. Für verschiedene [CO2] wurde das initiale radiative forcing RF an der Tropopause abgelesen und global gemittelt, punktweise gegen [CO2] aufgetragen und durch eine geeignete Fitfunktion (log) interpoliert.

„Betraegt eine Klimaperiode mindestens 30 Jahre, dann sind also mindestens 60 Jahre erforderlich, um ueberhaupt eine Klimaaenderung diagnostizieren zu koennen.“

Sie verwechseln Normalperiode mit dem Zeitraum, der für eine signifikante Erfassung statistischer Merkmale klimatischer Parameter nötig ist. Die WMO macht m.W.keine Vorschriften, dass JEDER statistische Klimaparameter 30 Jahre erfasst werden muß, bevor man eine Statistik damit macht. Oder haben Sie auch diese Definition in den WMO Dokumenten gefunden und nur vergessen, es hier wiederzugeben?

Sehr geehrter Herr Fischer,

wo beschleicht einem beim Meeresspiegelanstieg ein ungutes Gefühl? Seit den 40er Jahren gilt für den Deichbau in Deutschland die Faustregel: 30cm pro Jahrhundert erhöhen und so ähnlich sieht das ja auch der IPCC vor. Nur braucht es bei 30 oder gar bei 60 cm in 100 Jahren gar keinen Klimaschutz. Küstenschutz langt vollkommen.

Die Daten in ihrem link sind nebenbei zweifelhaft. Ob die Satelliten verlässliche Daten liefern ist mehr als fraglich. Einfach auf Grund der Messmethodik. Weiterhin ist fraglich ob ein globaler Mittelwert für den Meeresspiegelanstieg überhaupt eine Aussagekraft hat und wenn ja wie dieser korrekt ermittelt werden kann.

Ah sie haben eines der größten Glaubwürdikeitsprobleme der IPCC- und ähnlicher Prognosen erkannt. Sie sind nicht Ergebnissneutral aufgestellt.

Sie gehen praktisch grundsätzlich von einer Erwärmung durch antropogenes CO2 aus plus angekoppelter starker positiver Rückkopplungen. Für beides gibt es keine Beweise.

Auch geht man fast immer von klimatischen Kipppunkten aus die in eine Katastrophe führen.

Für beides gibt es keine Beweise. Es gibt nicht mal Indizien. Im Gegenteil gibt es sogar klare Indizien die dagegen sprechen. (alle großen menschlichen Zivilisationen sind in Warmzeiten entstanden und erlebten ihre Blüte in Warmzeiten;

Leben gedeiht am besten wenn es warm und feucht ist plus viel CO2)

Sehr geehrter Herr Tobies,

wir müssen präzisieren:

Es ist zum HEUTIGEN Zeitpunkt nichtssagend, durch Vergleich von gemessenen Temperaturen mit den IPCC-Prognosen deren Qualität zu beurteilen.

Die Zukunft wird zeigen, ob die gemessenen Temperaturen den prognostizierten Anstieg bestätigen, es ist einfach noch zu früh.

Schön wäre allerdings, wenn wir die weitere Entwicklung der Temperaturen mit Gegenmodellen derer vergleichen könnten, die meinen, es gäbe keine nennenswerte Erwärmung oder es sei alles der Sonne geschuldet. Dann hätten wir eine Alternativhypothese und könnten in den nächsten 20 Jahren leicht entscheiden, welches Modell die Temperaturentwicklung besser reproduziert.

Andererseits habe ich ein ganz gutes Gefühl, bei den Temperaturen sieht es optisch deutlich besser aus als beim Meeresspiegelanstieg.

Schauen Sie sich mal die Graphik zum Meeresspiegelanstieg im Vergleich zu den IPCC-Prognosen an:

http://tinyurl.com/66uf5vl

Natürlich sind damit die IPCC-Prognosen nicht widerlegt, aber ein ungutes Gefühl beschleicht einen schon, oder?

PS:

Ich muss mich korrigieren. Die angegebenen Fehlerbänder spiegeln eine 95%-Umgebung wider, keine 1-sigma-Umgebung, wie ich oben fälschlicherweise schrieb.

PPS:

Haben Sie #12 gelesen? Manchmal staune ich selbst über meine prophetischen Fähigkeiten 😉

#17: M. Weiss:

das Fischer-Zitat:

„bei EIKE wurde noch nie eine Arbeit wissenschaftlich widerlegt, was man auch daran sieht, dass keiner der EIKE Mitglieder seine Ergebnisse wissenschaftlich veroeffentlicht hat“

Diese dreiste Lüge ist unter der Rubrik „Publikationen“ zu erkennen.

Allerdings sind darunter auch einige wenige, die von einem Treibhauseffekt durch CO2 sprechen, was ich für eine große Schwächen von EIKE halte.

Es gibt also offenbar zwei Kritiker-Positionen:

1) Der TE von CO2, insbesondere der antropogene Anteil existiert, ist aber zu gering um nachweisbar zu sein oder das Klima nachweisbar zu verändern.

2)Der CO2 TE kann aus physikalischen Gründen nicht existieren.

Deshalb ist er bisher auch nicht messbar gewesen.

Die „Strahlenbilanz“ zum Weltraum erlaubt nur einen Kühleffekt.

Letztlich ist in jeder Naturwissenschaft besonders bei komplexen Zusammenhängen aber nicht die Theorie, sondern die Beobachtung des Klimas entscheidend, also die beobachtete Korrelation von Luft-CO2 und „Temperatur“.

Sowohl 1) als auch 2) kann sich also auf den fehlenden Nachweis des CO2Effekts stützen.

Hinzu kommt die mehrfahl widerlegte Gefährlichkeit einer Erwärmung eben durch Beobachtung.

Die Problematik der „globalen Temperatur“ hat ja jetzt Kramm dankenswerterweise nochmals erläutert.

Sie ist weder repräsentativ für eine „Globale Temperatur“ für Energiebilanzen, noch kann

man physikalisch exakte „Strahlenbilanzen“ mit dieser nicht repräsentativen Temperatur zum Weltraum aufstellen. Es geht aber nicht nur um Strahlung, sondern um „Energieflüsse“, die Strahlung INKLUDIEREN,

und für Energieflüsse darf der 1. und 2.HS nicht verletzt werden.

Damit wird das Problem wieder etwas einfacher überschaubar.

Und deshalb sind diese HS bei den AGW Forentrolle Becker, Fischer und Ebel etc. so verhasst 🙂

Für jeder „Erwärmung“ verlangt die Physik eine Wärmequelle.

Gruß

Herzlichen Dank Herr Kramm,

insbesondere für ihre Darstellung zur

„global gemittelten oberflaechennahen Lufttemperatur“ die noch dazu leicht nach oben manipuliert wird.

Ich wende mich besonders dagegen aus „einfachen physikalischen Überlegungen“,

dass der (geringe) theoretische CO2 von „untern“ stärker sein soll als von „oben“, also der Energiequelle.

Der beliebte Vergleich mit dem Wintermantel (blanket) kann doch nur für ein Modell gelten, ei dem die Wärmequelle die Erde selbst ist.

Gruß

Lieber Herr Kramm,j

„Hier ein Besipiel: Das anthropogene radiative Forcing, RF = 1,66 W/m^2, fuer CO2 wird an Hand des Ansatzes

RF = C log ([CO2](t)/[CO2](t_0))

berechnet, worin C eine Konstante ist und [CO2](t) sowie [CO2](t_0) die atmosphaerischen CO2-Konzentrationen zum Zeitpunkt t (=2005) sowie t_0 (= 1750) sind. Dieser Ansatz ist unvereinbar mit der Schuster-Schwarzschild-Milne-Gleichung.“

Sie sollten wissen, dass Sie eine Näherungs- bzw. Fausformel zitieren. Präzisere Berechnungen benutzen line-to-line-Integrationen.

„Betraegt eine Klimaperiode mindestens 30 Jahre, dann sind also mindestens 60 Jahre erforderlich, um ueberhaupt eine Klimaaenderung diagnostizieren zu koennen.“

Schon mal etwas von gleitenden Mitteln gehört?

#9 Bäcker

„fuer das Wissenschaftliche Verstaendnis des Treibhauseffeltes benoetigt man keine Datenflut“

Ich habe nicht von TE gesprochen sondern von AGW. Ich nehme nicht an, dass Sie diese Begriffe gleichsetzen.

„bei EIKE wurde noch nie eine Arbeit wissenschaftlich widerlegt, was man auch daran sieht, dass keiner der EIKE Mitglieder seine Ergebnisse wissenschaftlich veroeffentlicht hat“

Woher wissen Sie, dass noch kein EIKE Mitglied zu einem AGW Thema publiziert hat ? Ausserdem: ich betrachte das EIKE Forum als eine Diskussionsplattform und nicht als Ersatz für wissenschaftliche Publikationen in anerkannten Zeitschriften. Den Vorwurf gebe ich Ihnen gerne zurück mit der Frage, wo bitte schön in anerkannten Zeitschriften (und nicht auf den Web Pages der NASA und der anderen vom IPCC anerkannten Instutite der Temperatur- und Meeresspiegelmessung) die Methodologie und die Ergebnisse der Feststellung globaler Mittelwerte für die bodennahe Lufttemperatur und den Meeresspiegel publiziert sind. Ich habe noch nie irgendwelchen Publikationen in wissenschaftlich anerkannten Journals (z.B. Nature, Science) darüber gesehen. Sie etwa ?

Sehr geehrter Herr Fischer,

ich sage weder das sie falsch noch das sie richtig ist. Die Temperaturdaten lassen so einen Schluss nicht zu.

Ich kann auch nicht erkennen das es gut passt. Der Fehlerkorridor ist so rießig, das man da ne kleine Eiszeit drinen verstecken könnte. Daher muss ich sagen ist die IPCC-Prognose nichtssagend.

@nicobäcker:

Versuchen sie es mal freundlich, professionell und insbesondere ohne jemand anderes direkt oder indirekt zu beleidigen. Glauben sie das sie dazu in der Lage sind?

Ich weis sie als Hochgebildeter haben es schwer in der Welt der Ahnungslosen. 😉 Machen sie sich nichts draus. Giordano Bruno empfand sicherlich ähnlich.

Gemaess der Definition der WMO ist Klima (siehe World Meteorological Organization: International Meteorological Vocabulary. Sec. ed. WMO-No. 182. Geneva (1992) die

„Synthesis of weather conditons in a given area, characterized by long-term statistics (mean values, variances, probabilities of extreme values, etc.) of the meteorological elements in that area“

Eine Klimaperiode umfasst mindestens 30 Jahre, damit ein gewisses Mass an Zufaelligkeit in den Wettererscheinungen angenommen werden kann. Dieses Mass an Zufaelligkeit ist eine unverzichtbare Forderung, auf der die statistische Beschreibung beruht.

Eine Aenderung eines Zustandes kann immer nur an Hand eines unabhaengigen Referenzzustandes diagnostiziert werden. Das bedeutet in der Klimatologie, dass die statistischen Ergebnisse, die fuer eine Klimaperiode gewonnen wurden, mit denen des unabhaengigen Referenzzustandes zu vergleichen sind. Betraegt eine Klimaperiode mindestens 30 Jahre, dann sind also mindestens 60 Jahre erforderlich, um ueberhaupt eine Klimaaenderung diagnostizieren zu koennen.

Klimate werde fuer Orte bzw. Regionen erstellt, die dann in Klimazonen zusammengefasst werden. Die beruehmteste Klimaklassifikation ist die von Koeppen und Geiger.

Vor dem Hintergrund frage ich mich, was dieser Bloedsinn von Trends ueber einige Jahre ueberhaupt soll.

#9, NicoBaecker,

Sie behaupten:

„Fuer das Wissenschaftliche Verstaendnis des Treibhauseffeltes benoetigt man keine Datenflut, sondern nur ein solides physikalisches Grundwissen, welches man einfach so auf die Atmosphaere, wie man es fuer jedes andere Sstem auch machen wuerde.“

Genau das ist Ihr Problem. Sie sind mit den Bilanz-Gleichungen, wie sie fuer die Atmosphaere hergeleitet wurden, wenig vertraut.

Bis heute fehlt der wissenschaftliche Beweis dafuer, dass es einen Zusammenhang zwischen der global gemittelten oberflaechennahen Lufttemperatur und der atmosphaerischen CO2-Konzentration existiert. Der Grund dafuer ist einleuchtend, dann diese Temperatur spielt im globalen Energieflussbilanz-Schema des System Erde-Atmosphaere ueberhaupt keine Rolle. Es ist eine diesem System von aussen willkuerlich aufgepraegte Temperatur, die keinen thermodynamischen Zusammenhang mit dem globalen Energieflussbilanz-Schema aufweist.

Nach dem IPCC-Report von 2007 betraegt das sog. anthropogene radiative Forcing fuer die Zeitspanne 1750 – 2005 im Mittel 1,6 W/m^2. Dieses ist eine rein rechnerische Groesse, die nicht durch Beobachtungen belegt werden kann. Ueber die Art der Berechnung kann man trefflich streiten, weil in die Berechnungen Annahmen eingehen, die nicht erfuellt sind.

Hier ein Besipiel: Das anthropogene radiative Forcing, RF = 1,66 W/m^2, fuer CO2 wird an Hand des Ansatzes

RF = C log ([CO2](t)/[CO2](t_0))

berechnet, worin C eine Konstante ist und [CO2](t) sowie [CO2](t_0) die atmosphaerischen CO2-Konzentrationen zum Zeitpunkt t (=2005) sowie t_0 (= 1750) sind. Dieser Ansatz ist unvereinbar mit der Schuster-Schwarzschild-Milne-Gleichung.

Dann wird auch noch die climate feedback equation herangezogen, um die Erhoehung der globalen Oberflaechentemperatur zu berechnen. Man gelangt zu

DT = beta RF

wobei beta der climate sensitivity parameter ist. Dass die climate feedback equation aus physikalischen Gruenden zu verwerfen ist, stoert dabei offensichtlich nicht.

Die Klimatologie hat laengst die Bedeutung einer exakten Naturwissenschaft verloren. Insbesondere in den 70er Jahren, als Wolf Haefele, der Vater des deutschen Schnellen Brueters, Leiter des Projekts Energiesysteme bei der IIASA war, betrieb die Kernenergie-Lobby die Anti-CO2-Propaganda. Sie hat nie einen Beweis fuer die Rictigkeit dieser Hypothese belegt, auf der ihre Anti-CO2-Propaganda beruht. Heute ist das nicht anders. Auch heute verbreitet die Kernenergie-Lobby noch immer die Anti-CO2-Propaganda.

Haefele soll vor einigen Jahren behauptet haben, er habe das CO2 den Gruenen ins Gehirn gesch… Offenbar war er nicht nur bei den Gruenen erfolgreich.

Brav gemacht ,Herr Baecker

wie ein richtiger Politiker ad hominem. Mit Ihrer kleinen Sottise haben Sie sich selbst entlarvt.Vielen Dank (schmunzel)Wie ein Politiker fordern Sie von anderen Dinge, die Sie selbst nicht einhalten. Auch Sie sind ein eifriger EIKE-Schreiber. Ihre wissenschaftlichen Meriten halten Sie aber streng geheim, wieso eigentlich? Womit begründen Sie Ihr angebliches „Expertentum“? Zeigen Sie mal IHRE Arbeiten vor, bevor Sie es von anderen verlangen. Aber ein Politiker braucht sowas ja nicht zu machen scheinen Sie zu denken. Stimmt sogar, deswegen kann man sie auch an ihren Sprüchen, zu denen sie selbst nicht stehen, mühelos erkennen. So wie Sie.

MfG

W Eber

Es geht weiter mit den unbequemen Wahrheiten.

Nicht nur die anhaltende Erwärmung folgt nicht dem CO2. Sinkt etwa auch noch der Mehresspiegel?

http://tinyurl.com/5ud2lzp

Herr Tobies, #4

„@nico bäcker: Wir regen uns nicht über Fehlerbereiche auf. Wir regen uns darüber auf, das die Prognosen so schwammig sind, das man damit alles begründen kann.“

Man begründet damit aber nicht alles. Wenn Ihnen das so vorkommt, müssen Sie eben mehr auf die Qualität Ihrer Informationsquellen achten und in die Details einsteigen. Auch wenn die Physik auf globaler Skala den Kurs langfristig auf warm determininiert und dies auch mit elementaren Kenntnissen nachvollzogen werden kann (aber damit noch nicht wissenschaftlich belegt wird), ist das Klimasystem im Detail für Überraschungen gut, das ist kein Widerspruch.

Wenn Sie verwirrt sind, liegt das daran, dass Sie sich nicht mit der nötigen Intensität und Ausdauer mit dem Klimasystem beschäftigt haben. Dass man als Laie die Effekte in ihre Wirksamkeit nicht richtig einschätzen kann, ist normal, das lernt man mit der Zeit…

Sehr geehrter Herr Tobies,

statistisch betrachtet liegen etwa 2/3 aller Werte in der 1-sigma-Umgebung, ca. 1/3 außerhalb. Selbst wenn Sie 2010 weglassen, müssen Sie zugeben, dass die bisherige Temperaturentwicklung keinerlei Hinweis zulässt, dass die IPCC-Prognosen falsch seien. Natürlich ist es viel zu früh, um zu behaupten, die Temperaturentwicklung würde die Theorie betätigen, aber Fakt ist, dass es bislang sehr gut passt.

Ihre Anmerkung zu 2010 ist sicherlich berechtigt, aber dann wünsche ich auch, dass die ungewöhnlich lange Phase schwacher solarer Aktivität herausgerechnet wird.

Und ich bin gespannt, ob ich diese gute kritische Distanz von Ihnen auch dann noch beobachten werden, wenn hier bald in EIKE-Artikeln gewissens cherry-picking betrieben wird, z.B. Anstieg des Seeeises seit dem Rekordminimum 2007, Stagnation der globalen Temperaturen seit dem Super-El-Nino 1998 oder in Kürze ein Sinken des Meeresspiegels 2011.

Herr Weiss,

fuer das Wissenschaftliche Verstaendnis des Treibhauseffeltes benoetigt man keine Datenflut, sondern nur ein solides physikalisches Grundwissen, welches man einfach so auf die Atmosphaere, wie man es fuer jedes andere Sstem auch machen wuerde.

bei EIKE wurde noch nie eine Arbeit wissenschaftlich widerlegt, was man auch daran sieht, dass keiner der EIKE Mitglieder seine Ergebnisse wissenschaftlich veroeffentlicht hat.

Herr W Eber,

sind Sie etwas durcheinander heute? macht nichts!

Sehr geehrter Herr Mendel,

mir ging es nur darum zu zeigen das der „Rekord“ einfach keine Aussagekraft hat. In der Öffentlichkeit reitet man aber regelmäßig darauf rum. Das gleiche gilt ja auch umgekehrt für Kälterekorde. Hat man ja auch regelmäßig.

Ich stimme ihnen zu das solche Schwankungen die langfristigen Trends überlagern. Ob der langfristige Trend allerdings von Treibhausgasen herrührt wäre noch zu beweisen. Den Beweis ist man bis heute schuldig geblieben.

Lieber Herr Weiss

Herr Baecker verfügt über eine naturwissenschaftliche Ausbildung. Seinen Beiträgen ist aber zu entnehmen, daß er hier vor allem Politik betreibt. AGW-Politik pur,weswegen er auch alles was in Sachen Klima passiert auf den CO-2Gehalt bezieht. Sie reden von einem Politiker, der sein Programm als Wissenschaft zu tarnen versucht. Was ihm immer wieder glorreich misslingt, wenn er missliebige Fakten wie ein Politiker zur Seite schiebt und für sich allein die Deutungshoheit beansprucht. So sind Politiker halt leicht erkennbar.

MfG

Michael Weber

#Bäcker

Es wurden in verschiedenen Threads auf EIKE immer wieder klar aufgezeigt, wie fehlerbehaftet die Computerberechnung eines globalen Mittelwerts der Temperatur und des Meersspiegels sind. Dies scheint Herrn Bäcker überhaupt nicht zu kümmern. Unbeirrbar bringt er immer wieder die gleichen unlogischen Argumente.

Ich finde, die Beiträge von Herrn Bäcker stehen nicht im Einklang mit der ansonsten hohen Qualität des EIKE Forums. Herr Bäcker scheint nicht über ausreichende wissenschaftliche Qualitäten zu verfügen, um die Datenflut rund um das Thema AGW wissenschaftlich korrekt beurteilen zu können.

Lieber Herr Tobies,

dass Rekordjahre von El Nino begleitet sind liegt nunmal in der Natur der Sache da dieser Effekt auf kurzen Zeitskalen den langfristigen Erwärmungstrend durch Treibhausgase übertrifft.

Ein Entfernen dieser natürlichen Schwankungen finden Sie z.B. hier http://tinyurl.com/46t5lhe

Sehr geehrter Herr Fischer,

welche jüngeren Daten meinen sie? Könnne sie mal eine Quelle liefern?

Das Rekordjahr 2010? Sie meinen das El-Nino-Jahr 2010? Genau wie das El-Nino-Jahr 1998 ist die Aussage das es ein Rekordjahr war wertlos. Der Rekord ist hier nachweislich durch das Phänomen El-Nino verursacht. Um solche Jahre mit anderen Jahren vergleichen zu können muss man den Effekt von El-Nino rausrechnen. Und wenn wir das tun ist es halt kein Rekord mehr. (tippe ich mal, hat das schon jemand gemacht?) Nebenbei gilt 2010 als genauso warm wie 1998 und das war ja auch ein El-Nino. Echt tolle Rekorde. 😀

@nico bäcker: Wir regen uns nicht über Fehlerbereiche auf. Wir regen uns darüber auf, das die Prognosen so schwammig sind, das man damit alles begründen kann. Aber es ist immer eine durch antrophogenes CO2 verursachte Erwärmung. Egal wie sich die Temperaturen entwickeln. Diesen winter war es wieder zu beobachten als Studien auftauchten, die die kalten Winter mit der Erderwärmung begündeten. Vor ein paar Jahren hat man noch die milden Winter genauso begründet und sogar prohezeit das es keine kalten Winter mehr geben wird.

Die beste Prognose ist noch immer die, die immer eintritt. Egal wie die Realität aussieht.

Herr Limburg, #2

„Es passt deshalb „erstaunlich“ gut, weil die IPCC Prognose mit einem breiten Unsicherheitsband versehen ist. Das passt alles hinein, “

Jetzt hört’s aber auf! Nun beschweren Sie sich auch noch darüber, dass man Fehlerbereiche angibt?

Natürlich passt da viel rein, aber genauer kann man es heute prognostizieren!

Der Nachweis des Zusammenhangs basiert -wie Sie selber hoffentlich wissen- auch nicht auf einem Vergleich der letzten 20 Jahre, sondern über einen längeren Zeitraum. Und außerdem ist der Vergleich mit dem globalen Mittel nicht der einzige und beste Nachweis. Das wissen nicht nur Curry und Pielke, sondern weiß JEDER Klimatologe, der sich bamit beschäftigt!

Ein aktueller Vergleich (mit dem Rekordjahr 2010) der Temperaturdaten mit der IPCC-Projektion für das A1B-Szenario findet man hier: http://tinyurl.com/3bqprxm

Passt doch erstaunlich gut, wenn auch die Aussage, die Szenarien würden von der Temperaturentwicklung übertroffen, haltlos ist.

Aber auch da muss man die Autoren erst mal richtig zitieren. Der Verfasser schreibt

„behaupteten die Autoren, dass ein Sprung nach oben in der Kurve des Temperaturverlaufs zeigt, dass „die globalen Temperaturen schneller als erwartet steigen“, und als Konsequenz daraus, dass die Klimaänderung schlimmer als erwartet ausfallen würde.“

Im paper von Rahmstorf et al. steht aber:

„The data now available raise concerns that the climate system, in particular sea level, may be responding more quickly than climate models indicate.“

Also: Nicht der Temperaturverlauf, sondern das KLIMASYSTEM, insbesondere der MEERESSPIEGEL, was auch (leider) jüngere Daten widerspiegeln.

Die Übersetzung von econometrics ist Ökonometrie.