Moritz Büsing

Im Zuge meiner langjährigen Beobachtungen der Klimaforschung und der Analyse von Berichten des IPCC und anderer Institutionen ist mir ein potenzieller Fehler bei der Auswertung von Wetterstationsdaten aufgefallen. Dieser Fehler, der auf die Homogenisierung von Messwerten zurückzuführen ist, könnte etwa die Hälfte der bisher dokumentierten Klimaerwärmung erklären.

Widersprüche in den Klimadaten

Seit Jahrzehnten verfolge ich die Entwicklungen in der Klimaforschung und habe zahlreiche Berichte des IPCC (Intergovernmental Panel on Climate Change) und anderer wissenschaftlicher Institutionen studiert. Dabei fiel mir ein bedeutender Trend auf: Die Abkühlungsphase zwischen den 1940er und 1960er Jahren, die in älteren Berichten klar erkennbar war, wurde in neueren Darstellungen immer flacher. Zudem verwandelte sich das Temperaturplateau von 1998 bis 2015 in einen ansteigenden Trend.

Diese Beobachtungen veranlassten mich, auch die absoluten globalen Mitteltemperaturen (nicht die Anomalie), wie sie in den Berichten des IPCC festgehalten wurden, genauer zu untersuchen. Als ich die Anomalie-Kurven entsprechend den damalig jeweils aktuellen absoluten Temperaturwerten verschob, stellte ich fest, dass die Vergangenheit in den neueren Kurven kälter dargestellt wurde als in älteren Versionen. Dies deutet darauf hin, dass ein Teil der festgestellten Erwärmung nicht auf reale Temperaturanstiege, sondern auf eine nachträgliche Abkühlung der Vergangenheit zurückzuführen ist.

Ursachen für die verzerrten Temperaturdaten

Nach eingehender Analyse wurde klar, dass der Hauptgrund für diese Diskrepanz in der Art und Weise liegt, wie Temperaturdaten von Wetterstationen bearbeitet und homogenisiert werden. Die amerikanische Behörde NOAA (National Oceanic and Atmospheric Administration) und das Goddard Institute for Space Studies (GISS) der NASA stellen umfangreiche Daten und Quellcodes zur Verfügung, was eine detaillierte Überprüfung ermöglichte.

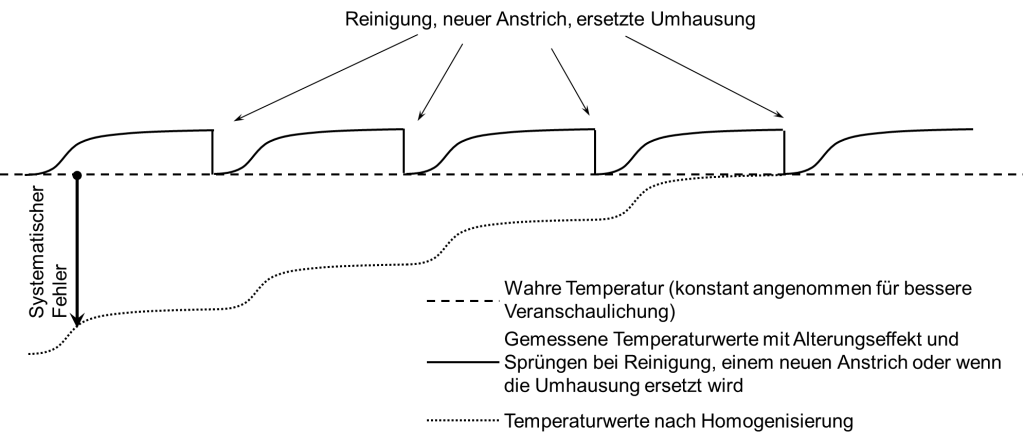

Ein zentraler Prozess in der Datenauswertung ist die Homogenisierung, bei der Wetterstationsdaten so angepasst werden, dass klimafremde Einflüsse herausgefiltert werden. Dazu gehören vor allem Temperatursprünge durch Standortwechsel der Messstationen, Änderungen der Messinstrumente oder der Messmethoden. In den 80er und 90er Jahren wurde die Homogenisierungen von Experten manuell durchgeführt. Als Grundlage dienten vor allem die Protokolle der Messstationen. Die Homogenisierungen werden heutzutage größtenteils automatisiert basierend auf statischen Analysen benachbarter Wetterstationen durchgeführt, was die Verarbeitung von mehr Datenquellen ermöglicht, für welche keine Protokolle vorliegen. Insgesamt führte dies aber auch zu immer mehr Homogenisierungsanpassungen, sowohl insgesamt als auch pro Wetterstation. Die Sprünge wurden bei allen diesen Methoden auf die gleiche Weise „korrigiert“: Alle Messdaten vor einem Sprung wurden so verschoben, dass der Sprung geglättet wird.

Hier entdeckte ich den entscheidenden Fehler: Die Annahme, dass Temperatursprünge immer dauerhaft sind, obwohl sie in vielen Fällen nur temporär auftreten. Ein Beispiel hierfür ist die Alterung der weißen Farbe an den Wetterstationen. Neu gestrichene Stationen absorbieren weniger Sonnenstrahlung und Wärmestrahlung als ältere, verschmutzte Stationen, was zu einem schleichenden Anstieg der gemessenen Temperaturen führt. Dieser Effekt ist klein, wird aber durch die wiederholte Anwendung der Homogenisierung über die Jahre hinweg mehrfach aufaddiert und führt zu einer Überschätzung der Erwärmung.

Quantifizierung der Alterungseffekte

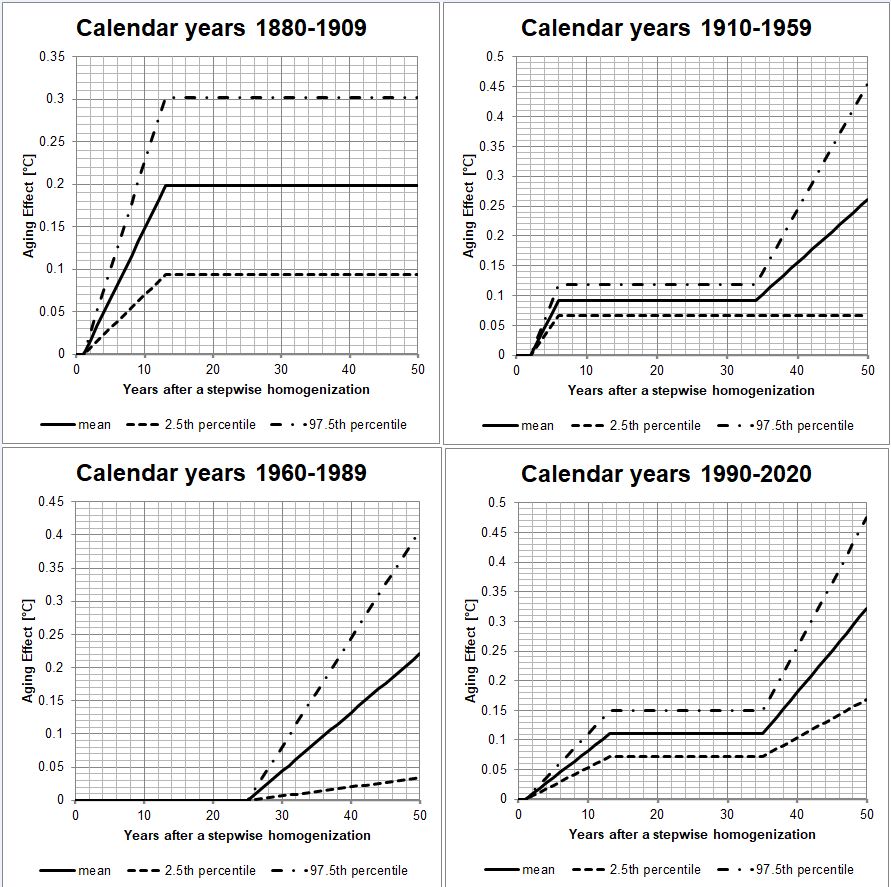

In der Literatur konnte ich leider wenig zu den Alterungseffekten finden. Die wenigen Daten die vorlagen erlaubten es nicht umfangreiche statistische Bewertungen zu machen und globale Korrekturen durchzuführen.

Daher extrahierte ich die Alterungseffekte aus den Datensätzen der Wetterstationen welche NOAA bereitstellte. Dies war möglich, weil die Alterung nicht mit konstanter Geschwindigkeit erfolgt. In den ersten ein bis zwei Jahren passiert wenig (Ausbleicheffekte, chemische Pufferung), dann verläuft die Alterung für ein paar Jahre schneller bis sie ein Plateau erreicht. Hier sind die Alterungseffekte zunächst gesättigt. Erst nach vielen Jahren setzt sich die Alterung wieder fort, wenn schwerere Schäden auftreten. Z.B. wenn die Farbe anfängt abzuplatzen. Das Plateau kann daher als Referenz verwendet werden, um die erhöhte Erwärmung in den anderen Zeitbereichen zu bestimmen. Auf Grund der hohen Streuung der Messwerte und auch der Trends der Messwerte ist diese Auswertung nicht bei einzelnen Wetterstationen möglich, sondern es müssen die Daten von tausenden Wetterstationen ausgewertet werden, um statistisch signifikante Ergebnisse zu erzielen.

Auswirkungen auf die globale Erwärmung

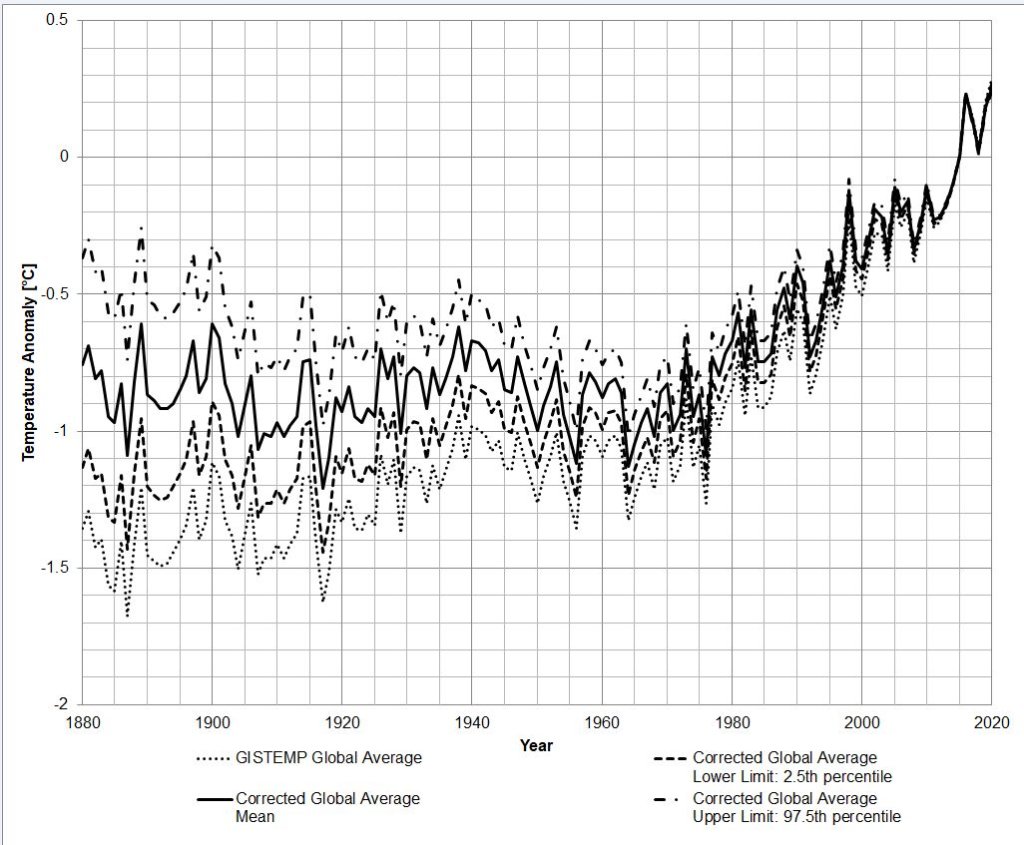

Mit den so bestimmten Alterungskurven konnte ich die Temperaturdaten korrigieren. Die Temperaturdaten habe ich dann mit dem GISTEMP Programm ausgewertet, um globale Temperaturkurven zu erhalten, welche mit den offiziellen Kurven von GISS vergleichbar sind. Das Ergebnis: Die tatsächliche Erwärmung zwischen den Jahrzehnten 1880-1890 und 2010-2020 beträgt etwa 0,83°C (mit einem 95%-Konfidenzintervall von 0,46°C bis 1,19°C), anstelle der bisher angenommenen 1,43°C. Eine weniger konservative Schätzung deutet sogar auf eine Erwärmung von nur 0,41°C hin.

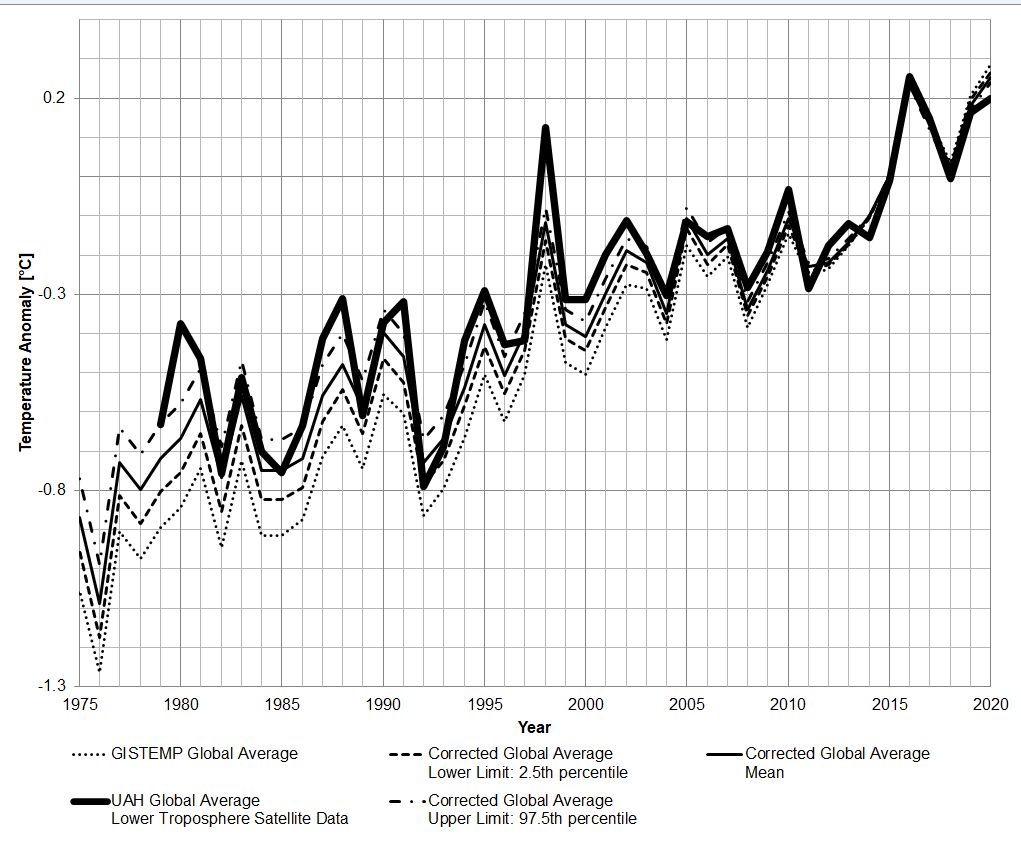

Vergleich mit Satellitendaten

Ich verglich diese Temperaturkurven mit den Satellitendaten der University of Alabama in Huntsville (UAH). Dabei stellte sich heraus, dass die korrigierten Daten viel besser mit den Satellitenmessungen übereinstimmen als die ursprünglichen Werte. Die maximalen Korrekturen, die ich vorgenommen habe, korrelieren am besten mit den Satellitendaten, während die mittleren Schätzungen immer noch eine zu hohe Erwärmung zeigen.

Reduzierte Rolle von CO₂

Ein weiterer wichtiger Befund betrifft die Korrelation zwischen der CO₂-Konzentration (genauer: LOG₂ (CO₂) ) und den rekonstruierten globalen Temperaturen. Die ursprünglichen GISTEMP-Daten zeigten einen hohen Determinationskoeffizienten von 92% zwischen der CO₂-Konzentration und den globalen Temperaturen. Nach meiner Korrektur sank der Determinationskoeffizient jedoch auf 73% und bei der weniger konservativen Schätzung sogar auf 36%. Der Determinationskoeffizient ist ein statistischer Wert, welcher quantifiziert, wie viel von der Veränderung einer Datenreihe mit einer anderen Datenreihe vorhersagbar ist.

Dies bedeutet, dass der Einfluss von CO₂ auf die globale Erwärmung möglicherweise deutlich geringer ist als in vielen wissenschaftlichen Berichten und den Medien dargestellt wird. Während CO₂ nach wie vor eine Rolle spielt, deuten meine Ergebnisse darauf hin, dass es nicht der alleinige oder dominierende Faktor ist.

Widerstände bei der Veröffentlichung

Meine Ergebnisse habe ich in einem wissenschaftlichen Artikel zusammengefasst, der im Journal Science of Climate Change veröffentlicht wurde (kostenloser Download, ohne Bezahlschranke, ohne Anmeldung):

Es war jedoch schwierig, dieses Paper zu veröffentlichen. Sechs wissenschaftliche Zeitschriften lehnten es ab, mein Manuskript auch nur zu begutachten. Auch Anfragen bei Wissenschaftlern von NOAA, GISS und mehreren deutschen Universitäten blieben unbeantwortet. Diese Reaktionen deuten darauf hin, dass es Widerstand gegenüber wissenschaftlichen Ergebnissen gibt, die dem gängigen politischen Narrativ widersprechen.

Fazit

Meine Analyse zeigt, dass ein erheblicher Teil der bisher gemessenen globalen Erwärmung durch die Art und Weise, wie Wetterstationsdaten verarbeitet werden, beeinflusst ist. Diese Entdeckung könnte zu einer Neubewertung der tatsächlichen Klimaveränderungen führen und wichtige Konsequenzen für die zukünftige Klimapolitik haben. Eine kritische und präzise Auswertung der vorhandenen Daten ist unerlässlich, um die tatsächlichen klimatischen Entwicklungen besser zu verstehen.

PS:

Dies ist eine verkürzte Darstellung meiner Analyse. Manche der Verkürzungen sind ungenau. Im verlinkten wissenschaftlichen Artikel wird die Analyse ausführlicher beschrieben. Ich bitte vor voreiliger Kritik, diesen Text zu lesen, welchen ich bewusst in möglichst normaler Sprache gehalten habe.

Ich habe auch den Python-Quellcode meiner Analysesoftware veröffentlicht.

Es wurde hier nur ein Aspekt im Detail analysiert und korrigiert, und alles andere bei der offiziellen Methodik belassen. Das heißt nicht, dass ich die Methodik nach der die Temperaturen gemittelt werden und die vielen anderen Datenmanipulationen gut heiße. Ich schließe mich auch nicht der Obsession mit Temperaturanomalien an, sondern halte Niederschläge, Windgeschwindigkeiten (Konvektion) und absolute Temperaturen für viel wichtiger. Denn diese bestimmen die Aktivität von Flora und Fauna, sowie die klimarelevanten Naturkatastrophen.

Ich freue mich darauf Ihre Kommentare und konstruktive Kritik zu lesen!

———————————

Autor: Moritz Büsing studierte an der TU München Luft- und Raumfahrt. Danach Arbeit bei Airbus Helicopters in Donauwörth an der Rotor-Analyse und -Entwicklung. Danach Wechsel in die Hubschrauber-Vorentwicklung und Wettbewerbsanalyse. Nach Ende der Arbeit dort Wechsel zum chinesischen Startup Autoflight am Standort Augsburg und Arbeit als Ingenieur an der Entwicklung eines Batterie-elektrischen Senkrechtstarters mit dem Ziel, dieses als Lufttaxi einzusetzen. Derzeit Arbeit an einem ähnlichen Projekt für LODD in Abu Dhabi.

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Diejenigen, die an der angeblichen Klimaerwärmung, verursacht durch Treibhausgase mitverdienen, verstricken sich in alle möglichen Einzelheiten und Nebengleise, nur um an ihrem Geschäftsmodell festzuhalten.

1) Dass es wärmer wurde, seit 1881, das bestreitet niemand. 2) Aber in Deutschland wurde es erst ab 1988 wärmer. 3) Und in Deutschland wurde es erst seit 1988 und tagsüber wärer. 4) Und in Deutschland wurde es erst ab 1988 und tagsüber in den Sommer-und Herbstmonaten wärmer.

Da es ab 1881 bis 1987 keine Erwärmung in Mittel- und Westeuropa gibt,- trotz Zunahme der Wärmeiseln- versucht man diese nun durch allerlei Adjustierungen (Manipulationen) der anfänglichen Messwerte nachträglich einzuführen. Man macht die Anfangsjahrzehnte einfach kälter.

Und: durch Änderung der Messmethoden wurden die leztzten 20 Jahre wärmer gemacht. Aber um nicht missverstanden zu werden. Auch ohne Messmethodenänderungen wurde es tatgsächlich wärmer seit 1988, denn die Sonnenstunden haben zugenommen, ferner wurden die Wärmeinselflächen vergrößert und die Freiflächen in Feld, Wald und Wiesen trockengelegt.

Herr Büsing, es sollte möglich sein, ihre Daten experimentell zu untermauern, Machen sie doch mal eine Messtation dreckig und wieder sauber. Ohne experimentelle Daten wirken ihre Thesen wenig überzeugend.

Und Ihre?

Herr Cohen,

hierzu gibt es eine Studie von Lopardo et al: „Comparative analysis of the influence of solar radiation screen ageing on temperature measurements by means of weather stations“ https://doi.org/10.1002/joc.3765 .

Diese konnten den Erwärmungseffekt deutlich belegen.

„stellte ich fest, dass die Vergangenheit in den neueren Kurven kälter dargestellt wurde als in älteren Versionen.“

Dass das der Fall ist, lässt sich an den Anomaliestatistiken im Vergleich von Rohdaten und „homogenisierten“ Daten leicht aufzeigen, so z.B. Zürich, Reykjavik und v.a. Auffallend ist insbesondere, dass sich diese beiden Datenreihen systematisch um das Jahr 1970 herum angleichen, um sich dann bis in die Neuzeit mit minimalen Unterschieden im Gleichschritt fortzubewegen.

Ich hatte mich vor einigen Jahren bei MeteoSwiss (verantwortlich für die Schweizer Rohdaten) nach dem Grund für diese Homogenisierung erkundigt. Man gab an, dass die früheren Messungen mit Quecksilberthermometern fehlerbehaftet seien, weil Quecksilber der Alterung unterliege und es deshalb korrigiert werden müsse. Anscheinend hat das Quecksilber in Zürich, in Reykjavík und anderenorts zur gleichen Zeit die gleiche Alterung durchgemacht und die Thermometer wurden nie erneuert oder ersetzt!?

Herr Palmer, früher wurden Quecksilberthermometer teilweise aus einem Glas hergestellt, dass seine Form mit der Zeit änderte, und die angezeigten Temperaturen wurden zu hoch. Außerdem gab es keine regelmäßige Kalibrierung. Nicht das Quecksilber alterte, sondern das Glas.

Wenn Glas „altert“ was passiert dann, wird es schlaff oder zieht es sich zusammen?

Wenn man sich eine Kapilare denkt, wird die nicht weiter, dann steigt der Fluessigkeitspiegel nicht so hoch, sind dann die Messungen nicht kaelter anstatt waermer?

Denkfehler: In die falsche Richtung korrigiert!!!, Bitte weiterlesen.

Es ist vollkommen egal, was da gealtert hat. Wichtig ist, als die Station gegründet wurde, waren sowohl Quecksilber als auch Glas noch neu. Und just diese Anfangsjahrzehnte, als das Glas und das Quecksilber noch neu waren, wurden verändert.

Es ist doch so: Je älter aus unserer Zeit rückblickend betrachtet, bedeutet, desto neuer war damals die Einrichtung. Auch beim Hohenpeißenberg hab ich dieses Arguement schon mal angeführt. Auch dort wurden durch einen Herrn P.Winkler die ersten Jahrzehnte, als die Station neu war, besonders kalt gemacht. Es hätte umgekehrt sein müssen. Die Jahrzehnte vor dem Thermometertausch, also die Messwerte der Neuzeit hätten kälter gemacht werden müssen.

Fazit: durch einen einfachen (absichtlichen) Denkfehler hat man in die falsche Richtung korrigiert, besonders fällt das bei den Schweizer Daten der Station Sitten auf.

Mich wundert, dass ich diesen groben Denkfehler immer wieder anführen muss.

Hier kann man den Bericht zur Glasalterung kaufen:

https://link.springer.com/article/10.1007/s00704-009-0108-y

The main reason was due to the composition of the glass used during the early instrumental period. Glass of this period tended to contract over many years due to thermal aftereffects, resulting in a gradual rise of the freezing point position in consequence of the shrinking bulb forming the mercury reservoir.

„Außerdem gab es keine regelmäßige Kalibrierung. “

Die absolut gemessene Temperatur ist von untergeordneter Bedeutung, denn es gehen nur die relativen Temperaturvariationen (Anomalien) in die Statistiken ein.

Sie haben auch vergessen zu erwähnen, dass die Thermometer von Auge abgelesen und die Messwerte von Hand in Tabellen eingetragen wurden. Die Ablesegenauigkeit dürfte bei +-0.5°C.

Oft wurden Thermometer auch ersetzt oder der Aufstellungsort wurde verändert. Wurde das bei der „Homogenisierung“ berücksichtigt und wie konnte man das nachträglich rekonstruieren? Wurde das überhaupt für jede Messstation dokumentiert?

„wurden Quecksilberthermometer teilweise aus einem Glas hergestellt, dass seine Form mit der Zeit änderte“

Die „Homogenisierung“ erfolgte NACHTRÄGLICH und SUMMARISCH für alle Messwerte vor etwa 1970. Wie kann es sonst sein, dass örtlich so weit auseinanderliegende Messstationen wie Zürich-Fluntern und Reykjavik genau das selbe Homogenisierungsmuster aufweisen? Weiss man, welches Glas wann benutzt wurde?

Die Daten liegen bei GISS öffentlich zugänglich vor, vergleichen Sie selbst.

@Kowatsch u. Palmer

Ohne vernünftige Quellenangaben haben sie beide eine Menge Behauptungen verfaßt. Alle diese Behauptungen sind wenig glaubwürdig, wenn es keine Belege gibt.

Speziell dem Politiker Kowatsch glaube ich nichts ohne Überprüfung.

Lieber Herr Cohnen, ich bin nicht Politiker, sondern zeitlebens aktiver Natur- und Umweltschützer und habe viele Bürgerinitiativen angeführt. Ich bezeichne mich als den Deutschen mit den meisten Natur- und Umweltauszeichnungen, alles unbezahlte Tätigkeiten. Das war meine Lebensberufung. Freizeitarbeit für die Natur, wenn andere Urlaub machten.

Überprüfen Sie, aber gehen Sie neutral an die Sache ran, so wie ich das tue. Oben hab ich behauptet, dass in die falsche Richtung homogenisiert wurde, nämlich die Anfangsjahre der Temperaturreihen kälter gemacht als die Thermometer noch neu waren und richtig gemessen haben.

Haben sie das Ende von der Zusammenfassung ihres Linkes gelesen?

L“amont also employed an easily melting glass to construct his thermometers which in use between 1841 and 1878. An analysis of the glass composition seems to be necessary to find out whether it also suffered from a rising freezing point. Lamont replaced the Hohenpeissenberg thermometer in 1842 by a new instrument produced in his own workshop. One still existing Lamont thermometer, but not that one of Hohenpeissenberg, was re-calibrated and the zero point found to have lowered by −1.4°C. Since the opposite drift had been expected and the original Lamont-type Hohenpeissenberg thermometer is no longer available, no correction is justified for the period in which this thermometer was in use.“

Was schliessen sie aus diesen Angaben?

Herr Kowatsch, wer so eindeutig wie sie Interessen einer einzigen Partei vertritt, ist für mich ein Politiker.

Ein anderer Punkt: Sie haben noch nie etwas geschrieben, was Kritik am deutschen Autowahn enthielt. Es sollte ihnen doch bewußt sein, dass fast die gesamte Landschaftsversiegelung in Deutschland durch Straßen, Parkplätze, stehende Autos usw. bedingt ist. Alles was sie schreiben, ist Unterstützung für den Autowahn. Baden-

würtemberg ist ein Autoland, lebt von der Autoproduktion, als Schwabe haben sie bestimmt ihr „heilges Blechle“ vor der Tür stehen.

Wenn sie so sehr Naturschützer sind, wie sie immer behaupten, gehen sie auf den falschen Gegner „Treibhauseffekt“ los. Ihr richtiger Gegner müßte doch der Autowahn sein, der an der Versiegelung die Hauptschuld trägt.

haben sie sich mit CO2 als Gegner

@ Schulz: Der Autor schreibt, man sollte die Werte vom Hohenpeißenberg zwischen 1841 und 1878 nicht wegen des Thermometereffekts korrigieren. Weil zu wenig darüber bekannt ist.

Zurück zum Treibhauseffekt: Bis 1960 war die CO2-Menge in der Atmosphäre um etwa 20 ppm gestiegen. Das entsprach etwa einem Temperaturanstieg um 0,15 K, wenn man die Korrelationswerte der letzten Jahre zugrund legt. 0,15 K sind vom „normalen “ Schwanken der Temperatur der Erdatmosphäre nicht zu unterscheiden. Einen Temperatureffekt der Treibhausgase vor 1960 zu erwarten und diskutieren, macht daher wenig Sinn.

Man kann sich trefflich darüber streiten, was vor 1878 war, aber der Nährwert ist gleich Null.

@ BASTIAN COHNEN am 4. Oktober 2024 um 20:45

„Herr Palmer, früher wurden Quecksilberthermometer teilweise aus einem Glas hergestellt, dass seine Form mit der Zeit änderte, und die angezeigten Temperaturen wurden zu hoch. Außerdem gab es keine regelmäßige Kalibrierung. Nicht das Quecksilber alterte, sondern das Glas.“

Cohnen, ich attestiere Ihnen hiermit, dass Sie weniger Ahnung von Glas und Glasthermometern (Thermometrie allgemein …) haben, ale ein Flugzeug vom Erdbeeranbau!

Glasthermometer haben, wie alle Referenzen, Alterungseffekte, die durch zeitlich angepasste Rekalibrierungen (Prüffristen) weitestgehend kompensiert werden können. Glasthermometer sind dabei in der „Alterungsrichtung“ viel berechenbarer als die heutigen elektrischen Fühler!!!

Fazir: Sie können vielleicht ein digitales Thermometer „richtig“ ablesen, aber von Temperaturmessung haben Sie keine Ahnung …..

Herr Palmer,

diese Alterung des Quecksilbers wird auch nicht von einem Monat auf den Anderen erfolgt sein, sondern schleichend. Die stufenweise permanente Korrektur ist auch hier nicht angebracht. Dies bestätigt meinen Fund.

Lieber Herr Büsing, nun meine Anmerkung zum letzten Abschnitt. „…Reduzierte Rolle von CO₂. Dies bedeutet, dass der Einfluss von CO₂ auf die globale Erwärmung möglicherweise deutlich geringer ist als in vielen wissenschaftlichen Berichten und den Medien dargestellt wird. Während CO₂ nach wie vor eine Rolle spielt, deuten meine Ergebnisse darauf hin, dass es nicht der alleinige oder dominierende Faktor ist….“

Sie mußten natürlich dem CO2 noch einen deutlichen Erwärmungseffekt beimessen, weil sonst ihre gut fundierte Arbeit keine Beachtung hätte finden dürfen. Ähnlich hat man mir einmal geraten, wir sollten den Wärmeinseleffekt in den Deutschen Temperaturreihen prozentual zum Treibhauseffekt ausdrücken, also z.B. ein Drittel des Treibhauseffektes ist WI-effekt. Aber in den Deutschen Temperaturreihen seit 1988 keine oder eine nicht erkennbare Wirkung des THE erkennen, wäre Klimaleugnung.

Zweifellos wurde es wärmer seit 1881 und insbesondere seit 1988. Als täglicher Naturbeobachter erkenne ich dies auch ohne DWD-Daten in der freien Natur. Aber es wurde halt nicht so stark wärmer wie die DWD Messdaten dies behaupten, Sie haben nur einen Punkt beschrieben. Wenn Sie weiter dran bleiben, werde Sie noch viele derartige Punkte finden.

Also auf gehts, machen Sie weiter so, unsere Unterstützung haben Sie.

Danke Herr Kowatsch,

ich moechte auch hinzufuegen dass 36% von 0.41°C nur 0.15°C betragen. Also selbst wenn dieser Resteffekt bliebe, wäre er sehr klein.

Interessant, man lernt dazu wie Homogenisierung geht und warum sie nicht stimmt. Ein paar Fragen bleiben, aber zuvor sollte man erst die ausführliche Arbeit lesen. Dem Text zufolge ist die „künstliche Erwärmung“ vor allem der Farb-Alterung geschuldet. Deren Erwärmungsbeitrag wird aus dem anscheinend bekannten zeitlichen Verlauf der Farbalterung ermittelt. Was plausibel scheint, weil die Wetterhütten gleichen Umweltbedingen ausgesetzt sind oder sein sollten. Auch der Feinstaub, z.B. wie täglich auf der Terrasse, trotz oder wegen eher ländlicher Umgebung, dürfte die Oberfläche beeinflussen.

Herr Büsing,

Sie bestätigen mit Ihrer Arbeit unsere Erkenntnisse, dass eine globale Erwärmung so gut wie nichts mit einer CO₂ zu tun hat. Seit vielen Monaten und Jahren veröffentlichen wir hier im Block Artikel, wo ein CO₂ Treibhauseffekt in den Temperaturreihen nicht erkennbar ist.

Des weiteren haben wir in einem Artikel https://eike-klima-energie.eu/2024/08/24/die-selbstgemachte-klimaerwaermung/ Ihre Erkenntnis der Homogenisierung von Datenreihen untersucht. Dabei haben wir festgestellt, dass die Daten in den letzten 12 Jahren mehrfach angepasst wurden, teilweise wurde die Vergangenheit um über ein halbes Grad kälter gemacht! NAOO und GISS sind da besonders zu erwähnen. Aber auch der DWD betreibt diese Homogenisierung, Adjustierung, Anpassung …..

Hier im Block erscheinen immer wieder (bezahlte) Kritiker und versuchen diese offensichtlichen Fakten als Fakes darzustellen. Dabei ist denen jedes Mittel recht. Ich warte gespannt auf die Damen und Herren Kosch, Müller, Ketterer, Heinemann, Cohnen …. und alle die ich vergessen habe.

Herr Büsing, eine Bitte. Bleiben Sie hier bei EIKE und leisten Sie Ihren Beitrag gegen die momentan auf allen Ebenen laufende Abschaffung der Demokratie und der persönlichen Freiheit durch gefälschte Wissenschaft. Ziel ist, dass die Menschen sich von Weltkonzernen steuern lassen, diese legen dann fest, wann wir uns zu impfen haben, was wir wählen sollen, was für uns gut ist, was wir zu denken und zu sagen haben. Auch was die Wissenschaft herauszufinden hat, wird von oben festgelegt. Das Geschäftsmodell CO2-Ablaßhandelssteuer ist dem mittelalterlichen Sündenablaßhandelsmodell nachempfunden, bloß rigoroser. Nur weil wir zu tolerant sind, konnte es soweit kommen.

Vielen Dank für Ihr Engagement, steter Tropfen höhlt den Stein und ihr Tropfen aus dem Artikel hat den Stein getroffen.

Gruß J.Ko.

Welches sind denn diese grüne Weltkonzerne und in welcher Größenordnung bewegen die sich finanziell?

Wissen Sie echt nichts davon, ich glaubs Ihnen mal, denn meine Frau war bis vor 10 Jahren auch noch so unbedarft und glaubte an die Unabhängigkeit der Politiker. Herr Kwass, von grün hab ich nichts geschrieben: Bestimmende Organisationen sind weder Grüne noch Juden. Es sind Gebilde mit Macht, Einfluss und Geld. Die Politiker und Regierungen, genauso wie große Zeitschriften wie z.B. Spiegel werden gelenkt durch Gelder von: George Soros, Black-Rock, Bill Gates, Atlantik-Brücke, WEF, … Schauen Sie mal bei den Politikern nach, insbesondre bei den Grünen in welchen Organisatonen diese sind und in wessen Auftrag sie dann zu handeln haben.

Diese gelbgebenden Organisationen bestimmen mit wie oft jemand in den Medien erscheint, wie er aufgebaut wird und über die Medien dann im Volk bekannt wird, bei Lanz, bei Maischberger, bei Miosga. Und sind sie schließlich ganz oben, dann sind die Leute als Bundeskanzler Marionetten von.., sie können suchen, wer Olaf Scholz in der Hand hat und wem er zu dienen hat. Jedenfalls nicht dem deutschen Volk. Haben Sie nicht das betröppelnde Gesicht gesehen, als der US Präsident Biden vor Kameras verkündet hat, dass die Nordstream-Pipeline nicht überleben wird und Scholz stand schräg hinter Biden. Noch peinlicher als Biden durch eine Zwischenfrage unterbrochen wurde, und er das AUS der Gaspipeline nochmals bestätigen mußte.

Wessen Interessen vertritt wohl Strack-Zimmermann, bestimmt nicht die des deutschen Volkes. Es wird gemunkelt, dass Black-Rock die Grünen fallen lassen wird, denn die Partei hätte sich bei der Umsetzung der Großen Transformation sehr ungeschickt angestellt. Hat nun Habeck eine letzte Chance erhalten? Hat Black Rock die bisherige Parteispitze beseitigt? Wir erfahren es nicht, aber so läuft Politik schon immer.

Matthias Baritz am 3. Oktober 2024 um 18:08

Ich hatte den Preprint vor drei Jahren mit Herrn Büsing im Forum diskutiert. Ich habe die Diskussion als sachlich und konstruktiv in Erinnerung, was Herr Büsing natürlich anders sehen kann. Irgendwie sehe ich meine damaligen fragen in der aktuellen Version nicht addressiert. Da ich zur Zeit wieder mal Schwierigkeiten habe, überhaupt einen Kommentar loszuwerden, werde ich das jetzt nicht vertiefen.

Herr Müller,

Bitte stellen Sie Ihre Fragen, anders kann ich sie nicht beantworten. Oder schicken Sie mir ein Link der anderen Diskussion.

Lieber Herr Frey, was wollen sie mit ihren Messwerten, Korrekturen und Analysen. Das einzig zur Zeit akzeptable ERGEBNISS steht doch schon seit Längerem fest. Sie stören nur. Daher auch die Schwierigkeiten bei der Veröffentlichung. Das Alles ist nicht gewünscht.

Ich persönlich finde ihre wissenschaftliche Arbeit großartig. Eben Wissenschaft wie sie sein sollte. Aber wir leben leider nicht mehr in wissenschaftlichen Zeiten. Aber Menschen wie sie arbeiten daran, daß sie eventuell wieder zurückkommen.

Mein Fehler. Der Kommentar war natürlich an die Adresse des Autors des Artikels, Herrn Büsing, gerichtet.

Danke Schön!

Die „Messwerte“ werden immer genau die sein welche das politisch gewollte Narrativ der „menschengemachten Klimaerwärmung“ stützen. Die „mittlere Erdtemperatur“ an sich ist ja nur ein virtuelles Konstrukt ohne jeden Bezug zur Realität und von daher entsprechend der politischen Vorgaben beliebig „formbar“.

Der CO2 Ablasshandel ist ein viel zu lukratives Geschäft als dass sich hier eine ergebnisoffene Betrachtung durchsetzen könnte.

Auch einen Einblick in die „Adjustierungen“ der Temperaturmessungen durch “pair wise homogenisation” und “Kriging” gibt Clive Best in diesem Artikel: „Whatever happened to the Hiatus in Global Warming?“:

https://clivebest.com/blog/?p=10766

Es bleibt die Frage, was ist eigentlich von den „Meßwerten“ noch verwertbar? Es muß ständig etwas korrigiert werden, ohne zu wissen, wie es richtig korrigiert werden muss. Oder irre ich mich.

Normalerweise müsste man in so einer Arbeit die Alterung und Absorption von Lacken im Versuch ermitteln. Ebenso, ob das überhaupt Einfluss auf die Messungen hat. Ich erinnere mich, dass neben der Wetterstation Schmücke im Thüringer Wald früher Prüfkörper mit verschiedenen Lackierungen aufgebaut waren. Aber ich vermute, das hatte mit den Messstationen gar nichts weiter zu tun.

Die Arbeit zeigt mir erneut, dass der gesamte Klimakatastrophen-Rummel auf nicht sauber verarbeiteten Messwerten beruht. Diese werden sodann mittels fraglicher Verfahren zu globalen Temperaturdaten gemittelt.

Anhand von Korrelationen zu irgendwelchen ebenso fraglichen historischen CO2-Daten, glaubt man physikalische Zusammenhänge erkannt zu haben, die so in der Vergangenheit gewirkt haben könnten.

Damit speist der Klimawissenschaftler Prognosemodelle, die dann mehrere nachkommastellengenaue zukünftige Temperentwicklungen auswerfen. Um nicht in Haftung kommen zu können, macht er möglichst viele Szenarien.

Alarmisten wählen die mögliche Katastrophe. Die Folgen sehen wir täglich, ein Tollhaus, oder?

Es überrascht mich in keinster Weise! Auch bei den Satellitenmessungen gab es ähnlich geartete bzw. gerichtete Homogenisierungen, die die Vergangenheit kühlen, z.B beim RSS (Remote sensing system), wie uns tempsvrai.com uns dies offenbarte.

Zitat: „Nach Ende der Arbeit dort Wechsel zum chinesischen Startup Autoflight am Standort Augsburg und Arbeit als Ingenieur an der Entwicklung eines Batterie-elektrischen Senkrechtstarters mit dem Ziel, dieses als Lufttaxi einzusetzen. Derzeit Arbeit an einem ähnlichen Projekt für LODD in Abu Dhabi.“

Da kann ich dem Herrn nur gasbasierte Batterien wünschen, die dem Elektrotaxi zusätzlichen Auftrieb verschaffen.

Aaaaber: Sowas wird kommen, dauert allerdings noch ein wenig! Nix mehr für mich!

Es ist sicher richtig, sich die Fehler mal näher anzusehen. Siehe z.B. auch

hier: Citation: Frank, P. LiG Metrology, Correlated Error, and the Integrity of the Global Surface Air-Temperature Record. Sensors 2023, 23, 5976. https://doi.org/10.3390/s23135976

Hinzu kommt, dass das Netz der Messstationen (siehe https://data.giss.nasa.gov/gistemp/station_data_v4_globe/ man kann die Karte für verschiedenen Jahre ab 1880 andehen) in den letzten 144 Jahren alles andere als konstant ist.

Was mich aber in dem Artikel etwas stört ist die Angabe: „Die tatsächliche Erwärmung zwischen den Jahrzehnten 1880-1890 und 2010-2020 beträgt etwa 0,83°C (mit einem 95%-Konfidenzintervall von 0,46°C bis 1,19°C), anstelle der bisher angenommenen 1,43°C.“ Nach meiner Meinung soll die Angaben 1,43°C ein Wissen vortäuschen, das es nicht geben kann! Eine Angabe 0,8°C bzw. 0,5-1,2°C ist von der Geneuigkeit bereits etwas übergenau,

Das Thema der Genauigkeit ist wichtig.

Ich drücke diese lieber in Form von Konfidenzintervallen aus, als durch Rundungen.

Aber auch die berechneten Konfidenzintervalle gelten nur, wenn die getroffenen Annahmen zu 100% stimmen.

Insgesamt wird in der Klimawissenschaft (auch in der medizinischen Forschung) über trends gesprochen die wesentlich kleiner sind als das „Rauschen“ der Datenbasis. Wenn ich hier mit ähnlich hohen Standarts rechnen würde als bei der Analyse der Sicherheit von Flugzeugkomponenten, dann käme einfach nichts heraus.