Entdeckung eines systematischen Fehlers bei Wetterstationen: Neue Analyse stellt bisherige Klimadaten in Frage

Moritz Büsing

Im Zuge meiner langjährigen Beobachtungen der Klimaforschung und der Analyse von Berichten des IPCC und anderer Institutionen ist mir ein potenzieller Fehler bei der Auswertung von Wetterstationsdaten aufgefallen. Dieser Fehler, der auf die Homogenisierung von Messwerten zurückzuführen ist, könnte etwa die Hälfte der bisher dokumentierten Klimaerwärmung erklären.

Widersprüche in den Klimadaten

Seit Jahrzehnten verfolge ich die Entwicklungen in der Klimaforschung und habe zahlreiche Berichte des IPCC (Intergovernmental Panel on Climate Change) und anderer wissenschaftlicher Institutionen studiert. Dabei fiel mir ein bedeutender Trend auf: Die Abkühlungsphase zwischen den 1940er und 1960er Jahren, die in älteren Berichten klar erkennbar war, wurde in neueren Darstellungen immer flacher. Zudem verwandelte sich das Temperaturplateau von 1998 bis 2015 in einen ansteigenden Trend.

Diese Beobachtungen veranlassten mich, auch die absoluten globalen Mitteltemperaturen (nicht die Anomalie), wie sie in den Berichten des IPCC festgehalten wurden, genauer zu untersuchen. Als ich die Anomalie-Kurven entsprechend den damalig jeweils aktuellen absoluten Temperaturwerten verschob, stellte ich fest, dass die Vergangenheit in den neueren Kurven kälter dargestellt wurde als in älteren Versionen. Dies deutet darauf hin, dass ein Teil der festgestellten Erwärmung nicht auf reale Temperaturanstiege, sondern auf eine nachträgliche Abkühlung der Vergangenheit zurückzuführen ist.

Ursachen für die verzerrten Temperaturdaten

Nach eingehender Analyse wurde klar, dass der Hauptgrund für diese Diskrepanz in der Art und Weise liegt, wie Temperaturdaten von Wetterstationen bearbeitet und homogenisiert werden. Die amerikanische Behörde NOAA (National Oceanic and Atmospheric Administration) und das Goddard Institute for Space Studies (GISS) der NASA stellen umfangreiche Daten und Quellcodes zur Verfügung, was eine detaillierte Überprüfung ermöglichte.

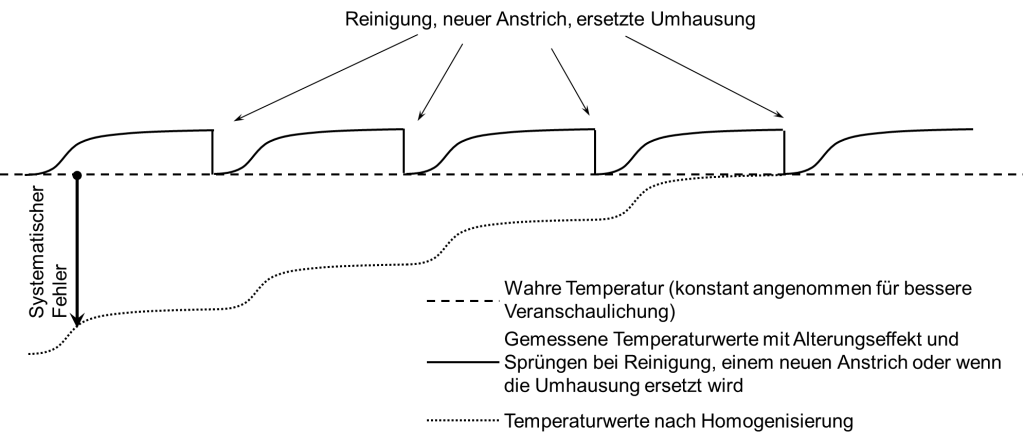

Ein zentraler Prozess in der Datenauswertung ist die Homogenisierung, bei der Wetterstationsdaten so angepasst werden, dass klimafremde Einflüsse herausgefiltert werden. Dazu gehören vor allem Temperatursprünge durch Standortwechsel der Messstationen, Änderungen der Messinstrumente oder der Messmethoden. In den 80er und 90er Jahren wurde die Homogenisierungen von Experten manuell durchgeführt. Als Grundlage dienten vor allem die Protokolle der Messstationen. Die Homogenisierungen werden heutzutage größtenteils automatisiert basierend auf statischen Analysen benachbarter Wetterstationen durchgeführt, was die Verarbeitung von mehr Datenquellen ermöglicht, für welche keine Protokolle vorliegen. Insgesamt führte dies aber auch zu immer mehr Homogenisierungsanpassungen, sowohl insgesamt als auch pro Wetterstation. Die Sprünge wurden bei allen diesen Methoden auf die gleiche Weise „korrigiert“: Alle Messdaten vor einem Sprung wurden so verschoben, dass der Sprung geglättet wird.

Hier entdeckte ich den entscheidenden Fehler: Die Annahme, dass Temperatursprünge immer dauerhaft sind, obwohl sie in vielen Fällen nur temporär auftreten. Ein Beispiel hierfür ist die Alterung der weißen Farbe an den Wetterstationen. Neu gestrichene Stationen absorbieren weniger Sonnenstrahlung und Wärmestrahlung als ältere, verschmutzte Stationen, was zu einem schleichenden Anstieg der gemessenen Temperaturen führt. Dieser Effekt ist klein, wird aber durch die wiederholte Anwendung der Homogenisierung über die Jahre hinweg mehrfach aufaddiert und führt zu einer Überschätzung der Erwärmung.

Quantifizierung der Alterungseffekte

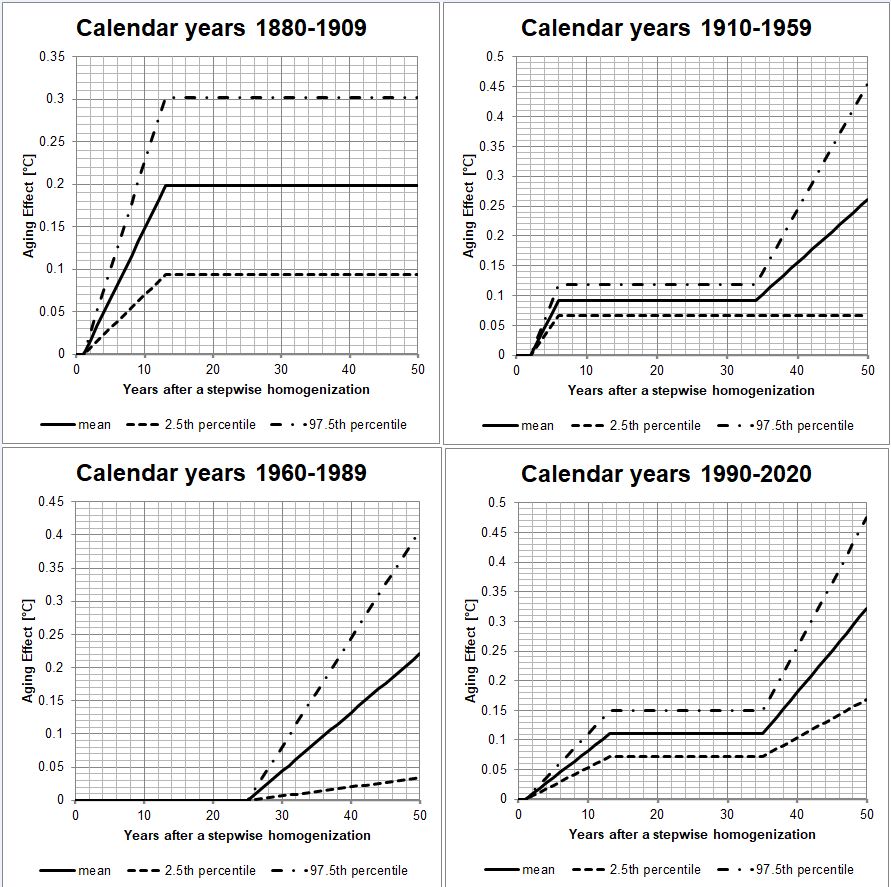

In der Literatur konnte ich leider wenig zu den Alterungseffekten finden. Die wenigen Daten die vorlagen erlaubten es nicht umfangreiche statistische Bewertungen zu machen und globale Korrekturen durchzuführen.

Daher extrahierte ich die Alterungseffekte aus den Datensätzen der Wetterstationen welche NOAA bereitstellte. Dies war möglich, weil die Alterung nicht mit konstanter Geschwindigkeit erfolgt. In den ersten ein bis zwei Jahren passiert wenig (Ausbleicheffekte, chemische Pufferung), dann verläuft die Alterung für ein paar Jahre schneller bis sie ein Plateau erreicht. Hier sind die Alterungseffekte zunächst gesättigt. Erst nach vielen Jahren setzt sich die Alterung wieder fort, wenn schwerere Schäden auftreten. Z.B. wenn die Farbe anfängt abzuplatzen. Das Plateau kann daher als Referenz verwendet werden, um die erhöhte Erwärmung in den anderen Zeitbereichen zu bestimmen. Auf Grund der hohen Streuung der Messwerte und auch der Trends der Messwerte ist diese Auswertung nicht bei einzelnen Wetterstationen möglich, sondern es müssen die Daten von tausenden Wetterstationen ausgewertet werden, um statistisch signifikante Ergebnisse zu erzielen.

Auswirkungen auf die globale Erwärmung

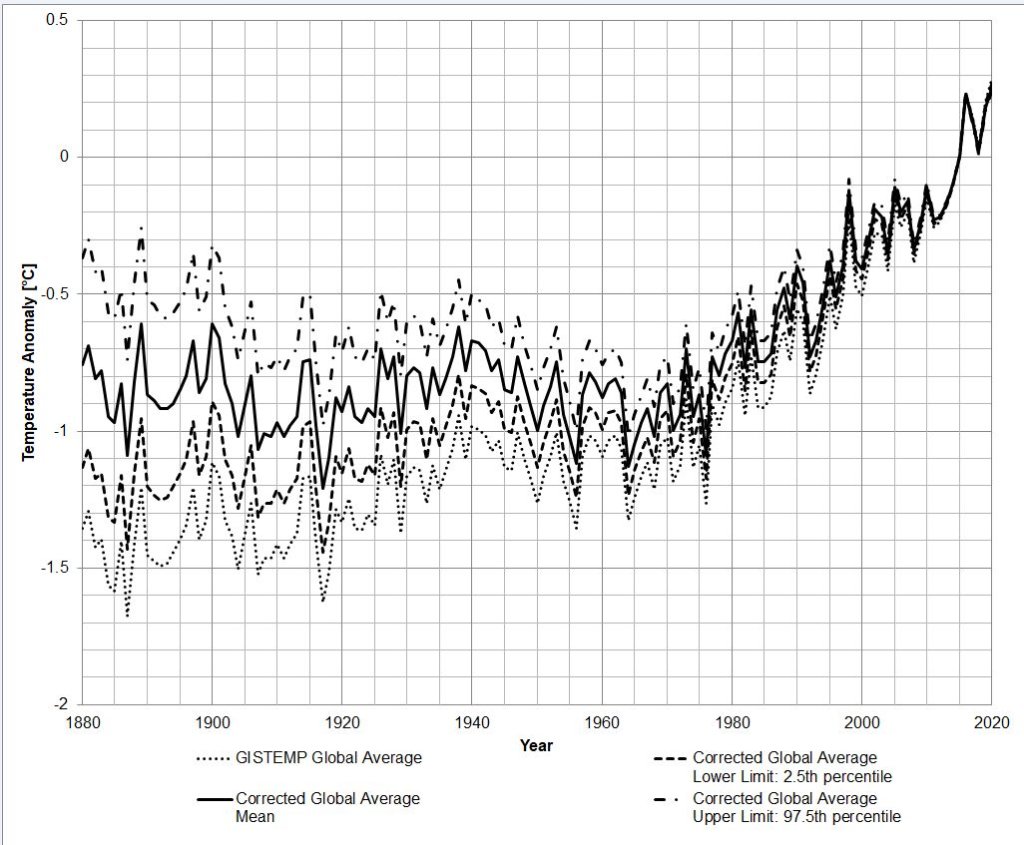

Mit den so bestimmten Alterungskurven konnte ich die Temperaturdaten korrigieren. Die Temperaturdaten habe ich dann mit dem GISTEMP Programm ausgewertet, um globale Temperaturkurven zu erhalten, welche mit den offiziellen Kurven von GISS vergleichbar sind. Das Ergebnis: Die tatsächliche Erwärmung zwischen den Jahrzehnten 1880-1890 und 2010-2020 beträgt etwa 0,83°C (mit einem 95%-Konfidenzintervall von 0,46°C bis 1,19°C), anstelle der bisher angenommenen 1,43°C. Eine weniger konservative Schätzung deutet sogar auf eine Erwärmung von nur 0,41°C hin.

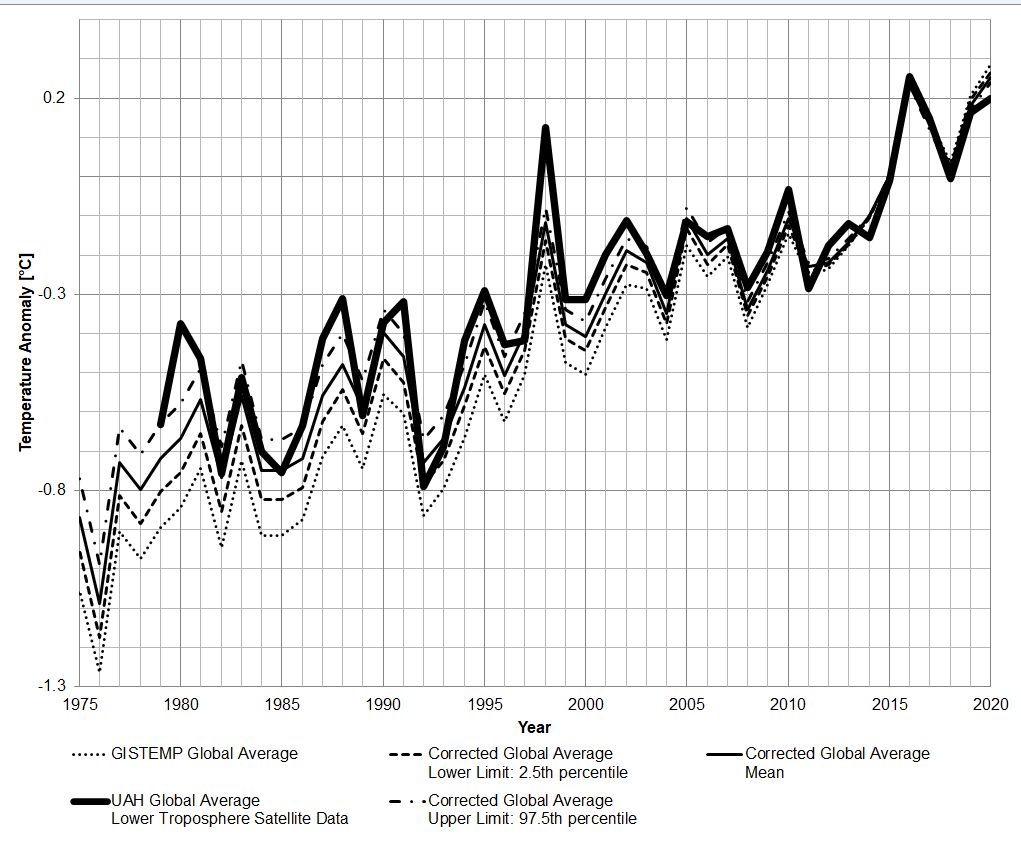

Vergleich mit Satellitendaten

Ich verglich diese Temperaturkurven mit den Satellitendaten der University of Alabama in Huntsville (UAH). Dabei stellte sich heraus, dass die korrigierten Daten viel besser mit den Satellitenmessungen übereinstimmen als die ursprünglichen Werte. Die maximalen Korrekturen, die ich vorgenommen habe, korrelieren am besten mit den Satellitendaten, während die mittleren Schätzungen immer noch eine zu hohe Erwärmung zeigen.

Reduzierte Rolle von CO₂

Ein weiterer wichtiger Befund betrifft die Korrelation zwischen der CO₂-Konzentration (genauer: LOG₂ (CO₂) ) und den rekonstruierten globalen Temperaturen. Die ursprünglichen GISTEMP-Daten zeigten einen hohen Determinationskoeffizienten von 92% zwischen der CO₂-Konzentration und den globalen Temperaturen. Nach meiner Korrektur sank der Determinationskoeffizient jedoch auf 73% und bei der weniger konservativen Schätzung sogar auf 36%. Der Determinationskoeffizient ist ein statistischer Wert, welcher quantifiziert, wie viel von der Veränderung einer Datenreihe mit einer anderen Datenreihe vorhersagbar ist.

Dies bedeutet, dass der Einfluss von CO₂ auf die globale Erwärmung möglicherweise deutlich geringer ist als in vielen wissenschaftlichen Berichten und den Medien dargestellt wird. Während CO₂ nach wie vor eine Rolle spielt, deuten meine Ergebnisse darauf hin, dass es nicht der alleinige oder dominierende Faktor ist.

Widerstände bei der Veröffentlichung

Meine Ergebnisse habe ich in einem wissenschaftlichen Artikel zusammengefasst, der im Journal Science of Climate Change veröffentlicht wurde (kostenloser Download, ohne Bezahlschranke, ohne Anmeldung):

Es war jedoch schwierig, dieses Paper zu veröffentlichen. Sechs wissenschaftliche Zeitschriften lehnten es ab, mein Manuskript auch nur zu begutachten. Auch Anfragen bei Wissenschaftlern von NOAA, GISS und mehreren deutschen Universitäten blieben unbeantwortet. Diese Reaktionen deuten darauf hin, dass es Widerstand gegenüber wissenschaftlichen Ergebnissen gibt, die dem gängigen politischen Narrativ widersprechen.

Fazit

Meine Analyse zeigt, dass ein erheblicher Teil der bisher gemessenen globalen Erwärmung durch die Art und Weise, wie Wetterstationsdaten verarbeitet werden, beeinflusst ist. Diese Entdeckung könnte zu einer Neubewertung der tatsächlichen Klimaveränderungen führen und wichtige Konsequenzen für die zukünftige Klimapolitik haben. Eine kritische und präzise Auswertung der vorhandenen Daten ist unerlässlich, um die tatsächlichen klimatischen Entwicklungen besser zu verstehen.

PS:

Dies ist eine verkürzte Darstellung meiner Analyse. Manche der Verkürzungen sind ungenau. Im verlinkten wissenschaftlichen Artikel wird die Analyse ausführlicher beschrieben. Ich bitte vor voreiliger Kritik, diesen Text zu lesen, welchen ich bewusst in möglichst normaler Sprache gehalten habe.

Ich habe auch den Python-Quellcode meiner Analysesoftware veröffentlicht.

Es wurde hier nur ein Aspekt im Detail analysiert und korrigiert, und alles andere bei der offiziellen Methodik belassen. Das heißt nicht, dass ich die Methodik nach der die Temperaturen gemittelt werden und die vielen anderen Datenmanipulationen gut heiße. Ich schließe mich auch nicht der Obsession mit Temperaturanomalien an, sondern halte Niederschläge, Windgeschwindigkeiten (Konvektion) und absolute Temperaturen für viel wichtiger. Denn diese bestimmen die Aktivität von Flora und Fauna, sowie die klimarelevanten Naturkatastrophen.

Ich freue mich darauf Ihre Kommentare und konstruktive Kritik zu lesen!

———————————

Autor: Moritz Büsing studierte an der TU München Luft- und Raumfahrt. Danach Arbeit bei Airbus Helicopters in Donauwörth an der Rotor-Analyse und -Entwicklung. Danach Wechsel in die Hubschrauber-Vorentwicklung und Wettbewerbsanalyse. Nach Ende der Arbeit dort Wechsel zum chinesischen Startup Autoflight am Standort Augsburg und Arbeit als Ingenieur an der Entwicklung eines Batterie-elektrischen Senkrechtstarters mit dem Ziel, dieses als Lufttaxi einzusetzen. Derzeit Arbeit an einem ähnlichen Projekt für LODD in Abu Dhabi.