Mein verhindertes Video-Gespräch mit Prof. Gerd Ganteför

Die Treibhaushypothese wird Stück für Stück mit Beweisen, Fakten und Logik widerlegt. Das mag nicht jedem gefallen, ist aber, bis zum Gegenbeweis, korrekt. Es wird nachgewiesen, dass dieses nur hypothetische Gebäude – bildlich gesprochen- ein Fundament hat, was auf Sand ruht, der seinerseits im Sumpf liegt.

Von Michael Limburg

Videoausschnitt ca. 3 Minuten lang, aus dem Gespräch mit Herrn Model mit Prof. Gerd Ganteför, zum Thema Klimawandel und Treibhauseffekt. Von Herrn Model vorgestellt mit den Worten: „In dieser Folge im Modelhof begrüßen wir Prof. Dr. Gerd Ganteför – Physiker, Autor und einer der unbequemsten Stimmen in der Klimadebatte“. ALLE ZEITANGABEN IM FOLGENDEN BEZIEHEN SICH DAS HIESIGE VIDEO, FALLS DAS GELÖSCHT WERDEN SOLLTE IN KLAMMERN, AUF DAS ORIGINAL.

Zurück zu den Mittelwerten aus vorindustrieller Zeit.

Ganteför bezieht sich…

- auf Anomalien, also die Differenz zwischen einem als Normalwert bezeichnete Größe und dem aktuellen Wert, mit einer Summe von + 1,5 °C

- auf eine Zeit, die er als „vorindustriell“ bezeichnet. Und so steht es auch in der Pariser Klimaübereinkunft.

Zu 1. Diese Anomalie hat eine Unbekannte, nämlich die „Mitteltemperatur“ der Erde vor der Zeit von 1978. Die bekannte Größe ist der Normwert der globalen Mitteltemperatur von 1990 bis 1961. 1978 war das Jahr in dem erstmals Wettersatelliten aufstiegen. Ein Programm, bei dem auch S.Fred Singer maßgeblich beteiligt war, und das ihn zum großen Atmosphären-Physiker seiner Zeit machte. Ich bin sehr froh, ihn nicht nur gekannt zu haben, sondern auch dass wir lange Jahre, bis zu seinem Tod, befreundet waren. Über diese Temperatur will ich im Folgenden schreiben, zuvor aber noch etwas anderes…

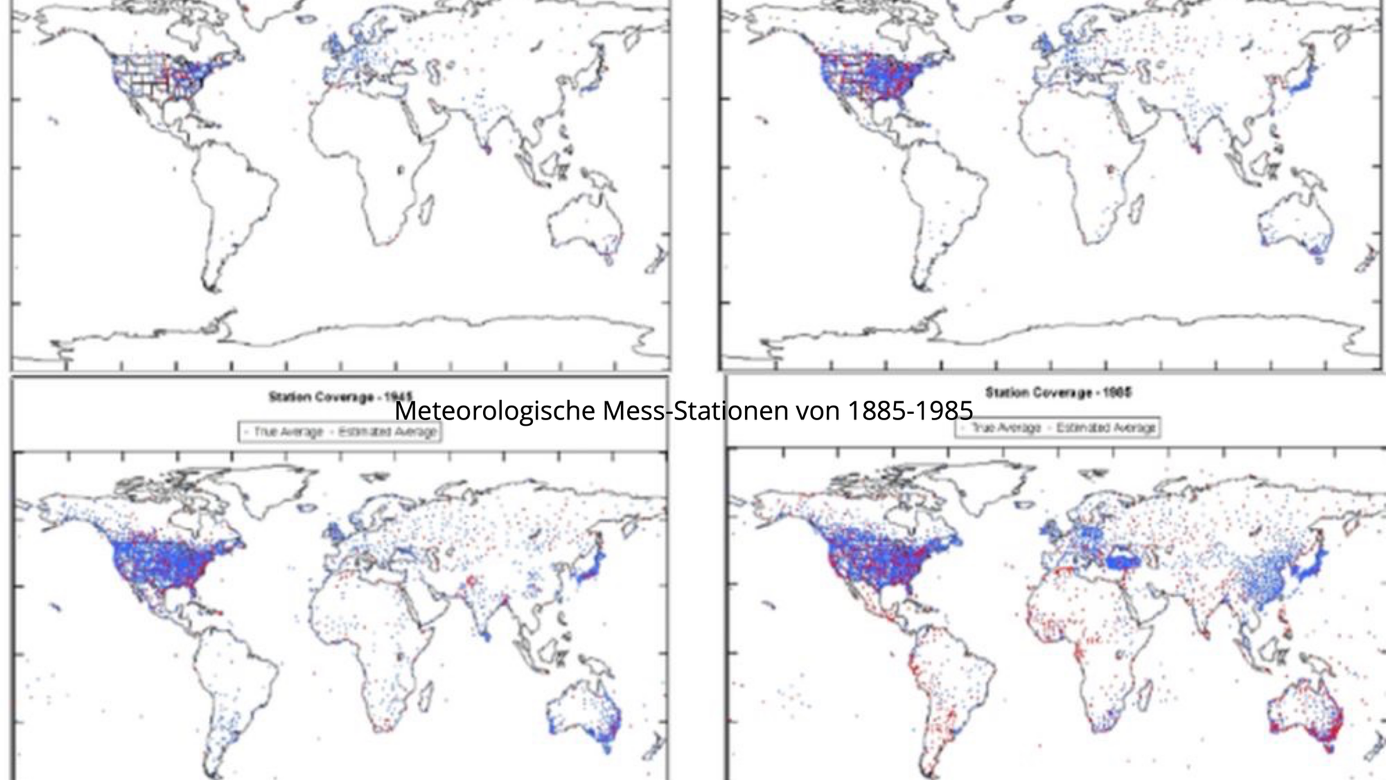

Zu 2. Das Problem mit „vorindustriell“ ist, dass niemand weiß, wann das war? Auch Ganteför nicht. Keiner, auch die Delegierten der Pariser Klimaübereinkunft, ebenso wenig wie die Bundesregierung, oder alle „Klimawissenschaftler des IPCC, des Potsdam Instituts für Klimafolgenforschung, etc. etc. Niemand. Man behilft sich dann mit den wenigen Daten, die man zur Temperaturmessung hatte, und sagt dann, dass sei vor 1850 gewesen. Nur weltweite Messungen hatte man keine. Nur wenige lokale Messungen mit Fehlern alle Art. Wie Abbildung 9 eindrucksvoll belegt.

Abbildung 9: Meteorlogische Temperaturstationen und deren weltweiter (nur Land) Verteilung von 1885 bis 1985. Es fällt auf, dass nur wenige in den USA, Europa, europ. Russland, und ein wenig in China lagen. Um 1885 ware es ingesamt ca. 500 Stationen, um das Jahr 1900 ca. 1000. Nichts jedoch in allen anderen Ländern außer den oben genannte, plus der Ozeane, die ca. 71 % der Weltoberfläche ausmachen.[1]

5. Das Nächste ist der Begriff der Anomalien.

Es gibt unter den „Klimaforschern“ die vermeintliche Tatsache, dass Anomalien genauer seien als Absolutwerte, weil sich deren Fehler ausgleichen. Doch das ist nur teilweise richtig, denn es bezieht sich nur auf die zufälligen, nicht auf die systematischen Fehler. Und es ist doppelt falsch für Zeitreihen. Weil letztere nur einen Normwert aus einer bestimmten Zeitspanne als eine der Zahlen beinhalten (bspw. der Normwert von 1961 bis 1990). Für die anderen Werte gilt die Bemerkung von Brohan et al überhaupt nicht. Und wenn in dieser Zeit des Normwertes ein systematischer Fehler, schleichend oder ad hoc, auftritt, dann auch nicht für diesen. Systematische Fehler, so man sie denn kennt, addieren sich nämlich, je nach Art – voneinander abhängig oder nicht- mit dem Absolutwert der Fehler oder mit der Wurzel der Summe der Quadrate der Fehler.

Brohan und Kennedy et al[2] haben jedoch dieses sehr eigene Fehlerverständnis mal in diese Worte gekleidet:

There will be a difference between the true mean monthly temperature (i.e., from 1 min averages) and the average calculated by each station from measurements made less often; but this difference will also be present in the station normal and will cancel in the anomaly. So this does not contribute to the measurement error.

Zu Deutsch

Es wird eine Differenz zwischen der tatsächlichen monatlichen Durchschnittstemperatur (d. h. aus 1-Minuten-Durchschnitten) und dem von jeder Station aus selteneren Messungen berechneten Durchschnitt geben; diese Differenz ist jedoch auch im Stationsnormal vorhanden und hebt sich in der Anomalie auf. Sie trägt also nicht zum Messfehler bei.

Und weiter..

Only random errors have been regarded.

Nur zufällige Fehler wurden betrachtet.

Und da haben Sie recht, denn je mehr zufällige Fehler vorhanden sind – und sie sind deshalb zufällig, weil sie in der Gausschen Fehlerverteilung gleichmäßig um den genauen Wert verteilt sind, dann mit dem Bruch aus 1 geteilt durch Wurzel n. gegen Null gehen. Wobei n die Zahl der Fehler darstellt.

Und zu systematischen Fehler bekennen sie sich, wenn auch nur zu einem sehr kleine Teil davon

See 2.3.1. Station Errors and 2.3.1.1. Measurement Error (εob)„.. If a station changes the way mean monthly temperature is calculated it will produce an inhomogeneity in the station temperature series, and uncertainties due to such changes will form part of the homogenization adjustment error.

Deutsch:

„Ändert eine Station die Berechnungsweise der durchschnittlichen Monatstemperatur, führt dies zu einer Inhomogenität in der Temperaturreihe der Station und die Unsicherheiten aufgrund solcher Änderungen sind Teil des Homogenisierungsanpassungsfehlers.“

Doch das ist wie schon erwähnt nur ein äußerst geringer Anteil der systematischen Fehler, und die Inhomogenitäten wurden weder anteilig noch komplett ausgeräumt.

Daher sagte Richard Muller, Projektleiter der BEST Temperaturstudie dazu

„…Using data from all these poor stations, the U.N.’s Intergovernmental Panel on Climate Change estimates an average global 0.64 °C temperature rise in the past 50 years, „most“ of which the IPCC says is due to humans. Yet the margin of error for the stations is at least three times larger than the estimated warming“ BEST Studienleiter Richard Muller 21.10.2011 Wallstreet Journal

Zu Deutsch

„…Anhand der Daten all dieser schlechten Stationen schätzt der Zwischenstaatliche Ausschuss für Klimaänderungen der UNO einen durchschnittlichen globalen Temperaturanstieg von 0,64 °C in den letzten 50 Jahren, von dem der IPCC sagt, dass er „zum größten Teil“ auf den Menschen zurückzuführen sei. Die Fehlerspanne der Stationen ist jedoch mindestens dreimal größer als die geschätzte Erwärmung.“ BEST Studienleiter Richard Muller 21.10.2011 Wallstreet Journal

Und noch eines ist sehr wichtig. Nämlich die Tatsache, dass die Anomalien nur einen kleinen Teil der Gesamtmessung darstellen. Ca. 50 bis 100 fach kleiner. Doch die Fehler werden auf die Gesamtmessung bezogen, das bedeutet, dass sie auf die Anomalien ein um den Faktor 50 bis 100 größeres Gewicht haben. Und das bedeutet, dass Anomalien für diesen Zeck unbrauchbar sind.

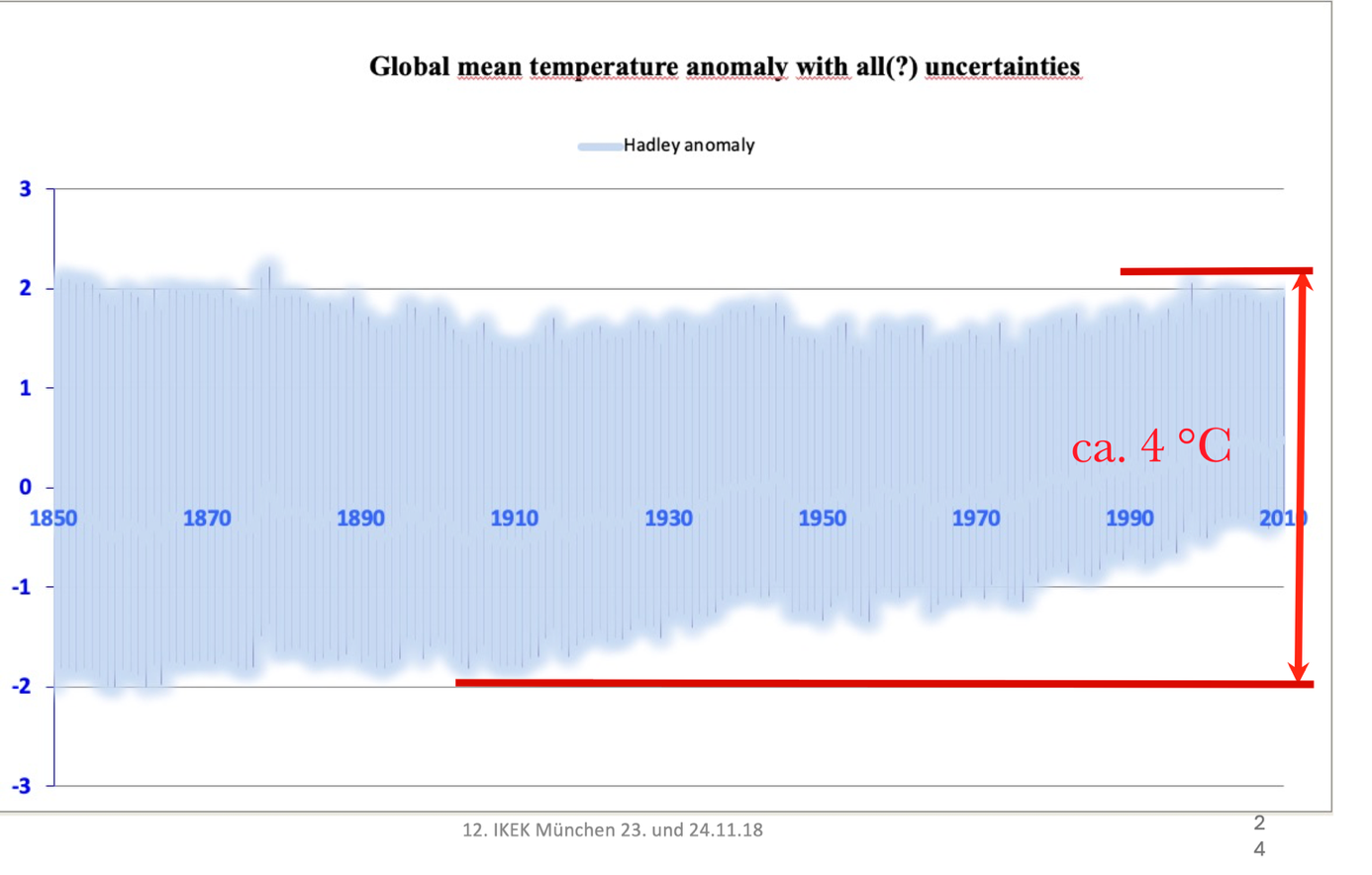

Und daher ist es immer wieder wichtig sich auf die Veröffentlichungen von Pat Frank zu beziehen, bspw. „Uncertainty in the Global Average Surface Air Temperature Index: A Representative Lower Limit“, oder SYSTEMATIC ERROR IN CLIMATE MEASUREMENTS: THE SURFACE AIR TEMPERATURE RECORD. Er hat dort einen geringen Teil der systematischen Fehler gefunden und analysiert. Aber diese wurden nicht von diesen Leuten betrachtet, obwohl sie die Zeitreihe der Anomalien der Welt-Durchschnittstemperatur wie ein sehr großes, zu großes Unsicherheitssband umschließen.

Abbildung 10 Global mean temperatures[3] als Anomalienbetrachtung jedoch mit sehr vorsichtig geschätzten Unsicherheitsband,

Und wenn das so ist, wie dargestellt, dann möchte das Wunderkind sehen, dass aus dieser Melange irgendeine Korrelation oder noch mehr Ursache – Wirkungsbeziehung herleiten kann, etwa wie das CO2 die vermeintliche Temperatur beeinflusste.

Aus eben dieser Arbeit (Limburg 2010) stammt dann auch die Bemerkung (S 147):

„Es ist in jedem Fall zu beachten, dass die Verteilung dieser und der anderen betrachteten systematischen und groben Fehler nicht einer Normalverteilung entspricht. Damit entziehen sich diese Fehler den statistischen Methoden, die auf Normalverteilung -oder guten Näherungen dazu- basieren. Diese Fehler müssten daher einzeln abgeschätzt und ggf. angegeben oder, besser, wenn möglich korrigiert werden.“

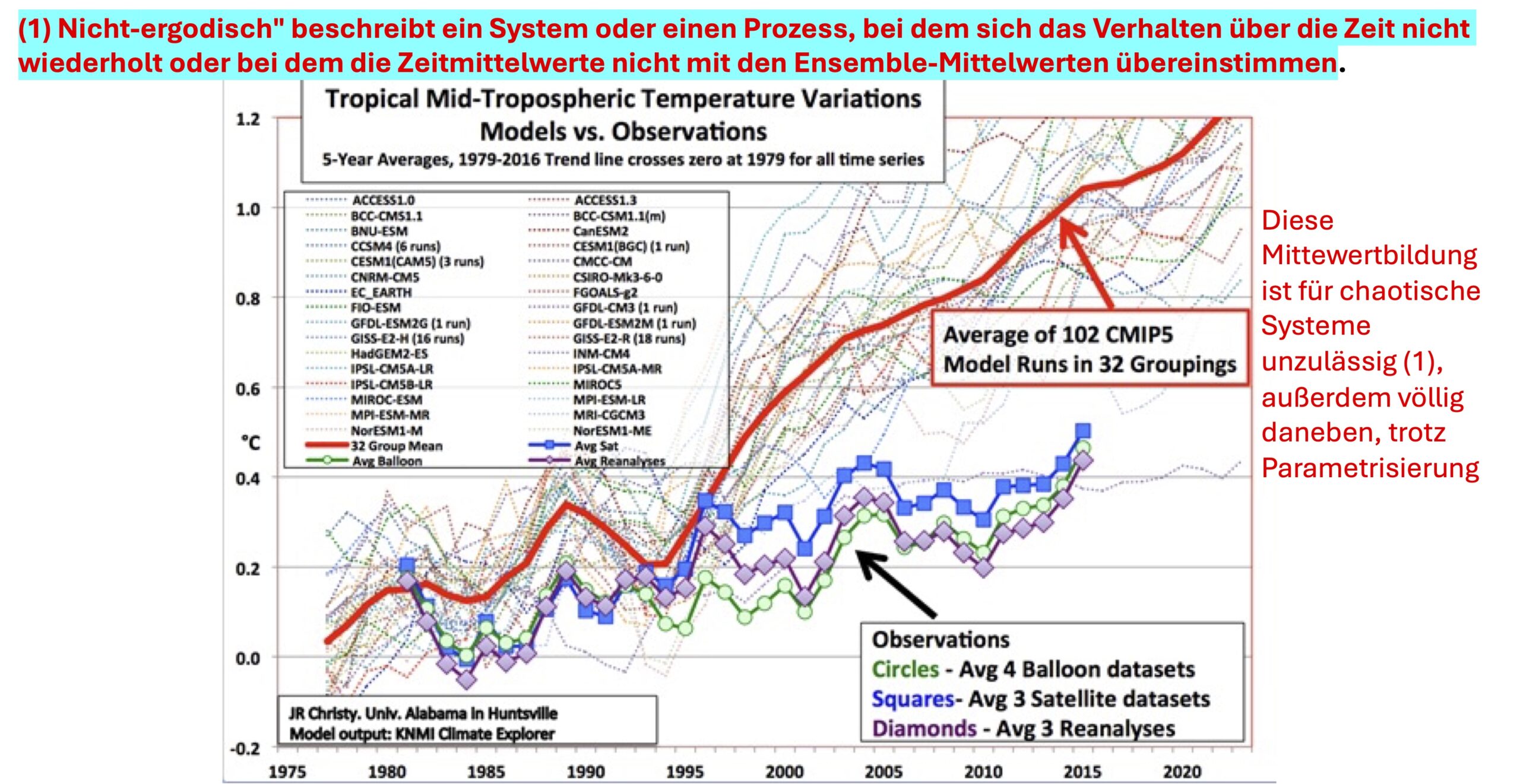

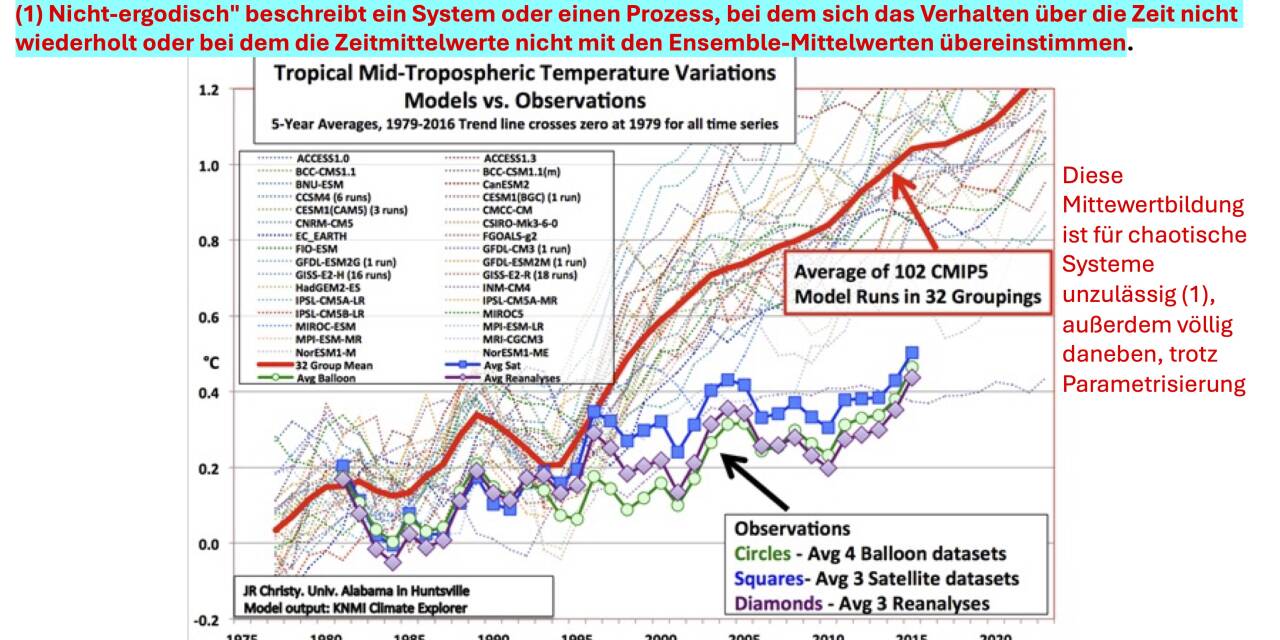

Diese eindeutige und klare Anmerkung wird gestützt durch die viel späteren Aussagen des Mathematikers und Physiker Heinz-Otto Peitgen, ebenso Mitglied des 4PI Solutions Vereins wie Ganteför, der Klima als nicht-ergodisch bezeichnet. Er meinte (ab Minute 1:08.54):

Der Hammer ist: in nicht-ergodischen Systemen ist Mittelwert und Standardabweichung und Varianz keine sinnvolle Technik. … Also, wenn diese beiden Dinge, wenn diese beiden Standpunkte Bestand hätten und ich glaube, sie haben Bestand, dann ist das das Todesurteil für belastbare Ensemble Rechnungen über die zukünftige Entwicklung des Klimas. .

Und das sieht dann so aus.

Abbildung 11 Darstellung der Mittelwerte von 102 Modellen, mit den Ergebnissen aus Ballons-, Satelliten- und Thermometerdaten.

Man kann es auch so sagen wie es der „Fürst der Mathermatiker“ Carl Friedrich Gauss feststellte

„Das Kennzeichen eines schlechten Mathematikers ist, dass er zu genau rechnet.“

6. Prognosen

ab Minute 3:14 (YT 18:40 ff) sagte Ganteför

„Ja, und jetzt wird es nach diesen Prognosen von den Klimamodellen vielleicht 2° wärmer und ich halte es für sehr wahrscheinlich, dass es sogar 2,5° wärmer wird.“

Auch das ist falsch. Es ist bestenfalls eine Hypothese, die es zu beweisen gilt. Und zunächst mal spricht Ganteför von Prognosen, obwohl Klimaforscher sich davor hüten von Prognosen zu sprechen, weil es das nicht gibt. Sie sprechen stattdessen von Szenarien.

Was ist damit gemeint?

Die treffendste Erklärung nannte der Klimatologe Hans-Christian Schönwiese[4] die (notwendige) Vorgehensweise der Modellierer und gleichzeitig deren Schwächen beschrieben:

„wir machen keine Vorhersagen, sondern bedingte, Szenarien gestützte Projektionen… Und Projektion heißt ..wenn – dann Aussage. Wenn ich in das Modell hinein stecke der Mensch macht das und das und die Natur macht quasi nichts, sie wird also weitgehend vergessen, bei diesem Blick in die Zukunft, dann wird die Temperatur so und so ansteigen“

„… das trifft praktisch auf die Gesamtheit der natürlichen Klimaprozesse zu „(Lehrbuch Christian-Dietrich Schönwiese Klimatologie 4. Auflage Seite 362)“

Diese Aussage trifft für alle Klimamodelle uneingeschränkt zu. Auch deshalb, weil in allen Modellen, der direkte wie indirekte Einfluss der Sonne (z.B. über die Modulation der kosmischen Höhenstrahlung und damit der Wolkenbildung, wie auch das Triggern der AMO wie der PDO (Pazifisch Dekadische Oszillation)) so gut wie völlig außen vorgelassen wird. Und das ist bei weitem noch nicht alles. Alle Modelle rechnen mit sehr, sehr vielen gekoppelten Differentialgleichungen. Da Computer das nicht können, werden sie zu Differenzengleichungen umgeformt. Doch auch diese Gleichungen sind so aufgebaut, dass das Ergebnis eher früher als später zu sehr exotischen Temperaturen auflaufen würden.

- Peterson et al 1997: An Overview of the Global Historical Climatology Network Temperature Database ↑

- Quelle: Uncertainty estimates in regional and global observed temperature changes: A new data set from 1850 P. Brohan, J. J. Kennedy, I. Harris, S. F. B. Tett, P. D. Jones ↑

- Aus eigener Arbeit Dissertation M. Limburg – nicht eingereicht bei UNI Leipzig vom März 2010. Näheres dazu hier https://eike-klima-energie.eu/2016/04/03/treibhaeuser-des-klima-alarmismus-mit-welchen-tricks-deutsche-universitaeten-abweichende-meinungen-niederhalten/ ↑

- In HR Statdtgespräche 2.2.2010 ↑

Wer sich den ganzen Bericht herunterladen möchte kann das hier tun Limburg Mein verhindertes Video 4

Das Video Teil 1 finden Sie hier

Das Video Teil 2 finden Sie hier

Das Video Teil 3 finden Sie hier

Das Video Teil 4 finden Sie hier

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Abbildung 11 ist nachweislich falsch. Warum wird Falsches unkommentiert gezeigt?

Die Satellitenauswertung von Roy Spencer zeigt eindeutig einen Temperaturanstieg von ca. 1 °C in den letzten 45 Jahren. Damit werden die Modelle bestätigt.

UAH_LT_1979_thru_September_2025_v6.1_20x9-scaled.png (2560×1152)

Herr Björn, ich tippe da auf ein Missverständnis. Die Modelle rechnen ja nicht mit Änderungen der Solaraktivität und Wolkenbedeckung. Die rechnen fälschlich mit 5facher Klimasensitivität des CO2.

Herr Dietze,

ich denke auch, hier liegt ein Missverständnis vor. Die Klimasensivität von Treibhausgaben ist das Ergebnis von Klimamodellen, nicht die Vorgabe.

Was sie sehen ist die Karlization!

Was sie nicht sehen ist, das die Modelle die Realitaet nicht nachbilden.

Bitte Nachweis fuehren was falsch sein soll!

„Karlization“

Was ist das für eine Krankheit? 😉

Aber Sie haben recht. In der Grafik Abbildung 11 kann nicht gesehen werden, dass die Modelle die Beobachtungen nicht nachbilden. Es ist auch nicht der Sinn von Modellen, etwas nachzubilden. Warum sollte man Aufwand betreiben, ein Ergebnis zu generieren, was wir bereits kennen?

Bitte dem Link folgen.

Bitte Sarc tag setzen!

Das Schlimme ist dass selbst wenn die Modelle den realen Temperaturanstieg nachbilden würden, sie immer noch den CO2-Effekt etwa um den Faktor 5 zu hoch annehmen, denn der hat ja nur etwa 20% des ∆T verursacht.

Herr Dietze,

wie kommen Sie darauf, dass die Klimasensitivität eines Treibhausgases als Vorgabe in eine Klimamodellierung eingeht, also angenommen wird? Dann wäre die ganze Modellierung völlig sinnlos.

Es ist doch gerade das Ziel vorab zu simulieren, welche Auswirkung die Erhöhung der CO2-Konzentration in der Atmosphäre auf das Klima hat. Vorgegeben werden z.B. Topografie, die physikalischen Eigenschaften der Bestandteile der Atmosphäre, die Veränderung dieser Bestandteile und dann wird ermittelt, welche Auswirkung sich ergibt.

Wenn eine Brücke modelliert wird, dann wird auch nicht vorgegeben, dass mit 100 Tonnen Stahl alle Lasten aufgenommen werden können, sondern es werden alle Einwirkungen auf das numerische Modell und die physikalischen Eigenschaften der Baustoffe vorgegeben, damit berechnet werden kann, wieviel Stahl benötigt wird.

Auch Ihre Begriffsverwendung wie CO2-Effekt oder 20% der Temperaturveränderung sind rätselhaft. Wenn in einer Simulation als einzige Veränderung die CO2-Konzentration der Atmosphäre verdoppelt wird und sich aus dieser Verdopplung eine Veränderung der Durchschnittstemperatur von X°C ergibt, dann ist die Klimasensitivität von CO2 X°C. Wenn Sie da anderer Meinung sind, dann haben Sie eine eigene Begriffsdefinition von Klimasensitivität. Dann ist eine Diskussion sinnlos.

Wie machen sie das denn, wenn die Klimasensitivitaet nicht als Eingangswert bekannt ist?

Sie fragen also, wie ein Ergebnis berechnet wird, wenn das Ergebnis nicht bekannt ist, Herr Schulz.

Da bin ich ratlos. Kann jemand helfen?

Wird es nicht. Die Abbildung 11 zeigt die mittlere Troposphäre (Mid), ihr Link die untere Troposphäre (LT). Und das ist ein bekanntes Defizit der Modelle, dass die beobachteten Temperaturen in der mittleren tropischen Troposphäre von den Modellen mit CO2 Forcing nicht reproduziert werden.

Herr Heß,

Sie meinen, in dem Diagramm Abbildung 11 werden die Temperaturverläufe in unterschiedlichen Bereichen der Atmosphäre vergleichend gezeigt? Dann ist das ja wohlwollend ausgedrückt völliger Unsinn, objektiv ausgedruckt Betrug.

Stand der Wissenschaft ist, dass Klimamodelle sehr gut mit den Beobachtungen übereinstimmen.

abb1.jpeg (1064×984)

abb2.jpeg (1089×1007)

Klimamodelle: wie werden diese validiert? | ScienceBlog

Welche Modelle sollen denn da abgebildet sein?

Ich weiß es nicht, Herr Schulz. Wenn Sie das wissen wollen, dann fragen Sie den Autor oder die Autorin des Artikels. Sie können ja dann hier berichten.

Sie haben diesen Artikel hier eingestellt, haben aber noch nicht mal die einfachen Fragen geklaert?

Ich halte ihre Quelle nicht sehr serioes, wenn solche elementaren Fragen nicht beantwortet sind.

Es ist Ihnen überlassen, was Sie für seriös und was Sie für elemtar halten, Herr Schulz.

Warum soll ich bei den Autoren des Artikels etwas erfragen, was mich nicht interessiert, Sie aber wissen wollen? Sie sind echt ein Scherzkeks.

Nein das haben Sie nicht verstanden. In Abbildung 11 wird die Temperatur der mittleren Troposphäre gezeigt. Ihr verlinktes Bild hingegen zeigt die Temperatur der unteren Troposphäre. Sie haben also das Bild 11 und ihr Bild nicht sorgfältig angeschaut oder verstanden und ihr Urteil gefällt.

Keine Ahnung was Sie für Stand der Wissenschaft definieren oder halten.

Aber wenn man im IPCC – Bericht nachschaut, dann sieht man, dass Klimamodelle die mittlere tropische Troposphäre wie im angehängten Bild und in Abbildung 11 gezeigt nicht reproduzieren, wenn sie frei, mit Ozean – Kopplung laufen.

Nur wenn die Meeresoberflächentemperaturen unnatürlich auf die experimentell beobachteten Werte festgelegt werden, passt es besser. Also wenn man die Rückkopplung mit dem Ozean unnatürlich weglässt. Diese Modelle kann man halt nicht für Prognosen verwenden.

Der Autor des Bildes 11 zeigt ja auch nur die öffentlich zugänglichen Daten. Dieses Problem der Klimamodelle ist ja jetzt auch lange genug bekannt.

„In Abbildung 11 wird die Temperatur der mittleren Troposphäre gezeigt. „

Die in Abbildung 11 gezeigten Temperaturverläufe aus Modellrechnungen zeigen Auswertungen von Modellrechnungen, die für die mittlere Tropsphäre gemacht wurden? Das bezweifel ich. Die in Abbildung 11 gezeigten Ergebnisse von Modellrechnungen zeigen genau das Bild, was auch in den Grafiken zu sehen ist, die ich verlinkt habe.

Die Modelle zeigen einen Temperaturanstieg von ca. 1°C in den letzten 45 Jahren. Die Satellitenauswertung nach Spencer zeigt einen Temperaturanstieg von ca. 1°C in den letzten 45 Jahren. Die Daten nach NOAA, NASA usw. zeigen einen Temperaturanstieg von ca. 1°C in den letzten 45 Jahren.

Also können wir doch beruhigt davon ausgehen, dass es in den letzten 45 Jahren um ca. 1°C wärmer geworden ist und Modelle und Beobachtungen übereinstimmen.

Weil es nicht in ihr Bild passt?

Lesen sie es selbst nach:

https://www.commerce.senate.gov/services/files/fcbf4cb6-3128-4fdc-b524-7f2ad4944c1d

Herr Heß,

ich lese doch keine 25 Seiten eines 10 Jahre alten PDFs, um irgendwas zu finden, was Sie dort glauben gefunden zu haben.

Alle gemessenen Zeitreihen der globalen Durchschnittstemperatur zeigen einen Anstieg um ca. 1 °C in den letzten 45 Jahren.

Modelle zeigen ebenfalls diesen Anstieg. Auf welcher Grundlage soll ich behaupten, dass das nicht stimmt?

Wir sehen die Erwärmung global und wir sehen die Erwärmung in unserem Land. Winter, wie vor 45 Jahren, gibt es bei uns nicht mehr. Wintersport in Mittelgebirgen ist nur noch durch den Einsatz von Kunstschnee wirtschaftlich. Winterreifen oder Allwetterreifen fahre ich nicht mehr, weil das bei Temperaturen ab ca. 5°C gegenüber Sommerreifen unsicherer ist. Die wenigen Tage (teilweise nur Stunden), wo mal Schnee auf den Straßen liegt, fahre ich kein Auto.

Herr Björn,

Nein die Mühe machen Sie sich nicht. Das zeigt ja dann, dass ihr Vorurteil:

unbegründet war, weil sie ihre Behauptungen nicht sorgfältig prüfen. Hätte 2 Sekunden gedauert. Ich hatte ja den Link geliefert.

Das sagt dann vor Allem etwas über die Qualität ihrer Behauptungen.

Mit der Qualität meiner Behauptungen bin ich absolut im Reinen, Herr Heß.

Es wird nachweislich wärmer.

Die Modelle geben diese Erwärmung in gleicher Größenordnung wieder.

Mehr kann ich, mehr können Sie nicht erwarten.

Das konnte man schon vorher sehen, ist halt ein Anzeichen von Dogma.

„Die Treibhaushypothese wird Stück für Stück mit Beweisen, Fakten und Logik widerlegt.“

Nein, es ist nicht unsere Aufgabe, für jede krude Hypothese Gegenbeweise zu suchen. Im Gegenteil. Wen einer meint, die Treibhaushypothese hätte einen realen Wert, dann sollte der den klaren physikalischen Wirkungsablauf zeigen. Da es den bis heute nicht gibt, brauchen wir uns mit diesem Thema nicht zu befassen.

Zu dem verhinderten Video-Gespräch mit Prof. Ganteför wird hier die Treibhaushypothese Stück für Stück mit Beweisen, Fakten und Logik widerlegt. Schön, dieses Sammelsurium zu lesen, bloß vermisse ich jegliche Behandlung der Klimamodellierung, welche doch auf der falschen Impulsresponse-Funktion IRF und dem Kumulierungsmodell von IPCC sowie auf den zentralen IPCC-Parametern CO2-Sensitivität ECS (Faktor 5) sowie der Halbwertszeit unseres emittierten CO2 (ungefähr Faktor 10 oder noch weit höher) beruht.

Das ist doch die essentielle Grundlage für die unnötige billionenteure fatale Dekarbonisierung (siehe z.B. den kürzlichen Dietze-Beitrag). Schließlich ist unter http://www.fachinfo.eu/dietze2022d.pdf dokumentiert dass eine CO2-Halbierug von Deutschland langfristig nur etwa 3/1000 Grad (!) bringt, was weder feststellbar noch erforderlich ist. Warum solche Fakten hier NICHT erwähnt werden, verstehe ich nicht.

Historische Städte- und Überschwemmungskatastrophen aus der Überforderung der natürlichen Lebensgrundlagen sind vielleicht ja überliefert, damalige Zivilisationszentren müssten

weiter zum Äquator hin gelegen haben.

Die Differentialgleichungen kann man analytisch und nummerisch lösen. Da liegt nicht das Problem. Das Problem liegt bei den Programmierern, die Annahmen in die Modelle stecken.

ZB wird eine hohe Klimasensitivität angenommen, da man die letzte Eiszeit sonst nicht erklären kann.

Herr Krüger, genau genommen ist es so dass nur etwa 20% des beobachteten ∆T seit vorindustriell vom CO2-Anstieg verursacht wurden. Der Rest ist Natur (solar und Wolkenbedeckung), und unterhalb von Wolken (IR-Schwarzstrahler) ist CO2 weitgehend wirkungslos, und auch die Wasserdampfüberlappung wird beim Strahlungsantrieb nicht beachtet.

IPCC behauptet grob falsch dass (insbesondere wegen Wasserdampf-Feedback mit Fake-Faktor 2,7) CO2 der wesentliche Treiber ist. Dies wird z.B. auch immer wieder von Herrn Ebel zitiert (+1 Grad pro 100 ppm wie beobachtet). In Wirklichkeit sind es nur etwa 0,6 Grad pro VERDOPPELUNG, und zwar sogar MIT Feedback, was im Gleichgewicht nur ein ∆T von +0,5 Grad für einen Anstieg von 280 auf max. 500 ppm ergibt.

Ich vermute dass in dem verhinderten Video-Gespräch mit Prof. Ganteför diese Fakten garnicht diskutiert worden wären.

Wenn der Autor die 2,5 Grad Prognose von Ganteför als „falsch“ abtut, wie wäre dann seine Prognose? Finde ich nicht im Text. Frage für einen Freund.

Wenn Ihr Freund richtig gelesen hätten, dann wüsste er, und Sie dann auch: Das Klima ist chaotisch und damit nicht ergodisch. Und damit sind sowohl Prognosen, die Ganteför hier fälschlich abgibt, wie auch Szenarien irgendwas sind. Nur nicht das, was sich im Klima abspielt. Mehr nicht.

Es sind also grundsätzlich keinerlei Prognosen oder Szenarien möglich?

Prognosen sind nicht möglich, aber statt zu versuchen den natürlichen Klimawandel irgendwie zu beeinflussen, sollten die xxx Milliarden für Anpassung an alle moglichen Szenarien benutzt werden.

Nennt sich Prevention.

Natürlich sind grundsätzlich Szenarien und auch Prognosen möglich.

Wenn, wie von Personen, die sich mit Modellieren beschäftigen, die Ergebnisse lediglich Szenarien darstellen, wird es interessant.

Szenarien sind etwas anderes, als Prognosen.

Prognosen wären Voraussagen, die sich auf Hypothesen bzw. Theorien stützen und sich aufgrund Deduktion derselben ableiten und überprüfen lassen.

Daran müssen sich wissenschaftliche Erkenntnisse messen lassen.

Eine Widerlegung, sei es durch Messungen und/oder Experimenten wäre der Tod einer (wissenschaftlichen) Theorie.

Beispiel: Die Theorien von Einstein haben u.a. prognostiziert, dass es auch Gravitationswellen geben müsste.

Das wurde vor wenigen Jahren nachgewiesen.

Insofern wurde auch diese Prognose der Einsteinschen Theorien durch Messungen bestätigt.

Die Aussagen der Einsteinschen Theorie sind daher bis auf Weiteres weiter gültig.

Bei Szenarien verhält es sich anders.

Szenarien der Klimawissenchaften, die ja auf Algorhythmen beruhen, müssen nicht vollständig auf überprüfbare und damit messbare physikalische Phänomene rückführbar sein. Es gibt eine Reihe von mathematischen, intrinsischen Korrekturfaktoren, die formuliert wurden, um unbekannte Einflussfaktoren auf die zeitliche Entwicklung des Klimas irgendwie zu berücksichtigen.

Ansonsten wären die Ergebnisse ja Prognosen und keine Szenarien.

Indirekt werden die Ergebnisse von Szenarien schon mit der wissenschaftlichen Wirklichkeit abgeglichen, nämlich in der Form, wie wahrscheinlich die Anfangsbedingungen der Rechenoperationen über einen angenommenen Zeitraum seien.

Die Wahrscheinlichkeit eines Szenarios fällt jedoch in der Berichterstattung der öffentlichen Medien zugunsten der Click Bait Vorgaben regelmäßig unter den Tisch.

Wenn eine Seite dann Jahr für Jahr eine Abkühlung prognostiziert, und in der Realität regelmäßig das Gegenteil eintritt, dann könnte man, ihrer Logik folgend, ja daraus schließen, dass sich deren Vorhersagen NICHT auf Hypothesen bzw. Theorien stützen und sich NICHT aufgrund Deduktion derselben ableiten und überprüfen lassen. Korrekt?

Szenarien zur Klimaentwicklung sind möglich, ausgehend von den bekannten Klimaschwankungen der Vergangenheit. Prognosen wann, was, und wodurch eintritt sind hingegen nichts als fauler Zauber. Bestimmt wenn die „Prognosen“ den Menschen als auslösenden und alles entscheidenden Faktor hinstellen. Unsere Politiker sollten sich besser mit der Finanzierung der Sozialsysteme anno 2026 beschäftigen als mit der „Durchschnittstemperatur der Erde im Jahre 2100“. Aber die wissen schon warum sie lieber „das Klima retten“ statt so profane Dinge wie die soziale Sicherheit….

Herr Kraus, wir zeigen Ihnen doch in jedem Artikel vielfältigst, dass die Erwärmung bei uns erst 1988 und zwar tagsüber begann. Der Hauptgrund sind die Zunahme der Sonnenstunden und der Strahlungsintensität. Sobald die Sonnenstunden wieder abnehmen werden, werden auch die Temperaturen wieder zurückgehen.

Sollten die SSH auf diesem Niveau bleiben, – was wir hoffen- dann wird die Erwärmung seit 1988 bei uns zu einem Ende gekommen sein.

Bessere Prognosen kann man nicht abgeben und Szenarienvorhersagen kann man vergessen. Mit solchen Märchen schafft nur die Treibhauskirche. Sie hatten für einen Freund gefragt, bitte geben Sie diesem die Antwort weiter.