Und schon wieder schreiben wir über die richtige Verwendung von Statistiken in der Klimawissenschaft. Traditionell werden die schwerwiegendsten Fehler bei der statistischen Analyse in den Sozialwissenschaften begangen, dicht gefolgt von medizinischen Arbeiten. Die Klimawissenschaft heftet sich an ihre Fersen.

In diesem Fall handelt es sich um einen Streit zwischen Nicola Scafetta, Professor für Atmosphärenphysik an der Universität Neapel, und Gavin Schmidt, Blogger bei RealClimate.org, Klimamodellierer und Direktor des Goddard Institute for Space Studies (GISS) der NASA.

Scafettas Originalarbeit aus dem Jahr 2022, veröffentlicht in den Geophysical Research Letters, ist der Ursprung des Streits (das Herunterladen der pdf-Datei ist kostenlos). Die Kernaussage der Studie lautet, dass CMIP6-Klimamodelle (GCMs), die eine ECS (Equilibrium Climate Sensitivity) von mehr als 3°C/2xCO₂ („°C/2xCO₂“ bedeutet °C pro CO₂-Verdoppelung) erzeugen, statistisch signifikant von den Beobachtungen seit 1980 abweichen (sie laufen zu heiß). Dieses Ergebnis ist nicht überraschend und steht im Einklang mit den jüngsten Ergebnissen von McKitrick und Christy (2020). Die Tatsache, dass die AR6/CMIP6-Klimamodelle zu heiß laufen und dass dies eine Funktion einer zu hohen ECS zu sein scheint, wird im AR6 eingeräumt:

„Der AR5 bewertete mit geringem Vertrauen, dass die meisten, wenn auch nicht alle CMIP3- und CMIP5-Modelle den beobachteten Erwärmungstrend in der tropischen Troposphäre während des Satellitenzeitraums 1979-2012 überschätzten, und dass ein Drittel bis die Hälfte dieser Differenz auf eine Überschätzung des SST-Trends (Meerestemperatur) während dieses Zeitraums zurückzuführen war. Seit dem AR5 zeigen zusätzliche Studien auf der Grundlage von CMIP5- und CMIP6-Modellen, dass diese Erwärmungsverzerrung bei den troposphärischen Temperaturen bestehen bleibt.“ – (AR6, S. 443)

Und:

„Mehrere Studien, die CMIP6-Modelle verwenden, deuten darauf hin, dass Unterschiede in der Klimasensitivität ein wichtiger Faktor sein könnten, der zu der Diskrepanz zwischen den simulierten und beobachteten troposphärischen Temperaturtrends beiträgt (McKitrick und Christy, 2020; Po-Chedley et al., 2021)“ – (AR6, S. 443)

Die AR6-Autoren versuchten, das Eingeständnis durch geschickte Formulierungen abzuschwächen, aber McKitrick und Christy zeigten, dass die AR5/CMIP5-Modelle in der tropischen Troposphäre zu warm sind und die Beobachtungen auf statistisch signifikantem Niveau nicht übereinstimmen. Doch ungeachtet der Beweise, dass AR5 bereits zu warm war, ist AR6 noch wärmer, wie im AR6 auf Seite 321 zugegeben wird:

„Die Schätzung des AR5 für die historische Erwärmung zwischen 1850-1900 und 1986-2005 beträgt 0,61 [0,55 bis 0,67] °C. Das Äquivalent im AR6 beträgt 0,69 [0,54 bis 0,79] °C, und die Differenz von 0,08 [-0,01 bis 0,12] °C ist eine Schätzung des Beitrags von Veränderungen im Beobachtungswissen allein (kapitelübergreifender Kasten 2.3, Tabelle 1).“ – (AR6, S. 321).

Wir sehen also, dass die AR6-Einschätzung, wonach die AR6- und AR5-Klimasensitivität für CO₂ zu hoch sein könnte und dass AR6 schlechter ist als AR5, die Arbeit unterstützt, die Scafetta, McKitrick und Christy in den letzten Jahren geleistet haben.

Betrachten wir nun den Streit zwischen Scafetta und Schmidt darüber, wie der statistische Fehler der mittleren Erwärmung von 1980-1990 bis 2011-2021 zu berechnen ist. Schmidts (2022) Einwände gegen Scafettas Fehleranalyse sind hier in seinem Blog veröffentlicht. Scafettas ursprünglicher Artikel in Geophysical Research Letters wurde später durch einen ausführlicheren Artikel in Climate Dynamics (Scafetta N., 2022b) ergänzt, in dem das Problem im ersten und zweiten Anhang ausführlich erörtert wird.

Scafettas (2022a) Analyse der Klimamodelle ECS

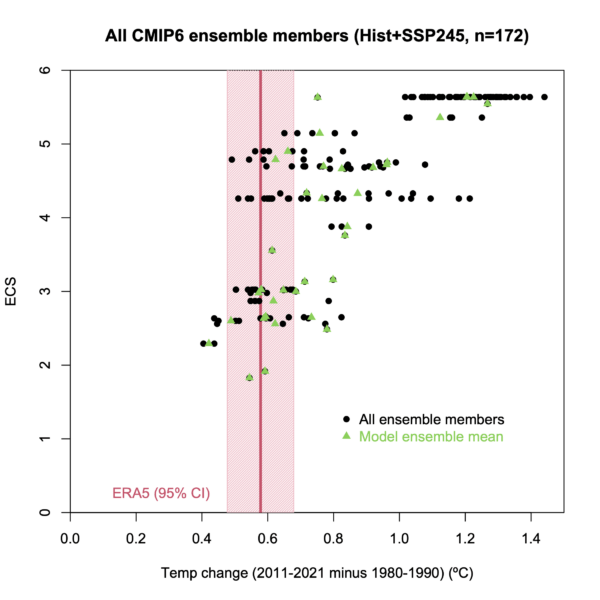

Der Kern von Scafettas Argumentation ist in Abbildung 1 dargestellt:

Abbildung 1. Die Ergebnisse der Klimamodelle sind in rot und die Beobachtungen der ECMWF ERA5 Wetter-Reanalyse in blau dargestellt. Die beiden oberen Diagramme zeigen Modellläufe, die zu ECS-Berechnungen von mehr als 3°C/2xCO₂ führen, und das untere Diagramm jene mit ECS von weniger als 3°C/2xCO₂. Diagramm aus (Scafetta N., 2022a)

In Abbildung 1 sehen wir, dass die Modelle heiß laufen, wenn ECS größer als 3°C/2xCO2 ist. Die Diagramme auf der rechten Seite zeigen einen Vergleich der mittleren Differenz zwischen den Beobachtungen und den Modellen in den 11-Jahres-Zeiträumen 1980-1990 und 2011-2021. Scafettas vollständige Analyse aus dem Jahr 2022a ist in Tabelle 1 enthalten, in der 107 durchschnittliche CMIP6-GCM-Simulationen für die von Climate Explorer bereitgestellten IPCC-Treibhausemissionsszenarien Historisch + SSP2-4.5, SSP3-7.0 und SSP5-8.5 analysiert werden. Die ERA5-T2m [1] mittlere globale Oberflächenerwärmung von 1980-1990 bis 2011-2021 wurde anhand des weltweiten ERA5-Gitters auf 0,578°C geschätzt. Die mittlere Erwärmung der IPCC/CMIP6-Klimamodelle ist bei allen dargestellten Modellen deutlich höher, wenn der ECS größer als 3°C/2xCO₂ ist.

Schmidts Analyse

Die rechts in Abbildung 1 dargestellten Diagramme sind der Kern der Debatte zwischen Scafetta und Schmidt. Die von Schmidt aufgezeichneten Daten (in unserer Abbildung 2) unterscheiden sich geringfügig, zeigen aber das Gleiche.

Abbildung 2. Schmidts Diagramm des IPCC/CMIP6 modellierten ECS im Vergleich zu den Beobachtungen der ERA5-Reanalyse. Die grünen Punkte sind die Mittelwerte des Modell-Ensembles, die in Scafettas Darstellung (Abbildung 1) verwendet wurden, und die schwarzen Punkte sind einzelne Modellläufe. Das rosa Band ist Schmidts Berechnung der Unsicherheit der ERA5-Beobachtungen.

In Abbildung 2 sehen wir, dass die einzigen ECS-Ensemblemittelwert-Schätzungen (grüne Punkte), die mit der mittleren Differenz der ERA5-Wetter-Reanalyse zwischen 1980-1990 und 2011-2021 übereinstimmen oder um diese herum liegen, ECS-Schätzungen von 3°C/2xCO₂ oder weniger sind. Alle Ensemble-ECS-Schätzungen über 3°C/2xCO₂ sind zu hoch. Bei den Basisdaten stimmt Schmidt also mit Scafetta überein, was hilfreich ist.

Der Disput

Der Kern des Streits ist die Frage, wie die 95%ige Unsicherheit (die Fehlerschätzung) des ERA5-Mittelwerts der Wetter-Reanalyse 2011-2021 im Vergleich zum Zeitraum 1980-1990 berechnet werden kann. Diese Fehlerschätzung wird verwendet, um zu entscheiden, ob ein bestimmtes Modellergebnis innerhalb der Fehlermarge der Beobachtungen (ERA5) liegt oder nicht. Scafetta berechnet einen sehr kleinen ERA5-Fehlerbereich von 0,01 °C (Scafetta N. , 2022b, Anhang) aus ähnlichen Produkten (z. B. HadCRUT5), da das ECMWF (Europäisches Zentrum für mittelfristiges Wetter) mit seinem Wetter-Reanalyseprodukt (ERA5) keine Unsicherheitsabschätzung bereitstellt, so dass er geschätzt werden muss. Schmidt berechnet eine sehr große ERA5-Fehlerspanne von 0,1°C unter Verwendung der ERA5-Standardabweichung für den Zeitraum. Sie ist in Abbildung 2 als rosa Band dargestellt. Dies ist der kritische Wert, um zu entscheiden, welche Unterschiede zwischen den Klimamodell-Ergebnissen und den Beobachtungen statistisch signifikant sind.

Wenn wir davon ausgehen, dass Scafettas Schätzung korrekt ist, zeigen die Abbildungen 1 und 2, dass alle Klimamodell-Simulationen (die grünen Punkte in Abbildung 2) für die 21 Klimamodelle mit ECS >3°C und die große Mehrheit ihrer Simulationsmitglieder (die schwarzen Punkte) offensichtlich auf statistisch signifikantem Niveau zu warm sind. Unter der Annahme, dass Schmidts Schätzung korrekt ist, deutet Abbildung 2 darauf hin, dass drei Klimamodelle mit ECS>3°C teilweise innerhalb der ERA5-Fehlerspanne liegen, während die anderen 18 Klimamodelle zu warm sind.

Obwohl Schmidts Ergebnis die Schlussfolgerung von Scafetta (2022a, 2022b), dass nur die Klimamodelle mit ECS<3,01°C die Erwärmung von 1980-1990 bis 2011-2021 am besten nachzuprojizieren scheinen, nicht wesentlich zu ändern scheint, ist es wichtig, die Fehlerfrage zu diskutieren. Ich beziehe mich dabei auf die stochastischen Standardverfahren zur Bewertung des Fehlers des Mittelwerts, die in dem klassischen Lehrbuch zur Fehleranalyse von Taylor (1997) diskutiert werden.

Im Folgenden wiederhole ich die von Schmidt vorgenommenen Berechnungen und kommentiere sie unter Verwendung des HadCRUT5.0.1.0-Jahresmittelwertes der globalen Temperatur anstelle des ERA5-T2m, weil er leichter zu bekommen ist, weil er dem ERA5-T2m nahezu gleichwertig ist und vor allem, weil er auch die relativen stochastischen Unsicherheiten für jedes Jahr angibt, was, wie bereits erläutert, eine entscheidende Komponente für die Bewertung der statistischen Signifikanz von Unterschieden zwischen der Realität und den Klimamodellen ist.

Schmidts Schätzung des Fehlers des Mittelwerts (der rosafarbene Balken in Abbildung 2) liegt bei ± 0,1°C (95%ige Sicherheit). Diesen Wert erhielt er, indem er davon ausging, dass die zwischenjährlichen Schwankungen im ERA5-T2m von 2011 bis 2021 gegenüber dem dekadischen Mittelwert zufälliges Rauschen sind. In der Praxis berechnete er die durchschnittliche Erwärmung (0,58 °C) von 2011 bis 2021 anhand der ERA5-T2m-Temperaturanomalien im Verhältnis zum Mittelwert von 1980-1990. Das heißt, er hat die Werte auf den Mittelwert von 1980-1990 „gestützt“. Dann schätzte er den Fehler des Mittelwerts, indem er die Standardabweichung der Basiswerte von 2011 bis 2021 berechnete, diese Standardabweichung durch die Wurzel aus 11 teilte (weil es N=11 Jahre gibt) und schließlich das Ergebnis mit 1,96 multiplizierte, um die 95%ige Sicherheit zu erhalten. Hier kann man eine Tabellenkalkulation herunterladen, die Schmidts und Scafettas Berechnungen durchführt.

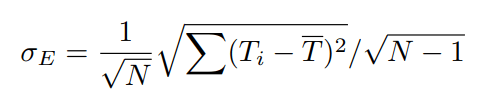

Abbildung 3 zeigt die Gleichung von Schmidt für den Fehler des Mittelwerts. Wenn dieser Wert mit 1,96 multipliziert wird, um die 95%ige Sicherheit zu erhalten, ergibt sich ein Fehler von ± 0,1°C:

Abbildung 3. Die von Schmidt verwendete Gleichung zur Berechnung des Fehlers des Mittelwerts für die ERA5-Daten.

Die von Schmidt verwendeten Gleichungen sind diejenigen, die in Taylor (1997, Seiten 100-102) aufgeführt sind. Das Hauptproblem bei Schmidts Ansatz ist, dass Taylor deutlich erklärt, dass die Gleichung in Abbildung 3 für den Fehler des Mittelwerts nur dann funktioniert, wenn die N jährlichen Temperaturwerte (Ti) zufällige „Messungen der gleichen Größe x“ sind. Beispielsweise verwendet Taylor (Seite 102-103) die obige Gleichung zur Schätzung des Fehlers des Mittelwerts für die elastische Konstante k „einer“ Quelle unter Verwendung wiederholter Messungen mit dem gleichen Instrument. Da die wahre Elastizitätskonstante nur ein Wert ist, kann die Variabilität der wiederholten Messungen als zufälliges Rauschen um einen Mittelwert interpretiert werden, dessen Standardabweichung die Standard Deviation of the Mean (SDOM) ist.

Bei der Verwendung der SDOM gehen Schmidt et al. implizit davon aus, dass jeder Jahresmittelwert der Temperatur eine Messung eines einzigen wahren dekadischen Wertes ist und dass der statistische Fehler für jeden Wert durch seine Abweichung von diesem dekadischen Mittelwert gegeben ist. Sie gehen also davon aus, dass die „wahre“ globale Oberflächentemperatur zwischen 1980 und 1990 oder 2011-2021 nicht schwankt und alle Abweichungen vom Mittelwert (oder wahren Wert) zufällige Schwankungen sind.

Die interannuelle Variabilität der globalen Temperaturen in diesen zwei Jahrzehnten ist jedoch kein zufälliges Rauschen um einen dekadischen Mittelwert. Die N Jahresmitteltemperaturmessungen von 2011 bis 2021 sind keine unabhängigen „Messungen der gleichen Größe x“, sondern jedes Jahr herrscht ein anderer physikalischer Zustand des Klimasystems. Dies ist in der Darstellung der beiden Jahrzehnte in dieser Tabelle leicht zu erkennen. Die x-Achse ist mit 2010-2022 beschriftet, aber für die orangefarbene Linie ist es eigentlich 1979-1991. Nach Taylor (1997) ist SDOM also nicht die richtige Gleichung für diesen speziellen Fall.

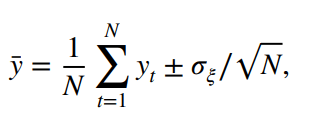

Wie Scafetta (2022b) erklärt, ist die Aufzeichnung der globalen Temperatur hochgradig autokorreliert, da sie die dynamische zwischenjährliche Entwicklung des Klimasystems enthält, die durch ENSO-Oszillationen und andere natürliche Phänomene hervorgerufen wird. Diese Oszillationen und Trends sind ein physikalisches Signal und kein Rauschen. Scafetta (2022b) erklärt, dass bei einer generischen Zeitreihe (yt), die von Gauß- (zufällig) verteilten Unsicherheiten ξ mit Standardabweichung σξ betroffen ist, der Mittelwert und der Fehler des Mittelwerts durch die Gleichung in Abbildung 4 gegeben sind:

Abbildung 4. Die richtige Gleichung zur Berechnung der Unsicherheit im Mittelwert der globalen Temperatur über einen Zeitraum, in dem sich der Mittelwert ändert.

Die Gleichung in Abbildung 4 ergibt einen Fehler von 0,01°C (bei einem Konfidenzniveau von 95 %; Einzelheiten zur Berechnung findet man in der Tabelle hier). Wenn die Standardabweichung der Fehler nicht streng konstant für jedes Datum ist, ist der in der obigen Gleichung zu verwendende Standardfehler die Quadratwurzel aus dem Mittelwert der quadrierten Unsicherheiten für jedes Datum.

Scafettas Gleichung leitet sich direkt von der allgemeinen Formel für die Fehlerfortpflanzung ab, die von (Taylor, 1997, S. 60 und 75) diskutiert wird. Taylor erklärt, dass die Gleichungen auf den Seiten 60 und 75 für die Schätzung des Fehlers einer Funktion „mehrerer“ unabhängiger Variablen übernommen werden müssen, von denen jede mit einem individuellen stochastischen Fehler behaftet ist, der verschiedenen physikalischen Zuständen entspricht, wie z. B. dem Durchschnitt einer globalen Temperaturaufzeichnung von N „verschiedenen“ Jahren. Die Unsicherheit der Funktion (z. B. der Mittelwert von N verschiedenen Größen) hängt nur von dem statistischen Fehler jeder Größe ab, nicht aber von der Variabilität der verschiedenen Größen gegenüber ihrem Mittelwert.

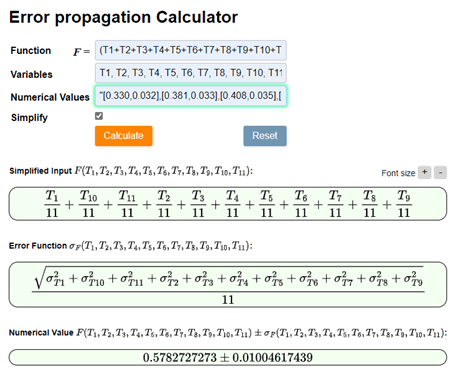

Wir können ein im Internet verfügbares Tool zur Berechnung der Fehlerfortpflanzung verwenden, um unsere Berechnungen zu überprüfen. Ich habe die Jahresmittelwerte der HadCRUT5-Temperaturdaten mit ihren relativen Unsicherheiten hochgeladen und den Rechner den Mittelwert mit seinem relativen Fehler bewerten lassen. Das Ergebnis ist in Abbildung 5 dargestellt.

Abbildung 5. Die richtige Gleichung zur Berechnung der Unsicherheit des Mittelwerts der globalen Temperatur über einen Zeitraum von N=11 verschiedenen Jahren, die durch unterschiedliche jährliche Temperaturmittelwerte gekennzeichnet sind.

Schmidts Berechnung der Standardabweichung des Mittelwerts (SDOM) basiert auf der irrigen Annahme, dass er mehrere Messungen derselben Größe mit dem gleichen Verfahren durchführt und dass daher die zwischenjährliche Abweichung vom dekadischen Mittelwert eine Art zufälliges Rauschen ist, das als stochastische Unsicherheit betrachtet werden kann. Keine dieser Bedingungen ist in diesem Fall erfüllt. Die globale jährliche durchschnittliche Temperaturanomalie ändert sich aus natürlichen Gründen ständig, obwohl ihre jährlichen Schätzungen auch durch einen kleinen stochastischen Fehler wie den in Scafettas Berechnung enthaltenen beeinflusst werden. Laut Taylor sind es nur die Messfehler der jährlichen Temperaturmittelwerte, die den Fehler des 11-Jahres-Mittelwerts von 2011 bis 2021 bestimmen können.

Wie Scafetta im Anhang zu Scafetta 2022b schreibt, enthält der globale Temperaturdatensatz von HadCRUT5 seine 95%-Konfidenzintervall-Schätzung, und von 2011 bis 2021 betragen die Unsicherheiten für die monatlichen und jährlichen Mittelwerte monatlich ≈ 0,05°C und jährlich ≈ 0,03°C. Die geschätzte Unsicherheit der Berkeley Earth Land/Ozean-Temperaturaufzeichnungen beträgt 0,042°C (monatlich), 0,028°C (jährlich) und 0,022°C (dekadisch). Je länger der Zeitraum ist, desto geringer ist der Fehler des Mittelwerts.

Jeder der oben genannten Werte, Jahr für Jahr, muss gemittelt und durch die Quadratwurzel der Anzahl der Jahre (in diesem Fall 11) geteilt werden, um den Fehler des Mittelwerts zu bestimmen. In unserem Fall beträgt der HadCRUT5-Fehler des Mittelwerts für 2011-2021 0,01°C. Bei dem Verfahren von Scafetta kann der „wahre“ Wert in jedem Jahr variieren, bei dem von Schmidt ist dies nicht der Fall.

Die für die ERA5-Wetter-Reanalyse verwendeten Beobachtungen sind nahezu identisch mit denen, die im HadCRUT5-Datensatz verwendet werden (Lenssen et al., 2019; Morice et al., 2021; Rohde et al., 2020). Wie Morice et al. anmerken, verwendet das MET Office Hadley Centre ERA5 zur Qualitätskontrolle.

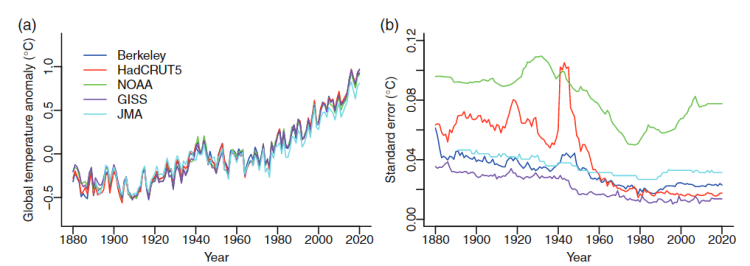

Lenssen et al., an denen Gavin Schmidt als Koautor beteiligt ist, nehmen eine umfassende Überprüfung der Unsicherheit verschiedener globaler Durchschnittstemperatur-Datensätze, einschließlich ERA5, vor. Craigmile und Guttorp stellen in Abbildung 6 den geschätzten jährlichen Standardfehler in mehreren globalen Temperaturdaten dar: GISTEMP, HadCRUT5, NOAA, GISS, JMA und Berkeley Earth:

Abbildung 6. Gesamt-Usicherheit für drei globale Temperaturanomalie-Datensätze. Diese Datensätze sollten eine ähnliche Unsicherheit aufweisen wie ERA5. Quelle: (Craigmile & Guttorp, 2022).

Abbildung 6 zeigt, dass der Standardfehler der Unsicherheiten von 1980 bis 2021 auf der Jahresskala und mit 95 % Konfidenz sehr viel geringer ist als der Schmidtsche Fehler des Mittelwerts von 0,10 °C, der zudem auf einer Zeitskala von 11 Jahren berechnet wird. Die in Abbildung 6 angegebenen Unsicherheiten sind nicht durch die interannuelle Temperaturvariabilität um ein dekadisches Mittel gegeben. Dieses Ergebnis zeigt deutlich, dass Schmidts Berechnung fehlerhaft ist, denn auf der 11-Jahres-Skala muss der Fehler des Mittelwerts deutlich kleiner sein (durch die Wurzel aus 11 = 3,3) als der jährliche Wert.

Scafetta (2022b) argumentiert, dass die Fehler für den Jahresmittelwert von ERA5-T2m in der gleichen Größenordnung liegen sollten wie die Fehler anderer Temperatur-Rekonstruktionen, etwa des eng verwandten HadCRUT5-Datensatzes. Daher muss der Fehler auf der dekadischen Skala vernachlässigbar sein, etwa ±0,01°C, und dieses Ergebnis wird auch durch die Online-Rechner-Tools zur Schätzung des Fehlers von gegebenen Funktionen unabhängiger Variablen bestätigt, wie in Abbildung 5 gezeigt.

Die Unterschiede zwischen Scafetta und Schmidt sind auf die unterschiedlichen Schätzungen des ERA5-Fehlers zurückzuführen. Ich halte die Schätzungen von Scafetta für wesentlich realistischer.

Patrick Frank helped me with this post, but any errors are mine alone.

Download the bibliography here.

- ERA-T2m is the European Centre for Medium-Range Weather (ECMWF) Reanalysis 2-meter air temperature variable. Link. ↑

Übersetzt von Christian Freuer für das EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Zitat «durchschnittliche Erwärmung (0,58 °C) von 2011 bis 2021» Durchschnittliche Erwärmung auf 1/100 ° C berechnet?! Eine solche Scheinpräzision ist gemäss den elementarsten Prinzipien der mathematischen Statistik cocolores.

Über die Mittelungen von Temperaturen zum Generieren einer „mittleren Global-Temperatur“ sollte man nachdenken, wenn man einmal die mittlere Telefonnummer von Berlin gebildet hat und dann sagt, was man damit anfangen kann.

Man kann ja erst einmal nur 2 Telefonnummern mitteln, also mathematisch summieren und dann durch 2 teilen. Schon die Summe von zwei Telefonnummern ergibt keinen Sinn, obwohl die mathematisch ermittelt werden kann. Man muss also eine sinnlose mathematische Summe durch 2 teilen, um dann was zu bekommen? Genau, eine mittlere Telefonnummer von Berlin, sofern Berlin nur über 2 Telefonanschlüsse verfügt. Was kann man damit machen? Aufschreiben! Man kann sie auch wählen, wenn sie – zum Teufel auch – nicht noch eine Nachkommastelle besitzt. Ob man jemanden damit erreichen kann, sozusagen einen mittleren Telefonbenutzer von Berlin???

Der geneigte Leser mache das jetzt mit 2 Temperaturwerten (30°C und 72°C). Was sagt uns die Summe (102°C)? Ist das etwas Sinnvolles? Und jetzt folgt die Division durch 2 von einem nicht sinnvollen Wert (51°C), der jetzt durch die Gnade eines Außerirdischen wieder etwas Sinnvolles ergib!? —- Viele Gedankenstriche!

Da die globale Mitteltemperatur mathematisch genauso definiert ist wie die globale mittlere Höhenlage der Erdoberfläche, frage ist Sie, ob Sie ebrnfalls keinen Sinn ist dem Wert der globalen mittleren Höhenlage der Erdoberfläche sehen? Jeder Geograph hält diesen Wert jedenfalls für sinnvoll.

Wofuer soll das sinnvoll sein?

Ernste Frage!

Über die Mittelungen von Temperaturen zum Generieren einer „mittleren Global-Temperatur“ sollte man nachdenken, wenn man einmal die mittlere Telefonnummer von Berlin gebildet hat und dann sagt, was man damit anfangen kann.

Die Kritik von Professor Puschner an einer „mittleren Global-Temperatur“ ist nach meiner Erkenntnis richtig.

Der Vergleich von Thomas Heinemann „Da die globale Mitteltemperatur mathematisch genauso definiert ist wie die globale mittlere Höhenlage der Erdoberfläche“ hinkt. Fest definierte Größen wie Längen und Höhen kann man zweifelsfrei mitteln. Bei „dynamischen“ Größen verbietet sich das.

Beim Transport von z.b. Feststoffen in bewegten Flüssigkeiten ist der arithmetische Mittelwert irreführend = falsch. Der arithmetische Mittelwert kann hier nur angewendet werden, wenn im gesamten Transportquerschnitt alle Festoffe gleich verteilt sind. Da an der Gerinnesohle oft höhere Feststoffkonzentrationen vorherrschen und ebenso über den Fließquerschnitt die Fließgeschwindigkeit variiert, kann nur ein „frachtgewogener Mittelwert“ eine Aussage über tatsächlich transportierte Feststofffrachten geben.

Vermutlich ist es mit der Mittellung von Temperaturen im hochdynamischen Klimasystem der Erde ähnlich. Es wird die Temperatur von bewegter Luft (atmosphärische Strömungen) und bewegtem Wasser (Meeresströmungen) gemessen. Die Fließgeschwindigkeiten, sprich der Transport von den Tropen zu den Polarregionen (vom Ort der Einstrahlung zum Ort der Ausstrahlung) ist höchst unterschiedlich. Auch haben die Luftmassen unterschiedliche Dichte, Energieinhalte und z.B. Anteile an Wasserdampf. Die Vermutung liegt deshalb nahe, dass allein der arithmetische Mittelwert keine gute Aussagekraft besitzt.

Betrachtet man die Klimaentwicklung in den verschiedenen Regionen der Erde so erkennt man, dass es keine allgemeingültige Klimaentwicklung gibt. Jede Region der Erde, jede Klimaregion hat ihre Klimageschichte. Die Wärmezentren der tropischen Ozeane zeigen seit 200 Jahren einen relativ stetigen Anstieg der Temperatur. Andere Gebiete zeigen regelrechte Klimasprünge, der Temperaturanstieg geschah dort innerhalb weniger Jahre. Und für die Region des Nordatlantik ist bekannt, dass dort das Klima von der Nordatlantischen Oszillation beherrscht wird. Wenn man allein diese drei realen Beispiele betrachtet, was soll man dann aus einem arithmetischen Mittelwert lernen? Vielleicht sind sogar manche Klimaregionen wichtiger für die globale Energiebilanz, so dass man diese höher „gewichten“ müsste. Die Zeitreihe der arithmetisch ermittelten mittleren globalen Temperatur gibt somit keine Aussage über das wahre Klimageschehen und seine Ursachen.

Steven Michelbach am 16. April 2023 um 21:12

Herr Michelbach,

Ihr Argument ist unzutreffend. Bei zeitlich veränderlichen Größen („dynamisch“) muss man natürlich die Kartierung der Größen an verschiedenen Orten zum gleichen Zeitpunkt machen, der resultierende Mittelwert gilt dann zu diesem Zeitpunkt. Das ist also nicht zu verbieten.

Ihr Beispiel ist richtig aber auch trivial, denn der eigentliche Punkt ist ja klar: Herr Puschner und Sie üben Kritik, da die Mittelung bzw. Summierung einer intensiven Größe wie die Temperatur bzw. Strömungsgeschwindigkeit keine extensive, d.h. massenbezogenen Größe liefert. Die Temperatur als intensive Größe ist nämlich nicht zu verwechseln mit der korrespondierenden thermischen Energie, die die Körper der entsprechenden Temperatur haben. Ebensowenig liefert die Strömungsgeschwindigkeit in Ihrem Beispiel nicht Ihre gesuchte Größe des Massenflusses eines suspendierten Feststoffes.

Sie bzw. Herr Puschner müssen dazu schon die korrekten Gleichungen hernehmen bzw. die richtigen gewünschten Größen den Klimamodellen bzw. Reanalysen entnehmen. Es ist offensichtlich, dass der Sinn der globalen Mitteltemperatur primär nicht ist, die Entwicklung der thermischen Energie des Klimasystems zu bemessen. Dazu muss man mit den spez. Wärmekapazitäten wichten, wie es in Klimamodellen implementiert ist. Die globale Mitteltemperatur zeigt nur an, was die Größe ausdrückt, nämlich dass es im Mittel wärmer wird. Da aber die bedeutenste Wärmekapazität das Meerwasser ist, skaliert die zeitliche Zunahme der thermischen Energie des Klimasystems sehr gut mit der globalen Erwärmung.

Zur gleichen Zeit? Auf einer Erde die rund ist?

Lokale Zeit etwa ohne den Sonnenstand zu beruecksichtigen?

Ihre Aussagen sind weiterhin unpraezise und vermitteln den Eindruck, das sie kein Grundkonzept haben.

Bitte, wenn sie zur Aufklaerung beitragen wollen, naeher erklaeren was sie meinen.

Zu ihrer obgien Aussage muss man ansonsten annehmen, das sie denken, die Erde waere eine Scheibe und es gibt keine Drehbewegung.

Korrekt. Gemeint ist gleiche Weltzeit UT. Die Meteorologen nennen das synoptisch.

Herr Heinemann,

sie wissen immer so viel. Darf ich weiterfuehrend fragen, ob die Hauptbeobachtungstermine 00, 06, 12 und 18 Uhr UTC

fuer die Stationen noch weiter aufgeloest werden also nach der Sonnenzeit (wahre Ortszeit) betrachtet werden? Das waere wahrlich Synoptisch!

Sicher. Bekanntlich läuft der Klimawandel regional auch unterschiedlich. Die globale Mitteltemperatur ist nunmal per Definition global und bemisst damit per Definition nicht die regionalen Abläufe.

Auf ihr Strömungsbecken übertragen: im Flussquerschnitt wird zwar in Summe Fracht stromab transportiert (global), aber dies steht nicht im Widerstpruch dazu, dass in einzelnen Strömungswirbeln auch mal Fracht in die andere Richtung stromauf transportiert wird (regional).

Da aber die bedeutendste Wärmekapazität das Meerwasser ist, skaliert die zeitliche Zunahme der thermischen Energie des Klimasystems sehr gut mit der globalen Erwärmung.

Sehr geehrter Herr Heinemann,

ihr letzter Satz trifft die Problematik auf den Punkt. Die Diskussion über flächen- oder frachtgewogene Mittelwerte hat genau diesen Zweck gehabt. Meiner Erkenntnis nach müssen wir beim Klimasystem der Erde ganz besonderes Augenmerk auf die Dynamik der tropischen Ozeane und der sich darüber befindlichen Atmosphäre legen. Die globale Betrachtung ist irreführend.

Nachweislich startete die Klimaerwärmung mit der Steigerung des Energieinhaltes der tropischen Ozeane vor 200 Jahren. Die Kernfrage ist doch: “Was hat diese Erwärmung, diesen Energieinput ausgelöst?“ Ist das vielleicht eine reine Erholungsphase aus der Kleinen Eiszeit? War während der Kleinen Eiszeit der Energieverlust der Erde wegen größeren Schnee- und Eisflächen erhöht? Möglicherweise durch Verminderung der solaren Einstrahlung wegen erhöhter Vulkanaktivität? War es eine verminderte Sonnenaktivität, welche nachfolgend den Energieeintrag minderte, wodurch globale Veränderungen der Meeresströmungen, also riesige Massenverschiebungen auftraten, welchen den Geoid Erde an seinen Nahtstellen zum Reißen brachten und verstärkten Vulkanismus auslösten? Weshalb der marginale CO2-Ausstoß zu der damaligen Zeit, eine Erwärmung der tropischen Ozeane ausgelöst haben soll, leuchtet mir bis heute nicht ein. Jeder, der schon einmal in tropischen Regionen war, hat explizit erfahren, dass die Erwärmung dieser Gebiete um die Mittagszeit stattfindet, dann wenn die Sonne senkrecht über einem steht. Die Betrachtung eines mittleren Energieeintrages über 24 Stunden mag dem Physiker und seinen Gleichungen helfen. Der Realität wird das noch lange nicht gerecht.

Ein Beispiel: Eine Pizza bei 200 Grad Celsius und 10 Minuten Backzeit schmeckt mir am liebsten. Ihre bei 50 Grad Celsius gebackene würde ich auch nach 40 Minuten „Backzeit“ nicht essen wollen. Eigentlich müsste man sogar in Kelvin denken. Dann hätte ihre Pizza 118 K. Von Backen ist da nicht mehr die Rede, und essen kann man sie auch nicht.

Für mich ist deshalb klar, dass für das Klimasystem der Erde die tropischen Regionen zwischen 9.00 Uhr und 15.00 Uhr den entscheidenden Energieimpuls erhalten. Dann reden wir von 1.000 W/m², die bis auf die Erdoberfläche gelangen können. Und genau hier und zu diesem Zeitpunkt werden Schwankungen der Sonnenaktivität für uns relevant. Das gilt auch für die darüber liegende Stratosphäre und ihre Ozonschicht. In einem Bild ausgedrückt: Die Sonne wirkt in den tropischen Regionen wie ein „punktueller“ Schweißbrenner, der aufgrund der Erdrotation in 24 Stunden einmal die Erde umläuft. Deshalb sind nicht die 24 Stunden maßgebend, sondern grob etwa die 6 Stunden zwischen 9.00 und 15.00 Uhr in den Tropen und Subtropen.

Sehr geehrter Herr Michelbach,

Wie schon erklärt, es ist wissenschaftlich ja klar, dass man global betrachten auch nur das Globale darf.

Wenn Sie glauben, dass Wissenschaftler unzulässig Globales auf Lokales übertragen, so nennen Sie Beispiele dafür.

Die Klimawissenschaften jedenfalls unterscheiden global von lokal.

Zu Ihrer Frage nach dem Energieinhalt des Ozeans über der Zeit: welche wissenschaftlichen Arbeiten dazu haben Sie bereits gelesen?

Physikalisch gesehen gibt es natürlich keine „Erholungsphase“, denn das Klima ist nur das Resultat der Physik und danach gibt es keine Abweichung in der kleinen Eiszeit von einem „normalen“ Klima, in welches es sich zurückerholt, wenn es durch „Anormalitäten“ wie Erdbahnänderungen oder Sonnenänderungen „gestört“ werden. Es gibt ja keinen physikalisch gegebenen „normalen“ Klimazustand. Und hoffentlich ist Ihnen klar, dass Physiker bzw. Klimamodelle generell nicht mit 24 Stundenmitteln rechnen. Modelle rechnen mit Zeitschrittweiten, die so sind, dass das Resultat nicht von der Wahl der Zeitschrittweite abhängt. Es ist sinnlos, mit Mittelwerten zu rechnen, wenn dies zu anderen Ergebnissen führt als wenn das Zeitverhalten berücksichtigt wird. Selbst beim Pizzabacken merkt man den Unterschied.

Darf man das einrahmen? Wie sieht eigentlich ein gestörter Klimazustand aus, wenn man den normalen nicht kennt?

Sie haben Nerven. Bitte bei der Klimafolgenforschung anbringen. Die freuen sich bei der Folgenabschätzung der unbestimmten Zustandsänderung…

Wie schon erklärt, es ist wissenschaftlich ja klar, dass man global betrachten auch nur das Globale darf.

Sehr geehrter Herr Heinemann,

in dieser Aussage steckt die Kernfrage der Klimadiskussion seit den 30er Jahren des vergangenen Jahrhunderts. Damals glaubte Callendar, dass er aus dem Anstieg der CO2-Konzentration eine mittlere globale Temperaturentwicklung ableiten könne. Physiker und Meteorologen waren fasziniert. Grundlagenforscher der Klimawissenschaft kritisierten dieses Ansinnen.

Physiker und Meteorologen glauben bis heute mittels einer globalen Sicht auf die Ursachen des Klimawandels schließen zu können. Grundlagenforscher analysieren stattdessen die hochkomplexen Teilprozesse des Klimasystems und die regionale Klimamuster, und versuchen daraus die Ursachen der Klimaerwärmung abzuleiten.

Physiker und Meteorologen bekamen schon nach dem II. Weltkrieg immer leistungsfähigere Computer. Sie entwickelten Gleichungen für die Klimaberechnung, obwohl damals die Grundlagenforschung warnte, dass man das Klimasystem noch nicht verstanden habe.

Die Grundlagen für ein besseres Verständnis des Klimasystems angefangen von der schwankenden Sonnenaktivität, der Dynamik der verschiedenen Schichten der Atmosphäre bis hin zu den Phänomenen ENSO, El Nino, NAO etc. war erst mit neuer Messtechnik im Weltraumeinsatz, also erst seit wenigen Jahrzehnten möglich.

Jedem Klimaforscher ist klar, dass der Hauptanteil der Energie, welche die gesamte Atmosphäre und Meeresströmungen antreibt aus den Tropen stammt. Hier ist die Sonne der sogenannte Player, CO2 ist irrelevant.

Es bleibt deshalb nach wie vor die Kernfrage, mit welcher „Energiequelle“ in Klimamodellen das virtuelle Klima angetrieben/berechnet wird. 2 Watt/m² mehr durch die Sonne, sollten zum gleichen Ergebnis führen wie vermutete 2 Watt/m² mehr durch CO2.

Den Tagesgang der Sonneneinstrahlung in Abhängigkeit von Ort und Zeit berechnet jedes heutige Klimamodell. Wieso haben Sie nun ein Problem damit oder war das nur eine Bemerkung?

Wenn Sie durch ihren Hinweis oben einen besonderen klimatischen Effekt erwarten, so sollte der in Klimamodellen also bereits zu sehen sein.

Sie sagen zu dieser Aussage

Der Beweis ist hier:

Sehen sie das Problem oder merken sie nicht wie sie sich selbst widersprechen?

Den Tagesgang der Sonneneinstrahlung in Abhängigkeit von Ort und Zeit berechnet jedes heutige Klimamodell. Wieso haben Sie nun ein Problem damit oder war das nur eine Bemerkung?

Dann bin ich ja beruhigt, wenn ihr Klimamodell das alles kann.

Dann kann es doch sicher auch die folgenden Fragen beantworten:

Wieso begann in den tropischen Ozeanen die Erwärmung schon vor 200 Jahren mit fast linearem Anstieg!

Wieso dauerte die Klimaerwärmung im westlichen Indischen Ozean nur etwa ein Jahr? Der Klimasprung geschah im Jahre 1998. Dies ist auch der Zeitpunkt der Zunahme von Hitzesommern in Europa durch eine Zunahme der Sonnenscheindauer.

Wieso fand die Erwärmung unserer Winter ebenso innerhalb weniger Jahre statt? Es war zwischen 1987 und 1989. Im norwegischen Gebirge betrug die mittlere Januartemperatur 1987 -18,8 °C und schon 1989 +0,2°C. Auch in Ostasien findet man diesen Klimasprung der Wintertemperaturen.

Wieso ist in einigen Regionen der Welt der Wärmehöhepunkt seit einigen Jahren überschritten, und eine Abkühlung hat eingesetzt?

Wieso ist die Schmelze des arktischen Meereises so gut wie gestoppt? Seit 2007 deutet der Trend des „Minimum Ice Extent“ für September laut dänischem Wetterdienst erst in 1900 Jahren (!) auf eine eisfreie Arktis hin, obwohl schon Anfang 2000 die Jahre um 2014 als eisfrei deklariert wurden.

Wieso begann die Erwärmung in Europa schon massiv im 19. Jahrhundert, obwohl die CO2-Konzentration erst nach dem zweiten Weltkrieg signifikant angestiegen ist. Schon um 1900 soll die Hälfte des Eisvolumens des Gletscherhöchststandes um 1850 wieder abgeschmolzen gewesen sein.

Wenn Ihr Klimamodell darauf gute Antworten geben kann, bin ich noch weiter beruhigt.

Steven Michelbach am 18. April 2023 um 23:16

Ich brauche kein eigenes Klimamodell. Aber Ihre Punkte sind valide klimawissenschaftlich Fragen, wenn diese Beobachtungen wissenschaftlich manifest sind.

Sie sollten dafür in der wissenschaftlichen Literatur suchen. Die Erklärung der Klimahistorie ist definitiv Gegenstand der Forschung. Aber es kann auch gut sein, dass einige der regionalen kurzfristigen Klimatrends noch keine wissenschaftliche Erklärung gefunden haben, denn kurzfristig und regionale Klimaänderungen können durch Umverteilung von Energie entstehen und das erfordert eine hohe Modellauflösung.

Ist es alarmistisch?

The Earth’s Temperature

New: Listen to the podcast!

Currently: 57.53°F/14.18°C

Deviation: 0.33°F/0.18°C

Stations processed last hour: 62876

Last station processed: Multan, Pakistan

Update time: 2023-04-15 07:28:05 UTC

More

Wie „Klimamodelle laufen“ ist vollkommen nebensächlich und vollkommen ohne Wert, so lange es keine auf der Physik fußende Bestimmung von ECS gibt. Und die gibt es nunmal nicht!

Das ist ungefähr so, wie wenn man streiten würde, ob eine Uhr richtig geht, aber keine Ahnung hat, ob das intern verwendete Zeitnormal das Richtige ist.

Wenn man diesen Uhrenvergleich heranzieht, muß für einen richtigen Gang sowohl das Zeitnormal (irgend eine Frequenz) stimmen als auch die Übersetzung, die die Zeiger antreibt.

Umgelegt auf Klimamodelle kennt man weder das Normal noch die richtige Übersetzung. Klimamodelle sind „virtual reality“ sonst nichts. Bereits die Tatsache, daß sie schon die Vergangenheit nicht reproduzieren können, müßte doch jedem ernsthaften Wissenschaftler massiv zu Denken geben. Wenn es das nicht tut, betreibt er reine Nudelsuppenwissenschaft …

Ihrer Behauptung fehlen Beweise. Und diese können Sie nicht haben, weil Ihre Behauptung in Realität nicht zutrifft.

A) Ihr „Normal“, also die Referenz an die Naturgesetze, wird durch Verwendung der bekannten physikalischen Gesetze und Naturkonstanten in Klimamodellen garaniert. Wenn Sie also ins Klimamodell noch ein Pendel in Hamburg einbauen, so beschreibt das Klimamodell auch die windgetrieben Pendelschwingung korrekt.

B) die Übersetzung wäre falsch, wenn man in A) die Naturgesetze falsch programmiert hätte oder Naturkonstanten falsch wären. Dafür gibt es keine Hinweise.

Wenn Ihre Behauptung richtig wäre, so würden andere komplexe Simulationen wie z.B. Strömungsmodelle für die Flugtechnik auch versagen. Die Physik dafür ist ja dieselbe.

„die Übersetzung wäre falsch, wenn man in A) die Naturgesetze falsch programmiert hätte oder Naturkonstanten falsch wären“

Die Übersetzung ist falsch, da kein Klimamodell die Vergangenheit und Gegenwart korrekt abbildet. Die Uhren gehen falsch. Ergo wurden Naturgesetze falsch programmiert. Beweisen Sie doch endlich, dass Sie via IR-Strahlung in der Lage sind, Energie gegen ein thermisches Gefälle zu transportieren. Sie hätten dann auch gleich die Wärmepumpe ohne Kompressor erfunden.

Solange keine Eindeutigen reproduzierbare echte Daten gemessen wurden ,schütze ich keine falsche Klimastatistik .