Dr. Roy Spencer, Ph. D.

Ich habe bereits eine Reihe von Artikeln veröffentlicht (z. B. hier und hier), in denen ich mich mit den Beweisen dafür auseinandersetze, dass die Temperaturtrends aus bestehenden homogenisierten Datensätzen ein gewisses Maß an falscher Erwärmung aufgrund von städtischen Wärmeinseleffekten (UHI) aufweisen. Obwohl weithin angenommen wird, dass Homogenisierungsverfahren UHI-Effekte auf Trends beseitigen, ist dies unwahrscheinlich, da UHI-Effekte auf Trends weitgehend ununterscheidbar von der globalen Erwärmung sind. Die derzeitigen Homogenisierungsverfahren können zwar abrupte Änderungen in den Stationsdaten entfernen, aber sie können keine Quellen für eine langsam ansteigende Scheinerwärmung korrigieren.

Anthony Watts hat sich diesem Problem für die Temperaturüberwachungsstationen in den USA genähert, indem er die Standorte physisch aufsuchte und die Exposition der Thermometer gegenüber störenden Wärmequellen (aktiv und passiv) dokumentierte und Trends von gut platzierten Instrumenten mit Trends von schlecht platzierten Instrumenten verglich. Er fand heraus, dass Stationen mit guten Standortmerkmalen im Durchschnitt niedrigere Temperaturtrends aufwiesen als die schlecht platzierten Standorte und die offiziellen „bereinigten“ Temperaturdaten der NOAA.

Ich habe einen anderen Ansatz gewählt, indem ich globale Datensätze zur Bevölkerungsdichte und, in jüngerer Zeit, die Analyse hochauflösender satellitengestützter Landsat-Messungen globaler menschlicher Siedlungen „bebauter“ Gebiete verwendet habe. Ich habe auch begonnen, Daten von Wetterstationen (meist von Flughäfen) zu analysieren, die eine stündliche Zeitauflösung haben, anstatt der üblichen täglichen Höchst- und Tiefsttemperaturmessungen (Tmax, Tmin), aus denen die aktuellen globalen Landtemperaturdatensätze bestehen. Die Stationen mit stündlichen Daten sind leider weniger zahlreich, haben aber den Vorteil, dass sie besser gewartet werden können, da sie die Flugsicherheit unterstützen und es ermöglichen zu untersuchen, wie die UHI-Effekte über den Tag und die Nacht variieren.

In dieser zweiteiligen Serie werde ich den neuesten offiziellen globalen GHCN-Thermometer-Datensatz (Tmax, Tmin) (Version 4) untersuchen, um zu sehen, ob es Anzeichen für eine falsche Erwärmung aufgrund zunehmender Urbanisierungseffekte im Laufe der Zeit gibt. In der neuesten Version des GHCN-Datensatzes werden Tmax und Tmin nicht mehr separat angegeben, sondern es ist nur ihr Durchschnitt (Tavg) verfügbar.

Nach dem, was ich bisher gesehen habe, bin ich davon überzeugt, dass es in den GHCN-basierten Temperaturdaten noch eine falsche Erwärmung gibt. Die Frage ist nur, wie viel? Diese Frage wird in Teil II behandelt werden.

Das Thema ist (natürlich) wichtig, denn wenn die beobachteten Erwärmungstrends überbewertet wurden, dann sind auch alle Rückschlüsse auf die Empfindlichkeit des Klimasystems gegenüber anthropogenen Treibhausgas-Emissionen überbewertet. (Ich werde hier nicht auf die Möglichkeit eingehen, dass ein Teil der jüngsten Erwärmung auf natürliche Effekte zurückzuführen ist, das ist eine ganz andere Diskussion für einen anderen Tag).

Was ich zeigen werde, basiert auf den globalen Stationen im monatlichen GHCN-Datensatz (heruntergeladen im Januar 2023), die über genügend Daten verfügten, um mindestens 45 Jahre Juli-Daten während des 50-Jahres-Zeitraums (1973-2022) zu produzieren. Das Startjahr 1973 wurde aus zwei Gründen gewählt: (1) der separate Datensatz mit stündlicher Zeitauflösung, den ich analysiere, hatte zu diesem Zeitpunkt einen großen Zuwachs an digitalisierten Aufzeichnungen (denken Sie daran, dass Wetteraufzeichnungen früher ein manueller Prozess auf Papierformularen waren, die jemand digitalisieren musste), und (2) die globalen Landsat-basierten Urbanisierungsdaten beginnen 1975, was nahe genug an 1973 liegt.

Da die Landsat-Messungen der Verstädterung eine sehr hohe Auflösung haben, muss man entscheiden, welche räumliche Auflösung verwendet werden soll, um einen Bezug zu möglichen UHI-Effekten herzustellen. Ich habe (etwas willkürlich) Mittelungs-Gittergrößen von 3×3 km, 9×9 km, 21×21 km und 45 x 45 km gewählt. Im globalen Datensatz erhalte ich die besten Ergebnisse mit der 21 x 21 km-Mittelung der Urbanisierungsdaten, und alle Ergebnisse hier werden für diese Auflösung gezeigt.

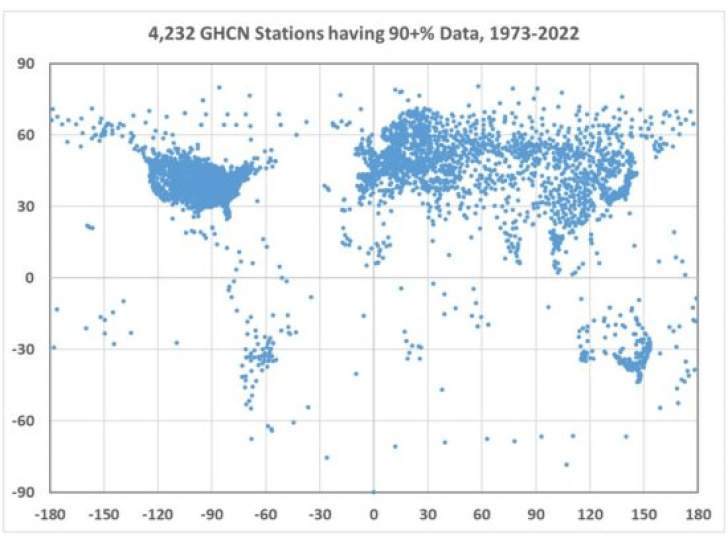

Die sich daraus ergebende Verteilung von 4.232 Stationen (Abb. 1) zeigt, dass nur wenige Länder eine gute Abdeckung aufweisen, insbesondere die Vereinigten Staaten, Russland, Japan und viele europäische Länder. Afrika ist nur schwach vertreten, ebenso wie der größte Teil Südamerikas:

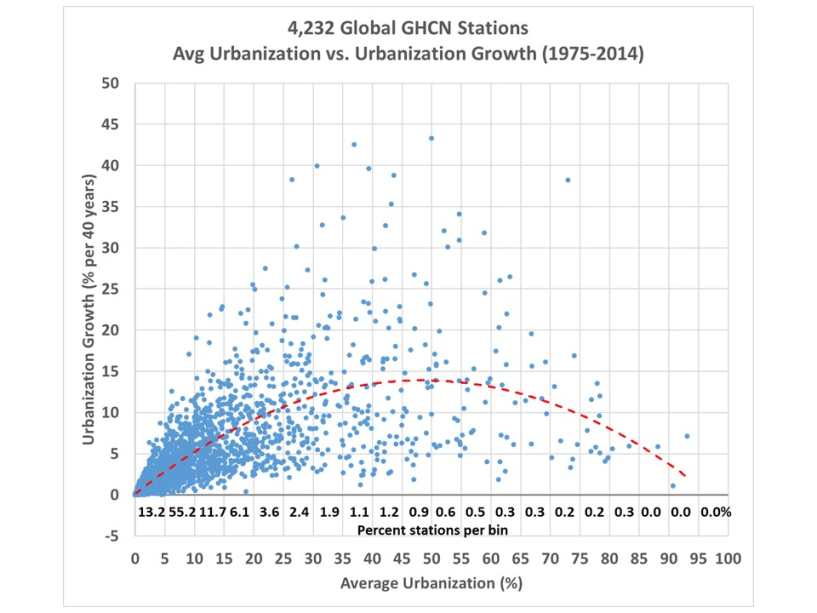

Ich habe die entsprechenden Landsat-gestützten Siedlungsdiagnosen für alle diese Stationen analysiert, die in Abb. 2 dargestellt sind. Dieser Datensatz deckt einen Zeitraum von 40 Jahren ab, von 1975 bis 2014. Hier habe ich den 40-Jahres-Durchschnitt der Urbanisierung gegen den 40-Jahres-Trend der Urbanisierung aufgetragen:

In Abb. 2 sind einige wichtige und interessante Dinge zu sehen:

1. Nur wenige GHCN-Stationsstandorte sind wirklich ländlich: 13,2 % sind zu weniger als 5 % verstädtert, während 68,4 % zu weniger als 10 % verstädtert sind.

2. An praktisch allen Stationsstandorten hat die Bebauung zugenommen, an keinem hat sie abgenommen (was eine Netto-Zerstörung von Gebäuden und die Rückführung des Landes in seinen natürlichen Zustand erfordern würde).

3. Das größte Wachstum ist in Gebieten zu verzeichnen, die nicht völlig ländlich und nicht bereits stark verstädtert sind (siehe die an die Daten angepasste Kurve). Das heißt, sehr ländliche Gebiete bleiben ländlich, und stark verstädterte Gebiete haben ohnehin wenig Raum für Wachstum.

[Alle Hervorhebungen im Original]

Man könnte meinen, dass die UHI-Effekte vernachlässigbar sein sollten, da die meisten Stationen weniger als 10 % der Bevölkerung aufweisen. Die bahnbrechende Studie von Oke (1973) hat jedoch gezeigt, dass die Erwärmung durch UHI nicht linear verläuft, wobei die schnellste Erwärmung bei den niedrigsten Bevölkerungsdichten auftritt und die Erwärmung bei hohen Bevölkerungsdichten schließlich gesättigt ist. Ich habe bereits früher auf der Grundlage aktualisierter Daten über die globale Bevölkerungsdichte gezeigt, dass die stärkste unerwünschte Erwärmung (beim Vergleich benachbarter Stationen mit unterschiedlichen Bevölkerungszahlen) bei den niedrigsten Bevölkerungsdichten auftritt. Es bleibt abzuwarten, ob dies auch für „bebaute“ Messungen menschlicher Siedlungen (Gebäude und nicht Bevölkerungsdichte) gilt.

Durchschnittliche Verstädterung oder Zunahme der Verstädterung?

Eine interessante Frage ist, ob der Trend der Verstädterung (wachsende Infrastruktur) oder nur die durchschnittliche Verstädterung den größten Einfluss auf die Temperaturentwicklung hat. Offensichtlich hat das Wachstum einen Einfluss. Aber was ist mit den Städten, in denen die Bebauung nicht zugenommen hat, aber der Energieverbrauch (der Abwärme erzeugt) gestiegen ist? Da die Menschen zunehmend aus ländlichen Gebieten in die Städte ziehen, kann die Bevölkerungsdichte viel schneller zunehmen als die Zahl der Gebäude, da die Menschen auf kleinerem Raum leben und Wohn- und Bürogebäude vertikal wachsen, ohne ihren Fußabdruck in der Landschaft zu vergrößern. Auch der Wohlstand, die Autonutzung, die wirtschaftliche Produktivität und der Verbrauch, Klimaanlagen usw. nehmen zu, was zu einer höheren Abwärmeproduktion führen kann, ohne dass die Bevölkerung oder die Urbanisierung zunimmt.

In Teil II werde ich untersuchen, wie die Temperaturtrends der GHCN-Stationen mit der Verstädterung der Stationen für eine Reihe von Ländern zusammenhängen, und zwar sowohl in den rohen (nicht bereinigten) Temperaturdaten als auch in den homogenisierten (bereinigten) Daten, und auch untersuchen, wie das Wachstum der Verstädterung mit der durchschnittlichen Verstädterung verglichen wird.

Übersetzt von Christian Freuer für das EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Es hat keinen Sinn, mit Technoquatsch gegen den Klimawahn angehen zu wollen. Wenn sie glauben, das sei das CO2, dann sollen sie es abfangen. Wie, sage ich ihnen seit Jahren*. Tun sie es nicht, dann ist es auch egal, weil CO2 egal ist. Wasserdampf ist klimawirksam, empfehle ihnen mal einen Zelturlaub in einer Wüste: Affenheiß am Tag, eiskalt die Nacht. Warum? Knochentrocken dort, CO2 spielt dabei keine Rolle. Wir singen: https://www.youtube.com/watch?v=8JDkdc246QQ

*https://www.researchgate.net/figure/The-George-Olah-Renewable-CO2-to-Methanol-Plant-of-Carbon-Recycling-International-CRI_fig3_324846670

So müssen wir sie packen, politisch.

Und wenn jetzt noch jemand freundlicherweise für Klima-Fußgänger erklären würde, was GHCN-Stationen sind, wäre das Leseglück perfekt.

Googeln hilft fast immer: https://www.ncei.noaa.gov/products/land-based-station/global-historical-climatology-network-daily

Nicht „googeln“, besser: „metager.de“ Das ist eine Metasuchmaschine, die größte im deutschsprachigen Raum. Kein Aushorchen, keine Werbung. Entwickelt von der TH Hannover, https://metager.de/about

„dass die Temperaturtrends aus bestehenden homogenisierten Datensätzen“

… das ist ja endlich einmal ein Fortschritt in richtiger Terminologie, es werden tatsächlich Temperaturen gemessen und keine „Erwärmung“. Wenn bestimmte Klimawissenschaftler jetzt noch dahinter kommen, dass man Volumina in Litern, Massen in Kilogramm oder Energien in Kilowattstunden addieren kann und dabei die jeweilige Dimension nicht verliert, weil das Ergebnis tatsächlich mit den summierten Skalaren und der zugehörigen Dimension existiert und Sinn macht, dies aber bei summierten Temperaturen für welche Verbiegung auch immer – und wenn es nur Mittelwerte oder Global-Mittelwerte sind – genau nicht der Fall ist.

Wer 275K, 298K und 333K addiert, erhält zwar einen Skalar in der Größe 906, aber nicht 906K. Keine Verknüpfung der drei Temperaturwerte führt zu einer existierenden physikalischen Größe. Wer dann die 906 mittelt und 302 erhält, hat für den Skalar richtig gerechnet. Dahinter jedoch die Einheit Kelvin zu schreiben, ist eine Art Adelung, die dieser sehr beliebten Methodik nicht gerecht wird. Durch 3 dividierte Skalare erfahren nämlich nach einem Dimensionsverlust einer Temperatur in Kelvin durch eine Addition nicht plötzlich eine Wiedergeburt einer Dimension in Kelvin. Der summierte Skalar 906 weiß nämlich gar nicht, ob er aus der Summierung von Temperaturen oder Geschwindigkeiten entstanden ist!

Das fordert nun doch Widerspruch heraus. Wer die drei Temperaturen in Kelvin addiert, kann nichts anderes herausbekommen als einen neuen Wert in Kelvin. Sonst würde da nämlich stehen

275K + 298K + 333K = 906

und das ist auf jeden Fall falsch. Denn links steht dann eine benannte Größe und rechts eine reine Zahl. Dazwischen kann keine Gleichheit herrschen.

Formal ausgedrückt: mit der Maßeinheit 1K bedeutet z.B. 275K = 275 • 1K. Das Assoziativgesetz der Multiplikation führt dann auf

275K + 298K + 333K = (275 + 298 + 333) • 1K = 906 K.

Auf einem anderen Blatt steht freilich, dass man damit physikalisch gesehen keine sinnvolle Temperatur erzielt. Man kann Temperaturen nicht addieren. Man kann sie aber sinnvoll mitteln, und bei der Mittelung ist die Addition jedenfalls ein Zwischenschritt. Deshalb ist auch die Division der Summe durch 3 keine Wiedergeburt in Kelvin, weil schon vorher nichts anderes da war als ein Wert in Kelvin.

#Michael Mechtel am 20. Januar 2023 um 21:46

Wenn Sie genau lesen, werden Sie feststellen, dass ich mich auf die Skalare der Temperaturen bezogen habe, ein Rechner kann auch nicht anders, er kennt nur Nullen und Einsen. Die Dimension ist immer leicht dahinter zugefügt, muss aber nicht immer noch einen physikalischen Sinn ergeben. Das sollte eigentlich meine Botschaft sein.

Es ist nicht so, dass ich in vielen Programmen für die Prozesssteuerung nicht auch Mittelungen von Messwerten vorgenommen haben, sie galten aber nicht den physikalischen Größen, sondern den induzierten Störgrößen, die als Wechselgrößen ohne Gleichanteil den momentan von Analog-Digital-Wandlern erfassten Wert beeinflussten.

Kleine Hilfe für das Verständnis zu meinem Kommentar: Wenn man die Geschwindigkeiten von 30 Mrd. Autos addiert, die jeweils über 50km/h fahren, könnte man ja dann sagen => Hurra, wir haben die Lichtgeschwindigkeit überschritten! ???

Aber nur, wenn die alle in dieselbe Richtung fahren und einander anschieben, oder? Was soll das Herr Professor? Rein vektoriell, versteht sich.

#gerhard giesemann am 21. Januar 2023 um 20:27

Was soll das Herr Professor? Rein vektoriell, versteht sich.

=> Eine Anregung, über Sinn und Unsinn einer sog. Global-Temperatur nachzudenken. Nicht mehr und nicht weniger!

@Peter Puschner, Prof. Dr.-ing am 21. Januar 2023 um 12:00

Das ist natürlich ein klares Beispiel dafür, dass nicht alles, was die Mathematik liefert, physikalisch sinnvoll ist.

Ich möchte aber doch noch eine Lanze für Temperaturmittelung brechen, weil das hier oft Thema ist. Nehmen wir an, wir hätten 2 Eimer Wasser (gleiche Masse), der eine mit 40 Grad, der andere mit 20 Grad. Schüttet man sie zusammen, erhält man natürlich keine 60 Grad, sondern den Mittelwert 30 Grad.

Jetzt könnte man erstens die Schwarzkörperstrahlung des zusammengemischten 30-Grad-Wassers berechnen (Emissionsgrad < 1 sei mal vernachlässigt). Zweitens könnte man jeweils die Schwarzkörperstrahlungen der beiden anfänglichen Wässer von 40 und 20 Grad berechnen und daraus den Mittelwert bilden. Dann wird man sehen, dass die Ergebnisse 1 und 2 sich unterscheiden (wegen der T-hoch-vier-Abhängigkeit) – aber eben nicht sehr viel! Der Wert 1, der zur Mischung gehört, ist eine gute Näherung für den Wert 2.

Verallgemeinert auf die Erde heißt das, für eine Näherungsbetrachtung ihres Strahlungsgleichgewichts mit der Sonne ist es nicht so abwegig, eine Erd-Mitteltemperatur und die dazu gehörige Strahlungsintensität zu benutzen.

#Michael Mechtel am 22. Januar 2023 um 18:00

Da sind natürlich ein paar Haken in dem Vereinfachungsmodell. Die Wassereimer mit 20°C und 40°C hatten offensichtlich identische Massen. Dei Temperaturdifferenz beträgt nur 20K. Global haben wir aber die Spanne von 180K (Antarktis) und 325K (Death Valley) also rund 145K. Zudem ist kaum anzunehmen das das Wasser in den Eimern, die Antarktis und Death Valley Schwarzkörper darstellen, dass man da mit Stefan-Boltzmann rangehen kann.

Wer einmal Temperaturreihen für die Erde simuliert und dann die Einzeltemperaturen mit Stefan-Boltzman Rechnung mit dem Ergebnis des Mittelwerts mit Stefan-Boltzmann behandelt vergleicht, wird zu seinem Schrecken feststellen, dass die beiden Werte sich um Faktoren 1,5 bis 2 unterscheiden. Keinesfalls sind sie geeignet, die wirklichen energetischen Zusammenhänge darzustellen (Globale Erwärmung / Globale Abkühlung.

So ganz nebenbei ist auch die erforderliche Statik der Massen (eingeschwungener Zustand), bei denen die Temperaturen erfasst werden, auf der sehr lebhaften Erde nicht gegeben. – Trotzdem, in Potsdam hat man gelernt, damit viel Geld zu bekommen, man verweist dann immer auf die supergroßen Rechner, die ja nicht falsch rechnen können. Da liegt aber eben gerade nicht das Problem, es liegt schlicht und ergreifend im falschen Verständnis und damit im falschen Ansatz. Ein Rechner kann nichts dafür, er leistet emotionslos seine Arbeit, als Knecht auch falsche Ansätze auf 3 Stellen hinter dem Komma genau zu berechnen.

Peter Puschner, Prof. Dr.-ing. schrieb am 22/01/2023, 21:49:53 in 313254

Könnten Sie mal auf eine Stelle verweisen, an der das gemacht wurde? Ich kenne bisher nur Kiel/Trenberth 2009, Kästchen „Spatial and temporal sampling“, in dem ein entsprechender Vergleich gemacht wurde. Und die kamen nur auf eine Abweichung von 7W/m² für das globale Mittel:

Im Diagramm werden die 396W/m² ausgewiesen. Das wäre der Wert, der durch Mittelung der lokalen Abstrahlung (also lokale Temperatur -> lokale Abstrahlung -> global gemittelte Abstrahlung) bestimmt wurde.

#313292

@Peter Puschner, Prof. Dr.-ing. am 22. Januar 2023 um 21:49

Herr Prof. Puschner, den Faktor 1,5 bis 2 kann ich auf die Schnelle nicht überprüfen, interessant ist die Aussage allemal. Nur prinzipiell möchte ich zu bedenken geben, dass man bei einer solchen Temperaturreihe zur Mittelwertbildung die zugehörigen Abstrahlungswerte mit der Fläche gewichten müsste, für die sie gelten. Da macht z.B. das Death Valley nur einen winzigen Anteil aus, die Antarktis natürlich schon mehr. Die Frage ist, ob dann immer noch so ein hoher Faktor 1,5 bis 2 herauskommt? Entscheidend für die Güte der Näherung durch eine Mitteltemperatur wäre jedenfalls deren gewichtete Standardabweichung, und die ist sicher deutlich kleiner als die Differenz von 145 K zwischen den Extremen. Ich würde sagen, so plus minus 10% zum T-Niveau von 288 K wären noch akzeptabel.

Aber klar: ein wirklich eingeschwungener Zustand liegt bei der Erde nicht vor, das muss man wohl so sehen.