Der sechste IPCC-Zustandsbericht (AR6) ist veröffentlicht worden, sehr zur Freude und unter dem Jubel der Mainstream-Medien. Es wurde erwartet, dass das Dokument von Düsternis und Verzweiflung durchdrungen sein würde – es sei denn, wir verabschieden eine drakonische Strategie zur Reduzierung von Kohlendioxid – und der IPCC hat nicht enttäuscht.

Woher kommen also diese extremen Klimaszenarien? Man könnte annehmen, dass sie „erfunden“ sein könnten; schließlich wird die Klimawissenschaft seit langem vom Maierschen Gesetz geplagt – wenn die Daten nicht mit der Theorie übereinstimmen, müssen sie verworfen werden. Aber die Wissenschaftler müssen für all das Geld, das sie für den Klimawandel ausgeben, auch etwas vorweisen können; mit der Erstellung von Klimamodellen können die Klimamodellierer also ihren Lebensunterhalt verdienen.

Im Gegensatz zu Modellflugzeugen oder -eisenbahnen ist ein Klimamodell keine physikalische Erscheinung, sondern eine mathematische Darstellung des Klimasystems. Man geht davon aus, dass wir alle Gleichungen, die alles beschreiben, was mit dem Klima zu tun hat, in einen Computercode umwandeln, den „RUN“-Knopf am Computer drücken und uns zurücklehnen und feststellen, dass die Erde in kürzester Zeit zu einem Feuerball wird – es sei denn, wir ergreifen extreme Maßnahmen, um den Anstieg der Kohlendioxidkonzentration in der Atmosphäre zu stoppen.

Nun, so funktioniert das nicht ganz. Im Jahr 2007 stellte der Workshop on Theoretical Alternatives to Climate Modelling fest, dass „entgegen einem weit verbreiteten Missverständnis die Computermodellierung des Klimas zu einem großen Teil auf empirischen Faustregeln und unkontrollierten Annäherungen in vielen ihrer wichtigsten physikalischen Aspekte beruht“. Ein Jahrzehnt später gaben die Klimamodellierer in The Art and Science of Climate Model Tuning (etwa: Die Kunst und Wissenschaft hinter dem Frisieren von Klimamodellen) schließlich zu, dass

„… mit der zunehmenden Vielfalt der Anwendungen von Klimamodellen auch die Zahl der möglichen Ziele für die Optimierung steigt. Es gibt eine Vielzahl von Zielen für bestimmte Probleme, und verschiedene Modelle können so optimiert werden, dass sie bei einer bestimmten Metrik besser abschneiden, was mit den spezifischen Zielen, dem Fachwissen oder der kulturellen Identität eines bestimmten Modellierungszentrums zusammenhängt.“

Modelle werden nach bestimmten Zielsetzungen optimiert? Ist das die Wissenschaft, wie wir sie kannten, oder ist es eine postnormale Wissenschaft, bei der das „Fachwissen“ das Ergebnis bestimmt?

Die einzig richtige Art, ein Klimamodell zu bewerten, ist der Vergleich mit beobachteten Daten. Man könnte annehmen, dass wir Thermometerdaten nehmen und sie mit den modellierten Zeitreihen vergleichen. Aber, wie ein berühmter Klimaalarmist [1] einmal sagte: „Die Daten sind schmutzig!“ Und in der Tat, das sind sie! Unsere Thermometer befinden sich überwiegend über dem Land, in mittleren Breiten, in niedrigeren Höhen, in wohlhabenderen Gesellschaften und entlang von Küstenregionen – kurz gesagt, dort, wo entwickelte Menschen leben. Über den Ozeanen, den hohen Breiten, den Wüsten und den tropischen Regenwäldern gibt es nur wenige Messungen. Darüber hinaus sind viele dieser Aufzeichnungen unvollständig oder aufgrund von Stationsverlegungen und -unterbrechungen, Änderungen in der Instrumentierung und schlechten Standortpraktiken verzerrt. Darüber hinaus messen sie nur die Lufttemperatur in einer Höhe von etwa 1,7 m* – eine bequeme Höhe für einen 1,80 m großen Wetterbeobachter, um die Station zu erreichen.

[*Die amtliche Messhöhe für Temperatur-Messungen im Bereich des DWD beträgt genau 2 Meter. Da fangen also die Ungenauigkeiten schon an! A. d. Übers.]

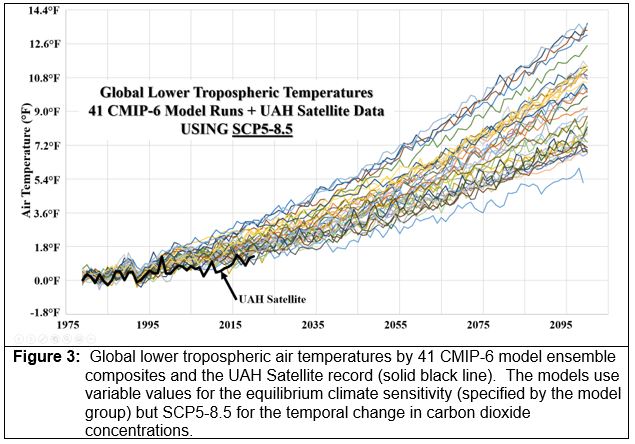

Aufgrund der Unzulänglichkeiten der Stationsbeobachtungen greifen Klimatologen häufig auf Satellitendaten zurück. Obwohl Satellitenschätzungen der Lufttemperatur erst seit 1979 vorliegen, bieten sie eine nahezu vollständige räumliche Abdeckung und integrieren die atmosphärische Temperatur in der gesamten unteren Troposphäre, nicht nur in einer Höhe von 5,5 Fuß. Daher sind Satellitenschätzungen der atmosphärischen Lufttemperatur vorzuziehen und relativ genau, wenn man sie mit disparaten Thermometer-Messnetzen vergleicht.

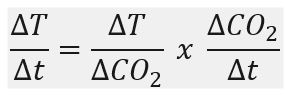

Wenn Modellsimulationen des aktuellen Klimas (1979 bis 2020) mit den Satellitenaufzeichnungen verglichen werden, neigen die Klimamodelle dazu, „heiß“ zu laufen, d.h. die Modelle überschätzen in der Regel den Anstieg der Lufttemperatur im Laufe der Zeit im Vergleich zu dem von den Satelliten beobachteten. Dr. John Christy hat vor beiden Häusern des US-Kongresses ausgesagt, dass die Klimamodelle den Anstieg der Lufttemperatur im Laufe der Zeit überbewerten. Warum ist das so? Wir können über die Anwendung von Konvektions-Parametern in den Modellen, den räumlichen Mittelungsprozess, der sich auf die Computersimulationen auswirkt, und die Unsicherheiten im Zusammenhang mit der Parametrisierung der Eisschilddynamik diskutieren – aber das sind sehr technische, wissenschaftliche Erklärungen. Auf einer sehr grundlegenden Ebene gibt es jedoch eine sehr einfache Erklärung dafür, warum die Modelle heiß laufen – und sie wird durch diese sehr einfache Gleichung gegeben:

wobei die Veränderung der Lufttemperatur mit der Zeit in den Modellen durch zwei einfache Terme erklärt wird. Ich werde zeigen, dass beide Terme überschätzt werden, was zur Überschätzung der Klimasensitivität (der Term links vom Gleichheitszeichen) beiträgt.

Der erste Term,

beschreibt die Modellreaktion der Lufttemperatur auf eine Änderung der Kohlendioxid-Konzentration. Dieser Begriff kann als transiente Klimareaktion (TCR) oder als Gleichgewichts-Klimasensitivität (ECS) bezeichnet werden, je nachdem, ob ein transienter Wert oder eine stationäre Lösung betrachtet wird. Sowohl Charney im Jahr 1979 als auch der Erste Bewertungsbericht des IPCC gingen davon aus, dass die ECS bei einer Verdoppelung des Kohlendioxids zwischen 1,5°C und 4,5°C fällt. Frühe Schätzungen in den 2000er Jahren deuteten auf Durchschnittswerte [des Anstiegs] zwischen 5,0°C und 6,1°C hin, obwohl die meisten anderen Schätzungen zwischen 2,5°C und 3,9°C für eine Verdoppelung des Kohlendioxids lagen. Seitdem sind die Beobachtungs-Schätzungen des ECS jedoch drastisch auf Werte von weniger als 1°C gesunken, obwohl Modelle und der Sechste Bewertungsbericht des IPCC immer noch von einem ECS von etwa 3°C ausgehen (Abbildung 1).

[Sämtliche Temperaturdifferenzen, im Original in °F angegeben, sind hier gleich in °C umgerechnet dargestellt. A. d. Übers.]

So wird der erste Term in der Gleichung – die Klimasensitivität – sowohl von den Modellen als auch vom IPCC im Vergleich zu aus Beobachtungen gewonnenen unabhängigen Schätzungen überschätzt. Der zweite Term,

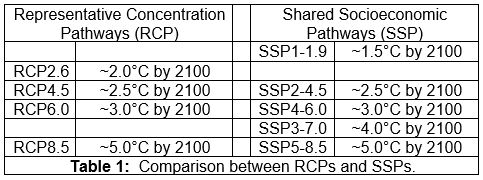

beschreibt, wie das Modell den Anstieg des Kohlendioxids mit der Zeit simuliert. In den vergangenen Jahren wurden vier Szenarien unterstellt: RCP2.6, RCP4.5, RCP6.0 und RCP8.5. RCP steht für „Representative Concentration Pathway“ (Repräsentativer Konzentrationspfad), und die nachfolgende Zahl gibt den anthropogenen Treibhauseffekt (in W/m²) an, der bis 2100 eintritt. In jüngerer Zeit wurden fünf Basisszenarien vorgeschlagen: SSP1-1.9, SSP2-4.5, SSP4-6.0, SSP3-7.0, und SSP5-8.5. SSP steht für „Shared Socioeconomic Pathway“ (Gemeinsamer sozioökonomischer Pfad), die erste Zahl ist die sozioökonomische Herausforderung (1-Nachhaltigkeit, 2-Mittelweg, 3-Regionale Rivalität, 4-Ungleichheit und 5-Fossile Entwicklung), und die zweite Zahl ist wie zuvor der anthropogene Treibhauseffekt bis 2100. In der folgenden Tabelle (Tabelle 1) werden die beiden Methoden miteinander verglichen:

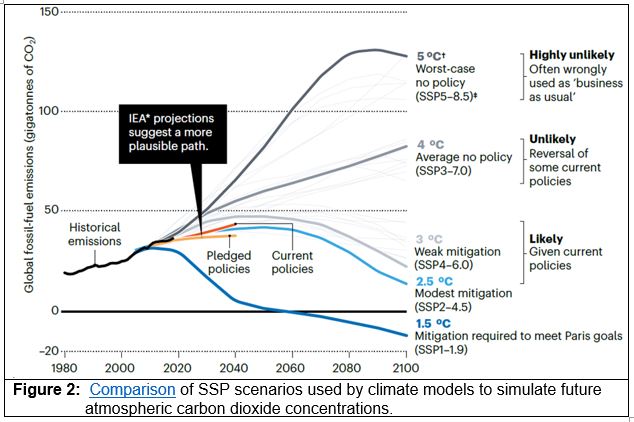

Der IPCC AR6 verwendet diese SSPs zur Modellierung des möglichen Energieverbrauchs und folglich der Emission von Treibhausgasen. Viele Wissenschaftler interpretieren ein „Business-as-usual“-Szenario als SSP5-8.5 (oder RCP8.5), wobei alle anderen Szenarien zu einer gewissen Einschränkung der Treibhausgasemissionen führen. Dies ist keine angemessene Interpretation, da die Szenarien SSP3-7.0 und SSP5-8.5 als „unwahrscheinlich“ gelten (Abbildung 2):

Leider verwenden die meisten Modellbewertungen zukünftiger Klimaszenarien SSP5-8.5 (oder früher RCP8.5), um die Auswirkungen von Veränderungen des atmosphärischen Kohlendioxids zu simulieren. Beachten Sie, dass Hausfather und Peters (Abbildung 2) dieses Szenario als „höchst unwahrscheinlich“ bezeichnen. Dennoch führt dieses Extremszenario zu extremen Veränderungen bei den meisten Klimavariablen, was genau das ist, was die Klimaalarmisten sehen wollen. So ist die Modelldarstellung der Veränderung der Lufttemperatur mit der Zeit …

… ist übertrieben (d. h. sie „laufen heiß“), weil die meisten Modell-Simulationen eine ECS anwenden (1), die zu hoch ist …

… jedenfalls im Vergleich zu Beobachtungen, und einem Szenario für sich ändernde atmosphärische Kohlendioxid-Konzentrationen …

… welche zugegebenermaßen „höchst unwahrscheinlich“ sind. Daraus ergibt sich rechnerisch eine dramatische Erwärmung bis zum Jahr 2100 (Abbildung 3):

[1] Professor Thomas Wigley, Personal Communication

Link: https://cornwallalliance.org/2021/09/a-simple-explanation-of-why-climate-models-run-hot/

Übersetzt von Christian Freuer für das EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Der erste Fehler (die Ursünde):

Man benutzt den Begriff delta CO2. Korrekt wäre: delta (IR-aktiv Gase).

Da aber dann jedem, auch Politikern, Journalisten, und dem einfachen Volk schlagartig klar würde, dass neben dem Wasser das CO2 nur ein Hundertstel Größenordnung beitragen kann, spielt man lieber das Falschspiel.

Luft Wassergehalt zwischen Tropen und Polen: 0-4 %.

In unseren Breitengraden zwischen 1-2 %. Und die Schwankung des Wassergehaltes sowohl innerhalb von 24 Stunden, wie auch jahrzeitbedingt ist das Mehrfache, was CO2 je erreichen könnte. Ich schreibe könnte, und nicht kann, weil ich weiss seit Jablonski, dass die durch die IR-Strahlen angeregte CO2-Molekül ihr Energiequantum tausendmal schneller an ihre Umgebung (O2- und N2-Moleküle) abgibt, als sie die Chance zur Rückstrahlung hätte. In der Troposphäre jedenfalls. Auch ist mir seit der dritten Schulklasse bekannt, dass warme Luft nach oben steigt, und an ihre Stelle kalte Luft strömt. Die natürlichen CO2-Emissionen erwähne ich lieber gar nicht.

Hätte es die Schildbürger wirklich gegeben (Sonnenlicht mit Scheffeln in das Gebäude tragen), wären sie ein hochintelligentes Volk unserer Gesellschaft gegenüber gewesen. Das Ganze zeigt nur: Die Medien, bzw. ihre Besitzer haben eine unheimliche Macht über uns.

Herr Balint,

Sie erliegen einem Irrtum. In der ECS von Co2 oder anderen LLGHGs sind die Klima-feedbacks bereits berücksichtigt, d.h. auch der Wasserdampfanstieg mit seiner Treibhauswirkung ist hier bereits berücksichtigt.

Wieder einmal richtig und zutreffend! Doch die Klima-Irren machen ungerührt weiter – auf beiden Ohren taub. Wo man doch so wunderbar und unbegrenzt Unsinn als „Alarm“ verkaufen kann. Und Medien, Politiker, Verfassungsrichter und die Straße nehmen jede Dummheit ab und glauben sie. Und sind geradezu süchtig nach mehr davon.

Grundvoraussetzung: Die Alarmforscher dürfen die Parameter nur soweit ändern und anpassen, dass auch weiterhin Klima-Alarm herauskommt. Denn wer will schon riskieren, dass die Klima-Panik ein vorzeitiges Ende nimmt? Dann doch lieber weiter nach Kräften übertreiben, damit der Klima-Schrecken weiter geht. Auch muss man es verstehen: Die Alarmforscher samt ihrer Forschung leben von Alarm und Panik, sonst leeren sich ganz schnell die Kassen…

Die „Weisheit“ der Modellierer findet ihre Kulminátion in der Annahme, Treibhausgase erzeugen ein „Forcing“ von einigen W/qm, und dieses Forcing addieren sie dann zu der Sonneneinstrahlung dazu, erhöhen damit so die Energiezufuhr über jene ab Sonne (sozusagen aus sich selbst heraus), und so berechnen sie mit stolzgeschwellter Brust Erwärmungen in fast beliebiger Höhe. So funktioniert „moderne“ Wissenschaft heutzutage.

Und der obige Beitrag ist ein Beleg, wie man über solche Absiurditäten dann auch noch Analysen erstellen kann, ohne den eigentlichen Kern der Sache anzutasten! Um Gottes Willen …

Klimamodelle wenden keine ECS an, ihr Sinn ist u.a., diese zu ermitteln.

Vielleicht könnten Sie mich ja mal diesbezüglich aufklären, wie eine Simulation eine ECS „ermittelt“?

Sehr geehrter Herr Gregor,

gerne. Ein Klimamodell ist letztlich ein Wettermodell. Dabei ergeben sich die atmosphärischen Stömungen und Wetterzustände aus Berechnung der physikalischen Grundgesetze. Darin spielt natürlich auch die Energieverteilung eine Rolle. Und dabei spielen auch die Energieflüsse durch Strahlung eine Rolle. Und darin die der langwelligen (Wärme)strahlung. Und diese wieder hängt von den Treibhausgasen ab. Die ECS ermittelt man, indem man das Klimamodell einmal mit der gegenwärtigen CO2 Menge laufen läßt und die damit resultierenden verschiedenen Temperaturverteilungen aufzeichnet. Und dann das sonst gleiche Modell aber mit z.b. verdoppelter CO2 Menge laufen lässt. Dabei ergibt sich eine Temperaturverteilung zu tendenziell höheren Werten. Daraus bestimmt man die ECS. Heute nimmt man auch Zwischenwerte zwischen 1x und 2x und geht über 2x hinaus in der CO2 Menge.