Eine einfache Erklärung, warum Klimamodelle „heiß laufen“

Der sechste IPCC-Zustandsbericht (AR6) ist veröffentlicht worden, sehr zur Freude und unter dem Jubel der Mainstream-Medien. Es wurde erwartet, dass das Dokument von Düsternis und Verzweiflung durchdrungen sein würde – es sei denn, wir verabschieden eine drakonische Strategie zur Reduzierung von Kohlendioxid – und der IPCC hat nicht enttäuscht.

Woher kommen also diese extremen Klimaszenarien? Man könnte annehmen, dass sie „erfunden“ sein könnten; schließlich wird die Klimawissenschaft seit langem vom Maierschen Gesetz geplagt – wenn die Daten nicht mit der Theorie übereinstimmen, müssen sie verworfen werden. Aber die Wissenschaftler müssen für all das Geld, das sie für den Klimawandel ausgeben, auch etwas vorweisen können; mit der Erstellung von Klimamodellen können die Klimamodellierer also ihren Lebensunterhalt verdienen.

Im Gegensatz zu Modellflugzeugen oder -eisenbahnen ist ein Klimamodell keine physikalische Erscheinung, sondern eine mathematische Darstellung des Klimasystems. Man geht davon aus, dass wir alle Gleichungen, die alles beschreiben, was mit dem Klima zu tun hat, in einen Computercode umwandeln, den „RUN“-Knopf am Computer drücken und uns zurücklehnen und feststellen, dass die Erde in kürzester Zeit zu einem Feuerball wird – es sei denn, wir ergreifen extreme Maßnahmen, um den Anstieg der Kohlendioxidkonzentration in der Atmosphäre zu stoppen.

Nun, so funktioniert das nicht ganz. Im Jahr 2007 stellte der Workshop on Theoretical Alternatives to Climate Modelling fest, dass „entgegen einem weit verbreiteten Missverständnis die Computermodellierung des Klimas zu einem großen Teil auf empirischen Faustregeln und unkontrollierten Annäherungen in vielen ihrer wichtigsten physikalischen Aspekte beruht“. Ein Jahrzehnt später gaben die Klimamodellierer in The Art and Science of Climate Model Tuning (etwa: Die Kunst und Wissenschaft hinter dem Frisieren von Klimamodellen) schließlich zu, dass

„… mit der zunehmenden Vielfalt der Anwendungen von Klimamodellen auch die Zahl der möglichen Ziele für die Optimierung steigt. Es gibt eine Vielzahl von Zielen für bestimmte Probleme, und verschiedene Modelle können so optimiert werden, dass sie bei einer bestimmten Metrik besser abschneiden, was mit den spezifischen Zielen, dem Fachwissen oder der kulturellen Identität eines bestimmten Modellierungszentrums zusammenhängt.“

Modelle werden nach bestimmten Zielsetzungen optimiert? Ist das die Wissenschaft, wie wir sie kannten, oder ist es eine postnormale Wissenschaft, bei der das „Fachwissen“ das Ergebnis bestimmt?

Die einzig richtige Art, ein Klimamodell zu bewerten, ist der Vergleich mit beobachteten Daten. Man könnte annehmen, dass wir Thermometerdaten nehmen und sie mit den modellierten Zeitreihen vergleichen. Aber, wie ein berühmter Klimaalarmist [1] einmal sagte: „Die Daten sind schmutzig!“ Und in der Tat, das sind sie! Unsere Thermometer befinden sich überwiegend über dem Land, in mittleren Breiten, in niedrigeren Höhen, in wohlhabenderen Gesellschaften und entlang von Küstenregionen – kurz gesagt, dort, wo entwickelte Menschen leben. Über den Ozeanen, den hohen Breiten, den Wüsten und den tropischen Regenwäldern gibt es nur wenige Messungen. Darüber hinaus sind viele dieser Aufzeichnungen unvollständig oder aufgrund von Stationsverlegungen und -unterbrechungen, Änderungen in der Instrumentierung und schlechten Standortpraktiken verzerrt. Darüber hinaus messen sie nur die Lufttemperatur in einer Höhe von etwa 1,7 m* – eine bequeme Höhe für einen 1,80 m großen Wetterbeobachter, um die Station zu erreichen.

[*Die amtliche Messhöhe für Temperatur-Messungen im Bereich des DWD beträgt genau 2 Meter. Da fangen also die Ungenauigkeiten schon an! A. d. Übers.]

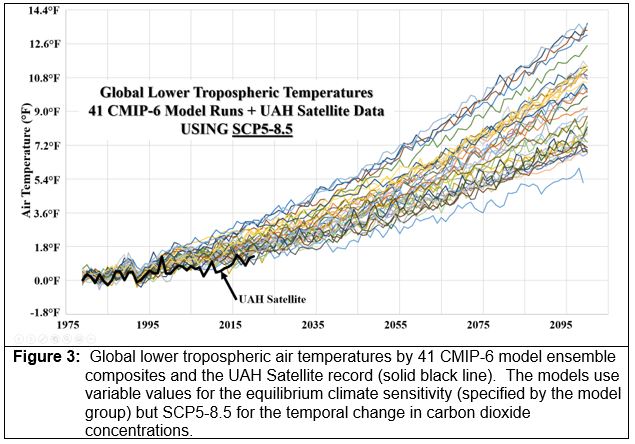

Aufgrund der Unzulänglichkeiten der Stationsbeobachtungen greifen Klimatologen häufig auf Satellitendaten zurück. Obwohl Satellitenschätzungen der Lufttemperatur erst seit 1979 vorliegen, bieten sie eine nahezu vollständige räumliche Abdeckung und integrieren die atmosphärische Temperatur in der gesamten unteren Troposphäre, nicht nur in einer Höhe von 5,5 Fuß. Daher sind Satellitenschätzungen der atmosphärischen Lufttemperatur vorzuziehen und relativ genau, wenn man sie mit disparaten Thermometer-Messnetzen vergleicht.

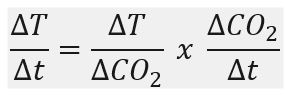

Wenn Modellsimulationen des aktuellen Klimas (1979 bis 2020) mit den Satellitenaufzeichnungen verglichen werden, neigen die Klimamodelle dazu, „heiß“ zu laufen, d.h. die Modelle überschätzen in der Regel den Anstieg der Lufttemperatur im Laufe der Zeit im Vergleich zu dem von den Satelliten beobachteten. Dr. John Christy hat vor beiden Häusern des US-Kongresses ausgesagt, dass die Klimamodelle den Anstieg der Lufttemperatur im Laufe der Zeit überbewerten. Warum ist das so? Wir können über die Anwendung von Konvektions-Parametern in den Modellen, den räumlichen Mittelungsprozess, der sich auf die Computersimulationen auswirkt, und die Unsicherheiten im Zusammenhang mit der Parametrisierung der Eisschilddynamik diskutieren – aber das sind sehr technische, wissenschaftliche Erklärungen. Auf einer sehr grundlegenden Ebene gibt es jedoch eine sehr einfache Erklärung dafür, warum die Modelle heiß laufen – und sie wird durch diese sehr einfache Gleichung gegeben:

wobei die Veränderung der Lufttemperatur mit der Zeit in den Modellen durch zwei einfache Terme erklärt wird. Ich werde zeigen, dass beide Terme überschätzt werden, was zur Überschätzung der Klimasensitivität (der Term links vom Gleichheitszeichen) beiträgt.

Der erste Term,

beschreibt die Modellreaktion der Lufttemperatur auf eine Änderung der Kohlendioxid-Konzentration. Dieser Begriff kann als transiente Klimareaktion (TCR) oder als Gleichgewichts-Klimasensitivität (ECS) bezeichnet werden, je nachdem, ob ein transienter Wert oder eine stationäre Lösung betrachtet wird. Sowohl Charney im Jahr 1979 als auch der Erste Bewertungsbericht des IPCC gingen davon aus, dass die ECS bei einer Verdoppelung des Kohlendioxids zwischen 1,5°C und 4,5°C fällt. Frühe Schätzungen in den 2000er Jahren deuteten auf Durchschnittswerte [des Anstiegs] zwischen 5,0°C und 6,1°C hin, obwohl die meisten anderen Schätzungen zwischen 2,5°C und 3,9°C für eine Verdoppelung des Kohlendioxids lagen. Seitdem sind die Beobachtungs-Schätzungen des ECS jedoch drastisch auf Werte von weniger als 1°C gesunken, obwohl Modelle und der Sechste Bewertungsbericht des IPCC immer noch von einem ECS von etwa 3°C ausgehen (Abbildung 1).

[Sämtliche Temperaturdifferenzen, im Original in °F angegeben, sind hier gleich in °C umgerechnet dargestellt. A. d. Übers.]

So wird der erste Term in der Gleichung – die Klimasensitivität – sowohl von den Modellen als auch vom IPCC im Vergleich zu aus Beobachtungen gewonnenen unabhängigen Schätzungen überschätzt. Der zweite Term,

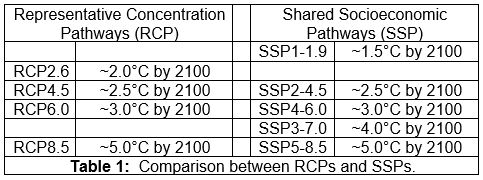

beschreibt, wie das Modell den Anstieg des Kohlendioxids mit der Zeit simuliert. In den vergangenen Jahren wurden vier Szenarien unterstellt: RCP2.6, RCP4.5, RCP6.0 und RCP8.5. RCP steht für „Representative Concentration Pathway“ (Repräsentativer Konzentrationspfad), und die nachfolgende Zahl gibt den anthropogenen Treibhauseffekt (in W/m²) an, der bis 2100 eintritt. In jüngerer Zeit wurden fünf Basisszenarien vorgeschlagen: SSP1-1.9, SSP2-4.5, SSP4-6.0, SSP3-7.0, und SSP5-8.5. SSP steht für „Shared Socioeconomic Pathway“ (Gemeinsamer sozioökonomischer Pfad), die erste Zahl ist die sozioökonomische Herausforderung (1-Nachhaltigkeit, 2-Mittelweg, 3-Regionale Rivalität, 4-Ungleichheit und 5-Fossile Entwicklung), und die zweite Zahl ist wie zuvor der anthropogene Treibhauseffekt bis 2100. In der folgenden Tabelle (Tabelle 1) werden die beiden Methoden miteinander verglichen:

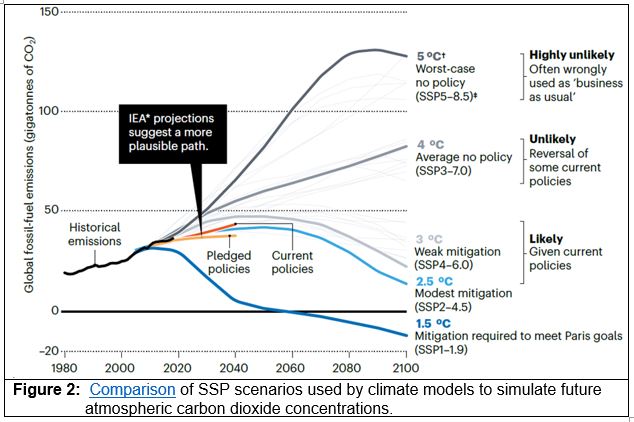

Der IPCC AR6 verwendet diese SSPs zur Modellierung des möglichen Energieverbrauchs und folglich der Emission von Treibhausgasen. Viele Wissenschaftler interpretieren ein „Business-as-usual“-Szenario als SSP5-8.5 (oder RCP8.5), wobei alle anderen Szenarien zu einer gewissen Einschränkung der Treibhausgasemissionen führen. Dies ist keine angemessene Interpretation, da die Szenarien SSP3-7.0 und SSP5-8.5 als „unwahrscheinlich“ gelten (Abbildung 2):

Leider verwenden die meisten Modellbewertungen zukünftiger Klimaszenarien SSP5-8.5 (oder früher RCP8.5), um die Auswirkungen von Veränderungen des atmosphärischen Kohlendioxids zu simulieren. Beachten Sie, dass Hausfather und Peters (Abbildung 2) dieses Szenario als „höchst unwahrscheinlich“ bezeichnen. Dennoch führt dieses Extremszenario zu extremen Veränderungen bei den meisten Klimavariablen, was genau das ist, was die Klimaalarmisten sehen wollen. So ist die Modelldarstellung der Veränderung der Lufttemperatur mit der Zeit …

… ist übertrieben (d. h. sie „laufen heiß“), weil die meisten Modell-Simulationen eine ECS anwenden (1), die zu hoch ist …

… jedenfalls im Vergleich zu Beobachtungen, und einem Szenario für sich ändernde atmosphärische Kohlendioxid-Konzentrationen …

… welche zugegebenermaßen „höchst unwahrscheinlich“ sind. Daraus ergibt sich rechnerisch eine dramatische Erwärmung bis zum Jahr 2100 (Abbildung 3):

[1] Professor Thomas Wigley, Personal Communication

Link: https://cornwallalliance.org/2021/09/a-simple-explanation-of-why-climate-models-run-hot/

Übersetzt von Christian Freuer für das EIKE