Man erspare mir hier die Übersetzung des längeren Auszugs aus diesem Beitrag, er lässt sich rasch zusammenfassen: Die Modelle waren super, alles passt. Middleton jedenfalls fragt sich [und leitet seinen Beitrag auch damit ein]: „Wie kann man so etwas schreiben, ohne eine Miene zu verziehen?“

Den Link zu dem Beitrag setzt Middleton so: Science! (As in “She blinded me with)

[Ende Einführung des Übersetzers]

Die Genauigkeit der gescheiterten Modelle verbesserte sich, nachdem man sie so frisiert hatte, dass sie zu den Beobachtungen passten … schockierend!

Die AGU und Wiley gestatten derzeit nur einen begrenzten Zugang zu Hausfather et al., 2019. Besonders hervorzuheben sind hier die Abbildungen 2 und 3 darin. Ich werde sie hier nicht wiedergeben wegen der Tatsache, dass es ein Dokument mit geschütztem und begrenztem Zugang ist.

Abbildung 2: Das Scheitern der Modelle

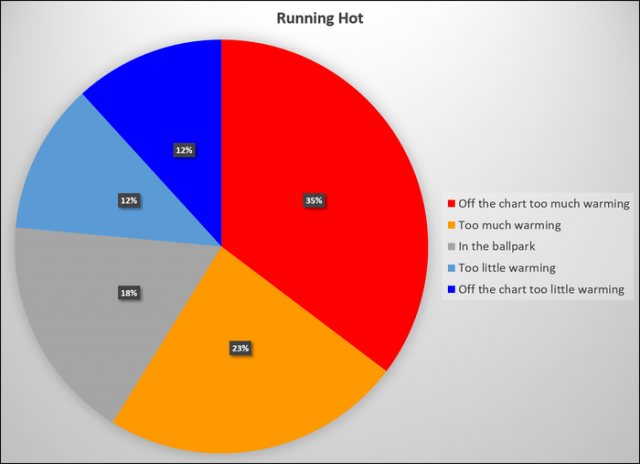

Abbildung 2 besteht aus zwei Graphiken. Die obere Graphik vergleicht die Rate der Temperaturänderungen in Modellen und nach Beobachtungen, wobei die Fehlerbalken vermutlich 2 Sigma (Standard-Abweichungen) repräsentieren. Meiner Mark I Eyeball Analysis zufolge lagen von den 17 ausgewählten Modell-Szenarien 6 außerhalb von 2 Sigma (außerhalb des Ausschnitts; viel zu viel Erwärmung), 4 lagen nahe der Obergrenze der 2 Sigma (zu viel Erwärmung), 2 lagen nach unten außerhalb von 2 Sigma (viel zu wenig Erwärmung), 2 lagen nahe der Untergrenze der 2 Sigma (zu wenig Erwärmung) und 3 lagen innerhalb 1 Sigma der Beobachtungen.

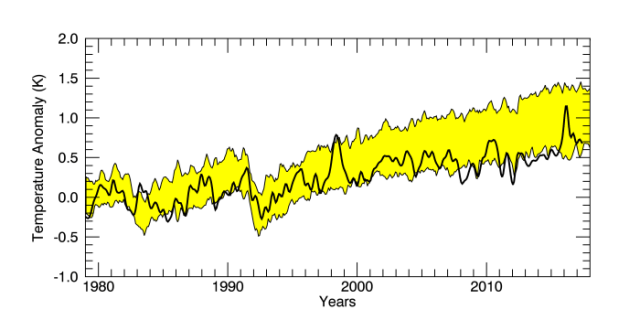

Abbildung 1: Weniger als 1 von 5 Modell-Szenarien lagen innerhalb der 1 Sigma-Standardabweichung der Realität.

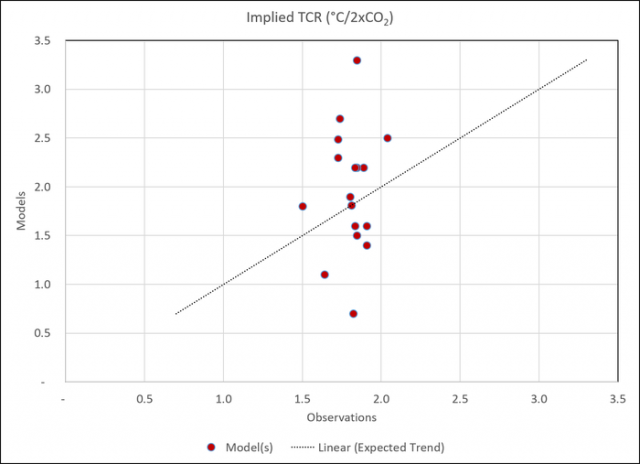

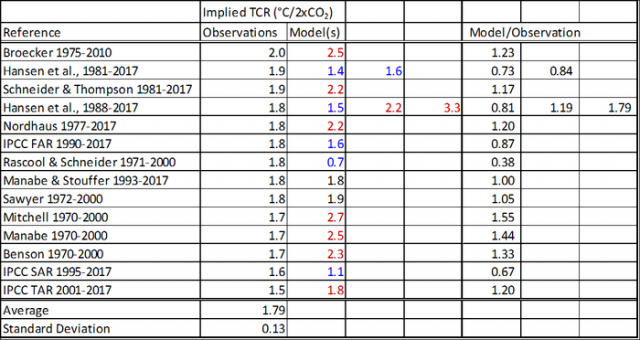

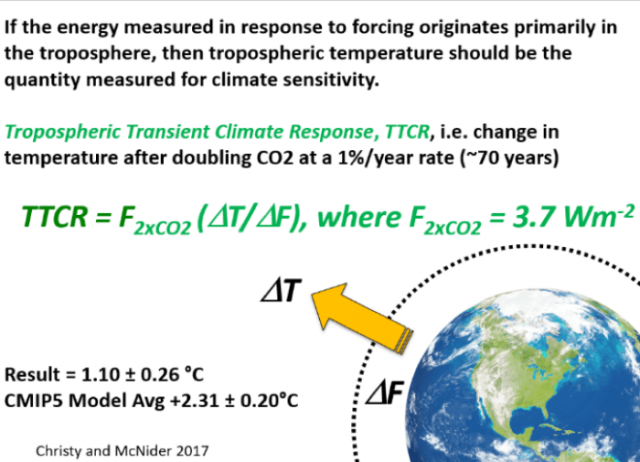

Die untere Graphik beschreibt die implizierte schwankende Klima-Reaktion (transient climate response TCR) der Beobachtungen und der Modelle. TCR ist die direkte Erwärmung, welche man bei einer Verdoppelung des atmosphärischen Kohlendioxid-Gehaltes erwarten kann. Es ist eine effektiv unverzügliche Reaktion und die einzige relevante Klima-Sensitivität.

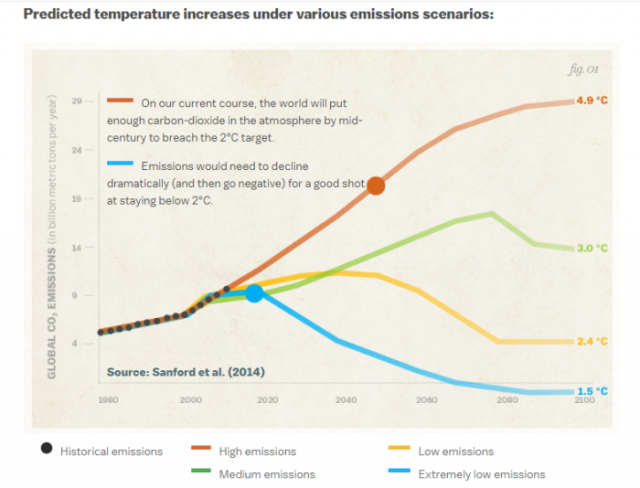

Im Falle der ECS von 3,5°C erfolgen 2,0°C der Erwärmung mit der Zeit der Verdoppelung des atmosphärischen CO2. Die verbleibenden 1,5°C der Erwärmung sollen vermeintlich während der folgenden 500 Jahre eintreten. Uns wird fortwährend erzählt, dass wir die Erwärmung bis zum Jahr 2100 auf keinen Fall über diesen Wert steigen lassen dürfen im Vergleich zu den Temperaturen in präindustrieller Zeit (also der kältesten Phase des Holozäns).

Abbildung 3: Die 2,0°C-Grenze (Vox)

Ich habe die untere Graphik digitalisiert, um die TCR-Werte zu erhalten. Von den 14 Datensätzen mit Beobachtungen bewegte sich die implizierte TCR zwischen 1,5°C und 2,0°C, im Mittel 1,79°C mit einem sehr kleinen Sigma von 0,13°C. Von den 17 Modell-Szenarien gehen 9 über die beobachtete TCR um über 1 Sigma hinaus, 6 lagen um mehr als 1 Sigma unter der beobachteten TCR. Nur 2 Szenarien lagen innerhalb von 1 Sigma der beobachteten TCR (1,79°C).

Ein cross plot [?] der Modell-TCR mit der beobachteten TCR ergibt eine Zufalls-Streuung…

Abbildung 5: Implizierte TCR (°C pro CO2-Verdoppelung), Beobachtungen im Vergleich mit Modellen. Der „zu erwartende Trend“ ist das, was sich ergeben hätte, falls die folgenden Beobachtungen zu den Modellprojektionen gepasst hätten.

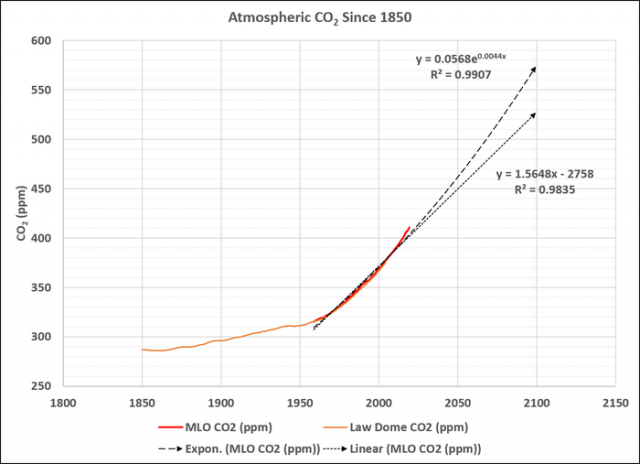

Der atmosphärische CO2-Gehalt ist auf dem Wege, diese Verdoppelung bis zum Ende dieses Jahrhunderts zu erreichen.

Abbildung 6: Atmosphärisches CO2, gemessen am Mauna Loa Observatorium (MLO, NOAA/ESRL) und der Eisbohrkern DE08 vom Law Dome, Antarktis (MacFarling-Meure, 2006).

Eine an die MLO-Daten angebrachte exponentielle Trendfunktion zeigt, dass die Verdoppelung etwa bis zum Jahr 2100 vollzogen werden wird. Falls die TCR 1,79°C beträgt, werden wir unter den 2°C bleiben und kaum über das „extrem wenig Emissionen“-Szenario in der Vox-Graphik (Abbildung 3) hinauskommen. Allerdings zeigen jüngste Messungen, dass die TCR unter 1,79°C liegt. Christy & McNider folgerten daraus, dass die TCR nur um 1,1°C beträgt, weniger als die Hälfte des aus den Modellen abgeleiteten Wertes.

Überprüfung der Klimawandel-Behauptungen

Dr. John Christy

Vortrag von Dr. Christy vor der GWPF am 8. Mai 2019:

Als ich in die Welt der Wissenschaft hinein wuchs, verstand man unter Wissenschaft ein Verfahren zur Gewinnung von Informationen. Man stellte eine Behauptung oder eine Hypothese auf und überprüfte diese dann anhand unabhängiger Daten. Fiel dieser Test negativ aus, zog man die Behauptung zurück und fing noch einmal von vorne an. Was ich dagegen heutzutage vorfinde ist, dass falls jemand eine Behauptung bzgl. Klima aufstellt und jemand wie ich diese Behauptung falsifiziert, die Behauptung nicht zurückgezogen wird, sondern dass der die Behauptung Erhebende immer lauter schreit, dass er recht hat. Sie beachten überhaupt nicht, welche konträren Informationen es gibt.

Also, worüber reden wir? Wir reden darüber, wie das Klima auf die Emissionen zusätzlicher Treibhausgase durch Verbrennung fossiler Treibstoffe reagiert.

( … )

Es sieht so aus: Es gab eine Temperaturänderung der Atmosphäre im Verlauf von 37,5 Jahren, wir wissen, wie viel Antrieb auf die Atmosphäre einwirkte, so dass wir diese beiden Größen in ein Verhältnis packen können und dieses mit dem Verhältnis des 2 X CO2-Antrieb multiplizieren. Also wird die TCR uns sagen, wie sich die Temperatur bei einer CO2-Verdoppelung verhalten wird – falls die Zunahme 1% pro Jahr beträgt, was in etwa dem Treibhauseffekt entspricht, und was in etwa 70 Jahren erreicht wird. Unser Ergebnis lautet, dass die TCR in der Atmosphäre 1,1°C beträgt. Das ist überhaupt keine sehr alarmierende Zahl bei einer CO2-Verdoppelung. Als wir die gleiche Rechnung unter Verwendung der Klimamodelle durchführten, betrug die Zahl 2,31°C. Eindeutig und signifikant unterschiedlich. Die Reaktion der Modelle auf den Antrieb – ihr ∆t hier, war über 2 mal größer als das, was in der realen Welt vor sich gegangen war.

( … )

Es gibt ein Modell, das nicht ganz so schlecht ist, nämlich das russische Modell. Man geht heute nicht zum Weißen Haus und sagt, dass das „russische Modell am besten funktioniert“. Man sagt das überhaupt nicht! Aber es ist eine Tatsache, dass sie nur eine sehr geringe Sensitivität in ihr Modell gesteckt haben. Betrachtet man das russische Modell bis zum Jahr 2100, dann sieht man nichts, was zu Sorgen Anlass gibt. Betrachtet man die 120 Jahre ab dem Jahr 1980, haben wir bereits ein Drittel des Zeitraumes hinter uns – falls man bis zum Jahr 2100 schaut. Nun sind diese Modelle bereits falsifiziert, man kann ihnen bis zum Jahr 2100 keinesfalls vertrauen, und kein legitimer Wissenschaftler auf der ganzen Welt würde das tun. Falls ein Ingenieur ein Flugzeug entwickelt und sagt, dass das Ding 600 Meilen weit fliegen kann, dann könnte er sagen, falls dem Flugzeug nach 200 Meilen der Treibstoff ausgeht und es abstürzt: „Ich habe mich lediglich um einen Faktor drei geirrt“. Nein, das tun wir nicht in der wahren Wissenschaft! Ein Faktor drei ist im Energie-Gleichgewichts-System gewaltig. Und doch sehen wir genau das in den Klimamodellen.

( … )

Mein Vortrag führt zu drei Schlussfolgerungen:

Die theoretische Klima-Modellierung ist zur Beschreibung von Variationen in der Vergangenheit ungeeignet. Klimamodelle scheitern bzgl. derartiger Variationen, deren Abfolge wir bereits kennen. Sie sind bei Tests der Hypothesen durchgefallen, was bedeutet, dass sie höchst fragwürdig sind, wenn wir aus ihnen genaue Informationen beziehen wollen, wie der relativ geringe Antrieb, und das ist die kleine Darstellung hier, das Klima der Zukunft beeinflussen wird.

Das Wetter, um das wir uns wirklich kümmern, ändert sich nicht, und Mutter Natur hat viele Wege, ihr eigenes Klima deutliche Variationen in Zyklen durchlaufen zu lassen. Falls man darüber nachdenkt, wie viele Freiheitsgrade im Klimasystem stecken, was ein chaotisches, nicht lineares und dynamisches System alles kann mit diesen Freiheitsgraden, dann wird man immer Rekord-Höchst- und -Tiefstwerte finden, ebenso wie gewaltige Stürme und so weiter. So läuft das in diesem System.

Und schließlich, Kohlenstoff ist heutzutage die dominante Energiequelle, weil sie bezahlbar ist und direkt zur Ausmerzung von Armut führt, ebenso wie zur Verlängerung und Verbesserung des menschlichen Lebens. Wegen dieser massiven Vorteile steigt der Kohleverbrauch weltweit – trotz des Geschreis nach dem Ausstieg aus derselben.

Dr. Christy’s presentation is well-worth reading in its entirety. This is from the presentation:

Der Vortrag von Dr. Christy ist es wert, vollständig gelesen zu werden. Daraus stammt die folgende Graphik:

Abbildung 2: Hansens Revisionismus

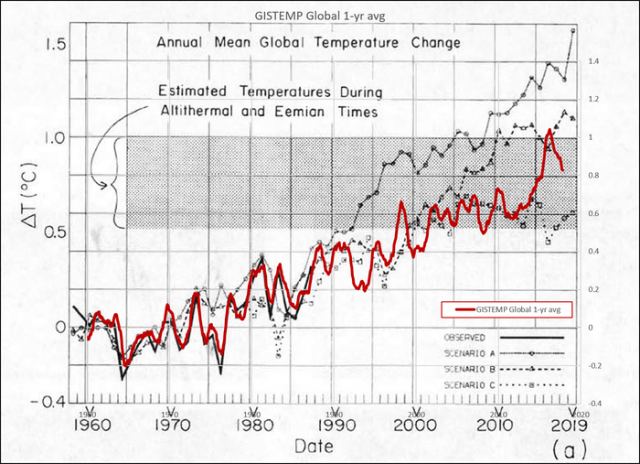

Abbildung 3 war nichts weiter als ein weiterer kläglicher Versuch, Hansen et al. (1988) wiederzubeleben:

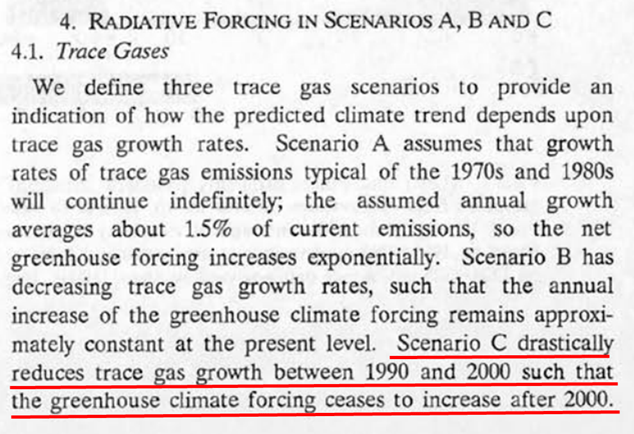

Abbildung 8: Szenario A „Business as Usual“. Szenario C ist ein Szenario, in dem Menschen das Feuer am Ende des 20. Jahrhunderts grundsätzlich nicht mehr erkennen.

Hansens eigene Temperaturdaten, GISTEMP, folgten Szenario C (dasjenige, in welchem wir Feuer nicht mehr erkennen) bis zum Jahr 2010. Es kreuzt den Weg mit Szenario B lediglich während des jüngsten El Nino…

Hausfather et al. (2019) zufolge war eigentlich Szenario B „Business as Usual“… Auszug:

Das „plausibelste“ Szenario B von H88 überschätzte die Erwärmung nach der Veröffentlichung um rund 54% (Abbildung 3). Allerdings ist ein großer Teil dieses Missverhältnisses der Überschätzung zukünftiger externer Antrieben geschuldet – vor allem von Methan und Kohlenwasserstoffe.

Hausfather et al. (2019)

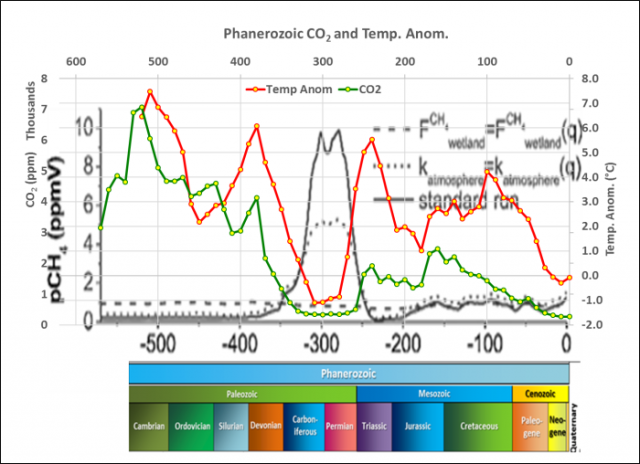

Ich dachte, dass es unmöglich sei, den Erwärmungseffekt von Methan nicht zu überschätzen, weil es in den geologischen Aufzeichnungen nicht präsent zu sein scheint. Die höchsten atmosphärischen Methan-Konzentrationen im gesamten Phanärozoikum waren während des Late Carboniferous (Pennsylvanian) and Early Permian Periods aufgetreten, der einzigen Zeit, in der es auf der Erde so kalt war wie im Quartär.

Abbildung 10: Das CH4-Niveau lag während der kältesten Klimaperiode des Phänozoikums 3 bis 5 mal höher als das heutige Niveau. pCH4 (Bartdorff et al., 2008), pH-corrected temperature (Royer & Berner) and CO2 (Berner). Ältere Daten sind links.

Tatsache ist, dass die Beobachtungen sich so verhalten, als ob sie bereits Vieles der Green New Deal-Kulturrevolution in Gang gesetzt hätten (¡viva Che AOC!)…

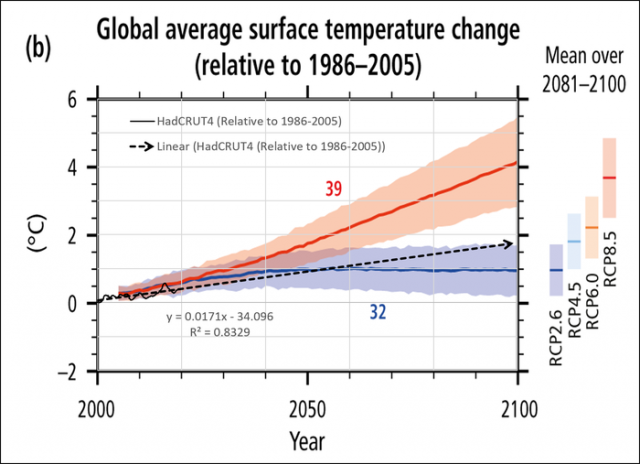

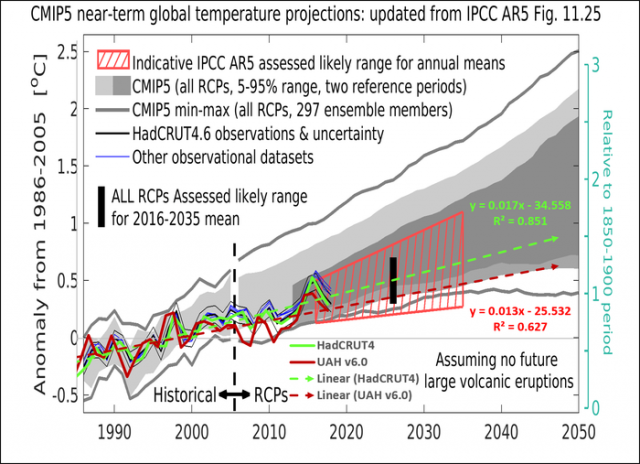

Abbildung 11: Die Beobachtungen (HadCRUT4) folgen einer AOC-Welt: RCP2.6-RCP4.0. (modifiziert nach IPCC AR5)

Modelle haben sich seit 50 Jahren nicht verbessert

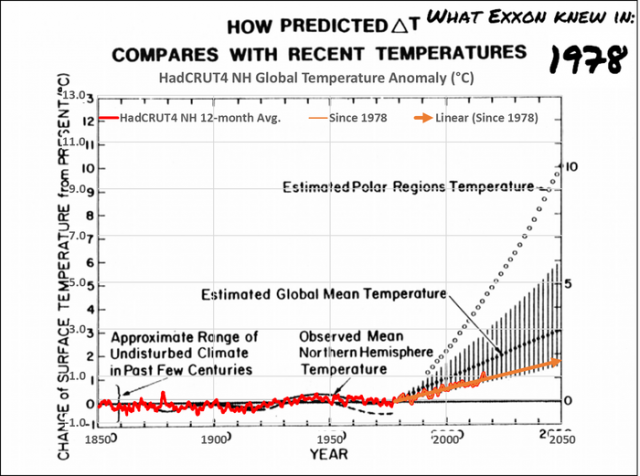

Dies ist eines der vermeintlichen #ExxonKnew-Modelle…

Abbildung 12: Was #ExxonKnew im Jahre 1978

„Das Gleiche, was es immer war“…

Abbildung 13: Die Modelle haben sich nicht verbessert. Vergleich des RSS V4.0 MSU/AMSU-Datensatzes der Temperatur mit den CMIP5-Klimamodellen. Das gelbe Band ist das Wahrscheinlichkeits-Band 5% bis 95%. Abgesehen vom jüngsten El Nino, war RSS (Remote Sensing Systems) kühler als über 95% aller Modelle. Der prädiktive Zustand ist nach 2005 …

… „Das Gleiche, was es immer war“…

Abbildung 14: Egal ob man nun die Temperaturen in der Atmosphäre (UAH v6.0) oder an Flughäfen (HadCRUT4) heranzieht – die Beobachtungen verlaufen nahe oder unterhalb der untersten Grenze der 5% bis 95%-Bandbreite. Abgesehen vom jüngsten El Nino sind die Beobachtungen kälter als 95% der Modelle (Modifiziert vom Climate Lab Book).

Falls die Öl- und Gasindustrie genaue Prognosen in der gleichen Art und Weise definiert wie die Klima-„Wissenschaftler“, wäre Deepwater Horizon die einzige falsche Prognose der letzten 30 Jahre gewesen … weil die Explosion der Plattform und deren Versinken nicht innerhalb der 5% bis 95%-Bandbreite der Ergebnisse von Prognosen vor der Bohrung gelegen hatte.

References

Bartdorff, O., Wallmann, K., Latif, M., and Semenov, V. ( 2008), Phanerozoic evolution of atmospheric methane, Global Biogeochem. Cycles, 22, GB1008, doi:10.1029/2007GB002985.

Berner, R.A. and Z. Kothavala, 2001. “GEOCARB III: A Revised Model of Atmospheric CO2 over Phanerozoic Time”. American Journal of Science, v.301, pp.182-204, February 2001.

Christy, J. R., & McNider, R. T. (2017). “Satellite bulk tropospheric temperatures as a metric for climate sensitivity”. Asia‐Pacific Journal of Atmospheric Sciences, 53(4), 511–518. https://doi.org/10.1007/s13143‐017‐0070‐z

Hansen, J., I. Fung, A. Lacis, D. Rind, S. Lebedeff, R. Ruedy, G. Russell, and P. Stone, 1988. “Global climate changes as forecast by Goddard Institute for Space Studies three-dimensional model”. J. Geophys. Res., 93, 9341-9364, doi:10.1029/JD093iD08p09341

Hausfather, Z., Drake, H. F., Abbott, T., & Schmidt, G. A. ( 2019). “Evaluating the performance of past climate model projections”. Geophysical Research Letters, 46. https://doi.org/10.1029/2019GL085378

Royer, D. L., R. A. Berner, I. P. Montanez, N. J. Tabor and D. J. Beerling. “CO2 as a primary driver of Phanerozoic climate”. GSA Today, Vol. 14, No. 3. (2004), pp. 4-10

Link: https://wattsupwiththat.com/2019/12/06/climate-models-have-not-improved-in-50-years/

Übersetzt von Chris Frey EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"@ All

Ein Herr P. Dietze kritisiert hier in seinem Kommentar vom 13. Dezember 2019 um 9:54 Uhr, dass auf dem EIKE-Blog ganz unterschiedliche wissenschaftliche Auffassungen wiedergegeben werden können. EIKE ist aber im Gegenteil dafür zu loben, dass dort in guter wissenschaftlicher Tradition die Vertreter unterschiedlichster Hypothesen zu Wort kommen; denn allein das ermöglicht eine echte wissenschaftliche Auseinandersetzung und ist in der heutigen Zeit nicht unbedingt selbstverständlich.

AUFFORDERUNG AN DIESEN HERRN P. DIETZE: Dieser Herr möge hier auf der Kommentarfunktion von EIKE doch mal sein Verständnis von Wissenschaft darlegen und insbesondere seinen antiwissenschaftlichen Hang zu ad-hominem-Diffamierungen begründen.

Weiterhin kritisiert dort dieser Herr P. Dietze zum wiederholten Male Aussagen, die er offensichtlich gar nicht verstanden hatte, diesmal geht es um die adiabatische Höhenformel. In Teil 2 meiner THE-Analyse hatte ich unter „BEWEISFÜHRUNG zu (1.3)“ ausgeführt, Zitat:

„ … dann entspricht die vorgeblich durchschnittlich 14,8°C warme Erdoberfläche zunächst einem S-B-Strahlungsäquivalent von 390 W/m². Gegenüber der hohen Atmosphäre mit minus 18°C ergibt sich damit nach der Umgebungsgleichung des S-B-Gesetzes [Delta S = Sigma * (T4-T04)] aber ein Delta-Wärmefluss vom Wärmeren (Erdoberfläche) zum Kälteren (hohe Atmosphäre) von lediglich 155 W/m²:

(@NST = 14,8°C&390W/m²) 155 W/m² => (@T@70 = -18°C&235W/m²) 235 W/m² => Weltraum

Damit folgt die bekannte Differenz von [Delta S = 155 W/m²] exakt den HS der Thermodynamik und hat gar nichts mit einem „Treibhauseffekt“ oder einer „Gegenstrahlung“ zu tun, sondern ist allein den jeweils behaupteten Ortstemperaturen (T=14,8 °C) und (T0 = -18°C) geschuldet.“

In den Kommentaren zum Teil 1 meiner THE-Analyse hatte die EIKE-Admin einen Herrn Michael Krüger mit Kommentar vom 2. Dezember 2019 um 18:35 Uhr auf diese natürliche Strahlungsdifferenz von 155 W/m² zwischen (T0 = -18°C) und (T=14,8°C) festgenagelt, Zitat:

„Und diese Temperatur von – 18 ° in 5000 m Höhe lässt sich ziemlich genau nach der adiabatischen Höhenformel berechnen, wenn man als Ausgangswert 15 °C am Boden annimmt. Was bleibt da noch für den Treibhauseffekt übrig?“

Diese Frage konnte Herr Krüger im weiteren Diskussionsverlauf zu meiner THE-Analyse trotz mehrfacher Aufforderung nicht beantworten.

AUFFORDERUNG AN HERRN P. DIETZE: Erkläre er uns hier bitte mal zeitnah, was zwischen Erdoberfläche (T=14,8°C) und dem vorgeblichen Abstrahlungsniveau der Erde (T0 = -18°C) mit einer natürlichen S-B-Strahlungsdifferenz von 155 W/m² vom Warmen zum Kalten nach Anwendung der adiabatischen Höhenformel noch für den sogenannten Treibhauseffekt übrig bleibt.

Herr Weber, ich kann es nicht fassen dass Sie als Geophysiker trotz aller Kommentare immer noch nicht verstehen wie sehr Sie sich mit dem Hemisphärenansatz verrannt haben. Die rein solare Temperaturgenese – ohne Gegenstrahlung, ohne Atmosphäre, mit Albedo, mit S-B und cos – bei nicht rotierender Erde hatte (wie Sie es im Teil 1 korrekt zeigen) Prof. Gerlich bereits 1995 in Leipzig vorgestellt.

Damit ergibt sich auf der Sonnenseite – wofür die gesamte Einstrahlung von 478 W/m² „verbraucht“ wird – ein Mittelwert von 288 K (15 Grad) und auf der Nachtseite 0 K. Der globale Mittelwert war also (288+0)/2=144 K. Das sind -129 Grad und NICHT +15 Grad, und da fehlt auch kein Faktor 2. Wie Prof. Kramm kürzlich bestätigte, war damit keinesfalls beabsichtigt, einen TE von 144 Grad zu postulieren, sondern lediglich zu zeigen dass solch eine Berechnung mit S-B unsinnige Werte ergibt. Die Ursache war die Nichtberücksichtigung der Erdrotation mitsamt Wärmespeicherung und -umverteilung, was im Idealfall eine isotherme Erde und 155 K (-18 Grad) bei mittlerer Ein/Ausstrahlung von 239 W/m² ergibt, wie es ja allgemein behauptet wird.

Da bei Ihnen die Abstrahlung der Nachtseite fehlte (welche ja real nicht 0 K hat, sondern allenfalls etwa 3% weniger als die Tagseite), haben Sie fälschlich in S-B den Umgebungs-Korrekturterm -T2^4 eingeführt und T2 mit 255 K (-18 Grad) angesetzt. Damit wurde die Netto-Abstrahlung der Tagseite deutlich verringert und war somit für die Nachtseite verfügbar. Diese Korrektur ist grotesk falsch, denn 1. bestimmt nach S-B die Abstrahlung – und nicht die Nettostrahlung – die Temperatur, und 2. erfolgt ja die Berechnung für den Hemisphärenansatz ohne Atmosphäre (d.h. ohne Gegenstrahlung, also Abstrahlung nach 0 K). Sie führen hier einen TE ein um damit global die Nichtexistenz des TE nachzuweisen!! Offensichtlich haben Sie den Durchblick verloren.

Auch Ihre „adiabatische“ Höhenformel im Teil 2 ist Unsinn, denn die Atmosphäre ist ein offenes System und keinesfalls adiabatisch. Deshalb darf man aus dem statischen Luftdruck, der keine Wärme erzeugt, auch keinesfalls eine Temperatur berechnen. Sie können doch nicht einfach die barometrische (!) Höhenformel umbenennen! So könnten Sie auch die Temperatur einer Pressluftflasche bei 200 bar ausrechnen und damit Ihre Wohnung heizen. Sie hätten eigentlich den Wärmeffekt durch Luftdruck am Boden auch in Ihrer Hemisphären-Rechnung addieren müssen und hätten dann weit mehr als 288 K herausbekommen.

Also hören Sie endlich auf, EIKE und seine Leser mit Pseudophysik zu täuschen und die zahllosen Modellierer für blöd zu erklären. Was die von Ihnen gelobte Offenheit für verschiedene wissenschaftliche Hypothesen betrifft, stimme ich zu – allerdings nur insoweit es sich um verschiedene physikalisch KORREKTE Ansätze zur Berechnung von noch unbekannten Größen handelt – wobei natürlich die Ergebnisse nicht wesentlich voneinander abweichen anstatt völlig konträr zu sein. Will heißen, bei EIKE sollte wiss. Aufklärung und nicht Verwirrung gestiftet werden, also kein Autor erscheinen bei dem die Sonne um die Erde kreist oder die Erde eine Scheibe ist.

UNGLAUBLICH: Ein gewisszzzzzer Herr P. Dietze dient sich mit seinen Vermutungen über „physikalisch KORREKTE Ansätze“ jetzt auch noch als physikalisch korrekter Blogwart an.

ZU DEN AUSFÜHRUNGEN DIESES HERRN ZITIERE ICH SCIENCEFILES: „Deshalb kann man ein KO-Kriterium formulieren und feststellen, dass Personen, die Aussagen dennoch treffen, obwohl sie sie nicht begründen können, Personen, die Aussagen treffen, um Dritte zu diffamieren, herabzuwürdigen oder in sonst einer Weise negativ zu diskriminieren, also Personen, mit denen ihren Emotionen durchgehen und entsprechend der Verstand auf der Strecke bleibt, dass diese Personen keine Wissenschaftler sind.“

ERGO: Vexator fororum utgardensis est: https://tinyurl.com/yxs657jo

ÜBRIGENS, DIE KORREKTE ANTWORT WÄRE GEWESEN: Der mittlere Temperaturgradient von 0,65K/100m ergibt bei 5.000 m Höhe einen Temperaturabfall von 32,5K. Für den Treibhauseffekt sowie für die Herren Dietze und Krüger ist die Luft damit sehr dünn geworden…

==> Der mittlere Temperaturgradient von 0,65K/100m ergibt bei 5.000 m Höhe einen Temperaturabfall von 32,5K. Für den Treibhauseffekt sowie für die Herren Dietze und Krüger ist die Luft damit sehr dünn geworden…

Herr Weber, wenn Sie postulieren dass der Luftdruck (obwohl er definitiv keine Wärme erzeugt) die Bodentemperatur von -18 (!) auf +15 Grad erhöht und damit den TE verursacht, erklären Sie uns doch bitte wozu Sie überhaupt noch Ihre solar-hemisphärische Temperaturgenese brauchen, welche ja bereits 15 Grad ergibt.

Damit hätten wir schon einen doppelten TE, und wenn wir noch den echten, der ja durch die (gemessene) zusätzliche Gegenstrahlung am Boden entsteht (was Sie allerdings in Abrede stellen), dazunehmen, hätten wir einen dreifachen TE und statt 15 Grad etwa um die 80 Grad. Mit Ihrer Alien-Physik blamieren Sie nicht nur sich, sondern insbesondere auch EIKE.

zu: blamieren Sie … EIKE

Voll der xxxxxxxxxx, ein (Un!)Rechthaber der den eigenen Zeigefinger anbrüllt. Daß Sie nicht wissenschaftlich methodisch vorgehen wollen merkt jeder hier der etwas von Empirie versteht.

Da Sie Empirie ablehnen, z.B. MWP+LIA bei Ihrer heiligen CO2-Sensivität, sind wissenschaftliche Auseinandersetzungen mit P. Dietze genauso sinnentleert wie weiland bei NicoBaecker.

==> Von des 14 Datensätzen mit Beobachtungen bewegte sich die implizierte TCR zwischen 1,5°C und 2,0°C, im Mittel 1,79°C mit einem sehr kleinen Sigma von 0,13°C.

Mich erstaunt immer wieder die „Flexibilität“ von EIKE hinsichtlich der Kommunikation zur CO2-Sensitivität. Wenn man davon ausgeht dass TCR gut 2/3 von ECS ist, so ergibt sich das ECS vom Verfasser zu etwa 2,63 Grad – liegt also nur unwesentlich unter dem (um den Faktor 5 zu hohen) „best guess“ des IPCC von 3 Grad inklusive Feedback, welcher fälschlich und viel zu hoch aus Eisbohrkernen abgeleitet und dann etwa um den Faktor 4,5 reduziert wurde – soweit der Wostok-Eiskern (1985) zugrunde gelegt wird.

Wir erinnern uns dass Herr Limburg am 23.11. im Beitrag zur IKEK 13 verkündete dass es – aufgrund der solaren Temperaturgenese (Uli Weber) von im Mittel +15 Grad (mit Albedo, ohne Gegenstrahlung) auf der sonnenbeschienenen Hemisphäre gar keinen Treibhauseffekt gibt. Dabei wurde die Nachtseite der Erde offenbar vergessen, d.h. angenommen dass deren Abstrahlungsenergie (bei einer Kelvin-Temperatur die nur etwa 3% geringer ist) Null ist oder aus dem Nirwana stammt. Erwähnt wurde auch dass allein schon der Luftdruck die Temperatur am Boden so erhöht dass für einen TE kaum etwas übrig bleibt.

Abgesehen davon dass statischer Luftdruck keine Dauerwärme erzeugt (Energie erzeugendes Perpetuum Mobile) hätte man diesen vermeintlichen Temperatureffekt zu der solaren Temperaturgenese addieren müssen. Insbesondere hätte man die Aussagen anderer Vortragender zum Treibhauseffekt des CO2 berücksichtigen sollen um Widersprüche zu vermeiden.

Mein Eindruck ist, dass EIKE glaubt, die CO2-Sensitivität sei nach 40jähriger Forschung *) noch immer unbekannt und deshalb brauche man sich nicht zu bemühen, den in etwa korrekten und heute längst bekannten ECS-Wert von nur etwa 0,6 Grad zu kommunizieren. Mit diesem Wert wird CO2 zu einem SCHEINPROBLEM. Z.B. ergibt die Dekarbonisierung von Deutschland längerfristig nur 0,01 Grad.

*) Carbon Dioxide and Climate: A Scientific Assessment (Charney Report: National Research Council 1979)

„Mein Eindruck ist, dass EIKE glaubt, die CO2-Sensitivität sei nach 40jähriger Forschung *) noch immer unbekannt und deshalb brauche man sich nicht zu bemühen, den in etwa korrekten und heute längst bekannten ECS-Wert von nur etwa 0,6 Grad zu kommunizieren. Mit diesem Wert wird CO2 zu einem SCHEINPROBLEM. Z.B. ergibt die Dekarbonisierung von Deutschland längerfristig nur 0,01 Grad.“

Jetzt mal von Vorwürfen befreit, es ist eine sehr interessante Aussage. Diesen ECS-Wert von 0,6 Grad C errechnen mehrerer Autoren (Dietze, Burkel, Harde und wahrscheinlich noch andere). Sie, Herr Dietze, schon sehr sehr lange. Bei Ihnen liegt eine weitgehend nachvollziehbare analytische Rechnung zugrunde, die, soweit ich mich erinnere, auch die Rückstrahlung beinhaltet. Bei einigen Details bin ich bisher noch nicht ganz durchgestiegen – ist aber schon wieder eine Weile her. Auch Burkel rechnet analytisch, bei dem allerdings der Boden und die Verdunstung eine wesentliche Rolle spielt. Und bei Harde werden viele natürliche Einflüsse in seinem Computermodell berücksichtigt.

Sicherlich ist es unmöglich, solche möglicherweise noch offenen Fragen hier erschöpfend zu auszudiskutieren, ich habe sie auch nicht präsent. Deshalb hier meine ganz naive Frage: Was ist denn bisher die Hauptkritik an diesen sehr erfreulich niedrigen ECS-Werten? Oder liegt es daran, dass jeder Modellierer sein eigenes Modell präsentiert und bestehende Unterschiede nie ausdiskutiert werden? Haben Sie aufgrund Ihrer langjährigen Erfahrung Kenntnisse darüber, was die Besonderheiten des russischen Modells sind? Offenbar ebenfalls mit sehr niedrigen ECS-Werten und gemäß obigem Artikel angeblich falsifiziert?

Es wäre natürlich eine fantastische Sache, wenn man anhand klarer Ergebnisse die gesamte Klimadiskussion erschlagen könnte. Aber ich befürchte, das ist leider zu optimistisch…

Das mag wohl daran liegen, dass die Modelle auf den falschen Variablen aufbauen. Denn nur 2 Faktoren bestimmen das Klima: Sonne und Contrails. Damit lässt sich alles perfekt beschreiben respektive modellieren.

Ich würde mir selbst Punkte für Kreativität verleihen, wäre das nicht ohnehin bekannt und außer Frage stehend. Dass die Sonnenaktivität das Klima steuert, das Maunder-Minimum zur kleinen Eiszeit führte und es sogar bis in die 1970er Jahre hinein eine sehr gute Übereinstimmung gibt, das wissen wir alles längst.

Damit alleine hat die CO2 Hypothese schon ein Problem, denn um 1970 rum hätte das anthropogene CO2 längst ausreichen sollen die Erde um ca. 0.8°C zu erwärmen. Stattdessen: nichts!

Erst ab den 1970ern gibt es eine autonome, von der Sonnenaktivität unabhängige Erwärmung des Klimas, die aber wiederum perfekt mit der Zunahme des Flugverkehrs übereinstimmt. Dass die durch das Fliegen erzeugten Kondensstreifen die Erde erwärmen, steht derweil völlig außer Frage, auch wenn man bei der korrekten Quantifizierung noch auf wackeligen Beinen steht.

https://www.spiegel.de/wissenschaft/mensch/kondensstreifen-heizen-die-erde-immer-staerker-auf-a-1274340.html

Seltsamer Weise nun weigern sich typische „Klimaforscher“ aber beharrlich diesen Faktor zu benennen oder gar zu berücksichtigen. Da hat wohl jemand Angst die Toten zu wecken. Modelliert man erst mal mit Contrails müsste man sich schnell fragen, wozu man überhaupt noch CO2 braucht.

PS. falls sich das jemand fragt: Sind wir nicht schon vor 1970 geflogen? Ja, aber erstens viel weniger und zweitens hauptsächlich mit Propellermaschinen die niedriger fliegen und daher kaum Contrails erzeugen. Es gibt eigentlich nur eine Ausnahme wo vor 1970 hoch und viel geflogen wurde, das war der 2te Weltkrieg und das hohe Fliegen hatte taktische Gründe (wegen Flak usw.). Tatsächlich wurden im 2.WK fast 800.000(!) Flugzeuge produziert. Und ja, auch in diese Zeit fällt eine Temperaturspitze die über die Sonnenaktivität hinaus reicht.

Interessanter Effekt. Normalerweise führt Bewölkung (und nichts anderes sind Kondensstreifen) zu Abkühlung. Aber angeblich nicht, wenn es sich um Wolken in großer Höhe handelt. Warum Wolken in großer Höhe letztendlich zur Erwärmung beitragen sollen, das habe ich bisher noch nicht verstanden. Denn das Verhältnis von reflektierten Sonnenlicht an der Oberseite zu vermehrter IR-Abstrahlung nach unten sollte sich doch nicht wesentlich ändern. Im Gegenteil: In großer Höhe sind die Temperaturen niedriger, also weniger IR-Abstrahlung. Sollte es dennoch einen Wärmestau geben, dann kann IR-Strahlung von dort oben leichter in den Weltraum entweichen, auch handelt es sich um keine geschlossene Wolkendecke.

Ich folge Zeke Hausfather auf Twitter (@hausfath)und halte ihn für einen Lügner, der weiß, dass er lügt. Ich merke es daran, dass er mich mit meinen recht bissigen Kommentaren nicht blockt und er bekommt nicht genug um die zu überlesen (<10). Der reimt sich da täglich einen Quatsch zusammen, unglaublich.

Nach neuen Klimamodellen hat sich die Klimasensitivität dann auch von 1,5-4,5° auf 1,8-5,6° erhöht, obwohl die schon vorher heiß liefen. Schon praktisch, wenn dann NOAA/NASA die Temperaturen an die Modelle anpassen als umgekehrt.

Wenn ich mir die Temperatur-Anomalien nicht erst seit heute anschaue…

https://climatereanalyzer.org/wx/DailySummary/#t2anom

… sehe ich einige Schnittmengen mit der letzten Eiszeit. Unter anderem Alaska war weitestgehend eisfrei, während der Osten der USA unter teils kilometerdickem Eis lagen und auch jetzt wieder kommt regelmäßig seit Jahren Arktische Kälte in die USA, wo es bis auf die Küsten das ganze Jahr zu kalt war. Kalifornien war während der letzten Eiszeit sogar teilweise wärmer als heute und wer die Dansgaard-Oeschger-Events kennt, kann eigentlich auch nichts mehr für unmöglich halten:

Interessant!

Hm, Kurven, die eigentlich erschrecken. Im Schluss wird dann alles relativiert… Warum ist z.B. das russische Modell bereits falsifiziert? Weil der „gemessene“ Anstieg der letzten 37 Jahre steiler war?? Obwohl wir wissen, dass hier eine 60 bis 70-jährige Periodizität ganz entscheidend mitwirkt? Man bei Berücksichtigung von Sonne/Weltraumstrahlung/Wolkenbildung und/oder Verdampfungswärme bei einer Klimasensitivität von 0,6 Grad C landet? (Harde, Burkel u.a.) Und wir wissen, dass bei den Temperaturmessungen unentwegt besch… wird? Es die Urbanisierungs- uns Landnutzungseffekte gibt? Geht man davon aus, dass das CO2 in der Atmosphäre unentwegt ansteigt, solange wir nicht vollkommen dekarbonisiert haben? Nur wegen des relativ geringen menschlichen Beitrags?? Obwohl es hier ganz andere Rechnungen gibt (z.B. Lüdecke)?

Angesichts solcher Kurven und Tabellen bleibt uns wirklich nur die Hoffnung, dass es endlich kälter wird. Dann werden wir sicherlich weiter „bei Laune“ gehalten, dass dies ja nur eine kurze Verzögerung sei. Bis dann unsere Urenkel mit der kommenden Eiszeit in Angst und Panik versetzt werden…

Wenn man heute wieder Frau von der Leyen gehört hat, sind unsere Politiker (und wir leider mit ihnen) die perfekten Opfer dieser Klima-Paranoia.

Es gibt schlicht keine physikalische Theorie zum großräumigen / langfristigen Verhalten der Erdatmosphäre („Temperatur“). Wenn überhaupt, dann vielleicht irgendwann für die Erde als ganzes oder besser gleich das Sonnensystem. Nur wird diese einfache Wahrheit überspült von einem Ozean aus Jauche.

Was besagt schon ein Klimamodell, wenn dessen Grundlage auf dem Vorkommen von Wetter basiert, das selbst nichtmal 14 Tage vorhergesehen werden kann, ausser, dass es im Winter kälter ist als im Sommer?

Es grenzt also an Hybris zu meinen das Klima vorhersagen zu können, … und dies alleine auf dem Faktor CO2 basierend. Irgendwie kaum zu glauben!

CO2 ist viel zu träge gegenüber Wasser als Wettertreiber, dass es einen erheblichen Anteil am Vorkommen von Wetter leisten könnte. Hat also kaum Volumenänderungsarbeit die mit der Temperatur einhergeht um Luftmassen zu bewegen also Wetter zu beeinflussen. Und „Klima“ soll nunmal Wetter statistisch gemittelt über 30 Jahre sein um es in Zahlen fassen zu können, also ein allein nur von Menschen beliebig festgelegtes Konstrukt, um mal darüber reden zu können.

Es existiert keine Menschen gemachte mathematische Beschreibung für das Vorausberechnen von Wetter in 4 Wochen, also auch keine fürs Klima.

Nichtmal existiert dafür eine Norm und darauf sollen wir vertrauen, na dann gut Nacht!

Die Lösung ist ganz einfach.

Es gibt keinen zusätzlichen Antrieb, bei Erhöhung der CO2 Konzentration. Ob Treibhauseffekt oder nicht. Erhöhung der CO2 Konzentration in der Atmosphäre führt zu keinem zusätzlichen Antrieb.

Die Strahlungsmodelle sind falsch, weil sie von ungestörten Spektren ausgehen. Faktisch ist aber die Abstrahlung von CO2 in der unteren Atmosphäre durch die Stöße mit anderen Molekülen praktisch nahe 0.

Antrieb (Forcing) durch CO2 Erhöhung ergibt sich aber nur bei Emission nahe 1.

Dadurch liefern alle Atmosphärenmodelle unsinnige Ergebnisse. GiGo!

Aber anstatt die Strahlungsmodelle genauer zu untersuchen, dort den Fehler, bzw, das Nichtwissen nachzuweisen, halten sich alle an den Atmosphärenmodellen auf.

Mit fehlerhaften Annahmen und Ausgangswerten liefert jede Berechnung falsche Ergebnisse.

Der Punkt ist doch der, daß die VooDoo Science weiß, daß der Antrieb minimal sein muß. Darauf kommt man zwangsläufig, wenn man die Vergangenheit mit den gemessenen Temparaturen nachmodelliert. Je weniger Antrieb, umso beseer passt es.

Aber dann wäre das schöne Thema tot und mit ihm das noch schönere öffentliche funding! Das geht gar nicht. Deshalb wird das tote Pferd Atmosphärenmodell weiter geritten, denn – merke! – kein Pferd kann so tot sein, daß man es nicht reiten könnte. Ich glaub, das weiß sogar Frau Merkel. Aber die braucht die Hysterie für die große gesellschaftliche Transformation, damit der Normalbürger nicht mekt, was da im Gange ist!

Die Lösung ist dch viel einfacher:

Die Ergebnisse der Wettermodelle werden so interpretiert, dass man für die vorhergesagte Temperatur eine Abweichung von 2-3 Grad für normal hält und es praktisch jedem bewusst ist, dass im Extremfall eine Abweichung von 10 Grad auftreten kann. Da nun mal Simulaion und Natur nicht übereinstimmen.

Der Unterschied zwischen eine Wettersimulation und eine langfristige Klimasimulation ist, dass beim Wetter die physikalische Zusammenhänge soweit bekannt sind, bei langfristigen Klimaveränderungen mehr oder weniger spekuliert wird.

Also kann man die Fehlerquote der Simulationen beim Wetter zwischen 2 und 10 Grad ansetzen, beim Klima zwischen 2 und 20…50…xxx Grad.

Und einfach das Ganze dem Gott oder der Natur überlassen, je nach Glaubenrichtung.