Vier Tage später veröffentlichte Roy Spencer Kritik an meiner Analyse bei WUWT, und zwar hier ebenso wie auf seinem eigenen Blog hier. Am nächsten Tag folgte bei WUWT hier ein Folgebeitrag dazu. Auf seinem Blog finden sich auch zwei weitere Kritiken, nämlich hier und hier.

Komischerweise postete Roy drei Tage vor seiner Kritik an meiner Arbeit einen Beitrag mit dem Titel [übersetzt] „Die Komponente des Glaubens bei Globale-Erwärmung-Prophezeiungen“ (hier). Er kam zu dem Ergebnis, dass Klima-Modellierer lediglich gezeigt hätten, was sie von Anfang an vermutet hatten. Sie machen sich eines Zirkelschlusses schuldig und haben eine Doppelaussage abgegeben.

Roy folgerte: „Ich sage nicht, dass ein zunehmender CO2-Gehalt keine Erwärmung verursacht. Ich sage, dass wir keine Ahnung haben, wie viel Erwärmung es verursacht, weil wir keine Ahnung haben, wie groß das natürliche Energie-Ungleichgewicht im Klimasystem ist während der letzten – sagen wir – 50 Jahre. … Folglich weisen Projektionen der globalen Erwärmung einen großen Anteil von Glauben auf, der in die Modelle einprogrammiert wurde“.

Roys Schlussfolgerung entspricht ziemlich genau derjenigen in meiner Studie, welche der danach kritisierte.

In diesem Beitrag werde ich die Kritikpunkte von Roy an meiner Arbeit aufgreifen und zeigen, warum jeder einzelne dieser Kritikpunkte falsch ist.

Welche Punkte kritisiert er nun? Er sagt:

1) Meine Fehlerfortpflanzung prognostiziert sehr große Abweichungen der Temperatur.

2) Klimamodelle weisen KEINE substantiellen Fehler in ihrem Gesamt-Energiefluss an der Obergrenze der Atmosphäre [TOA] auf.

3) Das Modell der Fehlerfortpflanzung ist für Klimamodelle nicht geeignet!

Darum soll es im Folgenden gehen. Es wird ein langer Beitrag. Falls man es in einem Satz zusammengefasst haben will: alle Kritikpunkte von Roy zeigen, dass er etwas erheblich falsch verstanden hat.

1) Meine Fehlerfortpflanzung prognostiziert sehr große Abweichungen der Temperatur.

Roy schrieb: „Frank zieht in seiner Studie als Beispiel einen bekannten Bias heran beim langwelligen (infrarot) Wolken-Antrieb (LWCF) in einem typischen Klimamodell und vermutet, dass der typische Fehler des Modells (±4 W/m²) im LWCF auf seine nachgebildete Modellgleichung angewendet werden kann, was den Fehler zeitlich in die Zukunft fortsetzt während der Integration in seinem nachgebildeten Modell. Die Folge ist eine gewaltige falsche Modell-Erwärmung (oder -Abkühlung) bis zu 20°C oder mehr bei der zukünftigen mittleren Lufttemperatur (GASAT). (Hervorhebung von mir [= dem Autor])

Für jedermanns Aufmerksamkeit – Roy fährt fort: „Die Modellierer sind sich dieser Verzerrungen (im Wolkenanteil) sehr bewusst, welche positiv oder negativ sein können, abhängig vom Modell. Die Fehler zeigen (beispielsweise), dass wir den Einfluss der Wolken nicht verstehen ebenso wie alle Prozesse, die deren Entstehung und Auflösung bewirken aufgrund grundlegender physikalischer Prinzipien. Anderenfalls würden alle Modelle in etwa die gleiche Wolkenmenge ergeben“. Bitte kein weiteres Auslassen des mittleren quadratischen Fehlers [root-mean-square-error].

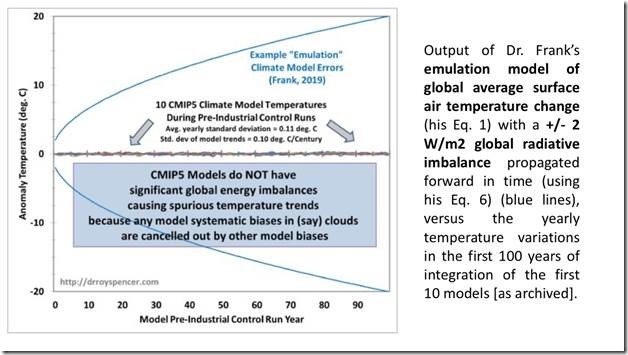

Hier folgt Abbildung 1 bei Roy, welche seinen ersten großen Fehler belegt. Die beweiskräftigen Worte habe ich hervorgehoben:

Bildinschrift [rechts]: Ergebnis des nachgebildeten Modells der Änderung der globalen Lufttemperatur von Dr. Frank (seine Gl. 1) mit einem globalen Strahlungs-Ungleichgewicht von ±2 W/m², was sich mit der Zeit fortpflanzt (unter Anwendung seiner Gl. 6; blaue Linien). Dies im Vergleich zu den jährlichen Temperatur-Variationen über die ersten 100 Jahre der ersten 10 Modelle.

Roys blaue Linien sind keine nachgebildeten Lufttemperaturen unter Anwendung von Gleichung 1 aus der Studie. Sie folgen nicht aus Gleichung 1 und repräsentieren überhaupt nicht physikalische Lufttemperaturen.

Sie stammen aus den Gleichungen 5 und 6 und stellen die anwachsenden Unsicherheits-Grenzen dar bei der projizierten Lufttemperatur. Unsicherheits-Statistiken sind keine physikalischen Temperaturen.

Roy hat seine ±2 W/m² als Strahlungs-Ungleichgewicht missverstanden. Im ganzen Zusammenhang meiner Analyse sollte man es sehen als eine ±2 W/m²-Unsicherheit des langwelligen Wolkenantriebs (LWCF). Es ist ein statistischer Wert und kein Energiefluss.

Noch schlimmer: falls wir Roys ±2 W/m² als Strahlungs-Ungleichgewicht in eine Modellsimulation einfließen lassen würden – eine, die zu einem Ausschlag der simulierten Lufttemperatur führt (was Roy meint), dann müssten wir annehmen, dass das Ungleichgewicht gleichzeitig positiv und negativ ist, d. h. ein ±-Strahlungsantrieb.

Ein ±-Strahlungsantrieb alterniert nicht zwischen +-Strahlungsantrieb und –-Strahlungsantrieb. Vielmehr treten beide sofort gleichzeitig auf.

Also folgen aus Roys Interpretation des LWCF-±-Fehlers als ein Ungleichgewicht im Strahlungsantrieb simultan positive und negative Temperaturen.

Man betrachte noch einmal Roys Abbildung. Er zeigt die nachgebildete Lufttemperatur gleichzeitig als ein Heiß-Haus und ein Eis-Haus mit sowohl +20°C als auch -20°C nach 100 Jahren. Das ist die unsinnige Botschaft von Roys blauen Linien, falls wir seine Interpretation übernehmen, dass die ±2 W/m² ein Strahlungs-Ungleichgewicht ist.

Diese physikalisch unmögliche Bedeutung hätte eigentlich schon der grundlegende Hinweis darauf sein müssen, dass die zugrunde liegende Annahme falsch war.

Das ± ist schließlich nicht entweder das Eine oder das Andere, plus oder minus. Es ist zusammenfallend plus und minus, weil es Teil der RMSE-Unsicherheits-Statistik ist. Es wird nicht angewendet auf einen physikalischen Energiefluss.

Es ist wirklich komisch. Mehr als einer von meinen Begutachtern machte den gleichen sehr naiven Fehler, dass ±C = physikalisch real +C oder -C sind. Stellvertretend hierfür das folgende Zitat, was in der Supporting Information erwähnt wird:

„Die Fehlerfortpflanzung des Autors ist physikalisch nicht gerechtfertigt. Beispiel: selbst nach der Stabilisierung der Antriebe, würde die Analyse des Autors ergeben, dass die Modelle sogar noch heftiger zwischen Schneeball und Runaway-Treibhaus-Zuständen hin und her schwingen. Was – und das sollte offensichtlich sein – tatsächlich nicht der Fall ist“.

Hier fehlt eindeutig jedes Verständnis für eine Unsicherheits-Analyse.

Genauso ist auch dieser erste Teil von Roys Punkt 1 vollkommen missverstanden.

Nächster Fehler in der ersten Kritik: Roy sagt, dass die nachgebildete Gleichung nicht die flach verlaufende GCM-Linie aus dem Kontrolllauf in seiner Abbildung 1 spiegelt.

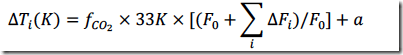

Allerdings würde die nachgebildete Gleichung 1 wirklich die gleiche flache Linie ergeben wie aus den GCM-Kontrollläufen mit Null externem Antrieb. Als Beleg folgt hier Gleichung 1:

In einem Kontrolllauf gibt es keine Änderung des Antriebs, daher Dfi = 0. Der Term in Klammern wird dann zu F0/F0 = 1.

Das auslösende FCO2 = 0,42, so dass sich Gleichung 1 ergibt zu DTi(K) = 0,42´33K´1 + a = 13,9 C +a = konstant (a = 273,1 K oder 0°C).

Zieht man eine Anomalie heran, ist die nachgebildete Temperaturänderung konstant Null, genau wie in den GCM-Kontrollläufen in Roys Abbildung 1.

Roys erster Einwand weist also drei Fehler auf:

1) Roy verwechselt einen RMS statistische Unsicherheit im simulierten LWCF als ein physikalisches Strahlungs-Ungleichgewicht.

2) Dann missversteht er eine ±-Unsicherheit der Lufttemperatur als eine physikalische Temperatur.

3) Seine Analyse der nachgebildeten Gleichung 1 war unachtsam.

Weiter mit Punkt 2 von Roy:

Klimamodelle weisen KEINE substantiellen Fehler in ihrem gesamt-Energiefluss an der Obergrenze der Atmosphäre [TOA] auf.

Roy schrieb: „Falls irgendein Klimamodell an der TOA einen Bias des Energieflusses von der Größe von 4 W/m² aufweist, würde sich eine substantielle falsche Erwärmung oder Abkühlung ergeben. Beides ist nicht der Fall“.

Im Folgenden werde ich zeigen, warum dieser Einwand irrelevant ist.

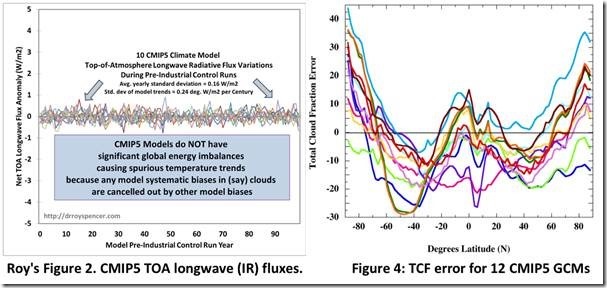

Hier folgt jetzt Roys zweite Abbildung, die wiederum das perfekte Strahlungs-Gleichgewicht der CMIP5-Modelle an der TOA zeigt. Rechts neben Roys Abbildung befindet sich Abbildung 4 aus der Studie, welche den jährlichen Fehler des Gesamtanteils der Wolken in 12 CMIP5-Klimamodellen zeigt, im Mittel ±12,1%. [1]:

Jedes einzelne der CMIP5-Modelle, welches einen Fehler von ±12,1% des simulierten Gesamt-Wolkenanteils erzeugte, erzeugte auch Roys perfektes Strahlungs-Gleichgewicht an der TOA. Daher erzeugte jedes einzelne CMIP5-Modell, welches einen LWCF-Fehler von gemittelt ±4 W/m² zeigte, ebenfalls das perfekte Strahlungsgleichgewicht an der TOA von Roy.

Wie kann das sein? Wie können Modelle ein perfektes TOA-Gleichgewicht einhalten und gleichzeitig Fehler beim langwelligen Wolkenantrieb erzeugen?

Indem sich Fehler ausmitteln. Von GCMs wird ein TOA-Gleichgewicht gefordert. Also werden die Parameter innerhalb ihrer Unsicherheits-Bandbreite so adjustiert, dass jenes Ergebnis herauskommt.

Roy sagt das auch selbst: „Falls ein Modell in ein globales Energie-Gleichgewicht gezwängt wurde, dann haben sich die Verzerrungen in de Strahlungsfluss-Komponenten herausgemittelt. …“.

Sind die gewählten GCM-Parameterwerte physikalisch korrekt? Das weiß niemand.

Sind die Parameter-Sätze von Modell zu Modell identisch? Nein. Wir wissen das, weil verschiedene Modelle verschiedene Profile erzeugen ebenso wie integrierte Intensitäten des TCF-Fehlers.

Dies nimmt Roys Einwänden bzgl. der TOA jede Grundlage.Modelle zeigen ein TOA-Gleichgewicht und einen LWCF-Fehler gleichzeitig.

In jedem Falle kommt man hier zu dem oben und in der Studie erwähnten Punkt, dass ein simuliertes Klima ein perfektes TOA-Gleichgewicht aufweist, während gleichzeitig der simulierte Klima-interne Energiezustand nicht korrekt ist.

Das bedeutet, dass die den simulierten Klimazustand beschreibende Physik nicht korrekt ist. Und dies wiederum bedeutet, dass die Physik zur Beschreibung der simulierten Lufttemperatur nicht korrekt ist.

Die simulierte Lufttemperatur beruht nicht auf physikalischem Wissen. Und das bedeutet, dass es eine große Unsicherheit bei der projizierten Lufttemperatur gibt, weil wir keine physikalisch gute kausale Erklärung für dieselbe haben.

Die Physik kann sie nicht beschreiben; das Modell kann es nicht lösen. Die offensichtliche Sicherheit bei der projizierten Lufttemperatur ist ein schimärisches Ergebnis von Frisieren.

Das ist die entscheidende Grundlage einer Unsicherheits-Analyse. Man kann die Messgrößen korrekt ermitteln. Aber wenn die falsche Physik die richtige Antwort gibt, hat man nichts gelernt und man versteht nichts. Die Unsicherheit im Ergebnis ist also konsequenterweise groß.

Diese falsche Physik ist in jedem einzelnen Schritt einer Klima-Simulation präsent. Die berechneten Lufttemperaturen fußen nicht auf einer physikalisch korrekten Theorie.

Roy sagt, dass der LWCF-Fehler unbedeutend ist, weil sich alle Fehler gegenseitig ausgleichen. Dazu weiter unten mehr. Aber man beachte, was er sagt: Die falsche Physik gestattet die richtige Antwort. Und das unveränderlich in jedem Schritt einer Projektion über 100 Jahre.

In seiner Kritik vom 12. September liefert Roy seinen Grund, warum er nicht an eine Unsicherheits-Analyse glaubt: „Alle Modelle zeigen die Auswirkungen anthropogener CO2-Emissionen, trotz bekannter Komponenten ihrer Energieflüsse (wie Wolken)! Warum?

Falls ein Modell in ein globales Energie-Gleichgewicht gezwängt worden ist, dann haben sich die Verzerrungen der Komponenten des Energieflusses herausgemittelt. Belegt wird dies durch die Kontrollläufe der verschiedenen Klimamodelle in ihrem (langwelligen Infrarot-)Verhalten“.

Da haben wir es: eine falsche Physik, die unveränderlich korrekt ist bei jedem Schritt über eine 100-Jahre-Projektion, weil jedwede großmaßstäbliche Fehler sich ausgleichen, um die Auswirkungen kleiner Störungen zu enthüllen. Ich glaube nicht, dass irgendeine andere Fachrichtung der physikalischen Wissenschaft eine solche Behauptung durchgehen lassen würde.

Roy präsentierte dann noch einmal die TOA-Strahlungs-Simulationen links im zweiten Satz der Abbildungen oben.

Er schrieb, dass die Modelle in ein TOA-Gleichgewicht gezwängt werden. Das heißt, der physikalische Fehler, der als TOA-Ungleichgewicht auftauchen würde, würde zwangsweise auf die simulierten Klima-Untersysteme verteilt.

Die Modelle zwangsweise in ein TOA-Gleichgewicht zu bringen kann sogar simulierte Klima-Untersysteme noch fehlerhafter daher kommen lassen als es anderenfalls der Fall wäre.

Nach der Beobachtung, dass das „erzwungene Ausgleichen des globalen Energie-Haushaltes“ nur einmal bei den „vorindustriellen Kontrollläufen über viele Jahrhunderte“ durchgeführt worden war, beobachtete Roy, dass sich die Modelle weltweit ähnlich verhalten, trotz einer „ERHEBLICHEN Vielfalt von Fehlern in den Energiefluss-Komponenten…“

Das ist eine interessante Aussage von Roy angesichts des Umstands, dass es einen Faktor von fast drei gibt in den Unterschieden der Modelle untereinander hinsichtlich ihrer Sensitivität auf eine CO2-Verdoppelung. [2], [3]

Stephens [3] schreibt: „Weithin glaubt man, dass die Diskrepanz Unsicherheiten bei der Rückkopplung durch Wolken geschuldet ist. … Abbildung 1 zeigt die Änderungen der tiefen Wolken, wie sie von zwei Versionen von Modellen prognostiziert werden, die an jedem Ende der Bandbreite von Erwärmungs-Reaktionen liegen. Die von einem Modell prognostizierte reduzierte Erwärmung ist eine Folge von vermehrter tiefer Bewölkung in jenem Modell, während die verstärkte Erwärmung des anderen Modells auf eine verringerte tiefe Bewölkung zurückzuverfolgen ist“.

Aha! Zwei CMIP5-Modelle zeigen entgegen gesetzte Trends des simulierten Wolken-Anteils als Reaktion auf einen CO2-Antrieb. Nichtsdestotrotz reproduzieren beide Modelle den historischen Trend der Lufttemperatur.

Nicht nur das, sondern sie sind vermeintlich invariabel korrekt in jedem Schritt der 100-Jahre-Projektion, weil sich ihre großmaßstäblichen Fehler ausgleichen, um die Auswirkungen kleiner Störungen zu enthüllen.

In Stephens Beispielobjekt können wir sehen, wie die versteckte Simulations-Unsicherheit sich manifestiert. Modelle reproduzieren auf Biegen und Brechen Kalibrierungs-Messgrößen und werden mit dieser Grundlage als fähig hinaus posaunt, dass sie zukünftige Klimazustände genau prognostizieren können.

Das Beispiel von Stephens zeigt eindeutig, dass GCMs schlicht und ergreifend nicht die Reaktion der Bewölkung auf CO2-Emssionen auflösen können. Daher können die GCMs auch nicht die Änderung der Lufttemperatur auflösen, falls diese überhaupt auftreten durch CO2-Emissionen. Von deren projizierten Lufttemperaturen ist nicht bekannt, dass sie physikalisch korrekt wären. Sie haben keine physikalische Bedeutung.

Dies ist die Ursache der großen und schrittweise zunehmenden Simulations-Unsicherheit bei der projizierten Lufttemperatur.

Dies umgeht Roys Punkt hinsichtlich sich ausgleichender Fehler. Die Modelle können die Reaktion der Wolken auf den CO2-Antrieb nicht auflösen. Das Beseitigen der Fehler bzgl. des Strahlungsantriebs schafft dieses Problem nicht aus der Welt. Eine derartige Beseitigung (mittels händischem Frisierens) versteckt die Simulations-Unsicherheit nur auf trügerische Weise.

Roy folgert: „folglich demonstrieren die Modelle selbst, dass ihre Vorhersagen bzgl. globaler Erwärmung nicht abhängig sind von jenen Bias-Fehlern in den Komponenten der Energieflüsse (wie etwa die globale Wolkenbedeckung), wie von Dr. Frank behauptet“.

Jeder sollte wissen, warum diese Folgerung falsch ist. Sich ausgleichende Fehler machen Modelle einander ähnlich. Sie machen die Modelle aber nicht genauer. Auch werde dadurch nicht physikalische Beschreibungen verbessert.

Roys Folgerung enthüllt implizit seinen Denkfehler.

1) Die Unfähigkeit der GCMs, die Bewölkungs-Reaktion darzustellen bedeutet, dass die Konsistenz von Temperaturprojektionen der Modelle untereinander ein schimärisches Artefakt ihrer Bearbeitung ist. Die Unsicherheit verbleibt in der Projektion, sie ist lediglich verborgen.

2) Der LWCF-rsme von ±4 W/m² ist kein konstanter offset bias error. Allein das ,±‘ sollte ausreichen, um jedermann klar zu machen, dass hiermit kein Energiefluss repräsentiert wird.

Der LWCF-rsme von ±4 W/m² repräsentiert eine Unsicherheit im simulierten Energiefluss. Es ist in keiner Weise ein physikalischer Fehler.

Man kann das Modell frisieren, um überhaupt keinen beobachtbaren Fehler im Kalibrierungs-Zeitraum zu erzeugen (Simulation minus Beobachtung = 0). Aber die der Simulation zugrunde liegende Physik ist falsch. Die Kausalität tritt nicht zutage. Die Simulation vermittelt keine Informationen. Das Ergebnis ist nicht irgendein Indikator physikalischer Genauigkeit. Die Unsicherheit ist nicht beseitigt.

3) Alle Modelle mit jenen Fehlern werden dann erzwungenermaßen in ein TOA-Gleichgewicht gebracht. Jene TOA-gleichgewichteten CMIP5-Modelle machen Fehler von ±12,1% beim globalen TCF [1]. Dies bedeutet, dass die GCMs die Bewölkung nicht mit einer besseren Auflösung simulieren können als mit ±12,1%.

Um die Auswirkungen jährlicher CO2-Emissionen maximal aufzulösen, müssen sie eine Wolken-Auflösung von etwa 0,1% aufweisen (siehe Anhang 1 unten).

4) Der mittlere GCM-Fehler bei der simulierten TCF über den Kalibrierungs-Zeitraum in der Vergangenheit enthüllt den Kalibrierungs-Fehler des simulierten langwelligen Wolken-Antriebs. Obwohl durchweg ein TOA-Gleichgewicht aufrecht erhalten wird, geht die korrekte Größenordnung des simulierten troposphärischen thermischen Energieflusses innerhalb eines Unsicherheits-Intervalls von ±4 W/m² verloren.

Zu Roys Punkt 3): Das Modell der Fehlerfortpflanzung ist für Klimamodelle nicht geeignet!

Auf seinem Blog schrieb Roy, dass die Modellierung des Klimas in etwa der Modellierung von Kesseln mit heißem Wasser gleicht. Und so: „Falls unser Modell eine konstante Wassertemperatur bekommen kann, wissen wir, dass jene Raten von Energie-Zufuhr und -Verlust gleich sind, obwohl wir deren Werte nicht kennen. Und dass falls wir das Modell mit ein wenig mehr Abdeckung des Topfes durch einen Deckel laufen lassen, wissen wir, dass die modellierte Wassertemperatur zunehmen wird. Jener Teil Physik steckt immer noch im Modell“.

Roy weiter: „Die Temperaturänderung von irgendwas, einschließlich des Klimasystems, ist einem Ungleichgewicht geschuldet zwischen Energiegewinn und Energieverlust des Systems“.

Roy impliziert hier, dass die einzige Möglichkeit einer Temperaturänderung einer Zunahme oder Abnahme der Gesamt-Energie im Klimasystem geschuldet ist. Das ist jedoch nicht richtig.

Klima-Subsysteme können Energie austauschen. Die Lufttemperatur kann sich ändern durch eine Umverteilung interner Energieflüsse ohne jede Änderung der Gesamtenergie, welche in das Klimasystem hinein oder aus demselben wieder hinaus geht.

So sagte beispielsweise Richard Lindzen im Jahre 2001 bei einer Anhörung des Environment and Public Works Committee des US-Senats am 2. Mai: „Behauptungen, wonach der Mensch irgendeinen Anteil an der beobachteten Erwärmung hätte, basieren auf der Hypothese, dass die Modelle die natürliche Variabilität korrekt erfasst haben. Allerdings erfordert die natürliche Variabilität keinerlei externe Antriebe – seien diese nun natürlichen oder anthropogenen Ursprungs [4].

Genau das Gleiche äußerte Lindzen in seinem Beitrag mit dem Titel Some Coolness Concerning Global Warming. [5]:

„Die genaue Ursache der natürlichen Variabilität ist nach wie vor unbekannt, aber das ist keine allzu große Überraschung. Obwohl die in das Erde-Ozean-Atmosphäre-System einfallende Solarstrahlung relativ konstant ist, ist das bei dem Grad, mit dem diese Energie in den Ozeanen gespeichert und wieder freigesetzt wird, nicht der Fall. Folge: Die der Atmosphäre zur Verfügung stehende Energie allein ist alles andere als konstant … tatsächlich war unser Klima schon sowohl wärmer als auch kälter als heute – allein der natürlichen Variabilität des Systems geschuldet. Externe Einflüsse sind für eine derartige Variabilität kaum vonnöten“.

In seiner Begutachtung des Artikels von Stephen Schneider „Laboratory Earth“ beschrieb er diese direkt relevante Beobachtung:

„Eine Verdoppelung des CO2-Gehaltes in der Atmosphäre führt zu einer Störung des Energie-Gleichgewichts in derselben um zwei Prozent. Aber die Modelle, die zur Prognose der Reaktion der Atmosphäre auf diese Störung herangezogen werden, weisen Fehler in der Größenordnung von zehn Prozent auf hinsichtlich ihrer Repräsentation des Energie-Gleichgewichtes, und diese Fehler involvieren neben Anderem die Rückkopplungen, welche für die resultierenden Berechnungen grundlegend sind. Folglich sind die Modelle kaum brauchbar bei der Abschätzung der klimatischen Reaktionen auf solche feinen Störungen. Außerdem, die starken Reaktionen (korrespondierend mit hoher Sensitivität) der Modelle auf die kleinen Störungen durch eine CO2-Verdoppelung hängen grundlegend ab von positiven (verstärkenden) Rückkopplungen von Prozessen, die nachweislich von den Modellen ganz falsch repräsentiert werden“.

Diese Beobachtungen sind bereits ausreichend, um Roys Beschreibung der Modellierung von Lufttemperaturen zu widerlegen, analog zu der Wärme, die einem Topf mit kochendem Wasser hinzugefügt und von diesem wieder abgegeben wird – mit unterschiedlich starker Abdeckung durch einen Deckel.

Vor allem der letzte Punkt von Lindzen widerspricht der Behauptung von Roy, dass die Ausmittelung von Simulationsfehlern eine zuverlässige modellierte Reaktion zulässt auf Antriebe oder auf genau projizierte Lufttemperaturen.

Außerdem ist die Lage sehr viel komplexer als Roy es in seiner Analogie mit dem kochenden Wassertopf beschrieben hat. Zum Beispiel, anstatt des einen Deckels in Roys Beispiel ähneln Wolken mehr multiplen Schichten siebartiger Deckel mit variierender Maschenbreite und Dicke, alle in konstanter Bewegung, und keiner davon bedeckt den ganzen Topf.

Die Topf-Modellierung geht dann weiter mit lediglich einer schwachen Darstellung, wo sich die verschiedenen Deckel zu jeder gegebenen Zeit befinden und ohne deren Tiefe oder Porosität vollständig zu verstehen.

Fehlerfortpflanzung: Ist eine mittlere jährliche Zunahme des CO2-Antriebs um 0,035 W/m² gegeben, beträgt die Zunahme plus Unsicherheit im simulierten troposphärischen thermischen Energiefluss (0,035±4) W/m². Und das alles unter Erhaltung des simulierten TOA-Gleichgewichtes.

Falls man also das Unsicherheits-Intervall für die Lufttemperatur für irgendeinen spezifischen Jahresschritt berechnen will, würde die Obergrenze des Temperatur-Unsicherheitsintervalls aus +4,035 W/m² berechnet, während die Untergrenze des Intervalls -3,9065 W/m² beträgt.

Setzt man dies auf der rechten Seite der Gleichung 5.2 in der Studie ein und setzt man F0 = 33,30 W/m², dann beträgt das Ein-Schritt-Unsicherheitsintervall der simulierten Lufttemperatur +1,68°C/-1,63°C.

Die vom CMIP5 GCM projizierte mittlere Anomalie der Lufttemperatur würde jedoch 0,015°C betragen – und nicht +1,68°C oder -1,63°C.

Bei der gesamten Modellierung bleibt das simulierte TOA-Gleichgewicht erhalten, hauptsächlich deswegen, weil der Simulationsfehler des langwelligen Wolkenantriebs ausgeglichen wird durch Simulationsfehler beim kurzwelligen Wolkenantrieb.

Dies bedeutet, dass die zugrunde liegende Physik falsch ist und auch der simulierte Klima-Energie-Status falsch ist. Im Nachhinein wird die beobachtete Lufttemperatur im Kalibrierungs-Zeitraum nur wegen der Anpassung der Kurve nach den händisch angebrachten Adjustierungen der Modellparameter korrekt reproduziert [2, 7]

Erzwungene Korrespondenz mit einem bekannten Wert beseitigt nicht die Unsicherheit in einem Ergebnis, weil die kausale Ignoranz ungelöst bleibt.

Wenn Fehler in einem Zwischenergebnis auf jeden einzelnen Schritt einer Reihe von Berechnungen auftreten – was eine Projektion der Lufttemperatur beschreibt – dann setzen sich diese Fehler im nächsten Schritt fort. Der nächste Schritt fügt dann noch seinen eigenen Fehler hinzu. Der einzige Weg, den Effekt der schrittweisen Fehler zu beurteilen ist die schrittweise Fortpflanzung der angemessenen rmse-Unsicherheit.

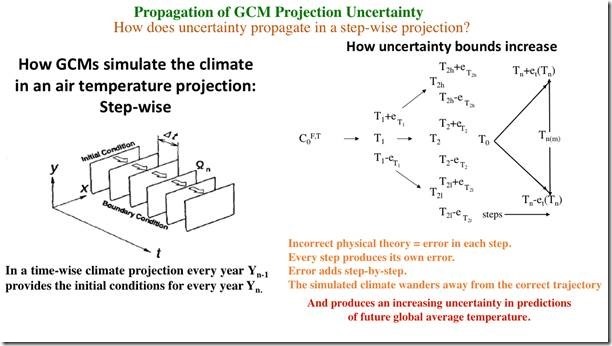

Abbildung 3 unten zeigt das Problem graphisch dargestellt. GCMs projizieren die Temperatur in einer schrittweisen Abfolge von Berechnungen [8]. Falsche Physik bedeutet, dass jeder Schritt fehlerhaft ist. Der Klima-Energie-Zustand ist falsch.

Der falsche Klimazustand setzt sich dann in den Berechnungen fort. Dessen Fehler legen die initialen Bedingungen des nächsten Schrittes fest. Falsche Physik bedeutet, dass der nächste Schritt seine eigenen Fehler erzeugt. Diese neuen Fehler addieren sich zu denen der initialen Bedingungen. Und so geht es immer weiter, Schritt für Schritt. Die Fehler addieren sich mit jedem Schritt.

Wenn man einen zukünftigen Zustand berechnet, kennt man nicht das Signal oder die Größenordnung von irgendeinem der Fehler im Ergebnis. Dieses Unwissen beruht auf der offensichtlichen Schwierigkeit, dass aus einem zukünftigen Klima keine Messungen vorliegen.

Die Zuverlässigkeit der Projektion muss dann mittels einer Unsicherheits-Analyse beurteilt werden. Man kalibriert das Modell gegen bekannte Messgrößen (z. B. den Gesamt-Anteil der Wolken). Hiermit erhält man eine relevante Abschätzung der Modell-Genauigkeit; eine geeignete mittlere rmse-Kalibrierungs-Statistik der Fehler.

Die Kalibrierungs-Fehlerstatistik informiert uns über die Genauigkeit eines jeden rechnerischen Schrittes einer Simulation. Wenn Ungenauigkeit in jedem Schritt präsent ist, setzt sich die Metrik des Kalibrierungs-Fehlers durch jeden Schritt fort. Damit ergibt sich die Unsicherheit im Ergebnis – also wie groß unser Vertrauen in die Richtigkeit der Zahl ist.

Involviert die Berechnung multiple Einzelschritte, von denen jeder seinen eigenen Fehler beiträgt, dann setzt sich die schrittweise Unsicherheits-Statistik durch die Abfolge der einzelnen Schritte fort. Die Unsicherheit des Ergebnisses muss immer größer werden. Diesen Umstand zeigt Abbildung 3:

Abbildung 3: Zunahme der Unsicherheit einer Projektion der Lufttemperatur. C0F,T ist der Grundzustand des Klimas, welcher einen initialen Antrieb F0 aufweist, der Null sein kann, und eine initiale Temperatur T0. Die finale Temperatur Tn wird festgelegt durch die finale Unsicherheit ±et als Tn±et.

Schritt eins projiziert einen Antrieb im ersten Schritt F1, welcher eine Temperatur T1 erzeugt. Falsche Physik bringt einen physikalischen Fehler e1 in die Temperatur ein, der positiv oder negativ sein kann. Bei einer Projektion eines zukünftigen Klimas kennen wir nicht das Signal oder die Größenordnung von e1.

Allerdings geben uns Kalibrierungs-Experimente im Nachhinein darüber Aufschluss, dass Einzelschritte bei der Projektion eine mittlere Unsicherheit von ±e aufweisen.

T1 enthält also eine Unsicherheit von T1±er1.

Die Temperatur von Schritt 1 plus deren physikalischer Fehler, T1+e1 geht in Schritt 2 als Ausgangsbedingung ein. Aber T1 wies einen Fehler auf, nämlich e1. Dieses e1 ist ein Fehler-Ausgleich eines unbekannten Signals in T1. Daher erhält die falsche Physik von Schritt 2 eine T1, die von e1 ausgeglichen wird. Aber bei Zukunfts-Projektionen kennt man nicht den Wett von T1+e1.

In Schritt 2 beginnt die falsche Physik mit der unrichtigen T1 und fügt einen neuen unbekannten physikalischen Fehler e2 zu T2 hinzu. Der Fehler in T2 beträgt jetzt e1+e2. Allerdings bleiben in einer Zukunfts-Projektion Signal und Größenordnung von e1, e2 und deren Summe unbekannt.

Und so geht es immer weiter – Schritt 3, … n addieren alle ihre jeweiligen Fehler e3+ … +en. Aber weil Signal und Größenordnung der Fehler unbekannt sind, kennen wir auch nicht den Gesamtfehler im finalen Zustand. Alles, was wir wissen ist, dass die Trajektorie des simulierten Klimas sich entfernt hat von der Trajektorie des physikalisch korrekten Klimas.

Die Kalibrierungs-Fehlerstatistik erlaubt jedoch eine Abschätzung der Unsicherheit in den Ergebnissen irgendeines Einzel-Berechnungsschrittes, also ±e.

Gibt es multiple Berechnungsschritte, wird ±e jedem Schritt unabhängig angeheftet. Die prognostische Unsicherheit nimmt mit jedem Schritt zu, weil die ±e-Unsicherheit sich durch jene Schritte fortpflanzt und die kontinuierliche, aber unbekannte Auswirkung des Fehlers reflektiert. Fortpflanzung der Kalibrierungs-Unsicherheit geht ein als root-sum-square (rss). Für ,n‘ Schritte ist das ![]() [9 bis 11].

[9 bis 11].

Es sollte jedermann völlig klar sein, dass die rss-Gleichung keine physikalischen Temperaturen ergibt oder die physikalischen Größenordnungen von irgendetwas Anderem. Es ist lediglich eine Statistik der prognostischen Unsicherheit, die notwendigerweise mit der Anzahl der Berechnungsschritte der Prognose zunimmt. Eine Zusammenfassung der Literatur bzgl. Unsicherheit habe ich in meinem ursprüngliche Beitrag behandelt.

Die Zunahme der Unsicherheit bedeutet nicht, dass die projizierte Lufttemperatur sehr hoch wird. Projizierte Temperaturen liegen immer zwischen irgendwelchen physikalischen Grenzen. Aber die Zuverlässigkeit jener Temperatur – unser Vertrauen darin, dass sie physikalisch korrekt ist – vermindert sich mit jedem Schritt. Das Vertrauensniveau ist die Bedeutung von Unsicherheit. Mit dem schwindenden Vertrauen nimmt die Unsicherheit zu.

C. Roy und J. Oberkampf (2011) beschreiben es so: „Prognostische Unsicherheit beruht auf fehlenden Kenntnissen der Modellierer, der die Analyse durchführenden Analysten oder der Experimentatoren, welche in die Validierung involviert sind. Das fehlende Wissen kann zum Beispiel die Modellierung des interessierenden Systems betreffen oder dessen Umfeld, Simulations-Aspekte wie numerische Fehler bei der Auflösung und Rundungsfehler seitens der Computer; auch fehlende experimentelle Daten spielen eine Rolle“.

Die Zunahme der Unsicherheit bedeutet, dass wir mit jedem Schritt weniger und immer weniger wissen, wie das simulierte zukünftige Klima nun ist relativ zum physikalisch korrekten zukünftigen Klima. Abbildung 3 zeigt die immer breiter werdende Unsicherheit mit der Anzahl der Schritte.

Große Unsicherheits-Bandbreite bedeutet, dass die projizierte Temperatur einen zukünftigen Klimazustand reflektiert, welcher einen vollkommen unbekannten Abstand zum physikalisch realen zukünftigen Klimazustand hat. Das Vertrauen darin, dass die simulierte zukünftige Temperatur der ,wahren‘ zukünftigen Temperatur entspricht, ist minimal.

Darum ist die Fortpflanzung von Unsicherheiten bei einer Projektion der Lufttemperatur vollkommen angemessen. Es ist unsere einzige Abschätzung der Zuverlässigkeit eines prognostischen Ergebnisses.

Anhang 1 unten zeigt, dass die Modelle Wolken bis zu einer Genauigkeit von ±0,1% simulieren müssen, also etwa 100 mal besser als die heutigen ±12,1%, um irgendwelche möglichen Effekte eines CO2-Antriebs aufzulösen.

Anhang 2 zitiert Richard Lindzen über die totale Korruption und Unehrlichkeit, welche die gesamte AGW-Konsens-Klimatologie durchzieht.

Bevor es weitergeht, folgt hier eine Aussage der NASA zu Wolken und Auflösung: „Bei einer Verdoppelung des atmosphärischen Kohlendioxid-Gehaltes, zu welchem es den Prognosen zufolge während der nächsten 50 bis 100 Jahre kommen soll, wird erwartet, dass sich das Strahlungs-Gleichgewicht an der Erdoberfläche lediglich um etwa 2% ändert. … Falls eine Änderung um 2% wirklich so bedeutsam ist, dann muss ein Klimamodell, um brauchbar zu sein, auf irgendetwas um 0,25% genau sein. Folglich müssen die heutigen Modelle um etwa das Hundertfache an Genauigkeit verbessert werden, eine sehr große Herausforderung“.

Dieses ,hundertfach‘ ist genau das, was ich mit dieser Studie zum Ausdruck bringen möchte.

Falls Klimamodelle die Reaktion der Wolken auf CO2-Emissionen nicht auflösen können, dann können sie auch unmöglich die Auswirkung von CO2-Emissionen auf die Lufttemperatur projizieren.

Die Unsicherheit von ±4 W/m² beim LWCF ist eine direkte Reflektion der ausgeprägten Ignoranz um die Reaktion der Bewölkung.

Die LWCF-Kalibrierungs-Unsicherheit in den CMIP5 reflektiert Ignoranz hinsichtlich der Größenordnung des thermischen Flusses in der simulierten Troposphäre, welcher eine direkte Konsequenz der Unfähigkeit der CMIP5-Modelle ist, den Wolkenanteil zu simulieren.

Der jährliche mittlere CO2-Antrieb von 0,035 W/m² ist genau ein solcher kleinerer energetischer Effekt. Es ist unmöglich, die Auswirkung einer Änderung des Antriebs von 0,035 W/m² auf die Lufttemperatur aufzulösen, wenn das Modell den troposphärischen Antrieb nicht genauer als ±4 W/m² auflösen kann. Die Durchdringung ist um ±114 Male kleiner als die untere Grenze der Auflösung in einem CMIP5-Modell. Das Unsicherheits-Intervall kann angemessen analogisiert werden als die kleinste Pixelgröße der Simulation. Es ist das Unschärfe-Niveau. Es ist die Breite der Unwissenheits-Bandbreite, innerhalb derer man nichts weiß.

Unsicherheit ist kein physikalischer Fehler. Sie subtrahiert sich nicht hinweg. Sie ist eine Maßzahl von Unwissen.

Das Modell kann eine Zahl erzeugen. Wenn die physikalische Unsicherheit groß ist, dann ist diese Zahl physikalisch bedeutungslos.

All dies wird in der Studie angesprochen, sehr detailliert in Abschnitt 10 der Begleitinformationen. Es ist nicht so, dass die Analyse fehlt oder kryptisch ist. Sie ist jedoch nicht Gegenstand meiner Kritik.

Kleinere seltsame und irrige Gedanken:

Roy schrieb: „Falls ein Modell tatsächlich ein Ungleichgewicht des Energieflusses an der TOA von +4 W/m² aufweist, würde dieser Bias mit der Zeit relativ konstant bleiben“.

Aber der LWCF-Fehler in der Statistik beträgt ±4 W/m² und nicht (+)4 W/m². Hier hat Roy eine Kalibrierungs-Fehlerstatistik nicht nur als einen Energiefluss missverstanden, sondern hat auch den irrigen Gedanken ausgenutzt, um das ± in ein (+) umzuwandeln.

Dieser Fehler ist auch unter meinen vorherigen Begutachtern weit verbreitet. Er erlaubt es ihnen, einen konstanten Ausgleichs-Fehler [offset error] anzunehmen. Und dies wiederum erlaubte es ihnen anzunehmen, dass sich der gesamte Fehler hinweg subtrahiert.

Diese Vermutung der Perfektion nach der Subtraktion ist gängiger Glaube unter den Konsens-Klimatologen. Sie wird direkt vor ihren Augen durch ihre eigenen Ergebnisse widerlegt (Abbildung 1 in [13]), aber das scheint nie eine Rolle zu spielen.

Ein weiteres Beispiel enthält Abbildung 1 in der Studie, welche simulierte Temperatur-Anomalien zeigt. Sie alle werden erzeugt, indem eine simulierte climate base-state-temperature [?] subtrahiert wird. Falls die Simulationsfehler hinweg subtrahiert werden, würden sich alle Anomalietrends überlagern. Aber sie sind von diesem ideal weit entfernt.

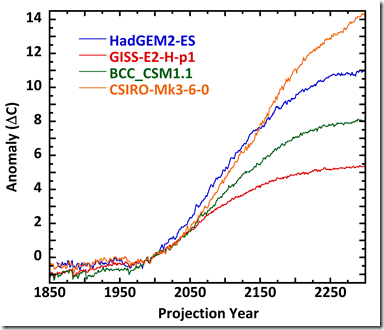

Abbildung 4 zeigt ein CMIP5-Beispiel der gleichen Widerlegung:

Modellabstimmungen haben alle vier projizierte Anomalietrends von 1850 bis 2000 nahezu übereinstimmend gemacht. Allerdings folgen die Modelle danach unterschiedlichen Temperatur-Entwicklungen. Im Projektionsjahr 2300 beträgt deren Bandbreite 8°C. Die Anomalietrends lassen sich nicht überlagern; die Simulationsfehler haben sich nicht hinweg subtrahiert.

Der Gedanke, dass sich Fehler in Anomalien hinweg subtrahieren, ist objektiv falsch. Die Unsicherheiten, welche in den Projektionen nach dem Jahr 2000 versteckt sind, finden sich auch im Zeitraum 1850 bis 2000.

Ursache hierfür ist, dass die Projektionen historischer Temperaturen auf der gleichen falschen Physik basieren wie die Zukunfts-Projektionen. Obwohl die Messgrößen reproduziert werden, wird die dem Temperaturtrend zugrunde liegende physikalische Kausalität vom Modell kaum beschrieben. Der Gesamt-Wolkenanteil wird im Jahre 1950 genauso falsch simuliert wie im Jahre 2050.

Der LWCF-Fehler ist in allen Simulationen präsent. Die mittlere jährliche Simulations-Unsicherheit von ±4 W/m² beim troposphärischen thermischen Energiefluss ist durchweg vorhanden, was in jeden Simulationsschritt der Lufttemperatur Unsicherheit hinein bringt. Das Frisieren der Modelle, um die Messgrößen zu reproduzieren, versteckt die Unsicherheit bloß.

Roy schrieb: „Ein weiterer komischer Aspekt von Gl. 6 ist, dass sie weit unterschiedliche Ergebnisse erzeugen wird, abhängig von der Länge des angenommenen Zeitschrittes.“.

Aber natürlich würde Gl. 6 keine weit unterschiedlichen Ergebnisse erzeugen, weil der Simulationsfehler mit der Länge des Zeitschrittes im GCM variiert.

Zum Beispiel können wir die mittlere Pro-Tag-Unsicherheit aus der jährlichen mittleren Kalibrierung von ±4 W/m² nach Lauer und Hamilton abschätzen.

Für das gesamte Jahr ist also (±4 W/m²)² = ![]() , wobei ei die Pro-Tag-Unsicherheit ist. Diese Gleichung ergibt ei zu ±0,21 W/m² für die geschätzte LWCF-Unsicherheit pro mittlerer Projektion pro Tag. Falls wir die tägliche Schätzung auf der rechten Seite von Gleichung 5.2 in der Studie einsetzen und F0=33,30 W/m² setzen, dann beträgt die Einen-Tag-Pro-Schritt-Unsicherheit der projizierten Lufttemperatur ±0,087°C. Die Gesamt-Unsicherheit nach 100 Jahren ist die Wurzel aus [(0,087)²’365’100] = ±16,6°C.

, wobei ei die Pro-Tag-Unsicherheit ist. Diese Gleichung ergibt ei zu ±0,21 W/m² für die geschätzte LWCF-Unsicherheit pro mittlerer Projektion pro Tag. Falls wir die tägliche Schätzung auf der rechten Seite von Gleichung 5.2 in der Studie einsetzen und F0=33,30 W/m² setzen, dann beträgt die Einen-Tag-Pro-Schritt-Unsicherheit der projizierten Lufttemperatur ±0,087°C. Die Gesamt-Unsicherheit nach 100 Jahren ist die Wurzel aus [(0,087)²’365’100] = ±16,6°C.

Das gleiche Verfahren ergibt eine über 25 Jahre geschätzte mittlere Modell-Kalibrierungs-Unsicherheit von Wurzel aus [(±4 W/m²)²’25] = ±20 W/m². Aus Gl. 5.2 beträgt die Unsicherheit pro Schritt ±8,3°C. Nach 100 Jahren beträgt die Unsicherheit der projizierten Lufttemperatur Wurzel aus [(±8,3)² ‚ 4)] = ±16,6°C.

Roy schloss mit den Worten: „Ich wäre froh, widerlegt zu werden“.

Sei froh, Roy!

—————————–

[Es folgt jetzt ein Anhang, in denen das oben Gesagte noch detaillierter ausgeführt wird. Auf die Übersetzung wird daher hier verzichtet. Anhang 2 unten wird aber wieder übersetzt, weil er ein längeres und interessantes Zitat von Richard Lindzen enthält. Anm. d. Übers.]

Anhang 1

Appendix 1: Why CMIP5 error in TCF is important.

We know from Lauer and Hamilton that the average CMIP5 ±12.1% annual total cloud fraction (TCF) error produces an annual average ±4 Wm-2 calibration error in long wave cloud forcing. [14]

We also know that the annual average increase in CO₂ forcing since 1979 is about 0.035 Wm-2 (my calculation).

Assuming a linear relationship between cloud fraction error and LWCF error, the ±12.1% CF error is proportionately responsible for ±4 Wm-2 annual average LWCF error.

Then one can estimate the level of resolution necessary to reveal the annual average cloud fraction response to CO₂ forcing as:

[(0.035 Wm-2/±4 Wm-2)]*±12.1% total cloud fraction = 0.11% change in cloud fraction.

This indicates that a climate model needs to be able to accurately simulate a 0.11% feedback response in cloud fraction to barely resolve the annual impact of CO₂ emissions on the climate. If one wants accurate simulation, the model resolution should be ten times small than the effect to be resolved. That means 0.011% accuracy in simulating annual average TCF.

That is, the cloud feedback to a 0.035 Wm-2 annual CO₂ forcing needs to be known, and able to be simulated, to a resolution of 0.11% in TCF in order to minimally know how clouds respond to annual CO₂ forcing.

Here’s an alternative way to get at the same information. We know the total tropospheric cloud feedback effect is about -25 Wm-2. [15] This is the cumulative influence of 67% global cloud fraction.

The annual tropospheric CO₂ forcing is, again, about 0.035 Wm-2. The CF equivalent that produces this feedback energy flux is again linearly estimated as (0.035 Wm-2/25 Wm-2)*67% = 0.094%. That’s again bare-bones simulation. Accurate simulation requires ten times finer resolution, which is 0.0094% of average annual TCF.

Assuming the linear relations are reasonable, both methods indicate that the minimal model resolution needed to accurately simulate the annual cloud feedback response of the climate, to an annual 0.035 Wm-2 of CO₂ forcing, is about 0.1% CF.

To achieve that level of resolution, the model must accurately simulate cloud type, cloud distribution and cloud height, as well as precipitation and tropical thunderstorms.

This analysis illustrates the meaning of the annual average ±4 Wm-2 LWCF error. That error indicates the overall level of ignorance concerning cloud response and feedback.

The TCF ignorance is such that the annual average tropospheric thermal energy flux is never known to better than ±4 Wm-2. This is true whether forcing from CO₂ emissions is present or not.

This is true in an equilibrated base-state climate as well. Running a model for 500 projection years does not repair broken physics.

GCMs cannot simulate cloud response to 0.1% annual accuracy. It is not possible to simulate how clouds will respond to CO₂ forcing.

It is therefore not possible to simulate the effect of CO₂ emissions, if any, on air temperature.

As the model steps through the projection, our knowledge of the consequent global air temperature steadily diminishes because a GCM cannot accurately simulate the global cloud response to CO₂ forcing, and thus cloud feedback, at all for any step.

It is true in every step of a simulation. And it means that projection uncertainty compounds because every erroneous intermediate climate state is subjected to further simulation error.

This is why the uncertainty in projected air temperature increases so dramatically. The model is step-by-step walking away from initial value knowledge, further and further into ignorance.

On an annual average basis, the uncertainty in CF feedback is ±144 times larger than the perturbation to be resolved.

The CF response is so poorly known, that even the first simulation step enters terra incognita.

—————————–

Anhang 2: Über Korruption und Unehrlichkeit in der Konsens-Klimatologie

Erwähnenswert ist, was Prof. Richard Lindzen über die Auswirkungen einer politisierten Wissenschaft sagt [16]: Ein zweiter Aspekt der Politisierung betrifft speziell wissenschaftliche Literatur. Artikel, welche die Behauptung einer alarmierenden Reaktion auf anthropogene Treibhausgase in Frage stellen, werden ungewöhnlich rasch zurückgewiesen. Diese Zurückweisungen werden normalerweise als unabhängige Studien veröffentlicht und nicht als Korrespondenz den Originalbeitrag betreffend, wobei Letzteres die übliche Praxis ist. Würde die übliche Praxis angewendet, dann würde die Antwort des/der Original-Autors/Autoren Seite an Seite mit der Kritik veröffentlicht werden. Gegenwärtig ist die Lage jedoch so, dass derartige Antworten bis zu ein Jahr lang verzögert werden. Meiner Erfahrung nach reflektieren die Kritiken nicht, dass man die Originalarbeit wirklich verstanden hat. Wenn die Original-Antworten der Autoren schließlich erscheinen, werden sie von weiteren Zurückweisungen begleitet, welche die Antworten allgemein ignorieren und einfach die Kritik wiederholen. Das ist eindeutig kein Verfahren, wie man sich in der wissenschaftlichen Forschung verhalten sollte, aber es ist nicht klar, ob Fortschritt wirklich erwünscht ist. Stattdessen ermächtigt die bloße Existenz von Kritik die umweltliche Presse dazu, das Original-Ergebnis als ,diskreditiert‘ darzustellen, während die lange Verzögerung der Antwort der Original-Autoren es zulässt, dass diese Antworten vollständig ignoriert werden.

Ein finaler Aspekt der Politisierung sind explizite Einschüchterung und Bedrohung von Wissenschaftlern. Beides ist zumeist, aber nicht ausschließlich, jenen zuteil geworden, welche den Alarmismus hinterfragen. Opfer derartiger Einschüchterungen schweigen zumeist. Anhörungen im Kongress wurden dazu verwendet, Druck auf Wissenschaftler auszuüben, welche den ,Konsens‘ in Frage stellen. Den Alarm in Frage stellenden Wissenschaftlern werden sorgfältig ausgewählte Opponenten gegenüber gestellt. Die eindeutige Absicht dahinter ist, den ,skeptischen‘ Wissenschaftler zu diskreditieren, von welchem man einen Widerruf verlangt“ [7].

Die außerordentliche Art und Weise, in der Richard Lindzen den Dschungel von Unehrlichkeit, der die Konsens-Klimatologie nun einmal ist, sollte man unbedingt lesen. Keiner der Akademiker, die er namentlich als Teilhaber an den Schikanen nennt, verdient es, als Wissenschaftler weiter beschäftigt zu werden [6].

Falls man seine Kommentierung seit den frühesten Tagen bis heute verfolgt, wird seine Entmündigung [als Wissenschaftler] schmerzlich und offensichtlich [4 bis 7, 16, 17]. Sein Beitrag „Climate Science: Is it Currently Designed to Answer Questions?“ sollte man in ganzer Länge lesen!

—————————–

References:

[1] Jiang, J.H., et al., Evaluation of cloud and water vapor simulations in CMIP5 climate models using NASA “A-Train” satellite observations. J. Geophys. Res., 2012. 117(D14): p. D14105.

[2] Kiehl, J.T., Twentieth century climate model response and climate sensitivity. Geophys. Res. Lett., 2007. 34(22): p. L22710.

[3] Stephens, G.L., Cloud Feedbacks in the Climate System: A Critical Review. J. Climate, 2005. 18(2): p. 237-273.

[4] Lindzen, R.S. (2001) Testimony of Richard S. Lindzen before the Senate Environment and Public Works Committee on 2 May 2001. URL: http://www-eaps.mit.edu/faculty/lindzen/Testimony/Senate2001.pdf Date Accessed:

[5] Lindzen, R., Some Coolness Concerning Warming. BAMS, 1990. 71(3): p. 288-299.

[6] Lindzen, R.S. (1998) Review of Laboratory Earth: The Planetary Gamble We Can’t Afford to Lose by Stephen H. Schneider (New York: Basic Books, 1997) 174 pages. Regulation, 5 URL: https://www.cato.org/sites/cato.org/files/serials/files/regulation/1998/4/read2-98.pdf Date Accessed: 12 October 2019.

[7] Lindzen, R.S., Is there a basis for global warming alarm?, in Global Warming: Looking Beyond Kyoto, E. Zedillo ed, 2006 in Press The full text is available at: https://ycsg.yale.edu/assets/downloads/kyoto/LindzenYaleMtg.pdf Last accessed: 12 October 2019, Yale University: New Haven.

[8] Saitoh, T.S. and S. Wakashima, An efficient time-space numerical solver for global warming, in Energy Conversion Engineering Conference and Exhibit (IECEC) 35th Intersociety, 2000, IECEC: Las Vegas, pp. 1026-1031.

[9] Bevington, P.R. and D.K. Robinson, Data Reduction and Error Analysis for the Physical Sciences. 3rd ed. 2003, Boston: McGraw-Hill.

[10] Brown, K.K., et al., Evaluation of correlated bias approximations in experimental uncertainty analysis. AIAA Journal, 1996. 34(5): p. 1013-1018.

[11] Perrin, C.L., Mathematics for chemists. 1970, New York, NY: Wiley-Interscience. 453.

[12] Roy, C.J. and W.L. Oberkampf, A comprehensive framework for verification, validation, and uncertainty quantification in scientific computing. Comput. Methods Appl. Mech. Engineer., 2011. 200(25-28): p. 2131-2144.

[13] Rowlands, D.J., et al., Broad range of 2050 warming from an observationally constrained large climate model ensemble. Nature Geosci, 2012. 5(4): p. 256-260.

[14] Lauer, A. and K. Hamilton, Simulating Clouds with Global Climate Models: A Comparison of CMIP5 Results with CMIP3 and Satellite Data. J. Climate, 2013. 26(11): p. 3823-3845.

[15] Hartmann, D.L., M.E. Ockert-Bell, and M.L. Michelsen, The Effect of Cloud Type on Earth’s Energy Balance: Global Analysis. J. Climate, 1992. 5(11): p. 1281-1304.

[16] Lindzen, R.S., Climate Science: Is it Currently Designed to Answer Questions?, in Program in Atmospheres, Oceans and Climate. Massachusetts Institute of Technology (MIT) and Global Research, 2009, Global Research Centre for Research on Globalization: Boston, MA.

[17] Lindzen, R.S., Can increasing carbon dioxide cause climate change? Proc. Nat. Acad. Sci., USA, 1997. 94(p. 8335-8342

Link: https://wattsupwiththat.com/2019/10/15/why-roy-spencers-criticism-is-wrong/

Übersetzt von Chris Frey EIKE

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"„Die Erde braucht möglicherweise das CO2 für ein stabiles und warmes Klima.“

Ja.

Oder Weißbier in den Flüssen…

@Marvin Müller: „Gibt es eigentlich irgend einen Grund dafür, dass hier immer nur eine Seite der Diskussion widergegeben wird?“

Stimmt so nicht. In diversen vorausgegangenen Veröffentlichungen kamen Kritiker, ich erinnere z.B. an eine sehr lange Video-Aufzeichnung, ausführlichst zu Wort.

Wenn sich jetzt Rahmstorf in seinem Blog diesem Thema annähme, würden wir dann auch „Ausgewogenheit“ einfordern? Wahrscheinlich käme dann von dort als „schlagkräftigstes Argument“, dass der EIKE-Vize, der sich tatsächlich mit Fehlertheorie auskennt, einer gewissen Partei nahesteht. Und unsere rotgrün versifften Medien würden applaudieren…

Auch geht es bei Pat Frank darum, ihn als Fehlertheoretiker überhaupt zu verstehen, um sich dann ein eigenständiges Urteil zu bilden. Die noch verschwurbelteren Darlegungen von Kritikern verwirren da teilweise nur. Auch hat Pat Frank in seinem letzten Beitrag die wichtigsten Einwände (und wer kann besser als er beurteilen, was ein ernstzunehmender Einwand ist) m.E. sehr akkurat wiedergegeben und beantwortet.

Letztlich geht es um die Kardinalschwäche aller Klimamodelle, nämlich die physikalische Unkenntnis der extrem wichtigen Wolkenbildung. Und dass dieser Fehler sich bei den weiteren Projektionen fortpflanzt und dabei dramatisch wächst, kann man schlecht abstreiten.

Schließlich zeigen ja die Klimamodelle des IPCC selbst, dass es nicht gelungen ist, die riesige Fehlerbreite (Entschuldigung „Szenarien“) in den letzten 20 Jahren zu verringern.

Für mich ist auch dies ein wichtiger Grund, mir stattdessen die existierenden Temperaturdatensätze genauer anzusehen – siehe das Beispiel weiter unten. Über ergänzende Erkenntnisse, Meinungen etc. würde ich mich sehr freuen.

@Günther Verdall „Ich denke schon, denn dann muss man nicht zugeben, dass man auf ganzer Linie daneben liegt.“

Typisch Klimakirche: Nullkommanull Durchblick aber felsenfest im Vorurteil…

Ich verstehe nur ansatzweise, worum es in dem obigen Aufsatz geht,

obwohl ich im Rahmen des BWL Studiums 2 Semester Statistik hatte und

auch ein Semester Praktische Mathematgik studiert habe.

Es wäre schön, eine Zusammenfassung in normaler Sprache zu bekommen.

@Alwin Bruno: Die Satelliten messen nicht wie Radar, die messen viel mehr die temperaturabhängige Mikrowellenstrahlung von Sauerstoff. Für eine Auflösung nach Höhe wird man sicherlich unter verschiedenen Winkeln messen müssen. Die RSS-Datensätze zeigen graphisch die Höhenprofile, denen sie zugeordnet sind. Also keine exakte Höhenangaben, sondern in der Art von Gauss-Kurven mit den unterschiedlichen Maxima in den jeweiligen Höhenbereichen.

Im Originaltext steht:

Das dürfte ein „I would be glad“ sein, was „Ich wäre froh, wenn ich widerlegt werden würde“ heissen dürfte.

Gibt es eigentlich irgend einen Grund dafür, dass hier immer nur eine Seite der Diskussion widergegeben wird? Warum gibt es immer nur die Texte von Oat Frank, aber nie die anderen Diskussionsbeiträge (oder gar Ausschnitte aus den Diskussionen in den Kommentaren)? Hat das Sinn, sich immer nur die eine Seite anzusehen, die Argumente der anderen Seite aber immer zu ignorieren (oder zu unterschlagen)?

@Marvin Müller,

„Hat das Sinn, sich immer nur die eine Seite anzusehen, die Argumente der anderen Seite aber immer zu ignorieren (oder zu unterschlagen)?“

Ich denke schon, denn dann muss man nicht zugeben, dass man auf ganzer Linie daneben liegt. 🙂

Man diskutiert den Artikel hier wie dort unabhängig, es steht jedem frei, das Original und die Diskussionen selbst zu lesen. Hier wird einfach nur, mal gut mal weniger gut, der Artikel übersetzt, die dortigen Kommentare sind hier nicht relevant, wenn auch um einiges fachlicher und sachlicher, was an der jeweiligen Leserschaft liegt.

Aber zu erwarten, dass hier auch die Kommentare übersetzt und dargestellt werden ist arg daneben, und, da von Ihnen, wieder das übliche Wühlen in irgendwelchen imaginären Krümeln.

Das verstehe ich nicht, Herr Müller. Die „andere Seite“ höre Sie doch tausendfach jeden Tag im Mainstream! Wird nicht umgekehrt ein Schuh draus?

Und die Kommentare zu den WUWT-Beiträgen mit zu übersetzen würde viel zu lange dauern! Ich bekleide noch andere Ehrenämter als nur übersetzen!

Chris Frey

Chris Frey schrieb am 23. OKTOBER 2019 UM 18:50:

Die Thesen von Pat Frank wurden auf WUWT in einer Vielzahl von Artikeln diskutiert, von Autoren wie Roy Spencer, Patrick Brown und Nick Stokes. Wo hört man von denen etwas in den Mainstream-Medien? Und wo wurden die Thesen von Pat Frank in den Mainstream-Medien diskutiert?

Hier wird dem des englischen nicht mächtigen nur Pat Franks Sicht präsentiert …

Korrigiert wenigstens jemand das Statement Spencers, das falsch übersetzt wurde?

Es steht Dir doch frei, die Kommentare zu übersetzen und hier zur Verfügung zu stellen.

Wenn Nick Stokes zu Pat einen Artikel verfasst, und du ihn hier sehen willst, geh an’s Werk. 😀

In allen Blogs, die ich verfolgt habe, ist es keinem der von Ihnen erwähnten Wissenschaftlern gelungen Pat Frank zu widerlegen. Selbst Klimafakten.de haben bis heute die wissenschaftliche Arbeit nicht verstanden. Sie werden in manchen internationalen Foren gar nicht mehr Ernst genommen. Wenn ich als Laie solche Fakten googeln kann, dürfte es für sie doch ein Klacks sein.

Hermann Horn schrieb am 18. Februar 2020 um 19:03:

Wie wäre es mit einer einfachen Frage, anhand derer jeder mal für sich verifizieren kann, ob er eher mit Pat Frank oder eher mit seinen Kritikern übereinstimmt?

Sie haben 3 Personen, eine ist 1,60m, die zweite 1,70m und die dritte 1,80m groß. Wie gross sind die 3 Personen im Mittel?

a) 1,70m

b) ?

Die Antwort b gebe ich mal nicht vor, wer die Diskussionen zwischen Pat Frank und den drei genannten Kritikern verfolgt hat, kennt die Antwort.

Was ist Ihre Antwort auf die Frage?

Googeln sie mal nach Dr. Jing-Jia Luo, das ist der mutige Wissenschaftler der die Arbeit von Pat Frank angenommen hat und einem „korrekten Peer reviewed“ unterzogen hat.

Betrachtet man die RSS-Temperaturdatensätze, kann man unterschiedliche Messhöhenbereiche auswählen:

http://www.remss.com/measurements/upper-air-temperature/

dort in „Browse Air Temp Time Series“ den jeweiligen Datensatz im Menü links anklicken.

Dort fällt ein sehr ausgeprägter Trend auf: Den steilsten Temperaturanstieg (0,2 Grad/Dekade) misst man in der untersten, bodennächsten Schicht der Troposphäre. Nach oben wird die Kurve flacher und kehrt sich oberhalb der Troposphäre zunehmend ins Negative um, also zunehmende Abkühlung während der letzten 40 Jahre!

Eine naheliegende Erklärung könnte sein: In der dichten Troposphäre verlangsamt das anthropogene CO2 die Abstrahlung (vermehrte Absorptions- und Emissionsvorgänge aufgrund der zunehmenden CO2-Teilchendichten). Weiter oben bei sehr viel niedrigeren Teilchendichten hilft das anthropogene CO2 bei der „ungebremsten“ Abstrahlung in den Weltraum. Unten heizt das anthropogene CO2, oben kühlt es…

Wer weiß es besser? Kann man diese Trendumkehr auch durch natürliche Ursachen (also ohne anthropogenes CO2) erklären?

zu: Messhöhen

Es sollte klar sein dass Satelliten keine Höheninformation aus dem Signal ablesen können (anders als beim RADAR und dessen gemessene Reflektion). Es ist also keines falls so dass CO2 „seine“ Temperatur reflektiert zusammen mit Orts(-abstands-)angabe.

Habe ich per Email 5.2.2018 mit Dr. Roy Spencer abgeklärt.

zu: Messhöhen

Es sollte klar sein dass Satelliten keine Höheninformation aus dem Signalspektrum ablesen können (anders als beim RADAR und dessen gemessene Reflektion). Es ist also keines falls so dass O2 „seine“ Temperatur reflektiert zusammen mit Orts(-abstands-)angabe.

Habe ich per Email 5.2.2018 mit Dr. Roy Spencer abgeklärt.

„Ich sage, dass wir keine Ahnung haben, wie viel Erwärmung es verursacht,…“

Nochmal: Roy Spencer ist ein ahnungsloser Schwätzer!

Ohne sämtliche Details nachzuvollziehen: Die Fehlerthematik ist wieder ein Stück klarer geworden. Auch die Zitatstellen von Lindzen sprechen für sich!

Das Dumme ist nur: Einem zunehmenden CO2 wird offenbar eine Erhöhung des Energiegehalts der Atmosphäre zugestanden (bei Verdoppelung des CO2 2% Energiezunahme). Vollkommen ungewiss ist demnach aber, was dieser zusätzliche Energieeintrag letztlich bewirkt.

Also bleibt uns nur übrig, auf die Temperaturmessungen zu schauen. Und jetzt kommt wieder Lindzen und sagt sinngemäß: Solange wir die natürlichen Variabilitäten nicht verstehen, ist das ganze sowieso sinnlos.

Eine tolle Gemengelage, um die Menschheit mit echten Luftnummern total verrückt zu machen. Aber auf jeden Fall geeignet, um endlich den „perfekten Sozialismus“ einzuführen…

Ich habe mich mehr als 25 Jahre mit der Programmierung von Anfangs-Randwert-Problemen, speziell der Navier-Stokes-Gleichungen, beschäftigt und wäre nie auf die Idee gekommen, dass man einem Rechner Klimaprojektionen beibringen kann. Ein Computer kennt keine physikalischen Einheiten; im Code werden Zeile für Zeile nur Zahlen hin- und hergeschaufelt. Der Gedanke, man könne diesem menschenerdachten Zahlenspiel Informationen über die Natur und Klimaparameter in 100 Jahren mit der notwendigen Genauigkeit abverlangen, ist vermessen. Dieses Zahlenspiel als solches ist wissenschaftlich durchaus interessant, es taugt aber als Basis für sogenannte politische Klimaschutzmaßnahmen überhaupt nicht. Insofern sind die Diskussionen von Frank und Spencer wichtig und beachtenswert.

Letztlich kann seriöse Klimaforschung nur empirisch sein.

Der Kern der Wahrheit: [Zitat: „Ich sage nicht, dass ein zunehmender CO2-Gehalt keine Erwärmung verursacht. Ich sage, dass wir keine Ahnung haben, wie viel Erwärmung es verursacht, weil wir keine Ahnung haben, wie groß das natürliche Energie-Ungleichgewicht im Klimasystem ist während der letzten – sagen wir – 50 Jahre. … Folglich weisen Projektionen der globalen Erwärmung einen großen Anteil von Glauben auf, der in die Modelle einprogrammiert wurde“.] Zitat Ende — Die Frage ist doch, gibt es ein „natürliches Energie- Gleichgewicht“ und wo genau wäre das einzuordnen; wenn wir das wüßten, könnten wir auch ein „natürliches Ungleichgewicht“ feststellen. Da die Erde aber nicht „konstruiert“ wurde, sondern eher zufällig entstanden ist und niemals unverändert gleich bleiben wird, bleibt uns Menschen nichts anderes übrig, als uns auf extreme Wärnme und Kälte vorzubereiten, auf Veränderungen bei Ozeanen (Meeresspiegel oder Absinken von Küsten = siehe Barrier Reef)) einzustellen und in dem Moment auf neue Bedingungungen vorbereitet zu sein !

Das ist gut zusammengefasst und geschlussfolgert.

Ich denke schon, dass es diese Kipppunkte gibt, wo das Klima aus dem Gleichgewicht gerät. Man schaue sich nur die Eiszeitzyklen an. Die Erde braucht möglicherweise das CO2 für ein stabiles und warmes Klima. CO2 = Leben und wir befinden uns in einem erdgeschichtliches CO2-Minimum.

Ja, der Roy Spencer hat sich da wohl ein wenig verplappert, will er doch wohl noch Forschungsgelder abgreifen, trotz „the Science is settled“. Soll „the Science“ das so doch nicht sein.

https://www.washingtontimes.com/news/2019/mar/13/what-are-the-opponents-of-donald-trumps-climate-re/

Dabei frage ich mich, was die da Jahrelang beforscht haben, ist doch Wasser über all seine Aggregatzustände und Aggregatzustandsänderungen der Klimatreiber schlecht hin.

… was schreiben die vom CO2?