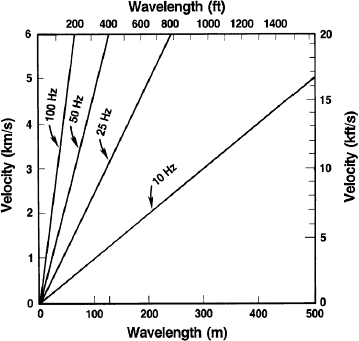

Abbildung 1a: Seismische Wellenlänge vs. Geschwindigkeit für dominante Frequenzen von 10, 25, 50 und 100 Hz (SEG Wiki)

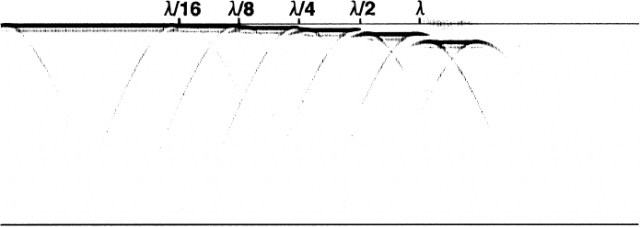

Dünnere Schichten können erkannt, aber nicht aufgelöst werden. Gleiches gilt für normale Verwerfungen. Falls die vertikale Auflösung mindestens λ/4 beträgt, kann die Verwerfung aufgelöst und eine genaue Schätzung aufgrund der seismischen Daten vorgenommen werden. Falls die Auflösung geringer ist, kann man bestenfalls erkennen, dass eine Verwerfung vorhanden ist.

Abbildung 1b: Seismisches Abbild einer normalen Verwerfung bei λ/16, λ/8, λ/4, λ/2 and λ. (SEG Wiki) [Hinweis: Auch im Original ist die Graphik nicht deutlicher!]

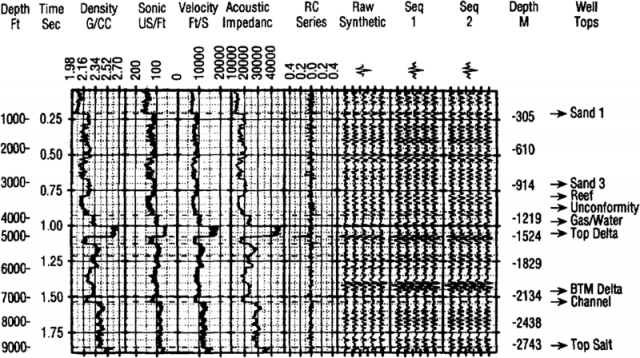

Wenn man geologische und geophysikalische Daten integriert, unterteilen wir den Bohrkern nicht einfach in ein seismisches Profil. Wir konvertieren die Bohrkerne in ein synthetisches Seismogramm. Dies wird auf höchst effektive Weise erreicht mittels Schall- und Dichte-Messungen [sonic and density logs].

Abbildung 2: Synthetisches Seismogramm (AAPG Wiki).

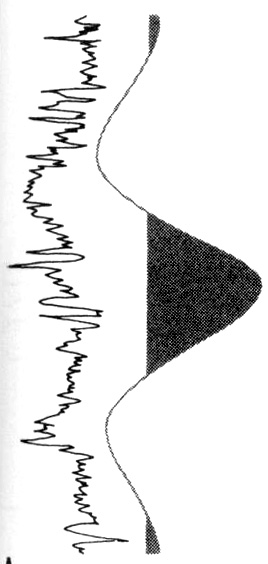

Die Schall- und Dichte-Messungen werden herangezogen, um akustische Impedanz und eine Serie von Reflektions-Koeffizienten (RC) zu berechnen. Der RC ist verbunden mit einer kleinen seismischen Welle, oftmals extrahiert aus den seismischen Daten nahe des Bohrlochs. Die synthetischen seismischen Spuren (3 Paneele zur Rechten), können dann direkt verglichen werden mit dem seismischen Profil. Der Unterschied in der Auflösung ist ziemlich groß. Das Intervall von Trog zu Trog im seismischen Impuls unten liegt bei etwa 150 Metern.

Abbildung 3: schematischer Vergleich eines Bohrkerns mit einem seismischen Impuls mit einer Wellenlänge von 150 m

Was hat das nun mit Klima-„Wissenschaft“ zu tun?

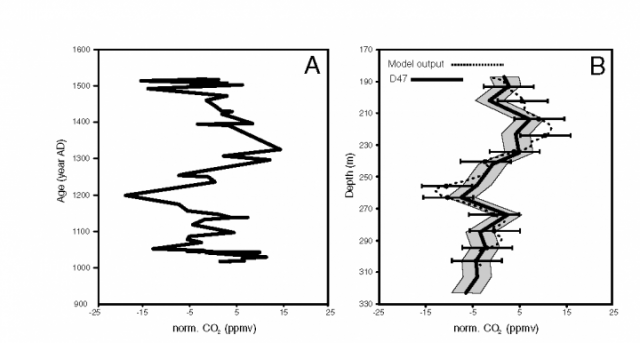

Die Signaltheorie [?] und die Prinzipien der Bearbeitung von Signalen sind auf alle Signale anwendbar, nicht nur auf seismische Daten. Ein Signal ist eine zeitlich variable Abfolge von Zahlen. Fast alle Rekonstruktionen von Temperatur, Kohlendioxid und Meeresspiegel werden mittels vieler der gleichen Datenverarbeitungs-Verfahren wie beim Verarbeiten seismischer Daten erstellt. Dekonvolution ist besonders unentbehrlich bei der Erstellung von Kohlendioxid-Chronologien aus Eisbohrkernen. Manchmal werden die Signal-Verarbeitungsverfahren ordnungsgemäß durchgeführt. Van Hoof et al. (2005) zeigten, dass die CO2-Daten aus Eisbohrkernen repräsentieren ein über Jahrhunderte und Jahrtausende gleitendes Mittel von CO2-Niveaus in der Vergangenheit. Im Wesentlichen wurde ein synthetisches Seismogramm erzeugt aus Stomata-Chronologien und mit dem Eisbohrkern in Zusammenhang gestellt.

Abbildung 4: Graphik A zeigt eine Häufigkeitskurve aus Stomata-Daten. Graphik B zeigt den Eisbohrkern D47 aus der Antarktis. Die gestrichelte Linie in Graphik B ist der „synthetische“ Eisbohrkern, erzeugt mittels der Stomata-Häufigkeitskurve (Van Hoof et al. 2005)

Aus meiner geologischen Perspektive sind die meisten Klima-„Hockeyschläger“ das Ergebnis unsachgemäßer Integration von instrumentellen Daten mit hoher Auflösung (wie in Bohrkernen) und weniger hoch aufgelöster Proxydaten (wie bei der Reflektion seismischer Daten). Viele dieser Hockeyschläger scheinen das Ergebnis einer nachlässigen, wenn nicht sogar unverantwortlichen Missachtung grundlegender Prinzipien der Signalverarbeitung zu sein.

Hockeyschläger bei der Temperatur-Rekonstruktion

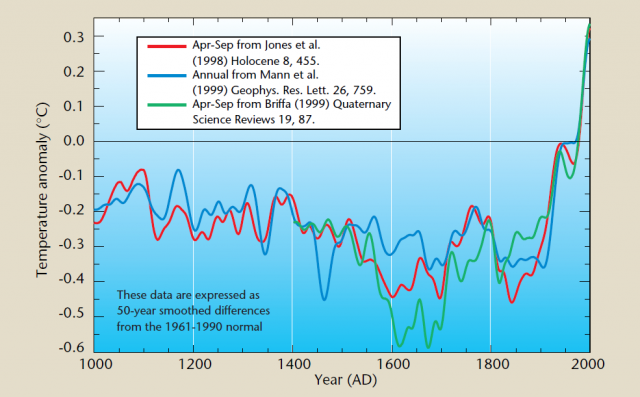

Abbildung 5: „Mike’s Nature Trick“. Ältere Daten stehen links.

Eine der ungeheuerlichsten Verstöße gegen diese Prinzipien ist die Erzeugung von Klima-„Hockeyschlägern“ mittels Variationen von „Mike’s Nature Trick“.

Nach dem Klimagate-Skandal führte die Penn State [= Pennsylvania State University] eine „Untersuchung“ von Mike’s Nature Trick durch. Die Weißwäsche seitens Penn State war grotesk:

Nach sorgfältiger Bewertung aller Beweise und relevanter Unterlagen kommt das Untersuchungs-Komitee zu dem Ergebnis, dass es keine glaubwürdigen Beweise dafür gibt, dass Dr. Mann jemals versucht oder daran teilgenommen hat, direkt oder indirekt, Maßnahmen durchzuführen oder durchgeführt hat mit der Absicht, Daten zu unterdrücken oder zu fälschen.

RA-10 Inquiry Report

Es kann nicht nachgewiesen werden, dass er die Absicht hatte, unbequeme Daten zu verstecken oder zu fälschen.

Das hier ist besonders lächerlich:

Tatsächlich war es im Gegenteil so, dass in Fällen, auf die sich Einige konzentriert hatten, um Fälschungen von Daten zu belegen, beispielsweise mittels eines „Tricks“ um Daten zu manipulieren, es dargestellt wird als eine Diskussion zwischen Dr. Jones und Anderen einschließlich Dr. Mann, wie man am besten eine Graphik für einen WMO-Report erzeugen könnte. Sie fälschten keine Daten, sondern sie versuchten, eine verständliche Graphik zu konstruieren für jene, die keine Experten in dem Bereich waren. Dieser so genannte „Trick“ war nichts weiter als ein statistisches Verfahren, um zwei oder mehr Arten von Daten auf legitime Weise zusammen zu bringen mittels eines Verfahrens, welches durch viele Fachleute in dem Bereich begutachtet worden war.

RA-10 Inquiery Report

Die harmloseste Erklärung des „Tricks“ lautet, dass man Teile der Rekonstruktion von Keith Briffa bearbeitet hat, weil die Chronologie der Baumringen zeigten, dass die 1930er Jahre bis Anfang der 1940er Jahre wärmer waren als zum Ende der 1990er Jahre. Also ersetzten sie die Baumring-Chronologie durch instrumentelle Aufzeichnungen. Im privaten Bereich ist dieses Verhalten alles andere als harmlos … Es ist vielmehr die Grundlage für sofortige Terminierung oder Schlimmeres.

Ich vermute, dass es keine Beweise dafür gibt, dass man dies in betrügerischer Absicht machte. Allerdings lässt es die Tatsache, dass man es „Mike’s Nature Trick“ nannte, es so aussehen, als ob diese Art des Verfahrens eine Standard-Prozedur war.

Zieht man einen Datensatz heran, welcher zeigt, dass die 1930er Jahre wärmer waren als die 1990er Jahre, und dann einen anderen Datensatz, um diese Relation umzukehren, dann ist das „kein Zusammenbringen von zwei oder mehr Datenarten auf legitime Weise“. Vielmehr handelt es sich dabei um eine totale Verfälschung der Daten.

Beispiele für „Mike’s Nature Trick“ gibt es hier und hier.

Man öffne irgendeinen der **cru_eiv_composite.csv oder **had_eiv_composite.csv-Dateien. Alle verbinden die zeitlich hoch aufgelösten instrumentellen Daten mit den gering aufgelösten Proxy-Daten. Zu Manns Gunsten muss man sagen, dass er zumindest dies so dokumentiert hat, dass man es ausfindig machen kann.

Folgende Aussage aus ihrer PNAS-Studie wird von den Proxy-Rekonstruktionen in keiner Weise gestützt: „Die jüngste Erwärmung scheint anomal zu sein hinsichtlich mindestens der letzten 1300 Jahre, ob nun Baumringe herangezogen worden sind oder nicht. Falls Baumringdaten verwendet worden sind, kann diese Schlussfolgerung auf die letzten 1700 Jahre erweitert werden“.

Die anomale Natur der „jüngsten Wärme“ ist vollständig abhängig von dem „trickreichen“ Gebrauch der instrumentellen Daten. Er hat keine Proxy-Daten nach 1850 verwendet. In der eivrecondescription-Datei heißt es: „Man beachte: Werte von 1850 bis 2006 sind instrumentelle Daten“.

Die folgende Graphik aus der Mann-Studie aus dem Jahr 2008 impliziert, dass alle Rekonstruktionen allgemein übereinstimmen hinsichtlich der Behauptung, dass die „jüngste Erwärmung seit mindestens 1300 Jahren anomal erscheint“ …

Abbildung 6: „Spaghetti-Graphik von Mann et al., 2008. Die älteren Daten sind links.

Durch das Ausfüllen der Graphik mit vielen Rekonstruktionen und das Verputzen mit den instrumentellen Aufzeichnungen am Ende des Graphen ist es unmöglich, irgendwelche Details zu erkennen.

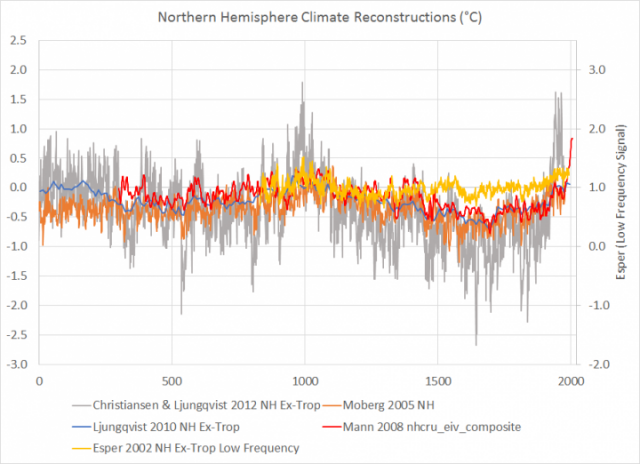

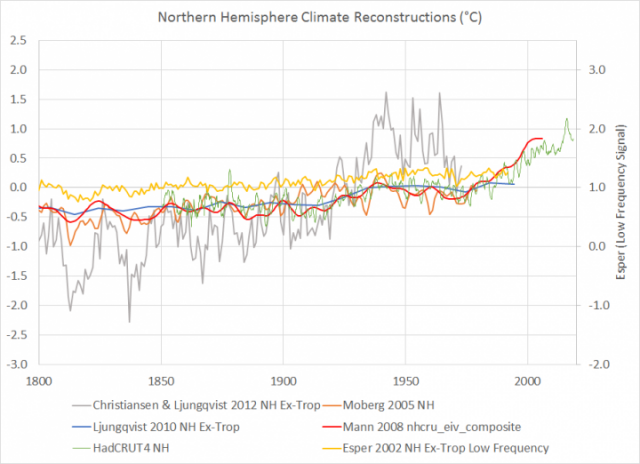

Hier eine Graphik von Mann & Moberg 2005; Christiansen & Ljungqvist 2012 (nicht geglättet), Ljungqvist 2010 und Esper 2002 (geringe Häufigkeit) …

Vergrößerung nach 1800 und hinzugefügten HadCRUT4-Daten der NH:

Die Moderne Erwärmung erscheint nur deswegen anomal, weil die höhere Auflösung der instrumentellen Aufzeichnungen und deren Lage alle am Ende der Zeitreihe liegen.

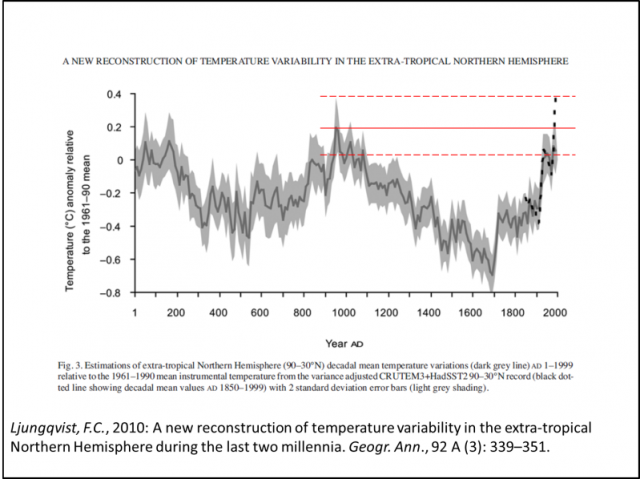

Ljungqvist (2010) erklärte das Problem des direkten Vergleichs von instrumentellen Daten mit Proxy-Rekonstruktionen:

Die Amplitude der rekonstruierten Temperatur-Variabilität im Zeitmaßstab von Jahrhunderten geht über 0,6°C hinaus. Diese Rekonstruktion ist die erste, welche eine ausgeprägte Römische Warmzeit zeigt, etwa vom Jahr 1 bis 300 und etwa auf dem Niveau des mittleren Temperaturniveaus von 1961 bis 1990. Es folgte die Kaltzeit des Dark Age von 300 bis 800, die Mittelalterliche Warmzeit von 800 bis 1300 sowie die Kleine Eiszeit von 1300 bis 1900 treten klar hervor. Letzterer folgte im 20. Jahrhundert eine rapide Erwärmung. Die höchsten Mitteltemperaturen in der Rekonstruktion zeigen ich Mitte bis Ende des 20. Jahrhunderts, die niedrigsten Ende des 17. Jahrhunderts. Dekadische Mittelwerte der Temperatur scheinen während substantieller Zeiträume der Römischen und der Mittelalterlichen Warmzeit höher gelegen zu haben als im Zeitraum 1961 bis 1990. Die Temperatur der letzten beiden Jahrzehnte jedoch liegt möglicherweise höher denn je während der letzten zwei Jahrtausende. Allerdings zeigt sich dies nur in den instrumentellen Temperaturdaten und nicht in der Multi-Proxy-Rekonstruktion selbst.

(…)

Die Proxy-Rekonstruktion selbst zeigt keine solche beispiellose Erwärmung, aber wir müssen berücksichtigen, dass nur wenige, in die Rekonstruktion eingegangene Reihen bis in die neunziger Jahre reichen. Nichtsdestotrotz ist eine sehr sorgfältige Interpretation des Wärmeniveaus seit dem Jahr 1990 im Vergleich zu den wärmsten Zeiten der Römischen und der Mittelalterlichen Warmzeit dringend geboten.

(…)

Die hier rekonstruierte Amplitude der Temperatur-Variabilität über Multi-Jahrzehnte und Jahrhunderte sollte als das Minimum der wahren Variabilität jener zeitlichen Maßstäbe betrachtet werden.

Ljungqvist 2010

Abbildung 9: Ljungqvist zeigte, dass die Moderne Warmzeit nicht eindeutig über die Bandbreite der natürlichen Variabilität hinaus gegangen ist. Die dick gestrichelte schwarze Linie repräsentiert die instrumentelle Aufzeichnung. Ich habe die roten Linien hinzugefügt, um die Fehlerbandbreite der Proxy-Daten relativ zu den instrumentellen Daten zu reflektieren. Ältere Daten stehen links.

Direkte Vergleiche der modernen instrumentellen Aufzeichnungen mit den älteren Proxy-Rekonstruktionen sind nicht robust, weil die Proxy-Daten eine viel geringere Auflösung aufweisen. Die Proxy-Daten zeigen das „Minimum der wahren Variabilität über jene Zeiträume“. Die instrumentellen Daten beschreiben es irgendwie näher der tatsächlichen Variabilität.

Den Proxy-Daten fehlt die Komponente hoher Frequenzen des Signals. Wird die Hochfrequenz-Komponente eines Signals herausgefiltert, dämpft das die Amplitude.

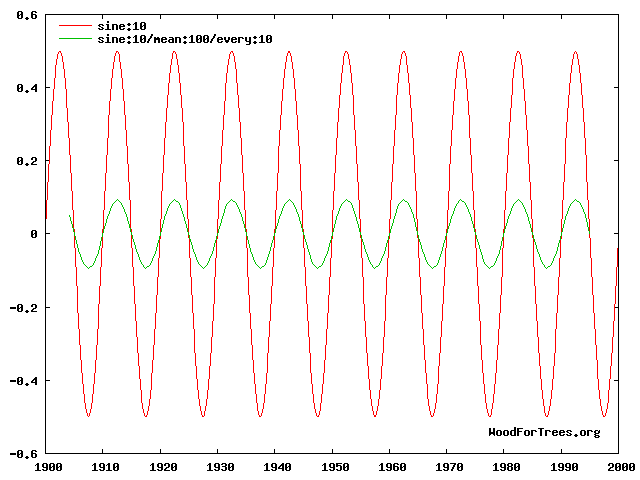

Abbildung 10: Sinuswelle mit einer 10-pt smoothing average. Man beachte die Reduktion der Amplitude infolge Filterung und Glättung (Wood for Trees). Ältere Daten links.

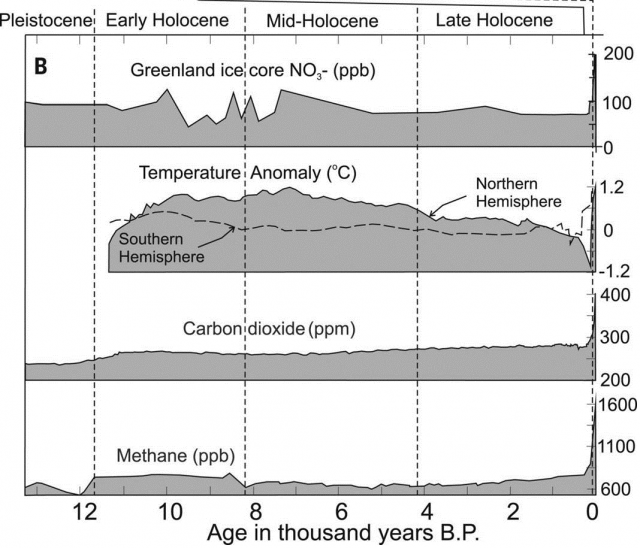

Der direkte Vergleich von instrumentellen Daten mit Proxy-Daten wird sogar noch problematischer, wenn man die zeitliche Länge der Aufzeichnung über 2000 Jahre hinaus verlängert.

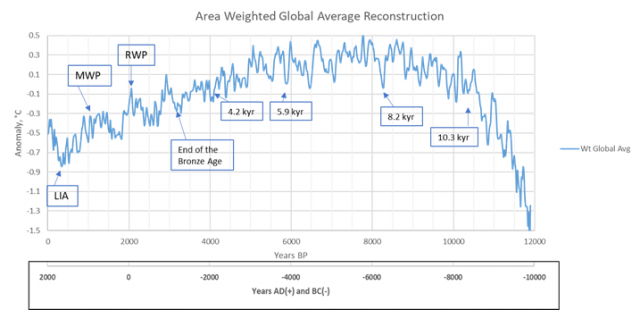

Abbildung 11: Klima-Rekonstruktion des Holozän, Andy May WUWT. Ältere Daten sind rechts.

Die vermeintlich „viertwärmsten Jahre jemals“ ereigneten sich etwa 300 Jahre nach dem kältesten Jahrhundert der vergangenen 100 Jahrhunderte. Dies kann nur von jemandem als „Klimakrise“ oder „Klima-Notstand“ bezeichnet werden, der absolut ignorant ist gegenüber grundlegenden wissenschaftlichen Prinzipien, besonders gegenüber Quaternary Geology und Signal-Verarbeitung.

Je zeitlich länger die Aufzeichnung der Rekonstruktion ist, umso wichtiger wird die Konsistenz der zeitlichen Auflösung.

„Konsistenz der zeitlichen Auflösung“ bedeutet, dass die Auflösung der älteren Proxys konsistent ist mit jüngeren Proxys. Die zeitliche Auflösung ist eine Funktion des Stichproben-Intervalls.

Wir glauben, dass die größere Fehlerquelle in diesen Rekonstruktionen die Auswahl der Proxys ist. Wie in diesen Beiträgen dokumentiert sind etwa 73 Proxys beeinflusst von der Art der Auflösung, welche die signifikanten Klimaereignisse verschleiert. Einige sind auch beeinflusst durch lokale Bedingungen, die keine regionale oder globale Bedeutung haben. Andere überdenken kurze Zeiträume, die nicht die beiden bedeutendsten Klimaereignisse des Holozäns abdecken, nämlich die Kleine Eiszeit und das Holozän-Klimaoptimum.

(…)

Wir haben auch Proxys über lange Zeiträume (mehr als 130 Jahre) außen vor gelassen, weil sie dazu neigen, die Auflösung der Rekonstruktion zu reduzieren und wichtige Details heraus zu mitteln. Der kürzeste Klimazyklus dauert grob 61 bis 64 Jahre, die so genannte „stadium wave“, und wir wollen versuchen, möglichst genau dessen Einfluss zu erkennen. In dieser einfachen Rekonstruktion haben wir versucht, all dem Rechnung zu tragen.

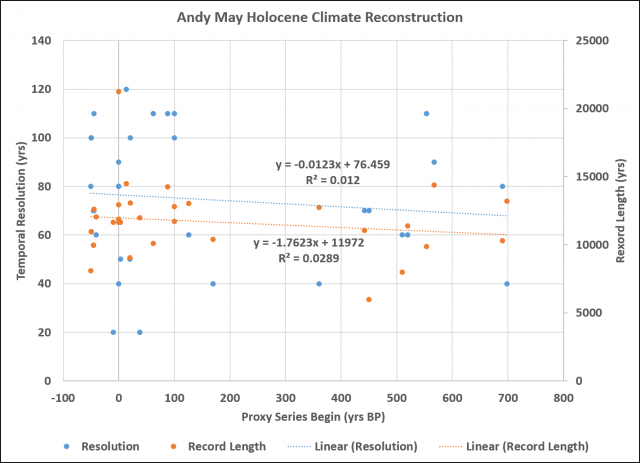

Dies ist eine Tabelle aller „untersuchten“ Proxys. Sie haben eine weitgehend konsistente zeitliche Auflösung. Es sind lange Zeitreihen und überdecken sowohl das Holozän-Klimaoptimum als auch die Kleine Eiszeit, also die wärmste und die kälteste Klimaphase im Holozän. Andys Proxys haben eine mittlere Auflösung von 75 Jahren und eine mittlere Länge der Aufzeichnung von 11.697 Jahren mit geringen Standardabweichungen. Es gibt keinen signifikanten Trend einer abnehmenden Auflösung mit der Zeit, wie es bei den meisten Proxy-Rekonstruktionen der Fall ist.

Abbildung 12: Zeitliche Auflösung (linke Achse) und Länge der Aufzeichnung (rechte Achse). Ältere Daten sind rechts.

Andys Rekonstruktion zeigt, dass der Tiefpunkt der Kleinen Eiszeit die kälteste Klimaperiode des Holozäns war. Dies ist ein Merkmal jeder Nicht-Hockeyschläger-Rekonstruktion und sogar der meisten Hockeyschläger-Rekonstruktionen einschließlich der reihenweise falschen Rekonstruktion von Marcott et al., 2013. Sie zeigt des Weiteren, dass die Moderne Warmzeit relativ zum allgegenwärtigen Klimasignal des Holozäns ziemlich unscheinbar daherkommt (Bohling &Davis, 2001).

Falls man die Übersicht der Referenzen der Rekonstruktionen öffnet und auf die rechts außen liegende Spalte schaut (Kommentare), liest man die Anmerkungen von Andy, ob das Proxy „herangezogen“ wurde, und er erklärt, warum es zurückgewiesen wurde. Die drei Hauptgründe für die Zurückweisung eines Proxys waren:

1. Grobe Auflösung (gekennzeichnet als „Auflösung zu groß“)

2. Nicht alt genug

3. Nicht jung genug

Andy hätte die instrumentelle Aufzeichnung bis zum Ende hiervon verbinden und einen Hockeyschläger erzeugen können … Aber das wäre außerhalb akademischer oder regierungsamtlicher „Wissenschaft“ betrügerisch. Es gleicht dem Zusammenfügen eines Bohrkerns mit einer seismischen Linie und es dann eine Anomalie nennt.

Hinsichtlich Marcott stellen die Autoren fest, dass ihre Holozän-Rekonstruktion nicht direkt verglichen werden können mit instrumentellen Daten infolge der Unterschiede bzgl. der Auflösung … aber sie tun es natürlich trotzdem.

Frage: Was sagen Rekonstruktionen der Paläotemperatur über den Temperaturverlauf der letzten 100 Jahre?

Antwort: Unsere Rekonstruktion der globalen Paläotemperatur enthält u. A. den so genannten „Uptick“ der Temperaturen während des 20. Jahrhunderts. Allerdings stellen wir in der Studie klar, dass dieses Einzelereignis von kürzerer Dauer ist als die inhärente Glättung bei unserem statistischen Mittelungsverfahren, und dieses basiert lediglich auf nur wenigen verfügbaren Paläo-Rekonstruktionen des von uns verwendeten Typs. Folglich ist der Anteil unserer Paläotemperaturwerte nicht statistisch robust und kann nicht als repräsentativ angesehen werden für globale Temperaturänderungen. Darum ist sie auch nicht die Grundlage unserer Schlussfolgerungen. Unsere primären Ergebnisse basieren auf einem Vergleich der längerfristigen Änderungen der Paläotemperatur aus unserer Studie mit den gut dokumentierten Temperaturänderungen, zu welchen es im vorigen Jahrhundert gekommen war, wie durch instrumentelle Aufzeichnungen dokumentiert. Obwohl es nicht Teil unserer Studie ist, wurden hoch aufgelöste Daten der letzten ~130 Jahre aus verschiedenen globalen Archiven zusammengestellt. Diese bestätigen den allgemeinen Erwärmungstrend über dieses Zeitintervall (Anderson, D.M. et al., 2013, Geophysical Research Letters, v. 40, p. 189-193; http://www.agu.org/journals/pip/gl/2012GL054271-pip.pdf).

Frage: Ist die Rate des Temperaturanstiegs der letzten 100 Jahre höher als zu irgendeiner anderen Zeit während der letzten 11.300 Jahre?

Antwort: Unsere Studie hat sich nicht direkt mit dieser Frage befasst, weil die in unserer Studie herangezogenen Aufzeichnungen der Paläotemperatur im Mittel eine zeitliche Auflösung von etwa 120 Jahren haben. Dies erlaubt keine Untersuchungen hinsichtlich der Änderungsraten innerhalb eines Jahrhunderts. Andere Faktoren tragen ebenfalls zur Glättung der Proxytemperatur-Signale bei, welche in vielen von uns verwendeten Aufzeichnungen stecken. Dazu gehören etwa Organismen im Schlamm am Grund der Tiefsee sowie chronologische Unsicherheiten in den Proxy-Aufzeichnungen, welche dazu neigen, die Signale zu glätten, wenn man sie in eine global gemittelte Rekonstruktion eingehen lässt. Wir wiesen nach, dass keine Temperaturvariabilität in unserer Rekonstruktion steckt mit Zyklen kürzer als 300 Jahre. 50% sind enthalten im Zeitmaßstab von 1000 Jahren, und fast alle sind enthalten in Perioden über 2000 Jahre oder mehr. Unsere Monte-Carlo-Analyse trägt diesen Quellen von Unsicherheit Rechnung, um eine belastbare, (wenngleich geglättete) globale Aufzeichnung zu erhalten. Jedwede geringe „Upticks“ oder „Downticks“ der Temperatur, die kürzer sind als einige hundert Jahre in unserer Zusammenstellung paläoklimatischer Daten, sind nicht belastbar, wie in unserer Studie festgestellt.

Falls der „Anteil im 20. Jahrhundert unserer Paläotemperaturen nicht statistisch robust ist“ … Warum fand das dann überhaupt Eingang in die Veröffentlichung? Die modernen instrumentellen Aufzeichnungen wären ein einzelner Datenpunkt bei der Auflösung von Marcotts Rekonstruktion.

Warum ist das von Bedeutung?

Was also würde es bedeuten, falls die Rekonstruktionen eine größere (Esper et al., 2002; Pollack and Smerdon, 2004; Moberg et al., 2005) oder geringere (Jones et al., 1998; Mann et al., 1999) Temperaturamplitude zeigen? Wir zeigen, dass Ersteres, also eine verstärkte Variabilität während vorindustriellen Zeiten zu einer Umverteilung des Gewichtes hin zu der Rolle natürlicher Faktoren bzgl. des Antriebs von Temperaturänderungen, den Einfluss anthropogener Emissionen natürlich zurückdrängt und prophezeite Zukunftsszenarien beeinflusst. Falls das der Fall sein sollte, wären Übereinkommen wie das Kyoto-Protokoll mit der Absicht, die Emissionen anthropogener Treibhausgase zu reduzieren, weniger effektiv als gedacht.

Esper et al. 2005

Es ist von Bedeutung, weil die einzige Möglichkeit, instrumentelle Daten direkt mit vorindustriellen Proxy-Daten zu vergleichen, eine Filterung der instrumentellen Daten auf die Auflösung der Proxy-Daten zu bringen. Dies ergibt Klima-Rekonstruktionen mit „verstärkter Variabilität in vorindustrieller Zeit“ und „verleiht der Rolle natürlicher Antriebe bzgl. Temperaturänderungen größeres Gewicht, was den Einfluss anthropogener Emissionen natürlich zurückdrängt und prophezeite Zukunftsszenarien beeinflusst“.

Es ist von Bedeutung, weil die Befürworter des Anthropozän als geologische Epoche sich auf den Marcott’schen Hockeyschläger stützen.

Abbildung 13: Lauft weg! Das Anthropozän ist über uns gekommen!!! Ältere Daten stehen links.

Es ist von Bedeutung, weil Hockeyschläger bemüht werden, um politische Änderungen zu rechtfertigen, Kohlenstoff-Steuern zu erheben und die individuelle Freiheit und den Wohlstand zu zerschlagen.

Viele der vermeintlichen Beweise, dass jüngste Klimaänderungen von den Normen des Holozäns abweichen, sind genauso konsistent wie das Ergebnis von Differenzen in der Auflösung von paläoklimatischen Daten und instrumentellen Aufzeichnungen.

References

Anklin, M., J. Schwander, B. Stauffer, J. Tschumi, A. Fuchs, J. M. Barnola, and D. Raynaud (1997), “CO2record between 40 and 8 kyr B.P. from the Greenland Ice Core Project ice core,” J. Geophys. Res., 102(C12), 26539–26545, doi: 10.1029/97JC00182.

Christiansen, B. and F.C. Ljungqvist. 2012. “The extra-tropical Northern Hemisphere temperature in the last two millennia: reconstructions of low-frequency variability”. Climate of the Past, Vol. 8, pp. 765-786. www.clim-past.net/8/765/2012/ doi:10.5194/cp-8-765-2012

Davis, J. C., and G. C. Bohling. “The search for patterns in ice-core temperature curves. 2001, in L. C. Gerhard, W. E. Harrison, and B. M. Hanson, eds., Geological perspectives of global climate change, p. 213–229.

Esper, J., E.R. Cook, and F.H. Schweingruber. 2002. “Low-Frequency Signals in Long Tree-Ring Chronologies for Reconstructing Past Temperature Variability”. Science, Volume 295, Number 5563, 22 March 2002.

Esper, J., R.J.S. Wilson, D.C. Frank, A. Moberg, H. Wanner, & J. Luterbacher. 2005. “Climate: past ranges and future changes”. Quaternary Science Reviews 24: 2164-2166.

Etheridge, D.M., L.P. Steele, R.L. Langenfelds, R.J. Francey, J.-M. Barnola and V.I. Morgan. 1998. “Historical CO2 records from the Law Dome DE08, DE08-2, and DSS ice cores”. In Trends: A Compendium of Data on Global Change. Carbon Dioxide Information Analysis Center, Oak Ridge National Laboratory, U.S. Department of Energy, Oak Ridge, Tenn., U.S.A.

Finsinger, W. and F. Wagner-Cremer. “Stomatal-based inference models for reconstruction of atmospheric CO2 concentration: a method assessment using a calibration and validation approach”. The Holocene 19,5 (2009) pp. 757–764

Kouwenberg, LLR. 2004. “Application of conifer needles in the reconstruction of Holocene CO2 levels”. PhD Thesis. Laboratory of Palaeobotany and Palynology, University of Utrecht.

Ljungqvist, F.C. 2009. N. Hemisphere Extra-Tropics 2,000yr Decadal Temperature Reconstruction. IGBP PAGES/World Data Center for Paleoclimatology Data Contribution Series # 2010-089. NOAA/NCDC Paleoclimatology Program, Boulder CO, USA.

Ljungqvist, F.C. 2010. “A new reconstruction of temperature variability in the extra-tropical Northern Hemisphere during the last two millennia”. Geografiska Annaler: Physical Geography, Vol. 92 A(3), pp. 339-351, September 2010. DOI: 10.1111/j.1468-459.2010.00399.x

Mann, Michael, Zhihua Zhang, Malcolm K Hughes, Raymond Bradley, Sonya K Miller, Scott Rutherford, & Fenbiao Ni. (2008). “Proxy-based Reconstructions of Hemispheric and Global Surface Temperature Variations over the Past Two Millennia”. Proceedings of the National Academy of Sciences of the United States of America. 105. 13252-7. 10.1073/pnas.0805721105.

McElwain et al., 2002. “Stomatal evidence for a decline in atmospheric CO2 concentration during the Younger Dryas stadial: a comparison with Antarctic ice core records”. J. Quaternary Sci., Vol. 17 pp. 21–29. ISSN 0267-8179

Moberg, A., D.M. Sonechkin, K. Holmgren, N.M. Datsenko & W. Karlén. 2005. “Highly variable Northern Hemisphere temperatures reconstructed from low-and high-resolution proxy data”. Nature, Vol. 433, No. 7026, pp. 613-617, 10 February 2005.

Van Hoof, Thomas, Karsten A. Kaspers, Friederike Wagner-Cremer, R.S.W. Wal, Wolfram Kürschner & Henk Visscher. (2005). “Atmospheric CO 2 during the 13th century AD: reconciliation of data from ice core measurements and stomatal frequency analysis”. Tellus B. 57. 10.3402/tellusb.v57i4.16555.

For additional references, see these Watts Up With That posts:

https://wattsupwiththat.com/2017/03/28/breaking-hockey-sticks-antarctic-ice-core-edition/

https://wattsupwiththat.com/2019/06/06/the-holocene-sea-level-highstand/

Link zu diesem Beitrag: https://wattsupwiththat.com/2019/06/25/resolution-and-hockey-sticks-part-1/

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Wenn man alle Artikel hier zusammen nimmt kann man feststellen,das so viele Unklarheiten über alle Einflussgrößen herrscht,das jeder Versuch „eindeutige Ergebnisse“ vorzuweisen fragwürdig ist.Das fängt bei den Wärmenestern an und zieht sich über die Sonderbedingungen bei der Abstrahlung von der Erdoberfläche weiter.

Warum kann man die natürlichen Vorgänge in der Natur nicht einfach beobachten und Schlüsse ziehen, um sich auf Veränderungen einzustellen. Die ganzen Mittel fehlen genau dafür.Überleben heißt anpassen.Wer das nicht kann ,wird aussortiert.80% der Unwetter sind in den Auswirkungen so schlimm,

weil die riesen Umweltschäden sich rächen und natürlich die „Menschliche Vermehrung“ zu Buche schlägt.Die dichtere Besiedlung lässt natürlich auch die Schäden anwachsen.

Das wäre eine interessante Aufgabe. Solarmodule heizen sich stärker auf als der natürliche Erdboden, kühlen aber auch sehr viel schneller wieder ab, wenn die Sonne nicht mehr scheint, während der von der Sonne tagsüber aufgeheizte Boden nachts viel länger Wärme abstrahlt. Zum zweiten: Solarzellen absorbieren die Sonnenstrahlen nicht zu 100 Prozent, je nach Einfallswinkel und Bauart wird ein Teil reflektiert, auch hier gibt es also Unterschiede zu Acker- oder Wiesenflächen. Ob man das alles präzise berechnen kann, halte ich für fraglich – man müsste mal die Luft- und Bodentemperaturen über längere Zeit im Freien messen, auf zwei Vergleichsflächen in direkter Nachbarschaft, eine mit, eine ohne Solaranlage, dann hätte man vielleicht einen Anhaltspunkt.

Dieser hochinteressante (und inhaltlich viel weitergehende) Artikel erinnert mich stark an den, den ich vor über einem Jahr schrieb und der auch auf EIKE veröffentlicht wurde:

http://diekaltesonne.de/signalanalyse-randbedingungen-fur-die-klimaforschung/

bzw.

https://www.eike-klima-energie.eu/2018/04/07/signalanalyse-randbedingungen-fuer-die-klimaforschung/

Bemerkenswerterweise wird offenbar in der Geophysik das Nyquist-Shannon-Abtasttheorem noch um den Faktor 2 verschärft:

> Laut einer Daumenregel muss eine stratigraphische Einheit mindestens so dick

> sein wie ein Viertel der seismischen Wellenlänge (λ/4), um aufgelöst werden

> zu können.

Ich habe eine Frage:Hat schon jemand die Temperaturbeeinflussung deutschlands DURCH VERSIEGELTE Flächen, speziell solarflächen berechnet oder abgeschätzt?

DANKE!

Meine Emailadresse: mwscheel@googlemail.com