Die meisten Menschen würden zustimmen, dass die Globalen Zirkulations-Modelle (Global Circulation model) GCMs primär konstruiert worden sind, um eine Bandbreite globaler und regionaler Feuchtigkeits- und Temperaturvorhersagen für Zeiträume zu erstellen, die von Jahrzehnten bis zu Jahrhunderten reichen. Diese Modelle werden jetzt reaktiviert für vieljährige bis dekadische Klimavorhersagen in zahlreichen spezifischen Unterregionen des Planeten.

GCMs fressen erhebliche Summen Geldes aus nationalen Förderquellen. Es kann sein, dass über 1,5 Milliarden Dollar Förderung der [US-]Bundesregierung während der letzten Jahrzehnte direkt in die Entwicklung von GCMs geflossen sind. Falls sie weiterhin öffentliche Gelder mit der gegenwärtigen Rate verschlingen, sollte man erwarten, dass GCMs sich auch mittels angemessener Vorhersageleistungen rentieren. Aus diesem Grunde, und einfach weil es öffentlich finanzierte Modelle sind, sind GCMs und deren Nachfolgeprodukte verpflichtet, Kalibrierungen transparent zu dokumentieren, und zwar bei jeder Anwendung.

Kein normaler Physiker oder Ingenieur würde großes Vertrauen in Modelle setzen, die keine transparente Dokumentation von Kalibrierungen zur Verfügung stellen. Viele einschließlich ich selbst argumentieren, dass sogar Modelle, welche tatsächlich Leistungen zeigen, auch etwas Vertrauen verdienen, jedoch nicht sehr weit in die Zukunft. Wie kommt es dann, dass die primären GCMs des IPCC weder die Modell-Genauigkeit noch Transparenz in Verbindung mit ihren Vorhersagen zeitigen?

Dieser Beitrag wurde geschrieben, um die überraschend schlechten Vorhersageleistungen zu erkunden, zusammen mit der genauso schlechten Dokumentation von Kalibrierungen dieser GCMs. Bei der Einführung zu diesem Thema möchte ich mich im Wesentlichen auf meine kürzlich gemachten Erfahrungen stützen, indem ich meine eigenen Ergebnisse mit denen der GCMs vergleiche. Bei diesen Bemühungen habe ich auch von den beispiellosen und undurchsichtigen Praktiken der Ersetzung von Modellergebnissen durch nicht veröffentlichte Daten erfahren. Diese Praxis ist eine neue Variante von Standardmodell-Initialisierungen.

Wer mit meinen bisherigen Begegnungen mit den ozeanischen pH-Daten (Wallace 2015) vertraut ist, kann eventuell die Ironie erkennen. Im Falle der ozeanischen pH-Werte wurden große gemessene Datenmengen durch nicht veröffentlichte Modellergebnisse ersetzt. In diesem GCM-Fall sind große Mengen von Modellergebnissen durch nicht veröffentlichte Beobachtungsdaten ersetzt worden.

Der jüngste Satz technischer und damit zusammenhängender Veröffentlichungen (WG1 AR5) des IPCC sind de facto Referenzen für die Überprüfung der GCMs. Eine damit zusammenhängende und oft zitierte Studie (Meehl et al. 2009) umreißt auch den neu definierten Zweck der GCMs. Den Autoren zufolge haben die Modelle inzwischen ihr primäres Ziel der Validierung von Treibhausgasen als Treiber einer langzeitlichen Erwärmung erreicht. Die Studie untersucht, wie diese GCMs als Nächstes angewendet werden zum Vorteil für Gesellschaften, indem regionalisierte Produkte erzeugt werden über kürzere Zeiträume, also über Jahre bis Jahrzehnte. Die Studie führt die Leser auch in die Studien der Coupled Model Intercomparison Project (CMIP) ein. Diese CMIP-Aktivitäten machen die primäre Dokumentation der Kalibrierungen der GCMs aus (Vorhersageleistungen, die zur Historie passen).

Teils aufgrund dieser Informationsquellen verlassen sich Viele im relevanten Ressourcen-Management wahrscheinlich bis zu einem gewissen Grad auf die IPCC-basierten dekadischen Vorhersagen zum Klimawandel. Diese Domäne der Klimavorhersage überlappt sich rein zufällig mit dem Gegenstand meiner eigenen kleinen Beschäftigung mit der Klimavorhersage – siehe http://www.abeqas.com.

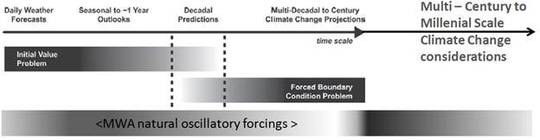

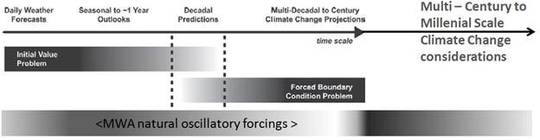

Mein Verfahren der Klimavorhersage basiert im Wesentlichen auf Regression (RB) im Vergleich zu der deterministischen Modellierungs-Strategie des IPCC. Trotz dieses bedeutenden Unterschiedes koexistieren meine Produkte und die GCMs im gleichen allgemeinen Spektrum von Klimavorhersagen. Abbildung 1 (übernommen von Meehl et al.) zeigt einige Größenordnungen der Vorhersagbarkeit in Bezug auf Ziele der Klimavorhersage. Die damit in Beziehung stehenden Vorhersage-Größenordnungen meiner Firma werden durch das unterste schattierte Band erläutert, welches ich der Originalabbildung hinzugefügt habe.

Abbildung 1: MWA-Vorhersagen umfassen ähnliche Bandbreiten wie die jüngst umgewidmeten IPCC-Modelle. Unsere Verfahren basieren ausschließlich auf verzögerten Korrelationen zu natürlichen oszillatorischen Antrieben. Abbildung übernommen aus Meehl et al. 2009.

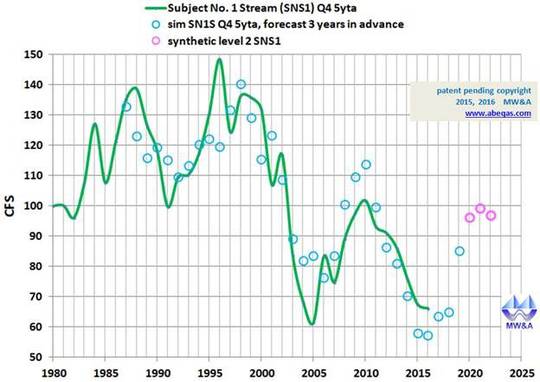

Die Abbildungen 2 und 3 sind repräsentativ für einige Klimavorhersageprodukte meiner Firma. In diesem Beispiel haben wir 5-year trailing average flow rate* eines mountain streams* für 3 bis 6 Jahre im Voraus vorhergesagt. In Abbildung 2 habe ich eine Zeitlinie (grüne durchgezogene Linie) des jährlichen mittleren Flusses dieses streams* dargestellt, und zwar via der Beobachtungen des Pegels des Pecos-Flusses nahe der Stadt Pecos im nördlichen New Mexico. Die über diese Zeitlinie gelegten offenen blauen Kreise sind meine Vorhersagen des stream flow*, und zwar auf der Grundlage von „Ozean-Antriebs“-Informationen aus vielen früheren Jahren.

[Kursiv gesetzte Termini mit * entziehen sich meinen Übersetzungskenntnissen. Anm. d. Übers.]

Abbildung 2: Vorhersagen und Beobachtungen stichprobenartig am oberen Pecos-Fluss im nördlichen New Mexico. Vorhersage: 6-jährige Projektion eines 5-jährigen trailing-Mittelwertes. Nachhersage: 5-jähriges trailing-Mittel auf der Grundlage einer dreijährigen Verzögerung zur Ursprungs-Variablen. Vorhersagen jenseits der durchgezogenen grünen Linie wurden nicht später als 31. Dezember 2015 erzeugt.

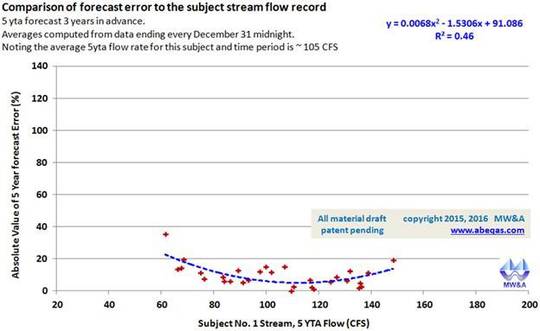

Abbildung 3: Repräsentation der Nachhersage-Leistung für 5 Jahre mit einer dreijährigen Verzögerung zum Ursprung. Die Gleichung für die Regression ist nicht gezeigt und basiert auf jüngsten Gesamt-Datenmengen. Gebiet: am oberen Pecos-Fluss im nördlichen New Mexico.

Normalerweise lenke ich die Aufmerksamkeit der Leute auf die Beobachtung, dass wir an dieser Stelle einige nachgewiesene Fähigkeit zur Vorhersage haben, um Feuchtigkeits-Defizite bzw. -Überschüsse für einen vieljährigen Zeitraum zu erkennen. Man kann sagen, dass dieses Verfahren helfen kann, einige Jahre im Voraus Dürren im Beobachtungsgebiet zu erkennen. Abbildung 3 zeigt die Güte für diesen Satz von Vorhersagen. Derartige Punktwolken haben diagnostischen Wert ebenso wie Vergleichswerte von Evaluierungen anderer Vorhersagen. Sie können auch herangezogen werden, um Werte wie den mittleren Fehler und den mittleren quadratischen Fehler zu berechnen.

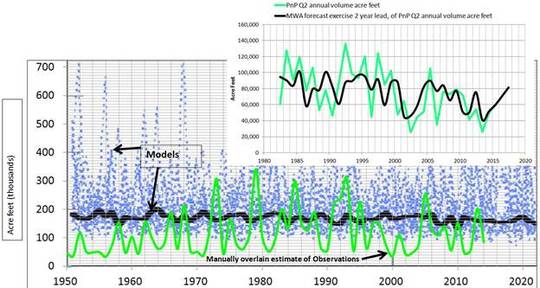

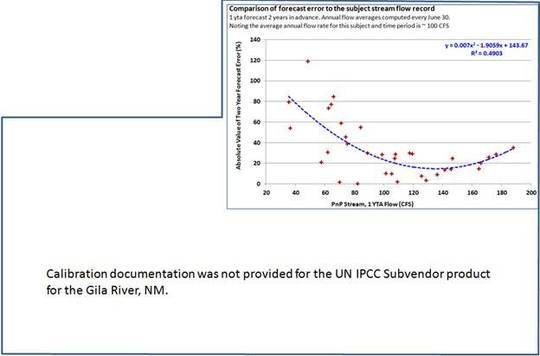

Wir haben auch damit zusammenhängende Produkte entwickelt wie eine über ein Jahr gemittelte Stream flow [Abflussrate?] zwei Jahre im Voraus vorherzusagen. Die Abbildungen 4 und 5 folgen der logischen Verteilung der Abbildungen 2 und 3. Zufälligerweise bin ich in diesem Fall auch in der Lage, unsere Vorhersagen direkt mit einem IPCC-Bericht zu untergeordneten Modellen zu vergleichen. Dieser Bericht dokumentiert die Anwendung herabgestufter GCMs, um das Volumen von Abflussraten über viele Jahrzehnte im Voraus zu simulieren, und zwar für den Gila-Fluss in New Mexico. Dieser Fluss liegt nur wenige hundert Meilen von der Pegelmessstelle am Pecos-Fluss entfernt, wo ich meine Untersuchungen durchgeführt habe.

Abbildung 4: Überlagerung tatsächlicher Beobachtungen zweier unterschiedlicher Flussbetten in New Mexico (grüne Linien) über zwei miteinander konkurrierende Vorhersage-Verfahren. Oben rechts: MWA-Nachhersage und Vorhersage von jährlichen Flussraten des Pecos-Flusses. Unten: SubVendor 001-Nachhersage jährlicher Fluss-Volumina für den Gila-Fluss.

Abbildung 5: Eine Repräsentation von Kalibrierungs-Vermögen. Oben rechts: Fehler in Prozent für jede Jahres-Schätzung: MWA 2 Jahre im Voraus für Fluss-Volumina des Pecos-Flusses in New Mexico. Unten: Fehler in Prozent für jede Jahres-Schätzung: IPCC SubVendor 001-Vorhersagen der Volumina am Gila-Fluss in New Mexico.

Allerdings enthielt jener IPCC-Bericht über die Untermodelle im Original keine Karte mit den tatsächlichen Beobachtungen, und daher gab es auch keine reproduzierbare Dokumentation der Kalibrierung. Für den Beginn des Prozesses, die Güte dieser Vorhersagen zu evaluieren, habe ich jene Beobachtungs-Zeitlinie in grün hinzugefügt. Aus dieser Graphik kann man eine Vielfalt von Modellläufen erkennen in hellem graublau, sowie ein Ensemble oder mittleres Modellergebnis in schwarz. Im Vergleich zu den beobachteten Flüssen scheinen die Modelle das minimale Fluss-Volumen für diesen Fluss konstant zu überschätzen. Außerdem zeigt kein Modell oder Ensemble eine überzeugende visuelle Korrelation mit der Historie der Beobachtung.

Die Informationen zur Kalibrierung in unserem Falle zeigen, dass unsere 2-Jahres-Vorhersagen für die Höhen und Tiefen des jährlichen Stream Flows sehr gut sind. Die Größenordnung dieser Schwingungen könnte besser sein als unsere Vorhersagen. Am besten schnitten die Vorhersagen ab in mittleren Flussjahren, und Ausreißer werden nicht immer genau vorhergesagt. Das ist kein ungewöhnliches Ergebnis. Wir teilen diese Schwäche mit den übrigen Vorhersageverfahren. Es scheint, dass quantitative Vorhersagen extremer Klimaereignisse derzeit jenseits der Möglichkeiten liegen. In jedem Falle ist es bei uns üblich, immer unsere Güte für jede Vorhersage bekannt zu machen. Während der letzten 2 Jahre hat die Mehrheit unserer auf Regression basierenden Vorhersagen ein Genauigkeit von 90% gezeigt. Mehr dazu hier.

Ich hatte das Gila-Beispiel im Oktober vorigen Jahres untersucht auf Anforderung eines weitsichtigen Klienten. Nachdem ich die Ergebnisse gesehen hatte, glaubte ich, dass es helfen könnte, die Aufmerksamkeit zu heben für unsere hohe Güte der Klimavorhersage mittels formaler Vergleiche mit zusätzlichen Anbietern. Ich entwickelte Kriterien für die Abschätzung mit dem Ziel sowohl von Transparenz als auch Güte von Klimavorhersage-Produkten für jedweden Kunden. Ich verschickte damit zusammenhängende Übersichten an eine Anzahl von Kunden und schaute auch auf deren Websites. Die Liste meiner Klienten reichte von Variationen im Old Farmers Almanach über USDA NRCS SNOTEL-Vorhersagen bis hin zum IPCC mit dessen heruntergestuften Sub-Modellen. In jedem Falle habe ich zunächst die Website des Klienten begutachtet. Falls ich auf fehlende Berichte zu Kalibrierungen stieß, habe ich dies dem Klienten per E-Mail mitgeteilt. Falls der Klient geantwortet hat, habe ich meine ursprüngliche Einschätzung mit diesen Informationen aktualisiert. Hat der Klient nicht geantwortet, habe ich einen Vermerk angebracht und weiter gemacht.

Was die Evaluierungen bei anderen Klienten betrifft, begann ich bei den High-Level-Summaries des IPCC, um generell die Inhalte ihrer Klimavor- und -nachhersagen zu verstehen. Bereits aus Abbildung 4 geht beispielsweise hervor, dass wir beide Vorhersageprodukte hatten, die über Zeit und Raum miteinander verglichen werden konnten.

Auch bin ich davon ausgegangen, dass deren Kalibrierung (Nachhersage-Güte) auf GCMs basierten, die allesamt kontinuierlich laufen gelassen worden sind über Jahrzehnte lange Simulationszeiträume, und habe sie mit historischen dekadischen Beobachtungen verglichen. Derartige Verfahren können beispielsweise bei Shuhua et al. 2008 eingesehen werden. Diese Hypothese hat sich als unrichtig erwiesen, wie ich hier detailliert beschreiben möchte.

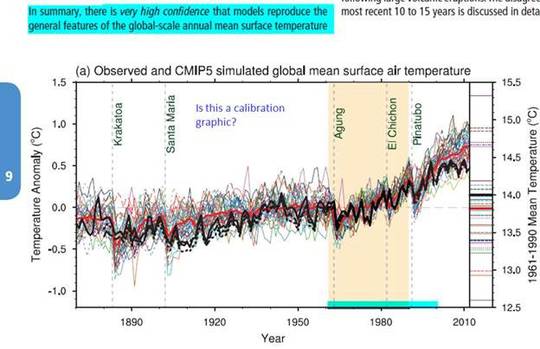

Abbildung 6 ist übernommen aus Kapitel 9 der WG1 des AR5 und repräsentiert einige potentielle Kalibrierungs-Produkte mit Bezug zu CMIP5. Die Abbildung zeigt eine offensichtliche Folge langzeitlicher Modellhistorie, die zu Zeitreihen-Produkten passt, zusammen mit einer Repräsentation von auf Beobachtungen basierenden Zeitreihen der gleichen Variable als dicke schwarze Linie. Die Variable ist in diesem Fall die Temperaturanomalie in Grad Celsius. Allerdings scheinen die Modellsimulationen in dieser Abbildung auch Läufe zu enthalten, welche jährlich einer Re-Initialisierung mit den Beobachtungen unterzogen worden sind.

Abbildung 6: In dieser Abbildung 9 aus WG1 im AR5 sind die unterschiedlichen Ergebnisse der GCMs gezeigt, zusammen mit Beobachtungen, die durch die dicke schwarze Linie repräsentiert werden. Der hellblau hinterlegte Text bezieht sich auf die IPCC-Repräsentation des prädiktiven Wertes der gezeigten GCMs. Hellblau hinterlegte Jahre heben einfach die Ergebnisse von etwa 1960 bis 2000 hervor.

Diese Initialisierungen sind bedenklich. Typischerweise werden in jedem deterministischen Modell Initialisierungen von Parametern nur einmal angebracht zu Beginn der Simulation der Zeitreihe. Wer würde argumentieren, dass diese einmalige „Initiation“ die Wurzel des Wortes ist? Es würde extensiver Qualifikationen bedürfen, wenn man jede Initialisierung durch den gesamten deterministischen Zeitrahmen wiederholt. Würde das auftreten, wären es Re-Initialisierungen.

Merryfield et al. (2010) zeigen Beschreibungen eines Re-Initialisierungs-Verfahrens eines GCMs. In diesem Falle betont das Dokument, dass derartige Verfahren im besten Falle zu Verbesserungen jahreszeitlicher Vorhersagen führen. Mit anderen Worten, von dem prädiktiven Wert ihrer Modelle wurde nicht behauptet, dass sie über jahreszeitliche Zeitrahmen von 3 Monaten oder so hinausgehen. Die Autoren stellten zusammenfassend fest, dass ein großer Teil der offensichtlichen Güte ihrer Vorhersagen der Tatsache geschuldet ist, dass sie die Modellwerte re-initialisiert hatten:

„…Wassertemperaturen im Modell sind an die beobachteten Werte angepasst [nudged] worden während eines vieljährigen Zeitraumes, der dem Beginn einer Vorhersage vorausgeht“.

Die Adjustierungen waren erforderlich, weil sie die Ozeanparameter nicht hinreichend weit in die Zukunft hinein genau modellieren oder vorhersagen konnten.

Und doch, trotz dieser Schwäche erfolgte die graduelle Ausweitung des Initialisierungs-Verfahrens durch die gesamte Gemeinschaft der GCM-Modellierer von Jahreszeitlichen zu dekadischen Vorhersagezeiträumen. Diese Initialisierungen dominierten schließlich meine Bedenken hinsichtlich der GCM-Kalibrierungen und der Berichte über deren Güte: Warum werden diese Parameter fortwährend zurückgesetzt, um zu den Beobachtungen zu passen, wenn doch die GCMs diese vorhersagen sollen? Woher bekommen sie jetzt jene Zukunfts-Beobachtungen, die sie brauchen, um ihre prädiktiven dekadischen Modelle auf Linie zu halten? Wie kommen sie dazu, ganze Publikationen von Ergebnissen mit hohem Vertrauen zu verbreiten?

Eine kürzlich erschienene Studie von Suckling und Smith (2013) befasst sich mit einigen Aspekten dieser Neuausrichtung und Initialisierung der GCMs. Vor allem verweist der Artikel auf die Praxis der Re-Initialisierung der Randbedingungen der GCMs mit jüngsten Beobachtungen. Die Autoren stellen in einfachen Worten fest:

„Gegenwärtig ist unklar, ob die Initialisierung der Modelle mit den Beobachtungen bei jedem Lauf die Güte dekadischer Vorhersagen verbessert … Grundsätzlicher, die Fähigkeit, brauchbare dekadische Vorhersagen zu erstellen mittels der Simulation von Modellen muss erst noch etabliert werden“.

Allgemein herrscht unter den Gemeinschaften der Modellvergleiche untereinander die Ansicht, dass man Modellvorhersagen nicht übernehmen sollte, die länger im Voraus Vorhersagen machen als die Zeitspanne, für die sie kalibriert worden sind. Aber trotz derartiger Bedenken liefert das CMIP5-Programm unverdrossen „ein Rahmenwerk für koordinierte Klimawandel-Experimente während der nächsten fünf Jahre, was folglich Simulationen im AR5 einschließt ebenso wie Simulationen, die über AR5 hinausgehen“. (Taylor et al. 2008).

Diese Design-Guidance von CMIP5 spezifiziert die folgenden Zeiträume zur Anwendung von Vorhersagen:

„1) kurzfristige dekadische Vorhersage-Simulationen (10 bis 30 Jahre), initialisiert in gewisser Weise mit…“ und

„2) langfristige (Zeitmaßstab von Jahrhunderten) Simulationen initialisiert von…“

Keinerlei Zweifel für diese Vorhersagezeiträume werden angegeben, anders als in Beispielen wie diesem tief inmitten von Untertiteln:

Kapitel 3. Abschnitt 1.2 Erweiterte Integrationen mit initialen Zeitpunkten Ende 1960, 1980 und 2005 für 30 Jahre. Untertitel: Weitere Details zu den Läufen: … „… die gesamte Frage der Initialisierung des Klimasystems ist eine der größten wissenschaftlichen Herausforderungen der dekadischen Vorhersage“ (Hervorhebung von mir).

Dieser seltsame Satz scheint zu behaupten, dass ihr Verfahren eine enorme wissenschaftliche Herausforderung ist. Ich frage mich, ob sie damit sagen wollten, dass dies unmöglich sein könnte. Sicherlich wringen viele Wissenschaftler und Ingenieure ihre Hände über die Aussagen in den Kapiteln 9 und 11 des IPCC-Berichtes über nichtlineare Dynamik und Chaos, einschließlich ich selbst. Aber wenn derartige Hindernisse das wirkliche Problem sind, warum sind dann meine Vorhersagen so genau? (1)

In jedem Falle erscheint die Re-Initialisierung der CMIP5-Design-Guidance jetzt institutionell zu sein für alle nachgeordneten regionalen dekadischen Vorhersagen. Das Lawrence Livermore National Laboratory (LLNL) hat das Programm der Klimamodell-Diagnose und Vergleiche [Program for Climate Model Diagnosis and Intercomparison (PCMDI)] dem Erhalt operationeller und re-initialisierender Fähigkeiten für CMIP gewidmet, und zwar hier:

http://cmip-pcmdi.llnl.gov/cmip5/docs/Taylor_CMIP5_design.pdf

http://cmip-pcmdi.llnl.gov/cmip5/experiment_design.html

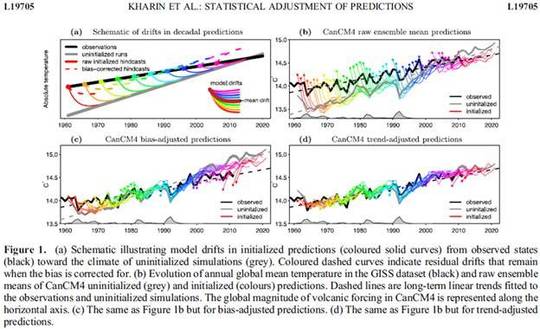

Dieses Programm enthält detaillierte Guidance und Unterstützung, wie die Re-Initialisierung implementiert werden muss. Abbildung 7 repräsentiert ein Beispiel von Kharin et al. (2012) von vier Schritten in Verbindung mit der Daten-Re-Initialisierung:

Abbildung 7: Aus Kharin et al.: Statistische Adjustierung von Vorhersagen

Bildinschrift: (a) schematische illustrierte Modellverschiebungen bei initialisierten Vorhersagen (farbige durchgezogene Linien) im Vergleich mit dem Klima von nicht initialisierten Simulationen (grau). Farbige gestrichelte Linien zeigen Verschiebungs-Residuen, die verbleiben, wenn der Bias korrigiert wird. (b) Evolution der jährlichen globalen mittleren Temperatur im GISS-Datensatz (schwarz) und Mittel des Roh-Ensembles von CanCM4 nicht initialisiert (grau) und initialisierte Vorhersagen (farbig). Die gestrichelten Linien sind langfristige lineare Trends, angepasst an die Beobachtungen und nicht initialisierte Lösungen. Die globale Größenordnung des vulkanischen Antriebs im CanCM4 ist repräsentiert entlang der horizontalen Achse. (c) Das Gleiche wie in Abbildung (b), jedoch mit Bias-korrigierten Vorhersagen. (d) ebenfalls wie in (b), aber trend-adjustierte Vorhersagen.

In dieser Studie wird kaum etwas der eigenen Vorstellung überlassen, außer jeder Reflektion, dass die Ergebnisse nur für saisonale Vorhersagen geeignet sind (falls überhaupt). Die Diagramme zeigen vier Komponenten zu den Adjustierungen:

1. Die Modelle werden jedes Jahr re-initialisiert.

2. Die re-initialisierten Modelle werden dann Bias-korrigiert.

3. Die Bias-korrigierten Modelle werden dann trend-adjustiert, und

4. Das Ensemble der Ergebnisse wird dann zusammengeführt.

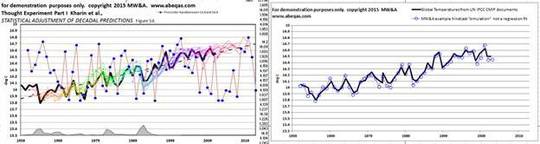

Ich habe wohl so etwas Ähnliches versucht, aber mit einem viel lockereren Prozess in einer informellen Bestätigung dieser Initialisierungs-Praxis (Abbildung 8). Ich habe auch gefunden, dass die allgemeine Praxis die Perzeption höherer Güte tatsächlich verbessert.

Abbildung 8: Ich erzeugte meine eigene Version des Initialisierungs-Verfahrens. Anstatt GCMs laufen zu lassen, erzeugte ich einen Satz von Randwert-Zahlen, gezeigt als blaue Punkte im linken Bild. Ich betrachte diese als random walk models (RWMs). Das rechte Bild dokumentiert mit den offenen blauen Kreisen, dass ich jedes RWM-Ergebnis jedes Jahr re-initialisiert habe, um sie zu den Beobachtungen passend zu machen, die ich mit der schwarzen Linie dargestellt habe. Dann habe ich die Ergebnisse übereinander gelegt via der gepunkteten blauen Linie: Ich kam auf eine sehr gute Anpassung!

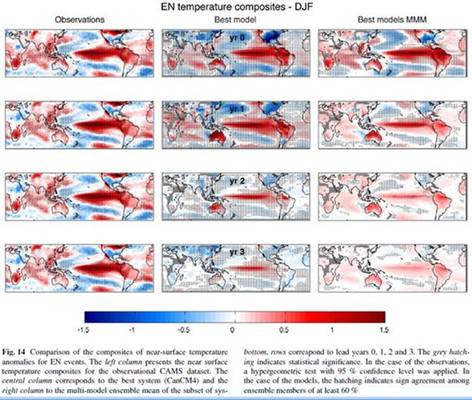

Ich hatte gedacht, dass Ozean-Parameter Hauptgegenstand der Re-Initialisierung seien. Abbildung 9, übernommen von Gonzales et al. (2015), zeigt eine partielle Erklärung für diesen Prozess.

Abbildung 9: nach Gonzales et al. 2015. Je länger man ein CMIP-Modell laufen lässt, umso weniger passen die Ergebnisse zu den Beobachtungen. Daher die Praxis der Initialisierung.

Das modellierte charakteristische Muster der Oberflächentemperatur des Pazifischen Ozeans auf beiden Hemisphären einschließlich der Äquator-Region nimmt rapide ab und werden schon nach einem Jahr von den GCMs nur noch sehr schlecht repräsentiert. Eine Re-Initialisierung scheint bei diesen Temperaturen durchgeführt worden zu sein, falls ich mich nicht irre. Nur dann können die Modelle sich ein paar weitere Monate nach vorne durchwursteln bzgl. einer potentiell plausiblen Vorhersage.

Ein offensichtlicher Appell, die Validierungs- und Kalibrierungs-Verfahren von CMIP zurückzubringen zu einer verlässlichen und transparenten Güte-Abschätzung scheint in einer Studie von Fricker et al. (2013). Allerdings bleibt der letzte Absatz der Studie unbeachtet:

„Die Ideen, die wir aufgezeigt haben sind noch etwas unterentwickelt und zeigen verschiedene Wege für zukünftige Untersuchungen auf. Wir fühlen, dass ein besseres Verständnis oder unterschiedliche Arten unechter Güte, deren Gründe und Implikationen für die Evaluierung wertvoll wäre. Viele weitere faire Messungen von Ensembles, die als unterschiedliche Arten von Stichproben interpretiert werden können, könnten ebenfalls konstruiert werden. Es wird außerdem interessant sein zu sehen, ob weitere Untersuchungen zur Vorhersagegüte über eine breite Spanne von Zeitmaßstäben helfen wird, die Qualität und Brauchbarkeit von Klimavorhersagen zu verbessern“.

Jetzt, wo der Prozess der CMIP-Validierung via Initialisationen institutionalisiert ist, glauben Klimawandel-Wissenschaftler offenbar, dass keine weitere Notwendigkeit für tatsächliche Experimente besteht, für Kalibrierungs-Dokumentationen oder Transparenz für Verbraucher. Solange das Geld fließt, werden stattdessen weiterhin die jüngsten Beobachtungen an einem Ende in die CMIPs gefüttert. Am anderen Ende werden weiterhin langfristige Klimavorhersagen für alle Gebiete, Modalitäten und Zeitspannen herauskommen. Die Entfaltung dieser ungenauen Ergebnisse wird dann weiterhin die Kosten steigen lassen und die Welt umfassen.

Es scheint, dass ohne Forderungen nach Transparenz aus der Öffentlichkeit die Multimilliarden Dollar schwere, CMIP-gesegnete GMS-Maschine weiterlaufen wird. Was kann man gegen ein titanisches und fehlgeleitetes Unterfangen tun? Ich empfehle zu Beginn, dass die Güte aller dekadischen Vorhersagen, Prophezeiungen, Projektionen und Nachhersagen aller Klimawandel-Klienten klar veröffentlicht werden, mit und ohne Initialisierungen. Anderenfalls haben kleinere Unabhängige, die weniger alarmierende, aber auch genauere Lösungen anbieten, kaum eine Chance.

References

Fricker, T.E., C.A.T. Ferro, and D.B. Stephenson, 2013, Three recommendations for evaluating climate predictions METEOROLOGICAL APPLICATIONS 20: 246 – 255 DOI: 10.1002/met.1409

Gonzalez, P.L.M,and L. Goddard, 2015, Long-lead ENSO predictability from CMIP5 decadal hindcasts. Journal of Climate Dynamics DOI 10.1007/s00382-015-2757-0

HYDROCOIN Sweden hosted workshop in 1992 on groundwater model skill inter-comparisons

http://www.iaea.org/inis/collection/NCLCollectionStore/_Public/24/002/24002761.pdf

Kharin, V.V., G. J. Boer, W. J. Merryfield, J. F. Scinocca, and W.-S. Lee, 2012, Statistical adjustment of decadal predictions in a changing climate GEOPHYSICAL RESEARCH LETTERS, VOL. 39, L19705, DOI:10.1029/2012GL052647, 2012

Meehl, GA, L Goddard, J Murphy, RJ Stouffer, G Boer, G Danabasoglu, K Dixon, MA Giorgetta, AM Greene, E Hawkins, G Hegerl, D Karoly, N Keenlyside, M Kimoto, B Kirtman, A. Navarra, R Pulwarty, D Smith, D Staffer, and T Stockdale, 2009, Decadal Prediction, Can It Be Skillful? American Meteorological Society, Articles October 2009 1467 – 1485

Merryfield, W.J., W.S. Lee, G.J. Boer, V.V.Kharin, P. Badal, J.F. Scinocca, and G.M. Flato, 2010, The first coupled historical forecasting project (CHFP1). Atmosphere-Ocean Vol. 48, Issue 4 pp. 263-283

Shuhua Li, Lisa Goddard, and David G. DeWitt, 2008: Predictive Skill of AGCM Seasonal Climate Forecasts Subject to Different SST Prediction Methodologies. J. Climate, 21, 2169–2186. doi: http://dx.doi.org/10.1175/2007JCLI1660.1

Suckling, E.B. and L.A. Smith, 2013, An evaluation of decadal probability forecasts from state-of-the-art climate models. Centre for the Analysis of Time Series, London School of Economics.

Taylor, K.E., R.J. Stouffer, and G.A. Meehl, 2008, A Summary of the CMIP5 Experiment Design, Lawrence Livermore National Laboratory http://cmip-pcmdi.llnl.gov/cmip5/docs/Taylor_CMIP5_design.pdf

UN Intergovernmental Panel on Climate Change UN IPCC home page:

UN Intergovernmental Panel on Climate Change UN IPCC WG1AR5 Chapter 9 Evaluation of Climate Models 2013

https://www.ipcc.ch/pdf/assessment-report/ar5/wg1/WG1AR5_Chapter09_FINAL.pdf

Flato, G., J. Marotzke, B. Abiodun, P. Braconnot, S.C. Chou, W. Collins, P. Cox, F. Driouech, S. Emori, V. Eyring, C. Forest, P. Gleckler, E. Guilyardi, C. Jakob, V. Kattsov, C. Reason and M. Rummukainen, 2013: Evaluation of Climate Models. In: Climate Change 2013: The Physical Science Basis. Contribution of Working Group I to the Fifth Assessment Report of the Intergovernmental Panel on Climate Change [Stocker, T.F., D. Qin, G.-K. Plattner, M. Tignor, S.K. Allen, J. Boschung, A. Nauels, Y. Xia, V. Bex and P.M. Midgley (eds.)]. Cambridge University Press, Cambridge, United Kingdom and New York, NY, USA.

UN IPCC assessment report: 2014 Climate Change 2014 Synthesis Report Summary for Policymakers

http://www.ipcc.ch/pdf/assessment-report/ar5/syr/AR5_SYR_FINAL_SPM.pdf

UN Intergovernmental Panel on Climate Change UN IPCC WG1AR5 Chapter 11 Near-term Climate Change: Projections and Predictability 2013

Kirtman, B., S.B. Power, J.A. Adedoyin, G.J. Boer, R. Bojariu, I. Camilloni, F.J. Doblas-Reyes, A.M. Fiore, M. Kimoto, G.A. Meehl, M. Prather, A. Sarr, C. Schär, R. Sutton, G.J. van Oldenborgh, G. Vecchi and H.J. Wang, 2013: Near-term Climate Change: Projections and Predictability. In: Climate Change 2013: The Physical Science Basis. Contribution of Working Group I to the Fifth Assessment Report of the Intergovernmental Panel on Climate Change (Stocker, T.F., D. Qin, G.-K. Plattner, M. Tignor, S.K. Allen, J. Boschung, A. Nauels, Y. Xia, V. Bex and P.M. Midgley (eds.)). Cambridge University Press, Cambridge, United Kingdom and New York, NY, USA.

Wallace, M.G. 2015 Ocean pH Accuracy Arguments Challenged with 80 Years of Instrumental Data.

Guest post at http://wattsupwiththat.com/2015/03/31/ocean-ph-accuracy-arguments-challenged-with-80-years-of-instrumental-data/

Übersetzt von Chris Frey EIKE, der öfter an die Grenzen seiner Fachkenntnisse stieß.

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Solange CO2 als treibende Kraft festgeschrieben steht, werden auch in Zukunft alle Adjustierungen und Re-Initialisierungen die „Prognosen“ der klimatischen Entwicklung falsch darstellen. Es wird weiterhin im Nachhinein nach Gründen gesucht, weshalb es dann doch nicht so dramatisch kam wie ursprünglich verkündet. Da werden dann „neueste Erkenntnisse“ der natürlichen Variabilität — vorher bestritten — plötzlich doch relevant.

„Jetzt sind diese Initialisierungen institutionalisiert worden, und sie führen direkte multidekadische Vorhersagen durch für das gesamte Gebiet globaler und regionaler Klimavorhersagen.“

Das ist Kaffeesatzleserei. Die GFDL-ESM-CMIP5-Familie hat global eine Auflösung von 2,02° meridional und 2,5° zonal. Also 143 mal 89 geografische Gitterboxen. Die wesentlichen atmosphärischen Strukturen kann man mit sowas nicht abbilden.