Übersetzung des Textes rechts aus dem Jahr 2007:

Monthly Weather Review

Januar 2007

Ist Ehrlichkeit nicht die klügste Politik?

Es ist falsch, die Aufzeichnungen eines beobachteten Naturphänomens zu verstümmeln oder zu unterdrücken, aber es ist auch falsch, die Aufzeichnung zu missbrauchen. Tatsächlich ist es der Missbrauch meteorologischer Daten, nicht die Beobachtung oder die Veröffentlichung, ein Verbrechen gegen die Gemeisnchaft. Beobachtung und sorgfältige Forschung müssen als nützlich ermutigt werden. Die Independent Press sollte als „Stimme des Volkes“ nicht nur „Vox Populi“ sein, sondern „Vox Dei“ und alle Schummeleien und Betrügereien unterlassen. Sie sollte die Wahrheit und die Interessen zum Wohle der ganzen Nation gegen Eigeninteressen verteidigen

Vor etwa zwei Jahren, Mitte 2012, haben wir an dieser Stelle eine Einführung in das Thema gegeben (siehe unseren Blogartikel „Die wunderbare Welt der Temperaturdaten-Korrekturen: Und plötzlich hatte sich der Trend ins Gegenteil verkehrt…”.). Der Artikel wird auch heute noch regelmäßig über Google gefunden und gelesen und hat bereits vielen Lesern die Augen geöffnet. Nein, es handelt sich leider nicht um eine Verschwörungstheorie der „Klimaskeptiker“, es ist ein reales Problem, das zu lange unter dem Radar geblieben ist. Im Folgenden wollen wir uns anschauen, wie sich die Diskussion zur Temperaturdaten-Korrektur in den letzten 24 Monaten weiterentwickelt hat.

Am 7. Juli 2014 veröffentlichte Zeke Hausfather auf Judith Currys Klimablog Climate Etc. unter dem Titel „Understanding adjustments to temperature data“ einen Rechtfertigungsversuch, weshalb alle Korrekturen als legitim zu betrachten wären. Zeke Hausfather ist ein Energiesystem-Analyst und Umweltökonom, der einst an der BEST-Temperaturstudie der University Berkeley beteiligt war. Hausfather räumt gleich zu Beginn seiner Abhandlung ein, dass die modifizierten US-Temperaturen stark von den ursprünglichen Messwerten abweichen:

Adjustierungen haben große Auswirkungen auf die Temperaturtrends in den USA und auch gewisse Auswirkungen auf globale Festlands-Temperaturtrends. Die große Menge von Adjustierungen auf US-Temperaturtrends im Zeitmaßstab von Jahrhunderten verleiht aus sich selbst heraus das unglückliche Narrativ, dass die „Regierungs-Bürokraten die Bücher fälschen“.

Die Materie ist technisch und schwierig. Bereits zuvor hatten Hausfathers Ansichten auf WUWT Kritik hervorgerufen (Beiträge von Bob Dedekind und Willis Eschenbach im Juni 2014). Wer liegt richtig, wer liegt falsch? Im Mai 2014 hatten Anthony Watts und Hausfather auf WUWT sogar einen gemeinsamen Artikel, der Diskrepanzen im Temperaturdatensatz des United States Historical Climatology Network (USHCN) zum Thema hatte. Im Gegensatz zu Steve Goddard sieht Klimaskeptiker Watts einen Teil der Temperaturkorrekturen durchaus als gerechtfertigt an. Trotzdem gab es im Juni 2014 dann doch einen Vorfall bei dem Watts Goddard Recht gab und USHCN in die Pflicht nahm. Die Fronten in dieser Diskussion sind daher alles andere als klar. Ende Juni 2014 brachte Judith Curry eine gute und wohlgewichtete Bestandsaufnahme der für Außenstehende verworrenen Diskussion.

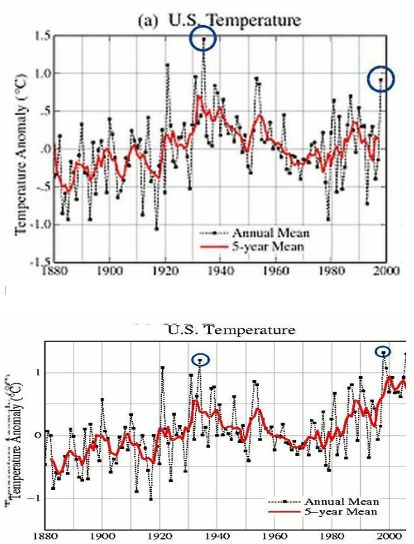

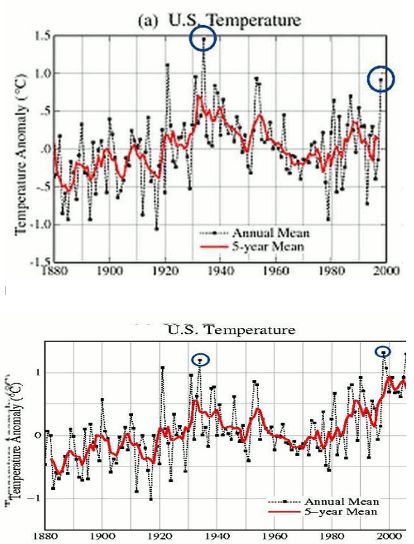

Grundsätzlich ist es schon etwas verdächtig, wenn stets die Vergangenheit künstlich kälter gemacht wird als ursprünglich gemessen. Ohne „Korrektur“ würden die heutigen Temperaturen der USA lediglich auf dem Niveau der 1930er Jahre liegen. Eine Erwärmung wäre dann für die letzten 80 Jahre nicht erkennbar. Im Gegenteil, es wäre sogar eine Abkühlung eingetreten.

In einem Manuskript bemängelte 2012 auch Frank Lansner die erheblichen Modifikationen, die am US-Temperaturdatensatz durchgeführt wurden:

Temperaturentwicklung in den USA von 1880 bs 2010 aus nicht adjustierten GHCN V2-Daten

Weltweite Temperaturtrends werden verwendet, um ein Erwärmungssignal infolge des zunehmenden CO2-Gehaltes zu schätzen. Sie sind folglich die Schlüsselparameter für die Grundlage einer angemessenen Klimapolitik. Trotz der Tatsache, dass das zusammenhängende Gebiet der USA die beste Verfügbarkeit von Temperaturdaten in der Welt aufweist, gibt es eine große Differenz zwischen jüngst (2) und früher (1) veröffentlichten Temperaturdaten von GISS. Dies wirft die Fragen nach der Robustheit der Daten auf. Der aus den nicht adjustierten Daten des Global Historical Climate Network (GHCN) berechnete Temperaturtrend in den USA zeigt, dass die dreißiger Jahre die wärmste Dekade waren, etwa 0,2 K wärmer als 2000 bis 2009. Der berechnete Temperaturtrend basiert auf Daten von 826 Stationen und ist praktisch identisch mit dem von Hansen et al. (1) berechneten Temperaturtrend. Der berechnete Temperaturtrend von 1930 bis 2010 ist etwa 0,5 K kälter als der aktualisierte GISS-Temperaturtrend in den USA (2) und etwa 0,4 K kälter als der aus den HadCRUT-Stationen berechnete Temperaturtrend. Der in den HadCRUT-Daten gefundene verstärkte Erwärmungstrend scheint mehr auf die Auswahl der Messstationen als auf die Adjustierungen der Stationsdaten zurückzuführen zu sein.

Bereits Balling & Idso hatten 2002 auf das Problem in den Geophysical Research Letters hingewiesen. Eine weitere Betrachtung steuerte 2013 Paul Homewood bei. Jim Steele führt auf Landscapes & Cycles eine ganze Reihe an fragwürdigen Korrekturbeispielen aus den USA an.

Die Diskussion erstreckte sich auch auf die Behandlung einzelner Monate, so etwa den Juli-Wert (Real Science, WUWT). Walter Dnes wies am 23. August 2014 auf WUWT darauf hin, dass die verschiedenen Monate offenbar in unterschiedlicher Weise korrigiert werden. US-Temperaturen der jüngeren Jahre sind offenbar besonders stark nach oben korrigiert worden (hier, hier, hier). Auch wird die Korrektur mit jeder neu eingeführten Datensatzversion auf mysteriöse Weise stärker. Zum Teil scheinen die offiziell mitgeteilten Korrekturen nicht einmal in der hauseigenen Datenbank enthalten zu sein.

Noch Ende der 1980er Jahre hatte man die Wärme der 1930er Jahre klaglos anerkannt. In der New York Times war am 4. Februar 1989 Erstaunliches zu lesen:

Kürzlich haben Wissenschaftler der NOAA gesagt, dass eine Studie von Temperaturmessungen für die 48 Kernstaaten der USA während des vorigen Jahrhunderts gezeigt haben, dass es während dieser Zeit keine signifikante Änderung der mittleren Temperatur gegeben hat. Dr. Phil Jones sagte in einem Telefoninterview, dass seine eigenen Ergebnisse für die 48 Staaten mit diesen Ergebnissen übereinstimmen.

Selbst zehn Jahre später, 1999, konnte James Hansen über die US-Temperaturgeschichte nichts anderes berichten:

Empirische Beweise unterstützen die Aussage nicht, dass sich das Klima plötzlich hin zu extremerer Hitze und Dürre bewegt (…) In den USA gab es während der letzten 50 Jahre, also dem Zeitraum rapide zunehmender Treibhausgas-Konzentrationen, kaum eine Änderung der Temperatur – tatsächlich gab es sogar eine leichte Abkühlung in den meisten Gebieten der Nation.

Mysteriöse Vorgänge auf Island

Ähnlich wie in den USA liegen in Island die heutigen Temperaturen auf dem Niveau der 1930er/40er Jahre. So berichtet es der Isländische Wetterdienst, und der sollte es wissen. Die globalen Datenkorrektoren sehen dies jedoch anders und haben kräftig mit ihrem Zauberstock in der Datensuppe herumgerührt. Schaut man sich die korrigierten Daten des Global Historical Climatology Network (GHCN) an, dann könnte man glauben, Island hätte sich in den letzten 70 Jahren erwärmt. Vormals harte Daten bekommen weiche Knie. Paul Homewood hat im Oktober 2012 auf WUWT die Misere detailliert protokolliert. Kurz darauf meldete sich auch David Stockwell auf der Webplattform zu Wort und zweifelte ebenfalls die Korrekturmethoden an. Wibjörn Karlén, ehemaliges Mitglied Royal Swedish Academy of Sciences, wirft GISS und NASA regelrechte Manipulation vor und geht auf das Island-Beispiel in einem Manuskript auf geoclimate.se ein. Im Tallbloke-Blog beschäftigte sich auch Roger Andrews mit den fragwürdigen Vorgängen auf Island. Zudem erschien im Dezember 2013 auf der Webseite der Swedish Stockholm’s Initiative ein Beitrag von Magnus Cederlöf, in dem die isländische Temperatur-Manipulation Schritt für Schritt enthüllt wurde.

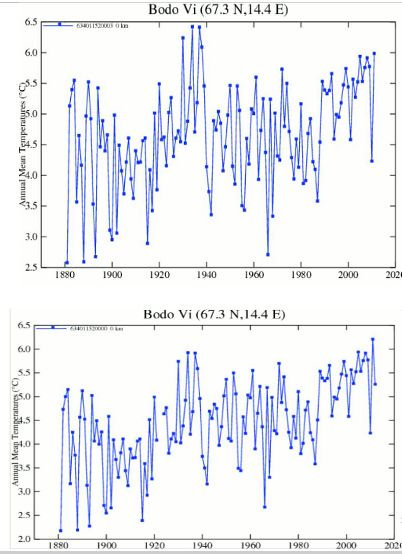

Ganz ähnlich sieht die Situation übrigens in Norwegen aus. Hier eines der bekannten Vorher-Nachher-Charts von Steven Goddard:

Auch in den Niederlanden wurde kräftig korrigiert, wie Frank Lansner 2012 auf WUWT darlegte.

Asien, Ozeanien und Antarktis

In China sind Zhang et al. 2014 ebenfalls auf Korrekturprobleme gestoßen, die die Erwärmung offenbar stärker aussehen lassen, als sie in Wirklichkeit wohl ist. Eine ausführliche Diskussion des Papers gibt es auf WUWT von Anthony Watts. Auszug aus der Kurzfassung der Arbeit:

Auswirkunen der Daten-Homogenisierung auf die Schätzung des Temperaturtrends: Der Fall der Huairou-Station in der Stadt Peking

Unsere Analyse zeigt, dass Daten-Homogenisierungen für Stationen, die aus den Innenstädten an den Stadtrand verlegt wurden, zu signifikanten Überschätzungen steigender Trends der Lufttemperatur führen kann, und dies erfordert eine sorgfältige Evaluierung und Adjustierung der städtischen Verzerrungen, bevor man die Daten für Analysen der lokalen und regionalen Klimaänderung verwendet.

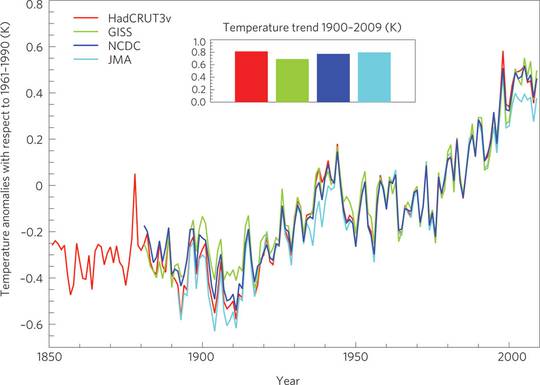

Interessanterweise liegen die Originalmessungen des japanischen Wetterdienstes JMA (hellblaue Kurve) deutlich unter den korrigierten Japan-Werten der internationalen Temperaturdatenbanken:

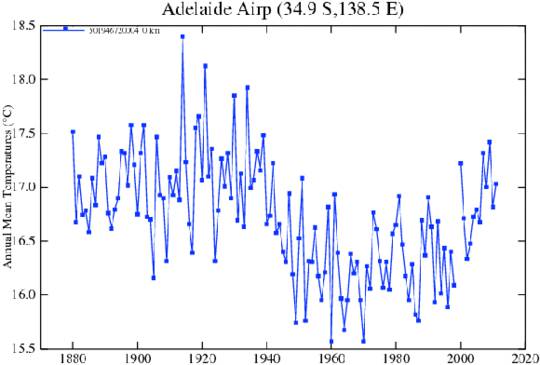

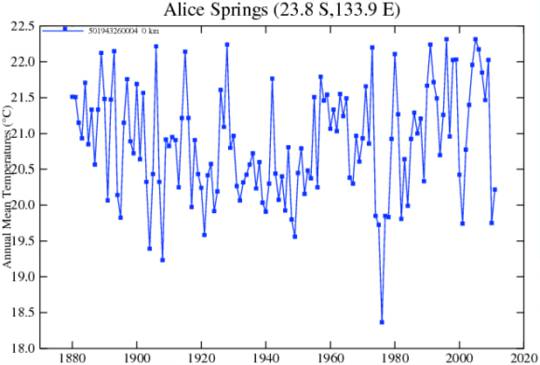

Gehen wir nun nach Australien. Roger Andrews berichtet aus dem Outback 2012, wie dort per Korrekturformel theoretische Erwärmung herbeigerechnet wurde. Im November 2013 publizierte Alberto Boretti im Fachjournal Theoretical and Applied Climatology eine Untersuchung zur Temperaturentwicklung im Northern Territory für die letzten 130 Jahre. Boretti fand, dass kaum eine Erwärmung feststellbar ist, wenn man die Datenkorrektur solide durchführt. Hier die Kurzfassung (mit Dank an The Hockey Schtick):

Das Nördliche Territorium von Australien befindet sich in der einmaligen Lage, eine Ausdehnung größer als Frankreich zu haben mit einer Bevölkerung von 200.000 und nur drei meteorologischen Stationen, die seit über 40 Jahren in Betrieb sind. Das sind die Stationen Darwin (DW), Alice Springs (AS) und Tennant Creek; und nur zwei davon, nämlich DW und AS, messen seit über 100 Jahren. Diese Stationen liegen 500 km voneinander und über 1000 km von benachbarten Stationen in Australien entfernt. Die Homogenisierung von Daten zwischen unterschiedlichen Messstellen an der gleichen Stelle ebenso wie die Methode, die fehlenden Daten abzuleiten, um mindestens 100 Jahre mit Daten abzudecken, werden detailliert analysiert, und die Auswirkungen auf die Temperaturtrends werden gleich danach untersucht. Die Verwendung ordnungsgemäß homogenisierter Daten aus über 130 Jahren und eine lineare Anpassung (fitting) ergibt hinsichtlich der Maximum- und Minimum-Temperaturen einen Trend von +0,009°C und +0,057°C pro Dekade für Alice Springs sowie -0,025°C und 0,064°C pro Dekade für Darwin. Mit den verfügbaren Daten besteht die einzige Option zur Erzeugung von Erwärmungstrends darin, die kalten Jahre Mitte der siebziger Jahre überzubetonen, was die Rückkehr zu wärmeren Temperaturen erhöht. Die Berechnung von Trends mit Beginn im Jahre 1980 zeigt immer noch eine klare Erwärmung in Alice Springs, aber ebenso klar eine Abkühlung in Tennant Creek, und ein gemischtes Verhalten mit steigenden Höchsttemperaturen und fallenden Tiefsttemperaturen in Darwin.

Schöne australische Vorher-Nachher-Bilder gibt es im Hockey-Schtick Blog zu bewundern. Hier zwei Beispiele:

Am 23. August 2013 griff dann die Tageszeitung The Australian die fragwürdige Datenmanipulation in zwei Artikeln auf (Artikel 1, Artikel 2), was große Wellen schlug:

Heiße Debatten zum Thema ,Wetteramt homogeniesiert Temperaturaufzeichnungen‘

Als im Januar 2011 Brisbane von einer Überschwemmung heimgesucht worden war, haben die Wassermassen in der Tiefgarage eines Gebäudes in dem Vorort St. Lucia am Fluss ein Corvette Sportauto absaufen lassen. Vergleicht man es mit dem Maßstab der Schäden von Dollar in Milliardenhöhe, zu der es in der Stadt durch diese vom Menschen verursachte Flut gekommen ist, scheint der Verlust eines Sportwagens nicht viel zu sein. Aber dieser Verlust fungierte als Katalysator für wachsende Zweifel und ernste Fragen an das staatliche australische Wetteramt hinsichtlich seiner Kompetenz und Integrität, die weit über die Sommerunwetter hinausgehen. Es geht bis ins Herz der Debatte um die Klimaänderung und im Besonderen darum, welche Computermodelle besser sind als reale Daten und ob die Temperaturaufzeichnungen manipuliert worden sind in einer Weise, dass jedes Jahr wärmer erscheint als das voran gegangene.

Wetteramt ,verändert Klimaangaben‘

Dem Wetteramt BOM ist vorgeworfen worden, historische Temperaturaufzeichnungen manipuliert zu haben, so dass sie danach zu einer vorbestimmten Ansicht bzgl. der globalen Erwärmung passen. In einem Streit mit BOM, dessen Anfänge bis zurück zur Brisbane-Flut im Januar 2011 reichen, hat die Forscherin Jennifer Marohashy behauptet, dass die adjustierten Temperaturreihen mehr „Propaganda“ als Wissenschaft seien.

Auszüge aus den nur für Abonnenten zugänglichen Artikeln finden Sie bei JoNova. Auch The Daily Caller griff das Thema auf. Im Laufe der sich daraufhin entwickelnden Diskussion kamen krasse Datenbehandlungsfehler durch den Australischen Wetterdienst ans Licht, so dass der Ruf nach personellen Konsequenzen laut wurde. Unter anderem redet sich der Dienst mit Wetterstationsverlegungen heraus, die er jedoch nicht belegen kann. Wiederum lohnt es sich, die Details bei JoNova nachzulesen.

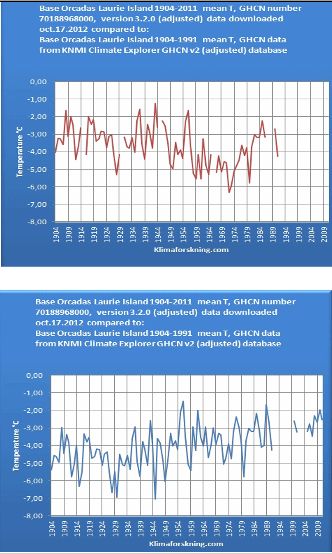

Auch aus der Antarktis sind beeindruckende und erwärmende Korrekturen zu vermelden. Roger Andrews brachte dazu im Tallbloke-Blog eine schöne Vorher-Nachher-Graphik:

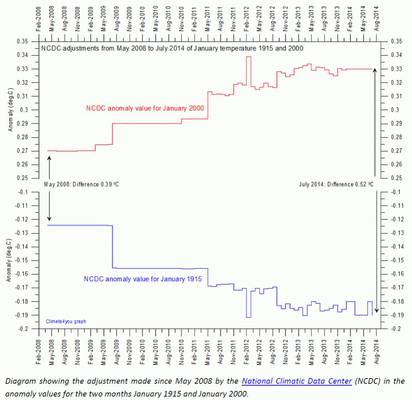

Globaler Korrekturwahn

Wenn man die Vielzahl der lokalen Korrekturen zusammenrechnet, kommt in der globalen Summe ein schöner Batzen zusammen. Ole Humlum von Climate4you zeigte im Juni-2014-Klimarundschreiben eine überraschende Graphik, in der die Entwicklung des Korrekturfaktors im Laufe der letzten 6 Jahre dargestellt wird (Abbildung unten). Während der Januar 2000 stetig künstlich wärmer gemacht wurde, gedachte man dem Januar 1915 das genaue Gegenteil an, nämlich man kühlte ihn immer weiter ab. Das National Climatic Data Center (NCDC) wird sicher eine gute Erklärung dazu haben?

Steven Goddard fand eine ganze Reihe von weiteren Korrekturen bei der NASA, angeregt durch den ehemaligen GISS-Chef und Klimaaktivisten James Hansen (hier, hier). Zum Teil wurden bereits frühere Archivversionen von der NASA vom Netz genommen bzw. gesperrt, damit die Entwicklung des Korrekturfaktors nicht mehr zurückverfolgt werden kann. Auch WUWT fand immer wieder Hinweise auf derlei mysteriöse Datenmodifikationen (hier, hier, hier, hier). Greg Goodman verfasste in Judith Currys Blog eine längere Analyse zur Problematik unter dem Titel „On the adjustments to the HadSST3 data set“. Goodman schlussfolgert, dass mit Ausnahme einiger Korrekturen für Werte aus dem Zweiten Weltkrieg, keine solide Basis für den Korrekturaktivismus vorliegt. Viele Veränderungen der Originaldaten basieren auf reiner Spekulation, die den Datensatz eher verschlechtern als verbessern. Die hinfort korrigierten “Anomalien” stellen vermutlich oftmals reale Temperaturentwicklungen dar. Hier Goodmans Schlußfolgerungen im Orginal:

HadSST3 enthält eine Reihe von Adjustierungen. Mit Ausnahme der Störungen zu Kriegszeiten sind sie auch durch Studien der Reihen nicht offensichtlich. Ihre Existenz basiert auf Spekulation und Hypothesen. Die Berechnung der Verzerrungen involviert eine Umkehrung eines wichtigen Teils der geschriebenen Metadaten der Aufzeichnung während der Periode hauptsächlicher Adjustierungen und ignoriert detaillierte Studien zum Verhältnis und der zeitlichen Abfolge der Änderungen bei der Datensammlung ebenso wie eine Spekulation hinsichtlich der Größenordnung der verschiedenen Effekte. Der hauptsächliche Effekt dieser Adjustierungen ist es, selektiv den größten Teil der langzeitlichen Variation aus den früheren zwei Dritteln der Datenreihe zu entfernen und deutlich in den Daten erkennbare etwa 10 bis 11-jährige Verteilungen zu unterbrechen. Diese Änderungen verändern den Charakter der Originaldaten fundamental. Die große Ähnlichkeit der Form zwischen den Variationen in den originalen ICOADS-Daten und den als notwendig erachteten Korrekturen bei der Stichprobe der Verzerrungen ist bemerkenswert. All dies gilt noch stärker vor dem Hintergrund, dass dokumentarische Informationen über die Grundlage der geschätzten Größenordnung und zeitlichen Abfolge der Adjustierungen fehlen. Die hier präsentierte Analyse zeigt, dass außerhalb der Zeit unmittelbar während des Krieges diese Adjustierungen die Daten verzerren und wertloser machen anstatt sie zu verbessern. Eine Anzahl verschiedener Analysen zeigt, dass eine einfache Korrektur der Kriegszeit (wie sie vor Gründung des Hadley Centers angewendet worden war) ein viel kohärenteres und glaubwürdigeres Ergebnis zeitigt. Ein Vergleich mit Studien von Nicht-Wassertemperatur-Daten [non SST data] zeigt, dass vieles der Variationen in den ICOADS-Daten ziemlich sicher realen Klimasignalen geschuldet sind und nicht Verzerrungen von Instrumenten. Diese Variationen müssen angemessen untersucht werden, anstatt sie a priori aus den Klimaaufzeichnungen zu entfernen.

Quo vadis Temperaturkorrektur? Wann platzt die Blase?

Link bei der „kalten Sonne“: Neues aus der wunderbaren Welt der Temperaturdaten-Korrekturen

Übersetzung der englischen Passagen von Chris Frey EIKE

Hinweis des Übersetzers: Dieser Artikel enthält mehrere Vorher – Nachher – Graphiken. Diese sind im Original einsehbar, ließen sich aber hier nicht übernehmen. Darum habe ich die Abbildungen als Standbilder nach dem Prinzip vorher – nachher dargestellt.

C. F.

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Herr Kowatsch, Sie schrieben: „wo sie die heißen Abgase einfach mitmessen.“

Das kann so nicht sein, denn heiße Abgase haben gemäß dem Archimedischen Prinzip die Eigenschaft aufzusteigen. Desweiteren entstehen bei den Fliegern bei Start und Landung Wirbelschleppen, die für eine gute Durchmisschung der Triebwerksabgase mit der Umgebungsluft sorgen. Wegen der sonstigen Turbulenzen sorgt ein startendes oder landendes Flugzeug (auch ohne Triebwerksabgase) dafür, daß „übehitzte“ Luft der bodennahen Grenzschicht den nötigen Impuls erhält, um audzusteigen, als sog. Themikblase. So mancher Segelflieger, der kurz vorm „Absaufen“ war, hat mit seinen Wirbeln die Thermikblase ausgelöst, die ihn oder seinen Kumpel über ihm noch einmal vor der (Außen-)Landung gerettet hat. Deshalb ist der Flughafeneffekt ein anderer.

Durch die Betonierung und Asphaltierung großer Flächen und der unmittelbaren Nähe der Flughafenmeßgeräte für Wind, Luftfeuchtigkeit und Temperatur zu diesen Flächen, gibt es eine Temperaturerhöhung der Mitteltemperatur durch den Speichereffekt der durch Einstrahlung erhitzten Flächen. Streicht der Wind mit flachem Winkel entlang der kilometerlangen Landebahn, findet eine Erwärmung ohne Thermik statt oder es bildet sich ein stationärer oder intermittierender Thermikschlauch aus, ein sog. Hausbart, den Segelflieger besonders lieben.

Bei den Städten und Ortschaften ist das im Prinzip nicht anders. Deshalb sind natürlich Stationen wie Hamburg Fuhlsbüttel, St. Pauli, Lübeck … zur Ermittlung der 30-jährigen Mittel oder des zeitlichen Verlaufs der Änderung der Mitteltemperaturen völlig unbrauchbar. Nicht weil da Flugzeuge fliegen, sondern weil da drumherum fast nur denaturierte Flächen existieren.

„Monthly Weather Review

Januar 2007 “

Das Bild zeigt Januar 1907!

Bitte Tippfehler korrigieren …

#1: Josef Kowatsch sagt:

„Nahezu alle Daten in den obigen Diagrammen wurden in die falsche Richtung korrigiert: Nämlich in den letzten 40 Jahren nach oben. Genau umgekehrt muss korrigiert werden. In den letzten 40 Jahren ist der Wärmeinseleffekt besonders gestiegen, aufgrund der Landschaftsveränderungen, Abholzungen, Urwaldrodungen, Trockenlegungen und flächenhaften Urbanisierungen. Zudem wurden viele ländliche Stationen zu Flughäfen hin verlegt, wo sie die heißen Abgase einfach mitmessen.“

Hallo Herr Kowatsch,

was ist eigentlich mit der Pt100-Umstellung???

MfG

Nahezu alle Daten in den obigen Diagrammen wurden in die falsche Richtung korrigiert: Nämlich in den letzten 40 Jahren nach oben. Genau umgekehrt muss korrigiert werden. In den letzten 40 Jahren ist der Wärmeinseleffekt besonders gestiegen, aufgrund der Landschaftsveränderungen, Abholzungen, Urwaldrodungen, Trockenlegungen und flächenhaften Urbanisierungen. Zudem wurden viele ländliche Stationen zu Flughäfen hin verlegt, wo sie die heißen Abgase einfach mitmessen. Al das führte dazu, dass der Wärmeinseleffekt bei den Messstationen in den letzten 40 Jahren besonders zugenommen hat. Wir -Kowatsch, Kämpfe,Leistenschneider- werden dies beim nächsten Artikel über die Berliner Stationen zeigen. Also: Um realistisch Temperaturen mit früher vergleichen zu können, muss der hintere Teil der Temperaturdaten nach unten abgesenkt werden und nicht nach oben.