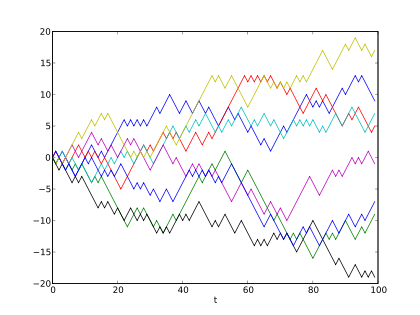

Bild rechts: Beispiel von acht Zufallsbewegungen in einer Dimension mit dem Startpunkt 0. Der Plot zeigt die gegenwärtige Position auf der Linie (vertikale Achse) in Abhängigkeit von Zeitschritten (horizontale Achse). Quelle: Wikipedia

Computermodelle scheitern kläglich bei der Vorhersage von Klimaänderungen in einzelnen Regionen.

Aus der Financial Post: Eine Studie aus dem Jahr 2011 im Journal of Forecasting nahm sich einmal den gleichen Datensatz vor und verglich Modellvorhersagen mit der „Zufallsbewegungen (random walk)“-Alternative, die einfach den letzten Wert der Periode an jeder Stelle als Vorhersage des Wertes in der nächsten Periode an dieser Stelle enthielt.

Der Test misst die Summe der Fehler relativ zu den Zufallsbewegungen. Ein perfektes Modell zählt als 0, d. h. es machte keine Fehler. Ein Modell, das nicht besser abschneidet als die Zufallsbewegung erhält die Kennzahl 1. Ein Modell mit einer Wertung größer als 1 lieferte schlechtere Ergebnisse als Raten ohne Informationen. Einfache statistische Modelle ohne Klimatologie oder Physik erhalten typischerweise eine Wertung von 0,8 bis 1, was auf geringe Verbesserungen der Zufallsbewegungen hinweist. In manchen Fällen ergab sich jedoch eine Wertung bis 1,8.

Im Kontrast dazu erzielten die Klimamodelle eine Wertung in einer Bandbreite von 2,4 bis 3,7, was auf ein totales Scheitern hindeutet, gültige Vorhersageinformationen auf regionalem Niveau zu liefern, selbst über lange Zeiträume. Die Autoren kommentieren: „Dies bedeutet, dass die gegenwärtigen (Klima-)Modelle mangelhaft sind hinsichtlich örtlicher dekadischer Prognosen, obwohl sie als Input für politische Entscheidungen benutzt werden“. …

Mehr: http://opinion.financialpost.com/2012/06/13/junk-science-week-climate-models-fail-reality-test/

Zuvor gab es bei WUWT zu diesem Thema Zufallsbewegungen hier etwas:

Ist die globale Temperatur eine Zufallsbewegung?

Aktualisierung: Die Studie Fildes, R. and N. Kourentzes, 2011: Validation and forecasting accuracy in models of climate change. International Journal of Forecasting. doi 10.1016/j.ijforecast.2011.03.008 ist als PDF hier verfügbar.

Link: http://wattsupwiththat.com/2012/06/14/climate-models-outperformed-by-random-walks/

Übersetzt von Chris Frey EIKE

Man sehe auch hier:

Klimamodelle und Temperaturrekonstruktionen wollen einfach nicht zusammenpassen: Neue Studie vom Hamburger Max-Planck Institut für Meteorologie

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Hallo Herr Georgiev, Ihre Antwort hatte ich im ganzen Threaddschungel lange übersehen. Vielleicht lohnt es sich ja trotzdem, darauf einzugehen.

„Thema verfehlt, Herr Hader. Der Kern meiner Aussage lautet, dass Simulationen nicht den Prozess wiederholen und damit zwangsläufig die gleichen Ergebnisse erreichen, sondern die Ergebnisse mit anderen, beliebigen Mitteln, abgekoppelt vom natürlichen Prozess, nachahmen. Vom Ansatz her absolut wertlos:“

Was den ersten Teil angeht, werden Sie kaum jemanden finden, der das abstreiten wird. Simulationen beruhen immer auf Vereinfachungen des natürlichen Prozesses. Nur ergibt sich daraus nicht automatisch, dass der Ansatz wertlos ist. Wir treffen permanent Annahmen über die Zukunft, wenn wir vor Entscheidungen stehen. Damit wir überhaupt einigermaßen brauchbare Entscheidungen treffen können, müssen wir ein stückweit die Folgen der Entscheidung in der Zukunft vorhersehen. Ärzte machen Vorhersagen über die Zukunft, wenn sie eine Behandlung planen. Beim Einkaufen machen Sie Vorhersagen über die Zukunft, wenn Sie vor einer Kaufentscheidung stehen.

Sie behelfen sich in dieser Diskussion, auf einen pauschalen Agnostizismus zurückzugreifen, der da lautet, man könne die natürlichen Prozesse nicht nachbilden und deshalb könne man auch keine Vorhersagen für die Zukunft treffen. Dass das pauschal so nicht stimmen kann, dürfte schnell einleuchten. Selbst wenn ich die quantenmechanischen Zustände eines Holzwürfels nie bis ins Kleinste simulieren kann, wenn ich ihn in Richtung Tischplatte werfe, so kann ich den Mittelwert der Augen bei N Würfen in einem relativ engen Intervall mit einer hohen Wahrscheinlichkeit vorhersagen.

Also wenn schon, müsste man eher überlegen, ob Vorhersagen über die Durchschnittstemperatur in den kommenden Jahrzehnten vernünftig möglich sind. Mit Pauschalaussagen wird man in dieser Frage allerdings nicht weit kommen.

„1. Weder das Wissen der Menschheit, schon gar nicht ein überdimensionierter Taschenrechner können die Vielfalt und Komplexität der Natur erfassen. Ein bisschen Strahlenspielerei reicht nicht, das Universum hat mehr Funktionen.“

Aus dem ersten Satz kann man nicht schlußfolgern, ob Klimavorhersagen in engen Grenzen möglich sind oder nicht, siehe oben.

„2. Der Algorithmenersteller hat keine Ahnung von Physik, ansonsten wäre er Physiker und nicht Codezeileschreiber. Je größer das Projekt, desto weniger hat die konzeptionelle (wissenschaftliche) Leitung Einblick in die Details der Ausführung. Glauben Sie, Wowereit hat vorgeschrieben, wie viel Adern für die Steuerleitung der Brandschutzanlage zu verlegen sind? Ich glaube, er hat nicht einmal gewusst, dass der Flughafen zur Eröffnung erst halb fertig ist! Genau so viel wissen die Wissenschaftler über den Inhalt und über die Auswirkung der einzelnen Codezeilen im Algorithmus.“

Wieso nehmen Sie an, dass Physiker keine guten Programmierer sein können. Schauen Sie mal in die erfolgreichsten Softwareunternehmen hierzulande rein. Da werden Sie jede Menge studierter Physiker bei den Softwareentwicklern finden. Das Argument, dass komplexere Softwareprojekte dazu neigen, dass in den erstellten Computerprogrammen die eigentlichen Algorithmen nicht richtig umgesetzt wurden, hört sich erstmal interessant an. :o) Aber auch das widerspricht der Praxis. Nehmen Sie hochkomplexe Programme wie SAP ERP oder OrCAD zur Entwicklung von elektronischen Schaltungen. Die müssten permanent Fehler liefern und da weiss z.B. der SAP-Chef auch nicht im Einzelnen, was im allerneusten Modul programmiert wurde. Zudem sind in der Softwareentwickung die Werkzeuge vorhanden, wie man eine Vielzahl von Programmierfehler verhindert und wie man nachprüfen kann, dass die Programme auch das tun, was sie sollen. Eine vollkommene Fehlerfreiheit wird man durch Softwaretest nicht erreichen (und auch nicht garantieren) können, aber das ist durch die hohe Redundanz an umgesetzten Klimamodellen auch nicht notwendig.

„3. Zwei komplexe Systeme mit z.T. gleichen Daten laufen innerhalb kürzester Zeit auseinander, entwickeln zwangsläufig unterschiedliche Datenbestände, wenn man nicht mittels Schnittstelle den permanenten Datenabgleich organisiert. Wo ist die Schnittstelle zwischen Natur und Modell?“

Ich selbst programmiere keine Klimamodelle, aber dafür im weitesten Sinne Vorhersage-/Klassifikationsysteme und in dem Fall, nutze ich die Natur durch konkrete Beobachtungen, die als Daten vorliegen und trainiere damit meine Modelle. Ihre Frage halte ich übrigens höchst interessant. Darüber können am besten diejenigen Antworten geben, die konkret an sowas arbeiten. Vielleicht kann beispielsweise Georg Hoffmann von Primaklima darüber Auskunft geben.

„4. Um die Richtigkeit komplexer neuentwickelten Berechnungsalgorithmen zu überprüfen, braucht man Referenzzahlen für alle Situationen, nicht nur unter bestimmten Voraussetzungen, z.B. Vergangenheit. Wo sind die Kontrollzahlen für die Zukunft? Da kann sich durchaus eine Abweichung um eine Zehnerpotenz herausstellen, obwohl in der Vergangenheit scheinbar alles übereinstimmt.“

Eine repräsentative Auswahl an Referenzzahlen genügt schon, um die Qualität der Vorhersagen zu überprüfen. Dabei zeigt sich, ob man die Zeitverläufe nur auswendig trainiert hat oder ob die Modelle die Daten generalisieren konnte. Die Schwierigkeit besteht meist darin, tatsächlich repräsentative Daten auszuwählen.

„5. Den Druck im Verhältnis Auftraggeber/Auftragnehmer können Sie aus Ihrem bequemen Sessel vermutlich nicht nachvollziehen. Mit den entsprechenden finanziellen Voraussetzungen lässt sich aber das gleiche Algorithmus-Entwicklerteam überreden, eine Simulation zu entwickeln, bei der die Sonne die Hauptrolle spielt. Es reichen handelsübliche Andeutungen über Erwartungshaltung und Stärke der Konkurrenz.“

Herr Georgiev, ich kenne durch meine Berufserfahrung sehr gut die Abhängigkeiten und Zwänge als Auftragnehmer. Hingegen scheinen Sie nicht mal im Groben auseinanderhalten zu können, wer bei einem Forschungsauftrag wen beauftragt. Sagen Sie doch mal bitte, welche praktischen Erfahrungen Sie allgemein auf dem Wissenschaftsgebiet besitzen und welche öffentlich geförderten Forschungsprojekte Sie begleitet haben. Natürlich können Sie im Projekt die Schwerpunkte anders setzen lassen. Es ist sogar eine interessante Fragestellung, ob man beispielsweise den Temperaturverlauf nur durch die Aktivität der Sonne hinreichend genau herleiten könnte. Entscheidend sind die Ergebnisse. Die können Sie nicht erkaufen.

„Das Ergebnis der Modelle ist gute Unterhaltung. Früher waren dafür die Gebrüder Grimm zuständig, heute die Computersimulationen. Verwerflich ist nur, dass die Ergebnisse als „wissenschaftlicher Nachweis“ beliebiger Behauptungen dargestellt wird, und das Schlimme, dass man hierzulande vorbehaltlos daran geglaubt wird. Wäre Selbstbetrug strafbar, würde das Deutsche Volk fast geschlossen lebenslänglich absitzen.“

Das aus dem Munde von jemanden, der sich hier zusammenreimt, wie es in der Wissenschaft zugeht, ist auch recht kurzweilig und teilweise erheiternd. :o)

#4 Thema verfehlt, Herr Hader. Der Kern meiner Aussage lautet, dass Simulationen nicht den Prozess wiederholen und damit zwangsläufig die gleichen Ergebnisse erreichen, sondern die Ergebnisse mit anderen, beliebigen Mitteln, abgekoppelt vom natürlichen Prozess, nachahmen. Vom Ansatz her absolut wertlos:

1. Weder das Wissen der Menschheit, schon gar nicht ein überdimensionierter Taschenrechner können die Vielfalt und Komplexität der Natur erfassen. Ein bisschen Strahlenspielerei reicht nicht, das Universum hat mehr Funktionen.

2. Der Algorithmenersteller hat keine Ahnung von Physik, ansonsten wäre er Physiker und nicht Codezeileschreiber. Je größer das Projekt, desto weniger hat die konzeptionelle (wissenschaftliche) Leitung Einblick in die Details der Ausführung. Glauben Sie, Wowereit hat vorgeschrieben, wie viel Adern für die Steuerleitung der Brandschutzanlage zu verlegen sind? Ich glaube, er hat nicht einmal gewusst, dass der Flughafen zur Eröffnung erst halb fertig ist! Genau so viel wissen die Wissenschaftler über den Inhalt und über die Auswirkung der einzelnen Codezeilen im Algorithmus.

3. Zwei komplexe Systeme mit z.T. gleichen Daten laufen innerhalb kürzester Zeit auseinander, entwickeln zwangsläufig unterschiedliche Datenbestände, wenn man nicht mittels Schnittstelle den permanenten Datenabgleich organisiert. Wo ist die Schnittstelle zwischen Natur und Modell?

4. Um die Richtigkeit komplexer neuentwickelten Berechnungsalgorithmen zu überprüfen, braucht man Referenzzahlen für alle Situationen, nicht nur unter bestimmten Voraussetzungen, z.B. Vergangenheit. Wo sind die Kontrollzahlen für die Zukunft? Da kann sich durchaus eine Abweichung um eine Zehnerpotenz herausstellen, obwohl in der Vergangenheit scheinbar alles übereinstimmt.

5. Den Druck im Verhältnis Auftraggeber/Auftragnehmer können Sie aus Ihrem bequemen Sessel vermutlich nicht nachvollziehen. Mit den entsprechenden finanziellen Voraussetzungen lässt sich aber das gleiche Algorithmus-Entwicklerteam überreden, eine Simulation zu entwickeln, bei der die Sonne die Hauptrolle spielt. Es reichen handelsübliche Andeutungen über Erwartungshaltung und Stärke der Konkurrenz.

Das Ergebnis der Modelle ist gute Unterhaltung. Früher waren dafür die Gebrüder Grimm zuständig, heute die Computersimulationen. Verwerflich ist nur, dass die Ergebnisse als „wissenschaftlicher Nachweis“ beliebiger Behauptungen dargestellt wird, und das Schlimme, dass man hierzulande vorbehaltlos daran geglaubt wird. Wäre Selbstbetrug strafbar, würde das Deutsche Volk fast geschlossen lebenslänglich absitzen.

Alles hier geschriebene schließt nicht aus, dass es manchmal Sinn macht, vollständig bekannte und mathematisch exakt beschreibbare Prozesse auf dem Bildschirm zu visualisieren. Ist ein ganz anderes Thema.

#4: Herr S.Hader, fleißig wie immer, nichts konretes zu äußern.

Das Thema lautet allerdings, dass random walks „genauer“ sind als die Klimamodelle.

Die Prognosen sind damit völlig wertlos.

Da werden also die tollen Rechner NACHWEISLICH mit falschen Basisannahmen gefüttert.

mfG

Na Herr Georgiev, da hätten Sie auch gleich meine Antwort aus dem Thread mit kopieren können. ;o) Tu ich es halt selbst.

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

#346: „Der Einsatz von computergestützten Modellen erhöht die Genauigkeit von Wetterprognosen entscheidend, glauben Sie, Hader? Oberflächlich gesehen habe Sie Recht. In Wirklichkeit ist aber keine Rechenmaschine genauer als der Kopf und der Bleistift. Es ist nur so, dass im gesetzten Zeitlimit die Maschine mehr Information verarbeitet und damit die Fehlerquelle manchmal ein wenig reduziert werden kann. Geben Sie einem Meteorologen alle Daten, die der Computer frisst und einen Monat Zeit, dann wird er Ihnen die Temperatur von Übermorgen besser prognostizieren. Da es keinen Sinn macht, pickt er sich im Zeitlimit nur einen Bruchteil der Informationen heraus und die Fehlerrate steigt…

Beim genaueren Betrachten stellen Sie fest, dass alle Computer und Programme nur den einen Zweck erfüllen, im Zeitlimit mehr Info zu verarbeiten. Eine erhöhnte Genauigkeit oder gar neue Erkenntnisse sind Einbildung, Selbstbetrug und Teil des Geschäfts.“

Herr Peter Georgiev, es scheint hier einiges bei den Begrifflichkeiten und Interpretation durcheinander zu geraten. Die erhöhte Genauigkeit bei Wettervorhersagen ist etwas, was man objektiv messen kann und nichts was man sich einbildet. Das man deutlich mehr Informationen mit heutiger Hardware verarbeiten kann, ist ja nichts, was jemand abstreitet. Die Relevanz dieser Geschwindigkeitssteigerung ist eigentlich auch nicht unstrittig. Wenn die höhere Rechengeschwindigkeit dazu führt, dass die Wettermodelle exakter berechnet werden können, muss man das jetzt nicht leugnen. Auf der anderen Seite hat sich auch bei den Modellen einiges getan und es ist in den letzten 25 Jahren einiges an Wissen dazugekommen. Darüber können beruflich aktive Meteorologen wesentlich mehr Auskunft geben.

„Wozu werden Computerprogramme incl. Klimamodelle geschrieben? Um das Klima vorherzusagen?? Wie naiv!! Der einzige Zweck ist der wirtschaftliche Erfolg, der Rest Mittel zum Zweck.“

Wissen was ich immer lustig finde? Wenn genau so eine Aussage von jemanden kommt und ich frage ihn, welche berufliche Erfahrung er denn auf dem Gebiet der Klimaforschung oder der Wissenschaft allgemein besitzt, dann sind die Antworten darauf sehr ernüchternd. Soll ich Sie auch mal fragen? ;o)

„2. Es müsste bekannte Klimaschwankungen folgen: Nun, da muss man sich ein bisschen mehr Mühe geben. Natürlich werden die Algorithmen immer auch weiter bearbeitet, damit die Ergebnisse bekannter Schwankungen aus unbekannten Gründen immer näher kommen. Heißt das jetzt, dass die unbekannten Gründe wie ein Sechser aus dem Lotto getroffen wurden? Die virtuelle Wiederholung der Schöpfung? Oder einfach, dass die Programmierer das notwendige Talent und Fantasie haben, um die Werte hinzubiegen? Wird denn hier nicht zwangsläufig das Pferd von hinten aufgezäumt? Beliebige Ursachen den bekannten Auswirkung virtuell nachträglich angepasst?“

Das hängt ganz von der Vorgehensweise ab. Es gibt nicht die eine dogmatische Methode, mit der sämtliche Modellrechnungen angestellt werden. Man kann versuchen, Modelle rein datengetrieben zu modifizieren, man kann genauso die Modelle wissensbasiert aufbauen und dazwischen gibt es noch jede Menge Mischformen. Ihre Vorstellung zu dem Thema sind dagegen holzschnittartig. Sie werden sich damit abfinden müssen, dass man Modellrechnung nicht alle in ein Schema pressen kann, von daher ist so eine Pauschalkritik wenig nützlich.

„3. Wenn das PIK der Auftraggeber ist, ist man sich im Klaren, dass der Bezug zwischen CO2 und Temperatur zum Ausdruck kommen muss, ansonsten läuft man Gefahr, den Auftrag zu verlieren.“

Sie haben schon eine ziemlich seltsame Auffassung, was die Beauftragung in der Wissenschaft angeht. Insbesondere was staatlich geförderte Forschungsprojekte betrifft. Zum einen, PIK ist kein Auftraggeber für Forschungsprojekte, sondern ist selbst Dienstleister in der Wissenschaft, die Grundlagenforschung betreibt und in der Leibniz-Gemeinschaft integriert ist. Forschungsaufträge kann man zudem nicht verlieren. Man kann einen Antrag stellen und über deren Bewilligung wird beim Träger entschieden. Wenn die Entscheidung gefallen ist, dann kann nicht nachträglich Geld zurückgezogen werden, weil man mit dem Ergebnis nicht zufrieden war. Mir ist wirklich nur in den aller, aller seltensten Fällen bekannt, dass sowas nur ansatzweise passiert ist.

„Der Zusammenhang CO2-Temperatur ist buchstäblich vorprogrammiert, nicht das Ergebnis des Modells.“

Richtig, weil man die direkte Wirkung von CO2 in der Atmosphäre kennt, siehe Treibhauseffekt und die Strahlenbilanz in diese Modelle programmiert. Um zu wissen, dass CO2 wie andere Treibhausgase zu mehr Energie in der Atmosphäre führt, braucht man keine Modelle. Das wusste man schon vor Zuses Erfindung. Lassen Sie sich das mal vom EIKE-Fachbeirat genauer erklären, bzw. lesen Sie die Ausarbeitungen von Prof.Lüdecke und Dr.Link zum Treibhauseffekt. Dieses Wissen dient als Grundlage für die Modelle und nicht umgekehrt.

„Ihnen ist die Fähigkeit abhanden gekommen, zwischen reellen und virtuellen Welt klar zu differenzieren.“

Also mir ist dieser Unterschied sehr bewusst. Auch ist mir der Unterschied der Kommunikation im Internet und im realen Leben bewusst, man erlebt es ja täglich hier. :o) Im übrigen wirklich jeder gute Wissenschaftler und Bearbeiter von Computermodellen kennt die Unsicherheiten seines Systems und kann Ihnen sehr viel über Stärken und Schwächen sagen, egal welchet Wert vorhergesagt werden soll. All diejenigen hier pauschal als dumme Programmanwender hinzustellen und selbst kaum praktische Erfahrungen zu besitzen, entbehrt nicht einer gewissen Komik.

am 5.7. schrieb ich meine Meinung über den Wert vom Computermodellen in der falschen Diskusionsrunde, die zu Recht geschlossen wurde. Hier nochmal der Beitrag zu Belustigung oder als Grund zur öffentlichen Steinigung durch die Anhänger der absoluten Wahrheit in den Klimamodellen:

u.a. #342 „Die richtige Anwendung der Physik (z.B. in Klimamodellen) liefert die richtige Klimasensitivität mit Toleranzen. Im Zuge der Verbesserung der Modelle werden die Toleranzen immer geringer.“

Liebe Ebel, Beacker, Hader

ich beobachte mit wachsender Erheiterung den eigentlich sinnlosen Schlagabtausch und vor allem ihre immer wieder zurückkehrende Hinweise auf die Wichtigkeit und wachsende Genauigkeit von Klimamodellen. Ich erlaube mir eine ganz einfache Frage: Wo liegen die Gemeinsamkeiten zwischen Klima und Klimamodellen? Das eine sind hochkomplexe natürliche Prozesse, die einer Reihen bekannter und noch viel mehr unbekannter Gesetzmäßigkeiten sowie wohl einen unbestimmten Grad von Zufälligkeiten folgen, das andere komplexe Algorithmen, die exakt den Willen des Programmierers und des Bedieners folgen. Mir fällt gerade kein Wort ein, dass den Begriff NICHTS an Bedeutung übertrifft. Die Gemeinsamkeiten entstehen nur im Auge des Betrachters. Der Programmierer hat keine Ahnung, wie die Natur wirklich funktioniert und glaubt, dass seine Algorithmen die Vielfalt der Natur (fast) exakt wiederspiegeln, der Bediener hat keine Ahnung, wie die Algorithmen funktionieren und glaubt das Gleiche. Und der Rest des von der naturwissenschaftlichen Verblödung bedrohten Volkes hat weder von einem, noch vom anderen einen blassen Schimmer und glaubt alles…

Der Einsatz von computergestützten Modellen erhöht die Genauigkeit von Wetterprognosen entscheidend, glauben Sie, Hader? Oberflächlich gesehen habe Sie Recht. In Wirklichkeit ist aber keine Rechenmaschine genauer als der Kopf und der Bleistift. Es ist nur so, dass im gesetzten Zeitlimit die Maschine mehr Information verarbeitet und damit die Fehlerquelle manchmal ein wenig reduziert werden kann. Geben Sie einem Meteorologen alle Daten, die der Computer frisst und einen Monat Zeit, dann wird er Ihnen die Temperatur von Übermorgen besser prognostizieren. Da es keinen Sinn macht, pickt er sich im Zeitlimit nur einen Bruchteil der Informationen heraus und die Fehlerrate steigt…

Beim genaueren Betrachten stellen Sie fest, dass alle Computer und Programme nur den einen Zweck erfüllen, im Zeitlimit mehr Info zu verarbeiten. Eine erhöhnte Genauigkeit oder gar neue Erkenntnisse sind Einbildung, Selbstbetrug und Teil des Geschäfts.

Wozu werden Computerprogramme incl. Klimamodelle geschrieben? Um das Klima vorherzusagen?? Wie naiv!! Der einzige Zweck ist der wirtschaftliche Erfolg, der Rest Mittel zum Zweck. Verzeihen Sie mir den etwas herberen Ausdruck, aber wer wiederholt mit braunen Schultern rumgelaufen ist, weil er bei der verzweifelten Jagt nach Aufträgen wieder bis hinterm Hals in den Arxxx des Kunden gekrochen ist, weis wovon ich rede. Der Rest könnte in Erwägung ziehen, dass ich Recht habe. In der Softwarebranche ist das Ziel der langfristige Wartungsvertrag, bei dem die Software gegen Geldfluss verbessert wird (Modelle werden immer besser!), ganz ohne Jagd!

Welche Eigenschaften müsste ein Klimamodell erfüllen, damit ein wirklich außergewöhnlich lukrativer Vertrag zustande kommt?:

1. Allgemein bekannte Naturgesetze dürfen nicht verletzt werden („richtige Anwendung der (bekannten) Physik“): Dürfte für gutbezahlte kompetente Programmierer keine Herausforderung sein.

2. Es müsste bekannte Klimaschwankungen folgen: Nun, da muss man sich ein bisschen mehr Mühe geben. Natürlich werden die Algorithmen immer auch weiter bearbeitet, damit die Ergebnisse bekannter Schwankungen aus unbekannten Gründen immer näher kommen. Heißt das jetzt, dass die unbekannten Gründe wie ein Sechser aus dem Lotto getroffen wurden? Die virtuelle Wiederholung der Schöpfung? Oder einfach, dass die Programmierer das notwendige Talent und Fantasie haben, um die Werte hinzubiegen? Wird denn hier nicht zwangsläufig das Pferd von hinten aufgezäumt? Beliebige Ursachen den bekannten Auswirkung virtuell nachträglich angepasst?

3. Wenn das PIK der Auftraggeber ist, ist man sich im Klaren, dass der Bezug zwischen CO2 und Temperatur zum Ausdruck kommen muss, ansonsten läuft man Gefahr, den Auftrag zu verlieren.

Der Zusammenhang CO2-Temperatur ist buchstäblich vorprogrammiert, nicht das Ergebnis des Modells. Wer das glaubt, begeht den Fehler meines halbwüchsigen Sohnes: Er kennt „die Fahreigenschaften eines BMWs, weil er oft damit gefahren ist“ (im Spiel natürlich). Ihnen ist die Fähigkeit abhanden gekommen, zwischen reellen und virtuellen Welt klar zu differenzieren.

korrektur zu meiner Ausage von Montag: Ich habe heute eine Antwort des NRW Umweltministeriums erhalten. Natürlich haben sie ihre Modelle nicht getestet. War ja auch nicht anders zu erwarten.

MfG

H.Urbahn

Sehr gute Aussage zum wert regionaler Klimamodelle. In NRW har das Umweltministerium kürzlich regionale Vorhersagen für das Klima veröffentlicht. War hier in allen Zeitungen zu lesen. Ich habe darauf hin bezugnehmend auf die diesen Artikel bei Umweltminister Remmel nachgefragt, ob und wie sie den die Güte der Modelle getestet hätten. Die Antwort kann man sich eigentlich denken: K E I N E

MfG

H. Urbahn