*BEST = Berkeley Earth Surface Temperature. Googeln!

Interessant daran ist der Umstand, dass der Autor der Präsident einer privaten Vereinigung ist, die sich WeatherSource nennt. Sie beschreibt sich selbst so:

WeatherSource ist der führende Lieferant historischer und gegenwärtiger digitaler Wetterinformationen höchster Qualität, und zwar für mehrere 10 000 Stationen in den USA und weltweit.

Das Besondere an dieser Gesellschaft ist, dass sie Wetterdaten auch hoch profilierten Kunden zur Verfügung stellen, die diese Daten nutzen zur Abschätzung von Risiken und vermuteten Ergebnissen. Diese Kunden wenden sich an dieser Gesellschaft, weil diese ein hervorragendes Produkt erzeugen; Bodendaten, die von vielen Problemen, die es im Datensatz des NCDC gibt, bereinigt sind.

Ich habe eine Präsentation von ihnen im vorigen Jahr gesehen, und es war auch das erste Mal, dass wir uns trafen. Das war ein besonderes Treffen, gab es doch hier zum ersten Mal nach der Durchsicht unserer Fotografien von Stationen eine visuelle Bestätigung der Probleme, die sie aus der Untersuchung der Daten ableiten konnten. Es war ein Zusammentreffen von Gleichgesinnten, von Daten und Metadaten.

Über ihre bereinigten Daten sagen sie Folgendes:

WeatherSource verfügt über eine einmalige Datenbank der Wetterinformation, erstellt aus einer Kombination von vielen verschiedenen Datensätzen, die in einen umfassenden „Super“-Datensatz von Wetterinformationen zusammengefasst worden ist. Es gibt heute nichts Vergleichbares auf dem Markt. Durch das Zusammenführen zahlreicher verschiedener Datensätze werden die Lücken in einem Datensatz häufig durch einen anderen Datensatz geschlossen. Dies ergibt eine Datenbasis, die konzentrierter und vollständiger ist als jeder einzelne der originalen Datensätze. Zusätzlich werden alle in Frage kommenden Daten einer Qualitätskontrolle unterzogen und korrigiert, bevor sie Eingang in die Datenbasis von WeatherSource finden. Das Endergebnis ist eine „Super“-Datenbasis, die vollständiger und genauer ist als jede andere derzeit existierende Datenbasis – Punkt!

Es ist diese „Super“-Datenbasis, die sich im Kern aller Produkte von WeatherSource befindet. Man kann sich beruhigt zurücklehnen in dem Wissen, dass alle Produkte und Leistungen von WeatherSource die besten sind, die es gibt.

Über historische Daten heißt es dort:

Umfassend und stabil sind die zwei Wörter, die den historischen Datensatz von WeatherSource am besten beschreiben.

Umfassend, weil unsere Datenbasis aus vielen Basisdaten aus verschiedenen Quellen zusammengestellt wurde. Aus diesen erzeugen wir zusammengefasste Datensätze, die vollständiger sind als jeder einzelne Datensatz. Dies erlaubt es uns, Ihnen nahezu jede Wetterinformation zur Verfügung zu stellen, die sie vielleicht brauchen.

Stabil, weil unser System der Datenkontrolle und Bereinigungsmethoden sicherstellen, dass die Daten, die Sie brauchen, akkurat und von höchster Qualität sind.

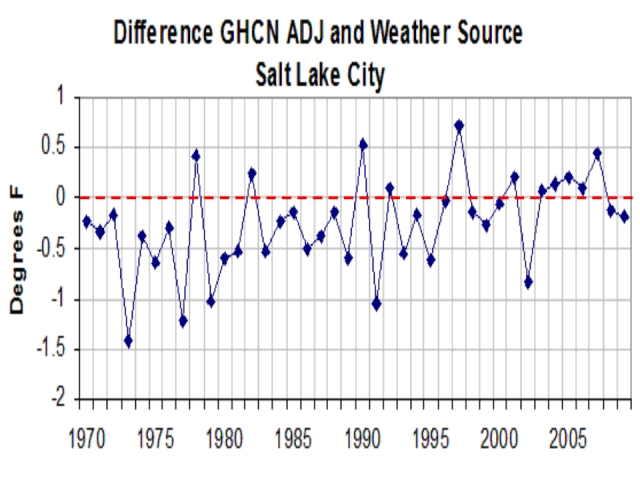

Als Beispiel folgt hier ein Vergleich des von ihnen bereinigten Datensatzes mit einer GHCN-Station:

Die Verfahren, die man benutzt, sind nicht unähnlich denen bei BEST; das Hauptaugenmerk liegt auf der Lösung von Problemen mit den historischen Daten, die von dem auf freiwilliger Basis operierenden Cooperative Observer Network (COOP) der NOAA zusammengetragen worden waren. Dieses COOP-Netzwerk enthält auch eine Unterorganisation, das U.S. Historical Climatology Network (USHCN), welches einen handverlesenen Satz von Stationen von Forschern am National Climatic Data Center (NCDC) besitzt. Dieser basiert auf der Länge der Reihen und die Bewegungen der Station:

Die Stationen des USHCN wurden gewählt mit Hilfe einer Anzahl von Kriterien, u. a. Länge der Aufzeichnungen, Prozentzahl der fehlenden Daten, Anzahl der Veränderungen der Station; alles Dinge, die die Homogenität der Daten und die flächenmäßige Abdeckung beeinflussen können.

Das Problem besteht im Folgenden: Bis das Projekt surfacestations.org ins Leben gerufen worden war, wurde nie die Umgebung der Messstation betrachtet. Den freiwilligen Beobachtern wurde nicht einmal gesagt, wie speziell diese Stationen waren, so dass diese Beobachter eben nicht immer besonders sorgfältig gemessen haben und auch nicht darauf geachtet haben, ob die Stationen die Mindestanforderungen an die Umgebung erfüllt haben, wie z. B. die 100-Fuß-Regel der NOAA:

Position des Sensors: Der Messfühler sollte sich 5 Fuß (ca. 150 cm) +/- 1 Fuß (ca. 30 cm) über dem Boden befinden. Die Beschaffenheit des Untergrundes, auf dem die Hütte steht (Strahlung) sollte typisch für das umgebende Gebiet sein. Eine offene, flache Ebene ist wünschenswert, so dass die Thermometer ungestört von der zirkulierenden Luft umweht werden. Man installiere den Sensor nicht auf einem steilen Hang oder in einer geschützten Höhlung, es sei denn, dies ist typisch für das Gebiet oder Daten aus einer solchen Örtlichkeit werden gewünscht. Wenn möglich sollte die Hütte nicht näher an einem Hindernis liegen als vier mal die Höhe des Hindernisses (Bäume, Zäune, Gebäude usw.). Der Sensor sollte sich außerdem mindestens 100 Fuß (ca. 3 m) von einer befestigten oder betonierten Oberfläche entfernt befinden.

Wie allgemein bekannt ist, und wie auch die NOAA in ihren eigenen Veröffentlichungen in dieser Sache einräumt, erfüllt nur etwa 1 von 100 Stationen im USHCN diese 100-Fuß-Regel. Dies ist die Grundlage für die Kritik, die ich schon seit einiger Zeit übe – dass die Örtlichkeit zu unberücksichtigten Verzerrungen in den Daten führt.

WeatherSource ist eine private Gesellschaft, die alle Daten einem speziellen Bereinigungsprozess unterzieht. Dieser beseitigt viele, aber nicht alle erkannten Verzerrungen und Fehler in den Daten. Ich habe einen detaillierten Ablaufplan ihrer Prozesse gesehen sowie den Vergleich vorher – nachher, und ich habe Vertrauen darin, dass sie auf diese Weise wirklich einen hervorragenden Datensatz erhalten. Jedoch, als Firma müssen sie auf ihren Vorteil achten, und ich habe beschlossen, den Prozess nicht bekannt zu machen, weil er das legale intellektuelle Eigentum der Gesellschaft ist.

Die Techniken, mit denen das BEST team die Daten bereinigt, und die ich bei einem Treffen mit ihnen im Februar 2011 kennen lernte, sind ähnlich, aber sie haben versprochen, öffentlich zugängliche Daten zu verwenden und den Prozess transparent und nachvollziehbar zu machen, wie sie es auf ihrer Website zeigen:

In dem Wissen, dass BEST unabhängig Techniken für die Bearbeitung von Bodendaten gefunden hatte, und weil es mit den Ideen der privat betriebenen Gesellschaft WeatherSource Überlappungen gab, kann man sich meine Begeisterung über dieses Projekt vorstellen.

Unglücklicherweise hat BEST am 31. März in vollem Licht der Öffentlichkeit vor dem Kongress den Ball verloren [fumbled the ball: ein Begriff aus dem American Football], so dass er dem gegnerischen „Team“ in die Hände fiel. BEST veröffentlichte einige potentiell wackelige [buggy] und zugegebenermaßen unvollständige vorläufige Ergebnisse (von denen ich die Grundlagen gesehen habe), ohne Transparenz und Nachvollziehbarkeit. BEST hat bislang nicht einmal ein Papier präsentiert.

Im Gegensatz dazu hat WeatherSource ein solches Papier erstellt, was heute online gestellt worden ist. Während es nicht von einem Journal begutachtet worden ist, wurde es von einer Anzahl professioneller Leute begutachtet, und wird natürlich mit dieser Einführung auf WUWT der weltweit größtmöglichen Begutachtung unterzogen.

Es muss festgehalten werden, dass die gesamte Datenanalyse von Mr. Gibbas von WeatherSource durchgeführt worden ist. Meine Rolle beschränkte sich darauf, Metadaten zur Verfügung zu stellen sowie Fotos von unserem Projekt zu Bodenstationen und bei der Formulierung zu helfen.

Hier findet man die vollständige Studie:

An Investigation of Temperature Trends from weather station observations representing various locations across Utah (21.5mb PDF) von Mark Gibbas

Man beachte, weil es sich hier um eine private Gesellschaft handelt und weil kleine Gesellschaften ihre IP-Rechte aus wettbewerbstechnischen Gründen schützen müssen, dass die Verfahren zur Datenbereinigung nur im Allgemeinen diskutiert werden können, aber die Gesellschaft kann den Code ohne den Verrat an ihren IP-Rechten nicht bekannt geben. Allerdings kann die Datenquelle dieser Studie auf Anfrage zur Verfügung gestellt werden, da WeatherSource den vorläufigen Zugang angeboten hat unter der Voraussetzung, dass der Endbenutzer damit forschen will und es nicht für kommerzielle Zwecke nutzt und es auch nicht unter seinem Namen in der ursprünglichen Form veröffentlicht. Nutzen Sie den Menüpunkt „contact“ hier auf WUWT, falls Sie eine Ausgabe der von WeatherSource bereinigten Daten haben wollen, nachdem Sie den bedingungen zugestimmt haben. Anonyme Anfragen werden ignoriert. Die Liste der Metadaten der Stationen findet man hier: Utah-stations-metadata (PDF) Utah-stations-metadata (Excel .xls)

Hier folgen ein paar Auszüge:

HINTERGRUND

Jedoch war es in dieser in viel kleinerem Maßstab durchgeführten Studie unser Ziel, die langzeitlichen Temperaturaufzeichnungen der über Utah verteilten Wetterstationen zu untersuchen und zu versuchen, lokale Einflüsse auf die Messungen herauszufinden. Beispielsweise ist bekannt, dass urbane Gebiete zu einem starken Erwärmungstrend führen. Weniger bekannt sind andere Einflüsse auf die Temperatur wie moderne Landwirtschaft [oder heranwachsende Bäume. A. d. Übers.].

Bevor diese örtlich begrenzten Einflüsse nicht eindeutig quantifiziert werden können, kann man nicht anfangen, Trends oder Fluktuationen in größerem Maßstab zu untersuchen, wie z. B. in einem Bundesstaat, einer Region, einem Land oder weltweit. Diese Untersuchung ist ein wichtiger Schritt zu diesem ultimativen Ziel – aber noch wichtiger, sie zeigt, dass dieses Ziel immer noch schwierig zu erreichen ist, wenn man die Ungewissheit und die Methodik betrachtet, die man angewendet hat, um ein Signal zur Klimaänderung aus den Aufzeichnungen der Bodenstationen zu extrahieren.

…

ANSATZ

Um die zahlreichen Beeinflussungen der gemessenen Temperaturreihen besser zu verstehen, identifizierte und untersuchte diese Studie zahlreiche Wetterstationen mit langen Temperaturreihen aus urbanen, landwirtschaftlichen und von natürlicher Wildnis umgebenen Stationen, aber auch von Stationen in Utah, deren Umgebung sich nur wenig oder gar nicht verändert hat.

Ursprünglich wurden für diese Studie die Daten des National Climatic Data Center (NCDC) U.S. Historical Climatology Network Version 2 (USHCNv2 2009)6 verwendet. Jedoch wurden mit der Zeit zahlreiche Unstimmigkeiten in den USHCN-Daten gefunden, so dass dieser Datensatz verworfen wurde. Stattdessen benutzte diese Studie Daten des original NCDC U.S. Cooperative Summary of the Day Data (als DSI-3200 dataset bezeichnet). Dieser Datensatz wurde mit Hilfe einer auf Regression beruhenden Methode bereinigt. Eine kurze Erklärung hiervon innerhalb des USHCN folgt in Kürze.

Innerhalb dieses bereinigten DSI-3200–Datensatzes konnten in dieser Studie Stationen in Utah mit einer mindestens 50 Jahre langen Reihe identifiziert werden. Unter Nutzung von Quellen wie Google Earth und demographischer Informationen aus einer Volkszählung in den USA wurden diese Stationen eingeteilt nach Kriterien wie Urbanität oder Landwirtschaft. Die Einschätzung erfolgte in 5 Einstufungen mit 5 als der höchsten Einstufung. Stationen mit einer niedrigen Einstufung waren solche mit einer geringen Urbanität bzw. einer geringen Landwirtschaft.

Basierend auf den urbanen und landwirtschaftlichen Indexwerten wurden die Wetterstationen in drei Gruppen eingeteilt, nämlich städtische, landwirtschaftliche oder nicht eindeutige Örtlichkeiten.

…

GRÜNDE FÜR DIE BEOBACHTETEN VARIANZEN DER TEMPERATUR

Man würde vermuten, dass zwei etwa 30 Meilen [knapp 50 km] voneinander entfernt liegende Wetterstationen in etwa gleicher Seehöhe und Umgebung konsistente Temperaturdaten innerhalb von 50 Jahren gemessen haben; die zeitliche Abfolge von Temperaturänderungen sollte nahezu perfekt korreliert sein, und beide Stationen sollten den gleichen generellen Trend zeigen. Jedoch fanden wir in der Praxis, dass solche Stationen signifikante Unterschiede bei ihren Messungen aufweisen, obwohl beide von den gleichen großräumigen Wetterlagen betroffen waren. Aber wie kann das sein? Die Antwort liegt fast immer in Veränderungen in der unmittelbaren Umgebung der Wetterstationen, die die Messungen beeinflussen.

…

Hat man einmal festgestellt, dass Veränderungen der Station auf künstliche Weise reale Wettertrends verdecken können, stellt sich die offensichtliche Frage: Zu was taugen all diese Stationsdaten, wenn jede Station Gegenstand falscher Trends wegen Veränderungen an dieser Station ist? Bei einer sehr kleinen Anzahl von Stationen ist das tatsächlich ein Problem, aber wenn man ein Gruppenmittel über mehrere Stationen bildet, heben sich die jeweiligen Veränderungen gegenseitig weitgehend auf. Der Grund hierfür beruht auf dem statistischen Prinzip, dass Veränderungen sich zu Null mitteln, während dies beispielsweise bei urbanem Wachstum nicht der Fall ist.

Also müssen wir, um den jeweiligen Trend für die drei Gruppen besser abschätzen zu können, diese zu einem Gruppentrend mitteln. Tafel 5 zeigt den mittleren Trend für jede der drei Gruppen. JJA bezeichnet die drei Sommermonate Juni, Juli und August. DJF steht für die drei Wintermonate Dezember, Januar und Februar. TMax steht für den Trend der täglichen Höchst- und TMin für den der täglichen Tiefsttemperatur. Die vertikale Achse zeigt den Trend in Grad pro Jahr.

Aus der Tafel 5 lässt sich Folgendes entnehmen:

§ Der Trend der Minimumtemperatur ist signifikanter als der der Maximumtemperatur. Eine gründliche Untersuchung, warum das so ist, wäre sicher notwendig. Aber für jetzt wollen wir einfach festhalten, dass der Trend der Minimumtemperatur genau wie erwartet ist.

§ Die urbane Gruppe der Stationen zeigt den stärksten Trend, gefolgt von der landwirtschaftlichen Gruppe und danach derjenigen mit geringen Veränderungen

§ Der Unterschied zwischen der landwirtschaftlichen Gruppe und der ohne Veränderungen ist im Sommer ausgeprägter als im Winter.

§ Der Trend der Minimumtemperatur in der Gruppe ohne wesentliche Veränderungen ist im Sommer und Winter nahezu gleich, wohingegen der Trend der Minimumtemperatur in der landwirtschaftlichen und der urbanen Gruppe im Sommer stärker ist als im Winter.

Karte 6 zeigt den kumulierten Trend im Sommer und im Winter für die drei Gruppen in Grad Fahrenheit pro Dekade [zum Umrechnen hier]. Der städtische Wert von 0,42°F stimmt überein mit den veröffentlichten Schätzungen zwischen 0,36°F und 0,44°F pro Dekade für die gegenwärtige globale Erwärmung.

Der generelle Trend [net trend] der landwirtschaftlichen Gruppe beträgt 0,27°F pro Dekade und liegt damit um 37% unter dem Trend der urbanen Gruppe. Der Trend der Gruppe ohne wesentliche Veränderungen beträgt 0,20°F pro Dekade oder 52% des urbanen Wertes.

SCHLUSSFOLGERUNGEN

Diese Studie hat gezeigt, dass es signifikante Unterschiede in den Temperaturtrends zwischen Wetterstationen in urbanen, landwirtschaftlichen und geringen Veränderungen gibt. Außerdem wurde gezeigt, dass urbane Stationen signifikant höhere Trends zeigen, hervorgerufen durch zahlreiche urbane Faktoren, die nichts mit dem CO2-Gehalt der Luft zu tun haben. Es konnte auch bewiesen werden, dass Stationen in landwirtschaftlicher Umgebung einen Erwärmungstrend infolge zunehmender Feuchtigkeit zeigen. Angesichts des Umstandes, dass sowohl urbane Stationen als auch solche in landwirtschaftlicher Umgebung einen Erwärmungstrend zeigen, der nichts mit einer Erwärmung durch CO2 zu tun hat, ist es sinnvoll, den Stationen ohne wesentliche Veränderungen viel mehr Gewicht zu geben. Gegenwärtig ist dies nicht der Fall, befindet sich doch der größte Teil der Stationen an Flughäfen, die per se in der Nähe urbaner Standorte liegen.

METHODE ZUR BEREINIGUNG DER TÄGLICHEN DATEN

Die in dieser Studie verwendete Methode zur Bereinigung der DSI-3200-Daten nutzt Schätzungen via Regression von benachbarten Stationen, um fehlerhafte Werte zu korrigieren oder fehlende Werte zu ergänzen. Dies ist notwendig, wenn man eine Zeitreihe von Temperaturdaten mit hoher Qualität haben will. Diese Methode zur Bereinigung dient nicht dazu, den urbanen Wärmeeffekt heraus zu rechnen, ebenso wenig wie Diskontinuitäten oder andere Einflüsse auf die gemessene Temperatur. Schlüsselfaktoren der Methode sind:

§ Anpassung aller Messungen an einen einheitlichen Morgen-, Mittag- und Abendtermin, um alle Stationswerte wirklich miteinander vergleichen zu können.

§ Alle Regressionen basieren auf jahreszeitlichen Zeitfenstern.

§ Zwei Arten von Regression wurden für jede Nachbarstation durchgeführt; außerdem eine jahreszeitliche Regression auf Basis der Daten aus drei Jahren, die um ein spezielles Datum liegen, und eine saisonale Regression, der alle Daten zugrunde liegen.

§ Regressionen von allen Nachbarstationen werden in einer Verteilung zusammengefasst, die analysiert und mit den Originalwerten der Zielstation verglichen wird. Sollten die Originalwerte der Zielstation basierend auf statistischen Tests bestätigt werden, wird sie einbezogen. Sollten hingegen die Werte unstimmig sein, werden sie durch die Regression der Station mit der größten Korrelation zur Zielstation ersetzt. In allen Fällen werden fehlende Werte der Zielstation durch Abschätzungen von Nachbarstationen mit der größten Korrelation zur Zielstation aufgefüllt.

Es hat sich gezeigt, dass die oben umrissene Methode Werte erzeugt, die höchst konsistent mit den originalen Zeitreihen sind. Dies wurde festgestellt durch die Qualifizierung akkurater Werte, die danach künstlich entfernt und durch andere Werte ersetzt wurden. Dies wurde anschließend der Bereinigungsmethode unterzogen. Die sich ergebenden eingesetzten Werte wurden danach mit den entfernten Originalwerten verglichen. Dieses Verfahren hat dazu geführt, dass Ersatzwerte im Vergleich zu den Originalwerten einen Korrelationsfaktor R2 oder 0,985 oder noch mehr haben.

– Ende der Auszüge

In einem Fall wurde bemerkt, wie eine zuvor abgelegene und ländliche Station des USHCN, und zwar die Station Snake Creek Powerhouse, zunächst von einem olympischen Sportzentrum und danach von einem bewässerten Golfplatz umgeben war. Hierzu wurde eine Fallstudie #2 durchgeführt.

Aus Fallstudie #2

Die nächste Darstellung zeigt, was nach dem Hinzufügen der von NCDC USHCN adjustierten Daten passiert. Unglücklicherweise korrigiert diese Adjustierung nicht die Daten der Station Snake Creek, und tatsächlich beeinträchtigt dieser Umstand die Qualität der Daten noch weiter. Der Trend für die Station Snake Creek ist ohnehin schon verdächtig, zeigt doch der Datensatz DSI-3200 einen aufwärts gerichteten Trend von 0, 246 oder grob ein Viertelgrad Fahrenheit pro Dekade. Im Gegensatz dazu zeigen die bereinigten Daten des USHCN einen Abkühlungstrend von -0,05 oder grob -0,5 Grad Fahrenheit pro Dekade.

Es ist klar, dass diese Adjustierung falsch ist; anderenfalls würde diese Station in Utah eine der extremsten Abkühlungen dieses Planeten erfahren.

Die Anpassungen an [die Werte der Station] Snake Creek müssen als alarmierend eingestuft werden und führen zu folgenden Schlussfolgerungen:

1. Es wird vermutet, dass die Anpassungen das Ergebnis einer einfachen automatisierten Methode sind, die eine lineare Anpassung an den Daten anbringt, so dass die Endpunkte der linearen Anpassung unrealistische Ergebnisse bringen.

2. Es ist offensichtlich, dass hier jedwede Begutachtung oder Qualitätschecks fehlen.

…

– Ende des Auszugs

Nun ist Utah gewiss nicht die Welt. Diese Studie demonstriert, was man lernen kann durch einen detaillierten Blick auf die Metadaten einer Station zusammen mit der Bereinigung von Temperaturwerten und einer Analyse. Wie in der Studie erwähnt, wurde nicht wie in der Präsentation von BEST versucht, den UHI-Effekt oder den Effekt zusätzlicher Feuchtigkeit zu korrigieren, die hauptsächlich Auswirkungen auf die Nachttemperatur hat, besonders in Gebieten mit künstlicher Bewässerung. Die menschliche Erfahrung kennt diesen Effekt aus den trockenen Wüsten im Südwesten der USA, wo es wegen der geringen Feuchtigkeit nachts sehr kalt werden kann im Gegensatz zum Südosten der USA, wo Feuchtigkeit für warme Sommernächte sorgt. Die Frage ist, wie stark die Nachttemperaturwerte durch diese zusätzliche Feuchtigkeit durch künstliche Bewässerung angehoben werden.

Eine Studie im kalifornischen Central Valley von Dr. John Christy 2006 von der UAH hat tatsächlich in einem kleinen Gebiet diesen Umstand untersucht. Er wandte besondere Sorgfalt auf, die Masse der Metadaten zu studieren, um diesem Effekt auf die Spur zu kommen. Siehe hier: Christy on irrigation and regional temperature effects

Bis wir eine Methode finden, um diese Umstände und den UHI-Effekt zu berücksichtigen, stecken die Oberflächendaten immer noch voller Ungewissheiten.

Jedoch finde ich es ermutigend, dass sich eine private Gesellschaft, die Wetterdaten mit einem inhärenten Risiko des Managements zur Verfügung stellt, bei dem es ökonomische Belohnungen gibt, falls sie recht haben, und den Ruin bedeutet, wenn sie falsch liegen, mit den Verzerrungen der Stationen von NOAA COOP befasst hat, zumindest teilweise. So etwas wird viel mehr gebraucht.

Die bloße Tatsache, dass diese Gesellschaft für den ausdrücklichen Zweck gegründet wurde, um korrekte und bereinigte Daten von der Temperatur der Erdoberfläche zu erzeugen und zu verkaufen, und dass sie Kunden haben, die dies dringend brauchen, spricht Bände.

Übersetzt von Chris Frey für EIKE

Alle Hervorhebungen (fett, kursiv) im Original!

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Warten wir doch erstmal die gesamte Studie ab, bevor sie das Ende des UHI ausrufen. Das lese ich aus diesen zwei Sätzen nämlich nicht raus. aber zwei Sätze sind ja auch nicht gerade aussagekräftig.

Oh, in #4 habe ich Watts Unrecht getan, als ich schrieb:

„Seine Kampagne zu UHI und schlechten Wetterstationen ist zu billig. Er könnte ganz leicht (Transparenz der Großen sei Dank) das tun, was schon andere (z.B. Tamino, Menne et al. 2010) getan haben: Nämlich die Erwärmungstrends der bearbeiteten Daten seiner als gut klassifizierten Stationen mit den Trends der von ihm als schlecht klassifizierten Stationen vergleichen und schauen, ob danach ein UHI-Effekt noch existiert.“

Er hat es getan und gab jetzt vorab schon mal den abstract seines papers bekannt. Es ist mir ein Vergnügen, daraus zu zitieren:

„Temperature trend estimates vary according to site classification, with poor siting leading to an overestimate of minimum temperature trends and an underestimate of maximum temperature trends, resulting in particular in a substantial difference in estimates of the diurnal temperature range trends. The opposite-signed differences of maximum and minimum temperature trends are similar in magnitude, so that the overall mean temperature trends are nearly identical across site classifications.“

Auf gut deutsch:

Seine als schlecht klassifizierten Stationen ergeben denselben Temperaturtrende wie seine als gut klassifizierten Stationen. Damit hat sich das Thema UHI und blabla wohl hoffentlich erledigt. Da muss man schon so etwas wie „diurnal temperatures“ erfinden, um überhaupt noch etwas bekritteln zu können, aber geschenkt.

@Norbert Fischer:

Linux ist ja immer ein Streitthema. Aus meienr Sicht ist Linux nur so bekannt, weil es einen so mächtigen Gegenspieler hat und sonst praktisch alleine auf dem Markt ist. Viel Feind viel Ehr. Und ganz so unabhängig ist Linux ja auch nicht, wenn man sich anschaut was da so für Firmen mit programmieren (IBM, Google um mal zwei zu nennen).

Wir sollen einer Firma doch gar nicht vertrauen. Das fordert doch niemand von uns oder wo lesen sie diese Forderung?

Das wird schon jeder Kunde selber entscheiden müssen. Allerdings hängt der wirtschaftliche Erfolg der Firma und damit ihre Existenz daran, ob sie dieses Vertrauen gewinnen und dann auch behalten kann. Qualitativ schlechte Arbeit wird in der Regel mit der Pleite bestraft. Solche Sanktionen fehlen leider in wissenschaftlichen Institutionen meistens und in politischen Körperschaften wie z.Bsp. dem IPCC fehlen sie vollkommen. Ein Garant für Qualität ist das allerdings trotzdem nicht, aber zumindest ist es ein Anreiz.

Also in dem Artikel finde ich zwei Charts mit dem direkten Vergleich der Erwärmungstrends verschiedener Stationen und natürlich findet man überall Erwärmungstrends. Muss man ja auch, da es sich seit Ende der kleinen Eiszeit erwärmt hat.

Ich schau eh lieber auf die reinen Satelitendaten. Die zeigen seit Mitte der 90er keinen Trend mehr. Sogar eine kleine Abkühlung, die aber innerhalb der Fehlertoleranz liegt. Schelnhuber nannte das Stagnation auf hohem Plateau, oder so ähnlich. Latif und einige andere sagen ja ähnliches.

Lieber Herr Fischer

Halten Sie einen Erwärmungstrend NACH einer kleinen Eiszeit für abnormal? Natürlich zeigen

auch die „gut“ klassifizierten Stationen diese ganz normale Erwärmung. Was sollten sie sonst tun, die Eiszeit ist vorbei. Die Daten der „schlechten“ Stationen sind es jedoch, die den Alarmismus befeuern, der uns bei Strafe des „Untergangs“ eine weisse Salbe namens CO-2-Vermeidung verkaufen will. Teuer

aber wirkungslos. denn CO-2 beeinflusst das klima nur wenig. Soviel sollten Sie von Herrn Lüdecke gelernt haben.

MfG

Michael Weber

Sehr geehrter Herr Tobies,

ich verstehe ihre Argumente, klingt plausibel, dass die Firma Wetterdaten aufarbeitet und verkauft.

Die Frage ist nur, warum wir einer Firma, die ihre Algorithmen zur Bereinigung, vertrauen sollten, eigentlich hatten wir lagerübergreifend andere Standards bezüglich Transparenz eingefordert.

Um bei ihrem Beispiel Software zu bleiben:

Natürlich ist es das gute Recht von Microsoft, ihre Codes nicht zu publizieren, aber genau deshalb fühle ich mich bei einem open-source-Betriebssystem wie LINUX besser aufgehoben.

Nein, ich mag Watts in der Tat nicht.

Seine Kampagne zu UHI und schlechten Wetterstationen ist zu billig. Er könnte ganz leicht (Transparenz der Großen sei Dank) das tun, was schon andere (z.B. Tamino, Menne et al. 2010) getan haben:

Nämlich die Erwärmungstrends der bearbeiteten Daten seiner als gut klassifizierten Stationen mit den Trends der von ihm als schlecht klassifizierten Stationen vergleichen und schauen, ob danach ein UHI-Effekt noch existiert. Tut er aber wohlweislich nicht, er kennt nämlich das Ergebnis.

Herr Fischer

Ich war nicht so ernüchtert das die Transparenz bei einem Unternehmen der Privatwirtschaft nicht so hoch ist wie sie in der Wissenschaft sein sollte. Das ist nichts neues. Kein Unternehmen verrät ohne Not Geschäftsgeheimnisse und erst Recht nicht ihr Kerngeschäft. Auch watts gibt sich nicht damit zufrieden, sondern er sagt das es ermutigend ist, das sich eine privatwirtschftliche Gesellschaft damit beschäftigt.

„der Verweis auf negative finanzielle Auswirkungen kann dies nicht rechtfertigen und ehrlich gesagt kann ich nicht nachvollziehen, warum eine Veröffentlichung finanzielle Einbußen nach sich ziehen könnten.“

Da diese Methode praktisch die Grundlage des Gesamten Geschäfts des Unternehmens ist, würde eine Veröffentlichung Konkurrenz nach sich ziehen und damit finanzielle Einbußen. Da aber Gewinn die wesentliche Maxime von Unternehmen ist, rechtfertigt dies sehr wohl die Geheimhaltung. Kaum ein Software-Unternehmen veröffentlicht seinen Code und das aus gutem Grund.

Wenn ich den Artikel richtig verstehe hat die Firma kein Kompensationsverfahren für den UHI entwickelt. Das angewendete Verfahren korrigiert wohl nur „Fehler“ in den Werten, durch den Abgleich mit vergleichbaren Stationen (sehr sehr grob gesagt). Damit bleibt der UHI in den Daten erhalten, was ja auch die charts 5 und 6 zeigen.

Ihren zweiten Kommentar kann ich nicht ganz nachvollziehen. Watt´s scheint stark enttäuscht zu sein über BEST. Ein totaler Verriss wie sie hier sagen ist es aber nicht. Im wesentlichen beschwert er sich über die mangelnde Transparenz und Nachvollziehbarkeit bereits veröffentlichter Daten, welche wie er sagt potenziell unvollständig und „buggy“ (fehlerbehaftet) sind. Transparenz war ja aber eines der wesentlichen Ziele von BEST. Daher verstehe ich seine Enttäuschung, ihre Schlussfolgerung die sie daraus ziehen verstehe ich allerdings nicht.

Auch das watts WeatherSource zu seinem Favoriten macht kann ich dem Artikel nicht entnehmen. Die Kritik im letzten Teil ist deutlich, aber natürlich auch sein Enthusiasmus.

Man merkt ziemlich deutlich das sie Watts nicht mögen. 😉

Interessant auch der abrupte Meinungsumschwung Watts in Sachen BEST-Projekt, ich zitiere aus WUWT vom 6.3.2011:

„I’ve seen some of the [BEST] methodology, and I’m pleased to say that their design handles many of the issues skeptics have raised and has done so in ways that are unique to the problem.“

„The approaches that I’ve seen during my visit give me far more confidence than the “homogenization solves all” claims from NOAA and NASA GISS, and that the BEST result will be closer to the ground truth that anything we’ve seen.“

„AND, I’M PREPARED TO ACCEPT WHATEVER RESULT THEY PRODUCE, even if it proves my premise wrong. I’m taking this bold step because the method has promise. So let’s not pay attention to the little yippers who want to tear it down before they even see the results.“

Und nun eine Artikelserie in WUWT, welche einem Totalverriss von BEST gleicht? Nein, die BEST-Methodik hat sich nicht verändert, es ist nur der Umstand, dass Muller vor Publikation von BEST-Papern (3 sind momentan im peer-review-Prozess) schon mögliche Ergebnisse andeutet, die Watts Argumentationslinie zusammenbrechen lassen.

Watts verweist darauf, dass dafür noch keine überprüfbaren Daten veröffentlich worden sind, BEST hatte aber angekündigt, alles sofort NACH dem Erscheinen des papers zur Verfügung zu stellen.

Stattdessen hat Watts die Chuzpe, WeatherSource zu seinem neuen Favoriten zu machen, obwohl diese prinzipiell NICHT ihre verwendeten Methoden und Verfahren der Öffentlichkeit zugänglich machen.

Ich werde nicht ganz schlau aus dem Artikel:

Hat „WeatherSource“ nun festgestellt, dass die Rohdaten von Stationen einen UHI-Effekt zeigen? Dies wäre nicht besonders spektakulär, dann warum hätten „die Großen“ sonst ihre Methoden entwickelt, diesen Effekt zu kompensieren.

Oder hat „WeatherSource“ einen eigenes Kompensationsverfahren entwickelt? Aber wenn die bereinigten Daten dann immer noch den UHI-Effekt zeigen, dann kann es nicht besonders gut sein.

Ich bin also etwas verwirrt und wäre dankbar, wenn mir ein Leser erklären könnte, was nun getan worden ist.

Ich ging zunächst von letzterem aus und wollte mir sofort die Methode der Bereinigung anschauen, war aber nach dieser Passage etwas ernüchtert:

„Man beachte, weil es sich hier um eine private Gesellschaft handelt und weil kleine Gesellschaften ihre IP-Rechte aus wettbewerbstechnischen Gründen schützen müssen, dass die Verfahren zur Datenbereinigung nur im Allgemeinen diskutiert werden können, aber die Gesellschaft kann den Code ohne den Verrat an ihren IP-Rechten nicht bekannt geben.“

Genügt das den Ansprüchen an Transparenz, die wir alle haben?? Damit gibt sich ein Watts zufrieden?

„IP“ steht für intellectuel property, also geistiges Eigentum. Somit gibt es keinen Zwang, sein geistiges Eigentum zurückzuhalten, der Verweis auf negative finanzielle Auswirkungen kann dies nicht rechtfertigen und ehrlich gesagt kann ich nicht nachvollziehen, warum eine Veröffentlichung finanzielle Einbußen nach sich ziehen könnten.