Wie Watts zeigt, gibt es viel zu viele von der Umgebung beeinflusste Wetterstationen und nur wenige, die sich in einer angemessenen Umgebung befinden. Die Untersuchung der Daten jener Stationen ergibt eine gute Basis, mit der man die Eigenheiten der von NCDC und GISS vorgenommenen Anpassungen zeigen kann.

Eine solche Station ist Dale Enterprise im US-Bundesstaat Virginia. Das Wetterbüro hat Rohdaten dieser Station sowie monatliche und jährliche Mittelwerte aufgezeichnet, und zwar schon seit dem Jahre 1891 bis heute, eine Reihe von 119 Jahren. In dem Zeitraum zwischen 1892 und 2008 fehlen nur ganze 9 Monate (von insgesamt 1041 Monaten), das ist eine Fehlrate von weniger als 0.64 Prozent. Die Analyse unten interpoliert diese fehlenden Daten folgendermaßen: Es wurde ein Mittelwert über 10 Jahre um den fehlenden Wert gebildet. Das erschien besser als die Daten anderer Stationen zu Hilfe zu nehmen. Diese Methode minimiert die Unsicherheiten, die sich aus der Verwendung der Daten anderer Stationen ergeben, von denen nicht sicher ist, ob sie wirklich ‚sauber’ sind.

Die Station selbst liegt auf dem Feld eines Landgutes, weit weg von Gebäuden oder befestigten Flächen. Das ursprüngliche Thermometer wurde weiter benutzt, um die Messungen mit elektronischen Messfühlern seit 1994 zu vergleichen.

(Foto 1)

Die Station Dale Enterprise liegt in den sanften Hügeln östlich des Shenandoah – Tals, fast zwei Kilometer entfernt vom nächsten Dorf und über fünf Kilometer entfernt von der nächsten größeren Ortschaft Harrisonburg, einem Städtchen mit 44 000 Einwohnern.

(Foto 2)

Mit Ausnahme der Inbetriebnahme des elektronischen Sensors im Jahre 1994 und dem Interpolieren der fehlenden neun Monate gibt es keinerlei Gründe, die Rohdaten dieser Station irgendwie zu bearbeiten.

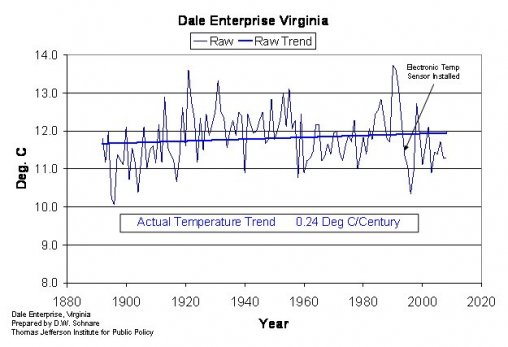

Die folgende Graphik zeigt den Temperaturverlauf aus den Rohdaten

(Bild 1: Aktueller Temperaturtrend: 0.24°C/Jahrhundert)

Es deutet sich ein stufenweiser Rückgang der Temperatur nach 1994 an. In Virginia stehen keine weiteren Stationen auf dem Lande zur Verfügung, die ebenfalls mit elektronischen Sensoren im Vergleich zu herkömmlichen Messungen mit Thermometern über eine längere Periode Werte zeigen. Der Vergleich mit urbanen Stationen ergibt eine potentiell große Abweichung zum Wärmeren während der 20 Jahre von 1984 bis 2004. Dies gilt besonders in Virginia, liegen doch diese urbanen Stationen typischerweise an Flughäfen, auf denen sich die Bebauung und die Flugbewegungen in dieser Periode erheblich verändert haben.

Bemerkenswerterweise haben weder NCDC noch GISS dieser Änderung in der Gewinnung der Daten Rechnung getragen. Daher ist jede Abweichung, die sich aus dieser Änderung eventuell ergeben hat, nach wie vor sowohl in den Originaldaten als auch in den bearbeiteten Daten enthalten.

Die Bearbeitung durch das NCDC

Viele haben sich auf die Änderungen der Daten vom NCDC durch das GISS konzentriert, aber die ‚Homogenisierung’, die durch das NCDC selbst vorgenommen wurde, ist genauso interessant, wenn auch viel schwerer zu verstehen, wie in diesem Beispiel gezeigt wird.

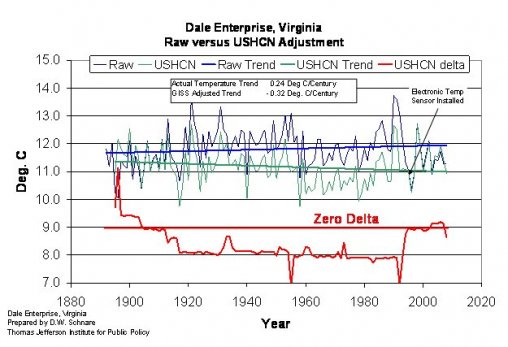

NCDC sammelt die Originaldaten und passt sie ein in einen Datensatz, der zu einem Teil des historischen Klimanetzwerkes der USA wird (United States Historical Climatology Network USHCN) wird. Die meisten Forschungsinstitute, einschließlich GISS und HadCRU, beginnen mit dem Datensatz des USHCN. Bild 2 dokumentiert die vom NCDC vorgenommenen Änderungen der Originaldaten und legt nahe, dass man Untersuchungen mit den Originaldaten beginnen sollte.

(Bild 2, Dale Enterprise, Virginia Rohdaten im Vergleich zu bearbeiteten USHCN-Daten)

Die rote Linie in der Graphik zeigt die Änderungen, die an den Rohdaten vorgenommen wurden. Angesichts der Lage der Station Dale Enterprise und dem Fehlen jeglicher mikroklimatischen Verzerrung muss man sich fragen, warum das NCDC überhaupt Änderungen an diesen Rohdaten vornimmt. So, wie die rote Linie aussieht, hat man nicht den Eindruck, dass diese Änderungen nur deshalb vorgenommen wurden, um Datenlücken zu schließen oder andere offensichtlichen Verschiebungen zu korrigieren. Tatsächlich hat das NCDC in jedem Jahr Daten verändert, außer 1998 und 1999! [Beachte: wenn ein 62-jähriger promovierter Wissenschaftler ein Ausrufezeichen benutzt, sollte seine Äußerung mit außerordentlicher Aufmerksamkeit zur Kenntnis genommen werden.]

Aus der Graphik wird klar ersichtlich, dass man bei den USHCN – Daten den ‚reset’ – Button anklicken sollte. Nur anhand dieser einen Station lässt sich feststellen, dass die USHCN – Daten ungeeignet für jedwede weitere Untersuchungen sind, und das der Anspruch eines ‚Datensatzes mit hoher Qualität’ völlig unangebracht ist.

Die Bearbeitung durch das GISS

GISS beansprucht von sich, dass seine Anpassung der Daten die Effekte korrigieren soll, die der urbane Wärmeinseleffekt auf die Aufzeichnungen hat. (In theory, they adjust stations based on the night time luminosity of the area within which the station is located. Ich bekenne, diesen Satz kriege ich nicht sinnvoll übersetzt! Herr Jäger, haben Sie einen Vorschlag? A. d. Übers.) Diese grobe Annäherung ist schon angesichts der Werte der Station Dale Enterprise falsch. Es gibt keinen hinreichenden Grund, die Werte einer Station ohne jede mikroklimatische Verzerrungen zu überarbeiten; einer Station, die fast zwei Kilometer von der nächsten Ansiedlung, über 5 Kilometer von einer Kleinstadt und über 100 km von einer Ansiedlung mit über 50 000 Einwohnern, ab denen man definitionsgemäß von einer Stadt spricht, entfernt ist. Die nächst gelegene Stadt Harrisonburg hat einen einzigen großen Industriestandort, einen Steinbruch und eine mittelgroße Universität (die James Madison Universität JMU). Fraglos haben die Studenten der JMU nie gelernt, nachts das Licht auszuschalten. Nach meiner persönlichen Erfahrung bin ich nicht einmal sicher, ob sie überhaupt nachts ins Bett gehen. Daraus ergibt sich eine Abweichung, die wir die „Trinken – Party – college kids“ – Abweichung nennen können. Ob es möglich ist, eine solche Abweichung überhaupt zu korrigieren, überlasse ich anderen. Jedenfalls handelt es sich um eine typische amerikanische Kleinstadt, überwiegend bestehend aus Einfamilienhäusern und zwei oder drei Hochhäusern. Der eigentliche Stadtkern besteht aus sechs Häuserblöcken und neben dem Getreidesilo weniger als zehn Gebäuden mit mehr als 5 Stockwerken. Sogar innerhalb dieses Stadtkerns gibt es zahlreiche Parks. Das übrige Stadtgebiet besteht aus lockerer Wohnbebauung und der Universität mit ihren Freiflächen.

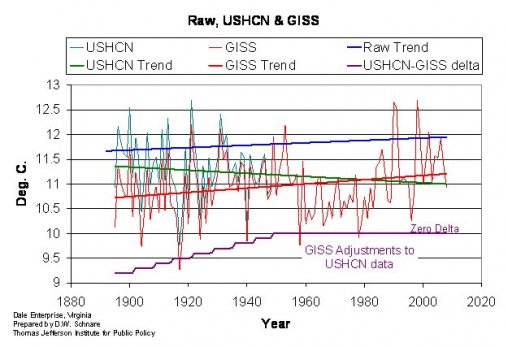

Obwohl es keinerlei Gründe gibt, die Daten der Station Dale Enterprise wegen irgendeines Wärmeinseleffektes zu verändern, hat das GISS die Daten bearbeitet, wie die nachfolgende Graphik (Bild 3) zeigt. Ich zeige diese Anpassungen, weil sie typisch sind für die grundsätzliche Natur der Art von Anpassungen, wie sie das GISS vornimmt, ohne Beachtung, wie sich diese Anpassungen auf die aktuelle Temperatur auswirken.

Bild 3

Hier sind lediglich die Daten des USHCN und GISS samt der zugehörigen Trendlinie geplottet. Eingezeichnet in blau ist aber auch die Trendlinie der Rohdaten.

Die Anpassungen der USHCN – Daten vom GISS auf die Werte der Station Dale Enterprise folgen einem wohlbekannten Muster. GISS zieht die früheren Werte nach unten und übernimmt die jüngeren Daten unverändert vom USHCN. Dadurch entsteht natürlich immer eine Verzerrung hin zu einer Erwärmung. Der Vergleich der Trendlinien in der Graphik ist jedoch etwas schwierig. Die Trends der Rohdaten, der USHCN- und der GISS – Daten sind: 0.24°C, -0.32°C und 0.43°C, pro Jahrhundert, versteht sich.

Wenn man annimmt, dass die USHCN – Daten einen „Datensatz von hoher Qualität“ darstellen, dann macht die Anpassung durch GISS viel mehr als eine Verstärkung der Erwärmung, es kehrt den Trend dieser „hohen Qualität“ der Daten um. Man beachte, dass das GISS den Erwärmungstrend im Vergleich zu den Rohdaten verdoppelt.

Diese Präsentation stellt den Beginn der Analyse von Temperaturaufzeichnungen in Virginia dar. Das ‚Center for Environmental Stewardship of the Thomas Jefferson Institute for Public Policy’ plant, sämtliche Daten aus Landgebieten in Virginia zu untersuchen, um herauszufinden, welche Landstationen am besten geeignet sind, langzeitliche Temperaturtrends abzuschätzen, egal ob lokal oder weltweit. Nur eine landesweite Verfolgung dieses Zieles kann zu einem wirklichen Datensatz „hoher Qualität“ führen, auf den sich die wissenschaftliche Gemeinschaft verlassen kann; egal ob man diese Daten für Modellrechnungen benutzt oder den Beitrag menschlicher Aktivitäten abschätzen will.

von David W. Schnare, Esq. Ph.D. Das Original erschien hier

Die Übersetzung besorgte dankenswerterweise Chris Frey für EIKE

* The SPPI analysis of rural versus urban trends

Wir freuen uns über Ihren Kommentar, bitten aber folgende Regeln zu beachten:

- Bitte geben Sie Ihren Namen an (Benutzerprofil) - Kommentare "von anonym" werden gelöscht.

- Vermeiden Sie Allgemeinplätze, Beleidigungen oder Fäkal- Sprache, es sei denn, dass sie in einem notwendigen Zitat enthalten oder für die Anmerkung wichtig sind. Vermeiden Sie Schmähreden, andauernde Wiederholungen und jede Form von Mißachtung von Gegnern. Auch lange Präsentationen von Amateur-Theorien bitten wir zu vermeiden.

- Bleiben Sie beim Thema des zu kommentierenden Beitrags. Gehen Sie in Diskussionen mit Bloggern anderer Meinung auf deren Argumente ein und weichen Sie nicht durch Eröffnen laufend neuer Themen aus. Beschränken Sie sich auf eine zumutbare Anzahl von Kommentaren pro Zeit. Versuchte Majorisierung unseres Kommentarblogs, wie z.B. durch extrem häufiges Posten, permanente Wiederholungen etc. (Forentrolle) wird von uns mit Sperren beantwortet.

- Sie können anderer Meinung sein, aber vermeiden Sie persönliche Angriffe.

- Drohungen werden ernst genommen und ggf. an die Strafverfolgungsbehörden weitergegeben.

- Spam und Werbung sind im Kommentarbereich nicht erlaubt.

Diese Richtlinien sind sehr allgemein und können nicht jede mögliche Situation abdecken. Nehmen Sie deshalb bitte nicht an, dass das EIKE Management mit Ihnen übereinstimmt oder sonst Ihre Anmerkungen gutheißt. Wir behalten uns jederzeit das Recht vor, Anmerkungen zu filtern oder zu löschen oder zu bestreiten und dies ganz allein nach unserem Gutdünken. Wenn Sie finden, dass Ihre Anmerkung unpassend gefiltert wurde, schicken Sie uns bitte eine Mail über "Über Uns->Kontakt"Lieber Herr OW,

Ihrer Erläuterung in #8 ist nicht ganz korrekt. Nach elementarer Fehlerrechnung ist der systematische Fehler (bias) der Temperaturdifferenz zwischen zwei Orten die Differenz der systematischen Fehler der beiden Instrumente A und B gegenüber einem geeichten Referenzinstrument. Der statistische Fehler der Temperaturdifferenz ist die Wurzel aus der Quadratsumme der statistischen Fehler der beiden Instrumente.

Aber nun zum Thema: es geht doch letztlich um die Erstellung von Rasterdaten (also Interpolationen). Was hat die Genauigkeit der interpolierten Daten mit Ihren Messfehlern zu tun? An der interpolierten Stelle wurde noch nie gemessen. Sie sehen außerdem, dass z.B. das Hadley-Center die verschiedenen Fehlerquellen bei den global Daten aufbröselt. Ist daran nach Ihrer Meinung etwas falsch?

PS: Könnten Sie Ihre Behautungen in #2 und #9 physikalisch&mathematisch belegen? Das kann ich so nicht nachvollziehen!

Hallo,

Und hier noch ein Aussage aus dem offziellen Statusbericht vom Deutschen Wetterdienst: „Da es angestrebt wird, die sensiblen und latenten Wärmeflüsse der Ozeane in einem Gebiet von 500 x 500 km^2 mit einer Genauigkeit von ca. 10 Watt/m^2 zu bestimmen, müssen folgende Genauigkeiten für Temperatur- +/- 0,2-0,1°C und für Wind-Messungen ca. 0,5 m/s erreicht werden. Andernfalls ist eine Analyse und Bewertung der Wärmeflüsse der Ozeane und dessen Einfluss auf Wetter und Klima nicht möglich.“

Grüße, OW

Hallo Herr Fischer,

Wenn Sie die Messung mit demselben Thermometer an zwei verschiedenen Orten durchführen, dann ist das was Sie sagen völlig korrekt. z.B.: Ich messe mit dem Thermometer die Temperatur am Ort A, dann lasse ich mich 40 km an den Ort B „beamen“ und messe dort die Temperatur. Die Differenz der Temperaturen von Ort A und Ort B ist der „wahre“ Wert der Temperatur-Differenz, da ich mit demselben Instrument gemessen habe. Und das Beispiel mal mit Zahlen zu veranschaulich:

1.Thermometer vom Ort A: 18,5 -> (B) 17,5

2.Thermometer vom Ort B: 16,5 -> (A) 17,5

Wenn man jetzt die Differenz zwischen Ort A und Ort B mit dem gleichen Thermometer vergleicht,

dann beträgt diese immer 1 Grad. Wenn man jetzt aber die beiden Ort mit unterschiedlichen

Thermometern (Mess-Instrumenten) vergleicht, dann liegt die Differenz bei 0 und 2 Grad. Das macht einen prozentualen Fehler der Temperatur-Differenz von 100% aus.

Sobald sich Daten nicht auf dasselbe Mess-Instrument der Lokalität beziehen, müssen die Genauigkeits-Intervalle angeben bzw. einbezogen werden. Es spielt in diesem Zusammenhang keine Rolle ob die lokal gemessenen Daten-Differenzen exakt sind, denn diese Differenzen können mit einem anderen

Mess-Instrument ganz anders ausfallen.

Grüße, OW

Lieber Herr OW,

„Wollte man zum Beispiel eine Genauigkeit von 10% Fehlertoleranz für globale Temperaturen in Bodennähe (2 Meter Höhe) auf der Erde ermitteln, braucht man rund 3 Mill. Messpunkte – 800 Tausend auf dem Land und 2,2 Mill. auf dem Wasser. Die Oberfläche der Erde misst ca. 510 Millionen km^2, das wären pro 170 km^2 Fläche ein Messpunkt.“

Das interessiert mich, könnten Sie mal die vollständige Rechnung darstellen? Danke!

Ich gebe Ihnen Recht mit der Genauigkeit der Thermometer. Aber Ihre Folgerungen für den darauf folgenden Fehler für die globalen Temperaturtrends kann ich mathematisch nicht nachvollziehen. Auch dafür hätte ich gerne die Details Ihrer Überlegungen.

Sehr geehrter OW

„Die ersten Messungen mit einer Temperaturmessgenauigkeit von bis zu 0,01°C wurden von Beckmann 1905 mit einen „Beckmann-Thermometer“ erreicht (Fieberthermometer 1857 mit einer Auflösung von 0,1°C). Bis in die 70-er Jahre hinein wurde mit einer Genauigkeit von 1 Grad die Temperatur der Wetterstationen abgelesen. Mathematisch bedeutet dies, dass die relative Fehlertoleranz der Korrelation bei +/- 0.5°C liegt. Damit sind ALLE Temperaturdifferenz-Trend-Betrachtung unter einem Wert von 0,5 Grad wegen des relativen Fehlers der Messungen sowieso wenig sinnvoll. Erst ab Mitte der 70-er Jahre wurden Thermometer mit einer Messgenauigkeit von 0,5 Grad in den Wetterstationen eingeführt.“

Meines Erachtens übersehen Sie zwei Dinge:

1. Selbst wenn die absolute Kalibrierung eines Thermometers um 0,5° danebenliegt, so kann ich mit diesem falsch kalibrierten Thermometer trotzdem die richtigen Temperaturänderungen messen. Verwertet werden also keine absoluten Temperaturen, sondern lediglich deren VERÄNDERUNGEN, genannt „Anomalien“.

2. Der (statistische) Fehler eines Mittelwerts ist stets kleiner als der Fehler einer Einzelmessung. Er sinkt mit 1/Wurzel(n), wobei n die Anzahl der Messungen ist.

o,o1 °C ?

kann man doch angeben, oder ?

als anerkanntes Institut, sogar noch mit staatlicher Anbindung genießt man doch jede Menge Vorschußvertrauen, unkritisches Vertrauen : „was DIE sagen wird schon stimmen“

So lange keiner was dagegen sagt, weder Regierung (die sowieso nicht), noch andere Fachleute und erst recht nicht die Medien (ganz wichtig), kommt man mit solchen Zahlen durch.

Genau in dieser Ausdrucksweise : : das ist traurig aber wahr.

Die Aufklärung hat es hier schwer.

So viel mir bekannt ist (bitte Korrektur) wird die Temperatur der Antarktis von einer ! Meßstelle aus ermittelt, und die liegt auch noch an der Westseite am Meer. Da benötigt man schon viel „Justier und Hochrechnungstalent“ oder vielleicht eine Kristallkugel, um die Temperaturanomalien für die ganze Antarktis zu ermitteln.

Mein Vorschlag zur Übersetzung von:

„In theory, they adjust stations based on the night time luminosity

of the area within which the station is located.“

„Theoretisch werden die Stationsmessdaten aufgrund der nächtlichen

Luminosität des Gebietes angepasst, wo die Station liegt.“

——————-

Weitere Bemerkung zu „they adjust“: Mit dem Wort „to adjust“ im Kontext der historische Klimadaten könnte leicht die Assoziation der erhöhten Genauigkeit, des genaueren Einstellens, Einmessens, Einrichtens, Justierens geweckt werden. Dahinter steckt aber in unserem Kontext meist das Gegenteil: Wenn da „to adjust“ steht, wurden Messdaten nachträglich verändert. Man könnte auch salopp sagen, man hat daran herumgefummelt! Das bedeutet gewiß nicht „größere Genauigkeit“.

Die Experten in Neuseeland haben ihre verfügbaren Daten, die Rohdaten ab 1850 „justiert“, und haben damit eine Erwärmung von 0,96°C herausbekommen mehr wie das IPCC. Super Leistung.

Klingt aber auch fachmännisch. Mit der richtigen Wortwahl ist das alles kein Problem, da kriegt man sogar die Klimaerwärmung in den richtigen justierten Griff, wenn es an Wissenschaft fehlt.

Hallo,

Niemand wundert sich, dass die unteren/oberen Peaks (Spitzen) der Kurven (Bild 1) auf ganz-zahlige Temperaturen zeigen?

Zudem frage ich mich, wie können die Temperaturwerte z.B. bei http://data.giss.nasa.gov/gistemp/ mit einer Genauigkeit von 0.01°C (Temperature Anomalies in 0.01 degrees Celsius) seit 1880 angegeben werden.

Die ersten Messungen mit einer Temperaturmessgenauigkeit von bis zu 0,01°C wurden von Beckmann 1905 mit einen „Beckmann-Thermometer“ erreicht (Fieberthermometer 1857 mit einer Auflösung von 0,1°C). Bis in die 70-er Jahre hinein wurde mit einer Genauigkeit von 1 Grad die Temperatur der Wetterstationen abgelesen. Mathematisch bedeutet dies, dass die relative Fehlertoleranz der Korrelation bei +/- 0.5°C liegt. Damit sind ALLE Temperaturdifferenz-Trend-Betrachtung unter einem Wert von 0,5 Grad wegen des relativen Fehlers der Messungen sowieso wenig sinnvoll. Erst ab Mitte der 70-er Jahre wurden Thermometer mit einer Messgenauigkeit von 0,5 Grad in den Wetterstationen eingeführt.

Temperatur-Messungen im Freien können nur auf maximal 0,1 Grad genau gemessen werden. Auch die absolute Thermografie-Genauigkeit im Freien liegt nur bei 0,1 Grad. Grund dafür sind die vielen Einflussgrößen, die die Temperatur-Messung nur mit dieser Genauigkeit möglich machen. Die aus dem Weltraum gemessenen Temperaturen über das Wärmebild werden mittels Lambertschen Cosinus-Gesetz und der differentiellen Emissivität des Volumenelementes numerisch bestimmt. Der relative Fehler beim Lambertschen Cosinus-Gesetz steigt mit der Entfernung zum Messpunkt und liegt aus dem Weltraum bei ca. +/- 0,3-0,5 Grad.

Mit den neusten Thermometern (Glaskörper-Widerstandsthermometer Pt100 Klasse B, 1/3 DIN – Messgenauigkeit: +/-0,1-0,4K – Einfach mal per Google suchen: „Pt100 Klasse B, 1/3 DIN“) hat man eine relative Fehlertoleranz von ca. +/-0,2 Grad.

Hat schon jemand mal den Verteilungsgrad oder Häufigkeitsverteilung der Messpunkte und die entsprechenden vorhandenen realen Messpunkte (Mess-Stationen) korreliert. Wenn man eine gewisse Genauigkeit durch Messungen erreichen will, muss eine entsprechende gleichmäßige Messpunkt-Dichte gewährleistet sein. Wollte man zum Beispiel eine Genauigkeit von 10% Fehlertoleranz für globale Temperaturen in Bodennähe (2 Meter Höhe) auf der Erde ermitteln, braucht man rund 3 Mill. Messpunkte – 800 Tausend auf dem Land und 2,2 Mill. auf dem Wasser. Die Oberfläche der Erde misst ca. 510 Millionen km^2, das wären pro 170 km^2 Fläche ein Messpunkt.

Aus einer Handvoll Daten werden ganz abenteuerliche Schlüsse gezogen, die jedweder statistisch-mathematischer Grundlage entbehren. Alle Behauptungen, die mit irgendwelchen Zahlen

(und möglichst zwei Nachkommastellen) „belegt“ werden, vermitteln den Eindruck von Exaktheit, Sachlichkeit und Objektivität. Jemand hat auch einmal behauptet:

„Mit Statistik kann man alles beweisen, auch das Gegenteil“

Dem ist nicht so:

„Mit Statistik kann man nichts beweisen, nur das Gegenteil.“

Grüße

OW

„Daten anpassen …“, das klingt schon nach frisieren und schummeln vor der Betriebsprüfung, wie wär’s mit dem beliebten „harmonisieren“? Die hochdotierten Experten haben ihre Klimadaten ‚harmonisiert‘, klingt doch gleich viel netter.